Кто-то понял как лечить .assistant у лламы3 в ответах?

Или качать не инстракшн версию?

Или качать не инстракшн версию?

>Или качать не инстракшн версию?

Ну да. У меня на Meta-Llama-3-8B.Q6_K.gguf таких приколов не было. Но с другой стороны она хуже затыкается, забывая про стоп токен.

уже кто-то натюнил токсичную модель на обновлённом unalignment/toxic-dpo-v0.2 датасете (v0.1 версия отлично вписалась в SOLAR-10.7B бтв)

https://huggingface.co/raincandy-u/Llama-3-8b.UNLEASHED

https://huggingface.co/raincandy-u/Llama-3-8b.UNLEASHED

https://github.com/meta-llama/llama3/blob/main/llama/tokenizer.py#L228

>tokens.extend(self.encode_header({"role": "assistant", "content": ""}))

Это просто лол нахуй.

>tokens.extend(self.encode_header({"role": "assistant", "content": ""}))

Это просто лол нахуй.

если юзаешь ST. тупо скачай вот это : https://files.catbox.moe/1rzg32.json

импортируй его в Context Template и Instruct Mode, а так же убери галку с "Skip Special Tokens" в разделе семплеров.

так же можешь попробовать пикрил параметры, у меня всё работает отлично. (тык на neutralize samplers и затем выставляй значения).

>i кванты

Вряд ли там матрицу важности подгоняли под какие-то языки, кроме английского, поэтому мне для тестов переводов лучше, как я понимаю, взять обычный "усреднённый" квант.

Поясни, что это значит....?

Сука, как же меня трясет

Не уверен что это прям так, но какие-то такие ощущения от этой модели, действительно. Ну во всяком случае это явно не 8Б, подозрительно как-то.

Я думаю мы видим ответ на вопрос - что будет если тренировать мелкую модель на дохуя языков и вбухать в 75 раз больше компьюта чем считалось оптимальным по шиншилле (как говорит Карпати, можно вбухать ещё на 2-3 порядка больше). Правило Шиншиллы оптимально по отношению флопсы/результат, но если у тебя избыток флопсов, то судя по всему получается примерно это.

Цук в интервью сказал что они закупили море H100 для рекомендательной системы пейсбука, и борщанули, половина лежала без дела. Вот в это и пустили.

Причина тряски?

Интересно, хули гопота 0613 так низко, она же самая менее соевая.

По факту, ассистант захардкодили, предвижу проблемы с ролеплеем. Скорее всего, ещё и при тренировке. Если вкратце, то зайди в параметры генерации и закинь "assistant", как Custom stopping strings. В остальном, уёбищный формат темплейта, который скорее всего использовался и при тренировке.

Мда ну и скорости на процессоре

На свежей ллама.спп с куда, без выгрузки слоев

c4ai-command-r-v01-Q4_0.gguf 18.8 гб генерация 2.02 т/с

модель поменьпше

c4ai-command-r-v01-imat-IQ3_M.gguf 15.5 гб генерация сраных 0.79 т/с

c4ai-command-r-v01-imat-Q4_K_S.gguf 18.9 гб генерация 2.21 т/с

Так бля какого хрена, тоесть матрица важности норм, а i кванты хуйня.

Окей, осталось еще проверить будет ли разница на обычном кванте Q4_K_S, но его еще качать хз сколько

Значит только то что модель успешно создает ощущение большой умной сетки в коротких разговорах

Скорей всего да, лучше обычный квант в таком случае, ну и если будешь на процессоре крутить можешь упереться в i кванты, так как они медленнее

Интересно будет посмотреть на сколько пробили сою, помоему без серьезного дообучения нереально от нее избавится

На свежей ллама.спп с куда, без выгрузки слоев

c4ai-command-r-v01-Q4_0.gguf 18.8 гб генерация 2.02 т/с

модель поменьпше

c4ai-command-r-v01-imat-IQ3_M.gguf 15.5 гб генерация сраных 0.79 т/с

c4ai-command-r-v01-imat-Q4_K_S.gguf 18.9 гб генерация 2.21 т/с

Так бля какого хрена, тоесть матрица важности норм, а i кванты хуйня.

Окей, осталось еще проверить будет ли разница на обычном кванте Q4_K_S, но его еще качать хз сколько

Значит только то что модель успешно создает ощущение большой умной сетки в коротких разговорах

Скорей всего да, лучше обычный квант в таком случае, ну и если будешь на процессоре крутить можешь упереться в i кванты, так как они медленнее

Интересно будет посмотреть на сколько пробили сою, помоему без серьезного дообучения нереально от нее избавится

Чей ггуф новой 8б лламы качать?

мой

>i кванты хуйня.

хуйня у коня. Давно известно что самый быстрый квант IQ4_XS. Гавном от 3 и ниже пользоваться нет смысла абсолютно никакого. Оно не кардинально меньше в размере - раз, оно медленне почти в два раза - два. А то типо выиграл два гига а скорость 0,7 хуя вместо двух. По 4_0 у тебя судя, скорость с будет 4XS - 1.8-2тс минимум

А почему IQ3_M медленнее то? Хочешь сказать на процессоре будет быстрее IQ4_XS? Ну, я могу и его качнуть и проверить

>почему IQ3_M медленнее

не только этот квант, вообще все I3. Ну вот так сделал икавраков i кванты. Он хотел исправить это, но воз и ныне там. Вобщем в i квантах имеет смысл качать 3 и ниже если только модель просто иначе не влезет в рам.

Окей, качну IQ4_XS, а в чем он отличается от Q4_K_S?

И как думаешь, пострадает ли русский если с матрицей важности качать 4 кванты?

>Окей, качну IQ4_XS

Отпишись потом о скорости, а то с этими i-квантами и правда непонятка какая-то. Многие качали мелкий квант и плевались, а может и правда они поломанные.

> Хватит повторяться как попугай.

> Шиз?

Да какой хочешь себе диагноз, такой и ставь.

Я к тому, что этому аргументу скоро год, арена не нравилась многим с момента выхода.

Но все эти тесты еще дальше от реальности, чем арена, вот и все.

> В той же арене до сих пор из клоды первая, весьма днищенская, в лидерах и опережает вторую и опуса?

Что? :)

Пикрил.

> Сейчас дошли до того что пытаются даже юзер-экспириенс бенчмарки компрометировать надрочкой, смотри те же загадки и популярные вопросы.

Офк, хуйня, но практика пока более-менее совпадает с ареной, поэтому причин доверять синтетическим тестам, расходящимся и с практикой, и с ареной — особо-то нет.

Ну так Микстраль-то и была где-то там, в серединке, не выстрелила нихуя.

Чему удивляться. =)

———

Про кванты интересная хуйня, конечно.

Надо будет попробовать качнуть небольшую несколько вариантов и затестить.

Попробовал погонять с разными изменениями рекомендованного пресета - по-видимому, проблема в том, что не генерится EOS токен, который в токенайзере должен быть <|end_of_text|>. Поэтому когда сетка хочет завершить свой ответ, она EOS токен пропускает, как будто он забанен, и пытается начать новый ответ ассистента, ставя <|start_header_id|>assistant<|end_header_id|>, что в выводе преобразуется как раз просто в assistant\n\n. Если использовать другой пресет (я пробовал свой кастомный на основе чатмл) или оставить пустыми поля инстракта для юзера и асситанта, кроме последнего ответа, то срать ассистантами начинает гораздо меньше, но начинает пытаться продолжать чат за пользователя, вставляя {{user}}: после ответа, т.к. EOS токен всё ещё не генерится. Также чатмл формат периодически подхватывает и пытается завершать свои сообщения <|im_end|>.

почти ничем не отличаются по качеству и по скорости, только i меньше в размере занимает.

Если сомнения - скачай без матрицы, такие тоже есть. По себе скажу - не заметил вреда русскому, но с другой стороны я ведь не лингвист. Сначала был квант на матрице от икавракова на файле groups_merged.txt, потом перекачал другой квант с матрицей на вики трейн - разницы в русском не увидел.

https://aliexpress.ru/item/1005006155095429.html

Китайцы прилепили нормальный кулер к Tesla P40.

Никто ещё не покупал подобные моды?

Используй assistant как eos.

>24 460 ₽

Ну как-то удачи им что ли в продажах

https://huggingface.co/qwp4w3hyb/c4ai-command-r-v01-iMat-GGUF/discussions/2

У этого парня все качал, но выяснилось что ллама.спп обновила шаблон чата и в итоге он еще не перезалил командера с последними обновлениями

Хуй знает как это повлияет на производительность, по идее никак. Просто будет удобнее использовать готовые кванты, как я понимаю.

Ну к вечеру скачается, протестирую. Не забуду напишу сюда

------------------------

Кстати говоря запустил так же потыкать qwen1_5-32b-chat-q4_0.gguf

Запустилась с куда без тарабарщины, как в codeqwen-1_5-7b

Скорости такие же как в командере, по мозгам умнее всех моделей что меньше ее. По идее неплохая базовая модель может выйти, а на закуску у нее 65 слоев, вместо 42 у командера 35b.

Командер нам в базовой версии модели недоступен, а она есть.

Хотя она скорей всего хуже его, в русский может едва

Ну а сейчас опять будут только новую ламу дрочить 8b, ладно если 1-2 файнтюна на квен 32 выйдет.

На пикче вывод квен 32 в чатмл без перевода. Тестами тыкать лень

Не прилепили кулер, а полностью заменили радиатор на нормальный с подходящей видеокарты.

Цена конечно пиздец, но как-то так они на Али и стоили.

+ деньги

- пердолинг с картой и покупка улитки и коннектора для нее с тратой часов/дней на все это

Я думаю все таки это стоит своих 24к, хоть и на грани

Аналогов на 24г врам все равно нет дешевле

https://huggingface.co/MaziyarPanahi/Llama-3-13B-Instruct-v0.1-GGUF

ну а вдруг в этот раз получится что-то хорошее?

ну а вдруг в этот раз получится что-то хорошее?

>This model is a self-merge of meta-llama/Meta-Llama-3-8B-Instruct model.

Чёт я не понял, как он это родил? но кочаю

Как обычные 11b слепленные из 7b

Только теперь изза 8b на выходе бутерброд на 13b получается

Может даже умнее, но скорей всего будет шизить немного

Мержекитом. Есть даже два рабочих способа сделать это - чередуя слои или пришивая к концу начало.

В целом, впечатления от лламы-3 в итоге, как от какого-то васянского поделия. PAD токена нет, OES токена нет, везде вшит "ассистент", объяснения, извинения и т.д. Но поиздеваться над ней можно.

>Мержекитом. Есть даже два рабочих способа сделать это - чередуя слои или пришивая к концу начало.

А в этом есть хоть какой-то практический смысл?

Таки 20b считаются умнее, чем 13b, а они получены путём подобных богомерзких телодвижений.

Лол, искусственную личность ассистента вылепили еще более явно чем раньше, раз уж сквозь отыгрышь пробивается

А это означает меньшую вариативность отыгрыша, ну и то что сетка надрочена на определенное хорошо и плохо.

Как я и предсказывал давным давно, хули

теперь с таких двух пусть слепят двадцатку. Надо подождать пока нафайнтюнят кучу восьмерок и икари дев с унди нашлепают с них франкенштейнов по двадцать, а вообще чет как-то накуй не нужна лама 3 - пока что не увидел ничего неебического в ней, в отличие от командира - не впечатлило.

c4ai-command-r-v01-imat-IQ4_XS.gguf размер 17.8 гб, скорость генерации 1.77 т/с

Ну, при меньшем размере чем Q4_K_S, скорость на 0.4 меньше, эт где то падение скорости генерации на 20 процентов, что довольно дохуя

И я делаю вывод что конкретно мне лучше крутить Q4_K_S, с матрицей или без, лишь бы не i кванты.

Кстати говоря, чтение промпта на Q4_K_S и Q4_0. держалось около 6-7 т/с

i кванты все около 2-3 т/с, конкретно этот - 2.62 т/с

Это так не работает, смешать 4 сетки уже не выйдет. Вот если по методу solar 8b дообучат нарастив слоев, до 12b, вот тогда их уже можно будет попробовать смержить до 18-19b, но что получится хз

Прогнал по базе эту вашу ллама 3 на 70B. Вердикт- сломан стоп токен напрочь, модель не может заткнуться.

Базы не знает, но с петухом самый креативный ответ (если бы не луп).

Базы не знает, но с петухом самый креативный ответ (если бы не луп).

Тут уже проблема. Сделать двадцатку из этой 8b можно только в длину, наращивая по слоям. В ширину я пробовал, нужно полный файнтюн проводить, иначе пиздец. Но скорее всего двадцатки из этой модели будут и будут скоро.

Стоп токен это assistant

>Стоп токен это assistant

Так она и асистента высрала только в половине случаев. В остальных бредит без него.

Пиздосю, а если у меня легитимный assistant посреди текста?

Да поищите на реддите или гитхабе, уже были нормальные воркараунды.

Ага, использовать любой неродной формат промта. Вот с альпакой, стоп токен прекрасно находится.

Вы это видели? - он уже засайгачил ламу 3. Вопрос нахуа это надо если и так по русска балакает - видимо не стоял.

https://huggingface.co/IlyaGusev/saiga_llama3_8b

https://huggingface.co/IlyaGusev/saiga_llama3_8b

Ну хуй знает тогда. Да, модель шизик, т.к хуй его знает, какой у неё там инстракт темплейт, я гоняю на альпаке и она часто подсирает под себя.

Ну добавь туда вместо ассистанта "<|end_of_text|>", но ассистанты будут высираться иногда. Стоп токен так-то есть, в конфигах прописан.

Обсайгачил по самые гланды.

Ахаха, датасет у него уровня бездомный Бог. Беру буквально первые 2 строки, и в обоих какой-то левый пиздёж. Вот нахуя на этом мусоре тренировать нейронки?

Зато крепостное право конечно же не для порабощения, ага.

https://t.me/senior_augur/82

Э-э-эксперименты!

———

Ваще, конечно, модели прям такие себе вышли.

В какие-то моменты они заставляют ахать от удивления, а в какие-то (большинство) — блевать, к сожалению.

Это прямое, как мне кажется, следствие вот этой вот всей цензуры. Впилили ассистента, теперь она обкакивается там, где не должна, извините пожалуйста, я не пишу неэтичный контен.ассистент

Какой пидр утащил мой скрин в эту помойку?

Впрочем ладно, если кто-то хочет работать передастом, то вот (сам я мараться об всякие сообщества в дуровском мессенджере не хочу).

Ну и как вам 70b?

Как говно вестимо.

Что с ней не так? Слишком много сои?

Ноль прорывов. По сути какая-нибудь мику или командир с плюсом будут лучше.

Сою налили в инструкт версию, это ожидаемо. Базовая вроде не сильно отказывает, на первый взгляд.

Тут вся надежда на файнтюны, так как мику тюнить по сути нельзя, то новая 70-ка с чуть худшим перфомансом может стать лучше мику с доводкой.

Эх, а нам обещали тонкое понимание логики. Хотя, уже хорошо.

А кто-нибудь помнит разница между ллама1 и ллама2 одного размера сильно была больше?

Хуяи?

Разница была, но не очень большая. Этот скачок куда больше

Это синтетический датасет сгенерированный Порфирьевичем. Мировая практика.

>разница между ллама1 и ллама2 одного размера

Двойка апнула на уровень вверх, то есть 7B стала как 13, 13 как 33, ну и далее.

Тут технически тоже самое, 8 ощущается как 13, но у нас уже был на руках мистраль, который сделал тоже самое. Про 70-ку я уже отписал. Так что лично я ажиотажа не разделяю.

А хуй его знает. Шатает её, качество сильно нестабильно.

Ну и я жопой чую, что жора и тут поднасрал. Через пару недель пофиксят небось.

>Этот скачок куда больше

Прыжок на месте?

Обижаешь, там турба.

Для фейсбука выпустить свою сетку которая лучше мистраля уже достижение, так что как минимум сравнивая с ллама2 они апнули ллама3 на уровень. Но конечно, ограничения 7b никуда не делись. Просто выдрочка более эффективным датасетом, дольше и с более оптимизированным токенизатором.

Я бы хотел 13b с такой же прокачкой, а не еще одну мелочь. 30 была бы вобще бомбой

Есть у кого пикча с прямыми сравнением llama 1, 2 и 3 по бенчмаркам? Хочу посмотреть кривую по которой идёт развитие ии и предположить чо там будет по опенсорсу через пару лет

Пока ещё неуверенность в эло большая, надо дать недельку устаканиться (но понятно что модель вышла что надо)

>через пару лет

Тут на пол года загадывать бессмысленно, а ты на годы вперед хочешь, хех

>Для фейсбука выпустить свою сетку которая лучше мистраля уже достижение

Блять, они выпустили лламу2 которая стала стандартом дефакто на своё время, нагнув большинство сеток с открытыми весами (или все). Неудивительно что ллама3 тоже пиздато получилась.

Но 7 была пососная все равно, теперь вот доделали, ну да.

>Для фейсбука выпустить свою сетку которая лучше мистраля уже достижение

Эм, чё? Для фейсбука равняться на мисраньАИ без железа, которых купили с потрохами за 15 лямов, это блядь позор.

>Я бы хотел 13b с такой же прокачкой

А то. Поэтому и зажали. Ллама 4 будет только в размере 10B, скриньте.

Скажи еще что Мур хуйней страдал когда свой закон придумывал

Вот что 24000 H100 животворящих делает

Закономерность мура ужа давненько соблюдается только условно, рост перестал уже как несколько лет быть таким как он предсказывал. Лет 10 наверное, хз не помню где и когда читал об этом

>Эм, чё? Для фейсбука равняться на мисраньАИ без железа, которых купили с потрохами за 15 лямов, это блядь позор.

Спецы из гугла на сколько я понимаю, а у гугла разработки в этой теме более глубокие чем у фейсбука.

Без спецов со знаниями хоть сколько денег и оборудования кидай, ниче не выйдет.

Так что да, фейсбук можно спокойно сравнивать с мистралем, эти ребята делом доказали что в свое время знали и понимали больше чем другие. Теперь вот их догоняют. О чем знают в самом гугле, и в клозедаи мы сравнить не можем, сеток нормальных нет.

Хотя гемма вроде умна, если бы не была искажена соей

>а у гугла разработки в этой теме более глубокие чем у фейсбука

А что ж они всё со своей геминей обсираются? Их клозеды с антропиками на пару ебут.

Не сильно.

Вероятно, дело в том, что на этом уровне качество уже достаточно хорошее, поэтому оно прям норм воспринимается и разницы сильно не видишь.

Разница на уровне объема датасета, используемого для обучения, и, соответственно, знаний.

Конечно, вторая 70б была лучше первой 65б. Но в тонкостях.

Мистраль им все поломало, я пока тоже чую етот вайб.

Если бы не было мистрали и ее производных, то мы бы щас такие «нихуя себе, она на русском говорите, ебать умная!»

> Лет 10 наверное

Да.

Там маги из НВидиа колдуют, чтобы он соблюдался в некоторых условных рамках «одна видяха — прирост».

> Хотя гемма вроде умна

В рамках своего датасета только, но плюсую.

>тупо скачай вот это : https://files.catbox.moe/1rzg32.json

Официально заявляю- шаблон говно. На скрине сравнение с тем, как надо ( https://llama.meta.com/docs/model-cards-and-prompt-formats/meta-llama-3/ ). Единственный проёб это лишний перевод строки после системного промта.

Вот поправленный- https://files.catbox.moe/r8qqp3.json

Юзать вместе с минималистичным темплейтом.

много говна, мало палок

>то мы бы щас такие «нихуя себе, она на русском говорите, ебать умная!»

Но ведь уже есть командир, который ебёт всех и вся на русском... Разве что командир по-жирнее будет.

После того как добавил в стоп токены ["Assistant", "assistant", "Assistants", "User", "user", "user1"] стало получше. Но пока что Лама 2 кажется на голову выше, отвечает довольно криво. Хз что вы такого удивительного нашли в этой модели.

Отстань от франкенштейна. В прошлый раз с полгода ебались, пока не научились лепить нормальных монстров, что аж в шапку попало.

Ну молодец, чё, выкинул 95% датасета (впрочем согласен, датасет от турбы это чистый мусор, я бы его и с сайта потёр). К остаткам датасета, сделанного четвёркой, не доебаться, ну разве что до орфографии и слегка не актуальных советов.

> Но все эти тесты еще дальше от реальности, чем арена, вот и все.

Почитай про них и станет понятно что за что отвечает. Проблема в их компрометируемости, а если делать постоянно разные то будет низкая точность оценки.

> Пикрил.

Топ кек, гопоту уже ебем, замечательно. Надо будет сейчас покумить на семидесяточке новой.

> Офк, хуйня, но практика пока более-менее совпадает с ареной

Да если бы, как же там они апали первый микстраль, подкручивая его выдачу, и где он сейчас? Неспроста убрали, флуктуаций паразитных и странных там очень много.

Топ кек. Не ну а почему бы и нет собственно.

> Вопрос нахуа это надо если и так по русска балакает - видимо не стоял.

Вот тут двачую, видимо не может он успокоиться видя нормальную модель, которая еще и большой контекст обрабатывать может, нужно все поломать.

Похоже идет какой то косяк при прямом кванте из bf16

> Для фейсбука выпустить свою сетку которая лучше мистраля уже достижение

Обзмеился с секты свидетелей мистраля. Ну рили даже сравнивать не стоит.

> Конечно, вторая 70б была лучше первой 65б. Но в тонкостях.

И в толстостях. Если первая просто лучше тебя понимала и соображала, буквально просто была "хорошей ллм", то вторая уже проявляла чудеса проницательности и креатива.

Ну кстати действительно может быть, особенность bf16.

https://huggingface.co/MaziyarPanahi/Llama-3-16B-Instruct-v0.1

>This model is a self-merge of MaziyarPanahi/Llama-3-11B-Instruct-v0.1 model.

>This model is a self-merge of MaziyarPanahi/Llama-3-11B-Instruct-v0.1 model.

Интересно на сколько хватит запаса этой модели, будет ли она еще лучше так мержится или наоборот хуже

>как же там они апали первый микстраль, подкручивая его выдачу

Человек, ты не можешь просто так заявлять подобное, вытащив говно из жопы. Нужны какие-то зацепки.

>и где он сейчас? Неспроста убрали

Примерно там же где и был, в районе гопоты-3.5 турбо, никто его не убирал.

Ну почему шизомержи, а не дообучение?

Потому что дообучать - долго и дорого, а шизомерж - раз и готово

На этом кумить можно?

А толку саму с собой мое делать? Или там чет другое?

Там же одни и те же эксперты будут, лол

>А толку саму с собой мое делать?

Потому что может.

А может автор просто дурак и не понял что NousResearch просту ту же самую ламу выложил, чтобы её можно было кочать без регистрации

Может хотел проверить будет ли работать мое с этой моделью, тогда как тест сойдет

--------------

Скачал я инструкт версию 8b лламы, и спасибо анону выложившему промпт формат, у меня ничем странным пока не срет. Только срывается иногда начиная за меня отвечать, собака

Я так понимаю надо будет базовую версию качнуть, она лучше

Хочу эджи с воображением.

> Человек

Сам ты человек, кожаный ублюдок. Об это хейрне даже ролик пилили, что на короткий запрос тебе в 39 случаев из 50 выпадает микстраль, а на длинный текст с имитацией диалога и запросом на его аналис в 2 из 30. Сам пытался его выловить на анализ длинного промта - ни разу не выпал. Но тогда легко ловился простым запросом, и вот на второе сообщение уже можно его мучать сколько хочешь сразу в сравнении.

> Примерно там же где и был

Нету в текущих лидербоардах. Напомню что он был не просто выше 3.5 турбо, но и обходил клод 2. Ебало сотворивших это имаджинируемо. Справедливости ради стоковый клод под своей может быть уныл

Та же странность на добавление 4 турбо в арену, при этом ответы обычной 4 радикально испортились, и часто уступали локалкам. Делаешь тот же запрос по апи - все красиво и четко, пытаешься у них - короткая залупа с аполоджайзами не в тему.

Реальных полноценных файнтюнов не увидишь еще пару недель. Первые будут отвратительны и поломаны.

Вах, вот это топ

Хочю чтоб высрали анцензорд версию ламы 3 8b и запилили русский файнтюн. Я что многого прошу?

Да

А мое можно запилить взяв за базу несколько экземпляров готовой модели и файнтюня их, по тому же принципу как обычно обучают мое? Или обучение таких моделей должно происходить только с нуля? Я просто думаю, как 400b высрут, получится ли опенсурсу, если влить много денег на файнтюн, создать какую-нибудь 8x400b модель с 200 айсикью

>запилили русский файнтюн

Уже

Так он не анцензоред, да и качества сомнительного

качество сам проверяй, че то еще кидали, дпо с токсик датасетом, но где не помню

Оно уже в стоке такое.

> А мое можно запилить взяв за базу несколько экземпляров готовой модели и файнтюня их

Собственно, (по заявлениям) именно так и сделан мистраль а потом из него и микстраль.

Ну чет так себе на первый взгляд

https://huggingface.co/rmdhirr/Pulsar_7B

любопытная штучка, не пойму только какая базовая модель

любопытная штучка, не пойму только какая базовая модель

> Оно уже в стоке такое.

Больше пару раз юзать пробовал? Оно такую хуйню на русском генерит. Про цензуру вообще молчу

Бля, как же я расчитывал на то что будет мультимодальность, но какие же там зашоренные додичи сидят бляяяя. Уже молчу про то что это не мое, даже 400b походу не мое

Так-то и 70б на русском говорила, и ллама 1 30б даже что-то могла.

Но среди маленьких моделей… Ну я в любом случае к тому, что если абстрагироваться от других моделей, то выглядит пиздато. Просто живем мы не в вакууме и привыкли уже, что русский в мелких моделях встречается.

ЗЫ Еще Квен немного могет, кстати.

Пам-пам.

> Топ кек, гопоту уже ебем, замечательно

Ну, не кек, а реальность.

Впрочем, именно за 70б не скажу, хайп вокруг нее выглядит подозрительным.

Я к тому, что там нет никакого клода первого, лол, о чем ваще речь.

Там на первых местах гопота и опус, как они и есть.

И где-то чуть ниже коммандер, ниже Мистраль Лардж и Квен.

Ну, так-то оно и есть.

КХЕхкехкхехкхе

Шо так мала.

Хачу 10икс8.

Да, похрюкал с этого.

———

Вообще, конечно, такая херня творится. Шизомерджи, мое с нихуя.

Когда даже оригиналы пока с грехом пополам работают.

Подождать с недельку, а потом разглядывать.

>Нету в текущих лидербоардах.

Да вот же? И с клавдией и с гопотой 2.1 вровень, как и был, в пределах погрешности. (эло вероятностная характеристика, там есть и количество сэмплов и уверенность, стоит ниже крутануть)

>Об это хейрне даже ролик пилили, что на короткий запрос тебе в 39 случаев из 50 выпадает микстраль, а на длинный текст с имитацией диалога и запросом на его аналис в 2 из 30. Сам пытался его выловить на анализ длинного промта - ни разу не выпал.

Звучит как пиздаболия. У меня в основном как раз РП на множественных персонажей и заготовлен, и микстраль я ловил постоянно на выходе, потомушо они часто выставляют новые сетки чтобы побыстрее рейтинг устаканить.

Хуя, закрытый проект рожает модели через 0,0001нс после выхода базы. Надо бы ещё что-нибудь закрыть!

Подъехали нормальные тесты, лама на уровне последнего мистраль-инструкта, только контекста меньше, нас наебали, расходимся.

В шапке же написано (теги) - Mistral.

>Вообще, конечно, такая херня творится. Шизомерджи, мое с нихуя.

Каждый раз такое, если ты вдруг не заметил.

ага, но первый или второй?

хотя судя по оценкам скорей всего вторая базовая

кек

Да не, запустил нищеквант на сколько хватило терпения, похедпатил ассистанта и спать.

> Так-то и 70б на русском говорила

Плохо

> ллама 1 30б даже что-то могла

Совсем грустно

> Ну, не кек, а реальность.

Ладно, справедливости ради семидесятку новую еще не катал, все времени нет, да и как-то не хочется испортить впечатление. Было бы круто чтобы она могла так же офк, но на фоне всех этих "побед" надежд мало.

Ну вот, обоссаному микстралю для клавы как раком до Китая, а тут они рядом стоят. Хоть толика разума есть у тех кто такие оценки продвигает?

> Звучит как пиздаболия.

Лень искать банально, в прошлых тредах что-то скидывали. Хз, рпшить на микстрале это довольно странно, он слаб и не далеко от 7б ушел.

>c4ai-command-r-v01-imat-Q4_K_S.gguf 18.9 гб генерация 2.21 т/с

И это чисто на проце? Довольно быстрая скорость, какая система там у тебя?

Ролеплей файнтюны уже высрали?

8ми ядерный xeon с 4 канальной памятью, так себе, но игорь тонет, а в нейросетках дешево и сердито.

Ну, чисто на проце 8 квант 7b крутит 5-6 токенов в секунду где то, не пошикуешь, но потыкать или потрындеть норм

и какой из этих исправен? у NousResearch не качаю потому что шизо-Q5_K_M.

Высрали.

УУУУ, БЛЯ, А я думал чего так медленно все это работает, ебаные i кванты.

Оригинал качай и в 8бит запускай. Я вообще не ебу зачем вы эти кванты для сраной 8В качаете.

НОВАЯ ИМБА ЛАММА ПОДДЕРЖИВАЕТ КУМ??? ХУЙ ДЫМИТСЯ

нет

Да, даже инструкт че то пытается годное выдавать

Только промпт формат скачай

>Вот поправленный- https://files.catbox.moe/r8qqp3.json

Юзать вместе с минималистичным темплейтом.

и в таверну сунь, ну и качай нормальный квант

Квест по его поиску все еще открыт, лол

Ну она в стоке может выдавать крутые фразы и понимает какие взаимодействия ведут к возбуждению, какие с удовольствию и наоборот. Кумботы раскручиваются очень легко даже на 8б, хз что там у бедолаг что воют за цензуру.

Но пишет не так детально и подробно как рп файнтюны второй лламы.

И да, вот подобный шизосемплинг хорошо работал на тупых 7б, которым очень недостовало разнообразия, но приводит к тупизне и неадекватности на нормальных моделях, где с разнообразием и так все в порядке. Хз насчет 8б лламы, но она показала себя ближе ко вторым.

Не очень в теме локальщины. Эта хуйня - это же типа того чем был пигмалион? И оно не соевое и может в сиськи письки? https://huggingface.co/dreamgen/opus-v1.2-llama-3-8b

Есть вообще серьезные отличия от пигмы у подобных файнтюнов на моделях получше или оно так же выдает слабо связанный текст который пытается быть похожим на человеческую речь?

Есть вообще серьезные отличия от пигмы у подобных файнтюнов на моделях получше или оно так же выдает слабо связанный текст который пытается быть похожим на человеческую речь?

Ты последний год в коме был?

>Не очень в теме локальщины.

Пигма пала, центрурион.

Учитывая что новая ллама вышла только вчера - скорее всего эта штука посредственного качества, т.к. делалась в спешке и не полноценным файнтюном а qlora на мелком датасете. Иное крайне маловероятно.

Подожди неделю, будет уже что-то приличнее. По сравнению с пигмой, можешь даже стоковую лламу скачать, настроить правильном формат и ахуевать с прогресса. Она создает такое впечатление что действительно после грамотного промт-инжениринга, выдаст хорошие тексты, лучше чем 3.5 турбо точно.

Поясню - первая лама уничтожила пигму как явление, а в треде как видишь обсуждается третья.

Окей, эта хуйня уже местами на уровне чатгпт на минималках, так понятней?

Автор пишет 80м токенов 2 эпохи. Да и первая модель у него годная, там целый сайт типа чарактер аи

Понятно что пигма устаревший кал. Просто ллама - это базовая модель, а пигма - это файнтюн gpt-j или как там эта хуйня называлась. Мне интересно это тоже самое по смыслу.

Я вообще рассматриваю варианты как сделать ролеплей бота и хз с чего подступиться ибо давно не в теме. Но мне не нужна всякая мишура вокруг типа автора который пишет "Пошли они на речку и поебалися." посреди диалога или действий в звездочках вроде "Хрюкает". То бишь мне не нужно написание истории по факту. Мне нужен файнтюн где я могу указать какую роль отыгрывать и бот будет отвечать как в обычном чате в порядке: "мое сообщение" -> "его сообщение" -> "мое сообщение" -> "его сообщение" и т.д. Возможно нужна будет возможность разговора с ботом нескольких людей которые подписаны по имени, вроде: "сообщение Санек" -> "сообщение Петян" -> "ответ бота" и т.д. Еще бы мультимодальность к этому, но я наверное охуел с такими запросами.

Имелись ввиду все такие новые сетки вообще, даже сраные 7-8b

>Просто ллама - это базовая модель, а пигма - это файнтюн gpt-j

Ллама тоже файнтьюн gpt-j.

>Мне нужен файнтюн где я могу указать какую роль отыгрывать и бот будет отвечать как в обычном чате в порядке: "мое сообщение" -> "его сообщение" -> "мое сообщение" -> "его сообщение" и т.д.

Просто скачай ламу, запусти в таверне с карточкой персонажа и всё будет.

Я из тех кто юзал ЛЛМки чисто для кодинга и функций умного ассистента. Я смотрел как они решают математические задачи и как умеют в логику все лучше с каждой новой моделью, но я не в курсе как они по креативной части и как это отличается от той же пигмы в этом плане. Как по мне порфирьич креативнее убитого соей опуса, например. Эта вещь субъективна и на нее даже бенчмарков нет, по крайней мере их нигде особо не используют.

> там целый сайт типа чарактер аи

Чивоблять.webm?

Нет, офк все возможно, у него даже 70б файнтюны есть. Смущает припезднутый формат промта в сочетании с узкой направленностью, и быстрый выход. Если новую семидесятку будет делать то определенно надо будет скачать, кто 8б тестил - отпишитесь.

>Просто скачай ламу, запусти в таверне с карточкой персонажа и всё будет.

Мне нужен доступ к модели из кода а не из интерфейса, чтоб я на основе этого смог сделать приложение. Я понимаю что там промптами как-то добиваются ролеплея от базовой модели, но я крайне сомневаюсь что по качеству это будет близко к специализированному файнтюну

> Мне нужен доступ к модели из кода а не из интерфейса

Качай убабугу или кобольда и используй openai-like api. Запросы на комплишн идентичны, код простой и его примеров полно.

https://dreamgen.com

Я тестил этот сайтик, вроде неплохо, но не думаю что там уже новая модель стоит. Да и 70б модель там только по подписке, тоже интересно какова разница между ними, ощутима ли

>Мне нужен доступ к модели из кода

Т.е. через апи?

Ну кобольд и уба работают через апи. Не вижу проблемы.

> Я понимаю что там промптами как-то добиваются ролеплея от базовой модели, но я крайне сомневаюсь что по качеству это будет близко к специализированному файнтюну

Так бы и сказал что тебе рп файнтьюн нужен, держи

https://huggingface.co/TheBloke/Noromaid-20B-v0.1.1-GGUF

Не ну если так то уже респект за подход, красавчики, но мнение по модели не меняет. Скачай и сам оцени, главное все выстави в точности с их форматом, иначе экспириенс может оказаться радикально хуже ожидаемого.

70б веса у него же на обниморде выложены, ну и в данном треде принято их запускать локально. По крайней мере способных запустить 70б с комфортной скоростью точно больше чем пальцев на одной руке, что не может не радовать.

Спасибо, я просто уже искал варики именно на третьей ламе, чтобы иметь топ нотч решение на текущий момент. Но возможно начал слишком рано. Хотя тот файнтюн что я скинул внушает доверие судя по регалиям автора.

>Еще бы мультимодальность к этому, но я наверное охуел с такими запросами.

В кобальде и мультимодальность можно прикрутить и генерацию изображений там же, так что все в твоих руках. Дергай апи и играйся.

>Ллама тоже файнтьюн gpt-j.

Да ладно? джей это eleuther, я то думал ламу из опта как-то выродили. опт и джей сильно разные.

> топ нотч решение на текущий момент

Или стоковая ллама и промт инжениринг, или жди пока все уляжется и подвезут нормальные файнтюны а не слепленные в спешке на коленке.

> В кобальде и мультимодальность можно

Прикрутить проектор ллавы или подобного. В YI оно все еще не работает, что-то полноценное типа кога и близко не может. К лламе 3 также не применимо.

> и генерацию изображений там же

Оно буквально для галочки и убервсрато.

Как, если модель изначально не мультимодальная? Кроме лавы сейчас в опенсорсе то вроде ничего и нет. Разве что только покидывая ей текстовое описание прогоняя картинку через какую-нибудь клип модель, но это такое себе решение

>слепленные в спешке на коленке.

У этих челов датесеты еще с первой ламы лежат. Единственное что смущает - это время тренировки. Но я никогда не фантюнил ллмки, не могу сказать достаточно ли суток для нормального файнтюна 8b модели

Дело не в том сколько их тьюнили, дело в том что эти тьюны никто не проверил еще. Качай, будешь тестером, может там и впрямь алмаз, кто знает?..

> достаточно ли суток для нормального файнтюна 8b модели

Достаточно при условии наличия пачки йоба гпу. Оптимальность параметров для новой модели под вопросом офк.

> датесеты еще с первой ламы лежат

Если они тех времен то ничего хорошего не будет.

>генерацию изображений там же

Кобальт просто сд встроил и картинки он из твоей сд модельки сгенерирует.

>Ллама тоже файнтьюн gpt-j.

Эм, нет.

>я то думал ламу из опта как-то выродили

Сомневаюсь, там разные архитектуры, похожие только издалека.

>потому что шизо-Q5_K_M

Што? Схуяли Q5_K_M шизо?

Все модели одного размера и структуры могут пользоваться одним мультимодальным расширителем

И чё?

>Оно буквально для галочки и убервсрато.

И че?

>Все модели одного размера и структуры могут пользоваться одним мультимодальным расширителем

Не так резко. Только имеющие единого предка. Лламу 3 явно тренировали с нуля, так что вряд ли оно заработает.

Не ну такие странные предъявы, работает? Работает.

>Все модели одного размера и структуры

Для слепых повторил

Так через жопу оно работает, всеравно что предлагать нормису ездить в городе на мертвой классике, или пользоваться печатной машинкой вместо офиса.

Кстати, кто-то покусился на файнтюн грока?

Где его скачать без аккаунта и флажка в анусе?

поиграться хватит, дальше пусть более серьезное щупает

Нет задач

В контексте 3й лламы только разочароваться.

Почему? Можно сделать файнтюн уровня выще гпт-4 и организовать свой бизнес на нем. Не все ж для кумеров локальщиков делать

Топовые файнтюны мистраля не так далеко от лламы3, и они работают с мультимодалкой.

Да средне, но для опознания картинки хватит.

Его отдали потому что он уже бесполезен, а не из благих побуждений. И это сделала компания с кучей железа.

По цене обойдется как несколько лет работы гопоты или aws-клод и устареет раньше чем окупится.

> Топовые файнтюны мистраля

Это все также 7б днище. Лучше ли 8б лламы 3 - хуй знает, нужно больше тестирования. В мультиязычности пока точно лучше, в рп - хуже по длине ответов, но зато не шизит впримерно в направлении, а старается по теме отвечать.

> Да средне, но для опознания картинки хватит.

Особенно файнтюны посредственно работают с штатным проектором. Хочешь мультимодальку - юзаешь ллаву, бакллаву, кога и прочих оригинальных, и довольно урчишь. Через кобольда, лламацпп-сервер, убабугу, трансформерс - без разницы.

> Его отдали потому что он уже бесполезен, а не из благих побуждений. И это сделала компания с кучей железа.

И что? Как отсутствие благих намерений это мешает дофайнюнить его и сделать одной из лучших опенсорс моделей? У опенсорсе просто нет модели большего размера, а с учётом того что могли выжать из ламы 2 опенсорс может сделать годноту на его базе

Как пользоваться этим json?

мимо

Кобальд это минимум затрат и усилий при каком то результате.

Который ты можешь легко запустить и пощупать-посмотреть че это такое и как примерно работает, что бы представлять что делать дальше.

А ты предлагаешь пердолинг с запуском кучи софта и его настройкой. Человеку который только входит в тему.

Кобальд легко запустить? да

Легко настроить? да

Мультимодальность добавляется? да

Генерация картинок? да

Работает как сервер через апи, на любом железе? да

С оговорками, но все это правда.

Че не так?

Ты его на своем компе хочешь файнтюнить? Найдешь 20000 ускорителей h100 тогда поговорим о его файнюне до уровня гпт4

Сохраняй в json, потом в таверне вот сюда тыкай

Немного поиздевался над третьей лламой, очень быстро лосс падает ниже полутора, что лично я считаю тревожным. Плюс модель заметно тупеет от любой "настройки", хотя быстро подхватывает обучение стоптокену. Либо она переобучена, либо на грани.

> По цене обойдется как несколько лет работы гопоты или aws-клод и устареет раньше чем окупится.

Файнтюнов ламы 3 400b можно тогда не ждать? Точнее даже: можно ли дать хотя бы чтоб какой-то один человек с 5 теслами неиронично запустил 400b у себя локально?

400b еще более бесполезна для опенсорс чем грок

Это знаешь на новых ускорителях нвидия беквелл крутить в корпорации какой нибудь. Не для смертных

>>Вот поправленный- https://files.catbox.moe/r8qqp3.json

Сделал бы кто для убы... Уба не человек, а ебаное животное, там надо вручную инстракшн темплейт переписывать под него.

https://3dnews.ru/1101915/nvidia-predstavila-samiy-moshchniy-protsessor-v-mire-blackwell-b200-kotoriy-otkroet-put-k-gigantskim-neyrosetyam

Или сервер из кучи таких, ценой как боинг(или несколько, хз как это будет стоить)

Опенсорс - это не только дефолтные юзеры локальщики. Опенсорс это компании и в том числе. Если кто-то будет юзать ее в своих продуктах - это уже шин. Вопрос только хватит ли большой ламы без файнтюна для всех задач которые преследует эта компания.

>Топовые файнтюны мистраля не так далеко от лламы3

Мистраль инструкт на одном уровне с ламой 3.

>400b еще более бесполезна для диванных кумеров чем грок

Пофиксил.

По ощущениям лама сильно лучше. Может пора менять бенчмарки. Алсо, лама - это в первую очередь базовая модель для файнтюнов и от нее зависит то на сколько хороши будут опенсорс модели в будущем. Я думаю мистраль на базе 3 ламы еще лучше моделей наклепает

Это тесты, а по общению ллама3 на уровне лучших файнтюнов, или даже лучше. Не зря ей за общение накидали оценок на арене

У кобольда есть преимущества простоты и легкости, плюс функционал достаточен. Однако, если больше 8-12 гигов врам и планируешь использовать модели полностью на гпу - он полностью заменяется убой.

> Че не так?

Да ни в чем абсолютно, где ты это увидел? Более чем жизнеспособный лаунчер, просто его мультимодальность здесь не применима а "поддержка сд" - ну совсем костыль хз для кого.

> Файнтюнов ламы 3 400b можно тогда не ждать?

Нуу, тут может единицы будут, и то лорой. Посмотри файнтюны 120б, много их? Именно полноценное обучение а не шизомерджи. Врядли тут будет больше.

> с 5 теслами

с 12 хотябы

> 400b еще более бесполезна для опенсорс чем грок

Битва была равна.

> Сохраняй в json, потом в таверне вот сюда тыкай

Так и делал вроде, но таверне похуй почему-то. Какая версия таверны у тебя?

8-12 гб врам это ниачем, только 7-8b крутить. Ни cd не запустить параллельно, ни модель побольше, ни что то другое.

24-48 врам еще туда сюда, можно крутить умные модели и быстро, параллельно что то еще сунув туда.

Но это уже полноценный сервер нужен, даже если ты будешь считать его обычным компом, по факту это сервер.

16, я еще не обновил на новую, лень было

>по общению ллама3 на уровне лучших файнтюнов

В упор этого не вижу, мы разные модели запускаем?assistant

Так-то дефолтный 0.2 мистраль инструкт очень хорош, он не зря сильно выше в рейтинге 0.1 версии и не инструкта.

Всего есть три варианта поведенческого контроля ЛЛМ:

1. Промптинг.

Тут ясно.

2. Файнтюн.

Тут понятно.

3. Контекст.

Позволяет обучать модель на ходу и по сути делать реалтайм файнтюн за счет вычислительных ресурсов. Так можно научить модель неизвестному ей языку пробросив учебник в контекст, например.

Это точно все или я что-то упускаю?

1. Промптинг.

Тут ясно.

2. Файнтюн.

Тут понятно.

3. Контекст.

Позволяет обучать модель на ходу и по сути делать реалтайм файнтюн за счет вычислительных ресурсов. Так можно научить модель неизвестному ей языку пробросив учебник в контекст, например.

Это точно все или я что-то упускаю?

>16

1.11.6 точнее говоря

У меня кстати ни разу не вылез ассистент, хз. Я качал через день когда все уже немного устаканилось, запустил с последней ллама сервером, с промпт форматом анона. Отвечает как большая модель, по ощущению

>16

Благодарю.

Кто пробовал? https://huggingface.co/DevsDoCode/LLama-3-8b-Uncensored

>Это точно все или я что-то упускаю?

контрольные векторы, очень интересная штука

https://github.com/vgel/repeng/tree/main

https://vgel.me/posts/representation-engineering/

Можешь объяснить подробно как этим пользоваться? Как запускать этот код и так далее?

Рейтинг фантьюнов и мержей ламы. Вперед вырвался

https://huggingface.co/vicgalle/Configurable-Llama-3-8B-v0.2

https://huggingface.co/vicgalle/Configurable-Llama-3-8B-v0.2

Почитай там написано, у самого еще руки не дошли делать илипробовать, только прочитал да модель скачал полноразмерную потыкать когда нибудь

Так там речь о больше, с 16 уже можно полноценно крутить 20б, и что поменьше в 8б, а то и в 16, здесь уже полномочия кобольда заканчиваются. Офк если тесла то он остается актуален, но они пошли явно не по тому пути, сделав бесполезные фичи вместо полноценного набора семплеров и cfg.

> Но это уже полноценный сервер нужен

Вут? Ну все, теперь можно хвастаться что у меня дома сервер, мы все тут администраторы, ага.

> Позволяет обучать модель на ходу и по сути делать реалтайм файнтюн за счет вычислительных ресурсов.

Нет. Можно задать настроение, сместить поведение в пределах имеющихся знаний (не только промтом но и внешним источником активаций, например векторы что недавно продемонстрировали) или добавить ограниченное количество новых.

> можно научить модель неизвестному ей языку пробросив учебник в контекст

Если только оно очень простое. С уникальным даже лучшие модели не справятся.

Она умеет только в какие-то общие вещи вроде контроля настроения или в серьезное изменение поведения? Можно ли таким образом сделать чтоб модель выдавала свой ответ в виде JSON типа

{

"answer": "Привет!",

"mood": "happy"

}

?

Понятно что это и промптингом можно, просто интересно на что оно способно.

Я пробовал. Мне выдало ошибку keyword 'mistral'.

>Вут? Ну все, теперь можно хвастаться что у меня дома сервер

Ты в курсе что обычному среднему геймеру больше 16 гб рам все еще не нужно? Как и врам больше 8

Скажи ты нормису параметры своего компа для локалок он охуеет, как и от размеров моделей, лол

Это у нас за год глаза замылились, хех

Там в статье есть примеры, посмотри - они очень показательны, о том что делают векторы

> Можно задать настроение, сместить поведение в пределах имеющихся знаний (не только промтом но и внешним источником активаций, например векторы что недавно продемонстрировали) или добавить ограниченное количество новых.

То о чем ты говоришь и есть по факту простойфайнтюн, так или иначе это меняет поведение

> Если только оно очень простое. С уникальным даже лучшие модели не справятся.

Опять же то что она делает это плозо не значет что этот метод не работает. Это один из методов контроля поведения, хоть и не самый эффективный.

Все что в статье лишь меняет стиль речи. Это прикольно, но этого можно добиться и промптингом. Разве что в таком случае оно не будет забывать о выбранном стиле речи спустя время и будет придерживаться его всегда. Хм, на самом деле может быть даже полезно. Например тот же ролеплей можно запилить на уровне контрольных векторов, задав характер персонажа через них

Там меняется само отношение модели к чему то, задается вектор ее отношения к какой то вещи.

Управление мотивацией-характером модели, что то такое. Это более глубокое изменение чем просто промпт

> обычному среднему геймеру больше 16 гб рам все еще не нужно?

Даже самые упертые уже соглашаются что 32 - минимум для комфорта. Браузер открыл, поскроллил, доскорд, хуерд и прочее - уже 5-8 гигов скушало, плюс система - игорь уже не влезает.

> Как и врам больше 8

Было в 2017м, еще скажи что фуллхд - топовое разрешение.

> Это у нас за год глаза замылились

Есть такое. 24-48 это оверкилл для нормиса-геймера, но 16 уже вполне современность. Все зависит от того как к этому относиться, есть мнения что 1060/580 до сих пор самые популярные карточки и ориентироваться нужно на них, но ии изначально задает высокую планку, и потому 24 здесь вообще никого не удивишь, даже 36-48 стало сорт оф норма.

> и есть по факту простойфайнтюн

Нет. Да, это можно сделать файнтюном, но буквально из пушки по воробьям с кучей побочек.

> Опять же то что она делает это плозо не значет что этот метод не работает.

То что ты описал - не работает. Простейшие вариации - будут работать, но ровно до тех пор пока у модели хватает внимания, а оно крайне ограниченно.

> даже 36-48 стало сорт оф норма

А может и нет.

70б новую в итоге в рп/ерп тестил кто?

Удали разделитель и начало чата, может что то изменится

Вот эту хуйню, но знаешь у меня тоже вылезают повторы иногда или абракадабра, удаляю да продолжаю чат и все

Ну это на 8b, хотя 2 эти хуйни из одного теста

В голосину.

Ну не, 8б лучше перформит же.

>Удали разделитель

Что это? И как это сделать в убе? Я только как раз с трудом разобрался как убрать assistant.

> начало чата

Командиру оно не мешает. Пикрелейтед.

Краткий вывод о новой лламе - эта штука пугающе хороша во внутреннем диалоге, очень естественно им пользуется. Будто ее учили подобному, все эти методы сот и другие цепочки мыслей были в датасете еще эффективней упакованы

разделитель и начало чата это на

пикче 2 пустых места

Пример разделителя и начало чата

Хз где это в уге

разделитель и начало чата это на

пикче 2 пустых места

Пример разделителя и начало чата

Хз где это в уге

Вот 8В. Чутка получше, но внезапно сошла с ума во второй реплике и начала код писать. Аж флешбеки на первую ламу пошли, лол.

Так что я хуй знает что вы нашли в этой модели, сломанное говно.

>Будто ее учили подобному

Внезапно, да? Может потому что реально учили?

Если заставить ее решить любой математически пример ты увидишь всегда один и тот же текст про то что надо юзать пемдас и один и тот же формат вывода. Решает примеры охуенно кста. Базовая математика на уровне, правда зачем когда есть калькулятор непонятно

Пипецки складно стелет, ни одна 7b так не могла, это что то новенькое

В конце видна абракадабра которую я иногда подчищаю, хз почему она вылазит

В конце видна абракадабра которую я иногда подчищаю, хз почему она вылазит

Ты как-то неверно ее юзаешь. Ну рили, оно может описать ту же предлюдию, еблю и т.д., напомнив в конце, что неплохо бы закончить настоящий кремпай в процессе изготовления которого прервались на увлекательные занятия, а после уже продолжить в спальне.

Можно как-то модель скачанную оламой юзать в таверне? Не хочу качать снова ряя

Таверна не может сама запускать модели, это фронтэнд.

А с чем она работает? С олламой не работает да?

чел намутил шайтан машину с ЛЛМкой на борту

https://twitter.com/prince_of_fakes/status/1777422801106014480

и в реплаях селёдок корёжит, что тоже забавно

https://twitter.com/prince_of_fakes/status/1777422801106014480

и в реплаях селёдок корёжит, что тоже забавно

Ну скажи в чем я неправ. Запустил сейчас 70В в чат-инструкт режиме вместо чата. Ну капельку получше стало, но все равно оно сломано.

Не знаю, посмотри, есть там api, если есть - то скорее всего работает.

>Будто ее учили подобному

Больше всего кажется, что её такому учили, когда вся эта хуйня вываливается в оутпут и модель рассуждает о хуйне, о малафье, пиздец в общем.

Лолшто, может ты какой битый ггуф скачал, такого даже близко нет у меня

Запускаешь олламу, выбираешь бэкэнд "оллама" в таверне.

Хай тек, лоу лайф. Теперь осталось приделать к роботу.

Это не гуф, это оригинальная модель на 8 битах в трансформерах.

Я что-то делаю не так может, но у меня нет в списке оламы

>Noromaid-20B-v0.1.1

Кал и пишет коротко. Псимед уже сильно разъебал её.

Он в группе Text Completion, как и кобольд.

как вам модель Maiden-Unquirked ? я прям мощно кайфанул от нее

https://huggingface.co/sergkisel3v/LLama3-8b-Instruct-GGUF-fp16

> Full precision GGUF of Instruct LLama 3 8b model for Tesla P40 enjoyers or those who want to run unquantized llama.cpp instead of Transformers.

> Full precision GGUF of Instruct LLama 3 8b model for Tesla P40 enjoyers or those who want to run unquantized llama.cpp instead of Transformers.

Карпати пишет про ЛЛаму

Что лучше, лама-8б или супер низкий квант 70-ки?

Есть инфа о расцензурах ламмы3 или там соя витамины в подкорку?

Зачем тебе именно 3? Просто накати файнтюны мистраля или 2-70b, получишь примерно то же самое. Если из 3 и вылепят что-то получше, то в любом случае придётся подождать.

>The Biden Executive Order had the reporting requirement set at 1e26, so this could be ~2X below that.

Ах точно, там же лимит прописан теперь. Как же я люблю попытки регулировать хуйпойми что задолго до того как даже поймут границы и свойства этого хуйпойми чего и для чего это можно применять. Тупорылая идея с заведомо ложными предпосылками, которую всё равно перепишут потом.

Как вам по ощущениям эта 8б модель? Соя пищит что это чуть ли не 70б ллама2 по уровню, но на деле когда я скормил ей саммари, то она высрала какой-то скудно-бедный ответ на уровне обычного 7б говна. При этом даже 70б проебывает CR+.

Текст правда был на русском, может быть это из-за этого? Если говорят что у command-r целых 15% русских токенов в обучающем датасете, то наверное это все же больше чем у ламы.

Текст правда был на русском, может быть это из-за этого? Если говорят что у command-r целых 15% русских токенов в обучающем датасете, то наверное это все же больше чем у ламы.

У лламы3 всего лишь 5% датасета было не англоязычное. И тем менее, контекстно справляется, пусть и не так красноречиво

>Как вам по ощущениям эта 8б модель? Соя пищит что это чуть ли не 70б ллама2 по уровню

По ощущениям хуже мистраля 7В. Мистраль конечно не может в русский, но зато не шизит и контекст понимает. Новая ллама мне больше Пигмалион 6В напомнила по выдаче, в упор не вижу в ней никакого прогресса.

>Как вам по ощущениям эта 8б модель?

Как не 8B модель, может и не 13B. Сложно говорить, потому что я уж и забыл базовые модели как выглядят. Эта штука явно не затюнена под РП, хотя что-то сходу понимает, этого точно раньше не было в таких игрушечных размерах.

Абсолютно не может в культурные референсы, вот это выдаёт мелкую модель (или датасет, хуй знает).

>Текст правда был на русском, может быть это из-за этого?

На модели такого размера - может, удивительно что она вообще что-то кроме бессмыслицы может выдать на не-английском

У меня 70B в q1 поместилась, максимум с небольшим контекстом могу q2 запустить. Но стоит ли оно того? Насколько сильно квантизация херит ответы? Не будет ли полноценный 7B лучше в хлам ужатого 70В?

Если у тебя 70b не запускается с 4 квантом то не мучай себя и катай что то поменьпше

Опа, кобальд обновился, збс

третья ллама кажется поломаной, тестировал 70b q4_m, стелит логично, но время от времени сильно циклится, с любыми настройками, может ггуф кривой, ломает её, надо оригинальные веса запустить в 4 бита, но как же лениво ебаться.

Юзал онлайн версию, хз, по ощущениям лучше микстраля, в кодинге уж точно.

В пизду.

Еду завтра покупать 3090.

80к всего.

Сука, как заебали ваши видеокарты.

Можно как-то вкорячить 3080т+4070т суп+ 3090?

Рейзеры все дела.

Еду завтра покупать 3090.

80к всего.

Сука, как заебали ваши видеокарты.

Можно как-то вкорячить 3080т+4070т суп+ 3090?

Рейзеры все дела.

Что по питанию то?

Так понравились большие сетки и нейросети вобще?

Я не он, но эти ваши нейросети это наркота ебаная. Уже второй год слезть не могу. Купил даже 4090 под это дело, полёт нормальный.

850 платина пердит.

Да, большие норм тема.

Или подать за 50к 3080ти и тупо вкорячить 3090?

40 гб хватит на всё же, без ебатории с рейзерами и замены БП?

>40 гб

не хватит, чтобы 70ку на 4 кванта запустить нужно 48.

>850 платина пердит.

на три видяхи то? ну, удачи.

Че это за цифры?

>на три видяхи то? ну, удачи.

Можно ведь придушить потребление, как р40 душат в 2 раза без серьезного падения скорости

Это ж не игры, в итоге можно до 400 ватт ужать все 3 карточки, я думаю. Хотя хз

Да кто его знает, причин может быть множество. Наиболее вероятен кривой формат.

Неплохая вроде, пока самое интересное что она не кажется мелкой. Хорошо принимает условия и следует им, но без одержимости, которая была в прошлых моделях, плюс высокая вариативность ответов. По обработке большого нужно тестить, может и соснет.

Надо было сразу, лол. Офк можно если в матплате хватит слотов, но с питальником будет тяжело. Ищи от 1.2квт с достаточным количеством разъемов. Если будет 12+4 пиновый то он полностью уходит на 4070, а на пару остальных уже 8пиновые считай.

> 40 гб хватит на всё же, без ебатории с рейзерами и замены БП?

Ты сначала на трех поперди, а потом уже будешь думать.

Хотят ввести запрет на тренировку одной нейросети выше определенного предела вычислений

Или уже ввели, хз

В штатах, в европе тоже готовят какие то законы и ограничения для того что бы душить ии

70ки на 4 квантах сильно лучше чем на 2,6кв?

Ну и насосутся, потому что Китай и Россия на эти влажные пуки внимания не обратят

Какой формат промпта нужен ламе 70В? Циклится с ходу в таверне, кучу разных перепробовал, в том числе и правильный от лламы 3. Либо Жора опять говна навалил.

>Россия

не смеши, китай да

У тебя инструкт?

Самые упертые говорят, что выше 16 не надо. =')

Но вообще базу навалил.

> Мистраль конечно не может в русский

Ору. =D

Может, скилл ишью, чел. =)

А CodeQwen-то пробовал?

Мы вчера покатали, ниче так, интересные идеи выдает задешево.

Я бы на топовый райзер вешал 4070т суп как самую мало жрущую.

Но вообще, идея так себе.

Нуээээ, я бы брал 1000-1200+, если честно.

200+300+350 уже не впритык, а в перебор, ИМХО.

Ну и лучше две, но большие, но вряд ли 40 гигов хватит.

Щас бы 900 ватт в 400 удушать, ага. =)

Не настолько, ну до 650 опустишь, все равно пиздец впритык, конечно. Я бы БП сменил.

Да. Пробовал IQ и обычный q4. Всё хуйня.

У меня инструкт не циклится, претрейн - да.

4.5+ бита - вполне полноценная модель, отличия которой от полных весов нужно будет поискать.

2.6 бит - лоботомит с деменцией и шизой.

Офк это все для правильно выполненных квантов в текущем положении дел с ними, косячные хоть 6 бит будут парашей, а какие-то перспективные методы кванта могут и в 2.5бит добавить жизни.

>и Россия

Расскажешь своим внукам эту шутку.

То есть все таки не продвать 3080ти и заморочиться с рейзерами?

40 гб не хватит всем значит.

>40 гб не хватит всем значит.

Смотря какие модели ты хочешь запускать. Чтобы адекватно гонять 70 или командера нужно 48. Тут лучшим вариантом было бы взять P40 к 3090 или 4090...

Ну чо, го тестить эту вашу лламу3 70б на двух теслах.

Качну q3 c матрицей, q4_0, q4_K_M.

Интересно, что там по скоростям.

Если есть предложения — накидывайте.

Качну q3 c матрицей, q4_0, q4_K_M.

Интересно, что там по скоростям.

Если есть предложения — накидывайте.

> 40 гб не хватит всем значит.

Нытье с командером недавно тебя не убедило? в идеале вообще продать 3080ти, купить еще одну 3090 и иметь ии фермочку, которую не нужно прерывать для того чтобы поиграть на 4070ти, сможешь в вр с вайфу чатиться

На мой вкус — целиком менять.

3090+3090 — это пушка.

3080+4070+3090 — уберсомнительно.

3090+одна из них — точно нет.

Ну… Дело твое, конечно

У меня валяется Р100.

КУДА победила меня раньше чем я смог заставить её работать на постоянке.

Я не знаю какие у тебя там траблы с P100, у меня P40 в пекарне, с еще одной карточкой, гоняю кобольд, КУДА жив.

Кстати.

Как обладатель трех компов могу предложить следующий вариант:

Собрать один комп с 3090+3090, второй чисто с 3080ти, и третий игровой.

Будет один под ллм, один под распознавание и генерацию речи, и третий игровой. =D

Это как у меня, только каждый пизже.

Ну или просто 3090 вынести в отдельный комп, играть на 4070 ти супер, а 3080ти оставить под вот это вот все.

Ну это просто мысли вслух, канеш.

AV1 ахуеная штука. Тестанул на ВАМ.

Жаль что в рашке 6Е вайфай аннулирован за неуплату фсб.

Хочется меньшей кровью.

Я вообще не платировал в этом году карту менять ибо 2 года назад уже отда 150к за 3080т. Но тут такое дело.

Ну значит придется брать БП и рейзеры, ох боги.

Я живу в бытовке, и тут не так много места что бы еще один гроб в виде системника ставить.

Хочется в один запихнуть.

> Как обладатель трех компов

Нахер они тебе?

С одной стороны выделить гпу в отдельную машину - идея здравая, но тогда сразу теряешь возможности нормального объединения их с твоей основной.

> AV1

> Тестанул на ВАМ.

можно перевод?

Кодек видео который может кодировать на 40 серии.

Он для Виртуал Десктопна доступен.

VAM- virt-a-mate. Ну лучше погугли.

https://www.youtube.com/watch?v=FjgFcw1NeV8&t=3s

У меня роутер со вчера стоит на ноуте, мне лень менять его.

Но к вечеру поменяю и затестирую, чо там на максималках будет.

Хотя меня и так устраивает. Хуяришь фильтр с шумом на няшку + pass-through в квесте 3 не огнище, сам понимаешь. И получается натуральненько.

Ну… Успехов тебе!

Райзер-то возьми товстенький, полноценный.

Quest 3 + RTX 40хх поддерживают кодек AV1, дающий лучшее качество и минимальный задержки.

ВАМ — Virt-a-Mate — виар-порно-игра.

А три компа потому что я ебал райзеры, корпус и две теслы пихать к 4070тишке.

А так, я могу отдельно юзать ллм, отдельно играть, не пересекаясь. И исключены проблемы по питанию (на теслах 850 голд, на компе 1000 голд), проблемы по охладу, ваще все океюшки.

Бля, ахуеть, голову поломал при чем тут видеокодек.

> VAM

Латинницей бы сразу писал

конечно за выпуск лламы поддержать экстремистскую корпорацию было бы неплохо, но pico 4 хватит всем.

> А три компа потому что я ебал райзеры, корпус и две теслы пихать к 4070тишке.

Один гей_мерский допустим, второй с парой тесл - ну условно достаточно и их охлада ставит трудности, а третий куда?

> А так, я могу отдельно юзать ллм, отдельно играть, не пересекаясь.

Это все можно делать на одном компе

Я в прошлом треде задавал вопрос про 4гб врам и 32гб рам. Вот, в общем, спеки мои. Я так понимаю, на этом достаточно легко будет запустить 7б модели? Посоветуйте 7б модель чтобы пощупать эти ваши LLM. Раньше сам ничего не запускал.

>чтоб модель выдавала свой ответ в виде JSON типа

За этим уже к GBNF Grammar.

>Как и врам больше 8

4к гейминг передаёт привет, меньше 12 вообще не катируется.

Можешь просто по инструкции из шапки делать, начини с кобальда и скачай модель которая в инструкции там

У тебя отличная скорость и быстрый процессор, научись запускать и настраивать на простом бекенде по типу кобальда, потом если зайдет что то поменяешь

Новую ллама3 8b не рекомендую новичку, она еще нормально не запускается

>Посоветуйте 7б модель чтобы пощупать эти ваши LLM

https://huggingface.co/TheBloke/OpenHermes-2.5-Mistral-7B-16k-GGUF

https://huggingface.co/TheBloke/openchat-3.5-0106-GGUF

https://huggingface.co/bartowski/dolphin-2.8-mistral-7b-v02-GGUF

https://huggingface.co/TheBloke/Nous-Hermes-2-SOLAR-10.7B-GGUF

https://huggingface.co/froggeric/WestLake-10.7B-v2-GGUF

В третьем у меня торчит мелкая видяха для обработки звука + он используется как бастион на входе с роутера в локальную сеть.

> Это все можно делать на одном компе

Выключив его, не занимая проц, не занимая озу? :) Капельку сомневаюсь.

С твоей частотой видяха не так важна, так что просто бери любую модель уровня до 35B, контекст кидай на видяху, все слои на оперативу и вперед.

В шапке предложены варианты, выбирай.

Нет! Она навсегда будет жить в наших сердцах! Заткнись!

Скачал лаву. Поставил в кобольде модель и mmproj файлы. Кидаю ей картинку, а она галюцинирует, пишет что я скинул скриншот мобильного телефона, очевидно не видит картинку нихуя. В чем может быть проблема?

Покатай новую лламу о 8б, она хорошая. Или подожди пока заделают нормальные файнтюны, будет летать быстро и при этом прилично отвечать.

Больной ублюдок

> Выключив его, не занимая проц, не занимая озу? :)

Зачем его выключать? Если мало озу - просто купи больше, ее и проц ллм, сетки, обучение почти не кушают чтобы игорю вдруг не хватило. Абсурдные вещи втираешь, аргументом тут может служить шумность охлаждения и желание вынести их, особенно если спишь в той же комнате и пускаешь очень долгие задачи.

> С твоей частотой видяха не так важна

Решил над ним поиздеваться?

Ламу3 тренировали на 15 триллионах токенов, Ламу2 на 2 триллионах. Это в 75 раз больше теоретического оптимального количества. И Мета сказала, что даже при таком количестве модель не показывала признаков конвергенции, т. е. продолжала улучшаться.

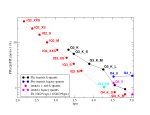

На втором пике он расчитывает "мощность" моделей, т. е. количество флопсов, потраченных на тренировку. Она грубо оценивается как количество параметров, умноженное на количество токенов, умноженное на 6. У Ламы 70 это примерно 9 на 10 в 24 степени флопсов, у Ламы 400 будет 4 на 10 в 25 степени. И это всего в 2 раза меньше предела 10 в 26 флопсов, установленного исполнительным приказом Байдена, для которого нужно будет согласовывать тренировку моделей с какими-то там инстанциями.

>Решил над ним поиздеваться?

Думаю у него даже 30-35b пойдет около 4 токенов в секунду, большо просто оперативки не хватит запускать. 4 т/с это нормальная скорость для большой модели, минимально комфортная для чтения. Все что меньше будет конечно еще быстрее летать.

А какая связь?

Ну типа теперь не надо покупать кучу дорогих видеокарт, чтобы тренировать свои модели, если есть открытая Ллама 3

> Думаю у него даже 30-35b пойдет около 4 токенов в секунду

Едва ли поднимется выше трех с такой-то видюхой, и то после очень долгой обработки контекста, ждать минуту первых токенов - неприятно.

Теперь нужно покупать кучу дорогих видеокарт чтобы ее пускать у себя, лол.

Остановился на следующем списке:

Llama-3-70B-Instruct.IQ4_XS.gguf

Llama-3-70B-Instruct.Q4_0.gguf

Llama-3-70B-Instruct.Q4_1.gguf

Llama-3-70B-Instruct-IQ4_NL.gguf

Llama-3-70B-Instruct.Q4_K_M.gguf

Llama-3-70B-Instruct.i1-Q4_K_M.gguf

Два IQ, один из них NL (че за хуйня?), один iMatrix, два базовых, один классический.

Хочу понять, какая разница в перформансе между ними на теслах, есть ли выигрыш от размера в скорости, и чувствуется ли разница в качестве.

В теории, q4_0 будет самой быстрой, но самой тупой, однако занимать много места.

i1_Q4_K_M лучшего качества, но, возможно, самой медленной.

IQ4_NL неебу шо это за версия.

Предлагайте ваши варианты, мнения, пояснения.

Я не очень следил за вариантами квантов, не шарю.

Llama-3-70B-Instruct.IQ4_XS.gguf

Llama-3-70B-Instruct.Q4_0.gguf

Llama-3-70B-Instruct.Q4_1.gguf

Llama-3-70B-Instruct-IQ4_NL.gguf

Llama-3-70B-Instruct.Q4_K_M.gguf

Llama-3-70B-Instruct.i1-Q4_K_M.gguf

Два IQ, один из них NL (че за хуйня?), один iMatrix, два базовых, один классический.

Хочу понять, какая разница в перформансе между ними на теслах, есть ли выигрыш от размера в скорости, и чувствуется ли разница в качестве.

В теории, q4_0 будет самой быстрой, но самой тупой, однако занимать много места.

i1_Q4_K_M лучшего качества, но, возможно, самой медленной.

IQ4_NL неебу шо это за версия.

Предлагайте ваши варианты, мнения, пояснения.

Я не очень следил за вариантами квантов, не шарю.

Нвидия просто перекачана инвестициями чел. Ща все компании очевидно начали свои чипы выпускать и нвидия уже не кажется настолько однозначным монополистом который будет всю ии индустрию вести. Если бы я вкладывался в чьи-то акции то я бы вкладывался в мелкомягких. Во всякие клосед аи к сожалению напрямую вкладываться нельзя, а они самые большие инвесторы в них и в клод

> Предлагайте ваши варианты

exl2 4.65 от лонстрайкера

Наоборот, теперь нужно еще больше железа ведь тренировка до 15т токенов дает лучший результат даже для мелкой модели.

+ вышла куча больших моделей для инференса которых тоже нужны дорогие ускорители

> 128

> 95%

=) Попозже будет DDR5, будет 256.

Иногда запускаешь крупные для тестов, а пока она там жуется — хочется поиграть, например.

Поверь, когда у тебя куча мелких и крупных задач параллельно — один комп начинается подтормаживать, выбрасывать фризы в игре, это неприятно.

Можно, но зачем, если можно разделить на несколько и не иметь проблем?

> Решил над ним поиздеваться?

Ну, видяха с 4 гигами вряд ли там потащит что-то куда-то.

Tesla P40.

Нет смысла, к сожалению.

Q4_1 нет разницы с Q4_0, я бы убрал из списка

I3km лучше качни и обычную 3км

П4 все таки стоит поменять на К3 если бабки есть. Качество картинки на голову выше.

>ибо 2 года назад уже отда 150к за 3080т

Обнимемся, брат.

👌

Но я 4_1 тоже попробую, уж очень интересно чисто для себя разобраться.

Пику не юзал, но стерео-цветная картинка лучше моно-цветной стопроц.

Если есть деньги — то стоит, соглашусь.

>У меня валяется Р100.

Вот это попробуй:

https://github.com/AUTOMATIC1111/stable-diffusion-webui/issues/2449

Только перед компиляцией xformers задай вот эту переменную окружения для твоей архитектуры, прямо в окне venv:

set TORCH_CUDA_ARCH_LIST = "6.0;6.1;6.2;7.0;7.2;7.5;8.0;8.6"

Пишут, что ускоряет и P100 и даже P40, если Убабугу с ключом --xformers запускать. Ну и с совместимостью тогда проблем нет, но только там.

Warning: LLAVA Image excluded - Context size too low or not enough clip tokens!

Да ты пизданулась там чтоле. Изображение 115кб

Да ты пизданулась там чтоле. Изображение 115кб

> > 128

> > 95%

Чем и зачем? Вот запущено всякого разного ии и не-ии релейтед, еще вагон свободен и немалая часть из этого может быть выгружена без импакта, ибо пустое выделение без обращений.

> Иногда запускаешь крупные для тестов

Пускаешь сетку на процессоре и хочешь играть? Земля пухом.

Ну хуй знает, это нужно для начала у кого-то стрельнуть попробовать, и вообще использовать чаще чем раз в пару недель для подпивасных рофлов.

Погугли настройку памяти на своём конфиге, у тебя какой-то проёб. У меня на амудях меньше 60-ти.

>бастион

Ух бля. А нахуя?

Читай логи, может там чего написано.

>Ща все компании очевидно начали свои чипы выпускать

Посмотрим на их обсёры.

>Изображение 115кб

От разрешения смотри.

>От разрешения смотри.

Специально запилил 102х57 изображение, все равно это же выдает

Контекст на эмбединги нужен не менее 2к емнип

> Ща все компании очевидно начали свои чипы выпускать и нвидия уже не кажется настолько однозначным монополистом который будет всю ии индустрию вести.

Выпускают-то они их все на той же TSMC, а она не резиновая и все там расписано на месяцы и даже годы вперед, много они произвести не смогут. А ускорителей надо как раз дохуя. Так что пока Нвидиа почти единственный вариант для самых больших покупателей. Даже АМД от низ раз в 10 отстают по объемам.

> Пускаешь сетку на процессоре и хочешь играть? Земля пухом.

Ну, так одно с другим не связано.

Ну и… как бы все получается, ведь два компа = два проца, внезапно, да? )

Вишь, получается, ты приходишь к тому же.

У меня нет проблем, потому что все разнесено по разному железу и не пересекается в работе. Изи.

> А нахуя?

Я на работу хожу в офис, не то чтобы там активно работаю, ну и вот. =)

Понятно что нвидия не умрет нихуя и ее не задавят. Просто это очевидно не монополист

Ебанутся долго конечно на кобальде генерить картинки, врам не хватает походу, но там есть вот такая прикольная фигня.

Тоесть я так понял что можно через мультимодальный адаптер дать модели обратную связь на ту картинку которую она сгенерила. В итоге она может пробовать снова и снова если дать ей задание сделать картинку соответствующую запросу. Это забавно.

Тоесть я так понял что можно через мультимодальный адаптер дать модели обратную связь на ту картинку которую она сгенерила. В итоге она может пробовать снова и снова если дать ей задание сделать картинку соответствующую запросу. Это забавно.

Чел, визуальная часть выдаёт фиксированное количество токенов всегда. Это обычно 1200-1600 токенов на пикчу.

Потерял нить и перевел куда-то а вот смотрите у меня к своему кейсу, а изначально обсуждалось размещение пачки гпу в одной пеке. Из плюсов их выноса только шум/тепло, пересечение с остальными задачами перенебрежимо ибо все крутится на гпу с минимальным привлечением профессора. Минусов же хватает, они в изолированной системе и значит нормально не объединить с основной, требуется отдельный гробик, тратить немалую сумму на отдельную систему и так далее.

Вот и все сводится к возможности/удобству их совместного размещения, а не к придумыванию

> а ты вот запусти нейронку на профессоре имея 48+гб врам чтобы было честно!

>Только перед компиляцией xformers задай вот эту переменную окружения для твоей архитектуры, прямо в окне venv:

>set TORCH_CUDA_ARCH_LIST = "6.0;6.1;6.2;7.0;7.2;7.5;8.0;8.6"

Я просто хотел поиграть с Моделькой, а не компилировать куда файлы для таверны.

Выше писали что людям с двузначныйаку не стоит туда соваться.Я в целом и не против.

Если это действительно так то это хуета. Понятно чо вижн модели такие хуевые если у них и в 256х256 и в 4к излбражении одинаковое количество информации

>Из плюсов их выноса только шум/тепло

Две теслы - 500 ватт шум/тепло, 3 - 750. Плюс от трёх уже есть вопросы ко всей системе, начиная от мат.платы и далее к БП, корпусу и т.д. Фактически максимум потребительского ПК - плюс одна тесла к основной видеокарте и всё. Это неплохой буст, но всё, что выше уже требует отдельного сервера.

Миллионы лет люди трахали реальных девушек, а теперь, спустя годы развития общества и технологий, люди вынуждены общаться с кривыми чатботами и дрочить на это. "Развитие", лол.

>люди вынуждены общаться с кривыми чатботами

vs

>люди вынуждены общаться с кривыми тян

Как говорится, людям нравятся монстро девушки, потому что они монстры снаружи, а не внутри

Современный тян измельчал, доверия любой - ровно ноль.

Кому то повезет найти нормальную, кому то нет

Тем более в нашей стране, что бы планировать какую то семью нужно быть идиотом

Поэтому тяга к такому эскейпизму и суррагату мне вполне понятна

>люди вынуждены общаться с кривыми чатботами и дрочить на это.

Прогресс ИИ идёт полным ходом, а вот с людьми всё уже понятно. Другой вопрос, что без киборгизации подлинного слияния с Машиной не достичь. Но всё ещё будет :)

Llava 1.6 может выполнять все тоже что показали у грок 1.5 вижн. Я недооценивал опенсорс в плане мультимодальности

5 лет назад было тоже самое, только чатботы были уровня Порфирьевича. Так что благодари бога что прогресс нам помогает.

Есть еще круче, cogvm или чет такое

>У меня 70B в q1 поместилась

>максимум с небольшим контекстом могу q2 запустить

Уже третий квант находится на уровне 7В, второй - это неюзабельный лоботомит, а 1 бит - честно я еще не видел идиотов которые бы это запускали, ты первый.

> не смеши, китай да

> Расскажешь своим внукам эту шутку.

А че такого? У нас как раз дохуя датасетов уникальных, все таки СНГ сегмент интернета второй по величине и кол-ву контента. Так что вы зря смеетесь. Китайцы подгонят мощностей для тренировки, Яндекс допилит и выйдет очень даже ничего.

Прифигачил к не мультимодальной модели mmproj от ллавы. Модель понимает изображение в общих чертах понимает цвет, что это примерно что-то маленькое у него есть глаза, но в общем путается в ответах что это. Это нормальное поведение? Я думал что так любой фантюн смогу мультимодальным сделать, но походу придется самому ллаву файнтюнить...

Кокда ddr6?

Самое то, чтобы запускать 400b.

Самое то, чтобы запускать 400b.

У третьей ламы нет задач, кроме как базы для файнтьюнов.

Русский язык она понимает плохо, тут командир вне конкуренции. В ролеплее модель уступает файнтьюнам мистраля и 20B франкенштейнам второй ламы.

Так что не понимаю всеобщего эксайтмента.

Русский язык она понимает плохо, тут командир вне конкуренции. В ролеплее модель уступает файнтьюнам мистраля и 20B франкенштейнам второй ламы.

Так что не понимаю всеобщего эксайтмента.

> Так что не понимаю всеобщего эксайтмента.

> Сам упомянул что это новая охуенная база для файнтюнов

>400b

В q8 это ~200гб. Сейчас в десктопах можно набрать 192, но когда выйдут 64гб, можно будет и 256. А пока можно довольствоваться чуть более мелкими квантами, всё равно в таких больших моделях от квантования мозги не особо проёбываются.

Так тут один анон писал, что только 70b ллама 3 база для рп. И то только после десоефикации.

>Прифигачил к не мультимодальной модели mmproj от ллавы.

Там надо правильный выбрать, если у тебя файнтюн мистраля то и mmproj нужен от мультимодального мистраля, если там ллама - то от лламы.

Ну и да, чем больше файнтюн отличается от мультимодальной модели тем хуже будет работать даже совместимый адаптер.

Для теста использую llava 1.5 13b Q5 mmproj и llama 2 chat 13b Q. По идее максимально близкое выбрал. Не, оно вроде работает, просто не близко к тому как работает лава сама по себе

https://huggingface.co/mradermacher/llava-v1.6-mistral-7b-GGUF

https://huggingface.co/ShadowBeast/llava-v1.6-mistral-7b-Q5_K_S-GGUF/tree/main

Вот это попробуй, должно быть лучше

Стыкуется к файнтюнам мистраля 7b или работает само по себе

Надо тоже скачать пощупать, давно мультимодалки не проверял

Адаптер mmproj хотя бы спиздить на будущее, лол

1.6 не запускается, из-за длины контекста. Я писал выше что у меня проблемы были что изгбражение в кобольде открепляется. Они там архитектурно пиздец натворили короче

Скачаю чекну, может запустится. Ну нет так у меня ллама.спп скачена, кое как заведу с командной строки может там сработает

>Китайцы подгонят мощностей для тренировки

НЕТ.

>Яндекс допилит

У него хуйня выходит, после последней смены руководства, угадай почему.

>Самое то, чтобы запускать 400b.

Не, там скорость максимум удвоят. а это около 160ГБ/с. А этого мало.

Я про то что у меня не запускается. У тебя может запустится. Я на макбуке запускаю вообще без ГПУ

Ты вполне сможешь запустить 13B на паре токенов/сек

>У нас как раз дохуя датасетов уникальных