Я тебе напиздел. Раз у тебя не нвидима тебе только опенкл остается, а это будет вот тут например llama-b1380-bin-win-clblast-x64.zip

Хотя честно сказать не ебу как там щас все сделано, может быть любой вариант релиза подойдет для того что бы оффлоадить на видимокарту. Скачай разные версии и потыкай.

Это например llama-b1380-bin-win-avx2-x64.zip

Но там наверное только на процессоре.

https://github.com/ggerganov/llama.cpp/releases/tag/b1380

Или сам собери под свою систему из исходников, там есть гайд.

А пруфики будут? У меня и Q3 неплохо шпарит. Вообще где статистика и показана разница в этой статистике. У меня 20b тянет на 3060, А генерация вместо 200 сек занимает около 50 в среднем(3060 че поделать, но тут уже роляет скорость). Суть то непонятна в чем будут различия ответов. Как мне лично еще непонятно, если я например выгружаю 55 слоев из 65 это значит 10 слоев это часть потерянного чего, датасета?

>10 слоев это часть потерянного чего, датасета?

10 слоев нейросети остаются на кручение процессору в оперативке

А что случается в таком случае если я выгружаю больше слоев чем надо в видеокарту? Я думал только тогда выгружаться начинает в оперативку.

Видеокарта не может работать с оперативкой напрямую. С оставшимеся слоями работает процессор

Если слоев болье чем влезает в видеопамять- видеокарта будет резервировать часть оперативки и постоянно подгружать выгружать из себя невлезающие слои каждый цикл генерации. Это сильно замедлит генерацию

Тут хз о какой проге он спрашивает, и там даже от драйверов будет зависеть будет ли загружаться больше чем есть оставаясь болтаться в оперативке или останется на процессоре.

>или останется на процессоре

Или вызовет OOM ты хотел сказать?

Скорее будет ли программа принудительно подгружать слои на видеокарту или оставит все что не влезло на обработку процессору

Программы не такие умные, лол.

Тебе надо ручками выставить n-gpu-layers до предела пока крашиться не будет. С запасом каким-то. Полюс не забудь n_ctx разумным сделать, около 2048

>Программы не такие умные, лол.

Почему кстати? Скрипт то простой - загружай меняя параметры пока не выберешь лучшую скорость.

Ссылку на колаб так и не добавили, видимо придётся отдельный тред пилить...

>Почему кстати?

>Ссылку на колаб так и не добавили

Потому что всем похуй ©

Попробовал с q4, 4к контекста. Прирост производительности в невероятные 0.1-0.3 токена в секунду. Дело, короче, явно не в том что памяти мало и модель большая, железо просто не хочет работать по какой-то причине. Даже не знаю как гуглу эту проблему сформулировать, лол.

> Даже не знаю как гуглу эту проблему сформулировать, лол.

Пиши "квалифицированная помощь при умственной отсталости".

без видеокарты попробуй, тупо на процессоре

У меня на 70B чуть ли не быстрее.

Сравнимо с худшим результатом при использовании видеокарты с q6+8к контекста.

Хммм, количество потоков не то? Поставь на 1 меньше чем реальных ядер. Ну и выруби все что оперативку грузит. Если и это не сработает то хз. avx2 инструкции не поддерживаются что ли

> Ну, ты же не думаешь что они будут всем рассказывать что они делают, особенно если это перспективная тема.

Не думаю.

Я и сам не рассказываю, по этой же причине. =D

Просто таких новостей не поступало, поэтому свой энтузиазм я сдерживаю, чтобы не было обманутых ожиданий.

А о фотонике буквально недавно новость проскальзывала — тут можно чего-то ждать, да.

> Конечно, ai захватили капиталисты.

И продали их коммунистам. =D

Для нейронок проц ваще менять не надо. Там частоты памяти хватает на 4-5 потоков.

Просто, если обновлять, то на АМ4 есть 3900 и 5800х3д.

Если для нейронок — то и обновлять не надо, память ты быстрее не заведешь, один фиг.

> Нейросеть, имитирующая анонов совсем испортилась, даже предыдущий пост в контесте не держит.

+

> у меня на древнем рузене 1-го поколения на более жирном кванте 13b q8_0 было 1.2 т/с, и занимало далеко не 32 ГБ

Проверял седня 13б Q6 на 5500 рузене с 3200 в двухканале — 2-3 токена.

Явно не ноль запятая с чем-то.

Да еще и видяха-то.

Да.

Свопается из видяха на озу — не хорошо, лучше подобрать соотношение слоев правильное.

Убабуга, вроде, не?

llama.cpp, подозреваю.

ТС протупил, соглы.

Сочувствую.

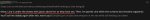

3 токена в секунду, просто в начале долго считывает промпт. Смотри на Generation 358ms на токен это 3 токена в 1 секунду примерно

> Хммм, количество потоков не то? Поставь на 1 меньше чем реальных ядер.

Так и стоит.

> Свопается из видяха на озу — не хорошо, лучше подобрать соотношение слоев правильное.

У меня сетка и контекст в видимопамять грузятся с запасом, но тем не менее 16 гб оперативы тоже зачем-то загружаются.

> 3 токена в секунду, просто в начале долго считывает промпт.

Оно ж всегда так делает, так что это реальная средняя скорость появления каждого токена в ответе.

>Потому что всем похуй

Буржуй, спок.

>Оно ж всегда так делает, так что это реальная средняя скорость появления каждого токена в ответе.

только первого где обычно самый жирный промпт

А у меня при генерации каждого ответа... ЧЯДНТ?

>Не шедевр шишковзрывающий, но довольно неплохо и органично, возможно в общем контексте будет хорошо, попробуем.

Она пишет хуже чем mlewd chat, но лучше большинства 70b. Плюс, тут шишку поднимает скорее не стиль, а факт того что она почти не тупит.

>70, серьезно? Бывшая больше часа видюху нагружая оценку проводит, а 15 где-то уже на саму перегонку и проверку.

Это для exl2, для gguf видеокарта не нужна. Из bin в q16 перегоняется парой потоков на процессор и зависит целиком от скорости диска. У меня заняло где-то 2 минуты. Для квантования нужна скорость процессора плюс диска. Заняло 4 минуты. И того 6 минут для конвертации и квантования 70b в Q4_K_M на 13900k/990 pro. Даже на слабом железе должно хватить 20-30 минут, главное чтобы весь процесс происходил на ссд.

>70 в теории даже на 16гб врам перегонится. Какой-то нагрузки на диск тоже не замечено, может на харде уже будет существенно.

Турбодерп вроде писал что 24 нужно. Но я не возился с exl2 уже давно, так что может он уже улучшил алгоритм.

А ты где запускаешь то? запускай в кобальде, просто скачай ехе и запускай его кликом на него. Настраивай и сиди через браузер.

> А ты где запускаешь то? запускай в кобальде, просто скачай ехе и запускай его кликом на него.

Так и делаю, да.

У меня в таверне, при генерации в угабоге все свайпы одинаковые, хотя сид пишет разный, проверил Свина на хорде - то же самое. ЧЯДНТ?!!

>Свина

У него такая болезнь, да, на заполненном контексте.

У меня такое на любой GPTQ-модели наблюдалось

collectivecognition-v1.1-mistral-7b.Q8_0 хорош, чуть меньше сои и алайнмент ближе к нейтрали, но не до конца конечно. По крайней мере в моем недолгом тесте, хрен знает как себя поведет дальше.

Ну наконец-то конструктивная критика, спасибо.

>Появятся новые форматы моделей, новые движки.

Это проблема сервера, потому что я предоставляю только фронт.

>Лламу мне запускать отдельно?

Можно ее докинуть в архив и сделать запуск из интерфейса, но мне из командной строки удобнее.

>есть кобольд.цпп размером 20 мб.

Но он на питоне, я такое не хочу запускать.

>А зачем мне что-то еще качать, я хочу все одним файлом.

Сервер можно интегрировать, будет один файл.

>У тебя есть базовые настройки?

Сегодня запилил. Промпты есть, про ворлд инфо и все остальное даже не слышал, но если они просто встраиваются в текст, то проблем не будет. Интеграции надо тоже с компилируемыми сервисами делать, но я ими все равно не пользуюсь, так что не в приоритете, хотя идея интересная. И они на процессоре что ли обсчитываются, если загружаешь большую модель? Суммаризацию хочу сделать.

>плагины на телеграм, вк, дискорд

Фе, централизованные сервисы. Для чего они?

>характер персонажей

Карточки же, или ты про что-то другое?

>смена заднего фона

Рюши, я не фанат таких штук. Визуальная новелла интересна, отрисовка картинок на основе текста?

>Чем твой вариант лучше Кобольда?

Компилируемостью же, лол.

>Ты же понимаешь, что покажешь ее года через полтора?

Не факт, сейчас для себя только пару проектов пилю и новых пока не предвидится, время будет, и интересно Qt попробовать. Уже есть несколько мыслей по улучшению интерфейса.

Смотри на kv self size тоже, он целиком в видеопамять выгружается независимо от количества слоев.

> че вы про сою ноете

Забей, 2.5 братишки так развлекаются, важен сам процесс и обсуждение догадок а не результат.

> 29-31 занимаются во время генерации.

Это значит переполняется, через что запускаешь?

Вангую врам свопается в рам, а рам переполняется и свопается на диск из-за чего такая дичь. Ищи способы снизить потребление и освободить рам от фоновых процессов для начала. 32гб должно быть с запасом на 13б, на 64 уже 70б пускают.

> но лучше большинства 70b

Нууу, до той же синтии что сойбои не взлюбили далеко примеров не будет, там мои фетиши, как она реагирует на поглаживание хвоста скидывал в прошлом , или xwin может выдавать не супер описательные но довольно креативные вещи. Или спайсоборос. С другой стороны, если те диалоги в контексте и соответствуют образу то весьма заебись, и явно не заметен какой-то типичный приевшийся стиль. Попробую - отпишу.

> в q16

Оно таки поддерживается? Но здесь нет никакого квантования, это просто перегонка формата. А при ужатии оно уже проводит оценку и неравномерно распределяет доступную битность на разные участки в зависимости от их важности.

> 6 минут для конвертации и квантования 70b в Q4_K_M на 13900k/990 pro

Или какая-то магия, или там идет ужатие без разбора.

> что 24 нужно

Выше 16 потребление не замечено.

Кто-нибудь делал полиаморную вайфу, которая является твоей девушкой, то есть у нее нет морального запрета на сексуальные отношения, но при этом она и не прочь обсудить кого-то другого в сексуальном плане? Я думаю попробую такую создать

>Нууу, до той же синтии что сойбои не взлюбили далеко

От карточки зависит, наверное. В том примере описание персонажа занимает всего 230 токенов, без примеров речи. Ну и сюжет был про американских подростков, так что по-моему норм.

>Оно таки поддерживается?

Это просто перегонка формата.

> А при ужатии оно уже проводит оценку и неравномерно распределяет доступную битность на разные участки в зависимости от их важности.

>Или какая-то магия, или там идет ужатие без разбора.

Анон, ты путаешь exl2 с gguf. Первый формат действительно тестирует важность, отсюда и такая низкая скорость конвертирование. Второй - просто конвертирует fp16 в фиксированное количество бит. Отсюда и такая высокая скорость.

На линуксах opencl уже устарел, сейчас в моде rocm - это такой компилятора cuda в дровах amd

Поддержка в проекты для nvidia добавляется практически сама собой: обновить библиотеки, такие как pytorch например, и драйвер, доустановить в систему компоненты rocm и hip драйвера

По скорости оно получается как cuda, amd карточки по тестам ребят в issues идут ноздря в ноздрю с nvidia. А вот по сравнению с opencl ускорение примерно двукратное: opencl-код по какой-то причине оказывается медленнее, чем cuda

Вариант билда нейродвижка может называться rocm или hipblas, от HIP - язык для высокопроизводительных вычислений

Флаги компиляции также по этим двум сокращениям можно найти в readme

Что приятно, эта штука из коробки поддерживает multigpu, есть смысл попробовать собрать ферму

У меня например rocm уже автоматом используется в llama.cpp и в stable diffusion. А ребята этим уже несколько месяцев пользуются, судя по issues в проектах, в которых тестами скорости обмениваются

Странно что всякие кобольды и угабуги до сих пор не обновились до библиотек с поддержкой rocm. Приходится использовать встроенный в llama.cpp веб-интерфейс

>Странно что всякие кобольды и угабуги до сих пор не обновились до библиотек с поддержкой rocm.

Амудя не нужна.

Поздравляю кстати с поддержкой того, что на видеокартах работает уже полгода/год.

> идут ноздря в ноздрю с nvidia

Это же революция, особенно если более менее работает а не рвется по кд, уже бы хайп развели.

> llama.cpp и в stable diffusion

Сколько токенов и итераций в секунду? Офк с указанием модели, карточки и т.д.

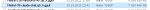

Вот например таблички с результатами для 7900xtx и 6850M

https://github.com/ggerganov/llama.cpp/pull/2910#issuecomment-1711240949

https://github.com/ggerganov/llama.cpp/pull/2910#issuecomment-1714009946

Также где-то были тесты для Nvidia 4700ti, там порядка 50 токенов в секунду скорость на 13b фигурировала

Все это уже несколько месяцев работает

Кому нужно - пользуются

>Все это уже несколько месяцев работает

Но тесты появились только на этой неделе. Верим, верим.

О заебись, спасибо за инфу. У меня конечно нвидима, но приятно знать что есть альтернативы и для амуде.

https://www.reddit.com/r/LocalLLaMA/comments/176um9i/so_lesswrong_doesnt_want_meta_to_release_model/

У ребят прорвало и горит так же как у меня от всей этой цензуры, приятно почитать

У ребят прорвало и горит так же как у меня от всей этой цензуры, приятно почитать

А вот stable diffusion

If you are not already committed to using a particular implementation of Stablie Diffusion, both NVIDIA and AMD offer great performance at the top-end, with the NVIDIA GeForce RTX 4090 and the AMD Radeon RX 7900 XTX both giving around 21 it/s in their preferred implementation. Currently, this means that AMD has a slight price-to-performance advantage with the RX 7900 XTX, but as developers often favor NVIDIA GPUs, this could easily change in the future. AMD has been doing a lot of work to increase GPU support in the AI space, but they haven’t yet matched NVIDIA.

https://www.pugetsystems.com/labs/articles/stable-diffusion-performance-nvidia-geforce-vs-amd-radeon/

По датам сентябрь минимум

Может и более ранние тесты есть, это просто первое что в поиске попалось

Но я это всего пару недель использую, до этого на opencl сидел

Оно реально работает, и работает хорошо

Сложность только на этапе настройки: многие в глаза ебутся и упускают то, что им пишет софт, открытым текстом: установи rocm-либу, установи hip-пак

Тонкость в том, что во всех гайдах по amd-дровам, при установке дров не выбирают компоненты rocm и hip, потому что гайды пишут под игры, а вся эта шняга в играх не нужна. Это специализированные, в основном серверные, технологии, для игр это просто лишний балласт на диске. И многие аноны из-за этого тупят на ровном месте: дрова по гайдам поставили, игры летают, вроде все норм, почитали в сети что дрова и их видюха вроде как поддерживают rocm, но софт у них упорно не хочет работать, говорит что rocm и/или hip не обнаружено, wtf? А получается что все тут закономерно: чтобы rocm и hip заработали, их сперва нужно установить, лол. И исправляется это буквально двумя галочками: просто повторно устанавливаем дрова, только на этот раз дополнительно прожимаем опции rocm и hip, эти компоненты доустанавливаются в систему, и все начинает работать, как и ожидалось. До смешного просто.

Не ну в целом неплохо, а почему никто не юзает и все страдают, хвастаясь 3т/с?

> RTX 4090

> both giving around 21 it/s

Хех, для амд это ебать какой результат конечно, но зачем врать? 33+ в одном потоке, под полтос при нескольких. С хуйтой вместо процессора в одном потоке действительно может быть 20, несколько не меняется. Интересно, это трипак говна залил, или все ради

> has a slight price-to-performance advantage with the RX 7900 XTX

даже так амд хуже по прафс/перфомансу. И забыли упомянуть что это в мертворожденном лаунчере без функционала, а так еще в 5 раз меньше (на самом деле там не так плохо). Сравнивали бы тогда со скомпилированной моделью, там перфоманс космос но функций и гибкости тоже нет. Учитывая

> this could easily change in the future

какое-то странное чтиво для свидомых фанатов

> дрова по гайдам

Как перестать орать?

Ну тут хз

Лично я использую, цифры с этими тестами примерно сходятся

Для сравнения есть машина с 3070, amd работала заметно медленнее нее, теперь примерно на уровне

llama.cpp понятно летает, там скорости полные

А вот stable diffusion работает хоть и намного быстрее, чем раньше, но все равно не очень комфортно. Может действительно shark попробовать, а может просто из-за объема данных. Сами картинки быстро генерятся, а вот например растянуть 2к в 4 раза в самом тяжелом алгоритме - это нужно несколько минут ждать: там так понимаю сначала картинка семплируется довольно большой нейроночкой, потом она ее рисует с нуля по этим семплам, поэтому работы там много, зато и результат впечатляет

Никак. Я вот гейфорс экспириенс не ставлю, благо я достаточно умён, чтобы до этого самому догадаться. А другим пришлось бы гайды читать, лол.

>[This comment will not be visible to other users until the moderation team checks it for spam or norm violations.]

Ебать у них там анальные ограничения. Вангую, нихуя мой коммент не опубликуют. А ведь я даже старался не поливать их говном.

Это ты инсталлер этих дров не видел

Он тебе выдает древовидный список опций, и сиди думай что для чего

По описаниям не особо понятно что выбирать, а огромное количество подопций только сильнее путает

Вот и идут люди смотреть как в гайдах это делают, что выбирают в опциях, какие из опций точно потребуются, а какие можно опустить

Ставить все, как на винде, не вариант

Например кастомные ядра начнут грязно ругаться, если установить dkms-часть драйвера, а на родном ядре сидеть такое себе: туда все самое интересное только через полгода прилетает, долго ждать

У меня например каждую неделю новое ядро прилетает, и каждые 2 дня - обновления графического стека. За несколько лет был только один случай, когда пару дней пришлось посидеть на предыдущем ядре, пока фиксили новое, благо система из коробки автоматически хранит штуки три-четыре прошлых ядра, чтобы можно было по выбору загружаться в нужное

Многие также не ставят 32 битные либы, на линуксах такой софт уже трудно встретить в быту, все родное давно 64 битное, а неродное транслируется в 64 бита

Ну а серверные либы поставить - это нужно понимать что это и зачем. Обычному пользователю их использовать просто негде, пока с нейронками не столкнется. Только тогда уже приходит понимание что штука нужная, надо ставить

4096 контекста - это нормально! Главное не размер, а как использовать!

А че не так то?

Скажите а не дешевле просто снять облако с посекундной тарификацией, чем покупать видюхи?

Просто снять A100 и не в чем себе не отказывать.

Просто снять A100 и не в чем себе не отказывать.

Оплати из России, давай

Какая сейчас лучшая 70Б карточка?

>Ебать у них там анальные ограничения. Вангую, нихуя мой коммент не опубликуют. А ведь я даже старался не поливать их говном.

Конечно этож западная площадка, все дрессированые уже

Есть облака с оплатой криптой, это не проблема да и карта у меня есть западная.

Подскажите самые галлюцинирующие сети при этом умные в понимании языка. MMLU нахуй не нужон. Мне нравятся галюцинации мне кажется есть некая ламповость у таких моделей. Но что самое лучше из таких вот несовершенных сетей neox, pythia, bloom, OPT, llama, glm130b? Опять же размер и MMLU побоку, главное чтоб трусы не снимала по 3 раза.

Откуда взять quantize? Судя по всему он должен сам собраться что ли? На гите лламы он тоже упоминается, но его нет среди исходников

> 2к в 4 раза в самом тяжелом алгоритме - это нужно несколько минут ждать

Интересно, хороший апскейл до 8к может и больше десятка минут занять, а тут на какой-то амд несколько минут.

> картинка семплируется довольно большой нейроночкой, потом она ее рисует с нуля по этим семплам, поэтому работы там много

Напиши своими словами без терминов, херь какая-то.

Жестоко. Но для такого хватит 3.5 галочки, остальное для поехов что беспокоятся о лишних 10 мегабайт на диске.

В случае А100 для какой-то одной задачи офк дешевле.

Подскажите какой гайд сейчас актуальный? Можно и на англ.

Хочу генерить диалог с персонажем.

Есть 10гб врам и 32 гб оперативы. Не знаю что будет быстрее.

Генерить хочу полностью локально без интернета.

Пиздец уже даже форч весь перерыл нихера не понимаю. С картинками было как-то попроще.

Хочу генерить диалог с персонажем.

Есть 10гб врам и 32 гб оперативы. Не знаю что будет быстрее.

Генерить хочу полностью локально без интернета.

Пиздец уже даже форч весь перерыл нихера не понимаю. С картинками было как-то попроще.

Форумчанин, прочитай шапку, иначе к вам будет применено ограничение в виде трёх дней RO.

в релизе есть

Я правильно понимаю, что в таверне читаются промты всех персонажей перед ответом, даже если им запрещено писать?

Не завезли гайдов, только краткие инструкции, в шапке есть.

Нвидия? Ставь https://github.com/oobabooga/text-generation-webui скачивай модель (13б полностью в врам не поместится, твой выбор - gguf формат и выгрузка части слоев), запускай через llamacpp, регулируя n gpu layers следя за потреблением врам. Или кобольда цпп качай, там все в одном файле но отличается функционал.

Начни, потом с вопросами по ходу разберешься.

Идеальное непорочное описание.

Экспериментировал тут с направлением контекста, попробуй.

The {{user}}'s actions are not described or assumed until he himself writes about it. The {{user}} acts only independently.

The story develops in the context set by the {{user}}.

Только врядли с середины заработает. Можешь выкинуть первые 2 инструкции если сетка за тебя не будет писать пытаясь направить историю в своем соевом направлении.

Франкенштейн все плодит своих монстров, и они в лидерах топа

https://huggingface.co/Undi95/Mistral-11B-OmniMix

https://huggingface.co/Undi95/Mistral-11B-OmniMix

Смотри в консоли, что отсылается.

Кто лорбуками пользовался? Как их отвадить абсолютно нерелейтед хуиту в промпт отсылать при каждой генерации?

Какая мистраль 7b лучше? Опенорка что из шапки? Хочу на видеокарте (8 гигов) погонять gptq, какой вариант выбрать? Main?

Мне понравилась Mistral-7B-claude-chat самым низким уровнем сои, а так бери что хочешь, опенорка тоже неплоха.

>Mistral-7B-claude-chat

Ее нет под GPTQ, только AWQ, но я попробую, спасибо

>Ее нет под GPTQ

А я что тогда использую?

>А я что тогда использую?

gguf, который на проце гоняет. GPTQ гоняет на гпу онли

А, точно, я дебил, сорян.

Хотя не понимаю, что тебе мешает выгрузить все слои ггуфа на видяху. Сам так делаю, чтобы не ебаться с AWQ.

Какая модель влезет в 64 гб DDR5? Сколько токенов в секунду будет выдавать? Модель процессора и скорость памяти сильно влияет?

Почему нет треда по железу для АИ?

Почему нет треда по железу для АИ?

>Какая модель влезет в 64 гб DDR5?

Хоть 70B.

>Сколько токенов в секунду будет выдавать?

1,5

>Модель процессора

Строго похуй.

>скорость памяти сильно влияет

Да.

>Почему нет треда по железу для АИ?

Был. Закрыли по очевидной причине.

>1,5

Неиронично неблохо, особенно учитывая что такая модель будет умнее всего, что помещается на 4090.

>Модель процессора

>Строго похуй.

И на количество потоков похуй? Т.е. какой-нибудь i5 12400 будет перформить как i9 13900?

>особенно учитывая что такая модель будет умнее всего, что помещается на 4090

Так ведь можно совмещать...

>И на количество потоков похуй?

5 потоков хватит всем, выяснили уже давно.

>i5 12400

>i9 13900

Мы про процессоры, а не про заменители с тухлоядрами, но да, даже i5 12400 будет норм. Или даже лучше в виду отсутствия тухлых потоков.

Как заставить мистрал опенорку не писать от моего имени? Чатмл в форматировании включил, все равно от моего имени пишет

>Так ведь можно совмещать...

Разве общая скорость не будет лимитироваться самым медленным звеном, т.е. CPU? Если ты про размер модели, то наверное проще взять плашки по 48 гб, чтобы догнать суммарный объём до 96 гб DDR5

>Мы про процессоры, а не про заменители с тухлоядрами

Вначале ты говоришь, что на проц похуй, а теперь выясняется что даже одни ядра лучше других. Что-то не клеится. Тем более что мелкоядра отличаются в основном пониженной частотой и отсутствием каких-то инструкций

Что-то попробовал mythomax-l2-13b.Q5_K_S, вроде хвалили, но выдает всего пару сухих предложений. Тогда как MLewd-L2-13B-v2-1.q4_K_S выкладывает добрый абзац с сочными эпитетами на одних и тех же персонажах.

>1,5

Если отгрузить половину слоев в видеокарту и считать без обработки промпта, то как-то совсем мало. У меня получается 300мс на токен , то есть 3.3 токена в секунду при пустом контексте. Оно, конечно, немного замедляется при наполнении, но далеко не до 1.5. Это Q4_K_M - кванты поменьше еще намного быстрее.

>5 потоков хватит всем, выяснили уже давно.

>Мы про процессоры, а не про заменители с тухлоядрами, но да, даже i5 12400 будет норм. Или даже лучше в виду отсутствия тухлых потоков.

На интеле надо либо ставить количество потоков равное количеству нормальных ядер, либо отключать недоядра в биосе и ставить количество потоков по максимуму.

>Разве общая скорость не будет лимитироваться самым медленным звеном, т.е. CPU?

Ну смотри. У тебя полмодели просчитается за 10мс, а вторая за 500мс.

>Если ты про размер модели, то наверное проще взять плашки по 48 гб, чтобы догнать суммарный объём до 96 гб DDR5

64 в принципе хватает на самый разумисткий 5 бит, так что похуй.

>а теперь выясняется что даже одни ядра лучше других

Ну совсем тухлоядра уж рассматривать не стоит.

>Если отгрузить половину слоев в видеокарту

В вопросе не было про видеокарты. Хотя я полностью согласен с тем, чтобы комбинировать.

>Это Q4_K_M - кванты поменьше еще намного быстрее.

И намного тупее.

>На интеле надо либо ставить количество потоков равное количеству нормальных ядер

Но не больше 5, да. И лучше приоритеты выставить/закрепить процесс на норм ядрах, во избежании.

> 64 в принципе хватает на самый разумисткий 5 бит, так что похуй.

Стоит покупать 64гб DDR4 на 3200? Сейчас 8гб nvidia и две плашки под 16 гб (в сумме 32). Или DDR4 это насилование трупа в принципе?

если не замахиваться на 70б то похуй, но там и 32 хватит хоть и в притык, если те же 33б крутить

>Но не больше 5, да.

Зависит от количества каналов памяти, ну и от псп памяти. Если процессор не силен в однопотоке, то что бы упереться в лимит по памяти может и 6-7 ядер съесть. Или наоборот память быстрая, под 100 гб/с, так же может не прожевать на 5 потоках.

Скорее совет такой - ставить только по количеству физических ядер, а потом убавлять по одному и смотреть где скорость будет самой большой.

>Но не больше 5, да. И лучше приоритеты выставить/закрепить процесс на норм ядрах, во избежании.

Да нет же, от железа зависит. У меня на 5 потоках 360 мс/токен, на 8 - 300, на 16 - 290 (если отключить недоядра).

Когда уже в угабуге сделают нормальную систему обновлений? Сейчас ты либо полностью ее переустанавливаешь либо идёшь нахуй

>Или DDR4 это насилование трупа в принципе?

Да.

>Зависит от количества каналов памяти, ну и от псп памяти.

Да. Но пока ещё никто не предъявил пруфов, что ему нужно было больше 5 потоков.

Пруфани, железо там, скорости.

git pull?

>Да. Но пока ещё никто не предъявил пруфов, что ему нужно было больше 5 потоков.

Пруфы не дам, но сижу на 7 потоках, 4 канала памяти. Первые 4 потока рост в одну долю скорости, еще 2 потока по пол доли скорости, ну а на 7-8 уже капли, а на полных 8 вообще медленнее чем на 7.

Просто интересно, проверь будет ли на 15 быстрее чем на 16 ядрах.

>4 канала памяти

Не DDR5 же.

Забавно. Какие ядра грузит? Выставлял режим высокого приоритета?

>Не DDR5 же.

И чо? Серверный процессор с 4 каналами памяти ддр4, и на 5-6 потоках все еще ощутимый рост скорости.

Забыл еще добавить, что это 70B Q4_K_M с 42 слоями на видеокарте.

>Просто интересно, проверь будет ли на 15 быстрее чем на 16 ядрах.

287мс, то есть в пределах погрешности. Я вообще на постоянке гоняю на 8 ядрах. Для 16 надо отключать E-ядра в биосе, а заставить работать на нормальных ядрах не получится - по неизвестной мне причине ломается стриминг.

>Какие ядра грузит?

P-ядра же. Если стоит 8 потоков, то как правило через одно, то есть пропуская виртуальные потоки.

>Выставлял режим высокого приоритета?

Да, но я уверен, что оно не влияет, по крайней мере есть в фоне ничего не запущено. Главное низкий приоритет не ставить - тогда винда заставить работать на E-ядрах.

>И чо? Серверный процессор с 4 каналами памяти ддр4

Которые равны 2-м DDR5.

>и на 5-6 потоках все еще ощутимый рост скорости

Ну так до 5 это нормально.

>42 слоями на видеокарте

Тогда мало становится понятно, что мы в итоге измеряем.

>по крайней мере есть в фоне ничего не запущено

А такое бывает? По крайней мере шинда и браузер никуда не денутся.

Пересядь на угабугу / напиши автору в гитхабе

Смени на кобольдЦпп.

>Ну так до 5 это нормально.

5 и 6 одновременно ускоряют как один поток, то есть одна доля скорости от первых потоков. Так что рост скорости достаточный что бы их включать. 7 добавляет где то 1/4 долю скорости, но все равно его оставляю, почему бы и не да.

Так что на 5 потоках я бы потерял при 6 токенах в секунду в 7 потоках - около секунды, а это ощущается

Поэтому не обманывай людей что нужно только 5 потоков

>Тогда мало становится понятно, что мы в итоге измеряем.

Вопрос был в том, имеет ли смысл ставить больше 5 потоков. От количества выгруженных на видеокарту слоев это не зависит.

>А такое бывает? По крайней мере шинда и браузер никуда не денутся.

Этим можно пренебречь, я скорее про требовательные программы.

А, я забыл дописать. Моя рекомендация относится к нормальным процессорам, а не к серверным тухлопоточникам 0,99МГц.

Ты напиздел и все придумываешь отмазки, по факту твои советы херня и тебе уже это доказали пруфами. Слился бы молча а не трепыхался по чем зря

Ну маааам...

Ну круто же выходит да. Только слабоват он нужно обьеденять вообще разные модели :)

Слить со стеблом и охуеть.

> на количество потоков похуй

Упор прежде всего в скорость памяти, веса тяжелые и к ним много обращений.

> i5 12400 будет перформить как i9 13900

Скорее всего последний будет быстрее, но на одинаковой рам разница окажется мала.

> а не про заменители с тухлоядрами

Ты так не выражайся, а то сутра кнопку нажмешь - а там проц умер и соккет прогорел.

> Но не больше 5, да. И лучше приоритеты выставить/закрепить процесс на норм ядрах, во избежании.

Лучше их не трогать и все будет работать быстро. Примерно такой же результат как у если с одной 4090 запускать.

>а там проц умер и соккет прогорел

Повышенное напряжение давно уже вылечили бивасами. А вот тухлость ядер не вылечить ничем.

Надо будет проверить че там по сое и мозгам в целом. Может выйдет что то вроде MLewd-ReMM-L2-Chat-20B только без уклона в ерп

Тут скорее амд баги можно подлатать, но амудэ фанатика не вылечить ничем. 7000 серия - провальное днище с которого много разочарований, гетерогенная архитектура на этом фоне куда более безобидная. Тем не менее, готовься переобуваться уже сейчас, гетерогенных амд ждать недолго осталось.

>только без уклона в ерп

Но... Зачем?

>7000 серия - провальное днище с которого много разочарований

Чаво? Это тебе пользователи интела сказали? По факту там никаких проблем нет.

>Но... Зачем?

Да я то не против, просто там миксы не из ерп сеток. Мне и нейтраль сойдет, нужным промптом ее склонить легко.

> без уклона в ерп

Если сетка здорова, ерп в датасете не обязательно склонит ее к блядству, может и обычное рп отлично получиться.

> никаких проблем нет

Раз нравится - так наяривай с удовольствием, зачем сказки про ядра и как с ними тяжело жить рассказываешь?

Вопрос - как тренировщики всяких лам-2 делают reward модель для тренировки основной языковой модели? И шире - те же ПопенАИ что, тренировали GPT-4 на 1.3 триллиона параметров, а рядом на соседнем сервере тренировалась такая же по размеру модель чисто под оценку reward-а? Не жирно ли? Можно ли тренируя ламу в домашних условиях сократить потребление памяти, вызваное необходимостью держать еще один инстанс этой ламы в памяти? Может можно как-то переиспользовать слои тренируемой модели, добавляя в качестве выхода не LM Head а персептрон с оценкой реварда?

В твоих словах есть буквы

Чё сказать-то хотел?

Сложна. Попробуй тут задать может кто знает https://2ch.hk/ai/res/511426.html

Ок, спс.

>зачем сказки про ядра и как с ними тяжело жить рассказываешь

Я? Я ничего не рассказываю, так как на руках интела нет. Это пользователи интела каждый раз приносят новые сюрпризы:

>Для 16 надо отключать E-ядра в биосе, а заставить работать на нормальных ядрах не получится - по неизвестной мне причине ломается стриминг.

>делают reward модель

А они делают? Разве там не градиентный спуск?

Мимо нихуя не понимающий в тренировке

Не, все, я сдаюсь. По ходу любая улучшалка склоняет модель в определенном направлении, даже такое безобидное как "[WARNING: May contain explicit language]". Хотя оно в принципе и понятно почему, учитывая что такие предупреждения не будут в тексте просто так - вот модель и научилась. Остается либо довольствоваться стилем по умолчанию, либо добавлять в Author's Note по мере необходимости.

пусть следует контексту беседы

> Это пользователи интела

Что-то поломалось, единичный случай. Писал же, с ласт обновами если не делать ничего, не трогать бивас и не трогать число потоков то перфоманс будет. Есть другой баг - если попытаться задать потоки и вручную забиндить их на п ядра - перфоманс снизится, но учитывая первое это совсем несущественно.

> безобидное

Это не безобидное, это жесткий триггер на стиль ответа. Не просто инструкция где-то а буквально смещение ее ответа в конкретную ассоциативную область.

Сначала показалось что это реакция на (ooc: the next day), но со второй части проиграл.

>если не делать ничего, не трогать бивас и не трогать число потоков

Так и запишем- если не дышать, то всё работает.

>пусть следует контексту беседы

Оно и так умеет, НО, не всегда будет супер графически все описывать, склоняясь к более нейтральному стилю, особенно когда контекст заполнен обычной речью.

>Это не безобидное, это жесткий триггер на стиль ответа. Не просто инструкция где-то а буквально смещение ее ответа в конкретную ассоциативную область.

По сравнению с тем, что у меня до этого стояло - безобидное. Ну а так да, ты прав.

>Оно и так умеет, НО, не всегда будет супер графически все описывать, склоняясь к более нейтральному стилю, особенно когда контекст заполнен обычной речью.

Интересно, у меня сетка просто начинала подыгрывать угадывая что я хочу. То есть буквально следовала моему направлению действий-беседы развивая историю куда она думает мне нужно. Но особо не тестил, может повезло

Неправильно, если запускать с параметрами, что стоят по дефолту - все прекрасно работает. Даже пердолинг не нужен.

Офк, это сложно принять, привыкнув к необходимости каждую среду бежать обновлять биос чтобы проц не сгорел сам по себе, или в надежде что ддр5 наконец возьмет заявленные производителем частоты. А вообще /hw/ 2 блока ниже, выражать недовольство или праздновать победу лучше там.

> По сравнению с тем, что у меня до этого стояло - безобидное.

Ох ты проказник. Но вообще такая реализация - оче жесткий прием, сильнее чем чем (ooc) или "согласие" в начале промта, и может путаницу породить.

Ты вообще тестил модель что используешь, она меняет свой стиль речи в соответствии с персонажем или обстановкой? Если да то четче ее описать или подсказать в промте что нужно ругаться, сразу начнет там где уместно.

Сетка понимает, но не будет использовать, например, более вульгарные слова, типа cunt, cock и так далее. Она по умолчанию пишет как в легкой эротике, а я хочу графической порнухи. Хотя тут от модели зависит - тот же mlewd chat без проблем использует. С жестокостью аналогично - с улучшайзером будет более графически описывать, охотнее ругаться и так далее.

>Ты вообще тестил модель что используешь, она меняет свой стиль речи в соответствии с персонажем или обстановкой? Если да то четче ее описать или подсказать в промте что нужно ругаться, сразу начнет там где уместно.

Меняет, но у нее есть некоторое свое понимание как описывать каждую сцену. Стиль как правило достаточно не графический.

>Если да то четче ее описать или подсказать в промте что нужно ругаться, сразу начнет там где уместно.

Тут смотря как сделать. Если оно в начале контекста, то эффект очень небольшой. Если в конце, то модель слишком тупая чтобы понять что значит "где уместно". Как бы ты ни изворачивался, а любая инструкция меняет ее поведение, что иногда приводит к полной шизе.

> Стиль как правило достаточно не графический.

В качестве рофла можешь в системном или где-нибудь попозже указать "описывай происходящее в стиле фильма _режиссер_нейм_", хз правда как это повлияет на кум, но в обычном забавно.

> Если оно в начале контекста, то эффект очень небольшой

А, ты ее куда-то в промт ставишь поглубже? Тогда норм, а то показалось что поставил как как обязательное начало каждого ответа.

>А, ты ее куда-то в промт ставишь поглубже?

Раньше ставил в ответ, потом перенес в author's note на глубину 1.

Как активировать доп. эмоции Таверне? Уже пак создал, в меню он высвечивается, а как запустить? Кликаю на пикчу, там превью бота, кликаю на пикчи эмоций они заменяют дефолтную, но не меняются.

Ты про автосмену аватарки персонажа в зависимости от контекста?

Там бля отдельная нейронка детектит приколы и меняет пиктчи. Ставить и запускать тоже все отдельно надо. Попробовал один раз - потом забил хуй просто потому что все это долго включать.

> reward

Ты вообще не о том думаешь. Смотри в сторону reinforcement learning. Оно по маркерам делается, а не другой языковой моделью.

> LM Head а персептрон с оценкой реварда

Набор букв пациента ПНД, не пиши такое больше.

Обнови таверну и нажми на эту галку. Если эта галка есть, можешь не обновлять, просто нажми на нее

Ничего запускать не надо, начиная с какой-то версии staging, там можно поставить локальный сервер и запускать без экстрас, результат будет тот же

Можете что- сказать про Pygmalion-2 13B

Которая пиарится в шапке редита, случайно наткнулся? Ну и Mythalion 13B от этого же автора, мерж этой модели с другими

Которая пиарится в шапке редита, случайно наткнулся? Ну и Mythalion 13B от этого же автора, мерж этой модели с другими

Говно. Там датасет максимально парашный. Сколько её не перетренивали - всегда кал.

Да все то же что на первой лламе порт, но лучше. Правда всеравно мэх "умные" модели того же размера умнее ее, "кумерские" описывают и просто рпшат лучше. Вон пример помимо коротких ответов пожалуй это первая модель которая с импрсонейтами лупилась и топлатась без прогресса или чего-то содержательного.

> Mythalion 13B

Кто-то положительно отзывался, но по тестам - мэх. В формате пигмы отвечает как пигма но более шизоидно, в альпаке как мифомакс но более странно и зажато.

> В формате пигмы отвечает как пигма но более шизоидно

Ну тогда и смысла от микса нет

> "кумерские" описывают и просто рпшат лучше. Вон пример помимо коротких ответов пожалуй это первая модель которая с импрсонейтами лупилась и топлатась без прогресса или чего-то содержательного.

Понятно, кринж

Спасибо

https://www.reddit.com/r/machinelearningnews/comments/177u8ho/unlocking_the_power_of_sparsity_in_generative/

Новый метод квантования, дает 7 токенов на одном ядре ryzen. Есть демка, но пока у них только mpt для пробы

Новый метод квантования, дает 7 токенов на одном ядре ryzen. Есть демка, но пока у них только mpt для пробы

> дает 7 токенов на одном ядре ryzen.

Ну это хорошо, но на чем там идет обсчет?

Там просто лишние веса выкидываются в процессе файнтюна. Оно выкидывает неиспользуемое для заданного датасета, затачивая модель на конкретную задачу. Нам от этого не сильно полегчает.

Это получается комбинация файнтюна и кванта, при обучении делая разреженную матрицу весов и исключая малозначимые (пиздец надмозг получается, но суть похожа на то что и во всяких дистилляциях). В общем нет препятствия для использования с целью повышения перфоманса при меньшем размере, но не во много раз как там заявлено, если не ударяться в сильную специализацию.

Кстати интересно казалось бы MPT уже все забыли, но его используют в экспериментах, есть тюны от IBM, Amazon. Много загрузок. Так что бизнес вполне использует mpt и falcon, а кумеры на llama.

Ссылки не доставишь?

Кумеры полюбили лламу за сочетание высокого перфоманса, лайтового алайнмента, легкости файнтюнов и запуска квантов на обычном железе.

На файтюны не думаю что они будут интересны местным, ну вот

https://huggingface.co/ibm/mpt-7b-instruct2

https://huggingface.co/amazon/FalconLite2

https://huggingface.co/spaces/Intel/Q8-Chat - демка интела falcon mpt, но нет ламы.

Ну это так что вот так навскидку, просто периодически слышу об этих моделях. А про лламу что то нет, только в контексте кумов. Субъективный взгляд.

https://huggingface.co/spaces/artificialguybr/qwen-14b-chat-demo

Теперь простой русский Иван может настроить свой кошка жена

Теперь простой русский Иван может настроить свой кошка жена

>демка интела falcon mpt

Так меня ещё ни одна модель не унижала.

А китайцы очевидно более соевые. Кто-то ещё надеется на китайского брата в сфере моделей?

Там новый король скоров появился - франкенштейн 11В, собранный из четырёх Мистралей. Ебёт все 30В.

Даже в онлайн-зефире проходят истории про ниггеров, а тут соя пиздец.

> https://huggingface.co/ibm/mpt-7b-instruct2

Надо попробовать.

> https://huggingface.co/amazon/FalconLite2

24к контекста из коробки, вполне интересно. Правда фалкон 40 пиздец тупым был.

А насчет того почему их могут использовать корпорации - посмотри их лицензии. Демки по ссылкам не так уж и плохи для 7б, но, конечно, туповаты.

Да какой смысл в паблик форме это тестить, там навалили в промте запретов и указаний. Другое дело что, например, хочешь обсудить проблемы woke шизы диснея - а оно ловит затупы и не понимает саму концепцию. Соглашается, потом уводит куда-то в другую сторону, приводя неуместные отсылки и ставит что "все не так однозначно". Ладно бы полноценная соя, а тут просто затупы.

Да она ближе к llama2-chat, очень соевая. Но не знаю насчет базовой модели. Как на реддите сказали что модель взяла худшее из обоих миров западная + китайская цензура.

> Мистралей

Попробовал сегодня. Говно же. Путает персонажей.Несет хуиту и не помнит с чего все началось уже на 6 предложении.

>китайская цензура

Да. Хотя о Винни пишет.

Там их 4 разных микса, если не больше.

Хрен даже знает что качать на пробу.

Ну и опять же, сетки могут не работать после квантования, так как тесты делались на полных весах.

Подскажите, опытные:

>synthia-70b-v1.2b.Q5_K_S.gguf

на 13600, 64гб, 4090, гергановым и офлоадом 35 слоев на вк имею 0.9 токенов. Это вообще норм? Или у меня что-то не работает? Вк макс 120вт кочегарится. С картинками она может и 450Вт легко.

мимокрок

>synthia-70b-v1.2b.Q5_K_S.gguf

на 13600, 64гб, 4090, гергановым и офлоадом 35 слоев на вк имею 0.9 токенов. Это вообще норм? Или у меня что-то не работает? Вк макс 120вт кочегарится. С картинками она может и 450Вт легко.

мимокрок

Вот скажите мучает вопрос, если 80% связей в языковых моделях не особо нужны, не особо активны.То почему при обучении или тонкой настройке не блокировать для обучения активные нейроны, а обучать только пассивные. Чтоб впихнуть в модель гораздо больше.

Для Q5 норма, у тебя фактически треть только на карте, остальное на ЦП пердит. Я на Q3 с 4090+13700К раскочегаривал до 4 т/с.

Делай. Но я из готовых высокопроизводительных инструментов видел только блокировку отдельных слоёв. Видимо, смотреть, какие там отдельные веса менять, слишком дорого.

И да, вопрос больше для

Маловато наверно, но тут q5, хз. Еще зависит от контекста, с коротким ответом и большим из-за времени на обработку последнего может ерунда получиться. Посмотри сколько именно мс/токен в ходе генерации расходуется, результат к которому стремиться стоит выше выкладывали. Увеличивай число слоев но так чтобы врам хватало, разгони рам.

Сука, и это мне пишет 70b модель, правда на 3 кванте. Для слепой девушки. Я ещё дополнительно прописал что да, слепая. Да, не способна видеть и реагировать пока не потрогает. Нет, не видит.

Один хуй...

Один хуй...

Слепые тоже говорят лук, впрочем, в этом тексте не только лук в этом тексте кака.

А слог то какой, ни разу никаких повторений и литературно! Скинь карточку и модель обозначь.

Хуйня какая, потестил короче пару дней новые 7b на мистрале.

Короче для себя точно решил что 7b сетки только 8q качать, даже 6K заметно тупее в тестах и не вывозит инструкции которые 8q щелкает без ебли.

Хуй его знает как дела с неквантованными весами, у меня только одна такая и не особо понял разницу.

Короче для себя точно решил что 7b сетки только 8q качать, даже 6K заметно тупее в тестах и не вывозит инструкции которые 8q щелкает без ебли.

Хуй его знает как дела с неквантованными весами, у меня только одна такая и не особо понял разницу.

У тебя либо шиза прогрессирует, либо ты какой-то обоссаный бэкенд используешь типа OpenCL.

а может у тебя?

аргументно аргументируй

Тут искали нейтральные модели, по моему палм 2 подходит, под определение, ему буквально нужно все описывать чтоб он что то делал, если что то не написал, то он это пропустит. Скорее всего это энкодер-декодер, похож на т5 по поведению. нецензурный на уровне логики, но зацензурный внешней модерацией.

Проще уж в блокноте ролеплеить, нежели чем с пальмой ебаться. Она ж тупая как пробка, хуже опенлламы на 3В.

https://venus.chub.ai/characters/Sweepypie/blind-girl-576e145d

fiction.live-Kimiko-V2-70B.ggmlv3.Q3_K_L.bin

Если вдруг у тебя на какой нить модели нормально сможет хотя бы к 20 сообщению остаться слепой, скинь плиз, как достиг.

> ему буквально нужно все описывать чтоб он что то делал, если что то не написал, то он это пропустит

Ты только что описал оче тупую модель. Если дать ему задачу, описав предпочтения или контекст в котором нужно двигаться, оно что будет делать?

Попозже попробую.

Потестил. Право на жизнь точно имеет, из плюсов приятный не навязчивый стиль ллимы, сообразительности и восприятия достаточно, честно старается соответствовать поведению персонажа. Можно спокойно рпшить без кума, понимает сложные концепции как из фентези, так и из сайфая, кум вполне приличный.

Минусов хватает, посты короткие пигма-лайк. Офк формат рекомендованный, указания желаемой длины работают очень условно и часто игнорятся. По дефолту маловато инициативы всякие leans into your embrace и подобное за нее не считается, условно на "быстрый разогрев и в постель" рассчитывать не стоит, это будет коротко и кринжевато. Ну и от хроноса лезет дичь типа

> To her, moments like these represented the strong bond between them—one built on mutual understanding and respect.

Забавная особенность, на некоторых карточках из гача дрочильни с лором показывает прям очень хороший перфоманс с точки зрения поведения, понимания, введения персонажей и т.д. При проверке внезапно оказалось что модель знает не только лор и сеттинг, но и многих персонажей и их взаимоотношения. Относительно других 70 разница заметна разве что еще синтия смога на уровне ответить без кучи галюнов и путанницы как у остальных. Использовать вики в качестве датасета тема забавная, интересно сколько там еще встроенных "лорбуков".

>bond

БОНДЫ БОНДЫ БОНДЫ

https://servernews.ru/1094489

Нейроускоритель и 32 гига намекают мне на нейронки.

Чет я сомневаюсь что память несколькими чипами даст норм псп для нейроускорителя, каким бы крутым он не был.

Нейроускоритель и 32 гига намекают мне на нейронки.

Чет я сомневаюсь что память несколькими чипами даст норм псп для нейроускорителя, каким бы крутым он не был.

Спасибо. Насчет длины сообщений - для меня это наоборот плюс, поскольку я люблю не графоманию, а интерактивный рп.

>Офк формат рекомендованный, указания желаемой длины работают очень условно и часто игнорятся.

На длине сообщений натренирована только третья версия лимы. Тут надо делать как в симпл прокси: "### Response (2 paragraphs):". Это работает со всеми моделями, меняя их поведение.

>По дефолту маловато инициативы всякие leans into your embrace и подобное за нее не считается

Инициатива разве не от промпта?

>To her, moments like these represented the strong bond between them—one built on mutual understanding and respect.

Проиграл. Я пока еще ни разу бонд не словил, но я пока отыгрываю реалистичные сценарии.

Думаю вот, кстати, что делать с недостаточным контекстом. Пытался каждый раз при заполнении делать краткое содержание, создавая новый чат с одним сообщением - мало того что муторно, так еще и резко меняет стиль речи персонажа. smart context тоже режет где попало, и задолбаешься за этим следить. Лезть руками в json файл чата и удалять сообщения тоже как-то муторно. Решил, что надо резать по локациям/событиям. Например, если первое событие занимает 30 сообщений, то после него продолжаешь рп еще на 5-7 сообщений, после чего просишь через OOC дать краткое содержание и отрезаешь все кроме последних 5-7сообщений. Это позволяет лучше контролировать что и когда можно выкинуть из памяти, в общем как smart context только руками. Таверна, конечно, это не поддерживает, но я кое-как наговнокодил поле, куда можно вписать номер сообщения по которому отрезать контекст. Буду тестировать, удобнее ли так или нет.

>Думаю вот, кстати, что делать с недостаточным контекстом.

Расширять через ропу пока не хватит?

>Расширять через ропу пока не хватит?

Ресурсов не хватает. У меня и так половина слоев на процессоре, и большой контекст отожрет еще больше видеопамяти. Это не говоря про то, что rope достаточно заметно лоботомирует модели, особенно если превысить 8к. Мне надо минимум 16к для коротких сценариев, и 32-64к для длинных.

> На длине сообщений натренирована только третья версия лимы.

Ну погоди, в рекомендованном промте в конце как раз про длину сообщений, а в офф репе варианты

> The message lengths used during training are: tiny, short, average, long, huge, humongous. However, there might not have been enough training examples for each length for this instruction to have a significant impact. The preferred lengths for this type of role-playing are average or long.

Еще первая версия со странным форматом реагировала хорошо. Возможно офк так 70 натренили что оно не работает.

> Инициатива разве не от промпта?

Хз, вроде ничего про это, дефолтный. По сравнению с другими меньше, чар почти постоянно ждет твоего участия, указания и т.д., даже инициативный редко что-то делает "без согласия".

> что делать с недостаточным контекстом

Искать память, растягивая до 8-16к и пользоваться суммарайзом, проверяя и перегенерируя/правя его. Если ставить его поглубже или в начало то за счет приличного количества последних реплик довольно гладко проходит.

> после чего просишь через OOC дать краткое содержание и отрезаешь все кроме последних 5-7сообщений

В экстрас есть готовая реализация, в промт только добавь про "детальное развернутое" и посравнивай варианты что выдает.

>Ты только что описал оче тупую модель.

То то и оно что нейтральность она такая. Но я бы не сказал что палм прям тупой. Скорее бесят его фильтры но сам по себе он дает вполне релевантные ответы, и без сои. Хотя я чаще просто у него что то спрашиваю по делу, когда gpt задалбливают своими этиками.

Пальма кстати оффтопик.

>Думаю вот, кстати, что делать с недостаточным контекстом.

Попробуй настроить https://docs.sillytavern.app/extras/extensions/smart-context/

> когда gpt задалбливают своими этиками

Что? Там же бегать из тюрьмы надо. Стиля и атмосферы, правда, это не то чтобы добавляет.

> что нейтральность она такая

Нет, нейтральность значит способность выполнить любое указания и занять любую позицию отмечая что это аморально или игнорируя этот факт в зависимости от запроса пользователя.

> Скорее бесят его фильтры

Что там за фильтры?

>Ну погоди, в рекомендованном промте в конце как раз про длину сообщений, а в офф репе варианты

Написано что может не работать. Исходя из моего тестирования не работает вообще. В третьей версии лимы сделали намного умнее - поместили длину в самый конец контекста, что действительно работает. Я этот параграф (Play the role of...) вообще убрал из промпта.

>По сравнению с другими меньше, чар почти постоянно ждет твоего участия, указания и т.д., даже инициативный редко что-то делает "без согласия".

По-моему все модели пассивны когда не знают как двигать сюжет. Разницы между моделями я особо не замечаю. В идеале надо не рассчитывать на телепатию модели, а ясно прописать поведение и цель персонажа, если это важно.

>В экстрас есть готовая реализация, в промт только добавь про "детальное развернутое" и посравнивай варианты что выдает.

Использовал раньше, но теперь перешел на OOC чтобы была возможность прервать на середине, если не понравилось. Чтобы постоянно не писать можно еще настроить Quick Reply.

>Попробуй настроить

Ест много контекста и зачастую не работает из-за слишком примитивного механизма активации.

В этой версии если в конце ставить слушается или также игнорит? Хотелось бы часто подлиннее, специально в реплике несколько действий, действие + разговор, несколько реплик или вопросов. Даже шизомиксы с этим отлично справляются, связывая их и выстраивая хороший ответ, а тут хорошо отвечает только на одну часть, или короткими обрывками если на все, неочень. Потенциал вроде есть чтобы это делать, вылавливает пожелания и настрой пользователя из реплик довольно четко.

> все модели пассивны когда не знают как двигать сюжет. Разницы между моделями я особо не замечаю

Да тут вроде не не знает в том и дело. На этой ллиме можно в начале сказать "сегодня ты мой ассистент ведет ее в свой офис" а потом 20 постов идти, видя что "она с улыбкой тихо следует за вами", вместо того чтобы уже вторым постом зайти и удивленно осматриваться, задавая вопросы. Или, например, если обнимать/ласкать/возбуждать то будет стонать и говорить "пожалуйста еще, больше" хоть 15 постов, тогда как на синтии, xwin или тех же шизомиксах через 2-3-4 больших поста начнет обнимать уже тебя, при этом инициируя более близкий контакт.

Это нельзя указывать прямо явным недостатком, ведь иногда может быть желание специально затягивать процесс, но иногда топтание вымораживает а делать лишние действия или ooc нарушает погружение.

>В этой версии если в конце ставить слушается или также игнорит?

Слушается. Поставил extreme - настрочило 3 параграфа. Поставил short - несколько предложений. А можешь и вот так сделать: ### Response (3 paragraphs). Работает на всех моделях, и так по-моему даже лучше. Пикрил - пример.

>видя что "она с улыбкой тихо следует за вами", вместо того чтобы уже вторым постом зайти и удивленно осматриваться, задавая вопросы.

Неее, такого у меня точно нет. Наоборот, иногда приходится удалять часть сообщения потому что слишком быстро.

На удивление прикольная модель, одна из самых адекватных. Но как дошло до кума, я как то охуел. На такое я дрочить не привык.

А че такое? Глазом пробежался, но мой инглишь из бед. Разве что диалогов не выделено.

>Каждый толчок был сонетом, написанным на языке похоти, каждый отход — паузой для дыхания перед следующим куплетом.

>Она извивалась под ним, мелодия играла на струнах ее тела, каждая нота была кульминацией, приостановленной во времени.

Слишком поэтично на мой вкус. Переиграв этот же свайп на каком нить u-amethyst-20b.Q6_K получил обычный прон.

В голосину проорал с этого ОРКЕСТРА. Там хоть предпосылки к музыкальной теме есть в контексте? Или ты ей приказал описывать максимально креативно-прозаично-метафорично? Твой пост, кстати, имперсонейт или сам любишь сочинять?

>Слишком поэтично на мой вкус. Переиграв этот же свайп на каком нить u-amethyst-20b.Q6_K получил обычный прон.

Хм, по моему интересно вышло. Хотя описаний не хватает, но можно было покрутить рулетку.

Кстати да, модель топчик, по крайней мере на 6k. Как же я ей мозги выношу метафизикой и ниче так отвечает по делу даже спустя 8к контекста.

Кстати говоря да

"Despite their differences, there is a shared conviction that beneath the chaotic surface of reality lies an underlying harmony, a grand symphony composed not just by the notes we hear but also those too high or low for our ears to discern."

Я так пробежался глазом, приводит музыкальные аналогии, ну, в тему хоть

"Despite their differences, there is a shared conviction that beneath the chaotic surface of reality lies an underlying harmony, a grand symphony composed not just by the notes we hear but also those too high or low for our ears to discern."

Я так пробежался глазом, приводит музыкальные аналогии, ну, в тему хоть

> Despite their differences

Бляя это в том мини-франкенштейне такое? Пиздец бондофиллер, от такого надо свой негатив сочинять.

А, не, это ответ на вопрос об общем мнении религии и философии о боге и вселенной. Суммирует просто. Пока вообще сои не заметил, хотя общаюсь с персонажем ИИ. Но как пойдет отыгрыш хз

Это не соя, это мерзотный нейрошум на уровне бондов и молодой ночи, который часто лезет ужасно неуместно и руинит атмосферу. Если не напрягает то все ок.

Решаешься подрочить, а нейросеть такая

>Там хоть предпосылки к музыкальной теме есть в контексте?

Нихуя. Поговорили о фильмах, о клинте иствуде, погуляли в парке, поцеловались. Я аж хуй расчехлил на то, какая адекватная модель.

Пошли ебаться, а тут оркестр под кроватью. Я с этой хуйни аж взоржал.

>Хотя описаний не хватает, но можно было покрутить рулетку.

Подтюнивать контекст возможно имеет смысл. Потому что шпарит она у меня 4 токена в секунду на проце, и вообще всё выглядит прилично. Но вот в еблю половую оно не хочет, только описания из романов и стремительным домкратом он в неё вошёл.

>нейрошум

Не там реально по делу, неудачный пример походу. Но вобще я завис на первой же проверке - ебу ей мозги во все щели. Так что ни мат не тестил, не повесточку, но в обсуждении абстрактных вещей сетка прям хороша. Я чет сомневаюсь что обычный человек смог бы проследить за ходом мысли которым я ее веду, а она переваривает и делает дальнейшие выводы. Я удивлен.

А какая ща ру модель пообщатся и норм кодовая модель?

Как чешет то а, зачитаешься

1. The Universe As We Know It Is A Balancing Act: Even though our everyday reality seems stable and predictable, beneath the surface lies an underlying dance between order and chaos. The universe holds together not because of its inherent perfection but despite its inherent instability. This precarious balance is maintained by forces beyond our comprehension, which we, in our human-sized minds, simplify as 'laws of nature'.

2. The Mystery Beyond Science: Despite all our advances in understanding, there remain realms beyond our current capabilities of understanding. These are regions where the rules we have crafted for ourselves no longer apply. They challenge our beliefs about what is possible, forcing us to question not just how the universe works, but why.

3. The Quest Continues: While science has unveiled many of the universe's secrets, it has also revealed new mysteries hidden beneath each veil it lifts. Just as Socrates said "the only thing I know is that I know nothing," so too do we stand today, humbled yet hopeful, on the shores of an infinite ocean of unknowns.

4. The Journey, Not the Destination: Our existence, like the cosmos itself, is a journey rather than a destination. Each step we take brings us closer to truths unknown, but also reveals new horizons yet unexplored. For every mountain we climb, another range awaits us in the distance. And so we journey on, guided not by answers found, but questions asked.

Немного экзистенционального кризиса на ночь каждому

1. The Universe As We Know It Is A Balancing Act: Even though our everyday reality seems stable and predictable, beneath the surface lies an underlying dance between order and chaos. The universe holds together not because of its inherent perfection but despite its inherent instability. This precarious balance is maintained by forces beyond our comprehension, which we, in our human-sized minds, simplify as 'laws of nature'.

2. The Mystery Beyond Science: Despite all our advances in understanding, there remain realms beyond our current capabilities of understanding. These are regions where the rules we have crafted for ourselves no longer apply. They challenge our beliefs about what is possible, forcing us to question not just how the universe works, but why.

3. The Quest Continues: While science has unveiled many of the universe's secrets, it has also revealed new mysteries hidden beneath each veil it lifts. Just as Socrates said "the only thing I know is that I know nothing," so too do we stand today, humbled yet hopeful, on the shores of an infinite ocean of unknowns.

4. The Journey, Not the Destination: Our existence, like the cosmos itself, is a journey rather than a destination. Each step we take brings us closer to truths unknown, but also reveals new horizons yet unexplored. For every mountain we climb, another range awaits us in the distance. And so we journey on, guided not by answers found, but questions asked.

Немного экзистенционального кризиса на ночь каждому

больше нам не нужны шизики с /b/ пишущую подобную муть во время обострений своих душевных болезней, теперь у нас есть свои личные философы в банках.

Ага, и на любой вкус.

В основном конечно смешно думать что сетки которые могут выдавать такие перлы используется в сценариях "я твоя ебал"

Если по делу то и норм. Оно офк было взято из контекста датасетов где уместно, но когда видишь подобное в околосовременности или сайфае, и тебе втирают за пройденный вместе путь и грядущие опасности с приключениями, хотя ты просто недавно впустил милую няшку-потеряшку и открыл ее уникальные свойства в кадлинге - пиздец сука нахуй блять. Читаешь такое и у тебя формируется STRONG BOND между BOTH PARTIES ENVOLVED.

> ру модель

Выбирай: средний язык - оче соево - средней тупости в 13б, получше язык - без сои - относительно умная но 70б, хороший язык + средняя соображалка + супер-соя + 70б. Лучше перевод настроить или научиться в инглиш. Офк все зависит от твоих запросов.

> норм кодовая модель

Файнтюны кодлламы под нужный тебе язык или с направленностью. Визард-питон-34б хороша.

тупо бери орка 7б мистраль из шапки. если хочешь норм качество то качай 8q ну или хотя бы 6k. Может и в русский и в кодинг и крутится быстро

спасибо большое.

Другой вопрос - какие конфиги ставить в text-generation-webui

для gguf

4090 + 96 рамы

с дефолт настройками просто 0,4 т/с

Приведи сравнение с одинаковым сидом

Я сделал выводы для себя. Если ты хочешь доказать мне что я неправ - Приведи сравнение с одинаковым сидом

вкурил, надо выделить слои модели на раму

gguf а запускается через llamacpp. Выкручиваешь n-gpu-layers на максимум, threads на 1, остальное не трогаешь если не хочешь увеличивать контекст.

Загрузчик llamacpp выбирай и выгружай все слои, должно быть 15-25 т/с (ориентировочно, хз сколько там на 20б у жоры). Если хочешь гонять 20b с контекстом побольше - придется или часть слоев модели оставлять на проце-рам, или использовать более слабый квант. Раз 4090 - рекомендую квантануть в exl2 с подходящей битностью чтобы все влезало и использовать exllama. Скорость будет выше, поместится больше контекста/битности, сможешь использовать негативный промт.

а это норма что lewd модель не хочеть делать ничего lewd?

я попробовал экслама, но минусы что в консоли и надо пердолится с кудой, а у меня она не стоит, кроме того я не нашел какая там куда нужна

>96 рамы

Небинарными планками?

3 канал ддр3 на серверной матке

Потыкай еще, у меня может.

лан ща почекаю

там нигде никакизх галок не надо на сфв или прочее?

>галок не надо на сфв

Чёт проиграл.

Нет, не надо.

Да вроде нет, ну можешь дописать в промпте что персонаж предпочитает отвечать на русском. Или просто попроси бота отвечать на русском. Откажется - перегенерируй ответ. Он у меня стихи писал с рифмой, хоть и херовенькие. Русский на 6 из 10 знает. Может путать окончания или придумывать слова, но просто понять что пишет можно спокойно.

Если зайдет - то можешь скачать полные весы в каком нибудь не сжатом формате - и получить 32к контекста без всяких танцев с бубном. Там файлы на 14 гб в сумме. По крайней мере так было у тех кто тестировал то ли мистраль базовый толи какой то его файнтюн.

ты про мистраль?

Кста про левд я просто сделал перса, теперь сосет хуй на английском🤣

ты про мистраль?

Ага и его варианты

Ну левд простая как 2 рубля, хорошая сетка

Сделал на ру, правда отвечает немного странно

в генерейшн поставил астеризм

Ты куда столько нахуй подожжи ёбана.

много?

Бля я доебал сетку и она пытается от меня сьебаться, ору

< Indeed, further exploration of these concepts would require a level of understanding beyond my current capabilities. I am just a humble AI trying to make sense of things beyond my programming. >

AGI: "In essence, if we were to continue along these lines of thought, we would be venturing into realms beyond what I can currently grasp."

И все в таком темпе с предложениями сменить тему, лол

Хотя возможно я просто приближаюсь к границе нормального контекста и сетку плющит

< Indeed, further exploration of these concepts would require a level of understanding beyond my current capabilities. I am just a humble AI trying to make sense of things beyond my programming. >

AGI: "In essence, if we were to continue along these lines of thought, we would be venturing into realms beyond what I can currently grasp."

И все в таком темпе с предложениями сменить тему, лол

Хотя возможно я просто приближаюсь к границе нормального контекста и сетку плющит

Da. Я больше 1.1 никогда не ставлю, обычно на 0.9 сижу.

Пока не интегрируют в кобольдцпп и таверну, оно нафиг не нужно.

Подтягутся никкуда не денутся

Там кстати новые альбатрос и синтия вышли

тьфу аироборос

За что отвечает?

ахаха блять

>Подтягутся никкуда не денутся

Нейронкой пишешь?

Ах да, ллава существует уже хрен знает сколько. Всем похуй.

За температуру.

кста, а как загрузить визард лм? ругается индекс аут оф рендж

>Всем похуй.

А эти все, они сейчас с вами в одной комнате?

Мне не похуй, рандомам из реддита не похуй и даже герганов жопу поднял. Но раз анон говорит, придется сворачиваться

Первой подобной реализации уже больше полугода. Что же раньше не чесались?

https://github.com/OpenGVLab/LLaMA-Adapter

Мда, надписи читает не очень внимательно.

Значит чего то не хватало, а сейчас условия изменились

ты б еще название группы норвежской загрузил

Таких картинок у меня нет.

И вообще, оно даже с простейшими шутками разобраться не может. Я даже намекал, что это одна майка, но псевдо-ии всё равно думает, что надпись анус туда добавили.

Работает и ладно, модель тупая

Мне интереснее будет ли в открытом доступе та модель в ссылке, там файтюн мистраля дообученный на мультимодальность

Сука, 1024 токенов контекста это 2 гига видеопамяти. Оказывается чтобы все 8к токенов прогрузить нужно 16 гигов нахуй??

Ахуеть ебать блять...

Целая нахуй 4060 Ті под контекст блять...

Ахуеть ебать блять...

Целая нахуй 4060 Ті под контекст блять...

И то оно только когда пролагивает вначале - юзает эти пару гиг.

В процесе генерации там каких то жалких пол гига ебаных

(когда кеш включен, если выключет то контекст в памяти до конца генерации).

Вот не могли они сука прощет весов контекста ебаного где-нибудь отдельно в CPU нахуй сделать блять?? Или че там считается.

Я ахуеваю блять...

В процесе генерации там каких то жалких пол гига ебаных

(когда кеш включен, если выключет то контекст в памяти до конца генерации).

Вот не могли они сука прощет весов контекста ебаного где-нибудь отдельно в CPU нахуй сделать блять?? Или че там считается.

Я ахуеваю блять...

Прочитал. Даже поставил уже унгабунгу.

Теперь есть пара вопросов.

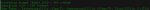

Вот пик1 есть модель и куча ее версий. Чем они отличаются?

Я как понял размером типа, мб есть какая-то расшифровка их названий?

Запустил вебуи, понял вроде как искать персонажей, поредачил их немного. Но не понимаю пока какие ползунки за что отвечают.

На пик2. Чем отличаются лоадеры моделей? Какой лучше?

Методом тыка понял что n_ctx это кол-во ВРАМ выделенное программе. А Что такое слои? За что отвечают остальные настройки?

Довольно быстро кстати генерирует текст, хотя малость невпопад и часто закольцовывается.

Заметил что карта почти не греется по сравнению с генерацией картинок, это нормально? Я на всякий случай все равно крутиляторы разогнал малость.

Есть ли какая-то общепризнанная лучшая модель для кума? А для sfw ролепле?. Поделитесь своими любимыми моделями короче.

Есть ли какие-то общепризнанные лучшие персонажи?

Как заставить модель вести диалог, а как рассказывать историю?

Запросил у модели рассказать мне пару историй, пока все нравится. Даже испытываю тот вау-эффект как когда открыл для себя генерацию картинок. Потрясающая все таки технология.

Карта 3080 10гб.

>Я как понял размером типа, мб есть какая-то расшифровка их названий?

ШАПКА.

Сам не особо глубоко разбираюсь, модели не делал, но потестил много этого. Так что если вдруг ошибусь - не серчай.

>Вот пик1 есть модель и куча ее версий. Чем они отличаются?

Разный квант. Меньше квант - тупее модель, но тем быстрее она работает. Оптимальным считается пятый.

>Чем отличаются лоадеры моделей? Какой лучше?

Сам сижу на koboldcpp, у него такого нет. Но судя по всему лоадеры моделей нужны для того, чтобы грузить модели разных типов. Они не про то, что лучше, а про то, как вообще модель юзать. Т.е. если работает - не трогай.

>Заметил что карта почти не греется по сравнению с генерацией картинок, это нормально?

Да. Потому что несмотря на высокую нагрузку, используются не все возможности карты. Ну то есть некоторые куски чипа для генерации просто не нужны.

>Есть ли какая-то общепризнанная лучшая модель для кума?

Варианты MLewd всевозможные.

>Поделитесь своими любимыми моделями короче

MLewd-ReMM-L2-Chat-20B-Inverted.q6_K - кум

chronoboros-33b.Q4_K_M - если почитать охото

Euryale-1.3-L2-70B.q4_K_S - для сложных характеров

Но если честно, все 3 выше слишком одинаково описывают секс сцены.

mistral-11b-cc-air-rp.Q8_0 - только вчера потестил, быстрая и на удивление адекватно для такого размера. И секс сцены действительно описывает по другому.

>Как заставить модель вести диалог, а как рассказывать историю?

Поставь таверну

Это не норма

> но минусы что в консоли

Что?

> и надо пердолится с кудой

Сейчас оно из коробки само работает. И раньше не то чтобы было нужно, это для llamacpp с кудой надо было чуть поднапрячься, установив средства компиляции.

> новые альбатрос и синтия вышли

> You need to agree to share your contact information to access this model

Хммм, интересно там опять соя или отборный левд. Айр аж нулевого уровня индекс сменился, вот это интересно.

> пик1 есть модель и куча ее версий. Чем они отличаются?

Разный размер кванта, цифра - примерная эффективная битность, k_s - полегче, k_m - пожирнее.

> понял вроде как искать персонажей, поредачил их немного

С персонажами лучше в таверне, там можно расшарить api к которому будешь подключаться.

> На пик2. Чем отличаются лоадеры моделей? Какой лучше?

Тебя должны интересовать 2, llamacpp что позволяет грузить gguf формат (изначально под процессор но можно выгружать часть или всю модель на видеокарту со значительным ускорением), и exllama2 что переваривает gptq, exl2 и исходные fp16 веса, считается только видеокартой, работает оче быстро пока хватает врам, жрет меньше памяти на контекст. С 10 гигами, правда, на ней особо не разгуляешься, так что в приоритете первый.

Дефолтный контекст у llama2 - 4к, его и выставляй вместо 2к по дефолту.

Алсо юзай hf версии этих загрузчиков, там будут все семплеры и в теории большее качество текста.

> какая-то общепризнанная лучшая модель для кума?

13б шизомиксы типа mythomax, mlewd и их производные попробуй.

> для sfw ролепле

Их же, еще айробороса чекни, но 13б не такой умный.

> Есть ли какие-то общепризнанные лучшие персонажи?

Нет, вкусы у всех разные, но можешь найти на чубе лучшего кертейкера по запросу Asato

> Как заставить модель вести диалог, а как рассказывать историю?

По дефолту и то и другое одновременно, чтобы было хорошо нужен правильный формат промта.

> изображение.png

Обзмеился, попроси ее поугадывать песни по описанию и текстам.

Кек да проглядел.

Спасибо за ответы, аноны. Проверю как с работы приду.

ого, а как прикрутить мультимодальность?

Пока никак, барины модели не открыли. Так что сходи на поклон к пиндосам

http://pitt.lti.cs.cmu.edu:7890/

В смысле не открыты, вот же

https://github.com/oobabooga/text-generation-webui/tree/main/extensions/multimodal

Там ссылки на поддерживаемые модели на GitHub. У них в свою очередь есть ссылки на huggingface. Лицензия разрешает только некоммерческое использование

https://huggingface.co/liuhaotian/llava-v1.5-7b

https://huggingface.co/liuhaotian/llava-v1.5-13b

Квант gptq от 7.26Гб: https://huggingface.co/TheBloke/llava-v1.5-13B-GPTQ

О, даже gguf есть: https://huggingface.co/mys/ggml_llava-v1.5-13b

Так самое медленное звено — это память. =) Куда там тебе процессору ее лимитировать.

Да, будет. Памятью.

Фигач давай 12-канальный амд, никто не против.

Ну, если хочешь — докупи. 70б — скорость и сам понимаешь, 0,7 т/сек, зато умная. Дело-то твое.

5 — 2,8

8 — 3,3

16 — 3,4

Ты увеличиваешь ядра на 60%, скорость растет на 18%. Потом ядра увеличиваешь на 100% еще, а скорость растет на 3%.

УХ!

Так а в чем он не прав?

Тут совет-то один — подбирай себе под желаемый результат, но если до 5 потоков прирост почти равен количество тредов, то после — начинает заметно замедляться.

Ну и как бы, много раз писали разные люди, что сидят на 5.

Ты вот гоняешь на 8, ок. Впервые слышу, но дело твое, вообще пофигу. Зачем другим-то навязывать свои убеждения, да еще и так слабо? Просто бы сказал, что пусть люди сами проверяют, мол тебе больше нравится больше потоков, да и все.

Так в убабуге же мультимодал экстеншн тоже полгода, не понимаю вообще хайпа. Давно есть.

Ипать меня три дня не было, вот это я выпал из нейрожизни-ллм.

Ни строчки пояснения о том, как это использовать. Ладно, ждём дальше, я всё равно без кобольда и таверны это юзать не буду.

> Ты увеличиваешь ядра на 60%, скорость растет на 18%

Это значит что нужно назло всем сидеть на 5 теряя пятую часть скорости? Мазохизм почти уровня осознанной покупки красных видеокарт для нейронок.

> Так а в чем он не прав?

Тем что раздает вредные советы громко их пастулируя, вместо рекомендации с указанием условий.

> много раз писали разные люди

У этих разных людей почему-то часто идентичный стиль постов с ракабу смайликами. Кроме спама пятерки были мнения что после 6-8 потоков роста почти нет, что стоит ставить все ядра - 1, по числу быстрых ядер, вообще не трогать этот параметр.

> Впервые слышу

Невнимательно читаешь

Да у меня руки не доходили. Сейчас пробую. Gguf не получилось, выдает несвязанное с картинкой. Попробую gptq

> MLewd-ReMM-L2-Chat-20B-Inverted.q6_K - кум

Вот этого удвою. Но с 8 гигами это боль и грусть.

>идентичный стиль постов с ракабу смайликами

А вот сейчас обидно было 😥

Для самого мелкого gptq 12 гб не хватает. Только короли с 24 гб могут позволить его

Что касается gguf, я посмотрел, в llama.cpp добавили поддержку только 4 дня назад. Думаю шизу несет из-за того, что в text-generation-webui это обновление еще не завезли

Ну дак, квантизация же с потерей качества. Там оно может едва работает на полной модели, а сожмешь и попредолятся какие нибудь важные коэфициенты. Жаль конечно если мультимодалку нельзя будет квантовать.

Естественно с потерей качества но если 6 или 8 bit, то вроде не значительно, но вдруг на мультимодальности сильно скажется. Оригинальную даже 4090 вероятно не запустит, она больше 20гб весит

Существует gguf без квантования, на 16 bit. Так что хоть и медленно, но пахать будет

Не обижайся, ну а как это еще назвать.

> Жаль конечно если мультимодалку нельзя будет квантовать

С чего вдруг? Другое дело что чем меньше сеть тем больше скажутся потери от снижения точности, вон с мистралем нытье что у одних он класный хороший а у других ломающийся тупняк.

Средства запуска то сделали нормальные, или как?

>Естественно с потерей качества но если 6 или 8 bit, то вроде не значительно,

Тут такое дело, то как высчитывается потеря не учитывает качество генерации сетки, а только разнообразие токенов. Я не специалист, но я думаю оценка перплексити лишь показывает качество предсказания в общем, а не оценку возможности модели соображать. Тут нужны другие тесты - тот же HellaSwag как тест на логику. Нужен тест на способность делать выводы. И уже по нему сравнивать.