оп, дрёмбудка давно уже на 16 ГБ едет, если речь о полторашке. Вот сдохля - там да, 20 минимум, ЕМНИП.

> дрёмбудка давно уже на 16 ГБ едет, если речь о полторашке

А в прошлом ноябре-декабре спокойно крутилась на 12.

мимо

аноны кто пользуется готовой кохой на васт.ай, помогите подключить логи. инстанс походу тупо перетащили с рунпода, видимо есть некоторые отличия. лог по команде tail -f /workspace/logs/kohya_ss.log не работает. подключил setup.log из кохи , но он не выдаёт прогресс тренировки, только первые команды.

Чел, с такими тупыми вопросами не пищи сюда.

Ну вот кто будет копаться в левых васянских покакуньках? Возьми да запили свой контейнер, и засунь в него коху с нуля. Я лог вообще смотрю в консоли, например, а сессию держу открытой через tmux, так что могу подключаться и отключаться когда захочу.

Готовый контейнер нормально работает, заводится быстро. Можно и не пилить свой если кто-то уже сделал.

Какой же коха дегенерат, столько времени убил на казалось бы простые вещи, которые надо юзеру сразу говорить.

Во-первых, блядские bucket, за каким-то хуем коха всегда ресайзит неквадратные пики, а если отключаешь bucket - кропит до квадрата. Вот у меня есть пики 768х1024 в датасете, я ставлю разрешение обучения 768, а они даунскейлятся до 640р. Что ещё хуже - если я поставлю разрешение 1024, эта хуита их заапскейлит, алгоритмом nearest. Хорошо хоть можно прописать костыль --bucket_no_upscale и ёбнуть разрешение обучения побольше, чтоб эта пидорасина не трогала мои пики. Остаётся только догадываться сколько лор запорото этим говном.

Во-вторых, про тренировку конволюшенов. Где-то в кишках документации ликориса хотя бы пик2 есть, но ни слова почему - просто возьмите такой-то пресет, нет времени объяснять. Потратил кучу времени чтобы выяснить какие слои конволюшенов вызывают пережарку и распидорашивание - это ебучие конволюшены в двух крайних ResNet с обоих концов сетки, естественно у кохи они тренируются. Опять надо костылить и отключать их через список conv_block_dims. У ликориса, кста, крайние ResNet нельзя выключить, ты либо тренишь конволюшены, либо нет, заебись. Алсо, лоры и так не тренируют все 25 слоёв, не понятно почему в ликорисе придумали тренировать конволюшены, но не протестили какие лучше не надо трогать, как это было сделано изначально с ванильными лорами.

Во-первых, блядские bucket, за каким-то хуем коха всегда ресайзит неквадратные пики, а если отключаешь bucket - кропит до квадрата. Вот у меня есть пики 768х1024 в датасете, я ставлю разрешение обучения 768, а они даунскейлятся до 640р. Что ещё хуже - если я поставлю разрешение 1024, эта хуита их заапскейлит, алгоритмом nearest. Хорошо хоть можно прописать костыль --bucket_no_upscale и ёбнуть разрешение обучения побольше, чтоб эта пидорасина не трогала мои пики. Остаётся только догадываться сколько лор запорото этим говном.

Во-вторых, про тренировку конволюшенов. Где-то в кишках документации ликориса хотя бы пик2 есть, но ни слова почему - просто возьмите такой-то пресет, нет времени объяснять. Потратил кучу времени чтобы выяснить какие слои конволюшенов вызывают пережарку и распидорашивание - это ебучие конволюшены в двух крайних ResNet с обоих концов сетки, естественно у кохи они тренируются. Опять надо костылить и отключать их через список conv_block_dims. У ликориса, кста, крайние ResNet нельзя выключить, ты либо тренишь конволюшены, либо нет, заебись. Алсо, лоры и так не тренируют все 25 слоёв, не понятно почему в ликорисе придумали тренировать конволюшены, но не протестили какие лучше не надо трогать, как это было сделано изначально с ванильными лорами.

>Какой же коха дегенерат

Сейчас бы не прочитать доокументацию, пользоваться не гуи от Кохи, а потом бомбить..

> доокументацию

Как будто у кохи она есть. В ней ни слово про то как надо делать, только описание параметров. Про то что он апскейлит пикчи говном можно только в коде узнать, а про конволюшены только проверив.

> гуи

Только хлебушки пользуются гуем от васянов, там уж точно про такое никто никогда не слышал, тренят как есть, а потом веса лор ставят 0.5-0.7, фактически выкидывая половину натрененого потому что говняк в паре слоёв пидорасит пикчу.

Добрый день мне понравился https://app.textcortex.com, но он платный кто-нибудь знает аналоги реальные? Именно аналоги, а не просто похожие чаты.

Было бы неплохо свести это в пасту, чтобы усилия не пропали зря. Только объяснив внятно.

> ставлю разрешение обучения 768

> подает на вход 886

> Почему он ресайзит или кропает?

Ебать ты, оно даже пишет все наборы разрешений которые получаются и про это вроде где-то написано.

Но момент действительно может быть показаться неочевидным, двачую

> Опять надо костылить и отключать их через список conv_block_dims

Раз тестировал, есть иллюстрация сравнения с ними и без них? Ликорис сам по себе странный, дефолтная реализация кохи лучше работают по ощущению.

В других слоях подобного не проявлялось, или еще какие-то выявил?

> Потратил кучу времени

Вбрасывай если замечаешь не стесняйся, другие подключатся и быстрее будет в худшем случае дебилом назовут

https://genforce.github.io/freecontrol/

Какой-то новый контролнет. От китайцев? Корейцев?

Пока без кода.

Кто разбирается - почитайте, расскажите, в чем там разница.

Какой-то новый контролнет. От китайцев? Корейцев?

Пока без кода.

Кто разбирается - почитайте, расскажите, в чем там разница.

Очередной контроль во время семплинга. Можешь посмотреть на FreeDoM, уже был ранее. Нахуй не нужно из-за скорости.

https://github.com/vvictoryuki/FreeDoM

Товарищи из КНР навалили годноты: любая анимация для персонажа, любой шмот на персонажа... Теперь можно сгенерировать по референсу любого персонажа в любой нужной позе, одеть в шмотку, сделать анимацию по шаблону, взятого из любого видео, - и всё это внутри одного workfow.

Это особенно радует меня как сторонника тотальной рандомизации (аатоматизации) в создании ИИ-арта.

Это особенно радует меня как сторонника тотальной рандомизации (аатоматизации) в создании ИИ-арта.

Где?

А, вот ты о чём. Ну так-то зирошот методов для пикч и раньше немало было, эта хуитка просто для видео.

Будущее - за видео

Nope

Разве что только будущее. В настоящем разве только за движухой следить, пока что покакуньки кривые до ужаса.

Я больше за трёхмеркой слежу. Вот тут реализуется новьё: https://github.com/threestudio-project/threestudio

Как они хитро ни на одном пике топологию не палят.

Потому что это те же покакуньки что и в видео, в юзабельных мешах вообще конь не валялся пока. Там вообще большинство в не-полигональных представлениях работает, полигоны если и выводить то классическими методами. А так гауссовы сплаты в анрилах с юнитями есть, не удивлюсь если рано или поздно их станут применять напрямую для каких-нибудь специфических элементов сцены.

>вообще конь не валялся пока

Не скажи, работы ведутся. Через вокселизацию перегоняют в полигоны. И это на самом деле самое перспективное направление. Зачем кинематограф, художники, игори, когда весь контент можно генерировать на ходу по запросу, перестраивать сюжеты, внешний вид, выбирать удобный ракурс, если предложенный нейросетью не понравится.

https://developer.nvidia.com/blog/omniverse-kaolin-app-now-available-for-3d-deep-learning-researchers/

>рано или поздно их станут

Рано или поздно - да. Но не ближайшие 10 лет, там расход пяти ебический, а кожаный, как всегда, зажопил.

> это на самом деле самое перспективное направление

Никто уже так не делает, зачем ты притащил протухшую статью. Брутфорс вокселями очень медленный и имеет кучу проблем с мелкими деталями. Уже давно придумали gaussian splatting.

https://gsplat.tech/excavator/

Вокселизацией можно замешить кое-как, но юзабельным для риггинга это всё равно не будет, там надо учитывать топологию для анимации.

>Но не ближайшие 10 лет, там расход пяти ебический

Хуйня, как раз модная тема это эффективные репрезентации, жрущие всё меньше и меньше. В ближайший год-два может уже стать юзабельным для каких-нибудь вспомогательных штуковин, если так пойдёт.

У жужла другой интерес от 3Д - ресинтез фоток. Синтезируют 3Д представление из нескольких 2Д фоток, затем перегоняют обратно в 2Д. Таким образом можно снимать на смартфон в темноте с гораздо меньшим количеством мыла, свойственного даже стаку в GCam. Правда тоже пока не лезет в смартфонное железо, но скоро будет.

Есть ещё риэлторские конторы, заинтересованные в виртуальных турах по хате, полученных из допустим сотни фоток, им тоже полигоны нахуй не нужны.

Так про них и речь. Только как ими замешить? Гауссовы сплэты это просто облако точек, в котором каждая точка имеет цвет/альфу/размер/ориентацию.

>gaussian splatting

Для реального использования бесполезно.

>заинтересованные в виртуальных турах по хате

В этой гауссовой залупе невозможно просчитывать освещение, только запеченное с картинки. А если клиент захочет лампы-фонари, приглушить освещение? Уже всё, нужны полигоны.

> Только как ими замешить?

SuGaR есть из свежего, до этого ещё несколько алгоритмов было. Но ещё было бы зачем, к сплатам уже анимации и физон даже прикрутили, у мешей производительность рендеринга сильно хуже чем у сплатов.

>В этой гауссовой залупе невозможно просчитывать освещение, только запеченное с картинки. А если клиент захочет лампы-фонари, приглушить освещение?

https://shunsukesaito.github.io/rgca/

Ну и вообще, потанцевала дохуя. С нейронками к этим штукам можно много чего прикрутить, от анимации до интерактива и нейро-имитации рейтрейсинга. Но это всё будет не скоро, если вообще будет.

>к сплатам уже анимации и физон даже прикрутили

Анимации там пока что запечённые, нет интерактива.

>у мешей производительность рендеринга сильно хуже чем у сплатов

Не у мешей скорее, а у всего комплекса в целом, надо ещё смотреть как сплаты будут перформить в полноценных играх, если они вообще доберутся до них. А то облака точек уже лет 15 пророчат, а воз и ныне там.

Может так статься что протегированные меши и скелеты, обрисованные через контролнеты (условно говоря) темпорально стабильной нейронкой, будут быстрее и гибче и того и другого. Как тут https://isl-org.github.io/PhotorealismEnhancement/

а может и не статься

>https://shunsukesaito.github.io/rgca/

А эта штука основана на обучении. Никакого рилтайма, замены объектов на лету, всё приколочено гвоздями и требует очень, очень много времени на подготовку. То есть потанцевал околонулевой. Ну, для кинца ещё может быть, но памяти жрёт как не в себя.

Вообще, оно уже тоже "протухло". Было год назад на выставке меты.

https://www.youtube.com/watch?v=2mnonWbzOiQ

>А эта штука основана на обучении.

https://nju-3dv.github.io/projects/Relightable3DGaussian/ рейтрейсинг напрямую на сплэтах

>В этой гауссовой залупе невозможно просчитывать освещение, только запеченное с картинки.

А там нет ничего запрещающего кастомное освещение. Это же просто облако анизотропных пиздюлинок, можно его как обычную поверхность юзать для шадоумаппинга, рейтресинга, AO всех сортов и мастей и т.п. Там главное интерактив, физон и т.п. движение/коллизии/симуляция - можно это обеспечить обычным риггингом.

>bounding volume hierarchy

Это не вокселизация случайно? И, опять же, оно не рилтаймовое.

>Pre-processed DTU

>For real-world DTU data, we follow the Vis-MVSNet to get the depth maps and then filter the depth map through photometric and geometric check. We then convert the depth map to normal through kornia. And we get perfect masks from IDR.

Восемь гигов предварительно запеченных данных.

>рейтресинга

Денойзер ебанётся. АО тоже, все алгоритмы заточены на детект краёв, а в этом облаке заебёшься искать, где краёв нет. Физика похуй, там всё равно используются упрощённые меши, можно на основе тех же объёмов генерировать меши для физики. Да они, по сути, и не нужны, всё равно деревья на основе тех же объёмов под капотом. На счёт ригинга не уверен, GPU ускорение отваливается, всё либо на вычислительных шейдерах, либо вообще на CPU, что гарантированно медленнее существующих решений. И без поддержки старых карт.

>Это не вокселизация случайно?

Это та самая хуйня которую RTX призван аппаратно ускорять

Легкий/удобный способ конвертировать имя с пиксива на бурятском или id в общепринятые теги существует?

В итоге https://danbooru.donmai.us/artists основное покрывает, есть api с приемлемым рейтлимитом.

аноны посоветуйте параметры дримбудки дл sdxl

датасет человек, 20 фото, качество норм, разные, капсы подробные

сколько стоит поставить повторов, всего шагов, LR?

датасет человек, 20 фото, качество норм, разные, капсы подробные

сколько стоит поставить повторов, всего шагов, LR?

>датасет человек, 20 фото

10 фото.

Спасибо

LR дефолтный 1e-5 не много?

> 20 фото

> дримбудки

Надеюсь, ты про лору хотябы?

Такой норм, ставь 250 шагов и тестируй накидывая по 50

Дримбут дает лучшее качество чем твои говнолоры куцые. Конечно, не у каждого есть боярские 10 гигов на модель.

нахуй лору ебаную

дримбут полноценный

если уж очень надо лору можно потом из будки выдернуть. хотя лучше натренить будку на нужной модели.

> 20 фото

> дримбут полноценный

> лору можно потом из будки выдернуть

Обучение лоры и ее извлечение - разные процессы и качество результата также будет отличаться в зависимости от конкретного случая, описанный подход - провальный.

Хочешь страдать - ебись. Нынче много любителей познать все ошибки на себе, не меньше и тех кто будет хвастаться своими идиотскими поступками.

На всех лорах перекошенные ёбла. Они всегда были компромисом. Для тренировки лица на дримбуте 10 фоток достаточно. Особенно если брать ванильные модели, где с весами все хорошо.

Покежь результат на 10 фото. Вангую что выйдет хуйня.

Дело не в гигах, а в невозможности потом композить несколько в одной пикче. Тогда уж локон делать, или что-то более продвинутое.

> На всех лорах перекошенные ёбла

Проблема в обучении какая-то. Даже на циве большое количество реалистичный лор, которые работают прилично. Будка переломает все остальное и обойдется огромной ценой, лучше решить проблему чем заправлять шубу в трусы.

у меня с одним и тем же датасетом дримбудка дает однозначно лучший результат, чем лора. и лору, и будку тренил на разных параметрах.

боярином не обязательно быть, 4090 на васте менее 50 центов в час. за час можно успеть всё завести и натренить будку в 2000 шагов в сдхл.

боярином не обязательно быть, 4090 на васте менее 50 центов в час. за час можно успеть всё завести и натренить будку в 2000 шагов в сдхл.

>На всех лорах перекошенные ёбла.

На моей лоре охуенно получается лицо. Но я вам ее не покажу потому что это лора еотовой и существует поиск по лицу, не хочу чтобы она знала что кто-то генерит миллионы ее нудесов потому что из ее знакомых таких может быть 1,5 человека. Но что сука характерно - делал наугад и в первый раз, потом пробовал по гайдам и получалось говно. Надо расковырять лору и достать настройки, но вроде бы в большинстве они были стандартные, 1 эпоха, 200 фото 512х512 с включенным Flip augmentation по 100 интераций на каждую и адамв потому что от 8 бит мое железо скукоживается. Еще я смутно припоминаю что мог увеличить LR на еще один 0 после точки.

Ебать ты крип, я б тебя скрысил

SDXL с настройками, позволяющими влезть в 24 гига, нихуя не запоминает нормально.

А другие типы лор? Тот же локон.

Значит ты тренишь через жопу.

> локон

Он наоборот для дампинга тренировки.

Иногда кажется что в фетишах совсем обдвачевался, но потом видишь такое.

> с настройками, позволяющими влезть в 24 гига

Ты про gradient checkpointing? Он ухудшает качество тренировки а не просто ее замедляет?

>Иногда кажется что в фетишах совсем обдвачевался, но потом видишь такое.

Ты не знаешь насколько глубока кроличья нора.

Кто-нибудь знает нейронку для смены эмоций на фото. Такие вообще есть даже во всяких инстаграм масках, но что-то опенсорсного с ходу не нахожу

Это ЕОС, не трогай.

В комфи забабахай конвеер - ip-adapter пересаживает то же самое лицо под управлением контролнета с mediapipe физиономией

Это не правильно. Использовать sd просто для смены эмоции. На телефоне инстаграм далеко не sd гоняет

Правильно или нет, главное результат. Специфичных открытых сеток для этой задачи не знаю, знаю только универсальные.

LAION-5B убрали из онлайна, ибо нашли в нём цопэ. а они быстрые, ещё бы в 5.8 миллиарда пикч со всего интернета не затесалось

https://www.404media.co/laion-datasets-removed-stanford-csam-child-abuse/

https://www.404media.co/laion-datasets-removed-stanford-csam-child-abuse/

Фрики не удивляют, есть и больший пиздец. А то, насколько поехавшими могут быть нормисы, преподносит сюрпризы.

Вот это лолита, выходит его зеркала - распространение?

Похуй, DataComp качественнее даёт результаты после обучения.

Слушай, братишка, мы все так или иначе нет-нет да удовлетворяем себя глядя на кого-то или представляя кого-то. У меня вот шишка колом на одну тян, но она замужем и влезать третьим не в моих правилах. Кроме того даже если бы она была одна - это все равно вариант без перспектив, потому что вместе я нас не вижу при любом раскладе. Что плохого в том что я стираю шишку в одиночестве на AI-генерации нудесов этой тян, при том что это является только моим маленьким секретом и кроме меня об этом никто никогда не узнает? Чем принципиально отличаются генерации на какую-нибудь Эмму Ватсон не будем упоминать что она светанула сиськи и трусы, Бель Дельфин не будем вспоминать про онлифанс или сорт оф, на которых тоже есть лоры? И в конце концов тысячи кулстори когда одна тян просит починить комплюктер/телефон из которого сливаются ее нудесы inb4 Желева - чем это принципиально отличается? Не этично? Возможно. Но вред это может принести только если это окажется в публичном доступе, но в этом мне интереса нет. Что же до нормисов - у всех есть загоны, выходящие из ряда вон. Даже их отсутствие на фоне прочих - это тоже девиация.

А между тем я пытаюсь вспомнить и повторить настройки, с которыми была натренена лора. Если получится - я вам их принесу.

Это да, лаион по сути гигантский скрейп говна с минимальной инженерией. (эстетический скор который нихуя не фильтрует)

Да один хуй, почистят и вернут.

>выходит его зеркала - распространение?

Если нефильтрованные - да, очевидно.

Да вообще без осуждения, каждый дрочит как хочет. Просто настолько преисполнились поехали, что подобные простые вещи вызывают удивление.

автоматик добавил fp8 вычисления, неплохо экономят память для SDXL, для 1.5 результаты не такие заметные

на рендерах слева fp8 вкл, справа выкл, разница есть, но небольшая

на рендерах слева fp8 вкл, справа выкл, разница есть, но небольшая

Уже месяц как.

В этом режиме кстати помедленнее на 1.5 работает, чем в обычном fp16. По крайней мере при замере на дефолтных 512 шакалах

разницы не заметил, возможно от видеокарты зависит

у кого скорость повысилась от этого hypertile? у меня что-то нет. перезапускал SD конечно же.

Миджорня тем временем продвинулась настолько что в ответ на промпт непосредственно выдает картинки на которых обучалось. Еще немного и сбудется моя мечта, можно будет использовать нейросетки с моделью в качестве оффлайнового поиска по картинкам, без этой вашей генерации шестипалых уродов.

Оверфит бывает везде, вопрос в том как его найти.

>можно будет использовать нейросетки с моделью в качестве оффлайнового поиска по картинкам, без этой вашей генерации шестипалых уродов.

Для этого нужно параметров в сотни тысяч раз больше, и сетку перетренить так что она всё запомнит.

О, это чтобы копирастам было проще набутылить тебя за использование их закопирайченной собственности. Найс.

Деградирует же.

>параметров в сотни тысяч раз больше, и сетку перетренить так что она всё запомнит.

Я верю в миджорни

обнаружил, что тензорное смешение двух схожих моделей отфайнтюненых даже через трейндифренс по итогу увеличивает консистенцию результата и качетсво ответа на токен, ничеси приколы

>в качестве оффлайнового поиска по картинкам

Это другая тема, про хранение информации в нейронках

Сап двосч. Подскажите, пожалуйста. У меня есть большой текст. Я натренил его на tesorflow. Но выдает он не то что можно. Как я могу дообучить какую-то крутую модель своему тексту? Есть гайд для тупых? Lora только для картинок или так же можно текст тренировать?

Сап двосч. Подскажите, пожалуйста. У меня есть большой текст. Я натренил его на tesorflow. Но выдает он не то что можно. Как я могу дообучить какую-то крутую модель своему тексту? Есть гайд для тупых? Именно для теста. Странно, я вроде заплатил уже и не увидел свой пост. Как-то потерся

Всем привет! Может кто-то поделиться пример дообучения какой-то сети на своем тексте?

Поздравьте меня. Натренировал своё первое Lora. 10 эпох, сутки. Сейчас пойду смотреть как работает.

Аноны, а подскажите, пжлста, если я хочу на мохнатую вагину натянуть эротические трусы, то это мне как такой датасет подготовить для лоры? Фоток таких для обучения у меня, естественно что, нет.

Есть только фотки, получается что:

1. Мохнатых вагин

2. Вагин с обычными трусами

3. Эротических трусов.

Как такое обучается?

Есть только фотки, получается что:

1. Мохнатых вагин

2. Вагин с обычными трусами

3. Эротических трусов.

Как такое обучается?

для того, чтобы в итоге получить возможность генерировать эротические трусы на мохнатых вагинах, датасет тоже ложен быть из пикч с эротическими трусами на волосатых пездах.

Поищи то, что тебе подходит в паках ATKHairy на порнлабе или где получится найти.

Ты тренить для SD или XL собираешься?

>Аноны, а подскажите, пжлста, если я хочу на мохнатую вагину натянуть эротические трусы, то это мне как такой датасет подготовить

Удали фон трусов до прозрачности и кинь их на свою пизду в фотошопе, затем обработай имидж ту имидж чтоб убрать швы. Можешь обойтись без фотошопа, нарсисовов труселя руками в маске.

Зачем для этого обучать, инпеинтом не получается, что ли? Если нужно конкретную модель трусов - IPAdapter'ом перенеси.

https://github.com/rockerBOO/lora-inspector пробовал кто-нибудь? Что скажете?

Нужно выдернуть настройки, с которыми обучалась лора, потому что методом тыка повторить не удается, а результат получился заебись.

Нужно выдернуть настройки, с которыми обучалась лора, потому что методом тыка повторить не удается, а результат получился заебись.

аноны, поделитесь, плиз, работающей SDXL inpaint моделью для автоматика.

все, что пробовал, либо не загружаются, либо выдают черное пятно в месте инпейнта.

все, что пробовал, либо не загружаются, либо выдают черное пятно в месте инпейнта.

К сожалению автоматик их не поддерживает. Наверное в будущем добавят, хотелось бы иметь возможность, вдруг она может более сложные вещи адекватно понимать

спасибо!

Так посмотри просто в интерфейсе автоматика, или в адднетах

Стабилити ведь не релизили инпеинт модель для хл, откуда ты взял вообще что она существует? На 1.5 и 2.0 вижу, а к хл так до сих пор и нету

Когда в кохе в поле "Model Quick Pick" указывается runwayml/stable-diffusion-v1-5 - что она грузит? v1-5-pruned или v1-5-pruned-emaonly? Или что? Или куда сохраняет чтобы посмотреть? В tmp чет не нашел.

пытаюсь смержить 2 лоры в одну но не понимаю что я должен в "save to" указать так или иначе выдает еррор, не уверен что это в целом должно так работать или какие еще есть способы это сделать

Если они были записаны в метаданные, то эти настройки проще в Авто найти. Там ж есть кнопочка для показа всех метаданных на миниатюре для лоры.

Если настройки не были записаны - никакой плагин тебе нифига не вытянет.

Так целиком путь пропиши. Типа E:\LoraMerge.safetensors

Или что-то вроде того.

Можешь вообще супермеджер накатить.

>Так посмотри просто в интерфейсе автоматика, или в адднетах

>есть кнопочка для показа всех метаданных на миниатюре для лоры

Так он мне через интерфейс показывает "ss_color_aug": "False", а через инспектор "ss_color_aug": true лол. И хуй знает кому верить.

Он грузит диффузоры в папку %userprofile%\.cache\huggingface\hub\

Спасибо. Добра.

avr_loss=nan ето плохо? Кое-где в инторнетах пишут что плохо, и что обучение можно килять. В другом месте пишут что норм и это потому что шедулер используется другой, а в третьем к шедулеру прибавляют проблемы bitsandbytes. А по факту что?

Если одиночный, то жить можно. Если все пошли NaN, то лору в мусорку. При нормальном обучении он никогда таким не будет, это определённо признак кривых рук.

Это пиздец означает, можешь заканчивать обучение

У меня с самого начала обучения nan лол.

а как интегрировать эти 4 файла в автоматик?

Здравствуйте, я новенький, а что здесь надо делать?

Как я понял, качаешь патч https://github.com/AUTOMATIC1111/stable-diffusion-webui/pull/14390.diff, и в ветке master с помощью git apply ставишь. Сам делать не буду, подожду 1.8, или где его добавят в релиз

спасиб, попробуем

Полгода будешь ждать, пока его в мастер пульнут. В дев, наверное, быстрее, но каломатик с 17 декабря хуи пинает.

Есть тут кто с амуде 6800ХТ или 6900ХТ

Какую модель посоветуете, за сколько у вас изображение генерится?

У меня щас за 20 сек на турбо хл 512х512 20 шагов, можно ли быстрее?

Есть ли гайд какой то по пердолингу настроек для амуды в виндоусе?

Какую модель посоветуете, за сколько у вас изображение генерится?

У меня щас за 20 сек на турбо хл 512х512 20 шагов, можно ли быстрее?

Есть ли гайд какой то по пердолингу настроек для амуды в виндоусе?

>6900ХТ

>для амуды в виндоусе

Ты же судя по карте не нищеброд как я, купи отдельный SSD и сделай дуалбут с линуксом.

Я ваще не шарю в этой хуйне, это жестко пердолиться придется? У меня как раз лежит нераспечатанный ссд на 500 гигов на полке

Ладно, так уж и быть, поставил. Дело то пару секунд, и ждать еще долго

Работает с базовой моделью, а вот с мержем у меня не получилось

Линукс - это синоним пердолинга. Но тут как обычно, гуглишь гайды и делаешь по ним.

Upd, с juggernaut xl получилось смержить inpaint разницу. Это значит из-за даунского кастомного запечённого vae в realvisXl 3.0 не работает, который видимо не сохраняется при мерже

> juggernaut xl

Заметил что с ним какие-то цветные полосы появляются. Но он хоть генерирует, realvis просто латентные нули выдаёт (просто бежевая заливка)

зачем 20 шагов для турбохл? там 5-6 с DPM++ SDE Karras хватает для вменяемой картинки

тоже самое но с 20 шагами - очевидный пережог. турбо и LCM модели требуют других настроек

Это на амуде?

У меня на 6900ХТ 1.5 мин генерится, пиздос...

нет, нвидиа. просто самое простое ускорение без пердолинга для тебя это уменьшение количества шагов, 20 не нужны для турбо.

мержить надо после обновления автоматика до dev версии? а то на 1.7 ошибку выдаёт

У меня на амуде почти не меняется от количества шагов время

С 20 где то 1 мин 40 сек генеринг с 5 шагами 1 мин 20 сек

может на процессоре генерится? провеь нагрузку на видеокарту

попробуй это https://github.com/nod-ai/SHARK

тут есть возможность выбрать на чём рендерить

на хилой встройке AMD аж заработало, думал она никуда не годится в SD

На винде такое запустится или надо линукс?

Окей спасибо попробую

Я в master 1.7.0 мержил

подскажи настройки пожалуйста

Не понял, как связан git и настройки?

настройки объединения кастомной xl модели с inpaint моделью

А - sdxl base inpaint

B - твоя модель

С - sdxl base

M - 1

сработало, но модель не грузится. ладно да и хер с ним, подожду официальной поддержки от автоматика вместо тыканья дев билдов

Оцените inpaint с помощью realVisXL 3.0

-кун реквестирует помощь.

Реквестирую работающий конфиг, который не будет выдавать avr_loss=nan, я заебался искать причину. Но у меня не работает bf16 и AdamW8bit потому что невидия 16 в это не умеет.

Если с вашим конфигом будет все хорошо - значит вот этот господин прав насчет рук.

И еще пара вопросов:

Допустим я хочу использовать runwayml/stable-diffusion-v1-5, он его конечно закачивает в .cache (спасибо вот этому доброму человеку), но я хочу держать его в другой директории. Как зделоть? При выборе custom я просто не ебу что указывать, там ёбаная куча safetensors в поддиректориях.

У меня довольно много всякого говна нагружено и помнить про что оно только по названию можно ебануться, поэтому я поставил https://github.com/butaixianran/Stable-Diffusion-Webui-Civitai-Helper и оно нагрузило мне превьюх, может подставлять триггеры и вообще оче удобно, но проблема в том что нагрузило оно в ту же директорию, где лежат модели. Можно как-то их разделить, чтобы модели были в одной директории, а их потроха в другой? очевидно что нет

Реквестирую работающий конфиг, который не будет выдавать avr_loss=nan, я заебался искать причину. Но у меня не работает bf16 и AdamW8bit потому что невидия 16 в это не умеет.

Если с вашим конфигом будет все хорошо - значит вот этот господин прав насчет рук.

И еще пара вопросов:

Допустим я хочу использовать runwayml/stable-diffusion-v1-5, он его конечно закачивает в .cache (спасибо вот этому доброму человеку), но я хочу держать его в другой директории. Как зделоть? При выборе custom я просто не ебу что указывать, там ёбаная куча safetensors в поддиректориях.

У меня довольно много всякого говна нагружено и помнить про что оно только по названию можно ебануться, поэтому я поставил https://github.com/butaixianran/Stable-Diffusion-Webui-Civitai-Helper и оно нагрузило мне превьюх, может подставлять триггеры и вообще оче удобно, но проблема в том что нагрузило оно в ту же директорию, где лежат модели. Можно как-то их разделить, чтобы модели были в одной директории, а их потроха в другой? очевидно что нет

> закачивает в .cache (спасибо вот этому доброму человеку), но я хочу держать его в другой директории. Как зделоть?

Гугли символические ссылки. Очень полезная вещь

Но вообще кеш hugging face можно через переменную окружения перемещать, гуглится за секунду. Так что осиль сам

Кэш SD у меня и так лежит в директории SD (спасибо дружку хача, рили удобно), но runwayml/stable-diffusion-v1-5 я бы хотел держать в директории models например, а перемещать туда кэш переменной - это значит насрать туда всем остальным, что в кэш пишется.

Симлинки это канеш все хорошо, но немного не то. Я хотел бы в директории с чекпоинтами/лорами/etc видеть только чекпоинты/лоры/etc. Кроме того, я не знаю корректно ли обрабатывает SD симлинки - мне встречался софт, который в упор этого не делал.

В дополнение к этому

Вероятно дело не в настройках или кривых руках (по крайней мере не моих), а в том что с какого-то релиза обучение сломано https://github.com/bmaltais/kohya_ss/issues/1758

Укажите пожалуйста, какой версией (или когда она была скачана/установлена) вы пользуетесь, пожалуйста. Попробую откатиться, но не знаю куда.

Вероятно дело не в настройках или кривых руках (по крайней мере не моих), а в том что с какого-то релиза обучение сломано https://github.com/bmaltais/kohya_ss/issues/1758

Укажите пожалуйста, какой версией (или когда она была скачана/установлена) вы пользуетесь, пожалуйста. Попробую откатиться, но не знаю куда.

Расширение, снижающее артефакты при больших CFG: https://github.com/scraed/CharacteristicGuidanceWebUI

Может быть это станет спасением для lcm лор, чтобы негативы включить? Надо будет протестировать

Может быть это станет спасением для lcm лор, чтобы негативы включить? Надо будет протестировать

Block merge охуительный underrated метод, когда берешь из другой модели только освещение и эффекты поверхностей. Гораздо лучше и практичнее чем обычный мердж. Ничего сложного там нет, делаешь две кривые на ползунах и всё, так что теперь запилю свой собственный зоопарк оранжей для XL.

Что, ещё одно? Это, старое, не помогало с лцм, если что. https://github.com/mcmonkeyprojects/sd-dynamic-thresholding

Ну что вы блядь, немощи, ни у кого не закомменчен git pull в батнике и никто не может посмотреть дату создания файлов/директорий в проводнике блядь?

Какой нахуй батник, у нас запуск через скрипт на питоне, последняя версия кохи работает без проблем.

> с какого-то релиза обучение сломано

Нихуя там не сломано. С таким припизднутым lr, как по твоей ссылке, и должны NaN идти через 100 итераций, ничего в этом нет что надо было бы чинить. Алсо, bf16 уже можно называть признаком дебила, потому что использующие его думают что оно как-то спасает от говна ебанутых настроек тренировки. Наоборот у bf16 точность значимой части ниже 7 бит вместо 10 у fp16, экспонента большая никогда не нужна, если всё нормализовано.

Давно не обновлял, но на этой должно всё работать, хз что там с последней версией 2a23713f71628b2d1b88a51035b3e4ee2b5dbe46

> думают что оно как-то спасает от говна ебанутых настроек тренировки

Ну а что же тогда спасает?

>у нас запуск через скрипт на питоне

Ну каждый дрочит как он хочет, мне например удобно срать только в директорию с кохой, а не в юзердир, поэтому у меня запуск через батник. Это вощем-то не отменяет моего вопроса, но ты уже ответил на него, спасибо.

Благодарю, я попробую.

Олсо повторяю реквест, дайте пожалуйста работающий конфиг. В кохе же 1,5 настройки в вебморде, ну не мог же я блядь объебаться конечно же мог, просто в упор не вижу где.

> когда берешь из другой модели только освещение и эффекты поверхностей.

Очередной чел с магическим мышлением по отношению к sd. Нет в моделе специальных областей с "освещениями и эффектами поверхностей", к которым нейронка обращается, когда "выбирает освещение и эффекты поверхности" что бы это не значило

> Ну каждый дрочит как он хочет

Это конечно верно. Но пользоваться виндой в 2023 - это, конечно, пиздец...

Ну извинити, у меня нет свободного времени впрочем и желания чтобы натянуть и настроить гуй на голый линупс, а искаробочными решениями пользоваться вызывает рвотный рефлекс наравне с виндой, поэтому из двух зол.

Не у всех есть деньги на Мак, а пользоваться гну-высером из нулевых - это вообще зашквар, ты бы ещё предложил на ХР перекатываться.

> Не у всех есть деньги на Мак

Щаз бы SD на маке запускать лол.

Лучше чем на амуде, лол.

Одинаково, вообще-то.

Что-то мне кажется, что на амд совместимость подучше. А на маке на уровне видеокарт интл

Амуде бы сейчас не видеокарты пилить, а бросить силы штата разрабов пилить либы для нейросетей. А то ёбаная куртка жмется на память словно она бешеных денег стоит, хотя стоит она почти нихуя на самом деле.

> А на маке на уровне видеокарт интл

На Маке автоматик из коробки работает так-то, в отличии от амуды.

Куртка начнёт конкурировать сам с собой, если добавит дохуя памяти в потребительские карты. Жди новый тип ядер для жёсткого ускорения нейросетей, которых не будет в потребительских картах. Тогда памяти доложат побольше. А пока куртка финансирует ии-сжатие текстур, чтобы можно было класть ещё меньше памяти.

>бросить силы штата разрабов пилить либы для нейросетей

Они и пилят, ROCm уже есть.

> дайте пожалуйста работающий конфиг

Для какой гпу и чем именно тренишь?

Я имею в виду конфиг для webui, параметры тренировки. Я где-то наебываюсь именно здесь, потому что ранее получал значения avr_loss хотя бы отличные от nan. Но в то же время это происходило на более ранней версии, примерно 22.1.1. Однако я попробовал ее и все равно получаю nan. Возможно конечно дело не в кохе а в модулях пердона, я попробовал откатить на более древние но и это не решило проблему.

Офк я попробовал чистую реинсталляцию (которую рекомендуют в 95% при решении проблем потому что никто нихуя не знает).

У меня 1063 и 1630@4gb, треню кохой, пытаюсь запуститься на runwayml/stable-diffusion-v1-5.

Я сам себе злобный буратина, поначитавшись всяких гайдов включил Full fp16 training (experimental). Корочи я дебил и еб бы вам голову зря, но... Отключив его я наконец начал получать на 1063 валидный avr_loss, наконец сохранил работающий пресет чтобы больше не заниматься такой хуйней, но перенеся его на другую тачку с 1630@4gb я снова начал получать nan. Охуеть, что за магия бля?

-кун

-кун

> 1063

Да какое обучение на 3 гб vram, успокойся. Для адекватного взаимодействия с сетью 8 гб мало, чтобы без постоянных компромиссов, а ты в обучение со своими тремя полез

Что в наличии есть - на том и учу. Пару раз даже успешно потом начал обсираться с каждым разом все жиже, но разговор не об этом, так что нормальное обучение, принципиально все работает, это я мудак конфиги кручу и не могу понять где сломалось.

Ля, вот вы...

Короче я сделал еще один тест. Голый конфиг, единственное что поменял - это оптимизатор AdamW8bit на AdamW (чтобы было одинаково, одна машина в AdamW8bit не может).

На 1063 голый конфиг заводится, на 1630@4gb получаю nan. Правда я не могу сказать с уверенностью, тренил ли я на 1630@4gb уже или еще нет, могу только сказать что генерил. Возможно этому огрызку отрезали что-нибудь нужное для обучения.

А так как вы молчите, я пожалуй скастую одного юродивого в этот тред: Я ИСПОЛЬЗУЮ ВЕРСИЮ ОТ ДРУЖКА ХАЧА

а потом буду его тыкать носом в хачевский батник, где написано git remote add origin https://github.com/bmaltais/kohya_ss.git && git pull origin master и размазывать по ебальнику user environment variables. Да, мне наконец совершенно нечем заняться в этот новый год, как же пиздато заниматься вот такой хуйней. С НГ всех, целую-обнимаю.

Короче я сделал еще один тест. Голый конфиг, единственное что поменял - это оптимизатор AdamW8bit на AdamW (чтобы было одинаково, одна машина в AdamW8bit не может).

На 1063 голый конфиг заводится, на 1630@4gb получаю nan. Правда я не могу сказать с уверенностью, тренил ли я на 1630@4gb уже или еще нет, могу только сказать что генерил. Возможно этому огрызку отрезали что-нибудь нужное для обучения.

А так как вы молчите, я пожалуй скастую одного юродивого в этот тред: Я ИСПОЛЬЗУЮ ВЕРСИЮ ОТ ДРУЖКА ХАЧА

а потом буду его тыкать носом в хачевский батник, где написано git remote add origin https://github.com/bmaltais/kohya_ss.git && git pull origin master и размазывать по ебальнику user environment variables. Да, мне наконец совершенно нечем заняться в этот новый год, как же пиздато заниматься вот такой хуйней. С НГ всех, целую-обнимаю.

Дегенератина, показывай свой конфиг и используй нормальную версию от кохи, а не всяких хачей-трюкачей.

> bmaltais/kohya_ss.git

Это ещё что за мокрописечная хуета? Оригинальная репа тут - https://github.com/kohya-ss/sd-scripts

Ладно, я нашел в чем дело https://github.com/kohya-ss/sd-scripts/issues/293

И действительно указав mixed_precision=no обучение на 1630@4gb начало отдавать значения avr_loss.

Кроме того, там же лежит решение чтобы mixed_precision=fp16 заработал, но у меня чет не получилось его завести. Ну да и хуй с ним, посмотрю на результат при =no.

>Это ещё что за мокрописечная хуета

Это мокрописечная хуета, в которую коха сделал 600+ коммитов, так что ебальничек завали.

> коха сделал 600+ коммитов

Принятия пул-реквестов и мержей из основной репы? Не вижу ни одного коммита с кодом от кохи за последние месяцы один багфикс нашёл всё же на 5 строк, да. И речь тут в первую очередь про то что авторы этого кала в конфигах по умолчанию делают, пользовался бы оригинальной репой - не было бы вопросов кто насрал.

>Принятия пул-реквестов и мержей из основной репы?

Хотя бы это делает мокрописечную хуету потенциально рабочей. На данный момент большинство мокрописечных хует - это суть то же самое, что развернуто на твоей пекарне, только ставится из гита. И я ебал ставить все руками когда можно почти полностью развернуть автоматически, тем более что (!) в мокрописечной хуете принятия (!) пул-реквестов и мержи (!) из основной репы (!). Не понимаю как даже не форк, а по сути аддон вдруг делает оригинальный код неоригинальным.

И как показывает практика - насрал обычно сам пользователь, но и вы далдоны не знаете нихуя как исправить ту или иную проблему, вся ваша помощь - это сиплые вскукареки на тему оригинальности источника и неканоничности мокрописечных хует. С одной стороны это не ваша вина - насколько я слышал но не читал, да маны кохи крайне неинформативны, что-то уровня "делай так и будет заебись". Но если такой подход вполне канает в треде, то в качестве официальной документации это полное говно.

И однако я удачно тебя скастовал лол.

> проблему

Ты пока ни одной проблемы не обозначил. "Не работает" без показывания что ты там напердолил - это не проблема, а диагноз об умственной отсталости.

>Не вижу ни одного коммита с кодом от кохи за последние месяцы

Хорошо, давай я повожу твоим ебальником по говну немного иначе: идешь в свою ультра-мега-гипер-оригинальную репу и в readme.md находишь

>For easier use (GUI and PowerShell scripts etc...), please visit the repository maintained by bmaltais. Thanks to @bmaltais!

А в браузере на странице "the repository maintained by bmaltais" вообще выполнено ссылкой на мокрописечную хуету.

Неудобненько вышло, коха ссылается на мокропиську, вот так новость.

>Ты пока ни одной проблемы не обозначил. "Не работает" без показывания что ты там напердолил

Я обозначил что получаю nan, и будь у нас всех чуть больше информации об этом - можно было бы сказать в каких кейсах это может происходить, прочекать эти кейсы и найти проблему.

Уже в этом посте можно предположить проблемы с совместимостью, а не проблемы в настройках или дистрах. А вот в этом посте я специально сказал что попробовал голый (читай - дефолтный) конфиг только с одним изменением, то есть я нихуя там не накрутил.

А уж указывать что дистрибутив не был инсталлирован руками - это вообще для вас, долбаёбов, красный флаг. Не перестаю лолировать с этого ощущения исключительности на самоподдуве - "я поставил все руками вместо автодеплоя, какой же я охуенный".

анончики, а есть какой-то нормально работающий теггер для НСФВ, без разницы на базе чего, данбору или нет - просто смотрю в гитхаб и там какая-то ебань для красноглазых, а в kohya гуе нет нифига нормального теггера для всяких пезд и жоп

и поделитесь пожалуйста нормальным гайдом по обучению лор на сдхл - карточку купил новую, а чето нихуя kohya не тренит - когда-то давно 1.5 модели нормально обучались, а щас sdxl какая-то пиздатня, и все гайды это сука двухчасовые видосы на ютубе от индусов и иранцев каких-то

>в kohya гуе нет нифига нормального теггера для всяких пезд и жоп

Ну обычно они прописываются в промт, стандарта как правило нет, но как одно из предположений - скачай другой чекпоинт, какой-нибудь эпикреализм или сорт оф. Дефолтный чекпоинт хуево рисует пезды и жопы.

Еще на пезды и жопы можно задействовать лору, им иногда нужен триггер.

Ну давай попробуем, хз. Расскажи модель новой карты и что происходит при обучении - какой выхлоп в сосноль дает, ошибки там чи шо?

> mixed_precision

> на 1630

Она разве вообще умеет в него? Все через жопу костыльно всегда было на недо-тьюрингах.

> вместо автодеплоя

Автодеплой что заменяет 2.5 строчки кода? Гуйня bmaltais в целом неплоха и для будки пригодна для формирования параметров запуска, хотя многого там всеравно нет. О чем у вас спор вообще?

> я поставил все руками вместо автодеплоя, какой же я охуенный

Случаем сам не имплаишь что юзать васянскую залупу - норма? Или что вообще хочешь сказать?

WD теггер работает с нсфв хорошо, не так давно там новая модель вышла которая знает оче интересные концепты и теги но при этом очень обильно срет и надо с ней устроить правильное обращение.

> там какая-то ебань для красноглазых

Все так, нормальный путь - пачка из нескольких моделей. Есть ленивый путь - экстеншн к автоматику, позволяет тегать батчами, выбирать модельки, делать базовые настройки и т.д., для простых задач хватит.

>Она разве вообще умеет в него?

1063 поколением ниже внезапно заводится норм, хотя казалось бы.

>Автодеплой что заменяет 2.5 строчки кода

В случае bmaltais - нет, но в случае портабельного варианта, который развертывает дружок хача - вполне себе годно, зависимости развернутся сами.

>хотя многого там всеравно нет

Вот с этого момента подробнее. Мне интересно, без сарказма.

>Или что вообще хочешь сказать?

Я хочу сказать что предмет нашего спора (конкретно репа bmaltais, на которую ссылается деплоер дружка хача) - сорт оф плейбук. Если взять эту аналогию, нихуя криминального в использовании плейбука из инторнетов в случае если он тебе подходит и работает - нет. И более того, сейчас это стандарт, никто не дрочится с деплоем и конфигурированием руками, но почему-то в этом треде это вызывает жопное горение.

>Я хочу сказать что предмет нашего спора (конкретно репа bmaltais, на которую ссылается деплоер дружка хача) - сорт оф плейбук. Если взять эту аналогию, нихуя криминального в использовании плейбука из инторнетов в случае если он тебе подходит и работает - нет. И более того, сейчас это стандарт, никто не дрочится с деплоем и конфигурированием руками, но почему-то в этом треде это вызывает жопное горение.

Ну или вот еще одну аналогию приведу. Вот есть SD, у него есть дефолтный чекпоинт. Приходит в тред анон и говорит "у меня не генерируется пиздохуй, что делать? Генерирую на чекпоинте пиздохуй.safetensors". В ответ на свой вопрос анон получает взвизги про то, что генерировать пиздохуй надо только на дефолтном чекпоинте, а все остальное мокрописьки и вообще пошел нахуй.

Я не призываю использовать одно, но не использовать другое, если что - дрочитесь как угодно, хотите ставить руками, срать в кэш юзердира и переменные среды - ваше право, никаких претензий, это дефолтный и рабочий вариант.

> 1063 поколением ниже внезапно заводится норм, хотя казалось бы.

Все верно, паскаль был полноценным, хоть и уже старенький, а обрезки тьюринга проблемные, хотя чипы мощнее и новее.

> В случае bmaltais - нет

Для гуйни офк нет, но просто поставить коху - гит пулл, венв@торч@реквайрментс, при необходимости раскомментировать дополнительные модули. Бмалтис еще много лишнего тащит для обеспечения остального функционала, он норм, особенно если начинаешь, но потом - неудобен. Например, лоры лучше тренить пачками с варьированием параметров, для будки там отсутствуют нужные параметры

> Вот с этого момента подробнее

Аргументы шедулеров (под них есть поле но для половины оно делает неверное форматирование из-за чего лезут ошибки), аргументы оптимайзеров (в основном работают), тренируемые слои, zero_snr - первое что в голову приходит, были еще. Ну и банально неудобно каждый раз все тащить-вбивать или переназначать даже при наличии сохранения конфигов (если речь о лорах).

> нихуя криминального в использовании плейбука из инторнетов в случае если он тебе подходит и работает - нет

Абсолютно, а что такое плейбук?

> никто не дрочится с деплоем и конфигурированием руками

Там нет дрочки и все относительно просто, проблемы прежде всего в отсутствии норм документации. Как только запросы выходят за рамки дефолта типа (натренить вайфу/натренить на еот) или не удовлетворяет их качество - придется вникать.

> но почему-то в этом треде это вызывает жопное горение

Хз, тут может вызвать пожар разве что когда варебух приходит и начинает что-то требовать, а на вопросы что не так - говорит "а вот у меня хуйня из под хача он мастер и знает как надо, настраивайте".

> Генерирую на чекпоинте пиздохуй.safetensors

Очевидно что сначала нужно проверить на заведомо нормальном, чтобы исключить релейтед к васянизации проблемы. А потом уже разбираться по дефолту. Хз чего тебя тригернуло на этом.

Ну и не эктраполируй мнение возможно вполне уместное, лень сильно сейчас ту нить читать на всех, и сам тут явно предвзят и напираешь на эту тему. Тред не быстрый и сейчас праздники.

Спасибо за пояснения.

>а что такое плейбук?

Суть скрипт с необходимыми действиями для получения готового к работе хоста или внесения изменений в существующий, используется в ansible, но есть еще пяток аналогов. В принципе это можно и шелл/помершелл/бат-скриптами делать, но возможно существуют некоторые нюансы. В основном используется в интерпрайзе, например когда нужно поднять очередной хост с типовой конфигурацией.

>проблемы прежде всего в отсутствии норм документации

Да, я выше уже посетовал на это. Возможно что-то сформирует комьюнити со временем.

>а вот у меня хуйня из под хача

А вот у меня хуйня из-под хача. Но по крайней мере я осознанно сделал этот выбор и осознаю что хуйня из-под хача разворачивает из репы bmaltais - а это дает возможность работы с проблемой не смотря на все прочее энивей. Приходится либо умалчивать про хача чтобы у очередного хлебушка не полыхнуло, либо тыкать носом под настроение.

>сначала нужно проверить на заведомо нормальном

Верное замечание с одной стороны, и я сам хотел его сделать, но по опыту в большинстве случаев к этому прибегают если попробовали уже все что можно.

Как завести коху ебаного на гетерогенной системе?

>гетерогенной

Подробности?

> Вот с этого момента подробнее.

В ваших гуях очень много чего нет из того что появилось за последние пол года.

Разные виды демпинга, типа debiased_estimation_loss. DPO и тренировка RL с ревардами от OpenPose или CLIP. Multistep-тренировка с дополнительными шагами на высоких timestep чтоб меньше уродов было. Референс-модели.

Можно кучу всего ещё по мелочи перечислить.

3090+3060

Дело в том что так называемый "сложный деплой" что кохи, что гуйни - это несколько дефолтных строк в консоль, а гуй - вообще склонировать репу и запустить один скрипт. В случае васян-инсталляторов требуется сначала понять что именно там наделано внутри, чтобы потом не страдать из-за левых костылей или идиотских решений. Особенно если эти васяны - недостойный гной и гниль, не раз пойманная на воровстве и включении вишмастеров. Реакция именно поэтому, а не потому что тут недружелюбные или надрачивают, что именно там внутри врядли кто-то будет разбираться и смотреть.

> В основном используется в интерпрайзе

Здесь не тот случай.

По докам все сложно, если найдешь их - скидывай, в основном обрывки в обсуждениях между теми кто понимает, что печально.

> но по опыту в большинстве случаев к этому прибегают если попробовали уже все что можно

А что у тебя не работает то?

Не стоит. Если реально хочешь - ставь wsl, под шинду в теории сделать можно, но придется собирать аккселерейт с нужными либами, или искать альтернативные пути.

Но вся проблема в заточенность на синхронное исполнение, 3060+3090 дадут скорость как две 3060 и скорее всего окажется медленнее чем 3090. Такое имеет смысл на близких по перфомансу гпу типа 3090+4090 и подобное. Если при конфигурировании выключишь параметр синхронизации - вообще вылетит вскоре после запуска.

Хочешь больше батчсайз - юзай градиент аккумулейшн.

Алсо есть альтернативный путь - трень разные модели на разных карточках, cuda visible devices в помощь.

И обе задействовать нужно, чи шо? Я чет слышал что такое возможно только при обработке разными картами разных же словоев.

Если разные - можно указать нужную при запуске accelerate config, но вот здесь вроде бы эту проблему решили https://github.com/bmaltais/kohya_ss/issues/521 правда с нюансами - зделоли использование VRAM+CUDA на одной карте, и CUDA на второй карте. При том что у 4090 больше VRAM - это может иметь смысл даже если

>>3060+3090 дадут скорость как две 3060 и скорее всего окажется медленнее чем 3090

>Здесь не тот случай.

Для дома тоже используется иногда, например один анон из треда про умный дом в /dom держит плейбуки для ядра, чтобы в случае падения железки можно было развернуть замену за 5 минут.

>А что у тебя не работает то?

Да все уже работает, я имел в виду опыт не с нейросетями, а в принципе - волею случая приходится воевать с разным софтом по работе, запускаться на нестандартных конфигурациях или чинить такой запуск. Но для полноценного девопса мои задачи будут детскими шалостями так-то.

>При том что у 4090 больше VRAM

Наебался. Имел в виду 3090 конечно.

>Здесь не тот случай.

Ну и вообще это аналогия была, я не предлагаю использовать деплой через энтерпрайзные инструменты для нейросетей лол.

>не раз пойманная на воровстве и включении вишмастеров

Соглашусь. Учитывая что пердон разворачивается из архива, а не скачивается из официального источника - это опасненько, тут уж хуй знает что могли туда впихнуть. В остальном firstrun на 10 строк и запуск примерно во столько же, особо вникать не нужно. Вообще ты навел меня на хорошую идею разворачиваться примерно так же, но закачивать тот же гит или пердон через curl из инторнетов. Не думаю что скрипт для этого сильно больше получится, а опасности меньше.

> И обе задействовать нужно, чи шо? Я чет слышал что такое возможно только при обработке разными картами разных же словоев.

Еще как можно и скорость пропорционально выше количеству, каждая видюха обрабатывает свои пикчи (считай батчсайз в N раз больше), а потом результат определенным образом усредняется.

> VRAM+CUDA на одной карте, и CUDA на второй карте

Вут? Это немного другая степь.

> из треда про умный дом

Там нужно быстро провести кучу автоматизированных типовых действий и все. Тут даже действий нет, скачал, нажал и все. Зато потом уже сидишь пердолишься, занимаясь подготовкой датасетов или настройками.

Суть не в нейросетях а в опенсорце. Там где нужно что-то готовое простое использовать - да. Но тут даже не готовый инструмент а кит-набор, с помощью которого разобравшись и настроив можно что-то делать.

> закачивать тот же гит или пердон через curl из инторнетов

Все что нужно - гит клон а потом запустить батник или шеллскрипт. Ну и после установки акселерейт конфиг под свое железо, если хачелла там конфигурирует под бф16 по дефолту а у тебя карточка младше ампера - то земля пухом бай дефолт скорее всего.

>https://github.com/bmaltais/kohya_ss/issues/521

У меня при таких же настройках происходит краш как в ишуях, фикс в library/train_util.py помогает, но тренировка происходит только на первом гпу, а если задать число процессов 2 то там такие ошибки, как будто запустили 2 раза тренировку на разных гпу, лол.

Какая система стоит на пекарне где идет обучение?

Винда, а акселерейт запускает гуи от дериана, который уже запускает коху. Пробовал и наоборот, чтобы гуй запускал акселерейт фиксом в main_ui_files/MainWidget.py, тоже что-то не получилось. Позже попробую без гуя короче.

> DPO и тренировка RL с ревардами от OpenPose или CLIP. Multistep-тренировка с дополнительными шагами на высоких timestep чтоб меньше уродов было. Референс-модели.

И это всё уже есть у кохьи? В патч ноутах только про debiased_estimation_loss

Под шинду дефолтный акселерейт не может в мультигпу. Если пройдешь по пути поиска ошибок то придешь к отсутствию нужных параметру и заглушке о том что ваша версия - говно, а при попытке собрать нормальную столкнешься с отсутствием всякой херни, если писать коротко.

На любом линуксе или wsl аккселерейт из коробки может. Просто установи убунту из магазина, а на нее накати тот же гуи и пользуйся им. Бонусом будет работать быстрее.

При конфигурировании аккселерейта выставляешь this mashine, multi-gpu, 1, Should distributed operations be checked while running for errors? - Yes, FullyShardedDataParallel - No, all или 0,1 на списке гпу. При запуске оно само запустится на двух гпу без доп параметров, но можешь их указать, в мане к аккселерейту есть. Эффективный батчсайз будет больше в 2 раза, учитывай это при задании числа шагов/эпох/повторов датасета.

>Эффективный батчсайз будет больше в 2 раза, учитывай это при задании числа шагов/эпох/повторов датасета.

Как он может быть в 2 раза больше, если у 3060 не хватит на такое видеопамяти? Придется урезать заданный батч сайз ровно в два раза, чтобы уместить? Какая же неповоротливая хуита.

>wsl

б-же упаси

> Как он может быть в 2 раза больше, если у 3060 не хватит на такое видеопамяти?

Ты не понял, при запуске будет работать в 2 потока каждый с заданными параметрами и на своей видюхе. Результат будет как с батчсайзом в 2 раза выше, поэтому нужно скорректировать число шагов, уменьшив в 2 раза.

> Придется урезать заданный батч сайз ровно в два раза, чтобы уместить?

Нет, на 3060+3090 придется выставлять тот, который влезет в 3060 ибо она ограничивающий. Возможно полезут еще какие-то подводные из-за асиметричного конфига или будет вылетать, оно и на симметричной системе может упасть если, например, подключать мониторы/телек.

> б-же упаси

Тогда ставь полноценный линукс и грузись в него. Или займись добавлением поддержки в шиндовскую версию, оба варианта несравнимо затратнее.

> И это всё уже есть у кохьи?

Ну коха слишком тупой чтоб это запилить, но в форках есть.

Да, вообще покури доки пустил слезу и код кохи, возможно всеже можно задать разный батчсайз на девайсах чтобы получить ускорение на подобных ассиметричных, или это уже как-то реализовано.

Так это ты не понял, я вот это имел в виду

>на 3060+3090 придется выставлять тот, который влезет в 3060 ибо она ограничивающий

На 3090 получается 12 гигов будут простаивать, что есть половина.

>ставь полноценный линукс

Давно бы уже накатил и радовался бы жизни. А так бля какая же хуйня, только на линуксе не под wsl блядь работает одна половина софта, только на винде другая половина, а я использую комп как сервер блять и мне нужно чтобы он 24/7 работал. Пидорасы.

>задать разный батчсайз на девайсах

Походу все же придется курить. Пиздец бля, уверен что запилить такую фичу с уже рабочим аккумулейшеном на мультигпу это дело 10 минут, просто прописав опции в конфиге, но ее до сих пор походу нет.

>в форках

Тише, тише, а то услышит юродивый и завизжит про мокрописечную хуету

Бля, на пик не обращайте внимания. Я хотел ответит с ним, но потом понял что вощем-то просто и не за чем.

> На 3090 получается 12 гигов будут простаивать, что есть половина.

Ага, увы, может получиться не ускорение а наоборот замедление. Возможно как-то можно, но вероятность сделать малой кровью, без больших правок кохи, мала, когда в свое время смотрел - было крайне примитивно средствами аккселерейта.

Если что-то получится - выкладывай.

> Пидорасы

Двачую

Блять, васяны рили этот пиздец с зашкваренными бинарниками хавают, вместо того чтобы скачать полноценные версии гита и питона?

Почему вы все до сих пор дрочитесь с юнетом и сд, когда есть дит и пиксарт?

Говно же

А ты пробовал?

О, точно, нужно их хотябы понюхать пока есть свободные дни. В любом случае наличие комьюнити и уже готовых средств запуска и обучения - крайне серьезный фактор.

Да

>пиксарт

Попробовал загуглить и проиграл

Пиксарт как модель ничего нового не предлагает, оно и понятно, бюджет у них меньше чем у сд 1.X почти в 12 раз. Да, понимание промпта присутствует (в первую очередь за счет большого Т5), но вот картинка все равно получается говном из-за малого размера денойзера, тут уже ничего не поделать.

Какой-то уровень дримбудок образца сентября 2022г.

Там основная причина говна — всратый и маленький датасет

И это тоже.

На самом деле я неправильно загуглил прост, но проигрывать не перестаю.

Их там много, в каких конкретно?

а при чем тут чекпоинт СД и чекпоинт клипа, это ж разные вещи. Если использовать клип через интерргейтор, то ты модель прям там выбираешь, и там нифига не СД модели a всякие vit16-h

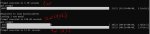

В поисках информации попался видос (из тех, что 3,5 штуки на русском) про сравнение базовых настроек при обучении лор. Таблица пикрил, оценка субъективна.

От себя добавлю что dim=16 alpha=8 тоже канают.

Сам видос тут https://www.youtube.com/watch?v=_8_k9LUOEes

От себя добавлю что dim=16 alpha=8 тоже канают.

Сам видос тут https://www.youtube.com/watch?v=_8_k9LUOEes

Уже пара месяцев прошло, а sd 1.6 так и не открыли...

А оно его живое? Вроде как упоминание повышенных разрешений из релиза вообще убрали...

Кстати о повышенном разрешении. Realistic Vision 6 тоже планировался как повышенное разрешении. Но в итоге и на заявленном 800+px выходит глючное говно

И еще там в комментах пишут, что переобученно на голых девушках, и выдает их даже тогда, когда не просят. Ну и в плане реализма - тоже говно, даже близко не EpicPhotogasm

Короче очень разочарован в realistic vision 6

Когда завезут в SD zero-shot персонализацию и фидбэк? (Типа как finetune в реальном времени, когда пользователь оценивает сэмплы и модель медленно дообучается по оценкам, в CharacterAI было такое)

Завези. Софт развивается сообществом

(А вообще звучит как что-то очень требовательное)

> когда пользователь оценивает сэмплы

Такое уже есть, 24гб врам для простых генераций приготовил?

> в CharacterAI было такое

Это вообще не близко к файнтюну и влияло крайне редко и опосредованно, 99.x эффекта - плацебо для пользователя.

Какое хорошее значение constrain для COFT?

> Такое уже есть, 24гб врам для простых генераций приготовил?

Где? 24Гб врам есть.

1

А, это я уже видел. Мертворожденный проект.

Как в публикации - 1е-5. На 1 от него результата ноль, с тем же успехом можешь выключить просто.

Пробовал уже по пейперу, с 1е-5 слишком слабо, без него пережарка быстрая, видимо надо пробовать промежуточные.

Алгоритм прошлогодний https://github.com/KohakuBlueleaf/LyCORIS/blob/main/docs/Algo-List.md#diag-oft

> с 1е-5 слишком слабо

Чем меньше, тем эффект сильнее.

> пережарка быстрая

OFT тренируется сильно быстрее, он не работает с теми же lr что и обычные лоры. Ставь lr раз в 10 ниже, не выше 5е-5. И я надеюсь ты там не жаришь по 10+ эпох. А лучше вообще не используй его, если не можешь осилить настройку.

С constrain 1e-3 уже почти не отличается от лоры, надо его чуть понизить вместе с лром и будет норм.

> И я надеюсь ты там не жаришь по 10+ эпох.

Скорее всего слишком долго тренил и лр был слишком большим.

У меня есть около 4к картинок с тегами, мне нужно протегать еще столько же в подобном стиле. Есть ли где то гайды как можно натренить свою модель для распознавания того что на картинке?

Берешь и файнтюнишь BLIP2. В чём проблема? Всё найдёшь в документации HF.

> Алгоритм прошлогодний

Ха ха 🤦🏻♀️

> протегать еще столько же в подобном стиле

Что за стиль? 4к пикч, наверно, будет маловато для тренировки клипа или чего подобного, но можно попробовать.

Если стиль описания дефолтный (натуртекст или буру теги) то есть готовые решения.

Если там что-то хитровыебанное то поможет комбинация вд-теггера, клипа, мультимодалки и ллм, с ними можно сделать почти любые описания без необходимости тренировки, если офк там не что-то суперспецифичное.

В большинстве своем это рендеры с койкатсу, моя цель что бы она узнавала персонажей и только. Если есть гайды как это все сделать, то я бы был крайне рад.

Можно меня лицом тыкнуть, куда мне копать?

Если персонажи популярные и их модельки там качественные - их имеющиеся модели будут узнавать. Если такого нет - нужно свою тренить. Если в этом будешь успешен или что полезное накопаешь - поделись потом.

Нахуй не нужно, неудобная хернь.

Зерошот должен быть в виде промпта - даёшь ему набор рефов, даёшь промпт что именно из них вытащить (бабу, дерево, веснушки, спицы колеса, прямые углы, красные цвета, стиль наброска), он вытаскивает и это потом можно использовать при генерации.

Лороделы! Ай нид ё хелп!

Какой пресет выбрирать в kohya_ss?

Я пытаюсь сделать лору на простой концепт. Для этого как я понял надо поставить Network Rank и Network Alpha поменьше, что бы не сильно корявило стили. Но эксперименты показали что очень сильно на результат влияет Optimizer. Пробовал разные, но так и не понял какой самый крутой.

Вроде в кохе есть куча пресетов, но хрен просышь какой и для чего нужен.

Какой пресет выбрирать в kohya_ss?

Я пытаюсь сделать лору на простой концепт. Для этого как я понял надо поставить Network Rank и Network Alpha поменьше, что бы не сильно корявило стили. Но эксперименты показали что очень сильно на результат влияет Optimizer. Пробовал разные, но так и не понял какой самый крутой.

Вроде в кохе есть куча пресетов, но хрен просышь какой и для чего нужен.

Не все мысли написал. Генерю для sdxl.

И суть проблемы в том, что какой бы я пресет не выбирал, такое чувство что через 20 минут лора перестаёт обучаться. avr_loss - не меняется (даже увеличивается). Семплы которые я через каждые 200 шагов делаю по качеству не отличаются.

Интересно, на этой херне контролнет возможно сделать? Было бы прикольно

https://orhir.github.io/pose-anything/

https://orhir.github.io/pose-anything/

Нахуй не нужно, сам попробуй демо, работает крайне погано с очень плохой точностью.

Листаю твиттер градио - они там видосы с демками выкладывают разные. И их ссмщик не знает как звук при записи с экрана отключать, и слышны сопения, зеляик мыши и т.п. Кринж бля

> зеляик мыши

Бля

Ну так если будет контролнет, то это особо значения не будет иметь, что точность приблизительная. А так, поза - это, наверное, самый главный концепт для контроля. Т.к. форма и всякие линии - это слишком уникально

В общем говно это все. За 2 месяца пролистал, из интересного - это только этот pose anything, и magic animate. Нашел что тут его вскользь обсуждали, сказали говно качество. Да и по примерам видно

А еще StyleAligned Controlnet - круто. Наверное даже круче тех двух

Остальное - бесконечные text2image, нашли чем удивить. И еще хуже: text2music. Этим нейронкам уже лет 5 наверное

А еще StyleAligned Controlnet - круто. Наверное даже круче тех двух

Остальное - бесконечные text2image, нашли чем удивить. И еще хуже: text2music. Этим нейронкам уже лет 5 наверное

Но этот твиттерский левацкий вайб, конечно, дико бесит. Пошел он нахуй

Тебе перед использованием ещё надо будет референс рисовать руками.

Печалька

На я больше боюсь, что он для контролнета вообще не сгодится, лол

Можно, конечно, его на что угодно можно натренить, включая и на парах картинка-выхлоп этой штуки. Получится годно. Как тренить, показано здесь. https://github.com/lllyasviel/ControlNet/blob/main/docs/train.md

> Note that if you find OOM, perhaps you need to enable Low VRAM mode

> Note that training with 8 GB laptop GPU is challenging.

Выходит тренировка доступна на десктопных гпу, почему тогда моделей контролнета так мало?

Это получается можно как минимум сделать свой скелет, отличающийся от имеющихся, потратить какое-то время на составление датасета, где он выставлен под генерации, и новый контролнет готов?

Сап аноны, экспериментирую с лорами, треню конкретные участки тел тянок. Например сейчас зеттай область. Да, они скорее всего есть, но у меня научный интерес. Датасеты без лиц и мишуры, чисто тематический ручной кроп. В целом выходит неплохо, но картинка слегка желтеет и становится какой-то немного другой стилистически. Это проходит, если уменьшать номер эпохи и веса, но тогда проходит и целевой эффект.

Мне копать в сторону понижения ранга/альфы? Насколько я понимаю, ранг соответствует количеству "идей", которые лора усвоит в тренинге, возможно желтизна одна из них. Но непонятно, усвоит ли она именно геометрию, а не что-то другое.

Фиксить ли колор левелы в датасете? (Они в целом не желтые)

Алсо стараюсь фиксить кепшены после блипа, но они куцые и повторяются.

Может мне вообще кепшены не делать?

Не делать тематический кроп? (Тогда вылезают особенности окружения)

Вредна ли регуляризация в таком случае? Например supermodel подходит, судя по пикчам. Если правильно понимаю, она помимо всего участвует в контрасте между как обычно и как с лорой.

Делал ли кто свой класс регуляризации?

Из того, с чем пока игрался, это snr gamma, swn. Треню обычно lr=1e-4, ulr={1,2}e-4, dim/a=128, adafactor+cos (12гб жрет), bs=2, ориентирусь на 3000 шагов / 10 эпох. База 1.5 прунед 7гб с морды. Пришел к этому набору на лицах.

Советуйте плиз, датасаентисты.

Я и сам пробую, но полчаса на итерацию -- печально как-то все это дерево вариантов перебором искать.

Все гайды тренят чаров или хуй в пизде, которые вместо мягкого добавления меняют вообще все. Бесполезные

Мне копать в сторону понижения ранга/альфы? Насколько я понимаю, ранг соответствует количеству "идей", которые лора усвоит в тренинге, возможно желтизна одна из них. Но непонятно, усвоит ли она именно геометрию, а не что-то другое.

Фиксить ли колор левелы в датасете? (Они в целом не желтые)

Алсо стараюсь фиксить кепшены после блипа, но они куцые и повторяются.

Может мне вообще кепшены не делать?

Не делать тематический кроп? (Тогда вылезают особенности окружения)

Вредна ли регуляризация в таком случае? Например supermodel подходит, судя по пикчам. Если правильно понимаю, она помимо всего участвует в контрасте между как обычно и как с лорой.

Делал ли кто свой класс регуляризации?

Из того, с чем пока игрался, это snr gamma, swn. Треню обычно lr=1e-4, ulr={1,2}e-4, dim/a=128, adafactor+cos (12гб жрет), bs=2, ориентирусь на 3000 шагов / 10 эпох. База 1.5 прунед 7гб с морды. Пришел к этому набору на лицах.

Советуйте плиз, датасаентисты.

Я и сам пробую, но полчаса на итерацию -- печально как-то все это дерево вариантов перебором искать.

Все гайды тренят чаров или хуй в пизде, которые вместо мягкого добавления меняют вообще все. Бесполезные

>почему тогда моделей контролнета так мало?

Технических препонов немного. Просто 99% сообщества кумеры с выжженными мозгами, и кроме дрочбы рулетки и прумптинга 24/7 ничем не интересуются. В SD довольно много непочатых краёв, которые дадут неплохой арт-инструмент если ими заняться. Но диаграмма Венна между людьми которые могут сделать что-то интересное и знают какой инструмент им нужен, людьми которые умеют тренить что-либо, и людьми которые юзают SD, исчезающе мала. (

>Это получается можно как минимум сделать свой скелет, отличающийся от имеющихся, потратить какое-то время на составление датасета, где он выставлен под генерации, и новый контролнет готов?

Ну да, и не обязательно скелет. Контролнет это универсальный механизм. Можно его натренить на пары "позиция камеры"-"пикча", или на нарисованную позицию источников света (на цивите есть такие эксперименты), на всё что угодно.

Это то же самое, но с другой оболочкой.

Попробуй разбавить кропы некропнутыми примерно пополам или в другой пропорции, желательно чтобы были разнообразны. Что по описанию к пикчам?

> копать в сторону понижения ранга/альфы?

Альфу попробуй снизить (с повышением лра), размерность для начала не трогай.

> прунед 7гб

Вут?

> которые вместо мягкого добавления меняют вообще все

Нормальные не портят ничего лишнего.

Грусть-печаль.

Про универсальный механизм - согласен, просто новый скелет кажется достаточно простым с точки зрения составления датасета и дальнейшего использования, как раз чтобы попробовать. Если есть что релейтед почитать про это - будут благодарен.

Пробую завести Nerogar/OneTrainer. Кто-то пробовал уже эту казуальную штуку с одной кнопкой "зделоть лору заебись"?

Нет, она бы наверное у меня завелась и так, поставь я в систему гит с питоном. А так я ей накидал потрохов от хача и насрал в батник с запуском кастомными set env по аналогии. Чето качает теперь наверное майнеры, ух бля.

Нет, она бы наверное у меня завелась и так, поставь я в систему гит с питоном. А так я ей накидал потрохов от хача и насрал в батник с запуском кастомными set env по аналогии. Чето качает теперь наверное майнеры, ух бля.

Однако здравствуйте, кое-как запустил руками.

Я не знаю что будет на выходе, но в кохе у меня было 50s/it+, а здесь просто космические 3-5s/it.

Одна беда, из памяти она не выгружается, VRAM так и забит. Возможно для этого есть где-то в интерфейсе триггер, но я пока не искал. А запускать ее заново руками мне дико лень, буду завтра пердолить батник, половину которого спиздил из-под хача. Нагенерю хуйни сегодня, а завтра тестировать буду.

А еще эта штука может тренить по маске, и более того, сама эту маску генерит. Ну охуеть вообще.

А можно как-то отдельно мёрджить текст и юнет?

Оно уже научилось работать без гуёв, чтобы можно было запустить не на жалких 24ГБ, а на большом утюге?

>в кохе у меня было 50s/it+, а здесь просто космические 3-5s/it

Скорее всего потому что в кохе врубил/не врубил что-либо, не должно быть такой разницы. Коха наркоман, хуёво документирующий свои поделия

Думается мне что оно умеет работать без гуев, просто разраб не выложил ключи запуска. И кто-то с более сильным кунг-фу вполне может расковырять/отдебажить чтобы ты мог запуститься на своем ботнете из роутеров лол.

Разбавить попробую да, чот не думал об этом.

>прунед 7гб Вут?

v1-5-pruned.safetensors https://huggingface.co/runwayml/stable-diffusion-v1-5/tree/main

Я поначалу тренил на чекпоинтах, потом прочитал, что правильно на базе. В автоматике была по-дефолту(?) емаонли (== 4.1гб по ссылке), подумал - она. Но выходило говно. Потом я допер и где-то прочитал, что это не для тренинга модель и скачал v1-5-pruned. Не знаю правильно или нет, но стало нормально.

>Что по описанию к пикчам?

Делаю блипом за что меня обосрали в базовом треде и послали в cogvlm с докой на китайском, по которой я кажется сам должен написать плагин для кохи, хз и правил руками / смотрел. Но конкретно щас пикчи такие, что и блип норм справляется. Там 90% собственно концепция на симпл фоне, плюс минус цвет одежды.

-

Вчера сам альфу скинул до 1, желтизна ушла. Лучше всего получилось вообще без кепшенов, видимо из-за датасета. Лры пока не трогал, попробую. Я их вообще боюсь трогать, потому что их три за каким-то хером.

Спасибо за советы, анон!

В целом все правильно, только без капшнов совсем лучше не стоит, оно будет всирать когда более гибко применить захочешь.

Блип для простых пригоден более чем, ког для чего-то заморочного, и то не факт что обучится. Лры - тот что для unet равен базовому, тот что для te - в диапазоне от 0.5 до 1 от базового.

Вот эти

https://github.com/Nerogar/OneTrainer/blob/master/modules/util/args/TrainArgs.py#L253

Передавать судя по всему надо сюда

https://github.com/Nerogar/OneTrainer/blob/master/scripts/train.py

И в целом смотрите "modules/utils/args/xxxx.py" для аргументов scripts/xxxx.py.

Питонисты, вечно распиздячат все по разным папкам в папках в папках в классах в бейзклассах в метаклассах, блять. Кода на три копейки, но хуй чо найдешь, будто в миллионнике ковыряешься. Хвала всевышнему за иде прям в гитхабе

Что может вызвать отключение питания на видеокарте и отрубание компа с крит ошибкой питания, после нескольких генераций в sd, даже если нету нагрузки, а только был открыт webgui с загруженым в память sdxl чекпоинтом? На фукусе была та же фигня с другими моделями Он там 60% памяти занимал примерно из 12гб на 4070 от гигабайта. Стресс тесты и игры нормально держит

может кто встречался с таким

может кто встречался с таким

а что предшествовало кернел пауэру то глянь в журнале событий

обычно полное отключение это невывоз блока питания пука с просадкой по одной или несколким линиям и уход блока в защиту, или может файлы винды поломались и надо восстанавливать чрез дисм и сфцсканнау, но во втором варике обычно бсод

из-за драйвера видяхи маловероятно, т.к. саму видяху просто ебануло бы и переключило на встройку, если конечно у тебя не старый срузен без встроенного граф ядра

>даже если нету нагрузки, а только был открыт webgui с загруженым в память sdxl чекпоинтом?

а нагрузка на видяху с процем есть даже если ты вебуи запустил, питоновская среда исполнения, в вебуйке даже багуля есть забавная которая ломает карту если недостаточно памяти - вставка через ктрл+в изображения в инпеинт и попытка начать рисовать маску поверх, начинается бесконечное расширение виртуального рабочего разрешения окна для рисования что вызывает фризы вебуя и в итоге краш карты если не успеть нажать крестик на рабочем поле

Спасибо за рассказ про все варианты, я думаю ты прав насчет блока питания, скорее попался дефектный и не держит на малых нагрузках

Вообще хуйня какая-то, БП должен норм держать в простое, это под нагрузкой он может посыпаться если хуевый.

Ну канеш есть еще вариант когда БП и в простое хуевые показатели дает, просто потому что хуевый сам, но тогда отказы были бы и просто при серфинге с выгруженными AI-инструментами.

Бп не модный сосоник невысокой мощности или его аналоги случаем? Они триггерились на всплески потребления амперов-ады, хотя мощность при этом не была превышена.

Были косячные серии, в которых "умная защита" была настроена чрезмерно агрессивно, срабатывание шло по скорости изменения потребления а не самой мощности. Могло отрубить и на малой нагрузке, такие бп меняют по гарантии.

Но это только версия, стоит проверить журнал как расписано

https://www.dns-shop.ru/product/8dfa7785edb83332/blok-pitania-cooler-master-mwe-gold-850---v2-full-modular-mpe-8501-afaag/opinion/

Сейчас долго ставил тесты на стабильность с 10% 40% нагрузкой, а потом комп опять вырубился, да еще и вместе с еще с сетевым фильтром и монитором.

А потом сразу после загрузки винды стал обрывать питание. Резкие всплески при генерации как раз могли тригернуть дефектный бп, который до этого еще держался при стабильных нагрузках. В днс в коментах у некоторых он тоже накрылся. Спасибо за помощь, может по гарантии пройдет

>мусор мастер

Хотел выпендриться? Нет денег - бери любой DeepCool. Есть деньги? Бери дорогой DeepCool. Брат жив: PF750 год 4(!) 3060 непрерывно держал, сейчас PX1000 держит как скала 4090

> DeepCool

Это же китай говна. У кулер-мастера хорошая 1200 платина есть, в отличии от глубокого охлаждения.

Точнее у меня тоже на 750, я его специально брал из этого списка b tier

https://cultists.network/140/psu-tier-list/

> Это же китай говна.

От владельца

>мусор мастер

смешно слышать.