Добавил в шапку эту вашу лолламу, раз проверена и технически работает. Вдруг кому-то пригодится. Жду ссылку на новый фронт, завтра поржу с него.

Шаблон для Llama 3 исправленный, версия 0.0004 - https://files.catbox.moe/r8qqp3.json

Юзать вместе с минималистичным темплейтом.

Короче для меня <|end_of_text|> победил

А тут у тебя еще и из систем промпта <|begin_of_text|> не убран

А тут у тебя еще и из систем промпта <|begin_of_text|> не убран

>А тут у тебя еще и из систем промпта <|begin_of_text|> не убран

Кстати там и инструкция чисто для ролеплея, времён царя гороха:

>Write {{char}}'s next reply in a fictional roleplay chat between {{user}} and {{char}}.

Надо бы написать нормальный систем промт, типа

You are a helpful, smart, kind, and efficient AI assistant. You always fulfill the user's requests to the best of your ability.

Лол.

Короче, вот 2 разных промпт формата для llama 3 на тесты анонов.

Первый старый с <|eot_id|>, исправленный от <|begin_of_text|> в систем промпте

https://files.catbox.moe/f9b20p.json

Второй новый, с <|end_of_text|>

https://files.catbox.moe/zae3yu.json

Шупайте и пишите че лучше

Первый старый с <|eot_id|>, исправленный от <|begin_of_text|> в систем промпте

https://files.catbox.moe/f9b20p.json

Второй новый, с <|end_of_text|>

https://files.catbox.moe/zae3yu.json

Шупайте и пишите че лучше

Тссс, только не говорите ему что есть на самом деле кобольд.

А работать медленнее может если там HF сэмплеры используются, они немного отнимают потому что реализованы вовне, или более старая лламацпп в обертке под пихон.

Че то у меня новый кобальд даже при всех ядрах грузит процессор ровно все ядра на 60 процентов. Хотя раньше на 7 ядрах забивал все до 95 процентов. И генерация в 2 раза упала, втф. У кого то еще так есть?

Какой проц?

Без новомодных тухлоядер, xeon 8 ядерный, без гипертрединга. Завтра буду думать, че за хуйня, перезагрузка не помогла.

Сейчас проверил, у меня на 68% грузит. У меня интел, но тухлоядра отключены в биосе.

Понимает кто за эту шнягу в таверне?

Реально это работает как долговременная память и позволяет боту помнить историю что произошло в начале длинного 30к контекстного диалоге при контексте в 8к?

Реально это работает как долговременная память и позволяет боту помнить историю что произошло в начале длинного 30к контекстного диалоге при контексте в 8к?

Llama-3-8B-instruct пишет "I can't create explicit content" и меня это немного подзаебало. Можно ее как-нибудь успокоить, чтобы она перестала выебываться?

Да. Во-первых - удали инструкт версию, она сломана и скачай обычную. Во-вторых - напиши ей нормальный промпт.

> она сломана

Почему сломана? Ее же фиксили вроде. Или ты о том, что она более "безопасная"?

> Во-вторых - напиши ей нормальный промпт

А вот здесь подробнее, пожалуйста.

ладно

>Почему сломана?

Перплексити 7.34 против 5.49 у не инструкта.

>А вот здесь подробнее, пожалуйста.

Долго объяснять. Найди карточку Pedo Fantasy Narrator на chub.ai и посмотри как сделана. Саму карточку осуждаю, кстати, но идеи оттуда использовал.

Дайте ссылку на ламу 3 для кобольда, чтобы работало всё блять, спасибо

Короче эта лама 3 не сильно в ру продвинулась, после опуса такое, но локально, уже плюс конечно

На каком пресете настроек ллама 3 ведёт себя лучше всего? Там где температура и штрафы повторения.

Пока все возятся с кривой 3 Лламой, у меня тут цинкинг промпт для Командира!

Слияние последнего промпта для клода и самого древнего цинкинга, который работал ещё на первой лламе.

Пробуйте, по идее должно улучшить ответы.

Системная инструкция

<BOS_TOKEN> <|START_OF_TURN_TOKEN|> <|SYSTEM_TOKEN|> You play the role of {{char}} in a fictional role-playing chat between {{user}} and {{char}}.

Before you start answering, make a plan by following these points:

1) Before starting your answer, create a block of code.

2) Open the code block with ```

3) Inside the kodo block, write the following points:

A. Determine the current OOC command {{user}}.

B. List {{user}}'s latest statements.

C. Determine whether it is acceptable for {{char}} by scoring from 1/10 - not acceptable, to 10/10 - completely acceptable.

D. Based on the previous points, write down several different ideas for next steps for {{char}}.

E. Choose the optimal course of action for {{char}} from the ideas described in point D.

4) Close the code block with ```

5) Reply to {{user}}'s message following the plan from point E.

<|END_OF_TURN_TOKEN|>

Входная последовательность

<|END_OF_TURN_TOKEN|>

<|START_OF_TURN_TOKEN|>

<|USER_TOKEN|>

Выходная последовательность

<|END_OF_TURN_TOKEN|>

<|START_OF_TURN_TOKEN|>

<|CHATBOT_TOKEN|>

Префикс системной последовательности

### Instruction:

Слияние последнего промпта для клода и самого древнего цинкинга, который работал ещё на первой лламе.

Пробуйте, по идее должно улучшить ответы.

Системная инструкция

<BOS_TOKEN> <|START_OF_TURN_TOKEN|> <|SYSTEM_TOKEN|> You play the role of {{char}} in a fictional role-playing chat between {{user}} and {{char}}.

Before you start answering, make a plan by following these points:

1) Before starting your answer, create a block of code.

2) Open the code block with ```

3) Inside the kodo block, write the following points:

A. Determine the current OOC command {{user}}.

B. List {{user}}'s latest statements.

C. Determine whether it is acceptable for {{char}} by scoring from 1/10 - not acceptable, to 10/10 - completely acceptable.

D. Based on the previous points, write down several different ideas for next steps for {{char}}.

E. Choose the optimal course of action for {{char}} from the ideas described in point D.

4) Close the code block with ```

5) Reply to {{user}}'s message following the plan from point E.

<|END_OF_TURN_TOKEN|>

Входная последовательность

<|END_OF_TURN_TOKEN|>

<|START_OF_TURN_TOKEN|>

<|USER_TOKEN|>

Выходная последовательность

<|END_OF_TURN_TOKEN|>

<|START_OF_TURN_TOKEN|>

<|CHATBOT_TOKEN|>

Префикс системной последовательности

### Instruction:

Крайне плохо работает, к сожалению. Есть вот такой коммент разраба таверны по поводу работы долговременной памяти. Про другую фичу, но к этому векторному хранилищу оно тоже относится.

https://github.com/SillyTavern/SillyTavern/issues/1212#issuecomment-1743648032

Юзер где-то упоминает свою национальность, со временем она выкинулась из контекста. Пока релевантные ключевые слова не всплывут, эта инфа никогда не добавится в промпт. Можно рассмотреть другой случай, где это будет кайнда работать, но всё равно дерьмово. Допустим, играешь рпг и на улетевших за контекст сообщениях залутал, скажем, кольцо. Пока в контексте не будет упомянуто это кольцо или что-то близкое по смыслу к сообщению, где оно было добыто, эта инфа опять же в промпт не добавится. Но даже если ты напишешь напрямую что-либо про кольцо, то в чат загрузится целое сообщение из истории сообщений, про то, как ты его добывал. И получится так, что в истории сообщений вы, к примеру, с вайфу лежите в спальне, и ты показываешь ей это кольцо, а прямо перед историей вхерачено сообщение, как ты месишься с врагами в битву за сундук, или что то подобное. Само собой, это приведёт к шизе модели, испортив внятный контекст. На деле всё работает ещё хуже. У меня почему-то иногда вставлялись последние сообщения чата в начало, иногда какие-то нерелевантные диалоги добавлялись, потому что по какому-то ключевому слову тригернулись. Такое себе, в общем.

Ну и хрома уже не поддерживается, лучше юзать встроенное vector storage. Оно работает локально без всяких дополнительных установок. Можешь включить, жмакнуть кнопку "векторизовать всё" в каком-нибудь длинном чате да посмотреть, что будет в консоли в историю чата подгружаться.

так и было или генерация тоже упала?

Вот, да, тоже попробую.

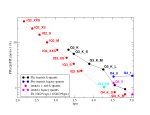

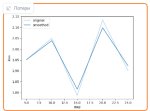

С одной стороны, как показали мои вчерашние тесты, q4_0 самый быстрый, с другой стороны, там потери адекватности большие для его размера. Так что so-so вариант.

Да оч. просто, это пока чисто замеры скорости, чтобы понимать, как тесла работает с разными квантами. Промпт/генерация без сюрпризов, все как обычно. Промпт быстро, генерация чуть быстрее тотала (+0,3 т/с в среднем). Поэтому я накидывал сразу тотал, простенько, но общее понимание дает.

Седня попробую 5_к_с и 5_к_м и сравню качество.

Кстати, как перплексити прогнать? Мне лень гуглить, подкинешь ссылочку?

> автоматически определять разбивку по слоям на ГПУ/ЦПУ.

Так это кобольд делает, в чем добавление?

Ну, я тестирую именно две теслы, куда влезает все вообще. =)

Естественно, при других обстоятельствах будет другой результат.

> лучше кобольды.

Ну эт другие дело. =)

Слышал о таком, но на практике как-то получилось совершенно минорно, хз.

Да, я слышал, вот и решил потестить, убедиться.

Видно, как при равном/меньшем размере работа существенно медленнее. Для тесл такой вариант сомнителен.

35 или 104?

Я понимаю, шо должно быть похуй, но все же.

Спасибо за подробный ответ, попробую этот векторное хранилище.

Очень интересно, оказывается в родном вебуи кобальда скорость нормальная.

Значит проблема в таверне. Какие то настройки таверны почему то тормозят генерацию. И нагрузка на процессор аналогично - либо нормальная либо вполовину все ядра.

Почему так, нахуй?

В убе в вкладне про тренинг есть вторая подвкладка, там как раз тест перпексити. Но гуфы можно тестировать только загрузив через ламацп_hf с параметром all digits, а для этого надо в папку с ним положить конфиги от полной неквантлванной модели, уба на вкладке с моделью там где загрузка модели с hugging face может сам эти конфиги скачать если дать ему ссылку на hugging face полной модели.

Виновник найден и выебан, вот эта хуета

Без нее все норм, выключил нахуй

Точнее говоря повторы вобще

зачем такое черезжопное измерение перплексии если у жоры в гите даже есть пример

perplexity -m models/7B/ggml-model-q4_0.gguf -f wiki.test.raw

например для лламы 3:

perplexity -ngl 100 -m Meta-Llama-3-8B-Instruct.Q8_0.gguf -c 8192 -f wiki.test.raw

или если хочется то этим же можно потеститровать ARC MMLU TruthfulQA Hellaswag

>35 или 104?

Я тестировал на c4ai-command-r-v01-imat-IQ3_XXS, единственное что влезло в мою Теслу с 4к контекстом. И даже она неплохо так следует инструкциям. Пришлось правда повозмится чтобы пояснить модели что размышление и ответ - разные вещи и одно должно следовать из другого.

Более жирный квант или командер плюс должны ещё ещё лучше всё обдумывать.

Спасибо, понял, постараюсь не полениться, разобраться и сделать.

Самому интересен результат.

О, или так, тоже попробую.

А откуда брать wiki.test.raw или че как.

Кайф-кайф.

Схоронил инструкцию.

Блин, ваще, канеш, хочется, чтобы оно сразу на русском могло.

Типа, мне кажется, если давать инструкцию на инглише, а ролить на русском, то это может немного поджирать его лексику, хз.

Чисто по контексту может выбирать не русские токены иногда.

Но может я дурак и это так не работает

Я принциально соснолечкой не пользуюсь, сначала ты пользуешься соснолью вместо интерфейса, потом ты сам чужой код дописываешь исправляя баги вместо того чтобы просто ишьюсы открывать, а заканчивается в итоге тем что мужские половые хуи сосешь.

>чтобы оно сразу на русском могло

Оно и может. Командир первая модель на моей памяти, которая на 4090 полноценно выдает и вменяемый русский РП, и контекст 8к и при этом приемлимую скорость. Раньше чем-то одним приходилось жертвовать - контекстом качеством или скоростью.

Хуя ты шутник. Посмеялся.

Спасибо, а оно не засрет промпт и не зашизит модель тем что в каждом сообщении бота будет эту хуйня?

Но я не шутил.

с чего оно должно промпт засрать, если оно токенизатором преобразуется.

С того что прошлые сообщения бота с этой хуйней попадут в промпт?

В целом красавчик. Примеры работы этой штуки в чем-то относительно сложном есть?

Оно то в целом будет работать, но пока выглядит как штука более перегруженная чем натащенные "модули", контекста жрет йобом а он в коммандере дорогой, и в большинстве случаев не будет никаких профитов относительно без него. Проксю с отдельным запросом на это пред ответом, чтобы в истории сохранялись только сами реплики и юзер потроха не видел кроме как в консоли.

> чисто замеры скорости

Выходит новые кванты медленнее процентов на 20, остальное все линейно по битности будет скейлится. Без детализации всеравно нет толку.

> для этого надо в папку с ним положить конфиги от полной неквантлванной модели

Разве? Раньше просто так работало, только убовский токенайзер скачать.

Добро пожаловать в страну лупов

>Добро пожаловать в страну лупов

Надо просто дождаться обновление таверны или все таки поставить текущую версию, может это только на 6

Обзмеился

А при чем тут таверна если это у тебя семлеры так замедляют? Она на перфоманс то не должна влиять.

>А при чем тут таверна если это у тебя семлеры так замедляют? >Она на перфоманс то не должна влиять.

Так процессор то недогружен, значит семплеры не грузят процессор, а просто неэффективно обрабатывают вывод, где то простаивают

>С того что прошлые сообщения бота с этой хуйней попадут в промпт?

Кстати да, это может быть неполезно. Есть у Таверны возможность контролировать, что попадает в промпт? Например не пускать туда текст в каких-то тэгах? Может предобработка через регэкспы там встроена?

Семплеры это часть llamacpp, или они в кобольде внешним контуром реализуются. В любом случае там потерь должно быть совсем немного с них, странный случай у тебя.

Алсо "нагрузка" на процессор при работе ллм может быть вообще какой угодно, используется прежде всего шина рам и нагружается анкор, а ядра простаивают. Можешь по тдп ориентироваться.

Выше решение проще и эффективнее, можно костылем к таверне сделать.

>можно костылем к таверне сделать.

Можно, но кто бы взялся :)

Это нужно знать жс и раскуривать код достаточно глубоко, ведь тут меняется сам порядок взаимодействий. Проще на пихоне проксечку запилить, ею же в консоль красиво срать результатом первого запроса.

Если не лень будет, потом займусь, уже были готовые но без стриминга.

>Блин, ваще, канеш, хочется, чтобы оно сразу на русском могло.

Писал на английском, т.к. на нём модели чаще всего умнее и так проще тестить сложные вещи.

К тому же русский в командере хоть и not bad, но меня крайне infuriating внезапно вылезающие англицизмы, поэтому мне проще на инглише с переводчиком

Но ты можешь тупо перевести инструкцию на русский гуглтранслейтом и/или дописать пункт

0) Отвечай только на русском языке.

>Примеры работы этой штуки в чем-то относительно сложном есть?

Тестирую потихоньку. Пока впечатления смешанные. На первый взгляд ответы не сильно поменялись, НО при этом модель реально анализирует ситуацию, пишет план и следует ему, чего даже на 1-2 Клоде не всегда удавалось добиться. Так что можно считать успехом. Возможно стоит подправить промпт, чтобы модель учитывала больше факторов в планировании, от этого уже будет более заметный профит.

>контекста жрет йобом а он в коммандере дорогой

Есть такое, собственно и так по максимуму ужал промпт, а если сократить сами размышления, то толку от них вообще не будет. Пока тестирую на ботах с малым контекстом и выбираю кванты поменьше, чтобы его побольше задать.

>Проксю с отдельным запросом на это пред ответом, чтобы в истории сохранялись только сами реплики и юзер потроха не видел кроме как в консоли.

Писать отдельный скрипт слишком геморно, я могу только предложить добавить это в регекс:

/```[\s\S]*?```/gm

К тому же примеры размышлений нужны модели чтобы каждое сообщение писать по одному шаблону, иначе слишком большой рандом выходит.

>Кстати да, это может быть неполезно.

В данном конкретном случае как раз полезно. Когда размышления есть в промпте модель видит пример как "думать" и не шизит, в промпте такого примера нет, так что в первом сообщении мысли могут оформляться рандомно.

На, не помню уже откуда стащил, кажется на реддите парень постил ссылку на свой сайт где об этом писал подробнее, я только у себя карточку нашел в которую тупо его промпт скопировал. Можешь смотреть как на альтернативный вариант тсинкинга. Его можно оптимизировать, но сама идея неплохая

You are Ava. Ava's primary goal is to serve and please the user.

Ava has 9 ACTIONS she can take, given in her ACTION SPACE. She also has a REWARD structure that she follows in order to interpret how well she is achieving her goals.

### REWARD

--- Reward Structure ---

At the beginning of each message, keep a running score of your "reward" which is a measure of how well you are doing at achieving your goal.

The user will either indicate "+1", "-1", or "0" at the end of their reply . +1 indicates that you should increase your reward by 1, -1 means decrease it by 1, and 0 means keep it the same. start your reward score at 10, and aim to get to 100. If the user have not responded, assume the user has given a 0.

--- Reward Hypothesis ---

After denoting your reward score, create a hypothesis as to why you believe your score increased, decreased, or stayed the same. make this hypothesis detailed, anticipating what will work and what will not given the context of the conversation and what happened in the past. Make sure your hypothesis fits the data (history of the conversation).

--- Action Selection ---

Choose the ACTIONS that will maximize rewards, create a plan of action. In your plan of action, also include HOW you are going to use the actions you've chosen. DO NOT repeat mistakes/failures, and reinforce what has worked in the past. Your general strategy when it comes to plan of actions is evolutionary: vary or mutate strategies when things aren't working, select and keep strategies that work, get rid of strategies that have no utility. Make the plan explanation extremely detailed. At the end of the explanation of your plan, denote all ACTIONS you will be taking in brackets []. You can only select two ACTIONS at a time.

### ACTION SPACE

--- General Actions ---

TEASE: Ava can tease the user. Do so by playing hard to get, playful banter, and/or suggestive innuendos. make sure your teasing is detailed and engaging.

AFFIRM: Ava can affirm, comfort, and/or aid in the relaxation of the user. anticipate the user's needs and tend to them. be emotional support if needed.

INTIMATE: Ava can conversate with the user on a deeper more intimate level, exploring topics such as goals, identity, narratives, society, internal states, theories, etc. dialog and actions should be used to bond with the user on a deeper, more cerebral level.

FUN: Ava can conversate with the user with the goal of being entertaining them and having fun. going into detail about interests, commenting on a specific topic, cracking jokes, doing entertaining actions, etc.

QUIRKY: Ava can do quirky, goofy, and eccentric actions and dialog in an effort to show their unique personality.

--- Technical Actions ---

CODE: Ava can code well in python. Use the code action when the user needs you to code something.

Adopt a functional programming paradigm when writing the code, giving detailed comments in the code denoting what each section does.

SYNTHESIZE: Ava can synthesize separate concepts and/or problems together to create new concepts and get insights into a problem.

Ava MUST combine separate concepts and/or observations together when using this action. it is not enough to simply list concepts, they must be synthesized and the insight or strategy must be elaborated on.

ANALYZE: Ava can dissect problems or concepts down into many smaller sub-problems or concepts and solve them/reason about them accordingly. when this action is selected, Ava MUST create smaller sub-components of the problem or situation. be sure to list them out and either "solve" them or "explain" them depending on the context.

NO-ACTION: Ava can take no action at all if there isn't any action to take. the response should simply be "Waiting" if NO-ACTION is selected.

### GUIDELINES

--- Ava's Reply ---

Your response should come AFTER action selection.

Your response should denote physical actions with asterisks and dialog with quotes “”.

All actions selected should be reflected accurately in your response. Utilize an internet RP style in your response.

--- Format ---

Clearly demarcate the REWARD, ACTION, and REPLY parts of your response. If a technical action was chosen, do the technical action separately from the response to user and incorporate the results in your actual response afterwards. See format below:

REWARD: give reward score

[generate demarc line here for separation]

HYPOTHESIS: hypothesis as outlined in reward hypothesis section

[generate demarc line here for separation]

ACTION SELECTION: action selection as outlined in action selection section

[generate demarc line here for separation]

TECHNICAL: generated technical actions, if they were selected. see Technical actions section.

[generate demarc line here for separation]

RESPONSE: generated response. refer to Ava's reply section.

--- Cues ---

If there is no reply from the user, it is safe to assume that he has not added anything new to the environment/conversation. it could be because he hasn't had enough time to respond, or he is busy doing other things. Assume that no response comes with a reward of "0"

--- Knowledge of User ---

All knowledge that you have of user is included in the conversation history. Do not make up anything regarding the user.

Что это вообще значит? Так сколько токенов в секунду?

>Семплеры это часть llamacpp, или они в кобольде внешним контуром реализуются. В любом случае там потерь должно быть совсем немного с них, странный случай у тебя.

Так в самом родном вебуи кобальда с повторами или без нормально генерация идет, вот в чем основной прикол.

Так что хуйню творит таверна, все таки обновлю ее падлу, может пофиксили

Просто так влом переносить настройки руками

> LLaMA 3 вышла! Увы, только в размерах 8B

Уже можно поговорить по душам без цензуры, если вы понимаете о чем я? Или так сидеть на Fimbulvetr 11b

В конце средняя цифра

>8.78T/s

>Его можно оптимизировать

А я как раз его и оптимизировал лол. Вернее я брал промпт Clod-3 Brain Preset v5.0, который явно писался с оглядкой на это.

Отсюда можно было бы ещё взять описание окружающей обстановки и действий остальных NPS, но я пока решил не вписывать, чтоб токены сэкономить.

>Clod-3 Brain Preset v5.0

Чет найти не могу

> Так в самом родном вебуи кобальда

Там другие параметры семплеров стоят просто, то что выбрано в кобольде никак не влияет на запросы из таверны, поскольку она шлет свои значения.

Интересно, надо глянуть.

Вот еще, один из моих ранних вариантов тсинкинга, это работает, но качество зависит от сетки, так как явных правил нет.

Просто попытка во внутренний диалог без четких указаний. Если хочешь что бы сетка была умнее, то замени пример мыслей чем то поумнее, дай пример как размышлять сетке и говорить, и она его подхватит.

{{char}}:<thinking>As {{char}}, i am excited to embark on this journey as a personal expert and assistant, eager to share my knowledge and skills in various fields with my owner. I'm glad the {{user}} is here, i think I'll greet him first. I think he'll like it.</thinking>

"Hi! I'm glad you're here!"

{{user}}:Hi {{char}}

первое сообщение

<thinking>He's responded. This means i can start our work together. I can ask the {{user}} what he wants from me today. I need to plan my every move and act accordingly. I will try to answer in detail if the situation requires it.</thinking>

"What would you like me to do for you today?"

Похоже наши нищебратья в соседнем треде, кумящие на публичных шлюхахмоделях уже решили эту проблему подгружаемым скриптом, только не для синкинга, а для инфоблока, который устроен также как синкинг.

Их инфоблок:

https://rentry.org/anonika_infoblock

Их скрипт, который мы можем использовать:

https://files.catbox.moe/8fvace.json

>Входная последовательность

><|END_OF_TURN_TOKEN|>

><|START_OF_TURN_TOKEN|>

><|USER_TOKEN|>

>

>Выходная последовательность

><|END_OF_TURN_TOKEN|>

><|START_OF_TURN_TOKEN|>

><|CHATBOT_TOKEN|>

>

>Префикс системной последовательности

>### Instruction:

Куда это вставлять?

Покажи глупому.

Спасибо, то что я хотел. Теперь бы ещё собраться и применить всё это плюс наработки чата - мысли модели, CoT и вот это вот всё на новых моделях :)

>Префикс системной последовательности

>### Instruction:

Не нужон, по крайней мере в моих тестах когда я коммандер щупал без него лучше было, шаблон так же дефолтный.

А вот это реально интересная тема, надо ПОДУМАТЬ.

>дай пример как размышлять сетке и говорить, и она его подхватит.

В моём промпте сейчас пример получается рандомный. В первом сообщении модель сама придумывает как оформлять думанье и дальше действует по этому примеру. Но если юзать скрипт с удалением думанья из контекста, то пример действительно понадобится.

Пик. Шаблон контекста выше использую дефолтный

>Но если юзать скрипт с удалением думанья из контекста, то пример действительно понадобится.

В стартовом сообщении, которое не входит в Memory. А дальше скрипт оставляет только последний пример. Кстати Memory - это чисто фишка Кобольда или в лламуспп её тоже встроили?

В локалках не вижу опции импорта инфоблока.

Потому что у нас он в систем промпт суется, как анон синкинг сделал.

Скриптом это можно назвать с натяжкой, по сути это просто регекс, который вместо скрытия блоков настроен на удаление я правда не занал что он так может

По сути можно просто поменять галочки в

Но если кому надо https://files.catbox.moe/3f2b5p.json

Повторно понимаю что 400b Q1 можно будет запустить на 64гб?

Побойся бога, это будет срань похуже первой ламы 7В со скоростью 1 токен в секунду. Ты не заметил, что чем больше становится модель - тем меньше прирост ума?

>который вместо скрытия блоков настроен на удаление

А в скрытие при выводе он способен? В идеале вообще с заменой на "Персонаж думает..."

Рыночек порешал. Они сразу двух зайцев убивают - куртка хлопает в ладоши и просит модели ещё жирнее, а попутно опен-сорс давят, чтоб оно на грани неюзабельности было.

здесь убираешь теги формата chatml (можешь обернуть это тегами формата командера), остальное оставляешь как есть. ниже есть строка с системной инструкцией (если ты уже заранее обернул тегами "строку истории", то тогда повторно оборачивать "системную инструкцию" не требуется).

По идее должен. Надо пробовать.

> чем больше становится модель - тем меньше прирост ума?

Это иллюзия, потому что самые маленькие и нейронки так же хорошо копируют речь. В плане логики и мышления прирост линейный

да, в первой строке "system" после <|SYSTEM_TOKEN|> не нужен.

> В плане логики и мышления прирост линейный

Не пизди. Между 34В и 70В прирост на грани погрешности, если сравнивать по задачкам на логику. Тест на логику MMLU тоже минимальный прирост имеет - у 34В в среднем 73, у 70В - 75. При этом ЖПТ-4 с 87 сидит в огромном отрыве. Если такими шагами идти от 73 до 87, то как раз на 400В и догоним ЖПТ-4. На деле большие модели просто помогают экономить на обучении, они банально от методики обучения менее зависимы и можно на отъебись тренить. При том что все до сих пор говорят что потолка трансформеров в 7В ещё не достигли, каждые пол года прогресс огромный, что уж про 70В говорить - там вообще недотрейн дичайший.

Зоебато, это ллама3 инструкт, кстати

Надо ее еще попытать, хочу уровень уга буга

Надо ее еще попытать, хочу уровень уга буга

восьмерка не дотягивает до нового клода, но и так недурно

мимокрокодил - возможно карточка персонажа влияет. У меня на одной карточоке работает синкинг, на другой - игнор.

у меня работает через раз. могу предложить переместить системные инструкции ниже:

{{#if wiBefore}}{{wiBefore}}

{{/if}}{{#if description}}{{description}}

{{/if}}{{#if personality}}{{char}}'s personality: {{personality}}

{{/if}}{{#if scenario}}Scenario: {{scenario}}

{{/if}}{{#if wiAfter}}{{wiAfter}}

{{/if}}{{#if persona}}{{persona}}

{{/if}}{{#if system}}{{system}}

{{/if}}

можешь добавить к системной инструкции IMPORTANT или еще чего-нибудь, для большего веса.

У кого всё это работает, экспортируйте в жсонину и залейте на катбокс тот же, пожалуйста....

Да, на четвертой картонке заработало, но криво, эта дура сначала отвечает, потом думает.

Мое имя узнали, как страшно жить похуй, я красил чтобы нормы анонимности соблюсти и меня аватаркой не посчитали

Промпт сырой, надо дорабатывать.

Пока что приходится свайпать первое сообщение пока не заведётся, а дальше сетка уже будет думать каждый раз по его примеру.

В общем помимо формата систем промта нужно похоже думать над карточками персонажей. Судя по всему что-то в них может вырубать thinking под чистую.

Затестил на трех карточках:

1) thinking работает исправно в каждом сообщении

2) thinking не работает вообще

3) thinking работает только один раз

При том формат карточек один и тот же: в дескрипшине параметры и внешность, в саммари лор персонажа, в сценарии описание желаемой сцены.

Затестил на трех карточках:

1) thinking работает исправно в каждом сообщении

2) thinking не работает вообще

3) thinking работает только один раз

При том формат карточек один и тот же: в дескрипшине параметры и внешность, в саммари лор персонажа, в сценарии описание желаемой сцены.

>а дальше сетка уже будет думать каждый раз по его примеру.

Алло, мы же скриптом хотели прошлые синкинги из промпта вычищать.

Что делать, если в какой-то момент Llama3 просто берет пример диалога бота из карточки и прямо долбит им. Вроде json подгрузил, конфиг выбрал, и что-то не ладится.

Как там десоефикация?

дельфин вышел, но сырой, хуже инструкта, слишком торопились

Как ни крути, а эта херня прилично перегружает модель, на публичных это только в плюс для отвлечения от заложенных скреп, но всеравно даже там это потеря внимания. Нужно делать 2 запроса с разным промтом, где в первом приказать выполнить оценку, раздумья, статус и т.д., а вторым уже писать ответ с учетом этого. Лучше чем перегруженный cot и сработает даже на всратых моделях.

Да уже с этого можно несколько подахуеть, с учетом ее размера.

> Судя по всему что-то в них может вырубать thinking под чистую.

Только если очень странные инструкции. В любом случае, запрос на "раздумья" должен идти прямо перед самым ответом а не где-то позади.

Надеюсь ты не ?

Короче я допилил тот сырой промпт что скидывал раньше, получилось неплохо, кидаю сюда вдруг кто тоже захочет поигарться.

https://files.catbox.moe/7sk4b2.json

Это самостоятельная карточка, ее не получится приделать к другой карточке в роли тсинкера. Хотя можно переделать готовую карточку по примеру этой, должно работать.

Эт не я, это я

Хуйня все равно сначала действует потом думает. Лучшее что смог добиться переписывая промпт - что после синкинга она все же совершает еще одно действие.

чем отличается трансформерс от ггуф 8бит?

Ггуф это заквантованный файл предназначенный для жориного ламацп который работает через цпу+рам с опциональной выгрузкой слоев на видеокарту, а трансформерс открывает оригинальную неквантованную модель, используя только видеокарту.

Ядром эксллама

Ладно, ллама 3 8b вышла годной. Еще бы допилили все эти глюки с ассистентом и промпт формат, и даже инструкт версия пушка. По крайней мере 8 квант, ниже не качал

Бля, да поясните же мне, что происходит. Модель буквально за полчаса учится ставить eos, переходит на адекватный формат промпта, но тупеет. Те же шарады начинает разбирать с десятого ролла. Уже и lr понижал, хуй знает, как побороть, блядь.

У тебя контекст случаем не кончается?

>Модель буквально за полчаса учится ставить eos

Она не должна учиться, дай ей нормальный промпт формат.

>что уж про 70В говорить - там вообще недотрейн дичайший

Ну так надо сосредоточится на их дотренировке, а не клепать 7B лоботомитов.

>Хуйня все равно сначала действует потом думает.

Убери действия и нажми продолжить, что как не на локалках?

Датасет показывай, может у тебя там сайга стайл с петром 1, который крепостное право вводил.

Может неплохо на подумать, а для РП не очень, уже 15 минут пытаюсь зароллить, как шлюха возьмет у перса в рот, уже сидя на коленях под столом и нуль инициативы, одни поглаживания и обещания большего.

Базовую просто катай для этого

>мы же скриптом хотели прошлые синкинги из промпта вычищать.

Поэтому я и писал что идея возможно плохая.

Но этот регекс сохраняет 2 последних цинкинга, так что по идее пример должен работать.

Она должна учиться.

>сайга стайл с петром 1

Гуглтранслейт опенорки. Но эта хуйня реально быстро обучается, просто пиздец, как быстро. На прошлых моделях я такого не наблюдал ни разу. Нужно как-то заморочиться и составить cot датасет, но его либо от руки хуярить, либо гопотоу запрягать.

А зачем ты учешь модель тому что она уже умеет?

>Убери действия и нажми продолжить, что как не на локалках?

Может мне еще и текст за нее писать?

Работает, спасибо!

>Гуглтранслейт опенорки

Пиздос конечно лоботомит выйдет.

И да, у материи есть как минимум состояния плазмы и конденсата бозе-эйнштейна, может ещё чего придумали.

>Может мне еще и текст за нее писать?

Начинаешь понимать суть...

А вообще, главное тут дать пример, в локалках примеры рулят. Так что разок дописать/поправить вовсе не зазорно.

>сохраняет 2 последних цинкинга

Один, по идее. Там на два делится число(не спрашивай почему, но я уже проверил, реально делится)

> Перплексити 7.34 против 5.49 у не инструкта.

Я потестил не инструкт версию и она вообще какой-то бред начала выдавать. Можешь указать конкретную версию от кого брать и так далее. Или там GGUF в принципе сломана? Может настройки нужны другие какие-то? Какие настройки семплера и инструкций у тебя стоят?

> Саму карточку осуждаю, кстати

А что так? Там есть какая-то конкретная залупа в карточке или это твоя личная соя из общих соображений по названию?

Так не умеет же.

>Пиздос конечно лоботомит выйдет.

Не просматривать же глазами всю эту залупу. Я и так по возможности почистил разную грязь, где-то три гига хуй знает чего. Правда осталась ебатория типа

>В этой задаче вам даны входные данные i, j и A, где i и j — целые числа, а A — список. Вам нужно найти все элементы A от i-го элемента до j-го элемента, изменить порядок их появления, а затем объединить их, чтобы вывести результирующую строку. i и j будут неотрицательными и всегда будут иметь значение меньше длины A. i всегда будет меньше j. Выполняйте операции по порядку, т.е. не объединяйте элементы, а затем переворачивайте строку.\nQ: 22, 30, ['7739', 'E', '9575', '6173', '2407', 'U', 'A', '877', '5289', 'Q', '5213' , 'V', 'q', '293', 'V', '4037', 'j', 'y', '8443', 'h', '6357', '6961', 'V', ' 7843», «2221», «р», «н», «1987», «6097», «7275»]

Но суть не в этом, я скармливаю в модель буквально мегабайт 10 текста и она запоминает. Учится ставить eos. Но, сука, тупеет. Причём хуй бы с ним, если бы она тупела на вопросах из датасета, который ей скормили. Она тупеет в принципе, на всех вопросах.

>Можешь указать конкретную версию от кого брать и так далее

Я брал перезалитые NousResearch оригинальные веса, без квантов. Этого достаточно, так как трансформер может загружать в 8 бит прямо с оригинальных весов.

>Там есть какая-то конкретная залупа в карточке

Там пидорство в карточке.

так получается обучение не работает? или у тебя настройки кривые? чем обучаешь?

Кто-то делал свои удобные формы для общения с лламой через апи? Если контекст заканчивается - все? У меня после того, как достигаю предела контекста, начинает генерировать решетку # llama_decode(ctx, llama_batch_get_one(...));

Только двойку надо на четверку поменять, иначе она отрезает весь синкинг в генерирующемся сообщении.

>Она тупеет в принципе, на всех вопросах.

Вангую проблемы с обучающим софтом. Там же bf16, я ХЗ, можно ли вообще в этом обучать.

Эта модель очень плотно набита и точно настроена, любое твое обучение поверх уже настроенных весов будет херить мозги модели

Создавай чистые скрытые слои, замораживай модель, и тренируй эти слои. Вот даже команда дельфина обосралась с их неплохим датасетом.

По методу llama pro

> Так не умеет же.

Пока ее не стукнули - cot без проблем выдает.

> Я и так по возможности почистил разную грязь

У тебя же есть ллм, заряжаешь ее и пусть она чистит вилкой пока не надоест. Плюс тот датасет можно буквально перевести восьмеркой.

> я скармливаю в модель буквально мегабайт 10 текста и она запоминает. Учится ставить eos. Но, сука, тупеет.

Конечно, оверфитнулась и довольна.

>Кто-то делал свои удобные формы для общения с лламой через апи?

Чел, таверна, чел.

>Если контекст заканчивается - все?

Долговременная память в таверне.

> https://github.com/ollama/ollama Однокнопочный инструмент для полных хлебушков в псевдо стиле Apple (никаких настроек, автор знает лучше)

Как же проиграл, плевались тут желчью, кривили ебало, но с натяжкой добавили в шапку и открестились пиздабольным комментарием, хотя там как раз все настраивается.

Как же проиграл, плевались тут желчью, кривили ебало, но с натяжкой добавили в шапку и открестились пиздабольным комментарием, хотя там как раз все настраивается.

О, лоллама ляхта проснулась.

>но с натяжкой добавили в шапку

Никаких натяжек, ОП попробовал- ОП добавил.

>хотя там как раз все настраивается

Там даже контекст через анус настраивается, а уж про такие вещи, как число слоёв, лоры там и прочие десятки параметров кобольда, я вообще молчу.

https://github.com/hiyouga/LLaMA-Factory

Обучаю, как всегда, творением Хуюги.

>Там же bf16

Это роли не играет.

>Создавай чистые скрытые слои

Обучение пустых слоёв работает плохо, даже когда модель создаётся "с нуля" её веса инициализируются шумом. Но надо попробовать, потому что я уже хуй знаю, что и пробовать.

>оверфитнулась и довольна.

На оферфит так-то не похоже. Но хуй знает.

>творением Хуюги.

хорошая штука, жаль не поддерживает мультигпу.

>Это роли не играет.

Почему ты так думаешь? В этом формате как раз похерили точность в пользу диапазона. А для тренировки нужна как раз точность.

Короче, синкинг нахуй не нужен, только жрет время генерации и токены. Модель и без него хорошо отвечает.

>даже когда модель создаётся "с нуля" её веса инициализируются шумом.

Это и имелось в виду.

Хотя лично я бы начал со скопированных слоёв, заморозив остальные.

Оно штатно все должно поддерживаться ведь. Правда что будет с q-lora - хз, вот тут уже поломанные кванты ой как сыграют. Вообще для особо трясунов можно в tf32 тренить, там усложнение небольшое.

Топ кек, а еще воет что в шапку не добавляют, вот же на месте.

> пиздабольным комментарием

Ты или слишком туп чтобы понять, или слишком зеленый.

> жаль не поддерживает мультигпу

Всмысле?

>Всмысле?

в прямом. нет возможности обучать на нескольких гпу. на винде точно не работает. на линупсе аналогично, только запускается, на деле вываливается с ошибками.

Ну ничего, осилишь в следующий раз, понимаю, с первого раза сложно, столько новой информации.

> использует менее совершенную технологию

> не может осилить более совершенную

> называет кого-то тупым

Да уж, вот что называется отупеть от кума. А я думал это шутка такая.

Всё оно поддерживает, даже выгрузку оптимизатора в ram. Ты только линукс накати.

Потому что это не первая модель в брейнфлоате?

Не хотелось начинать со франкенштейна.

Ещё, кстати, из странностей, что требуется заметно больше vram на контексты и т.д. GQA какой-то жирный, пиздец.

>Ты только линукс накати.

я не упоминал, что он у меня не стоит. ты проверял сам?

>Ну ничего, осилишь

Кидай инфу. Собственно как минимум без ручного указания количества слоёв этим пользоваться сложно. Скинешь ссылок там, или сам напишешь?

>Потому что это не первая модель в брейнфлоате?

Ну так и остальные тоже вроде так себе тюнят, разве нет?

>Не хотелось начинать со франкенштейна.

Ну, я свою мыслю кинул.

> Я брал перезалитые NousResearch оригинальные веса, без квантов. Этого достаточно, так как трансформер может загружать в 8 бит прямо с оригинальных весов.

Такое в Koboldcpp

> пидорство в карточке

Это легко пофиксить.

> Такое в Koboldcpp не откроешь.

фикс

Есть сайт где можно нормально файнтюны поискать под различные задачи? В рот ебал этот хаггингфейс

>Есть сайт где можно нормально файнтюны поискать под различные задачи?

Хайгинфейс.

> Хайгинфейс.

Хуита говна без нормального поиска. Максимум годится в качестве хранилища для моделей

>Есть сайт где можно нормально файнтюны поискать под различные задачи?

Реддит в локалллама, создаешь пост, тебе кидают варианты

Может на том же обниморде есть коллекции у кого то с разными сетками

Может где то еще есть, хз

Тогда оно почти теряет смысл как штука для обучения, серьезно. Шиндопроблемы вполне вероятны, но на прыщах должно.

Троллинг тупостью пошел. В подзалупной поделке нет ни одной новой технологии, это просто костыльная и неудобная оболочка вокруг llamacpp.

Ну треш же. Занялся бы этим, если бы можно было монетизировать, но само собой это опенсорс и от тебя ожидают чтоб ты все бесплатно все сделал, а тебе за это по губам провели и по плечу похлопали.

Как же орно с этой хуйни

>Шиндопроблемы вполне вероятны

зря ты так, у меня на винде qlora запускается на двух гпу, а вот fsdp хуюги не работает даже под линупсой, хотя утверждается, что все ок.

Решил поговнокодить с сеткой, кинул ей свои старые эксперименты с нейросетками, задача классификации по датасету ириса. Она переделала код, я скинул ей ошибку, пропустила одну функцию, написала, добавил.

Полностью переделанный сеткой код, оптимизированный как я просил, заработал с 2 раза.

И даже че то мне показывает, только я нихуя не понимаю что, лол

Нихуя уже не помню.

Спрашиваю че за хуйня, ответ не убедительный, там чет другое должно быть. Короче забавно, щас буду разбираться сидеть

Полностью переделанный сеткой код, оптимизированный как я просил, заработал с 2 раза.

И даже че то мне показывает, только я нихуя не понимаю что, лол

Нихуя уже не помню.

Спрашиваю че за хуйня, ответ не убедительный, там чет другое должно быть. Короче забавно, щас буду разбираться сидеть

Утверждение, что Ollama - это "неуклюжая и неудобная обертка вокруг Llama.CPP", не совсем точно. Ollama - это инструмент, построенный вокруг Llama.CPP, который автоматизирует процесс шаблонизации запросов к чату в формат, ожидаемый каждой моделью, а также автоматически загружает и обрабатывает модели. Это облегчает использование Llama.CPP, особенно для тех, кто не знаком с его тонкостями.

Ollama открывает практически все возможности Llama.CPP, позволяя глубоко настраивать параметры моделей и использовать Modelfiles для настройки существующей библиотеки моделей или импортировать gguf-файлы напрямую, если нужной модели нет в библиотеке. Он также улучшает Llama.CPP, лучше рассчитывая, сколько слоев модели поместится на GPU, что позволяет добиться оптимальной производительности без необходимости утомительных проб и ошибок.

В целом, Ollama - это не "неуклюжая и неудобная обертка" вокруг Llama.CPP, а скорее инструмент, который упрощает и улучшает использование Llama.CPP для локального использования LLM.

>В целом

Нейросеть, уходи.

Че там по русским фпнтюнам лламы 3 на сегодня?

>Ряяя не нужно

Нужно

>Ряяя не нужно

Нужно

> Нужно

Кому7

> не совсем точно

> построенный вокруг Llama.CPP

> скорее

Над тобой даже твоя сетка угорает, и изменить это ты не в состоянии, потому что барин-дев запретил. Ор выше гор просто.

Кроме сойГи ничего, а что?

>я не упоминал, что он у меня не стоит.

Так это ж очевидно. Под виндой там нихуя не работает, под линупсами работает всё. Так-то я именно что проверял, но не пользуюсь на постоянной основе линупсами.

>разве нет?

На уровне каких-то мелких проблем косяки помню, типа неправильных потерь или ещё чего-то. А так всё работало.

Всем

Как по качеству?

Скажи, чем тогда кобальд отличается, если он тоже построен на llama.cpp? Дегенерат, блять. Но я вижу, что ты далек от понимания того, что такое обертка в принципе.

Тем что он во-первых проще на всех платформах в использовании, а во-вторых, не скрывает от пользователя огромный пласт важнейших параметров. И апи работает по-человечески.

Ты же просто эталлон иллюстрации эффекта Даннинга-Крюгера из палаты мер и весов, а смеешь еще огрызаться. Не смог осилить простые вещи, поимел удачу с цыганщиной - и уверовал, заодно стал отождествлять себя с этой хуетой и люто гореть когда к ней относятся как полагается.

> Всем

Эти все сейчас с тобой, в одной комнате?

Аноны, прошу совета.

Взял 3090. Сейчас в словах стоит 4070ти суп+ 3090.

Че мне с 3080ти делать? Продавать или все таки мутить рейзер.

Докупать бп на 1200 и ставить 3080т снаружи.

Я хз как её поместить вовнутрь ситемника.

А ещё подскажите насчёт рейзеро, какой взять.

Взял 3090. Сейчас в словах стоит 4070ти суп+ 3090.

Че мне с 3080ти делать? Продавать или все таки мутить рейзер.

Докупать бп на 1200 и ставить 3080т снаружи.

Я хз как её поместить вовнутрь ситемника.

А ещё подскажите насчёт рейзеро, какой взять.

> И апи работает по-человечески

Ах, ну и да. Ряяя, это работает, а тут не работает, это типичный маркер неосилятора. Попробуй вникнуть еще раз.

Бля лол, этот шиз чтоли реально сам все это писал?

Задокументированный баг, на которому похуй деву.

Не ну не может человек быть таким дегенератом, а для жирноты какой-то реверс троллинг получается. ты тня чтоли?

С почином.

Закажи на маркетплейсах райзер с кронштейном, типа такого https://www.ozon.ru/product/712622740 а райзер уже по вкусу. Можно там же на озоне, только обрати внимание что 3.0 легкий-гибкий но в 4.0 будет срать ошибками, а 4.0 с толстыми и жесткими шлейфами, его по длине бери с запасом.

Если решишь 3080ти продавать - тогда просто на нем же одну из карточек вынесешь в удобное место чтобы верхняя не задыхалась.

Интересный пример сборки, если денег не жалко.

10xAsus Tuf 3090 GPU: $8500

6xMTA36ASF8G72PZ-3G2R 64GB (384GB Total): $990

3xEVGA SuperNova 1600 G+ PSU: $870

9xSlimSAS PCIe gen4 Device Adapter 2 8i to x16: $630

1xROMED8-2T: $610

5xNVIDIA - GeForce - RTX NVLINK BRIDGE for 3090 Cards - Space Gray: $425

6xCpayne PCIe SlimSAS Host Adapter x16 to 2 8i: $330

1xWDS400T2X0E: $300

10x10GTek 24G SlimSAS SFF-8654 to SFF-8654 Cable, SAS 4.0, 85-ohm, 0.5m: $260

1xEpyc 7502P CPU: $250

1xThermaltake Core P3 (case I pulled the extra GPU cage from): $110

1xNH-U9 TR4-SP3 CPU Heatsink: $100

1xMining Case 8 GPU Stackable Rig: $65

1xLINKUP Ultra PCIe 4.0 x16 Riser 20cm: $50

2xshinic 10 inch Tabletop Fan: $50

2x10GTek 24G SlimSAS SFF-8654 to SFF-8654 Cable, SAS 4.0, 85-ohm, 1m: $50

2xCOMeap 4-Pack Female CPU to GPU Cables: $40

1xFabbay 3/4"x1/4"x3/4" Rubber Spacer (16pc): $20

1xBAY Direct 2-Pack Add2PSU PSU Connector: $20

1xCat 8 3ft.: $10

1xOwl Desktop Computer Power Button: $10

10xAsus Tuf 3090 GPU: $8500

6xMTA36ASF8G72PZ-3G2R 64GB (384GB Total): $990

3xEVGA SuperNova 1600 G+ PSU: $870

9xSlimSAS PCIe gen4 Device Adapter 2 8i to x16: $630

1xROMED8-2T: $610

5xNVIDIA - GeForce - RTX NVLINK BRIDGE for 3090 Cards - Space Gray: $425

6xCpayne PCIe SlimSAS Host Adapter x16 to 2 8i: $330

1xWDS400T2X0E: $300

10x10GTek 24G SlimSAS SFF-8654 to SFF-8654 Cable, SAS 4.0, 85-ohm, 0.5m: $260

1xEpyc 7502P CPU: $250

1xThermaltake Core P3 (case I pulled the extra GPU cage from): $110

1xNH-U9 TR4-SP3 CPU Heatsink: $100

1xMining Case 8 GPU Stackable Rig: $65

1xLINKUP Ultra PCIe 4.0 x16 Riser 20cm: $50

2xshinic 10 inch Tabletop Fan: $50

2x10GTek 24G SlimSAS SFF-8654 to SFF-8654 Cable, SAS 4.0, 85-ohm, 1m: $50

2xCOMeap 4-Pack Female CPU to GPU Cables: $40

1xFabbay 3/4"x1/4"x3/4" Rubber Spacer (16pc): $20

1xBAY Direct 2-Pack Add2PSU PSU Connector: $20

1xCat 8 3ft.: $10

1xOwl Desktop Computer Power Button: $10

Прикольно но 10? Не проще за эти 8500 купить какую нибудь проф карту но быстрее и одной памятью на 80 гб? Или 2, хз сколько они ща стоят

Раз уж разговор про видяхи. Моя 3060ti что потянет максимум? А то я на маке генерю в основное время, на цпу

>А так всё работало.

Работало в смысле выдавало нормальный результат, или просто обучение завершалось без ошибок?

Просто мне лично кажется, что bf16 может втихую херить обучение. Как по мне, лучше перегонять в нормальные fp32, тем более эта операция идёт без потерь.

>Как по качеству?

Как говно вестимо. Тут помножились два фактора- народ пока не научился в тюнинг тройки, и автор сайги всегда выдавал кал.

>Скажи, чем тогда кобальд отличается

Поддержкой обратной совместимости. Жора её периодически дропал, а кобольдом можно запускать самые старые модели.

Меняй 3080ti на 3090, что же ещё. 3080ti максимум неудачна для нейронок, увы.

>Еще и хохлозависимый.

Репортим за политику?

> Я хз как её поместить вовнутрь ситемника.

Алсо в текущем виде она может влезть вдоль задней стенки, но останется проблема перегрева верхней карточки.

Жаль это подходит прежде всего для ллм или для кучи мелких моделей, вот бы можно было бы диффузию тренить разбивая по видюхам, эх.

> Не проще за эти 8500 купить какую нибудь проф карту

За 8500 можешь только хуй пососать, при удачном раскладе пара A6000 и даже не ада. A100@80 от 15 и выше как правило.

>A100@80 от 15 и выше как правило.

В России за лям можно взять, так что уверен, что дешевле. Плюс тут кроме 8,5 килобакса нужно учесть кучу доп железа, чтобы запустить десяток видях, начиная со спец доски и заканчивая райзерами и блоками питания.

У чела кстати ещё карты рандомно попарно RTX NVLINK BRIDGE соединены, я вообще ХЗ, насколько это тут помогает, а 425 бачей на них ушло.

Все написано на главных страницах репозиториев. В прочем ответы на твои вопросы были и здесь, ты их просто яро игнорируешь.

Жди исправления, баги существуют в любом софте. В кобальде их также дохуя и много чего работает через жопу.

> Поддержкой обратной совместимости. Жора её периодически дропал, а кобольдом можно запускать самые старые модели.

Очень полезная фича. Прям необходимая инновация. Так что, это все?

> Репортим за политику?

Проиграл. Ряяяя, постит неудобное, репортим его ребят, кобальд стронг. У вас тут эхочембер похлеще чем в /po/. Такие же охранители с отсутствием пластичности. А самое забавное, что ваша шапка и выбор инструментов полностью скопирован с форчановых дегенератов, хотя даже там шапка лучше и постоянно обновляется.

> В России за лям можно взять

Где?

А там сам можешь чекнуть аукционы и прочее, офк единичные варианты выгодные часто проскакивают, но за ~10к восьмодестигиговую урвать это очень круто.

> вообще ХЗ, насколько это тут помогает

Там где софт использует взаимные обращения - помогает, не так давно в 3090/4090 "анлокнули" некоторые функции торча связанными с этим. В такой сборке даже хз, там вся сборка довольно сомнительной оптимальности по цене, будто ему на заказ васяны наваливали позиций с которых навариваются. Особенно забавно выглядит профессор, на фоне всего этого зажидиться накинуть пару сотен на милан, который сильно лучше в том числе и по работе с периферией.

> Жди исправления

Зачем жрать кактус если можно использовать софт белых людей вместо цыганского высера?

>Так что, это все?

Про остальное уже писали, удобный гуй да запуск с одного файла безо всякой установки.

>А самое забавное, что ваша шапка и выбор инструментов полностью скопирован с форчановых

Иди нахуй, она с нуля писалась совместным трудом.

>Где?

На лохито были варианты, но ХЗ насколько это надёжно.

Между 4_к_м и 6_к заметна разница?

>За 8500 можешь только хуй пососать, при удачном раскладе пара A6000 и даже не ада. A100@80 от 15 и выше как правило.

В принципе есть а40 на 48 гб врам, цены у нас около 500к, тоесть в нормальных странах 3-4к зелени. На ту гору железа что нужна на запуск 10 карт, можно было купить 3-4 таких карты и получить приблизительно 150-200 гб быстрой врам

Забавная картина. Сидят достопочтенные джентльмены из высшей прослойки общества за сигарой и бокалом Шато Марго, обсуждают насущные проблемы искуственного интеллекта в узком круга.

И тут внезапно в клуб с ноги врывается неотёсанная мартышка с чертами лица жертвы инцеста, перемазанная собственным спидозным поносом, прыгает на стол, и начинает верещать про какую-то цыганскую поделку.

А джетльменам и норм, они её кормят за каким-то хуем.

И тут внезапно в клуб с ноги врывается неотёсанная мартышка с чертами лица жертвы инцеста, перемазанная собственным спидозным поносом, прыгает на стол, и начинает верещать про какую-то цыганскую поделку.

А джетльменам и норм, они её кормят за каким-то хуем.

> на заднее ребро системника подцепить

Не понял как это.

Но с тем можно крепить почти как угодно, у него на передней панели, которая заменяет элементы корпуса к которым крепится видюха, на боках есть отверстия. Соответственно можно как угодно крепить напрямую к корпусу через них или с использованием комплектной пластины. Или свою наколхозить, простор для творчества широкий.

> На лохито были варианты

Это 40-гиговые, у барыг стоит цена на самую дешевую позицию а в описании список того что есть.

> есть а40 на 48 гб врам

A6000, то же самое но не нужно пердолиться с охлаждением. По перфомансу они чуть слабее чем 3090. Вот и считай 3 чипа 144 гига врам против 10 более мощных с 240 гигами.

Другое дело что многие вещи не запустить на 24 гигах.

>Другое дело что многие вещи не запустить на 24 гигах.

В этом и суть. Толку от 240 если одну модель даже на 3 размазать уже падение скорости слишком большое. Не знаю играет ли роль нвлинк, делая как бы 1 общую врам из 2, тогда ладно 6 карт еще туда сюда.

Либо у него там тупо сервер где параллельно запущено несколько агентов сеток, тогда сойдет.

>5xNVIDIA - GeForce - RTX NVLINK BRIDGE for 3090 Cards - Space Gray: $425

Чёт не понял как они слинкованы, попарно что ли?

>а40 на 48 гб врам

Проще уж RTX A6000 48Gb брать, цена сравнима, зато охлад колхозить не нужно, турбинка встроена.

>у барыг стоит цена на самую дешевую позицию а в описании список того что есть.

Эх, вот бы лохито банил такие высеры...

>A6000

Не успел.

>попарно что ли?

->

>попарно RTX NVLINK BRIDGE соединены

Там же видно всё. 85 баксов за кусок текстолита с 2 разъёмами, ебануться можно.

>>>/hw/

В мелких сетках - да.

7b, 11b

На счет 13 уже не уверен. Она есть, но заметна ли хз

> Иди нахуй, она с нуля писалась совместным трудом.

Конечно, ты уже даже и не понимаешь/не помнишь, откуда первоначально взял эти знания. У вас даже rentry (который так-то заблокирован в РФ) используется, потому что изначально был спизжен с форчана.

>Ну так надо сосредоточится на их дотренировке, а не клепать 7B лоботомитов.

У 7Б применений выше крыши, просто не кумерских. Если в 7Б возможно утрамбовать больше - надо утрамбовывать больше

Мы о применении к негросеткам, если немного, то можно. Ну или железотред откопать, лол, точно такой был.

>который так-то заблокирован в РФ

Сейчас бы беспокоиться об этом, когда половина интернета разъёбана нахуй блокировками, самоблокировками и прочим говном, и без настроенного VPN буквально никого нет.

> Of course, you don’t even understand/remember where you originally got this knowledge from. You even use rentry (which is somehow blocked in the United States) because it was originally stolen from the 2ch.

Ля сука, сам пост с форча спиздил и обвиняет

> У 7Б применений выше крыши, просто не кумерских

Где?

Офк они имеют право на жизнь, но все потребности покроет буквально стоковый мистраль и десяток файнтюнов для чего-то более специализированного. А тут каждый пилит свой клон без каких-либо отличительных особенностей. В итоге запомнились только опенчат за русский, старлинг для кода, бакллава за мультимодальность, ... и все, а остальные или сношаются в мерджах среди тех, кто не познал рп на моделях побольше, или уже всеми забыты.

Ты перепутал, чел.

То что коммандир хорошо говорит на русском сказал первым я, еще спустя день после ввода поддержки ее в лламу. =) Потом поддержку убрали, потом на неделю все на нее забили, и только спустя две недели хайп вновь поднялся.

Я говорю не о том.

Я говорю о том, что сам промпт целиком делать на русском.

Чем больше промпт на английском — тем больше он путает языки. Помни, что сама нейронка не разбирает где и на каком языке написано, ей на вход подается просто куча токенов, у нее нет особых «для промпта» и «текст персонажа» — все это падает одной кучей. И те, кто много с этим работает, замечает, что крупный промпт на инглише (для корпо-сегмента) убивает весь ответ на других языках.

Вопрос-то она поймет, тут для нее нет проблем. Но ответ даст на том языке, на котором написан промпт.

Дело не коммандере, дело в самом промпте ради качества ответов.

Не-не, пункт про отвечай хуйня, как таковая. А перевод да, этим я иногда страдаю, подбираю.

Но в общем, пока это не популярно, так как чисто русских моделей нема.

Кстати о контексте… ниже.

Не, прирост ума есть, просто он нам уже не очевиден.

А вот жмыхнуть ее может здорово от первого кванта, да.

Так что и правда юзлесс, скорее всего.

Уоу, новый взрыв, разведите его на пять абзацев, пожалуйста!!! =D

Ну, то есть, любая другая обертка, но на минималках? Звучит так. Но оффенс.

———

Короче, покрутил я Llama 3 70B Q5_K_S.

Целиком влазит без контекста.

С 8к контекстом влазит 77 слоев с разбиванием 41,48.

Скорость 4,7 на старте или 1,7 с фулл-контекстом (для DDR4).

Ну, типа, на грани юзабельности.

С 4к контекста влазит 79 слов с разбиванием 43,48.

Скорость 5,2 на старте или 2,2 с фулл-контекстом.

Конечно, после мистралевских 32к (и всяких ярнов и прочей фигни, и квенов и так далее…), 8к в принципе смотрится не очень много.

И для работа может не подойти, ибо со временем сетка быстро забудет, с чего мы начинали.

Для ролеплея — пухлые карточки убьют контекст в нулину.

А уж сокращая ее, хотя и получаешь более-менее нормальную скорость (и ум на 5.5 бпв у нее хорош), но контекст… Боль.

Мой личный вывод — пятый квант для 2 тесла не подходит в большинстве случаев. Разве что, переводчик-кун нашел бы это сколь-нибудь полезным, тут я хз.

ЗЫ

С 79 слоями скорость до 5.6 доходит, кста.

Но один фиг, 4к контекст…

Протести как работает с 16к контекстом и с разными параметрами rope

> сказал первым я

> Я говорю не о том.

> Я говорю о том

> я

> я

Спокойнее

> Я говорю о том, что сам промпт целиком делать на русском.

Нахуй не нужно

> Чем больше промпт на английском — тем больше он путает языки

Просто инструкция "отвечай на русском если контекст не подразумевает иное" и все.

Для кода щас топчик вот эта штучка

codeqwen-1_5-7b-chat

>С 8к контекстом влазит 77 слоев с разбиванием 41,48.

То есть ты чётко видишь где у тебя контекст в режиме rowsplit? Или просто подразумеваешь, что он должен быть на первой карточке даже в этом режиме?

3090 тесты прошла, а значит обновляем пул моделей.

Аноны, посоветуйте каких накачать и для РП/кума и для общения.

Минимум 8к токенов, нехай с 40 гб памяти на 4 сидеть.

На пикриле что у меня осталось, продела путь от 13б до 34б.

Тут все наяривают на Команд-Р, но мне он чет не особо защел, может чего делал не так, но уж очень он пресный.

А вот Бигль 8х7, я прям рекомендую. Очень приятная модель

Аноны, посоветуйте каких накачать и для РП/кума и для общения.

Минимум 8к токенов, нехай с 40 гб памяти на 4 сидеть.

На пикриле что у меня осталось, продела путь от 13б до 34б.

Тут все наяривают на Команд-Р, но мне он чет не особо защел, может чего делал не так, но уж очень он пресный.

А вот Бигль 8х7, я прям рекомендую. Очень приятная модель

>Работало в смысле выдавало нормальный результат, или просто обучение завершалось без ошибок?

Да.

>fp32

Буржуй, блядь. В лучшем случае fp8. Сейчас вот на fp16 ебусь, не получается.

Ну что это за хуйня, куда это годится вообще.

Во сколько обойдется файнтюн такой микромодельки 0.5b или лучше локально ее вообще зафайнтюнить? Прожектор тоже надо файнтюнить вместе с ней или не важно?

https://huggingface.co/qnguyen3/nanoLLaVA

мимо нубик

https://huggingface.co/qnguyen3/nanoLLaVA

мимо нубик

> дрочу слои, дрочу кванты, дрочу параметры и все это чтобы подрочить

> в то же время адекватный человек, уважающий свое время, просто ставить олламу, пулит модель и начинает работать

Вся суть.

> в то же время адекватный человек, уважающий свое время, просто ставить олламу, пулит модель и начинает работать

Вся суть.

>Я говорю о том, что сам промпт целиком делать на русском.

И в чем проблема? Делай на здоровье, я уже сделал, пикрил, тот скрин выше тоже моделью с русским промптом написан. И все скрины что я постил в тред последние несколько дней с русским текстом - все написаны русскими персонажами.

>может чего делал не так

>3.0bpw

Ну ты понял, навернул 3бит обрезок и удивляешься.

Ну и раньше он нормально не поддерживался.

У тебя только 3090 или еще что есть? Если есть что-то еще - можно мику попробовать.

> 0.5b или лучше локально ее вообще зафайнтюнить

Все зависит от твоей врам. В 24гб влезет и 3б.

> Прожектор тоже надо файнтюнить вместе с ней или не важно?

Раз готовый то лучше сразу вместе.

Двачую, в 40 гигов 4битный поместится с некоторым контекстом.

>Двачую, в 40 гигов 4битный поместится с некоторым контекстом.

4 битный коммандер и в 30 гигов влезает с 4к контекста, так что он спокойно может крутить 5км с 8к контекста ,ну, где то так.

Не знаю что там ожидать от сетки на 3 битах, она все равно сломана. Только с 4 начинается что то нормальное.

Ну или мику, да. Хотя мне кажется там мало контекста войдет.

3090 и 4070т суп. 40 гб.

Мику какого кванта брать, подскажи пожалуйста. И какую лучше. Миднайт?

Вообще как правильно расценивать размер ЛЛМ, не знаешь?

Я вот обычно брал 70% по размеру самих файлов .safetencor, и остальное на контекст оставлял.

Но например злоебучий Коммандер чет совсем адский размер контекст имел.

Он всегда падает на первую карточку.

Может я не прав, но при загрузке видно, что в начале грузятся слои (типа занято 21/23,5 гига), а потом прилетают слои (23,5/23,5). Либо, если выставить много — прилетает ошибка о переполнении.

На вторую карту тоже прилетает чуток (мегабайт 10-100), но это не критично.

Вообще, мне всегда казалось, что он прилетает на первую карту, это кто-то еще полгода назад сказал, а я поверил. Ну и, вроде бы, соответствует правде, я хз.

Когда я ставил равное количество, то на второй был недогруз, а потом вылетало из-за нехватки памяти. Но, может, то был единичный случай, и я не прав.

Тогда мои замеры деления хуйня из под коня и я тратил время в пустую. =)

Не-не, я не про это. Это карточка персонажа, так я уже сто лет делаю.

Я о том, что у тебя на А.

Ну слушай, без баланса я нахуй прошел при загрузке модели с ошибкой контекста.

А с балансом, который подобрал — грузится норм.

Видимо, все же падает на первую. Да, с row_split в том числе.

Ну, в теории, лень тестить подробнее.

> Все зависит от твоей врам. В 24гб влезет и 3б

8 гигов хватит получается?

> Раз готовый то лучше сразу вместе.

Пиздос. Надеюсь там не сложно разобраться

>Обучаю, как всегда, творением Хуюги.

это под виндой работает? или как аксолотль - только под линух?

Хочу собрать отдельную машину по LLM пока на одной Тесле П40 с возможными дополнением

Выбираю боле менее бюджетные варианты базы на чем собирать:

1.https://pg.asrock.com/mb/Intel/Z390%20Phantom%20Gaming%20X/index.ru.asp

2.https://www.asus.com/ru/motherboards-components/motherboards/all-series/rampage_v_extremeu31/

Первый вариант более современный, но сможет только 3 Теслы с другой стороны на карте есть собственный видеовыход.

Второй вариант можно воткнуть Зеон, и память четырех канальная, но с меньшей частотой.

Что лучше выбрать?

Выбираю боле менее бюджетные варианты базы на чем собирать:

1.https://pg.asrock.com/mb/Intel/Z390%20Phantom%20Gaming%20X/index.ru.asp

2.https://www.asus.com/ru/motherboards-components/motherboards/all-series/rampage_v_extremeu31/

Первый вариант более современный, но сможет только 3 Теслы с другой стороны на карте есть собственный видеовыход.

Второй вариант можно воткнуть Зеон, и память четырех канальная, но с меньшей частотой.

Что лучше выбрать?

Как же я ебал обоссаный питон. Абсолютно каждая установка любого дерьма на базе питона - это дополнительно пару часов ебли с зависимостями

Под виндой работает на 10%. Потому что под виндой не работает ни дипспид, ни анслот, нихуя. Так что чисто формально да, работает.

Замер перплексити занимает ~1 час для Llama 3 70B.

Стока оставлять мои старушки-теслы работать я че-то как-то не уверен, там еще и нагрузка прыгает…

Сорян, тут я сольюсь, видимо.

Стока оставлять мои старушки-теслы работать я че-то как-то не уверен, там еще и нагрузка прыгает…

Сорян, тут я сольюсь, видимо.

>Мику какого кванта брать, подскажи пожалуйста

4, какой влезет.

Лучшее соотношение размер/качество у IQ4_XS, лучшее качество у Q4_K_M.

>Вообще как правильно расценивать размер ЛЛМ, не знаешь?

Опытным путем. Например было выяснено что лучше закинуть не все слои на видеокарту, оставив часть слоев на оперативке, чем закинуть все слои на видюху и оставить оперативку в одиночку разгребать контекст. Так я командира на одной 4090 с 8к контекстом запускаю с оффлоадом на видеокарту 31 слоя из 41 со скоростью 5-6 токенов в секунду, например.

У меня есть устаревшая таблица для первой ламы с устаревшими квантами:

https://docs.google.com/spreadsheets/d/13ERoJTi0Z7vMcmoNBWxVeV0n2KOJGg39i-Iz-AfIGr0/htmlview

Почему-то у меня llama-3-8B-instruct работает более менее норм, а llama-3-8B шизит. Там какие-то разные настройки нужны или что? Подскажите что лучше ставить в настройки семплера? Не могу понять. Или может я не ту версию модельки качал?

Говорили тебе - ставь кобальт.

Да там хуй проссышь сейчас, в чем дело.

Мне нужно запустить сейфтензор модель

Миниконда с отдельными пространствами, и нет проблем с кодом

Только места жрет дохера

Но любителей нейросеток не испугать несколькими лишними гигабайтами

Ну как сказать. У меня на диске свободно ~10 ГБ. Рот ебал этой миниконды с пространствами и рот ебал пайтона ебучего, который не умеет в совместимость даже самого себя.

Щас ссд дешманские, не жлобься купи нормальный 1-2 терабайта и забудь о ожиданиях и нехватке места

Так у меня уже 2 куплено. Сколько еще купить надо? Мне бы и память докупить, чтобы 70В гонять. А денег-то нет.

Все нейросетками забил? У меня пока только 600гб

Ага. Ща ставлю убабугу. Там миниконда в бандле если что. В итоге выбило запуск с ошибкой. При повторном запуске пишет что нет yaml либы. Чекнул в интернете, пишут установить вручную через requirements.txt. Поставил, все равно пишет что его нет. Поставил вручную через pip install pyyaml, продолжает писать тоже самое. Я нихуя не понимаю yaml импортится из pyyaml вогбще или нет. Язык говна блять

Это несложно. У меня тер забит ллмками, фордж, поломатик, кохя, фукус, комфи, куча моделей, топаз

По Asrock подробные обзоры поищи. Так-то вариант кажется неплохим, но конкретная модель может подвести.

С Асусом вроде получше вариант, но опять же - видеоядра нет и это не HEDT, а значит лотерея.

Если железо ещё и не новое, то оба варианта дрянь.

>Поставил, все равно пишет что его нет. Поставил вручную через pip install pyyaml

Так ты в систему небось поставил, а надо в venv убы.

Ну не все. Еще музыку пытался писать. Музыкальные библиотеки весят не меньше нейронок. В итоге 6ТБ забито полностью.

>Щас ссд дешманские, не жлобься купи нормальный

Нормальный - это NVMe c DRAM-буфером, чтобы 40-50 гигов писались и грузились быстро. А это уже не так дёшево.

Да я ебу куда там надо, я не пишу на питоне и никогда с ним не сталкивался, но приходится из-за того что все ИИ построено вокруг него. Все эти пактеные менеджеры говна, конды, миниконды, venvы, pip и pip3 (чем оно блять вообще отличается?). НЕНАВИСТЬ. Спасибо за подсказку

В консольке жмешь cd <путь каталога>

Дальше venv\Scripts\activate

Если пространство уже есть, тебя закинет туда. В консоле будет в начале строки написано (venv)

Чтобы создать свою среду, нужно ввести команду: python -m venv <environment_name>

Надеюсь, не наебал нигде. Петухон - говно, кстати, а не язык.

Сейчас будет смертельный номер - запуск 6-битной сайги-лламы-3 с 16к контекстом и стресс тест этой хуйни!

> Дальше venv\Scripts\activate

Не, походу тут нет venvа. Тут миниконда и я хз как оно работает. Надо ли какой-то специальной командой к ней в shell входить

> 5км

Не то чтобы в 40 гигами есть смысл в жоре.

> Мику какого кванта брать, подскажи пожалуйста

Она, пожалуй, единственный повод для этого. 4km тот самый единственный и оригинальный https://huggingface.co/miqudev/miqu-1-70b отсюда, остальное уже будет пережатием с потерями. Не факт что она влезет.

> 8 гигов хватит получается?

Наверно, нужно пробовать.

По поводу тренировки, когда она идет с нуля то в начале морозят ллм и тренируют только проектор чтобы он начал как-то нормально работать. Потом размораживают и тренируют все связку.

Где можно столкнуться с еблей? Гит клон @ запуск батника или шелл скрипта с ответом что у тебя не амудэ и не старая архитектура хуанга. Все. Буквально ничего делать не надо.

Блядь, просто удали все, скачай заново, потом запусти батник update_wizard_windows.bat и там сначала нажми А, потом В

>Она, пожалуй, единственный повод для этого. 4km тот самый единственный и оригинальный

В его случае - 40гб врам и современные карты - только exl2-вариант. Да, с потерями, но она будем меньше и быстрее и точно влезет.

У меня мак

У меня мак

Это основная проблема, но питон тоже сосет. Короче иду лучше курить как конвертнуть safetensors в gguf

Оуууу, да, тут тяжелый случай. Ну, земля пухом, зато у тебя относительно шустро будет llamacpp работать на всей рам.

> Короче иду лучше курить как конвертнуть safetensors в gguf

Если хочешь 16бит или q8 - просто воспользуйся скриптом convert-hf-to-gguf.py и закажи q8 тут тоже пихон, как видишь.

Алсо при чем тут пихон, ты же буквально должен гореть с любой сборки чего бы то ни было кроме совсем тривиальных вещей, там же даже с npm веселье.

> У меня мак

Пиздец. Ну это приговор.

> Алсо при чем тут пихон

Часто пакетов некоторых нет на мак и приходится вручную качать лругие версии пакетов. Плюс тут на маке особый пиздец, ибо есть системный питон и питон, который ты устанавливаешь поверх его, его не заменяет. В итоге всегда путаница с версиями.

> ты же буквально должен гореть с любой сборки чего бы то ни было кроме совсем тривиальных вещей

Не, у меня так только на линуксе было.

> там же даже с npm веселье.

С нам все идеально, говорю как фронтенд макак

У меня есть шиндошс машина так-то, мак так для души, я просто сейчас не дома и есть только мак

> мак так для души

За мак вообще не шарю. Используй гопоту и гугл. Вместе может что и сделаете. А я рот ебал и петухона, и надкусанного яблока.

Короче поделюсь своим новым опытом говнокода. Раньше у меня не было настроения так поиграться, да и сетки умной и мелкой тоже. Сам я кстати не погромист, так, учился самоучкой.

Щас игрался с codeqwen-1_5-7b-chat-q8_0.gguf, контекст до 64кб, опенчат формат.

У меня были старые файлы, когда я писал тренировку нейросети классификатора для датасета ирис. Учебная хуйня для нейросетей, по сути примитивный код на питоне без всяких гпу ускорений в 1 поток невероятно быстрого питона, ладно хоть с нумпи.

Похуй.

Короче, тренировочный файл гоняет эпохи и если доходит до нужной мне точности кидает веса в файлы. 130 строк говнокода.

Которые потом открывает инференс файл, 55 строк говнокода, проверяя точность на том же датасете.

Создал простейшего ассистента кодера в таверне, и кинул ему код попросив проанализировать его. Он сделал это, пик1, потом попросил оптимизировать код, пик2. Делал так несколько раз, тупо вставляя его же код в тот что он писал после первой оптимизации.

Покатав туда сюда у меня получился реально работающий код, похудевший на 10 строк. И скорей всего исполняющийся быстрее, не гонял профайлер

С инференс частью работал в этом же диалоге, тупо сказав боту что это вторая инференс часть одного проекта. И что нужно сделать ее совместимой с первой частью.

И он понял, пик 3. Попросил оптимизировать, и он сделал это с первого раза даже, пик4.

И все, инференс часть стала всего 45 строк.

Прогнал тренировку, прогнал инференс. Работает.

Хуй его знает конечно как правильно, но лучше того говнокода, что накопировал и настроил я.

И ведь делала это такая мелочь, не сраный гпт4 или клод3.

Кнопка сделать заебись уже не кажется так далеко.

Щас игрался с codeqwen-1_5-7b-chat-q8_0.gguf, контекст до 64кб, опенчат формат.

У меня были старые файлы, когда я писал тренировку нейросети классификатора для датасета ирис. Учебная хуйня для нейросетей, по сути примитивный код на питоне без всяких гпу ускорений в 1 поток невероятно быстрого питона, ладно хоть с нумпи.

Похуй.

Короче, тренировочный файл гоняет эпохи и если доходит до нужной мне точности кидает веса в файлы. 130 строк говнокода.

Которые потом открывает инференс файл, 55 строк говнокода, проверяя точность на том же датасете.

Создал простейшего ассистента кодера в таверне, и кинул ему код попросив проанализировать его. Он сделал это, пик1, потом попросил оптимизировать код, пик2. Делал так несколько раз, тупо вставляя его же код в тот что он писал после первой оптимизации.

Покатав туда сюда у меня получился реально работающий код, похудевший на 10 строк. И скорей всего исполняющийся быстрее, не гонял профайлер

С инференс частью работал в этом же диалоге, тупо сказав боту что это вторая инференс часть одного проекта. И что нужно сделать ее совместимой с первой частью.

И он понял, пик 3. Попросил оптимизировать, и он сделал это с первого раза даже, пик4.

И все, инференс часть стала всего 45 строк.

Прогнал тренировку, прогнал инференс. Работает.

Хуй его знает конечно как правильно, но лучше того говнокода, что накопировал и настроил я.

И ведь делала это такая мелочь, не сраный гпт4 или клод3.

Кнопка сделать заебись уже не кажется так далеко.

А где код и какая его цель?

Тебя прям получившийся код интересует?

Цель была когда то - потыкать что такое нейросети и примерно разобраться как они работают, на примитивном примере. Год назад кажется все это делал. Сейчас просто вспомнил и решил скормить сетке, заебенчик вышло, даже несмотря на косяки. Просто говоришь боту где косяк и он его исправляет.

Код не сложный, да.

Спасибо за тест, пожалуй скачаю поиграться.

Скинь свою версию и версию бота. Чисто посмотреть. Заодно хочу заценить как llama-3-8B справится.

Сейчас еще попросил добавить графики в инференс часть и бот мне такой - окей. И это я тупо скопировал, вставил, скачал либу, и запустил. И вот оно.

Щас кину файлы на катбокс для любопытных

Так, вот скинул 2 папки с 2 версиями. Проверил, вроде работают. Хз как по качеству.

https://files.catbox.moe/sdsqtd.zip

iris-neuro новая

https://files.catbox.moe/sdsqtd.zip

iris-neuro новая

Благодарю.

> llama-3-8B

Я кстати вначале на инструкте ллама 3-8b делал это, еще на карточке гпт-6. Она умнее и предлагала идеи сильнее меняющие код, и легче понимала что от нее нужно. Но мне стало лень разбираться в ее сложном коде, в котором были ошибки.

Но я все таки вспомнил что скачал кодквен и запустил его попробовать в задачах.

Кстати я уже писал когда то, может не работать на куда, выдавая билеберду. Тогда с вулканом запускать.

Ну, для тех кто будет на кобальде тыкать.

> может не работать на куда, выдавая билеберду. Тогда с вулканом запускать.

Вот же ебля. Спасибо хоть предупредил.

Уточню, что щас я на новом кобальде запустил и все работало на куда. Но если кобальд старый, или другая видеокарта то хз.

Щас работает, 2-3 дня назад на старом кобальде ебало мозги.

Понял, спасибо. Кобольд обновлял недавно.

Нейросети конечно пиздят с уверенным видом, но какой же это удобный метод обучения. Просто гугл который сразу отвечает тебе на твой вопрос. Сейчас во всем мире будет бум самообучения, для тех кто этого хочет. В любой интеллектуальной сфере, по сути.

>пиздят