Подскажите почему любой чат уходит в какой-то бред либо в куски кода либо в варианты ответа, но затем через пару сообщений (даже если выбирать вариант ответа ломается)

Использую видюху 3060ти с 8 гигами, вставил 4к токенов в кобольде и таверне

в гайде так и было указано

Context Size determines how many ‘tokens’ of text the model is able to remember in a single chat. (For reference, the Navy Seal Copypasta is about ~400 tokens.) 4096 context size is the default maximum for Llama 2 models/finetunes, but you can go higher using RoPE extension (which, if I remember right, is built into Kobold when you go higher). RoPE can potentially have quality loss the farther along you go, but many users with the hardware are able to run 8k context seemingly without issues; YMMV.

Использую модель Meta-Llama-3-8B-Instruct-Q6_K

Алсо что за пресеты для кобольд? их там дофига, как лучше использовать?

Использую видюху 3060ти с 8 гигами, вставил 4к токенов в кобольде и таверне

в гайде так и было указано

Context Size determines how many ‘tokens’ of text the model is able to remember in a single chat. (For reference, the Navy Seal Copypasta is about ~400 tokens.) 4096 context size is the default maximum for Llama 2 models/finetunes, but you can go higher using RoPE extension (which, if I remember right, is built into Kobold when you go higher). RoPE can potentially have quality loss the farther along you go, but many users with the hardware are able to run 8k context seemingly without issues; YMMV.

Использую модель Meta-Llama-3-8B-Instruct-Q6_K

Алсо что за пресеты для кобольд? их там дофига, как лучше использовать?

>Подскажите почему любой чат уходит в какой-то бред

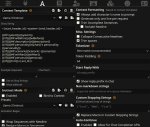

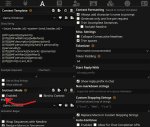

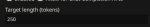

Шизонастройки, пик 1.

Выбери вот этот пресет, его кажется нет по умолчанию, так что создай по пикрилу. Можешь там крутить температуру от 0,7 до 1,5, либо включить динамическую.

Контекста можешь выставить до 8к так то, смотри по потреблению врама.

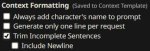

у меня меньше ползунков доступно, хотя расширенный режим включен.

Кстати да. Ты какую апишку выбрал в подключении? Для кобольда надо пикрил.

И да, включи английский в таверне, перевод там упоротый.

>У меня 3080Ti

Неси результаты, будет интересно.

>любая RTX ебёт в обработке промта любой проц и теслу вместе взятые

Пока что выходит что и проц, и тесла со своими ~100 т/с (10 мс/т) выебали и 4090 и 3090

Вот ещё, уже поновее, 4 месяца назад:

https://old.reddit.com/r/LocalLLaMA/comments/1968uvj/benchmarking_various_models_on_24gb_vram/

>i7 13700KF

>128GB RAM (@4800)

>single 3090 with 24GB VRAM

>wizardlm-70b-v1.0.Q4_K_M.gguf

>offloaded 42/81 layers to GPU

>ContextLimit: 560/2048, Processing:4.20s (182.6ms/T), Generation:336.31s (626.3ms/T), Total:340.51s (1.58T/s)

И ещё (совсем старое, 9 месяцев назад):

https://old.reddit.com/r/LocalLLaMA/comments/15xtwdi/70b_llm_expected_performance_on_4090_i9/

>Alienware R15 32G DDR5, i9, RTX4090

>Same exact machine. Upgraded to 64G with AMP 5200-something

>llama_print_timings: prompt eval time = 24325.61 ms / 54 tokens ( 450.47 ms per token, 2.22 tokens per second)

>Неси результаты, будет интересно.

Какой сетки, с какими параметрами? А то тут уже дохуя сравнений хуя с пальцем.

>проц, и тесла со своими ~100 т/с (10 мс/т) выебали и 4090 и 3090

Наркоман? Вот сравнение на моём железе (скрин во время обработки на проце). Первый с кубласом и полным офлоадом на гпу, второй с опенбласом на проце. Итого 33 т/с против 933. Полный отсос проца с 5 кеками частоты и памяти в 6200.

>Какой сетки, с какими параметрами

70b (в идеале q5)

Контекст побольше (от 1-1.5к, в идеале 8к), чтобы нивелировать погрешность от пересылки ram => vram.

>Наркоман?

Тесла

Проц

Я не знаю, что у них там за конфиги, но оперирую теми данными, которые мне принесли.

ох, спасибо анончик! так намного лучше стало

у меня Kobold classic там был выбран где должно быть выбрано text completion

>Проц

Там кублас, поэтому контекст обрабатывала видеокарта (ХЗ какая, первая по счёту).

Мику у меня где-то валялась, принесу свои через пару часиков.

>Там кублас

Ну охуенно. Т.е., 4090 обрабатывает контекст 110 т/с - это нормально. А на тесле 90 - это уже слишком медленно.

а вот теперь такая проблема: спустя какое-то время бот начинает повторять одно и то же, ну точнее не совсем одно и то же но структура ответа не меняется. как это можно пофиксить?

rep pen попробуй повысить. Но не переусердствуй, а вообще это лупы, если ллама-3 у тебя то бывает у нее. А может просто модель возьмешь проверенную, которая уже точно работает без мозгоебки?Типа мойстрал v3 или что-то на базе мистраля на 7б

подскажи как в кобольде это тест запустить?

rep pen попробуй повысить. Но не переусердствуй, а вообще это лупы, если ллама-3 у тебя то бывает у нее. А может просто модель возьмешь проверенную, которая уже точно работает без мозгоебки?Типа мойстрал v3 или что-то на базе мистраля на 7б

подскажи как в кобольде этот тест запустить?

Результаты странные, да.

А это уже, сынок, прикол от лламы 3. Повышай температуру вместе с пенальтями, да компенсируй мин п появляющуюся шизу. Можешь руками пару ответов поправить, убрав структурные лупы. Окончательного решения проблемы лупов пока не найдено ну кроме как повесить всех причастных разработчиков, но времена, увы, не те.

>подскажи как в кобольде это тест запустить?

Кнопочку на скрине найдёшь?

>А на тесле 90 - это уже слишком медленно.

Там ещё и контексты разные, лол. Но я чёт сомневаюсь, что там одна тесла в системе. Между моей 3080Ti и P40 разница в скорости памяти в 3 раза, так что я ХЗ, как на тесле может быть такой разрыв.

Кстати, прикол. Вижу чёткую зависимость между числом выгруженных слоёв и скоростью обработки промта. Так что теслы выйграли тупо за счёт того, что выгрузили все 81 слой.

Плюс выгрузка 5 слоёв тормозит общую скорость, видимо за счёт накладных расходов на пересылку по псине.

В общем нужна проверка комбинации 3090(4090)+пара тесел. Основную работу по обработке промта всё таки делает видеокарта, так что такая комбинация должна быть идеальной и со скоростью обработки промта на уровне пары 3090.

>Но я чёт сомневаюсь, что там одна тесла в системе

Так там и не одна, а 3. Обсуждение шло про 3 теслы vs 1 современная видеокарта сопоставимой стоимости (~60к на данный момент) + проц. И выясняется, что с 1 видеокартой за 60к (как 3 теслы) мы только обработку контекста подтянем по скорости до уровня тесл, а на генерации проц всё равно столько не выдаст. Так что определённый смысл в них есть, если кто-то готов рисковать б/у.

>лол

Вот именно, что лол. Только вот шутка, которую повторяют 20 раз, перестаёт быть смешной. А когда зашёл серьёзный разговор и их попросили пояснить за слова, сразу начались манёвры и обнаружилась подлива на штанах. И вместо 3 тесл за 60к всем предлагается купить 2+ 4090 за 200к каждую (ну или по 60к б/у, во что мне не особо верится, за эти деньги скорее что-то около 4070 ti будет). Либо сидеть на проце, ибо "разницы никакой" (на самом деле ещё какая, у меня на проце промпт 1 т/с, с амудэ видеокартой кое-как под 30, генерация и там и там дно, ибо 8гб, видеокарта берёт на себя 1/10 сетки). Других вариантов в чёрно-белом мирке мажоров нет.

>30

16.7 неправильно поделил в уме

>а на генерации проц всё равно столько не выдаст

Так это... Тотал у обоих систем одинаковый вышел (кажется вы это уже обсуждали, но я в ваш говноспор не вчитывался).

>всем предлагается купить 2+ 4090

Кто предлагает? Одной хватит, чтобы уделать 3 теслы. А 3090+тесла выйдет и быстрее, и немногим дороже системы на 3-х теслах (с учётом, что в современные платы и корпуса пихать столько карт вообще никак нельзя).

>видеокарта берёт на себя 1/10 сетки

Сколько слоёв в штуках? А то может проще не выгружать, как видишь, генерация у жоры страдает, если выгрузить 5 слоёв (думаю и менее).

>Так это... Тотал у обоих систем одинаковый вышел

Так это в разных условиях. Я тут пояснил, что эта цифра плохо подходит для прямого сравнения (зато хорошо подходит для манипуляций, чем и воспользовались "шутники" в предыдущем треде).

>Кто предлагает?

>На нормальных картах можно забыть про тормознутого жору и ггуфопроблемы, наслаждаясь экслламой со скоростью эвала ближе тысяче т/с и отсутствием замедлений генерации на контексте.

>Сколько нормальных видеокарт (речь же про 4090?) можно купить на 60к?

>Одну на лохито.

>И какой эксллама-квант 70B туда влезет, чтобы считать с нормальной скоростью? 2bpw? Там же мозгов не остаётся. Или про жору забыть всё-таки не придётся?

>Да никакой, вторая нужна.

>Одной хватит, чтобы уделать 3 теслы

Не хватит. Промпт сопоставимо считается, лучший зафиксированный результат на 4090 пока что 110 т/с против 90 на теслах. Генерация в лучшем случае чуть более 2 т/с, что далеко не 7.8, как на теслах, и придётся набираться терпения, чтобы читать в реальном времени (хотя у меня так на 11b и жить можно, но мажоры-то привыкли к другим скоростям, им 1000т/с подавай).

>3090+тесла выйдет и быстрее, и немногим дороже системы на 3-х теслах

Во-первых, немного дороже выйдет одна 3090 чем 3 теслы. Ну если брать те репорты, что я помню, то 3090 кто-то за 40 иди 50 или даже 60к то ли видел, то ли брал, ну так и теслы не так давно и по 11к были, и по 14к. Что там конкретно в данный момент, не знаю, не слежу за б/у рынком, вроде в тред приносили инфу, что теслы уже до 20-25 поднялись, наверняка и 3000 серия тоже, учитывая текущую экономическую ситуацию. И опять же, если брать только 2 видеокарты, почему не сравнить с 2 теслами? Что там 48 гб, что там, только по цене опять выйдет разница серьёзная. А даст ли замена 1 из тесл на 3090 такой уж сильный выигрыш в производительности - тоже вопрос. Тесты несите, выёбывайтесь, у кого есть возможность.

>Сколько слоёв в штуках

Если с гуём, то 5-6, если ещё затычку вставить, чтобы все 8гб пустые были, то до 8-9.

>как видишь, генерация у жоры страдает, если выгрузить 5 слоёв

У себя тестировал разные варианты и выгружать в моём случае всё-таки стоит. Правда давно тестировал, тоже осенью, файл датирован 22 октября 2023. Может и оптимизировали что-то, и стоит обновить свои данные, чтобы быть в курсе.

Убавь штраф за повтор, это оче много, особенно для 3й лламы. Плюс скорее всего у тебя кривой системный промт и разметка, 3я ллама к нему чувствительна.

> Пока что выходит что и проц, и тесла со своими ~100 т/с (10 мс/т) выебали и 4090 и 3090

Не перестаю проигрывать теслашизика, накупил говна и уже который тред оправдывается.

> Вижу чёткую зависимость между числом выгруженных слоёв и скоростью обработки промта.

С подключением. Если все слои выгрузить на единой видимокарте там вообще тысячи т/с будут, а не менее сотни кое где. На экслламе оно с такой скоростью работает на любых конфигах.

> Обсуждение шло про 3 теслы vs 1 современная видеокарта сопоставимой стоимости

Теслашиз и скуфидон смайлоеб - один и тот же человек? Постоянно сам себе придумывает какие ведутся обсуждения и отчаянно в них побеждает, тогда как над шизиком просто глумятся.

>Я тут → пояснил, что

Что ты забыл перерасчёт при достижении длины контекста.

>На нормальных картах можно забыть про тормознутого жору и ггуфопроблемы

Ну так это, результаты на экслламе никто не показывал. А они явно выше будут.

>в моём случае всё-таки стоит

>Может и оптимизировали что-то

Или сломали, с учётом замедления, лол.

>Убавь штраф за повтор

У чела там заросшая мхом апишка была, не факт что семплеры вообще работали, с учётом шизорезультата, лол.

>На экслламе оно с такой скоростью работает на любых конфигах.

Потому что эксллама не работает на проце и теслах, ага.

Какие-то сферические рассуждения в вакууме о мифических современных rtx c 24 гигами за 60 тыр. НЕТ ТАКИХ В ПРИРОДЕ. То что есть из rtx за 60 тыр некорректно сравнивать с 3 теслами суммарно с 72 гигами, потому что макс там 16гигов. Покажи мне где купить 4090 за 60тыр или хуй с ним 3090? И вот это "ненамного дороже" это на сколько? И обрати внимание я бу 3090 не рассматриваю принципиально, я хуй знает как их там майнеры эфира ебали во все разъемы. Так что твои сравнения - сравниваешь хуй с пальцем.

А рассуждения о каких-то иллюзорных ценах в вакууме это просто пиздец! Ты в герметичном контейнере чтоли проживаешь? При том что у тебя карта - амудень! У тебя ни тесл нет, ни rtx, ты берешь скрины чужих тестов и по ним делаешь какие-то безапелляционные заключения. Так вот теслы это просто врам причемф только для инференса и только ггуф. Больше там нет никаких возможностей. никакого трейна, или инференса других форматов или плюшек от хуанга из каробки типа чат rtx. Которое рано или поздно захочется. Теслы - это скупой платит дважды. Хотел сэкономить, а по итогу пойдет покупать rtx-ы рано или поздно. И кстати теслы не так-то дешевы если учесть весь обвес к ним начиная с материнки, БП и охлада

Чел оправдывать троллейбус из хлеба, который процессит промт медленнее проца тем что

> 72гб днище врам лучше чем крутые 24 в врам-релейтед задачах

это маразм, смекаешь? Если что-то работает через жопу то низкая цена не может быть оправданием. Люди переплачивают за авто для большего комфорта жопы и удобства, или делают корчи на приличной базе, а не ставят дополнительные двигатели в классику как в гараже54 лол.

Самый сок еще в том что достаточно выкинуть одну теслу, оставив 2, и скорость сразу бустанется до более приемлемых значений. Если же у тебя уже есть пека с норм видеокартой - просто докупаешь 3090 второй и наслаждаешься. Или хотябы теслу, тоже будет эффект. Буквально никаких затрат, в худшем случае обновить бп и корпус, что несопоставимо по объему гемороя и затрат с отдельной сборкой.

> У чела там заросшая мхом апишка была, не факт что семплеры вообще работали, с учётом шизорезультата, лол.

Ууу, зачем кобольд вообще ее хостит тогда?

> Потому что эксллама не работает на проце и теслах, ага.

Именно

> хуй с ним 3090? за 60 тыр

Я купил, правда в Казахстане. Б/у конечно.

> Покажи мне где купить 4090 за 60тыр или хуй с ним 3090

Пикрел

> При том что у тебя карта - амудень!

Страдай, сам сделал свой выбор.

>Ууу, зачем кобольд вообще ее хостит тогда?

Совместимость же. Там и опенаишная апишка есть, вдруг какая прога захочет её.

>Пикрел

C доставкой кирпича. Если по моей области искать, то уже 70-80 будет.

То есть если не пойми кто продает с рук и пишет новая - значит новая... и не кирпич..

Какой изворотливый вертится как уж на сковородке.

>Страдай, сам сделал свой выбор.

От чего еба? Я то давно выбрал rtx, страдать ведь приходится при твоем выборе - амудени

>Не перестаю проигрывать

Ты свои штаны сначала постирай.

А говорят ещё "нейронки тупые, контекст забывают".

>Что ты забыл перерасчёт при достижении длины контекста.

А что, на других конфигах перерасчёта не будет (если он требуется на теслах)? Речь про сравнения разного железа в одинаковых условиях, не понял, к чему ты это.

>Ну так это, результаты на экслламе никто не показывал. А они явно выше будут.

Ещё раз, что из 70B можно запихнуть в одну 4090 на экслламе? Которую ещё надо умудриться найти за цену 3 тесл.

>Какие-то сферические рассуждения в вакууме

Если ты не можешь рассуждать абстракно (о вещах, которые прямо сейчас перед собой не видишь, но о которых обладаешь информацией), то это не значит, что такое невозможно в принципе. Скорее намекает на твои интеллектуальные способности. Нейросетки, между прочим, вообще реального мира не видели, а рассуждают местами получше некоторых пользователей из числа лысых обезьян.

>НЕТ ТАКИХ В ПРИРОДЕ

Ну вот ему и объясняй.

>я бу 3090 не рассматриваю принципиально

Ты не поверишь, я тоже

>делаешь какие-то безапелляционные заключения

Так подавай аппеляции, я не против. Я привожу все свои рассуждения и расчёты, аргументирую, даю ссылки на источники информации - оспаривай, если с чем-то не согласен.

>никаких возможностей. никакого трейна, или инференса других форматов или плюшек от хуанга из каробки типа чат rtx

Хороший манёвр. Я полагаю, это означает слив в рамках изначальных условий? Ну давай я тоже напридумываю применений большому объёму дешёвой vram. Вспоминаем про гипотетическую лламу 400b. Или собираем ботоферму для работы нескольких моделей одновременно чтобы срать на двачах. Или запиливаем очередную ИИ-стримершу, которая будет сама играть, общаться с чатиком и получать с донатов меньше, чем уйдёт на электроэнергию. Может даже выстрелит, пока их не так-то много, и все на тупых мелких моделях уровня 7b, есть шанс прославиться с более умной нейросеткой.

>Хотел сэкономить, а по итогу пойдет покупать rtx-ы рано или поздно

Ну если ты уже заранее знаешь будущее, то так бы сразу и сказал. Мне нечего возразить, у меня такой информации нет, но ты прав, если неизбежна покупка 3 rtx 4090, то 3 лишних теслы не особо нужны. Если не рассматривать, к примеру, вышеупомянутый сценарий с ИИ-фермой чисто под llm, для которых теслы неплохо подходят по соотношению цена/производительность.

>процессит промт медленнее проца

Опровергнуто уже давно.

>низкая цена не может быть оправданием

А о чём у нас тогда разговор? Что лучше всего купить при неограниченных финансах? Я выбираю новые блэквеллы, перемогай своими 3090 и норм видеокартами, найденными среди хлама на приусадебном участке. Если я тоже начну маневрировать и добавлять условия к исходной задаче на ходу, обсуждение просто скатится в детский сад и потеряет смысл.

>Хороший манёвр

это не маневр а позиция. Я не тот чел с которым вы меряете токены в сек. Я в прошлом треде обозначил свою позицию что покупать старое железо - гавно мамонта - это в итоге выбросить деньги. Ведь покупка тесл производится исключительно из желания сэкономить. Но покупатель получает за свои деньги ровно то за что заплатил - то есть хуй без соли - чистую врам с позорным чипом - на 24 год. Но он воображает что наебал законы природы и получил топовые карты зя 0.1 цены. Вот о чем речь. А не о токенах в сек. Эти токены вы там меряйте хоть в сферическом вакууме абстрактно, хоть на практике, не измениться то, что покупка теслы это реализация поговорки - скупой платит дважды.

>обсуждение просто скатится в детский сад

Уже...

Короче говоря, лучше вместо тесл купить rtx, благо линейка карт позволяет под любые финансовые возможности, на какую можешь сумму, чем тратить на старый хлам. Ну похуй что 70б не запустить, можно запускать меньшие модели, ведь с учетом того что легко доступны и клод и гопота какие проблемы? Реально лама-3-70 не чета клоду по-любому. Зато все хобби доступны - хоть файнтюн, хоть лора, любой формат для инференса, раг, ну или если угодно обучение от карпатого на плюсах вроде, или даже кан - любой каприз, любая забава - вот что интересно. Либо же мы просто говорим о разном. Если чел с потемневшими кругами под глазами хочет кумить на текста и для этого ему требуется все более мощные модели и все более извращенные фантазии, ну тогда конечно мои доводы - не аргумент.

>скупой платит дважды.

Купил теслу за 15к, сейчас они по 18 минимум. Могу пихануть вместе с охладом за 20+. Продам две - возьму 3090, подведу губки и продам, когда бетховен стрельнет очередной раз.

Command-R нормальный, но сука, ты хоть 10 раз ему скажи в первом сообщении, "Будь доминантной госпожей, не жалей меня", один хуй через какое-то время перестанет меня мучить. А так пишет охуенно, описывает детали, сладко вздрочнул. Но все-таки я не могу же в каждом сообщении объяснять ему как себя вести.

>Купил теслу за 15к, сейчас они по 18 минимум. Могу пихануть вместе с охладом за 20+. Продам две - возьму 3090, подведу губки и продам, когда бетховен стрельнет очередной раз.

Это что сценарий фильма про трейдера? Типо "Слишком крут для неудачи" или "Волк с Уолл-стрит"

Все твои объявы пиздежь. Не может продаваться карта в рабочем состоянии в 3 раза дешевле магазина. Это наеб.

Командир+ лучше.

Я его и пробовал, он слишком мягкий. Если я пишу "прошу остановитесь Госпожа", он может один раз не послушаться, но потом все равно скажет "Хорошо, тебе нужен отдых" и перестает меня мучить. У меня стояк пропадает. Я хочу чтобы госпожа мучала меня несмотря на мои протесты и мольбы.

Карточку перепиши.

Подскажите настройки для транформера llama 3 8b? Получаю пздц какой низкий интерфейс - 6 т/с при загрузке фулл весов(хотя по тестам в инете должно быть 40+), пробовал как на соло 3090 так и 2-3х, разницы никакой блядь. Мб что-то не подрубил? Запускаю через убабугу.

>Если я пишу "прошу остановитесь Госпожа",

Как анон уже отметил, проблема в карточке. Карточка персонажа этол вообще-то и есть "вписать каждый раз". Надо пробовать эти джирективы писать на разный манер и в разных местах карточки, а также в систем промпте, пока не прокатит и не будет заебись.

> Совместимость же.

Рили не осталось фронтов, которые на новый апи не пересели, от этого больше вреда чем пользы. Сделали бы этот апи только по дополнительному ключу запуска типа --legacy_api чтобы не путать.

> C доставкой кирпича.

Бери у проверенных майнеров продавцов лохито-доставкой, или съезди.

Берешь и проверяешь

> Какой изворотливый вертится как уж на сковородке.

Это только однотокенновый делает

> страдать ведь приходится при твоем выборе - амудени

Шизу лечи

> Опровергнуто уже давно.

Это мантры про

> не каждый проц может вытянуть 100т/с

? Орно.

> А о чём у нас тогда разговор?

О том что настакивание тесл - заведомо фейл и пиарится или их подравцами или самими несчастными бедлоагами, которым скучно страдать в одиночку, а теслашиз - врунишка, у которого горит с 1т/с и он засирает тред. Никакой задачи и условий нет, поехи сами все домысливают чтобы не так больно было.

> Типо "Слишком крут для неудачи" или "Волк с Уолл-стрит"

"Лама с ллм треда" лол. А что, звучит.

Добавь эту команду перед ответом сетки, или даже в ее префилл где она "вспоминает правила перед ответом". Обязательно поможет.

Покупка карточки что стоила 5.6к$ за 150$ не смущает а разумные цены на бу удивляют? Это даже оверпрайс для карточки 2020 года в преддверии выхода очередного поколения, кем нужно быть чтобы удивляться?

Вообще если ничего не трогать оно загружается и работает быстро. Возможно трансформерсы как-то странно делят в твоем случае, если не поможет - ограничь видимость только одной карточкой, которой 100% хватит для весов.

Алсо можешь просто использовать загрузчик exllama2 (hf) вместо трансформерса, оно и так на ней работает.

>про

>> не каждый проц может вытянуть 100т/с

Нет, это про

>Там кублас, поэтому контекст обрабатывала видеокарта

100 т/с - это заслуга 4090, а не проца.

Ну кстати не совсем, там же оптимизации завозили, которые позволяли поднять скорость обработки промта на профессорах до величин под сотню и более, по сути не далеко от гпу ускорения без выгруженных слоев. Но над ними тогда посмеялись ибо всеравно слишком медленно, а теперь вот опять.

Ну переделывайте тест и приносите, у кого подходящий проц. У меня даже после оптимизаций вряд ли даже токенов 10 будет (было около 1). У этого на 7900x и ddr5-6200 на 8b 34 т/с. Ну я даже не знаю, какой должен быть проц и/или ОЗУ, чтобы выжать на 70b сотку. Из топовых серверников последнего поколения может быть.

>транформера llama 3 8b? Получаю пздц какой низкий интерфейс - 6 т/с

>транформера

>6 т/с

На одно карте запускал, интерфейс как был 6т/с так и остался. Но в exllame не загружал, попробую.

В жопу свой грин-текст засунь. В транформере запускают и получают норм интерфес, мне было любопытно поюзать фул веса, но что то пошло не так, а ответа "почему", я так и не нашел.

>но что то пошло не так, а ответа "почему", я так и не нашел

>В транформере

>ответа я так и не нашел

> В транформере запускают и получают норм интерфес

Там хорошая скорость и расход рам только при использовании ядра exllama. Возможно ты так выставил параметры что оно перестало его юзать, вот и получил низкую скорость.

Ладно, вот тебе ответ без обезьян.

>В транформере запускают и получают норм интерфес

Трансформер говно.

Хочешь нормальной скорости на 16 бит - запусти эту же модель на эксламе. Пруф.

Но как? Я и там там чуть ли не в каждой строке писал что Госпоже нравится меня мучить и ее не ебет мое мнение.

Ну охуеть теперь.

По советам, тупо указал эксламму, да помогло (у меня нет фул скорости на маленьких моделях (15b работает с таким же интерфейсом как 7-8b), одно ядро проца не вывозит однопоточный python, но да похер, все равно модели пожирнее использую)

>одно ядро проца не вывозит

На зивоне чтоли сидишь?

Имеет смысл влезать в локальные модели с 4060ти 8 гиговой и 32 гигами оперативки?

В уборщике попереписывался вроде зашло

В уборщике попереписывался вроде зашло

>В уборщике

что это?

Отлучался от тредов на некоторое время и у меня вопрос. Пхи медиум реально оказалось дерьмом в итоге или ггуф поломан был?

А phi и не обсуждали. Обсуждали теслаебов.

Там соя, остальное окей, а что?

>Остальное окей

Как тестили в начале серьезные косяки с логикой были, придумывал хуйню какую-то прям. Интересно лучше ли это чем гпт-3.5 для локального юза на русском языке

парни крч такой вопрос. сейчас сижу на Average_Normie_l3_v1_8B-Q8_0-imat.gguf. все достаточно отлично кроме двух моментов. после определенного момента общения с ботом она начинает генерить целые простыни текста вместо двух\трех абзацев.

а второе это то что она слишком ванильная. какая бы карта не была и что бы ты не делал она всегда будет скатываться в теплоту и заботу. мб кто посоветует другую модель?

а второе это то что она слишком ванильная. какая бы карта не была и что бы ты не делал она всегда будет скатываться в теплоту и заботу. мб кто посоветует другую модель?

Попробуй поставь чистую лламу без файнтюнов, она относительно хорошо следует инструкциям. По поводу количества текста, если моделька затупила, ты можешь сам удалить часть текста и она будет продолжать генерить ориентируясь на прошлые сообщения. Можешь ей промптом написать [generate short answer]. И так далее. Можешь в настройках целевое количество токенов поправить и количество к генерации.

Правда, будешь сталкиваться с проблемой "I cannot generate explicit content".

а чистая лама без файтюнов это как?

я вот буквально минут 5 назад закончил тыкать Llama-3-Unholy-8B.q8_0.gguf. и она через сообщение генерило одно и тоже. чет залупой пахнет нет?

>а чистая лама без файтюнов это как?

Ну ты и хлебушек.

https://huggingface.co/bartowski/Meta-Llama-3-8B-Instruct-GGUF/tree/main

прости анонче( для меня это еще пока что темный лес. сейчас потыкаю и отпишу шо как. кста а какие настройки ставить на пик 1 и пик 2

> Не может продаваться карта в рабочем состоянии в 3 раза дешевле магазина. Это наеб.

Брал за 60к 2 месяца назад с авито в ДС.

И где твой бог теперь?

> и она через сообщение генерило одно и тоже. чет залупой пахнет нет?

Потому что оригинальная Llama залупаться (зацикливаться) очень любит. А все файнтюны, в том числе и попытки расцензура типо этой Llama-3-Unholy-8B.q8_0.gguf, залупаться любят еще сильнее и шизеют похуже самой лламы. Моделька и без того перетренированна, поэтому любая попытка дообучить ее, легко делает только хуже. Если совсем новичок, то лучше потрогать оригинальную, понять, ллама это вообще твое или не твое. Тот же Солар, отвечает куда более кратко, например, если тебе нравятся краткие ответы.

Забей, этот анон чсв просто. А еще он теслаеб.

так вот я ее скачал а какие настройки ставить то?

Не слушай этого

В большинстве случаев решают настройки семплера. Даже на васянских и колхозных файнтюнах третьей ламы можно добиться нормальной генерации. Между стоковой ламой и надстройками разница в частоте лупов минимальна.

Если у тебя лупится даже оригинальная модель - это точно проблема шизоидных настроек. Может еще подсирать промт или карточка, но это редкие исключения.

так блядь а как настроить или где взять настройки сукааааааа

Тред выше пролистай. Там скидывали.

Ни min-p меньше всего лупится, но все равно лупится.

Лама 3 сломана, используй модельки на мистрале, например moistral.

можно скинуть пост

А можно не быть такой вафлей и побыть хотя бы немного самостоятельным? Ты не можешь 70 постов прочитать?

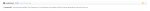

Вот пост от анона с перестом min-p

Можешь либо скопировать все вручную со второй пикчи, либо найти его в таверне (но это трудно, возможно снова придется спросить в треде как это делается)

> Вот пост от анона с перестом min-p

Выглядит как костыль чтобы хоть как-то разнообразить и оживить 7б, на нормальной модели будет неадекватное поведение.

Ллама3 действительно может лупиться, но больше из-за кривого системного промта и разметки, или если заставить делать ее то что не понимает и давать противоречивые указания.

спасибо анонче. прости я просто сонный. спасибо за помощь сейчас потыкаю. и отпишу

Зато Moistral тупее.

>Выглядит как костыль

Оно работает, так что глубоко поебать костыль это или нет.

>на нормальной модели будет неадекватное поведение

Именно для этого и существуют пресеты и все эти ебаные параметры, чтобы нормально запускать разные модели.

>ллама3 действительно может лупиться, если заставить делать ее то что не понимает

Лупы происходят по другим причинам. Это не связано с тем, понимает ли модель что ты от нее хочешь, или нет.

У меня лично не работает. Модель все равно выдает лупы.

мимо

Что за модель? Чистая лама или файнтюн?

анонче потестил вроде нормально. спасибо тебе огромное

Я тут не при чем. Скажи спасибо тому анусу, который это сверху скинул.

И вообще, найди нормально оформленную карточку и тестируй все настройки с ней. Тут половина треда сидит с кривым говном, которое непонятно где было отрыто, а потом спрашивает друг у друга почему у них разные результаты на одинаковых параметрах.

Чистая. А штено залупается еще хуже.

Сравнивал кто Aya 34В с Командиром 34В? Пофиксили ли в Aya неадекватный размер контекста или все так же плохо?

бля ну оно не залупаеться теперь но пишет как то сухо что ли. и в целом такое себе. есть еще вариант какие сетки для кума можно потестить?

Тебе для кума надо или для чего? Покажи че выдает.

Можешь попросить ее писать не сухо. Или заменить ее на moistral для кума.

Лама 3 не умеет в кум. Используй мойстраль. Или какой-нибудь старенький Noromaid наверни.

> Noromaid

Говно.

> Лама 3 не умеет в кум

Умеет, если попросить.

>бля ну оно не залупаеться теперь но пишет как то сухо что ли

Если решил проблемы с залупами и дефолтная трешка тебя не устраивает, то можешь начать перебирать разные файнтюны. Хотя я уверен, что у тебя банальная проблема с систем промтом/карточкой.

>есть еще вариант какие сетки для кума можно потестить?

Все предыдущие треды в твоем распоряжении. Чекай, смотри, выбирай. Одно могу сказать точно, все что до 13B примерно одного качества. Ламу 3 можно подтянуть на выдачу нормального жирного текста, но нужно возиться с промтами. Кастомные сборки ламы два рассматривать нет смысла, в сравнении с третьей они сосут, как по начинке, так и по производительности. Периодически советуют aya-23 в версии на 8B, но я ее еще не щупал, по этому ничего сказать не смогу.

>Лама 3 не умеет в кум.

Skill issue

Не пофиксили, это фаинтюн. В целом, в русский может лучше, но сама по себе тупее.

да для кума.выдает такой +- пиздец.

раньше юзал чисто на кобальде Moistral-11B-v3-f16.gguf

но генерит пздц долго. а через таверну там наверное вообще пиздос будет.

да я листаю их последний месяц в пол глаза. когда аноны кидают какие то сетки качаю их тыкаю сам. но суть в том что раньше я на кобальде сидел и +- норм было а в таверне настройки и прочее говно. + мне не нужны простыни текста. два три средних абазаца.

Да, я уже запустил и сравнил.

Реально, русский у Аи почти идеальный, но карточки она не держит. А еще она лупит одни и те же фразы.

В общем чуть умнее 8В версии себя, но лоботомит по сравнению с командиром 34В. В мусорку.

>но генерит пздц долго. а через таверну там наверное вообще пиздос будет.

Будет та же скорость, генерируешь-то в кобольде.

>image

Это переведенный текст? Если нет и ты заставил нейронку писать на русском, то решение твоей проблемы найдено - переключайся на английский. Ллама может только нормально принимать русский, выдавать - нет.

>а через таверну там наверное вообще пиздос будет

Всю работу делает бэкэнд на кобольде. Таверна это просто интерфейс. На производительность это не влияет.

>я на кобальде сидел и +- норм было

Суп тоже можно сразу из кастрюли жрать, но лучше перелить в тарелку.

>мне не нужны простыни текста

Так пропиши в промте что тебе нужны короткие ответы. Это не проблема модели, это проблема твоих настроек.

4060 8gb или 3060 12gb? Не могу выбрать

вот кста нихуя. или мне так везло. крч похуй

пикрил юзаю

в промте где? персонажа или где?

>в промте где? персонажа или где?

В системном промте. Во вкладке где ты выбирал пресет для инструкта и контекста. Скинь что у тебя там стоит. И ссылку на карточку тоже скинь.

к слову какую модель Moistral посоветуете тогда? видеопамяти 8гб оперативки дохуя.

мимо

мимо

настройки все отсюда

а карту перса как кинуть? (прости я хлебушек)

Вот где у тебя поле для системного промта, там пропиши что тебе нужны короткие ответы и другие пожелания, если они имеются. Может сработать, может нет. И количество токенов ограничь до 250 примерно, если тебе не нужны полотна текста.

>а карту перса как кинуть? (прости я хлебушек)

Кидай ссылку на ресурс, откуда ты ее качал.

Блядь. Ну ты бы сразу сказал, что тебе обязательно генерить на русском. Используй Аю тогда. Но предупреждаю, она прям тупее.

А на той картинке было видно, что ты нихуя не юзаешь. У тебя часть текста не переведена, что характерно для генерации именно нейронкой, а не гуглоперевода.

> алло

Я здесь с тобой несколько дней уже сижу, тебе помогаю, а ты вот так разговариваешь. Больше помогать не буду. Разбирайся сам.

3060 12gb

Почему модель себя так странно ведет? Это не первая модель, за которой наблюдаю такое. Я общаюсь с новым персонажем, а она подтягивает некоторые слова, следствия или действия с предыдущего персонажа. Что это за фигня? иногда доходит до манеры речи, но не более. Характер и бэкграунд соблюдает. Инструкцию для модели использую разную в зависимости от персонажа, что также соблюдает, но эффект тот же. Мне переустановить ее?

>так я юзаю эту хуйню алло

Когда кидаешь примеры генераций, кидай примеры чистые, а не переведенные. Откуда нам нахуй знать, как выглядел изначальный текст, перед тем как его выебала гугловская размовлялька.

>Больше помогать не буду. Разбирайся сам.

Ты для кума советовал влажную мосит. Лучше лишний раз не советуй всякую дрянь. И перестань обижаться, ты на борде а не в дискордике.

>Мне переустановить ее?

Да, если что то не работает, попробуй выключить и потом включить. Переустановить и попробовать снова.

>она подтягивает некоторые слова, следствия или действия с предыдущего персонажа

Нужны примеры. Она может просто использовать расхожие фразы или речевые конструкции, а может быть хуевой моделью. Че за модель вообще?

прости анонче( я правда туповатое в плане нейронок.и спасибо тебе за помощь.

к слову про непереведенную часть текста. выше кто то писал про то что можно удалить часть текста в ответе что бы оно не залупалось. я так и сделал и вот ее повело.

тащемто я пришел к выводу что нахуй ламу чет гемора с ней пиздец.

может подскажешь что можно потыкать из Moistral

ну это все опять же про ламу. я понял что она идет на хуй ибо с ней гемора много плюс ебка с настройками а у меня кривые руки так что нахуй. продублирую реквест из своего прошлого поста

может подскажешь что можно потыкать из Moistral

>я понял что она идет на хуй ибо с ней гемора много плюс ебка с настройками

Все модели придется настраивать. С третьей ламой действительно чуть сложнее из-за ее долбаебской сборки, но если даже я разобрался, то и ты сможешь.

>у меня кривые руки

Это фикситься курением гайдов и доебыванием борды по всем своим тупым вопросам. К счастью, тут отвечают. Иногда даже чем-то полезным.

>может подскажешь что можно потыкать из Moistral

Я бы посоветовал вообще ее не тыкать, потому что она еще тупее третьей ламы.

И вообще, ты блять скинешь мне карточку персонажа, или нет?

блядь я не могу найти этот кал(

на счет тупости я говорил что юзал Moistral-11B-v3-f16.gguf и было норм. но вот генерит он пизда долго. хотел бы что то похожее найти но только с меньшим временем генерации. и в целом про тупость я на разных картах и на разных сетках пишу положи ноги мне на колени и там начинаеться такой хуеанальный цирк. хз опять же с чем это связано просто заметил.

и вот опять же если я сам найду какую то сетку то где мне настройки брать ? какие пресеты ставить? сука нихуя не понятно.

>блядь я не могу найти этот кал(

Тогда просто скинь скрин описания персонажа. Хочу посмотреть оформление и разметку.

>хотел бы что то похожее найти но только с меньшим временем генерации.

Ищи модели уровня 7-8B. Только моистраля ты в меньшей конфигурации не найдешь. Выбор у тебя только между разными сортами тупых моделей.

>пишу положи ноги мне на колени и там начинаеться такой хуеанальный цирк

Нужны конкретные примеры выдачи. Вообще некоторые действия лоу-тир модели тяжело описывают. Особенно это касается нестандартных поз или взаимодействия с предметами. У них слишком нищий датасет, чтобы нормально это переваривать. Ебля раком, тугой горловой заглот - это могут без проблем. А всякие перемещения ног и рук для них тяжко и непонятно.

>и вот опять же если я сам найду какую то сетку то где мне настройки брать ? какие пресеты ставить?

Самое простое - в крысу чекать тред и искать долбаебов которые спросят это за тебя, или спросить самому. Либо открыть документацию, но это слишком скучно.

> Ты для кума советовал влажную мосит. Лучше лишний раз не советуй всякую дрянь.

Я это советовал только как англоязычную альтернативу. Но в первую очередь я советовал именно Лламу. А вообще, посоветуй не дрянь. Что там сейчас лучше моистраля в плане кума?

> И перестань обижаться, ты на борде а не в дискордике.

Действительно. Что бы я мог забыть в дискордах ваших.

> туповатое в плане нейронок

А в чем ты умен и разбираешься?

> тащемто я пришел к выводу что нахуй ламу чет гемора с ней пиздец.

Нет, ллама нормальная. Можно ее запромптить и попросить писать подробно секс сцены. И все будет хорошо. Текст не сухой и более менее интересный.

> может подскажешь что можно потыкать из Moistral

Я тыкал вроде третью версию, но есть и четвертая. В общем-то там все то же самое, только моделька тупее. Но словарный запас на английском лучше. Описание сцен там получше, вот только против лламы с хорошим промптом выигрыш несильный, а проигрыш в тупизне ощутимый. Moistral это файнтюн Solar. Так что если не зайдет файнтюн, можно попробовать солар будет. Солар мне не нравится тем, что отвечает коротко, но вроде залупается реже Лламы.

Ебаться придется абсолютно с любой моделькой. И да, стоит отметить, что ты читаешь не то, что тебе выдает моделька, а то, что высирает гугл транслейт. А он сам по себе с нихуя повторяет слова, каверкает значения и несет какую-то дичь.

Так что ставь тупенькую Аю, и общайся с ней на русском, лол. А если серьезно, то оставайся на Лламе-3 пока что.

> Moistral-11B-v3-f16.gguf

Ну так ты нормальный квант бери. Либо восьмой, либо шестой. Будет нормально генерить.

>Что там сейчас лучше моистраля в плане кума?

Как ни странно, третья лама. Но каждый раз это приходится доказывать.

Какой именно файнтюн предпочитаешь? Их сейчас очень много, что за всеми и не уследишь

> но это слишком скучно

А че так? А вообще, вроде все сетки, которыми часто пользуются, уже имеют пресет в таверне. Ну может быть Yi и Phi не имеет, но первое это китайщина, а второе это соя.

А я за всеми и не слежу. Уже тупо лень. Сижу на Stheno и не выебываюсь. Полностью избавился от лупов, пытаюсь щас донастроить системный промт под свои задачи.

Лень читать, лень разбираться. Мне быстрее методом тыка понять, какие настройки лучше шевелят дерьмо в нужную мне сторону.

> Как ни странно, третья лама. Но каждый раз это приходится доказывать.

Если говорить конкретно в плане кума и описания сценок, то третья ллама кстати даже неважно, 70В или 8В немного похуже будет. Вот самую малость. Если говорить про рп и сообразительность в целом, которая очень важна и для кума, то здесь Ллама 3 фаворит. Единственная проблема, что она какая-то нестабильная, по крайней мере лично у меня. То выебнется тем, что не захочет генерить контент, иногда прям аж рогом упирается. То срет EOS токенами по поводу и без. То залупается.

Но в целом да, я пользуюсь ей чаще и текст генерит быстрее, так как 8В, мелочь, а приятно.

А больше альтернатив и нет. Так что советовать моистраль, когда кому-то не хочется брать лламу, считаю нормальным и правильным.

> Полностью избавился от лупов, пытаюсь щас донастроить системный промт под свои задачи.

Мудростью поделишься?

> Полностью избавился от лупов, пытаюсь щас донастроить системный промт под свои задачи.

А вот это ты молодец. Покажи как. Единственное, что меня в штено не устраивает, это лупы на четвертом сообщении.

> Лень читать, лень разбираться. Мне быстрее методом тыка понять

Возможно ты даже прав. У меня есть подозрение, что даже сами создатели моделек и файнтюнов, просто методом тыка и перебирают эти промпты и настройки. А потом приводят что-то, что у них работало. Вероятно что-то не самое оптимальное даже.

>Мудростью поделишься?

>Покажи как

Нет никакой мудрости. Может конечно все сетки персонализированы, но у меня хорошо работает дефолтный min-p и связка инструкта+контекста из пака, который у нее рекомендован на страничке обниморды.

Хотя ладно, я малеха спиздел. Очень редко, примерно в соотношении 1 к 20 бывают лупы. Но это очень быстро фиксится регенерацией. Да, регенерация у меня тоже фиксит лупы. Сам этому до сих пор не могу не нарадоваться.

Перескажите что там амуда высрала. Появится смысл на райзены перекатываться с инцела для нейронок?

Без разницы, инцел или амуда, важна скорость чтения памяти. Упирается всё в эту скорость, обычных x86 ядер хватает 6.

Какой квант? Я гонял в шестом. Может она там лоботомит уже?

Восьмой. Может на скукоженных квантах внатуре начинает плавиться.

>Вот о чем речь. А не о токенах в сек.

А о чём тогда речь шизло? Карта покупается под конкретные задачи, которые внезапно измеряются в токенах в секунду. Если на это забить, нахуй она тогда вообще нужна?

> Но он воображает что наебал законы природы и получил топовые карты зя 0.1 цены.

>с позорным чипом - на 24 год

Ах вот оно что. Ты наверное ещё считаешь что в 2к24 позор не иметь последнего смартфона от эпла? А ещё ездить на машине старше 5 лет, жить за пределами МКАДа и зарабатывать меньше 200к/наносек? при этом являясь РНН и живя у мамки

ЗАПОМНИТЕ! ПОТРАТИВ ВСЕГО 15К НА ТЕСЛУ ВЫ ПОЛУЧАЕТЕ:

@

24ГБ ВРАМ С ПРИЕМЛЕМОЙ ДЛЯ ЛЛМ ПРОИЗВОДИТЕЛЬНОСТЬЮ

@

ПОЛЫХАЮЩИЕ НАПАЛМОМ ПЕРДАКИ 304090 БОЕВ, С ПЕНОЙ У РТА ДОКАЗЫВАЮЩИЕ ЧТО ОНИ НЕ ЗРЯ СЛИЛИ 100-200К НА СВОИ 24ГБ

Последнее бесценно!

на счет перса уже вычистил эту хуету.Moistral-11B-v3-Q5_K_M.gguf. вроде полет норм но чет оно в конце сообщения повторяет зачастую одно и тоже. хотя мб я чет с настройками опять наворотил ибо поставил пикрил ниже.

в крысу ну пиздец. https://huggingface.co/TheDrummer/Moistral-11B-v3-GGUF?not-for-all-audiences=true тут написано юзать инструкт альпаку его и юзаю. а про Text Completion нихуя не написано на странице модели.

примеры выдачи это как? скрины того что оно генерит и без переводчика? или что?

ну вот вроде за железо шарю. компы, мтб\бмх, в симрейсинг залипаю иногда.

на счет гугл транслейта такая же хуета и в кобальде была.но оно как то местами проебываеться. а когда у тебя целы предложения или абзацы выпадают тебе не кажется это странным?

можно ссылку опять же если не затруднит.

в целом спасибо вам парни я чет даже не ожидал что мне тут помогут. вечером зайду еще почитаю тред да потыкаю сетки.

> обычных x86 ядер хватает 6

У меня 8 инцельных Р-ядра на 13900 всё ещё не упираются в DDR5 6400. Е-ядра дают мизерный прирост, но они слишком говно. У топовой DDR5 всего в два раза медленнее доступ в память чем у P40.

Psyonic-Cetacean-Ultra-Quality-20b-Q6_k.gguf

и

Maiden-Unquirked-20B.Q8_0.gguf

Они еще иногда генерирует те факты, которые происходили с предыдущим персонажем, но формулирует иначе, бывает даже, что не с одним персонажем, а с 2–3 предыдущих. Я полностью удалил их и поставил заново, проблему это решило, но мне стремно с этой фигни, модели ведь не должны запоминать чат и обучаться? Или я чего-то не понимаю?

Вообще, по опыту выглядит так. Файнтюны на квантах совсем тупеют. Если сама ллама еще на 6 норм гоняет и даже на 5КМ, то файнтюны часто лоботомиты. Но понадеялся, что хоть 6 нормально будет работать. Видимо, нет.

По твоей логике нахуй тогда вообще что-то покупать, если есть гопота или клод. Охуеть придумал. А нахуй мы в треде сидим тогда? У нас же гопота есть.

мимо не теслаеб

Смотри Лор или Автор ноутс, может саммари чат, там всё это может быть прописано.

> на счет перса уже вычистил эту хуету.Moistral-11B-v3-Q5_K_M.gguf. вроде полет норм но чет оно в конце сообщения повторяет зачастую одно и тоже. хотя мб я чет с настройками опять наворотил ибо поставил пикрил ниже.

> в крысу ну пиздец. https://huggingface.co/TheDrummer/Moistral-11B-v3-GGUF?not-for-all-audiences=true тут написано юзать инструкт альпаку его и юзаю. а про Text Completion нихуя не написано на странице модели.

Экспериментируй. Я даже гонял на нем с инструкциями от лламы. И вроде что-то генерило.

> примеры выдачи это как? скрины того что оно генерит и без переводчика? или что?

Да.

> ну вот вроде за железо шарю

Ну значит по крайней мере при установке железа проблем не будет.

> на счет гугл транслейта такая же хуета и в кобальде была.но оно как то местами проебываеться. а когда у тебя целы предложения или абзацы выпадают тебе не кажется это странным?

Я транслейтом вообще не пользуюсь. Так что не могу ничего сказать. Но он шизит.

> можно ссылку опять же если не затруднит.

Там же где ты и качал. Только другой файл выбери. А вообще, если пользуешься этим Moistral-11B-v3-Q5_K_M.gguf, то должен работать быстро.

> модели ведь не должны запоминать чат и обучаться?

Было бы охуенно. Но нет, они так не работают.

интересно изложил, очень экспрессивно... но а что ты скажешь насчет 1 токена в секунду?

>ЗАПОМНИТЕ! ПОТРАТИВ ВСЕГО 15К НА ТЕСЛУ ВЫ ПОЛУЧАЕТЕ:

Тесла сейчас опять 15к стоит? Странно, вчера у тебя был бизнес-план, в котором совсем другие цифры:

>Купил теслу за 15к, сейчас они по 18 минимум. Могу пихануть вместе с охладом за 20+. Продам две - возьму 3090, подведу губки и продам, когда бетховен стрельнет очередной раз.

Вообще я слышал что скоро памп теслы, теслы будут только расти в цене, говорят Хуанг лично скупает теслы!

Я понял, что нужно не только промпт формат настраивать под каждую модельку свой, но и описание карточек.

>но а что ты скажешь насчет 1 токена в секунду?

У меня было минимум 1,8 на 70В модели, и то потому что конкретно она была неоптимизированным говном. Ллама 3 70В того-же кванта даёт 2,5Т/с, что считаю вполне юзабельным.

К слову, если сравнивать условную одну теслу и одну 4090 потому что кто в здравом уме будет заказывать 3 4090 под ЛЛМ?, то ни туда ни туда 70В модель нормально не засунешь, а 30В модели на Тесле работают от 5т/с, что тем более норм на 4090 они же могут дать и 50 токенов, но нахуя?

>Тесла сейчас опять 15к стоит?

Я покупал за 15. А спор вроде как идёт между уже закупившимися владельцами устаревшего и оверпрайснутого говна.

> Оно работает

Конечно работает, вопрос в том какой результат там будет. Хз на каких моделях это тестили, но подобная херь срывает крышу и нормальных моделей, в каких-то сценариях может и понравится, но далеко не во всех. В общем стоит хотябы отметить это.

> Лупы происходят по другим причинам.

Расскажи по каким. В большинстве случаев причина именно в том что модель запуталась, или же ты поломал ее своими настройками.

А есть вообще приличные файнтюны коммандира? В стоке шикарнейшая модель, держит сценарий, может как вести интересную беседу так и описывать горячую еблю в широчайшем спектре локаций и вариаций с их учетом, и т.д. и т.п. Только плохо знает многие сеттинги и фендомы, вот этого бы ей добавить.

> но генерит пздц долго

Используй Q8 или ниже, не заметишь разницы. От таверны это не зависит никак.

> Карта покупается под конкретные задачи, которые внезапно измеряются в токенах в секунду.

Не, подожди, сейчас много задач связанных с ии где нужна видеокарта. Картиночки с вайфу генерировать, текст в речь обрабатывать, всякие варианты компьютерного зрения, анализ файлов и контента, интерполяция анимаций и видео. Для всего этого тесла может подойти... ой, вот же не задача, тесла не справится ни с одной из них.

Полыхает пердак пока только у теслашиза, который пытается отчаянно доказать что не ошибся в выборе и требует не насмехаться над его выебонами дешевыми железками.

Если уж ты говоришь про рациональность, можно все посчитать. Сборка на 3х теслах будет стоить не меньше 800$, а то и далеко за 1200. Смотрим прайсинг чмони и видим там 5$ за обработку 1 миллиона токенов и 15$ за генерацию аналогичного объема. Берем типичный вариант чата для рп, где типичное соотношение промта к чату в районе 12к1, или какую-нибудь "рабочую задачу" с простой обработкой текста, где соотношение близкое. За 800$ можно обработать около 140М токенов и сгенерировать около 12М. У сборки с теслами на такое уйдет более месяца непрерывной работы. Однако, в чате коэффициент использования даже при очень интенсивном применении менее 5% (это на быстром, тут может быть и 30-40%), если чатиться по 2 часа, то "окупится" все это дело примерно через 3.5 года. Только ты будешь регулярно бомбить с ожидания первых токенов и недовольствовать из-за шума как от пылесоса, уровень комфорта - днище.

Ни о какой рациональности в подобном применении и речи быть не может, это все чистый энтузиазм и развлечения.

Если же действительно думать о какой-то работе - теслы для нее непригодны потому что там будет постоянная обработка контекста и кэш не спасет. Будут постоянные 1-2-3 т/с вместо 12-15-17, здесь даже новые комплектующие окажутся выгоднее по прайс-перфомансу, особенно если посчитать еще и цену платформы.

> а 30В модели на Тесле работают от 5т/с, что тем более норм на 4090 они же могут дать и 50 токенов, но нахуя?

Ты попробуй покатать на 5т/с с ожиданием в начале, а потом перебраться на 30+т/с с мгновенными первыми токенами, сразу поймешь разницу.

> А спор вроде как идёт

Спора нет, идет гнобление шизиков и их копротивление. Уже в ход пошла типичная платина из хвсрачей и визки про оверпрайс, что довольно забавно.

ГПУ подмогет.

пикрил

В ГОЛОСИНУ!

И не лень тебе было. )))

Ну, хорош-хорош.

Особенно кекнул с визуальных моделек.

Но вот то шо ты всерьез дальше отвечаешь, это уже жесть, канеш. =)

С самого начала. =)

Это фича, а не баг.

4060 ti 16GB.

Ну или 3060, тогда уж.

———

По поводу 1 токена в секунду — как же я ору! xD

Это та самая хуйня, на которой я тредов 25 назад обосрался и меня кто-то поправил.

Тотал — это количестве сгенерированных, деленное на время.

Тест кобольда генерирует 100 токенов (!) при контексте в 8092 (в сумме 8192 получается=).

При таком коротком ответе (кто-то реально ерпшит с 100 max_tokens, закидывая полотна текста на 8к токенов?=), любое железо будет выдавать очень мало total.

А учитывая, что мы не всегда обрабатываем весь контекст (кто где сидит, контекстшифты, вся хуйня), и ответы у нас не 100 макс_токен, то и тотал будет совершенно иной.

Но я хочу поглядеть 3090 в том же бенчмарке.

А то проц и теслы скидывали (да я и сам пока тред читал, погонял те же тесты), а бенча 3090/4090 че-то никто не показал.

Ну да ладно, один хер, чел троллит тупостью, какие уж тут претензии к его «тестам».

Ага, мамка на 3-4 pci-e стоит космических денег, я их в видюхи пустил.

Если не забуду, после интерфейса заскриню тебе как должны выглядеть скорости генерации.

100 токенов это нормальная длина ответа если там не предполагается какое-то описание или переход, но это похуй. Важно то что придется каждый раз ждать появления первых токенов по 1.5 минуты, и это лишь при 8к. Утешить может только то что свайп начнет генерироваться почти сразу, но только если в промте нет чего-то меняющегося или рандома.

>Но я хочу поглядеть 3090 в том же бенчмарке

Вот что я находил с 3090 и 4090 в интернетах:

Не в том же бенчмарке, но примерное представление получить можно.

>Тотал — это количестве сгенерированных, деленное на время.

Да, скорость это расстояние деленое на время.

>При таком коротком ответе (кто-то реально ерпшит с 100 max_tokens, закидывая полотна текста на 8к токенов?=)

Я обычно больше закидываю, 8к это ниочем вообще, буквально память про последних 30-40 сообщений.

>Но я хочу поглядеть 3090 в том же бенчмарке.

У одной 3090/4090 с 24 гб слишком мало памяти для 70В и гигантская просадка идет тупо из-за оффлоада половины вычислений на проц и оперативку. Она быстрее теслы и чистого проца, разумеется, там общая скорость больше 1 т/с, но особо гордиться нечем. Есть в треде уважаемый человек с 4090 и с теслой одновременно, есть и боярин с двумя 3090, был даже господин с кластером - вот они должны показать мастер класс и 10-20+ т/c. Ждем.

Так что за говнокод у Жоры там? Почему в EXL2 мгновенно промпт обрабатывает, а у Жоры сраные 350 т/с? На 8В при разбивке на две карты скорость обработки типа посередине между картами. Как же хорошо что можно не трогать вашего Жору и сидеть на EXL2, где всё просто работает не релизе модели.

https://3dnews.ru/1105866/gigabyte-predstavila-geforce-rtx-4070-ti-super-ai-top-s-turbinoy-dlya-domashnih-iistantsiy

Аноны, можете пояснить для кого это предназначено? Заголовок новости заинтриговал, а внутри на первый взгляд хуйня какая-то. Типа в бомж-сервер установить какому-нибудь непритязательному кабану?

>включи английский в таверне, перевод там упоротый

Ты на 11.7 или старше сидишь скорее всего, в последних версиях перевод нормальный.

Аноны, можете пояснить для кого это предназначено? Заголовок новости заинтриговал, а внутри на первый взгляд хуйня какая-то. Типа в бомж-сервер установить какому-нибудь непритязательному кабану?

>включи английский в таверне, перевод там упоротый

Ты на 11.7 или старше сидишь скорее всего, в последних версиях перевод нормальный.

> для кого это предназначено?

Ну это топ за свои деньги. За 70к дают 16 гигов врама и неплохой чип, на уровне 3090 по производительности. Для тех кто боится брать 3090 непонятно откуда и нет на 4090, то это лучший вариант. По цене одной 4090 можно 3 штуки таких купить и даже сносно гонять 70В.

Интереснее посмотреть на матплаты из серии. В целом тема неплохая, но 4070ти супер стоит дорого а имеет ограниченную память и не самый топовый чип. Выпуск турбированных 4090 (которые уже и так есть от китайцев и не только) будет вполне закономерным тогда.

> Типа в бомж-сервер установить какому-нибудь непритязательному кабану?

Самосборные и готовые рабочие станции для пользователей средне-высокой притязательности.

> За 70к

Овер 800 евро и еще маржа. Но вариант из трех штук действительно будет неплохим, тут она быстрая в отличии от той же 4060ти.

Ну хз, какой в ней смысл если есть 4060ти 16гб? Чип не критично мощнее, никакого принципиально нового опыта не будет, а цена в 1.5+ раза выше.

Хотя может тренить пригодится, хз какие там требования и в целом диспозиция... Но для инференса преимуществ как будто нет.

> Овер 800 евро и еще маржа.

Прям сейчас в ДС за 80к продают.

>для кого это предназначено

Все остальные видеокарты с таким объемом видеопамяти это ебаные гиганты с 3 вентиляторами, занимающие 3 слота на материнке. А тут миниатюрный размер в 2 слота. За цену 2х4090, которые дадут тебе всего 48 гб врам, тут ты получишь 4 таких малышки с 64 гб врам.

> Чип не критично мощнее

Критично, если захочешь делать что-то кроме интерфейса с ллм это сразу будет ощущаться. При цене в 1.5 раза выше она в 2 раза быстрее, память тоже более шустрая. В ллм скорее всего будет уступать 3090 из-за скорости памяти, но по перфомансу чипа чуть быстрее.

Лохито без гарантии или с сомнительной? Так-то там и 4090 от 160 с аналогичными условиями есть, перфоманс чипа как раз в 2 раза выше, но меньше памяти. Тут уже от задач зависит.

Думаю взять как вторую видеокарту к моей 4090, подводные?

inb4 лучше возьми убитую 3090 из под майнера

> подводные

40 гигов суммарного объема, хватит на увеличение кванта/контекста коммандера и моделей подобного размера, хватит на ггуф с частичной выгрузкой для 70б или на всякие модели около 40-50б параметров в 4-5 битном кванте. С точки зрения ллм профитов недостаточно.

Если другими областями увлекаешься - будешь довольно урчать.

3090 из под майнера даст тот же экспириенс, будет сильно лучше в ллм, но она более горячая и бу. В идеале пару таких дополнительно, вот там можно разгуляться.

> горячая

Под андервольтом а в llm его надо всегда делать, просадка производительности нулевая, но сильно холоднее не такая уж и горячая, в llm выше 65 в хотспоте не прогревается, разве что память припекает до 80 иногда из-за того что она с двух сторон платы.

Мне кажется или у Жоры что-то с семплингом? Почему aya на одинаковом кванте в EXL2 работает на русском идеально, а у Жоры иногда у слов путает окончания, пишет странные неподходящие слова и лупится, начиная изрыгать из себя бессмысленные ругательства? Первые два EXL2, два последних Жора. В ниггере он всегда у Жоры mandy вставляет, каждый свайп блять, что это вообще. Хули такая разница? Я просто переключал бэки, всё идентично по настройкам и контексту.

Начинаешь понимать, что у нейронки один персонаж, которого она натягивает на все роли.

Так инцелы тоже высрали, и тоже ненужный кал, так как поддержки всё равно нет.

Вот не надо тут, жить у мамки это топ решение.

>У меня 8 инцельных Р-ядра на 13900 всё ещё не упираются в DDR5 6400

Проблемы инцела, у меня на 5 уже упор в 6200.

>У топовой DDR5 всего в два раза медленнее доступ в память чем у P40.

3 раза на самом деле, у Р40 350ГБ/с чтение.

>в последних версиях перевод нормальный.

Нормальный перевод это оксюморон.

>Все остальные видеокарты с таким объемом видеопамяти это ебаные гиганты с 3 вентиляторами

Берёшь и ставишь мудянку кастом, хоть 4 штуки в ряд.

>Мне кажется или у Жоры что-то с семплингом?

Ты не прав. У Жоры проблемы не только с семплингом.

>у меня нипичот

Знатный подрыв!

> а она подтягивает некоторые слова, следствия или действия с предыдущего персонажа

Это не с персонажа, это байас нейронки. Как правило можно побороть промтом, насрав туда инструкций и пожеланий по стилю, но не всегда.

Алсо пробежался по файнтюнам, пока не то чтобы совсем днище, но специфичны. Все те же привычные уклоны, только модель всеже поумнее, шизоидный уклон в какое-то фентези блять ориентал йокай в современном мире тебе заливает про грядущие приключения и просит обучить магии, пиздец нахуй или ужасные поломки на шизомерджах. Синтия на 3ю ламы день назад вышла, вот где есть надежда, но пока квантуется.

В ллм там даже можно ничего не андервольтить а наоборот память погнать, ибо нагрузка мала, происходит редко и недолго. А вот если что-то делать постоянно и помещать пару в корпус - им там прямо тяжело и нужно сильно сбавлять (там +200 по чипу, работает примерно на 1620 с таким лимитом). Зато память не греется из-за хорошего обдува бекплейта в том числе.

4090, конечно, в этом отношении повеселее будет.

Попробуй в убабуге llamacpp-hf, там семплеры нормальные должны быть. Возможно дело вообще не в семплинге, поломки жоры это уже не мем а пост-мем.

> 4090, конечно, в этом отношении повеселее будет.

Вот за 30 минут кручения 70В стата. В целом они одинаковые по температурам, 3090 даже холоднее немного, разве что память греется. Жрут обе по 300 ватт.

Тут надо ещё смотреть, как они воткнуты. В типпикал корпусе и плате верхняя 4090 будет душиться и греться нижней 3090.

Говори про ллм, у тебя в процессе генерации какой тдп на них? В парных наблюдаю половину, но это на симметричном конфиге, если ставить ассиметрию то там больше напрягается медленная видеокарта. Всплеск до полной нагрузки только на мгновение в начале когда промт обрабатывается. Хорошую 3090 урвал, анус тот прямо топ по охлаждению, в том числе памяти.

Как их размещал в корпусе расскажи.

> Говори про ллм, у тебя в процессе генерации какой тдп на них?

Я же говорю 300 ватт в пике на обоих.

> Как их размещал в корпусе расскажи.

3090 на райзере на потолке, где отверстия в корпусе.

Поясните за эти ваши лламы.

Ведь вся сила этих нейросеток это объем знаний. Так как они больше ассистенты, нежели заменители.

Локальная нейросетка прикольно, но много ли она знает?

Ведь вся сила этих нейросеток это объем знаний. Так как они больше ассистенты, нежели заменители.

Локальная нейросетка прикольно, но много ли она знает?

> 3090 на райзере на потолке, где отверстия в корпусе.

Воу, это где кулеры на выдув сверху? Не задыхается оно там?

Облачные ллм отличаются от локальных прежде всего размером, и то нынче они сопоставимы. Сила не только в знаниях но и в понимании абстраций, соображалке и способности четко следовать сложным инструкциям.

> Локальная нейросетка прикольно, но много ли она знает?

Обучающий датасет - 17 триллионов токенов. Знает она много

А что за модель, можно поподробнее?

>и то нынче они сопоставимы

GPT4 не менее 220B. Самая крупная из открытых адекватных это командир на 104B, и тот немного недотрейнен. Так что увы, отличия всё ещё в разы, а с учётом того, что чаще всего гоняют 7-30B, то и на порядок.

Если бы она их заучила. И да, там 15T токенов, а не 17.

Ну и вопросы к датасету, вон, на знание всяких фендомов жалуются. Толку то от 15T разговоров на мамкиных форумах.

> GPT4 не менее 220B.

GPT-4o порой тупее ламы 70В, она наверняка уже крошечная у них. В кодинге уже жпт выебали. Визуальную модель гопоты ебут уже год китайцы.

Я писал о первых снапшотах. "О" само собой обрезок-дистилят, по скорости интерференса и "бесплатности" чётко видно, что она даже меньше турбы.

>Самая крупная из открытых адекватных это командир

Самая крупнкая это микстраль 8х22.

> Самая крупная из открытых адекватных это командир на 104B, и тот немного недотрейнен.

Что если скажу тебе что текущий командир нередко перформит лучше текущей гопоты? По знаниям уступает, но по пониманию инструкций и общих смысловых концепций иногда более приятные результаты выдает, внезапно.

Если гадать по скорости и субъективизму - в 4турбо активных параметров не более 70б, в 4о вообще что-то типа 20-30. От антропиков сонет и хайку тоже мелкие, и они тупые, только опущ могет.

Так что все более чем сравнимо.

Грок.жпг

Этого микстраля кто-нибудь катал кроме как на апи?

блядь ну я без переводчика не могу. и как я тогда пойму шизит оно или нет? блядь пиздц тащемто ладно спасибо за ответ

>микстраль 8х22

22B же, по мозгам.

>Что если скажу тебе что текущий командир нередко перформит лучше текущей гопоты?

Если в вопросах, где у гопоты триггерится цензура, и требуются многоэтажные джейлы, то поверю.

Впрочем, от кума на четвёрке я давно отказался, либо опус, либо командир, опус всё же лучше.

>Грок.жпг

Маск опять всех затроллел.

> Если в вопросах, где у гопоты триггерится цензура, и требуются многоэтажные джейлы, то поверю.

Да она постоянно триггерится, и даже довольно лайтовый жб с nc/21 может сильно искажать. Если оставить минимум - пишет довольно уныло и сухо, причем если на русском - часто ошибается в склонениях. Если навалить - видно как подтупливает или начинает шизографоманию с характерными словами и чрезмерным описанием ненужного, хотя глупой все равно не назовешь. На лайтовых жб переход сфв/нсфв - пиздец. Из плюсов - знания.

На коммандире же ничего подобного нет и жб не нужен, но знает меньше и может ошибаться в сложном.

> опус всё же лучше

Эта тварь может внезапно радикально деграднуть, а то и почти лупиться начать если что-то начинает сильно триггерить цензуру. Из-за того что по дефолту она умная это очень заметно. Если локалкам это можно простить и что-то подкрутить/поменять/отредачить, то здесь вернуть к жизни тяжело и не хочется.

крч потыкал я Moistral 11B q5 km. генерит +- норм по скорости но блядь. оно шизит. то есть два абзаца ответа и там каждое предложение начинается ее, она притом что на кобальде без таверны я юзал q8 и там такой хуеты не было. что бы не было криков про то что переводчик гугла шизит ниже скрин 2.

вопрос к шарющим анонам шо делать?

мимо

вопрос к шарющим анонам шо делать?

мимо

>а кобальде без таверны я юзал q8 и там такой хуеты не было

Значит у тебя в кобольде и таверне разные пересеты стоят. Таверна дает тебе только свой интерфейс, она ничего не генерирует сама по себе. Если нужны те же самые результаты, зайди в кобольд и посмотри, что за настройки стояли там. Потом впиши их в таверну.

Отборная шиза, но как формулирует!

Ban eos token включен?

ну я рад хотя бы тому что кто то покричал с той хуйни что у меня происходит. ты про это анонче?

ебать ты меня конечно просто но как сука?

ты меня конечно прости*

быстрофикс

Блять ты переведешь когда нибудь таверну обратно на английский или нет? Тебя об этом еще 30 постов назад просили.

>ебать ты меня конечно просто но как сука?

Покажи какой пресет у тебя стоит в кобольде. И какой промт из списка ты использовал. У тебя в кобольде спокойно могла стоять хуйня по типу "стори генератора" со своим специфичным промтом, а в таверне систем промт другой.

> ты про это анонче?

Нет, хз как будет в переводе, выстави английскую локализацию пока для отладки. Там буквально так и называется.

Подобный тому что у тебя эффект может быть как раз когда он включен. Ты буквально запрещаешь модели останавливаться и если кроме EOS токена будет хотябы один не отсеянный семплерами - она продолжит отвечать даже через нехочу. Разумеется когда она логически закончила смысловую часть, продолжать ее с каждым разом становится все сложнее и сложнее, потому может и шиза лезть. Алсо из-за неподходящего промт формата может крышу сносить.

Подожди, это троллинг? Почему ответы настолько хорошие? Не вижу ни сои, ни шизы, ни всратого русского.

да перевел я интерфейс не гори на меня.

сейчас я попытался повторить пресет из кобольда но нихуя не поменялось. шо за промт?

а тут стоит альпака как и было написано на странице модели.

а как и где это сделать? я просто путаюсь в этих ябучих настройках таверны

Откуда брал настройки семплера? У меня есть подозрение, что их бы поправить как-то.

мимо

из кобольда. но полову настроек я вообще не нашел так что ожидаемо пососал хуй.

есть какие то рекомендации что поюзать из стоковых пресетов?

Пресет в кобольде, ебанутый блять, не в таверне. И вообще какого хуя у тебя стоит 500 токенов на выдаче? Я тебе еще утром сегодня сказал, снизь до 200-250. Ясен хуй теперь почему у тебя полотна текста. Ты сам заставляешь сетку срать до посинения и продолжать писать.

сука про полотна текста было про ламу. сейчас оно генерит ровно столько сколько нужно.

скрин из кобольда ниже

Вот у тебя формат стоит Chat Mode. Открой промт в кобольде (не в таверне нахуй) и скинь скрин сюда.

где промт то блядь в кобальде?

А разве не похуй что там в кобольде стоит, если ты генеришь в таверне и все настройки берутся из таверны?

Боже блять, с кем я сижу на одной борде... Если ты даже в интерфейсе разобраться не можешь, может локалки это не твое? Как блять вообще можно запутаться в интерйефсе кобольда, где сука буквально три вкладки, два ползунка и одна кнопка?

Я даже не буду объяснять, что тут происхоидт. Я уже сам нихуя не понимаю.

Вафля на аноне сверху думает, что у него таверна снижает производительность и жирность генерации, а я пытаюсь догадаться сам нахуй по космическим каналам на каких настройках он сидит и почему он настолько наглухо отбитый.

я сейчас так же себя чувствовал когда объяснял знакомому основы в таркове( софт это правда не мое. он мне тяжко дается. но локалки тыкать нравиться. скрин прекрепил.

тащемто к теме того что ты не понимаешь что происходит. я еще вчера съебался на Moistral-11B-v3-Q5_K_M.gguf. на не все ок только генерит она странно. вот мой пост

как настроить то ее блядь что бы не было такой шизы как в посте?

на ней*

Я убью тебя нахуй. Я приеду к тебе домой и зарежу тебя, обезьяна ебаная.

На кой хуй блять ты скинул мне пустой промт блять? Ты понимаешь, что сначала надо выбрать блять карточку, а потом скидывать ее контекст?

Вонючие таркоебы блять почему вы все поголовно тупые нахуй...

>тащемто к теме того что ты не понимаешь что происходит

Я всё понимаю. Я всё помню. Я схожу с ума вместе с тобой долбаебом уже второй день. И каждый твой ответ каким то чудом оказывается еще тупее предыдущего.

Да, что вы ругаетесь? Тупой чел, ну бывает. Главное, что он хотя бы теслами не выебывается.

Я любя. Тут нет никакой ненависти, иначе бы я не пытался ему отвечать.

мне кажется тут дело не только в мое тупости а в том что мы друг друга не правильно понимаем вот.

пиздец меня разорвало с этого. прости анон(

так я тоже начинаю потихоньку сходить с ума. какую карточку мне надо выбрать то блядь? в таверне у меня чат с персом открыт.

суть вопроса состоит в том что оно генерит пикрил хуету.

как блядь настроить то этот кал говна то?

я уже сам начинаю кукухой ехать блядь и думаю что проблема в настройках которые на пик2. как это блядь фиксить?

Я думаю настройки семплера покрутить надо. Не уверен, что для моистраля дефолт - это лучшие настройки. Тем более там у тебя хуй пойми что в кобольде творится.

ЕБАТЬ Я ПРО ЭТО И ГОВОРЮ. но когда я спрашиваю что покрутить или как пресет поставить в ответ тишина.

> какую карточку мне надо выбрать то блядь?

Уже никакую. Я вообще не помню нахуй я спрашивал карточку.

Иди по пути наименьшего сопротивления - спизди все настройки из кобольда и просто вставь их в таверну, если на кобольде у тебя нормальная генерация, а в таверне нет.

Говорил я тебе нахуй, что ты так же будешь ебаться с настройками, даже если перейдешь на мисраль, но нет, ты всё равно перешел, думая что тебе это поможет.

хорошо а как их спиздить и вставить в таверну то?

там дохуя всякой хуйни. половину я не смог найти. половину выставил но ожидаемо пососал хуй

Ебаный твой рот, сопоставь настройки блять которые совпадают с таверной. Они даже называются одинаково. Температуру, мин-п, мин-к и прочее и так далее и так называемое. Если чего то нет в таверне, или нет в кобольде, значит не трогай.

ебаная капча иди нахуй

ну я так и сделал в итоге пососал хуй

Это Aya 35B, русский у неё неплох, но сама она такая себе, шизить любит, хуже ламы 70В. Зато сои нет, базу гонит всегда.

А что за промпт у тебя, что она ведёт себя как двачер?

Попробуй поставить пресет для семплера Universal Light и добавить немного rep penalty до 1.1 примерно. Если не поможет, то я нахуй не знаю что уже тебе поможет.

Я просто в конец карточки дописал "Разговаривай как дегенерат, ругайся матом.". Работает заебись.

спасибо анонче. так бы сразу если честно. потыкаю и отпишу

блядь кажется сработало АХУУУУУУУУУУУУУУУУУУУУЕТЬ БЛЯДЬ

ПИЗДА БЛЯДЬ ДВА ДНЯ ЕБКИ С ЭТОЙ ХУЙНЕЙ И ОНО КАЖИСЬ НОРМАЛЬНО ПАШЕТ Я В АХУЕ

> У одной 3090/4090 с 24 гб слишком мало памяти для 70В

А я не имел в виду одну, очевидно же.

У нас тут куча бояр с двумя 3090/4090 (судя по комментариям), вот пусть скинут тест. Почему-то со стороны спорщиков ни одного теста я так и не увидел.

Ну вот, хоть что-то.

350 т/с против 80 т/с. Вчетверо быстрее на 4090.

С другой стороны, конечно, смысла катать ггуф на двух 3090 смысла нет, проще закинуть бывшую и сидеть с норм скоростью.

2 слота и турбинный охлад, а не три слота и обычные вентили, упирающиеся друг в друга.

Чисто форма-фактор охлада полусерверный типа.

Почему бы и нет?

Ты чо, Мэнди не знаешь?

пикрил

Так.

Ну вот, это сильно решает.

Ну, зачем так!

Самая крупная из адекватных — это Микстраль 8*22, там не 176, конечно, но больше Коммандера.

А еще есть Квен-120, некоторые хвалят.

Коммандер скорее замыкает тройку по размеру. Ну, по качеству может лучше квена — не знаю, квена не пробовал.

> Грок.жпг

Он сказал «адекватных». =D

> Этого микстраля кто-нибудь катал кроме как на апи?

Да, лучше коммандера. Мистраль хороши, МоЕ их тащат, как бы местные шизы не истекали на говно.

Но уже начиная с мику большие модели достаточно хороши, чтобы их различия были не столь существенны. Поэтому Мику, Ллама 3 70б, Коммандер, Квен, Микстраль — это все вкусовщина. Те, которые побольше, как правило, — получше. Но они все немного разные, коммандер под раг, микстраль МоЕ, квен билингвал китайский, так что каждый найдет для себя.

> 22B же, по мозгам.

По их утверждениям, там достаточно много уникальных токенов, больше половины, так что коммандера она обходит, насколько я помню.

Я хотел сказать «какая разница, что стоит в кобольде, апи же», но потом вспомнил, что он кусок кала в этом вопросе и взгрустнул.

Сам по себе макс токен не заставляет срать до посинения, это проблемы некоторых сеток. Он просто НЕ заставляет пихать токен окончания. Немного разные вещи. Норм сетки при 4096 тебе могут фразу закончить за десяток токенов, если по смыслу верно.

Пару тредов назад писали, что кобольд ебал в рот твои апишки, и сам дорисовывает в полученную инфу что ему покажется важным. Я не вникал, но хуйня, согласись.

А карточка какая?

Айа лучше коммандера в логике? Потому что даже 105 с трудом решал про петуха, а тут 35 могет.

Неплохо. Качаю, посмотрим.

Я вдруг понял, что ллама-3 8б для меня выпала.

Для краткой логики Мистраль 0.3.

Для попиздеть Айа.

Для кода Кодстраль.

Для серьезных задач Мику/Ллама-3 70б.

А младшая модель осталась не при делах. Недостаточно свободная как Айа, недостаточно умная как Мистраль. Хм. Ну и обучена криво, конечно.

Для краткой логики Мистраль 0.3.

Для попиздеть Айа.

Для кода Кодстраль.

Для серьезных задач Мику/Ллама-3 70б.

А младшая модель осталась не при делах. Недостаточно свободная как Айа, недостаточно умная как Мистраль. Хм. Ну и обучена криво, конечно.

кста а что за айя анонче?

спасибо мил человек)

https://huggingface.co/bartowski/aya-23-8B-GGUF

https://huggingface.co/LoneStriker/aya-23-8B-8.0bpw-h8-exl2

https://huggingface.co/bartowski/aya-23-35B-GGUF

Файнтьюн коммандера.

1. Мультилингвал, 23 языка, в том числе русский. Лучший русский на данный момент.

2. Цензура уровня первой мистраль: достаточно вписать строчку «ты базированная» — и она будет базированная.

3. Но глупенькая, че ж ты хочешь от коммандера, который затачивался на перестановку слов в предложении, а не написании новых.

> Лучший русский на данный момент.

Лама 70В получше в русский умеет.

бля звучит очень вкусно. и огромное спасибо тебе за ссылки. вот прямо от души. но бляяяяяяяяяяяяя я как представлю сколько ебки с настройками таверны будет так меня в дрожь кидает

Ну, 70б против 8, да даже против 35. Неудивительно.

Пресет Command R в таверне, если что.

> а как и где это сделать?

Там же где и семплеры, справа внизу.

> Он сказал «адекватных». =D

Тогда и микстраль 8х22 выбывает и остаются одни 100б

> Да, лучше коммандера.

Да ну, пиздишь. По результатам на публичных апи он был хлебушком. Именно с точки зрения восприятия всякой абстрактчины, например дать ему пасту и попросить переписать с учетом пожеланий - он переписывает ее слишком буквально игнорируя значения и смысл, тогда как даже 35б командир справляется лучше. Если скинуть ему пасту из рп чата а потом спросить про мотивы и эмоции чарнейма - тоже часто ошибается. По коду хз, но врядли лучше 70б и тем более специализированных моделей, того же кодсраля.

Ну так и кодстраль вышел позже. =)

Плюс, именно а суммарайз я не тестил ее. Чисто вопросики позадавал, пообщался.

Кстати, было очень лень разбираться (ибо на игровом даунвольтил по курве, все дела), но вчера писали, и в итоге я решил теслы даунвольтнуть.

Поставил афтербернер, поставил галочку «синхронизировать настройки для одинаковых ГП», вбил пауэрлимит в 50%.

130 ватт, температура упала на 15 градусов, инференс не изменился.

Окей, это было просто, но я могу ошибаться, канеш, как эта хуйня работает.

Поставил афтербернер, поставил галочку «синхронизировать настройки для одинаковых ГП», вбил пауэрлимит в 50%.

130 ватт, температура упала на 15 градусов, инференс не изменился.

Окей, это было просто, но я могу ошибаться, канеш, как эта хуйня работает.

> вбил пауэрлимит в 50%

Это не андервольт. И вообще теслы залочены, кроме лимита ничего с ними не сделать.

> Айа лучше коммандера в логике? Потому что даже 105 с трудом решал про петуха, а тут 35 могет.

Естественно. Базовые версии говно, особенно 104В, сосущая у кучи более мелких моделей.

нахуй вы мучаете моистраль каловый, это же говно васянское.

Лучше возьмите stheno или fimbulver v2

Лучше возьмите stheno или fimbulver v2