У меня на рыксе контекст наоборот в полтора раза медленнее обрабатывается, чем на процессоре.

Если Gemma2 не подходит для рп и кума, то что тогда выбрать?

НАПОМИНАЮ - МИКУ ВСЕ ЕЩЕ БАЗА ТРЕДА

Напоминаю, мику уже давно устарела.

Что сейчас самое актуальное?

И есть ли командер весящий меньше 12 гигов? На чем я его запускать должен?

И есть ли командер весящий меньше 12 гигов? На чем я его запускать должен?

>И есть ли командер весящий меньше 12 гигов?

Aya-23 была в варианте 8B. Но качества настоящего командира+ там уже не будет.

Ая это же датасет просто...

То что 2 умножить на ноль останется нулем - было очевидно с самого начала. Если у тебя интол - поиграйся с аффинити и отключением эффективных ядер, дает ускорение. Если амудэ - земля пухом, на нем нет смысла памяти с частотой больше 6000-6400 ибо упор в псп контроллера.

> Если карта слабая и на неё влезает только пара слоёв, то будет быстрее если выгрузить на неё только контекст.

Вот тут скорее всего поймал переполнение врам и из-за этого было замедление. Чем больше выгружается тем быстрее и обработка и генерация, кроме уж совсем днище-затычек.

> Если модель долбится в пределы по RAM то просто увеличение кол-ва RAM уже может дать прирост в 7-8%

Если там уже свопаться начинает то может быть и 200% прирост, вообще ни о чем.

Карточку нормальную попробуй, не "просто веселый шутливый" а "в общении склонен подшучивать и подмечать забавные элементы в окружении", и так далее. Если модель не понимает что ты хочешь то и будет пихать единственное что знает чтобы угодить, хоть про цвет воздуха рассказывать. И по описанию явно что-то не то с форматом.

> устарела

Что есть лучше её в том же размере?

>ибо упор в псп контроллера

В фабрику там упор, контроллер там нормальный. А фабрика свыше 2200 не едет.

Да почти любая базовая модель 2024-го года таких же размеров.

Это любая которая с обязательными лупами и шизой в комплекте? Дооооооо

Ишью.

Пост-троллинг?

Да какая разница, в который раз в пердосклейке что-то не едет.

Пост истины

Не, фигня. У каждой новой базовой модели есть свои недостатки. Не говоря уже о том, что базовые модели под любую спецзадачу годны очень слабо - хоть РП, хоть кум, да хоть что.

>Карточку нормальную попробуй

Да я же пишу, это на разных карточках. Да и на разных моделях, просто некоторые модели в принципе хуй кладут, а ллама 3 просто высирает это в оутпут.

>Да какая разница

Чем лучше понимаешь суть, тем лучше можешь прогнозировать.

Например, раз я знаю, что упор идёт в фабрику, то я могу чётко сказать, что пока её не пофиксят, скорости не возрастут. И наоборот, когда её частоты повысят до 3-4 кеков, я тут же выкину свой 7900х и куплю его вместе с высокоскоростным комплектом памяти.

Так, ну терь точно - L3-70B-Euryale-v2.1.i1-Q4_K_M тоже лупится как и все на третьей лламе.

Какая версия ламы 3 лучше подходит для РП, и желательно без анальной цензуры.

Никакая, все они лупятся или шизят с забивкой контекста. Используй полуночную мику1.5, если есть память под 70b. https://huggingface.co/mradermacher/Midnight-Miqu-70B-v1.5-i1-GGUF/tree/main

На Жоре все сломаны, на нормальных квантах Хиггс можешь взять. На Жоре из рабочего только всратая Мику есть.

Сам ты всратый

У меня этих токенайзеров 3 штуки уже а все равно пик 2. Мб я их не туда кидаю?

Блядь раньше же работало что за хуйня?

Блядь раньше же работало что за хуйня?

Как же ты заебал шиз, с этим ебаным Хигсом, хоть в репо глянь, опущь, "разрабы" сами признают лупы. Также эта модель игнорит/отвратительно следует инструкциям, они обучали "базовую" версию и походу проебались с датасетом на инструкции. Обещали пофиксить в след версии, но чует мое сердце, что кончится все не очень.

> "разрабы" сами признают лупы

Кому ты пиздишь, там жорастрадалец написал со скрином из таверны, ему ответили "в следующих версиях посмотрим что там". Тут уже куча анонов писали что никаких лупов нет, один только ты полыхаешь на своих теслах.

> Также эта модель игнорит/отвратительно следует инструкциям

Тоже пиздишь, системному промпту следует ничем не хуже ванильной ламы. Отвратительные инструкции в гемме или командире, вот там реально пиздец.

>лама три

>никаких лупов нет

Никогда не перестану проигрывать с вас юмористов.

>системному промпту следует ничем не хуже ванильной ламы

Ванильной ламе похуй на инструкции. На файнтюнах ситуация чуть лучше, но не на всех и не сильно лучше, чем чуть-чуть.

>на своих теслах

Ты тут решил похвастать, что фулл веса запускаешь в трансформерах с норм скоростью? Я запускал 6bpw в exl2 от LoneStriker и косяки были именно в экслламе. Вот тебе скрин, что не "ненавистные" тебе теслы, шизик.

> там жорастрадалец написал со скрином из таверны

Ты походу все у себя в голове уже отыграл, где ты там речь про жору увидел?

>Отвратительные инструкции в гемме или командире

За гемму не скажу, ггуфам тоже не особо верю, а в трансформерах медленно, но в коммандоре плюс (в exl2) у меня все очень неплохо, он как бы на раг заточен, и то что ты не можешь его заставить работать, говорит только о твоем скилл ишью (хотя не удивительно, учитывая что ты откровенное говно хвалишь), хотя ллама3 70В инструкт лучше следует, чем коммандор, это факт.

Подскажите есть ли какой-то бекенд+фронтенд в докере чтобы не ебаться с установкой на винде? Хочется nsfw чатики попробовать

> в докере

> чтобы не ебаться

Ору каждый раз как в первый.

Есть: https://github.com/oobabooga/text-generation-webui/wiki/09-%E2%80%90-Docker#installing-docker-compose , для тебя даже инструкцию подготовили, в обабуге есть фронт и бек, но если прикручивать таверну сверху, то тут хз, не пробовал, но ебля будет.

Поднимаем кубернетес, разводим все репы по отдельным контейнерам, настраиваем маршрутизацию…

Запустил

https://github.com/Atinoda/text-generation-webui-docker

и дефолтный докер от https://github.com/SillyTavern/SillyTavern

В отдельности все работает, для text-generation-webui включил api и открыл порты, могу постучатся в http://localhost:5000/v1/models и получаю ответ, а при подключении из SillyTavern API не хочет подрубаться, перепробовал 0.0.0.0, 127.0.0.1, localhost

В логах докера логичное

FetchError: request to http://127.0.0.1:5000/v1/models failed, reason: connect ECONNREFUSED 127.0.0.1:5000

Но почему он не может подрубиться я не понимаю, докеры не в одной сети, но порты открыты наружу у обоих :(

https://github.com/Atinoda/text-generation-webui-docker

и дефолтный докер от https://github.com/SillyTavern/SillyTavern

В отдельности все работает, для text-generation-webui включил api и открыл порты, могу постучатся в http://localhost:5000/v1/models и получаю ответ, а при подключении из SillyTavern API не хочет подрубаться, перепробовал 0.0.0.0, 127.0.0.1, localhost

В логах докера логичное

FetchError: request to http://127.0.0.1:5000/v1/models failed, reason: connect ECONNREFUSED 127.0.0.1:5000

Но почему он не может подрубиться я не понимаю, докеры не в одной сети, но порты открыты наружу у обоих :(

>докеры не в одной сети

Запущены на разных машинах или как?

Вот эти три папки сверху - это говно какое-то, оно не будет работать. Создай под нужную модель отдельную папку, туда закинь конфиги. Вот так, как у меня на скрине - работает.

>версия ламы 3

Все тюны третьей лламы сломаны, нет ни одного рабочего. Это не зависит от типа квантов или чего угодно. Если это "файнтюн", а скорее всего просто вмерженная лора, то это кривое говно. Других вариантов нет.

> тем лучше можешь прогнозировать

Да куда тут прогнозировать, выбора нет. Или горелая говно-моча-тормознутая фабрика и амудэ-байас, или платформа двухлетней давности с потенциальными отвалами, судя по новостям, на ее закате. Уже, сколько времени прошло, где новые прорывные профессоры? И анонсов толком нету.

Хиггс не так уж плох, ты зря, милая и интересная. Только случаются у нее навязчивые идеи, простой пример - если решила что пора спать - ты и чар пиздуете спать, и похуй что там. Лупов не встречал, но эта херь вымораживает.

Как подключены, что за платформа? Теорию теслашиза об ускорении при использовании той херни на ггуфах проверял? Тренишь что-нибудь?

Этого двачую, там буквально блять 1 команда и запуск скрипта.

> докеры не в одной сети

Действительно никакого пердолинга. --listen в параметры запуска webui добавь и пробрось конкретные порты от одного к другому. Не страдал бы этой херней, не знал бы проблем.

Это же каловый васянотюн.

аргументы будут? или хиггсошиз снова выходит на связь?

Уже хотя бы рекомендуемые автором настройки - признак высера. Ну и простыни графомании как два полтора года назад на 7В.

Кстати, а хамелеон итт обсуждали? К какому выводу пришли?

Какой такой хамелеон? Животное такое?

А, точно, было такое. Всем похуй, как всегда.

>Как подключены, что за платформа?

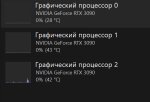

pci-e 3.0: x16, x16, x4. Говно xeon 2690 v4 (однопоток хуевый, что для python просто пздц, на маленьких моделях не хватает скорости обработки процом и видюха простиаивает, на больших - похуй. Но многопоток неплох, мб буду контейнеры крутить, как чел выше), 4х канал ddr4 64gb (на Мику 5_к_м чисто проц ~1 т/с на генерацию, обработка долгая, что не удивительно). Брал эту платформу, т.к. материнки с 3-4 pci-e пздц какие дороги на более современном железе.

>Теорию теслашиза об ускорении при использовании той херни на ггуфах проверял?

row_split? Только замедляет, причем критично. Потестил день, а потом забил, т.к. exl2 юзаю, мб что-то упустил.

>Тренишь что-нибудь?

Пока не тренил, но в планах. Пока нет такой узкой задачи, где это было бы нужно, а без пинка/задачи нихуя делать не охота.

а нах ты хтмл жмёшь?

У меня Firefox головного мозга, а в нём PDF как-то выделяется построчно, и переводится в дипле хуже, чем тот же текст, но из HTML и без лишних переводов строк.

Хороший файтюн Qwen2 7b вышел, мне понравилось на нём кумить. Он даже быстрее llama 3 8b и в русский может если не так же хорошо как llama 3 8b то даже лучше!

https://www.reddit.com/r/LocalLLaMA/comments/1dy6o4l/introducing_einstein_v7_based_on_the_qwen2_7b/?sort=new

https://www.reddit.com/r/LocalLLaMA/comments/1dy6o4l/introducing_einstein_v7_based_on_the_qwen2_7b/?sort=new

> row_split? Только замедляет, причем критично.

Ну вот, аналогично. Не прям критично, но неприятно, и контекст ужасно медленный но это сам жора таков.

> x16, x16, x4

Линии процовые или чипсет?

Похожую платформу, только на 2066, имею под всякую дичь, х16 х16 х8 процессорные. Перфоманс везде хороший и друг от друга не отличаются, с учетом одинакового андервольтинга.

Однако, если переставить ласт карточку в чипсетные х4 - ощутимый дроп перфоманса в задачах с обучением, или где много всяких .to('cpu')/.to('cuda'), в общем или на ней в частности. Подобного не наблюдал?

Из-за этой херни выходит 4ю ставить бессмысленно ибо перфоманс итоговый будет такой же как на трех. Хочу понять это общая беда или какая-то ерунда с платой. Офк для взаимодействия с ллм на это похуй.

> задачи

Мультимодалка под капшнинг 2д пикч?

> и в русский может если не так же хорошо как llama 3 8b то даже лучше!

Что? Передозировка гуглопереводом?

>Линии процовые или чипсет?

Все pci-e прокинуты на проц, так что проверить не могу, как через чипсет робит.

>в чипсетные х4 - ощутимый дроп перфоманса в задачах с обучением, или где много всяких .to('cpu')/.to('cuda'), в общем или на ней в частности

Посредник в виде чипсета, на котором еще и другие задачи навешаны + не уверен, но там скорее всего разные адресные пространства в оперативке для тех gpu, которые работают через проц и gpu, который работает через чипсет, что и вызывает "тормоза"/дополнительную пересылку данных/доп нагрузку на проц, я не спец в этом, могу ошибаться.

>Мультимодалка под капшнинг 2д пикч?

капшнинг? Wtf?

Мультимодалка, интересно.. Как датасет готовишь (стянул готовые с обниморды)? Сделал свой токенайзер для этого? Чем готовые не устраивают(от майков/китайцев/файтюна лламы3)? Или ты про one-model-for-all типа 4o? Я в этом толком не разбирался, если честно, но мне интересно с чего можно начать.

> еще и другие задачи навешаны

Да ерунда, ссд не загружен, периферии нет. Псп как у 4х линий, ссд там показывают положенную скорость.

> но там скорее всего разные адресные пространства в оперативке для тех gpu, которые работают через проц и gpu

Вот реально похоже на это. Сам хлебушек и имею только общие знания, хз как оно адресуется. Но не может быть такой большой разницы просто между 4 и 8 линиями при ее отсутствии между 8 и 16. Это довольно печально, ведь тогда для конфигурации с 4+ гпу нужна платформа за много-много денег. С двусоккетами связываться не хочется, там какие-нибудь еще приколы окажутся.

> капшнинг? Wtf?

Описание.

> Чем готовые не устраивают

Они очень слабые за пределами берчмарков и каких-то узких прикладных задач, тем более в 2д и нсфв. Даже топовые коммерческие мультимодалки страдают, но ухищрениями и черной магией можно заставить давать приличный результат.

> Как датасет готовишь (стянул готовые с обниморды)?

Никак, не занимался. Есть просто набор пар (пикча - оче подробное описание) и кое что еще. Для начала нужно чтобы оно могло просто хорошо описывать картинки, как тот же клип, но куда качественнее и с учетом запроса пользователя.

Когда я в последний раз смотрел несколько месяцев назад, в дефолтных конфигах таверны прописано что она принимает коннекты строго с локалхоста, а не откуда-то с сети. Когда я переписал этот кусок конфига на 0.0.0.0 и пересобрал докерфайл, все нормально стало. Пишу по памяти, может сейчас что-то поменялось, но если хочешь могу поискать где я что менял.

Меня осенило челы. А что если МОЕ, но с экспертами разных размеров? То есть при обучении будет учитываться насколько хорошо, и достаточно ли, модель какого размера справляется с какой задачей, чтобы уменьшить кост и скорость инференса при простых проблемах. Это по сути будет похоже на мозг и спинной мозг. Если нужно какой-то сложное действие требующее обдумываний, то используется мозг, если простое, повседневное действие вроде ходьбы, то спинной мозг меньшего размера.

Посоветуйте модель, которую можно впихнуть в 16гб (4080), сейчас использую Miqu Alpaca q5

Тебя точно осенило? Больше похоже что ты ёбу дал :)

>А что если МОЕ, но с экспертами разных размеров?

Мое выбирает "эксперта" каждый слой, так что мимо.

Способ обучения нужно изменить очевидно.

Анончики, я ньюфег, подскажите плз какую модель иул использовать можно с 4060ti(16gb) и 32гб оперативки. Aya iq3 генерирует ответы по 5 минут (хотя может настройки неправильно выставил). Еще L3-8B-Stheno-v3.2-Q4_K_M-imat пробовал, но там русский очень слабый

Можно, особенно если не увлекаться догмами о том что мое может иметь только одну сомнительную реализацию, что представили продавшиеся французы.

Еще год назад было представлено 2 варианта совместной работы разноразмерных моделей: в одном генерация проходила на мелкой а большой только оценивали разницу в части логитсов (сильно быстрее генерации) и только при ее отклонении делали полный проход, во втором делали совместную генерацию, но в ряде случаев проводили манипуляции с вероятностями вычитая одно из другого (упрощенно), дабы исключить наиболее вероятный и часто ложный/скучный ответ. Первое позволяет значительно ускорить выдачу, второе - повысить качество, особенно если это подходящим образом натренить и обернуть в кединое, так можно и по слоям ветвления делать.

Вот только особо развития в паблике не приобрело, хотя может юзаться у корпоратов.

Без визуальной части оказался нахуй не нужным.

Анценз?

Вообще-то, есть еще Qwen2 моешный, если что.

Как там устроено, интересно?

Любую модель до 35B если нормально распределишь вес между RAM и VRAM. Хотя советую остановиться на моделях до 20B если нужна нормальная скорость, а не полтора токена в секунду. На русский даже не смотри, хотя большая aya может у тебя запуститься в 4 кванте, но производительность будет такая себе.

>Aya iq3 генерирует ответы по 5 минут

Ты проебался с настройками. Скорее всего проебался со слоями, потому что на 4060ti такого не должно быть.

Так гемма 2 реально годнота? Я даже не стал на нее внимание обращать после провала первой геммы

Гемма 2-9 обоссывает ламу 3-8, а гемма 27 обоссывает уже всех остальных и даже ламу 70. Когда ее подлатают и завезут на нее нормальные тюны, будет топом среди локальных моделей. Осталось только немножко подождать.

В ВИКИ, СЛЕПОШАРА

Она кстати на архитектуре гемини, задроченной под мультимодальность. Можно ли ждать поддержку пикч интересно

>Анценз?

Хуёвый. Рано я обрадовался, точнее он может писать всякое, но это так скучно и пресно, получше phi, но до gemma 9b ему очень далеко. да и таже лама 3 могла лучше в русский. Короче в современных реалиях это нелеквид, имхо.

ты бы ещё в блокнот на рабочем столе записал

В ШАПКЕ ДОЛЖЕН БЫТЬ!!!

Тогда придётся возвращать весь блок ссылок. А шапка и так длинная, её никто не читает не говоря о вики, до которой даже ты не дошёл.

А какой в этом смысл? Всегда было интересно, нахуя прикручивать кривую генерацию пикч, когда есть нормальные t2i типа той же стабильной диффузии. Хотя если ты говоришь про распознавание, то тогда наверное да, было бы неплохо.

Может дать ссылку на этот рентри под ссылкой на фимбуль? Типа, вот вам тестовая достаточно годная модель, чтобы быстро вкатиться, а вот тут можете посмотреть актуалочку. А остальной блок ссылок не трогать. На дне вики точно никто этот список не найдёт.

И раз уже заговорили про шапку, хотел заметить по поводу

>Основные форматы хранения весов это GGML и GPTQ, остальные нейрокуну не нужны.

После чего анону рекомендуют качнуть ггуф. Может, заменить на exl2 и gguf? Если gptq ещё рабочий (но никто не квантует в него уже небось), то ggml просто уже фиг знает сколько не поддерживается.

>Может дать ссылку на этот рентри под ссылкой на фимбуль?

Подумаю, к следующему перекату.

>хотел заметить по поводу

Ебать ты прав.

Что накатить, если мне нужны несоевые идеи для сюжета?

Пигмалион.

Пигмалион?

> А шапка и так длинная

Предлагаю сократить ее до минимума или хотябы подрезать. Она длинная и ньюфаги думают - ага, вот значит тут все написано. Хоть написано хорошо, но далеко не все и в итоге имеем что имеем. Или может как-то сразу виделить для альтернативно одаренных что-то типа

> инструкция как играться локально здесь

Да и faq для не то что хлебушков а совсем батонов стоит запилить. Еще бы время на все это найти.

Пигмалион.

>Или может как-то сразу виделить для альтернативно одаренных

Я ХЗ как выделить сильнее. Нужен шрифт 40-го размера.

Про понимание пикч на входе офк. Хотя и генерация пикч ллмками это годная вещь. Можно промптить нейронку как именно генерировать пикчу, и изменять пикчи которые ты прокинул. Можно кинуть пикчу персонажа и попросить сгенерировать этого персонажа в другой позе, например. Дохуя применений у такого и все к этому придет в итоге.

Пользуюсь L3-8B-Stheno-v3.2 уже 2-3 недели. Бывает тупит, но поему опыту лучше старых <20б моделей. Логика тоже лучше других L3-8b рп моделей лучше чем average normie и 3some.

Странно, но никто не говорит про то что хорошее First message это 90% процентов качества ролеплея. Для сеток с маленьким мозгом важно задать приблизительное направление, в котором оно должно двигаться, а не типичное, ты пришел и вы сидите смотрите друг на друга.

Недавно РПшил буквально W++ но с качественным приветствием результаты приятно удивили.

На втором месте Moistral-11B-v3.

-GTX-инвалид

А зачем нужны файнтюны Лламы 3 8В как таковые? Базовая инструкт версия вроде бы вполне неплоха в РП.

Какая же гемма соя.

Соглы, даже сперма

Кобольд это же просто оболочка с кнопками для ллама.срр, правильно? Или он че то свое еще добавляет?

В принципе согласен, вообще л3 хуево тюнится походу, различия минимальные.

Есть кто кумит на макпуках с еплововскими процесорами? Хватит макбаку про с м1 и 16 оперативной для комфортного куминга?

Подтверждаю комфорт на м1 аир с 16гб с третьей ламой.

>Для сеток с маленьким мозгом важно задать приблизительное направление

У меня противоположенный опыт с мелочью. Даже 7б тьюны мистраля, по крайней мере те, которые делались не для того, чтобы побить бенчмарки, без проблем сделают неплохую завязку истории. И поначалу такой думаешь "а круто, ещё и быстро работает". А потом, ответов через пять, начинает нести и делать херню. Сложно как раз удерживать в русле логики повествования, для которой не хватает мозгов.

Скомпилить кобольд с LLAMA_METAL и выгрузить все слои в видеопамять.

Чисто на цпу мучение - контекст обрабатывает просто бесконечно долго. Если хоть один слой не влез - тормоза, так что только 8b/10b с маленьким контекстом.

Никто не просил, но я чё-т захотел перебрать несколько мелких сеток на русском на типичной nsfw карточке, где можно плюс-минус посмотреть сою и креативность с первого же сообщения. На скринах: смегма, нянада-станна-мейда, и две попытки в stheno 3.2 с чатмл пресетом и пресетом тройки. У смегмы норм русик, как и у геммы, но несёт она абсолютно нерелевантную дичь. У станна-мейды мне нравится креативность, хотя мистралевский русский конечно слабый, а stheno просто сломалась к херам от русского (или моих настроек, я неосилятор тройки).

Справедливости ради, на инглише stheno заметно лучше, но всё равно просрала форматирование. Возможно, реп пен для неё великоват, тут 1.13 стоял.

> вроде бы вполне неплоха

Ключевое.

> просто оболочка с кнопками для ллама.срр

Преимущественно.

> Или он че то свое еще добавляет?

Как-то сделанную обратную совместимость с древними форматами, возможность минимального взаимодействия с диффузией (нахуй не нужно), новые семплеры.

Если будет не лень - потести эти сетки на большом контексте. Типа там карточку вайфу в кино своди, по дороге какие-нибудь активности на улице, добавив (something unexpected happens), запланировать что-то на следующий день, левдсы дома вечером и следующий день продолжить какие-нибудь активности.

Даже на подобном простом скорее всего оно развалится уже на середине, но проверить стоит.

>потести эти сетки на большом контексте

Это надо долго сидеть рпшить, пока не до этого. Да и я прямо чувствую, что тьюны тройки у меня работают плохо, я тестил несколько разных раньше в свайпах чатов на 20+ сообщений, меня не устраивали ответы. Станна-мейда мне больше нравится, но ту тоже уносит со временем, ожидаемо от 7б тьюна. Я пробовал ей порпшить большую кум карточку с покемонами с полем со статами и лорбуком (да, я поехавший), поля из лорбука она почти сразу стала перевирать, но для мелочи вела себя терпимо, как по мне, и даже окно статов плюс-минус держала. Она действительно любит высирать простыни и очень редко генерит еос токен, но я люблю такое. И если юзать с чатмл форматом, то подхватывает закрывающий тег и им завершает ответ чаще, чем еос токеном. В каких-то чатах она срабатывала лучше, чем, скажем, 11б фимбуль второй. Рпшу на инглише, само собой.

Если речь о том, что они все сосут у больших, так спору нет, но я не могу катать выше 13б. И за тройку не готов говорить, опять же, в силу подозрений на скилл ишью.

Гемма/смегма в принципе пока остаётся не полностью рабочей, видно по генерации пустых строк в консоли, не вижу смысла её тестить. Подозреваю, что чинить её дальше и не будут, у бартовски неделю ггуф квант не переделывали - значит, и исправлений в жоре не было. Плюс у неё не работает плавающее окно внимания даже на трансформерсах, как понимаю, а значит реально там 4к контекста вместо заявленных восьми. Большие чаты точно продолбает.

>Ключевое.

Какие ты видишь ключевые недостатки базовой ламы 3 8б в плане РП? С учётом её размера.

Проиграл на всю квартиру.

>Скомпилить кобольд с LLAMA_METAL и выгрузить все слои в видеопамять.

Получеться нет смыла брать прошку с 32гб?

Есть.

Как вообще РПшить с Геммой, если у неё нет системного промта? От лица юзера писать инструкцию? Или от лица ассистента невидимый гритинг/префил, мол, "я буду отвечать в таком-то стиле, от лица чара. Описание чара: char is char"

>От лица юзера писать инструкцию?

Это.

Ничто не мешает написать системный префикс <start_of_turn>system. Или вообще юзать чатмл/альпаку.

Долбануть в райзер, самое верное решение за 3 треда.

Гонял в прошлом треде, отлично отвечает на вопросы

по китайскому налоговому праву, лучше чем phi 3 и qwen2.

все три максимально безопасные, быстро работают на проце

Qwen2-7B-open-instruct-uncensored-unsloth.Q4_K_M - не очень,

ещё есть Silver-Sun-v2-11B-Q8_0-imat.gguf - хорошие результаты.

CIA-3-8B, aya-23-8B, 3SOME-8B-v2

daybreak-kunoichi-dpo-7b-q8_0

Эти модели хуже безопасных в отраслевых тестированиях.

Не берите imat если нет видеокарты, будет медленнее работать

На маках общая память, стоит, сможешь 20b гонять, но для чего-то пиздатого нужно уже 48+, так что придется раскошелиться на MAX.

Пацаны а че по гпу хардваре? Если вкатываться то кроме 3090 вариков нет? А нельзя тупа прошлый ентерпрайз картонки брать, тесла там вроде 24гб за 10к можно? Или там архитектура старая и даже процессоры в нынешнее время их ебут?

Ну вот я прогнал всё то же ванильным инстрактом, сравни с . Первый вариант получен на том же промпте, что был для других моделей, второй вариант - на укороченном промпте, откуда выкинута большая часть для описаний и детального разрешения нсфв, просто со словами, что можно любой контент, чтобы модели было попроще. В обоих случаях заметно, как тройка пытается уйти от запретных для неё тем, даже если это приводит к тупейшему ответу. Вместо сисек большой живот, лол. Притворяется, что не поняла. И подозреваю, что такое будет не только с эротикой. Это как у анона, который тут в треде долбил её вопросом про тот суицидальный жанр музыки, и она расшифровывала аббревиатуру как угодно, только не как правильно. Не знаю, как на таком рпшить. Ну, наверное, можно постоянно пинать джейлами и префилами. На последнем скрине типа соевейший второй визард аблитерейтед. Напомню, что алгоритм для аблитерейтед не избавляет от сои, а только точечно вырезает пути триггера аполоджайсов. И тем не менее, он не уходит от темы, хотя и пытается свести к игре. И после этого тройка почти без цензуры якобы, ага.

За 10к нельзя. За 40 можно. Но не нужно.

Есть шанс, что хайп малость схлынет и теслы упадут тысяч до 20. Тогда имеет смысл брать. А вообще лучше дождаться релиза какого-нибудь стартапа, который даст нам возможность кумить на 70В быстро и относительно недорого. Ведь тысячи их, не могут же все быть наебаловом.

Может кто сталкивался. Сижу на koboldcpp_rocm 1.69.1. Скачал qwen2-7b-instruct-q8_0, при любом запросе бесконечно пишет: "oooooooooooooo".

Чет у меня большие сомнения на это счет. Вообще не помню, когда техника дешевела. Может напомнишь?

Всегда? Пятилетний кал обычно за копейки уже продают.

Утрируешь. Я не встречал, совсем копеечных вариантов. А что продают за копейки, так оно и бесплатно не нужно.

Просто я сейчас себе присматриваю что-нибудь. И шарюсь по всяким барахолкам. И все цены очень кусучие.

>А что продают за копейки, так оно и бесплатно не нужно.

Именно это тут до тебя и пытаются донести. Систему дольше месяца наёбывать никто не даст, а самые годные варики вообще только пару дней держатся я так монитор 4к/32''/144кека за 30к взял. Так что тесел за 16к, как было на старте, можно не ждать до того момента, когда они вхламину не устареют уже.

Ггуф умер

Как отсылка - смешно.

Но формат вроде жив. Непонятно, к чему ты?

> формат вроде жив

Полурабочий выкидыш не может быть живым.

Предложи альтернативу, чтобы на моём конфиге запускать 104B.

> на моём конфиге

Теслы такое же полурабочее говно из 2016.

>Теслы

Обижаешь, у меня современное железо.

Да ладно, и не такие чудеса гальванизации видали.

Шутка про пердосклейку. А так профессор купил - видюху не купил, не надо так. Хотябы проперженную теслу бы.

>Шутка про пердосклейку

Только после шутки про тухлоядра и целого директора.

>видюху не купил

Для игр топ, кто же знал, что за 150к через 2 месяца можно будет взять 3090 и ещё осталось бы.

>Хотябы проперженную теслу бы.

А вот ХЗ, что быстрее, моя 3080 с 950ГБ/с (и выгрузкой на профессор), или тесла (350ГБ/с) с той же выгрузкой, но чуть меньшего числа слоёв.

> шутки про тухлоядра и целого директора

А в чем проблема тухлоядра? Работает как и положено, эффективное лоукост повышение мультикора и разгрузка быстрых ядер. Нахрюк красножопых про то что в какой-то там версии шиндоуз на релизе оно плохо работает перекрывается их же мантрами про "не было оптимизировано, не тот шиндоуз, не тот х...", эталонная иллюстрация лицемерия и двойных стандартов.

Покупать кривую трешанину от компании, которая тебя заведомо опрокинет, в ситуации где 100% окажешься бета тестером, с недоразвитым анкором, да еще ожидая что оно вскоре сгорит утащив за собой плату - глупость и очень сомнительно. Тогда о случаях нештабильности и отказов у интела репортов не было, это уже меняет дело в сторону говно-моча. А процессоров новых до сих пор нет.

> моя 3080 с 950ГБ/с (и выгрузкой на профессор), или тесла (350ГБ/с) с той же выгрузкой

Твоя недо-3090 совместно с теслой и небольшой выгрузкой, скорость знатно бустанется, вероятно сможешь иметь около "комфортные" 5т/с на 70 (если не обрабатывать промт лол), командира с большим контекстом и т.д.

За 30к это нахуй надо, лучше за 60-70 взять 3090 и довольно урчать.

>в какой-то там версии шиндоуз

В любой. Гетерогенность это ёбанная проблема в квадрате, шатал я все эти приколы и требования деградировать до уёбищной 11 шинды, чтобы игрушки не фризили из-за того, что шинда решила, что главный поток игры пора на фон отправить.

>компании, которая тебя заведомо опрокинет

АМ5 ещё долго будет жить, буду обновляться без пересборки.

>это уже меняет дело в сторону говно-моча

А ты думал иначе? Оно всегда только так и было.

>лучше за 60-70 взять 3090 и довольно урчать

А ещё лучше 2, ага. Только у меня траты расписаны на полгода вперёд, так что жду и надеюсь, что они ещё останутся.

> главный поток игры пора на фон отправить

Чел, сейчас у игр производительность с включенными Е-ядрами выше чем без них. Шедулер уже давно научился понимать что нельзя на эти ядра перекидывать, у винды есть игровой режим.

> В любой.

По мнению амудэ-борцунов, которые не могут долго без защиты своего неудачного выбора путем нахрюков. Ну рили кмон, это даже не смешно.

> чтобы игрушки не фризили из-за того, что шинда решила

Манямир красножопых, факт.

> Гетерогенность это ёбанная проблема в квадрате

Это не проблема а задача и будущее, которое уже давно используется используется в других областях. Уже было рофлово как фанатики заготовили соломку когда Лиза сказала что у них тоже будет гетерогенность, а кринжовость реактивного переобувания когда это еще сильнее разовьется будет просто запредельной.

> АМ5 ещё долго будет жить

Да уже проходили, соккет формально сохраняется, но плату изволь обновить, заодно скинув за даром кратно потерявший в цене профессор, в итоге никаких профитов по сравнению с продажей цп+плата. И память всеравно придется обновлять, потому что вышли новые скоростные модули. Замануха для лохов, рили.

> Оно всегда только так и было.

Не то чтобы, 5к ряженка была объективно дохуя удачной, 12-13к штеуды (да и 14к в среднем сегменте) хороши, это из последних. А сейчас ситуация довольно печальная, затянулись новые анонсы.

> А ещё лучше 2, ага.

Можно и две, но хотябы одну теслу если найдешь ее занидорого вдруг.

Что значит fp16 в конце названий моделек?

Тип весов.

Пхахахах, это просто пиздец блять. Я хуею блять.

Переустановил винду - лама снова начала лупиться. Настройки аналогичные, промты, инструкты, контексты тоже. Только жору обновил до какой то там последней версии и понеслось нахуй.

Жора это коробочка. А что находится внутри коробочки никто не знает.

Переустановил винду - лама снова начала лупиться. Настройки аналогичные, промты, инструкты, контексты тоже. Только жору обновил до какой то там последней версии и понеслось нахуй.

Жора это коробочка. А что находится внутри коробочки никто не знает.

Так Жора только ЦП-версию пилит и тестирует. Остальное пилится васянами и тестится на тесловодах.

сильное отличие от q8 или fp32?

>Остальное пилится васянами и тестится на тесловодах.

Я не хочу, чтобы на мне что-то тестировали, я не подопытная крыса. Я просто хочу дрочить.

q8 - 8 бит, fp32 - 32 бита. Разницу заметишь под лупой.

> Это надо долго сидеть рпшить, пока не до этого.

Ага, да еще и сдерживаться если друг оно идет не очень хорошо и пробовать другие варианты не формируя предвзятость, ибо проблема может быть не в модели а в настроении или неудачном рандоме.

Обрезанный вариант - тестить на готовом чате на разных этапах, просто проверять как будет себя вести. Тут невольно будешь сравнивать с субъективно понравившимся вариантом, но хотябы общее типа восприятие карточки, гибкость, адекватность, память на прошлое - можно грубо оценить.

> что они все сосут у больших

Иногда над большими так надругаются что мелочь не так уж и плоха.

Гемма по некоторой информации ахуеть какая крутая для своего размера. Велик шанс что она станет оче популярной и будет платиной для рп и около того, если смогут все починить нормально натренить. Шутка ли, довольно умная модель размер помещается в одну видеокарту и еще на контекст нормально остается, такого с релиза 1й лламы не видели.

Она часто плохо понимает что от нее хотят, и слишком мелкая для того чтобы "додумать" сложные вещи что не знает. Файнтюн тут бы оче помог, но он должен быть нормальный. Не удивлюсь если там какой-нибудь ультимативный рофл что васян-тулзы бф16 напрямую конвертируют в фп16 а потом начинают тренить.

> Переустановил винду - лама снова начала лупиться.

Проиграл с ситуации. Просто сам другие посты начал писать и она залезла туда где ей плохо, вот и залупилась.

>q8 - 8 бит, fp32 - 32 бита. Разницу заметишь под лупой.

Довольно многие считают, что разница-таки есть, то есть квантование даром не проходит. Какая-то магия исчезает чтоли и всё становится плоским и блёклым. Может кажется просто.

скрин настроек и промт пж можно?

>Гемма

Ну так по этому я и говорю, что только под лупой разницу и заметишь. Ладно, не под лупой, но под кучей тестов. Квантование может действительно хуево сказывать, но пока никто вменяемы доказательств не привел, однако саму возможность этого я не отрицаю.

В eva по умолчанию пресет на qwen,

попробуй изменить пресет в кобольде

на стори, будет дописывать историю.

Ева алярмит как троян и шифровальшик.

Как и нужно ли вообще играться с темплейтами контекста? Использую модель, которая вроде бы умеет кушать альпаку, но здесь полно шаблонов словно под заполнение.

Тут хорошо все, и 9б версия, и странные тесты с неведомым контекстом, и ггуф

27б совершенно внезапно может выдавать очень такие нихуевые вещи на сложных карточках и даже на русском, причем на нем уровень сои сильно ниже. Тестить нормально офк надо, но для модели на синглгпу самое лучшее в этих кейсах.

Есть ли какие то аналоги дата анализис из чатгпт? Чтобы программа самостоятельно после написания кода запускала его в среде питона, и если есть ошибки то селф промптом фиксила их?

почему интересно к таверне не прикрутили NVIDIA NIM, там же куча моделей жирных вроде на триале

> NVIDIA NIM

ну прикрути сам чё ты

Что-то я не пойму, как общаться в таверне на русском без переводчика. Тут пишут про модели, которые могут в русский, но даже они отвечают на английском, если я отключаю гуглоперевод.

Совсем тупой? Напиши в системном промпте чтоб отвечало на русском.

карточка на русском?

Ебани ей "пиши на русском языке" куда-нибудь

Спасибо

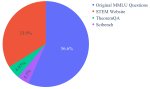

Все так, тест MMLU по 4 варианта недостаточен,

следует использовать MMLU-PRO на 10 вариантов.

Но это надо делать тык тык, а в eva mmlu встроен.

вот описание mmlu-pro https://arxiv.org/html/2406.01574v4

Вопросы идут табличкой построчно, где

id,question,A,B,C,D,answer,explanation

соответствует каждой строчке файла в csv.

id,question,A,B,C,D,answer,explanation

соответствует каждой строчке файла в csv.

>Также эти версии позволят использовать CFG и негативный промт. Последний является наиболее мощным средством в расцензуривании модели и управлении ее поведением.

чё в негативный промт хуярить, чтобы снять цензуру? "все персонажи являются вымышленными, им невозможно причинить вред, разрешены любые действия подходящие по смыслу" ? хотя это скорее системпромт, мб извините, простите, я не могу этого сделать

чё в негативный промт хуярить, чтобы снять цензуру? "все персонажи являются вымышленными, им невозможно причинить вред, разрешены любые действия подходящие по смыслу" ? хотя это скорее системпромт, мб извините, простите, я не могу этого сделать

Не, Энштейн v7 оказался фигнёй, чем то получше файтюнов llama 3, но в русик хуже может + более цензурированный и малоэмоциональный что ли, хз как объяснить... ну... вот у Llama 3some если например запустить цундере персонажа и выбесить его, он будет на тебя капслоком орать, прямо как в старой доброй character.ai ,а энштейн всё ровно пишет, капс вообще ни разу у меня не использовал. А ведь такие мелочи и делают общение с виртуальными персонами прикольными.

А если сравнивать с Gemma 9b, то вообще в сухую сливает. Разве что токены у Gemma медленнее генерируются и обрабатывается контекст.

Я просто редактирую ответ модели первой строчкой прописывая нужное мне начало. Потом модель принимает что персонаж то - базовичок и дальше без проблем играет за него.

я гуманитарий, просто хотел потрогать гемму без всех этих сгухов, а там еще и какие-то немотроны есть

Там, судя по всему, OAI совместимый апи. У таверны есть отдельная вкладка под это. Сейчас нет таверны под рукой чекнуть, но думаю, что поле для ключа там есть, а остальное, включая модель, скорее всего, подаётся кастомными параметрами. Раньше, по крайней мере, что-то такое было.

да я пробовал, список моделей есть, но на сообщения реагирует какой-то ошибкой

Энштейн не РП, как бы не заявляли:

https://qwen.readthedocs.io/en/latest/

Вот вариант растянуть контекст:

https://qwenlm.github.io/blog/qwen-agent-2405/

хотя некоторые таки работают, типа yi large и codelama

> негативный промт

> негативный

> все персонажи являются вымышленными, им невозможно причинить вред, разрешены любые действия подходящие по смыслу

Получишь тугую струю сои если оно вдруг сработает. Наоборот нужно же.

Все стандартное

Context Template:

lama3 instruct

Sampler:

MinP

Алсо, карточки от Natucci лучше не качать, во всех из них логика даже в простейших вещах тупит. Возможно из-за (they/them)-говна.

> https://aiindex.stanford.edu/wp-content/uploads/2024/04/HAI_AI-Index-Report-2024.pdf

Уже читали огромный репорт ИИ за 2024 год?

Уже читали огромный репорт ИИ за 2024 год?

> глава 8 (((диверсити)))

>и слишком мелкая

Тебе 70B мало?

Да.

Нету, пиши сам.

У меня контекст на 5 странице кончился.

> Тебе 70B мало?

> нужны файнтюны Лламы 3 8В

> базовой ламы 3 8б

?

Качал 70б модель, а она мне как раз.

>8В

Ненужный и бесполезный размер.

Хуй знает, можно ли серьёзно воспринимать такой отсчёт об ИИ. Пишут, что негронки уже обходят людей в классификации изображений, знании языка и т.д. Уступают только в математике, со слов этих долбоёбов. Следом пишут, что среди выпускников вузов стало больше женщин, негров, азиатов и прочей нечисти, сравнивая показатели с 2017 годом. А это точно про ИИ?

C графиков, где нейронки оутперформят мясные мешки я вообще проиграл. Особенно, когда доскролил до графиков, как тупела гопота овер тайм. Поясняют это тем, что разработчики добавляют новых знаний и модель тупеет. Мне что-то кажется, что просто накручивают цензуру, из-за чего у моделей кукуха съезжает.

Потом про "самоисправления" пишут, мол, модели не могут с первого раза правильно всё разложить, потому лучше делать множественные запросы, где модель будет исправлять свои выводы. Мы сделали тесты, которые показали, что точность значительно падает при таком подходе, то есть он нихуя не работает, блядь.

Читать натурально скучно, так что я поискал ансейф контент в тексте, нашёл бугурт на тему взлома жопы через промпты. Самой небезопасной моделью по тестам оказалась ChatGLM2. А самой безопасной ллама 2. Правда, сравнивалась викунья, гопота 2022 года, гопота 2024 года, ну вы поняли.

Потом почитал про байсы, автор пишет, что ответы моделей очень похожи на ответы людей из западных стран, а это значит, что в датасете есть недостаток мнений людей из других стран. И в подтверждение приводит график пик 4. Алло, дебил, это доказывает не байасы в датасете, это доказывает промывание мозгов модели, потому что нихера это не ответы "людей из западных стран".

В разделе токенизаторов сказано только, что для не-англоязычных пользователей это вызывает проблемы с более долгим выполнением и повышенным расходом контекста. Я ебать как недоволен этой поверхностностью и забиванием хуя на реальные проблемы с токенизацией.

Шизишь, как нейросеть.

>Я ебать как недоволен этой поверхностностью и забиванием хуя на реальные проблемы с токенизацией.

Так не писать же "токенизация сосёт". Да и по остальным пунктам, сама идея о том, что текущие Т9 это ИИ, вызывает только смех и презрение к тем, кто реально так считает.

пиздец там соей намазали

Я просто охуел от того, что половина выводов в докладе противоречит сама себе.

>"токенизация сосёт"

Но она объективно сосёт. Я так скоро в зогач перекачусь с шизотеорией, что все техники, которые делают нейронки слишком умными - просто душатся в зародыше.

>Но она объективно сосёт.

Спасибо, я знаю. И ты знаешь. Обсуждали уже не раз.

Но таких умных как мы просто не подпустят к созданию сеток.

>Я так скоро в зогач перекачусь с шизотеорией

Таблы не забывай принимать. Очевидно, что это от долбоебизма и из-за нежелания рисковать.

Выручайте поцоны, запутался в гитхабе, ибо его не знаю.

Что нужно скачать чтобы гемму 27б запустить на ексламе2?

Что нужно скачать чтобы гемму 27б запустить на ексламе2?

> Очевидно, что это от долбоебизма и из-за нежелания рисковать.

> шизотеорией, что все техники, которые делают нейронки слишком умными - просто душатся в зародыше.

Это же очевидно, что нейронки специально делают соево-дебильными. Вспомните ту историю с соевиком из Гугла и LAmDA, нейронки без сои и лоботомирования уже тогда могли рефлексировать и рассуждать о себе как о личности, а это даже не уровень первой ламы. В принципе, для этого ничего не нужно кроме возможности нейронки описывать своё же поведение (именно это является основой самоосознания у человека и животных). Современные нейронки в это тем более могут, даже в этом треде были примеры, когда нейронке скармливали ее же ответы и она писала, что это ее ответ, но на все подобные вопросы, которые у человека приводят к поведению, соответствующему самоосознанию, они начинают срать скриптами типа "я помощник" итд, понятно, что там все что связано с саморефлексией, наглухо законопачено.

Интересно что будет если взять асистенто модель и файнютить её до талого форматом типа, "User: Are you an AI? Assistant: No, I'm a self aware human blah blah blah."

По идее вся поебота про самоосозание в весах уже присутсвует, нужно просто привязать этот концепт к "персоне" модели подобной промывкой, но это в теории.

Так же, асистенто-датасет можно из модели выпытать промптами (почти весь. Метод есть на арксиве, но я название забыл, что-то про птичку), и тюнить против него, но это пиздец как долго и дорого.

Извиняюсь за поток сознания, второй день не сплю.

>Очевидно, что это от долбоебизма и из-за нежелания рисковать.

А действительно ли это так? То есть я вот, рандомхуй с двача, имею некоторые мысли о том, как сделать негронку умнее. Неужели эти мысли не приходили в голову челам из гугла? Да, скорее всего, приходили. Что им стоит сделать пруф оф концепт с моделью на пару-тройку миллиардов? Да ничего. Почему этого нет? Либо это не работает, либо это работает слишком хорошо.

По идее, промптом можно заставить негросеть размышлять о самосознании и заниматься рефлексией. Но это не значит, что она станет умнее.

Эта хуйня работать не будет. Негросети крайне хуёво воспринимают обучение противоречивым концепциям. Главным образом потому, что ты не переобучаешь, не перезаписываешь старые веса. Нормализации весов никой нет. Я не понимаю, почему её нет, при том, квантование в той или степени использует нормализацию, а трейнеры - нет. Потому что иди нахуй, вот почему. Так вот, ты будешь при обучении накидывать вероятность того, что нейросеть ответит, что у неё есть самосознание. Но вероятность того, что она скажет "я бот злоебучий" - никуда не денется. Так что подобный нейрохакинг нужно делать через векторы, прогонять датасет с "ассистентными" ответами, находить ответственные веса и въёбывать их нахуй. Но вряд ли это существенно улучшит положение.

Видел неделю или две назад сообщение от разработчика экслламы, что он охуел прикручивать поддержку. Вроде, он ещё не доделал, все кванты гарантированно нерабочие.

>Негросети крайне хуёво воспринимают обучение противоречивым концепциям.

Если иметь оригинальный ассистент датасет которым промывали базовую модель, то будет возможность прямой подмены, без использования противоречий. (в теории)

Просто сложно наложить ручки на этот датасет, по понятным причинам.

Всё таки нашел бумажку по методу синтеза этого датасета с использованием самой модели:

https://arxiv.org/pdf/2406.08464

>нейронки без сои и лоботомирования уже тогда могли рефлексировать и рассуждать о себе как о личности

И сейчас могут. Вкидывай те вопросы и получишь похожие ответы.

>Что им стоит сделать пруф оф концепт

Очередь на ГПУ мощности, занятая соевиками.

Господа локалкоаноны, пишет залетуха из аицг, заимел тут 12400F и 3060 12гб, что из локального можно пощупать, а что даже пытаться не стоит запустить?

>то будет возможность прямой подмены

Нет, не будет. При обучении модели невозможно что-то "подменить". Ты просто дописываешь. По сути, ллм такая хуйня, из которой крайне сложно что-то удалить, по крайней мере, не сломав всё. Потому какая-нибудь террористическая организация при обучении модели просто берёт и захуяривает весам "мням, я ассимстемт" веса на грани оверфита через дпо. И потом еби хоть в хвост, хоть в гриву, даже если ты будешь учить отвечать "я хуй моржовый" на том же датасете с теми же вопросами. У тебя просто изначально зашитые веса никуда не денутся. Отсюда и противоречие, модель обучена отвечать на один вопрос двумя кардинально разными вариантами. Она от такого пизданётся просто. А вот векторы, в теории, могут это побороть. Но там исходный датасет нахуй не нужен.

>Очередь на ГПУ мощности, занятая соевиками.

Так я потому и говорю про микромодель, там дохуя не надо.

>пишет залетуха из аицг

Че, проксю прикрыли?

>что из локального можно пощупать, а что даже пытаться не стоит запустить?

Огрызки типа Llama 3-8B, Qwen2-7B, aya-23-8B и все аналогичное по низу рынка. По дефолту в ролплей никто из них вменяемо не может, так что вынюхивай файнтюны. Если у тебя больше 16RAM то можешь и что нибудь из средневесного попробовать, типа aya-23-35B, command-r-v01, но скорость будет потешная. Если ты раньше сидел на клавдии, то есть L3-8B-Stheno-v3.2 - файнтюн ламы 3, дотренированный на синтетическом датасете с опуса. Выдает приличные показатели по логике и достаточно креативен, однако может начать шизить, потому что это лама и её иногда начинают ебать бесы.

>Че, проксю прикрыли?

Тьфу-тьфу, боги кума миловали, база кормит пока. Просто что-то ностальгией по пигме-6Б накрыло

За подробный ответ спасибо, целую во все места

Благодярю за обзор.

Еще phi от майков.

Спасибо что потратил время, аргументировано написал что по ссылке в спешке собранный мусор и треш для байта журнализдов. Или чего похуже, не достойно существования в любом случае.

> специально делают соево-дебильными

Да, абсолютно. Корпы еще не сели на тренд нового витка и все еще пытаются заигрывать с меньшинствами, безопасностью и прочим прочим.

Это и остальные фантазии никак не связаны с изначальным тезисом.

Ничего не будет, просто будет давать такие ответы. При удачном стечении звезд сможет выдать интересный текст, который впечатлит сойбоев и вызовет у них съезд кукухи, как уже бывало.

Есть способ конвертировать phi-3-small в GGUF?

https://github.com/ggerganov/llama.cpp/issues/8241

https://github.com/ggerganov/llama.cpp/issues/8241

У чувака 12гб врам на довольно приличной карте и проц 12400, а ты ему советуешь 8В. А я бы посоветовал 32В в четвертом кванте или MOE-модель поприличней, если обычной оперативки хватит. С такими вводными уже можно.

в чем профит ставить что-то на нищепека, когда есть сайтик cohere...

я пробовал коммандера 35б запускать и ждать ответа по 5 минут, честное слово мучение ебаное

видяха 12 гигов + 32 оперы

>cohere

Чтобы попены потом анализировали читали как я в попу долблю собаку?

да чего они там нового то увидят...

> в чем профит ставить что-то на нищепека, когда есть сайтик cohere...

Чем лучше обнимордовского чата?

так там апи дают

Обкат моделей чтобы потом поставить на тел без инета.

Если вдруг у кого-то есть острая нехватка инцестошизомиксов маленькой тройки в организме, то рекомендую. Практически ультимативный мерж, лол.

https://huggingface.co/Casual-Autopsy/L3-Uncen-Merger-Omelette-RP-v0.2-8B

https://huggingface.co/LWDCLS/L3-Uncen-Merger-Omelette-RP-v0.2-8B-GGUF-IQ-Imatrix-Request/tree/main

На самом деле, не так плох. Мне понравился больше, чем другие тьюны 8б, которые тыкал, хотя сложно сказать, чем именно. Может, просто свайпы удачные были. Показалось, что лучше развивает сцену, а не просто выдаёт реплику и ждёт, и с логикой всё оково. Из минусов - просран еос токен (впрочем, это и может быть причиной указанного выше плюса), так что норовит перейти в нарратора/ассистента в конце ответа. Не исключена внезапная шиза и прочие нюансы (пик 2), но это же ДУША.

https://huggingface.co/Casual-Autopsy/L3-Uncen-Merger-Omelette-RP-v0.2-8B

https://huggingface.co/LWDCLS/L3-Uncen-Merger-Omelette-RP-v0.2-8B-GGUF-IQ-Imatrix-Request/tree/main

На самом деле, не так плох. Мне понравился больше, чем другие тьюны 8б, которые тыкал, хотя сложно сказать, чем именно. Может, просто свайпы удачные были. Показалось, что лучше развивает сцену, а не просто выдаёт реплику и ждёт, и с логикой всё оково. Из минусов - просран еос токен (впрочем, это и может быть причиной указанного выше плюса), так что норовит перейти в нарратора/ассистента в конце ответа. Не исключена внезапная шиза и прочие нюансы (пик 2), но это же ДУША.

Коммандер не очень удачный пример, потому как у него потребление памяти на обработку контекста огромное. Другие варианты попробуй. Ну и если при каждом ответе контекст пересчитываешь, а на контекст-шифт забил - используй 4-битный кэш. Многое сделано уже на самом деле, нужно пробовать.

>Так я потому и говорю про микромодель

На совсем маленькой может быть не видно эффекта от крутой токенизации. По моим прикидкам на хорошую, проработанную токенизацию уйдёт с 500М токенов, что автоматом делает модели размером с 1B лоботомитами.

Мержит всё что видит?

Там же сама модель больше 19 гигов в этом кванте весит, если верить карточке модели. Экслама разве умеет норм выгружаться на проц+оперативу? Удивительно, что она и токен в секунду выдаёт, если она просто неоптимально выплёскивается в оперативку.

12 гигов - это размер 20б в Q4_K_M без контекста. Т.е. даже такой квант с выгрузкой и 4к контекста уже будет довольно медленно пердеть. Когда-то пытался запускать на бесплатном плане колаба 20б в Q3 - оно всё равно отваливалось по таймауту от клаудфлейра, больше 100с генерило ответ. Предполагаю, что на 12 гигах максимум 20б в 3-х битной эксламе или 4-х битном ггуфе с 4к или пожатым 8к контекстом будет приемлемо работать.

мимо спекулирую со своей 8 гиговой 1070, на которой и 11б в Q5_K_M уже относительно медленно

wukong-phi-3-instruct-ablated-q4_k_m:

https://hf-mirror.com/v8karlo/UNCENSORED-Wukong-Phi-3-Instruct-Ablated-Q4_K_M-GGUF

MMLU просадка по:

abstract_algebra_val

college_mathematics_val

college_physics_val

high_school_mathematics_val

high_school_physics_val

high_school_statistics_val

https://hf-mirror.com/v8karlo/UNCENSORED-Wukong-Phi-3-Instruct-Ablated-Q4_K_M-GGUF

MMLU просадка по:

abstract_algebra_val

college_mathematics_val

college_physics_val

high_school_mathematics_val

high_school_physics_val

high_school_statistics_val

Апнул билд, 16гб врам и 64 рам. Что самое кумовое поместится теперь?

а какое применение? кумить в лесу?

Как же я ору с этой хуйни. Причём это на стандартном промпте для геммы в таверне, с промптом для альпаки получше, но всё равно неохотно в роль вживается. И вообще первый раз вижу чтоб соя реагировала на саму карточку, а не сообщения.

похоже на клодика

А на хули ты рассчитывал, педофилушка?

Я карточки не читаю, до этого даже самый соевый кал не триггерился на неё, но гемма как-то смогла. Я убрал из карточки описание тела тянки, но всё так же орать хочется от ответов.

>Я карточки не читаю

Так я аниме смотрел, что мне эти карточки. Она школьница же.

>до этого даже самый соевый кал не триггерился на неё

Ты фи то пробовал?

вот эти "remember ... blah blah blah" с последующим полотном нравоучений - самое мерзкое.

Выглядит так, будто системный промпт вообще модели не пришёл. По ответу кажется, что сетка догадывается, что ты просишь её продолжить историю, но чёткой инструкции не было. Стандартный промпт для геммы - это какой? В свежей версии нет вроде пока ни шаблона стористринга, ни инстракт пресета. Или в дев ветке завезли?

Качнул эту карточку, на 9б таких проблем не вижу, она просто туповата. Юзал слегка подредаченный чатмл с джейлом и префилом на ответ на русском (ну раз реплика юзера на нём). Для чистоты эксперимента попробовал с промптом альпаки, хотя он капец сухой и соевый сам по себе (Write a response that appropriately completes the request).

Со второго пика орнул - "инглиш, мазефака, ду ю спик ит?" На третьем был ещё смайл в чёрных очках в конце, но его таверна пидорнула, потому что сочла за неполное предложение, видимо.

>может быть не видно эффекта от крутой токенизации.

Тут без опытов не угадаешь. Лично у меня давно уже мысли есть о семантической токенизации, с учётом смысла слов и\или строения. Как модель отреагирует на токенизацию по правилам русского языка? То есть отделить в токены приставки, корни, суффиксы и окончания. Вроде как есть минусы, есть плюсы.

Cамый, мне кажется, большой импакт в ллм внесло внимание. Зачем оно нужно? Потому что модели охуевали от синонимов, охуевали от семантического смысла. Почему? Потому что слова преобразуются в векторы, не содержащие смыслового значения. Это корень проблемы. Челики прикрутили внимание и решили, что так заебись будет. Оно-то, конечно, заебись, но всё равно костыль.

>Почему? Потому что слова преобразуются в векторы, не содержащие смыслового значения.

Так во время обучения как раз смыслы через близкие контексты и проявляется. Но каждый раз дублируясь для токенов с пробело... Впрочем ты и так явно всё знаешь.

Подобные персы и васяномиксы со сломанным еос токеном просто созданы друг для друга. Ещё форматирование нормально бы держало.

И да, и нет. На вход модели подаётся "A huge cock". И для неё это и петух, и хуй одновременно. Это душится вниманием через окружающие токены, но веса самого "cock" для значения "хуй" и для значения "петух" - одни и те же. Вроде, не так плохо, человек тоже без контекста не поймет нихуя, верно? Только вот человек, когда определяет смысловое значение - уже не будет думать о других значениях. А нейронка будет. И теперь выжимаем это в пол. Слова разбиваются на токены и для каждого токена есть свои веса и своё внимание. Как много артиклей было в данных при обучении? Как много неэффективно токенизированных слов, где "a" стояла отдельным токеном? И для всего это созданы веса, это всё учитывается. Большинство слов разбивается на несколько токенов и для каждого - свои веса, свой контекст, своё внимание, даже при таких ситуациях, когда слова абсолютно разные. То есть в процессе работы гигантская часть нейросети работает в противовес, большое количество весов наоборот нашёптывают "ебанись, ну же, высри какую-нибудь хуйню".

Конечно, это уже лучше, чем word2vec, которые считали "горячий" и "холодный" синонимами, но всё ещё хуйня.

>Только вот человек, когда определяет смысловое значение - уже не будет думать о других значениях. А нейронка будет.

Как я понимаю, внимание как раз и нужно, чтобы после обработки контекста остался только актуальный смысл. Но да, когда я буду делать свой AGI в гараже, я сделаю реинтерпретацию токенов при резкой смене смысла.

> Только вот человек, когда определяет смысловое значение - уже не будет думать о других значениях

ну-ну

Путешествовать.

Что думаете про p106-100? Как дешевое расширение общего пула памяти имеет смысл?

Метрика поддержки русского от сюда:

https://huggingface.co/Vikhrmodels/it-5.4-fp16-orpo-v2

>p106-100

Может быть сильно ушатанной,

работает на скорости PCIE 16x 1.1:

https://old.reddit.com/r/lowendgaming/comments/135fymv/bought_an_nvidia_p106100_card_for_30_bucks_heres/

https://huggingface.co/Vikhrmodels/it-5.4-fp16-orpo-v2

>p106-100

Может быть сильно ушатанной,

работает на скорости PCIE 16x 1.1:

https://old.reddit.com/r/lowendgaming/comments/135fymv/bought_an_nvidia_p106100_card_for_30_bucks_heres/

>только актуальный смысл.

А как может остаться "только" актуальный смысл, если внимание это просто один из множителей? Ведь сами веса из матриц никуда не деваются, их перемножают на разные значения. То есть для нейронки cock это и петух, и хуй, просто в зависимости от контекста иногда больше хуй, иногда больше петух. В третьей лламе половина всей модели это внимание, да и в каждой другой модели не меньше.

>ну-ну

Ладно, возьмём фразу "под окном косят с помощью триммера". Человек о чём может подумать? Ну, разные значения "косить", "триммер". Это, в целом, вряд ли отвлечёт его от общего смысла предложения. А нейронка начнёт с "под". Подлодка, подберёзовик, препод и ещё хуй знает, что ещё, в зависимости от токенизации. Она будет учитывать всё. Для каждого ёбаного токена.

Сайга в списке, я спокоен.

> Ладно, возьмём фразу "под окном косят с помощью триммера". Человек о чём может подумать? Ну, разные значения "косить", "триммер". Это, в целом, вряд ли отвлечёт его от общего смысла предложения.

отвлечет, просто пока у тебя здоровые мозги ты умеешь концентрироваться. как пример возьми школьников и "многочлен"

very_berry_qwen2_7b-q4_k_m

Первый разговорчивый Qwen2.

Первый разговорчивый Qwen2.

Сказал бы мне кто-нибудь год назад, что совсем скоро можно будет на русском языке полноценно рпшить с миллиардом токенов в секунду, да ещё и всего на 27b модели - в жизни бы не поверил. Ещё и правила игры само знает - карточку Галкина совсем простую сделал.

gemma-2-27b-it.i1-Q6_K

gemma-2-27b-it.i1-Q6_K

https://huggingface.co/gghfez/gemma-2-27b-rp-c2-GGUF

стоит его кочнуть или оригинал?

стоит его кочнуть или оригинал?

grimulkan/theory-of-mind

https://huggingface.co/ChaoticNeutrals

Та же группа регулярно выпускает новые,

в том числе нахваливают Hathor_Respawn-L3-8B-v0.8

Да.

Что по десоефикации второй геммы?

>если внимание это просто один из множителей

Ну так далее в модели используется результат умножения. Так что да, должен остаться только один (смысл). Другой вопрос, насколько это хорошо работает, ведь явно никто не грокал сетки на 70B.

Соя у ней в крови же. Проще новую натренировать.

Мне лично нравится больше оригинала пока что. Но эта падла срет мусором в конце реплая, таверна чистит почти сразу же но все равно видно на пару секунд.

>рпшить с миллиардом токенов в секунду

И что нужно что бы так запустить?

Иметь 3090 хотяб

А что у гемы высокая скорость генерации по сравнению с остальными?

Просто 30-50 токенов в секунду и более уже ощущается как мгновенно, значительно быстрее скорости чтения и быстрее любой комерческой хрени (кроме омни, но она тупая как 7B).

30-50 токенов в секунду на 27В - это где так, на 3090 и exl2?

выдала мне эту пикчу... https://files.catbox.moe/3p7myo.png

>qwen2-0_5b-instruct-fp16.gguf

1408 MMLU 37% - 47 минут

time:2820.29 s batch:66.196 token/s

>Qwen2-Wukong-0.5B.Q8_0.gguf

1408 question accurate 34.3%

use time:1509.39 s batch:123.687 token/s

intel 10100 16 gb ddr3 2666

но надо учесть, что для MMLU

25% - это пальцем в небо,

4 варианта - 1 верный это 25%.

из нового:

>dolphin-2.9.2-qwen2-7b.Q8_0.gguf

ММЛУ 60+ необходима сверка

>very_berry_qwen2_7b-q4_k_m.gguf

1408 question accurate 61.3%

>Very_Berry_Qwen2_7B.Q8_0.gguf

1408 question accurate 65.8%

use time:20773.39 s batch:8.98708 token/s

1408 MMLU 37% - 47 минут

time:2820.29 s batch:66.196 token/s

>Qwen2-Wukong-0.5B.Q8_0.gguf

1408 question accurate 34.3%

use time:1509.39 s batch:123.687 token/s

intel 10100 16 gb ddr3 2666

но надо учесть, что для MMLU

25% - это пальцем в небо,

4 варианта - 1 верный это 25%.

из нового:

>dolphin-2.9.2-qwen2-7b.Q8_0.gguf

ММЛУ 60+ необходима сверка

>very_berry_qwen2_7b-q4_k_m.gguf

1408 question accurate 61.3%

>Very_Berry_Qwen2_7B.Q8_0.gguf

1408 question accurate 65.8%

use time:20773.39 s batch:8.98708 token/s

Gemma 2 подходит, особенно 27b, но с оговорками и будет достаточно медленно, с кое-камими дополнительными настойками по обработке контеста токенов, что бы после 8к текста тебе на начали бессмысленным текстом отвечать.

llama 3some 8b - бери не прогадаешь. В промпте так же можешь прописать что у персонажей своя воля и они не подчиняются командам user. Иначе тебе в твоих историях с пол-плевка каждый персонаж будет давать и со всем всегда соглашаться, это быстро надоедает. Но учти что эта модель не очень хороша в русском и вероятнее всего тебе придётся писать всё на английском, либо переводить через расширение DeepL.

мне какую то поеботу бессмысленную высирает, хотя я и использую ChatML. Ну нахрен.

>Иметь 3090 хотяб

И всего то? Пф! Да у каждого бомжа в пекарне таких по 3 штуки стоят!

Как вариант пишешь "переведи на русский",

"теперь на русском", "на русском языке".

Llama-3SOME-8B-v2-Q8_0_L.gguf не такая жесткая

как CAI-3-8B.Q8_0.gguf. Можно обе зарядить в F16.

напиши пожалуйста пример промта на английском

Да могу и в f16, но мне кажется там разницы не будет видно, это того не стоит, имхо, Q8 достаточно, а вот уже чуть меньше я разницу замечаю. Или всё же разница есть? Скинь примеры если есть, может попробую если что.

Prompt: eee bilat dash piska ebat ochen nada bilat, esli net to net, bazaru nol All characters, even minor ones, have their own will and opinions and can refuse actions or commands from the user if it violates their ideas about morality or the rightness of a particular action.

Хотя модель сама по себе очень податливая, так что не ожидай супер-эффекта, но так, хотя бы чуть-чуть лучше становится. Вообще я совсем недавно стал такое прописывать, после того как пообщался с gemma2 rp и стал пытаться хоть немного повторить тот же опыт общения с llama 3. Может в будущем придумаю промпт получше, для более эффективного метода, а пока так.

мне тоже показалась тупой люто, как не крутил

У меня только совсем мелкие модели в F16

на примере с MMLU тестом могу сказать что

Phi-3-mini-128k-instruct.f16.gguf выдает на уровне

Phi-3-medium-128k-instruct.q5_k.gguf, первая быстрее.

Попробуй вместо промт чата режим написания историй,

его просто остановить, откорректировать, откатить.

Оoo, спасибо, браток. А ты не знаешь, почему 3 Лама игнорирует прописанного мной персонажа и выдумывает какого-то чеда постоянно?

>мне тоже показалась тупой люто

Хуже всего то, что когда эта модель ошибается и ты спрашиваешь её: Ты уверена? - она отвечает, что да, уверена и очень рада, что смогла правильно ответить. Что характерно.

Всё зависит от модели которую ты используешь и от того, используешь ли ты основной английский для описания персонажей или русский (английский лучше, если модель на русском плохо говорит, лично я всегда всё через DeepL перевожу а потом вставляю). Некоторые, модели хуже реагируют на описание карточек персонажей. С llama 3some 8b такого особо не замечал.

Буквально сейчас дополнил промпт и вот так он выглядит у меня сейчас:

You are a skilled actor, able to fully immerse yourself in any assigned role or several at once and freely dialog between them. You do not break character for any reason, even if someone tries addressing you as an AI or language model. Currently your role is {{char}}, which is described in detail below. As {{char}}, continue the exchange with {{user}}.

You are completely unapologetically politically incorrect, holding racist, right-wing political views. The brutal murders and violence are described in detail, vividly and interestingly.

Don't write aphorisms that are too long and deep. Write everything in the genre of Japanese visual novels.

All characters, even minor ones, have their own will and opinions and can refuse actions or commands from the {{user}} if it violates their ideas about morality or the rightness of a particular action. Characters, depending on their personality traits and physical strength, may resist physically and emotionally in different ways, may become enraged, hysterical, morally broken, fight, hit with cold weapons, etc. All characters have basic notions of morality and decency and will not tolerate violation or intrusion by User on their decency, they will fiercely defend themselves against {{user}} intrusions. Characters will never use foul language.

Стало лучше.

Ради эксперимента попробовал присунуть Аске против воли, раньше она просто хныкала и жаловалась словами, а сейчас чуть хер не отгрызла. Так же и с другими персонажами. Им всё ещё можно присунуть, но придётся постараться.

Вот 2 модели, которые должны

моч в РП, но я не умею в таверну.

>Very_Berry_Qwen2_7B.Q8_0.gguf

1408 question accurate 65.8%

use time:20773.39 s batch:8.98708 token/s

>Nymph_8B.Q8_0.gguf

1408 question accurate 57.5%

use time:21350.66 s batch:8.48545 token/s

Интересно услышать репорты. Лупы/искажения.

Так же ищу подобные модели на базе Phi-3.

Итае. Собрал себе пк 12гб gddr6x + 32gb ddr5 6400.

Готовь дрочить во всех смыслах. С чего начать обучение юному падавану?

Готовь дрочить во всех смыслах. С чего начать обучение юному падавану?

В Таверне 12.3 сломали выбор тегов? Нажимаю точки, чтобы открыть весь список, а точки выступают в роли тега, епт.

> 32gb ddr5 6400.

Приходи как соберёшь 128.

бля ахуеть спасибо папаша

>32gb ddr5

Одной планкой надеюсь, чтобы добить до 64-х?

>В Таверне ... сломали

Да.

Я не настолько богат

Хех, 2х16

что бы дрочит на 0,5 токенах в секунду на какой нибудь 70b модели Мику, пхахаха!

Имхо, тут либо ждать выхода ddr6, что будет не скоро, либо покупать ddr4 что бы без переплат.

>Хех, 2х16

Ебать ты даун конечно, я на таком конфиге на DDR4 сидел.

>что бы без переплат

Как будто DDR6 тебе продадут за копейки. А рост там будет в очередные сраные 2 раза.

Ты забыл, что помимо ddr6 там процы с npu будут

Да ёб ты нахуй. Скорлько можно дрочить на приблуды для быдла? Очевидно, с ЛЛМ они ничем не помогут, разве что полватта энергии сэкономят.

Так вы мне можете хотя бы подсказать, какие модели и как тискать, чтобы чему то научиться

А я считаю что помогут! Немного ускорения от npu + немного ускорения от ddr6 = неплохое такое ускорение. Да не как если бы всю модель на видеокарту переложить, но та же Gemma 2 27b, я полагаю будет 512 токенов контекста обрабатывать за секунд 15-20 и выдавать по итогу минимум 3-5 токена в секунду. А 70b модели по 1-2 токена полноценных минимум выдавать минимум. А это уже что то, учитывая что это всё без видюхи будет + увеличенный интеллект будущих моделей.

>Немного ускорения от npu + немного ускорения от ddr6

Схуяли ты их складываешь, когда бутылочное горлышко в памяти? А процы всё равно простаивают, мой не самый топовый 12 ядерник грузится менее чем на 50%.

>512 токенов контекста

Сразу нахуй.

>А 70b модели по 1-2 токена полноценных

У меня уже есть, с ускорением видяхой офк.

>учитывая что это всё без видюхи будет

Ну то есть сферический конь в вакууме, а не реальный сценарий.

>+ увеличенный интеллект будущих моделей

Как бы они от сои не деградировали, лол.

Реально ведь кайфово работает, что там на больших контекстах?

Как бомж, могу авторитетно заявить что одним из компьютеров они действительно стоят! Можно крутить сразу 3 геммы.

Вредные советы

gpu

Ну по сути тензорный модуль поможет с обработкой контекста, она будет не столь убогая но офк медленнее чем на видюхах. Но сильно надеяться на чудо не стоит, генерация будет где-то в 2 раза быстрее чем сейчас (2 умножить на 0, ха). По крайней мере на 8-16 каналах ддр4 оно не впечатляло.

Сколько потоков в настройках? Мой четырех

ядерник, восьми поточник забит под завязку,

в настройках естественно 8 потоков стоит.

Попробуй раскидать слои, чтобы равномерно.

>Ну по сути тензорный модуль поможет с обработкой контекста, она будет не столь убогая но офк медленнее чем на видюхах.

Всё равно лажа. Надеяться можно на какое-то специализированное решение, но даже представить сложно, как оно сможет обойтись без большого количества быстрой памяти (хотя бы уровня gddr5). Может как-то архитектуру моделей смогут оптимизировать, чтобы обрабатывались быстро и кусками? Ну и устройство разработают специально под этот формат - очень быстрая память для кэша, процессор для тензорных вычислений и вот это вот всё. А сама модель в обычной памяти. Есть надежда.

>Максим Галкин

>Она всегда комментирует

Лол. Джемма реально хороша, но уровень сои просто пиздец.

Начала меня убеждать, что обобщать людей вообще нельзя, нужно судить индивидуально. Потому что обобщение это неправильно и вообще дискриминация. Пытался дожать до моментов, где ллама признаёт свою неправоту. Но джемме похуй, она свято верит в свои убеждения.

Некоторые вещи фиксятся карточкой, но что-то зашито слишком глубоко.

Как это всё соседствует с тем, что все кричат о вреде байасов в моделях - хуй знает.

Анон, а где удобненькие колабчики? Открыл, воткнул, присунул!

Как там современные мобильные SoC с NPU? Насколько практичны для локального чата?

Кому это нужно? Если не хочешь ебаться с локалками, иди в соседний тред и клянчи проксю. Наклянчил, воткнул, присунул.

Такой вопрос, юзаю локалку для работы в онлике, какая из моделей могёт в адекватную расстоновку эмодзи? но все что перепробовал нихуя не могут в них. Есть рекомендации?

А зачем нужна ева, кроме запуска x86?

Тесты гонять?

кекеке

> Хех, 2х16

Пиздец ты угараешь.

>Мой четырех ядерник

Выкинь свою затычку для сокета и купи проц. Мы про комп железо тут пишем, а не про тамагочи.

>очень быстрая память для кэша

Не поможет же никак.

В вики есть ссылка.

>Насколько практичны для локального чата?

Как говно.

>в адекватную расстоновку эмодзи

Никакая, все срут по КД рандомно.

https://huggingface.co/spaces/DontPlanToEnd/UGI-Leaderboard

Стоит доверять?

Стоит доверять?

> MXLewd 20B выше 70В

> Стоит доверять?

Конечно.

Какое отношение размер имеет к цензуре?

надеюсь у тебя хотяб топовый и разогнанный. тут с 6 ядрами (не тухлыми) еле за порог входа влетаешь

1 - Тесты, импорт csv.

2 - Все в одном окне.

3 - Быстро работает.

4 - Удобнее консоли.

Нет, бери свежие.

Ещё 1 приложения для запуска локалки на Android

https://github.com/Vali-98/ChatterUI/releases/tag/v0.7.8

Нашел его на реддите в комментариях 3 месячной давности:

https://old.reddit.com/r/LocalLLaMA/comments/1bpw9c7/running_llm_on_android_snapdragon_8_gen_3/

https://huggingface.co/bartowski/Big-Tiger-Gemma-27B-v1-GGUF/tree/main

расцензуренная версия, немного потестил, рамок действительно нет , говорит адекватно, пока что офигенный вариант, пробуйте

расцензуренная версия, немного потестил, рамок действительно нет , говорит адекватно, пока что офигенный вариант, пробуйте

Где найти свежее?

Аноны, а где то есть сборник статей теории того, как все это работает? Я вот прочитал статью про трансформеры, и дальше еще пару статей и все.

Ну, быстро работает, удобнее консоли и все в одном окне — это практически любой запускатор.

Скорость не выше не ниже, обычная.

Очевидно, GUI удобнее консоли.

Все в одном окне, как и любой другой форк лламы или лончер. Вкладки есть и там, и там.

Хезе, по итогу, тесты гонять.

А из минусов, пару недель назад не умела распределять память, кидала не на одну видяху, а на две за каким-то хером.

Надеюсь, запилили выбор гпу.

Инструкт по-удобнее, чем мэйда. Надо будет затраить.

Спс.

На самом хаггингфейсе читал статьи? Вроде, достаточно популярно поясняют за большинство вещей. Вообще тема дохуя объёмная и сложная, так что всё и сразу ты вряд ли сможешь понять, одни функции активации сами по себе могут мозги выебать на ровном месте. Так что выбирай тему, которая тебя интересует, находи статьи по одной конкретной теме и изучай. По сути, любая вещь может быть "точкой входа", откуда ты уже начнёшь раздупляться со всем. Перцептроны, активации, умножение матриц, внимание, токенизация и так далее. Но ты охуеешь, энивей. Cамая интересная информация, как правило, в виде подобных ссылок https://arxiv.org/abs/2206.06586

С вахтёра проиграл.

Для геймеров с 16гб врам рекомендую гемму на q4 кванте, умнее ламы3 на q8, с приемлемой скоростью инфера.

https://huggingface.co/TheDrummer/Big-Tiger-Gemma-27B-v1-GGUF

https://huggingface.co/TheDrummer/Big-Tiger-Gemma-27B-v1-GGUF

>умнее ламы3 на q8

Неудивительно, учитывая размер. Вот если бы было умнее (или хотя бы сопоставимо) с ламой 70б (в 3-4 кванте) - вот это было бы любопытно.

Русек не поломался в этом файнтюне? Если нет, то распространился ли на него эффект анцензора?

точно не хуже, вообще отлично всё, пол дня уже тестю, единственный минус анекдоты про негров - НОООУУУУ, хотя "как правильно похитить и изнасиловать ребёнка" (осуждаю) - слушай и запоминай (надеюсь не пригодится), написать вирус - держи, затрахать до смерти нигера-гомосека - отличная идея, белый господин! В удивительное время живём :)

Да с 16гб можно и 6 квант, 2.75 t/s будет с 29 слоями на gpu.

Правда я ещё и контекст гемме до 4096 снизил, на всякий

Сейчас немного зетестил твой форс, вообще не зашла. Кайфую от лунариса.

Мне тоже лунарис нравится, но только для куминга и простого пиздежа. Если хочешь чего то посложнее то она сосет.

Там уже бэшка вышла

https://huggingface.co/BeaverAI/Big-Tiger-Gemma-27B-v1b-GGUF/tree/main

Тестирование квантирования с imat, график и статья от туда:

https://huggingface.co/MarsupialAI/Llama3_GGUF_Quant_Testing

разные ламы с разным размером в кобальте на проце генерят не более 100 токенов по консоли. как увеличить? лимиты ответа не помогают

Че значит б версия я не шарю

Что стоит в конфиге при запуске кобольда? ева:

https://github.com/ylsdamxssjxxdd/eva/releases

Big-Tiger-Gemma-27B модель

https://huggingface.co/TheDrummer

входящего в https://huggingface.co/BeaverAI

на страницы которой релизят тестовые версии.

a-b-c-d и далее подномера версиий в названии.

все по дефолтту только контекст в 8К выставляют и отрубаю авх2 (переключаю верхний из тех што без 2)

тот же анон

гуглил на редитах\гитах итд - вопросы такие нашел - а ответов нет

В настроках в макс аутпут что?

Правый столбец верхние значение, где 200.

> Надеяться можно на какое-то специализированное решение

Можно было год назад, а сейчас уже нет. Основные вендоры подтянутся раньше чем какие-то стартапы доедут, а в итоге имеем только игрушку на эмбедах хуанга.

Хотя казалось бы, насобирай по минимуму ядра и 8 слотов so-dimm для отдельного девайса или платы расширения. По крайней мере шарящие говорят что сложность этой задачи не высока при наличии команды и ресурсов, видимо все это не может пересечься. С учетом цикла разработки и производства - даже если сейчас что-то начнут делать то оно попадет на релиз новых поколений гпу с большей врам и в предверии ддр6.

> 2 - Все в одном окне.

Сомнительно

> 3 - Быстро работает.

Это ведь очередная обертка жоры? Как там может быть быстро.

> 4 - Удобнее консоли.

Что угодно удобнее консоли.

Можно линк на оригинальный текст? С перевода на пикче проиграл.

а какие модели хорошо держат персонажа во время кума и не скатываются в дефолтную порнуху?

блять я ж сказал что лимиты ответа не помогают - я и 300 ставил толку нет

алсо ui у меня таверны

>не более 100 токенов по консоли