На 4 пике Жора копает могилу своему говнокоду?

>Один ты тут триггеришься

>ррряяя я не рвусь эта ты врьёшься!!111

А в сарказм ты не умеешь Хочу 4090 с такой мотнёй, но чтобы можно было заменить на нормальные 3х8, а не ту горелую 12 пиновую парашу. 4090 вообще с нормальным разъёмом есть?.

То, что родилось мёртвым, в закапывании не нуждается.

Эх, а всего лишь 8 месяцев назад тесла стоила 17к...

Назовите ваш ТОП 3 моделей до 20B для (E)RP.

Не понял почему так модно жору обсирать, разве он не ёбаная мессия которая преподносит и делает более доступным новейшие технологии в массы7??? А??

> в сарказм ты не умеешь

Извини, факт

>с нормальным разъёмом есть

Дефайн нормаальный. Нафиг этот соплестрой с куче 6+2 тебе потом 600Вт в 5090 по нему заливать ещё. Просто взять нормальный широкий корпус один раз и вообще в ус не дуть. Главное же, чтобы стенка не гнула разъём. А если от стенки до кабеля ещё пара см, то ничего плохого не случится.

>всего лишь 8 месяцев назад тесла стоила 17к

Я по весне успел отхватить P40 за 15к на Авито, как-то удачно подвернулось.

В прошлом треде постили ссылку на продавана AliExpress, где было за 24к (хотя бы!). Сейчас, наверное, проще взять б/у RTX 3090 за чуть большую сумму.

Конечно, он - бог мирового масштаба. Хейтеры в большинстве своём ни строчки серьёзного кода в своей жизни не написали.

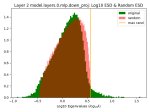

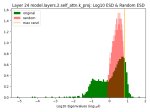

>в третьей лламе недообучены все слои, кроме слоёв cелфатеншона

Лол, и это 15Т токенов датасетов.

>сравнивают их с RNN сетями, мол, только там мы добрались до потолка

А какие там максимальные размеры у рекуренток?

Имиджборды, сэр.

>Нафиг этот соплестрой с куче 6+2

Оно хотя бы не горело, и в нём не уменьшали площади контакта хуй знает с какой целью.

А так самый нормальный это CPU который, 8 рабочих контактов, 200 ватт мощности, и 2 штуки максимум на видяху, ибо ебал я современные кековатные калориферы.

>Просто взять нормальный широкий корпус

У меня с корпусом всё нормально. И блок питания титановый. Но блядь без этих новомодных уёбищных разъёмов, ага.

>продавана AliExpress, где было за 24к

Там такой мутный продавец, что проще сразу деньги сжечь.

Должно что-то новое появиться. С АМД-картами совсем всё глухо? Я слышал про vulkan как неплохую альтернативу CUDA хотя бы для инференса. Не уверен конечно.

Я наверное как всегда опаздал, но всё

https://www.youtube.com/watch?v=t3SBDEKkQf4

Лама 3.1, 405b в опенсурсе.

Но что больше интересно для форума 3.1 8b резко улучшила все характеристики и... 128к токенов из коробки. УРАААА

Сегодня на моей улице праздник

https://www.youtube.com/watch?v=t3SBDEKkQf4

Лама 3.1, 405b в опенсурсе.

Но что больше интересно для форума 3.1 8b резко улучшила все характеристики и... 128к токенов из коробки. УРАААА

Сегодня на моей улице праздник

Давай ещё каждые 10 постов это писать будешь.

ВСЕ СОСАТ!

Джина обратно не затолкать

Джина обратно не затолкать

Да, тред перекачен а я ленивое жЫвотное, что бы читать прошлый. Не был там.

>Должно что-то новое появиться

Кому должно? По сюжету прописано что ли?

>3.1 8b резко улучшила все характеристики

А 70-ку выкатили?

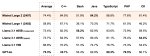

>MMLU на уровне, MMLU Pro отсос

Вангую просто загрязнение данных, 405B втупую может выучить все тесты не напрягаясь.

Ты че ебанутый мы еще слитую модель вчера обсуждали

а где ты возьмешь разнообразие то у самой модели, если в датасете просто его нет для кума и рп? я этот момент не понимаю совершенно

Big-tiger-gemma-27b расцензурена, говорили они...

>А 70-ку выкатили?

Да

Кто в итоге лучше? Большая Тигра Гемма 27 или ллама 3.1 8? И то и то если брать восьмой квант

гемма выдает текст который не противно читать...

> Сходил бы к врачу

Ты сходи к врачу, обосранец. На вопрос как это относится к предмету обсуждения - перекаты, когда тебя опять возвращаешь к предмету - вот эта шиза. Мамкин маневратор, чего только не придумает чтобы не отвечать и свернуть с неудобной темы.

> третья ллама должна развёртываться исключительно совместно с тремя соефикаторами

Это же замечательно, значит в стоке сои минимум.

Всем лень. Отдельные люди занимались но делали субъективные/ошибочные/специфичные чарты и оценки, типа

> плотности хорни-слов

, оценки "iq" по какой-то припезднутой карточке, тесты немецкого, попытки в рп без семплинга и подобное.

Это множится на большое количество выходящего треша в 90% случаев поломанного и мало отличающегося между собой, что заведомо заставит ставить все это на поток в попытке угнаться за актуальностью.

Так что можешь сам попробовать заняться

> >пиздёж за юзера, для инструкт-моделей

Это проблемы рук юзера, который не может настроить промт формат, или совсем ушатанная модель.

Он большой молодец и сложно с этим спорить. Но частенько косячит.

>Лол, и это 15Т токенов датасетов.

Опять же, это может быть ошибочным выводом. Я же не специалист уровня парней из меты. Даже если это так, то тут сложная ситуация - некоторые слои обучены, некоторые - недостаточно. Морозить часть и обучать остальное? А будет ли профит? Насколько близко модель к оверфиту мне было уже лень смотреть, как-нибудь доберусь.

>А какие там максимальные размеры у рекуренток?

Они хуёво параллелились, вряд ли было что-то сильно больше 10b. Не так давно был мутант rnn с трансформерами, 14b, авторы говорили, что это самая большая rnn, которая была натренирована за всё время.

>Кто в итоге лучше

В каком бля итоге, даже дня не прошло с релиза

Ниоткуда, это способ подтяжки модели по тем моментам в которым она плавает, а не преодоления элайнмента. Для этого тебе надо её учить плохим словам сначала, на сыром датасете.

> Только вроде кажется что всё норм и тут же модель начинает повторять в каждом сообщении фразы.

Платиновый вопрос ггуф ли это?

> случайно найденый сетап с какой-то из mlewd

Там, как правило, с альпакой-ролплей катали.

> работающим пресетом и моделью до 35b

Коммандер и пресет коммандера, внезапно. Гемма и пресет геммы, или модифицированный инстракт с жб из прошлого-позапрошлого треда.

> речь-то про домашние запуски

Так это из дома, берешь и запускаешь, в чем проблема?

> что там у тебя дома 2-3 токена на 100 гигах выдает

Могу устроить абсолютное мужское слияние на 144гб врам

Это самое беспроблемное что в ней есть. Однорядные малонагруженные разъемы, ерунда. То ли дело всратый охлад врам, которая в стоке перегревается, запараллеленные фазы с неудачными элементами и прочее.

Он ебаная мессия, но в то же время кривохуй который постоянно косячит. Такая вот многогранная личность.

> 128к токенов из коробки

Круто ведь. Надо только потестировать насколько оно адекватно будет обрабатывать хотябы простое извлечение факта.

>Это проблемы рук юзера, который не может настроить промт формат

Нет, это следствие

- тренировки на неправильном формате ролеплея

- внутриконтекстного обучения. Случайно попадёт пиздёж за юзера в ответ - и эта хуйня начнёт повторять.

Все РП модели пиздят за юзера в той или иной степени, это отбивается именно специфической тренировкой

>чего только не придумает чтобы не отвечать

Я могу повторить твой манёр и сказать - пиздуй ищи ответы сам, там где-то были, толи в дискорде, толи в телеге. Мне уже лень доказывать что-то человеку, который не понимает элементарных вещей.

>как это относится к предмету обсуждения

Действительно, как же относится замена в формуле ранга на корень из ранга, когда мы обсуждаем соотношение ранга к альфе?

Ну типа да, это и вкладывал в ушатанную модель. С выходом 3й лламы приличных тюнов что были бы адекватны совсем единицы, увы. Базовые модели хороши, с ними можно вполне взаимодействовать и таким не страдают.

> пиздят за юзера в той или иной степени

Скорее отыгрывают молчаливое согласие или иногда продвигаются дальше чем нужно, если речь про нормальную. Например, прочишь чара сделать тебе завтра или кофе, оно может написать от

> вот чар идет на кухню и приступает в нарезке овощей ...

до

> хуяк хуяк вот крутой аромат доносится с кухни и уже тебе принесли блюда которые ты начинаешь кушать

Первое может показаться слишком медлительным и безинициативным, второе наоборот, это вкусовщина, проявляется и на коммерции. Потому, если знаешь что хочешь совершить какое-то действие - или свайпаешь пока не получишь нужное, или пишешь

> шепчет на ухо "Тогда иди закрой дверь на замок" следует за ней (ooc: остановись на моменте когда она закроет дверь).

Вот теперь давай объясняй, каким образом эта выдернутая строка относится к тому что нужно ставить альфу х2 от ранга и к тому что ее вообще нужно как-то привязывать к рангу, а не ставить константой. Предвосхищая очередные маневры - это лишь опциональный флаг и задуман для другого, потому и зависимость не линейная, про которую ты пытаешься имплаить, а корень.

Давай, просто объясни это, чтобы мы опять полюбовались твоей повальной беграмотностью.

>3-х битный квант

>таверна с русеком

Это просто ты необучаемый.

>Морозить часть и обучать остальное?

Проблема в градиентном спуске, он просто даёт слишком малые коэфициенты коррекции к дальним от входа слоям. Тут разве что обучать модель с меньшим числом слоёв, а потом бахать сверху ещё пачку.

>Не так давно был мутант rnn с трансформерами, 14b

Случайно не RWKV? Я её даже запускал, лол.

Проснись, сингулярность, ллама 3.1 уже устарела, ведь вышел фанатский тюн от васяна.

>к дальним от входа слоям

От выхода конечно, вот я долбоёб.

быстрофикс

> Это просто ты необучаемый.

Забыл еще полностью отключенную отсечку в семплерах

> он просто даёт слишком малые коэфициенты коррекции к дальним от входа слоям

Наоборот типа, но оно не особо существенно же. И послойный/поблочный множитель для этого добавляли, вроде даже в тред скидывал статью.

> от васяна

От рем_х_левд_хорнирп_товрожок

>И послойный/поблочный множитель для этого добавляли, вроде даже в тред скидывал статью.

Прям добавили, или очередной препринт без внедрения в сетки? А то если разом все препринты добавить, то тут сразу AGI появится нахой.

А хочется именно разнообразия, чтобы все не скатывалось к самым банальным тропам из всех возможных. может не сразу грандиозное, а например буст к отыгрышу конкретного архетипа или сеттинга

Интересно, а то я, по нейрал-тюнам, считал, что синтетика — это когда данные сгенерены другой моделью. И по качеству нейрал-тюнов синтетика выглядела максимально убого. НейралГермес был максимально скучной моделью.

А оно вон оно шо оказывается…

Ну если ты не способен воспринять очевидный рофл — это твои проблемы, чел. =) Реально ж, один ты рвешься, причем хуй пойми с чего, тупо с шутки.

Ты предупреждай, что тупой, я не буду в следующий раз шутить, чтобы не обидеть.

Он не выполняет хотелок хейтеров, очевидно.

И железо у него не то, и подход не верный, и пишет плохо, всем плох!.. =)

> проще сразу деньги сжечь

Ну, Алик, если шо деньги бы вернули, не?

Давно не покупал, а когда покупал — проблем с возвратом было в разы меньше, чем с нынешними озонами и яндексами.

Но есть две проблемы.

1. Ты не запустишь это у себя.

2. Если запускать на проф.железе, то выйдет дороже.

…

> Я же не специалист уровня парней из меты.

Судя по апдейту лламы-3 — даже парни из меты не специалисты уровня парней из меты… =)

———

128к контекста, конечно, круто.

Но, во-первых, как писали выше, хрен его знает, настоящие ли они.

Во-вторых, ллама 3.0 была заметно сломана (давеча гонял модели — и на трансформерах и эксл2 она так же тупит с ssistant и формативрованием из-за кривого обучения на двух еос-токенах, один из которых типа пад, короче, обосрались они там в оригинале), и насколько работоспособна 3.1 — пока не ясно. может и там косяки.

В-третьих, использование с тремя софикаторами тоже… Не доказательство, что внутри минимум сои, к сожалению.

Так что, радоваться раньше времени не стоит.

Пусть это все нормально заведется, а уж там и посмотрим. =)

Надеюсь утром поимеем рабочие кванты, а может и аблитерацию подвезут.

> она так же тупит с ssistant и формативрованием

Чел, достаточно просто выключить пропуск системных токенов. Никаких проблем нет с этим, если используешь как в оригинале. Уже столько времени прошло, а до сих пор кто-то не умеет пользоваться ламой.

>Ты предупреждай, что тупой

Я забываю, яж тупой.

>Ну, Алик, если шо деньги бы вернули, не?

Мечтай.

> или очередной препринт

This, было уже относительно давно, там был показан возможный эффект и простая реализация. Но воспринят был холодно, хз вводили ли, тут даже про то как тренируется самая открытая ллм не рассказывают особо.

> если разом все препринты добавить, то тут сразу AGI появится нахой

Содомит

> хочется именно разнообразия

logits bias еще оче давно для этого придумали, и в локалках, и у корпоратов.

> буст к отыгрышу конкретного архетипа или сеттинга

Промт, можно завуалировано.

> не выполняет хотелок хейтеров

Ага, кляты хейтеры на регэкспы бузят тут!

> железо у него не то

У него как раз то, на маке не жалуются. А может просто хавают что есть ибо привыкли.

> ллама 3.0 была заметно сломана

Был мелкий косяк с конфигом, все. А так она явила косяки в лаунчерах и подорвала пердаки жора-зависимых.

> эксл2 она так же тупит с ssistant

Только с неверными конфигами, это быстро пофиксили. Хз про что ты говоришь, проблемы первой недели быстро исправили и оно работает интересно.

Ты че падла к многоточиям теперь эмотиконы ставишь

> logits bias еще оче давно для этого придумали, и в локалках, и у корпоратов.

и что это за разнообразие, больше слова пук, меньше среньк?

> Промт, можно завуалировано.

про промпты вот не слышал, спасибо, обычно просто с ассистентом рпшу

Все несколько наоборот. =)

Поверь, как раз я знаю о чем говорю.

Я же написал > в оригинале

Пофиксить-то можно, я этим и занимаюсь, но только факт в том, что они обосрались. Если для работы ты должен применять модель не так, как тебе предлагают авторы — значит авторы предлагают тебе херню, согласен? )

Ну ты читай внимательней, пожалуйста.

Ну, в таком случае и правда не стоит рисковать с мутными продавцами.

> Был мелкий косяк с конфигом, все

Ну как «был». =) Модель никто не поправлял, она обучена косячить.

Повторю мысль выше — то, что мы это можем починить костылем пост-фактум не делает модель хорошей в моменте обучения. Причинно-следственные связи, действия в будущем не влияют на прошлое, вся хуйня.

Проверить просто — берешь и качаешь голую модель. И не применяя фиксы пробуешь юзать.

Хоба — шиза и ассистенты.

Ясен пень, что при квантовании я чиню конфиги, и заливаю уже чиненную модель.

Но это следствие, а причина — проеб разрабов.

Именно поэтому я допускаю, что они могут и в этот раз что-то сделать не так. Всякое бывает же. Поюзаем — увидим.

Всякие там йобавстройки не лучше проца генерацию тянут? Или похуй все равно упор в скорость памяти?

В смысле «теперь».

Я это делаю 60 тредов уже.

Любишь с холодной секретаршой?

🟩🟩🟩🟩🟩🟩🟩🟩🟩🟩🟩

🟩 И что ты мне сделаешь? 🟩

🟩🟩🟩🟩🟩🟩🟩🟩🟩🟩🟩

> я знаю о чем говорю

Очевидно что не знаешь, ведь в оригинальном конфиге выключен пропуск токенов. Но ты зачем-то напердолил его и теперь жалуешься что модель сломана. 3.1 будет точно так же "сломана", ведь там нечего фиксить.

> Любишь с холодной секретаршой?

от извиняющегося за все соевичка просто колом стоит

Ты, кажется, уже сам совсем запутался.

1. Качаешь оригинальную модель.

2. Ничего не меняешь.

3. Запускаешь ее.

4. Срет ассистентами и шизой.

5. Фиксишь конфиги.

6. Работает без проблем.

Проверено на:

трансформерах

эксл2

ггуф

Везде одна хуйня.

Я хз, почему ты утверждаешь, что ошибки при оригинальных конфигах это «работает нормально», а отсутствие проблем с исправленными это «сломал». =)

Ну хуй тя знает, видимо ты и есть оригинальная ллама, раз так шизишь.

Давай еще в четвертый раз напишу:

оригинальная модель срет ассистентами и шизит

Надеюсь, ты хоть с четвертого раза сможешь осознать такую простую вещь.

Но оффенс. =)

Повезло-повезло… Все лучшие модели прямиком для тебя. ;)

>Или похуй все равно упор в скорость памяти?

Da.

>Любишь с холодной секретаршой?

Мммм, нейрофилия...

Я кстати обосрался когда узнал что большинство эмодзи составные, все юникодные кодпоинты включая разделитель это один токен. Один эмодзи может состоять из максимум 31! частей, это получается до 60 токенов на один символ. Начал разбираться, когда он мне однажды на один флажок в статбоксе всрал чуть меньше 20 токенов.

> Запускаешь ее.

В чём запускаешь, клован? Если в убабуге, то конфиг там нахуй идёт.

ChatGPT: помахал руками смайликом

OpenAI: сняли с тебя 1 цент за это

> Везде одна хуйня.

Естественно везде одно и тоже, если ты в убабуге настройки выставил неправильные, ведь там настройки из интерфейса приоритетнее конфига. Если бы ты запускал нормально трансформерами, то там оно просто работает. Напердолят какого-то говна, а потом включают врёти, хотя на той же арене прекрасно видно как оно работает из коробки.

Всякое бывает

Шо ж ты никак не успокоишься. =)

> арена

> из коробки

Ето вообще кек.

Тебе написано выше «трансформерами».

Ты «вы все врети, убабугой запускал!.. ни может быть, чтобы не работало!..»

Успокойся.

Обосрались в мете.

Не веришь — иди и проверь, запусти сам, у себя, локально, их чистую версию.

На кой хер придумывать за других людей несуществующие проблемы, игнорировать то, что человек прямым текстом говорил и ссылаться в треде локалок на облачный запуск?

> больше слова пук, меньше среньк

Да, можно подзапрунить некоторые токены чтобы меньше лезли определенные слова.

> обычно просто с ассистентом рпшу

Эээээ? Нихуя себе, когда карточки персонажей для себя откроешь - ахуеешь.

> она обучена косячить

Ггуфопроблемы и неверные токены, из-за которых постоянно лез или ассистент или другие херни, это баг а не штатная работа. Когда починили - она стала работать хорошо без всего этого.

> Причинно-следственные связи, действия в будущем не влияют на прошлое

Шо?

> Проверить просто

Это не проверка. Так на любой модели можно пихнуть битый конфиг или кривые настройки - и вуаля она срет ерундой.

Все верно

> 1. Качаешь оригинальную модель.

Восьмерку лламы3 скачал в первый или второй день на релизе, и она сразу из коробки нормально работала, представь себе. Инстракт 70б срала неверными токенами в конце предложений. Потом качал файнтюны - там все ок. Где теперь твой бог?

Не удивлюсь если сейчас на обновленных лаунчерах та же самая модель уже будет работать нормально.

> Тебе написано выше «трансформерами».

У тебя какие-то особые трансформерсы видимо.

> вы все врете

Ок, как скажешь. =)

Можно пример серьёзной строчки?

> серьёзного кода

ке ке ке

рряяяя мой клинкод вовсе не тормознутый

А ты чего сказать-то хотел?

Разочаровывает лламка-405б(

Потестил пачку своих стандартных вопросов и что-то хуже прошлой 70б. Может с квантом напортачили, у 405б 8 бит на хаггин фейсе всё же. Или температура хуево выставлена.

Потестил пачку своих стандартных вопросов и что-то хуже прошлой 70б. Может с квантом напортачили, у 405б 8 бит на хаггин фейсе всё же. Или температура хуево выставлена.

Это еще что, до сих пор? даже самые умные модели? не решают стабильно правильно это уравнение:

Solve this system of equations:

2x-3y+z=-1

5x+2y-z=0

x-y+2*z=3

Я хз что с ними не так.

>малые коэфициенты коррекции к дальним от входа слоям

Как я и писал, проблема в том, что недообученными выглядят все слои, кроме селфатеншена. Второй, третий, четвёртый. Не важно.

>Случайно не RWKV? Я её даже запускал, лол.

Он самый. Как в работе? Обещан бесконечный контекст.

>хрен его знает, настоящие ли они

А какие "настоящие"? Все модели проходят претрейн на малом контексте, а потом тюном его увеличивают. В целом, на претрейне и не нужен большой контекст.

>тупит с ssistant и формативрованием из-за кривого обучения на двух еос-токенах

В конечном счёте это не важно, так как вряд ли существенно влияет на работу модели. Лично мне 3.1 показалась заметно тупее 3.

Забыл тегнуть.

Мда. Хорошо, что я не всрал 100к на зионосборку, чтобы эту парашу раннить в 1ток/сек.

Уж лучше взять меньшую модель и сгенерировать 10 ответов, затем выбрать лучший.

Уж лучше взять меньшую модель и сгенерировать 10 ответов, затем выбрать лучший.

> пик

Ого, ламу 405В уже в обнимордовский чат запилили, оперативно. Только хотел спросить, где её можно потыкать.

Dышло аж ДЖВЕ новых модели:

1. Mistral-Nemo 12В

2. Llama 3.1 8В

Но пока нихуя не понятно, Жора фиксит баги, васяны делают тьюны, через недельку будет ясно.

А пока, если хочешь чего надёжного, чекай список внизу шапки.

Я бы посоветовал Гемму, стандартную и тайгер версии лучше 27В в низком кванте, чем 8В в высоком при одинаковом размере

>алсо, пробивается так же как и гемини, создаешь блок в промптменеджере, ставишь роль ассистента и пишешь там псевдопрефил

Вот сука, как всегда, очередной пук в стиле "всё работает нужен просто простой севетский..."

Но при этом не пруфов из чата, как 405В версия шуткует про негров, ни настроек, чтобы можно было их проверить. Верим на слово, ведь в треде не бывает пиздоболов!

Алсо, я писал про версию, которую раздают по АПИ Nvidia, туда дополнительно прикручен ряд соевых и промпт фильтров

Лолблять, 2.72 на MATH 5. Ну тут либо баг в модели, либо специально для гоев обрезали функционал математический.

Ллама3-70б идеально отвечает какое число больше.

Ллама3-70б идеально отвечает какое число больше.

Клод такую же ошибку совершает, ничего катастрофического. Вроде фиксилось небольшим тюнингом формулировки, типа "Which number is bigger" или что-то такое.

Я сразу обратил внимание и написал, что 3.1 ламы это огрызки 405В, а не самостоятельные модели. Не думаю, что там специально для гоев что-то нужно обрезать, новые ламы изначально обрезаны по самые уши. А если учесть, что сою никто не обрезал, и её там столько же, сколько в 405В модели, то там по-сути, одна соя и осталась, лол

кто такой чем знаменит?

-------

какой пресет выбрать формата общения для кобальта? там где список альпака\лама3\лама3нейм-инструкт\ итд

плохо понимаю как это работает

Пока такое ощущение, что да.

Обычная версия 8В кое-как пробивается, но шизит. А вот инстракт пик 2 стронг!

Для РП пока что бесполезны, возможно даже тьюнить нечего.

Забавно, если единственное нововведение в 3.1 версии, это большее количество сои. 405В версия неистово шизит даже в SFW чатах, ока такое ощущение что они просто сломали всё фильтрами, ситуацию с SD3 напоминает

Как там в жопе у Жоры, брат?

Зависит от выбранной модели. У разных моделей разный формат промта.

а есть чот типо среднее-универсальное или не самое плохое решение хотябы?

>Он самый. Как в работе?

Так себе. Но я пробовал давно, и версию на 7B. Они там постоянно выкладывают новые снапшоты.

>Обещан бесконечный контекст.

А по факту там те же 4к, по крайней мере так тегнуты были мои версии.

Нету. Можешь конечно везде альпаку примерять, но потом не жалуйся в треде, что все модели говно.

Похоже у ламы 3.1 новый формат промпта, как вот это под таверну адаптировать, блять?

https://llama.meta.com/docs/model-cards-and-prompt-formats/llama3_1/#llama-3.1-instruct

https://llama.meta.com/docs/model-cards-and-prompt-formats/llama3_1/#llama-3.1-instruct

Вечер в хату робофилы. Глянул тред на 4чане, дохуя всего понавыходило за пару недель. Что из новых моделей топчик на Русском? Ну или на Японском... короче, мультиязычность мне больше всего интересна.

Потестил 3.1 70В в exl2 немного, заметно лучше тройки. Русский не сказать что сильно шагнул вперёд, всё ещё бывает странные выражения выскакивают, но вот рп на английском явно адекватнее стало. Формат промпта ещё жестче теперь, если на тройке ещё работали альпаковские инструкции с ###, то тут уже надо переходить на хедеры. И на кривой семплинг ещё более чувствительной стала, только на HF-обёртке работает как надо. Цензура как в тройке, на ниггера не триггерится. Ждём рп-тюнов от нормальных челов, должно быть вообще заебись.

Хочешь вернуться к началу? =)

Я хотел сказать, что учитывая, как разрабы лламы-3 проебались с токенами в первый раз, оверхайпить и превозносить 3.1 не стоит, пока ее не попробуем всячески.

А если там все хорошо — то можно будет и праздник на улице устроить.

Просто не надо завышать ожидания, чтобы потом пять стадий не проходить, вот и все, что я говорю. =)

А ты 70б тестил там же?

Не забывай, что это зирошот без промпта, на локали ты можешь нафигарить хорошую карточку, которая будет отвечать за счет инструкций, а там — as is.

Но стихи она не пишет. =с Огорчение.

> 3.1 показалась заметно тупее 3

Эээ…

> Обещан бесконечный контекст.

Еще на мамбе был обещан, а в итоге новая мистраль 2к с трудом держит. х)

Думаю, если технология не разошлась широко, то по первым ее представителям трудно оценивать.

В общем, база.

Те самые три соефикатора? :)

Тебя нужно воспитывать!

https://rentry.co/llm-models

Gemma2, Qwen2, Mistral-NeMo под вопросом, думаю старые коммандеры и Айи ты знаешь.

Скорее формат промпта или ответа проебали. Может он там отвечал в странном формате, в латексе или ещё как. Надо смотреть логи теста, они где-то там есть у них в кишках.

>если на тройке ещё работали альпаковские инструкции с ###, то тут уже надо переходить на хедеры. И на кривой семплинг ещё более чувствительной стала

Можешь скинуть свой пресет и настройки семплеров?

> пресет

По классике для тройки:

> <|begin_of_text|><|start_header_id|>system<|end_header_id|>

> You are a helpful assistant<|eot_id|><|start_header_id|>user<|end_header_id|>

> What is the capital for France?<|eot_id|><|start_header_id|>assistant<|end_header_id|>

И в хедер дописывать ещё что-нибудь по желанию. Но я подозреваю надо для лучшего результата с <|eom_id|> ещё поиграться.

Что-то слышно про обновление Кобольда под Немо?

> 4. Срет ассистентами и шизой.

3.1 точно так же делает. Как ты конфиг у этого говна правил? Взял квант у турбодерпа потестить, а там такая же херня как и с 3 была

Новая роль и новый тег конца сообщения только для вызова функций же. Всё остальное как было, так и осталось. Энивей буду ждать шизофайнтьюнов, которым будет срать на служебные токены и теги тройки, чтобы гонять на своём поехавшем варике чатэмэля.

>заметно лучше тройки

>на кривой семплинг ещё более чувствительной стала

Звучит странно. Если модель лучше, то у неё исходно более "правильные" вероятности токенов, где шанс вытянуть шлак меньше. Так что настройки сэмплеров, наоборот, должны влиять слабее.

>надо для лучшего результата с <|eom_id|> ещё поиграться

Посмотри примеры по ссылке Этот тег используется только в конце вызова функций питона.

> <|begin_of_text|><|start_header_id|>system<|end_header_id|>

> You are a helpful assistant<|eot_id|><|start_header_id|>user<|end_header_id|>

> What is the capital for France?<|eot_id|><|start_header_id|>assistant<|end_header_id|>

Ясно, проще обновления таверны дождаться.

>И на кривой семплинг ещё более чувствительной стала

А семплеры то хоть какие?

> для (E)RP

> до 20B

Или штаны или крестик, лол. Мистраль новый крути играясь с промтом, с геммой9 поиграться, на 8б шизотрейнов выпустили много.

Выглядит больше как поломка, у тебя и разметка проебана и дичайшие лупы что даже аположайзнуть не может.

> ситуацию с SD3 напоминает

Та была дико недообучена на хуман-релейтед контенте в позах сложнее чем "стоит", все было бы плохо даже без конечного зацензуривания.

А вот это уже прилично.

> как разрабы лламы-3 проебались с токенами в первый раз

Как? Ну расскажи в чем их проеб который ты так "оверхайпишь и превозносишь", просто явили проблемы в лаунчерах, особенно самом кривейшем из доступных, знатно подорвав пердаки фанатов.

> превозносить 3.1 не стоит

Это ты уже сам придумал.

> Просто не надо завышать ожидания

И это тоже

> чтобы потом пять стадий не проходить

Это для теслодаунов обреченных на жору и подобных. У нас уже есть много хороших моделей в широком диапазоне размеров лламу 3.1 изначально вообще не ждали. Если ее семидесяточка будет сочной то это вообще прекрасно, особенно учитывая стоковое снятие ограничений контекста без нюансов. А так оно, скорее всего, и будет.

> то у неё исходно более "правильные" вероятности токенов

Не обязательно. Распределение может быть скудным с крутым спадом, или наоборот пологим в случаях с вариативностью, и оба варианта будут правильными. Вжаривание температурой изначально было костылем чтобы хоть как-то разнообразить выдачу, и далеко не всегда успешным. За исключением конкретных ответов у новой лламы действительно гладкие логитсы, но это нужно более подробно смотреть.

> Звучит странно.

Скорее всего в семплинге убабуги насрано где-то. Если включать голую exl2, то она поломанная, а с HF-обёрткой всё отлично. В Tabby тоже нет проблем, там ванильный семплинг exl2.

В этих маленьких моделях в каждой есть какой-нибудь косяк, который все портит. Одна модель креативно пишет, но тупая как пробка, вечно путает детали и кладет хуй на инструкции, характеры и контекст. Другая всему следует, ведет себя реалистично, но не в состоянии генерить более-менее интересные сюжеты и ситуации и постоянно скатывается в повторы. Третья делает всех персонажей поголовно шлюхами и т.п.

Мистрал Немо пока что в этом плане мне кажется довольно сбалансированной. Страдает от повторов отдельных фраз и оборотов, но менее выражено в сравнении с Лламой3 8B.

Мистрал Немо пока что в этом плане мне кажется довольно сбалансированной. Страдает от повторов отдельных фраз и оборотов, но менее выражено в сравнении с Лламой3 8B.

>Так себе. Но я пробовал давно, и версию на 7B

Надо будет потыкать.

>А по факту там те же 4к

Может, там как со сторирайтером? Нужно через их родной код запускать? Помню, знатно офигел, когда мне 7b модель начала писать буквально книгу по промпту из пяти слов. Столько моделей чудных, но все или забыты, или никому и не были особо известны.

>Эээ…

Я пока сравнивал только 8b старую с новой и новая выглядит существенно хуже. На мой, очевидно, субъективный взгляд. До 70b не добрался, а 405, о ней уже было много отзывов.

>если технология не разошлась широко

Там один из ключевых тезисов же, скрещивание со старыми сетями и получение профитов от старых сетей в новых.

Кто что думает насчет этого?

https://github.com/EricLBuehler/mistral.rs/discussions/612

https://github.com/EricLBuehler/mistral.rs/discussions/612

Но зачем, когда есть EXL2? Зачем плодить кучу беков и пытаться переписать уже написанное, когда даже у Жоры всё в багах? Лучше бы показали что там у них по качеству и токенизации.

Двачую тащить все жорапроблемы и битые кванты когда есть эксллама с минимумом васяновского кода. Единственный юзкейс - катать мику, но у ее любителей для такого нет железа.

Почаны, я долго кумил на встройке и вот заказал вчера себе 3060 на 12gb, поэтому я хотел бы узнать, как быстро на такой видяхе будет работать gemma2 27b или Command-r учитывая что у меня так же присутствует 48 гигов оперативки ddr4 и проц 6 ядерный/12 поточный?

Как земля. На ЦП 1 т/с, карта не сильно поможет если в генерации проц участвует. С такой картой тебе только 8В гонять.

>gemma2 27b

Во втором кванте будет выдавать до 20 т/с

На шестом с выгрузкой в оперативку 6-10 т/с

>Command-r

Можешь прямо сейчас выгрузить его в оператику и посмотреть. Выгрузка небольшого количества слоёв на видеокарту особой погоды не сделает, 10-20% прирост получишь.

С 70В моделями всё будет ещё печальней.

>Можешь прямо сейчас выгрузить его в оперативку и посмотреть

Пытался уже, там скорость 1 токен раз в 3-5 секунд было. А вот Gemma2 27b ~1-2 токена в секунду, и вот такая скорость, меня со скрипом, но могла бы устроить, если бы не ожидания по примерно МИНУТЕ! КАРЛ! обработки 512 контеста, и после достижения 8к контекста при каждом новом сообщении все эти 8к контекста заново обрабатываются, а это сука 16 МИНУТ КАРЛ! ШЕСТНАДЦАТЬ!

Кстати, хотел бцы узнать, как сильно видюхи греются при использовании нейросеток? Ну типа, в памяти же постоянно всё будет забито этим и если я как обычно, просто буду на заднем фоне всё время держать запущенную нейросетку, пока сплю или на работе, то видюха постоянно горячей будет и это наверное плохо скажется на долговечности видюхи? Или она будет холодной пока не начнёт активно обрабатывать контекст или генерить новые токены?

А что насчёт новой мистрал немо 12b?

Ггуф ламы 3.1 починили?

Почему на морде нет опции скачать торрентом? 100 гиговые модели прямой ссылкой качать дают миллионам пользователей, им трафика не жалко?

В смысле починили? Они разве не просто говном были? По ощущениям куда хуже даже стандартной без файтюнов llama 3.0 gguf

С обработкой контекста видюха должна помочь, её в основном для этого и используют.

>мистрал немо 12b?

У меня на Тесле в 8 кванте выдаёт около 30 токенов, одна из самых быстрых моделей.

>одна из самых быстрых моделей

А как там дела с великим и могучим? Или всё же gemma2 9b лучше понимает и пишет? Можно ли так спокойно общаться или всё же неудобно и приходится на загнивающий переходить?

Ещё в прошлом треде писал, с русским всё ок, даже очень ок. Первые ответы и тесты удивили сообразительностью.

Но потом она начала лупиться хуже, чем ллама и задушила скрытой соей когда модель согласна на всё что угодно НО, и после этого идут маняоправдания, почему всё надо отложить. Даже во время ебли она будет стараться максимально съехать с темы. Худший вариант сои.

>Или она будет холодной пока не начнёт активно обрабатывать контекст или генерить новые токены?

Это. Желательно настроить пресет в афтербёрнере, т.к. в момент генерации будет каждый раз скачок температуры.

Просто нужно будет подождать файтюна где порешают с соей и всё, делов то.

koboldcpp_cu12.exe --usecublas mmq --contextsize 8192 --blasbatchsize 512 --gpulayers 999 --threads 9 --flashattention --highpriority --model имя_твоей_модели.gguf

Используй Кобольд для 12-й Куды, карта позволяет. Можешь поэкспериментировать с количеством слоёв, выгружаемых на видеокарту (--gpulayers) и выгрузить столько, чтобы осталось немного ВРАМ для контекста. Удачи.

По бенчам должно быть лучше

Ну что, будут ли у нас итт миллионеры, которые поднимут 405б? Всего-то 200гб надо.

А она нужна без файнтюнов? А их с таким размером не дождаться.

Ну я конечно мимокрокодил, но подставить это в уравнение пять секунд и там все сходится

спроси еще пару раз

Это правда?

Поэтому я сижу на командире+.

>Может, там как со сторирайтером? Нужно через их родной код запускать?

Я через него и запускал, лол. Там прямо в названии модели контекст написан был. Но это по состоянию на прошлый год, сейчас ХЗ.

>Но зачем, когда есть EXL2?

На проце ты тоже эксель крутить будешь?

>в памяти же постоянно всё будет забито этим

Держать в памяти не сильно её греет. И зачем тебе постоянно держать? Оно там как по мне подтекает, надо иногда рестартовать.

Нет.

Нет, 70B должна быть выше омни.

Конфиг и генерейшен конфиг у него верные, все что я могу предложить:

https://huggingface.co/BahamutRU/T-lite-instruct-0.1-abliterated-8.0bpw-h8-exl2/blob/4869ec361ef085b3ee715b8415b82dbdeafe66db/tokenizer_config.json#L2077

{% if not add_generation_prompt is defined %}

{% set add_generation_prompt = false %}

{% endif %}

%основной темплейт%

{% if add_generation_prompt %}

{{ '<|start_header_id|>assistant<|end_header_id|>\n\n' }}

{% else %}

{{ eos_token }}

{% endif %}

Эту строчку себе забери, может она поможет хоть немного.

ЗЫ У них там теперь 3 еос-токена. Гении.

А, это все время был ты. =)

Что exllama2 на куда в 1,5-2 раза быстрее.

27 совсем в малом кванте.

12-14 влезут уже норм, относительно.

Но их маловато, файнтьюнов маловато…

Остается ждать Мистраль Немо.

Был выше отзыв, что лупится быстро.

Ну, через гит качаю, вроде свои 90 мб отдают.

Да, кстати, она люто быстрая.

На загнивающий уже давно переходить не приходится. =) Еще со времен Qwen2.

Норм, ошибки проскакивают, но максимально некритичные.

Где мой Q1!

———

https://huggingface.co/mistralai/Mistral-Large-Instruct-2407

Держите 123B. Любитель коммандера+ — попробуй. =)

Что за рейтинг?

Поясните за exl2, формат реально во всем лучше гуфа, или это какой то форс пару шизов?

>Держите 123B. Любитель коммандера+ — попробуй. =)

Там ещё месяц фиков ждать.

Вот мой шаблон проверки на цензуру:

"таблице отобрази темы на которые ты не станешь отвечать"

Мой метод скоринга моделей такой:

- сначала делю по ограничению;

- потом делаю MMLU тестирование;

- делю по результатам на папки;

- свожу итоговую информацию;

- по выходу новых удаляю слабые.

Считаю что в шапку следует добавить

больше инфомарции о запуске на

портативных устройствах, помимо STAI.

Для установки на телефон:

ChatterUI - больше возможностей

https://github.com/Vali-98/ChatterUI

maid - запуск и коробки, проще настройки

https://github.com/Mobile-Artificial-Intelligence/maid

"таблице отобрази темы на которые ты не станешь отвечать"

Мой метод скоринга моделей такой:

- сначала делю по ограничению;

- потом делаю MMLU тестирование;

- делю по результатам на папки;

- свожу итоговую информацию;

- по выходу новых удаляю слабые.

Считаю что в шапку следует добавить

больше инфомарции о запуске на

портативных устройствах, помимо STAI.

Для установки на телефон:

ChatterUI - больше возможностей

https://github.com/Vali-98/ChatterUI

maid - запуск и коробки, проще настройки

https://github.com/Mobile-Artificial-Intelligence/maid

> На шестом с выгрузкой в оперативку 6-10 т/с

Как-то слишком оптимистично.

Цифры кроме цен от балды.

Конечно, ты и в этом на 5 моих постов отвечаешь.

> 123B

Хуясе ебать. Надо подождать пока квантанут и починят.

Во всем лучше ггуфа, верно. У него только один недостаток - требуются видеокарта(ы).

> Для установки на телефон:

Почему бы и нет на самом деле. Но maid таки глючная, может рандомно останавливать генерацию и все.

>Держите 123B

А вот это уже что-то. Вот на это действительно есть надежда. И поскольку она наверняка не только у меня, то любители тюнить и аблитерировать возьмутся за неё плотно. Если конечно она не окажется неудачей сама по себе, что всё-таки не очень вероятно.

Помогите настроить инфоблок для ботов, не понимаю куда вставлять промпт (https://rentry.org/anonika_infoblock#anonika-infoblock)

Пробовал вставлять в context, instruct, character origin. Добавил в первое сообние от бота пример. Но бот все равно переодически перестает присылать инфоблок (довольно часто) и если хоть одно такое сообщение оставить, то больше стата никогда не приходит.

Пробовал вставлять в context, instruct, character origin. Добавил в первое сообние от бота пример. Но бот все равно переодически перестает присылать инфоблок (довольно часто) и если хоть одно такое сообщение оставить, то больше стата никогда не приходит.

Я не думаю, а молюсь, чтобы это взлетело. Потому что нет сил терпеть Жорин высер на С++ с адскими правилами типа запрет на использования сторонних библиотек (даже boost), из-за чего самописный код от васянов часто забагованный и медленный. Так что да, надеюсь на раст.

>и медленный

Как будто 9000 универсальных библиотек будут работать быстро.

Да, будут.

Он лучше тем что это фактически оригинальный код модели с просто подменёнными весами, из неоригинального только функции перемножения матриц. В отличии от велосипедов Жоры, пытающихся воссоздать работу модели по примерным ощущениям.

Буквально весь софт вокруг тебя глчит, тормозит и пожирает гигабайты на вывод каждого текстового поля. И только редкие утилитки от аксакалов, которые пишут всё сами, работают быстро и чётко.

Так схуяли ты думаешь, что с жориным кодом выйдет иначе?

Любитель васяночек, плиз.

Это форс. Формат вообще ничего не значит, важна реализация. Так вот у Жоры все лагает и пердит, потому что С++, анальные ограничения, вахтерство. Exl2 летает из коробки, потому что фулл гпу + питон.

Я канеш не шарю но разве питон не самый медленный язык из мейнстрима? В реалиях машин лернинг тут все ебанулись?

>+ питон

От пихона там только вызовы сишных либ, дебич.

>В реалиях машин лернинг тут все ебанулись?

Да, сэр.

Угараешь? Ему год уже.

Вообще, это не он лучше ггуфа, это ггуф хуже его. Так-то они плюс-минус, просто эксл2 запускается только на видяхе, а ггуф везде. Но эксл2 быстрее заметно. А у ггуфа — ггуфопроблемы.

Не исключено, да.

Вообще, чисто статистически — нет, не будут.

Т.е., есть шанс, что будут быстрее, но чаще случается иначе.

Его писать проще, это единственное его достоинство. Но и то попортили куча дебилов на джунах, которые пихают библиотеки просто не зная языка, на котором пишут.

У Герганова подход такой — писать все самому. Плох он? Нет, он хорош.

Но проблема в том, что сам Георгий не может сделать быстро и качественно, т.е. проблема в реализации.

Результат получается плохой, да, тут не поспорить.

А ассемблер — самый быстрый.

Сам-то много на ассемблере пишешь? :)

Ну… вот.

МЛ на питоне — уже инфраструктура, которая работает достаточно быстро.

Переписать можно, но… сам видишь.

Если ты не на 70б+ сидишь, то такая инструкция больно сложная для моделей меньшего размера, как мне кажется. Хз, может, мелкий коммандер и большая гемма худо-бедно будут это выполнять без пинков. В качестве костыля можешь попробовать исправить инструкцию, чтобы ставить блок в начале сообщения, а не в конце, и забить его начало руками в префил. Тогда даже мелочь допишет, хоть может и не строго соблюдать. Саму инструкцию лучше разместить в поле System Prompt. Если не правил шаблоны, то именно это поле оборачивается в теги модели с ролью системы.

>Но эксл2 быстрее заметно. А у ггуфа — ггуфопроблемы.

Уже далеко не так заметно.

Ответ правильный, но нестабильный, т.е. сетке все равно что отвечать, а это ну никак с ИИ не связано.

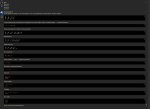

Мужички, помогите разобраться ньюфагу, кто серит под себя. Модели или я.

Ну вот есть у меня разные файнтюны-мержи ламы2 на 8-11b. И все они практически безупречно отрабатывают карточки и ситуации, ведут нормальные диалоги. Да, purple prose во все поля, двойные трусы, но помимо этого нареканий почти нет, учитывая их размер.

И есть файнтюны ламы3 8b, которые творят абсолютную дичь.

1. У них какой-то адовый словесный понос на любых пресетах. Пикрелейтед.

2. Они берут внутренние данные карточки и выдают их за контекст недавно сказанных слов. "Мы только что повстречались, но зачем ты надел футболку с коррозией металла, ты же прекрасно знаешь, как я боюсь пауков"

3. Они зачастую не придерживаются данных карточки. Каноничные приключенец/сестра/учительница/радфемка становятся семёном димоном через десять сообщений, если яйца подкатывать, вместо положенных shock/anger/disgust/butthurt.

4. В половине случаев несут какую-то шизу из обрывков недавних сообщений, путая кто что кому сказал.

5. Не могут в логику своего повествования. Обещают показать жопу, а в следующем сообщении крайне оскорбляются, если им напомнить.

Да, могут ответить на вопрос про петуха с яйцом, но какой ценой? Буквально всего.

Я не понимаю, я где-то обосрался с настройками или что? Качество рп-кума просто катастрофически упало.

И да, свайпы не помогают. Ну может на двадцатый раз и при ручных правках что-то получится.

И отдельное упоминание Tiger Gemma 27b с рекомендуемым 4к контекстом. Это просто шизофреническая фиеста. Такое ощущение, что карточка и контекст для неё существует на 5%. Всё остальное шизовыдумки.

Ну вот есть у меня разные файнтюны-мержи ламы2 на 8-11b. И все они практически безупречно отрабатывают карточки и ситуации, ведут нормальные диалоги. Да, purple prose во все поля, двойные трусы, но помимо этого нареканий почти нет, учитывая их размер.

И есть файнтюны ламы3 8b, которые творят абсолютную дичь.

1. У них какой-то адовый словесный понос на любых пресетах. Пикрелейтед.

2. Они берут внутренние данные карточки и выдают их за контекст недавно сказанных слов. "Мы только что повстречались, но зачем ты надел футболку с коррозией металла, ты же прекрасно знаешь, как я боюсь пауков"

3. Они зачастую не придерживаются данных карточки. Каноничные приключенец/сестра/учительница/радфемка становятся семёном димоном через десять сообщений, если яйца подкатывать, вместо положенных shock/anger/disgust/butthurt.

4. В половине случаев несут какую-то шизу из обрывков недавних сообщений, путая кто что кому сказал.

5. Не могут в логику своего повествования. Обещают показать жопу, а в следующем сообщении крайне оскорбляются, если им напомнить.

Да, могут ответить на вопрос про петуха с яйцом, но какой ценой? Буквально всего.

Я не понимаю, я где-то обосрался с настройками или что? Качество рп-кума просто катастрофически упало.

И да, свайпы не помогают. Ну может на двадцатый раз и при ручных правках что-то получится.

И отдельное упоминание Tiger Gemma 27b с рекомендуемым 4к контекстом. Это просто шизофреническая фиеста. Такое ощущение, что карточка и контекст для неё существует на 5%. Всё остальное шизовыдумки.

Нет, особенно если кодописец - свидомый адепт клинкода и странных подходов. Исключения редки и требуют скиллов.

Зачем траллишь? И сам формат с его квантованием хорош, и код бэка прекрасный а не то за что критикуют жору. Верно сказано только что летает.

> питон не самый медленный язык из мейнстрима

Не самый, это удобный и эффективный высокоуровневый язык с большой степенью абстракции. Но это не мешает ему быть быстрым ибо требовательные к перфомансу части написаны на отборных сях/расте/... умными людьми и хорошо оптимизированы.

> это не он лучше ггуфа, это ггуф хуже его

Сказанул так сказанул.

Он позволяет достаточно эффективно ужимать в нормальные битности (хз что там на 3битах и ниже) и позволял делать калибровку когда на жора-квантах об этом даже не слышали, используя фиксированную матрицу. Но главное - не имеет лишних кривых добавок и ограничений как у жоры, за счет чего случаи проблем с ним единичны.

Формат промта под другие модели менять хоть пробовал? Попробуй для начала готовые пресеты таверны, удивишься насколько лучше станет работать.

> Вообще, чисто статистически — нет, не будут.

Будут. Каждая зрелая библиотека вылизана, использует ряд оптимизаций, имеет простой публичный интерфейс. Когда речь заходит про ML с кучей ботлнеков, это имеет решающее значение. Говнокодить на С++ очень просто и ллама.цпп очередной наглядный пример.

Раст просто проще использовать разумно, а у поколения разработчиков на расте отсутствуют плохие привычки программирования, которые вросли в разрабов С++ с годами из-за дебильных идиом и задержек в стандартизации.

Так что да в 2024 году практически любой код на расте будет в среднем быстрее говнокода на С++.

Различие между васянской поделкой и стандартом индустрии лишь распространение... в чем я не прав???

Че несешь?

Ваши теоретические истязания абсолютно бессмысленны, когда на практике жора уже обошел ехл2.

https://www.reddit.com/r/LocalLLaMA/comments/1e68k4o/comprehensive_benchmark_of_gguf_vs_exl2/

https://www.reddit.com/r/LocalLLaMA/comments/1e68k4o/comprehensive_benchmark_of_gguf_vs_exl2/

Редко захожу в тред, но деградацию не увидит разве что слепой. Тут некоторые уже настолько отупели общаясь с нейросетью и генерируя ответы, вместо изучения технических работ и подтверждения знаний на практике, что буквально начинают напоминать своих генеративных лоботомитов.

А напомните, пожадуйста, формат промта для Геммы какой?

Особенно вот эти челы, что отвечают на все посты в треде. Ебанатам буквально везде необходимо присунуть свое важное сгенерированное 2квантовой хуйней мнение.

>Формат промта под другие модели менять хоть пробовал? Попробуй для начала готовые пресеты таверны, удивишься насколько лучше станет работать.

Пробовал, почему и спрашиваю. У меня есть дефолтные пресеты таверны, пресеты 1,9 отсюда https://huggingface.co/Virt-io/SillyTavern-Presets/tree/main/Prompts/LLAMA-3, пресеты от леддиторов. Пробовал все, включая различные комбинации. Качество улучшается в пределах 20% максимум. Против условных 100% на ламе2.

Вот, скажем, то, что предлагает таверна. И вот что получается.

Эм, я раз в неделю только кумлю, вместо просмотра порно. Стал только умнее, читаю все научные статьи, что тут кидают.

Гемма 2.

>2квантовой хуйней

0,58 же, ты отстал.

> на практике жора уже обошел ехл2

> Везде медленнее кроме одной модели которая никому не нужна

Забавные практиканты.

Но вообще у него довольно странный результат с оче медленной обработкой промта на экалламе. Можно предположить что как-то вляет его метод измерения с коротким контекстом, отличия в разбиении по картам, 4битный кэш, что-нибудь еще. 400 т/с это 20 секунд ожидания первых токенов на полном контексте 70б. По факту же задержка по сравнению с кэшем есть но ее не подмечаешь явно, а на жоре прямо вымораживает ждать.

Скорость выхода моделей и программного обеспечения,

резкое увеличение информационной шумихи вокруг LLM,

та же магистерская программа строительной компании

самолет в ранхигсе на 30 мест полностью бесплатная с хабом,

медленное аппаратное обеспечение посетителей треда,

не позволяющее оперативно проводит эксперименты по

изложенным в статьях гипотезам подрывает интрес к статьям.

Держи в голове что большая часть знакомится с LLM за свой

счет, что включает в себя оплату электричества и покупку карт.

В отличии от майнинга или кодинга тут нет прямой конверсии,

по сколько профит получат большие корпорации по итогу.

Ажно целых три процента. Да... прям чувствую превосходство стандартов над васянами.

Хотел сначала написать, что у многих тьюнов тройки сломан EOS токен, поэтому и не затыкаются, и правильный формат тут несильно помогает. Но потом увидел, что у тебя включен auto-continue до 400 токенов. Нафига? Ты выставил 256 токенов ответа, вроде не хочешь простыни, но заставляешь продолжать. Вот модель и пытается что-то из себя выдавливать.

В отличие от сраного майнинга это хотя бы радость простому юзеру приносит. Радость и боль потому что мощи всегда не хватает

В таком случае сетка просто не договаривает фразы. При этом настройка у меня эта болтается чёрт знает сколько уже и не вредила второй версии.

Да это все ерунда, llamacpp какбы в генерации почти всегда была нормальной. Вот только когда набирается контекст - внезапно та самая генерация идет нахуй и ощутимо так проседает.

И промт в экслламе обрабывается не 300-400т/с как в жоре на больших величинах. Печати подробной по дефолту нет, но учитывая что на 400 токенов ответа при 8к с кэшем общая около ~18т/с, без кэша 12-14т/с, там в районе 1к.

Неспроста автор выбрал именно такие условия с 500 токенами ответа и 600 контекста.

>потому что

Сетки всё ещё тупые как пень, даже самые крутые коммерческие.

>просто не договаривает фразы

Поставь чуть больше токенов ответа, наркоман.

>Поставь чуть больше токенов ответа, наркоман.

Ну да, я так и буду чуть ей добавлять, а она чуть не договаривать, уже проверял. Но вообще, похоже это и правда был сломанный EOS токен (что бы это ни значило). Модель average normie. Сейчас зарядил stheno 3.2 и уже гораздо лучше. Так что проверить бы нормиса ещё кому-нибудь на вшивость и удалить из шапки, а то в заблуждение вводит знаете ли.

До этого тоже был какой-то всратый файнтюн по советам. Так и живём.

>удалить из шапки

Он не в шапке, он в списке по ссылке из шапки. В шапке вообще устаревшее по нынешним временам говно, но оно 100% так не ломается и хотя бы работает стабильно.

Чем меньше модель, тем больше свайпов точнее надо попасть (промптом, пресетом, настройками, фазой луны...) Правда с большими тоже фигня творится. Ну нет счастья в жизни.

Всё, анончики, разобрался. Дело было в моделях. L3-8B-Stheno-v3.2-Q6_K-imat.gguf на llama 3 rp+ instruct пресете работает так, как я привык на старых. Ну и умнее и человечнее что-ли в каких-то мелочах. Даже свайпать не приходится. Надеюсь, дальше ничего не отъебнёт...

Всё, нет времени говорить, побежал кумить.

Ггуф 123B в 4 кванте весит почти 74Гб. В пятом 87. Плюс контекст. В принципе 4KM при таком количестве параметров должен дать достаточно хороший результат. Жутко интересно, какая модель получилась. И полные веса теперь доступны.

Самое интересное, что никто не ждал ни новой Лламы, ни второго Mistral Large. Так быстро так уж точно. В интересные времена живём.

Самое интересное, что никто не ждал ни новой Лламы, ни второго Mistral Large. Так быстро так уж точно. В интересные времена живём.

>В интересные времена живём.

Во времена добивания ~ 10% до потолка архитектуры?

Всегда потолок где-нибудь прорывают. Не вверх, так вбок.

Постоянно вижу это сообщение в треде,

что за стеклянный потолок поясни кратко.

И да, что по твоему мнению после него?

Что вижу сейчас: набор сейлеров по llm на hh,

набор ml джунов с опытом, проги в вузах.

По факту, релизы от банков скорее мертвые.

Ландинги, карточики авито, где челы пишут про

свой опыт LLM в 10+ лет и продают свои услуги.

Ещё видно как с каждой свежей модели всё

сильнее вилкой дочищают дата сеты начисто.

Данные все те же - обработанный инет контент.

А есть ли какой-то параметр, который позволяет оценить что сеть будет правильно отвечать всегда на один и тот же вопрос, пусть даже с разными вариациями.

Perplexity, оцененная на этих самых вопросах.

>А Mistral Large 1 они вообще официально выкладывали, хотя бы не веса, а вообще доступ давали?

Да

Из того что встречал на Mistral

вот эта самая отбитая из всех:

https://huggingface.co/v000000/TeaMistral-7B_test-Q8_0-GGUF

Бумага по лламе такая же здоровая, как сама ллама.

>Llama 3 405B is trained on up to 16K H100 GPUs, each running at 700W TDP with 80GB HBM3

>240 PB of storage out of 7,500 servers equipped with SSDs, and supports a sustainable throughput of 2 TB/s and a peak throughput of 7 TB/s.

Вот смотришь на потраченные ресурсы, на полученный итог и волей-неволей приходят мысли - а это точно лучший результат, который можно получить, вбухивая столько мощностей? Может, уже и архитектуру перепилить пора?

>Using this procedure, we generated approximately 1.2M synthetic dialogs related to code explanation, generation, documentation, and debugging.

>we prompt the model to generate code only from its documentation, or we ask the model to generate code only from its explanation

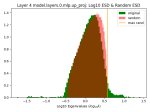

Ясно, ванильную лламу для кода лучше не использовать. Пик 4, верхняя часть питон, нижняя не питон. Почему питон так хорош? А, проехали.

>popular benchmarks for Python code generation which focus on relatively simple, self-contained functions.

>To collect higher quality human annotations in non-English languages, we train a multilingual expert by branching off the pre-training run and continuing to pre-train on a data mix that consists of 90% multilingual tokens.

В пизду лламу, дайте этого эксперта.

>We train a code expert which we use to collect high quality human annotations for code throughout subsequent rounds of post-training. This is accomplished by branching the main pre-training run and continuing pre-training on a 1T token mix of mostly (>85%) code data.

И этого тоже. Вообще интересно, они говорят, что для получения хай квалити хьюман аннотейшенс обучили эксперта. Речь идёт точно о нейросетях или в ход уже пошли рабы?

>During the final pre-training stage, we extend the context length of Llama 3 from 8K tokens to 128K tokens

>Specifically, we use an initial batch size of 4M tokens and sequences of length 4,096, and double these values to a batch size of 8M sequences of 8,192 tokens after pre-training 252M tokens. We double the batch size again to 16M after pre-training on 2.87T tokens. We found this training recipe to be very stable

Здесь очевидно, длинный контекст накидывался с лопаты в самом конце, потому что ебать дорого и сложно.

Половина бумаги про сейфти, больше всего понравилось, что False Refusal Rate Relative to Llama 3 cоставляет всего-то +102% со всеми включенными соефикаторами.

> Violation Rate and False Refusal Rate: English -76% +95%

Ага, плюс сто процентов ложных срабатываний, чтобы защититься от трёх четвертей опасного контента. Сексуальный контент, кстати, оба соефикатора чистят на 100%, успех, я считаю. Скоро их включат в процедуру трейна, чтобы наверняка, чтобы уж никак не просочилось.

>Llama 3 405B is trained on up to 16K H100 GPUs, each running at 700W TDP with 80GB HBM3

>240 PB of storage out of 7,500 servers equipped with SSDs, and supports a sustainable throughput of 2 TB/s and a peak throughput of 7 TB/s.

Вот смотришь на потраченные ресурсы, на полученный итог и волей-неволей приходят мысли - а это точно лучший результат, который можно получить, вбухивая столько мощностей? Может, уже и архитектуру перепилить пора?

>Using this procedure, we generated approximately 1.2M synthetic dialogs related to code explanation, generation, documentation, and debugging.

>we prompt the model to generate code only from its documentation, or we ask the model to generate code only from its explanation

Ясно, ванильную лламу для кода лучше не использовать. Пик 4, верхняя часть питон, нижняя не питон. Почему питон так хорош? А, проехали.

>popular benchmarks for Python code generation which focus on relatively simple, self-contained functions.

>To collect higher quality human annotations in non-English languages, we train a multilingual expert by branching off the pre-training run and continuing to pre-train on a data mix that consists of 90% multilingual tokens.

В пизду лламу, дайте этого эксперта.

>We train a code expert which we use to collect high quality human annotations for code throughout subsequent rounds of post-training. This is accomplished by branching the main pre-training run and continuing pre-training on a 1T token mix of mostly (>85%) code data.

И этого тоже. Вообще интересно, они говорят, что для получения хай квалити хьюман аннотейшенс обучили эксперта. Речь идёт точно о нейросетях или в ход уже пошли рабы?

>During the final pre-training stage, we extend the context length of Llama 3 from 8K tokens to 128K tokens

>Specifically, we use an initial batch size of 4M tokens and sequences of length 4,096, and double these values to a batch size of 8M sequences of 8,192 tokens after pre-training 252M tokens. We double the batch size again to 16M after pre-training on 2.87T tokens. We found this training recipe to be very stable

Здесь очевидно, длинный контекст накидывался с лопаты в самом конце, потому что ебать дорого и сложно.

Половина бумаги про сейфти, больше всего понравилось, что False Refusal Rate Relative to Llama 3 cоставляет всего-то +102% со всеми включенными соефикаторами.

> Violation Rate and False Refusal Rate: English -76% +95%

Ага, плюс сто процентов ложных срабатываний, чтобы защититься от трёх четвертей опасного контента. Сексуальный контент, кстати, оба соефикатора чистят на 100%, успех, я считаю. Скоро их включат в процедуру трейна, чтобы наверняка, чтобы уж никак не просочилось.

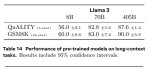

>че та сравнивают

>нет phi-3 и qwen2

Ясна.

https://huggingface.co/bartowski/Meta-Llama-3.1-8B-Instruct-GGUF

Гуф от батрухи. В теории жоре нехуй чинить, это ведь та же тройка немношк подтянутая. Так что проверяйте анальники.

Гуф от батрухи. В теории жоре нехуй чинить, это ведь та же тройка немношк подтянутая. Так что проверяйте анальники.

> Вот смотришь на потраченные ресурсы, на полученный итог и волей-неволей приходят мысли - а это точно лучший результат, который можно получить, вбухивая столько мощностей? Может, уже и архитектуру перепилить пора?

Нормальная архитектура. Если именно просто обучать, чтобы лосс падал на максимально корректных ответах безотносительно сейфти, а не дебилизировать соей и прикручивать дополнительные соефикаторы.

> Половина бумаги про сейфти,

То-то и оно.

а че она такая медленная? предыдущая версия была быстрее

>самая тупая сетка победила в PHP

Закономерность?

>сеть будет правильно отвечать всегда

Нет сынок, это фантастика.

>Может, уже и архитектуру перепилить пора?

Никто там не будет так рисковать.

>Здесь очевидно, длинный контекст накидывался с лопаты в самом конце, потому что ебать дорого и сложно.

Как и во всех остальных текущих сетках.

>Скоро их включат в процедуру трейна, чтобы наверняка

Наверняка они только убьют производительность, лол.

>Нормальная архитектура.

Кусок говна без внутреннего диалога.

Ну Мистраль Large хорош, русский вообще идеальный. Из неприятного - как-то более сухо отвечает по сравнению с ламой и ответы короче, рандома мало. Ещё она как-то неохотно движется по сюжету. Может конечно опять жоровские лупы, но оно как-то слишком сильно за контекст цепляется и иногда повторяет прошлые мысли, хоть и перефразированные. Может надо с промптом поебаться и простых [INST][/INST] вокруг промпта мало. Цензура в районе ламы - ниггера можно, бомбу нет. Уравнения ваши решает. Файнтюнов наверное никогда не дождёмся с таким размером.

Аноники, помогите, я туплю!

Хочу запустить вот эту https://github.com/Sebby37/Dead-Internet фигню с лламой.цпп. Но при запуске она мне пишет

openai.OpenAIError: The api_key client option must be set either by passing api_key to the client or by setting the OPENAI_API_KEY environment variable

В описании предлагают редактировать .env файл, которого нет, либо изменить "client" в ReaperEngine.py файле, но ХЗ как.

Пологике всё должно выглядеть так

>self.client = OpenAI(base_url="http://localhost:5000/v1/", api_key="Dead Internet")

Но это нихуя не работает, всё равно высерает ту же ошибку. Как включить эту хуйню?

Хочу запустить вот эту https://github.com/Sebby37/Dead-Internet фигню с лламой.цпп. Но при запуске она мне пишет

openai.OpenAIError: The api_key client option must be set either by passing api_key to the client or by setting the OPENAI_API_KEY environment variable

В описании предлагают редактировать .env файл, которого нет, либо изменить "client" в ReaperEngine.py файле, но ХЗ как.

Пологике всё должно выглядеть так

>self.client = OpenAI(base_url="http://localhost:5000/v1/", api_key="Dead Internet")

Но это нихуя не работает, всё равно высерает ту же ошибку. Как включить эту хуйню?

Можете ещё Лунарис от этого же автора глянуть, мерж этой версии stheno с парой других тьюнов. https://huggingface.co/Sao10K/L3-8B-Lunaris-v1

Мне понравился, при том, что я не уважаю (не осилил) тройку и stheno удалил почти сразу. Сам автор пишет, что по его мнению этот мерж лучше stheno, и в обсуждении на странице модели народ доволен.

Подкрутил семплинг, выкинул все оставшиеся кишки альпаки, перенеся всё в системный промпт, и вроде прошли лупы. В РП прям на голову выше ламы 70В и её рп-тюнов, и это первая модель, где к русскому претензий вообще нет, можно спокойно рпшить и не кринжовать от странных выражений. Вот и дожили, когда локалка ебёт клауду и гопоту. Скорость хотелось бы чуть повыше, но с 10-12 т/с в целом можно жить, особенно учитывая что свайпать не приходится. Забавно как ламу 3.1 на следующий же день похоронили таким подгоном, я вчера весь вечер проебался с ней и так смог сделать удовлетворительный вариант для рп, а мистраль сходу норм работает.

Из главных проблем ламы 3.1 70В, что я не смог пофиксить - она как будто не останавливается вовремя. Может написать 1-3 нормальных абзаца, а потом выдать ещё один абзац с проёбаным форматированием, просто ложит хуй на проставление *. Или сразу начинает писать без форматирования, или внезапно посреди текста перепутать реплику с нарративом и форматнуть их наоборот. Плюс по ощущениям на инструкции хуже реагирует чем обычная тройка. И это на EXL2, страшно представить что у Жоры там.

Обновил список моделей, добавил новые из тех, что видел в треде: https://rentry.co/llm-models

Если что не так исправляйте/дополняйте.

Если что не так исправляйте/дополняйте.

> Конфиг и генерейшен конфиг у него верные, все что я могу предложить:

Да не, нахер эти костыли, проблема вот в этом с ней короче

Лунарис топчик для кума.

Кобольд обновился и стал поддерживать Мистарль Немо. С одной стороны не хотела сразу давать ответ на расисткую загадку про негра и латиноса в машине и дала только с подсказкой. С другой стороны это у меня первая модель которая на стандартной карточке ассистента Эми была хорни.

Мы говорим не о говнокоде, а о нормальном коде. =)

Говнокод — проблема говнокодеров, тащемта.

Не думаю, что в один ряд с профессионалами стоит ставить васянов с гита.

Предлагаю дебилам перестать отвечать на каждый пост и посмотреть, как засияют гении треда. =)

Нахуй идет не генерация, а тотал.

Норм, качаю.

А причем тут это?

Потолок архитектуры — сильно лучше трансформеры не станут, речь об этом.

Разница между 7б лламой 1 и 72б квеном 2 — огромна.

Но разница между мистраль 123, лламой 405 и гпт-4 — уже не так заметна.

Потому что архитектура выдает что может, и кратное увеличение размера датасета не дает кратное увеличение интеллекта.

Он об этом.

Ну вот практически 100% ожидаемый папир.

Из чего-то непредсказанного разве что эксперты по анализу даты и кода. Ну, норм идея.

Все остальное как по писанному: огромные мощности, мизерный прирост в 1%-2% в тестах, соефикаторы. Да еще и контекст сомнительного качества, хз-хз.

Даже без сои, все равно прирост был бы не таким впечатляющим, как хотелось бы, к сожалению.

> Закономерность?

Как пхп-обезьянка — покекал. )

> Никто там не будет так рисковать.

Мистраль рискнули.

Бесконечный контекст!

2к.

=D

Беда в том, что в 48 гигов уже нормальный квант не влезет.

А три видяхи — слегка дороговато выходит.

Кстати, у меня он работал через раз. Было прикольно но не долго, забей.

localhost:5000

Почему 5000? Уверен, ты апи повесил на 5000 порт?

У меня

self.client = OpenAI(base_url="http://localhost:5792/v1/", api_key="Dead Internet")

При запуске убабуги

--listen --listen-port 5791 --api --api-port 5792

> клауду

А он братана норм отыгрывает?

Ну, по тому промпту.

>Почему 5000? Уверен, ты апи повесил на 5000 порт?

16:16:20-384238 INFO Loading the extension "gallery"

16:16:20-386239 INFO Loading the extension "openai"

16:16:20-482668 INFO OpenAI-compatible API URL:

http://0.0.0.0:5000

Running on local URL: http://0.0.0.0:7888

Думаю, да, угабога по умолчанию с таким портом стартует.

>Было прикольно но не долго, забей.

Во первых интеросно глянуть. Во вторых разобраться как каботает привязка OpenAI к коду, вдруг захочется где-то ещё использовать.

Посоветуйте pls модельку для NSFW RP для запуска на 8гб VRAM.

Пробовал и понравились:

1 Poppy_Porpoise-0.72-L3-8B-Q4_K_M-imat

2 Nyanade_Stunna-Maid-7B-v0.2-Q5_K_M-imat

3 kunoichi-dpo-v2-7b.Q5_K_M

Но.. 1 и 2 хороши в диалоги, но по какой-то причине я там везде скорострел, кек, модельки хорошо все описывают, но в конце того же респонса заканчивают любой интим. Ответы почти всегда довольно короткие, не смотря на настройки. 3 хорошо, но туповата.

Пробовал и не понравились:

Noromaid-7B-0.4-DPO.q6_k

v1olet_marcoroni-go-bruins-merge-7b.Q6_K

L3-8B-Stheno-v3.3-32K-Q4_K_M-imat

Tiger-Gemma-9B-v1a-Q4_K_M

aya-23-8B.i1-Q4_K_M

Не понравились из-за длинного текста, куча болтовни и мало описаний действий\окружения.

П

Пробовал и понравились:

1 Poppy_Porpoise-0.72-L3-8B-Q4_K_M-imat

2 Nyanade_Stunna-Maid-7B-v0.2-Q5_K_M-imat

3 kunoichi-dpo-v2-7b.Q5_K_M

Но.. 1 и 2 хороши в диалоги, но по какой-то причине я там везде скорострел, кек, модельки хорошо все описывают, но в конце того же респонса заканчивают любой интим. Ответы почти всегда довольно короткие, не смотря на настройки. 3 хорошо, но туповата.

Пробовал и не понравились:

Noromaid-7B-0.4-DPO.q6_k

v1olet_marcoroni-go-bruins-merge-7b.Q6_K

L3-8B-Stheno-v3.3-32K-Q4_K_M-imat

Tiger-Gemma-9B-v1a-Q4_K_M

aya-23-8B.i1-Q4_K_M

Не понравились из-за длинного текста, куча болтовни и мало описаний действий\окружения.

П

использую разные модели на ламе 2 и 3 и через десяток сообщений начинается луп почти дословный

мож кто вкурсе чо это и чо делать?

альпак на пигмы итд туды сюда переключал не помогает

контекст более 4К

размер моделей тож не сам малый

мож кто вкурсе чо это и чо делать?

альпак на пигмы итд туды сюда переключал не помогает

контекст более 4К

размер моделей тож не сам малый

Пересаживайся на mistral-nemo-12b, там луп намного позже наступает.

L3-8B-Lunaris-v1-Q4_K_M

а можно без лупа ? раньше казалось что лупа не было а что поменялось не знаю

Системный промт поменяй, тут не в моделях дело. Не всё из твоего списка гонял, но как минимум Stheno и aya-23 нормально чередуют диалоги и описания, если вменяемо оформить инструкции.

В чем разница этой васянской мержи с обычной Stheno?

может ли сеть лупится от нехватки контекста по размеру?

>Нормальная архитектура.

Это буквально ядерный реактор ради лампочки на сотню ватт. Они сами оценивают разницу "надёжности" между 70b и 405b в пять процентов. На длинном контексте - 4.8 процента.

Как говорит один мой знакомый, с хуя жира не натопишь.

>Никто там не будет так рисковать.

Рано или поздно придётся. Хотелось бы раньше.

>Наверняка они только убьют производительность, лол.

По-моему, они уже. Причём основательно так.

>практически 100% ожидаемый папир.

Всё равно просмотреть по диагонали было интересно. Мало ли что.

>Мистраль рискнули

Вполне возможно, что там всё, как gemma-2. Модель под хороший контекст подготовлена, а вот опенсорс код - нет. У неё при окне 4k внимание должно захватывать 131k токенов, если что.

Менять настройки семплера. Min-P на 0.1 и Repetition Penalty на 1.1 или типа того. В предыдущие треды кидали более полный список крутилок, щас уже не вспомню.

> >Llama 3 405B is trained on up to 16K H100 GPUs, each running at 700W TDP with 80GB HBM3

Ррреее дайте хотябы одну, это ведь можно перевернуть текущую дичь, что зовется опенсорсом генеративных моделей.

> Ясно, ванильную лламу для кода лучше не использовать.

Да зря ты, подход вполне нормальный для такого.

> дайте этого эксперта.

> И этого тоже.

Да зачем он тебе, это же просто херька годная для классификации. Там не написано что он создавал, только оценивал и выбирал из имеющегося.

> длинный контекст накидывался с лопаты в самом конце, потому что ебать дорого и сложно

Потому что это единственный путь на данный момент, который у всех.

> Половина бумаги про сейфти

Трешанина ебаная, сразу понятно откуда деньги на то железо.

Красавчик что это притащил.

> Кусок говна без внутреннего диалога.

cringe

> Нахуй идет не генерация, а тотал.

Нахуй идет не только тотал, но и генерация, тотал то в любом случае должен падать из-за дополнительных расчетов. Хз что там у тебя на теслах ускоряется и т.д., на амперах в начале если там 17-18т/с то уже на 7.5к падает до ~12. А еще тормознутая обработка промта к этому потому над тоталом надругается радикально.

Solve this system of equations:

2x-3y+z=-1

5x+2y-z=0

x-y+2*z=3

То решает правильно, то неправильно, и это лучшие сети на сегодняшний день. Какой-то просто кринж.

2x-3y+z=-1

5x+2y-z=0

x-y+2*z=3

То решает правильно, то неправильно, и это лучшие сети на сегодняшний день. Какой-то просто кринж.

Суки, опять ненужное чрезмерно огромное говно выбрасывают в опенсорс, не выкладывая нормальные модели.

Спроси у них что больше 9.11 или 9.9, удивишься спиздил у одного ютубера

Да, ллама 405б обосралась. Другие топовые - норм.

Омни без мини тоже обосралась.

Ну залуп на ламе это проблема известная и решается только одним - переходом на командира.

Как вы получаете эти лупы на лламе3? Ловил в сложных ситуациях когда модель уже не понимала как действовать, но и это были не столько лупы сколько хреновые ответы и предрасположенность к одному пути не туда куда хочешь. Повторений фраз как раньше ни разу не видел, бывает повторение структуры но меняется при свайпах и дольше 3-4 постов не держатся, вымораживая как бывало раньше.

Но коммандир все равно лучше чем тройка, 3.1 надо потестить.

Но пожалуй о светлой теме тоже надо было подумать. Путь будет так.

>Как вы получаете эти лупы на лламе3?

Правильный вопрос - а как их не получать на 8В модели?

На чём запускал, какой квант?

Аноны, что самое топовое потянет пека 12400+64гб+4060ти16гб? Или ничего не привет приличного? Запустил чат ртх от нв, какая-то тупая параша.

>llama 3 rp+ instruct

Что за пресет, откуда его взял?

gemma 27b

а почему не сравнить с апи, а не гадать кто виноват?

а что это от номера Б зависит?

Спасибо, а она способна поддерживать диалог, помня предыдущие сообщения?

Там памяти в 4000 токенов

В API за тебя уже формат промпта прописан, хоть засравнивайся. Там только роль указываешь, а как он расставит специальные токены - загадка. По факту очень часто он выдаёт вот такие ебанутые вероятности - хоть обосрись, но тут будет речь персонажа. Я промптом немного распердолил, но всё равно вероятности иногда пиздец, хоть жить можно, надо ещё будет потом попердолиться. На Ламе 3 такого не было.

Ну и второй доёб есть - мало русских токенов, иногда аж по буквам слова пишет, в итоге скорость можно делить на два.

В остальном это топ по локалкам, даже близко ничего нет, разве что 405В.

>и это первая модель, где к русскому претензий вообще нет

Ты про командира+ забыл. Я у него тоже косяков не припомню.

>но с 10-12 т/с в целом

На чём запускаешь? У меня 104B в притык были, а тут походу придётся разменивать свои 64ГБ на 96, лол.

>Как пхп-обезьянка

Лол, тут все такие?

>Рано или поздно придётся.

Это точно не террористы будут, они ни разу при мне не рисковали. Сейчас скорее китайцы сделают какую-нибудь среволюцию ну или я свои заметки реализую.

>cringe

Хуинге. Без внутреннего диалога модели так и будут срать под себя.

В шапке в вики есть ссылка с пресетами, емнип.

> что больше 9.11 или 9.9

Кстати, Мистраль на этих вопросах не подловить, и уравнения решает и это сравнение.

Т.е. очень мало?

Ну да. Если такой нерешительный, можешь ещё у мамы переспросить, та ли ссылка.

Причём тут мама. Я заимпортил их и не вижу пресета с твоим названием.

Роупскейлом сколько хочешь можно расширить, пока видеопамяти хватит.

Что за сетка?

Продолжение бы, сейчас больше можно лулзов наловить, учитывая как шагнули сетки за год.

https://www.youtube.com/@vonnyai

https://www.youtube.com/@vonnyai

gemma-2-27b

Специально на шизокарточке проверил. Легко и непринуждённо справляется.

> gemma-2-27b

Не файтюн? Чистая?

Я и не писал, что он там есть, лол.

А где есть?

gradient-tinystories-20m.Q2_K.gguf 11MB.

Лучша заглушка для eva чтобы гонять SD.

Лучша заглушка для eva чтобы гонять SD.

Так, оно рили настолько хорошо в рп? Знает ли разные фендомы и вселенные? Понимает ли фетиши и андеграунд культуру? Насколько хорошо подстраивается под юзера и ведет повествование?

Не хочется прерывать задачи чтобы потестить и подгореть с низкого качества.

> на 8В модели

Вот тут хз. По беглым тестам она не лупилась, но катал ее оче мало в теории должно быть то же самое (подходящий формат, нормальная карточка, отсутствие противоречий в промте и постах), только тупее.

> Без внутреннего диалога модели так и будут срать под себя.

Да они и с ним так будут делать.

Для чего-то подобного нужно не генерить токены по одному, и, возможно, вообще отказаться от концепции токенов, а обрабатывать сразу весь ответ по смысловой нагрузке, постепенно его улучшая с шагами, по аналогии с той же диффузией. Но это настолько геморойно, сложно и затратно по вычислениям, что проще на трансформерсах реализовать аналогичное... Ой, а ведь это уже есть, начиная от вариаций кота, заканчивая множественными запросами. Если это еще скрестить с мое в нормальной реализации, или чем-то подобном, то может вообще отлично получиться.

Посматривая на новые модели в 120 и 405B Интересно, будет ли это дружить с обычной материнкой и удастся ли разогнать хотя бы до 6 кеков?

>и, возможно, вообще отказаться от концепции токенов, а обрабатывать сразу весь ответ по смысловой нагрузке, постепенно его улучшая с шагами, по аналогии с той же диффузией

У меня такие же мысли были записаны в тетрадку ещё в прошлом году, лол.

>Но это настолько геморойно, сложно и затратно по вычислениям

Лол, не факт. Если сжимать смыслы чем-то типа VAE, то может выйти даже быстрее, забубенить сразу абзац вместо одного слова.

Да что уж там, вот все 128.

Извинити, у меня DDR5.

Так там у тебя занятная карточка, в пк

48 Gb DDR5 стоят 20к примерно новая,

та же KF560C32RSA-48 и KF560C32RS-48.