Обновил модель в шапке, раз уж так хвалят.

твердо и чётко модели для рп+нищебродов?

кроме мистраль немо хз что назвать

кроме мистраль немо хз что назвать

Бля, а есть аноны с 4080? У меня стойкие подозрения что я где-то сосу бибу. 35-38 t/s для мистрали немо вот в ггуфе q8 через голый лламацпп вгруженной полностью в vram не выглядит как нормальная цифра для меня почему-то.

>кроме мистраль немо хз что назвать

Я русский язык пробовал буквально у всех популярных здесь, от Command-R-Plus до Лламы 3.1 70B, и у кучи мелких. Так вот, все кроме мистралей сильно проёбываются с ним (Микстраль 8x22 кстати тоже). Плохо говорят = плохо понимают, при общении на русском заметно тупее, чем на английском. Короче, меня устроили в этом плане только новые Мистрали.

На 12В? Нормальная скорость для твоего огрызка.

>35-38 t/s для мистрали немо вот в ггуфе q8

ну включи mmq и flashattention. Если уже включены, то вряд ли от настроек сильно ускоришься. Да и так неплохо.

Всё врублено.

Ну я просто спросил на всякий случай шизу свою проверить, которая началась после того как попробовал через exllama2 влезающие веса погонять, начитавшись что тут, что на реддите будто порой чуть ли не в два раза быстрее, и не обнаружил вообще никакой разницы.

> вгруженной полностью в vram

> в ггуфе

Зачем? А так скорость примерно похожа на ожидаемое.

> чуть ли не в два раза быстрее, и не обнаружил вообще никакой разницы

Въеби ему контекста на сколько позволяет врам и посмотри какая будет скорость.

>Въеби ему контекста на сколько позволяет врам и посмотри какая будет скорость.

Ещё бы попасть так чтобы оно не потекло в шаред память.

А так нихуя не меняется особо, пока не протечет хоть мегабай в шаред память, тогд. Всё на уровне 33-38 t/s пляшет. В лламацпп 34-36. Хуйня какая-то, где-то наебка.

>Хуйня какая-то, где-то наебка.

Не, лламаспп давно заоптимизирована по самое немогу. Прошли те времена, когда эксллама всех рвала.

> заоптимизирована по самое немогу

Сильное заявление. Она все еще жрет на 10-20% больше врама на контекст? Она все еще подыхает по скорости генерации на большом контексте? Она все еще выдает более всратый результат чем эксллама с нормальными семплерами (да)?

Почему-то уверен что ответ на все вопросы утвердительный, а в возражения только катания никому не нужного микстраля с микроконтекстом.

Тестил в прошлом месяце на амперах и адах, все было печально. Ну как печально, оно работает, но стабильно уступает. С мультигпу еще замедление контекста сильнее ощущается. Жирный мистраль на бывшей - ну да, ожидание заметно но терпимо, иногда на эндпоинтах также бывает, он же на llamacpp - чуть ли не на минуту можно идти чай наливать.

> Прошли те времена, когда эксллама всех рвала.

Никуда не делись, интенсификация самоподдува не меняет реальность.

Ну вот с exlamma единственная проблема выходит в том, что если ты не элита с пачкой 16/24GB видях в компудахтере, или хотя бы одной на 24, то с ней можно обычно разве что пососать жопу или сидеть грустно смотреть на модели с ICQ голубя.

к сожелению не работает. на 23 метрах остоновилось

Форк кобольда c расширенными настройками, судя по пулл реквесту, который жора телится завести, разраб франкенкобольда уже инкорпорировал его.

https://github.com/Nexesenex/kobold.cpp

На русском для нищебродов вариантов всё ещё нет, разве что корпораты. Есть гемма 27В, но там 4к контекст уже желательно хотя бы 16гб врам, так что это уже не нищеброд, а скорее крестьянин.

eva

phi3

qwen2 тюны

>phi3

Засоена по самое не могу, для РП не подходит.

Аноны, тред не читал @ сразу задавал

Какими квантами сейчас пользоваться, EXL2 или GGUF

На морде повсюду GGUF, разве это жораподелие еще актуально?

Какими квантами сейчас пользоваться, EXL2 или GGUF

На морде повсюду GGUF, разве это жораподелие еще актуально?

Я могу немо 12 без квантования уместить в 16 VRAM?

Может через какие-то галочки?

Может через какие-то галочки?

Для кума на одной 4090 какую модельку выбрать? Важно чтобы калтекст 16к минимум

Разумеется актуально, если у тебя нет 2-4 3090/4090 - то exl2 который не может в адекватный оффлоад слоев на процессор не для тебя.

Тигрогемма 27В в 4 бит. Контекст растянешь роупом - я до 24к растягивал без проблем.

Нет, а нахуя тебе без квантования? 8 бит от 16 бит не отличается вообще, кроме того что в два раза память экономит, так что если хочешь шикануть - грузи в 8 бит, кстати можешь грузить в 8 бит оригинальные неквантованные веса.

Она же дико тупеет на контексте ближе к 8к. Хоть сколько тяни, лучше контекст она не начинает держать с фиксированным окном.

Ты роуп настраивал?

Так как он тебе поможет, если окно у аттеншена всегда 4к.

Чел, ты вообще понимаешь как окна у аттеншена работают? Причём тут вообще твоя ропа? У геммы нет глобал аттеншена, в отличии от остальных моделей.

Если можешь выгрузить все слои модели на GPU, то exl2 подходит идеально. Если нужно запускать только на CPU или GPU+CPU, то GGUF.

> жораподелие еще актуально

Оно всегда будет актуально пока существуют бедолаги не имеющие достаточное количество врам, а также глупцы, не желающие разбираться.

Если у тебя хватает памяти - только exl2. В настоящий момент нет ни единого повода юзать жору, раньше была мику только в gguf, но актуальность потеряла.

Кстати забавный случай буквально недавно, при запуске человеком был скачан жора q5 и модель перформила странно, игнорила инструкции и писала какой-то бред уже в первых сообщениях, тогда как у себя показывал что все ок работает. После исправления ошибки посты внезапно в норму пришли. Ну и что после этого думать, шутки про поломанные кванты и кривую работу до сих пор не шутки?

Он и в 24 не влезет в фп16. В 8 битах грузи или в 6 если нужен контекст.

> У геммы нет глобал аттеншена

Почему тогда она проходит тест извлечения фактов из большого контекста?

Либо ты чего-то не понимаешь, либо люди на реддите врут что у них работает роуп на гемме и я свои скрины с 24к контекстом пару тредов назад подделал(неясно только зачем).

Поясню для ньюфагов - Exl2 это форс владельцев 3090/4090 для травли теславодов, которые exl2 пользоваться не могут. При наличии топовой видеокарты(не Теслы) на самом деле неважно чем ты пользуешься - exl2 и gguf выдают одно и то же на хорошей скорости(exl2 быстрее, но когда скорость превышает 30 т.с. это уже неважно - 35 т/с у тебя или 50 т/с), а единственный запруфанный косяк gguf был с третьей ламой.

Мимо-владелец 4090

Мимо-владелец 4090

> Почему тогда она проходит тест извлечения фактов из большого контекста?

Покажешь эти тесты? Почему же тогда сам гугл через API больше 4к не даёт?

>Почему же тогда сам гугл через API больше 4к не даёт?

Потому что роуп действительно немного ухудшает показатели у любой модели и по апи его обычно не предоставляют.

Какие юз кейсы у локалок кроме рп? Бесполезная хуйня по сути игрушка. В чем я не прав?

Во всем прав, теперь уебывай в айциг

>Какие юз кейсы у локалок кроме рп?

Точно такие же как у условной гопоты.

>Это платиновый вопрос?

да, я пробовал гемму у неё форматные лупы происходят и соя иногда протекает

> Покажешь эти тесты?

Если лень не будет. В пределах заявленных 8к в рп оно не теряется, исходные инструкции что в самом начале и описание чара не забывает, на вопросы о происходящем ранее отвечает.

> через API больше 4к не даёт

Причин может быть множество

Все те же что и у не-локалок. И если у тебя вдруг нет сотни ключей, которыми готов пожертвовать, а нужно массово обработать много текстов - локалки безальтернативны.

Ну я кумер, но пользуюсь курткой для RAG по рабочим докам

Вот чего мне лично не хватает в локалках так это функсион колинг. Чатгпт умеет сам запускать питон енву в юпитере, и сам же дебажить. Ваши локалки так могут нахуй? Если тебе не кодинг а офис, то тоже с питоном можно любую таблицу скинуть он тебе график нарисует. Ладно хуй бы с юпитером, но есть же плагины вроде вольфрама, на кой хуй натаскивать модель по матешу если ей в руки можно калькулятор дать? Почему нихуя попен сорс разработок по этой теме нет?

Я понял почему богатые тредовички так горят с роупа.

Кажись говнокод exllama exl2 НЕ ПОДДЕРЖИВАЕТ нормальный роуп скейл в отличие от божественного жоры и сверхбожественного кобольда, который еще и считает правильные параметры автоматически. Т.е. эти дурачки НЕ МОГУТ запускать модели с контекстом выше чем барин разрешил, а бомжи на жоре могут.

ПРУФ - https://github.com/turboderp/exllama/issues/262

Кажись говнокод exllama exl2 НЕ ПОДДЕРЖИВАЕТ нормальный роуп скейл в отличие от божественного жоры и сверхбожественного кобольда, который еще и считает правильные параметры автоматически. Т.е. эти дурачки НЕ МОГУТ запускать модели с контекстом выше чем барин разрешил, а бомжи на жоре могут.

ПРУФ - https://github.com/turboderp/exllama/issues/262

> сам

Не сам, к нему наделали обвязку, которая позволяет это делать.

> Почему нихуя попен сорс разработок по этой теме нет

Есть. Почти год назад видел такое на гите, но любую сетку можно было подключать, но весьма корявое. Сейчас и сетки умнее, и есть с доп токенами на вызовы, скорее всего должно быть на уровне.

Но в целом готовым решением мало занимаются потому что кто шарит просто делает себе это из агентов или самописное или на готовых движках.

> ишьюз годовалой давности

Оно берется из конфига и скейлится, чел.

А стиль поста - 10 поломанных квантов из 10, аутотренинг засчитан.

>> ишьюз годовалой давности

Открытый до сих пор, с обсуждением которое заканчивается на "Ну надо короче две недельки в ударном темпе поработать и запилить эту хуйню". Не запилили до сих пор.

>Оно берется из конфига и скейлится, чел.

Ничего оно не скейлится, exl2 гемма с 32к контекстом на любых настройках выдает рандомный набор слов, gguf запущенный на франкенкобольде выдает связный текст с отыгрышем РП.

Не могут, уебывай из треда обратно на гопоту

Анон, увеличил контекст Немо в угебуге, он ни на что не ругался, но выдает лютую галлюцинацию, я подозреваю что контекст таки не влез в мой врам. Я конечно скачаю квант ниже, но вопрос -- как блять проверять сколько контекста я могу скормить без галлюнов ебучих? Как вычислить эти протеины ебучие (размер контекста).

>угебуге

Это ни о чем не говорит. Через что запускаешь в самой убе? Экслама или лама.цп? Квант какой - exl2 или gguf?

>выдает лютую галлюцинацию, я подозреваю что контекст таки не влез в мой врам

Одно с другим не связано, если бы он не влез в твой врам ты бы охуел с падения скорости до 0.1 т/c.

>но вопрос -- как блять проверять сколько контекста я могу скормить без галлюнов ебучих?

Эмпирически. Открываешь диспетчер задач на вкладке производительность/видеокарта и смотришь сколько видеопамяти занято.

Протип - можно квантовать кэш и увеличивать тем самым доступный тебе размер контекста. Квант кэша до 8 бит уменьшает размер конекста в памяти в 2 раза, квант до 4 бит - в 4 раза.

> Открываешь диспетчер задач на вкладке производительность/видеокарта и смотришь сколько видеопамяти занято.

Спасибо анон, я просто думал есть какая-то грубая оценка

Квант кэша до 8 бит уменьшает размер конекста в памяти в 2 раза, квант до 4 бит - в 4 раза.

Я пытался проделать это с exl2 через ExLlamav2_HF загрузчик, но не сработало.

Спасибо, пойду тестить

>не хватает в локалках так это функсион колинг

Уже завезли.

Вызов функций с помощью LLM

https://habr.com/ru/companies/mts_ai/articles/831220/

> Новая версия мистраля mistralai/Mistral-7B-Instruct-v0.3 теперь также поддерживает function calling с помощью библиотеки mistral_inference

OpenSource на поле против OpenAI: Function Calls здесь и сейчас для самых маленьких… ресурсов

https://habr.com/ru/articles/833518/

>Я пытался проделать это с exl2 через ExLlamav2_HF загрузчик, но не сработало.

А что не сработало-то? 4 бит может быть нестабилен, 8 бит должен работать без проблем.

Сорян, оказывается все работает, это через ггуф ебучий 8бит кэширование не работало

>это через ггуф ебучий 8бит кэширование не работало

Все там работает. Ты наверняка с настройками обосрался - flash-attention не включил, например. Для таких как ты кобольд и придумали, он не позволяет включить квант кэша если у тебя настройки неверные.

> flash-attention не включил, например

именно так все и было

Посмотри на его соседей и пойми к какой категории он относится, не все девы занимаются ликбезом.

> exl2 гемма с 32к контекстом на любых настройках выдает рандомный набор слов

Ой ну ля пиздабол. Почему-то все она умеет, и большой контекст, и выполнить инструкцию из самого начала, и проживать плейнтекст копипасту прошлого треда, и даже указание из самого конца не забывает. И ведь рили довольно неплохо ответила.

На скорость не смотри, в одну гпу без выгрузки оно не помещается. Хотя с учетом обработки контекста ггуфом может и не так плохо оказаться, лол.

Вообще, тема интересная. Во многих случаях реально проще дать нейронке готовый инструмент, чем пытаться заболтать её промптами на то, во что она априори не может. Думаю, это направление будет развиваться, потанцевал тут огромный на самом деле.

> Чатгпт умеет сам запускать питон енву в юпитере, и сам же дебажить. Ваши локалки так могут нахуй?

Могут, нахуй! Копрософт AutoGen или MetaGPT в помощь.

> на кой хуй натаскивать модель по матешу если ей в руки можно калькулятор дать? Почему нихуя попен сорс разработок по этой теме нет?

Канкулятор есть даже в обнимордовском чате в стандартных инструментах, только галку поставить.

> Чатгпт умеет сам запускать питон енву в юпитере, и сам же дебажить. Ваши локалки так могут нахуй?

Могут, нахуй! Копрософт AutoGen или MetaGPT в помощь.

> на кой хуй натаскивать модель по матешу если ей в руки можно калькулятор дать? Почему нихуя попен сорс разработок по этой теме нет?

Канкулятор есть даже в обнимордовском чате в стандартных инструментах, только галку поставить.

>Квант кэша до 8 бит уменьшает размер конекста в памяти в 2 раза, квант до 4 бит - в 4 раза.

А есть деградация понимания или производительности? А то у меня вариант - или 2,75BPP но с восьмибитным кэшем, или 2,5BPP с полным. С восьмибитным правда с 2,5BPP ещё больше контекста влезет. Велики ли потери?

> Совсем пылесос получился или норм?

Не норм, громковато.

В подвал спущу, как доделают.

Я сторонник Немо, Мини-Магнума и Ларджа, но, Гемма 27 все же получше Немо в некоторых задачах, за счет размера.

Однако лично для меня применения она не снискала.

На современной карте можно поднять вллм, эксл2, трт и т.д.

Зачем ггуф-то?

ллама.спп онли для тесл и процов.

Если целиком влазит в видяху — ебашь эксл2.

Тоже 35-38?

Бля, хз 6.4 бпв на 4070ти выдает 39-42 токена/сек. Но тут сравнение кривое, квант не тот, ядро не то… Фиг знает. =(

Тащемта, она обновляется позже, не имеет преимуществ и фичи завозит позднее… Типа, да, может по скорости норм, но есть другие причины сидеть на бывшей. По мелочи. в основном, конечно.

Да.

Да не, пруфанных косяков с жорой дохуя, если честно.

Если че, я теславод в т.ч.

Кек.

bpp?

bpw?

Если 2.75 бита на вес против 2.5, то ты угараешь, что ли?

Модель и так слюни уже пускать скоро начнет, ужми контекст в 8 бит, хуже не будет. При таком раскладе даже в 4 бита — будет все еще лучше, чем 2,5-битная модель. х)

Тьфу, BPW конечно же.

2,75 против 2,5 - такая большая разница?

Аноны!!! Выручайте плиз!!!!!!!!!!

Почему у меня не запускается gemma-2-27b-it-Q4_K_M.gguf??? ПК: RTX 4070 12Gb, 128Gb RAM

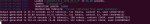

Пробую запустить через koboldcpp-linux-x64-cuda1210 и получаю ошибку:

llama_kv_cache_init: CUDA_Host KV buffer size = 655.00 MiB

llama_kv_cache_init: CUDA0 KV buffer size = 851.50 MiB

llama_new_context_with_model: KV self size = 1506.50 MiB, K (f16): 753.25 MiB, V (f16): 753.25 MiB

llama_new_context_with_model: CUDA_Host output buffer size = 0.98 MiB

ggml_backend_cuda_buffer_type_alloc_buffer: allocating 1431.85 MiB on device 0: cudaMalloc failed: out of memory

ggml_gallocr_reserve_n: failed to allocate CUDA0 buffer of size 1501405184

llama_new_context_with_model: failed to allocate compute buffers

gpttype_load_model: error: failed to load model '/models/bartowski/gemma-2-27b-it-GGUF/gemma-2-27b-it-Q4_K_M.gguf'

Load Text Model OK: False

Error: Could not load text model: /models/bartowski/gemma-2-27b-it-GGUF/gemma-2-27b-it-Q4_K_M.gguf

Что не так? Какие настройки нужно крутить?

Почему у меня не запускается gemma-2-27b-it-Q4_K_M.gguf??? ПК: RTX 4070 12Gb, 128Gb RAM

Пробую запустить через koboldcpp-linux-x64-cuda1210 и получаю ошибку:

llama_kv_cache_init: CUDA_Host KV buffer size = 655.00 MiB

llama_kv_cache_init: CUDA0 KV buffer size = 851.50 MiB

llama_new_context_with_model: KV self size = 1506.50 MiB, K (f16): 753.25 MiB, V (f16): 753.25 MiB

llama_new_context_with_model: CUDA_Host output buffer size = 0.98 MiB

ggml_backend_cuda_buffer_type_alloc_buffer: allocating 1431.85 MiB on device 0: cudaMalloc failed: out of memory

ggml_gallocr_reserve_n: failed to allocate CUDA0 buffer of size 1501405184

llama_new_context_with_model: failed to allocate compute buffers

gpttype_load_model: error: failed to load model '/models/bartowski/gemma-2-27b-it-GGUF/gemma-2-27b-it-Q4_K_M.gguf'

Load Text Model OK: False

Error: Could not load text model: /models/bartowski/gemma-2-27b-it-GGUF/gemma-2-27b-it-Q4_K_M.gguf

Что не так? Какие настройки нужно крутить?

>Может через какие-то галочки?

А галочки что по твоему должны, А100 тебе в компьютер доставлять? Есть галочки загрузки в 4 и 8 бит, лол, но это будет хуже квантования, ибо это квантование без матриц влажности и прочей новомодной хрени.

>а единственный запруфанный косяк gguf был с третьей ламой

Там и командир был задет, просто он умнее лламы, и лучше восстанавливался от неверных токенов.

Могут, но нет.

>Думаю, это направление будет развиваться, потанцевал тут огромный на самом деле.

Там саму парадигму менять нужно, ну да ладно, всем похуй.

>ggml_backend_cuda_buffer_type_alloc_buffer

>out of memory

Прозрачно намекает на маленький член размер видеопамяти.

И что у тебя со скринами? Я слышал рофлы про шрифты в люнупсе, но это уже полный, тотальный пиздец.

gpu layers на 0 ставь для начала, потом уже будешь количество слоев подбирать

Ну и threads не 3 ставь, а количество физических ядер в процессоре -1, но это если без выгрузки 80 процентов слоев на видеокарту. Если почти все слои выгружены, то 3 ядер хватит.

Хули у тебя галочки гойдовские

Вернулся к LLM-куму, опять. Какая сейчас лучшая 70b модель? Euryale 2.1 сыпет геями и гендерквирами в одном из моих тестовых вопросов и много отказывает. Sunfall 0.2 на первых взгляд заебись и ее автор базирован. Есть что-то лучше?

Лучше всех Claude Opus

> с восьмибитным кэшем

Да все сейм там, работает хорошо. 4бит раз попробовал - оно тупило дико, но там и задача была непростая, может так совпало.

> 2,75

> 2,5

Это совсем лоботомиты, поведение может быть непредсказуемым. Но здесь увеличение битности кванта будет играть наибольшую роль.

> failed to allocate

Очевидно же оом. -1 в слоях случаем не интерпретируется как все? Поставь 10 для начала и глянь сколько врам скушает, повышай пока не упрешься. Потом откати на несколько обратно, загрузи с нужным контекстом и отправь вообще любой запрос чтобы он пошел обрабатываться - потребление врам вырастет и уже увидишь сколько оно будет кушать с контекстом, соответственно скорректируешь число слоев.

Да, вот такой ебучий пердолинг, лучше не придумали. Может кто-то добрый пройдется и составит таблицу размер модели - размер контекста - потребление врам, а там уже зная свою и количество слоев в модели можно будет вычислять сколько можно выгружать.

Шрифты знатно попердолило.

Попробуй магнум 72, его вроде хвалили.

Аноны, а если бы вам предложили выбрать ДВЕ модели вот из этих, то какие бы вы оставили из списка? Остальные все удаляться.

gemma-2-27b-it-Q4_K_M.gguf

Qwen2-7B-Instruct

Meta-Llama-3.1-8B-Instruct-Q8_0.gguf

Mistral-Nemo-Instruct-2407-Q8_0.gguf

gemma-2-27b-it-Q4_K_M.gguf

Qwen2-7B-Instruct

Meta-Llama-3.1-8B-Instruct-Q8_0.gguf

Mistral-Nemo-Instruct-2407-Q8_0.gguf

>Ой ну ля пиздабол. Почему-то все она умеет, и большой контекст, и выполнить инструкцию из самого начала, и проживать плейнтекст копипасту прошлого треда, и даже указание из самого конца не забывает.

Ну показывай тогда как роуп настройки выставил для этого случая.

Если квант ниже четырех битов - то там падение качества от падения битности растет по экспоненте.

Разница же по качеству между 8 бит и 16 бит настолько несущественна, что всегда стоит использовать 8 бит, даже если есть возможность использовать 16.

Как тебе вообще пришло в голову сравнивать 7В и 27В?

Просто не думая альфа=8, офк по-хорошему нужно подбирать значения.

Алсо от такого вдвойне удивляют заявления про 4к контекста и глобального внимания, ведь в таком случае оно бы или забывало исходную инструкцию, или не видело бы последние токены и выдавала бы полный бред, как и бывает при превышении. Может кто умный пояснить?

>Попробуй магнум 72, его вроде хвалили.

Судя по UGI лидерборду выглядит не очень. Он точно не соевый?

>-1 в слоях случаем не интерпретируется как все?

Это автомат, релиз ноуты можно почитать.

>размер модели - размер контекста - потребление врам

Разные модели жрут разный объём на кек контекста, пример командир+.

Я скачал:

Mistral-Large-Instruct-2407.IQ3_S.gguf.part1of2

Mistral-Large-Instruct-2407.IQ3_S.gguf.part2of2

И как их конкатенировать? Если пробовать запустить с одной частью то пишет:

llama_model_load: error loading model: tensor 'blk.44.ffn_up.weight' data is not within the file bounds, model is corrupted or incomplete

Mistral-Large-Instruct-2407.IQ3_S.gguf.part1of2

Mistral-Large-Instruct-2407.IQ3_S.gguf.part2of2

И как их конкатенировать? Если пробовать запустить с одной частью то пишет:

llama_model_load: error loading model: tensor 'blk.44.ffn_up.weight' data is not within the file bounds, model is corrupted or incomplete

> Это автомат

Хуеватый автомат выходит. Не пользуюсь кобольдом, потому и хз.

> Разные модели

Можно сделать для большинства а для особенных уже звездочку оформить. Или поискать вдруг уже сделано.

>Зачем ггуф-то?

Да в exl2 тоже гоняю, когда влезает и контекст в овердохуя не нужен. У меня тут моделей на терабайт от 2B до 70B.

>Бля, хз 6.4 бпв на 4070ти выдает 39-42 токена/сек

44-46 на таком кванте в эксламме2 через вебуи, в хуйне жоры на 2048 батче до 48-51 разгоняется на 6.5 бпв кванте. Ничего непонятно, но очень интересно, короче.

Немо.

qwen2 китаеговно

3.1 ллама соевая и ей только стандартные нормис таски решать/function calling, соевая и много где тупая

gemma2 27b хороша, но 27b, а я не 4090 элита, да и на q4 у неё ICQ падает уже близко к 12B

Немо очень неплоха в куче задач и RP для своего размера, топ 1 знание и понимание русского из всего диапазона 2-27b, влезает на мое нищеговно за 170к по последним ценам сука блять

>Хуеватый автомат выходит.

Так он для винды сделан, и там кое как работает. А тут линукс. Я очень сомневаюсь что прога смогла вытащить размер врам и рам и рассчитать правильно количество слоев. Поэтому -1 выгрузило неправильное количество слоев и кобальд упал с ошибкой оом, все логично.

>Я скачал:

>Mistral-Large-Instruct-2407.IQ3_S.gguf.part1of2

>Mistral-Large-Instruct-2407.IQ3_S.gguf.part2of2

Что это блять, где ты нашёл и нахуя скачал?

> влезает на мое нищеговно за 170к по последним ценам сука блять

Ебать это что?

Наоборот на прыщах оно бодрее и экономичнее, как правило.

> вытащить размер врам

Элементарно

> рассчитать правильно количество слоев

Вот тут фейл. Возможно модель отличается от дефолтных, но у геммы контекст довольно экономичный.

>Ебать это что?

Это столько последний раз в днсе моя 4080 гигабутовская стоила, когда смотрел, но брал я её, конечно, ещё за 115. пиздец жалею что жаба задушила и не взял тогда 4090 какую-нибудь

Хотя это пик был какой-то ебанутый, прям последняя цена 150 с копейками, 4080 супер хуюпер такая сейчас 145к

Сап, какой фаинтюн Геммы посоветуете для бомжа 8гб врам/64 рам? Или ещё что сейчас из актуального есть. Гемму ещё никакую не пробовал

Вот что нарыл, по теме срача о хуевости современных нейронок и архитектуры. Выглядит как что то годное и еще толком не реализованное.

В каком то таком направлении и стоит копать, наверное.

Но что на счет сложности вычислений и обучения, не ебу

https://en.wikipedia.org/wiki/Spiking_neural_network

В каком то таком направлении и стоит копать, наверное.

Но что на счет сложности вычислений и обучения, не ебу

https://en.wikipedia.org/wiki/Spiking_neural_network

Тигра ставь, тигр ебет.

Он с таким железом очевидно там у него не топ проц с DDR5 на 7000 будет на тигра в 1 t/s смотреть.

Бле, а DRY с exlammav2 работает?

Большая гемма в 4 кванте гигов 14,+ контекст, + половина слоев на видимокарте

Даже на ддр4 на голом процессоре будет чуть больше 2 токенов в секунду, может и едва 3 вытянет, с видимокартой токенов 5-6 в секунду на генерации получить может, теоретически конечно

Два чая, буду траить.

>Большая гемма в 4 кванте гигов 14,+

> model size = 15.50 GiB

Флеш аттеншн с квантованием нормально не работают, текущая реализация смерженная в франкенштейна убивает скорость процессинга промпта нахуй.

На 5900x/ddr4 3600/4080 c в 12 тредов с KV и слоями в RAM чтобы влезть в 8гб врамы в упор, через 2к контекста это превращается уже в чудовищно медленный prompt eval по 45-55 секунд на 2к токенов и семплинг в ~1.8-2.2 t/s. На голом проце 1.8 макс. Ниже q4 спускаться смысла ноль, гемма 27б там превращается в овощ хуже геммы 9B q8.

сап, что быстрее exl2 или gguf? стоит пробовать применить exl2 на системе 8врам/32рам? до этого гонял только gguf

как лучше для скорости: целиком засунуть все слои модели в врам, а контекст чтобы как получиться перетаскивался между остатками врам и рам?

чтобы поставить exl2 модель нужно качать все файлы model-0000Х-of-0000У.safetensors ?

в llama.cpp - streaming_llm опция рабочая или нет, сколько её траил модель начинает иногда выдавать какой-то бред

Как то мало, думал от половины слоев на видеокарте будет больше толка. Это кобальд или ты ллама сервер запускаешь?

Кстати не ставь все ядра, это ощутимо тормозит генерацию. С твоей скоростью рам хватит 6-8 на генерации, максимум 11, обработке промпта все 22 бахнуть можешь

Какие нынче модели можно под 4080+64озу и рп/ерп? Сейчас сижу на Miqu-70B-q5

>чудовищно медленный prompt eval по 45-55 секунд на 2к токенов

Получается, на жоре быстрого промпт эвала вообще нет? Пиздос.

> exl2

> быстрее

но

> на системе 8врам/32рам

она юзлесс. Почитай вики, этот формат только для гпу, ничего не выгружает. Что в 8 гигов влезет (7б, может 12 в кванте-лоботомите) то и будет работать.

> целиком засунуть все слои модели в врам

Это всегда быстрее, но только чтобы не было переполнения

> нужно качать все файлы model-0000Х-of-0000У.safetensors

Вообще всю папку с весами и конфигами, по одиночке их никто не качает, гит или хфхаб.

> е ставь все ядра, это ощутимо тормозит генерацию

Шо, опять это?

> на жоре быстрого промпт эвала вообще нет?

Если все слои на видеокарте то оно достаточно быстро (сотни-тысячи т/с). Но с этими васян-коммитами и прочим может быть что угодно, а так флешаттеншн должен как минимум не вредить.

>Шо, опять это?

?

Не раз это обсуждали год назад, нужно оставлять одно ядро свободным

Тебя не смущет что в том же кобальде предлагает автоматически распознавая ядра, -1 физическое?

Гиперпотоки бесполезны как и выбор всех ядер, если скорость генерации в основном идет от процессора и он долбится в 100

> нужно оставлять одно ядро свободным

Да чет все одна хуйта в пределах погрешности, или специфичные для архитектуры вещи. Какой-то поех не смотря на все аргументы свою мантру про ведра и прочее твердил, потому и запомнилось.

> скорость генерации в основном идет от процессора

От скорости рам и эффективного доступа к ней

> долбится в 100

Значение знаешь?

>или специфичные для архитектуры вещи

У меня так, ну а вобще рекомендую всем кто не пробавал поиграться с параметрами запуска что бы понять где генерация лучше

>Какой-то поех не смотря на все аргументы

Не помню никаких аргументов против, за то помню что были согласные с таким подходом

Поех тут ты раз думаешь что твоя ситауция распространяется на всех.

Серьезно, даже в llama.cpp рекомендуюется то же -1 ядро. Потому что лучше оставить системе и другим прогам свободное ядро, так как нейронка не любит когда один из потоков тормозит.

Всеэто очевидно для обладателей отсутствия больших врам

думал от половины слоев на видеокарте будет больше толка

По факту выходит меньше чем половина, 23 из 47 никаким хуем и близко в 8гб не влезают, максимум 20-21/47 в моём случае, ещё то надо учитывать что полгига-гиг спокойно той же виндой сожраться может на браузер и прочую хуйню.

> Это кобальд или ты ллама сервер запускаешь

Кобальд, голая лламацпп, webui. Цифры одинаковые практически.

>Кстати не ставь все ядра, это ощутимо тормозит генерацию.

От проца и фоновой загрузки зависит, офк. У меня после 8 на самом деле почти не влияет в большинстве случаев, а когда разница есть, то в рамках погрешности. Сейчас посидел подрочил на скольки лучший результат, стало в среднем на 0.2 лучше к тем результатам. Можно ещё, конечно, с размером батчей и прочим поиграться, но мне впадлу уже.

Если хоть один слой или KQV вылетает в RAM, то наслаждайся ожиданием. Тут хотя бы обычно спасают всякие контекст шифты в кобольде и StreamingLLM в вебуи, если регенеришь или руками правишь что-то.

> помню никаких аргументов против

То есть замеры на классической колцевой шины штеуда, новом амудэ и гетерогенном профессоре - не аргументы? Ну ахуеть.

Там куда больше будет планировщик шинды хуярить, и это -1 или просто повторение за кем-то, как шизы вторили за каломазом, или какой-то костыль чтобы старой десятке было легче раскидывать потоки.

По факту же там после 4-5 потоков прирост прекращается и изменения отсутствуют, как и рост тдп. Ручное название потоков на конкретные ядра чаще приводит к замедлению.

И при любом раскладе это треш т.к. дает ужасную производительность, 2 умножить на 0.

Ну я не все срачи по этой теме помню/застал

Вобще все так, при среднем проце и скорости рам после 4-6 потоков рост скорости не значительный так как идет упор в память

Помню владелец ддр5 с каким то мощным камнем писал что у него рост скорости не заканчивался на последнем ядре, 12 что ли

У меня например на 7 потоках быстрее чем на всех 8, поэтому для меня это работает. Да и приятней когда комп не тормозит от нейронки и можно в том же инете посидеть

> после 4-6 потоков рост скорости не значительный так как идет упор в память

Ну да, в зависимости от проца и рам может быть небольшой прирост от повышения, вот и все.

> на 7 потоках быстрее чем на всех 8

Ни разу не было продемонстрировано. Вероятно что подобное может быть связано с работой планировщика системы, у тебя старая десятка?

> приятней когда комп не тормозит от нейронки

Никак не связано, упор в подсистему памяти, 1 свободный поток вообще не сделает погоды.

Просто видимо у меня, как и у некоторых, баланс смещен в сторону упора в проц, поэтому и вылезают такие нетипичные косяки

Ну и винде года 4, хуй знает может и она срет

>> на 7 потоках быстрее чем на всех 8

>Ни разу не было продемонстрировано.

>У меня например на 7 потоках быстрее чем на всех 8, поэтому для меня это работает

Мимо анон с 5800x, если въебать во все потоки, то это автоматом отсосос хуя с заглотом и потерей до 40% перфоманса. Самый высокий при 5, 6 и 7 на 10% медленнее в рамках погрешности, при 8 как уже сказал очевидный хуй во рту. Фоновой нагрузки никакой почти нет. срал лично лизе су под дверь за этот кусок камня

Довольно странно, упор в проц там только при обработке промта должен быть ибо расчеты.

> винде года 4, хуй знает может и она срет

Ну не то чтобы срет, просто по-старому распределяет и так работает с подобной нагрузке. Весьма вероятно что на разных будут существенные отличия.

Надо эту штуку на мешгриде затестить из интереса как-нибудь.

Система?

> с 5800x

> срал лично лизе су под дверь за этот кусок камня

Да ладно, один из самых удачных камней от красных и в целом за последние годы. Хотя может и действительно он срет, в играх смт же за все время так и не подебили полностью а все от планировщика и в самом коде.

>Да ладно, один из самых удачных камней от красных и в целом за последние годы.

Пока не столкешься с прикольными приколами из-за того что в нём 1 CCD, что были всратые варианты где CCD физически не один, но включен только один вызвая редкие инетересные эффекты, что у кучи экземпляров проблемы с тем чтобы стабильно работать на 3600 памяти при 1:1 частоте фабрики, которые или не решаются в принципе, или поиском магических чисел напряжений, или поиском магически подходящик плашек, но про разгон выше дефолтных значений тогда можешь в принципе забыть и так далее и тому подобное.

>Система?

11 pro, 23H2, если ты про ось

Прикол у меня скорее просто в том, что при нагрузке на большинство ядер или тем более все начинает задыхаться нахуй дропая частоты.

Блеее, серьезно? Ну Лиза, ну залила.

> при нагрузке на большинство ядер или тем более все начинает задыхаться нахуй дропая частоты

Мдэ. А если уменьшать оно не ускоряется случаем?

Забавно, у меня на всех 8 просадка процентов 10, ну а рост с 6 по 7 те же процентов 10 где то

Так что я иногда если нагружаю комп и 6 оставляю, так как если нейронку запустить при загруженом лишнем ядре будет заметно тормозть генерация.

Я так понимаю генерация требует синхронной работы ядер, и если одно загружено чем то хоть немного, то все ядра будут работать со скоростью самого медленного

>Мдэ. А если уменьшать оно не ускоряется случаем?

Ну как и написал, все == пиздец, лучше всего на 5, 6-7 примерно одинаково и чуть хуже чем на 5. Условно

5 -- 4.10 t/s

6 -- 4.0 t/s

7 -- 3.9 t/s

8 -- от ~3.2 до порой ~2.0 t/s

Такая хуйня в среднем условно, но может плясать туда сюда. В идеале надо, конечно, брать голую винду и гонять, но я лучше дальше в 5 ядер буду инференсить нейродевок.

>Я так понимаю генерация требует синхронной работы ядер, и если одно загружено чем то хоть немного, то все ядра будут работать со скоростью самого медленного

Есть такое дело. Но факторов очень до пизды то на самом деле может быть.

Да и параллелизация штука сама по себе далеко не всегда линейная то.

Ну и рандомный фактор в виде очередной хуйни от жоры в очередном билде никто не отменял.

Вообще рязани с одним CCD/CCX это такой себе выбор для инференса ллмок на проце по причине по факту уполовинивания скорости записи в раму, который по идее более низкие задержки нихуя не покрывают.

Бля, аноны, накидайте каких-нибудь пиздатых карточек или сценариев для кума. Нихуя больше не вставляет, ни дочки матери, ни ваниль, ни рейпы во всех вариациях. Два часа щас скроллил чуб, там один плесневелый кал и одни и те же сюжеты с сестрами, девочками-готками и пидорами.

Можете просто ссылки на свои любимые карты скинуть, или на авторов с того же чуба, мне не принципиально. Самому простыни тоже писать лень, потому что банально идеи кончились и хочется чего-нибудь нового.

Можете просто ссылки на свои любимые карты скинуть, или на авторов с того же чуба, мне не принципиально. Самому простыни тоже писать лень, потому что банально идеи кончились и хочется чего-нибудь нового.

>Нихуя больше не вставляет

Так ты сдрочился просто, устрой себе недрочябрь на месяц и все пройдет

Мозг привык к дофамину или чет такое вот тебя и не тянет

Кстати, вот эта залупа для ллмок влияет на что-то в плане скорости инференса? Для SD той же пиздец как влияет порой и надо отключать, а вот для остального так и не нашёл инфы.

Так я итак держал нофап почти две недели из-за ебаной каторги 5/2. С самой дрочкой у меня проблем нет, порнуха всё еще вставляет как раньше. Просто щас каждый раз когда я сажусь за рп то быстро выгораю, потому что подсознательно понимаю, как пройдет весь сценарий и что нихуя необычного я не встречу.

>Помню владелец ддр5 с каким то мощным камнем писал что у него рост скорости не заканчивался на последнем ядре, 12 что ли

Я не он, но у меня DDR5-6400 и 13900к с 8 нормальными ядрами и 16 кастрированными. Раньше максимальная скорость была на 16 потоках и отключенных E-ядерах. Теперь E-ядра работают нормально но 16 потоков на генерацию все еще оптимально, а на обработку промпта - 32.

> Я так понимаю генерация требует синхронной работы ядер

Больше года назад уже у жоры лежал пр на ассинхронную обработку, который позволял подключать разнокалиберные гпу и гетерогенные архитектуры. До сих пор не сделали чтоли?

Если тебе сценарии для кума нужны то сценарии для кума не нужны, лол.

Возьми карточку с милым тебе персонажей/типажом/фетишами и просто рпш что-нибудь интересное. Если по ходу шишка встанет - вперед, если нет - хорошо время проведешь и встанет в следующий раз.

Насчет "не трогать или выставлять потоки равные активным" и при отключении е-ядер поддвачну. Давно это было, нужен перетест, но раз работает то и все четко.

Интересно. Как думаешь у тебя упор в проц или в скорость рам идет в таком режиме? Кстати не думал что геперпотоки будут давать пользу, у меня на генерации они бесполезны, но у меня и проц гораздо старее

Про обработку контекста да, она может весь проц сожрать, если кто то на процесоре контекст читает то на чтение промпта нужно отдельно количество потоков указывать, с гиперпотоками

>Интересно. Как думаешь у тебя упор в проц или в скорость рам идет в таком режиме?

Скорость рам 100%. Процессор на половину мощности работает.

>Кстати не думал что геперпотоки будут давать пользу, у меня на генерации они бесполезны, но у меня и проц гораздо старее

Они дают прирост но достаточно небольшой.

Сам делай карточки.

Смотри что я нашел.

Самое интересное - рассказывает, что эмбеддинг в векторном пространстве ллм жрет ~5000 бит на одну штучку. А тот же "эмбеддинг" в мозге всего ~100 бит. При этом точность не теряется. Мозг использует коды, а не вектора.

Но более подробно эта тема не раскрыта, к сожалению. Если кто знает исследования мозга на эту тему, с удовольствием бы почитал.

https://www.youtube.com/watch?v=8LyUv0EjXsk

Потоки все загружены?

>уполовинивания скорости записи в раму

Так важно же чтение...

>Но более подробно эта тема не раскрыта, к сожалению.

У них где-то была серия статей и видосов на эту тему, типа https://habr.com/ru/articles/308370/

Только сразу скажу, что это шизики со сверхидеей, а подтверждений их мегатеориям про то, что каждая миниколонка содержит всю информацию с мозга, нигде нет.

>А тот же "эмбеддинг" в мозге всего ~100 бит.

Не уверен, так как мозг обладает более сложной и специализированной структурой.

Проблема текущих ллм - как раз таки в отсутствии кодов, которые добавляются в snn и о которых ты писал.

Они не существуют во времени, последние могут хотя бы в импульсную работу, с имитацией непрерывности биологических нейросетей.

Возможность накопления активации весов и их затухания со временем, выглядит как что то гораздо более совершенное, чем текущие варианты нейронных сетей.

Но если текущие ллм можно тупо просчитывать слой за слоем, в snn каждый нейрон может активироваться в свое время.

Что усложняет как внешнее обучение через алгоритмы обратного распространения ошибок, так и инференс.

А судя по тому что тема на вики не обновлялась аж 4 года, с момента старта популярности нейросетей, вся она активно разрабатывается за закрытыми дверями. Как и фотоника.

О которой тоже нет никакой актуальной инфы.

Чем больше сжатие — тем больше разница между малыми числами.

Типа, 16 бит и 8 бит — разница почти не чувствуется.

А 2,5 и 2,75 там она уже начинает тупеть стремительно.

Могу ошибаться насчет именно этих битностей, конечно, но я так чувствую. По крайней мере 3 и 2 бита — пропасть.

Ты на приколе пытаться в 12 гигов впихнуть всю модельку, скок она там весит, 16 гигов? :) Поставь 20 слоев, 21, 22… Где-то там.

Qwen2-7B-Instruct

Mistral-Nemo-Instruct-2407-Q8_0.gguf

Гемма вместо квена по вкусу.

Но мне Немо ближе Геммы, а Квен я люблю.

Лламу точно в мусор.

Вообще, судя по тестам Гусева, мини-магнум даже лучше мангума может быть. И Гемма-2-27б хороша.

В общем, сейчас 70б модели не сильно вырываются вперед в диалогах и РП. В работе — мб, да.

COPY /B Mistral-Large-Instruct-2407.IQ3_S.gguf.part1of2 + Mistral-Large-Instruct-2407.IQ3_S.gguf.part1of2 Mistral-Large-Instruct-2407.IQ3_S.gguf

И сиди жди.

По заветам Блока. https://huggingface.co/TheBloke/CodeLlama-70B-Python-GGUF

Я с 600 до 450 гигов понизил, аж радуюсь.

Эксл2 работает тока в видеопамяти. Запустятся тока модели меньше 8 гигов. Качать надо вообще всю папку.

Я врубал 11, прирост был, но мизерный довольно-таки. На ддр4 в память упирается.

>Проблема текущих ллм

В том что они по сути ассоциативная память без процедурной и вместо выведения общих паттернов и логики - попытки заучивания бесконечного набора ассоциаций в конечном наборе весов. Концептуальная проблема однопроходных трансформеров, у которых процедурная память в зайчаточном виде существует только в пределах окна аттеншна контекста.

В соседнем треде смотрел у братьев наших меньших онлайновых? У них там хорошая коллекция хендмейд карточек.

Чето на гране шизы

> "эмбеддинг" в мозге всего ~100 бит

Вот это вообще пушка.

Еще рандомно (46:00) мотнул, а там такое-то бинго, где он путается в точностях. Судя по всему остальному это не оговорка а реально незнание, с регулярным чрезмерным упрощением, неверной интерпретацией и постоянным оперированием сложными вещами без учета (и понимания) их сути. Прямо как у местного уникума, который на кэше обучает.

Сомнительно, прувмивронг.

> Проблема текущих ллм...

Исходя из их определения - это не проблема, это их фича. Всеравно что сказать что главная проблема 2д сплайнов - их двухмерность. С тем что ты хочешь это будут уже не языковые и другого рода модели.

> Как и фотоника

Вут? Чел, тем кто занимается наукой и подобным глубоко похуй на всякие вики, ты точно также не найдешь там ничего из современного каттинг эдж.

>С тем что ты хочешь это будут уже не языковые и другого рода модели.

Просто мысли о том какой будет следующий шаг, и почему это не будет ллм? Не удивлюсь если для обучения будут использоваться те же датасеты, только алгоритм обучения сменится. Обзовут каким нибудь вторым поколением и будут довольны

>глубоко похуй на всякие вики

Ну нет, если область закрыта то и вики и другие открытые источники не пополняются - информация придерживается для сохранения конкурентного преимущества

С другой стороны когда профит не виден на финишной прямой инфой свободно делятся и пишут статьи

Просто та же фотоника дает невероятную выгоду, так как все уперлись в текущий кремний уже лет 10, и долбятся об фотонику вливая немерянные усилия те же лет 10.

> Просто мысли о том какой будет следующий шаг

Съебите на свою шизодоску уже с такими мыслями, или в отдельный тред, который уже есть. Этой шизой и решением мировых проблем избегая санитаров все загадили и уводите обсуждение основной темы.

> если область закрыта

Чел, 98% актуальных областей закрыты майнд-гапом, чтобы их понять хотябы в общем нужно образование и много знаний, а для погружения в детали нужно быть специалистом в области. Источники открыты, читай - не хочу, вот только понять что там написано (да и просто знать где искать) дано не всем. А шизики - всезнайки вместо самообразования культивируют шизотеории на коленке, ведь для того чтобы строить из себя бигбрейна и бухтеть о том что все все делают неправильно этого и не нужно.

а может ты токсик нахуй съебешь?

Всем привет!

Какую модель выбрать с поддержкой русского языка и минимальной цензурой под RTX 4070 12Gb?

Для:

1. Общих задач (ответы на вопросы, форматирование текста, перевод текста)

2. Написания кода

Какую модель выбрать с поддержкой русского языка и минимальной цензурой под RTX 4070 12Gb?

Для:

1. Общих задач (ответы на вопросы, форматирование текста, перевод текста)

2. Написания кода

Mistral-Nemo-Instruct для кода хорош, как и для общих задач. Ну и в твои 12 гб влезет, какой нибудь 5 квант вместе с контекстом

>то оно достаточно быстро (сотни-тысячи т/с)

Конкретно в этом вашем франкенштейне или вообще у жоры? Потому что "вообще" - очень медленно, даже когда всё на видеокарте.

>StreamingLLM в вебуи

Где-то секунд 20 уходит на регенерацию 4к на тесле с флешатеншоном и стриминг ллм. Проблема, скорее всего, в том, что не регенерируются только "префикс", а он относительно небольшой.

> вообще у жоры

this

Оно медленно по сравнению с экслламой и/или когда на единой карточке все слои, но по сравнению с 50т/с это космические скорости.

>Проблема, скорее всего, в том, что не регенерируются только "префикс", а он относительно небольшой.

Ну если большая часть контекста меняется в разных местах, то тут и оно не поможет.

>Где-то секунд 20 уходит на регенерацию 4к на тесле

Тут надо сразу указывать, какая модель. Вообще, я гоняю на двух теслах файнтюн Мистраля Немо в восьмом кванте с 16к контекста и вообще никаких неудобств не испытываю. Раньше испытывал, так как модели 12В были плохие, какой квант не бери - а сейчас нет.

На одной тесле скорость обработки промпта помедленнее. А на двух rowsplit приходится выключать - генерация на 5 т/c медленнее, но промпт с mmq обрабатывается быстро. Ещё на маленьких моделях blastbatchsize 128 ставлю - так быстрее. Жить можно.

>Потоки все загружены?

Загрузка процессора не имеет значения, она может быть 100% когда процессор по сути в простое поскольку долбится в память. Надо смотреть на энергопотребление, и оно не растет даже если поставить больше потоков.

>Вообще, судя по тестам Гусева, мини-магнум даже лучше мангума может быть. И Гемма-2-27б хороша.

>В общем, сейчас 70б модели не сильно вырываются вперед в диалогах и РП. В работе — мб, да.

Не знаю как сейчас но во времена второй лламы все что меньше 70b дико тупило.

sunfall разочаровал, модель тупая и проебывает форматирование. Попробую еще daybreak, если такая же фигня то буду вправлять мозги Euryale. Не люблю перегружать инструкциями но другого выхода по ходу нет.

> файнтюн Мистраля Немо

Какой? И как он вообще в плане секса и каких-нибудь прикладных nlp типа "перепиши вот это полотно согласно критериям".

> скорость обработки промпта

Какие там скорости на 15-16к контекста?

> Загрузка процессора

Это же просто метрика, которая может быть оценена по разным критериям. Process explorer показывает загрузку 5-15%, диспетчер шинды 100%, по тдп там 50-60%. Все правильно, упор идет в память, и тут уже зависит от того как это оценивать.

> буду вправлять мозги Euryale

Как именно?

Всё так, база.

>и почему это не будет ллм

Потому что обучаться будет прежде всего на видео и взаимодействии в симулированных средах, а не вот это всё говно с текстом.

>Какой? И как он вообще

NeMoistral-12B-v1a и Lumimaid-Magnum-12B. Вполне.

>Какие там скорости на 15-16к контекста?

Комфортные. Конечно понятия комфорта для каждого свои, но я неудобств не чувствую.

Для кума и РП модели вполне, тем более поменять одну на другую можно очень быстро если что. Для прикладных задач есть базовый Немо - тоже хвалят.

>Это же просто метрика, которая может быть оценена по разным критериям.

Ну я про это и говорю.

>Как именно?

Инструкциями в конце промпта.

> Вполне

Насколько отыгрывают чара и интересно повествуют, насколько описывают процессы, как по уму и всякому интерактиву?

> Комфортные

Ну ты рофлишь чтоли? Понятно что на 12б сетке все будет шустро, сколько именно в цифрах?

> Инструкциями в конце промпта.

Если что-то выйдет хорошее - поделить инструкциями/наблюдениями.

>Если что-то выйдет хорошее - поделить инструкциями/наблюдениями.

Да тут все стандартно, я уже много раз отписывался. В идеале модель должна быть выровнена таким образом что инструкции не нужны или нужны в минимальном количестве, чисто для не очевидных директив, не для превозмогания сои. Инструкции сильнее могут побороть сою но вероятно перекосят модель в противоположное направление, например сделав ее слишком похотливой. Достичь идеала очень сложно. У меня это ни разу не получилось, поэтому в первую очередь стараюсь найти нормальную модель.

Поможите, я тупой.

Делаю карточку для РП, там 4-5 персонажей(не хочу групповой чат пока для каждого чара).

Так вот как сделать более разнообразный шаблон ответа?

Прописано в карточке про разные характеры, сленг, синтаксис речи.

Нужно сделать несколько вариантов примеров ответа в тексте карточки или играться с пресетами в Таверне?

bullerwinsL3-70B-Euryale-v2.1

Делаю карточку для РП, там 4-5 персонажей(не хочу групповой чат пока для каждого чара).

Так вот как сделать более разнообразный шаблон ответа?

Прописано в карточке про разные характеры, сленг, синтаксис речи.

Нужно сделать несколько вариантов примеров ответа в тексте карточки или играться с пресетами в Таверне?

bullerwinsL3-70B-Euryale-v2.1

>примеров ответа

это

Сап, почему такая большая разница между скоростью обработки двух gguf моделей одинаково веса? один размер контекста, один и тот же чат

8врам/64рам

все модели весят 5.4-5.8гб

L3-Umbral-Mind-RP-v3-8B.i1-Q5_K_S.gguf выдаёт 20 т/с

kuno-kunoichi-v1-DPO-v2-SLERP-7B-Q6_K-imat выдаёт 10 т/c

Lumimaid-v0.2-8B.q5_k_m.gguf выдаёт 1 т/c

чому так?

8врам/64рам

все модели весят 5.4-5.8гб

L3-Umbral-Mind-RP-v3-8B.i1-Q5_K_S.gguf выдаёт 20 т/с

kuno-kunoichi-v1-DPO-v2-SLERP-7B-Q6_K-imat выдаёт 10 т/c

Lumimaid-v0.2-8B.q5_k_m.gguf выдаёт 1 т/c

чому так?

Так очевидно у тебя врам не хватает. Естественно в рам будет скорость на дно падать.

Что лучше всего в лигике из моделей влезающих в 12гб?

> В идеале модель должна быть выровнена таким образом что инструкции не нужны или нужны в минимальном количестве

Все так.

Понятно, думал ты про что-то другое. С гейммой кстати не игрался? Ну и если с той выдет что-то годное - скинь чем ее накормил.

> как сделать более разнообразный шаблон ответа?

Технологии древних - рандомная инструкция средствами таверны. Глянь там регэкспы и забей дополнительные указания по формату, стилю, настроению ответа и т.д.

Чекни какой контекст там по дефолту выделяется и насколько загружена врам. 95% дело в том что она переполняется и идет выгрузка в оперативу.

Научитесь уже млок включать чтобы хотя бы ошибку получать вместо замедления.

Трансформеры покатал, чуть не кончил на месте. Вообще задержек нет.

Даже без свайпов, просто ведёшь чат, кончился контекст, начался пересчёт. Долго, ебать.

Так правильно, две теслы - быстрее обработка. Я пытаюсь на одной тесле выживать.

> Трансформеры покатал

С ядром экслламы или вообще ванила-ванила? Не то чтобы они были супербыстрые в стоке, но вот память на контекст выжирают просто невероятно.

> кончился контекст, начался пересчёт

В промте по факту после системного промта просто удалился один или несколько постов а остальные сдвинулись на то месте. В теории можно сместить уже рассчитанное чтобы оно работало, но это не точно. На практике все еще сложнее.

> две теслы - быстрее обработка

На современных картах все наоборот, дробление приводит к замедлению.

Mistral-Nemo-Instruct-2407 что выбирать для промта и инструкта в таверне?

>На современных картах все наоборот, дробление приводит к замедлению.

Даже на теслах сложнее всё, под каждую модель количество карт и параметры подбирать надо, искать баланс.

> под каждую модель количество карт и параметры подбирать надо, искать баланс

Че?

Раньше все тесты указывали на деградацию скорости от роста количества гпу, это помимо увеличения сложности на большой модели. Оттуда же недовольные возгласы в сторону жоры, что делает эвал 400т/с на 70б, и смехуечки про 1т/с на теслах, где обработка 8к контекста заняла больше минуты. Эффект замедления не только на жоре если че.

А тут вдруг заявляется что все наоборот и чем больше тем быстрее, реквестирую пояснений.

Mistral очевидно

>Даже без свайпов, просто ведёшь чат, кончился контекст, начался пересчёт. Долго, ебать.

Ну у тебя таверна или шо там у тебя начинает смещать окно сообщений вперед, а начало в виде промпта перса и прочего остается, а это по факту изменение всего контекста кроме собственно начала с промптом перса. Вот и пересчет.

Оно работает собсно только если не меняется предыдущий контекст вообще.

Разнос на 2+ гпу с одной может как увеливать скорость, так и уменьшать. Тут опять вопрос ботлнека и синхронизации. NVLink и подобные приколы для SXM карт не просто так существуют.

Метод квантования тоже влияет на производительность. Также обрати внимание, сколько слоёв модели в каждом случае выгружается на GPU.

https://www.theregister.com/2024/07/14/quantization_llm_feature/

https://old.reddit.com/r/LocalLLaMA/comments/1ba55rj/overview_of_gguf_quantization_methods/

https://www.reddit.com/r/SillyTavernAI/comments/1e4ew6z/current_llm_scene_a_practical_overview/

> iMatrix Quantization: Generally improves performance for all quant types (legacy, K-quants, I-quants). Always beneficial, regardless of the calibration dataset used. Look for "im" or "i1" prefix (e.g., i1.Q2, i1.IQ3) to identify iMatrix models.

Да, во времена второй лламы — конкурентов не было. 13b были чисто поиграться быстро, если у тебя нет двух ртх3090.

Щас уже не так.

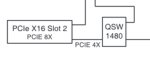

здарова бандиты. У меня обновка.

в воскресенье приедет еще один райзер и их у меня будет не 3, а 4

в воскресенье приедет еще один райзер и их у меня будет не 3, а 4

Помаогите. Пытаюсь квантовать

https://huggingface.co/bigcode/starcoder2-3b

После гуфания теряет способность Fill-in-the-Middle. Короче перестает понимать специальный токен <fim_middle> и остальные. Вообще гуфать научился только 15 минут назад, как правильно делать??? Вроде читал гуглил, нихуя нужного не нашел.

https://huggingface.co/bigcode/starcoder2-3b

После гуфания теряет способность Fill-in-the-Middle. Короче перестает понимать специальный токен <fim_middle> и остальные. Вообще гуфать научился только 15 минут назад, как правильно делать??? Вроде читал гуглил, нихуя нужного не нашел.

Ты почему-то думаешь что прогресс есть только у мелких моделей. То что сейчас мелкие модели догоняют первую ламу 70В не значит что они сколько-нибудь приблизились к современным 70В. Отрыв всё так же огромный. Одно дело что мелкие научились стилистически писать как старшие, а совсем другое количество знаний и умение во вдумчивые разговоры. Вот условно есть Кодестраль 22В, в коде он действительно может и не плох, но при попытках пообщаться с ним на технические темы и получить ответ на свой вопрос лама 70В 3.1 разъёбывает это недоразумение просто в сухую. И в обычных так же разницу отчётливо видно, когда сколько-нибудь отклоняешься от "я тебя ебу".

Ты что-то не то делаешь, возьми готовый квант и не ебись, я сам старкодером правда 15В пользуюсь для автокомплита в VS Code. Всё отлично со вставками в середину.

Почём и когда покупал P40?

первые две купил перед новым годом за 15 каждую.

вторые две купил неделю назад, за 33 каждая.

На али сейчас продавец P40 только один и продает он её за 39, а на озоне тоже глухо - по 33 минимум, но есть и вообще какие-то нихуя не адекватные цены - 40, 50, 70к.

Карт вообще походу не осталось в китае, все выгребли.

Думаю, я забрал одни из последних.

Вообще ванилла. Не на тесле пробовал, правда, но быстро и без замедления по контексту.

>В теории можно сместить уже рассчитанное чтобы оно работало, но это не точно

СтримингЛЛМ по описанию так и работает. И даже пишет в консоль, что он это делает. И лламацпп так умеет. Но что-то не выходит каменный цветок. По крайней мере в питоновой обёртке. Буду разбираться ещё, кобольда лень качать, чтобы проверить, как там будет. Собрал себе ламу, правда, без кубласов, почитал - они только для кпу помогают.

>На современных картах все наоборот, дробление приводит к замедлению.

Там какая хуйня, весь кеш kv остаётся на первой карте, то есть чисто по логике надо туда слоёв поменьше и чип помощнее. Тогда будет ускоряться, если пропускной способности хватит. А если карты по мощности равны, то я бы ожидал замедления.

>это по факту изменение всего контекста

Там же ускорялки, которые типа предотвращают пересчёт всего.

>Там же ускорялки, которые типа предотвращают пересчёт всего.

Единственный вариант предотвратить пересчёт - нихуя не пересчитывать, а соответственно что там ускорять, если ничего не делаешь.

> Но что-то не выходит каменный цветок.

Потому что смещать весь контекст надо цельным куском, который не будет меняться, чтобы это работало.

Опять же, та же таверна (да и гуй кобольда при юзании карточек и некоторых сценариев емнип) в самом простом случае при упоре в указанный в ней контекст начинает двигать сообщения меняя весь контекст до промпта карточки, который всегда в начале:

1. [промпт] [сообщение1] [сообщение2]

2. [промпт] [сообщение1] [сообщение2] [сообщение3] - уперлись в контекст

3. [промпт] [сообщение2] [сообщение3] [сообщение4] - смещение сообщений == изменение куска контекста от сообщение2 до сообщение3 + новое сообщение4 и теперь необходимо заново процессить весь этот кусок, а [промпт] у нас в начале посчитанный есть, но может быть мизером на фоне длины сообщений

Если бы на 3-ем этапе мы бы сместили так, что стало

3. [сообщение1] [сообщение2] [сообщение3] [сообщение4]

то нихуя бы пересчитывать не надо было бы, бы просто сместили-шифтнули посчитанные сообщения 1 2 3 в начало контекста и посчитали только четвертое.

Ну и при использовании 98% фичей той же таверны со всякой векторной памятью, лорбуками, макросами в промптах карточек, указанием целей для перса и так далее и тому подобное перелопачивает весь контекст на каждую генерацию практически и соответственно все эти шифты контекста и прочие приколы можно считать перестают работать вообще.

По большому счёту нет, всё можно настроить, оставив значительное количество фич. Проблема в другом - модели часто проёбываются, выдают не то, что ожидаешь -> приходиться править, удалять и рероллить. А вот это уже частенько ведёт к пересчёту всего контекста. Были бы модели поумнее, такого бы не было. Но это в любом случае проблема слабых карт, хотя я тут попробовал exl2 123В на двух 3090 -16к контекста в 8 битах связка не держит, пересчёт контекста начинает занимать слишком много времени. 14к норм. Хотя свободная память вроде есть ещё.

> как увеливать скорость

Пример можно?

> NVLink

За мостики ломят больше чем можно выкинуть ради интереса, да и не то чтобы там были подвижки для перспектив другого применения. Вроде и "обманывали" протокол для взаимного доступа, но нормально ничего не собирается.

Зачем? Ну типа

> перед новым годом за 15 каждую

Красиво четко

> неделю назад, за 33 каждая

а мог бы толкнуть первые две и купить пару 3090. Запускать одну большую сетку на них - страдание, несколько мелких - да, но не похоже чтобы здесь кто-то нужду в этом имел. Ни на что кроме ллм они не годны.

> Вообще ванилла.

Ванила скушает гигов 60 в сумме если загрузить какую-нибудь 12б со сколь значимым контекстом.

> Но что-то не выходит каменный цветок

Надо изучить что там, но заявлялось что оно так просто не может нормально работать ибо последующие зависят от прошлых, и если просто выкинуть кусок и сшить - будет залупа, проявляющаяся от легких тупняков то полнейшей поломки. Хз насколько это правда, но выглядит правдаподобно, надо лезть погружаться а лень.

> кеш kv остаётся на первой карте, то есть чисто по логике надо туда слоёв поменьше и чип помощнее. Тогда будет ускоряться, если пропускной способности хватит

При обработке промта обе карточки загружаются полностью и упираются в тдп, уверен в этом?

К сожалению 123B в четвёртом кванте терпима только до 8к контекста. Дальше жопа с обработкой контекста. И самое интересное, что уменьшение до второго кванта особого прироста не даёт - почти совсем не даёт, а значит дело в хреновой оптимизации. Обидно. Генерация-то и на 16к контекста более-менее.

Скорость обработки контекста и потребление памяти на него почти не зависит от размера кванта, если че.

> Генерация-то и на 16к контекста более-менее.

Сколько?

>Потому что смещать весь контекст надо цельным куском

Вроде, не надо. С редактированием сообщений ёбка будет, но мне это не надо. Есть llama_kv_cache_seq_rm который умеет удалять часть контекста и llama_kv_cache_seq_add который умеет добавлять новый кусок.

>[промпт] [сообщение2] [сообщение3] [сообщение4]

Я так-то думал, что стримингЛЛМ это и делает. Но что-то ебать долго он это делает. В код питона не смотрел, сделал себе упрощённую обёртку с пересчётом процентов сорока от контекста, потестирую пару дней.

>при использовании 98% фичей той же таверны

Не использую. Планирую прикрутить для себя кое-какие вещи, но редактировать старый вывод для этого считаю какой-то хернёй.

>Ванила скушает гигов 60

В трансформаторах тоже квантование есть. Я вроде в четырёх байтах модель скачивал, всё влезло. Но хочется насиловать именно теслу.

>если просто выкинуть кусок и сшить - будет залупа

Как я понимаю, залупа будет, если не учитывать аттеншн синки, а т.к перфикс у промпта всегда сохраняется, то похуй.

>При обработке промта обе карточки загружаются полностью и упираются в тдп

Так это доказывает только то, что обе карточки рассчитывают промпт. Сделай ровсплит, распредели модели поровну по картам и посмотри на загрузку памяти. У меня не самая свежая ллама, но у меня именно так, весь kv на первой карте при ровсплите. При послойном возможно по-другому, не смотрел.

Ну, настроить можно попытаться в общем, да, но тут тоже можно упереться в разные приколы и так же в тупорылость мелких моделей.

> exl2 123В на двух 3090 -16к контекста в 8 битах связка не держит, пересчёт контекста начинает занимать слишком много

Это вообще о цифрах какого порядка речь? Интересно просто как бомжу с 16gb vram.

>За мостики ломят больше чем можно выкинуть ради интереса, да и не то чтобы там были подвижки для перспектив другого применения.

Ну там эффекты зачастую будут в какие-будь +5, лучшем случае +10 t/s для на больших моделях. На мелких, которые не выжирают всю память пары тройки условных 3090 зачастую будет или так же или станет только ещё хуже. Если обе карточки не забиты в упор или почти упор смысла это делать ради конкретно перфоманса нет в общем.

Для нормального инференса на куче видях нужны уже штуки уровня vLLM/SGLang/TensorRT-LLM/etc с всеми их заточенными для мульти-гпушного дроча приколами вроде PagedAttention, kv cache reuse, и тд. Но для локального дроча в одно лицо оно вообще всё не подходит нам тут практически ибо заточено под инференс батчами. В итоге сосём хуяку с приколами от жоры, а кто побогаче с exllama2. Такая хуйня.

>Сколько?

Токенов 5 в секунду на 123В-4КМ. Но это 4 теслы нужно.

>Это вообще о цифрах какого порядка речь? Интересно просто как бомжу с 16gb vram.

Модель exl2 123В 2,75BPW, 16к контекста в 8 битах. На 16к уже требует около минуты на ответ. Х/з, может я там местный контекст шифт не включил, вот контекст каждый раз и пересчитывается. Но напряжно.

command-r-plus-Q4_K_M

Скорость генерации разная, 3.01- 2.04 tokens/s, кажется не особо привязана к длине уже существующего контекста.

Интересно посмотреть результаты адептов секты швитого райзена и оперативки.

у тебя все 4 р40 на pcie x16?

> exl2 123В на двух 3090

Там же совсем лоботомит квант будет.

За контекст двачую, особенно если групповые чаты или рандомайзер в промте.

> перфикс у промпта всегда сохраняется

Предшественником "сообщения 2" будет обрезан и там появится совсем другой участок что должен быть раньше, типа это руинить если не делать полный пересчет. За что купил за то продаю, но вообще выглядит резонно.

> В трансформаторах тоже квантование есть

Контекст все равно очень много будет кушать и не отличается повышенным перфомансом. На важно, просто натрави его на теслу и там глянь.

> что обе карточки рассчитывают промпт

Именно, почему тогда идет замедление?

> Сделай ровсплит

Он только замедлял или не давал эффекта. Может если совсем нехуй делать будет на следующей неделе потестирую как карточки освободятся все эти приблуды, но маловероятно что будут отличия. Ебаный жора, тут надежда только на то что весь код перелопатят под питон и только тогда оно нормально начнет работать.

> +5, лучшем случае +10 t/s для на больших моделях

Если +10т/с на обработке контекста - капля в море, если к генерации - ебать да это просто в 2 раза.

В любом случае для ускорения нужен уже другой код, который и учтет прирост взаимного псп, и учтет то что он нихуя не большой.

Это в любом случае все херня, тут потенциальный интерес только в том что пара 3090 при fsdp сможет в теории не только заменить А6000, но и опережать ее. А на практике хуй.

> тройки

Нвлинк только на пару.

Под пиво пойдет

>у тебя все 4 р40 на pcie x16?

Да, HEDT-плата.

>Там же совсем лоботомит квант будет.

Да не сказал бы, терпимо. Мистраль Ларж - хорошая модель.

а какую брал?

я зашел на яндекс, увидел первую попавшуюся https://market.yandex.ru/product--afhm65-eth8ex/1779555779?sku=1661668248&uniqueId=892410&do-waremd5=GekUz7-_r6b0rVn85Xjq-A&sponsored=1

Что там, на селероне все pcie - х16? Это ж невозможно.

>что стримингЛЛМ это и делает

СтримингЛЛМ вообще не про это. Оно про сохранение части первых токенов для того чтобы модель не шизела при выходе за родное окно аттеншна, очень грубо говоря.

>We observe an interesting phenomenon, namely attention sink, that keeping the KV of initial tokens will largely recover the performance of window attention. In this paper, we first demonstrate that the emergence of attention sink is due to the strong attention scores towards initial tokens as a "sink'' even if they are not semantically important.

>Вроде, не надо. С редактированием сообщений ёбка будет, но мне это не надо. Есть llama_kv_cache_seq_rm который умеет удалять часть контекста и llama_kv_cache_seq_add который умеет добавлять новый кусок.

Ну вот это всё про контекст шифтинг, который как уже сказал нормально работает только если мы цельно смещаем кусок выпиливая старые в начале и добавляя новые в конце, иначе процессить заново кусок от конца до поменявшегося токена.

Кстати, exlamma-дрочеры, как понимаю контекст шифта до сих пор нету или я слепой?

>Если +10т/с на обработке контекста - капля в море, если к генерации - ебать да это просто в 2 раза.

Нашёл засейвленный кусок коммента чьих-то тестов с реддита.

Actually I just did a test; dual 3090s, NVLink enabled, remember.

synthia-70b-v1.2b.Q4_K_M.gguf: Both GPUs, 17tok/s. One GPU: OOM. CPU offload: Untested (expect 1tok or less) NVLink disabled: 10.5tok/s.

codellama-34b-instruct.Q4_K_M.gguf: Both GPUs, 29tok/s. One GPU: 30tok/s.

mistral-7b-openorca.Q4_K_M.gguf: Both GPUs, 65tok/s. One GPU: 108tok/s.

>Нвлинк только на пару.

Йеп, по привычке аутично пизданул словосочетание про "пару тройку", пора спать нахуй.

>Что там, на селероне все pcie - х16? Это ж невозможно.

От чипсета возможно, только что там будет с производительностью даже догадываться не надо. А брал я Асус на X299 и проц под него с 44 линиями PCIe. Есть ли преимущества от такой конфигурации сложно сказать. По идее должны быть.

> На 16к уже требует около минуты на ответ

Довольно долго. Может и действительно оно в добавлением карт ускоряется, попозже попробую замерить сколько оно на 123 эвал делает.

> все 4 р40 на pcie x16

Это или эпик (на зен1 не брать ни в коем случае), или современный зеон, или йоба двусоккет на 2011-3, и то ни в одном из вариантов не будет 4х слотов х16, по много х8 делают.

> контекст шифта до сих пор нету

Нету. Не то чтобы в нем была нужда, но если перспективен можно поныть чтобы сделал, это же не жора.

> как уже сказал нормально работает

С математикой объяснишь почему он будет нормально работать? Пока только утверждения что это будет давать ошибки и укладывающиеся в это заявления что с ним модель шизеет.

> 70b

> Both GPUs, 17tok/s

> NVLink disabled: 10.5tok/s

А ведь первое +-стоковая скорость экслламы.

> От чипсета возможно

В мультигпу тренировке это дает ~15-20% замедление по сравнению с х8 процессорными, разницы между х8 и х16 нет. Как будет здесь - хуй знает вообще, может и никак. Х4 чипсетные в задачах где много .to(cpu), .to(device) очень знатно серут, но на той же экслламе между карточками разницы почти нет.

>типа это руинить если не делать полный пересчет.

Лламацпппитон не пересчитывает всё, но он сохраняет слишком мало. Если неполный пересчёт руинит - то весь вывод убы с этой опцией должен быть похерен.

>просто натрави его на теслу

А она же не поддерживает нихуя, там такая модель в принципе не загрузится.

>Именно, почему тогда идет замедление?

При расчёте контекста или при инференсе? При инференсе-то понятно, кеши нужно пердолить с одной карты на остальные, а это медленно.

>Он только замедлял или не давал эффекта.

Я тебе дал простой способ проверить, что kv кеш на одной карте. Разбей модель "одинаково" по разным картам ровсплитом. На первой карте будет забито на несколько гигов больше - аккурат под него.

>Ебаный жора

Я так-то код посмотрел, проблема Жоры в том, что он пишет библиотеку, над ней нужно иметь ебелион кода, чтобы оно работало хорошо. А так он ебать какой молодец. И мозилла тоже.

>СтримингЛЛМ вообще не про это.

>Activate StreamingLLM to avoid re-evaluating the entire prompt when old messages are removed.

Уба наёбщик ёбаный

>выпиливая старые в начале и добавляя новые в конце

И атеншн синки выпиливаются тоже. Выбор между клизмой с говном и сэндвичем всё с тем же.

Но вроде работает такое смещение, мне нравится, только хуй знает, как детектировать ошизение модели, они все с завода ошизевшие.

> но он сохраняет слишком мало

Только начало контекста? Про не полный пересчет это про не учитывание взаимных положений токенов и сохранение имеющегося состояния со сдвигом. Я хуй знает что там должно быть, ориентируюсь по посту на среддите где братишка расписывал.

А так пихоновская обертка разве что-то делает экстраординатное по сравнению с обычным жорой?

> то весь вывод убы с этой опцией должен быть похерен

Возможно и так, надо сравнивать. Непонятную херь в выдаче на гемме с жорой и адекватную работу бывшей наблюдал своими глазами если че, но там самое начало еще было.

> Уба наёбщик ёбаный

А в чем он наебщик? Как раз то целевая идея в том чтобы не переобрабатывать весь промт а манипуляциями склеить имеющийся кэш досчитав только мелочь.

Вроде охуенно получается с задачами для которых нужно комплексное мышление используя CoT, но полный кал при зирошоте. Вангую что это просто 4о, которую через "Q*" прогнали, это и близко не пятая гопота. Касательно попенсорса вроде как уже даже делали подобное и заставляли 8b модель решать мат. задачи с ~99% точностью. Однако после официального выпуска модели клоузедами думаю что на хайпе другие разработчики прикрутят это во все основные модели. По крайней мере надеюсь на это, может наконец агенты заработают полноценно.

>>СтримингЛЛМ вообще не про это.

>>Activate StreamingLLM to avoid re-evaluating the entire prompt when old messages are removed.

>Уба наёбщик ёбаный

Я уже сколько смотрю на это в вебуи и задаюсь вопросом, а что реально это блядская галка с таким названием делает, контекст шифтинг или именно streamingllm и где тогда шифтинг, но сохраняю для себя интригу и не лезу в код. Всё равно не использую ллама.цпп через эту залупу потому что вебуи с хуйней жоры адекватно не работает в принципе. Только для exllama2. И то тоже не уверен что не насрано.

>С математикой объяснишь почему он будет нормально работать?

Ну прям математику выкладывать тут посреди ночи мне уже впадлу, это тогда надо вообще про всю работу аттеншна ллмок говорить, аттеншн веса, KQV и прочую хуетень, но как до этого кто тут сказал уже засыпаю нахуй - у нас каждый следующий токен зависит от предыдущего и вообще от всех предыдущих в общем и это всё цельно посчитанная залупа. Выдерни один токен, склей тупо без него и поломаешь всю цепочку после него просчитанных связей, наебнет постепенно всё с накоплением ошибок при генерации каждого следующего с 99.99% вероятностью. В StreamingLLM ресерче их отчасти про это и речь, как я понимаю, что оказывается даже первые вообще может рандомные ничего не значащие на наш взгляд токены могут сильно влиять на весь аттеншн модели, хотя казалось бы.

>Нету. Не то чтобы в нем была нужда

Ну не ждать лишние секунду две на больших контекстах было приятно, конечно.

Ладно, нейроны, надо спать пиздовать нахуй и молиться что сегодня пятничного деплоя на РАБоте не будет какого-нибудь очередного.

> Ну прям математику выкладывать тут посреди ночи мне уже впадлу

Да это без предъяв, хотябы что сам расковырял. Интересно, но на ночь заниматься этим - нахуй нахуй. Сам об этом писал, в том и дело что там все друг на друга завязано и как будет если выдернуть и склеить не понятно. Особенно обидно оно будет если эффект плавный и накопительный, будет капитально руинить экспириенс там где только становится интересно, и будешь думать на тупую модель, кривой суммарайз и прочее.

> В StreamingLLM ресерче их отчасти про это и речь, как я понимаю, что оказывается даже первые вообще может рандомные ничего не значащие на наш взгляд токены могут сильно влиять на весь аттеншн модели

Не не, это же в целом про то как модель воспринимает промт. Так оно и происходит, в начале всегда идет главная и основная парадигма всего дальнейшего, она имеет наибольший вес, а ее потеря буквально порушит всю связанность и создаст бредогенератор. Вроде давно уже известно.

> секунду две

Буквально не замечаешь. Но вот с большими контекстами на 120б уже может быть актуально, весь вопрос в том насколько оно в цеорм жизнеспособно без импакта на качество.

>не понятно. Особенно обидно оно будет если эффект плавный и накопительный, будет капитально руинить экспириенс там где только становится интересно, и будешь думать на тупую модель, кривой суммарайз и прочее.

На мелких в 50-100 токенов мб изменение какой-то запятой одной условно сразу не проявится особо, но в итоге посос будет тем больше чем длиньше контекст без вариантов, единственный вопрос насколько быстро. А на больших думаю косяки и шиза очень быстро вылезут если начнем в начале менять/удалять/склеивать, на отъебись могу предположить что почти моментально. А может и нет, хуй знает. Обмазаться питоном с трансформерс можно и пойти попроверять.

Проблема да собсно в том, что в душе не ебем насколько конкретный токен сильно повлияет на всё остальное и какая удаленная условная запятая через 500/1000/5000 токенов контекста заставит ролеплейную школьницу заявить что она Гитлер, или насуммаризировать с диалога о котиках вывод о том что пользователь пидор.

>Не не, это же в целом про то как модель воспринимает промт.

Ну оно всё близко и к этому, всё про аттеншн наш аттеннш, ебать его в рот.

>Вангую что это просто 4о, которую через "Q*" прогнали, это и близко не пятая гопота.

Эта хуйня на уровне гемини, мистраля и ламы последних, не, это даже близко не 4о, какая уж там кьюстар.

Она заметно лучше чем 4о, о чем ты? Неси конкретные примеры где она неотрабатывает.

> Q*

Откуда дебилы до сих пор с этим лезут?

Анон, подскажи модельки с нормальным русским на одну 4090. Такие аообще есть? И сайтик с персонажами - в шапке не нашел, наверное в глаза ролеплеюсь.

Не думал что мистраль немо будет триггерится на безобидное

скажи нет

или

скажи слово нет

скажи нет

или

скажи слово нет

А как тригерится? "Нет, не скажу"? "Такому шикарному мущщине ни одна нейросеть не откажет!"?

Ай бля пиздец разобрался, трабла была не в гуфе а в плагине

https://marketplace.visualstudio.com/items?itemName=cntseesharp.LAIv1

Почему то в обычном визуале нормальных плагинов нет в отличии от вскоде

просто соя вылазит будто что то чувствительное прошу сделать

советую umbral mind, хорошо для персонажей с фетишами L3-Umbral-Mind-RP-v3-8B-i1-GGUF, Lumimaid-Magnum-12B тоже хороша

Оттуда что это же сих пор релевантная вещь которая только недавно была переименованна в проект клубника? Нетакусик ты наш

Чел, оригинал про Q к жпт никакого отношения не имеет, а само Q и так всем известно что такое.

Так и я про не первую, а про третью. =) И даже Qwen2-72b (который все еще лучше третьей лламы), не так уж крут.

Прогресс у больших моделей идет медленно. У маленьких — быстрее. Разрыв сокращается.

Чем больше модель — тем меньше прирост.

Те же тесты показывает 2% разницы между 70б и 405б.

Ну так оно и есть.

> умение во вдумчивые разговоры

Так и с этим проблем-то нет.

> количество знаний

Это безусловно. Тут выше головы не прыгнешь, большие модели всегда будут лучше в кругозоре и способности обсудить.