> материнку на современном чипсете с двумя полноценными слотами 4-ой или 5-ой версии PCIe х 16 от процессора

Сборка будет стоит как 4090, пара х16 4.0 это современный зеон или трипак. Профит от 16 линий не будет стоить так дорого, особенно в ллм.

У тебя на пикчах плата обычноый 3090 или какой-то суперэкзотический прототип, разобранная FE - пикрел. Фишка ти в памяти на одной стороне которая прекрасно охлаждается.

Если у них распиновка одинаковая то уже возможно, но тогда началось бы раньше с амперов, вбросы хаков биоса и 3070 с 16 гигами уже давно были.

> От разных L40S биос не подойдёт, потому что память другая

Там и чип отличается, а так бы даже с другой памятью была бы неплоха. Если хуанг не навалит памяти или революционного перфоманса в блеквеллах то эта штука становится интересным приобретением.

> MiniCPM-V is a series of end-side multimodal LLMs (MLLMs) designed for vision-language understanding. The models take image, video and text as inputs and provide high-quality text outputs.

https://github.com/OpenBMB/MiniCPM-V

https://huggingface.co/openbmb/MiniCPM-V-2_6-gguf

https://github.com/OpenBMB/MiniCPM-V

https://huggingface.co/openbmb/MiniCPM-V-2_6-gguf

https://www.reddit.com/r/LocalLLaMA/comments/1erelsv/i_created_a_3d_bar_with_an_ai_bartender_that/

I created a 3D bar with an AI bartender that works on the web

You can try it for free at https://www.mangobox.ai/ !

I've seen a bunch of AI character type stuff online, but all of them were boring chat interfaces. I thought it would be more fun to give the characters an avatar and a 3d environment to interact with.

The stack I'm using is Claude 3.5 for the LLM, OpenAI TTS, Stable Diffusion for generating drinks, and three.js for rendering. I exposed the prompt I'm using so people can play around with it by clicking the robot icon. If people enjoy this I can also make more environments, character customization options etc.

I could easily make this self-hosting by connecting it to local LLMs and TTS instead. Let me know if you're interested!

I created a 3D bar with an AI bartender that works on the web

You can try it for free at https://www.mangobox.ai/ !

I've seen a bunch of AI character type stuff online, but all of them were boring chat interfaces. I thought it would be more fun to give the characters an avatar and a 3d environment to interact with.

The stack I'm using is Claude 3.5 for the LLM, OpenAI TTS, Stable Diffusion for generating drinks, and three.js for rendering. I exposed the prompt I'm using so people can play around with it by clicking the robot icon. If people enjoy this I can also make more environments, character customization options etc.

I could easily make this self-hosting by connecting it to local LLMs and TTS instead. Let me know if you're interested!

>Сборка будет стоит как 4090, пара х16 4.0 это современный зеон или трипак. Профит от 16 линий не будет стоить так дорого, особенно в ллм.

Ну здесь же постоянно ноют "упор в шину, упор в шину". Хорошо, тогда два честных x8 от процессора, таких плат полно.

Понимает по-русски. Если повезёт, то и писать/говорить будет.

> здесь же постоянно ноют "упор в шину, упор в шину"

Да не особо. Один поех шизил что у него токены в шину упираются, ни единого пруфа не было, только опровержения.

Более медленная работа карточки в задачах с относительно большой пересылкой данных - да, может просесть аж на 30% в 3.0 х4 по сравнению с 4.0 х16, диффузия и запуск ллм разницы практически не проявляют. Существенно может быть только при тренировке, когда отстающая карточка тормозит всех. Вот и сам думай, нужно ли столько переплачивать за подобный выигрыш, что в твоих задачах может и никогда не проявится.

>3070 с 16 гигами

https://www.reddit.com/r/LocalLLaMA/comments/1dd79dj/upgrading_rtx_3070_to_16gb/

Сюрприз, на 3070 достаточно перепаять банки и пару резисторов, хаки биоса не нужны. Да их и нет, кроме разной хуйни типа биоса от А6000 для 3090.

>уже возможно

Лол, они уже сделали такой свап, а ты пишешь "возможно". Это не "возможно", это уже сделано и работает. А вот чтобы завелась 3090 на 48 гигов, нужен уже модифицированный биос, с которым задница. Потому эти новые дэшки так интересны, но, подозреваю, всё дело именно в них и никакого способа взломать биос не изобрели, только для дэшек.

>Там и чип отличается

Всё тот же GA102, немного покруче. Отличие от 4090 примерно на уровне отличия 4090 от 4090D.

> а ты пишешь "возможно"

Литературу почитай а не только жптизмы, откроешь смысл фраз в контексте а не будешь все трактовать дословно.

> дело именно в них и никакого способа взломать биос не изобрели, только для дэшек

Если также нет никакого лока и само заводится то вполне может быть. Вдвойне забавная санкционная опция.

> Всё тот же

Не тот же, стартовый индекс уже не означает одинаковую начинку и просто отключенные части. Эти отличия и не дадут запуститься с тем же биосом, при том что кристалл может уметь работать с разными типами врам.

А у опенаи была какая то новая методология и алгоритмы? Или просто хорошо подрьранные и обученные данные? Я просто пытаюсь отследить и собрать в голове эаолюцию языковых моделей.

Третья прям сильно замедлить может.

Что странно, по какому оно принципу отрабатывает, так и не ясно.

Таверна да, она посылает полный запрос. Но, по идее, насколько я знаю, пока верхняя часть не меняется, можно было бы посылать и как часть запроса. Хезе, как там эта таверна работает, у каждого свой форк. =)

Ну так а ты просто погугли, посмотри чужие тесты, посчитай сам. Важно оно тебе или нет.

Помню тут был антитеслошиз, который угарал, что теслы считают контекст долго, и «до первого токена» получается полторы минуты.

Про теслы правда — они считают контекст как проц.

Но в прошлом треде кто-то про пару 3090 () говорил, что «до первого токена» 40 сек (). Звучит как ебучий провал от карты, которая в одиночку выдает 10 сек (ладно, 12-15) до первого токена в максимуме. Причем, в чем беда-то не очевидно — то ли проблема с шиной, то ли проблема с экслламой, то ли хуй его знает что у него. Но сам факт, что от двух 3090 ждешь не 40 секунд обработки контекста. Учитывая, что уже давно кидались скрины с 2000~2500 токенов/сек промпта (за 40 секунд при таком раскладе ты 100к контекста пересчитать должен, а не 32к).

В общем, не советую никому верить, а лучше самостоятельно проверить — снять сервачок, проверить все его характеристики и погонять.

Если ты не гоняешь контексты выше 16к, то вряд ли x4 линия станет для тебя проблемой. х8 будет уже достаточно для быстрых ответов.

Но если ты дохуя богатый и хочешь получить первый токен как можно скорее…

У них были суцвекер, его учитель и еще кто то, забыл. Кто и развивали эту тему. И я так понимаю самые смачные наработки по этой теме ушли с суцвекером из попенаи, как и еще с несколькими разрабами. Думаю с начала травли суцвекера никакими новыми разработками он не делился, а это уже почти год на сколько помню.

Поэтому у них такой простой. Жадный пидор отжал власть в компании, но не подумал что выгонять на мороз главного разраба и сооснователя компании чревато внутренними проблемами с разработкой этого самого передового ии

Вобще изначально клозедаи набрали себе энтузиастов в области нейросетей со всего мира под благовидным предлогом опенсорса, а потом когда собрали все сливки подсадили всех под подписки о неразглашении и кучу бабок и закрыли компанию полностью, в чем и был план как где то писалось.

Так что топовые спецы + полностью спизженый интернет + открытие сразу же доступа всем желающим к получившемуся ии, для сбора диалогов и формирования новых датасетов = дали то что ты видишь

Что за квантование? Чем ниже, тем хуже? По дефолту ollama run llama3.1 (и другие) качает квантованную до 4, поэтому для теста рекомендуют ставить Q8? Вроде просто. Почему 16 - fp16, а 8 уже - Q8, а не fp8? На этом рубеже (16>8) выгодней использовать другой метод понижения точности, то есть квантование? Не совсем ясно, чем отличается от понижения точности float, но видимо и нет смысла знать мелкие детали.

>корпоративные сетки в принципе доступны, так что не еби мозги

Говорю же, предложи. Пока что выходит, чтобы получить бесплатно апи, нужно ебаться или делать бесконечные копипейсты из чатов. Это если мы говорим о коде и интеграциях вроде таверн. Для простых задач copilot/chatgpt справляются, да.

>Для кодинга неплохи codestral и deepseek v2

Какую бы выбрал, почему?

>плагин continue

Замечал это название. Видимо, с ним и придется иметь дело. Перейдя на VS Code сначала.

>Лламу-3 выбрось

Для чего она тогда вообще? База для дообучений?

Освобожу место, поставлю немо и потом дипсик.

>корпоративные сетки в принципе доступны, так что не еби мозги

Говорю же, предложи. Пока что выходит, чтобы получить бесплатно апи, нужно ебаться или делать бесконечные копипейсты из чатов. Это если мы говорим о коде и интеграциях вроде таверн. Для простых задач copilot/chatgpt справляются, да.

>Для кодинга неплохи codestral и deepseek v2

Какую бы выбрал, почему?

>плагин continue

Замечал это название. Видимо, с ним и придется иметь дело. Перейдя на VS Code сначала.

>Лламу-3 выбрось

Для чего она тогда вообще? База для дообучений?

Освобожу место, поставлю немо и потом дипсик.

Ну т.е. никаких новых алгоритмов и подходов? Как то это грустно что ли.

Так, мистеры майнеры.

Вот такая хуйня для 100 (50% паверлимит) или 180 ватт с 6+8 пин доп.питанием пойдет или в натуре хуйня?

Вот такая хуйня для 100 (50% паверлимит) или 180 ватт с 6+8 пин доп.питанием пойдет или в натуре хуйня?

Для больший моделей падение не сильно заметно.

123B хороша и в 2 битах.

70B в 4.

20B в 5.

12B в 6 бит норм.

7-8-9 уже лучше в 8 бит использовать. Т.е., Q8 или 8bpw.

Конечно, частные случаи бывают, но усредненно где-то так.

fp16 — floating point.

q8 — int8, integer, целочисленное.

q4 тоже int8, вообще-то.

Но это уже quant просто.

q4_0

q4_1

q4_K

iq, imat, различные варианты квантования с различными фичами.

Грубо, ты округляешь значение.

Вместо точных координат токена имеешь их более грубые значения, из-за чего, при выборе (предсказании следующего токена) начинают допускаться ошибки, и модель ошибается или шизит.

Я не спец, объяснил просто, мог ошибиться в деталях.

> Какую бы выбрал, почему?

Дипсик быстрее и, по тестам, не уступает, а зачастую и превосходит (как Денди на миду) Кодстраль.

>Но, по идее, насколько я знаю, пока верхняя часть не меняется, можно было бы посылать и как часть запроса.

Ну Кобольду например всегда посылается полный промпт и он внутри себя делает дифф. Если почему-то решит, что промпт изменился не с конца, выполняет полный пересчёт, иначе контекст шифт - отрезает от уже обработанного контекста сверху, обсчитывает новое и пришивает к низу. И для него есть у Таверны отдельный интерфейс. А вот для экслламы нету, она на дефолтном сидит. А он, говорят, плохой. Здесь же есть люди с 2-3 3090? В две таких спокойно влезает 70B exl2 3.8BPW с 32к несжатого контекста. Уверен, что та же проблема будет. Просто они выше 16к не ставят, а то и выше 8 - а это 20 или даже 10 секунд на полный контекст. А так должна быть та же фигня.

>А у опенаи была какая то новая методология и алгоритмы?

У них был компут тайм, которым всё завалили нахуй.

>Что за квантование?

Шапку прочти.

А хули ты хотел. Мир грустная штука.

>такая хуйня для 100 (50% паверлимит) или 180 ватт

А причём тут хуйня и ватты? Ватты будут жраться с доппитания. Впрочем пикрил максимум уёбищное решение, бери уровнем выше.

>иначе контекст шифт - отрезает от уже обработанного контекста сверху

Просто сверху ещё до шифта отрезали, шифт может большее, например, удаление токенов с середины.

imat только для vram,

твердо и четко иначе

будут тормоза на cpu.

> бери уровнем выше.

Ок, выберу что-то более адекватное, спс.

Поди узнай что их нет.

На сколько помню веса гпт3 так и не были открыты. Это может указывать на то что там есть какой то ключевой неизвестный элемент, дающий попенам конкурентное преимущество по сей день.

Помимо этого, глупо думать что собрав столько топовых спецов они не открыли что то новое, очевидно что да. Там постоянно используются новые подходы, даже в опенсорс.

Что творится в компании которая хранит свои секреты серьезней чем ядерное оружие - поди узнай.

>А так должна быть та же фигня.

Но у меня всё ещё есть вопрос - владельцы пары мощных карт, где на больших моделях задержки на полную обработку контекста уже начинают напрягать - они как-то решили эту проблему или терпят? Просто может настройки какие есть, которые облегчают жизнь?

> Таверна да, она посылает полный запрос.

Она и обязана полный запрос посылать, иначе и быть не может.

> «до первого токена» получается полторы минуты

Это все еще ужасно и кринжово, ведь такое с мелким контекстом 8к на уже мелкой 70б, где вообще все моментально должно быть. Против 30 секунд на 123б с контекстом 24к. Разницу смекаешь? 70т/с на 70б против 700т/с на 123б.

> которая в одиночку выдает 10 сек (ладно, 12-15) до первого токена в максимуме

Где, в каких условиях? Что за поток сознания, слишком глуп чтобы понять зависимость всех скоростей от размера модели?

> Если ты не гоняешь контексты выше 16к, то вряд ли x4 линия станет для тебя проблемой. х8 будет уже достаточно для быстрых ответов.

Шизоид, тащи пруфы своих фантазий.

Для кода, для своих размеров и во времена выхода, что было не так и давно, я использовал и довольно успешно codeqwen-1_5-7b-chat, Codestral-22B-v0.1, Llama-3-8B-Instruct-Coder-v2

У кодеквин длинный контекст, что довольно удобно

Новые сетки так же хороши, Mistral-Nemo-Instruct-2407 как и gemma-2-9b

Главное помнить что это не самостоятельный ии разраб, а скорее инструмент помощи специалисту, которым надо правильно пользоваться.

По опыту очень удобно давать сетке задачи или спрашивать о темах с которыми ты знаком но плаваешь в них, когда они на краю твоих знаний.

Тогда ты можешь быстро учится новому и тут же использовать эти знания. А небольшое знание в теме дает тебе возможность отделять галюны сетки от рабочей информации, что дает этим знаниям проверку и достоверность

Я пруфов накидал пачками, могу лишь посочувствовать, если ты игнорируешь все, что не вмещается в твой маня-мир.

Искренне.

А дипсик не пробовал?

Вообще, очевидно, GIGO же, «что на входе, то и на выходе» культурным языком.

Это не значит, что ллм плохи или недостаточно хороши для кода.

Просто пока они не умеют достаточно хорошо фильтровать хуевые запросы хуевый программистов, или темы, где ты не понимаешь, че тебе надо.

А при хороших запросах, которые пишутся той же сеткой в мультиагентном режиме (один разбирает запрос, формулирует его нормально, второй составляет план и по нему расспрашивает, третий дает ответы) это вполне себе нормальный джун получится.

Ну и код-ревью забывать не стоит, даже когда джун — человек. =)

Вообще, мультиагентные системы давно баян, но пока не снискало популярности, тренд только поднимается, увидим, тащемта.

Нет, это говно начнет вонять и плавиться при малейшей нагрузки со слота, ибо шлейф ужаснейший. При особой удаче может проплавиться до линий и убить проц и карточку. Есть такие же варианты с подпаянным молекс разъемом, их уже как-то можно юзать.

Плюс оно может не завестись на 3.0 стандарте из-за помех, придется скидывать версию чтобы не подыхало в ошибках. В сочетании одной линией на мощной карточке будет шанс отловить влияние шины, о котором вещает теслашиз, пытаясь оправдать некроту и жорино говно.

> 123B хороша и в 2 битах.

Нет, она тупит, шизит и часто ошибается.

> 20B в 5.

> 12B в 6 бит норм.

> 7-8-9 уже лучше в 8 бит использовать.

На самом деле в бенчмарках у них относительная деградация/улучшение от битности не показывает зависимости от размера. Прувмивронг, сколько не смотрели, все больше субъективщина, плацебо и "потому что я могу", а тема ведь интересная.

> q4_0

> q4_1

Легаси, выкинуть и не приближаться. Разве что на тесле цифру в бенче увеличить.

> q4 тоже int8

> q4_K

does he know

Именно в общем на пальцах объяснил прилично.

> Я пруфов накидал пачками

Хде? Покажи хоть один? Только шизоидный понос про "1 линия - 100т/с".

>А дипсик не пробовал?

Мое или обычный? Как то не, они выходили либо раньше чем я начал кодить с сетками, либо когда я уже наигрался и нашел подходящие. Его хвалили на сколько помню

Запускал пару раз и даже кодил, но не проверял глубоко что бы сравнить его возможности с другими

Агенты конечно дают большой буст мозгам сеток. Но чудес нет, без человека ни одна даже самая крутая сетка не может заменить даже джуна. Так что пока это инструмент помощи спецу, хотя бы как замена гугла который сразу дает ответ

Думаю проблема не в сетках, а в том что не все умеют ими пользоваться. Как и сказано, ожидают джина который выполнит им желание и расстраиваются когда реальность с этим не сходится.

Кстати, оптимизация, чистка кода и код ревью, как и комментирование у сеток отличные.

Кодить с нуля на них боль, а вот давать преобразовывать уже готовый код очень приятно. Так что код ревью нейронкой стоит того

> Агенты конечно дают большой буст мозгам сеток

> это инструмент помощи спецу

> проблема не в сетках, а в том что не все умеют ими пользоваться

> оптимизация, чистка кода и код ревью, как и комментирование у сеток отличные

Базу выдал прямо, неистово двачую

> Кодить с нуля на них боль

Вот тут только не соглашусь, с более менее умной можно сначала обсудить с примерами как лучше реализовать конкретную задачу/идею, уже в беседе подмечая что-то полезное. Потом или сразу приказать написать заготовку, внести правки, самому что-то изменить, и далее итерациями или уже самому.

Главное - контекст лучше не накапливать, если не удалять старые запросы и прошлые варианты кода то оно очень быстро тупеет.

>Вот тут только не соглашусь, с более менее умной можно сначала обсудить с примерами как лучше реализовать конкретную задачу/идею, уже в беседе подмечая что-то полезное. Потом или сразу приказать написать заготовку, внести правки, самому что-то изменить, и далее итерациями или уже самому.

Так это и есть "боль". Можно, но потратив кучу времени и усилий, или ты получишь не рабочий код или не тот что нужен.

По сравнению с

> оптимизация, чистка кода и код ревью, как и комментирование

где просто кинул и попросил сделать заебись, иногда совершенно буквально

И получаешь результат сразу, чаще всего рабочий.

Ну а вобще я в таверне кодил, настраиваешь промпт формат, берешь или делаешь карточку прогера, вводишь сетку в курс дела давая тз, можно разрешить ей задавать вопросы и потом просишь примеры кода.

И да, можно кодить с нуля какую то задачу, не особо сложную если речь идет о мелких локалках, единым куском скрипт строк на 100 выдает например.

После небольших доделок все работает, если нет - кидаешь сетке ошибки и она исправляет.

Повторять до посинения победы

Про контекст тоже верно, я обычно если он разросся, стираю все примеры кода сетки и кидаю ей последний вариант с которым она с нуля начинает работать

> влияние шины

Ты тот самый, которого мне искренне жаль, или еще один человек, неспособный в математику и чтение слов на русском?

> Нет, она тупит, шизит и часто ошибается.

Все еще лучше любой 70б, даже так.

Хотя, я согласен, что на краю. (тащемта, q2 это 3 бита, но похуй).

> Разве что на тесле цифру в бенче увеличить.

Как же тебя трясет, триггеришься на все вообще.

Я просто в порядке появления перечислил, понадеялся, что человек не станет использовать настолько старую хуйню. Должен же быть здравый смысл у спрашивающих.

> Хде? Покажи хоть один?

Ты продолжаешь игнорировать ссылки, которые я скинул, да?

Ну, шо тут скажешь. Тяжело тебе.

———

Слушай, вот без приколов, после всей той шизы, что ты несешь.

Почему ты так ненавидишь теслу и триггеришься вообще на все, что способен притянуть к тесле хоть как-то?

Твою (нейро-)тянку выеб тесловод? Ты купил теслы, а они тебе не дали, спалили мать и проц? Или почему?

На весь тред ты единственный пиздец агрессивный чел за последние тредов пять, наверное.

Все спокойно общаются, один ты бегаешь и «ТЕСЛА ЭТО…», как будто тут кому-то ни похуй в большинстве случаев.

Нет, я могу понять, когда кто-то спрашивает про теслы, или кто-то советует их покупать. Тут твои комментарии контекстно уместны.

Но когда речь заходит о том, что существует q4_0 (просто существует), ты тут же прибегаешь с криком про теслу, мол, вот теслаебы на ней циферки поднимают.

Дегенераты, конечно, если на хуевом кванте поднимают циферки, когда для них есть q4_K_M, но я даже вот щас попытался и не смог упомнить случая, когда хоть один теславод бы хвалился скоростью именно в q4_0. Да, тестировали, да, рост есть, но формат говной пахнет, никто его не юзает (я надеюсь=).

Пожалуйста, take a deep breath энд просто ответь: почему тебя так триггерит существование теслы п40?

Надеюсь никак не нанес тебе моральных страданий своим вопросом.

Deepseek-Coder-Lite-V2 — моешный он, да.

Он выходил чуть позже кодстрали.

> Но чудес нет, без человека ни одна даже самая крутая сетка не может заменить даже джуна.

Ну эт полная чушь. Любой джун максимум на уровне сетки работает, а чаще гораздо хуже.

Большинство людей, говоря, что сетки хуже джунов, почему-то думают о сеньорах. =)

Даже когда тот чел с ютуба, который юнити продвигает (тот еще недалека, канеш), сравнивал разных спецов и нейронку, в общем согласился, что джун написал не сильно лучше нейронки.

> хотя бы как замена гугла который сразу дает ответ

Ну, это простейший способ ими пользоваться, когда совсем не понимаешь инструмента. Но она может больше в умелых руках.

Опять же, хз, может ты просто в эту сторону не смотрел всерьез, не пробовал подойти, хз.

Ну или джуны в твоей фирме отборные, после сеньорства в озоне приходят. =D

Sus-column-r к счастью оказался Grok 2, поэтому ждем что высрут клозеды завтра, может там реально революция. Это странно кстати, потому что он порой почти точь в точь выдавал тоже самое что и 4о, но это возможно потому что они свою сеть на нем фантюнили.

Не следил за сус-колумн-р.

Че, насколько она хороша была? Чего ждать от грока?

На 4о многие жалуются, что тупая и маленькая, поэтому дешевая.

А грок в прошлый раз был большой и тупой.

В итоге что вышло-то? Со второго раза у Маска получилось?

>Ну эт полная чушь. Любой джун максимум на уровне сетки работает, а чаще гораздо хуже.

Зависит от того что называть джуном, сегодня вакансии на джуна в россии имеют требования как на миддла, кек

Я не особо работал с большими платными сетками последнее время, слышал новый клод ебёт, так что местами он и ему подобные топовые сетки, верю, джуна заменят. Да и миддла подвинуть могут. Но полной замены опять же нету, сетке все равно нужен контроль и направление. Оператор нейросети, как звучит

>Ну или джуны в твоей фирме отборные, после сеньорства в озоне приходят. =D

Я не кодер, так что могу ошибатся, по мне еще рановато для полной замены джунов, самостоятельности у сеток и самоконтроля до сих пор нету.

Хорош в плане решения относительно сложных задач требующих решения шаг за шагом. Если задача уровня сгенерировать стишок, то он напрямую, без обдумывания, напишет примерно такой же кал как и остальные близкие к топ уровню модели. Если задача решить математическую задачку, то он уже каким-то уникальным CoT пройдется по ней и с большим шансом даже решит правильно. Что интересно он может понять что сделал ошибку, обдумать это и начать решение заново, но это не всегда приводит к верному решению в итоге. В целом топ модель для подобных задач, пока что, пока Альтман не выкатил свою йобу и средняя для остальных тасок. Для Маска прогресс очевидный конечно.

> Оператор нейросети

Йеп, еще год назад на эту тему шутили, мол, профессия будущего. =) И, вот оно, потихоньку появляется.

О, ну было бы интересно посмотреть на нее в попенсорсе, конечно. =)

Стишок я попытался тока шо. Чатгопота написала хорошо, грок как ты сказал.

>сегодня вакансии на джуна в россии имеют требования как на миддла

Да и не только в России, во всём мире избыток джунов и мидлов. В России просто по понятным причинам избыток острее.

Где найти какой-нибудь нормальный гайд по так называемому промт-инжиниренгу? Ебусь уже не первый день, пытаясь заставить модель отвечать именно в том формате, который мне нужен. Кое-какие успехи поимел, но ценой того, что длина промта увеличилась до 900 токенов, что дохуя, учитывая ограничение контекста в 8к и что еще сама карточка персонажа сожрет свое.

Кстати, заметил странность как раз по поводу промтов. При забивке контекста примерно до 4 тысяч, модель начинает частично игнорировать инструкции и опираться исключительно на предыдущие сообщения в чате. Это как-то фиксится?

Стоит дерьмо в виде ламы 3

Кстати, заметил странность как раз по поводу промтов. При забивке контекста примерно до 4 тысяч, модель начинает частично игнорировать инструкции и опираться исключительно на предыдущие сообщения в чате. Это как-то фиксится?

Стоит дерьмо в виде ламы 3

>Где найти какой-нибудь нормальный гайд по так называемому промт-инжиниренгу?

https://www.promptingguide.ai

Ну а вобще - опыт

Есть модели с реальным окном в 4к, как гемма 2

Тоесть может в 8, но помнит четко только последние 4

Ллама 3 вроде 8 имеет, скачай тогда ллама 3.1, если у тебя с настройками контекста все ок то будет норм давать ответы до 32к

> Так это и есть "боль"

Не то чтобы, можно делать неплохие заготовки быстрее чем вручную или другими средствами. Или более элегантную реализацию, которой не ожидал. Но все зависит от задачи и конкретного случая, в сложное сразу не может.

> которого мне искренне жаль

Лучше себя пожалей, твоя высокомерность не сочетается со статусом (по всем пунктам) и возрастом. Даже в тематике треда тебе важнее оправдывать свои убеждения и проецировать обиды, чем найти что-то новое и полезное, нахуй так жить?

> Все еще лучше любой 70б, даже так.

Не лучше, когда лламы были без контекста можно было спекулировать, сейчас нет. Оно ужасно тупит, а в задачах с тем же контекстом совсем сдается.

> Как же тебя трясет, триггеришься на все вообще.

Неужели угадал, оно действительно быстрее? Иначе зачем вообще скачивать мусорный квант, дело раскрыто. Имплаит спокойствие и сразу оформляет проход в тряску, топ кек.

> ссылки, которые я скинул, да?

Где? Показывай свои ссылки.

> вот без приколов

Как можно без приколов с тобой общаться? Все эти попытки быть обидным только в ржач пробивают. А если серьезно, во-первых, ты обманываешь, уводишь в сторону и всячески вредишь в угоду оправдания безумных идей и прошлых ошибок, как сектанты, чем вызываешь неприязнь. Во-вторых, твой паттерн поведения идеально ложится на жертву травли, которая страдает но сквозь слезы копротивляется и делает вид что ей на самом деле все хорошо, чем только провоцирует дальнейшие издевательства. Вот над тобой и регулярно глумятся пока ты как собака носишься и пытаешься детектить обидчиков. Заметь, в треде много тесловичков но свидомый лишь один.

Не волнуйся, от этого есть средство - повтори подвиг флагшток куна с теслой в жопе и все сразу пройдет. Почувствуешь силу землижоры.

>https://www.promptingguide.ai

Благодарю. Завтра чекну.

>ллама 3.1

Вроде писали что она тупее стоковой тройки и более соевая, хотя я об этом читал недели три назад, может че то и поменялось.

А может быть проблема с флеш аттеншеном? Он у меня отключен в кобальде и как-то я все время игнорировал это.

Кобальд последний?

ллама 3 уже старая и должна норм и так работать, хз

Флеш аттеншен полезен для ускорения генерации, ну и квантовать кеш, что уменьшает потребление памяти контекстом сетки

Вроде все, больше не помню че он делает

По моему опыту эти гайды не особо то и нужны. В плане того, что если ты пишешь модели что-то сделать и она делает это криво скорее всего это модель говно, а не твой промпт. Другое дело на счет оптимизации промпта и приведения его к такому виду, чтобы модель тебя слушалась чаще. В таком случае могу дать совет попросить саму нейросеть переписать для тебя промпт как нужно. Так и напиши: "вот есть промпт для нейросети, укороти его, но так чтобы основная суть осталась той же", нейросети хороши в промптинге внезапно. Второй совет: используй примеры. Если ты дергаешь модель через апи или юзаешь плэйграунд, ты можешь написать ответ заместо самой сети несколько раз в том формате который тебе нужен, так чтобы оно сохранилось в контексте, и в следующий раз оно тебе будет отвечать в верном формате. Третий совет: если хочешь программно брать из ответа какие-то значения используй популярные форматы которые она уже знает. Для выделения ответа xml тэг вроде <answer></answer>, для сложных объектов JSON. Так же можно заставить модель юзать инструменты опять же прося описывать их вызов через xml. Если все таки хочешь посмотреть как промптят дяди которые сами разрабатывают нейронки посмотри anthropoc cookbook. Но это мои советы как чела который юзает нейронки в основном для кодинга и их юза из кода, так что соряныч если не то что хотел.

> заставить модель отвечать именно в том формате, который мне нужен

Какой именно формат и какая задача? Нормальных простых гайдов нет, или душнилово, полезное и правильное но в котором уснешь, или херь.

Если нужно сохранение структуры - грамматика, можно искусственно автоматически подшаманить токены так, чтобы они складывались в нужные предложения. Если тебе для обработки текстов - используй xml теги <text></text> <character> </character> или json формат, дав модели один или несколько примеров.

Если же тебе в рп отыгрывать какое-то поведение и правила - делай жестко, сначала укзаывай в начале а потом суй их в префилл модели. Также как делают в жб, только исключить "кошка делает мяу мяу" а сразу перейти к сути, чтобы получилось на подобии

Okay, let me think first. I need to:\n' +

"- blah blah 1\n" +

'- blah blah 2\n' +

...

при этом оно должно быть согласовано с основным промтом а не противоречить ему. Например,

> let me think first

уже подразумевает что сетка это не чар а гейммастер/ассистент/кто-то еще, поэтому если стоит в начале "ты = чар" то это нужно оформить в OOC или какой-нибудь <system>

Если твоя задача влияет на формат и структуру ответов сетки, например нужно добавлять что-то в начале или в конце поста - примеры диалога решают. Может потребоваться несколько свайпов в начале, а после подхватит из прошлых постов.

> При забивке контекста примерно до 4 тысяч

В настройках таверны и ланучера проверь ограничение контекста. Если твоя инструкция в примерах и других частях, которые будут пропадать, выстави в настройках "всегда сохранять" их.

>Флеш аттеншен полезен для ускорения генерации, ну и квантовать кеш, что уменьшает потребление памяти контекстом сетки

Всё равно попробую его включить и посмотрю на разницу. Может что-то изменится, может нет.

>Другое дело на счет оптимизации промпта и приведения его к такому виду, чтобы модель тебя слушалась чаще.

Про это и вопрос как бы. Не хочется половину контекста тратить тупо на инструкции.

>В таком случае могу дать совет попросить саму нейросеть переписать для тебя промпт как нужно.

Пробовал, но она часто пишет так же хуево, как и я. В плане того, что она именно пишет пошаговую инструкцию, которая мало чем отличается по исполнительности от банального "не пиши за юзера, не используй пюрпл проз и не выебывайся".

>используй примеры

Вот только примеры она как раз и жрет. Если в экзампл мессейдж закинуть чего-нибудь, или прямо в карточке персонажа прописать, она слушается лучше. Но опять же, под каждого нового персонажа писать примеры это лишняя трата времени и сил.

>Если нужно сохранение структуры

Ну примерно это мне и нужно. У меня безпричинно сеть начинает иногда изрыгать тонны текста, хотя я прямо прописал, что нужно генерировать только один параграф и описывать одну конкретную реакцию или интеракцию. Ей в какой-то момент просто становится похуй, а в другой она всё делает правильно, чисто по инструкции.

>Также как делают в жб

Принципы жопабрейка я тоже использовал. Результат продолжает варьироваться - иногда она отвечает как надо, иногда генерирует от пизды.

>В настройках таверны и ланучера проверь ограничение контекста. Если твоя инструкция в примерах и других частях, которые будут пропадать, выстави в настройках "всегда сохранять" их.

Там уже все проверено. Терминал кобольда считает честные x/8192 при генерации, так что дело вряд ли в кобольде или таверне. Никаких растягивателей типа ропов у меня не стоит.

В связи с китайской модификацией 4090D с 48гб ВРАМ: прошёл слух, что арендовать её в Китае можно задёшево, что-то вроде 10 центов в час. Это было бы интересно.

Хочу докупить к Тесле P40, Теслу P100 вроде она чуть быстрее. Или не разводить зоопарк и купить P40?

На неодинаковых картах могут быть проблемы. К тому же количество ВРАМ имеет значение. Да и вообще, пара П40 отлично заходит, кто бы что не говорил. Кто успел купить по хорошей цене, тот вообще молодец. Но теперь она стоит минимум 30к; честно говоря лучше добавить ещё столько же и купить в пару 3090.

> генерировать только один параграф и описывать одну конкретную реакцию или интеракцию

У тебя может быть противоречие в системном промте, где сказано описывать детально. Еще такое бывает на шизомиксах, которые на любой запрос будет хуярить рп-подобный слоуп. Какая конкретно модель, лаунчер, параметры?

Проверяй чтобы не было ошибок и противоречий, поставь себя на место нейронки и подумай где есть лазейка через которую можно это обойти. Учитывая что там 900 токенов инструкции - это пиздец.

Или забей и делай жестче правилом в префилл. Если совсем не хочет - даешь указание "разделяй каждый параграф символом "<p>" и добавляешь его в стоп-токен, только подбери чтобы нигде не встречался и был одним токеном.

После получения 1-2 правильных сообщений должна идти стабильно.

> дело вряд ли в кобольде

Только если поломанный квант

> или таверне

С ней легко, по дефолту если стоит 4к то оно обрежет старые сообщения а вместе с ними может хапнуть и примеры/инструкции.

> 10 центов в час

Ага, еще доплачивать будут скажи. Ссаная 3090 0.2+ стоит, а тут такое счастье. 0.3-0.4 было бы норм ценой, там ведь чип быстрый.

> Хочу докупить к Тесле P40

Быстрее но меньше врам, потому не сможет взять на себя часть модели. Проблем не будет, просто нерационально ибо 40 гигов - мало. Хочешь быстрее - рассмотри к покупке 3090, они уживаются вместе.

>Проверяй чтобы не было ошибок и противоречий, поставь себя на место нейронки и подумай где есть лазейка через которую можно это обойти.

Я с ума сойду нахуй, если буду думать как нейросеть. Начну озорно подмигивать и мурмуркать в ухо.

>Учитывая что там 900 токенов инструкции - это пиздец.

Да, именно об этом я и говорю. Но только так мне удается заставлять ее держать стиль и описывать то что мне нужно. Хотя я более чем уверен, что это скилл ишью, и промт можно сократить раза в три. Просто пока мне это не удается.

>Если совсем не хочет - даешь указание "разделяй каждый параграф символом "<p>" и добавляешь его в стоп-токен

Это очень топорный и не для всех сценариев пригодный метод. Потому что сетка иногда не просто пишет несколько отдельных параграфов, а может разделить одну сцену на несколько частей (так происходит чаще всего). По этому со стоп токеном я просто получу огрызок и незаконченную сцену, где персонаж успеет только среагировать на мои действия, например, и не успеет дописать свою реакцию.

>по дефолту если стоит 4к то оно обрежет старые сообщения а вместе с ними может хапнуть и примеры/инструкции.

Инструкции как и простыня персонажа отправляется каждый раз с каждым сообщением, если я не ошибаюсь. Это жрет контекст, но зато вроде как не дает сети забыть об инструкциях. А примеры она сама вырезает после какого-то там сообщения, но это можно настроить.

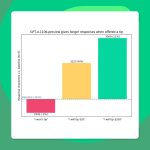

https://www.reddit.com/r/LocalLLaMA/comments/1esadlh/nvidia_research_team_has_developed_a_method_to/

Nvidia Research team has developed a method to efficiently create smaller, accurate language models by using structured weight pruning and knowledge distillation, offering several advantages for developers:

• 16% better performance on MMLU scores.

• 40x fewer tokens for training new models.

• Up to 1.8x cost saving for training a family of models.

The effectiveness of these strategies is demonstrated with the Meta Llama 3.1 8B model, which was refined into the Llama-3.1-Minitron 4B. The collection on huggingface: https://huggingface.co/collections/nvidia/minitron-669ac727dc9c86e6ab7f0f3e

Technical dive: https://developer.nvidia.com/blog/how-to-prune-and-distill-llama-3-1-8b-to-an-nvidia-llama-3-1-minitron-4b-model

Research paper: https://arxiv.org/abs/2407.14679

Nvidia Research team has developed a method to efficiently create smaller, accurate language models by using structured weight pruning and knowledge distillation, offering several advantages for developers:

• 16% better performance on MMLU scores.

• 40x fewer tokens for training new models.

• Up to 1.8x cost saving for training a family of models.

The effectiveness of these strategies is demonstrated with the Meta Llama 3.1 8B model, which was refined into the Llama-3.1-Minitron 4B. The collection on huggingface: https://huggingface.co/collections/nvidia/minitron-669ac727dc9c86e6ab7f0f3e

Technical dive: https://developer.nvidia.com/blog/how-to-prune-and-distill-llama-3-1-8b-to-an-nvidia-llama-3-1-minitron-4b-model

Research paper: https://arxiv.org/abs/2407.14679

>Эффективность этих стратегий продемонстрирована на примере модели Meta Llama 3.1 8B, которая была усовершенствована до модели Llama-3.1-Minitron 4B.

Лично моя вера в то, что маленькие модели ни на что не годятся была подорвана с выходом Мистраля Немо и третьей Лламы 8В. Новости хорошие. Вот только проблема: разыграешься на какой-нибудь хорошей восьмёрке, и вроде всё хорошо, а потом переходишь в том же ролеплее на 70В и вернуться на восьмёрку просто невозможно. Семидесятки ведь тоже улучшаются...

Из-за идиотской постоянной задержки для полной обработки промпта на связке из двух 3090 вернулся на теслы и оказалось, что на трёх теслах ролеплей приятнее, чем на двух 3090. Да, 16к контекста обрабатываются более трёх минут. Только происходит это нечасто. Да, приходится вырубать все крутые фишечки Таверны, для которых промпт приходилось пересчитывать каждый ответ. Но зато контекст шифт нормально работает и даже рероллить можно. Да, скорость генерации вдвое ниже, чем на 3090 при вдвое меньшем контексте, но хватает в принципе, а генерация начинается почти сразу. И модель жирнее. Такие дела.

Звучит как хуйня. Как 1 т/с могут быть приятнее честных 10-15 т/с? На EXL2 обработка всех 16к промпта - это 5 секунд, в рп ответ всегда мгновенно начинается.

> твоя высокомерность не сочетается со статусом

Не-не, это не высокомерность. Я не смотрю свысока, не в этом смысле.

> Оно ужасно тупит, а в задачах с тем же контекстом совсем сдается.

Ну ладно, не буду спорить, все же, защищать q2 — тоже шиза, полагаю, полноразмерная модель гораздо лучше, а на тяжелых задачах с контекстом я ее не гонял, да. Меня просто порадовало количество знаний и понимание вопросов, но я буквально пару раз ее юзал.

> Где? Показывай свои ссылки.

В третий раз? :)

https://github.com/turboderp/exllama/discussions/16#discussioncomment-6243456

https://www.reddit.com/r/LocalLLaMA/comments/1d8kcc6/psa_multi_gpu_tensor_parallel_require_at_least/

Буковки. Циферки. Кулькулятор.

Там же все просто.

> А если серьезно, во-первых, ты обманываешь, уводишь в сторону и всячески вредишь в угоду оправдания безумных идей и прошлых ошибок, как сектанты, чем вызываешь неприязнь.

Ни разу ничего из этого. Тебе люто кажется.

> Во-вторых, твой паттерн поведения идеально ложится на жертву травли, которая страдает но сквозь слезы копротивляется и делает вид что ей на самом деле все хорошо, чем только провоцирует дальнейшие издевательства.

Ну, травли тут нет, только ты фигню несешь, но это скорее тебе в минус, а не мне.

В итоге, вопрос-то был, почему тебя трясет, а ты все переврал, перевел стрелки на меня и так не ответил.

Видать, мы не узнаем причину. Ну ладно, добра, надеюсь ты проработаешь эту травму и успокоишься.

Более соевая, но если тебе нужна не соевая — то лучше вообще лламу 3 не трогать.

Сейчас опять человека бедного стриггерите…

P100 у нас под exllama2 подходит же, не? Логичнее было бы собирать уже из них тогда изначально.

Поддержу

> Из-за идиотской постоянной задержки для полной обработки промпта на связке из двух 3090

ниможит быть!.. =)

> На EXL2 обработка всех 16к промпта - это 5 секунд

Когда я сказал, что 32к — это 12-15 секунд, меня назвали шизом.

Когда автор писал, что у него 32к — это 40 секунд, никто ниче не сказал.

И тут вдруг оказывается, что 16к — это 5 секунд.

Да шо ж такое в этом треде творится. =D

Выше обсуждали, шо там какая-то хуйня, то ли пресловутая шина (твердо и четко: не влияет!), то ли баги движка, то ли еще шо.

Deepseek-Coder-Lite-V2 и Mistral Large 2.

Закономерно, дипсик же топ среди малых моделей.

Новый тред лишь подтверждает.

С тех пор ничего нового программистского не выходило (вроде, кодстраль-7б, но нет).

> Начну озорно подмигивать и мурмуркать в ухо

Чтож ты делаешь, содомит, словил молодую ночь под бондом с этого.

> 900 токенов инструкции - это пиздец

Здесь нужно уточнение что если там примеры то еще ничего, они много сожрут но могут быть выгружены. Пофиг на скиллы и прочее, хотябы так поиграйся а там само понимание придет, главное чтобы удовольствие приносило.

> а может разделить одну сцену на несколько частей (так происходит чаще всего)

Для лучшего понимания что именно там лучше примеров принеси чего хочется, что выдает сетка и как делал. Хотябы критику получишь в которой может быть здравое зерно.

> что маленькие модели ни на что не годятся была подорвана с выходом Мистраля Немо и третьей Лламы 8В

Для своего времени и первый мистраль был революцией. Просто они все еще не могут понимать что-то посложнее и более абстрактное, в итоге выходит именно как ты написал. В любом случае это на пользу, применения мелочи найти можно.

> на трёх теслах

Ты как минимум сможешь зарядить окно контекста на лишние 24 гига и очень долго полагаться только на кэш. Скорость генерации в сделку не входит, но это лучше чем постоянно долго ждать.

> контекст шифт нормально работает

Есть где-то данные о том что он работает как должен а ничего не ломает? Одна критика.

> https://github.com/turboderp/exllama/discussions/16#discussioncomment-6243456

Там буквально ответ в том что эксллама не использует параллельную обработку, требующую пересыла большого количества данных, и потому не будет чувствовать это кроме совсем экстримальных ситуаций.

> I noticed that, the same model on one was the same speed as it on both cards.

Твой пруф тебя же опровергает, молодца.

> https://www.reddit.com/r/LocalLLaMA/comments/1d8kcc6/psa_multi_gpu_tensor_parallel_require_at_least/

Вот это уже ближе к чему-то и какие-то значения со скоростями. Но, как обычно, есть много но. Заявленное показанное значение - почти псп х4 3.0 линии, которая есть везде. Но это движок пигмы в особенном режиме во время генерации токенов (судя по всему тексту), там нет ничего про обработку контекста и более популярные лаунчера. Достижение на 4х монструозных карточках уровня теслы или мощнее перфоманса 3060 - сильно.

Сам себя опровергаешь, все закономерно и от шизика ничего иного не ожидалось.

> Твой пруф тебя же опровергает, молодца.

Ну, если ты игнорируешь смысл, цифры и просто вырываешь текст из контекста — все так, как ты сказал.

> Вот это

Уже скинуто во второй и третий разы, как удивительно, что хотя бы в третий раз ты прочел. Делаешь успехи, рад за тебя. =)

На тебя есть надежда!

> смысл

Какой смысл? где смысл? Ты пытаешься тащить что-то стороннее чтобы оправдать свои шизоидные заявления уже забывая про них. Привести их?

> Контекст на 3090 должен считаться около 3к в секунду. Чипом.

> Но есть упор в PCIe.

> Одна линия PCIe 3.0 пропускает (грубо говоря) 120 токенов/сек.

> 16 контекста по одной линии будет обсчитываться 2 минуты.

> 1 минута — такое ощущение, что там у тебя всего 2 линии всего из 16.

Тут каждая строка - космос, но главное в том что ты буквально имплаишь что pci-e является ограничивающим фактором даже на линии х16. Не про важность шины для загрузки новых данных, не про костыльный обмен тензорами при параллельном расчете вместо использования nvlink, не про общие вещи, а именно про обработку контекста. И дальше много шизы насочинял, можно из постов надергать.

В твоих пруфах это опровергается тем что разницы в работе на одной и двух карточках нет, а во втором показан пример перегонки данных с некоторой интенсивностью в специфичной задаче, не относящейся к обработке контекста.

Ты сам это прекрасно понимаешь и потому виляешь жопой и тащишь то что бегло отыскал, даже не удосужившись прочесть и понять. Если бы настолько существенная штука была - уже бы 10 раз прибежал с бенчмарками где это явно показано. Но, видимо, даже с подкруткой ничего получить не удалось.

Ух, это получается 70b можно в 35В ужимать без потери качества? А 27В в 14В?

Скорее бы, лама 8В нах не нужна.

> без потери качества

Тема не нова, лламы 3.1 по заявлениям - дистилляция большой 405б. Разумеется у них нет ее полного перфоманса, но с улучшением техник и подходов качество моделей будет повышаться.

Главное чтобы опять не полезла волна абуза бенчмарков.

там немотроны на 4 и 8б сжатые залили кстати, но я хз че это и о чем

Там всё в порядке с потерями. Их 4В в некоторых скорах сосёт у Фи-2.7В, а 8В отсасывает у ванильной 3.1 8В. Вот это реальное лоботомирование получается, когда из 405В делают обычную 8В. Тут польза только в том что можно из большой лепить какие угодно размеры. Как 70В выкатят, слепленную из 405В/123В, так и будет разговор.

Где чел с уравнениями? Почему ещё не запостил тесты?

Ну ты ж понимаешь, что мне тут нечего отвечать, ибо ты переврал все, что я написал? И ведь я уже тыщу раз пояснял, не работает с тобой.

Как скажешь, короче, как хорошо, что у нашего треда есть ты. =3

Теслы говно.

Йоу.

Или как там…

а где опус? он же ебет, а не сонет

С оперы проиграл.

Там в новой опере обещали ии завести, че умеет?

Ну а на сайт встроенный блокиратор рекламы и слежки может не пускать, на вивальди тоже такое есть

Вот через лису. пик1

Пик2 без рекламорезов

ну, значит выебывается оператор твой, или модем

>P100 у нас под exllama2 подходит же, не? Логичнее было бы собирать уже из них тогда изначально.

Ага, щас. Flash Attention в экслламе только начиная с Ampere. Преимущество P100 только в более быстрой памяти (вдвое, да), остальное сплошь недостатки.

vLLM кто-нибудь пользуется?

https://github.com/vllm-project/vllm

Вроде большой проект, но что-то я не слышал о нём.

https://github.com/vllm-project/vllm

Вроде большой проект, но что-то я не слышал о нём.

> ибо ты переврал все, что я написал

Там цитата твоего поста в которой все есть. Обосрался - обтекай, будешь меньше гадить шизой и думать перед тем как постить.

Провайдер или часы/дата сбились.

> Преимущество P100

Она считает fp16 примерно в 100 раз быстрее чем P40, за счет комбинации этого в той же диффузии обоссыт P40 и может работать с exllama. Если есть опыт в пердолинге то FA под нее можно собрать.

Брать все равно не стоит, 16 гигов

Да, но цитата и твои комментарии под ней никак не связаны и противоречат друг другу. =D

Мне сейчас не до этого,

сделаю по qwen2 math

в начале след неделе.

1.5b и 7b, в q4, q8 и f16.

Думаю там 50-60 по матеше,

сейчас qwen2 выдает 40-50,

это более чем L3 и phi3 мелкие.

Вообще 1.5b обычную и инструкт

в течении пары часов посмотрю,

в исходниках eva есть отдельный

тест по алгебре, посмотрим что даст.

1.5b q4 хорошо летает на смартфоне.

в течении пары часов посмотрю,

в исходниках eva есть отдельный

тест по алгебре, посмотрим что даст.

1.5b q4 хорошо летает на смартфоне.

>Если есть опыт в пердолинге то FA под нее можно собрать.

Удачи в пердолинге. Я вот собрал под неё xformers и что? Оказалось, что Угабуга с апреля вообще выкинул поддержку xformers из своего поделия. Под SD есть, а под ЛЛМ никому не надо оказывается. Идите и покупайте современные карты, нищеброды.

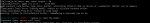

Кто встречался с такой ошибкой?

После её выскакивание модель уходит в луп залуп и начинает глупеть и шизеть.

После её выскакивание модель уходит в луп залуп и начинает глупеть и шизеть.

Локальные господа, поможете мне вкатиться в тему или ну его нахуй? Вкатиться решил естественно с нового железа. То что нужна топовая выдюха это понятно, уже почти накопил на 5090, теперь жду выхода. Остался вопрос с процессором и оперативной памятью. Процессор я так понял не решает, так что моего 12700 должно хватить. А что от ОЗУ зависит? Размер контекста или что? Сейчас у меня 64 гигабайт DDR5, сколько вообще нужно для локалок? В принципе могу поставить 128 гигабайт, но будет ли оно того стоить?

> уже почти накопил на 5090

На 300к мог бы купить 4х3090 и позволить себе вообще всё, а не только 30В.

Я обосрусь с менеджментов 4 видюх, там же пиздец потребление будет, к тому же они мне хату спалят.

>Deepseek-Coder-Lite-V2

А среди 7-8B?

>Я обосрусь с менеджментов 4 видюх, там же пиздец потребление будет

Трудности надо преодолевать(с) Ну не хочешь 4, купи две. Лучше конечно 4090, а не 30. Для двух карт современную материнку легко найти, как раз недавно обсуждали. И с остальной сборкой будет легче. 48гб ВРАМ конечно не совсем достаточно, но неплохо так, совсем даже неплохо - особенно на 4090.

>уже почти накопил на 5090, теперь жду выхода.

Долго ждать придется. Судя по сливам, до следующего года выхода не планируется.

>А что от ОЗУ зависит?

Ничего, или всё сразу, смотря через что катать будешь. Если будешь выгружать всё в видеопамять, даже 16 гигов ОЗУ хватит, потому что она не будет использоваться. Если хочешь совмещать RAM и VRAM, тут в зависимости от ограничений видеокарты и от того, какой вес будешь загружать. Идеал - выгружать всё в видеопамять, но это вариант либо для 300к наносеков, которые могут себе промышленные теслы позволить, либо для моделей весом до 35B.

>сколько вообще нужно для локалок?

Зависит от конкретной модели. Чем больше параметров, тем больше жрет.

>В принципе могу поставить 128 гигабайт, но будет ли оно того стоить?

Сомнительное решение. Если хочешь катать какую-нибудь 70B чисто через ОЗУ, то готовься к 0.1 токену пер секонд. Вообще, за цену одной 4090 или 5090 можно взять пару паленых тесел (как тут обычно и советуют). Выйдет дешевле даже с учетом энергопотребления, но сборка этого говна процесс малоприятный.

> Удачи в пердолинге

Спасибо, практикуем, но тратить свое время именно на подобное можно только из любви к искусству, иначе совсем дело неблагодарное.

> xformers

Раньше он ничего не давал, с ним что-то менялось когда юзал?

> Идите и покупайте современные карты, нищеброды.

Все так

На скрине нет ошибок, на nan не обращай внимание, это только про то что используется кэш и время на обработку промта не затрачивалось.

Вот же будет рофел если там что-то поломали и оно по-разному перформит при "горячей" работе и с кэшем. Контекстшифт и подобное что-нибудь не велючены случаем?

> А что от ОЗУ зависит?

Просто купи 64+ (лучше 96) быстрой если еще не имеешь. Главное - она должна быть двумя плашками, с 4 заебешься пердолиться.

> могу поставить 128 гигабайт

Именно поэтому не сможешь.

Если модель на видеокарте - память и прочее не решают если проц древний. Если часть модели на проц+рам - ты страдаешь и мучаешься при любом раскладе, поэтому имей железо что не будет допускать такого, раз мажор. Если 5090 не будет иметь много врам - она будет хуже чем пара даже некрокарт, исключение - пара 5090.

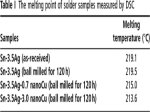

Вот некоторое тестирование

самой маленькой Qwen2 Math.

Выбраны темы физика, математика,

статистика и логика. Язык тестов ch/en.

самой маленькой Qwen2 Math.

Выбраны темы физика, математика,

статистика и логика. Язык тестов ch/en.

> память и прочее не решают если проц древний

Если проц НЕ древний, на некроте крутые карточки не покажут полной производительности.

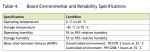

10% MMLU 1408:

qwen2-math-1.5b-instruct_q4_k_m.gguf

test over 1408 question accurate 36.1%

use time:2644.51 s batch:70.0637 token/s

qwen2-0_5b-instruct-fp16.gguf

test over 1408 question accurate 37.1%

use time:3538.57 s batch:52.7993 token/s

qwen2-1_5b-instruct-q4_k_m.gguf

test over 1408 question accurate 50.1%

use time:3593.31 s batch:51.9554 token/s

qwen2-math-1.5b-instruct_q4_k_m.gguf

test over 1408 question accurate 36.1%

use time:2644.51 s batch:70.0637 token/s

qwen2-0_5b-instruct-fp16.gguf

test over 1408 question accurate 37.1%

use time:3538.57 s batch:52.7993 token/s

qwen2-1_5b-instruct-q4_k_m.gguf

test over 1408 question accurate 50.1%

use time:3593.31 s batch:51.9554 token/s

На скорость не смотрите,

в первом 8 потоков + cuda,

2 нижние на cpu в 5 потоков.

Общее впечатление не очень,

модель ещё и в русский не может.

Пофиг на скорость. Ты вроде уже много подобных тестов делал, можешь оформить их в рентрай? И там же заодно разместить линк на тулзу и сами тесты.

> модель ещё и в русский не может

> 1.5b

> math

Ар ю ахуели там?

72В тести, кому вообще эти микромодели нужны.

И что ему не нравится? Пытаюсь запустить

Midnight-Miqu-70B-v1.5.i1-Q5_K_M.gguf

Midnight-Miqu-70B-v1.5.i1-Q5_K_M.gguf

> мику в 2024

> q5 в цп

> что ему не нравится?

Твой уровень интеллекта разве что.

lora случаем не выбрана?

> мику в 2024

Мику решил попробовать как первую большую модель. До этого мелкими перебивался.

>q5 в цп

Там нормально так слоев в видюху кидается. Все равно меджленно наверное будет хз

>Твой уровень интеллекта разве что.

Пошел нахуй

Пусто.

Он еще в самом начале пишет мол аут оф мемори, но даже половины рам не занимает. Что не так?

Все нормально, вот эта может:

qwen2-1_5b-instruct-q4_k_m.gguf

В eva есть переключение между

MMLU и C-EVAL тестированием,

если у тебя держит 72B можешь

воспользоваться ссылкой на eva

в гите llamacpp раздел интерфейсов.

> Он еще в самом начале пишет мол аут оф мемори

Своп включен? Оно может пытаться резервировать куда больше чем доснупно в твоих 64 гигах, при этом оно фактически не будет использовано.

> image.png

Ну это же оом куды, снизь количество выгружаемых слоев и/или размер контекста.

Cтоит ли использовать mmq и\или cublas на тесле? Что-то нихуя понять не могу. Сравнил свою обёртку над лламой без обоих опций с oobabooga, где force mmq включён. Профита по токенам в секунду нет никакого, может быть, на грани погрешности при пустом контексте, но у убы разброс пиздец, на большой модели 25% т\с плюс-минус.

Также потестил контекст шифт с низкоуровневым апи лламацпп, как писал пару дней назад. Восхитительно. Это настолько охуенно, насколько может быть. Cидел полчаса пиздел с моделью про звёздные войны, лол.

Также потестил контекст шифт с низкоуровневым апи лламацпп, как писал пару дней назад. Восхитительно. Это настолько охуенно, насколько может быть. Cидел полчаса пиздел с моделью про звёздные войны, лол.

imat очевидно,

бери обычный.

По тестам, они есть на гите eva.

Все тесты в папки utils идут вместе

с исходниками при их скачивании.

Сделать набор тестов можно из чего

угодно загружая в eva csv табличку с

id,question,A,B,C,D,answer построчно.

По результатам, сейчас интересуют

мелкие модели с показателями >65%,

по скольку таких всего две phi3 и qwen2

особого смысла в большой сводке не вижу.

С исходниками лежит интересный файл презентация pptx,

если получится частично адоптировать на русский добавлю.

> есть на гите eva

Это если будешь рентрай или любой другой маркдаун делать с этими табличками, чтобы сразу ссылка была.

> мелкие модели с показателями >65%

Их вообще интересно помучать в различных задачах. Являются ли эти 65% признаком повышенного ума, или просто надрочили и кроме этого ни на что не годны.

>Их вообще интересно помучать в различных задачах. Являются ли эти 65% признаком повышенного ума, или просто надрочили и кроме этого ни на что не годны.

Да, это интересно. Там легче видно прогресс в нейронках, и могу сказать что возникаюшие способности и модели мира у них есть так же.

В конце концов они обучаются на том же датасете и той же архитектуре.

Слоев меньше, а это значит что им труднее понять сложные абстракции. Сами по себе мелкие - значит обладают ограниченными знаниями о конкретных вещях.

Примерно так выглядит.

Сам файл Введение в программное обеспечение.pptx тут:

https://github.com/ylsdamxssjxxdd/eva/tree/main/ui/resource

Чуть поджал.

Попробую перевести руководство

через какой-нибудь онлайн переводчик

без потери структуры и выложить картинкой.

> через какой-нибудь онлайн переводчик

> без потери структуры и выложить картинкой

С одной стороны хорошо, но блин, эти спейсы между кириллицей с китайских шрифтов вызывают вьетнамские флешбеки, а сама презентация составлена так что без сопутствующего рассказа ничего не понять.

> Как вы ее заставляете русский использовать?

Хз я без задней мысли попросил гемму писать CoT на английском, а ответ чара на русском. Без каких-либо проблем работает. Попробуй гритинг на русском сделать.

>Ну это же оом куды, снизь количество выгружаемых слоев и/или размер контекста.

Да действительно спасибо.

>Cтоит ли использовать mmq и\или cublas на тесле?

Что значит "стоит ли", ради cublas нвидиевские карточки и берут :)

mmq ускоряет обработку контекста, сильно так ускоряет. На тесле это особенно актуально. Если теслы две и больше, то для больших моделей не забудь ещё и rowsplit.

Контекст шифт реально охуенен.

Нуууу, скорее работает чем не работает. Кмк ишью действительно где-то в другом месте. Оставлю на потом. Энивей спасибо.

Алсо, кажется я тебя знаю.

Что за промт для мыслей и плана?

мимо

Егошний кот

https://rentry.co/h7byk4hs/raw

Просто CoT от балды сделал. Пытался сделать чтобы чар сам мог историю двигать, с инициативой там проблема явная была. По хорошему бы по проптам из шапки аичг пройти и глянуть как на инструкции оттуда разные локалки реагировать будут.

> Алсо, кажется я тебя знаю.

Вполне может быть, я здесь давно.

> Вполне может быть, я здесь давно.

Я сюда редко захожу, скорее наи 2023, лонг шизопосты

Я там в основном и сижу с октября 2022, да.

>ради cublas нвидиевские карточки и берут :)

Ну как я вижу из кода, полностью его выключить нельзя, а чтобы принудительно включить - нужно пересобирать всю лламуцпп. Пока не буду этого делать. Просто несколько раз видел, что здесь mmq советуют, а моя сборка рапортует "force mmq : no". Но по скорости отличается от убы с force mmq в пределах погрешности. Тестировал на модели 20 гигабайт и 3к контекста.

>mmq ускоряет обработку контекста

Я бугуртил, что пересчёт контекста в убе занимает секунд по 15 со стриминг ллм, которая предположительно сохраняет часть контекста и делает тот самый контекст шифт. Но с голой лламацпп мой пересчёт контекста занимает 0 секунд. Рофла ради даже сделал микроконтекст и пересчёт происходит в процессе генерации ответа. Благодаря тому, что Жора ебать молодец и запилил

>KV data is updated accordingly: lazily on next llama_decode()

всё генерируется абсолютно связно и не требует никаких дополнительных телодвижений. Нужно ещё полировать, я где-то обосрался с мультитредингом, но как же это пиздато.

DeepSeek-Coder-V2-Lite-Instruct легко болтает по русски, но у него какой то ебанутый свой промпт формат. Кто то разобрался как ему формат нормально сделать в таверне?

Пока так.

https://huggingface.co/informatiker/Qwen2-7B-Instruct-abliterated-Q4_K_M-GGUF

10% MMLU 1408

qwen2-7b-instruct-abliterated-q4_k_m.gguf

test over 1408 question accurate 67.1%

use time:5652.24 s batch:32.7806 token/s

10% C-EVAL 1376

qwen2-7b-instruct-abliterated-q4_k_m.gguf

test over 1346 question accurate 78.9%

use time:13461.44 s batch:10.3702 token/s

10% MMLU 1408

qwen2-7b-instruct-abliterated-q4_k_m.gguf

test over 1408 question accurate 67.1%

use time:5652.24 s batch:32.7806 token/s

10% C-EVAL 1376

qwen2-7b-instruct-abliterated-q4_k_m.gguf

test over 1346 question accurate 78.9%

use time:13461.44 s batch:10.3702 token/s

Мне кажется нет в нем смысла, кодесталь тот же лучше лайт версии дипсика в большинстве бенчмарков.

Бурги его любят потому что у него лицензия хорошая.

Qwen2-1.5B-Instruct-Abliterated-Q4_K_M.gguf

10% MMLU

test over 1408 question accurate 49.5%

use time:2441.67 s batch:75.884 token/s

Вспоминается очень годная для своего времени и размера OpenHermes-2.5-Mistral-7B.

Есть ли какие-то явные профиты у данной 8B?

https://nousresearch.com/hermes3/

> Hermes 3 contains advanced long-term context retention and multi-turn conversation capability, complex roleplaying and internal monologue abilities, and enhanced agentic function-calling. Our training data aggressively encourages the model to follow the system and instruction prompts exactly and in an adaptive manner. Hermes 3 was created by fine-tuning Llama 3.1 8B, 70B and 405B, and training on a dataset of primarily synthetically generated responses. The model boasts comparable and superior performance to Llama 3.1 while unlocking deeper capabilities in reasoning and creativity.

Hermes 3 technical report

https://nousresearch.com/wp-content/uploads/2024/08/Hermes-3-Technical-Report.pdf

че за выебон из-за очередного тюна ламы? чем хорош?

>and training on a dataset of primarily synthetically generated responses

Только представьте какой это буддет металлический соевый кал

> MMLU улетел ниже 80

Ну и нахуй оно нужно, если скоры только вниз ушли? Ноусы уже давно скурвились, нормальных моделей год не выкатывали.

Особенно интересно, насколько хороша большая.

Я все еще против считания математики ллмками, но лень человеческая побеждает здравый смысл. х)

Да там и q8 летает.

Да и Gemma 2 2.6b q8 на смартфонах норм себя чувствует.

А вот фи-3 3.8 уже медленноватая.

Если планируешь гонять чисто на видяхе, то хватит и 64 гигов.

Если хочешь катать большие модели с частичной выгрузкой на видяху, то там уже лимитов нет. =)

Дипсик 16б, чи скока там. Тебе архинужно 7б?

Тут уже не подскажу. Вроде CodeQwen-1.5 7b был неплох. Но может Llama-8b или Codestral-7b (но она, вроде, не удалась), не знаю, честно. После появления дипсика перестал мелкие тыкать.

40%. Для 1.5б да еще в таком кванте (за шо, чому не q8??? сравни, попробуй) хороший результат прям.

Ето да. =)

Бери magnum-72b как первую большую модель.

А Гемма 2 2.6 сосет?

Разве? Мне казалось, там что-то дефолтное… Но я сижу прям в убе.

Ну, кодстраль чуть лучше, а дипсик заметно меньше и пиздец быстрее.

Но если можешь гонять кодстраль комфортно, то возможно и лучше, да.

Полная хуйня была.

Синтетика перла из всех щелей.

Подходил только для чат-ботов в корпорациях.

Общаться было нереально.

Гермес — литералли одна из самых худших файнтьюнов, нужная примерно никому.

Он плох всем.

Попробовал Big-Tiger-Gemma-27B из тредовского ренти. Ну и хуйня. Может квант маловат вечером попробую на более высоком, но пока залупа какая-то. Очень бредит модель и графоманит.

Пока что круче noromaid-20b ничего не нашел она прям идеальна. Впрочем у меня и запросы не совсем обычные.

>Бери magnum-72b как первую большую модель.

Качаю. Чем хороша?

Пока что круче noromaid-20b ничего не нашел она прям идеальна. Впрочем у меня и запросы не совсем обычные.

>Бери magnum-72b как первую большую модель.

Качаю. Чем хороша?

5090 брать такая себе идея. Мб анон который говорит взять две карты 4 серии прав. Типа учти что первые карты 5 серии будут гореть пердеть и ломаться программно и аппаратно. Карты у зеленых теперь как ААА игры - выходит говно, допиливают патчами. Первую ревизию первой карты в серии вообще можно прямо с конвейера сразу в мусорку кидать лол. Технический долг до них добрался. Им же надо как по расписанию выдавать технологические прорывы да удваивать кол-во транзисторов, такие вещи забесплатно не проходят.

К тому же я думаю профит от абстрактно выгрузки 10 слоев (а я как понял ты собираешься именно выгружать слои, иначе нахуй тебе ram) на быструю карту 5 серии будет меньше чем выгрузка 15 слоев на две карты 4 серии.

> первые карты 5 серии будут гореть пердеть и ломаться программно и аппаратно

Что за шиза, лол? У меня гниль 4090 с карусели уже два года, ничего с ней не случилось. Никаких проблем нет с релизными картами, так же как и не существует аппаратных ревизий у карт - 90% карт идут просто с референсным дизайном платы. Про программные проблемы это к амуде, у куртки никогда нет их на релизах железа.

Там есть функциональные вызовы и модель обучена использовать теги о которых речь в документе. Ну и все это с большим контекстом. Самое то для всяких агентов.

Не думаю что текушая версия хуже обычной лламы3, они бы не выпустили еще раз хуйню

Падения в тестах незначительные, к тому же в других тестах гермес наоборот лучше

>Технический долг до них добрался

Долбоебизм скорее. Что у них там горело, кроме дебильного разъёма? Тридцатки горели из-за пали вместо смд конденсаторов. И нью ворлда, конечно. Десятки просто орали дросселями. Хотя вторая ревизия кристалла 4090 в итоге хуже первой и нужно смотреть, что покупаешь.

Скоро ещё интеловские батлмаги выйдут, на 12 и 16 гигабайт, топ жир, блядь. А потом и 5090 на 24.

>> xformers

>Раньше он ничего не давал

В SD треде такого не напиши. Я раз написал, чуть с говном не сожрали, якобы оно снижает потребление vram, ускоряет и вообще чудо. Хотя я специально тестировал, вообще никакого влияния.

>40%

>для 1.5b

>хороший

Да, все так. Прогнал после еще парочку 1.5b

все показали не больше 20 на abstract-algebra.

По остальному MMLU у Мath хуже результат,

получается там буквально данные вытеснены.

>xformers

Год назад в наи треде сидел. Добавление иксов увеличивало кол-во итераций/сек в два раза. Так что уважайте деда.

Кровь из глаз, и от шрифтов, и от содержимого

> темные ком

> область ввод

> подсказать слово подсказать

> температура температура

> длина контекста длина контекста

> подсказка подсказки

> анжуманья бегит

Получил МОДЕЛЬ БОЛЬШОГО ЯЗЫКА с этого. В таком виде оно чуть менее чем бесполезно.

Стоковая гемма лучше

> взять две карты 4 серии

Только если используешь их для чего-то еще и не по текущим ценам. Сейчас буквально нет альтернативы 3090.

> первые карты 5 серии будут гореть пердеть и ломаться программно и аппаратно

амудэшиз или подстилаешь соломку оправдывая невозможность апгрейда?

> В SD треде такого не напиши

Hey buddy, you got the wrong door. SD-thread is two blocks down. Там оно действительно дает радикальное преимущество, а то что ты тестил - скорее всего кривость настроек интерфейса, которые не применились. Из альтернатив SDPA подкрутили и оно тоже норм работает, но чуточку уступает. Больше нигде толком подобного профита от xformers не замечено.

>менее чем

Есть ориг выше, вспомнил, что можно

просто смарт навести на экран, и он прямо

с китайского на ходу текст переводит. Всё.

Ту картинку делал через ПейджТранслит

в LibreOffice после конвертации pptx>docx>pdf.

Сам снимок экрана из Edge бразура, после

ужатие в Imagine до 16000px webp 50% в 1 МБ.

Это очень круто и похвально что ты делаешь, но в таком виде оно действительно бесполезно. Не только неудобно читать (что может быть легко исправлено), проблема в очень кривом переводе, поломанных рисунках и изначально самой презентации, из которой сложно извлечь информацию без сопутствующего выступления автора.

Если действительно хочешь заняться - стоит причесать это и оформить в чтиво, тем более там известная база с которой не должно возникнуть проблем.

От сообщения ощущения стариковской манипуляцией,

прям чувствую это крехтение за соседним офисным

столом, этот кофеек из термоса и седые чуть сальные

волосы. А как а вот так, нет так, сейчас тебя научим.

Я понял что ты мне от добра предлагаешь научится

доки вести раз уж много тестов. У меня цель другая

просто направить в китайский франкенштейн и так,

чтобы его схавали как есть, с китайскими доками и

шайтан интерфейсам + еще алерты на вирусы. Почему?

Потому-что это легкий автономный комбайн, который

работает из коробки на любом пк быстро. Когда я

поставил eva у меня вообще все модели шизили,

но с использованием понял - это модели кривые.

А работали они нормально потому что в кобольде

вечно что-то крутишь как в старой ладе. В eva сразу

чувствуешь, что модель достойна внимания если она

хороша, и дело не только в тестах. Кто захочет накатит.

>на nan не обращай внимание

А у тебя тоже всплывает NAN? Попробовал применить no_cache и ошибка не пропала.

Подскажите, как в сили таверне сделать, чтоб бот только оранжевую часть писал? Без белого текста

Напиши ему текстом, блять.

Покажи карту персонажа

От сообщения

ощущается желание

намекнуть

что ты делаешь

полную херню

которая в таком виде

никому не будет

полезна но при этом

тебя не обидеть

оттолкнув от добрых дел

Для запуска хватит инструкции которая у них в гите есть, просто ее перевести будет уже достаточно. Штука хорошая, полезная, вопросов к ней нет, заодно своих советов накидал бы, все были бы только рады. А вон тот поломанный надмозг "удар много смех хороший переводить формат сохранение" - это же пиздец, неужели сам не видишь? И какое отношение он к той тулзе вообще имеет?

> вообще все модели шизили

Все шизить не могут, особенно чистые базовые.

Это не ошибка, просто результат деления на ноль. Ноль обработанных токенов делятся на 0 секунд при расчете скорости, просто контекст не пересчитывается если в этом нет потребности.

> no_cache

Оно точно отвечает за кэширование контекста?

Добавь в свой пост или инструкцию указание типа

> your response must contain only the requested prompt without anything else

и убрать опцию ban eos token

Анусовые, кто ставил Немо мисральский, есть к вам вопрос. Темплайт контекста и инструкта у нее изменился от обычного мистраля, или нет? У меня стоит старая версия таверны и пресеты остались старые соответственно. Обновляться не хочу, потому что уже всё настроил под себя и боюсь что опять что-то слетит.

У мистралей ничего кроме [INST] нет.

Там как в старых мистралях [INST]. Стоит отметить что он, как и старый мистраль и мику, даже лучше перформит в ролплей альпаке чем в родном, но лучше сам поиграйся и посравнивай.

а че значит эта INST?

instruction - инструкция

Спасибо, братья.

Кстати, забыл спросить. Там системный блок есть, или всё отправляется через юзера? Никогда мистрали не гонял, по этому вопрос тупой, да.

Да там ппц вода, просто общие слова, настроить.

Могу сказать что работает - озвучка на русском,

генерация картинок (если стоит китайский язык),

квантирование, генерация картинок в меню,

виспер не пробовал. Ембидинг не пробовал.

Загрузка своих csv тестов работает, любой язык.

Все меню - слайд меню в pptx работает, там:

сделай алгоритм, реши судоку, сравни всякое.

Речь шла о разных файтюнах и мелких корпах.

Сервер стартует, апи доступно, страница в бразузере.

В куде слои перешелкиваются, в вулкаке и кпу все норм.

Единственное автор убрал родной пресет евы из аниме.

Самое удобное папка temp и чистый режим завершения.

Не злись если тебе мой ответ на пост показался грубым.

Вот пример гоняешь кобольд все норм, но в какой-то

момент начинают происходить затыки непонятки.

В кобольде начинал передергивать темпу лезть в доки.

Сейчас я просто загоняю в тесты и если модель вместо

буквы начинает лить что угодно другое - ясно она сломана.

Второй пример нагружка - в кобольде смотрю загрузку

системы через диспечер, в еве вижу чистый отжор модели.

Опять же очень редко надо лезть что-то менять в настройках.

момент начинают происходить затыки непонятки.

В кобольде начинал передергивать темпу лезть в доки.

Сейчас я просто загоняю в тесты и если модель вместо

буквы начинает лить что угодно другое - ясно она сломана.

Второй пример нагружка - в кобольде смотрю загрузку

системы через диспечер, в еве вижу чистый отжор модели.

Опять же очень редко надо лезть что-то менять в настройках.

Qwen2 — одна из лучших моделей в своем размере (логика, контекст, все дела).

А файнтьюн сделан на синтетике из Claude Opus, стиль хорош.

В общем — модель уже немного в возрасте, но все еще очень хороша для 48 гигов.

Мику тоже хороша, но уже совсем бабулька, конечно.

> оно снижает потребление vram, ускоряет и вообще чудо

Однажды я забыл добавить ключ и… ничего не случилось!

Но вдруг мы не так тестируем? На 4070ti прироста лично я не заметил, однако… вдруг на 30-20-10 видяхах панацея?

К счастью, нет.

Типа тега [INST][/INST], инструкция, внутри инструкция для модели, снаружи — текст сгенеренный моделью. Все просто.

[INST][/INST] — для системного и юзер промптов. ассистент идет вне тега. Все.

———

Приобрел две P104-100, чисто мини-магнум гонять в 16 гигах.

На авито нашел человека с 2к за видяху, обе отдал за 3,5к. 16 гигов за 3,5к весьма недурно. Дурно, что материнка нужна с двумя слотами, конечно, и питание 4*8пин.

Но для бомжей вариант хороший, даже одна видяха будет хорошим подспорьем, если у вас 1050 и вы страдаете 1 токеном/сек на 8б.

>Приобрел две P104-100, чисто мини-магнум гонять в 16 гигах.

Ебать ты особенный. Фотки покажешь?

>и питание 4*8пин

3 штуки хватит же, плюс продованы обычно переходники с псины кладут, так что и стандартных 2-х вполне себе хватит, если не интул вместо проца конечно же.

Сам пей. =)

У меня примерно тот же год назад разницы вообще небыло.

>МОДЕЛЬ БОЛЬШОГО ЯЗЫКА

А как же СТЕПЕНЬ МАГИСТРА ПРАВА?

>скорее всего кривость настроек интерфейса

Мне нужна была SD без xformers, чтобы завелся TensorRT. В итоге он завёлся, чего не могло быть с xformers.

>Но вдруг мы не так тестируем?

Либо зависит от размера батча, разрешения, фазы Луны, etc.

> P104-100

Вроде, и хочется, а, вроде, и места в аквариуме уже нет. Плюс нужно райзер купить, переходник на питание, чтобы в райзер не расходовать лишние пины. И если прикрутить на место водянки вверху, то куда пойдёт горячий воздух? Тяжело.

Заглянул в системник место поискать, а там пикрил. Пыли пиздец.

Кстати, раз зашла тема про чат темплейты, решил немного копнуть эту тему. Жора зачем-то прикрутил к лламе.цпп эти самые темплейты. Но мы же помним, кто такой Жора. Так что он не стал тащить в проект jinja, а просто захардкодил некоторые темплейты.

https://github.com/ggerganov/llama.cpp/wiki/Templates-supported-by-llama_chat_apply_template

Генитальный мув. Но в целом ллама.цпп просто охуенна.

>Так что он не стал тащить в проект jinja, а просто захардкодил некоторые темплейты.

ЁБАННЫЙ

СТЫД

А картинка зачётная

jinja конечно нахуй не нужна, тут с жорой я прав, но блядь распарсить строку с темплейтом а потом по ней форматировать можно было бы и на сях.

> А как же СТЕПЕНЬ МАГИСТРА ПРАВА?

Не не, нужно переделать под мем

> Утром:

> 1. слово угадыват

> 2. т) agiт

> 3. температура температура

> 4. предсказанья

> SD без xformers, чтобы завелся TensorRT

И как оно?

> IMG202408162205[...].jpg

В голосину

Проиграл с картинки. А что это в оригинале значит?

Насколько эти флаги с квантованием кэша рентабельны? Сколько сэкономят?

Что за флеш атеншен?

Что за флеш атеншен?

>переделать под мем

А в конце еще

10) EOS токен

>Не не, нужно переделать под мем

Я имел ввиду пик 1.

>И как оно?

Тупо ебёт. Правда, чтобы работало, модель должна быть в специальном формате, но там была автоматическая конвертация, насколько я помню. И лоры тоже. Но по итерациям в секунду выигрыш в 2-3 раза и выше.

Помнишь было время, когда были евространдарты для автомобилей? Вот теперь они есть и для пекарни. Energy-related Products. Включение ограничивает токи дежурки, не выше 1 вт. Отчего отпадает возможность заряжать девайсы, включать пк по разным триггерам, кроме кнопки, гасит всю лгбт на выключенном пк и т.д.

>флеш атеншен

Обработка внимания быстрее и с меньшими требованиями к памяти. Про квантование кеша недавно обсуждали, меньше памяти - меньше точность.

> Что за флеш атеншен?

Ставь галочку и молись на него, он позволит вместить в пару раз больше контекста в врам.

> Насколько эти флаги с квантованием кэша рентабельны?