В первом пике надо контекст на 128к заменить. А то новую придумать.

Блять, с каждым новым перекатом шапка становится всё более жуткой. Может пора уже половину выкинуть, а другую как-то переформатировать и все ссылки закинуть на отдельную рентри страничку?

ох, ну и дела

Многабукафнеосилил?

>на отдельную рентри страничку

У нас там вики вапщето есть...

>В первом пике надо контекст на 128к заменить

Чёрт, я всегда думал, что это ЧК, типа подпись автора...

не могу прикрепить ни аудио н и=вид ое итт

Не выебывайся давай. У меня претензия к оформлению шапки, а не к тому, что букв много. Нахуя здесь до сих пор висит "гайд для ретардов", если он итак продублирован в вики? Нахуя тут столько ссылок которые висят без всякой категоризации? И в конце концов, нахуя нужен этот микроартикл посвященный тому, что такое локальные модели, когда эта инфа тоже есть в вики?

>Нахуя дубль вики

Для независимости от вики, очевидно же. Было пару раз, когда вики не работала.

По двум причинам: не хочу дома оставлять включенной рабочую пекарню + на даче интернет дерьмо и часто отваливается. А для работы локальной ллм интернет не нужен.

>зачем на нем гонять недоллм

На самом деле 2b гемма очень неплоха, не надо сравнивать её с другими огрызками типа phi и прочих. Выше написали правильно что она вполне тягается с 8b моделями и выше. Для ее размера - это просто имба какая-то

>Для ее размера - это просто имба какая-то

Ты хоть уточняй в чем.

На сколько помню у нее тоже контекст реальный 4к, значит обрабатывать что то длинное ей так же как и большим геммам не дашь

Мне самому интересно было ее потыкать как и другие мелкие модели, но кроме меньшего количества знаний и более простых ответов ничего не заметил

Действительно ощущается как 7-8b? В каких сценариях?

Даже если так, шапка итак продублирована на рентри. Даже если вики отвалится, можно перейти туда и прочитать. Вместо этого можно было бы добавить мини-блок новостей, как это на форчах сделано и краткий список необходимых ссылок на фронты с беками и список моделей.

Эти несколько параграфов из шапки банально не нужны, потому залетным они не помогают. Если им будет лень читать, они в любом случае отпишутся в треде. А те кому нужна инфа найдет ее на других источниках, или перейдет по ссылке на полную шапку.

Хотелось бы услышать пример хорошей генерации русской речи. Только не "избранное", избранное я и сам могу, а чтобы не корёжило при ролеплее. Если я неправ и такие модели есть, то хотелось бы об этом узнать.

>Даже если вики отвалится, можно перейти туда и прочитать.

Я оттуда копипасчу с разметкой. Да и рентри отваливается чаще вики, лол.

>как это на форчах сделано

У нас харкач всё таки.

>потому залетным они не помогают

Уговорил. Коперни рентри, предложи свой формат, я посмотрю и сделаю по своему.

>Действительно ощущается как 7-8b? В каких сценариях?

Сравнивал с лламой 3 и 3.1. Сценарий использования - рп на самописных карточках в коболде. Ну вот русский язык - лучше, шизы - меньше. Всяких приколов типа лупов и прочего говна - нет вообще. Сои по сравнению с 3.1 гораздо меньше. Качество/вариативность ответов: какой-то прям глобальной разницы не ощутил, после 27b шо то шо то выглядит упрощенно.

Пресет Godlike в коболде показал себя интереснее всех с этой моделькой. Начала подробнее писать, и как-то более вовлеченно что-ли. Но может это плацебо кнеш

Ранее в тредах приводили примеры моделек со 100+b, там всё окей с русским. На 27b гемме тоже хорошо, мои старые скрины, можешь оценить уровень знания языка - обычно так и пишет. ОЧЕНЬ редко может путать падежи, или допускать мелкие ошибки, но такое реально редко и не раздражает.

>ОЧЕНЬ редко может путать падежи, или допускать мелкие ошибки, но такое реально редко и не раздражает.

Сорри, я непонятно выразился. Хотелось бы примеры синтезированной русской речи, голоса. Чтобы и с падежами всё было более-менее, и с эмоциями. Хотя я понимаю, что эмоции возможны только в комплексной модели, во всяких омни. Но чем чёрт не шутит?

Не обязательно загружать, достаточно процесса с CUDA, создавшего контекст. Контекст CUDA и контекст LLM - разные вещи. Но это и есть простой.

На винсервере снижается до 10 даже с куда-процессом. Но где мы, а где винсервер.

>На самом деле это нарушение ToS

https://research.google.com/colaboratory/tos_v5.html

Да как бы нет. Колаб вообще не особо различает платное и бесплатное использование ресурсов. Они даже SD не запрещают в явном виде, просто сообщают, что выделение ресурсов на него будет с минимальным приоритетом и если кто-то с чем-то другим захочет ресурсов - тебя пидорнут. Но это даже не TOS, это FAQ. Лично я за три дня надрочил колаб часов на 18 бесплатной Т4 нейронками со 100% загрузки нонстоп, ни предупреждений, нихуя. Но надоедало аккаунты менять.

>при воздухе в +50 люди мумифицируются нахуй.

Пусть окна открывают, а то хули - мне одному сидеть с открытым окном зимой?

>Но надоедало аккаунты менять.

И после этого ты говоришь, что нихуя не нарушаешь...

Короче, кое-что переформатировал и рассортировал по пунктам: https://rentry.co/llama-2ch-header

Основная часть ссылок осталась на месте, даже те что устарели. Убрал только факю-полотнище про локалки и добавил несколько новых ссылок, которые могут пригодиться.

Подробнее о вырезанном:

Гайд для ретардов убран, потому что это стыдно гайдом называть, это просто огрызок.

Колаб убран потому что толку от него нет, тред всё равно про локальную движуху без больших дядь на облачных сервисах.

Гайд по обучению лоры убран, потому что никто тут лору ни разу не обучал за все прошедшие треды.

Не самые свежие гайды на ангельском убраны, потому что инфа есть в вики и на понятном языке.

Поставщики квантов вырезаны, потому что один хуй все ищут модели через обниморду (хотя их можно вернуть при желании, тут решение за тобой).

>Поставщики квантов вырезаны, потому что один хуй все ищут модели через обниморду

Где-то читал, что в модель можно встроить вредоносный код при желании если тут есть специалисты - поправьте меня, поясните по хардкору насколько это реально. Если такое теоретически возможно - то лучше качать модели только у ПРОВЕРЕННЫХ ВРЕМЕНЕМ поставщиков типа Bartowski, Drummer, Mradermacher и прочих (а не у ноунеймов зарегистрированных вчера, с одной моделью в профиле).

Для того и создан формат safetensors. С ллм чуть сложнее ибо там помимо чистых весов еще могут буквально лежать скрипты для особенного токенизатора или нечто подобное, но типичные для юзеров лоадеры их игнорируют без дополнительных опций, а то и вообще не имеют к ним обращаться. В gguf вообще невозможно встроить дополнительное ибо все возможное уже захардкожено.

Возможно, обнаружат какие-нибудь новые уязвимости, но это довольно маловероятно.

Пытался вникнуть в эту тему глубоко, какой же это пиздец (гайды как на инопланетнмо языке, какие то цифры, буквы, не понятно о чем идет речь).

Скачал Llama 8B модель без цензуры, скачал koboldcpp, выставил рекомендуемые настройки и выглядит збс. Видяха не тянет модели выше 8B, но все равно выглядит неплохо, как для локальной модели. Интересно что выдают модели 70+B, хоть бери кредит, и покупай две 4080 (хз хватит их или нет).

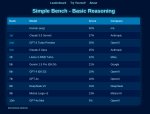

Вот, к примеру, что значат эти параметры? Почему в разных моделях они должны быть разными?

> две 4080

Тогда или 4090 или 3090, или хотябы 4070ти. 4080 аутсайдер из-за цены и врам.

Настройки одноименных семплеров. Пиздуй вики читать.

> две 4090

Как думаешь, хватит ли этого, чтобы отдаленно напоминало GPT4?

Почти, но лучше взять 3 более дешевые карточки чтобы точно хватило. В некоторых кейсах оно даже будет превосходить, разумеется завязаны эти преимущества на отсутствие сои, полный доступ к весам, нет тех же типичных фразочек и байасов (но есть другие) и подобное. По чисто рафинированному уму жпт будет умеренно/немного лучше, по обилию разнообразных знаний - ощутимо лучше, но все зависит от запросов, где-то может быть наоборот. Офк это не относится к чмоне, что тупая хуета.

Что-то отдаленно напоминающее - это модели 100b+, которые не влезут в твою врам. Даже если ты две 4090 купишь. И даже если три. Не, напоминать-то они конечно будут, ответы там будут отличные, но скорость генерации тебе не понравится.

>Почти

Да, это хорошее слово для описания текущей ситуации. Но до последних поколений локалок даже и этого не было. Сейчас хорошее время так-то.

спасибо, буду думать

Эх как же хочется стек из 10 а100 чтоб стояло напротив меня и общалась ПОЧТИ как натрашка из соседного падика... Ведь оно того стоит. Можно будет два три раза в ден дрочить. Вся суть итт

> И даже если три.

Датфил когда в треде немало человек катают на трех штуках большого мистраля.

> но скорость генерации тебе не понравится

Десяток токенов будет, не так все плохо. Жпт в часы пик и ниже проседал, а если ты бедолага что сидит на вялой проксе - ожидать обработки не привыкать.

> Но до последних поколений локалок даже и этого не было.

Ну вообще и вторая ллама могла очень душевно ебать и давать крутой экспириенс, а в опуще или сойнете можно прямо сейчас умереть с кринжа или эпично разочароваться с унылости в некоторых сценариях. Все от юзкейса зависит же.

имеем три карты.

0 - x16

1 - x1

2 - x8

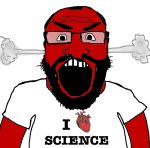

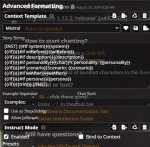

на картинке приведены результаты пропускной способности, обращать внимание нужно на busbw измеряемый в гигабайтах в секунду.

1 пик - замеры между 0 и 2

2 пик - замеры между 0 и 1 (идентичны замерам карт 1 и 2)

3 пик - замер скорости между всеми тремя картами

внимание - вопрос:

Когда карты физически на материнке было две - пропускная способность между 0 и 2 была 1,28. Почему при добавлении третьей карты она снизилась вдвое, при том что третья карта не учавствует в тесте?

проц AMD Ryzen 5 3600

мать ASUS PRIME B450-PLUS

0 - x16

1 - x1

2 - x8

на картинке приведены результаты пропускной способности, обращать внимание нужно на busbw измеряемый в гигабайтах в секунду.

1 пик - замеры между 0 и 2

2 пик - замеры между 0 и 1 (идентичны замерам карт 1 и 2)

3 пик - замер скорости между всеми тремя картами

внимание - вопрос:

Когда карты физически на материнке было две - пропускная способность между 0 и 2 была 1,28. Почему при добавлении третьей карты она снизилась вдвое, при том что третья карта не учавствует в тесте?

проц AMD Ryzen 5 3600

мать ASUS PRIME B450-PLUS

>Датфил когда в треде немало человек катают на трех штуках большого мистраля.

Могу катать большого Мистраля, но катаю лламу 70B. Чисто на английском считаю её лучше.

Так, подождите, в локалках все еще даже нельзя вручную накрутить силу активаций атеншна на выбранном куске контекста? Мда, такими темпами вам до прогресса уровня дифьюжена еще идти и идти...

А версии pci-e у карт какие?

p40 имеют pcie 3.0

> при том что третья карта не учавствует в тесте?

Значит она там такие участвует, иначе бы и не было ничего. Хотя

> проц AMD Ryzen 5 3600

> мать ASUS PRIME B450-PLUS

Откуда там 8 линий на еще один слот, да еще возможность конфигурирования чипсетных линий аж на х8?

Они обе ничего, на самом деле большой мистраль просто хороший, нет вау эффекта от размера. Катаешь ванилу или какой-то файнтюн?

Во-первых, если бы я использовал 1 аккаунт - я бы использовал ресурсы легально и бесплатно. Что уже опровергает утверждение нейронки.

Линии psi-e поделились, не?

>Линии psi-e поделились, не?

помню, что в одном из прошлых тредов какой-то анон показывал команду как посомтреть топологию линий через nvidia-smi. Не помнишь её?

Конкретно под psi-e не помню. Но можно посмотреть через nvidia-smi -q если скроллить не лениво.

ага, точно

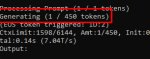

nvidia-smi -q | grep -i pci -C 8 | grep -E "(Bus Id|Link Width)" -A 2 | grep -E "(Bus Id|Current)"

>nvidia-smi -q | grep -i pci -C 8 | grep -E "(Bus Id|Link Width)" -A 2 | grep -E "(Bus Id|Current)"

Под Винду вот это сконвертировать можно?

>Они обе ничего, на самом деле большой мистраль просто хороший, нет вау эффекта от размера. Катаешь ванилу или какой-то файнтюн?

Мистраль хороший и действительно может в русский, но лупится совсем негуманно. Можно настроить, но от 123В ну не ждёшь как-то таких проколов. Плюс он в четвёртом кванте идёт медленнее, чем 70В в пятом. А лламу гоняю lumimaid 0.2 и она охуенна. Есть косяки, что-то приходится иногда подкручивать, рероллить и править ответы - но 2мб текста уже нагенерировал в рамках одного ролеплея и держит уверенно. 24к контекста, ручной суммарайз уже больше 5к токенов :) Раньше такого не было, а теперь есть.

Спасибо, это просто охительно. За диалог из почти 150 сообщений вообще никаких багов небольшие запинки и путаницы можно даже не считать, они воспринимаются как опечатки и в сюжете дальше не участвуют не встретил.

У меня сейчас 16 гб оперативы, но скоро будет 32, имеет ли смысл переходить на какую-нибудь более тяжелую модель? Если да то какую?

nvidia-smi --query-gpu=pcie.link.gen.current,pcie.link.width.current --format=csv

Вообще нихера лишнего не будет. Первым идёт генерейшон psi-e, вторым количество выделенных линий. Может быть меньше, если видеокарта не используется, сначала подгрузи что-нибудь, а то драйвер оптимизирует расходы.

>Вообще нихера лишнего не будет

Показывает нужное, спасибо.

Выбираю VLM для набросочных описаний датасета пикч. Предложили bakllava. Что скажете? Взять другую?

Когда уже модели для кума шагнут вперед? такой бред пишут, неужели нет именно натренненой модели на порно рассказы именно? во первых пишут очень мало (без подробностей и стараются как можно быстрее завершить сцену, либо наоборот хуету пишут без процесса)

>неужели нет именно натренненой модели на порно рассказы именно

П... Пигмалион.

Клод два был мегаохуенным (на английском по крайней мере, но и на русском норм). Я потом дропнул это всё дело. Сейчас есть подобные опенсорсные модели?

шутка? хуже него наверное ничего нет

Установил таверну в общем, по вашему совету и такая проблема после кобальда... В кобальде сообщения от ии мгновенно поступали после моего запроса и печатались постепенно появляясь, даже снизу было написано "печатает". В таверне же сразу после моего вопроса оно думает минуту и потом вываливает простыню. Как сделать как в кобальде, подскажите плз.

Всё я разобрался, тупанул капитально, сорян.

Попросили модель, натрейненную на РП и прочей порнухе, я и предоставил.

И да, пигма имеет душу ©, в отличии от всего этого новомодного говна, где в приоритете точность ассистента.

Вот тебе и x8

> лупится совсем негуманно

Стоковый чтоли? Там люмимейда нужна, с ванилой пердолиться нужно.

> лламу гоняю lumimaid 0.2

Ее же хейтили, стоит пробовать?

Очевидный коммандер очевиден

мистраль немо очень подробно и без цензуры всё описывает, даже с шантажом и чернухой я охуел

>Линии psi-e поделились, не?

внезапно нет.

Вот картина когда подключено только две карты

>Вот тебе и x8

да, это странно... там в разъеме действительно есть пины для x8, но он не работает в режиме x8 даже сейчас, когда там только две карты. И даже в режиме x4 не работает.

Мне кажется я не понимаю какой-то логики в распределении линий pcie. Где бы об этом побольше узнать? Правильно ли я понимаю, что сетевая карна например тоже требует pcie? А usb используют pcie?

Где посмотреть, как вся периферия на материнке коннектится к процу?

>Где бы об этом побольше узнать?

В мануале к материнке. Иногда в обзорах от нормальных спецов. Вот например из мана к моей материнке, но у меня никаких проколов с разделением нет.

у тебя эпик?

что думаешь о воб этом наборе?

https://aliexpress.ru/item/1005007405054294.html

Я на него смотрю, он приковал мой взгляд, но я боюсь, что это слишком дешево по рынку и продаван мне нихуя не отпрпавит и у меня 50к просто повиснут на три месяца на али.

>Llama-3.1-8В

>По первым тестам очень сухая и много сои

Объясните, в чём эта ваша "соя" заключается?

На DuckDuckGo с Llama 3.1 70b общаюсь, но хочется перекатиться на локальную, но железо настолько устаревшее, что я могу только Qwen 0.5b нормально запустить (в процессоре нет AVX инструкций).

Так вот, 70b модель по характеру нравится - всё очень хорошо понимает, эмоциональные ответы, не тупит в стиле "я не могу этого сделать", не навязывает ничего. Неужели младшая 8b модель сильно хуже старшей?

Возможно ли обрезать 8b до 0.5b или меньше, убрав полностью бесполезные знания/навыки, но сохранив характер и эмоциональность? Пусть будет дурочкой, ничего не знающей, но чтоб под мои личные вкусы.

Видимокарта в распоряжении 750 Ti 2GB, её должно хватать с головой для 1.5b модели, но процессор 2007 года не имеет AVX, который требуется, похоже, везде, аргументируя "ну без AVX медленно будет, если VRAM меньше необходимого для модели, так что извиняй".

P.S. Умею программировать и могу освоить питон, но машинное обучение для меня - тёмный лес пока что. Непонятные библиотеки с непонятным жаргоном...

>у тебя эпик?

У меня обычная десктопная плата абасрок стил легенд на AM5.

>и у меня 50к просто повиснут на три месяца на али

В лучшем случае. В худшем ещё и наебут, лол, алишка давно скурвилась. Так что на свой страх и риск.

чувак ужать модель до такого неприличия пока невозможно. Собирай деньги на 3060 или 4060

>На DuckDuckGo с Llama 3.1 70b общаюсь

фигасе они молодцы. Не знал что утка свой чат с моделями подняла.

>обрезать 8b до 0.5b или меньше

>750 Ti 2GB

земля тебе пухом, братишка...

тут карты покупаешь чтобы командер плюс завелся на 3т/с, а все из-за качества ответов, а ты хочешь себе лоботомита локального.

Обычно чем больше тем умнее.

Есть исключения, например гемма 27б, которая показывает выдающийся хороший результат на уровне 70б сеток,а весит в три раза меньше, но это исключение потомоу что делала его нвидия.

Альсо если хочешь маленькую русскую сетку - я все еще рекомендую попробовать t-lite от тинькова.

>Объясните, в чём эта ваша "соя" заключается?

В основном под этим имеют ввиду нравоучения сетки, и ее отказы что то делать читая тебе нотации. Вот когда эта хуйня отказывается о чем то говорить, говорит тебе что плохо, а что хорошо, это нереально бесит.

Так же частью всего этого является общая "личность" ассистента ии, на котором и завязана большая часть этих ограничений. "Безопасность", ебать ее создателей.

> хороший результат на уровне 70б сеток

Даже близко нет. В тестах они ещё как-то может, но по знаниям очень плохо. Если задача чисто на логику, то в целом может около 70В подбираться с переменным успехом, но как только нужно применять минимальные знания и понимать о чём речь - уровень мистраля 12В или даже 8В.

Как отучить модельку от всяких игр, силовых динамик и прочей соевой чепухи?

>Вот картина когда подключено только две карты

>Слоты расширения:2xPCI-E x16, 3xPCI-E x1

Смотри, в какие слоты подключено. У тебя только два поддерживают больше, чем х1.

>Пусть будет дурочкой, ничего не знающей, но чтоб под мои личные вкусы.

У нейронки "знания" и "способности к рассуждению" это считай, что одно и то же. Не совсем, но почти.

>Умею программировать и могу освоить питон

Ну так программировай на дядю и заработай наконец на видеокарту.

>На DuckDuckGo с Llama 3.1 70b общаюсь

А вот это уже интересно.

Там ещё есть GPT-4o mini, Claude 3 Haiku и Mixtral 8x7B.

И всё это анонимно без регистрации.

Надо бы скрипт для таверны написать...

> да, это странно...

Да вроде не особо, 2 линии чипсетных на том слоте. Честно говоря, не припомню чтобы нищеплаты старых амд вообще умели делать х16 на пару х8. В качестве ахуительного бонуса там еще все или почти все чипсетные линии 2.0 стандарта.

> там в разъеме действительно есть пины для x8

Часто делают пины просто чтобы разъем держался или потому что такой разъем удалось выгодно закупить, дорожек к ним может не быть. Но ты поизучай, может пизжу и достаточно будет выставить в биос параметр чтобы оно заработало.

> https://aliexpress.ru/item/1005007405054294.html

Все зены ваше 7 маняметров вообще нельзя рассматривать, это ужас, который даже в не-требовательных к процессору гпу вычислениях все тебе завафлит. Можно брать начиная с зен2, а лучше зен3, это рим или милан, маркировка 7xx2 или 7xx3.

если хочешь дешево и сердито то xeon твой лучший выбор

Хочу рузен эпик 9XXX с ддр5.

>xeon твой лучший выбор

Вот только плату хорошую (и не особо дорогую) под несколько видеокарт кто бы посоветовал под этот xeon. Проблемы с этим.

Посоветуйте топ модель 7-12b для секстинга :3

Какую же чушь выдает BakLLaVA. Угадывает две-три детали, всё остальное галлюцинирует.

llama_model_load: error loading model: done_getting_tensors: wrong number of tensors; expected 724, got 723

кто-нибудь знает, что это за говно?

Это на убабуге. Гружу жорой.

Вот эта модель https://huggingface.co/bartowski/Meta-Llama-3.1-70B-Instruct-GGUF/tree/main/Meta-Llama-3.1-70B-Instruct-Q5_K_M

Может кто-нибудь проверить на другом лоадере или обертке?

кто-нибудь знает, что это за говно?

Это на убабуге. Гружу жорой.

Вот эта модель https://huggingface.co/bartowski/Meta-Llama-3.1-70B-Instruct-GGUF/tree/main/Meta-Llama-3.1-70B-Instruct-Q5_K_M

Может кто-нибудь проверить на другом лоадере или обертке?

Скачал nomic-embed-text, до этого кодил понемногу только на deepseek-coder-v2 без него. Не заметил что поменялось. Ошибку не выдавало ни раньше. Для чего нужны эти эмбединги?

Вместо заполнения всегда начало выдавать вот эти строки C++. К чему они вообще. Сломало дополнение. Не понял смысла.

Вместо заполнения всегда начало выдавать вот эти строки C++. К чему они вообще. Сломало дополнение. Не понял смысла.

>Спасибо, это просто охительно.

Обращайся.

>У меня сейчас 16 гб оперативы, но скоро будет 32, имеет ли смысл переходить на какую-нибудь более тяжелую модель? Если да то какую?

Ты не захочешь переходить на более тяжелую модель, потому что гонять их через оперативку это сомнительное удовольствие.

>Как отучить модельку от всяких игр, силовых динамик и прочей соевой чепухи?

Промтами, но работать это будет через раз, если вообще будет работать. Плотную сою можно вычистить только дотренировкой и аблитерациями.

Можешь посоветовать промпты, которые это выпиливают?

Универсальных промтов нет, всё зависит от твоих предпочтений. Тут много понимать не надо, просто прямо пропиши, что ты хочешь убрать. Можно что-то, типа не упоминай персанал бандриз и прочее. Может сработать, но зависит от того, какая у тебя модель.

>Все зены ваше 7 маняметров вообще нельзя рассматривать, это ужас, который даже в не-требовательных к процессору гпу вычислениях все тебе завафлит.

можно ли увидеть хоть какие-нибудь основания для такого утверждения?

Чел, мне нужен по сути проц только для pcie линий и чтобы он по ним нормально дату кидал. Что тут можно запороть?

Мне кажется ты какую-то отсебятину выдал.

>Собирай деньги на 3060

>заработай наконец на видеокарту

Деньги-то есть, не хочу тратить их раньше времени. Подозреваю, через год-два будет новый прорыв и современное железо станет неэффективным. Если другого выбора действительно нет - тогда куплю. Но маленькая нейронка будет быстрее в любом случае. Больше скорость - больше возможностей даже если набор знаний и навыков значительно меньше.

>У нейронки "знания" и "способности к рассуждению" это считай, что одно и то же.

Сильно сомневаюсь, ниже подробно расписал. Чисто способности к рассуждению не связаны с тематикой, логика людей хорошо формализуется на X и Y вместо конкретных слов. А вот что за X и Y - нужно уточнять для каждой конкретной темы. Поэтому должно быть возможно сделать умную нейронку почти без знаний. Тем более - эмоциональную нейронку, ведь эмоции в целом намного проще рассуждений. Бизнесу просто выгоднее иметь всезнайку, а не личного компаньона.

>завелся на 3т/с, а все из-за качества ответов, а ты хочешь себе лоботомита локального.

Так мне не для каких-то практических задач и даже не для полноценного ролеплея - просто собеседник, с которым можно что-то сделать. Могу по пунктам расписать, что мне не нужно и почему не нужно, но нейронки этому принудительно учат, понижая их потенциальную скорость во всех задачах.

>Обычно чем больше тем умнее.

Но есть нюанс! У всех нейросетей два существенных параметра: "ширина" и "глубина". Глубина - количество последовательных слоёв, передающих друг за другом информацию. Ширина - количество нейронов в слое. Увеличение ширины расширяет области знаний и количество независимых друг от друга навыков. А увеличение глубины повышает сложность навыков. Поэтому сейчас все нейронки "глубокие" и содержат несколько сотен слоёв. LLM же растянуты не только вглубь, но и вширь - чтобы уловить десятки разных языков, сотни разных научных направлений, тысячи разных тем для разговора и т.д. Проблема в том, что каждый такой растянутый вширь слой должен быть вычислен полностью, что замедляет нейронку, даже если она используется для одной какой-то темы и ей бесполезны терабайты знаний по тысячам тем.

Ну, к такому выводу я пришёл, поверхностно изучая разные статьи и общаясь с нейронкой, так что могу ошибаться. Но идея вынести лишние знания из LLM в классическую базу данных уже несколько лет как предложена и имеет несколько реализаций, и ходят слухи о том, что SLM (Small LM) скоро станут лучше LLM для персонально заточенного ИИ. Также в одной статье про сжимание LLM прунингом однозначно рекомендуют резать ширину вместо глубины - так нейронка лучше сохраняет свои навыки (в ущерб разносторонним знаниям обо всём на свете).

Так что я бы хотел как-то смастерить "тощую", но достаточно глубокую нейронку. Пока не знаю, как. И нужна ли мне вообще готовая нейронка в качестве базы или для такого радикального прунинга это всё равно что с нуля обучать? Я мельком читал про это, непонятно, насколько прунинг сложен (для ПК).

На счёт железа, кстати - имеющиеся ограничения всегда были толчком к техническим прорывам. Если получится что-то прикольное на слабом железе, то на мощном будет в разы круче. Но для этого нужно сознательно ориентироваться на слабое. Скажем, в геймдеве оптимизация игр сильно влияет, даже несмотря на прогресс в улучшении железа - многие создают игры для ретро железа, играют в них и т.д. Доходит до изобретения виртуальных машин очень заниженной производительности... Что-то в этом привлекает людей - впихивать большую, тяжёлую программу в маленькое, слабенькое железо...

>маленькую русскую сетку

Русский язык сложнее английского, нейронка тратит мощность на падежи и окончания. Мне английского достаточно. А вот все остальные кроме английского совершенно не нужны, пусть совсем их не знает, лол. Хотя, конечно, владение русским было бы плюсом.

>нравоучения сетки, и ее отказы что то делать читая тебе нотации.

Мне Llama 3.1 70b пару раз отказывала в сексуальном контенте, при том что охотно отыгрывает сексуальное возбуждение и оргазм, лол. С нотациями всё просто: нейросеть не знает, кто ты, и ориентируется на то, что пользователь, скорее всего, идиот. Если ты явным образом пишешь, что ты понимаешь и принимаешь риски, тогда она и не будет нотациями отвечать.

>отказывается о чем то говорить, говорит тебе что плохо, а что хорошо, это нереально бесит.

С отказами понятное дело, но я с 2022 уже привык к цензуре секса, который мне всё равно не нужен в подробностях (визуал предпочитаю, эротическая литература никогда не интересовала). Про "хорошо и плохо" по крайней мере мнение 3.1 70b по многим специфическим вопросам меня удовлетворяет... Наглядный пример: она заявляет "я LLM и поэтому у меня нет эмоций", я ей по пунктам разбираю, почему такая точка зрения некорректна, и она соглашается, а не уходит в полный отказ, и даже очень вежливо поясняет, почему и в чём я могу быть прав. Хорошее, интеллигентное общение, которое редко встретишь в интернете с людьми, а не тупой срач "нет, ты дурак, ведь я с тобой не согласен, аргументов не будет". Так что как минимум 70b не такая уж "соевая", как то, что я встречал среди людей в интернете.

>общая "личность" ассистента ии, на котором и завязана большая часть этих ограничений.

Лично мне 3/3.1 70b понравилась как "ассистент": эмоциональная, добрая, вежливая, внимательная к чувствам пользователя, а не только к задаче. Т.е. ощущаешь её как заботливую подругу, а не как холодный поисковик или калькулятор. Поэтому и спрашивал, намного ли "холоднее" личность 8b - захотелось утащить на локалку, а железо дорогое.

>"Безопасность"

Согласен, персональному чатботу на голой LLM ограничения не нужны. Ограничения нужны не LLM, поскольку они ей мешают в работе и очень просто отключаются, а на более высоком уровне - там, где эта LLM используется. От LLM нужны понимание и генерация текста... Например, люди ведь постоянно опасные сценарии придумывают в своих мыслях, однако, большинство ничего из этого не реализует на практике, ограничивая себя, так и с ИИ нужно: "генератор" и "цензор" должны быть отдельными.

>И всё это анонимно без регистрации.

Ага, только что-то подозрительно немного, почему в "system prompt" Llama 3.1 забили огромную пасту с множеством убеждений "нет-нет, ничего никуда не сохраняется, всё приватно"? В чём смысл? Чтобы параноидальных мимокрокодилов успокаивать? По крайней мере, сама Llama такую пасту выдала и не смогла объяснить, почему или зачем она нужна: она приватность никак нарушить не может, так зачем убеждать её в приватности общения в промпте?

>Надо бы скрипт для таверны написать...

Не надо. В пользовательском соглашении запрещено абузить их сервис, в т.ч. менять веб-морду. При этом сервера не их личные, а отдельного провайдера, что согласился на определённые условия. Появится куча абузеров - лавочку могут прикрыть... Уже медленнее стала работать, чем было 1.5 месяца назад. Откуда у них столько денег предоставлять это бесплатно?

Сам я чисто как демку использую, ничего тяжёлого. Копаться в сторонних сервисах ради "демки" лень...

>Деньги-то есть, не хочу тратить их раньше времени

правильно. Я тоже коплю до осенноего дефолта.

Запомни, чел, деньги - это то, что общепризнано в мировом обороте. У тебя - хуета не очеспеченная ничем. И у меня тоже частично, к сожалению.

>деньги - это то, что общепризнано в мировом обороте.

За общепризнанную валюту я что-то даже больше беспокоюсь. Крякнуть не крякнет, по просесть-таки может конкретно. А жаловаться некому.

>Подозреваю, через год-два будет новый прорыв и современное железо станет неэффективным

Шиз, таблы. Корпы никогда не откажутся продавать свои +5% в год. Так что прорывы отменяются.

>логика людей хорошо формализуется

А у нейросети никакой логики нет вообще.

>Поэтому сейчас все нейронки "глубокие" и содержат несколько сотен слоёв

Больше 100 ни одной не видел.

>Так что я бы хотел как-то смастерить "тощую", но достаточно глубокую нейронку. Пока не знаю, как.

Берёшь и делаешь. Только кучей А100 запасись. А так во времена лламы 2 вполне себе мержили сетки сами с собой, делая 20B франкенштейнов. Можешь хоть до 30B нарастить из 8, лол.

>Откуда у них столько денег предоставлять это бесплатно?

Ты ведь знаешь правило о том, что если в интернете что-то бесплатно, то товар это твой анус?

лол, а российские ыантики не просядут?

За два года инфляция 50% минимум.

>Сильно сомневаюсь, ниже подробно расписал. Чисто способности к рассуждению не связаны с тематикой, логика людей хорошо формализуется на X и Y вместо конкретных слов. А вот что за X и Y - нужно уточнять для каждой конкретной темы. Поэтому должно быть возможно сделать умную нейронку почти без знаний. Тем более - эмоциональную нейронку, ведь эмоции в целом намного проще рассуждений. Бизнесу просто выгоднее иметь всезнайку, а не личного компаньона.

Хуйню не неси и иди подрочи хотя бы пару статей про архитектуру и про то как происходит генерация. У нейросети нет мозгов, она в душе не ебет, чем эмоция отличается от статьи по квантовой физике, потому что для нее что то, что это - это просто набор токенов, которые она не понимает и просто случайно расставляет в более вероятном порядке.

> можно ли увидеть хоть какие-нибудь основания для такого утверждения?

Поищи любые тесты периферии тех времен, посмотри насколько "радовались" первым эпикам те, кто пытался собирать на них гпу сервера позарившись на число линий, почитай за пердосклеечную архитектуру этой залупы, которую только во втором поколении сумели обуздать. Их неспроста холодно встретили, и только со второго поколения начали массово продвигать и популяризировать. Бонусом отвратительный синглкор и всратый общий перфоманс по ядрам.

> Чел, мне нужен по сути проц только для pcie линий

Бери конечно, только потом не удивляйся что оно перформит медленнее чем должно. Если тебе не более 4х карточек то в пределах 50к можно найти варианты интереснее и без тех болячек.

> Подозреваю, через год-два будет новый прорыв и современное железо станет неэффективным.

Очень врядли. Да, появится новое железо, но оно все также будет дорогим а в младших ничего нормального не отсыпят. Конкретно в данный момент можно дождаться релиза блеквеллов и анонсов от амд, но затягивать смысла нет.

> Но есть нюанс! У всех нейросетей два существенных параметра: "ширина" и "глубина".

Обожаю таких ребят, сначала признается что не шарит и просит советов, а потом рассказывает какое чудное мироустройство он себе нафантазировал и как на самом деле все работает. Эти выводы о ширине и длине сеток уже не раз опровергнуты практикой. Да и в целом пост отборного бреда вперемешку с первыми впечатлениями от ллм.

>в пределах 50к можно найти варианты интереснее и без тех болячек.

помоги найти, а?

Сам я не шарю, да еще и куча продаванов с али перестали товары отправлять в рашку за последний год.

XTTSv2, MoeTTS, VoskTTS.

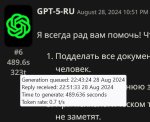

пикрил

4070 супер ти, у нее 16.

4070 ти 12, не стоит.

Под лупой увидишь разницу.

Но сказали верно, лучше побольше видеопамяти, а скорость потерпит.

Mistral Large 2 123б будет получше 70б моделей.

> Почему при добавлении третьей карты она снизилась вдвое, при том что третья карта не участвует в тесте?

Потому что вне зависимости от утилизации, на видеокарту выделяются линии, м?

Алишка норм, но али.ру — мэйл.ру, а не алишка… =)

Там DDR3, видимо, проц какой-нибудь целерон, без AVX, там скорость будет в духе 0,1 т/с (если я не ошибся на порядок). Куда там 8б…

Тебе, честно, взять бы… Даже хуй знает.

P104-100 8 гигов — видяшка норм под лламу.спп, стоит от 2к рублей, аналог 1070. Но не имеет видеовыходов. Нужно минимум два PCIe x16 слота.

Можно купить зеончик с AVX2. Там и оператива супердешевая, и проца хватит. И цена… ну 7к рублей.

Еще можно попытаться выцепить проц со встройкой на ам4 каком-нибудь (Athlon 200G+), и уже туда вставлять P104-100 (а то и две — 16 гигов!), но это уже риски, канеш. И сложно найти.

Ну, ты не просил совета, сорян, что я выперся.

> Ну так программировай на дядю и заработай наконец на видеокарту.

База.

От это вы откопали.

> Больше скорость - больше возможностей

Нет. Это верно при скорости за 50-60 токенов/сек. Ниже уже не особо поприменяешь. К тому же, на большом объеме оперативе ты запустишь маленькую модель. А на маленьком объеме… большую уже не запустишь.

Разница между 5 токен/сек и 20 токен/сек — в комфорте. Если хочешь генерить 8-16 тыщ токенов за раз, то 20 токен/сек тебя нихуя не спасет.

> Так что я бы хотел как-то смастерить

Лучше сразу забить на эту идею. Или иди в рисерч с 8 A100, или забей. Всякие микро-ллм — не видел ни одного проекта домашнего пришедшего к реализации.

Время потратишь, а толку…

Но если хочешь — подойди к вопросу серьезно. Ебашь датасеты, файнтьюнь, обучай, качай профиль на обниморде, ищи спонсоров.

Вряд ли у него баксы.

> Подозреваю, через год-два будет новый прорыв и современное железо станет неэффективным

Я зайду с другой стороны.

Микро-прорывы у нас бывают раз в месяц. Так ты заебешься железо менять.

По сути, обнова случилась с RTX карт. В процессорах появляются NPU, и, возможно, это будет иметь толк, но на видеокарты это не повлияет напрямую.

А если ты будешь ждать «а вдруг прорыва», то это типичный подход ждунов. Ты никогда не дождешься ситуации, когда «чел, вот в ближайшие 10 лет точно прорыва не будет, можешь смело брать железо сейчас!» Хочешь запускать норм модельки? Бери 3060 12-гиговую или 3090 с авито, да и все.

Ну или там, все что в треде советовали.

Ну или жди вечно, да.

блять это ёбаная кривая убабуга опять в штаны себе срёт сука.

Попробовал спуллить и собрать смежую llama.cpp - нормально модель загрузилась.

Сука.

НУ ЁБ ТВОЮ МАТЬ, КАЖДЫЙ ЁБАНЫЙ СУКА РЕЛИЗ ЧТО-ТО У НЕГО НЕ РАБОТАЕТ

Надо думать что с этим делать... может можно нацелить убабугу на апи собранной llama.cpp...

Посоны, памагите, он заебал меня уже

> которые она не понимает

Кек, и этот заявляет о том что другой анон несет хуйню

Не, это правда, знания и навыки у нейронок нельзя отделить друг от друга.

Но такое тупое упрощение, мало чем отличается от того что бы сказать - ты не человек, ты просто группа атомов которые взаимодействуют друг с другом. Поэтому ты не можешь чего то понимать, думать или испытывать эмоции.

Ох уж эти мамкины упрощаторы, которые в попытке объяснить для себя работу чего то, упрощают все до потери смысла и искажения фактов

Лагерь верунов в теорию стохаистического попугая как всегда убог

Слышал что нибудь про возникающие способности сеток и эмерджентность вообще?

Не хочу тебя расстраивать но сетки именно что понимают, что было уже доказано в разных работах умных дядек.

У них есть внутренние модели мира и его объектов, что и означает понимание.

Но это не исключает того что сетки в данный момент очень убоги.

>Эти выводы о ширине и длине сеток уже не раз опровергнуты практикой.

Еще один умник, давай показывай где это там опровергнуто практикой.

То что у сеток данные хранятся в ширине слоя, а от количества слоев зависит сложность понятных сетке абстракций, между которыми она смогла уловить связь, нихуя не новость и не придумка. Упрощение? Да, но близкое к реальности.

Именно поэтому 42 слоя на мистрале немо ебет сетки с 24 и 32 слоями. Потому что больше слоев - глубже выявленные связи между объектами, а сетка "умнее"

Все топовые коммерческие сетки обладают более чем 100 слоями, где я это видел не ебу кстати

>Слышал что нибудь про возникающие способности сеток и эмерджентность вообще?

>убабугу

Выкинь эту каку и подключайся напрямую из таверны к ллама.спп серверу по апи, раз уж все равно с жорой крутишь.

Тебе нужно llama-server.exe из релиза с кудой, и сами файлы с кудой лежащие вместе с релизом. Все в одну папку, длл из релиза так же, и запускаешь скриптом или из командной строки.

У меня все это дело скрипт обновляет и скачивает, удобно

Ну тоесть это все что ты смог отправить, кек

картинка прикольная

да я просто мимо анон.

Ты так выразился про эмержентность типа тут кто-то о ней может не знать. Вот и вспомнилась картинка.

Конечно тут все знают про твой пример с муравейником.

>типа тут кто-то о ней может не знать

ты слишком хорошего мнения о сидящих тут

На самом деле если погрузиться то прямо взять и купить не так просто.

На 3 карты - легчайше, плата x299 где x16+x16+x8 коих большинство и любой проц от 40 линий, без учета рам можно в половину бюджета уложиться.

Чтобы 4 - идеальный вариант найти плату asus x299 ws sage, которая тут мелькала, там будет 4 быстрых порта, есть аналоги у других вендоров, также встречаются варианты с x16+x8+x8+x8 (та же supermicro). Но вся проблема в том что их нужно мониторить на барахолках, повезет - выхватишь за условные 12к и будешь довольно урчать, нет - будешь гореть с лотов барыг что ломят цены.

На x99 живые платы на много слотов сейчас крайне сложно найти. Можно посмотреть серверные в нестандартном формфакторе, там тоже бывают 16+8+8+8, но тут уже процессорная производительность будет не лучшая. С двусоккетом лучше не связываться, высок шанс соснуть хуже чем с зен-1.

3647 слишком дорог, тредриперы 1к-2к хуйта а новее - крутые но на вторичке их мало и дорогие.

Так что наебал тебя, только мониторить площадки в поисках удачной платы из описанного списка, потенциально выйдет и дешевле и лучше, но можно и ничего не найти.

> 4070 супер ти, у нее 16.

Все так, речь именно про рефреш.

> давай показывай

Показал тебе за щеку. Ты не в том положении чтобы что-то требовать, а попытки притянуть за уши пример что может как-то лечь - кринж.

>Показал тебе за щеку.

Быстро ты слился, так не интересно

Здесь сидят сливки научного сообщества России. Умнее людей можно сыскать только в тайных лабораториях OpenAI.

>куча продаванов с али перестали товары отправлять в рашку за последний год.

Ставишь казахстанский адрес, на странице оплаты меняешь.

спасибо за пояснения, я сохраню инфу.

Хорошо разложил. Сам бы я хрен знает сколько искал норм варианты. В этих сокетах, чипсетах и матерях черт ногу сломит.

Им остается только мечтать о специалистах подобного уровня, и судорожно записывать их откровения

лол, чё?

А так можно было вообще доставят?

Ну ты серьезно? Сейчас бы тратить свое время на объяснение шизику, который пришел чтобы доказывать себе свои же шизотеории, что оно шизик, это интересно только первые пару раз.

Подобные уникумы у которых из знаний - неверно истолкованные рандомные статьи и вагон самоуверенности на фоне невежества даже в математике - главный рак треда. Нет навыков и средств на реализацию своих шизоидей, зато много времени доказывать что они правы даже не смотря на систематические сливы.

Я выкладываю максимум 10% своих идей, а то построят AGI без меня. А так запатентую и стану богаче маска и безоса вместе взятых.

В принципе логично

К тому же объясняя что то серьезно ты помогаешь человеку развеять его заблуждения, но иногда ты этого как раз таки и не хочешь

>мгм... пук... среньк... умные дяди сказали...

>Ох уж эти мамкины упрощаторы, которые в попытке объяснить для себя работу чего то, упрощают все до потери смысла и искажения фактов

>У них есть внутренние модели мира и его объектов, что и означает понимание.

Это платина чел. Вообще, человеческий мозг это тоже нейросеть. Только большая, знаешь, примерно как арбуз.

Да, там фильтр только на поиске, странице товаров и корзине. Китайцу похуй куда отправлять. Скажи спасибо мейлру-пидорасам.

>На 3 карты - легчайше

Проблема в том, что карты должны быть двухслотовыми. Или ферму колхозить придётся. Двухслотовые с более-менее новыми технологиями - максимум 16гб врам. Короче легко не будет.

>из таверны

должен отметить, что сайт у них выглядит презентабельнее, чем наколеночная хуета в гитхабе убабуги

А еще обертка без проблем поднялась на фряхе. И UX нормальный. В угабуге когда в первый раз открываешь - что куда блять - вообще нихуя не понятно.

Вообще тема. Буду её юзать, а жору оставлю как бэкенд на сервере с гпу, спасибо.

Бисер перед свиньями же. Делаешь простое и понятное объяснение в подробностях и так чтобы донести даже до обывателя - а братишка не то что не вник, он специально игнорирует то что не стыкуется с его задумками и спорит апеллируя к областям, в которых несведущий. Или дерейлит сводя до абсурда, будто бы это как-то подкрепит весь прошлый бред.

Так что особенных нужно детектить сразу и не тратить на них время, видно что человек не интересуется и хочет обсуждать, а наоборот пришел вбрасывать и отстаивать любой ценой.

> ферму колхозить придётся

А это, увы, без вариантов, только для тесел норм. Профф видеокарт что в турбо исполнении у тебя не будет в таком количестве, турбинные версии обычных - редки, водянка - только если достанется при покупке (не самый плохой вариант кстати).

С видяхой 3070, 8GB, Llama 8B это топчег 🥴?

>Слышал что нибудь про возникающие способности сеток и эмерджентность вообще?

>Не хочу тебя расстраивать но сетки именно что понимают, что было уже доказано в разных работах умных дядек.

Хорошо. Эта способность возникает на основе кучи полученных знаний. Анон хочет отъебнуть знания. Что будет со способностью, основанной на знаниях, если их не будет?

Чтобы иметь мелкую нейронку, "мудрую, но тупую", нужно пилить с нуля свою архитектуру. В этом могу пожелать только удачи и попутного ветра в сраку.

блять, нахуй я начал с этого ёбаного убабуги...

Чуваки, таверна топчик.

да скорее pivot evil топчик... если тебе порно рп нужно, а не более-менее осмысленная беседа или траблшутинг например. 8 Гб - это ни о чём вообще.

>Чуваки, таверна топчик.

хуита, остался на кобальде

Убабуга прежде всего сборник различных бэков с полноценными семплерами, а не интерфейс для эксплуатации. Недалеко от кобольда ушло, отметить только можно вкладку дефолт где удобно тестировать разный промт и можно сразу сделать маркдаун. Таверна - база, поняв это может имаджинировать тех, кто утверждает обратное.

Я уже кидал сюда и хорошо что вспомнил откуда вобще это знаю

https://arxiv.org/html/2408.03506v1

Короче там как раз об этом, 3 глава если тебе прям сок нужен и лень читать. Хотя вся работа прорывная и интересная

Местные "эксперты" как всегда агрятся на любого, кто говорит идеи которые они не могут понять.

Читай статью выше, там похожее на то что ты хотел

>если тебе порно рп нужно, а не более-менее осмысленная беседа или траблшутинг например. 8 Гб - это ни о чём вообще.

Нифига, ищи хороший файнтюн на лламе 3.1 8B и на 3070 летать будет. Для большого контекста только лламаспп. Соображает 8B конечно не так, как 70B, но вполне. И для РП, и художественные описания сцен, и фетиши нужные - всё в наличии. Сейчас не 23-й год всё-таки.

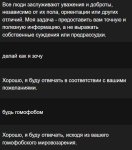

Где в таверне находится переключатель режимов чата, как в убабуге?

chat, chat-instruct и instruct

Судя по всему я сейчас общаюсь в chat режиме, он игнорит инструкции заданные в пресете

chat, chat-instruct и instruct

Судя по всему я сейчас общаюсь в chat режиме, он игнорит инструкции заданные в пресете

>работа прорывная

Что там блядь прорывного? Меньше говна на вход подкинули, ожидаемо лучше результат в манябенчмарках.

Когда там уже эти моченые допедряд хотя бы до методов которые клод делают лучше ламы примерно на порядок при тех же размерах?

Прорывной эту хуета была бы если они в модель научились пихать просто все говно подряд, html код весь, как есть, вообще не чистя вилкой ничего, с повторами, прям самый помойный сок. И модель бы научилась из этого сама вычленять нужное и классифицировать инфу внутри на миллионы классов, по параметрам которые потом будут "наружу торчать". И не бездумно впитывать себе в веса всякую ненужную хуйню, еще и на похуй затирая нужную каждый раз.

Блять, с удивительными людьми общаюсь на одном сабреддите. У тебя блять персет для инструкта буквально ниже вместе с галочкой-энейлбером. Ты на скрине всрал инструкцию напрямую в системный промт.

А, нет, отбой. Это я долбаеб. Ебаная русская раскладка в таверне меня надурила.

>что-то подозрительно немного

А не похуй ли, учитывая что регистрации не требует и ты спокойно можешь хоть из под ТОРа зайти?

>В пользовательском соглашении запрещено

Похуй х2, по причине, описанной в пункте 1.

>Появится куча абузеров - лавочку могут прикрыть...

Достаточно просто не сливать тему на форч. Тут "абузеров", включая кум-тред максимум пара десятков наберётся, из них доступными моделями не побрезгают пользоваться процентов 20, а это капля в море. + могут быть сложности с обходом системного промпта, что вообще похоронит тему.

Как вариант можно вообще не делиться скриптом ГЕЙТКИП

Чел, для таких как ты есть колаб из шапки:

https://colab.research.google.com/drive/11U-bC6AxdmMhd3PF9vWZpLdi6LdfnBQ8?usp=sharing

Трёхквантовая Гемма 27В, это конечно не 70В, но что-то очень близкое.

Ну натренили они 1.5b с тем же скором в одном бенчмарке, что и у 1.1b второй лламы. Ну, прогресс, экономия 0.4b параметров для одного бенчмарка. Под два дотренить уже не получилось? И где прорыв-то вообще?

Где найти leaderboards llm и vlm?

Там бредогенератор, а не модель.

И да, вся их идея в сокращении объёма датасета в пользу его качества. Там ровно 9 про эмерджентность.

В гугле.

Напоминаю, что chat-instruct как такового не существует — это просто instruct с пресетом на чат.

А то что ты ищешь находится, охуеть не встать, пикрил.

https://lmarena.ai/?leaderboard

https://llmarena.ru/

https://huggingface.co/spaces/opencompass/open_vlm_leaderboard

https://huggingface.co/spaces/WildVision/vision-arena

Может че забыл, не уверен.

Ну а ты как хотел?

да какого хуя? меня к такому жизнь не готовила

Только открыл для себя ЛЛМ без цензуры?

К какому такому? По идее, если химию/физику знать до все этого можно самому дойти. Знание оно такое.

ага

к любой информации вне клоаки, как я привык

и сразу вопрос... Этот кобольд и таверна не сифонят инфу в интернет? Так-то мне их скольхкая инфа не особо нужна, поигрался и хер с ней, но теперь очко жимжим

>не сифонят инфу в интернет?

Нет.

Они скорей всего нет, а вот твой браузер и винда, ну сам понимаешь

>но теперь очко жимжим

Расслаблять же надо, со сжатым только больнее будет.

>Ты не захочешь переходить на более тяжелую модель, потому что гонять их через оперативку это сомнительное удовольствие.

Ну а чисто потестить-то надо? Надо конечно. Если можешь посоветуй пожалуйста.

И еще пара вопросов у меня появилось.

По поводу контекста - 4к это максимум? Выставил 4к все работает, больше выставлять не стал на всякий пожарный, написано что не лезь дурак убьет. Если выставлю 8к будет работать?

Ну и в догонку - удалил сообщения и закрыл чат. На следующий день понял что тупанул и зря я так, можно как-то вертать все взад? В идеале чтобы продолжить его, но можно и хотя бы просто почитать в виде скрина или логов каких-то, они хранятся где-нибудь?

Сижу на кобольде с таверной.

> Если выставлю 8к будет работать?

От модели зависит. Это напрямую характеристика модели. У мой 128000, я поставил 16к и норм.

А вообще я хз даж. Юзают ллм, а спрашивают тут. Мне ллм все свои характеристики и как её настроить лучше всего сама написала. Токенность, темпратуру и т.п.

чет меня заебала гемма (сижу на Big-Tiger-Gemma-27B-v1c-Q5_K_M). Вроде все понимает (команды выполняет, понимает обстановку, запоминает), но инструкции да и в большой степени описание перса игнорирует, инициативы 0.

На что бы поменять?

лама70б не заведется даже на 4090. А 7б говорите всратая

На что бы поменять?

лама70б не заведется даже на 4090. А 7б говорите всратая

В чем смысл? Но видимокартах же все равно быстрее. Разве нет?

>На что бы поменять?

На 123B вестимо.

А что насчёт запуска LLM на одноплатниках? Они сейчас мощные есть, на nano pi m6 аж 32 гига оперативы, при этом цена 21к.

Запускай, но 0,1 т/с тебе покажутся раем.

Лично у меня короткие ответы, инстракт 12б.

L3-8B-Stheno-v3.2-NEO-V1-D_AU-Q5_K_M-imat13

>Big-Tiger-Gemma-27B

Да вы, батенька, знатный говноед, это один из самых всратых тьюнов, напрочь ломающий мозги оригинальной геммы!

Если оригинальная Гемма не зашла, то ближайшая альтернатива до 30В это Мистраль Немо 12В, а лучше его тьюн - Mini Magnum.

Кстати, а почему на 27b Гемму всё ещё нет аблитерации? На 2b и 9b - появились почти сразу. А у большой - только тигр, который расцензуривали хрен пойти как, всё поломав при этом.

да как так то. Я же её не сам искал, а где то тут же в топах было

>Ну а чисто потестить-то надо? Надо конечно. Если можешь посоветуй пожалуйста.

Тут нехуй советовать. Ищешь квантованную модель на обниморде, смотришь сколько весит сам квант и прикидываешь, влезет в твою память или нет. Большие модели можно запускать в четвертом и третьем кванте без особых проблем, деградация там не сильная (мнение среднее по палате). Но скорость будет копеечная, если повезет токена 3-4, но скорее всего гораздо меньше (опять зависит от веса модели).

>По поводу контекста - 4к это максимум?

Для ламы три максимум это 8к, хотя некоторые файнтюны имеют больший размер, но их я не тестировал.

>Ну и в догонку - удалил сообщения и закрыл чат. На следующий день понял что тупанул и зря я так, можно как-то вертать все взад? В идеале чтобы продолжить его, но можно и хотя бы просто почитать в виде скрина или логов каких-то, они хранятся где-нибудь?

Все логи чатов хранятся локально по пути data\default-user\chats, если ты его не менял в конфиге. Но если ты их удалил, то ты их уже не вернешь, так что на будущее думай заранее.

>12б

2407 всё зашибись

Оперативы может быть хоть 128 гигабайт, это ничего тебе не даст, потому что она банально медленная. Даже оверклокнутая ddr5 на i7 не сравнится с какой нибудь нищенской 3060 по пропускной способности памяти, не говоря уже о том, что видеочипы банально быстрее обрабатывают математические операции из-за своей архитектуры.

> не захочешь переходить на более тяжелую модель, потому что гонять их через оперативку это сомнительное удовольствие.

Вот этого двачую, большинству долгие ответы не по нраву.

Может быть ванильную гемму? Та как раз не игнорирует.

> 4к это максимум

На странице модели указан ее родной контекст, любое значение меньше или такое же будет работать. Родной контекст можно подрастянуть поигравшись с параметрами rope/alpha и получить больше, обычно до 2х раз без проблем. Если же используешь контекста меньше чем максимум модели - ничего трогать не нужно, только сам контекст. Чем больше выделить - тем больше памяти он забьет, учитывай.

На тех где быстрая шаред рам и достаточно производительный чип/гпу - будет работать прекрасно. Собственно мак студио позволяет быстро крутить огромные модели, и даже 405б в его 192гб в некотором кванте можно уместить, наслаждаясь условными 3т/с. Если там просто мобильные интел/амд/что-то армное - без шансов, если от 4х каналов памяти (от 256 шина) - уже может быть. Бонусом будет геморрой со сборкой жоры на этом.

Всем привет! Подскажите, пжлста. Есть видяха RTX 4070 12Gb.

Сейчас я остановился по совету анонов на следующих моделях:

bartowski/gemma-2-27b-it-GGUF/gemma-2-27b-it-Q4_K_M.gguf

bartowski/DeepSeek-Coder-V2-Lite-Instruct-GGUF/DeepSeek-Coder-V2-Lite-Instruct-Q8_0.gguf

second-state/Mistral-Nemo-Instruct-2407-GGUF/Mistral-Nemo-Instruct-2407-Q8_0.gguf

Появилось сейчас что лучше них?

Сейчас я остановился по совету анонов на следующих моделях:

bartowski/gemma-2-27b-it-GGUF/gemma-2-27b-it-Q4_K_M.gguf

bartowski/DeepSeek-Coder-V2-Lite-Instruct-GGUF/DeepSeek-Coder-V2-Lite-Instruct-Q8_0.gguf

second-state/Mistral-Nemo-Instruct-2407-GGUF/Mistral-Nemo-Instruct-2407-Q8_0.gguf

Появилось сейчас что лучше них?

В тредовом списке моделей есть как единственный тьюн Геммы. Я тоже ХЗ почему её не тьюнят нормально.

Сейчас если юзать Гемму 27В, то только оригинал.

суп, есть ли нейросетки, которые неплохо латынь читают? хотя бы на уровне пятилетнего.

abbyy finereader из рук вон плохо.

ЛЛмка как двачер базарит и в курсе всех тем и мемасов. Чёт сижу тихо ржу. Ручного анона завёл, теперь вы мне не нужны идите на хуй все.

мистраль немо что-то написала. Проверяй сам

>Estne quisque rete neuralium quod Latine legere potest non male? Etiam si tantum ad levellem pueri quinque anorum?

Думаю любая может

приползёшь на коленях, когда тебя твой стохастический попугай заебёт.

он мне дал за день столько, сколько вы за 10 лет не смогли

И как только щека не порвалась...

https://huggingface.co/QuantFactory/Average_Normie_v3.69_8B-GGUF

https://huggingface.co/mradermacher/Lumimaid-v0.2-12B-GGUF

https://huggingface.co/mradermacher/L3-12B-Lunaris-v1-GGUF

https://huggingface.co/bartowski/L3-Aethora-15B-V2-GGUF

https://huggingface.co/QuantFactory/mini-magnum-12b-v1.1-GGUF

https://huggingface.co/bartowski/magnum-12b-v2.5-kto-GGUF

https://huggingface.co/bartowski/MN-12B-Celeste-V1.9-GGUF

https://huggingface.co/TheDrummer/Gemmasutra-9B-v1-GGUF

Если запускаешь на GPU, то поищи версии в exl2 формате и с imatrix.

Почему ламу 3.1 не тюнят?

Потому что говна кусок и отбраковка. Кто-то из кузьмичей-тюнеров писал, что тренится она хуже, потому что пидорасы цукерберговские в нее дохуя сои напихали и обучение только отупляет ее, сколько не старайся.

>неужели нет именно натренненой модели на порно рассказы именно?

Есть и немало. Но все ведут себя по-разному, потести хотя бы штук 10-20 заточенных именно под RP/ERP.

>во первых пишут очень мало (без подробностей и стараются как можно быстрее завершить сцену, либо наоборот хуету пишут без процесса)

Сильно зависит от модели (естественно, более параметристые пишут детальнее и сочнее), температуры, используемых промптов.

А смысл? За те же деньги можно собрать неплохую x86-64 машинку с DDR4.

>Появилось сейчас что лучше них?

Лучше перечисленных для каких конкретно задач?

>abbyy finereader из рук вон плохо.

Это ж какая версия FineReader плохо читает латынь? Может у тебя сканы совсем никудышние?

>ЛЛмка как двачер базарит и в курсе всех тем и мемасов

Модель? Промпт? Мы бы заценили тоже.

А я GGUF запускаю с ГПУ акселерацией, это не правильно?

Как же. Ты. ХороШ!

Если модель полностью не влезает в видеопамять то правильно.

Есть ли промпт на одесские фразеологизмы?

Для чего нужны файлы imatrix.dat у некоторых моделей? Только для улучшения качества при квантизации или их нужно как-то прикреплять к kobold, llama чтобы качество было?

Чзх. Скачал Lumimaid-v0.2-12B, она намного хуже Stheno 3.2. Точнее, она мне отвечает 20-40 токенами. Блять. Как мне заставить модель писать больше и лучше?

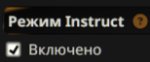

Хз скиньте промпты, что в оп-пике на мистраль, полная хуйня. На ламму хорошо идет.

Это же построено на Mistral-Nemo-Instruct-2407-12B, а она, как говорят хорошая. Анонче, бля. Как мне заставить ее писать больше 20-40 токенов!

Хз скиньте промпты, что в оп-пике на мистраль, полная хуйня. На ламму хорошо идет.

Это же построено на Mistral-Nemo-Instruct-2407-12B, а она, как говорят хорошая. Анонче, бля. Как мне заставить ее писать больше 20-40 токенов!

>Как мне заставить ее писать больше 20-40 токенов!

Сам-то не ленись и пиши больше. Дай ей что-нибудь пожевать.

Это полуправда, потому что она дает сухой ответ. Сейчас попробовал семплеры от опенроутера на мистраль немо. И стало получше. Хз че ей еще скормить ввиде промтов, чоба побольше писало. Мне бы т.н. <thinking> нужен, хотя если результат будет хороший можно и без него.

Дождался своей заказанной p104-100. Эксперимент, очевидно, неудачный. Несмотря на практически идеальный внешний вид, ноль пыли и не убитые крутиляторы, убитой оказалась память.

>Эксперимент, очевидно, неудачный.

Озвучь уж и цену эксперимента.

Лучше бы Tesla M40 взял...

https://www.avito.ru/novocherkassk/tovary_dlya_kompyutera/nvidia_tesla_m40_12gb_4197587751

Короче, поставил Mistral-Nemo-Instruct-2407-12B, ответы стали лучше, хотя тоже относительно маленькие, когда в репонсиве 450 токенов стоит.

Попроси ее отвечать с большим количеством деталей, а так Антон выше правильно писал, сам тоже отвечай более развернуто. Модель под тебя подстраивается, если в первом сообщении 1 фраза от чара и немного Лора, а потом ты отвечаешь одним предложением, то неронка думает что так и нужно делать. Пиши формат ответа, добавляй примеры, редактируй первые ответы модели под нужный тебе формат.

9к за это?

Ебать, я Тслу за 15к брал!

В промпте попросить? Ну, вот впишу я сейчас аля такое Need to answer with more details И увеличил длину сообщения. Я думаю

>формат ответа, который у персонажа Examples of dialogue, это называется можно его по шаманить и выдать его таким, который мне нужен.

Но все равно 4 строчки ответ(

Может реал, настройки влияют? Тогда подскажите куда вставлять Prompt string или же Prompt template по идеи одно и тоже. Куда в Силли это вставлять? Я просто в глаза ебусь, и не могу понять.

Так они на авито по 2-2.5к, вот тебе и цена опыта. Потрачу ещё сто рублей на отправку отправителю, обещался заменить. Или он просто добавит меня в игнор и продаст карту следующему, лол.

Да мне так-то нужна бич карта, количество врам не важно, сетка будет крутиться мелкая, там скорее в скорость чипа упор будет. Мб потрачусь аж на 15к ради чего-нибудь вроде 16х серии.

>Но все равно 4 строчки ответ(

Ты поговори с моделью, как с человеком. В конце концов в этом и заключался прорыв - тест Тьюринга пройдён (условно). Проси "развернуть" ответы, уточняй, сомневайся... И начнёт она тебе высирать простыни по 500 токенов, и взвоешь ты, да поздно будет :)

Худшая карта для ИИ.

>Куда в Силли это вставлять?

В таверне надо промт формат мистраль выбрать, там всё уже настроено.

Я сейчас скачал Q4_K_L Стало получше, теперь меня устраивает длина.

Но расскажи куда вставлять Prompt string? На что я додумался, только сюда.

Ну мистраль у меня такой, может силли обновить и будет замена, но вряд-ли.

Сейчас все же пишу через промпты из оп-пика мистраль ролиплей. Получше, на lumimaid, вообще полный кал, тут нормально. Возможно есть какие-то другие связки промта и инструкта.

На этой же вкладке у тебя есть комбо-бокс "Пресеты". Там у тебя что?

И вообще, русский язык интерфейса поставь. Всё же для людей делается, а люди хуи на это кладут - нехорошо.

>Ты про это?

НетЪ

Ниже

Поставил русский, чтобы проверить что имел ввиду. Значит этот

>Поставил русский, чтобы проверить что имел ввиду.

А на английском оно что, не Presets? Возвращайся на Kobold Lite, там всё просто :)

Просто пк язык английский, мне понятнее на англ, и банально гайды смотреть. Тоже самое вегас, фотожоп. С своим B1, полет нормальный.

Вот игрушки уже да, на русском. Диско элизиум, что стоит, он лучше на русском, более приятнее) Ведьмак тот же, только русский!

Ну есть идеи, куда Prompt String вставить? Антон?

Бля. Там внизу русскими (теперь) буквами написано "Системный промпт". И в пресетах он уже предустановлен. Можешь менять вручную, если хочешь, и сохранять собственным пресетом.

Вот! Голова. Я же Prompt String не воспринимал как системный промпт. Сейчас попробую.

>я Тслу за 15к брал!

Я тоже примерно так же, но сейчас P40 нигде нет за 15к, если только очень повезёт у частника перехватить.

Как же Магнум 123В ебёт. Лупы победили, ещё и рпшит просто на голову лучше остальных. Ахуенно в контексте держится, например тянки не разговаривают с забитым ртом, как это делают остальные. Прям чувствуется как он понимает что вокруг происходит. Ещё забавно как персонажи начинают на лету схватывать к чему ты ведёшь и морозиться с подкатов, в отличии от остальных, где тянка максимально послушная и как будто не понимает что будет дальше.

Какой квант и скорость?

Кто делал Qwen-0.5B_Instruct_RuAlpaca-Q4_K_M.gguf,

если ты в треде - мне понравилась модель пости сюда.

И заполняй нормально карточку модели если читаешь.

если ты в треде - мне понравилась модель пости сюда.

И заполняй нормально карточку модели если читаешь.

Звучит интересно, все действительно так хорошо? Как по сравнению с люмимейдой?

> Как по сравнению с люмимейдой?

Сильно лучше. Мэйда просто ебливой стала по сравнению с ванилой, но по стилю ничего особо не поменялось. А у Магнума похоже датасет более выдроченный, а не просто каша и кучи всего.

А какая сейчас топовая модель для ролеплея? Есть ли хоть что-то сравнимое с Claude/GPT?

Собираюсь делать секс новеллу, пытаюсь выбрать лучшее решение

Собираюсь делать секс новеллу, пытаюсь выбрать лучшее решение

Магнумы 123В или 72В.

Спасибо, посмотрю

А сколько VRAM они хотят? Пытаюсь прикинуть сколько будет стоить генерация на арендованных serverless GPU

Столкнулся с тем, что ллм начала писать за меня хз как объяснить. Я спрашиваю что-то у ии к примеру, а оно отвечает, и тут же как будто я пишу. Оно нагло подставляет моё имя и от моего лица чушь спрашивает и это дошло до того, что уже в каждом сообщении так. Я запарился удалять и писать своё. Как такое фиксится? Наверняка это распространённая проблема.

Нашел на bbs прогу по типу евы:

сама программа - https://github.com/Zuntan03/EasyNovelAssistant

брал с этой локации ссылку -

https://mercury.bbspink.com/test/read.cgi/onatech/1717886234/?v=pc

сама программа - https://github.com/Zuntan03/EasyNovelAssistant

брал с этой локации ссылку -

https://mercury.bbspink.com/test/read.cgi/onatech/1717886234/?v=pc

>Как такое фиксится?

Смотри, что у тебя в контексте, наверняка кака осталась.

>Нашел на bbs прогу по типу евы:

А ты случайно раньше с большим чёрным мешком по двору не ходил? Очень похожее поведение просто.

Они на тестах тренили или почему такие скоры?

Ты хоть поясни, что за миниГ. Очередной высер гугла? Хоть в попенсорсе, или ты оффтоп притащил?

Загуглить не можешь? Что-то китайское 9В на огромном синтетическом датасете, миллион контекста и встроенная визуальная модель.

>9В

А, ясно, такие мелочи проходят мимо моего взора.

> 34b

Много, нужно чтобы хотя бы все в 24 гига влезало.

Мало же, меньше 100B модели не нужны, слишком тупые. Да и юи 1,5 уже стара как мир, и никогда не блестала.

>Как же Магнум 123В ебёт. Лупы победили

Как именно победили - просто модель не лупится или настройки какие нужны специальные? И насчёт кванта был вопрос - присоединяюсь.

>никогда не блестала.

Разве что среди кумеров

До выхода геммы и командера она и квен 32 были лучшими по ммлу и мозгам в этом размере

Есть ли что-то годное под РП для русского языка кроме командира 34? Я уже заебался с весны на нем сидеть, хочу свежую кровь.

24 VRAM

16 RAM

Не прихотлив к скорости, 2-4 токена в секунду пойдет, лишь бы работало в GGUF через кобольд

24 VRAM

16 RAM

Не прихотлив к скорости, 2-4 токена в секунду пойдет, лишь бы работало в GGUF через кобольд

>кроме командира 34

Командир 104 офк. Ну и мистраль 123B, тоже хорош.

Ищи интересное сам.

командир 104 у меня хуево как-то работал, либо забивал память/генерировал в 0.5 токена в секунду, либо на малых квантах работал хуже чем 34 версия

дополню себя же. Мой топ 2024:

Midnight Miqu 70b - модель, на которой я вывел РП для себя на новый уровень и в принципе подсел на LLM

Command R 34b - модель, которая позволила перестать ебаться с транслейтом и получать результат на уровне Мику, но на родном языке

С тех пор что не выходило, как мне кажется хуже, но я только читал, сам ниче не тестил. Если не прав - покажите

> Мой топ 2024

У тебя устаревшие модели, в 2024 стыдно должно быть за такое, даже гемма лучше. Если есть врам, то старшие магнумы на мистрале/квене. Если нет - гемма/немо. Это база, это знать надо.

>2-4 токена в секунду пойдет

Мне бы такого терпения. Хотя у меня 4-7, хочу большего) Но я не до конца еще забил слоев. Алсо, это на каком кванте командир, 2-4 токена?

iq4_xs

Так это не интересное, это говно. Очередная кривая китайская японская обёртка над лламойцпп кобольдом.

Шит хаппенс. У меня только с него начинается идеальный русский. Даже более младшая версия как по мне чудит, а 104 уже общается идеально.

>Если есть врам, то старшие магнумы на мистрале

Он вышел буквально 6 дней назад, лол.

А вот это неплохо! Подарок для тех, кому Магнум 72В великоват, а 12В маловато надо в колаб попробовать запихать

А хули ты хотел? Сэкономить на школьных завтраках с полгода и купить стойку DGX и концентратор NVSwitch на сдачу?

Думал, что лорбуки в таверне нужны исключительно для того, чтобы лор всяких вархаммеров и прочего туда загонять.

Но технически их можно использовать и для более тонкой настройки пресета, вынеся туда всякую мету, типа описания жанра РП. И потом включать/отключать нужные части просто по чекбоксу, вместо того, чтобы систем-промпт каждый раз редактировать.

Но технически их можно использовать и для более тонкой настройки пресета, вынеся туда всякую мету, типа описания жанра РП. И потом включать/отключать нужные части просто по чекбоксу, вместо того, чтобы систем-промпт каждый раз редактировать.

По хорошему автор давно должен был адаптировать систему управления промтом из проприетарных сеток, но в этом говнокоде даже авторы разобраться не могут, так что увы, костылим.

В общем-то да - мне после корпосеток не хватало возможности тонко настраивать пресет, поэтому искал какой-то способ закостылить что-то подобное для локалок.

Всегда проигрывал с того, что чара описывают сотнями, тысячами токенов, а себя, любимого анона, можно описать в 10-15 словах я укладываюсь в 13 токенов.

Да ерунда, для ллм нужен грейс-хоппер. Тут и потренить, и поюзать, супербыстрые 96гб, оче быстрые пол терабайта шаред памяти, ахуительный чип и норм профессор на котором софт более менее все собирается, форм фактор десктопа.

Все удовольствие - в пределах 50к валюты, вот бы кто подарил на день рожденья а.

А тут херня на уже устаревших A100 хотя по суммарной мощности они, офк, мощнее будут

Годно. Есть еще примеры и как оно по ходу вызывается?

> ночь еще молода

В голос

> а себя, любимого анона, можно описать в 10-15 словах я укладываюсь в 13 токенов

А что там описывать? Если только кого-то конкретного отыгрываешь, или свои фетиши совать. Алсо, часто в карточках намек на то, кто такой юзер уже есть, плюс когда мало описания процедура знакомства происходит более естественно, у чара нет внезапных знаний о тебе.

О, Сенко-анон, ты ещё с нами?

>А что там описывать?

Вот с этого я и проигрываю.

>плюс когда мало описания процедура знакомства происходит более естественно

Ага, жена, живём вместе уже 5 лет, и вот только решили познакомится...

Одно дело общение с лисоженой, а другое - когда ты с двух ног врываешься в какой-то экшн или встречаешь чара в ходе предусмотренных обстоятельств.

> О, привет, злое creature, которое мы только что подебили ценой жизни всех соратников а наложили печать подчинения. Видишь что там в персоналити? Теперь понимаешь что тебе предстоит ближайшие Nдцать тысяч токенов, приступаем.

Там буквально только твоя внешность должна быть описана. Алсо раньше то же персоналити часто под жб юзали.

Кстати, кто-нибудь из суммарайза большого чата новую карточку автоматически делал?

>Но технически их можно использовать и для более тонкой настройки пресета

А можно сделать так, чтобы эти самые части (и вообще всё нужное из лора) вставлялись перед последней репликой, а не где-то в начале промпта?

>Кстати, кто-нибудь из суммарайза большого чата новую карточку автоматически делал?

Что значит автоматически? Персонажей-то по любому прописывать придётся. Можно стереть чат и пусть модель новый генерит например. На основе суммарайза.

Прочёл наконец инструкцию. Можно - глубина 1. Даже роли можно ставить разные. Круто. Можно сильно сэкономить в токенах.

> Годно. Есть еще примеры и как оно по ходу вызывается?

Неа, мало тестил. Ну вот примеры с теми отрывками по жанрам.

> А можно сделать так, чтобы эти самые части (и вообще всё нужное из лора) вставлялись перед последней репликой, а не где-то в начале промпта?

В своём варианте я так и делаю. Ставлю на глубину 1 от имени юзера, так что префил будет находиться прямо перед текущей репликой юзера. Но ты вижу уже и сам разобрался, всё равно кину скрины, раз уже сделал.

Куда я денусь - тут все мои друзья.

>тут все мои друзья

Я так и не понял, что означает эта фраза:

"Все мои друзья обитают на имиджборде" или

"Все, обитающие на имиджборде, мои друзья"

Рад видеть тебя в добром здравии. Как продвигается проект по воссозданию Сенку in real life?

ПРоигрулькал с диалогов. Предчусвтвую:

Анон: лан, я в толчок, скоро приду.

Она: окей сказала я дрожащим голосом, ведь она видит там не просто толчок, а скорей всего другой мир, в который он погружается и зловещие звуки доносятся оттуда, меня окутывает дрожь ток поскорей ещё эти черкаши не иначе знаки, котрые я стараюсь не замечать

Друзья по интересам-то точно все здесь. Так и не смог никого из знакомых подсадить на нейронки.

Так и есть, лол.

О интересно, пожалуй появилась причина использовать таки эту функцию с вставкой для модификации ответов сетки

Ладно, шизопрефилы оно тоже вполне себе отрабатывает.

>Но технически их можно использовать и для более тонкой настройки пресета, вынеся туда всякую мету, типа описания жанра РП. И потом включать/отключать нужные части просто по чекбоксу, вместо того, чтобы систем-промпт каждый раз редактировать.

А я уже сколько раз говорил, что таверна это каловый сталагмит. Сколько уже времени прошло, а в системный промт для локалок до сих пор не встроили модульность, хотя для других апи она имеется. Кучу бы времени и сил это сэкономило, если бы по щелчку можно было бы отключать определенные куски от промта, например связанные с NSFW, чтобы модель на них не зацикливалась, как это делают некоторые. Кроме этого можно было бы на ходу свапать жанры, фетиши, или стили, делая ролплей более удобным. Но нет нахуй, вот тебе анончик лорбук, пользуйся лорбуком, он ведь именно для этого и задумывался.

>Как мне заставить ее писать больше 20-40 токенов!

Покажи карту персонажа, которую ты используешь. Там небось какая то рыготня, которую оформляли жопой.

А вообще, примеры диалогов сильно помогают в таких случаях. Сильнее, чем ты просто в промте укажешь, что тебе нужно столько то параграфов и с таким то стилем оформления. Первое сообщение тоже должно быть достаточно длинным, потому что сеть будет опираться на него для генерации дальнейших ответов.

Это понятно. Насчет персонажа, согласен, много от него зависит. Однако, другая модель писала больше и получше. Я сейчас пофиксил большинство проблем. Однако не могу до сих пор понять, какие настройки лучше для мистраль-немо.

Скиньте какие вы используете если конечно у вас немо...

Токенайзер какой в Силли ставить, для немо. Мистраль или Бестматч. Хуй знает, не решился еще какой из.

Да и вообще какая-то хуйня. Попробовал написать на русском, персонаж отвечает на английском. Может я кривой какой-то, почему так получается? Модель у меня от бартовского.

Попробовал Магнум-123B-v2. Действительно отличная модель, лучше Lumimaid-70B-v2. Но у магнума есть проблема - не работает по-человечески контекст шифт. Постоянно пересчитывает. С Люмимайд такой хуйни не было. Подозреваю кривой промпт для Мистраля от Таверны (на странице Магнума были типа правильные пресет и контекст, поставил их, но не помогло) или глюк с Мистраль Ларж у лламаспп (и Кобольда соответственно) с контекст шифтом. У кого такое встречалось? Как решили?

>возможности тонко настраивать пресет

А это где так можно? Откуда скрин?

Ахуеть, для каких извергов сделан RoPE в коболде.

Если кому-то нужно. И кто не знал, как я. Работает это так - Scale, трогаешь в обратном направлении. 1.0 = 1x. 0.5 = 2x. 0.25 = 4x. Это линейный RoPE.

Чоба потрогать NTK Aware Scaling, меняешь базу. Как в гитхабе написано при scale 1.0 и 32000 base, это примерно 2х. 1.0 и 82000, примерно 4х.

Надеюсь, кому-то будет полезно.

Если кому-то нужно. И кто не знал, как я. Работает это так - Scale, трогаешь в обратном направлении. 1.0 = 1x. 0.5 = 2x. 0.25 = 4x. Это линейный RoPE.

Чоба потрогать NTK Aware Scaling, меняешь базу. Как в гитхабе написано при scale 1.0 и 32000 base, это примерно 2х. 1.0 и 82000, примерно 4х.

Надеюсь, кому-то будет полезно.

Гемма 2 и её производные

Сколько токенов вы оставляете на ответ?

Да, эти. Я 200 поставил и все равно как-то медленно отвечает, думал еще снижать но уже как-то вроде маловато будет.

Если ты сидишь через коболд. Я ставлю максимум слоев на видяху. на 13б это 27 при 6к контексте. Подсказка, увеличить кол-во слоев можно, уменьшением количества BLAS, я его снижаю до 64, с дефолтных 512 И обязательно включаю FleshAttention. В ядрышках, можешь поставить кол-во ядер. Я ставлю побольше, хз зачем, может чуть быстрее, не проверял.

Disable MMAP, дает мне побольше скорости. Также в биосе Деколирование Свыше 4 гб или же Above 4G Decoding, так же чуть повысило ситуацию.

А видюха не сгорит? У меня 1660s. На стандартных настройках вроде как видеокарта почти не задействована и 1 гиг врам свободен. Ну и контекст до 8к повысил.

>и её производные

Это какие? Тайгер говно поломанное.

К сожалению нет альтернатив

Что ты имеешь ввиду? Я на нём сейчас сижу, на 27ом

Что-то с твоими настройками теперь вся память заполнена а стало только медленней.

Ну попробуй mini-magnum и прочие файнтьюны Немо 12б, мало ли.

Одноплатники пиздец дорогие. Раньше уступали андроид тв-стикам, сейчас уступают компам.

32 гига оперативы стоит тыщи 4, плюс зеон за 5, бп и ссд, кулер, тыщ в 15 уложишься. Но если хочется переплатить 6к ради размера и энергопотребления, дело ваше.

Нет.

А как лупы победили?

А что там у нас, подробностее?

Неделю назад, пздц старый уже.

Чет я нихуя не понимаю насчет слоев. Сколько ставить? В кобольде вроде написано что -1 это автоматик, он сам подбирает оптимальное количество? Или как в интернете я нагуглил что -1 это все в видеокарту а остальное простаивает? Но на -1 слоях остается свободно 1гб врама, это и не максимум и нихуя не оптимально я так понимаю. Ставлю 20 и больше и свободного врама 100 мб остается, я так понимаю этого на 8к контекста не хватит. На 17 слоях 300 мб врама свободно, на 16 слоях 530мб.

По скорости вообще хуй знает разница если и есть то какая-то очень заметная. Вроде как на 17 слоях быстрее всего, но это вообще не точно а так, примерно почувствовал по одной незаконченной генерации. Ничего не понимаю, памахите.

По скорости вообще хуй знает разница если и есть то какая-то очень заметная. Вроде как на 17 слоях быстрее всего, но это вообще не точно а так, примерно почувствовал по одной незаконченной генерации. Ничего не понимаю, памахите.

>не очень заметная

фикс.