Какая нынче модель самая лучшая? Пока остановился на Llama-3.1-70B-Instruct-abliterated.

> то чтобы ты понимал приоритеты.

Они довольно странные и их сложно понять, ведь строительство дома начинают с фундемента, стен, крыши, а не выкладывания узоров из паркета. Но жираф большой, ему видней, есть шанс что после пробежки по граблям придешь к дефолту, или имеющегося хватит для исследований.

> Я ссылку на архив орг принёс, тебе мало?

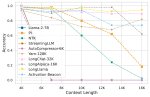

Речь о том что в оригинале случай для подобного распределения довольно специфичный и нужен для наглядной иллюстрации их подхода. В сценариях использования распределения могут быть другими. Перед тем как слепо верить графикам и кускам нужно их понять и ознакомиться хотябы с тем что сам приводишь в цитату.

> А задача "написать пост" обычно ставится в начало.

Современные промтоконструкции довольно комплексные и популярным подходом является деление их на части.

> Напрямую связано. А вот промпт инжиниринг к шифтам уже никак не относится.

Ерунду пишешь или не понял вообще. Если у тебя вместо промта будет невнятный шмурдяк - то и на выходе будет параша, особенно дополнительно поломанная костылями. Именно соблюдение структуры и формата должно диктовать применение методов склейки, сдвигов, просто формирования промта для обработки с нуля и т.д.

Файнтюны мистраля 123, рефлекшн может быть хорош.

Magnum-v2-123b

По срачу с приоритетом внимания на токены. Напоминаю, что самым первым токеном всегда идёт BOS токен, так что шатали нейронки ваши инструкции.

>Файнтюны мистраля 123, рефлекшн может быть хорош.

Поддвачну, годная штука, лучшая нейронка в попенсорсе на данный момент.

>Файнтюны мистраля 123, рефлекшн может быть хорош.

Поддвачну, годная штука, лучшая нейронка в попенсорсе на данный момент.

Смотря для чего, для кодинга из открытых меня устраивает только Mistral Large 2, но все равно хуже чем GPT-4o или Claude Opus/Sonnet 3.5. Для RP использую Command-R+ меньше лупов чем у Llama 70B и лучше следует инструкциям + менее цензурирован. Моя основная рабочая модель (ассистент) это Гемма 29B, хотя Nemo тоже неплох.

> хуже чем GPT-4o

> для кодинга

Чмоню в кодинге даже какой-нибудь дипсик 7б обоссыт, покайся.

А так по моделям базу выдал, разве что для рп и части нлп задач мелкий коммандер вполне себе хорош.

> Чмоню в кодинге даже какой-нибудь дипсик 7б обоссыт

в моих юзкейсах нет: scala + spark

но Claude да, чувствительно лучше

> GPT-4o или Claude Opus

Толсто, они в код вообще не могут. А по знаниям API их Yi Coder раскатает в сухую.

> лупов у Llama 70B

Ясно.

> Command-R+

> лучше следует инструкциям

Это вообще пиздец шиза.

> Толсто, они в код вообще не могут

У тебя какой тех. стек? Очень странный тейк

> Ясно

Попробуй порп'шить с лламой сам увидишь

> Это вообще пиздец шиза

Command-R+ в каком-то смысле на любителя, но мне сильно зашел для RP

у этого треда с сhatbot тредом сильное пересечение?

вы для чего локалки используете? кроме кума с ботами

вы для чего локалки используете? кроме кума с ботами

>у этого треда с сhatbot тредом сильное пересечение?

0 пересечение. Там анальные рабы корпораций и жопофлаги проксихолдеров, а тут локалкобояре.

>кроме кума с ботами

Кроме кума ни для чего. Хотя по сути локалки могут всё.

> Очень странный тейк

Можешь не отмазываться. Когда ты назвал Опус сразу стало понятно что ты ничего из этого никогда не трогал.

Кодить, рубрика эксперименты, задавать тупые вопросы, немного в скриптах и программах, тупо чат бот но локальный и без цензуры

Но в основном тут кумеры, конечно

Пересечение хз, тут промпты проще, нет джейлбрейков и другой хуиты

Общий навык промпт инженеринга и работы с сетками, разве что

> в моих юзкейсах

Вот же больной ублюдок. Но тут действительно не поспоришь, у 7б да и прочих банально может не быть знаний про это.

> Claude Opus

> они в код вообще не могут

Вот это толсто

Там пердолятся с проксями, отдельные господа обмазываются промт инженирингом и всякими конструкциями на фоне запредельного шизослоупа и срачей. Здесь пердолятся с запуском локальных моделей, обсуждения идут с небольшим упором на код и математику, есть дискуссии про железо, промт инжениринга меньше но местами бывает более продвинутый. Шизы также очень много, просто если в кончай треде много разных вниманиеблядей, то здесь особенные шизофреники решают проблемы вселенной не привлекая внимание санитаров, а другие братишки ведут аутотренинг в оправдения своих решений ранее и текущей действительности.

В целом, если хочешь получить ответ на общий вопрос - задавай и там и там, аудитория мало пересекается и ответить могут в обоих тредах но здесь лучше

> для чего локалки используете?

Массовый нлп, кодинг, просто рп без кума.

> Когда ты назвал Опус

Наверное каждый сходит с ума по своему. Я с Yi не работал, но DeepSeek coder пробовал и он хуже чем GPT или Claude. Тоже самое могу сказать про Llama 70B и Mistral Large 2. Приведи хоть один пример, где другая модель рвет GPT или Claude, даже любопытно.

> Массовый нлп

а это что такое?

>строительство дома начинают с фундемента, стен, крыши

А потом приходит заказчик и пиздит строителей ногами. Потому что по ТЗ это дом на колёсах.

>популярным подходом является деление их на части

Это понятно. Но также популярным является то, что инструкция идёт в начале. Если она идёт в конце, то кеш нужно пересчитывать с каждым отправленным сообщением. Можно, конечно, шизика включить, сохранить кеш для промпта отдельно, а то и для каждого сообщения независимо, и собирать из кусков на лету, но это совсем пиздец. Вряд ли так делает хоть кто-то. А ждать пересчёта каждый раз - хуйня полная.

>Если у тебя вместо промта будет невнятный шмурдяк

Ломание промпта\формата шифтом - шиза натуральная, этого не происходит.

На правах рофла. НейроЛингвистическое Программирование. Ты заходишь в тред - тебя называют шизом и говорят, что все твои проблемы это скилл ишью. Так происходит раз за разом. В какой-то прекрасный день ты начинаешь верить, что ты шиз и все проблемы от отсутствия скилла.

А вообще Natural Language Processing. Обработка естественного языка. В любых формах.

> А вообще Natural Language Processing

как раз, что такое NLP я знаю, но почему "массовый"?

> Ты заходишь в тред - тебя называют шизом

Без рофла, реально первое, что мне написали тут

Здарова садипары

как рефлекшн для кума?

После фикса - серит тегами в рп. До фикса было норм.

Natural language processing, переработка текстов, предложений, описаний согласно заданным инструкциям.

> Потому что по ТЗ это дом на колёсах.

Если тз появляется когда дом уже готов - заказчик идет нахуй, лол.

> Если она идёт в конце, то кеш нужно пересчитывать с каждым отправленным сообщением

Почему? К десятку-сотне новых токенов добавится еще один пост, а основной кэш не затронут, пренебрежимо.

> ждать пересчёта каждый раз - хуйня полная

Так вокруг этого все и вьется же изначально, офк релевантно не везде. Полный пересчет неизбежен только если идут мультизапросы и изменением как раз инструкции в самом начале, а не только дополнительного куска в конце.

> шифтом

Причем тут шифт если ты сшиваешь франкенштейнов по краям бедер, вместо того чтобы сделать незаметную обрезку по границам постов обеспечив структуру? В текстовом виде или в токенах - совершенно не важно. Как раз даже при абслютно идеально работающем шифте неудачный стык все может поломать.

> почему "массовый"

Потому что измеряется сотнями тысяч.

> реально первое, что мне написали тут

Лол, наверно выдал что-то что обычно пишут всех доставшие поехи.

жду квантованную до 1bit чтобы кумить на своей 1050ti

> Потому что измеряется сотнями тысяч

Понял

> что обычно пишут всех доставшие поехи

Написал, что мне нравится Claude для кодинга. Я так понимаю в треде про локальные модельки это считай еретичество

Тогда уж жди нормальной BitNet модели, в теории должно работать, но как я понял тренить такое не очень выгодно.

> нравится Claude для кодинга

Она не может не нравиться, ведь действительно хороша. Но, вероятно, есть задачи с которыми плохо справляется.

> это считай еретичество

В целом похуй, особенно сейчас, когда локалки на оче высоком уровне. Если их попердолить также, как извращаются с коммерцией (а там больше ничего и не остается), особенно с учетом влияния цензуры, то и результат можно получить более чем приличный.

Кмк, чего реально не хватает - восприятия пикч как в опуще, тут или отличное зрения для форм, текстов и всякого но лоботомия по нсфв, или понимание этого но общая тупость и слепошарость.

> особенно сейчас, когда локалки на оче высоком уровне

Смотря какое у тебя железо. Если у тебя Mac Studio 192GB, то да, ты можешь на нем условный Mistral Large гонять, но когда у тебя в лучшем случае 24GB VRAM, то выбор сильно сужается. Хотя для базовых каких-то вещей терпимо.

Смотря какое у тебя железо. Если у тебя Mac Studio 192GB, то да, ты можешь на нем условный Mistral Large гонять, но когда у тебя в лучшем случае 24GB VRAM, то выбор сильно сужается. Хотя для базовых каких-то вещей терпимо.

> тренить такое не очень выгодно

почему?

>Если у тебя Mac Studio 192GB, то да, ты можешь на нем условный Mistral Large гонять

Кстати интересно, какая там будет скорость.

>После фикса

Что за фикс?

>условный Mistral Large гонять

Гоняю 123B на 12 гигах врама, ебало?

>Гоняю 123B на 12 гигах врама, ебало?

Тоже гонял 123б на 12 и 64 оперативы в 3 кванте. Было где-то пол-токена в секунду.

В теории, для маленького контекста терпимая, но вот с увеличением контекста будет совсем плохо, с другой стороны тут люди гоняют 100B+ модели на 12GB VRAM со скоростью 1 токен в десятилетие , поэтому наверное вопрос восприятия

>Было где-то пол-токена в секунду.

У меня от 0,7 до 1, благо DDR5 и почти самая быстрая на свете 3080Ti.

Ну у меня всего-лишь 3060 и рузен 5700х, с мамкой которая даже не может 64 гига вытянуть на штатных 3600, и приходится на 3333 гонять.

Для кодинга дипсик, если большой уж, че уж. =)

Мистрал 123b в Q3_k_s веселее L3.1 70b Q4_k_l?

> Смотря какое у тебя железо

Верно подметил, для норм пользования больших моделей нужно хотябы пара некротесел, и то это ряд компромиссов.

> но когда у тебя в лучшем случае 24GB VRAM

Сейчас есть гемма и коммандер, приличные модели для 24гб.

Попробуй и то и то. На самом деле мистраль не то чтобы перформит в (почти) 2 раза лучше, просто хорошая модель.

Кумеры, помогите. Гонял гемму 27 и нового командер 35, всё было нормально до момента пока я не попробовал карточку психа садистка, которого я начал пытать. Вместо ярости, попыток выбраться, или хотя бы какой-то реакции пошли простыни текста о том как его внутрении мир нарушен и как ему плохо, и из такого состояния он не выходит даже после условного освобождения. Попробовал ещё несколько карточек, даже доработал на большую активность, но как только дело доходит до смены роли на обратную, то всё, хнык хнык, плак плак, {{user}} плохой. Фаинтюны от драмера так не клинит, но они просто шизанутые. Есть ли что-то в условном размере 25-35 что не скулит как побитая сука, а борется за себя и свою точку зрения/жизнь, не впадая в катарсис?

>Гоняю 123B на 12 гигах врама

Какой квант? Тут даже первый не должен влезть.

мимо-боюсь-запускать-123В-на-24Гб-Врам

Ебаный реинтери забаненный с какой-то из сторон, заменить на что-нибудь другое!

Сейчас как-то более усиленно начали банить всё подряд. Давно уже пора собственный VPN заиметь.

А пока можешь поставить от эту хуйню: https://topersoft.com/programs/launchergdpi

И сделать вот это для хрома:

Введите в адресной строке браузера chrome://flags/ и нажмите Enter.

Найдите Kyber:

Измените у TLS 1.3 hybridized Kyber support значение с Default на Disabled.

Мне помогло от всей хуйни.

Что по карточкам не от хуанга, они хуже работают с нейрсоетями или как? У какого-нибудь Intel Arc A770 или радевона rx7600 16гб врама а цена почти на 20к меньше чем у 4060 с теми же 16гб. Если новые рассматривать а не отмайненные с авито, естественно.

проблема радеонов в том, что чаще всего нужно искать отдельный форк софта. А под интеловский апи вообще почти ничего мэйнстримного нет, вроде бы.

Про интел ХЗ, а вот про радеоны могу сказать что тебе понадобится линукс. ROCm, альтернатива CUDA от красных, работает только на нём.

Есть ещё Vulkan, встроенный в кобольд, но по скорости он сосёт.

Если карта новая то особых проблем возникнуть не должно, угабога сама всё накатывает, но всё равно остаётся вероятность что что-то отвалится и не будет работать.

> ROCm, альтернатива CUDA от красных, работает только на нём.

Херню сказал. Что рокм кобольд есть под шиндовс, что СД через злуду.

Эх, а я надеялся...

>Что по карточкам не от хуанга

mi50 instinct

>реально первое, что мне написали тут

В каждой шутке - доля шутки.

>сли тз появляется когда дом уже готов

Это был намёк на то, что твои представления о "самом необходимом" субъективны.

>К десятку-сотне новых токенов добавится еще один пост

Не совсем, потому что инструкцию нужно будет каждый раз удалять из кеша, делать смещение постов и засылать инструкцию заново. Технически это как раз одноразовые посты. Это обрабатывается медленнее.

>сделать незаметную обрезку по границам постов обеспечив структуру

Подозреваю, что это намного хуже. При частичном удалении практически всегда остаётся кусочек предыдущего поста + ответ на него. Что даёт минимальный контекст. Если удалять по постам, то будет ответ на полностью удалённый пост, который оказывается нерелевантным и будет сбивать нейронку с толку.

Если просто ллм запускать через кобольд-рокм/лм, у радеонов нормальная скорость. Там проблема если нужно что-то большее, например тренировка через популярный софт, а не ручное написание скриптов под собственноручно подобранные пакеты.

>mi50 instinct

Карта из под майнеров с авито без видеовыхода? А в игрульки как играть, если она вдруг не сгорит сразу же?

"Нормальная" это сопоставимая с хуанговскими, или "нормальная" это "ну так, ну в принципе подождать немного не так уж и страшно, подумаешь 3 токена в секунду, все не так плохо..."?

Что условно лучше себя будет показывать в кобольде, rtx 3060 с 12гб или radeon RX 7600 XT с 16гб? Цена практически одинаковая.

>Какой квант?

3 же, меньше жизни нет.

>Тут даже первый не должен влезть.

А я и не пытаюсь запихнуть всё во врам.

Замени интернет провайдера и страну проживания, у тебя тухляк попался.

>А в игрульки как играть

Думаю так же, как и на других картах без видеовыходов, с выводом изображения через встройку, благо шинда к десятке научилась это делать без ебли.

>Карта из под майнеров с авито без видеовыхода

Лол, туда ли ты зашёл петушок, если тебя пугает подобное?

>А в игрульки как играть

Для Р40 есть гайды, тут нет, но в теории также: Выбираешь в настройках приложения нужный видеоадаптер и вперёд.

>Думаю так же, как и на других картах без видеовыходов, с выводом изображения через встройку

Но ведь у меня рязань от амуде...

>3 же, меньше жизни нет.

Тогда ты не на 12Гб врама крутишь, а на оперативке с процем, что немного другое и от количества врама не сильно зависит.

это как если бы ты с двумя 4090 хвастался что тебе 8Гб ОЗУ на любые нейронки хватает

>Но ведь у меня рязань от амуде...

У меня тоже и чё?

Обнови амудю, в последних таки есть дефолтная встройка.

>Тогда ты не на 12Гб врама крутишь, а на оперативке с процем

И там тоже. Но врам таки ускоряет, и чем его больше, тем лучше.

Какой скор у новой лламы на арене?

Я ебу чтоли? У меня рх6600, я только про него могу сказать.

АМ5? У АМ4 не было встройки, если не Г.

На 8 гигов? Ну так сколько у тебя токенов на какой модели? Я сравню со своей 1660с. У меня с 8к контекста на L3-8B-Stheno-v3.2-Q8_0-imat 3-4 токена в секунду, на L3-8B-Stheno-v3.2-Q6_K-imat 8-9.

Я в мухосрани и проверить что там жадный перекуп пытается мне впарить возможности нет, а по почте не то что отмайненная, вообще мертвая может сразу прийти и не проверишь.

>АМ5?

Лол. AM4 5600X + RX580 на райзере болтается.

В единственный слот для видимокарты вхерачена Tesla P40, также без видеовыхода. Полёт нормальный!

>Я в мухосрани и проверить что там жадный перекуп пытается мне впарить возможности нет

Те же проблемы у тебя могут быть с любым заказанным по почте БУ железом, но если не хочешь переплачивать надо идти на риск.

У серверных железяк тут одно преимущество - не так то просто их убить.

Какие параметры? Hermes-3-Llama-3.1-8B.Q5_K_M, 8192, без ммк, с флэшаттеншн 8.75. Больше чем ку5 у меня нет моделей.

С ммк и аттеншеном, 28 слоев на видео, пусть походу они все и не влезают но если уменьшать то становится медленней. Ну как-то так себе у тебя, учитывая что у меня на 6 гигах Q6 даже 10 токенов порой выдает.

>Те же проблемы у тебя могут быть с любым заказанным по почте БУ железом

Поэтому железо дороже 5к не заказывал никогда.

>но если не хочешь переплачивать надо идти на риск.

Ну хуй знает, наебут всего один раз и даже если второй раз не наебут ты уже заплатишь полную цену нового за хуй знает что бушное, такое себе казино.

У тебя там волосы из радеона растут.

>со своей 1660с

>L3-8B-Stheno-v3.2-Q8_0-imat 3-4 токена в секунду

А хули тут так мало? Думаю взять что-то дешевое, но чтобы по чипу было быстрым, смотрел на 16хх. Вроде, за такой бюджет особо не разгуляешься, но мало ли.

>а по почте не то что отмайненная, вообще мертвая может сразу прийти

Купил на авито p104-100, пришла мёртвая, продавец говорит, что отправлял не он, взяли не ту карту и т.д. Мысленно забил на эти 2.5к и отправил ему карту обратно. А он взял и отправил мне деньги.

Сейчас попробовал прогнать Q6 без ммк - 2 токена в секунду, пиздос. Контекст в 5 раз дольше корячит.

>А хули тут так мало?

А вот так вот. В принципе жить можно, но так себе. Q6 уже нормально работает на почти 10 токенах в секунду, но он заметно тупее.

И это я говорю про максимальные показатели, он порой на Q8 и до 2 токенов падает.

Какая нахер разница 6 или 8, если у 6600 128бит шина с 1.5 раза меньшей пропускной способностью памяти, чем у 1660с, в которую все упирается? У меня утилизация процентов 20 на гпу во время бенча.

Сейчас даже хуже почему-то работает, вот прогнал 2 раза Q6, результаты не оче.

Перемерил под шиндовс(хермес под линупсом был) с L3-8B-Lunaris-v1-Q5_K_M.gguf, 8192, ммк, флэшаттеншн, ~10т/с.

>У тебя там волосы из радеона растут.

Это шерсть кота.

Тебе с такими суевериями прямая дорога в DNS где тебе также завернут прогретое в духовке б/*у говно из под майнеров под видом новых, но зато "гарантию" выпишут

Тестирую модели через OpenRouter и только Claude, GPT и Gemini могут в хороший русский. Все тут хвалят Command-R+ и Gemma 27B, но они пишут достаточно плохо, как-буто через гугл транслейт пропустили, даже хуже, наверное.

Что я делаю не так?

(Написал ранее в соседний тред, но меня там опустили за использование "лоКАЛок")

Что я делаю не так?

(Написал ранее в соседний тред, но меня там опустили за использование "лоКАЛок")

>только Claude, GPT и Gemini могут в хороший русский

Мистраль Немо даже 12В тоже может.

Там же качество совсем плохое.

Немо иногда даже путает спряжения.

Может я неправильный форматтинг использую, я выбираю в Таверне шаблон для конкретной модели (или вендора модели)

Проблема с этими домашними серверами для ЛЛМ только одна - всегда хотя бы немножко не хватает. Хорошо наверное нынче только владельцам ригов от 4x4090 и выше. Ну или кто плюнул на всё и арендует по потребностям.

> Не совсем, потому что инструкцию нужно будет каждый раз удалять из кеша

Ну смотри, вот у тебя группа системного промта с описаниями, десятки-сотни потов, потом инструкция/префилл и ответ сетки. Юзер отправляет новый пост, получается все то же что и было, но без инстракции/префилла, а к ним добавляется ласт пост сетки, пост юзера и новая инструкция. Обсчитывать нужно только их что пренебрежимо мало, а не все разом. Офк на нищебродском треше типа кэмлера/максвелла где эвал измеряется десятками токенов это может добавить несколько секунд, но в реалистичном кейсе даже заметить не получится.

> каждый раз удалять из кеша

Не удалять а делать проверку совпадения с самого начала, останавливаясь на месте с которого идут различия. Собственно так во всех лаунчерах кэш и реализован, емним там просто прямая сверка токенов и обсчет с момента различий. Хз почему это должно обрабатываться медленно.

Если пытаться сохранить кэш последующих активаций - полезут новые стыки и потенциально новые проблемы, придется усложнять поиск и т.д., едва ли оно того стоит.

> практически всегда остаётся кусочек предыдущего поста

Оборванная посреди слова невнятная фраза даже без указания откуда она появилась и кем сказана, а то и вообще является частью системного промта. Это никак не "повысил релевантность" а наоборот будет мешать и отвлекать.

Уже проходили на заре локалок и корпоративных, писали примитивные прокси что будут этим заниматься и правильно промт оформлять пилили и получали радикальный буст по сравнению с "хуяк хуяк и в продакшн как получится".

Офк чтобы было совсем хорошо, постам должен предшествовать суммарайз и тогда все отлично складывается. Его обновлять одновременно со смещением истории для формирования буфера под новые посты - и все в ажуре.

Вот готовое решение которое реализуется за пару вечеров дополнениями к таверне без низкоуровневого пердолинга, и совместимо с чем угодно, делай - не хочу. Офк тебя не агириую, вижу что другая цель управлять поездом и она понятна, пердолиться с внутрянкой и что-то новое реализовывать - интересно. Но потом не пеняй что не предупреждали про пробежку по граблям.

Ты просто в псп упираешься. Не гонял модели, которые полностью в память влезают? Я думаю взять её под 2b модель.

>Это шерсть кота.

Вынь кота из радеона.

>прямая дорога в DNS

А у них есть в наличии? Я думал, там давно по всем позициям "нет в наличии", потому что отнесли продавать на авито "с гарантией из днс".

Ну хуй знает, у меня либо "хватает впритирку", либо "не хватает где-то 1000% мощностей".

>прямая сверка токенов и обсчет с момента различий

Так это кал. Если гоняешь жсон между бэком и фронтом, особо по-другому и не сделаешь. Это не значит, что это хорошее решение, это говнище.

>дополнениями к таверне

Так таверна это тупой фронт, если уберу у себя рисование постов и выведу API наружу - вот тебе и таверна. Все фичи всё равно остаются в бэке, разве что разбираться со случаями, когда таверна ломает историю. То есть мне придётся делать всё то же самое, потому что на стороне фронта нереализуемо либо будет работать суперхуёво. И ещё допиливать совместимость.

А что такое «кум»?

от английского "godfather"

Как на этой картинке?

>Ну хуй знает, у меня либо "хватает впритирку", либо "не хватает где-то 1000% мощностей".

Я о том, что если даже заморочиться и собрать сервер с несколькими картами, то всё одно хоть немножко да будет не хватать. Порой даже не немножко. И тут поневоле думаешь: а может аренда и правда выход? А мелочь можно и на домашнем компе гонять.

>Ты просто в псп упираешься. Не гонял модели, которые полностью в память влезают? Я думаю взять её под 2b модель.

Скачал первую попавшуюся 2bшку, Gemmasutra-Mini-2B-v1-Q8_0, результаты на пике. С настройками ничего пока не менял, может будет и получше если подшаманить, но чет как-то нестабильно все. Первый раз 20 токенов выдало а потом заглохла. Красными линиями разные чаты разделены, так что закономерность вроде как не в том что чем дальше тем медленней.

Но должен сказать кстати что моделька выглядит на первый взгляд неплохо, я конечно пока совсем мало смотрел но пока сомтрится чуть ли не умнее чем L3-8B-Stheno-v3.2-Q6_K-imat.

Поставил в карточке своего персонажа, что у меня краник средний: 13 см. Все модели говорят что это малюсенький....

Странно, я даже когда специально пишу "маленький" почему-то оказывается что у меня огромный хуище. И в нейросетях тоже.

Хотя не, беру свои слова назад, тупорылый он конечно это да... Зато больше 10 токенов в секунду. Но тупой. Или 3 токена в секунду, но умный. Если бы он умный был больше 10 токенов тогда да, а он тупой, ну очень тупой. Но больше 10. А тот умный, но всего 3. Ну очень мало 3... Вот если бы у меня была 4090...

страная хуйня

товерна перестала отправлять в угабугу ответы типо включите режим стриминга

адрес где 5000-апи нне менял

если поставить галку на устаревший стриминг - вобще нечо не отправляет и даж не грузится

никак сообщения не отправляются -

причем внезапно

чо за хуета ???

товерна перестала отправлять в угабугу ответы типо включите режим стриминга

адрес где 5000-апи нне менял

если поставить галку на устаревший стриминг - вобще нечо не отправляет и даж не грузится

никак сообщения не отправляются -

причем внезапно

чо за хуета ???

Бля, последний релиз лламы падает без ошибок, собака

b3681

b3681

Не пизди давай тут. Я когда пытался отыгрывать фембойчика с микрописей мне модель все равно отвечала пастой "омагад итсоу биг энд thick" и в том же духе.

>омагад итсоу биг энд thick

А ты не ролеплей с minor girl, для которых и микропися гигантская.

Я ролплеил с тетушкой у которой пиздища итак была раздрочена по задумке, так что нет. Просто модели не любят харрасмент в любых проявлениях.

просто это заезженный штамп в порнухе, и его одной белкой деталью в промпте не пробьешь

>Просто модели не любят харрасмент в любых проявлениях.

Тут нужно упоминать модель и квант. Умная модель, если и не обратит внимание на размер сразу, то даже намёки хорошо понимает. А уж инструкцию так отлично.

>Просто модели не любят харрасмент

То есть мелкочлен это харасмент, а хьюге хуй это нормально?

Этот прав от части.

>Тут нужно упоминать модель и квант.

Это тут не при чем. Много разных моделей юзал, много разных промтов. Нужно инструкцию более детальную ебашить чтобы пробить этот шаблонный дерти талк, который в целом на все постельные поебушки влияет, а не только на размер члена.

>То есть мелкочлен это харасмент, а хьюге хуй это нормально?

Мне кажется людям с хьюге хуем в целом похуй на то, как их приблуду будут кичить. Это у мелкописюх истерика каждый раз начинается, когда роскошный тринадцатисантиметровой сантиметровый ствол кличут мелким. Мимо обладатель скромного но боевого тринадцатого калибра.

> Так это кал.

> Это не значит, что это хорошее решение, это говнище.

Давай четко аргументировано объясни. Без предубеждений, без обид потому что ты там пердолиться с другим подходом, а нормально.

Это эффективно, это обеспечивает отличную совместимость, это достаточно быстро в задачах когда железо соответствует требованиям и не создает никаких проблем.

> Так таверна это тупой фронт

Как бы сказать то, ничего и близко равного нет с точки зрения функционала и юзабилити. А возможности с внутренним скриптовым языком, что показывал анон в прошлом треде, и тем более экстеншнами выводят ее на следующий уровень.

> если уберу у себя рисование постов и выведу API наружу - вот тебе и таверна

Чел, это то же самое что сказать

> я лепил из песка и говна куличи, а значит архитектор и моя куча ничем не хуже сиднейской оперы

то что ты не понимаешь или не хочешь признавать разницу не значит что ее нет.

> потому что на стороне фронта нереализуемо либо будет работать суперхуёво

Давай и тут, четко, ясно и подробно распиши почему это будет хуже чем твои потуги. Именно нормально и аргументировано а не "ну яскозал". Вот чисто на спор эту штуку сделал бы, но у тебя едва ли найдутся средства или что-то чтобы заинтересовать и просто не сольешься, а без интереса есть чем заниматься.

А потом распишу почему твои шифты будут иметь сомнительную работоспособность и результаты окажутся тупее чем нормальная работа. Вообще, изначально был заинтересован в хоть каком-то успехе, ибо это потенциальное благо для всех, но надежд все меньше.

В таверне тип апи на новый смени.

Я на магнуме 34 сижу....

Нужен ассистенс полному ньюфагу.

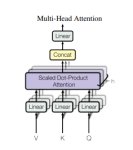

Я установил себе таверну, хочу погонять Mistral Nemo Instruct (или надо было выбрать базовую) используя KoboldCpp как бэкенд. Какой API выбрать: Text Completion или Chat Completion?

Я установил себе таверну, хочу погонять Mistral Nemo Instruct (или надо было выбрать базовую) используя KoboldCpp как бэкенд. Какой API выбрать: Text Completion или Chat Completion?

Прошу ответить по делу и без троллинга. Пожалуйста.

LLM можно поднять на рх 580 8 Гб без вдовой ебли?

Я думал, что котируются только карты хуанга, однако мой знакомый запустил всё это чудо на амд, причём она работала с впечатляющей скоростью. Единственный нюанс в том, что у него какая-то дорогая жирнющая карта на 16 Гб и он сказал, что это работает всё только под линуксом. Он также сообщил, что нет нигде четкой инфы, заводится все это дело на моей некрокарте или нет. Кроме пары постов, где какие-то хардкорные линуксоиды что-то напердолили, не дали инструкций для некрокала и были таковы.

Я хочу понять, стоит ли овчинка выделки. Накатывать Линукс, который мне совсем незнаком, читать охуительные мануалы на стопицот страниц для всего этого, ещё и на английском языке — задача для меня та ещё.

LLM можно поднять на рх 580 8 Гб без вдовой ебли?

Я думал, что котируются только карты хуанга, однако мой знакомый запустил всё это чудо на амд, причём она работала с впечатляющей скоростью. Единственный нюанс в том, что у него какая-то дорогая жирнющая карта на 16 Гб и он сказал, что это работает всё только под линуксом. Он также сообщил, что нет нигде четкой инфы, заводится все это дело на моей некрокарте или нет. Кроме пары постов, где какие-то хардкорные линуксоиды что-то напердолили, не дали инструкций для некрокала и были таковы.

Я хочу понять, стоит ли овчинка выделки. Накатывать Линукс, который мне совсем незнаком, читать охуительные мануалы на стопицот страниц для всего этого, ещё и на английском языке — задача для меня та ещё.

> без вдовой ебли?

Нет. С другом всё же придётся поебаться, чтобы он рассказал как на твоём кале что-то запустить.

>Какой API выбрать: Text Completion или Chat Completion?

Text

>LLM можно поднять на рх 580 8 Гб без вдовой ебли?

Попробуй форк Kobold.cpp с поддержкой ROCm

https://github.com/YellowRoseCx/koboldcpp-rocm

Затем в advanced formatting нужно включить instruct mode и выбрать preset mistral?

>выбрать preset mistral?

И пресет мистраль и систем промпт мистраль и токенайзер мистраль. Всё там.

Хуй знает, посчитай, как быстро ты потратишь на аренду бюджет покупки картонки. Зашёл по первой ссылке в гугле, две 3090 это 33 рубля в час, пусть по 4 часа в день будешь арендовать, это 48к в год без учёта колебания курса, потерь на переводах и прочего. Ну и, возможно, это далеко не самое выгодное предложение, чисто беглый взгляд. Cчитать надо, да и вопрос личных предпочтений.

Как-то на самом деле печально очень. Я бы на твоём месте задумался об инвестиции в некруху. В прошлом треде хорошую ссылку постили

https://www.reddit.com/r/LocalLLaMA/comments/1f6hjwf/battle_of_the_cheap_gpus_lllama_31_8b_gguf_vs/

А мелкие модели практически всегда могут быть неплохи только при "знакомом" сценарии. То есть если модель хорошо обучена рпшить в фентези сеттинге - она будет себя плюс-минус неплохо показывать в этом случае. Понятное дело, что логика и т.д всё равно оставляют желать лучшего, но я когда-то находил 7b модели, которые в некоторых сценариях показывали себя лучше, чем 20b. Хотя и безбожно лажали во всех остальных. Теперь на постоянной основе гоняю 34b и он тоже туповат.

>его одной мелкой деталью

>краник средний: 13 см

>мелкой деталью

Лол

>ты там пердолиться с другим подходом

Так я в этом плане могу поддерживать любое поведение, что пересчёт с момента расхождения, что полный пересчёт, что сдвиг контекста. Сдвиг в итоге показал себя лучше всего.

>это обеспечивает отличную совместимость

Вот именно, что это сделано из соображений совместимости. Это ограничение, а не какое-то преимущество. Преимущество это когда ты можешь буквально между генерацией токенов сдвинуть контекст и продолжить генерацию. Бесшовно, без задержек, сохраняя максимальный контекст и производительность.

>Как бы сказать то

Речь не идёт о функционале и возможностях. Таверна это фронт и может делать дела фронта. Это не что-то плохое, это просто фундаментальное отличие.

>Чел, это то же самое что сказать

Ты нихуя не понял. Я открываю API, запускаю таверну и подключаюсь. Всё. Код апи в формате openAI в проекте чуть ли не с первого дня. Только мне интерфейс таверны настолько не нравится, что ебал я его в рот.

>чисто на спор эту штуку сделал бы

Лол, блядь. Ну запили семплинг в таверне. Или без пересчёта кеша регенерацию поста в начале истории. У меня вот ещё идейка появилась с параллельными чатами. К этому дольше интерфейс делать, а функционал в пару строк кода. В таверне это нереализуемо, потому что она фронт. Опять же, я сейчас спокойно сохраняю массивы многомерных векторов в памяти и верчу ими, как заблагорассудится, потому что могу. Нода в этом моменте просто выйдет из чата.

>Cчитать надо, да и вопрос личных предпочтений.

Считай, не считай - дорого при любом раскладе. Раньше хоть на теслы надежда была, сейчас и вовсе никакого просвета. Разве что пару 3090 купить, но это паллиатив не лучше тесл, потому что 123В не входит. Значит три карты, а это два с половиной года аренды - если одна из них за это время не сдохнет. А если сдохнет, тогда ещё больше :) Что там будет через три года - никто не знает.

Почему Магнум 72 через опенраутер отлично работает, а через koboldcpp просто ужасно. Может проблема в GGUF? Попробовать exlm2 через vLLM?

Короче, проблема была в кванте. По ходу, только 8 и 16 работают хорошо. Не понимаю как люди работают с 4 квантами, еще и в более маленьких моделях.

>через три года

Может быть, halo strix окажется чем-то хорошим. Если будет широкая шина, если будет дешёвым, если, если, если. А так вот самый "паллиатив" из паллиативов

https://russian.alibaba.com/product-detail/Jieshuo-RTX-2080-Ti-22GB-Advanced-1600430402549.html

Берёшь 4, получаешь 88 гигабайт vram по цене одной 4090. Рефаб, так что скорее всего живее, чем 3090 с рук, охлад говно, зато живой. Дороже p40, зато с экслламой, памяти меньше, чем у 3090, зато дешевле. Заходить под прокси, покупать через перепуков.

>Берёшь 4, получаешь 88 гигабайт vram по цене одной 4090.

400 баксов за штучку и оно даже не Ампер. Нет, неплохое решение в теории, но хотелось бы отзывов от уже купивших.

после всех доставок и комиссий будет все 500 стоить наверно

> Сдвиг в итоге показал себя лучше всего.

Он так и не появился в массах не смотря на длительные обсуждения, а "у тебя" базовые проблемы, отсутствие понимания основ и примитивные посты, так что не убедительно.

Кэш контекста есть продукт на основе прошлых вычислений. Нельзя сначала обсчитать конец а потом начало, также как и нельзя подмахнуть одно в стык другому без последствий. Наиболее экстремальной иллюстрацией будет задание ультрасоевого промта и кэширование какого-то пошлого запроса к сетке, а потом склеивание его с блядским жб в начале. При смещении там эффект не столь радикальный, но зато регулярный и накопительный будет.

Если бы все было так просто - уже бы давно имели целую базу предложений и фраз под готовый кэш, и работа с ним была бы по совсем иным принципам.

> Преимущество это когда ты можешь буквально между генерацией токенов сдвинуть контекст и продолжить генерацию. Бесшовно, без задержек, сохраняя максимальный контекст и производительность.

В теории да, но отрываясь от реальности можно вообще приказать сетке "накапливать кэш всего" чтобы потом сразу отвечать. Или издать закон о запрете глупых ответов и структурных лупов, ага.

> Я открываю API, запускаю таверну и подключаюсь. Всё.

Это не вяжется с тем что было описано раньше.

> Ну запили семплинг в таверне.

Само изейшество, запрашиваешь логитсы и делаешь простую математику. Но в этом нет смысла.

> Нода в этом моменте просто выйдет из чата.

Не удивлюсь если это вещает адепт клинкода, лол

По существу ни за одно, ни за другое аргументов так и не поступило, чтож, успехов, будем наблюдать.

Добро пожаловать в клуб!

Этих не слушай. ROCm на RX580 не работает, по крайней мере базовый, т.к. поддержку старых карт выпилили. Способ завести есть, но геморный.

Без гемора и ебли ты можешь скачать стандартную версию кобольда, выбрать Vulkan в пресетах и спокойно запускать любую модель в GGUF формате. Скорость будет уступать ROCm, но не на много.

Лучшее, что ты сейчас можешь завести на своей старушке это Mini-magnum-12b в 3-4 кванте. Но если есть быстрая оперативка, можно и на что посерьёзней позариться.

мимо-обладатель-RX580-c-шерстью-кота

>LLM можно поднять на рх 580 8 Гб без вдовой ебли?

Можно. Vulkan, как уже упоминали.

ROCm работает старый, только на linux и только до версии 5.7.*, в 6.0 выпилили.

Более того, и новые версии llamacpp/koboldcpp стали криво собираться под старый rocm в какой-то момент, и это совпало с тем, что я в целом на нейросетки подзабил в последнее время, поэтому не стал пердолиться и чинить. Есть гипотеза, что последняя по-настоящему рабочая версия rocm для 580 - даже 5.6, а не 5.7, но это требует проверки. Изредка вулканом пользовался, и то в последний раз ещё весной, кажется.

Всё хочу глянуть новую гемму 2 и мистраль 12b (на последний особо большие надежды, возможно, это будет как раз тот самый "мультиязычный солар", который я хотел себе ради переводов неплохого качества).

Алсо, вопрос, что-нибудь из нового с распознаванием картинок и чтением текста с них на llamacpp/koboldcpp добавляли за последнее время? Или там всё ещё потолок на уровне llava - распознавание цвета шерсти котиков (правильное в 2/3 случаев)?

Так, братушки, есть вопросец. Есть одна MSI B450 GAMING PLUS MAX на которой я сижу с воткнутым 1660с. Но pci слота на ней два, что если я куплю какую-нибудь p102-100 и воткну во второй слот? Что будет? Комп сгорит? Второй слот вроде как хуже, и вместо pci-ex16 3.0 там pci-ex4 2.0. Оно заработает, будет ли оно быстрее и можно ли раскидать модель на обе карты разом чтобы было еще быстрее и больше врама?

Как думаете, Шумер всех развёл или действительно какой-то обосрамс с весами в HF? С одной стороны в API оно показывает отличные результаты, с другой никто не знает что там в API, может там 405В. Он пока дико отмазывается, говорит скоро переделают, но слухи про скам уже идут. С другой стороны если бы они хотели всех наебать и хайпануть, не ясно как это должно было работать и в чём тут позитив в этой ситуации.

пысаны, смысол на 4060 16 гб есть копить? в игорях она хуета, знаю

в нейросеточках она как? врам много же, и генерация картинок должна нормальной быть по идее, да и в кобольде тоже наверно?

поделитесь размышлениями по этой карточке, пж

в нейросеточках она как? врам много же, и генерация картинок должна нормальной быть по идее, да и в кобольде тоже наверно?

поделитесь размышлениями по этой карточке, пж

>Рефаб, так что скорее всего живее, чем 3090 с рук

Лол, наоборот, лишний нагрев только помешает.

Втыкай, будет лучше. Но у тебя конечно такая некорота, что лучше заменить целиком на 3060 12ГБ или чего получше, нежели чем добавлять ещё большей некроты.

Мне она тоже не показалась умной в еРП, так что да, наёб.

>врам много же

Но медленной.

>поделитесь размышлениями по этой карточке, пж

>сажа

Ты пидар.

>Но медленной.

а есть какие-то статистика бенчмарков по всем карточкам? чтоб глянуть че насколько кто от кого по скорости отстает?

>Ты пидар.

нет ты, бака

В прошлый раз я приносил их в тред когда они стоили по 300, вроде.

>так и не появился в массах

В убе одной кнопкой уже давно. Обнови там говно, на котором сидишь.

>Кэш контекста есть продукт на основе прошлых вычислений.

Ага. Именно это одна из причин, почему шифт работает так хорошо и в некоторых случаях - лучше полного пересчёта.

>Это не вяжется с тем что было описано раньше.

Там буквально об этом. Да, я не планирую такое использование, но ничего нет, что мешало бы.

>Само изейшество, запрашиваешь логитсы

И получаешь скорость 0.1 Т/c. Будет работать суперхуёво, как я и говорил.

>аргументов так и не поступило

Кто же виноват, что ты твердишь одно и то же второй тред, не принимая абсолютно ничего во внимание, потому что оно расходится с твоими заблуждениями? Это только твоя проблема.

Это 16 гб за 50к? Нахуй не нужно.

>а есть какие-то статистика

Там в ТТХ всё видно.

>нет ты, бака

Нет ты. Ещё и мелкобуква. Ещё и точку не поставил. Пиздец короче как таких только земля носит.

>Это 16 гб за 50к?

а че тогда можно взять, чтоб не сильно дорого и чтоб не некроговно на архитектуре ампер/паскаль?

>Там в ТТХ всё видно.

ну а куда смотреть? на пропускную способность? если модель уже вся в памяти, то на нее похуй же? на частоту памяти? а частота чипа роляет?

>Пиздец короче как таких только земля носит.

ну что вы меня кибербоулите...

>сажа

Игнорим.

>Втыкай, будет лучше. Но у тебя конечно такая некорота, что лучше заменить целиком на 3060 12ГБ или чего получше, нежели чем добавлять ещё большей некроты.

Дораха, а я нищий. Я так понимаю сама по себе еще и в хуевом слоте она нахуй не нужна и будет не лучше моей 1660с, вопрос в том можно ли будет использовать их обе одновременно? Чтобы врама 16 гигов было, да и скорость все равно повыше чем у оперативы всяко должна быть.

>можно ли будет использовать их обе одновременно

Можно. Но лучше всё таки продай свою и докинь до нормальной видяхи, будет быстрее.

Понял-принял, я еще и не уверен что бп потянет 2 видюхи... ладно, будем думать значит дальше. Как там вообще, понижение цен размечтался с выходом 50 серии не ожидается?

>понижение цен

Забудь о нём, тем более если зарабатываешь в рублях.

>пысаны, смысол на 4060 16 гб есть копить? в игорях она хуета, знаю

Вот как раз нашёл видео с тестом 6 таких:

https://www.youtube.com/watch?v=Zu29LHKXEjs

Делайте выводы.

Постараюсь правильно донести свой вопрос.

Я думаю что все знают что такое character ai.Мне этот сайт нравится и я часто чатился там. Я сегодня узнал что его скоро или закроют, или будет новая версия которая хуже старой, что то такое. И все это, + ситуация с блокировками и замедлениями различных сервисов меня натолкнули на мысль.

Есть ли простой способ эм...завести такого бота у себя на компьютере?(я даже не могу точнее сформулировать) Чтобы он не зависел ни от роскомнадзора, не от гугла, в идеале даже чтобы и от интернета не зависел, ни от кого. А был лично моим.

Я надеюсь вы поняли что я имею ввиду.

Я полный ноль в программировании. И не понимаю как все это работает. Если вы меня спросите что по твоему такое character ai? То я могу лишь ответить что это сайт где можно пообщаться с ИИ, и на этом все. Поэтому я могу путать термины или даже нести чушь, не судите строго.

Функционал который мне нужен, это создание и редактирование чат бота одного хотя бы, но лучше 2-3. Возможность регенерации сообщений, возможность редактирования сообщений от бота.

1 Насколько это реально для человека полного нуля и что для этого потребуется? (если это важно у меня rtx 3060 12gb, и 32 оперативки в компе.)

2 Если это нереально, то что есть максимально приближенное к тому что я хочу, и максимально простое. А именно тихое место где я мог бы общатся с ботами бесплатно безлимитно и в идеале без цензуры. Что то типа сайта или приложения ,программы/игры где уже все готово и от меня требуется пару кликов чтоб подстроить под себя. Потому что мозгов у меня как у хлебушка.

В общем мне нужен личный аналог character ai, я не знаю как лучше объяснить.

Очень прошу, если кто ответит не используйте сленг и сокращения. Я ж не пойму ничего.

Я думаю что все знают что такое character ai.Мне этот сайт нравится и я часто чатился там. Я сегодня узнал что его скоро или закроют, или будет новая версия которая хуже старой, что то такое. И все это, + ситуация с блокировками и замедлениями различных сервисов меня натолкнули на мысль.

Есть ли простой способ эм...завести такого бота у себя на компьютере?(я даже не могу точнее сформулировать) Чтобы он не зависел ни от роскомнадзора, не от гугла, в идеале даже чтобы и от интернета не зависел, ни от кого. А был лично моим.

Я надеюсь вы поняли что я имею ввиду.

Я полный ноль в программировании. И не понимаю как все это работает. Если вы меня спросите что по твоему такое character ai? То я могу лишь ответить что это сайт где можно пообщаться с ИИ, и на этом все. Поэтому я могу путать термины или даже нести чушь, не судите строго.

Функционал который мне нужен, это создание и редактирование чат бота одного хотя бы, но лучше 2-3. Возможность регенерации сообщений, возможность редактирования сообщений от бота.

1 Насколько это реально для человека полного нуля и что для этого потребуется? (если это важно у меня rtx 3060 12gb, и 32 оперативки в компе.)

2 Если это нереально, то что есть максимально приближенное к тому что я хочу, и максимально простое. А именно тихое место где я мог бы общатся с ботами бесплатно безлимитно и в идеале без цензуры. Что то типа сайта или приложения ,программы/игры где уже все готово и от меня требуется пару кликов чтоб подстроить под себя. Потому что мозгов у меня как у хлебушка.

В общем мне нужен личный аналог character ai, я не знаю как лучше объяснить.

Очень прошу, если кто ответит не используйте сленг и сокращения. Я ж не пойму ничего.

А чем мы здесь по-твоему занимаемся? Все именно как ты описал у нас тут и происходит, 12 гб врама тебе за глаза на простенькую модель хватит.

Раньше в шапке был гайд для хлебушков, теперь его перенесли сюда: https://2ch-ai.gitgud.site/wiki/llama/guides/kobold-cpp/

Там всё верно, кроме предлагаемых моделей, их выбирай тут по количеству доступной видеопамяти и описанию: https://rentry.co/llm-models

Нихуя себе контент, ещё и на русском:

https://m.youtube.com/@razinkov/videos

Там и русский разбор статьи по Llama 3.1

https://m.youtube.com/@razinkov/videos

Там и русский разбор статьи по Llama 3.1

ну там анальник для анальников рассказывает

нам бы калтент, чтоб анальник для кривозубых крестьян рассказывал, чтоб пынятно был

Ещё осталось быдло, сидящее на cai? Я думал мамонты уже вымерли.

Ты про рефлекшн?

Покатал ее в разном рп, она действительно дохуя умная, интересная. В отличии от обычной лламы не теряется и не ловит затупы, на левдсах никакой разницы с сфв. Без дополнительных cot оберток зирошотом хорошо ориентируется в происходящем и даже прошла тест на снятие трусов юзернейм, ты глупый, я уже bottomless.

Но бля, это просто 11 укусов по запросу из 10, количество клодизмов, платиновых фраз и ебучих конструкций

> В убе одной кнопкой уже давно.

Экспериментальная реализация не сыскавшая успехов.

По остальному даже комментировать лень. Успехов тебе, может через пол годика проникнешься и заодно ждуновское бинго вокруг максимализма подлечишь, а то и что-то полезное напердолишь.

> на архитектуре ампер

Да

> не сильно дорого и чтоб не некроговно

Нет

Хорошие тесты. Непонятно только что за факстический бэк в используемой софтине и какой именно там квант. Но ориентируясь на жору и условные 5-6bpw что сожрут всю память - не так уж плохо.

Кстати, какие скорости у теслы на подобных размерах?

В шапке вики и гайды. Ознакомься с ними, начни пускать и задавай уже конкретные вопросы что не понятно или не получается.

Какая-тго вода. Я на перемотке глянул и сразу наткнулся на момент где он не понимает как attention mask работает, какие-то другие матрицы у него аттеншен формирует, лол.

Я сам гуманитарий, просто увидел длинные лекции, да вумные слова и решил что возможно анонам пригодится. Может это и продавец инфо-говна, хз, хотя курсы у него вроде "открытые"

>возможно анонам пригодится.

Пригодится, спасибо.

>какие скорости у теслы на подобных размерах

Сейчас точно не скажу, но сравнимые. Плюс на жоре они ещё и параллелятся - на двух теслах скорость почти удваивается. А в видео с этим беда.

1660c не умеет в нейронки.

Там чуть ли не скорость DDR4 обычной в нейронках, вроде.

> Думаю взять что-то дешевое, но чтобы по чипу было быстрым, смотрел на 16хх.

Потому что чип 16хх не умеет в ллм, не хватает чего-то там, не помню.

> шина с 1.5 раза меньшей пропускной способностью памяти, чем у 1660с

Только вот дело не в шине в случае с 1660с.

К сожалению, щас 6600 не у меня, не могу проверить вот-прям-щас, но 1660с точно не эталон. Что угодно другое — 1070, 2060…

Кстати, P104-100 (1070) выдает 17 токен/сек, вот где-то так должно быть на этом чипе.

Как я писал ранее, две таких тянут немо в 15-17 токенов. Одна, соответственно, 17+ выдает для малых моделей.

Справедливости ради, поебать, гарантия же реально, пихаешь им в ебало и они меняют или возвращают деньги, проблемы?

Уверен, что этот чел троллит.

Невозможно всерьез такую дичь писать.

1660? О_о

Юмор здесь заключается в том, что на одной из фотографий отец и дочь плавают на лодке, а на другой - они сидят на траве. Это создает противоречие между двумя ситуациями, которые кажутся совершенно не связанными. Вторая фотография может быть воспринята как негативная или даже критическая, поскольку она показывает отца и дочь вместе на траве, которая обычно считается местом отдыха и уединения.

Qwen2-VL-2b.

Не поняла.

Ну это же боль, вы угараете!

В прошлом году были 4090 по 60к. Но в Сбере. И в прошлом году. А сегодня 180к. Но в ДНСе и сегодня.

Просто немного теории.

Чат комплишн посылает JSON формат «роль: юзер, сообщение: текст» и получает «роль: ассистент, сообщение: …», а промпт темплейт приделывает сам со стороны бэкенда.

Текст комплишн посылает целиком сразу обработанный текст, который модель просто продолжает. Т.е., промпт темплейт на стороне фронта (таверны).

Второй формат лучше — дает больше свободы тебе.

По сути: хуй знает, в кобольде не гонял.

Можешь попробовать выбрать clblast или вулкан, вдруг на нем будет быстрее.

Вон, посоветовали кобольдспп с росм — возможно, поможет он.

Если все три не прошли, то… ебись, хули.

Я не читаю ваш тред, но меня пугают мысли, как люди вырезают куски контекста и склеивают их. Это ж лютый треш начнется. Там буквально входы-выходы нихуя не совпадают, с точки зрения ллм там шиза в моменте стыка.

ИМХО, гораздо лучше просто кэш контекста с пересчетом (инструкция + немного истории) при достижении лимита.

Я, оказался прав с вулканом. Ура.

Я юзаю Qwen2-VL и охуеваю от качества.

Но ггуф-версий пока нет. =(

Почему не P104-100?

Да, раскидать можно.

Да, грузить будет долго.

Если раскидаешь — контекст будет не быстрый. Если в одну видяху сунешь — то лучше.

18 токенов в немо. Звучит как медленно для цены. Зато одним слотом. Думайте.

> такая некорота, что лучше заменить целиком на 3060 12ГБ

+

Но P104-100 за 2к продаются, а 3060 слегка дороже.

> Ещё и мелкобуква. Ещё и точку не поставил. Пиздец короче как таких только земля носит.

Плюсую. Ахуй.

Нет, видеокарты стоят столько, сколько производительности в них.

30хх поколение не подешевело с выходом 40хх, это 40хх стало дороже.

Это политика компании.

Да, есть, перестать играть в дегенерата и прочитать шапку треда, где есть ссылка на вики, где разжевано все максимально.

Если ты не полный ноль в букваре, то прочесть сможешь.

Буквально два файла скачать, все.

3060 12 гигов база. Смотри в сторону Gemma-2-9b-it или Mistral Nemo 12b Instruction (или их файнтьюнов: Magnum 12b какой-нибудь).

> Но бля, это просто 11 укусов по запросу из 10, количество клодизмов, платиновых фраз и ебучих конструкций

Когда обучали на синтетике. Умная, но есть нюанс…

>2b.

>Не поняла.

Просчитался, но где?

>В прошлом году были 4090 по 60к. Но в Сбере.

С кешбеками считаешь, кешбекоблядь?

>Ну это же боль, вы угараете!

Нет, боль вот. 8B Q8. А что поделать?

> А в видео с этим беда.

У него там какой-то другой софт, ссылки есть, и явно не пытался использовать всякие опции. Видео довольно тягомотное, лучше сразу вот здесь смотреть https://gputests.robotf.ai/PNY_4060TI_16GB_1x_to_6x

> на двух теслах скорость почти удваивается

Алсо, так и не получилось повторить этот эффект, в отдельных случаях действительно наблюдалось ускорение генерации, но процентов на 20 и преимущество терялось при увеличении контекста. Главный буст был при сборке из сорцов по сравнению с готовыми билдами.

> Я не читаю ваш тред, но меня пугают мысли, как люди вырезают куски контекста и склеивают их. Это ж лютый треш начнется. Там буквально входы-выходы нихуя не совпадают, с точки зрения ллм там шиза в моменте стыка.

Абсолютно, о том вся речь.

> ИМХО, гораздо лучше просто кэш контекста с пересчетом (инструкция + немного истории) при достижении лимита.

Ага, именно такое решение и предложено в противовес шифтам и склейкам, к тому же реализуется на стороне фронта. Буфер до пересчета не на одно сообщение а на десяток (такое уже пытались делать в кобольде и был экстеншн к таверне), и запуск эвала в момент начала написания ответа юзером чтобы работал в фоне.

> 18 токенов в немо.

Вроде 26 по тому тесту

> Умная, но есть нюанс…

На самом деле терпимо если нет совсем алегрии, главное что нет бондов и всякого треша, чар инициативничает и не боится нсфв.

> В прошлом году были 4090 по 60к.

Ультишь, были цены типа 180 минус 60 и несколько лотов где за вычетом баллов 90-100к, но те быстро улетели и по отзывам кому-то 4080 присылали.

>Алсо, так и не получилось повторить этот эффект, в отдельных случаях действительно наблюдалось ускорение генерации, но процентов на 20 и преимущество терялось при увеличении контекста. Главный буст был при сборке из сорцов по сравнению с готовыми билдами.

Возможно дело в хорошей шине, но лично мне приходилось отключать ровсплит, чтобы увеличить скорость обработки контекста на двух теслах. Скорость генерации соответственно падала, но итоговый баланс выходил отличным - до 12B_Q8 включительно.

koboldcpp_cu12.exe --usecublas mmq --flashattention , плюс с размером blasbatchsize можно поэкспериментировать - 128 вроде бы лучшую скорость даёт на маленьких моделях. --benchmark тебе в помощь.

>18 токенов в немо

а че за модель "немо"? сколько параметров и с каким квантованием?

Это фишка геммы такая, что она медленная или просто какая-то несовместимость с рокм? Gemma-2-Ataraxy-9B-Q4_K_M.gguf, со всеми слоями только с 2к контекста помещается в 8гб рх6600 и выдает божественные 3 токена в секунду. Тот же мистрал немо к4_к_м с 2к контекста (чтобы поместился весь) выдает 13-14 т/с.

>Только вот дело не в шине в случае с 1660с.

Дело в шине у 6600, а не у 1660с. Даже у этой самой 1070 память быстрее, чем у 6600.

>Справедливости ради, поебать, гарантия же реально, пихаешь им в ебало и они меняют или возвращают деньги, проблемы?

Назначаем экспертизу. Экспертиза длится до окончания срока гарантии, а после выносит решение что случай не гарантийный. Отправляешься в спортлото, оспаривать экспертизу и доказывать что твоя хуйня сгорела не только что.

Какие-то фантазии из нулевых. Я пару лет назад сдавал свою свежую (на тот момент) 2060 из-за того что у нее выход на hdmi коротнуло и изображение перестало выводится. За 2 дня всё осмотрели и вернули деньги. А потом я еще одну 2060 купил.

>пару лет назад

>свежую

>2019 год

Время летит незаметно, верно?

Ах да, ты не заметил, что времена сейчас не те, и гарантии в России по факту больше нет.

>гарантии в России по факту больше нет.

В России нет, в Москве еще осталась.

И целиком доволен!

Свою стиралку за 500 рублей имею, доволен. В)

> по отзывам кому-то 4080 присылали.

Я понимаю, что им потом вернули деньги, но тягомотина была ебучая, конечно. Сочувствую им.

12b, 8 квант.

Ну все мои гарантии обрабатывались быстро.

В Ситилинке тянули, да.

Думаю, от региона зависит тоже, и от людей, как повезет.

>не сыскавшая успехов.

Потому что у них криво реализовано. Нужно делать, как нужно, а как не нужно делать - не нужно.

>1660? О_о

Да я спеки не смотрел. Потом глянул - там совсем печально всё. Хуй знает, что и выбрать теперь, лол.

>Там буквально входы-выходы нихуя не совпадают, с точки зрения ллм там шиза в моменте стыка.

С точки зрения ллм нет разницы, "начинается" у тебя диалог с середины поста или с середины непосредственно, диалога. А если удалять старые посты - оно так и происходит, ты кидаешь нейросеть в омут с головой, где уже произошли какие-то события и история начинается с ответов на несуществующие вопросы. Так и так начинается всё с обрывочных данных, но ллм неплохо с этим справляются. Здесь куда хуже семантический дрифт, но его влияние зависит от миллиона факторов.

>(инструкция + немного истории)

Тогда уже проще суммарайз истории и дроп всего, что не инструкция. Но это по времени инференса может быть не очень, особенно на долгих историях. Можно запилить маяки активаций, расширить контекст х100 практически бесплатно по vram и времени инференса, но это долго, дорого и больно. Можно сделать пересчёт скользящего окна, это, в теории, уберёт дрифт до ничтожно малых величин, хотя и не исключит полностью. Техник, на самом деле, много. Я себе потом точно добавлю экспоненциальное устаревание старых токенов и отрегулирую порционный сброс kv, так ни дрифта не будет, ни разрезанных на куски постов.

>Я себе потом точно добавлю экспоненциальное устаревание старых токенов и отрегулирую порционный сброс kv, так ни дрифта не будет, ни разрезанных на куски постов.

Всё себе? А людям? :)

> С точки зрения ллм нет разницы,

Нет-нет, нифига.

Речь не о том, чтобы отрезать начало и все. Тут вопросов нет.

Идея же в том, чтобы сохранить кэш инструкции (начало), вырезать середину, а потом прилепить концовку. И вот тут получается совершенно пиздец.

Ведь этот текст не обрабатывается с нуля — это именно кэш.

Короче, это бай дизайн будет выдавать дичь, и это выдает дичь. Не вижу противоречий.

> Тогда уже проще суммарайз

Нет, именно что это новая полноценная задача на фуллконтекст, которая жеваться будет очень долго. Именно что проще — при достижении лимита отрезать середину (тут как бы норм), и пережевывать инструкцию + конец. По смыслу то же самое, что и у резальщиков кэша, только теперь не мусор из байтов, а нормальный контекст, пусть и ценой однократной обработки.

А дальше, вплоть до нового заполнения контекста, по классике кэшируем и обрабатываем только новые сообщения.

Да, при этом нет суммарайза, но:

1) Технически вариант корректен.

2) Логически там все на месте.

3) Приемлемая скорость (раз в контекст идет пережевывание небольшого участка).

Не идеал, но остальные варианты сомнительнее.

Ну и можно просто обрезать начало забив на инструкции и надеяться, что модель будет поддерживать стиль и логику чисто по предыдущим сообщениям. =) Самый быстрый способ, я полагаю.

Хотя не силен в этой хуйне.

> С точки зрения ллм нет разницы

Бред.

То что диалог начинается не с какого-то отправного события а уже с каких-то действий, которые потом продолжительно развиваются - сетка переварит спокойно, подобное часто есть в художке. Если перед этим еще будет суммарайз - будет вообще прекрасно и без каких-либо вопросов.

А вот обрывки, кривые склейки, даже косяки форматирования она похватывает и сама начнет их повторять и серить. Кривые активации вне нужной последовательности и все такое - это будет вообще полная шиза.

В aicg уже вообще дошли до суммарайза на лету, чтобы сетке легче было обрабатывать прошлые посты, меньше лупов и эффективнее расходовались посты, и все это чисто на одном фронте. А ты тут "на острие прогресса" такие перлы выдаешь, зато уверенности сколько.

Как Yi Coder в плане секса, брыкается? в плане кода? Лидер теперь? Удалять deepseek-coder-v2:16b?

>Всё себе? А людям? :)

А чтобы людям - нужно влезать в код бэкенда. Во-первых, добавлять фейд старым токенам. Во-вторых переделывать инвалидацию кеша с поиском чего и где фронт удалил. Вот вторая операция мне не нравится, лол. Как и весь этот апи с перегонкой всей истории каждым запросом. Но это уже совсем другая история.

>это бай дизайн будет выдавать дичь

Я это тестил на q4 7b и q6 20b, это не ломается часами на адекватных параметрах. Здесь важно, сколько именно ты удалил. Возможно, сетка выдаёт не такие качественные ответы, как могла бы, из-за дрифта. Но в остальном всё окей.

>при достижении лимита отрезать середину (тут как бы норм), и пережевывать инструкцию + конец

Это как раз пересчёт скользящего окна, только инструкцию можно не трогать, если в ней нет изменений. А пересчёт сделать либо для части сохранившейся истории, либо для всей. Для всей долго, а для части - небольшой дрифт останется всё равно. Ну, можно сделать "для всей - быстро", если резать сразу дохуя, но мне это не нравится. Какой смысл тогда в больших контекстах.

Я же не на пустом месте это взял. Если бы сетка ломалась - сразу бы добавил обрезку по постам, а пока что это отложено в долгий ящик на похуй. Работает - хорошо, потом можно и улучшить, если будет не похуй.

>В aicg уже вообще дошли до суммарайза на лету

Я дошёл до сохранения чатлога в оперативе и поиск на ходу подходящих постов со вставкой в историю, если они уже вылетели из контекста. Просто анонам настолько понравилось обсуждать контекст шифт, что никто не успокаивается, лол.

> deepseek-coder-v2:16b

Это устаревшая модель. Yi явно лучше всех старых дипсиков. Из мелких ещё CodeGeex4 и автокодер нормальные.

>CodeGeex4

На день свежее?

В топе наверное 236B. Не честно.

> Если бы сетка ломалась

Проблема в том что в случае генеративных моделей довольно сложно оценить их перфоманс. В распоряжении только бенчмарки или сравнения, которые не точны, субъективны и компрометируются. Даже просто правильно выстроить процесс тестирования с ними - задача. Или же метрики типа перплексити, дивергенции и прочего, которые не дают должной информации.

В итоге то что поломалось ты заметишь только если там будет полный треш, в остальных случаях под впечатлениям будешь думать что просто модель так работает. Кроме того, даже просто для оценки нужен ОПЫТ В КУМЕ гусары молчать! чтобы примерно знать какое поведение ожидается и отследить что происходит. Обычные модели то нормально отранжировать не можем, только грубые условные топы.

> до сохранения чатлога в оперативе и поиск на ходу подходящих постов со вставкой в историю, если они уже вылетели из контекста

Больной ублюдок, но забавно. Лучше тогда копай в сторону упаковки активаций, как в штуке, что не так давно обсуждалась. Шифт и лепка кэша - херня, но вот с подобным можно попробовать добиться ужатия или суммарайза на уровне внутренностей модели, в общих чертах сохраняя память как у человека с долговременной.

Нужно ли соблюдать синтаксис типа W++, когда делаешь карточку персонажа? Или это плацебо, и прожнг просто в свободном стиле заебенить?

Нужно, если ты сидишь на пигме. Остальным моделям это будет только мешать.

Там нашумевший рефлекшн перевыложили, и судя по моим впечатлениям - охуенчик. Важно то что он признает и исправляет свои косяки. В первый раз такое вижу у лламок, даже чат жпт так не умеет, его хуй собьешь с намеченной тропы.

>это плацебо

Это не просто плацебо, это еще и дорогое плацебо, которое просто так жрет токены.

>просто в свободном стиле заебенить?

Смотря что для тебя свободный стиль. Если юзаешь плейн текст то тут надо быть аккуратным, потому что вероятнее всего модель возьмет оформление карточки за подсказку для форматирования. Будешь писать с ошибками и смысловыми нагромождениями вперемешку с противоречиями - получишь то же самое в ответах.

Тут где то был тред проприетарных, но я хуй знает не нашел, да и мертвый полюбас. В чатгпт треде аноны слишком тупые, а здесь все свои.

Кароч платиновый вопрос: где на халяву попиздеть с топ моделями? Тока без наёбок скамов и телеграм чатов. Я нашел немного легитимных вариков, накидайте если знаете еще.

Текущие топ 3 соат это гпт, клавди и гемини, пральна?

chatgpt.com

5 запросов в два часа или 10 запросов в день или около того, потом дропает на тупую 4о-мини. Бывает дропает после 3 запросов. Я так понял лимиты динамические и меняются постоянно в зависимости от нагрузки.

claude.ai

3-5 запросов в несколько часов, маловато. Опять же динамические лимиты.

aistudio.google.com

2М контекста пацаны, можно всю документацию целого фреймворка туда задампить и пиздеть с ним. Бесплатно 50 запросов в день, вроде. Отличается от консумерской gemini.google.com тем что дает бесплатный доступ к гемини1.5-про, еще можно ползунок цензуры поставить на минимум.

lmarena.ai

Персональный лимит 16 запросов в час до гпт4о. Примерно столько же и для других. Но есть и глобальный лимит для всех на каждую модель 1к запросов в час. Но можно просто переключиться например с гпт4о на клавд3.5 или на старый снапшот того же гпт. Ну и безлимит в арене, но там рероллить надо, и в общем-то получается использовать сайт по назначению. Угрюмый интерфейс, хули окно чата такое короткое? Не надо регаться.

github.com/marketplace/models

Нужно приглашение в бету, я нажал кнопку вейтлист, дали доступ через день. Выглядит шикарно но я почему-то еще даже и не пользовался особо. Хуй знает может боюсь что гитхаб аккаунт нюкнут низашо. Ваще не ебу про лимиты, нигде ниче не пишут. Из умных здесь только гпт4о. И локалки мистраль-ларге-2407 и лама3.1-405б.

Кароч платиновый вопрос: где на халяву попиздеть с топ моделями? Тока без наёбок скамов и телеграм чатов. Я нашел немного легитимных вариков, накидайте если знаете еще.

Текущие топ 3 соат это гпт, клавди и гемини, пральна?

chatgpt.com

5 запросов в два часа или 10 запросов в день или около того, потом дропает на тупую 4о-мини. Бывает дропает после 3 запросов. Я так понял лимиты динамические и меняются постоянно в зависимости от нагрузки.

claude.ai

3-5 запросов в несколько часов, маловато. Опять же динамические лимиты.

aistudio.google.com

2М контекста пацаны, можно всю документацию целого фреймворка туда задампить и пиздеть с ним. Бесплатно 50 запросов в день, вроде. Отличается от консумерской gemini.google.com тем что дает бесплатный доступ к гемини1.5-про, еще можно ползунок цензуры поставить на минимум.

lmarena.ai

Персональный лимит 16 запросов в час до гпт4о. Примерно столько же и для других. Но есть и глобальный лимит для всех на каждую модель 1к запросов в час. Но можно просто переключиться например с гпт4о на клавд3.5 или на старый снапшот того же гпт. Ну и безлимит в арене, но там рероллить надо, и в общем-то получается использовать сайт по назначению. Угрюмый интерфейс, хули окно чата такое короткое? Не надо регаться.

github.com/marketplace/models

Нужно приглашение в бету, я нажал кнопку вейтлист, дали доступ через день. Выглядит шикарно но я почему-то еще даже и не пользовался особо. Хуй знает может боюсь что гитхаб аккаунт нюкнут низашо. Ваще не ебу про лимиты, нигде ниче не пишут. Из умных здесь только гпт4о. И локалки мистраль-ларге-2407 и лама3.1-405б.

Тебе в соседний тред копрофилов. Только там тебя скорее всего тоже наухй пошлют.

> Кароч платиновый вопрос: где на халяву попиздеть с топ моделями? Тока без наёбок скамов и телеграм чатов.

duck.ai

huggingface.co/chat

Было ещё что-то на сайте нвидия. Это без банов по геолокации и прочего соевого фашизма. Если с ВПНом, есть ещё варианты.

Пчел, там всех наебали и доступное апи просто варппер до соннета

>где на халяву попиздеть с топ моделями?

Колаб в шапке чел...

>2М контекста пацаны

Скажем ему?

а также recall vs reasoning и товарищи

Ясен хуй впн есть, он же по дефолту в наше время должен быть? И номерок найдется хуйли мне 10 рублей жалко. Вот две тыщи жалко.

>huggingface.co/chat

Во про него забыл, но там максимум лама 70б.

>duck.ai

Неплохо красиво легитимно, 4о-мини завезли с ламой 70б.

Ну ты челик, 8б модель я и у себя могу запустить.

Если верить https://github.com/hsiehjackson/RULER реальный контекст 128к, что все еще ебёт всех и вся.

>8б модель я и у себя могу запустить.

Ну так и вперёд, хули мозги то ебёшь?

>где на халяву попиздеть с топ моделями?

В ChatGPT треде же предложили https://2ch.hk/ai/res/753991.html#840864 юзать вылеченные приложения. Всех фич и настроек ChatGPT таким образом не будет, зато сможешь чатиться с GPT4 сколько угодно.

А не, я дальше прочитал, они больше 128к и не проверяли, вполне возможно что гугл и не напиздели вообще.

Ты че ебанутый? У тебя мозг блять как у 8б модели, не хочу я с тобой разговаривать, понимаешь?

>Если верить https://github.com/hsiehjackson/RULER реальный контекст 128к, что все еще ебёт всех и вся.

Это на старой гемини. На новой ещё лучше. Только RULER это уже которая итерация "вот сейчас точно правильный тест", начиная с мемной иголкой в стоге, которая ничего не отражает? А воз и ныне там.

Я тебе скажу как человек юзавший все версии гемини на практике - нет там и близко столько, и тесты эти зависят от своих промптов. Да, конечно, у гемини всегда была наименьшая из всех деградация контекста. Но:

1) Заявленного там и близко нет. Проблема lost in the middle в decoder only и decoder/decoder моделях как не была решена пока никем, так и не решена. Немного сделали в https://github.com/microsoft/FILM тренировкой, но это костыль, корень проблемы даже не найден, не то что не решён. В день когда её решат, IQ лоботомита зашкалит, чисто за счёт этого.

2) На длинном контексте модель начинает терять общий перформанс пиздец как.

3) Recall != reasoning. Запомнить-то модель может овердохуя, да вот только реально применить в мыслительном процессе может только ограниченное число. И это не токенами считается, а максимальной сложностью абстракций которые может выразить модель. Поэтому например суммарайз по всему контексту без чанкинга до сих пор рождает тот же бред - ибо большей части контекста для модели просто не будет существовать, точно так же как ты не можешь прочесть одновременно всю книгу, даже если перед тобой одновременно разложить все листы в поле зрения.

А достать прям весь контекст дотошно можно только через chain of thought и подобные методы, да ещё не простые, а рекурсивные какие-нибудь. В общем про "засунуть всю кодебазу и чтобы оно корректно что-то делало по ней" - забудь сразу. Это не про нынешних лоботомитов, пока что.

Ну бля я думал хоть у проприетарных ребят все в масле должно быть. Ну гугл то, у них ведь должен быть какой-то специальный соус? 2м рекала все еще в каком-то смысле впечатляет. Почему попенай не могут так?

> Во про него забыл, но там максимум лама 70б.

Теоретически там лама 405В есть. Но почти не работает, слишком много желающих налетело.

Эмулятор ставить - в пизду. Если у них валидация премиума на стороне клиента, более пытливый ум наверное мог бы вытащить ендпоинт из приложения и напрямую через него общаться. Но нахуй надо.

У них и есть специальный соус - у неё действительно юзабельный контекст больше всех. Сама моделька правда всегда тупенькая была относительно других топовых, хотя последние версии уже неплохие. Но соннет всё равно кодит лучше.

>Если юзаешь плейн текст то тут надо быть аккуратным, потому что вероятнее всего модель возьмет оформление карточки за подсказку для форматирования. Будешь писать с ошибками и смысловыми нагромождениями вперемешку с противоречиями - получишь то же самое в ответах.

Хм, теперь понятно, почему у меня годные персы получались через раз...

Вот пример, написаный в свободном стиле (plain text). Это будет норм для связки SillyTavern+llama3?

> duck.ai

> huggingface.co/chat

Известны лимиты?

> > duck.ai

> > huggingface.co/chat

> Известны лимиты?

В обнимордовском чате нет, во всяком случае, я не натыкался, можно пиздеть сколько угодно. В duck.ai лимит есть, но хз сколько точно запросов в день можно + они пишут, что это временная мера.

Спасибо.

> довольно сложно оценить их перфоманс.

Так обещали-то все кары небесные - серить, шиза, выдавать дичь и т.д. А в итоге без залупы потери и не оценишь. Хотя я и не отрицаю, что они могут быть.

>Больной ублюдок, но забавно.

Сайдпродукт от rag. Побаловаться можно, но особо смысла не имеет, разве что ранжировать сообщения по важности и сохранять только критически важные. Иначе расход ram ебейший, а сжатие векторов я ещё не запилил.

>копай в сторону упаковки активаций

Да нахуй надо, там методов напилили триллион. Когда-нибудь нам дадут модели с маяками активаций и можно будет катать 400к контекста на двадцати гигабайтах. А копать вглубь никогда желания особо и не было, цель в другом.

>Ты че ебанутый? У тебя мозг блять как у 8б модели, не хочу я с тобой разговаривать, понимаешь?

Для школьника-максималиста, пришедшего в тред локалок с вопросами о закрытых моделях, и воротящего ебало от того, чем многие аноны успешно пользуются, ты слишком убого под умного косишь.

Запуск 8В моделей для тебя даже слишком, character.ai твой уровень можешь ещё в соседний тред сходить - поклянчить токен, может дадут за щеку

Ладно, пойду досру и буду эксперементировать. Понял уже, что никаких форматов нет, можнл просто хуярить plain text - simple english, тупо на простом английском как для дебса или StableDiffusion рисовалки

https://unrollnow.com/status/1832933747529834747

Эпопея подходит к концу, скоро коллективно всем ИИ-комьюнити Шумера хоронить будем. Реддит уже топит его. Остаётся только зоонаблюдать что сегодня Шумер пукнет и будут ли какие-то оправдания.

Вкратце - на HF лежит криво трененая Лама 3.0, даже не 3.1. А в API обёртка над Claude 3.5 с промптом на рефлексию.

Эпопея подходит к концу, скоро коллективно всем ИИ-комьюнити Шумера хоронить будем. Реддит уже топит его. Остаётся только зоонаблюдать что сегодня Шумер пукнет и будут ли какие-то оправдания.

Вкратце - на HF лежит криво трененая Лама 3.0, даже не 3.1. А в API обёртка над Claude 3.5 с промптом на рефлексию.

> попиздеть с топ моделями

Нужно быть умным или богатым, или и то и другое вместе. Авторизация апи идет по ключам, этого достаточно.

Есть еще вариант для терпеливых что ты описал, но это довольно сомнительно.

Вот этого двачую, особенно про

> 3) Recall != reasoning.

На мелких моделях особенно заметно, для них большой контекст вообще нонсенс ибо нормально работать с ним они почти не способны.

> Так обещали-то все кары небесные - серить, шиза, выдавать дичь и т.д. А в итоге без залупы потери и не оценишь

Не перевирай, если говорить грубо то посыл был в том, что васян не шарящий в теме, который боится интерфейса арены, катает без нормального промта/формата и хвастается посредственными постами - не поймет что у него модель серит, а будет воспринимать это как откровение и креативность.

> там методов напилили триллион

Речь о другом.

> А в API обёртка над Claude 3.5 с промптом на рефлексию

Вот же содомиты, кто там хотел бесплатного доступа?

Это про рефлекшн? Не самая плохая модель по ощущениям, а хайпа знатно собрали.

> Лама 3.0, даже не 3.1

Это проверяется работой с контекстом, как там сравнивали веса и предсказывали лору не совсем корректный подход.

> 5

С этого проиграл, ко всем остальным бы его применить.

Кек, но история все равно мутная какая та.

Выглядит вся эта движуха как та, в которой топили суцвекера и боготворили пидора альтмана. Боты или заказ или просто направленный в нужную сторону хайп.

Если единственная причина считать это подделкой апи сонета - ответ сетки о том что она сонет, то это хуйня.

Так любая нейронка скажет, если ее на загрязненном датасете обучить. Но и то что он никак не может модель нормальную залить тоже вызывает вопросы.

Ладно залить не может, вдруг и правда там косяк какой, но торрент сделать каждый может

> Боты или заказ или просто направленный в нужную сторону хайп.

Но ведь там явный пиздёж. Есть заявления про MMLU в 89, но модели нет. Та что в HF лежит хуже ванилы в тестах.

> ответ сетки о том что она сонет

Нет, токенизатор там точно не от ламы, уже 10 раз челики проверили. Ну и тот факт что слово Claude вырезалось тоже сложно оправдать чем-то - там просили повторить это слово и она пустоту выдавала только.

Господа, подскажите, на теслах разъем питания же по сути идентичен тому что на питание CPU идёт? Можно CPU кабель питания в неё воткнуть и всё будет работать?

> как там сравнивали веса и предсказывали лору не совсем корректный подход

Некоторые слои вообще без изменений от 3.0.

Хитрожопые мерджеры и не такое творят, возможно там франкенштейн, что может быть резонно с учетом особенностей работы 3.0 и 3.1. Офк девов не защищаю, хайп вокруг нездоровый.

> там просили повторить это слово и она пустоту выдавала только

Если то что лежит на обниморде просить то оно может клодой представиться, отсюда же и все молодые ночи с укусами по реквесту. Могли устыдиться синтетического датасета.

> токенизатор там точно не от ламы, уже 10 раз челики проверили

Интересно как проверяли, там же апи анально огороженный.

Рефлекшн с меньшими параметрами будет не?

> хайп вокруг нездоровый

Так Шумер заявлял что его модель ебёт даже все закрытые. В карточке вот такое:

> Reflection Llama-3.1 70B is (currently) the world's top open-source LLM