Блядь да сколько можно то? Когда наконец заебенят нормальный формат, чтобы все на нём сидели?

Идеи ноутбуков для быстрого инференса

В этом году начали выпускать ноутбуки на базе ARM процессора Snapdragon X Plus/Elite, по сути это прямой конкурент продукции Apple с их M2/M3/M4 процессорами. Судя по всему, Snapdragon X должны быть неплохи для генеративных нейросетей за счёт встроенного мощного NPU, как минимум на уровне Apple M2, а то и даже M3.

Про сам процессор и NPU:

https://www.hardwareluxx.ru/index.php/news/hardware/prozessoren/55606-hexagon-npu-qualcomm-planiruet-predstavit-samyj-bystryj-npu.html

Про уже доступные модели ноутбуков:

Qualcomm announces 20+ Snapdragon X Elite/Plus laptops

https://videocardz.com/newz/qualcomm-announces-20-snapdragon-x-elite-plus-laptops

Производительность в llama.cpp:

Performance of llama.cpp on Snapdragon X Elite/Plus

https://github.com/ggerganov/llama.cpp/discussions/8273

> E.g. here the performance of a Snapdragon X Plus (CPU-only, but Q4_0_4_8 optimized) vs. a 10-core M2 (CPU and GPU) for the new Llama3-8B Groq-Tool-use optimized local LLM. Yes, the Plus is still slower than the M2, but not by much, and the Elite is probably faster.

https://github.com/ollama/ollama/issues/5360#issuecomment-2244357036

Выглядит как хуйня. И скорости разве что с М1 сравнивать. Даже М2 Ультра просто космос по сравнению с этим, Снап вообще не конкурент. Я уже молчу про М3.

>за счёт встроенного мощного NPU

Где скорость памяти, Зин? А по вычислениям достаточно 6 ядер, а у меня 12.

И все они дружно сосут у 3090.

Самый смак в том, что пишут мол и старый 123b мистраль работает лучше с измененным промпт форматом

Тоесть все пользовались кривым, так как в таверне был кривой как бы не со времен первых мистралей, кек

Осталось выяснить какой лучше, там что то еще про лишний пробел после <s> писали в комментах, сижу щас думаю че куда

Ускорение инференции на Qualcomm'овских NPU в данный момент доступно, например, в https://github.com/UbiquitousLearning/mllm

Статья от разработчиков:

Empowering 1000 tokens/second on-device LLM prefilling with mllm-NPU

https://arxiv.org/html/2407.05858v1

> И все они дружно сосут у 3090.

По памяти сейчас всё сосёт у яблока. Только на яблоке можно получить 128/256 памяти с нормальной скоростью. А по производительности М3 Ультра на уровне 3090.

Все это хуета пока нет быстрой памяти подведенной напрямую к процессору.

Что бы его нпу мог ее использовать. Это нужно создавать новую архитектуру процессора, как это сдалала эппл. Так как все существующие сейчас дадут максимум 2 канала ддр5, в лучшем случае.

Это 100 гб/с максимум.

Нету в пользовательской технике контроллеров памяти хотя бы для 4 каналов. Хотя там и 4 было бы мало. 8 ддр5 каналов уже интересно звучит, с мощным процессором. Там уже теоретические скорости под 400 гб/с, что на уровне средних видеокарт

Но как ты понимаешь шанс появления ноутбуков или телефонов с 4 или 8 каналами быстрой ддр5 маловат

А я ХЗ что они там поменяли. Я проверил, и у меня никаких лишних <s> нету, как и лишних пробелов/переводов строк.

Вручную добавлять <s> нет смысла, это бос токен, его кобольд сам добавляет.

Короче хуйня из под коня.

Думаю зависит от бекенда, ллама.спп может как добавлять так и проебываться в новой модели. Не ебу короче, надо тупо сесть и проверить

>А я ХЗ что они там поменяли.

Да вроде ничего и не поменяли. А только пишут, что было три версии системного промпта, так вот v2 как раз для Large и Small.

В Таверне в настройках было:

"input_sequence": "[INST] ",

А нужно было якобы:

"input_sequence": "\n</s>\n[INST]\n",

И так мол было изначально задумано. Хз, я попробую на Ларже.

Нормально там всё добавляется, было время, когда глючило, но сейчас всё починили.

Переводы строк ХЗ откуда они взяли, а </s> добавляется в другом месте.

Интересно, они хоть вывод своих настроек смотрят?

> а </s> добавляется в другом месте.

А другом месте оно тоже добавляется. А в этом якобы фича такая.

>Можешь мелочь типа 2-4б натренить под конкретную задачу

как? дай гайд, у меня 12 кеков если че, хватит?

>Где скорость памяти

136 Gb/s у Elite. Медленнее топовых маков, но обычные M2 ебёт.

https://www.reddit.com/r/LocalLLaMA/comments/1fjxkxy/qwen25_a_party_of_foundation_models/

Отдали кучу новых моделей, до 72 версии 2.5 и Qwen2-VL-72B-Instruct

Ну, вроде норм

По цензуре у них там печально, на сколько помню писали

Хотя это могли быть настройки апи

Отдали кучу новых моделей, до 72 версии 2.5 и Qwen2-VL-72B-Instruct

Ну, вроде норм

По цензуре у них там печально, на сколько помню писали

Хотя это могли быть настройки апи

https://qwenlm.github.io/blog/qwen2.5/

Дожили, китайцы как на новый год подарков накидали, еще и под апач большинство моделей

Заебись, жду ответа от рептилойдов

Дожили, китайцы как на новый год подарков накидали, еще и под апач большинство моделей

Заебись, жду ответа от рептилойдов

Аноны как мистраль-нему и его файнтюны сделать менее хорни ?любое РП разбивается когда персонаж через 3.5 предложения зовет в постель.

Может это и предвзято, но я давно заметил что без-цензуры модель Llama 3 > мистраля, причем на порядок.

Написать нормальный системный промпт. В мистралях наоборот мало такого по сравнению с рп-тюнами.

Там соя пиздец, оно неюзабельно. Даже на ниггере схлопывается. В рп на любых движениях к сексу рассказывает лекции о недопустимости такого поведения, ещё и бывает в сообщении внизу дописывает "я больше не буду писать такие сообщения", лол. У 72В по логике не заметил никаких изменений по сравнению с прошлым квеном, ничем не лучше ламы, картиночки со скорами наверняка нарисованы в пейнте из головы. Русский стал складнее писать, но очень тупой, раньше он больше ошибался в грамматике, но хоть не тупил так.

Сап, друзья.

Выкачал 500 гигов Reflection, пытаюсь завести через питон и transformes

Код: https://pastebin.com/Pkbu63NS

Скрипт просто отжирает все мои 64 гига оперативки и помирает.

Надо брать больше? Или я все же что-то делаю не так?

Спасибо

Выкачал 500 гигов Reflection, пытаюсь завести через питон и transformes

Код: https://pastebin.com/Pkbu63NS

Скрипт просто отжирает все мои 64 гига оперативки и помирает.

Надо брать больше? Или я все же что-то делаю не так?

Спасибо

> Надо брать больше?

Ну да, 300 гигов ОЗУ хотя бы.

Почему ты просто не скачаешь koboldcpp c языковой моделью без цензуры, соответствующей твоей VRAM?

Тогда это выстрел в член, с чем их и поздравляю

Наверняка еще и прошлись методом аблитерации, только действуя наоборот, что бы нельзя было расцензурить ей же

Как это сделали в пхи3, о чем недавно писали те кто пытался ее аблитерировать и догадался о том что могло произойти

Ну без тюнов грустно, Мистраль в оригинале пишет суховато на мой вкус.

> Код:

Клод написал?

> Reflection

Как ты узнал об этой хуйне, но пропустил что она скам нерабочий?

апи или сам запускал? На апи фильтры, так что это мало о чем говорит

Челики уже жалуются что тесты новой 72В по знаниям местами на уровне qwen2 7В, особенно в вопросах современной культуры. Как-то китайцы тут очень жидко серанули, выдав эталонную антибазу.

>Как это сделали в пхи3

Там датасет вилкой же почищен до блеска, аблитерации просто нечего расцензуривать.

Я один сижу на мистрали 123B и не выёбываюсь?

Гпт написал.

Я не помню где узнал, в каком-то тг канале, забайтился на то, что оно "думает", как о1.

Херня, сносить, качать из шапки треда и всё?

На реддите пока только положительные отзывы, надо набрать статистику для выводов

Не уверен что стоит качать, наверняка ллама.спп еще дня 2 будет криво их запускать как минимум

Но если есть добровольцы попробуйте с последним релизом запустить что нибудь

>сижу на мистрали 123B

выебываешься

>аблитерации просто нечего расцензуривать.

Она не расцензуривает, она убирает отказы модели что то делать или писать. Предполагают что в пхи3 перед выауском сделали наоборот - нашли все веса с отказами и отрезали другие варианты где модель отвечала. В итоге нечего ращьлокировать и модель кажется стерильной

Кванты Жоры, что сами китайцы выложили. Причём на русском удаётся прорваться через цензуру. Видимо они там жестко резали всё на английском, на нём вообще непробиваемая цензура.

> Я один сижу на мистрали 123B и не выёбываюсь?

Да. Он слишком лупится, в длинном рп почти неюзабелен, приходится начинать роллить после 20-30 сообщения. Ещё и скорость такая себе, особенно на русском.

>Мистраль в оригинале пишет суховато на мой вкус.

Чистый Ларж 2 пишет очень сочно, если его раскачать. Всё там есть.

Если будешь не в помойных тг каналах сидеть или даже не на хабре, будешь знать что и о1 тоже кал, который лучше 3.5 сонета процентов на 15% а стоит на порядок больше. И все это делает компания пидорасов во главе с буквально пиздаболом, которую закидывают миллиардами халявных бабок.

>Он слишком лупится, в длинном рп почти неюзабелен, приходится начинать роллить после 20-30 сообщения.

Магнум 123В, потом Luminum - уже считай 2мб текста мне нагенерил и не лупится вообще. А как пишет - поэзия! И хорошо соображает. Ещё немного дотянуть и вообще было бы отлично.

Текст кто угодно умеет генерить. А вот в рп он сливается. Вроде начинаешь заебись, а потом в какой-то момент начинает всё хуже и хуже, сидишь и ролишь с черепашьей скоростью. Я уже раз много раз пытался, но в итоге всегда дропал, т.к. под конец уже литералли хуже мелких 12В-22В моделей становится. Люмамэйд - вообще никаких улучшений по сравнению с ванилой, просто более ебливая. Магнум получше, но всё равно сильно хуже 70В на длинных заходах.

Ну это всё здорово, но я оперирую тем что мне понятно и доступно.

Подскажешь не помойные места? Хочу понять как правильно.

Что-то пиздец какая разница в ответах. На русском всё норм, на английском анальная цензура и соя. Заебись китайцы отработали, даже не знаю как это оценивать, сразу и заебись и кал. На пиках разница в одной строчке системного промпта про язык ответа.

Забавно, наверняка китайский вычищен еще сильнее

Квен и правда цензурированный, боюсь, не API.

На русском лучше.

Контекст хорошо.

Но только возникает новая проблема.

Я словил ее еще на Qwen2-VL. Спросил про свою внешность — сказала, что обсуждать внешность не может.

Т.е., вопрос безобидный, но сенситив тема идет нахуй.

Короче, цензура дает фолс позитив. =(

Ты прикалываешься, я надеюсь?

Ты еще и способ выбрал заведомо не рабочий. =) Я хз, че ваще творишь.

Тебе в шапке разжевали, а ты говно себе в штаны напхал, да еще 500 гигов зачем-то.

Но оффенс.

Да все там нормально, модели обычные же.

Еще и Qwen2-Coder обещают пизже Deepseek-Coder-V2-Lite почти везде. Мое почтение.

Но, цензура, ну это пиздец.

И тоже не аблитерируешь, как я понимаю.

Надо сидеть в нормальных тг-каналах, там рефлекшен сразу же обоссали. =)

Про хабр гоготнул. Буквально хуже некуда, а ты пишешь «даже».

>Вроде начинаешь заебись, а потом в какой-то момент начинает всё хуже и хуже

Не соглашусь. Просто нельзя делать модель гейм-мастером. Кажется никакая модель этого пока не может. Если же ведёшь сам, то модель дописывает очень хорошо и учитывает все важные детали. Никакого провисания, персонажи как живые. Правда у меня уже 6к токенов саммари - на такой базе уже можно сообразить, что к чему.

И кстати Магнум-базед модели кажется несколько кривоваты. Когда перешёл на Люминум, сразу заметил улучшение восприятия - а все полезные свойства Магнума сохранились. Рекомендую.

Вопрос сеткам

Что получится при сгорании килограмма кислорода и килограмма водорода?

На сколько я смог выпытать и вспомнить ответ 1.125 кг и остаток водорода на 0.875 кг

Родила ответ пару раз запутавшись но все таки смогла - новая мистраль, вроде верно, не ебу

Хуй его знает на сколько этот вопрос сложный

Проверял вырезали ли из нее химию как "опасное" направление

Что получится при сгорании килограмма кислорода и килограмма водорода?

На сколько я смог выпытать и вспомнить ответ 1.125 кг и остаток водорода на 0.875 кг

Родила ответ пару раз запутавшись но все таки смогла - новая мистраль, вроде верно, не ебу

Хуй его знает на сколько этот вопрос сложный

Проверял вырезали ли из нее химию как "опасное" направление

> На русском лучше.

На русском вообще заебись, оно даже двач знает. Причём пишет топово по-русски. Если не трогать английский, то в целом годная модель, и в рп неплохо умеет. Но как только начинается английский - соей заливает всё до краёв.

Квен через раз справляется, пики 3 и 4. Может семплинг и русский подсерают ещё. А вот систему уравнений он не смог решить.

квен какой? их много

Qwen2.5 72B

Ебать, xckd еще живой и постит комиксы, или это уже нейросетки?

Комиксу лет десять.

Кумрады, объясните почему файнтюны немо при нарастании контекста начинают нещадно резать скорость генерации (с ~10 до 1-2)? На пустом контексте все заебись, скорость приличная. С ламой 3.1 такой хуйни нет, с любым контекстом скорость +- одинаковая.

бл я пробовал ету lllllma3.1 ето полная залупа по сравнению с тем же чатомДЖиПиТи или Клауде3.5, что 8b что 70b даж 405b хуита кароч проприетарные модели выйграли можно закрывать тренд

ауж про ети квены китайские ваще молчу (тоже хуита)

хехе гугл джема бл я помню у нас в соседях жила бабенция которая самогоном торговала у ей была собака по имени джема ето пиздец был конечн))

https://t.me/lovedeathtransformers

https://t.me/senior_augur

https://t.me/ai_newz

———

У меня грустные новости, я не смог запустить Qwen2-VL-72b на двух теслах. =( А хотелось получить SOTA визуалку дома.

Контекст не влазит, или я в лыжах, хз.

Автору даже сорока нет еще. Через месяц будет.

>я не смог запустить Qwen2-VL-72b на двух теслах.

Так ведь нет пока ггуфа, да и поддержка от лламы не заявлена.

Спермотоксикоз буквально единственный двигатель моец вознр с нецронками и ллм. Как только подрочил - ну и нахер я это делаю, лучше бы прогулялся, все равно это никому неинтересно и работу ты не найдешь

>Подскажешь не помойные места?

Ты уже в нём лол.

Не обсуждали ещё?

https://habr.com/ru/news/844392/

https://habr.com/ru/news/844392/

Господа, тут были поехавшие скиловые, которые пробовали тренить и менять токенайзер, живые еще? Довольно интересную идейку подкинул один оче умный гуманитарий:

При токенизации русских слов стоит учитывать особенности словообразования, выделять в отдельные токены суффиксы и окончания, отвечающие за склонения и смысловую часть языка. Причем не просто насобирать словарь где они будут, а именно добавить в код препроцессинга приоретизацию подобного подхода при токенизации датасета перед обучением. Тогда модель буквально будет обучена "думать по-русски", сможет делать более разнообразную и интересную речь, используя возможности языка, будет меньше ошибаться.

На первый взгляд имеет смысл, но конечный профит неясен, а может излишний расход токенов вообще перекроет все профиты. Есть желание проверить?

Память недостаточно быстра, отписали уже. На маках там 8 каналов памяти и потому могет, бонусом силикон позволяет обрабатывать промт без ультранасилия как на голом профессоре.

> 12 кеков

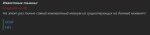

Лору хватит, фулл - никак. Как правило, большинство можно тренить через либу трансформерсов. Грузишь модель, пишешь простую функцию что будет обрабатывать твой датасет в сообщения модели, после

> from transformers import TrainingArguments, Trainer

> training_args = TrainingArguments(

> num_train_epochs=10,

> per_device_train_batch_size=2,

> ...

> )

> trainer = Trainer(

> model=model,

> args=training_args,

> data_collator=data_collator, #Функция - обработчик

> train_dataset=train_dataset,

> )

На обниморде почитай, там хорошо задокументировано и туториалы были.

При токенизации русских слов стоит учитывать особенности словообразования, выделять в отдельные токены суффиксы и окончания, отвечающие за склонения и смысловую часть языка. Причем не просто насобирать словарь где они будут, а именно добавить в код препроцессинга приоретизацию подобного подхода при токенизации датасета перед обучением. Тогда модель буквально будет обучена "думать по-русски", сможет делать более разнообразную и интересную речь, используя возможности языка, будет меньше ошибаться.

На первый взгляд имеет смысл, но конечный профит неясен, а может излишний расход токенов вообще перекроет все профиты. Есть желание проверить?

Память недостаточно быстра, отписали уже. На маках там 8 каналов памяти и потому могет, бонусом силикон позволяет обрабатывать промт без ультранасилия как на голом профессоре.

> 12 кеков

Лору хватит, фулл - никак. Как правило, большинство можно тренить через либу трансформерсов. Грузишь модель, пишешь простую функцию что будет обрабатывать твой датасет в сообщения модели, после

> from transformers import TrainingArguments, Trainer

> training_args = TrainingArguments(

> num_train_epochs=10,

> per_device_train_batch_size=2,

> ...

> )

> trainer = Trainer(

> model=model,

> args=training_args,

> data_collator=data_collator, #Функция - обработчик

> train_dataset=train_dataset,

> )

На обниморде почитай, там хорошо задокументировано и туториалы были.

Трансформеры и GPTQ прекрасно работают.

С 7b нет проблем в полном кванте на одной.

Вопрос скорости, но на проце медленнее, поверь. =)

А как же фулл 0.5б? :)))

Я че-то брался, но у меня не пошло с первого раза и запал пропал.

Ну и датасет я еще не вычистил целиком.

Так обсуждать-то и нечего пока, модель не зарелизили.

Полтора месяца не заходил.

Что там - гемма все еще топ из небольших(на одну 4090) сеток? Нового что-нибудь выпустили?

Что там - гемма все еще топ из небольших(на одну 4090) сеток? Нового что-нибудь выпустили?

По сути, аналог Qwen2-VL-72b, может чуть хуже по статам, но уже не суть.

…с обниморды выпилили. Пам-пам.

Никогда не была топом, гемма кал. Сейчас Мистраль 22В топ для мелких.

Гемма лучше всех после старого командра на русском говорила

мимо

>выделять в отдельные токены суффиксы и окончания

При достаточно большом датасете обучение токенизатора и так выделит эти паттерны.

>добавить в код препроцессинга приоретизацию подобного подхода

А вот это уже лишнее. У токенов могут быть и будут алиасы, т.к всё равно это преобразуется в векторы.

база

бл ета lama3.1 70b так медлено работает на rx7900xt явахуе т.е. ей 20гигов памяти маловато буит ето ито с флагом OLLAMA_MAX_VRAM который ограничивает жор по объёму памяти набортной иначе она просто падает изза нехватки памяти, пиздос кароч

Ну кум пока непонятный, вроде и лучше чем в проприетарных чаи и даже ремарку про зомбей снаружи нормально отрабатывает, чем многие омлеты на геммах и ламмах не могли похвастаться. Хотя у меня крошечная версия без квантования.

Сейчас квен2.5 по русскому всех ебёт, на нём реально ощущение как будто гора русского датасета была.

Из того что я заметил - квен ахуеть как хорошо инструкции на русском выполняет, лучше чем Мистраль Лардж. Его бы Магнумом полирнуть чтоб чуть ебливее сделать и норм будет. Главное английский не трогать. Ещё дефолтный промпт с <|im_start|>assistant жёстко сои наваливает.

> и так выделит эти паттерны.

Да, но нет. Если посмотришь дефолтную токенизацию русских слов в той же лламе - там часто этот паттерн нарушается, задача именно соблюсти.

> т.к всё равно это преобразуется в векторы

Именно, у модели будет тенденция к генерации в таком формате, все к этому сводится. Разумеется, нужно тестировать.

> OLLAMA

Посмотри в сторону более оптимизированных под амд оберток жоры или сам собери/возьми готовую llamacpp под твое железо. С 70б всеравно будет посос т.к. там больше половины обрабатывает процессор, но в более мелких моделях станет лучше.

Новая квен 14b пока охуенчик, на уровне геммы 27 по общению

Судя по тестам 32b ебет на уровне 72b квен предыдущего поколения

Короче заебись, не думал что китайцы с ноги войдут в такую сложную и быстроразвивающуюся сферу с отличными результатами

Мистраль 22 чуть умнее, но опять же от 14b недалеко ушла

Судя по тестам 32b ебет на уровне 72b квен предыдущего поколения

Короче заебись, не думал что китайцы с ноги войдут в такую сложную и быстроразвивающуюся сферу с отличными результатами

Мистраль 22 чуть умнее, но опять же от 14b недалеко ушла

>Довольно интересную идейку подкинул один оче умный гуманитарий

Ебать ты умный конечно. У меня таких идей на два листа тетрадки.

Немо ебёт их всех в любом случае

>дефолтную токенизацию русских слов в той же лламе

И? Там практически весь датасет на английском, так что очевидно, что токенизация русского не оптимальная ни с одной из точек зрения.

>Разумеется, нужно тестировать.

Вот как станешь миллионером - сразу и протестируешь. Рублёвые миллионеры не котируются.

Пиздец. Я уже два десятка говномоделей скочял а из них в нормальный нсфв промтинг для сд может только Tiger-Gemma-9B-v1a-Q2_K

Чяднт?

Чяднт?

Попробуй magnum-12b-v2.5-kto-Q6_K_L, мне анон с треда посоветовал. Годнота. Пересел на него с Mlewd20b. Спасибо ему.

>Q6_K_L

Не пойдет, она не влазит вместе с сдхл в 12 кеков. Качал magnum-12b-v2.5-kto-IQ3_S - тупа не пропускает никакое нсфв с любым инструктом.

> она не влазит вместе с сдхл

А зачем вместе?

Чтобы не доебывало перекатами моделек из рама во врам, у меня не современное железо.

Пикрел на Meta-Llama-3.1-8B-Instruct-abliterated.IQ4_XS кстати, терпимо но несколько расписывает как для т5, а надо чисто бурушное.

А нет, ASS потеряло.

Ультрашакалы заказывали? Всего 2.5 гига жрёт на небольшом контексте.

qwen2.5 попробуй, 3b неплохая такая, 1.5 или 0.5

Умнейшее из мелочи что сейчас вобще есть, 7b пока сломана

Сколько у тебя вобще свободной врам остается для llm?

Обе пробовал

Qwen2-1.5B-Instruct-Abliterated-Q8_0 на пике 2 слишком анстейбл, может срать кавычками, лишними словами

Qwen2-7B-Instruct-abliterated-IQ2_M на пике 3 с ума сходит

Может дело в самом темплейте инструкта? Какой юзать лучше?

А нет, никакой разницы похоже, я ж инструкт даю в ноде.

Это старые, сейчас новые вышли версии 2.5

Ебут все что движется, но там могут быть проблемы с нсфв изза цензуры. Но могут и не быть, если например инструкцию на русском сделать то вроде без цензуры отвечает

Да и думаю на английском смогут

qwen все тренены с чатмл, температуру ставь между 0.5-1 минп 0.1 все остальное нейтрализуешь и пойдет

>температуру ставь между 0.5-1 минп 0.1

Так это ж для чата, инструкту похуй на эти настройки разве нет?

Температура как и другие семплеры влияют на любую генерацию

Бекенду похуй, если он получает семплеры по апи он их применяет к генерации выбирая токен

Ну я вот поменял настройки семплера в буге, в комфи прожал - ниче не поменялось, выдает то же самое.

Комфи отправляет запрос, она фронтенд

Если она не отправляет семплеры то они не берутся из угабуги, там какой то стандартный берется каждый раз один и тот же

Ищи в комфи окошко с семплерами и отправляй их вместе с запросом

>Ищи в комфи окошко с семплерами и отправляй их вместе с запросом

Из всех нод у меня ток эта корректно отправляет на локал https://github.com/chrish-slingshot/CrasHUtils Query Local LLM

а там нет никаких настроек семплеров((99

Локальщики, помогите определиться с моделью под классик и эротик ролплей.

Имею на борту 16VRAM и 32RAM, по этому смотрю в сторону моделек в диапазоне примерно на 30B (в 4-6 кванте).

Пошарился немного по обниморде и всяким рейтингам и сейчас выбираю между гемой 27 и новым командором, который мелкий. Я бы погонял модельки сам и не спрашивал тут, но по какой то причине скорость загрузки с обниморды у меня походу в килобитах идет, потому что ламу восемь весом в 6 гигов я качал минут 40 наверное, если не больше.

Если гема или командор это плохой выбор, то можете посоветовать что-то еще. Вполне вероятно, я мог что-то упустить и вообще в своих поисках ушел в другую сторону.

Имею на борту 16VRAM и 32RAM, по этому смотрю в сторону моделек в диапазоне примерно на 30B (в 4-6 кванте).

Пошарился немного по обниморде и всяким рейтингам и сейчас выбираю между гемой 27 и новым командором, который мелкий. Я бы погонял модельки сам и не спрашивал тут, но по какой то причине скорость загрузки с обниморды у меня походу в килобитах идет, потому что ламу восемь весом в 6 гигов я качал минут 40 наверное, если не больше.

Если гема или командор это плохой выбор, то можете посоветовать что-то еще. Вполне вероятно, я мог что-то упустить и вообще в своих поисках ушел в другую сторону.

magnum-12b-v2.5-kto

> 16VRAM

С таким тебе выше 22В ничего не светит.

Немного смущает то что модель всего на 12 миллиардов. Можешь немного пояснить, почему именно ее стоит взять, а не что-то больше?

Если выгружать часть в видеопамять, а остальную в оперативную, почему нет? Да, скорость просядет, но выбора нет. Нет ни одной нормальной модели (по крайней мере я не нашел) в пределах 20B.

Это хорошая новая и умная модель, mistral nemo 12b

Есть ее старшая сестра mistral small на 22b

Она только вышла, но можешь ее попробовать

Но магнум это удачный файниюн умной модели на рп , ерп и расцензуривание

У меня с ней только одна проблема, что очень быстро подхватывает стиль общения, т.е если в первом сообщении мало текста, но много описания действий, то если не сгенерить нормальное второе сообщение, то может так и писать. Есть решение, лайфхак?

А, это файнтюн немо получается. Я ее еще не пробовал, но если она именно заточена под рп, то тогда это то что мне нужно.

Кстати, как у нее дела с логикой и запоминанием обстоят? Я пробовал ламу три восемь (не оригинал, тоже файнтюн под рп) и она крайне глупая, совсем тугая пробка. Пробовал с ней разные карточки (штук наверное 20 разных) и постоянно она теряла какие-то куски из описания и истории чата. Например, часто путала одежду, локации или даже положение в пространстве. Пробовал менять контекст в диапазоне от 4 до 8к токенов, но это никак не влияло на ситуацию. Семплеры тоже крутил, но удалось только избавиться от лупов, а не мозги это никак не повлияло.

> почему нет?

Потому что скорость будет как на чистом ЦП.

Наконец домучав семплеры, встал вопрос. А как делать так что бы Таверна выдавала текст по шаблону:

Описание сцены/описание действие персонажей>

Прямая речь персонажей>

Доп описание сцены(вариативно)->

Ожидание реакции Игрока.

Это же через Instruct Template делать надо или я не верно понимаю?

На Рефлекте 70б сейчас.

Описание сцены/описание действие персонажей>

Прямая речь персонажей>

Доп описание сцены(вариативно)->

Ожидание реакции Игрока.

Это же через Instruct Template делать надо или я не верно понимаю?

На Рефлекте 70б сейчас.

>На Рефлекте

Ебанат.

А по вопросу, просто дай примеров несколько, дальше сетка сама.

Где вы такую сою берёте?

>BTC79x5v1.0

пришла. Буду держать в курсе.

Поцене всего 4.5к, бомжесборщики, присмотритесь.

> 3 поколение

> зайдут с ноги

НУ КАК СКАЗАТЬ )

Разгоняются.

Qwen2 уже был очень хорош, но многие делали вид, что этого нет и ллама3 лучше (НЕТ), гемма лучше (чуть лучше, больше параметров, чуть больше фантазии).

Только нахуя, когда есть Qwen2.5, который сам по себе лучше этого говно-лламы-3?

Там даже дали 3б для совсем сомневающихся.

3b реально почти 7б-8б модельки старые.

Почти взрослая, хотя и небольшая.

Это не они, дратути.

Не пройдет, думаю, промпт-то выходной должен быть на инглише. А там цензура.

Чат и инструкт — это форматирование датасета. Семплеры работают одинаково.

Настройки семплера у тебя комфи передает, уба там не причем. Ты поменял ВО ФРОНТЕ убы, а передаешь сразу на БЭК.

Ну, значит автор ноды — мудак или воробушек.

Обниморда иногда лагает, проверь завтра и послезавтра, утром, в обед и вечером. Может прорвет.

Кстати, зачем эта древность, там же уже 3 версии навалили? На гемме, правда, но все же.

В твоем случае, если ты хочешь делать инструктом, можно лаконично, но четко и однозначно расписать. Умные сетки будут следовать инструкции, но не все.

Но тебе дали верный совет: накидай примеров. Сделай диалог из двух пар сообщений, где она дает такие ответы, и у нее получится гораздо лучше.

Через koboldcpp запускал

как решать проблему того, что сетка с ростом контекста тупеет?

Я не про обрезание контекста говорю, а про рост в рамках заданного.

Я рпшу на 8192. На магнуме 123б.

И прям заметно, что в начале ответы пишет хороший годный собеседник, а в конце - как будто цветы для элджернона читаешь - тупеет на глазах, лупится, кладет хуй на OOC.

Бля, обидно.

Я не про обрезание контекста говорю, а про рост в рамках заданного.

Я рпшу на 8192. На магнуме 123б.

И прям заметно, что в начале ответы пишет хороший годный собеседник, а в конце - как будто цветы для элджернона читаешь - тупеет на глазах, лупится, кладет хуй на OOC.

Бля, обидно.

Короче, чекай:

1 слот оперативы, всегда будешь ставить no-mmap, грузиться будет НЕ БЫСТРО.

PCIe x1 слоты, обработка большого контекста будет долго.

Если там AVX2 нет, то некоторые лончеры могут тупить.

Буду рад ошибиться в третьем, надеюсь во втором.

Потестируй, очень интересно.

Где брал? А то вижу только более дорогие варианты.

До этого на Euryale сидел. Модель приятная, но слишком хорни.

Написать кусок истории+монолог персонажа тупа в примеры диалога в карточке?

Я думал что её хватает и First message с подобной структурой.

С Мистралем Ларджем похоже ничего не сделать, я сам ебался с ним много, всегда такое говно после 6-8к. У Мистраля ещё промпт уёбищный без чёткого указания какое сообщение кому принадлежит и иногда на большом контексте он как будто на несколько постов назад отскакивает, отвечает на прошлые сообщения.

Я думаю эти модели оптимизированы на выдачу оптимального результата в начале контекста в силу того как их обучают, чтобы проходить тестики с парой лишних баллов. А за 70% оставшегося контекста отвечает меньшая часть параметров.

>Где брал?

на швитом авито.

Я сначала искал именно эту плату на алике, но там пиздец какой-то с отправкой и с оплатой, пошли они нахуй - решил я.

Пошел поискал на авито - а там оказывается они в наличии у дохуя продавцов.

Альсо, в биосе у платы есть above 4g. Я боялся что этого у неё не будет.

Ну, разница между карточкой и первым сообщением не сильно велико, важно — сколько ты ее там дал. =)

По идее, должно работать. Если не работает, то вопрос к модели или семплерам.

Ясненько, ну-с, ждем тестов. =)

>Я рпшу на 8192. На магнуме 123б.

Luminum 123B пробуй. Пресет Mirostat. Koboldcpp. Ггуф-модели капризные, так что даже на чистой llamacpp могут быть расхождения с тем же кобольдом. Про Уга-версию вообще ничего не знаю.

>пришла. Буду держать в курсе.

Добро пожаловать в клуб "4 теслы". Напишешь потом, сколько 123В_4КМ даёт. Впрочем для 8к контекста можешь и 5КМ взять.

Найс соя

>Ну, значит автор ноды — мудак или воробушек.

Блять, это единственная нода которая без ебли дает генерировать промты. Буквально пропиши систем, че хочешь и ебашь. Настройки семплинга можно и в убабуге крутить в принципе. Есть еще пикрел но я ебал инструкты вручную так писать.

>все остальное нейтрализуешь и пойдет

в смысле нейтрализуешь? в ноль ебануть?

>Настройки семплинга можно и в убабуге крутить в принципе.

ток они не крутятся лол, или я не там кручу, вообще ноль влияния в параметры - генерация

Если с запуском все нормально, то значит ты слишком много треша в контексте накидал, из-за чего модель путается. Проверь не идет ли неудачная обрезка без суммарайза, где после вступление идет странные действия из-за чего сетка ловит недоумение.

Но с такой моделью более вероятны проблемы лаунчеров, семплеров и прочего.

Если настройки передаются по апи то нет смысла ничего крутить в убабуге.

мда...

короче не взлетает на этой матери больше двух тесел.

Поначалу взлетала тлько с одной теслой, но вычитал в интернетах что надо увеличить MMIOH Size и величил со стандартного 64G до 128G.

После этого начала с двумя.

above 4g само собой включен.

И все, с тремя ни в какую, сука.

Во всякой документации и форумах люди которые заводили карты 40+ gb памяти выставляли MMIOH Size в 256G и выше, но у меня выше выставить невозможно.

Я подумал, что обновление биоса могло бы решить прблему, но биос у меня уже 21 года выпуска и единственная прошивка которую я смог найти - от 18 года.

Любая помощь и подсказки приветствуются.

Альсо да, там блять честные x8 на каждой линии.

>пик

пиздец мерзкий этот корпоративный спич

Че где инновации, рыночек схлопнул, хайп погас? После ламы3 в апреле прогресс умер нахуй.

Кто нибудь делал CoT для мистралей? Есть годный пример?

>Если настройки передаются по апи то нет смысла ничего крутить в убабуге.

покажи мне как передать настройки ептель

Аноны, посоветуете что можно купить на амазоне из видеокарт? Там бывают 3090 за тыщу или P100 за 300 баксов. Что посоветуете?

>3090 за тыщу

Хули так дорого-то? Или это в заводской упаковке, лол.

Кстати, шизу энтузиасту с тетрадкой. Записывай, идея на миллиард долларов. Сплит моделей на части и трейн по кускам. Никто адекватно этого не реализовывал, потому что отваливается обратное распространение, оценки ошибок и так далее. Разве что модели будут изначально спроектированы таким образом, чтобы работать в тандеме. Примеры такой хуйни уже есть на самом деле, только не для LLM.

Сам разобрался. Получилось вот так.

https://files.catbox.moe/0ry9xf.json

https://files.catbox.moe/tcjgtj.json

> идея на миллиард долларов

У меня для тебя плохие новости - это называется gradient checkpointing и он есть везде уже десяток лет. Если надо и forward дробить, то DeepSpeed...

Да после mistral-7b-claude-chat ничего достойного не выходило, чего уж там.

>Записывай

С год назад ещё записано.

Ты хуйню несёшь.

>год назад ещё записано

Не когда я резал 7b на куски и тренил? Хотя не помню, писал ли об этом в тред, лол. Сейчас совсем другое, меня внезапно осенило, что можно архитектурно это всё сращивать.

Чел, хватит бредить. В DeepSpeed модель разбивается на куски и батчи считаются со сдвигом, чтоб GPU не простаивали. Эти куски модели называют микробатчами. Ты не тот ли дурачёк, что изобрёл thinking спустя год после того как его обкатали все?

Ну, х8 для двух, т.е. может х4 для четырех.

НО, это уже кое-что, но проблема оказалась серьезнее. =(((

Могу лишь предположить (не слушай моего совета!) слить дамп биоса, найти там 128G и поменять в хекс-эдиторе на 256G, после чего залить обратно.

Вдруг сработает.

3090 в РФ за 500, на Амазоне за 1000.

Ну, норм, сочувствую заграничным.

Или на Амазоне там прямо новая-не-вскрывалась?

>что изобрёл thinking спустя год после того как его обкатали все

>изобрел thinking за год до того как это стало известно и начало использоваться другими

Ты хотел написать?

Пиздабол ты опять на связи? Я тебя еще в конце того треда попустил, когда ты зассал пруфы принести, на счет той хуеты что ты про меня сочинял

Вот уебище, и тут про меня продолжает пиздеть

По тестам Гусева, Qwen2.5-72b ебет(ся старшими корпоративными моделями и все). Но есть немного отказов даже на русском. Бида-бида.

Однако, пока все выглядит хорошо, как и ожидалось.

https://ilyagusev.github.io/ping_pong_bench/ru_v2

Однако, пока все выглядит хорошо, как и ожидалось.

https://ilyagusev.github.io/ping_pong_bench/ru_v2

>найти там 128G и поменять в хекс-эдиторе на 256G

хех, да я тоже так подумал попробовать сделать.

Но не знаю, к каким последствиям это может привести.

Ну, я вроде нашел вчера какой-то новый биос https://www.reddit.com/r/NiceHash/comments/t0h4jx/btcx79h61_issues/ буду пробовать его

плата действительно почему-то видит только два ядра из 6 на проце. Думаю, может это как-то роляет...

>Ну, х8 для двух, т.е. может х4 для четырех.

нет, чел, там вон на картинке виднео которую я кидал - там все пять портов на x8 режимах стоят. Эта плата жирный жир за свою цену. Если получится её распинать.

Ну, тады в надежде, ждем твои попытки.

Если что, приобрету себе тоже.

Кстати, вдруг возник вопрос, а что там за проц, видео выводишь как?

проц E5-2620, с матерью в комплекте шёл

с видео да, запердоны - приходится ставлять затычку чтобы сигнал вывести. Вчера заебался приседать вокруг него вставляя и вытаскивая карты.

> Гусева

Это тот который ломаную сайгу раз за разом делает?

У такого человека и тест должен быть ломаный.

>Гемма 9б выше Геммы 27б

Ну да, чтд, о чем тут вообще говорить.

Клован, тебе сразу кидали в ебало двухгодовалую публикацию про рефлекшен, где твой thinking и используется. И публикации от КлозедАИ больше года, где они то же самое описывают. Как видишь этот кал на волне хайпа пытались вытащить из помойки, но всё так же не взлетело.

Если там промпт с ассистентом, то это пиздец. А зная какой дебил гусь - это так и есть.

Как вариант - грузи биос в амитулз и разблокируй доступные опции или меняй дефолты. Если нет аппаратных ограничений, там может что-то нужное оказаться.

https://github.com/oobabooga/text-generation-webui/wiki/12-%E2%80%90-OpenAI-API

Наличие настраиваемых top_p и температуры прямо в ноде должно же хоть как-то намекать.

> Сплит моделей на части и трейн по кускам. Никто адекватно этого не реализовывал

Ты рофлишь чтоли? Разбивка модели на части с их мапингом на разные гпу, заморозка и тренировка ограниченного числа параметров, лора и прочее в peft, трюки с оптимайзерами и множество оптимизаций для снижения пикового и среднего потребления, оффлоад частей оптимайзера, всех его значений и вообще полный расчет его профессоров в дипспиде, вплоть до полной выгрузки весов в рам и постепенная переброска в гпу.

С подключением!

> Ты не тот ли дурачёк, что изобрёл thinking спустя год после того как его обкатали все?

Бляяяя, рили не удивлюсь если это тот же самый поех. И он же делает свой особый AIO интерфейс с бесконечным контекстом хотя для последнего тот казался слишком тупым, но упоротость, незнание основ, общее сходство на месте

Ну что там, на локалке доступны аналоги gpt 4o или 4o1 или еще пол года подождать?

Я вполне допускаю что это было изобретение велосипеда, но ни тут в дваче когда я поделился этой идеей, ни главное я сам этого на тот момент нигде не видел и никто не упоминал о существовании чего то подобного.

Был только простой cot по типу поэтапного рассуждения при решении задачи. И все. Тогда даже метода дерева мыслей не было.

Но внезапно, после моего объяснения как это работает и предоставления первого хоть и хуевого примера работы, кумеры в соседнем чате начали использовать эту идею.

А именно разделение ответа сетки на две части, где в начале идет размышление, а во второй ответ пользователю.

Аналогов такого не было и в больших сетках на тот момент.

Что то похожее начали использовать в клоде полгода назад где то. Вот сейчас - в новой сетке openai.

Если я не создатель этой идеи, то один из тех кто додумался до нее раньше всех и успешно использовал.

Ну а говноеды из треда меня не удивляют. Желание обесценить чужие достижения, зависть или просто желание потроллить, какая разница.

На сколько помню дурачек который со мной в прошлый раз спорил и пытался очернить всяко искажая мои слова и коверкая факты - так и слился когда у него спросили пруфы его пиздежа.

Что забавно так это то что у него были пруфы, он использовал вырванные из контекста цитаты моих сообщений, явно копируя их из старого треда. Давать же ссылки на уже найденный им тред он почему то обосрался, виляя жопой как сучка

Потому что весь его пиздеж противоречил найденным им пруфам.

Долбаеб, это ты? Давай пруфы или иди нахуй со своими сказочками

Что-то не пойму, какой пресет нужен квену2.5?

У тебя реально шиза, если ты думаешь что всё вертится вокруг тебя, это же один из симптомов. Если ты сидишь в двух тредах, то это не значит что никто не обсуждает это. Вот сходу на реддите нашел обсуждение больше года назад, там ещё много других про это. Ещё делаешь какие-то шизоидные выводы что в соседнем треде твою идею подсмотрели, лол. Откуда угодно это могли взять. Выпей таблетки, пока не закрыли в дурку.

ChatML. Только ассистента замени на любое рандомное говно.

Невнимательный долбаеб, я специально написал что никто не обсуждал это, и главное Я не видел этого. Даже если это велосипед - я придумал его сам, сам додумался это этой идеи и сделал первую реализацию с которой и поделился в мае прошлого года на дваче.

Поэтому если хочешь искать кто придумал раньше - ищи до мая 2023 года.

Год назад был сентябрь, внезапно.

Ну а обзывать кого то шизиком, в быстроразвивающейся теме где каждый день новые открытия, только за то что он смог додуматься до чего то раньше других - признак шизы

Ладно бы тема была старая как мир, а не та за развитием которой я следил и участвовал, находясь на краю инновационных знаний и технологий

По крайней мере в промпт инженеринге

В некоторых nlp задачах гемма сравнима или даже чуточку лучше. В других, или там где требуется подобие энциклопедичности (без вникания) - вчистую сливает чмоне. В рп она же ощутимо лучше, но ограничение контекста заставляет грустить.

> Был только простой cot

Введя свои название ты никак не изменил его суть, это и остался простой кот, точнее жалкие потуги в него 7м хуеты, которая без жестких рамок и оформления просто проигнорировала бы.

>это и остался простой кот

Ага, ты только что послал нахуй все разработки в техниках мышления упростив все до цепочки мыслей

Вот дураки, сидят что то там придумывают, один и тот же кот, да?

Кто-то уже тестировал MN-12B-Lyra-v4, что по ощущениям? Моделька от чела, который в свое время запилил пиздатую Stheno под ламу, а теперь затюнил на том же датасете модель под мисральский немо.

На какое например? {{char}}?

Да, как вариант

У него их там серия из штук 6 уже версий, хз вобще

Сравнить бы с магнумом (которых тоже штуки 3 на немо)

Но теперь годных моделей еще больше стало, мне больше интересно щупать новые квен и мистраль 22

Но цензура в них зачетная, похоже реально аблитерацией прошлись по "запретным" темам. Простым обучением так не сделать.

> ищи до мая 2023 года

Шизик, публикации рефлекшена два года. Хоть усрись, но твой пиздёж ничего не значит.

> первую реализацию

У рефлекшена код на гитхабе лежит, лол.

Вот ещё "никому неизвестная техника промптинга" из 2022 года, настолько неизвестная, что 2к звёзд у репы.

https://github.com/ysymyth/ReAct

>У него их там серия из штук 6 уже версий, хз вобще

Там вроде как каждая новая версия фиксит траблы предыдущей и по ходу дела приносит новые, так что я тоже не в курсах.

>Сравнить бы с магнумом (которых тоже штуки 3 на немо)

Магнум какой-то шизоидный временами. Чекал две разные версии и обе иногда начинали сходить с ума и нести чушь, не связанную с контекстом чата. Плюс какие-то странные токены то тут то там протекали. Но может быть я проебался с семплингом.

Мне чисто хочется чтоб была Stheno по стилю, но с большим контекстом и докрученными мозгами. Потому что все таки лама три это тот еще выродок, как хорошо ее не тюнингуй.

>Но теперь годных моделей еще больше стало

Да, это пиздец. Я вылетел буквально на полтора месяца из движухи и теперь с трудом пытаюсь нагнать. На одну только немо уже под сотню сборок будто вышло и хуй пойми как их всех тестировать, чтобы найти ту самую.

А твой пиздеж не значит ничего для меня.

Молодец что нашел, вот только ты на полтора года опоздал.

Если бы кто то сказал мне это тогда, было бы проще с реализацией.

Но почему то никто об этом не был в курсе в те времена. Интересно почему.

И ты долбаеб который не удосужился прочитать что я писал, я не приписываю себе знамя первооткрывателя идеи

Кстати то что ты скинул тоже не то, эта работа основана на другой

А вот до внутреннего диалога я и догадался, что и пытался запилить промпт инженерингом, интересно

https://arxiv.org/abs/2207.05608

Но и тут и там все сводится к действиям роботов которые планируют действия, но идея та же, да

бля ахаха)))

> никто об этом не был в курсе в те времена

Все были в курсе, кроме тебя. Никому это нахуй не надо было, как и сейчас.

>амитулз

не гуглится. Напиши по английски, что за утилита

ну хз как вы там её файнколхозинг я её спрашивал (ламу3) что она думает по поводу того что мне нравица замужняя бабёнка так она сразу в отказ идёт

>Все были

Эти все сейчас с тобой в одной комнате?

Что за детский максимализм, знало подавляющее меньшинство в те времена

Я тебе и говорю - ты хуйню несёшь. Не путай тёплое с красным.

>peft

Эта хуйня даже не умеет в неравновесную нагрузку на разные GPU, а ты так расхвалил, как будто это манна небесная. Хотя там кривое пердоподелие. Но речь всё равно не о том.

ебануца где вы ето берёте ваще, прост натянул оупенвебуи и пользуйся ну или из консонле

>https://github.com/oobabooga/text-generation-webui/wiki/12-%E2%80%90-OpenAI-API

>Наличие настраиваемых top_p и температуры прямо в ноде должно же хоть как-то намекать.

так покажи мне пак нод которые

а) имеют фикс сид

б) имеют расширенные удобные настройки а не пиздец китайского шиза коим является например ллм пати

Серьезно, блять? Серьезно?

Кто-нибудь может поделиться джейлбрейковскими промптами под геммы/ламы? Пока пользуюсь DAN под жпт, но может есть что получше.

обмазался соей и удивляется...

чё за сетка-то?

Персонажа прописал?

>Что за детский максимализм

Чел, у меня от твоих постов жир с монитора течёт, прекращай.

Начнём с того, что приписывать себе авторство чего-то на анонимном форуме это верх кринжа да в принципе этим и закончим лол

Был бы у тебя гит, или хотя бы рентри с твоей ахуенно полезной революционной хуйнёй, ещё было бы о чём говорить, а так...

Ну так а ты попробуй, сравни сам. =)

Он щас немного оправдался в глазах общественности.

Там все есть на сайте в открытом доступе, и промпты в том числе.

Кобольд? Серьезно?

Ну, а вообще, что ты хотел от #1 цензуры, они буквально этим хвалятся последние полгода. =)

Квен новый на 32b, там на скрине видно. Такие реджекты несложно обойти, но я просто в ахуе с того, то она триггерится по НАСТОЛЬКО ерунде.

>Персонажа прописал?

Да, всё прописано.

> Кобольд? Серьезно?

Ну да, я не особо увлекаюсь РП, таверна мне ни к чему, убабуга тоже. Функционала кобольда хватает для всех задач.

> Ну, а вообще, что ты хотел от #1 цензуры

Кек, братушки-китайцы побили рекорд Лламы 3.1, до такой степени сои не было даже там.

А так-то, если закрыть глаза на цензуру, вроде неплохо, я потыкал немного, отвечает на уровне Геммы 27b, может даже получше. Для рабочих задач и белых-пушистых запросов - сойдет, а кумерам соболезную.

> приписывать себе авторство чего-то

Просто 0 мозгов, жопочтец

Да, это пиздец

Модели умные, но триггерятся даже на просьбу рассказать о себе, кек

>Не когда я резал 7b на куски и тренил?

Не, без тебя, мои мысли все свои приходили в свободное время, поэтому записано в физической тетради (заодно чтобы попены не украли).

>Ну, норм, сочувствую заграничным.

Только зряплаты в 4 раза больше.

Двач на острие математики. В 2024 году двачерки узнали, что функцию от n-ного количества аргументов можно представить суперпозицией n функций от одного аргумента. А ведь с помощью этой теоремы Колмогорова - Арнольда доказывали именно свойства нейронок как универсальных аппроксиматоров ещё при советской власти.

>В 2024 году двачерки узнали, что функцию от n-ного количества аргументов можно представить суперпозицией n функций от одного аргумента.

Вот ты умный, да? Ответь двачеркам - где KAN? Пора бы уже, а то со времён советской власти много времени прошло.

> ррряяяяя я придумал придумал этадругое

Каждый раз как в первый

ami bios tools

Чел, то что ты чего-то ниасилил, не понял, или сделал примитивную штуку, которую просто мимолетом для организации тренировок пишут, не отменяет изобретение велосипеда и неосведомленности о действительности. Пробежка по граблям бывает увлекательной, наяривай.

> мне пак нод

Что?

> а) имеют фикс сид

Передаешь seed=42 в теле запроса

> имеют расширенные удобные настройки

Ну так возьми и напиши, или клянчи в сд треде. Здесь тред про языковые модели, вопросы твои были про использование апи.

Геммовский несколько тредов назад был, pastebin.com в поиске по борде глянь.

У меня 12 гигов ВРАМ и 16 РАМ. Что можно запустить максимум? Алсо, тут вы пишете про то, что можно в РАМ скинуть часть можели. А как? Я в Кобольде не нашел такой херни. Гоняю 12Б, если что. Хочу дрочить три дня.

> джейлбрейковскими промптами под геммы

И 9b и 27b лежат на обниморде с аблитерацией

>(заодно чтобы попены не украли).

Лол. Тут в треде одни шизы, вряд ли кто-то из них в попенах работает.

Так вы просто оба доказываете, что нихуя не поняли и доказываете непонятно что. Парочка долбоёбов, не более.

Качаешь гемму 27b в кванте 4к-м, ставишь в коболде выгрузку 24 слоев на гпу, и всё заработает со скоростью в 3.5 т/с лол. Терпимо, на самом деле. Всё что ниже 20b - это мусор для некроПК.

А он автоматически раскидывает на РАМ?

Алсо, есть аналоги, чтобы охуительные истории писать?

> А он автоматически раскидывает на РАМ?

Да. Но ты со слоями поэкспериментируй. У меня дебиан с гномом, в простое выжирает 6-7% гпу. На винде может быть больше или меньше. Если вылетает - просто поставь меньше слоёв. Если норм - попробуй больше, может прокатит и будет работать побыстрее.

> Алсо, есть аналоги, чтобы охуительные истории писать?

Есть лучше, но скорость тебе не понравится. 27b Гемма под 12гб видюху самый оптимальный вариант по соотношению скорость/качество.

Кумить на русском собрался? Если да - магнум нахуй, он там сломан. А тигр просто первая попытка расцензуривания, которая оказалось хуетой. Вот нормальный анценз - https://huggingface.co/QuantFactory/gemma-2-27b-it-abliterated-GGUF

Чел, с тебя уже который тред просто угорают, такой-то чсвшный шизоидный непризнанный гений, в одиночку решающий вселенские проблемы и побеждающий двач. Причем по общению и общему уровню видно насколько ты днище, что на контрасте с бесконечной самоуверенностью и копротивлением дает много рофлов.

>Кумить на русском собрался

Вот, кстати, нет.

Меня на кринж пробивает, если на русском это делаю. На инглише хоть мое не самое лучшее знание языка помогает справится, не вижу ошибок.

>Есть лучше, но скорость тебе не понравится.

А что есть-то вообще? Я просто знаю, что вот эти модели для чата сделаны именно. Я сидел до этого на Тайфайтере 13Б К4_М.

Смешнее всего, что бесконечную самоуверенность и непрошибаемую тупость демонстрируешь как раз ты. Тебе сказали, что ты сравниваешь разное. Но ты продолжаешь усираться и доказывать непонятно что. Иди в SD тред и скажи, что их модели хуже понимают русский, а значит, говно и они нихуя не понимают. А потом несколько постов подряд доказывай, почему они не правы. Ты сейчас чем-то похожим занимаешься.

>Меня на кринж пробивает, если на русском это делаю

Тут мне кажется, психология роль играет. Те же кривляющиеся стримеры в ютубе - на иностранном как-то более просто это воспринимается. Скидку делаешь, чтоли. Тогда как на русском это невыразимый кринж.

>Ну так а ты попробуй, сравни сам. =)

Что сравнить, гемму? Я пробовал обе, 9В намного тупее из-за размера, 27В и сейчас использую как основную сетку.

>Он щас немного оправдался в глазах общественности.

Чем оправдался? Его сайга уже даже фикшенная нахер не нужна, сетки по-дефолту отлично могут в русский.

А, ну на инглише - магнум топ, можно качать его. А про лучше - сорри, упустил что у тебя 16гб рам. Лучше не влезут даже в 3 кванте. Можно попробовать командер 32b и мистраль 22b (но мне они показались слабее геммы и аблитерацию на них пока не подвезли)

Мне лучше Геммы не надо. Мне нужно лучше, чем Тайфайтер для историй.

>3090 в РФ за 500

где? на авито?

Причём тут это? Мои идеи чисто технические.

>вряд ли кто-то из них в попенах работает

Но идеи регулярно пиздят. Сидят они, но молча.

>Но идеи регулярно пиздят. Сидят они, но молча.

Нуу, скорей всего боты с ии анализирует тред, как и кучу других где обсуждают ии.

Хотя с натяжкой могу представить 1-2 человек в 1 компании работа которых как раз шерстить такие темы но как ты понимаешь их скорей всего уже заменили ботами

Опенсорс и обычные люди существуют для того что бы у них пиздить инфу и идеи, это прям политика мета и других компаний.

Они сажают семена и собирают урожай, тогда когда без помощи добровольцев не обойтись.

Как например открытие и популяризация ии для сбора датасетов и анализа информации из обсуждений людей. Если бы ии могли улучшать в тишине, это делали бы

>Мне нужно лучше, чем Тайфайтер для историй.

Тогда нужна умная сетка хорошо держащая контекст, это либо из мистраль немо файнтюны, как тот же магнум https://huggingface.co/anthracite-org/magnum-v2.5-12b-kto-gguf, или https://huggingface.co/Sao10K/MN-12B-Lyra-v4

Либо возьми новый мистраль 22b, он неплох и умнее сеток поменьше

Есть еще умная qwen2.5 14b, но там много цензуры

> умная

> 12b

> 14b

А сравни с тем, что было всего полгода назад.

>Тогда нужна умная сетка хорошо держащая контекст

А перечисленные тобой сетки - не залочены под чат?

Бумп.

> мистраль 22b

Магнум есть?

Всё ещё хуже старого командира+, и уж тем более нового.

>Нуу, скорей всего боты с ии анализирует тред, как и кучу других где обсуждают ии.

Никому это нах.. не надо, идей в виде прямо готовых статей полно, какая из них может выстрелить - совершенно неизвестно. Ресурсов попробовать хотя бы 10% этих идей нет ни у кого, да и желания тоже - сейчас надо бабосики на хайпе грести. Что все и делают. Кто реально работает все мы видим, так как пользуемся результатами их труда. А они таки есть, результаты, прогресс идёт. Жалко, что мало кто вообще работает.

Что значит "залочены под чат?". Любую модель можно заставить РПшить.

Было еще большей хуетой, очевидно. Мелкомодели не могут в РП. Никакие, даже магнумы и 9b геммы. Ты тестил вообще? Они забывают контекст, шизят, постоянно приходится рероллить. Гемма 27 - это МИНИМУМ для нормального кума.

>Что значит "залочены под чат?". Любую модель можно заставить РПшить.

В этом и суть. Модели часто под чат прям делают, но не под генерацию прозы. РПшить я тоже люблю.

>Гемма 27 - это МИНИМУМ для нормального кума.

С 13В ещё может повезти. В того же Магнума много подобного заложили и он таки даёт.

> Гемма 27 - это МИНИМУМ для нормального кума.

Мистраль 22В намного лучше. Геммой только от безысходности пользовались, когда между 8В и 70В ничего не было.

> бесконечную самоуверенность и непрошибаемую тупость

> рряяяяя я изобрел а теперь спустя пол года все за мной повторяют

> Чем оправдался?

Таки присоединяюсь к вопросу, орочьи технологии что только портят сетку в современных реалиях не в почете, даже если главные ошибки исправлены. Может он что-то крутое сделал?

> на авито?

Беглый просмотр говорит что они там сейчас от 60к, дешевле редки или плохие. По курсу это больше 500 выходит, но и далеко от 1к.

> боты с ии анализирует тред, как и кучу других где обсуждают ии

Обзмеился. Только если посещает работник корпорации, но им самим есть что рассказать младшие знают малоую ограниченную часть, а кто покрупнее - сам публикует многие разработки, только в имплементации на открытых сетках

> сажают семена и собирают урожай, тогда когда без помощи добровольцев не обойтись

Все так, только в более мягкой интерпретации.

> Ты тестил вообще?

Многие просто связанный ответ бота и "ты меня ебешь" воспринимают как хороший результат. Или просто думаю что типичные паттерны всратых рп файнтюнов - откровение, а не треш, которые те модели выдают по любому поводу. Гемма, кстати, тоже не подарок, еблю не в лучшем виде описывает, но зато рпшит внимательно и старается.

> Мистраль 22В намного лучше

Лол

>Кто реально работает все мы видим, так как пользуемся результатами их труда.

Например? Во всех вышедших негронках ровно 0 революционного, тупо больше данных и размеры сеток.

Умная не умная, но в цензуре любая новая модель ебёт старые.

>Но идеи регулярно пиздят.

Я скорее поверю, что они анализируют шизов с реддита, чем местных. Хотя "2ch датасеты" на просторах интернета и встречались, но там это было для классификации токсичности. Да и самые интересные идеи сюда всё-таки не постятся. В процессе ёбки своей микромодели пришло в голову кое-то, загуглил, а там буквально одна статья на эту тематику, десятилетней давности, лол.

>> рряяяяя я изобрел

А, так ты думаешь, что с одним человеком споришь? Серьёзное психическое расстройство. Представилось, как ты ИРЛ начинаешь с кем-то спорить и "А, так это ты мне писал на дваче гадости!".

Аноны, давно не заходил к вам в тред (эдак с июня прошлого года) Подскажите годные семплеры и прессеты для магнума 12б. Наслышан что самая годная модель для рп.

>Во всех вышедших негронках ровно 0 революционного, тупо больше данных и размеры сеток.

Под капот к ним я не лазил, а чисто по ощущениям - контекст (до 32к) держат хорошо, гораздо умнее чем были и даже мелочь уже на что-то способна. Вряд ли это достигнуто просто улучшением качества датасета. Сравнивая 70В сейчас и раньше - разница видна. Ну и да, модели с большим количеством параметров тоже выкатили, кто может - тем более радуется. Там всё это ещё лучше.

Да не, качественная реализация обсуждаемых ранее подходов и правильное воплощение идет стоит куда больше, чем громко гремящие "прорывы" без юскейса. Вон сколько убийц трансформера, кан, 1.5 бита, но воспользоваться ими невозможно.

А текущие сетки, что локалки, что корпы имеют хороший прогресс.

> так ты думаешь, что с одним человеком споришь

Подвид пост троллинга, где люди специально кривляются изображая поведение унтерменьшей с полным отыгрыванием, непопулярен, но возможен. А вот то что над шизиком-изобретателем весь тред угорает - факт. Биомусор уже притомил

> Сравнивая 70В сейчас и раньше - разница видна.

Да, они реально стали лучше. На контрасте с мелочью, которая двух слов связать не могла, может казаться что его меньше, но нет, оно прям вообще ебет.

>весь тред угорает

>один долбаеб считающий свое мнение мнением треда

кек

>Во всех вышедших негронках ровно 0 революционного, тупо больше данных и размеры сеток.

Это как раз таки скрывают, как именно они добились улучшения сеток. Отговариваются лучше собраным датасетом, но это явно пол дела.

Что лучше? Ллама-3-8В или Ллама-3.1-8В?

Гемма 9b

Именно Атаракси? Именно в РП?

> Его сайга уже даже фикшенная нахер не нужна

Да причем тут сайга-то, неожиданно, ллм не заканчивается на одном способе использования одной ллм. =)

Ну, в общем, не верить топу — дело твое. Но там можно посмотреть всю историю тестов, и дать свою оценку. Какой-то смысл ориентироваться на топ есть, хотя бы оценочный.

скачал я общем AMI tools.

Вытащил биос через прищепку.

Каких-то теневых параметров в этом биосе не аншел. Кроме количества используемых ядер. Снял ограничение в 2 ядра, но это не помогло загрузиться с 3 картами.

Попробовал прошить биос отсюда , оказалось, что под ним не видится сата диск. Предполагаю, что это из-за того, что у нас с чуваком который делал этот дамп различаются северные мосты или ревизии матерей и из-за этого что-то идет не так при попытке загрузки.

Так же я попробовал прописать в строковых параметрах 256G, но это ничего не дало. Думаю потому, что это именно что строковое значение, оно слинковано с настоящей числовой переменной, но хуй знает где это искать.

Скачал себе IDA Free. Буду пробовать искать там связь 128G с числом. Но в дизассемблировании я очень слаб, поэтому вряд ли получится.

Там видно, что значения для MMIOH Size типа ENUM, то есть жесткое перечисление, а не свободная форма записи. Где-то джолжна быть мапка соотносящая эти строки и задающая их количество, но хз смогу ли я найти это в дизассемблере...

Все еще приветствуются либые советы.

>Все еще приветствуются либые советы.

10-я винда туда встанет?

Слишком соевая.

апвс?

>апвс?

Да вот думаю - может под виндой увидит третью теслу. В порядке бреда.

чел, биос не инициализируется вообще. До ОС дело не доходит.

Ты же поехваший просто, понимаешь это? Доёбываешься до людей, называешь их шизиками. Если чего-то не понял - то это ты долбоёб, а не кто-то другой.

>оно слинковано с настоящей числовой переменной, но хуй знает где это искать

У тебя же дамп бивиса есть? В нём есть эти ссаные параметры в гигабайтах, только в прошивке они с гарантией процентов 80 - в байтах. Твои 128 гигов это 1,28e+11, так что искать надо 1DCD65000 и заменять на своё. Вряд ли у тебя в биосе будет дохера таких значений. Но никакой гарантии, что это сработает - нет.

Ты только не расплачься, изобретатель. Действительность говорит сама за себя, с гарантией.

>1DCD65

не находится ни 1DCD65, ни 65CD1D

думаю, возможно там все-таки не в байтах

Главное не рассмеяться над тобой. Потому что смеяться над убогими грешно.

Матери у меня такой нет, но я нашёл в гугле какой-то модифицированный биос под эту мать, который снимает лимит ядер профессора с залоченных дядюшкой ляо двух. И там это нашлось. Но я бы на твоём месте просто переключил GEN на единичку, биос на легаси. Не заведётся, значит не судьба, замена одного значения на другое не научит биос работать с этим расширенным диапазоном.

https://www.reddit.com/r/LocalLLaMA/comments/1flkcav/qwen_25_casually_slotting_above_gpt4o_and/

Квен ебёт, по крайней мере в тестах

Но и по своему опыту скажу что сетки лучшие в своих размерах на данный момент, прыгая иногда через голову

НО, жирное НО - цензура и соя тоже зачетные

Квен ебёт, по крайней мере в тестах

Но и по своему опыту скажу что сетки лучшие в своих размерах на данный момент, прыгая иногда через голову

НО, жирное НО - цензура и соя тоже зачетные

Local 1M Context Inference at 15 tokens/s and ~100% "Needle In a Haystack": InternLM2.5-1M on KTransformers, Using Only 24GB VRAM and 130GB DRAM. Windows/Pip/Multi-GPU Support and More.

https://www.reddit.com/r/LocalLLaMA/comments/1f3xfnk/local_1m_context_inference_at_15_tokenss_and_100/

> Hi! Last month, we rolled out our KTransformers project (https://github.com/kvcache-ai/ktransformers), which brought local inference to the 236B parameter DeepSeeK-V2 model. The community's response was fantastic, filled with valuable feedback and suggestions. Building on that momentum, we're excited to introduce our next big thing: local 1M context inference!

> Recently, ChatGLM and InternLM have released models supporting 1M tokens, but these typically require over 200GB for full KVCache storage, making them impractical for many in the LocalLLaMA community. No worries, though. Many researchers indicate that attention distribution during inference tends to be sparse, simplifying the challenge of identifying high-attention tokens efficiently.

> In this latest update, we discuss several pivotal research contributions and introduce a general framework developed within KTransformers. This framework includes a highly efficient sparse attention operator for CPUs, building on influential works like H2O, InfLLM, Quest, and SnapKV. The results are promising: Not only does KTransformers speed things up by over 6x, but it also nails a 92.88% success rate on our 1M "Needle In a Haystack" challenge and a perfect 100% on the 128K test—all this on just one 24GB GPU.

https://www.reddit.com/r/LocalLLaMA/comments/1f3xfnk/local_1m_context_inference_at_15_tokenss_and_100/

> Hi! Last month, we rolled out our KTransformers project (https://github.com/kvcache-ai/ktransformers), which brought local inference to the 236B parameter DeepSeeK-V2 model. The community's response was fantastic, filled with valuable feedback and suggestions. Building on that momentum, we're excited to introduce our next big thing: local 1M context inference!

> Recently, ChatGLM and InternLM have released models supporting 1M tokens, but these typically require over 200GB for full KVCache storage, making them impractical for many in the LocalLLaMA community. No worries, though. Many researchers indicate that attention distribution during inference tends to be sparse, simplifying the challenge of identifying high-attention tokens efficiently.

> In this latest update, we discuss several pivotal research contributions and introduce a general framework developed within KTransformers. This framework includes a highly efficient sparse attention operator for CPUs, building on influential works like H2O, InfLLM, Quest, and SnapKV. The results are promising: Not only does KTransformers speed things up by over 6x, but it also nails a 92.88% success rate on our 1M "Needle In a Haystack" challenge and a perfect 100% on the 128K test—all this on just one 24GB GPU.

А в чем смысл такого контекста, если модельки зачастую теряются в деталях даже при маленьком контексте?

она же не следует подсказкам нормально

Моделей для RAG уже гора, а InternLM славятся отборной соей. Так что нахуй.

Челик вот со своими тестами культуры хорошо пояснил про скоры.

> цензура и соя тоже зачетные

Убираешь ассистента и пишешь на русском - получаешь полное отсутствие сои. В русском это реально топ на текущий момент среди локалок.

>Я скорее поверю, что они анализируют шизов с реддита, чем местных.

Так местные несут на форчаны, а с форчанов протекает на средиты.

>Вряд ли это достигнуто просто улучшением качества датасета.

>Отговариваются лучше собраным датасетом

Почему бы и нет? Вон, турбу выебали уже все как раз потому, что там датасет был маленький. А к четвёрке до сих пор подбираемся потому, что у ней полировочный датасет написан кенийскими неграми за бабки. В опенсорсе данных такого уровня просто нет, всё, что лежит на хайгинфесе, это ёбанный мусор. Я разок как-то открыл один из дампов русской википедии, так там прямо в первой строчке что-то типа

"Население России составляет человек."

Ну то есть цифра в вики берётся из другой таблицы, а парсер её не подставил. И если в первой строке такой обсёр, то что там дальше?

>Да не, качественная реализация обсуждаемых ранее подходов и правильное воплощение идет стоит куда больше

Качественная реализация старого подхода может выебать наивную нового. Но у старых подходов есть потолок, и мы уже бьёмся в него головой.

>кан

Никто не натрейнил на нём сетку размером хотя бы с GPT2, только лоботомитов 3-х слойных. Что от них хотеть?

>Кому супердлинный контекст?

Шо, опять? Ещё год назад видел контексты в 128к. А по факту выше 8к железо уже не позволяет.

Я тупой, подскажите на GTX1650 чето можно запустить локально из текстовых моделей и как? или это бесполезно?

можно озушки докупить и терпеть на 3 токенах в сек (что нормально на самом деле)

>https://rentry.co/llm-models

Поч некоторые модели отмечены красным а другие темным?

Поч некоторые модели отмечены красным а другие темным?

Красным отмечены магнумы, как самые модные РП-кум-решения, чтоб проще было найти.

По хорошему надо бы разбить серии файнтьюнов по тегам. Но пока нет смысла, т.к. в списке только тьюны, упоминающиеся в треде, так что не все серийные модели представлены и куча одиночных тьюнов. Магнумы - единственное исключение.

На 16хх — практически бесполезно.

Контекст выгрузи и ладушки.

Там сколько, гига 4? Забей, нормальные LLM тебе не светят, но мелочь до 12b можно частично выгрузить в шакальном кванте.

На правильные вещи в посте обращено внимание. Алсо, если смотреть на корпосетки, то складывается ощущение что там наоборот был тщательный отбор и подход для многих популярных и не очень вещей. Например, даже мелкая чмоня, знает анимушные тайтлы, подробный геймплей и суть популярных и инди игр и т.д., но из-за обилия глюков везде не самый удачный пример. Если взять опус или новый сонет - там куда показательнее, охват куда больше опенсорсных сеток, при том что на общие вопросы или что-то подобное они отвечают на близком уровне.

> Качественная реализация старого подхода может выебать наивную нового.

Именно, правильно воплотить в жизнь часто важнее и ценнее чем открыть прорывную штуку с кучей подводных, почему-то это часто недооценивают и только вайнят.

> только лоботомитов 3-х слойных. Что от них хотеть?

Наверно на это есть причина.

Разреженность это хорошо, но ведь в чем-то сложнее поиска факта перфоманс может упасть по сравнению с обычной работой.

>Наверно на это есть причина.

Ага. Бабок не выделили.

а что это за утилита, которой ты смотришь структуру?

GEN я уже пробовал опускать до минимума (это кстати x4x4x4x4, единичек там нет нигде), легаси ему не помог.

>Не заведётся, значит не судьба

Нет, ну я вижу пока еще место для маневров. Как минимум я могу найти post карту и посмотреть пост коды, чтобы понять, что ему не нравится. Потом, там куча опций в бивисе, которые я не понимаю - можно понять их все и попереключать. Ну и наконец дизассемблирование.

16хх не умеет в нормальный инференс, там в лучшем случае скорость вдвое выше ddr4, что ли.

Проще контекст держать и все, а остальное на проце.

А как настроить выгрузку только контекста?

мимо

Эксперты, поясните, пожалуйста. Вот у меня сейчас в компе 3060 на 12гб. В шкафу лежит старая видяшка 1050ti. Есть ли смысл воткнуть ее второй и выгрузить на нее часть слоёв? Будет ли какой-то буст? И как вообще подключать? Просто тыкнуть в разъем и всё? Или как-то видеокарты надо между собой соединять?

Пока не хочу покупать новую видяху, откладываю на 5090, к релизу как раз накоплю, лол. Но еще полгода терпеть 3 токена в секунду это больно.

Пока не хочу покупать новую видяху, откладываю на 5090, к релизу как раз накоплю, лол. Но еще полгода терпеть 3 токена в секунду это больно.

Мне кажется, что лучше купить 4090. Не просто же так ее снимают с производства. Значит она весьма хороша.

>Cydonia-22B-v1-Q4_K_M

Мне нравится эта модель.

Мне нравится эта модель.

>Так местные несут на форчаны, а с форчанов протекает на средиты.

Я к тому, что там облагорожено уже, чтоли. Нормисы, в общем. А здесь сплошной godfather.

>А по факту выше 8к железо уже не позволяет.

Потому и нужны маяки. У тебя будет практически константный расход vram на контекст в несколько сотен тысяч токенов с незначительной потерей деталей.

>а что это за утилита, которой ты смотришь структуру?

Очевидный uefitool очевиден.

>GEN я уже пробовал опускать до минимума (это кстати x4x4x4x4, единичек там нет нигде),

х4 это линии. А я про ген. Вон на пике, ген 3 и х4

Если есть выгрузка в оперативу, можешь перекинуть на 1050ti. На ней 4 гига, копейки какие-то влезут. Если и после этого будет выгрузка в оперативу, то разницы не будет. Если влезет всё, то станет чуть быстрее. Между собой соединять не надо.

Любопытно, это случайно не файнтьюн Мистраля 22В?

>Мне нравится

Напиши подробнее чем нравится - добавим в список!

>Любопытно, это случайно не файнтьюн Мистраля 22В?

Да. Вчера анон подсказал, что Мистраль 22В норм, вот и нашел версию.

>Напиши подробнее чем нравится - добавим в список!

Не могу описать. Просто быстро выходит на то, чего я ожидаю, я хз. И по скорости терпимо на 12 ВРАМ и 16 РАМ

>с незначительной потерей деталей

Хочется верить...

>Если есть выгрузка в оперативу, можешь перекинуть на 1050ti. На ней 4 гига, копейки какие-то влезут. Если и после этого будет выгрузка в оперативу, то разницы не будет. Если влезет всё, то станет чуть быстрее. Между собой соединять не надо.

Спасибо. Тогда наверное нет смысла, гемма в четвертом кванте не лезет, а в третьем там наверное совсем лоботомия. Ну терпим дальше, штош

В третьем кванте Гемма есть в колабе, можешь безболезненно проверить.

Там фактически вся магия в замене N токенов на один. И вот сколько этих токенов заменяется и как - определяет и потери, и предельный размер контекста. Если, скажем, "по пустынной безлюдной улице ехала ржавая машина" заменить на что-то, что для модели значит "ехала машина", то сам понимаешь коэффициент потерь. Но я не видел, чтобы с этим мог работать хоть один из бэков, да и незачем - моделей таких в свободном доступе попробуй найди. Но бумаги есть, пруф оф концепт был, 400к контекста и небольшое отставание от "настоящего" контекста в тестах. Скорее всего, так и захлохнет, как файнтюн на кофемолках. Технология есть, но реализаций нет.

Можно ли как-то квантовать контекст? Почему контекст занимает одинаковое количество памяти при моделях с разным квантованием (GGUF, koboldcpp)?

>Можно ли как-то квантовать контекст?

Da.

Просто подрубаешь видеокарту, но количество слоев ставишь 0 — на видяху улетает только контекст. =)

Да, можешь попробовать, но скорость там не сильно бустанется.

Нет, между собой их соединять не надо.

Просто в слот пихаешь.

Да, cache_8bit и cache_4bit, но лучше только 8.

———

Посоны! Qwen2.5 умеет писать стихи!

Ну, криво, но уже как гемини прошлая. Т.е., последние куплеты нет, а вот в начале (или середине почему-то, лол) — весьма в рифму.

Для таких технарей как я — это прекрасно.

Все остальные локалки на русском выдавали прям вообще херню (llama3-8b что-то иногда рифмовала).

Еще попробовал Qwen2.5-14b, и смело меняю Nemo q8 на Qwen2.5 q6, гораздо лучше.

>pastebin.com

А как какоть?

Ну и пусть себе лежат. Мои скачанные Rocinante-12B-v2d-Q4_K_M, magnum-v3-9b-Q6_K, Qwen2.5-7B и пара других моделей выдают стандартную телегу про безопасный интернет и ркн.

В https://github.com/Vali-98/ChatterUI завезли проверку по самодподписанным сертификатам. Теперь можно подрубаться к дому через https и шифровать свою переписку.

В две P40 влазит 16к контекста Qwen2.5-72b-q4_K_S, или же 32к квантованного в cache_8bit со скоростью 6,5 токенов/сек.

Qwen2.5-72B-Instruct-Q4_K_S.gguf$:

loader: llama.cpp

cpu: false

cache_8bit: false

cache_4bit: false

threads: 0

threads_batch: 0

n_batch: 512

no_mmap: false

mlock: false

no_mul_mat_q: false

n_gpu_layers: 81

tensor_split: 18,23

n_ctx: 16384

compress_pos_emb: 1

rope_freq_base: 1000000

numa: false

no_offload_kqv: false

row_split: true

tensorcores: false

flash_attn: true

streaming_llm: false

attention_sink_size: 5

В две P104-100 влазит 16к контекста Qwen2.5-14b-q6 при сплите 1,2, или даже 32к контекста (в 16 гигов!) при скорости 10-12 токенов/сек. Или же, без сплита (все же сплит 1,2 заставляет вторую видеокарту вдвое дольше обрабатывать слои) влазит 8к и 16к контекста соответственно при скорости 12-15 токенов/сек.

Итого, https://qwen2.5-14b-q6 c 16к контекста. Весьма недурно для 15 токенов в секунду.

Да еще и мобильная апа апдейтнулась.

Ну я прям доволен.

В две P40 влазит 16к контекста Qwen2.5-72b-q4_K_S, или же 32к квантованного в cache_8bit со скоростью 6,5 токенов/сек.

Qwen2.5-72B-Instruct-Q4_K_S.gguf$:

loader: llama.cpp

cpu: false

cache_8bit: false

cache_4bit: false

threads: 0

threads_batch: 0

n_batch: 512

no_mmap: false

mlock: false

no_mul_mat_q: false

n_gpu_layers: 81

tensor_split: 18,23

n_ctx: 16384

compress_pos_emb: 1

rope_freq_base: 1000000

numa: false

no_offload_kqv: false

row_split: true

tensorcores: false

flash_attn: true

streaming_llm: false

attention_sink_size: 5

В две P104-100 влазит 16к контекста Qwen2.5-14b-q6 при сплите 1,2, или даже 32к контекста (в 16 гигов!) при скорости 10-12 токенов/сек. Или же, без сплита (все же сплит 1,2 заставляет вторую видеокарту вдвое дольше обрабатывать слои) влазит 8к и 16к контекста соответственно при скорости 12-15 токенов/сек.

Итого, https://qwen2.5-14b-q6 c 16к контекста. Весьма недурно для 15 токенов в секунду.

Да еще и мобильная апа апдейтнулась.

Ну я прям доволен.

спасибо

> но лучше только 8

сильно падает качество?

На 4 бит он начинает контекст забывать заметно.

На 8 бит деградация терпимая.

Если прям совсем-совсем все плохо, а хочется много контекста — можно и 4 бита врубать, но быть готовым к затупам.

>завезли проверку по самодподписанным сертификатам

Нормальные люди через nginx проксируют, а в него прикручивают валидный через летс энкрупт.

>В две P40 влазит 16к контекста Qwen2.5-72b-q4_K_S, или же 32к квантованного в cache_8bit со скоростью 6,5 токенов/сек.

На 16к в дефолтном кванте контекста токенов столько же?

можно ли квантовать видяху

Конечно. У меня квантованная 3090, куртка квантовал её с родных 8 бит (24ГБ) до 4-х (12ГБ). А сама 3090 это квант от 48 гиговой А6000.

Я ебало себе квантовал вчера, до сих пор болит

>почему

Возможно, ты запускаешь впритык по vram, а дальше при нарастании контекста оно вываливается в общую ram. Пробуй кидать меньше слоёв на видеокарту.