Убрал из шапки мёртвые ссылки:

https://technothread.space

https://static.nas1.gl.arkprojects.space/stable-diff

Добавил ссылку на GUI для тренировки лор:

https://github.com/anon-1337/LoRA-train-GUI

Маякните, если ещё что-то конкретное поправить в шаблоне надо.

https://technothread.space

https://static.nas1.gl.arkprojects.space/stable-diff

Добавил ссылку на GUI для тренировки лор:

https://github.com/anon-1337/LoRA-train-GUI

Маякните, если ещё что-то конкретное поправить в шаблоне надо.

Не поторопился ли? Там аскотест анон сегодня уже хотел запилить вроде. Ну в шаблон добавится тогда на следующий.

Когда последний раз торч обновлял кстати? Версия от 13.03 и последний коммит искформерсов мне еще накинул немного производительности, если сравнивать с 18.02. Кстати, сам твой гайд тут тоже к месту был бы

> Не поторопился ли? Там аскотест анон сегодня уже хотел запилить вроде. Ну в шаблон добавится тогда на следующий.

Ага, добавим в следующий тред тогда. Ну, или можно мода попросить поправить шапку, раз этот тред такой медленный (прошлый за 11 дней до бамп-лимита дошёл).

> Когда последний раз торч обновлял кстати? Версия от 13.03 и последний коммит искформерсов мне еще накинул немного производительности, если сравнивать с 18.02.

11.03 обновлял и сборку сюда выложил: https://rentry.org/xformers_builds

Но я замеры у себя не делал ещё для сравнения с 18.02, просто перед паблишем убедился, что локально ничего не ломается.

> Кстати, сам твой гайд тут тоже к месту был бы

Окей, добавлю в шаблон позднее. Меня, правда, смущает, что не у всех анонов версии из гайда работают попробую ещё потом пару старых версий собрать и запаблишить.

Таки поторопился но ладно, все лучше чем тонуть. Поведение в разных версиях тестирую пока всеравно, 5ю пожалуй стоит отложить ибо там так много отличия и кое что поломали, да и понял что нужно прям совсем для хлебушков пошагово писать а не более детальные вещи для тех кто уже что-то знает

> 5ю пожалуй стоит отложить

Речь про sd-scripts?

> Окей, добавлю в шаблон позднее. Меня, правда, смущает, что не у всех анонов версии из гайда работают → попробую ещё потом пару старых версий собрать и запаблишить.

Ну на 4000 серии это же мастхев, хз только насчет более младших, чем 4090 карт, эти шедевры кто то покупал вообще из местных? А на 3000 только хуже делает, у меня например было с 3000 и самосбором иксформеров меньше производительности. Как минимум стоит рекоммендовать собирать самому наверное, раз готовый не ставится. Лучше, конечно, у тех анонов выяснить причину, почему не ставилось, логи там хотя бы глянуть, инфу о системе, как ставил

А вообще вангую у него таже проблема с венвом в первом и втором случае, а в третьем он не те версии пытается ставить, у меня было что к версии, условно от 03.03 торча не подходит версия торчвижона, нужна от 02.03 или 04.03

> да и понял что нужно прям совсем для хлебушков пошагово писать а не более детальные вещи для тех кто уже что-то знает

Разделил бы просто, для хлебушков и смешариков разделы например, всяко хлебушек рано или поздно станет смешариком, если тренить много будет

Да

Ну что, основной текст есть, осталось гриды запилить да и свежим выглядом посмотреть. Если звезды сойдутся будет завтра.

Все пытаюсь воспроизвести оче долгое обучение на относительно низком лр, уже и батчсайз2 и дим 64 и fp16 поставил. Увидев первый грид даже удивился и показалось что вот оно - но нет, просто пытается копировать пикчу с датасета а при задании какого-то фона тот нахуй уничтожается. На большом bs чуточку лучше но та же херня.

> кто то покупал вообще из местных

У кого-то точно есть 4080

> А вообще вангую у него таже проблема с венвом в первом и втором случае, а в третьем он не те версии пытается ставить

Двачую, оно должно влет ставиться а один бедолага долго пердолился

Бля, наверное, я еблан, но спрошу по лора про регуляризационные. Может кто-то объяснить или ткнуть ебалом в гайды как правильно называть папки концептов для них? Туда пихать полностью промпт-класс генерируемых пикч а ля a photo of my big hui и оно соотв. матчится с тегами пикч на которых обучаем?

В чем разница между dreambooth и fine tuning? Как обучалась оригинальная модель?

Есть ли какой нибудь софт для управления датасетами? Что бы можно было хранить изображния, тегировать, искать, делать выгрузку данных. Не поднимать же для этого локальный сервер booru.

>Есть ли какой нибудь софт для управления датасетами?

Нет вроде, есть мокрописька для тегирования

https://github.com/arenatemp/sd-tagging-helper/

Я хотел еще написать токенизер, который бы обрезал лишние теги, если превышен лимит, но не нашел актуального кода по которому webui это считает.

И я снова обращаюсь к вам за помощью. Как вот ето вот фиксить то? Вроде бы спрашивал уже, относительно недавно, сказали подтянуть файлы подгрузки и что-то там с процессором сделать - если честно, без понятия как что-либо из этого делать на коллабе. Вот такое происходит при попытке смены моделей или вае. Если что у меня почти все модели загружены ярлыками с других дисков из-за маленькой вместительности оных. Раньше такого не было, началось месяца два назад?... Причем, сначала случалось 50/50, а сейчас прямым блоком не дает ничего сделать. С других устройств/айпи/дисков та же проблема. Буду крайне благодарен за помощь, а то от фреклмикса уже тошнить начинает.

Бля я щас подумал. Это может быть от расширений? У меня стоит контролнет, экстернал нетворкс, вилдкарды, и еще что-то, что изначально в этом коллабе было. Потому что началась вся хуйня подозрительно одновременно с тем ,как я поставил контролнет и экстернал нетворки.

Насколько low/medvram влияют на производительность и максимальное разрешение?

Есть пример датасета в гайде по лорам https://mega.nz/folder/lMQyDTTB#0XM9piheaxg-a9TI7vuDJQ/folder/8cw2nKbT у многих тут с ними выходили лорки хуже, судя по отзывам

Что ты пытаешься сделать то? Просто генеришь в колабе каком-то? По логу ничего не понятно, кроме того что процесс умер

Да, в коллабе, https://colab.research.google.com/github/ddPn08/automatic1111-colab/blob/main/automatic1111.ipynb

Если есть ссылка на другой, более живой и с поддержкой диска и экстеншонов - буду благодарен

Да, просто генерирую, точнее генерация происходит прекрасно, но вот при попытке сменить модель на другую все умирает к черту. Лога там больше и нет толком, выше сообщения об ошибке только строчка о том, что загружаются веса модели.

Так апдейт. Я поставил медврам и попробовал загрузить модель не-ярлык - ОХУЕТЬ СРАБОТАЛО. Собственно, я думаю, что вряд-ли дело в самом медвраме. Тут как я понимаю с видеопамятью вообще никакой связи. Скорее всего виноваты ярлыки, и это очень удручает. Теперь нельзя иметь централизованный диск хранилище моделек, а придется дрочить десять дисков одновременно.

А нет, сука. Оно сгенерировало одну картинку и сдохло... Сука.

Хз если честно насчет колабов. После генерации картинки вылет, может попробуешь вае перекачать/поменять, ну или для начала хотя бы без отдельного попробовать сгенерить?

Так, без вае не вылетает. У меня стоял старый как мир эни в3 вае, если что. Но у меня и модели старые, так что хз, хз. Спасибо энивей.

Как впасть в депрессию и отчание: 3 часа теггировать датасет и потом понять что у тебя проебалось и поехало всё из-за того что поехали имена файлов из-за разных форматов. Сука.

Да этот пример говно какое-то. Везде пишут и по идее, что регулярки должны быть сгенерены с близким к твоим пикчам промптом/классом, например a photo of dick и мой концепт будет N_mybighui с .txt тегами к пикчам с этим классом и остальными тегами. В этом примере же вообще в тегах нет триггер ворда, раз есть .txt значит из названия папки класс не берётся, а регулярки с этим классом проименованы. Каво нахуй. Или я что-то не понимаю, или в гайдах все пиздят не приводя примера датасета, или что вообще. Если я не еблан, то не удивительно, что у всех с ними хуже получается тупо потому что пример неправильный.

Да этот пример говно какое-то. Везде пишут и по идее, что регулярки должны быть сгенерены с близким к твоим пикчам промптом/классом, например a photo of dick и мой концепт будет N_mybighui с .txt тегами к пикчам с этим классом и остальными тегами. В этом примере же вообще в тегах нет триггер ворда, раз есть .txt значит из названия папки класс не берётся, а регулярки с этим классом проименованы. Каво нахуй. Или я что-то не понимаю, или в гайдах все пиздят не приводя примера датасета, или что вообще. Если я не еблан, то не удивительно, что у всех с ними хуже получается тупо потому что пример неправильный.

Как несколько разрешений повлияет на качество обучения лоры? Что если я в основном обучаю на 1024, но определённый концепт буду тренеровать на меньшем?

Я в любом случае попробую перед тем как тренеровать основную сделать мини версию, но может кто то уже знает

Никак. Кидаю в датесет некропнутые арты произвольных форматов

Если по количеству примерно количество пикч разных разрешений одинаково, стоит ли ставить количество повторений делать разное для них, делая акцент на больших, или похуй

У меня они разделены по папкам только как концепты. Я не сортировал их по размерам

Если у вас часть пикч меньше разрешения обучения (дефолтные 512x512), то не надо нахуй так делать. Если больше то уже вопрос кропа/бакетов, один хуй всё отресайзится под разрешение обучения

У меня стоит 1024 на обучении, туда нельзя пихать разрешения меньше?

medvram у меня давал замедление на 50% при генерации.

16 картинок 512х512 на euler_a.

Только с иксформерсами - почти минуту (56 - 59 секунд).

Иксформерсы + medvram - полторы минуты (1:28 - 1:31).

Как на разрешение влияет не тестировал.

lowwram тоже не тестировал.

Сравни хеши файлов оригинального вае и твоего, который ты подгружать пытаешься, возможно проблема просто в том что он закорраптился

3090/4090-царь шоле

Не пробовал пихать вы высокое разрешение обучения пикчи меньшего, но логика подсказывает что так лучше не делать. На крайняк если пикчи не совсем шакалы лютые руками их апскейлить до 1024x1024+

3060 среднеанон, спасибо, попробую апскейлить, ещё не пробовал запускать с меньшим размером, может вообще пукнет ошибкой что ниже определёного разрешения не буду кушать и тогда точно апскейл, или выбросить и забить

Тоже уже протестил, как-то так вышло:

Time taken: 18.08sTorch active/reserved: 3008/3668 MiB, Sys VRAM: 5669/11264 MiB (50.33%)

Time taken: 22.89sTorch active/reserved: 1734/3074 MiB, Sys VRAM: 5075/11264 MiB (45.06%)

Time taken: 5m 45.17sTorch active/reserved: 1094/1670 MiB, Sys VRAM: 3671/11264 MiB (32.59%)

Технари, поясните за выбор ГПУ. Там нужно на ещё что-то обращать внимание при выборе помимо VRAM? Типа тензорные ядра там или что-то такое?

Уже в шапку можно...

Да, я это сразу нагуглил. Но типа там же 3060 к примеру от разных издателей есть. Вот и спросил на что ещё внимание обращать.

>Но типа там же 3060 к примеру от разных издателей есть

Похуй.

>Вот и спросил на что ещё внимание обращать.

На шину памяти. Больше - лучше, при прочих равных.

Всё понял, добра, анонче!

Вторую не забудь.

3060 с 12 гигами нужна, а то есть и по 8. В этом бюджете 2080ti лучший вар я считаю.

Ага, ага, запарился про эти PCI-E сейчас читать, а то у меня на материнке 3.0, а 3060 на 4.0 работает.

>а то у меня на материнке 3.0, а 3060 на 4.0 работает.

Похуй, хоть 2.0

Там же обратная совмесьимость, как у usb например, зря читаешь, лол. Если не хочешь идти на авито или разоряться на 40 серию, то у тебя 3060 единственный вар по сути.

Мужики, пытаюсь обучить лору, но нихуя не получается, че это такое?

Пути неверно указал, судя по всему.

Должны быть прописаны к папке, в которой уже лежат остальные папки, у которых шаблон названия ЧИСЛО_ИмяКонцепта

Исправил пути, вроде прошло, но вторая ошибка все еще на месте

Ребзя, подскажите че делать с такой ошибкой?

Больше месяца назад тренил лоры с помощью Kohya's GUI по конфиг файлу от Aitrepreneur, а теперь такая хрень. Все что поменялось это Kohya's GUI и дрова обновлял. Как фиксить или придется тупо менять настройки? Если кто пользуется Kohya's GUI поделитесь своими конфигами плз.

Больше месяца назад тренил лоры с помощью Kohya's GUI по конфиг файлу от Aitrepreneur, а теперь такая хрень. Все что поменялось это Kohya's GUI и дрова обновлял. Как фиксить или придется тупо менять настройки? Если кто пользуется Kohya's GUI поделитесь своими конфигами плз.

Вот это уже хз.

Кто в курсе, как в фотошопе избавиться от плавного градиента, при выделении объекта?

Нужна жесткая граница, без полутонов при закрашивание. Чтоб потом latent couple скинуть маску.

Нужна жесткая граница, без полутонов при закрашивание. Чтоб потом latent couple скинуть маску.

Благодарю, местный Анон очень отзывчивый, добра.

Размытие выделение в верхней строке есть.

Но оно там вообще небольшое, порядка полупиксела по умолчанию вроде.

Можно еще когда маску сделаешь "Порогом" пройтись или "Постеризацией". Зашарпит так, что порежешься =)

Как та штука называлась, которая позволяла более гибко для LatentCouple зоны забивать? Не прямоугольниками этими дурацкими, а "пятнами", как нарисуешь.

Тебя чел немножко наебал, выбирай серию карт по производительности и +- цене, а потом селись в хардваче на пару дней, там тебе за большинство вендоров пояснят.

Алсо из неочевидного: 3060 медленнее для сд чем 2060с.

Алсо накидывание говна на хардваче никто не отменял, держу в курсе, будь готов выуживать истину.

Анончики, буду задовать несколько глупых вопросов.

1. Что лучше для обучения на одну тян? Лора или Дримбус? (4090 как-то у меня оказалась, так что могу и то и то, вопрос, что подойдёт лучше)

2. Лору можно подключать к разным моделям? Как VAE? Т.е. смогу еблет ЕОТ кидать в разные стили?

3. И самый важный вопрос. Какой положняк по апскейлером по умолчанию. Reesgan4 до сих пор стронг, или есть что-то сильно лучше?

1. Что лучше для обучения на одну тян? Лора или Дримбус? (4090 как-то у меня оказалась, так что могу и то и то, вопрос, что подойдёт лучше)

2. Лору можно подключать к разным моделям? Как VAE? Т.е. смогу еблет ЕОТ кидать в разные стили?

3. И самый важный вопрос. Какой положняк по апскейлером по умолчанию. Reesgan4 до сих пор стронг, или есть что-то сильно лучше?

Дримбут позволяет большее разнообразие во внешности и ракурсах сделать, поэтому варианты могут варьироваться от не очень до суперпохожих, но натуральных. Как человек один на фотках выглядит разно, но в то же время это один человек. Лора высирает "пластиковое лицо", которое легко можно получить элементарным фейс свапом неудачной внешки после того же дримбута. Единственный минус - размер, но не похуй ли.

Да можно не спрашивать, а брать гигабайт игл. Сильно переплачивать за охлад нет смысла.

Спасибо, потраю оба варианта.

>2. Лору можно подключать к разным моделям? Как VAE? Т.е. смогу еблет ЕОТ кидать в разные стили?

>3. И самый важный вопрос. Какой положняк по апскейлером по умолчанию. Reesgan4 до сих пор стронг, или есть что-то сильно лучше?

Остаються в силе.

2. Сможешь. Я свой кидал во все, сам собой не налюбусь. Не то что в зеркале.

3. Видел для ИРЛ такой хвалили, сам не юзал 4x_NMKD-Superscale-SP_178000_G

А так Валар и Ремакри

Какой апскейлер юзать для изображений на которых хочу тренить, но не подходят по размеру, там чистое аниме, valar или resergan anime ? Или вообще что то другое?

Аноны, кто нибудь пробовал DAdaptation юзать? Попалось в этом гайде https://rentry.org/59xed3#dadaptation , пробовал оттуда параметры, результаты пока непонятные.

Я вот думаю, можно ли как-то сделать так, чтобы выделенное в промпте по нажатию кнопки обрамлялось скобками и добавлялся вес? мастерипись -> (мастерпись:1.5)

contrl+ стрелочка вверх

Воу, спасибо, даже лучше чем я хотел работает.

Как-же эту лору ебёт. Эти ваши скрипты и кохуягуи ничего кроме тренировки на анимэ2Дтёлках не умеют?

Ты клипскип 1 выставил?

да. вот пик1 с клипскип2, не лучше. конкретно эту лору тренил на первом клипскипе, до этого тренил на втором - ломает так-жепик2. мб из-за ебнутого дефолтного лёрнинг рейта в кохуягуи(юзаю впервый раз) 5e-5, хотя вчера пытался на нормальном скрипте тренить с 1e-3, на котором нормально тренил все свои анимэ лоры пик3

вообще хз куда двигаться, в последний раз такие артефакты видел когда несовместимые модели смешивал, которые были разных эпох с разными клипскипами

> Лора высирает "пластиковое лицо"

Хач, ты заебал. Не умеешь делать - не пизди, иди пиши свои ролики по пятихатке и трень гиперсетки, ведь большее ты не осилил.

Newtork Dim 32/64. Alpha в два раза меньше. Можно всё 128/128 поставить, нихуя страшного не случится. По дуфолту у него 8/1, для фото не подходит, может только для анимеговна. Остальное всё по умолчанию - косинус, лёрнинг рейт вот это всё нихуя не трогай, всё как есть у Кохуи оставляешь и бьёшься в кайфе. И да, у тебя очевидный пережёг, попробуй для начала в два раза уменьшить количество проходов.

Спасибо за совет, завтра попробую. Но я чутка напиздел - у меня не дефолт настройки были, а оптимизированный json от какого-то додика с ютуба для карточек на 6гигов vram.

В итоге я накрутил до такого https://pastebin.com/msFxqgdP

В основном всё совпадает, кроме network_dim": 128, но эта шляпа, как я понял, тупо на вес лоры влияет, так что похуй, больше - не меньше. По пережегу возможно, но бле, 1600 степов на 16 картинок и так по базе самый минимум, впервые тренил лоры всего за полчаса, да и при генерации на малых весах лоры лицо сильно не морфит, как надо короче, ебало не ломается.

Возможно. Но я наконец разобрался в проблеме - оказывается, какого-то хуя при подгрузке моделей с ярлыков с гугл диска требуется НАМНОГО больше оперативки, чем при подгрузке напрямую с подключенного диска. Вот хуй знает почему. И в итоге просто крашается из-за недостатка оперативной памяти. К сожалению придется ебаться с моими шестью гугл акками по-отдельности, или собрать пару моделей, которые использую больше всего, на один из дисков. Мейби пробовать загружать напрямую в память колаба, но это ебля ужасная с моей скоростью загрузки.

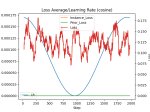

100 проходов на картинку это много, можно уменьшить в два-три раза. А лучше смотри, что там в тензорборде. Кнопочка внизу гуя запускает и открывает окошко в браузере. Ищи момент где шло вниз, до подъёма, Примерно в этом районе твоя цель.

Ну вроде как раз. Могу конечно на 400 степах словить, но это рофл полнейший будет

Тогда ковыряй Network Dim / Learning Rate

400степов, всё ещё вермишель. Рили надо лернинг рейт ковырять, мб даже альфу на 64 поставить

У тебя что за видяха? В конфиге Gradient checkpointing и Memory efficient attention можно вырубить, а батч сайз увеличить. Если это не какой-то спец конфиг под мало ВРАМ у тебя.

Что за гуй?

мимо анон

2060 6гб. батч сайз 2 точно не вывезет и так впритык.

На дофотл настройках без

>спец конфиг под мало ВРАМ

сыпит ошибками и отлетает.

https://github.com/bmaltais/kohya_ss

Альфа 64 и 254. всё ещё не понимаю чо оно делает

Найс, спасибо

256 точно перебор, пробуй D128/A64

Глаза странные, ты генеришь и тренируешь на одной модели?

Ну че, погнали https://rentry.org/2chAI_easy_LORA_guide

Проверяйте работают ли ссылки, пикчи, ошибки и т.д.

Есть еще довольно немало материала по сравнению различных подходов к обучении, разных альфа, дим, bs, lr, шагов и прочего, можно будет потом добавить

>пробуй D128/A64

Этот гуи не даёт выбирать dim, а ровняет его к альфе или это я слепой и не нашел крутилку

Dim - это вот это?

Треню на sd1.5, f генерю на shittrinberrysamf222.safetensors[ffd1dc3d30]

Просто по тому, что фотки лучше обучались на SD, но сама сд генерировает говняно как на пик2, а около аниме делают немного лучше.

Успел попробовать 1e-3 и 4e-4 - на 400степах выдаёт ультраговно.

>пробуй D128/A64

Пик 3. По-моему в сравнении с d128\a128 стало хуже

Найс, я как раз собираюсь сам вкатится в эти ваши лоры. Кстати реально ли научить ее стилю из лабиринтов в Мадоке?

Да, оно. Проставь цифрами, может глюк какой, при старте посмотри параметры в консоли, что точно применилось.

И попробуй тренировать на той же модели. Ну или генерить, на какой тренировал. (хотя SD1.5 уже пора на покой, мне кажется).

В теории офк возможно, на практике как это тегать и поймет ли это модель? Попробовать в любом случае стоит, датасет собери. Если клип часть слабее обучать или при использовании подурезать то может даже сработает простая стилизация.

SD это база. Да и хотелось повторить удачную дримбут модель, которая была на сд и впоследствии смерджена с моделью на которой генерирую. Ну а так обучать надо на 2.1 модели и 728 пикселях минимум, только вот гигов не хватит

Обучил на той-же модели, на которой и генерирую - стало выдавать результаты уровня sd1.5. Теперь я точно нихуя не понимаю.

Начну в любом случае с чего-то попроще, тоже нет идей какие тут должны быть теги

Хера ты бахнул, сначала скрипт запускается в гайде, потом собирается датасет.

Одну немаловажную вещь забыл, необходимо много системной памяти, будть то рам или своп, тут были такие, кто не мог запустить тренировку и получали разные ошибки.

Кстати, там же можно вроде как то только основные теги сохранять, без меты всякой типо абсурдрез или худождикнейм, во время сбора датасета, знаешь как это делать? Понятно, что можно потом теггером потереть, но это куда дольше.

Имхо, аскотест слабо затронул, датасет там где то валяется в гайде, но абсолютно не привлекает внимания, сделал бы шафл токенс 0 и сид какой нибудь там 1337228, с финальным результатом, чтобы кому надо повторил и проверил правильность работы тренировки.

Еще кстати мало альфу затронул, прошлый гайд хорош, но постепенно уже устаревает, в этом стоило бы именно затронуть тему с 0.4.0 и этой ебучей альфой, в прошлый раз ты какой-то дженерик стиль хуй отличимый тренил, но на большой альфе бледность лиц художника стала больше заметна, попробовать бы с узнаваемым, попозже займусь и покажу результаты, если хочешь. Как раз хотел углубиться в параметры, и отличия версий почитать, имея уже небольшой опыт в этом, но пока дела появились.

А так хорош че, спасибо, лисю твою тебе в наи запощу за труды, полюбуйся хоть зайди.

Проверял бы сначала без хуйдожников в промте, чтоб получалось что-то усреднённое по датасету, когда будет как живая - лепи дальше что хочешь.

Да, сам допер. Сначала небольшой экстенд выделения, по необходимости, потом в режим маски и применить постеризацию минимальную.

Такая маска без лишних зон воспринимается расширением и с фоном охуенно взаимодействует.

Есть встроенный приоритет по цветам B - G - R, стоит учитывать, когда от прямоугольников к маске переходишь, чтоб промты не переделывать.

Представление: компудыхтер рисует красивое по одной фразе

Реальность: сырые костыли, десятки ползунков и необходимость держать в голове характеристики моделей.

Моё ебало, когда поставил Network Alpha = 1

У меня сейчас задача избавиться от вермишели. хуйдожники на неё не влияют, а раз уж начал тестить с одним промтом и сидом - нет смысла менять.

Увидел бы ты насколько хуёвый датасет я собрал...

У меня сейчас задача избавиться от вермишели. хуйдожники на неё не влияют, а раз уж начал тестить с одним промтом и сидом - нет смысла менять.

Увидел бы ты насколько хуёвый датасет я собрал...

покажи датасет тренировочный

мимовкатывальщик

> сначала скрипт запускается в гайде

Ага, сразу в бой. В начале же ссыль на готовый датасет есть, офк он не супероптимален, но в целом работает. Плюс это позволяет избежать всех ошибок из-за косячного датасета и на раннем этапе отследить что что-то не работает в самом скрипте без лишних выяснений.

> необходимо много системной памяти, будть то рам или своп

Во, дело говоришь, офк там в коде ошибки пишется о том что нужно увеличить пейджфайл, но хлебушек может не разобраться, добавлю

> Кстати, там же можно вроде как то только основные теги сохранять, без меты всякой типо абсурдрез или худождикнейм, во время сбора датасета, знаешь как это делать?

Даже не интересовался, написал простой питон чтобы лишнее удалял в один клик, ну и пройтись самому пара минут. Если способ опишешь - буду благодарен

> датасет там где то валяется в гайде

В самом начале капсоболдом, но стоит продублировать, да

> сделал бы шафл токенс 0 и сид какой нибудь там 1337228

Они же потом так и будут тренировать с такими настройками, шафл всеже лучше. С точки зрения воспроизводимости - абсолютно верно, вот только реально ли вообще, ведь еще как минимум xformers может насрать. Попробую потестить, если будет получаться воспроизведение - можно добавить.

> Еще кстати мало альфу затронул

Базовое дано, мнения упомянуты, можно еще выделить синеньким. Для большего надо кучу примеров, свалку гридов лучше потом в конце или отдельным, они так-то есть. Если конкретно по тексту и формулировкам предложения есть - велкам

> прошлый гайд хорош, но постепенно уже устаревает

Не не, к нему есть 3 серьезные претензии:

- неоче структура, про которую уже кучу тредов пишут и хотят исправить

и дримбус через ватоматика, и лора через скрипт, в начале зачем-то втирается про патч модели(!) , и один датасет, и тут же к нему другой с какой-то странной структурой, в одном надо кропать и чето писать, в другом не надо но давать ИМЕНА КОНЦЕПТАМ и это все описано рядом подряд. Сам запуск тоже с отсылками в другую часть на незаметные ссылки, а про многие очевидные проблемы упомянуто вообще в конце

- гриды, в них нихуя не понятно, тянки и какие-то заросли в разных концептуальных стилях, толи там плохой результат, толи автор наоборот этого добивался

- нет предложения настроек тренировки а значения в гридах не менялись с версии 0.3.х

Так то когда разобрался он уже выглядит неплохим, и его неоспоримая заслуга что он есть (ссылку на него алсо добавлю, таки многое разжевано полезно), но при прочтении в первый раз даже с неким багажом знаний по нему что-то сделать невозможно без помощи со стороны.

> попозже займусь и покажу результаты, если хочешь

Хочу, самому же интересно, это все пишу не потому что дохуя знаток а потому что никто не делает

> и отличия версий почитать

Там новый оптимайзер помимо адама добавили, говорят оче годный но надо тестировать, а так много оптимизаций, быстрее работает, лоры на выходе +- такие же

Что за ввермишель?

Если причёска не описана и при этом разная на фотках - с волосами может быть любой хтонический пиздец. Сетка смотрит на все причёски персонажа сразу и прикидывает что это и как это запомнить. Если цвет не меняется и не собираешься менять - можно не писать, но длинные/короткие/собраны/растрёпаны - лучше добавить в тег, потом всегда сможешь вызвать нужную причёску.

В текстах лично хуйню всякую прописал типо никнейм, 1girl, smiling и т.д.

Макароны в волосах и на фоне как тут

Пиздос

Но это стиль художника, нет?

>лично хуйню всякую прописал

А прогнал бы через таггер, хоть в СД гуя автоматика, хоть кохуя_гуи и был счастлив. Тем более у тебя датасет небольшой.

Возможно. Но не того, который в промте.

Так таггеры эти бред генерируют. Мне быстрее было самому прописать, чем фильтровать. Тем более, что в датасете картинки почти все одинаковые и можно вообще без тегов обойтись.

Хорошо, что ты этим занимаешься, а не девочек в лесополосе насилуешь. Знаю я таких, как ты. Ночной кошмар любого следователя.

Сейчас такие девочки, что лучше уже сразу следователей насиловать.

Ты на 0.5.0 кохье тренить пытаешься? Интересно получится если да и он опять все поломал и надо заного искать удачные параметры

> Даже не интересовался, написал простой питон чтобы лишнее удалял в один клик, ну и пройтись самому пара минут. Если способ опишешь - буду благодарен

Как буду собирать на какого то художника постараюсь разобраться как раз

> Они же потом так и будут тренировать с такими настройками, шафл всеже лучше. С точки зрения воспроизводимости - абсолютно верно, вот только реально ли вообще, ведь еще как минимум xformers может насрать. Попробую потестить, если будет получаться воспроизведение - можно добавить.

Я не говорю что это надо использовать постоянно, именно ради воспроизведения, на уровне отличия иксформеров может воспроизвести, чекай прошлый с постом на кокоро, я там расписывал как делал

> Хочу, самому же интересно, это все пишу не потому что дохуя знаток а потому что никто не делает

Надо со стилем определиться, вот там повыше вроде интересный, только сомневаюсь что его можно так просто с бору собрать, да и по примерам трудновато такое будет натренить, много слишком лишнего как по мне

> Там новый оптимайзер помимо адама добавили, говорят оче годный но надо тестировать, а так много оптимизаций, быстрее работает, лоры на выходе +- такие же

А с 0.5.0 кохьей в итоге как там?

Ладно, если так нихуя и не получится отпишись, завтра попробую её сделать. Глянул, фоток в сети достаточно. Ну или свой датасет скинь.

>Ты на 0.5.0 кохье тренить

Хз на какой, но буквально сегодня гуи поставил

>он опять все поломал

Тут скорее я еблан

у самурая нет цели только путь

> А с 0.5.0 кохьей в итоге как там?

Хз, я перед обновлениями опенсорца обычно жду пару дней и смотрю багрепорты. Посмотрел и решил не спешить, тем более сам автор о крупных изменениях говорит.

> Надо со стилем определиться, вот там повыше вроде интересный

Ты про Мадоку? Он ахуенен да, но сложно с тегами. Хотя по тем трем пикчам может и ничего, с этим наверно и wd справится

> чекай прошлый с постом на кокоро, я там расписывал как делал

вут?

Охуенен. Нет других слов.

Пиздец, заметил что куда 11.3 стоит и решил обновиться до 11.6

Все лоры поехали

Все лоры поехали

Бля, походу реально хуйдожник-пидарас в промт затесался и говном своим подсирал. Ну хоть тред чутка повайпал, а то тухловато тут было Хотя без него фулл боди генерировать лучше не стало

> вут?

Повторяемость есть у лорок с одним сидом и офф шафлом, на уровне иксформеров, хеш другой, можешь конечно и сам проверить, может это случайность

> Хз на какой, но буквально сегодня гуи поставил

В папке с сд-скриптс консоль открой и пропиши git log там дату покажет, заодно и хеш коммита. Все таки лора норм получилась, я так понимаю

Как сгенерирую мегагрид с десятью надюпанными лорами - посмотрю

>Все таки лора норм получилась

Как минимум надо ещё попердолиться в диапазоне 1е-5 - 8е-5 Text Encoder learning rateов и заменить главный токен с никнейма этой чиксы на менее узнаваемый, так как из-за имени генерирует гоблинов с анимэ глазищами

> Есть мнение что долгие обучения на низких лр позволяют получить наилучший результат а подобный подход хуев - пруфов этого мы так и не увидели, есть лишь обратное, однако ты, анон, можешь взять и сам сравнить.

Пару дней назад проводил эксперимент на эту тему. Для одного и того же датасета сделал две модели с разными параметрами - в v8 lr уменьшен в 10 раз, а число повторов по всем концептам наоборот увеличено в 10 раз, сравнительно с v7. Одна модель обучалась два часа, другая 20 часов.

Я лично для себя не заметил какой-либо значительной разницы между ними. Надо переходить на нормальный нейминг файлов моделей, а то я сам скоро забуду, чем они отличаются.

Хз чо эти буковки тебе дадут. Но все эти говнолоры я делал через гуи пик1 после того, как у меня с первой попытки получилось ультроговно на сдскриптс пик2

В гуй где выставляется размер и альфа?

Ух, а вот у тебя случай сложный, полагаю много чего намешано. С Шимкой попробуй прогнать, получается также или что-то иначе? Для тестов хотябы.

Так еще суть в чем, окрестность в которой проходит обучения может быть довольно таки широкой, а большой батч сайз смягчает поломку на долгом обучении. Вот тебе большой грид с 5e-4, результаты для лр в 10 раз больше в гайде есть. Тут по сути после 10й эпохи ничего уже не меняется в этих пикчах, хотя орижинал костюмы достигнуть не успело, а если сравнивать их в других промтах то проблемы сразу вылезают, особенно с фоном и штамповкой одинаковых пикч, косящих под датасет. Для BS=2 хорошо видно как ломается Есть и с меньшим лр, там суть вся та же только похожесть меньше, эту хоть вполне можно отнести к положительному результату.

Тут аргументов против долгого медленного обучения дохуя привести могу но таки стоит больше потестить и может найдется нюанс, который все объясняет.

Попробуй развернуть грид по эпохам, все станет на свои места.

> Одна модель обучалась два часа, другая 20 часов.

Ахууууеть, завидую твоей целеустремленности, я с 25 минут обучения на батчсайз 2 горел

А папки с папками гуй воспринемает?

Листал раздел наткнулся на пикрил, можно промпты модель настройки на эту тян?

wget в помощь.

Ещё бывает

!nohup wget ... -O ...

Топ тема. Модели ставишь загружаться - а пока оно качается, ставишь сам поломатик. Благо подгрузка модклей на лету

>Надо переходить на нормальный нейминг файлов моделей, а то я сам скоро забуду, чем они отличаются.

Последние скрипты и гуй пишут параметры обучения в метаданные лоры, можно через Additional Networks их из автоматика смотреть.

Как это вообще интерпретировать, котаны? Есть гайд?

Здесь по пизде пошло.

и чё делать? это прогон 35ти эпох были с 0,0002 unet LR был

Чем отличается dreambooth от fine tuning? Второй вроде как лучше, но дольше и нужно больше памяти?

Произошел троллинг от гуи. Все лоры обучались без подхватывания .txt файлов судя по графикам. В последнюю лору токены подсосались, но при вызове главного кастомного токена на персонажа "polumna" - генерирует собак. Но генерирует персонажа при токене "luna lovegood", который был в первой версии .txt файлов и больше нигде. Как чинить?

Руская смекалочка починила проблемку + вот как простая смена токена помогает от лупоглазия.

Осталось только лору нормально обучить.

Версия все таки важна, это же опенсорс экспириенс, когда может выйти новая версия и поделить все на ноль. Все таки не 0.5.01, а разве этот гуй не очередная обертка для сд-скриптс, только веб версия? Не пользовался им

Почему просто уникальный токен не вписать в начало и не шафлить его? https://github.com/2kpr/dreambooth-tokens/blob/main/all_single_tokens_to_4_characters.txt

Кстати, если уже есть удачный дримбут, то можно вроде из него просто лору извлечь, только не помню где видел как это делать, пробовал?

>Почему просто уникальный токен не вписать в начало и не шафлить его?

Хз чо такое шалфить, но вроде так и делаю.

>удачный дримбут, то можно вроде из него просто лору извлечь,

Да, пробовал. Двумя инструментами через тот-же гуи для тренировки лор и через экстеншон для автоматика supermerger чото там и с двух версий дримбута - чистую и смердженную с красивой моделькой. Во всех случаях, очевидно, получилось говно т.к. удачную дримбут модель я обучал так-же как и все эти лоры.

Я ещё, как еблан, все гриды генерил с хайрезфиксом, которым даже не пользуюсь.

Вот ещё в последнем гриде словил пикчу, которая отдалённо напоминает пикчи с микса дримбут и модели на которой это сгенерировалось

Прикольно, что в GUI можно online отслеживать обучение LORA. Только вот если бы была кнопка с остановкой этого обучения в нужный момент - было бы ещё прикольнее.

аноны вы же программисты. я сейчас лежал думал над чатом гпт. там есть fine tuning модели на основе массива { вопрос, ответ }, но он занимает около двух часов там написано. файн тюнинг это другая тема, которая не юзает лимит токенов. т.е. получается у нейронки есть два вида памяти - веса нейронки, которые меняются только после файн тюнинга, т.е. это долгосрочная память + токены, которые являются краткосрочной памятью. если мы будем файн тюнить нейронку после каждого сообщения, то у неё не будет лимита по токенам получается и она будет помнить всё? и типа во внутренних серваках опенаи уже работают с нейронкой с долгосрочной памятью получается? т.е. у них уже гига машина есть по типу вики из я, робота?

а не туда написал это стабле диффузион

Что мешает делать тренировать в несколько эпох и оставлять нужную?

>она будет помнить всё?

Нет.

/question

question/ Почему?

Очевидно, при тренировке на диалоге "Анон, нам негде жить" "Хуёво, давай купим дом" бот на вопросы "Где мы живём" Начнёт отвечать в духе "Хуёво, давай купим дом", а не то что ты хотел.

/question

> Хз чо такое шалфить, но вроде так и делаю.

$shuffle_caption = 1 в конфиге, перемешивает каждое повторение теги на пикче, чтобы оно по старшинству не запоминались

Тестовые гриды делать с хайрезом долго слишком, и почему кстати так мало денойза, даже несмотря на пиксельный апскейлер? Такие значения уже приходится ставить только если несколько контролнетов + несколько лор + много разделений тушотом

> питон

Ты питонист опытный вообще? Хочу прежде чем начну копаться в нововведениях и сравнениях альфы для стиля допилить хгуй для лоры, который не браузерный, добавив в него старт тензорборда галочку и выбор оптимайзера.

Оптимайзер наверное просто будет, я хз.

А вот старт тензорбоарда наверное потребует дополнительного процесса с командой для консоли и проверки на дурака, если в очереди будет стоять несколько лор, чтобы не запускался каждый раз тензорбоард.

Что там еще из нового, только оптимайзер же?

Тебе наверное эту херню 5 минут написать и собрать, поможешь?

question/ Почему это неправильный ответ? Просто закрепится инфа, что дома нет, и смежные ответы будут с этим контекстом генерироваться. В нейронке же не прямо хардкодится вопрос ответ, а подбираются веса, которые наиболее близки ко всем тренировочным данным, т.е. ко всему диалогу, т.е. он просто будет помнить весь диалог любой длины, т.е. нейронки уже как человеки, и единственное, что останавливает от выката их в массы - ответ раз в два часа. Можно даже оптимизировать и типа когда лимит токенов заканчивается, то попросить нейронку сделать саммари из диалога, описать самое важное событие тремя словами, а потом уже этим событием тренировать.

Хотя я понял, что это уже везде и юзается, как, например, в чарактер.аи. Там же чем больше диалогов у бота, тем он умнее. Просто разрабы выбрали вариант не тренировать на raw диалогах, потому что тогда нейронка будет знать конфиденциальные данные на всех. Они юзают только лайки и дизлайки, чтобы тренить только характер самой нейронки, т.е. половину от возможного функционала. А в реальности на локальных серверах эта нейронка знает всё про всех.

>Просто закрепится инфа, что дома нет

Ага, после того, как его купили. Так что...

>т.е. он просто будет помнить весь диалог любой длины

Хуй там плавал.

>чарактер.аи. Там же чем больше диалогов у бота, тем он умнее

Ебать ты верующий в маркетинговые заявления.

/question да когда же он закроется?

там Хруст выпустил видево по Лоре, попробуй, может у тебя получится по его напутствию сделать. У меня получилась какаха. Ща буду пробовать по своим канонам делать, посмотрим, кто из нас двоих просветленней.

Если хочешь писюнами меряться - вот все мои лоры. Почти все сделаны с первой попытки и на стандартных настройках.

>там Хруст

Загуглил этого, промотал всю воду и отступления и в итоге, по параметрам, ничего нового он не привнёс. Тупо гайд по лоре в видео формате

Я не с тобой собрался меряться же, а с ним.

>Хруст

Ебать, кто-то реально слушает этого хача?

А, ну тогда ясен хуй ты. Даже мерять не надо, любой анон итт прошаренее этого ебла.

Кто-нибудь разобрался, чем отличаются обычные лоры от всяких Locon, Loha и Lycoris (или как их там)?

И можно ли их как-то между фораматами конвертировать? Пусть даже без сохранения каких-то особых фичей (если они там вообще есть).

Хочу несколько лор разных типов смерджить, а гуй не дает, ругается ошибками.

И можно ли их как-то между фораматами конвертировать? Пусть даже без сохранения каких-то особых фичей (если они там вообще есть).

Хочу несколько лор разных типов смерджить, а гуй не дает, ругается ошибками.

делибирейт хуйня полная, как и гайд (начал бы делать стилизованные сложные фото - вся ограниченность сразу вылезла бы). на 1.5 живых людей гораздо лучше обучать.

Да и один проход я пока не смог получить пиздатый результат. Несколько дообучений с понижением рейта дает лучшую проработку (суммарно где-то 180 повторений). Хотя алгоритм даже для своего случая я пока выявить не смог. Но только несколько дней ебусь.

> Хруст выпустил видево по Лоре

Сильнее зашквариться хач не мог, рыдал в голосину с его видео, где он не указывает папку с логами и удаляет папку с семплами, крича что это разраб насрал. Мразь тренирует на РАБОЧЕМ СТОЛЕ, это просто пиздец. Путает параболу и косинус. И он ещё что-то продаёт в платных каналах? Как же низко мы пали.

Воу-воу, просто ставь cosine и проходов на один раз, примерно сколько тебе надо почувствуй. И не надо никаких дообучений, оно само понижает ЛР и делает это плавно и красиво.

Тест влияния большого батч сайза на тренировку, заодно по совместительству проверка дохлых тензоров, коммит сд-скриптс feb 11 b32abdd327f314fabc76fbbb627218090afb7b69 дефолтные настройки для 0.3.0 кохьи: D128/A128, shuffle=1, сид залочен.

V12 - batch 1, 1e-4. Ну просто рабочий сток, что тут еще сказать. Проверил тензоры, скрин компейра слева Д128/А128, справа Д64/А32. И там и там встречаются дохлые вторые значения 0.0. Поиск по 0.0\r\n Д128/А128 count = 187, Д64/А32 = 126. Еще скрин сравнения лоры 64/32 с 16/1, там таких значений куда меньше - 15. Это значение кстати включая поиск по последнему выключенному слою те, который вообщем то и должен быть 0.0 при клипскипе 2, примерно 6 значений во всех подсчитанных ранее правильные, так что можно из них вычитать это число, посчитал сам и оно может быть неправильным.

Судя по логу апдейтов кохи

> Noe the script shows the mean of the absolute values of the weights, and the minimum of the absolute values of the weights.

Первое число это среднее значение весов в слое(?), а второе минимальное, то есть в этом слое присутствует дохлый тензор.

V13 - batch 12, 2e-3. Как и советовали умные дядьки лр увеличен во столько же раз, во сколько и батч сайз. Результат - смэрть, лосс сразу перевалил за 0.5

V14 - batch 12, 6e-4. Половину лра от рекомендуемого умными дядьками, popierdolilo, но не полностью сожгло, никуда не годится.

V15 - batch 12, 1e-4. Вообще не измененный лр, только батч. Приемлемый результат, но по такой маленькой выборке виден недотрен по сравнению с батчем 1

И чего, и как тренить с таким батчем, ведь умные дядьки не могли соврать насчет лр, правда? Понятно дело, что при альфе 1 и 2е-3 покатит, не раз уже подтверждалось, но это увеличение связано именно с уменьшением альфы, но не увеличением батча.

V12 - batch 1, 1e-4. Ну просто рабочий сток, что тут еще сказать. Проверил тензоры, скрин компейра слева Д128/А128, справа Д64/А32. И там и там встречаются дохлые вторые значения 0.0. Поиск по 0.0\r\n Д128/А128 count = 187, Д64/А32 = 126. Еще скрин сравнения лоры 64/32 с 16/1, там таких значений куда меньше - 15. Это значение кстати включая поиск по последнему выключенному слою те, который вообщем то и должен быть 0.0 при клипскипе 2, примерно 6 значений во всех подсчитанных ранее правильные, так что можно из них вычитать это число, посчитал сам и оно может быть неправильным.

Судя по логу апдейтов кохи

> Noe the script shows the mean of the absolute values of the weights, and the minimum of the absolute values of the weights.

Первое число это среднее значение весов в слое(?), а второе минимальное, то есть в этом слое присутствует дохлый тензор.

V13 - batch 12, 2e-3. Как и советовали умные дядьки лр увеличен во столько же раз, во сколько и батч сайз. Результат - смэрть, лосс сразу перевалил за 0.5

V14 - batch 12, 6e-4. Половину лра от рекомендуемого умными дядьками, popierdolilo, но не полностью сожгло, никуда не годится.

V15 - batch 12, 1e-4. Вообще не измененный лр, только батч. Приемлемый результат, но по такой маленькой выборке виден недотрен по сравнению с батчем 1

И чего, и как тренить с таким батчем, ведь умные дядьки не могли соврать насчет лр, правда? Понятно дело, что при альфе 1 и 2е-3 покатит, не раз уже подтверждалось, но это увеличение связано именно с уменьшением альфы, но не увеличением батча.

Еще грид без бекграунда

> проверка дохлых тензоров

А это лоры в fp16 или bf16? А то может быть...

мимо

Все fp16

> без рук

Пофиксил.

Было бы интересно сравнить по нулевым тензорам в bf16.

> bf16

Чел, bf16 нигде кроме TPU не нужно. Разницы для обучения с fp16 нет никакой.

Так у bf16 ренж как у fp32 и в андерфлоу он выпадает намного реже чем fp16 же.

Дело говоришь, попробовал, count = 6, то есть дохлых тензоров нету, прямо вообще. Д128/А128

> ренж как у fp32

Нет, это динамические fp16, с ним просто fp32 местами используется, он для совместимости с TPU сделан.

А для нормальных градиентов надо использовать скейлер, а не просто автокаст. Даже в документации к торчу написано не использовать автокаст для обратного прохода, но в ваших лорах зачем-то делают это. Со скейлером нет никакой разницы в качестве обучения между fp16 и fp32.

>но в ваших лорах зачем-то делают это

Покажешь, где посмотреть и менять?

> Нет, это динамические fp16, с ним просто fp32 местами используется

Каво? В смысле нет? Ну и ты только что миксед пресижн, что как с fp16, так и с bf16 можно.

Это не ты говорил что с 8 бит адам градиенты по пизде идут?

Выше пролистай, есть ссылка

> Ты питонист опытный вообще?

Поверхностно знаю, хотя с чем сравнивать

> Тебе наверное эту херню 5 минут написать и собрать, поможешь?

Попробовать то можно, но я не кодер и с этим не работал, не факт что будет польза

> Что там еще из нового, только оптимайзер же?

Судя по значениям у тебя там фп-16, наглядный пример преимущества бф16 получается прямо

> Д128/А128

Там при 5e-4 уже страшно пережаривается и распидарашивает, в наи гриды были, могу притащить

> V15 - batch 12, 1e-4. Вообще не измененный лр, только батч. Приемлемый результат, но по такой маленькой выборке виден недотрен по сравнению с батчем 1

А промежуточные между 1 и 6 значения не смотрел?

Таки почему ты так не хочешь альфу1? Наглядное сравнение оптимальной лоры на ней с оптимальной лорой на =дим можешь показать? Тема ведь интересная.

В ближайшее время попробую разобрать свалку гридов с разными альфами в том числе, надо разбираться.

У const_v1 и const_v2 одинаковый сид и отключено перемешивание токенов. На эталон не тянет но по тому же сиду сравнивать можно. Сейчас почищу и добавлю.

> ты только что миксед пресижн

Так вот bf16 - это всегда он. По скорости он обычно хуже чем нормальный fp16 со скейлером. Ну и bf16 не спасёт от NaN если автокастом ебашишь. Вот из документации, но в лорах автокастом обернули вообще всё.

> Судя по значениям у тебя там фп-16, наглядный пример преимущества бф16 получается прямо

Еще какой, хорошо анон подкинул идею

Потестил еще save_precision fp32 + mixed_precision fp16, выдает тоже нормальную лору, но весит она естественно в 2 раза больше.

То-есть можно будет и на старых картах использовать такие лоры, без бф16 для 3000+, только весить они будут слишком много, хз правильно ли я вообще параметры расставил, в этом гуе mixed_precision выше fp16 нету, скрипт вообще понимает такое значение параметра?

> Там при 5e-4 уже страшно пережаривается и распидарашивает, в наи гриды были, могу притащить

Тащи конечно, я вот понял что увеличивать лр как минимум в такое же количество раз не нужно.

> А промежуточные между 1 и 6 значения не смотрел?

Нет, вот эти две сделал с обычным 1е-4 и батчем в 10, они более менее нормальные, можно конечно что-то типо 3е-4 поставить наверное и будет норм. Бтв шафл включен, но все равно большинство пикч повторяется.

>Таки почему ты так не хочешь альфу1? Наглядное сравнение оптимальной лоры на ней с оптимальной лорой на =дим можешь показать? Тема ведь интересная.

Я пока не собрал датасет на стиль, завтра планирую как раз, отложу пока допиливание гуя. Могу лишь старый пример скинуть, но там тесты не каноничные, без залоченных сидов, с шафлом, не на одинаковых настройках

Кстати проблему с черным канвасом я уже идентифицировал, это наи вае такое выдает периодически при генерации, хз насчет дальнейшей тренировки вместе с ним.

Ну вот не улавливает низкая альфа стиль, хоть убейся, все остальное получается, форма лица, одежда, мимика, окружение, остальные аттрибуты, но стиль хуй и всё тут. Надо перетестивать короче, если уж на то пошло, можно и старый датасет раскопать, он уже отфильтрованный ведь. С низкой альфой заебись тренить просто персонажа без влияния на стиль, вот что могу сказать, просто охуенно, ничего лишнего не присасывается.

> То-есть можно будет и на старых картах использовать такие лоры

Ты только учитывай что это потребует дохуя большего объема врам, а ее в старых картах и так не густо совсем. То что весят много это вообще ерунда.

> в этом гуе mixed_precision выше fp16 нету

Который вебинтерфейс? лол

> я вот понял что увеличивать лр как минимум в такое же количество раз не нужно.

В такое же - абсолютно нет. Вот сейчас вглядываюсь и пытаюсь интерпретировать, на одном сиде прямо явно выражено что на бс2 гораздо ближе к оригиналу чем бс12 где похоже на недотрен, но смотришь на соседний - уже нихуя. Всеже если разница присутствует то для батчсайзов под 20+ гигов врам она составляет 1.5-2 раза от силы по сравнению с 1-2. Потому в примерах дефолтными и были выставлены значения 2e-3 и 3e-3, уж вероятность поломаться при больших ЛР с BF16 и BS12 у модели меньше это 100%. Будет вообще весело если тут еще зависимость от датасета подъедет, особенно на чем-то шизофазическом типа стиля мадоки

> можно конечно что-то типо 3е-4 поставить наверное и будет норм

2-3 еще попробуй, всеравно обучается по 4 минуты. А, кстати, сколько там у тебя шагов?

> Могу лишь старый пример скинуть

ты по что, ирод, лисодевку в бабу с воротником превратил!

> Ну вот не улавливает низкая альфа стиль

Полагаю здесь надо определиться с тем что понимать под стилем в принципе. Надо примеров заготовить, возможно тут суть в чем-то конкретном, или важны и другие параметры.

> С низкой альфой заебись тренить просто персонажа без влияния на стиль

Эх если бы все так просто было, избавиться от стиля при однотипном датасете та еще боль, а иногда и нереально.

> Тащи конечно

Может завтра, может на днях

Гайдецкий обновил, что-то поправлено, что-то добавлено, есть теперь референсные пикчи для дефолтного сида

> Ты только учитывай что это потребует дохуя большего объема врам, а ее в старых картах и так не густо совсем. То что весят много это вообще ерунда.

А если запрунить?

> Который вебинтерфейс? лол

Нет, который без веба работает https://github.com/anon-1337/LoRA-train-GUI им то я и хочу заняться как со стилем разберусь наконец, а после начинать разбираться как правильно пилить эти новомодние лоры, пока почитал, нихуя не понятно но очень интересно, лоха и локон это типо теперь просто ликорис, они походу дополнительным слоем ложаться на основную лору, или вообще можно отключать основную и не тренить, там еще rank!=dim, вроде может быть больше или меньше, вроде лоха больше подходит для стилей, что-то такое тоже читал, короче еще разбираться надо.

> Будет вообще весело если тут еще зависимость от датасета подъедет, особенно на чем-то шизофазическом типа стиля мадоки

Всмысле подъедет? Датасет это же база, дерьмо вошло дерьмо вышло

> 2-3 еще попробуй, всеравно обучается по 4 минуты. А, кстати, сколько там у тебя шагов?

Вот попробовал 3е-4 с теми же параметрами и 1е-3 с альфой 1 и дим 32. Первая лучше всего овералл получилоась по этой выборке, имхо.

Всего навсего 240 х 10 батч, не меняется ничего уже с 200, судя по гридам, которые я делал с этим датасетом.

> Полагаю здесь надо определиться с тем что понимать под стилем в принципе. Надо примеров заготовить, возможно тут суть в чем-то конкретном, или важны и другие параметры.

Ну я хз как объяснить, на примере этого художника, вот эта характерная мазня, передается с датасетом лучше на большой альфе, на низкой с повышенным лр тоже может, но похуже, зато тени вроде получше, короче надо тренить нормально с лок сидом, как и с кокоро, чтобы видеть точные отличия

> Гайдецкий обновил, что-то поправлено, что-то добавлено, есть теперь референсные пикчи для дефолтного сида

Про системную память не упомянул опять? Кстати хорошо было бы чек тензоров добавить в него.

Как тебе кстати такое Илон Маск? Удалось распердолить до двухминутного финиша. Вообще просто рофла ради, потому что там жалуется на тритон. Либ bitsandbytes под последний торч с кудой на винде тоже нету, интересно насколько быстро это тренится на линуксе, я просто смотрю для него либы как раз имеются, а с тритоном вообще хз на самом деле, может он в них лежит? Ошибки начало сыпать после перестановки версий просто.

А можно по подробнее про то что по видосу хуйня?

1) Caption

2) Lerning rate

3) Epoch

Хочется понять суть.

1. Caption работает, то что Лора иногда запоминает протеганные моменты - да, есть такое, может кто-то знает как бороться.

2. Learning/Epoch - у него дефолтный лёрнинг (это не плохо, это база) с линейным шедуллером, в итоге получится что одна эпоха и сто проходов, что десять эпох по десять проходов - финальный результат не изменится. И он не правильно говорил про Learning rate и Unet learning rate - первый можно ставить что угодно, для лоры важен Unet, если уж совсем доебаться.

Про батч сайз он втирал какую-то совсем не логичную дичь.

В общем лучше читай гайд по лоре от анона, там больше пользы в разы.

https://rentry.org/2chAI_easy_LORA_guide

киньте гайд для обучения произвольным концептам, если есть

а то что-то мне подсказывает, что научить нейронку рисовать очередное маняме, отличающееся от другого маняме цветом трусов, намного легче, чем обучить нейронку совершенно новому объекту

а то что-то мне подсказывает, что научить нейронку рисовать очередное маняме, отличающееся от другого маняме цветом трусов, намного легче, чем обучить нейронку совершенно новому объекту

Кстати, а есть ли разница тренить на фулл или прунед версии нейронки?

>а то что-то мне подсказывает, что научить нейронку рисовать очередное маняме, отличающееся от другого маняме цветом трусов, намного легче, чем обучить нейронку совершенно новому объекту

"Что-то" подсказывает тебе неправильно.

Тэгаешь как обычно, ИИ находит похожее в картинках по тэгам, на этом обучается.

И всё же интересует вопрос имеется 20 пикч на трейно лоры:

1)100 повторений каждой пикчи в одну эпоху

2)10 повторений каждой пички в 10 эпох

Говорят разницы типа нет, но при втором варианте loss ближе подошел к 1.000. Требуется мнение эксперта.

1)100 повторений каждой пикчи в одну эпоху

2)10 повторений каждой пички в 10 эпох

Говорят разницы типа нет, но при втором варианте loss ближе подошел к 1.000. Требуется мнение эксперта.

Разницы нет между 10 повторениями в 10 эпох и 2 повторениями в 50 эпохах, в одну эпоху лучше не тренить. Хотя на 20 пикчах и если там датасет пиздецовый то эффект рандома может вообще оказаться определяющим

> выбираем fp16 или bf16. Последний вариант более предпочтителен, но поддерживается только последними сериями видеокарт.

Тьюринг сюда входит?

Алсо, получаю вылетает ошибка при установке, не знаю что делать.

(venv) PS E:\kohya-ss\sd-scripts> pip install -U -I --no-deps https://github.com/CHNOS/stable-diffusion-webui/releases/download/f/xformers-...dev-cp-cp-win_amd.whl

ERROR: xformers-...dev-cp-cp-win_amd.whl is not a supported wheel on this platform.

С 3000 серии.

> win_amd.whl

Там amd64 должно быть, и возле cp циферка. Покажи ка какая у тебя шинда и какой питон установлены (python --version)

Понял, спасибо.

Вроде справился, помогло либо обновление pip, либо добавление папки со скриптами в path.

В общем запилилось все на твоем датасете, спасибо за гайд и скрипт анону, пойду грабить художников.

Спрошу и сюда.

Братаны, если обновлюсь до вин11, то автоматик заведется?

Братаны, если обновлюсь до вин11, то автоматик заведется?

Да. Почему ты подумал что не заведется?

Трясун просто. Привык что обновления все ломают.

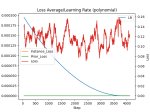

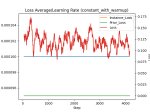

Очердное исследование влияния альфы на тренировку стиля, один и тот же сид, шафл включен

Начать надо с того, что художник настолько охуенный, что я прямо снимаю шляпу, выдержанный общий стиль всех картинок, я такой низкий лосс на стиль впервые встречаю, у аниметяночек и то порой побольше, его даже в камепанотест на стиль можно добавлять, лол.

Первые попытки что то сделать с прошлыми настройками на кокоро, пик1, 3е-4, бс11, (40х5х12)/11 шагов не дали нужного результата, свитспотом даже и не пахнет и я увеличил количество эпох с 12 до 15 и повторений в два раза с 5 до 10

Получил второй грид, свитспот прекрасно видно, я его даже пометил. Вообщем то это всё, что можно сказать насчет альфы 128, just works.

А вот приключения с альфой 1 только начинаются, 3e-3 не дал никакого результата, пошел смотреть график, пик4, и пытаться достигнуть такого же лосса как и с альфой 128, в итоге такой лосс был получен только на 7е-3, свитспот скорее всего где то в помеченной области, пик3, тут уже нету такого резкого видного перехода как при альфе 128. И да, 1е-2 уже смерть.

Ну хорошо, в некст посте будет более подробный грид.

Начать надо с того, что художник настолько охуенный, что я прямо снимаю шляпу, выдержанный общий стиль всех картинок, я такой низкий лосс на стиль впервые встречаю, у аниметяночек и то порой побольше, его даже в камепанотест на стиль можно добавлять, лол.

Первые попытки что то сделать с прошлыми настройками на кокоро, пик1, 3е-4, бс11, (40х5х12)/11 шагов не дали нужного результата, свитспотом даже и не пахнет и я увеличил количество эпох с 12 до 15 и повторений в два раза с 5 до 10

Получил второй грид, свитспот прекрасно видно, я его даже пометил. Вообщем то это всё, что можно сказать насчет альфы 128, just works.

А вот приключения с альфой 1 только начинаются, 3e-3 не дал никакого результата, пошел смотреть график, пик4, и пытаться достигнуть такого же лосса как и с альфой 128, в итоге такой лосс был получен только на 7е-3, свитспот скорее всего где то в помеченной области, пик3, тут уже нету такого резкого видного перехода как при альфе 128. И да, 1е-2 уже смерть.

Ну хорошо, в некст посте будет более подробный грид.

Промпт элементарный, мастерпися, (1герл, ковбой шот:1.2), тег лоры, вилдкард бекграунда

Какая лора лучше редактируется я не могу точно сказать, они обе легко меняют бекграунд. Так же не могу сказать что какая-то из них не передает стиль. Но 7е-3 и альфа 1 получилась какой-то более темной чтоли, как будто тени там абсолютно другие, вообщем мне она меньше нравится, но охуеть в такой лр целиться при тренировке стиля, по мне так легче просто поставить большую альфу и бф16, ведь тогда тензоры не сломаются.

> Если способ опишешь - буду благодарен

Короче, пока собирал, разобрался с этим, это точно ускорит сборку датасета с бур. Помнишь скрин из старого гайда? https://i.imgur.com/VH5HOcQ.png так вот all надо заменить на general

Какая лора лучше редактируется я не могу точно сказать, они обе легко меняют бекграунд. Так же не могу сказать что какая-то из них не передает стиль. Но 7е-3 и альфа 1 получилась какой-то более темной чтоли, как будто тени там абсолютно другие, вообщем мне она меньше нравится, но охуеть в такой лр целиться при тренировке стиля, по мне так легче просто поставить большую альфу и бф16, ведь тогда тензоры не сломаются.

> Если способ опишешь - буду благодарен

Короче, пока собирал, разобрался с этим, это точно ускорит сборку датасета с бур. Помнишь скрин из старого гайда? https://i.imgur.com/VH5HOcQ.png так вот all надо заменить на general

Ещё раз бампану, может кто знает?

На прунедах никто не трейнит, ЕМНИП.

Как ты в тензорборде сделал названия графиков названиями лор? Или переименовывал уже руками после дела? Меня это жутко напрягает, сразу не переименуешь, вся папка с логами лочится , потом уже забываешь где что было.

Они же по дефолту идут по названиям лор, разве нет? Ничего не переименовывал, просто один раз тензорбоард запустил и называл лоры по разному через гуй анона1337

Надо попробовать тот гуй, правда смотрю он два месяца не обновлялся. У меня кохуя_гуй, вот такая беда там, думал может есть какая настройка отдельная, логам давать названия лор.

Если мне нужно только чтобы воспроизводился один костюм, то только его в датасет пихать или в какой-то пропорции?

На такой случай тот пропавший анон сделал план б, в гуе есть строка для задания произвольных параметров, ведь все что из себя этот гуй представляет это просто набор этих параметров к скрипту, можешь пока вручную дописывать новые. Я как раз собираюсь заняться его допиливанием, уж пару параметров то я надеюсь смогу осилить. Если смогу надо будет пр тому анону кинуть, может оживет.

>Воу-воу, просто ставь cosine и проходов на один раз

Какой-то странный косинус в дримбуте.

Добавил в шаблон.

ЧЗХ C каких пор запятая считается как токен, а не разделитель? автоматик совсем ебанулся? Почему никто не говорит, что запятые теперь только подсирают? как чинить? Не могу повторить картинку месячной давности из-за пик4

запятые вначале промта

Есть ли способ скопировать все файлы с определёным тегом в другую папку, а не перемещать? В dataset editor я не вижу такой функции

Ладно просто скопировал папку и из неё переместил файлы

Чем отличаеться тренировка лоры и дримбута?

Первая делает лору, а вторая модель.

Ясно, а структура папок и концепты остаються теми же?

Да что такое этот ваш лосс? Это то, насколько разъёбывается сетка, чем меньше, тем лучше? Меня напрягает этот забор на лосс/каррент, что это, почему?

3 пик в шапке зырь.

> чем меньше, тем лучше

Лосс - это не метрика, на значение похуй. Важна динамика.

И не говори, это пиздос

На сложном сете держится на одном уровне

Что это за графики такие?

дефолтный dreambooth

поебень от kohya категорически отказывается работать на паскале.

Кста Антон который писал гайд, можешь пояснить за разницу в тегировании для стиля/концепта/персонажа/вещи

> А если запрунить?

Так оно всеравно в 2 раза больше потребует чем фп16, офк надо тестировать

> Всмысле подъедет? Датасет это же база, дерьмо вошло дерьмо вышло

Имею ввиду что если там уж пиздец какие разноплановые и странные пикчи то подгонка по одной и при рассмотрении группы может дать разный результат и явить то что в нормальных датасетах не проявляется

> вот эта характерная мазня

Тут бы примеры какие с описанием

> надо тренить нормально с лок сидом

А толку с этого если в итоге пойдет по другому пути? Если же ты хочешь чтобы гриды похожие получались - через промт вызывай, оно иначе применяется и пикчи с одним сидом генерации с разными лорами довольно таки похожи

> Про системную память не упомянул опять?

В начале желтеньким чтобы своп выделяли есть

Хуясе, этоже на минуту быстрее, вот это интересно. Раз ошибки лезут значит что-то есть, оно может просто быть подсосано настолько костыльно что лучше не вскрывать это тему трогать

О, топчик

> (1герл, ковбой шот:1.2)

Вообще стоит попробовать сравнение с более подробным промтом, ведь при обучении оно натягивает клип по всем тегам которые есть, соответственно %платье_нейм% будет иметь также черты. Но может там достаточно только возмущений юнета, надо тестить.

Если сравнивать гриды то на второй виднеются признаки поломанной/чуть перетрененой лоры с альфа=дим - глаза и лица уплывают, появляется характерное двоение - глоу. Но если это приближает к желаемому - почему бы и нет.

Тестирование сменой фонов это базовое, но не достаточное, попробуй разные ракурсы, масштабы от клозап на лицо до оче далеко и т.д., позиции персонажа (фром бихайнд и т.п.), если везде срабатывает значит все прекрасно.

> бф16

А его, пожалуй, и нужно всегда выставлять, поводом выбрать фп16 может стать только старая видюха

> так вот all надо заменить на general

Найс, красава

А какая разница? Нужно наиболее подробное и правильное описание как всего арта, так и той вещи, которую ты хочешь тренить, причем чем больше тегов относятся именно к ней тем лучше. Например, хочешь сделать меч - к нему должны идти типа "холдинг ин хенд", "флаинг" и т.д. А по датасету желательно чтобы было наибольшее разнообразие и совпадение только в том что тренишь. Если у тебя автор рисует одного персонажа или действие происходит только с ним - как ни тегируй, всеравно он будет пытаться вылезти, также как и персонаж в одном стиле будет его воспроизводить (каноничная сенколора хороший пример).

> Так оно всеравно в 2 раза больше потребует чем фп16, офк надо тестировать

Вот это точно лень делать, все равно ниже ампера ничего нету чтобы протестить, там же хотя бы тютюрю нужно

> Имею ввиду что если там уж пиздец какие разноплановые и странные пикчи то подгонка по одной и при рассмотрении группы может дать разный результат и явить то что в нормальных датасетах не проявляется

Ты про гриды после тренировки? Все равно не понимаю

> Тут бы примеры какие с описанием

> А толку с этого если в итоге пойдет по другому пути? Если же ты хочешь чтобы гриды похожие получались - через промт вызывай, оно иначе применяется и пикчи с одним сидом генерации с разными лорами довольно таки похожи

Как раз уже закончил тренить стиль, все наглядно вроде расписал выше

> Если сравнивать гриды то на второй виднеются признаки поломанной/чуть перетрененой лоры с альфа=дим - глаза и лица уплывают, появляется характерное двоение - глоу. Но если это приближает к желаемому - почему бы и нет.

На второй вообще то альфа 1 и 7е-3, мне этот результат тоже не понравился

> Тестирование сменой фонов это базовое, но не достаточное, попробуй разные ракурсы, масштабы от клозап на лицо до оче далеко и т.д., позиции персонажа (фром бихайнд и т.п.), если везде срабатывает значит все прекрасно.

Я уже это все попробовал, рисует просто охуенно на самом деле на лоре с 128 альфой, ну единственная проблема наверное это миксование лор, но тут уж хз что поделать, кроме как вес снижать с 1.0, ну и дальние ракурсы нуждаются в инпеинте, хотя где они не нуждаются в нем с такого расстояния то?

> Хуясе, этоже на минуту быстрее, вот это интересно. Раз ошибки лезут значит что-то есть, оно может просто быть подсосано настолько костыльно что лучше не вскрывать это тему трогать

Я пока еще даже не до конца прочитал лог апдейтов кохьи, вот зацепился за параметр --persistent_data_loader_workers и протестил, это он основную работу делает, между эпохами нету выгрузки-загрузки в память, пиздец, надо было сразу почитать это а не мучиться как идиот раньше. А на торч 2 похуй, и так вроде быстро, тем более там и либ каких то не хватает.

Алсо сегодня узнал такую вещь, сд вае намного лучше для тренировки, литералли мое ебало когда тренирую на наи вае пик 1 вс мое ебало когда тренирую на сд вае пик 2, с руками тоже все получше, ну и грид сравнительный, лосс тоже другой, и пришлось даже перетренить на меньшем лр, потому что тренируется тупо лучше.

> Ты про гриды после тренировки? Все равно не понимаю

Шизодатасет с пикчами-тегами, которые будут сильно отличаться от того что сеть делает обычно, да еще протеган так потребует противоположных возмущений. Неудачно сложившееся обучение на одном потоке может увести в сторону и поломать, тогда как усредненные по нескольким даст более адекватные данные. Вот и получим что чтобы не ломалось на бс1 потребуется сильно снижать лр, а на бс_дохуя все будет ок, хотя по факту такой разницы быть не должно.

> --persistent_data_loader_workers

Ну наконец, давно просилось. Хотя надо отметить что в новых версиях сам процесс подгрузки значительно ускорили.

> не до конца прочитал лог апдейтов кохьи

--use_lion_optimizer пробовал? Дохуя перспективно и качественно обещают

> Алсо сегодня узнал такую вещь, сд вае намного лучше для тренировки

Хуясе ебать, надо попробовать

По стилям потом, надо свалку разгрести и для чистого эксперимента натренить пару чтобы сравнить объективно.

Что писать здесь, не пойму какую ссылку требует от меня что бы загрузило модель, это в колабе по дримбуту

> сд вае намного лучше для тренировки, литералли мое ебало когда тренирую на наи вае пик 1 вс мое ебало когда тренирую на сд вае пик 2

> 2023

> держать включенным что-то кроме сд вае

Ебало неимаджинируемо.

Ну что там сделали уже однокнопочную тренировку лор? Чтобы датасет закинуть и все

> Хуясе ебать

Бля в начале прочитал ванильную сд модель и ахуел, а по совместимости вае тема не новая, на какой модели тренилось?

> 2д23

> Видеть черный только на черных квадратах

Еще как имаджинируемо

>Если у тебя автор рисует одного персонажа или действие происходит только с ним - как ни тегируй, всеравно он будет пытаться вылезти, также как и персонаж в одном стиле будет его воспроизводить

Тут вообще как повезет.

Лору на Могунами взять - так она вполне спокойно разных персов воспроизводить может, особенно если на вес тэгов поднажать. В итоге лора на персонажа выдает вдобавок еще и стиль художника.

А всё потому что Могунами там протэгана была полностью.

Вот одежду толком не протэгали, и поэтому с одеждой лора справляется хуже - всё норовит в бело-синюю школьную форму персонажей нарядить (ну или ее вариации).

Неделю или полторы за темой не следил - чего-то нового придумали?

Лоры эти новые видел - какой в них толк, чем отличаются?

Лоры эти новые видел - какой в них толк, чем отличаются?

О, и еще - кнопки "освободить видеопамять" не придумали еще? А то грузится туда всякое и зависает, только перезапуском спастись можно.

После загрузки автоматика 3.3 гига занято, а после генераций (особенно с контролнетом) память может до 6-7 гигов забиться.

И даже когда ты это всё отключаешь - память не освобождается, что ведет к постоянным out of memory до перезапуска.

После загрузки автоматика 3.3 гига занято, а после генераций (особенно с контролнетом) память может до 6-7 гигов забиться.

И даже когда ты это всё отключаешь - память не освобождается, что ведет к постоянным out of memory до перезапуска.

> Шизодатасет с пикчами-тегами, которые будут сильно отличаться от того что сеть делает обычно, да еще протеган так потребует противоположных возмущений. Неудачно сложившееся обучение на одном потоке может увести в сторону и поломать, тогда как усредненные по нескольким даст более адекватные данные. Вот и получим что чтобы не ломалось на бс1 потребуется сильно снижать лр, а на бс_дохуя все будет ок, хотя по факту такой разницы быть не должно.

Кстати реально интересно, насколько это влияет все таки на обучение, так по наблюдениям на большом батч сайзе лорки реально лучше выходят, по времени то понятно, но даже бс2 8 минут всего с этим параметром, про который я тебе написал

> --use_lion_optimizer пробовал? Дохуя перспективно и качественно обещают

Этого дохуя перспективно и качественно там вот столько:

def add_optimizer_arguments(parser: argparse.ArgumentParser):

parser.add_argument("--optimizer_type", type=str, default="",

help="Optimizer to use / オプティマイザの種類: AdamW (default), AdamW8bit, Lion, SGDNesterov, SGDNesterov8bit, DAdaptation, AdaFactor")

и к каждому походу свой подход еще нужен, у ады вообще какой то рофл видел пока дебажил, типо рекомендации в консоле ставить лр 1.0, и в этот момент не понял прикола

> По стилям потом, надо свалку разгрести и для чистого эксперимента натренить пару чтобы сравнить объективно.

А я как то не чисто или не объективно сравнил чтоли?

Лора может запомнить несколько персонажей или скорее характерные им черты и связать их с промтом, также и стиль художника подсасывается если он везде одинаков и будет присваиваться всем объектам. Другое дело что прям сильно детально если необычные и много не выйдет, а с формой сам видишь нюанс.

> типо рекомендации в консоле ставить лр 1.0

лол

> А я как то не чисто или не объективно сравнил чтоли?

Не, как взгляну на что-то типа 7296x7251 где нужно вглядываться сравнивать, вспоминаю про то что еще лежит ждет, ловлю флешбеки с работы и мотивация пропадает. Но рано или поздно надо будет заняться

Удваиваю проблему, чтоб повторить декабрьские генерации - и то частично, по очевидной причине - пришлось чистить вилкой промпт из пнгинфо.

Какие профиты от тренировки не на nai?

В целом концепция верная, обновления нинужны!

мимо лаптоп-2011-кун

Может скопироваться стиль модели

Гайс, приветствую!

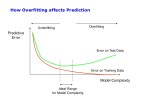

Вкатываюсь в нейросети не так давно. Недельку я осваиваю всю эту шушару с лорами, дримбусами и прочим, в целом минут за 10 обучения получилось в дримбусе создать свою модель, внешне похожую, но далеко от какого-то фотореализма. При этом сколько я материалов не смотрю все лезут в какую-то залупу, какие-то лоры в кое, чето делают, текстуал инверсии, а как начнешь разбираться в этих разных вариантах обучения, то оказывается оно всё мало чем отличается друг от друга первый пик в ОП посте, тоже датасет, тоже настраиваю часто такие же параметры, только в другом интерфейсе и прочее.

В связи с чем возникает вопрос: что и как использовать для того, чтобы СД генерировал реалистичную модель человека, а-ля сфоткал на свой телефон, на основе своего датасета? Достаточно ли будет накрутить какие-то настройки в дримбусе автоматика1111, чтобы из того, что есть сейчас (1-2 пик), сделать так же красиво как делают чуваки используя лору в Кои_Гуи или просто на готовой модели (3-4)?

Заранее благодарен любой посыльной помощи, я мог шото спросить не правильно, я просто вообще нихуя не разбираюсь в этих ваших штуках

Ебал в рот пидараса который утверждал что локально обучение лоры не запустится на 10гб

sup

В нейросетях упарываюсь по обучению на фотках людей для создания их портретов.

В основном пользуюсь колабом Fast Freambooth.

Из того, что примерно получается - взять 15-20 фото с лицом, натренить на Dreambooth. В результате периодически получаются вполне удачные фотопортреты или портреты в стилистике а ля "amazon warrior", "elf", "elsa from Frozen".

Какая есть проблема - если брать фото с лицами крупно, то при попытке запросить что-то типа full length portrait - оно все равно норовит отрисовать только лицо. Начинаешь увеличивать вес промпта - теряется схожесть.

Тренишь на портретах в полный рост - лицо и близко непохоже становится.

Как с этим бороться? Посоветуйте хороший гайд, анонче.

Попробуй Colab какой-нибудь, на Youtube набери "how make my portrait with dreambooth", там полно индусов поясняющих за это.

В нейросетях упарываюсь по обучению на фотках людей для создания их портретов.

В основном пользуюсь колабом Fast Freambooth.

Из того, что примерно получается - взять 15-20 фото с лицом, натренить на Dreambooth. В результате периодически получаются вполне удачные фотопортреты или портреты в стилистике а ля "amazon warrior", "elf", "elsa from Frozen".

Какая есть проблема - если брать фото с лицами крупно, то при попытке запросить что-то типа full length portrait - оно все равно норовит отрисовать только лицо. Начинаешь увеличивать вес промпта - теряется схожесть.

Тренишь на портретах в полный рост - лицо и близко непохоже становится.

Как с этим бороться? Посоветуйте хороший гайд, анонче.

Попробуй Colab какой-нибудь, на Youtube набери "how make my portrait with dreambooth", там полно индусов поясняющих за это.

ебаться с img2img, переделывая только ебало

А вот если я в дадасете на некоторых фото замазал фон тупа зеленым пятном, оно так и будет его потом рисовать? Типа оно не понимает что нужно взять только лицо?

Обознач это каким то тегом, что бы потом в негатив кидать, мне помогло

пон спасибо, но походу снижение cfg помогло

Судя по заказанному лицу, результат отличный.

Какими тегами пользуешься? Тренишь фотками с лицом крупно или по-другому? Как маркируешь, чтобы сказать сетке - "нужен именно этот конкретный человек"?

На самом деле с лицом все не так однозначно, я больной ублюдок и использую 2 гиперсетки и 1 лору на небольших значениях, только так удается получить нужную схожесть с оригиналом. Вообще я лору научился делать буквально на днях и все еще эксперементирую. До этого использовал 3 гиперсетки. Фон бывает из-за такого охуенного коктейля пидорасит пиздец как

Тренил чисто с фотками лица крупным планом, других нормальных нет, и пишу просто photo of young woman

Можно ли сделать в webui чтобы у img2img и inpaint были индивидуальные настройки и не приходилось каждый раз отключать апскейл и менять ползунки?

Джва года жду возможность автоматизировать SD-апскейл. А то открывать вкладку с браузером картинок, send img2img, выставляешь одни и те же настройки каждый раз.

Зачем менять тег персонажа на свой при тренировке лоры?

Вкатился с работами

Лучше не зеленью замазывать, а заполнением фона.

Или просто вырезать кусок с другой стороны и уже его вставить.

Пусть там каша какая-то непонятная будет, но хотя бы в цветах картинки. Это лучше, чем зеленое пятно. Если таких пятен в материалах много будет, нехорошо получится.

Ваша нейронка полойдёт для того, чтобы надрочить её рисовать арты в стиле одного художника? Проблема в том, что хочу обучать её на манге, вырезая отдельные арты. Сколько в среднем артов надо скормить для достижения приемлемого результата?

И, полагаю, мне нужен будет коллаб, так как с 4 Гб видеопамяти точно делать нечего?

И, полагаю, мне нужен будет коллаб, так как с 4 Гб видеопамяти точно делать нечего?

Подойдёт конечно, сам тренирую хуйдожников периодически.

30 хороших качественных примеров вполне достаточно, можно больше. Закидываешь в колаб жмяк жмяк жмяк через полчаса-час забирай результат.

>Мразь тренирует на РАБОЧЕМ СТОЛЕ

Типа папка с датасетом на рабочем столе? Тоже так делаю, брат жив