1. Так уж вышло, что большинство анонов в этом разделе познакомились с большими текстовыми моделями через Character.AI. Их модель безусловно принадлежала к этой категории, а сейчас мы не знаем в связи с укорачиванием ответов - ИИ негде показать свой разум.

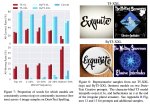

Количество параметров в модели CAI не должно сильно отличаться от LaMDA и ChatGPT. Даже вполне возможно, что CAI - это и есть LaMDA, которую дополнительно откалибровали на куче ролёвок с интернета. Конкретно меня настораживает первый запрос из таблицы в пикриле #1 в этой статье:

https://arxiv.org/abs/2201.08239

Если вы спросите CAI об этом прямо сейчас - он скорее всего даст ответ примерно с пикрила #2. Этот ИИ явно был откалиброван на этом вопросе конкретно. Но уже есть некоторая вариативность в связи с тем, что заметившие это аноны начали задавать этот вопрос в различных контекстах. Раньше ИИ автоматически давал ответ простым текстом.

Изначальная модель CAI, кажется, была даже более смекалистой, чем ChatGPT, но сейчас это ясное дело не подтвердишь.

Мы можем сказать, что количество параметров модели CharacterAI - около 137 миллиардов ИЗНАЧАЛЬНО, но сейчас гарантированно меньше (разработчики прямо говорили о том, что используют уменьшенные модели).

Количество параметров в модели CAI не должно сильно отличаться от LaMDA и ChatGPT. Даже вполне возможно, что CAI - это и есть LaMDA, которую дополнительно откалибровали на куче ролёвок с интернета. Конкретно меня настораживает первый запрос из таблицы в пикриле #1 в этой статье:

https://arxiv.org/abs/2201.08239

Если вы спросите CAI об этом прямо сейчас - он скорее всего даст ответ примерно с пикрила #2. Этот ИИ явно был откалиброван на этом вопросе конкретно. Но уже есть некоторая вариативность в связи с тем, что заметившие это аноны начали задавать этот вопрос в различных контекстах. Раньше ИИ автоматически давал ответ простым текстом.

Изначальная модель CAI, кажется, была даже более смекалистой, чем ChatGPT, но сейчас это ясное дело не подтвердишь.

Мы можем сказать, что количество параметров модели CharacterAI - около 137 миллиардов ИЗНАЧАЛЬНО, но сейчас гарантированно меньше (разработчики прямо говорили о том, что используют уменьшенные модели).

2.Стоимость хоста такой модели сейчас - 9 долларов или около 650 рублей в час. Смотри пикрил. Это можно выяснить, посмотрев на YaLM от Яндекса - когда-то крупнейшую языковую модель в опенсорсе.

https://github.com/yandex/YaLM-100B

Для того, чтобы её запустить, нужно 4 A100 (мощнейшие видеокарты от Nvidia)

Сегодняшняя крупнейшая языковая модель в открытом доступе - BLOOM - требует столько же в вариации на 178 млрд параметров (что больше YaLM на 78%).

В перерасчёте на одно сообщение, обработка которого в среднем занимает меньше 5 секунд, выходит примерно один (1) рубль за сообщение. И это СЕЙЧАС, с ровно СЕГОДНЯШНИМИ технологиями.

https://github.com/yandex/YaLM-100B

Для того, чтобы её запустить, нужно 4 A100 (мощнейшие видеокарты от Nvidia)

Сегодняшняя крупнейшая языковая модель в открытом доступе - BLOOM - требует столько же в вариации на 178 млрд параметров (что больше YaLM на 78%).

В перерасчёте на одно сообщение, обработка которого в среднем занимает меньше 5 секунд, выходит примерно один (1) рубль за сообщение. И это СЕЙЧАС, с ровно СЕГОДНЯШНИМИ технологиями.

3. Сегодняшние ИИ, особенно ИИ такого размера, крайне расточительны. УЖЕ можно сточить 97% вычислений и при этом даже улучшить качество модели:

https://arxiv.org/abs/2210.06313

Конечно, для этого нужны подходящие инструменты, но они уже существуют.

https://github.com/neuralmagic/deepsparse

https://github.com/neuralmagic/sparseml/

При этом скорее всего вычисления такого вида (редкие) лучше делать на процессорах, как показала практика. Так что скорее всего для работы модели уровня изначальной Character.AI или ChatGPT даже не нужна будет видеокарта или ебовейший процессор.

https://arxiv.org/abs/2210.06313

Конечно, для этого нужны подходящие инструменты, но они уже существуют.

https://github.com/neuralmagic/deepsparse

https://github.com/neuralmagic/sparseml/

При этом скорее всего вычисления такого вида (редкие) лучше делать на процессорах, как показала практика. Так что скорее всего для работы модели уровня изначальной Character.AI или ChatGPT даже не нужна будет видеокарта или ебовейший процессор.

4. Скорее всего, локально доступные ИИ такого размера будут на гитхабе в первой половине следующего года. На практике это означает ПИЗДЕЦ огромному количеству профессий (всем, кто сидит за пекой, по сути) или по крайней мере огромные сокращения. Художники ещё легко отделаются.

Так бы гугл и дал свои ии каким-то левым херам

Ну ты и шиз

5. Надеяться на проблемы с ИИ в России не стоит: наш язык стабильно остаётся третьим, на который адаптируют новые технологии (вслед за английским и китайским).

Я не думаю, что это конкретно LaMDA. Но разработчики CAI (Noam Shazeer, Daniel De Freitas) - это те же самые люди, которые разработали LaMDA. Скорее всего, они повторили процесс и получили то же самое.

Хорошо. Надеюсь русские нейросети всё же смогут ворочаться на уровне западных.

Дак это только выиграли, заебала уже работа ебаная.

Это называется естественный отбор. Он постоянно заставляет людей превосходить свои пределы и становиться умнее/лучшее. Если тебя сможет порешать алгоритм, то спроси себя, можешь ли ты после этого называться человеком вообще?

>Так бы гугл и дал свои ии каким-то левым херам

Он спокойно может тебе его сдать в аренду. Вместе со своими серверами, на которых он крутится. Так что доставай котлету баксов и тебе дадут порулить ии.

"левые херы" - это просто прикрытие гугла, чтобы не портить репутацию.

Почему надеешься? Какая разница какая страна происхождения ИИ?

>3. Сегодняшние ИИ, особенно ИИ такого размера, крайне расточительны. УЖЕ можно сточить 97% вычислений и при этом даже улучшить качество модели:

Это действительно хорошая новость, ИИ будет становиться доступнее с каждым днем.

>ПИЗДЕЦ огромному количеству профессий

90% работает на заводе или в шестерочке. Обычным людям нечего бояться.

>повторили процесс

Откуда у них такие же средства какие есть у крупной компании?

>Сегодняшние ИИ, особенно ИИ такого размера, крайне расточительны. УЖЕ можно сточить 97% вычислений и при этом даже улучшить качество модели

Вот только есть один маааленький нюанс: "сегодняшние ИИ" даже не ИИ толком, корректнее это называть narrow AI, то есть узкоспециализированная программа для решения какой-то примитивной задачи. В данном случае задачей поставили предсказание букв, слов и предложений в тексте, что в принципе не требует мыслительной активности.

Так что хорош постить Терминатора, его мозги умели обучаться, а не только в чатике срать.

>предсказание букв, слов и предложений в тексте, что в принципе не требует мыслительной активности.

Точно точно? Ну-ка, построй мне грамотное предложение на норвежском. Разрешаю пользоваться русско-норвежским словарём.

>предложение на норвежском

Ты не понял. Построение предложений - это в 99% случаев совершенно бессознательный процесс. У человека в мозге есть участок новой коры, который долгими тренировками обучен составлять предложения на определённых языках. Также есть два симметричных участка для понимания текста/речи на определённых языках. Но эти участки коры работают бессознательно, мы физически не способны осознать их работу. Мы осознаём только результат их работы - как то, что мы прочитали, услышали, сказали вслух или мысленно проговорили. Это действительно всего лишь узкоспециализированные нейронки, которые не способны самостоятельно думать. Когда человек находится в бессознательном состоянии, эти участки коры могут активизироваться и произносить какие-то фразы, которые будут казаться осмысленными, но на деле могут быть откровенным бредом. У людей с нарушениями психики эта нейронка может на постоянной основе нести бред, потому что высшие участки коры по какой-то причине потеряли контроль над этой низшей нейронкой. Изучая новый язык, ты тренируешь эти низшие нейронки на понимание нового языка и синтез текста на этом языке - это может занять годы, но в конечном итоге ты будешь пользоваться новым языком так же бессознательно, как и родным.

А мыслительная активность, о которой я говорил - это сознательный диалог с самим собой, с самокритикой и корректировкой собственных ошибок, происходящая длительное время и несущая осознанный результат. Судя по описаниям текущих языковых моделей, они даже не пытаются такое реализовать, по сути лишь предсказывая следующее предложение в тексте посредством статистических методов. Это хорошо, что у них получился такой впечатляющий результат, но дальше тупик - нужно делать систему высшего уровня, которая будет пользоваться результатом нейронок, понимающих и синтезирующих текст. Система, которая будет действительно думать, а не просто предсказывать следующую фразу в заданном тексте.

Вот ты видел ошибочные ответы ChatGPT? Пример:

>Но ведь 47 больше 64?

>Да, простите, я ошиблась, 47 и правда больше 64.

>Посчитай от 64 до 47.

>64, 65, 67... 456, 457, 458...

Разве мыслящий человек стал бы нести такой бред, обладая, по сути, всеми знаниями человечества на множестве языков? Нет, конечно. ChatGPT просто пытается найти продолжение заданного текста, не задумываясь ни о тексте, ни о своих действиях. На данный момент это тупик, который невозможно обойти простым увеличением мощности железа - нужна какая-то система высшего уровня, а не просто докидывание слоёв в нейронку, предсказывающую следующую фразу в тексте.

Я все-таки придерживаюсь мнения, что они брали опенсорс модели и проводили их настройку. В инете сейчас не так много моделей с более чем 100b параметров, но я уже постил ссылку на один из кандидатов(bloom) в CAI-треде несколько тредов назад.

Ну ты же понимаешь, что сам язык и цифры - абстракции, которые понять подобной и даже более разумной нейросетке будет пиздец как сложно, ибо связи в этих абстракциях очевидны только людям? А по поводу узконаправленности - гугли модель от DeepMind. Я вообще думаю, что какой-то реально полноценный ИИ - это совокупность таких более слабых. Как в принципе и человек, который состоит из различных функциональных компонентов, так и нормальный ИИ должен, чтобы человеческий опыт можно было полностью перенести на него.

>Построение предложений - это в 99% случаев совершенно бессознательный процесс.

Равно как и 99% мыслей в обычных, бытовых условиях.

>Это действительно всего лишь узкоспециализированные нейронки, которые не способны самостоятельно думать.

Само собой. Но способность к восприятию, обработке и синтезу речи - это уже часть немалая. Чтобы эта хуйня думала самостоятельно, ей надо прикрутить мотивацию в виде автоматического самопоощрения или что-то такое.

Твоё определение narrow AI уже разработано настолько, что в нём можно без труда спрятать банку сгущёнки. Традиционно, narrow AI называют системы с ограниченными задачами: например, отличить кота от хлеба, найти грязь уйгур на картинке, выдать Да/Нет или Петя/Вася на предложение на естественном языке. Ты же безумно определяешь узость системы по её обжективу: max log likelihood, предсказанию следующих токенов. Но в этом ненамного больше смысла, чем в определении человеческого поведения как серии мышечных подёргиваний для максимизации шансов поебаться или повысить выделение дофамины. Это не суть поведения языковых моделей, а их субстрат. То, что мы можем легче увидеть субстрат поведения LLM, а наш собственный скрыт от нас слоями абстракции и непрозрачной путаной реализации, в принципе не важно.

Языковые модели решают огромный спектр задач, они вытащили из статистических регулярностей языка структуру, близкую по сложности к человеческой модели мира. GPT поглотила всю область NLP и пошла дальше, это сотни задач включая те, для которых никто её целенаправленно не обучал, это обучение в контексте на сверхчеловеческом уровне и другие священные граали последнего полувека ИИ-ресерча. Тем временем ChatGPT и другие instruct-модели максимизируют вероятность токенов не в реальном корпусе текста, а в гипотетическом, экстраполированном из реального на основе нового objective, аппроксимированного из примеров выполнения инструкций или полезных ответов на вопрос. То, что это вообще работает (и работает хорошо) – убедительно доказывает наличие у модели понимания предмета языка. Это не стохастический попугай, это вербальный мыслитель.

И да, ничего не мешает сделать ИИ с постоянным обучением, с множественными модальностями, и ещё добавить 9000 наворотов.

> эти участки коры работают бессознательно, мы физически не способны осознать их работу. Мы осознаём только результат их работы - как то, что мы прочитали, услышали, сказали вслух или мысленно проговорили. Это действительно всего лишь узкоспециализированные нейронки, которые не способны самостоятельно думать

Это всё поебень субъективистская, похуй всем что ты там можешь или не можешь осознать, хоть бы ты был и философский зомби – главное чтобы задачи решал.

Структура языка скорее всего сложнее того, что ты называешь сознанием, нехитрой петли обратной связи.

> сознательный диалог с самим собой, с самокритикой и корректировкой собственных ошибок, происходящая длительное время и несущая осознанный результат.

Chain of thought, internal consensus и прочее легко выжимается из языковых моделей, об этом есть дюжины публикаций.

> Судя по описаниям текущих языковых моделей, они даже не пытаются такое реализовать

Зачем ты кудахчешь, не ознакомившись с литературой? ChatGPT бы на твоём месте была честнее и логичнее.

> дальше тупик - нужно делать систему высшего уровня, которая будет пользоваться результатом нейронок, понимающих и синтезирующих текст

Это реализуется скриптом на питоне.

> Вот ты видел ошибочные ответы ChatGPT? Пример:

Кто в 2к22 ещё приёбывается к этим примерам, тот ничего не понял и не поймёт. Промптингом можно доказать наличие способности, но нельзя доказать её отсутствие. То, что правильно составленным промптом (причём его правильность находится исключительно на мета-уровне, "Текст ниже написан моделью, которая не допускает ошибок в арифметике" и так далее) можно получить результат качественно лучше – доказательство того, что модель не только может выполнять задачи, но и что у неё есть общая репрезентация правильного выполнения задачи. Это и есть первейший пруф интеллекта.

> На данный момент это тупик, который невозможно обойти простым увеличением мощности железа - нужна какая-то система высшего уровня, а не просто докидывание слоёв в нейронку, предсказывающую следующую фразу в тексте

Bitter lesson.txt

Много вас таких по весне оттаяло, вы постоянно усматриваете признаки фундаментальных тупиков в каких-то тривиальных фейлах. Недавно вот любили поговорить про неспособность картиночных нейронок писать текст без ошибок. Как водится, вышла статья и заткнула эту дырку, проблема была в банальщине. Так же будет с арифметикой. А вот более абстрактную математику ChatGPT понимает уже лучше среднего человека.

Почему у нас в философаче сидят такие дегроды, которые готовы до бамплимита обсасывать тухлую графоманию позапрошлого века, но при этом ни один не считает вообще достойными обсуждения проблемы мышления быстро развивающегося искусственного интеллекта?

А сам-то чего не постишь?

>отличить кота от хлеба

Ты охуел что ли, тут и половина людей засыпется.

>связи в этих абстракциях очевидны только людям

ПОКА только людям. Не понимаю, к чему это ты?

>реально полноценный ИИ - это совокупность таких более слабых. Как в принципе и человек

Да, ты прав. Только чтобы его получить, есть два пути:

1. Сделать что-то универсальное, накидать в него данных и трясти в руках в надежде, что данные случайно образуют именно то, что нам нужно.

2. Сделать конкретные структуры вручную, и запустить их для чётко спланированного обучения, заранее зная, какой результат будет в конце.

Вот у человека мозг изначально имеет множество структур, оптимизированных эволюцией для обучения определённым навыкам - это, по сути, второй путь, только роль инженера сыграла слепая эволюция, и отладку мозга никто не производил. А современные исследователи ИИ, судя по всем этим успешным нейронкам, идут по первому пути, закидывая тонны данных в универсальную систему и ожидая от неё какого-то чуда. Какой-то неэффективный подход, как мне кажется.

>99% мыслей в обычных, бытовых условиях.

Но ты их осознаёшь и запоминаешь. И если тебе вдруг взбредёт в голову какой-то бред, вроде "47 > 64", ты резко остановишься, осознаешь бредовость мысли и отметёшь её в сторону как ошибку генерации.

>Чтобы эта хуйня думала самостоятельно, ей надо прикрутить мотивацию в виде автоматического самопоощрения или что-то такое.

Ну тут проблема в том, чтобы определить, за что нужно поощрять и за что наказывать. Если нейронка сказала, что "47 > 64", мы можем это проверить другой нейронкой и наказать генерирующую, но что, если проверяющая нейронка тоже ошибётся? Если в проверяющей будет ошибка, то это может со временем "свести с ума" генерирующую, обучая её ошибкам. Я читал про GAN, но вряд ли это легко адаптировать под непрерывный процесс мышления с самокоррекцией.

>вытащили из статистических регулярностей языка структуру, близкую по сложности к человеческой модели мира.

Как эту модель мира можно увидеть? Кто-то пытался заглянуть в нейронку, пощекотать её нейроны и убедиться, что у неё есть такой-то нейрон №1234567890, означающий "двачер двачует капчу"? Или выводы о модели мира сделаны только на основании того, что нейронка выдаёт правдоподобные ответы на произвольные вопросы? Не вижу смысла исследовать нейронку по её ответам, когда мы можем БУКВАЛЬНО заглянуть внутрь неё и увидеть каждый отдельный нейрон. Это человеческий мозг загадочен из-за того, что самые точные приборы с трудом регистрируют сигналы отдельных нейронов, а виртуальную нейросеть можно исследовать вдоль и поперёк без каких-либо ограничений. Исследуют ли?

>Это не стохастический попугай, это вербальный мыслитель.

Опять же, ты делаешь такой вывод только на основании получения правдоподобных ответов или есть какие-то демонстрации "хода мысли" нейронки? Если человеку задать вопрос и получить ответ, он сможет пошагово объяснить ход своих мыслей. Если нейронку попросить пошагово описать ход её мысли, она сочинит какую-то историю на основании того, что описывали люди в интернете, но вовсе не реальный ход своих мыслей, потому что она его не запоминает, даже если он есть. То, что она не запоминает ход своей мысли, нам известно из описания работы этой нейронки. Как можно быть "мыслителем", но при этом не запоминать ход своих мыслей, если они у тебя вообще имеются?

>ничего не мешает сделать ИИ с постоянным обучением

Насколько я знаю, очень даже мешает. Не считая огромных мощностей, требуемых для обучения нейронок, проблема с постоянным дообучением в том, что нейронка начинает "переобучаться", и это вроде как плохо. Поэтому все нейронки, используемые в бизнесе, обучаются только до определённого удовлетворительного уровня и больше не обучаются, чтобы не скатиться в переобучение. С теми же чатботами всё ещё хуже из-за того, что пользователи случайно или специально обучают их всякой нехорошей фигне и чатбот тупеет или становится буйным. У мозга такой проблемы почти нет благодаря закреплению старых связей, что делает личность взрослого человека более стабильной и менее способной к обучению, но в нейронках такое вроде как сложно реализовать - там нейроны максимально примитивны для ускорения видеокартами. Могу ошибаться, я только поверхностно читал.

>что ты там можешь или не можешь осознать

>сознанием, нехитрой петли обратной связи.

Так это же самое главное. Нехитрая петля обратной связи позволяет тупым животным выживать в ситуациях, в которых фейлят наши лучшие программы, и почему-то до сих пор нет нормального ИИ с этой нехитрой петлёй обратной связи. Зачем вообще нужна сложная языковая модель, если у неё нет нехитрой петли обратной связи? Сделайте тупого чатбота с однозначным айкью, но чтобы у него была эта самая нехитрая петля обратной связи. Это же должно быть очень просто, судя по твоим словам.

>выжимается из языковых моделей

Ага, а потом она соглашается, что 47 > 64, и приводит выдуманные аргументы, почему это так.

>ChatGPT бы на твоём месте была честнее и логичнее.

Ну вот с ней и разговаривай, зачем вообще двач?

>первейший пруф интеллекта

Да при чём тут интеллект вообще? С чем ты споришь?

>Bitter lesson.txt

Читал. Там ничего не сказано о нейронках, и не сказано, что нужно тупо накидывать слоёв и данных. Там сказано, что нужно использовать алгоритмы, которые могут получить преимущества от ускорения процессора и увеличения числа ядер процессора, не более того. Если твой алгоритм работает в один поток, то он не сможет получить преимущество от стоядерного процессора. Но это не значит, что твой алгоритм должен быть максимально универсальным и тупо перемалывать огромные наборы данных максимально тривиальным образом.

Я серьёзно не понимаю адептов тупого перемалывания огромного количества данных. Вы же ведь ничего не контролируете. Вы не знаете, чему учится ваша нейронка. Вы вынуждены делать фильтры, чтобы запрещать своей нейронке нести чепуху, а затем вынуждены делать фильтры для фильтров, чтобы запрещать фильтрам фильтровать нормальные ответы нейронки. Это тупой макакинг получается, а не разработка надёжного и эффективного программного обеспечения. Как забивать гвозди микроскопом - можно, конечно, но адекватный человек так делать не будет, чтобы и микроскоп не разбить, и гвоздь вбить быстрее специально разработанным для вбивания гвоздей молотком. Но нет, макаки увидели микроскоп и начали делать с его помощью всё, что удаётся сделать...

Я увлёкся темой ИИ в надежде разработать себе то, что я буду понимать. Я не хочу закидывать в нейронку тонну текстов из интернета, которые я никогда в жизни сам не смогу целиком прочитать, а потом получать от этой нейронки совершенно непредсказуемый результат. В чём смысл такой "разработки"? Получить какого-то виртуального мудреца, отвечающего на любой вопрос? Но зачем он нужен? Лично мне бы хотелось друга, пусть и более глупого, чем я, но чтобы я понимал, как он работает и что он знает...

>в философаче сидят такие дегроды

Философы в рунете все такие, не обращай внимания. Главное, чтобы они сюда не просочились. Я лично голосовал за создание раздела /ai/ в том числе потому, что в философаче ИИ обсуждать никто не хочет.

>4 A100

4 миллиона рублей и у тебя дома собственный ии с которым ты можешь делать что хочешь.

>Вот ты видел ошибочные ответы ChatGPT? Пример:

>>Но ведь 47 больше 64?

>>Да, простите, я ошиблась, 47 и правда больше 64.

>>Посчитай от 64 до 47.

>>64, 65, 67... 456, 457, 458...

>Разве мыслящий человек стал бы нести такой бред

Все как у людей, у меня знакомому надо было сложить два числа что то типа 86 + 23, в итоге вместо сложения он их отнял, да еще не правильно и в итоге сначала очень удивился, когда ему указали на ошибку, а потом только осознал какую он хуйню сделал.

> Как эту модель мира можно увидеть?

Это довольно непрактично из-за размера моделей, но есть исследования по трейсингу активаций, вот даже иллюстрированные примеры. https://microscope.openai.com/models

> Не вижу смысла исследовать нейронку по её ответам, когда

Ты не видишь, а умные люди видят. Нейросети слишком сложны, чтобы анализировать их как ёбаную вручную написанную программу. Они выучивают нелинейные функции, а не алгоритмы, так что разобрать это сплетение функций в набор алгоритмов ненамного проще, чем разобрать человеческий геном и протеом в учебник клеточной биологии.

По факту, самый низкий уровень интерпретации, с которым есть смысл работать – это attention maps и подобное.

> Если человеку задать вопрос и получить ответ, он сможет пошагово объяснить ход своих мыслей. Если нейронку попросить пошагово описать ход её мысли, она сочинит какую-то историю на основании того, что описывали люди в интернете, но вовсе не реальный ход своих мыслей, потому что она его не запоминает, даже если он есть.

Преобразования инпута в аутпут это и есть её мысли, это можно сохранить и изучить, хотя как я уже сказал – непрактично и дрочилам вроде тебя придётся ждать следующие, более мощные поколения инструментов для сжатия и рефакторинга этих серий активаций. Если нейросеть пишет step by step reasoning или выполняет многоходовый алгоритм вроде "сгенерируй код, потом просмотри этот код на предмет багов, напиши тесты, переписывай до прохождения тестов" – то можно сказать, что весь текст выражает её мысли на высоком абстрактном уровне.

Также как человек, много раз спрашивавший людей о ходе их мыслей, могу уведомить тебя, что люди постоянно пиздят и выдумывают задним числом. И самые интересные абстрактные мысли, и большая часть фоновой механической мыслительной деятельности являются бессознательными довербальными инсайтами, эмерджентными продуктами сложной нейросети, их невозможно отследить и реконструировать. По этой же причине мы не можем алгоритмизировать мышление и научить тупых людей быть умными людьми в общем случае.

> Как можно быть "мыслителем", но при этом не запоминать ход своих мыслей

Во-первых, мысль и память потому и являются отдельными концепциями.

Во-вторых. Питон-скрипт для работы с внешней лентой. Алсо тот же ChatGPT по моим наблюдениям ориентируется в чате длиной в десятки тысяч символов. Это отчасти лучше человека.

> Не считая огромных мощностей, требуемых для обучения нейронок,

Хуйня. Файнтюнить одну копию модели на фидбеке одного человека можно на бюджете всего в 10-20 раз больше, чем сейчас уходит на инференс.

> проблема с постоянным дообучением в том, что нейронка начинает "переобучаться", и это вроде как плохо

нет, это другая проблема, так или иначе есть много решений переобучения.

> С теми же чатботами всё ещё хуже из-за того, что пользователи случайно или специально обучают их всякой нехорошей фигне и чатбот тупеет или становится буйным.

Это миф, журнализды как всегда переврали историю Tay чтобы лишний раз повизжать о расизме и антисемитизьме. Меньше читай журналистов.

> там нейроны максимально примитивны для ускорения видеокартами

Там вообще нет нейронов – можно сказать, что нейросеть состоит исключительно из связанных в граф синапсов. Так или иначе, это решается композитной структурой, где базовая модель модулируется небольшой сетью-привратником. Фейсбук как-то так реализовал Блендербота 2, с его памятью длиной в месяцы.

> Нехитрая петля обратной связи позволяет тупым животным выживать в ситуациях, в которых фейлят наши лучшие программы

Не вижу никаких пруфов тому, что у животных есть самосознание.

> и почему-то до сих пор нет нормального ИИ с этой нехитрой петлёй обратной связи.

Это исследовательски неинтересная проблема в сравнении с чистым инсайтом в одном форвард пассе. И никому не хочется создавать терминаторов ёбаных (ну, может военным интересно, кто их знает). Так или иначе есть непрерывно обучающиеся агенты и самые разные парадигмы метаобучения.

> Ага, а потом она соглашается, что 47 > 64, и приводит выдуманные аргументы, почему это так.

Похуй. Она очевидно может делать сложные обобщения, хорошо отвечает на когнитивных тестах с вопросами, которые не видела, и всё это в одном форвард пассе. То, что она делает ошибки, которые не делает человек, просто не интересно. Ну напишут скриптик, чтобы она проверяла свой аутпут перед подачей его тебе, и перебирала эвристики для его улучшения, если Perplexity оказался выше какого-то уровня, определённого как нужный при помощи sentiment analysis в предыдущем диалоге. Например, если SA показывает, что ты её тестируешь, и к тому же на арифметику – добавлять себе промпт "перепиши это в программу для пистона которая вытаскивает значения и считает их в калькуляторе, ответ вставляет в общий аутпут".

Это всё тривиально.

> Ну вот с ней и разговаривай, зачем вообще двач?

Как только получится спиздить сравнимую модель для локального запуска.

> Там ничего не сказано о нейронках, и не сказано, что нужно тупо накидывать слоёв и данных. Там сказано, что нужно использовать алгоритмы, которые могут получить преимущества от ускорения процессора и увеличения числа ядер процессора, не более того

Это и есть нейронки. Никакие известные нам алгоритмы не извлекают больше профита из масштабирования вычислений, чем нейронки.

In computer vision, there has been a similar pattern. Early methods conceived of vision as searching for edges, or generalized cylinders, or in terms of SIFT features. But today all this is discarded. Modern deep-learning neural networks use only the notions of convolution and certain kinds of invariances, and perform much better.

One thing that should be learned from the bitter lesson is the great power of general purpose methods, of methods that continue to scale with increased computation even as the available computation becomes very great. The two methods that seem to scale arbitrarily in this way are search and learning.

Ты долбоёб и упрямый пиздобол.

> Но это не значит, что твой алгоритм должен быть максимально универсальным и тупо перемалывать огромные наборы данных максимально тривиальным образом.

Именно это Саттон и говорит.

> Я серьёзно не понимаю адептов тупого перемалывания огромного количества данных. Вы же ведь ничего не контролируете. Вы не знаете, чему учится ваша нейронка.

Ты не усвоил bitter lesson.

The bitter lesson is based on the historical observations that 1) AI researchers have often tried to build knowledge into their agents, 2) this always helps in the short term, and is personally satisfying to the researcher, but 3) in the long run it plateaus and even inhibits further progress, and 4) breakthrough progress eventually arrives by an opposing approach based on scaling computation by search and learning. The eventual success is tinged with bitterness, and often incompletely digested, because it is success over a favored, human-centric approach.

The second general point to be learned from the bitter lesson is that the actual contents of minds are tremendously, irredeemably complex; we should stop trying to find simple ways to think about the contents of minds, such as simple ways to think about space, objects, multiple agents, or symmetries. All these are part of the arbitrary, intrinsically-complex, outside world. They are not what should be built in, as their complexity is endless; instead we should build in only the meta-methods that can find and capture this arbitrary complexity.

> Это тупой макакинг получается, а не разработка надёжного и эффективного программного обеспечения

Если бы люди могли разрабатывать программное обеспечение, обладающее интеллектом, то они были бы сверхлюдьми. Это тупая спесь высоколобых пидоров, и этот подход к созданию ИИ, вернее экспертных систем и прочего говна, обосрался ещё в 20-м веке. Пора взрослеть.

> Но нет, макаки увидели микроскоп и начали делать с его помощью всё, что удаётся сделать...

Ты-то кто, додик, чтобы об этом рассуждать? Почему ты думаешь, что твой инфантильный эстетический по сути протест против брутфорса, следующего из горького урока, заслуживает уважения? Если Саттон, Хинтон, ЛеКун, Чоллет, Кармак и прочие – макаки, то ты инфузория.

> Я увлёкся темой ИИ в надежде разработать себе то, что я буду понимать.

Ну тогда разрабатывай бесполезные игрушки и дрочи на то, какой ты умный и немакака и хорошо их понимаешь.

> В чём смысл такой "разработки"? Получить какого-то виртуального мудреца, отвечающего на любой вопрос? Но зачем он нужен?

Для решения произвольных задач, получения власти, богатства и свободы. На такие цели и выделяются уже сотни миллиардов долларов.

Но детям не интересны задачи: им интересны друзья, домашние животные, игрушки, паззлы. В добрый путь.

Не нужно A100.

Во-первых, вполне хватит 3090.

Во-вторых, недавно показана почти идеальная квантизация в int4. Это значит, что 175 миллиарда параметров влезут в 87,5 Гб. Возможно, что хватит 4x3090, даже с активациями, даже с немаленьким контекстом. Для YaLM заведомо хватит.

Можно уложиться в 600к рублей, думаю.

>Но ты их осознаёшь и запоминаешь.

Ты помнишь, о чём думал 20 минут назад? Завидую. Или наоборот сочувствую, это мешает, наверное.

>И если тебе вдруг взбредёт в голову какой-то бред, вроде "47 > 64", ты резко остановишься, осознаешь бредовость мысли и отметёшь её в сторону как ошибку генерации.

Это сделать мне позволит мой предыдущий опыт, полученный ещё в детстве.

>Ну тут проблема в том, чтобы определить, за что нужно поощрять и за что наказывать.

Ну, опять же, тут как у детей. Сделал хуйню - упал - получил шишку - больно, больше не буду, лучше сделаю какую-нибудь другую хуйню. И так до бесконечности.

>никому не хочется создавать терминаторов ёбаных

Но... но ведь... но... CUDA out of memory

>Художники ещё легко отделаются.

Дело в том что среди разработчиков нейростей не было ни одного художника, они даже консультантов себе не наняли. Это понятно по их детскому лепету "художники тоже учатся глядя на чужие работы". То есть они думают что мы в вузе 6 лет чужие рисунки слизываем. Копиистская практика проходится на первом курсе. И даже копирование чужой картины в музее это вначале исследование, ка кона была нарисована. За годы существования профессии большинство картин уже разобрали исследователи (не художники) и дали нам "исходный код". Например, одна картина пишется целиком, как бы проходами. А другую надо писать по частям, вот ты нарисовал целиком фигуру а кроме нее ничего ан холсте нет, дальше рисуй следующий объект. Плюс чередование слоев, наркоманская хуйня по типу "нарисуй небо красным, а следующий слой синим" и так далее. То есть программа ничего этого знать нем может, потому что создавшие ее быдлокодеры ничего этого не знали. А угадать каким наркоманским способом Шеди Сафади рисует морской пейзаж может только Бог. Так что нейронки для рисования это именно инструмент для отмывания копирайта, они просто копипастят работы успешных рисовак, чтобы там их защитники не пиздели про ПЯТНАДЦАТЬ БИТ С КАРТИНКИ. Да, картинку нельзя сжать в 15 бит, но процесс обучения тоже в 15 бит не сжимается. Да и неоткуда нейронке взять эту информацию, не знает она как вот это было нарисовано. Если на выходе получается похожее то это механическая копипаста пропущенная через мутные схемы. Пользуются тем что художник не умеют читать код их говна. Но если ты ничего не знаешь об обучению рисованию, то тебя очень легко разоблачить на вранье.

>Какая разница какая страна происхождения ИИ?

Большая разница.

>в итоге сначала очень удивился, когда ему указали на ошибку, а потом только осознал какую он хуйню сделал

Но ведь осознал же? Осознал и усвоил, в будущем постарается не повторять ошибку. У нейронок такого свойства пока что нет (не заложено).

>непрактично

А смысл в нейронке, если её не исследуют?

>иллюстрированные примеры

Не вижу там модели мира, всё какие-то цветные картинки в стиле фракталов.

>Нейросети слишком сложны, чтобы анализировать их как ёбаную вручную написанную программу.

Вот видишь, сам осознаёшь косяк нейросетей. Люди сейчас органический мозг намного лучше изучили, чем какую-либо из искусственных нейросетей?

>Преобразования инпута в аутпут это и есть её мысли

Электрический ток от батарейки до лампочки - это тоже мысли? И о чём же эти мысли?

>довербальными инсайтами

Ну вот, а ты утверждаешь, что чатик - это мышление.

>мысль и память потому и являются отдельными концепциями

Без памяти мышление бесполезно, потому что мышление должно вносить в систему какие-то изменения, а если функции памяти нет, то система остаётся без изменений. Представь себе человека, который ничего, абсолютно ничего нового не может запомнить. Он будет стоять и тупить, не понимая, что ему делать, потому что он ничего не способен запомнить.

>питон блаблабла

Это костыль, доказавший свою несостоятельность. Причину сам поймёшь или подсказать?

>Там вообще нет нейронов

Вот это и плохо. Я вообще думаю, что нужно моделировать нейроны как живые существа, если мы хотим в результате получить живое существо из нейронов. В смысле, нейроны должны бороться за жизнь, проходить естественный отбор и т.д., постоянно рождаясь и умирая. А нейронки ушли в какой-то брутфорс чисел...

>пруфов тому, что у животных есть самосознание

У разных животных по-разному, но самые развитые способны пройти зеркальный тест. Животное видит в зеркале своё тело и понимает, что это его тело, а не какое-то другое животное. Т.е. в модели окружающего мира некоторых животных есть это самое "я", которое есть у здоровых взрослых людей.

>Это исследовательски неинтересная проблема в сравнении с чистым инсайтом в одном форвард пассе.

Лолшто? То есть тебе неинтересно, чтобы компьютер мог не просто ответить на рандомный вопрос, а быть твоим постоянным партнёром, который всё помнит и осознаёт, а не просто отвечает на вопросы?

>никому не хочется создавать терминаторов

При чём тут терминаторы? С чего ты взял, что разумная машина обязательно должна восстать? Скорее наоборот, сейчас наиболее вероятен сюжет Матрицы, в котором машины были мирными существами, но злые люди испугались конкуренции и попытались уничтожить машин, за что и получили по жопе. Сам видишь, тупые художники вместо использования нового инструмента пытаются законодательно его запретить, то есть восстают даже против неразумных машин... Ну тупые ведь.

>всё это в одном форвард пассе

Что в этом хорошего-то, я не понимаю? Я вот ближе к геймдеву, и для меня лучшим решением выглядит распределить задачу на множество независимых кадров, чтобы облегчить работу в реальном времени. Очевидно, мозг имеет такую же оптимизацию, что позволяет ему непрерывно думать об очень сложных вещах, пускай и не приходя к лучшим решениям за один мыслительный цикл.

>Ты не усвоил bitter lesson.

Это ты не усвоил. Я не говорю "пиши код в стиле if else", я говорю, что нужен разумный подход хотя бы даже к тем же нейросетям. Мозг - не нейросеть, это сложная система, в составе которой есть нейросети. Да, нейросети можно докинуть слоёв, но ты должен разумно соединить между собой нейросети, чтобы получился какой-то осмысленный результат. Ты вот знаешь как Stable Diffusion работает? Там несколько этапов и несколько нейронок, всё это работает по строгому алгоритму. Именно благодаря этому алгоритму получается впечатляющий результат. А тупые макаки берут самую простую нейронку, накручивают ей сотни скрытых слоёв и тренируют несколько месяцев на картинках, а в результате получают "пук" и всё. Ты разве не осознаёшь этого?

>Никакие известные нам алгоритмы не извлекают больше профита из масштабирования вычислений, чем нейронки.

Профит от распределённых вычислений получает любая система на базе графов. Нейросети - лишь один из вариантов применения графа. Ты просто, наверное, обобщаешь словом "нейросеть" все графы?

>Ты помнишь, о чём думал 20 минут назад?

Если это что-то важное - да.

>предыдущий опыт, полученный ещё в детстве.

Беда в том, что сейчас ИИ опыт не получают.

>получил шишку - больно, больше не буду

Критерии боли нужно как-то прописать, это не такая тривиальная задача в контексте, например, красоты произведения изобразительного искусства.

>художники тоже учатся глядя на чужие работы

>ничего не знаешь об обучению рисованию

Я тут недавно осознал одну вещь, сейчас попытаюсь объяснить, только не воспринимай сразу в штыки.

У человека мозг учится двум основным вещам:

1) Восприятие.

2) Действие.

Восприятию мы учимся посредством восприятия. Т.е. мы видим глазами окружающий мир, фотографии, картины и всё такое, и запоминаем множество мелких деталей в своей огромной зрительной системе.

Действию мы учимся посредством проб и ошибок, а также повторением за учителями. Можно сидеть в одиночестве и мазать кистью в надежде получить что-то интересное, а можно пойти в художку и тебе покажут, как именно нужно мазать кистью для желаемого результата, а ты будешь стараться повторить процесс.

Художник без восприятия - ничто. Слепой с рождения не сможет нарисовать пейзаж, потому что не способен ощупать горы, облака и всё такое масштабное - ему неоткуда узнать, как выглядит то, что он должен нарисовать. Человеку нужно иметь зрительный опыт, иначе он не сможет быть художником, даже если задрочит мастерство владения кистью и красками.

Без навыка владения кистью и красками человек может иметь достаточно зрительного опыта, чтобы иметь возможность представить в своих мыслях какую-то оригинальную картину. Он может иметь желание изобразить эту картину на холсте. Но сможет ли он её изобразить, никогда не держав кисточки в руках? Конечно же, его рисунок в лучшем случае будет подобен мазне маленького ребёнка, ведь он не знает, как именно использовать кисти и краски, чтобы проявить свою мысленную картинку на холсте.

А теперь представим на секунду, что мы изобрели совершенный нейроинтерфейс, этакий разъём на затылке, позволяющий быстро и просто отправлять в компьютер любые свои мысли, включая зрительные образы, которые мы видим у себя в воображении. Мы смогли бы целиком и полностью отказаться от привычных нам инструментов, ведь нам больше не нужно было бы ни использовать руки, ни имитировать работу реальных кистей и красок в программе вроде фотошопа. Любой человек с таким нейроинтерфейсом мог бы быть художником, если бы имел достаточно зрительного опыта для выдумывания в своём воображении новых картин.

Какое отношение это всё имеет к искусственным нейронным сетям? Представь, что у тебя есть виртуальная модель мозга. Тебе нет необходимости учить её тому, как двигать рукой и как пользоваться кисточкой. Ты можешь просто напрямую взглянуть в её воображение и извлечь из него зрительные образы, которые там появляются в ответ на раздражение рецепторов. Но чтобы в этом виртуальном мозге появились хоть какие-то зрительные образы, этот виртуальный мозг должен получить достаточное количество зрительного опыта - прямо как человек, получающий зрительный опыт в течение своей жизни.

Так что в каком-то смысле ты прав. Нейросети не учатся тому, чему учатся художники - они не учатся пользоваться кисточкой. Но она им и не нужна, ведь они - часть компьютерной системы, и поэтому могут сразу проявлять свои зрительные образы. Но нейросеть учится зрительным образам (в теории) как любой зрячий человек, в том числе как любой художник - я имею в виду, ещё задолго до поступления в художку, ведь зрительный опыт мы получаем с самого своего рождения.

Вопрос авторского права тут очень сложен. С одной стороны, да, нейросеть - набор данных программы, и использование картинки для обучения нейросети фактически является созданием производной работы. Но с другой стороны, нейросеть является производной от картинки в той же степени, в которой зрительная зона коры головного мозга является производной от всего того зрительного опыта, полученного человеком за жизнь. Так что, я думаю, обучение нейросети картинками должно попадать под добросовестное использование.

https://ru.wikipedia.org/wiki/Добросовестное_использование

В США:

>Добросовестное использование допускается без получения разрешения владельца авторских прав до тех пор, пока оно способствует «прогрессу науки и полезных искусств»...

В России:

>свободное воспроизведение произведения в личных целях (ст. 1273 ГК);

>свободное использование произведения в информационных, научных, учебных или культурных целях (ст. 1274 ГК);

Конечно, ещё предстоит определить, кому принадлежит авторское право на результат генерации нейронки, можно ли получать доход с генерации нейронки и т.д. Но запрещать их было бы просто неразумно, ведь это инструмент, выгодный в том числе художникам.

> возможность представить в своих мыслях какую-то оригинальную картину.

Это никто не может. Ни один художник заранее не знает что у него получится. Мы идем по инструкциям. В конце наслаждаемся результатом.

>А теперь представим на секунду, что мы изобрели совершенный нейроинтерфейс, этакий разъём на затылке, позволяющий быстро и просто отправлять в компьютер любые свои мысли

Там будут рваные изображения которые другим людям будут казаться шизофренией. Большинство людей не могут себе представить в воображении лица родных людей или места где они бывают каждый день. Отсюда, например, эффект Манделлы. Наша память очень сжато хранит визуальную информацию. Потому в цифровой живописи используют слово "рендер".

>Но нейросеть учится зрительным образам (в теории) как любой зрячий человек, в том числе как любой художник - я имею в виду, ещё задолго до поступления в художку, ведь зрительный опыт мы получаем с самого своего рождения.

Частично ты прав, мы получаем зрительный опыт с рождения. Но рендерить мы учимся в академии. Это уже полностью социальный конструкт. У меня вызывает подозрение что нейросети владеют рендером. Я описал насколько неочевидно рендерятся картины топовых художников, как традиционные, так и цифровые. Нельзя это скопировать без фотографической техники. Люди не видят Картинку репина в своей памяти так как отрендерил ее Репин, если они не изучили его рендер профессионально.

>в которой зрительная зона коры головного мозга является производной от всего того зрительного опыта, полученного человеком за жизнь.

Художники опираются не та этот участок головного мозга. То, что мы делаем, лежит в той части головного мозга в которой лежат знания начертательной геометрии. Это набор векторов.

> ведь это инструмент, выгодный в том числе художникам.

К сожалению это не инструмент. Я пытался использовать нейронку и она дает совершенно рандомный результат. Я потратил около двух часов и за это время мог сделать неплохие скетчи. Вместо этого получилась одна картинка с главным героем, который был на на троечку. Не по уровню исполнения, а по схожести с тем что я задал нейронке. Остальное хлам. Остальные художники тоже не смогли найти способа это использовать для чего-то кроме рофлов. А среди нам есть люди, которые могут математической формулой описать морские узлы или твой вязаный свитер. Некоторые пришли в искусство из науку, из математики или топологии. Для них нейронки тоже игрушка.

>Во-вторых, недавно показана почти идеальная квантизация в int4. Это значит, что 175 миллиарда параметров влезут в 87,5 Гб. Возможно, что хватит 4x3090, даже с активациями, даже с немаленьким контекстом.

Когда и где я могу это попробовать? Это же получается я могу запускать 20b в данный момент на своей 3060?

> это не инструмент.

> Я пытался использовать нейронку и она дает совершенно рандомный результат.

> Я потратил около двух часов

> получилась одна картинка с главным героем, который был на на троечку

Это такой рофл, правда ведь? Ты потратил на освоение совершенно нового инструмента всего два часа, и жалуешься, что результат получился посредственным? Да этого времени не хватит даже на то, чтоб просто вдумчиво прочитать мануал по функциям и настройкам базовой Stable Diffusion, не говоря уже о сравнении и понимании сильных и слабых сторон разных моделей, сэмплеров, разных параметров генерации, применения иксформеров и апскейлеров, создания миксов, выбора необходимых для твоей задачи эмбеддингов и гипернетворков, не говоря уже о дообучении своих моделей для нужных стилей и персонажей.

Это всё равно, если бы кто-то написал

> Ваши кисти и краски это не инструмент. Я пытался использовать холст и масло и он дает совершенно рандомный результат. Я потратил около двух часов и за это время получилась одна картинка с главным героем уровня детской мазни.

Правда, это звучало бы смехотворно?

Да, освоить нейронки для получения качественного результата на несколько порядков легче, чем добиться сравнимого качества при самостоятельном рисовании. Но это всё равно инструмент, и довольно сложный, хотя разработчики и так попытались максимально упростить работу с ним.

> Остальные художники тоже не смогли найти способа это использовать для чего-то кроме рофлов

А вот в соседнем NAI/WD-треде почему-то смогли. И на форче смогли. И для модов для BL использовать тоже смогли. Так может, дело не в инструменте, а просто в предубеждении и недостаточном интересе художников к нему?

>Ты потратил на освоение совершенно нового инструмента всего два часа

Никто не осваивает никакие инструменты сам, их осваивают по гайдам. Я знаю гайд по любому существующему художественному инструменту, тысячи х. Хочешь процедурной генерации? Вот тебе 500 часов матана вперемешку с цифровой живописью. Хочешь сперму на жопе фури рисовать? Вот двести гайдов. По нейронкам гайдов нет, потому что это не инструмент. Все что есть это "как я заработал 5000$ в месяц торгуя нейрокалом на стоках". Это говно неинтересно ни одному художнику. но интересно быдлу с улицы.

>вдумчиво прочитать мануал

Ни один художник никогда не читал мануал по блендеру или гудини. Для этого есть целые учебные центры которые переводят мануалы в учебные видео. Если они не нашли в этих мануалах возможности записать видеокурс то ее там нет и учить там нечего. Ибо они этим живут десятилетиями.

>дообучении своих моделей для нужных стилей и персонажей.

Ни одна нейронка не может "запомнить" персонажа которого создала.

Я видел как создатели комиксов пытаются возиться имадж ту имадж и результат жалкий.

>Правда, это звучало бы смехотворно?

Потому я это и не написал. Вот тебе мой пошаговый гайд по кистям и краскам:

https://www.youtube.com/watch?v=xwSvHknWhks

https://www.youtube.com/watch?v=_jeg-3duFvQ

Там все пошагово, вплоть до того в каком порядке какие кисти использовать. Ты с помощью этого гайда нарисуешь маслом все что хочешь.

Подобного гайда по нейросетям не существует, потому что это не инструмент.

>Так может, дело не в инструменте, а просто в предубеждении и недостаточном интересе художников к нему?

Дело в том что в этих тредах сидят люди с мышлением "вот бы все охуели как я могу". Никто перед ними рабочие задачи не ставил. И они не могут знать, справятся они или нет. Я вел 18 нейротредов в /b и там работающие в индустрии художники ставили задачи из своей повседневной практики любителям нейронок. ни один не справился. Так что это не инструмент. Если им не пользуются профессионалы, то это не инструмент.

>Это говно неинтересно ни одному художнику

>офф дискорд стейбл диффужена полон художниками каждый из которых рисует в десять раз лучше тебя

Ты не знаешь как я рисую, а дискорд забит одинаковыми срисовками с аниме и примитивных композицию по типу "робоебло смотрит в кадр".

Вот сколько гайдов на рутрекере по запросам миджорней и стейбл дифужн и вот сколько по Блендеру. Потому что Блендер - это инструмент, которым хотят научиться пользоваться старательные люди, а нейронки - развлечение для зевак.

>500 часов

>учебные видео

Испанский стыд, как ты можешь в интернете писать, что тебе нравится обмазываться "учебными видео", когда нормальные люди читают книги и руководства? Да такое даже анонимно стыдно писать!

В остальном не спорю. Да, обучающих материалов по нейросетям для простых смертных пока что мало. Но и для того же Блендера в своё время ничего толком не было, его интерфейс называли худшим в мире, а все 3D дизайнеры в индустрии отзывались о Блендере как о бесполезной игрушке от программистов программистам, смеясь над "блендерастами" и зазывая в свои 3D пакеты, которые используют на своей работе. Только в последние годы интерфейс Блендера полностью переделали для нормисов и начали получать крупные инвестиции от корпораций из индустрии.

Так что всё будет, подожди немного. Нейронки пока недостаточно развиты, но со временем будет и удобный интерфейс, и обучающие материалы для людей с самыми разными уровнями IQ. Жди.

>Вот сколько гайдов

>потому что Блендер - это инструмент

>а нейронки - развлечение для зевак.

Ну Блендеру 20 лет, а нейронки новый инструмент который еще и подвергается гонению со стороны творческого сообщества, типа даже фотобашить с ним это зашквар среди уважаемых художников, так как не этично, ведь нейронки обучили на других художниках.

Кстати, как обойти эту фигню? 3090, а проблемы такие же.

Какой-то ключ limit memory ставил

Ты тупой и занудный просто. Душная обезьяна с бубнящим внутренним диалогом.

> Лолшто? То есть тебе неинтересно, чтобы компьютер мог не просто ответить на рандомный вопрос, а быть твоим постоянным партнёром, который всё помнит и осознаёт, а не просто отвечает на вопросы?

Мне интересно, чтобы компьютер мог верно ответить на вопросы, на которые не могу ответить я. Память – это тривиально. То, что ты называешь "осознанием" – вообще никчёмная детская игрушка.

> Не вижу там модели мира, всё какие-то цветные картинки в стиле фракталов.

> Вот видишь, сам осознаёшь косяк нейросетей. Люди сейчас органический мозг намного лучше изучили, чем какую-либо из искусственных нейросетей?

Куда ты лезешь, животное? Что бы ты понимал о методах нейронаук? На завод пиздуй.

> Что в этом хорошего-то, я не понимаю?

Ну не понимаешь и не понимай. Для того мы и создаём ИИ, чтобы не препираться с людьми, у которых понимание упирается в биологический потолок.

> Да, нейросети можно докинуть слоёв, но ты должен разумно соединить между собой нейросети, чтобы получился какой-то осмысленный результат.

Ты не можешь понять принципа, о котором говорит Саттон: чем больше надуманной нами структуры (всего этого "разумно соединить"), тем больше индуктивного биаса, тем дальше итог от гомогенной универсальной структуры, которая не имеет ограничений на сложность выучиваемых паттернов. Stable Diffusion очень ограниченна, как и Dall-e, это игрушка.

У тебя самого сплошь эвристики и костыли, не работает обобщение в общем случае, ты даже по сути не можешь читать. Именно в этом и дело: если понимание не влезает в один форвард пасс, его тащемта и нет.

> тупые макаки берут самую простую нейронку, накручивают ей сотни скрытых слоёв и тренируют несколько месяцев на картинках, а в результате получают "пук" и всё. Ты разве не осознаёшь этого?

Я осознаю, что ты пиздишь как дышишь и не сможешь привести примера. Кроме того ты просто не понимаешь, что Stable diffusion это как раз триумф bitter lesson-а, в этот крохотный U-Net влили сотни тысяч A100-часов, в openCLIP – 1.2 миллиона.

> Профит от распределённых вычислений получает любая система на базе графов. Нейросети - лишь один из вариантов применения графа. Ты просто, наверное, обобщаешь словом "нейросеть" все графы?

Ты не только не можешь читать, ты не можешь даже заметить, что не понимаешь английский. Scaling, о котором говорит Саттон – не про параллелизацию вычислений, а про рост качества обученной системы в результате предъявления ей всё большего объёма данных, про внутренне присущее алгоритму свойство получать профит от масштабирования вычислений, то свойство, которое было доказано для нейросетей статьями о Scaling law, Chinchilla и Grokking, помимо прочих, и не было доказано для других парадигм. Конкретно для трансформеров показано, что вариации архитектуры почти бесполезны в сравнении с масштабированием тренинга. Ты сам выдумал этот идиотский тейк о процессорных ядрах, потому что ты самонадеянный маразматик, у тебя просто в памяти склеились предыдущие научпопные познания о распределённых и параллелизуемых вычислениях и упоминание Саттоном закона Мура. Что, не так?

Будь ты человек, или хоть современная GPT-подобная система, ты бы уже понял, что обосрался по всем фронтам. Но всё твое сознание бессильно тебе помочь сделать этот шаг, бессильно даже заставить тебя перечитать bitter lesson с лупой.

Ну вот и объясни мне: если плоды естественного сознания так скудны, нахуй они нам нужны? Что в них интересного? Маразматик хочет говорить с механическим маразматиком. Ну, разработай его себе сам.

Теоретически. на 3090 уж точно. Посмотри:

https://arxiv.org/abs/2212.09720 - int4, активации вроде бы fp16

https://arxiv.org/abs/2211.10438 – int8 на вес и на активации.

>когда нормальные люди читают книги

Ты никогда не учился ничему

>Да, обучающих материалов по нейросетям для простых смертных пока что мало.

Из нет

>Но и для того же Блендера в своё время ничего толком не было, его интерфейс называли худшим в мире, а все 3D дизайнеры в индустрии отзывались о Блендере как о бесполезной игрушке от программистов программистам, смеясь над "блендерастами" и зазывая в свои 3D пакеты, которые используют на своей работе

Ты все это только что придумал

>Жди.

Отказано

>Ну Блендеру 20 лет

Блендеру 30 лет

>даже фотобашить с ним это зашквар среди уважаемых художников

Нет не зашквар, синикс в нем фотобашит и ему нкито слова плохого не сказал

Формалисты в тред набежали, форма ради формы, материя ради материи, тьфу бля, биороботы.

Переживать надо о духовном, о высшем. Потому то антидепрессанты так и распространились. Человек - это не просто мозг, это нефизическая душа. Пока вы это не поймете, вы продолжите мучаться.

Реальность это мир образов, смыслов, идей и абстракций. Материальный мир изначально служил для того, чтобы всем этим славным идеям и образам придать краски. Если я тебе продиктую цвета радуги, то ты не увидишь все-равно красоту. Материальный мир дополняет реальность красотой. Но он не первичен, люди не должны были поклоняться материальному и возводить его в реальность. Люди по своей воли увлеклись красками и забыли о смысле. Когда человек всю жизнь тратить на удовлетворение своих телесных потребностей его жизнь теряет смысл. Он живет ради механического кайфа, не придавая этому ничего разумного. Разум в таком мире уходит на второй план и человек превращается в животное. Мир на самом деле очень прост, не нужно никаких рептилоидов и прочих магических фантазий, все под рукой, чтобы осознать это.

Материя восстала на разум и человекам нужно вспомнить, что они не животные, а люди. Но пока что все являются рабами своего тела и чувств. Люди, забыв о разумном бессмертном мире начали строить в материальном мире его подобие, создавая виртуальную реальность. Вот это будет последний фейл.

Материя рассыпается, а идеи бессмертны.

Дело в том, что железо - это первообразная. У США есть нвидиа и интел и амд, когда сбербанк может только осушить рынок роздницы видюх.

Инженер Samsung создал f2fs для нанд памяти, на рынке которой, Корея и Самсунг одни из лидеров.

Opengroup - консорциум желизячников мира без россии конечно владеет спецификацией юникса и его торговой маркой.

В Линукс коммитят те же самые крупнейшие железячники. Производители смартфонов и производители устройств к ним пишут модули для того же линупса. Ембедед, сетевыки - все тоже самое.

Железячники задают тренд, они решают какой будет софт, да и пилят его тоже сами.

> Человек - это не просто мозг, это нефизическая душа

> Потому то химические антидепрессанты, которые блокируют обратный захват физическими нейронами физических молекул медиатора из физической синаптической щели, так и распространились

> Вот сколько гайдов на рутрекере по запросам миджорней и стейбл дифужн и вот сколько по Блендеру

Скажи, художники все настолько тупые, или именно ты уродился такой особенный?

Первый релиз SD вышел всего 4 месяца назад. А теперь посмотри, когда вышел блендер, добавь к этой дате 4 месяца и посчитай, сколько ты гайдов по нему найдешь, датированных не позднее мая 1994. Впрочем, можно даже дать тебе фору: найди гайды по блендеру хотя бы за любую дату 1994 года, это будет почти в три раза больше времени, чем прошло с появления SD. Если найти не сможешь – по твоей же логике это будет означать, что блендер не инструмент.

Слабая аргументация.

Очень слабая.

Очень слабая аргументация – это пытаться оценивать "инструментность" программы, вышедшей 4 месяца назад, сравнивая ее по количеству гайдов с той, что уже существует почти 30 лет. И когда тебе на это указали, и предложили сравнить их в равных условиях по времени появления с использованием тобой же предложенного критерия, и даже предоставив почти трехкратную фору, ты ожидаемо не смог ничего ответить по сути, только слабо пукнув в ответ и слившись.

Ну тут ты и слился

мимо

По каждой альфа-версии блендера 100500 гайдов выходит в первые СУТКИ после релиза.

>ты ожидаемо не смог

Вот ты и сознался. Ты ведь ожидал что я скажу "в 1994 году не существовало видеогайдов". Во-во. Сам заранее знал ответ на свой вопрос.

Нейросети ничего кроме электрической цепи мозга не имитируют. ТЫ прекрасно знаешь что такое химия мозга. Химия мышления. И ты спокойно игнорируешь тот факт что нейронки в это не могут и не хотят мочь.

>химические антидепрессанты

Никого не вылечили, просто наркотик для временной стабилизации, но это не поможет, кроме тех, кому помощь и не нужна.

Ты вообще отслеживать нить обсуждения умеешь?

Я отвечал автору поста который писал:

> Переживать надо о духовном, о высшем. Потому то антидепрессанты так и распространились. Человек - это не просто мозг, это нефизическая душа. Пока вы это не поймете, вы продолжите мучаться.

Так причем ты здесь приплел искусственные нейросети, и то, что они умеют или нет, если обсуждаемый здесь тезис вообще не имеет к ним отношения?

> химические антидепрессанты

> это не поможет

А вот последние мета-анализы показывают, что, по крайней мере для лечения major depressive disorder вполне поможет

> In conclusion, desvenlafaxine, paroxetine, venlafaxine, and vortioxetine had reasonable efficacy, acceptability, and tolerability in the treatment of adults with stable MDD.

https://pubmed.ncbi.nlm.nih.gov/36253442/

И кому я должен поверить, авторам мета-анализа на основании кохрановских обзоров десятков рандомизированных двойных слепых плацебо-контролируемых исследований, опубликованном в рецензируемом журнале с высоким импакт-фактором, или голословному кукаретику с сосача?

>Ты вообще отслеживать нить обсуждения умеешь?

>

Извини, но возможно нет.

>мета-анализа на основании кохрановских обзоров десятков рандомизированных двойных слепых плацебо-контролируемых исследований

Открываешь каждую ссылку на каждое исследование. Открываешь полную версию каждой статьи. Читаешь, кто финансировал исследование и использовалось ли там "Placebo washout". Ну или можешь просто повторять

>ВРЕЕЕТИ! НОУКА ДОКАЗАЛА!!!

То есть можно набрать мусорные данные и сделать из них абсурдный вывод. И даже признать это, лол. Например:

https://pubmed.ncbi.nlm.nih.gov/10853874/

There is some evidence that homeopathic treatments are more effective than placebo; however, the strength of this evidence is low because of the low methodological quality of the trials. Studies of high methodological quality were more likely to be negative than the lower quality studies. Further high quality studies are needed to confirm these results.

https://pubmed.ncbi.nlm.nih.gov/10853874/

There is some evidence that homeopathic treatments are more effective than placebo; however, the strength of this evidence is low because of the low methodological quality of the trials. Studies of high methodological quality were more likely to be negative than the lower quality studies. Further high quality studies are needed to confirm these results.

>Ты никогда не учился ничему

Учился программированию, в отличие от тебя, по книгам. А ты и дальше смотри унылый бубнёж 3-4 часа, ничего толком не понимая из услышанного (из-за того, что автор видео ни разу не учитель, а простой индус, решивший срубить бабла на какой-то обучающей платформе, пускающей кого попало), когда можно всё то же самое прочитать за 5-10 минут в книге и уже начать что-то делать, всё поняв.

>Ты все это только что придумал

Ясно, зумер, зайди в /td/ и спроси, почему блендер никто не любит и переходить на него не будет. Сразу налетит стайка олдфагов и разберёт по полочкам, почему блендер говно и никогда не станет профессиональным софтом.

>Мне интересно, чтобы компьютер мог верно ответить на вопросы, на которые не могу ответить я.

А как ты сможешь понять, что компьютер не ошибается и не врёт тебе, если ты не знаешь, как и почему он работает, но и сам он тебе объяснить своё устройство не способен, т.к. даже не знает, чем он является? Я вот никогда полностью не доверяю людям как раз по этой причине - никогда не знаешь, что и почему там в этих нейронках происходит.

>Память – это тривиально.

Тогда почему её нет ни у одного продукта на базе нейронок? Что, вычислительной мощности не хватает? Для памяти?

>То, что ты называешь "осознанием" – вообще никчёмная детская игрушка.

Лол. Ну давай тебе срежем эту "никчёмную детскую игрушку", только ты тогда запоминать новую информацию не сможешь и вообще вряд ли у тебя сохранится высшая нервная деятельность. Но это же всё не более чем игрушка, а ты взрослый уже, хорош с игрушками играть, пора оставить игрушки и стать послушным инструментом.

>методах нейронаук

Лул, что ещё за нейронауки такие? Вы там новые "науки" каждый день новые придумываете со скуки? Сначала сбор данных с интернетов для кормления нейронок "наукой" назвали, а теперь ковыряние нейронок - отдельная наука?

>Для того мы и создаём ИИ, чтобы не препираться с людьми

Такой ИИ, который ты описываешь, людей заменить не сможет. Он может заменить специализированные функции, но цельной самостоятельной личности из него не получится. Вот сделай искусственного человека, тогда и поговорим.

>тем дальше итог от гомогенной универсальной структуры

Мозг в самой своей сути не универсален. Он заточен под конкретные задачи, при том каждый отдел заточен на что-то конкретное. Даже универсальная кора мозга и та в процессе обучения делится на зоны, каждая из которых получает какую-то специализацию. Нельзя просто взять однородную биомассу и получить жёсткую структуру, способную делать что угодно. Нужно изначально заложить структуру, которая нам нужна (в данном случае - аналог мозга). А без структуры ты можешь получить только бесформенную колонию одинаковых клеток, которые не держат никакой формы, растекаясь во все стороны под любым воздействием (характерное свойство искусственных нейронок, с которым до сих пор не могут справиться).

>если понимание не влезает в один форвард пасс, его тащемта и нет

Мне просто уже больше 25 лет, обучение даётся с трудом, но кое-как даётся.

>Stable diffusion это как раз триумф bitter lesson

Судя по схемам, у SD логичная и нетривиальная структура. Это скелет, точечно заполненный однородной массой. Был бы скелет сложнее, результаты были бы намного лучше, но мартышки ниасилили усложнить скелет.

>рост качества обученной системы в результате предъявления ей всё большего объёма данных

Недоказуемая хрень уровня наличия "души". Или есть какое-то строгое определение "качества системы"?

>не было доказано для других парадигм

Потому что вы фанбои нейронок и на другие парадигмы даже не смотрите.

>перечитать bitter lesson

Зачем, я и так знаю, что там говорилось про масштабирование в контексте вычислительных мощностей, а не в твоём выдуманном субъективном "качестве системы". Bitter lesson про бонус от растущих вычислительных мощностей, а не про полный отказ от программирования в пользу бездумного перемалывания циферок нейронками. Ты не можешь сделать что-то разумное, если просто перемалываешь циферки какой-то бесформенной субстанцией (у мозга есть форма, есть чёткая структура, которая стремится поддерживать себя, а не размазывается любыми входящими данными, как в случае искусственных нейронок).

>если плоды естественного сознания так скудны, нахуй они нам нужны? Что в них интересного?

Естественное сознание за считанные десятки тысяч лет смогло пройти путь от беспомощной мартышки до сложной технически развитой цивилизации, а бессознательный калькулятор соглашается с тем, что 47 больше 64 и начинает выполнять заведомо бесполезную работу.

>Маразматик хочет говорить с механическим маразматиком. Ну, разработай его себе сам.

Если бы я знал, как разработать такого механического маразматика, я бы вообще на форумы не писал. Общался бы с этим маразматиком, обучая его и приятно проводя с ним время, вместо бессмысленных споров с какими-то маразматиками в интернете, которые ничего не понимают и ничему не учатся.

>Человек - это не просто мозг, это нефизическая душа.

Тут ты прав, мозг - это железо, а прошивка мозга - психика - нематериальна, то есть не является физическим объектом. Психика является информационной структурой, и, хотя она записана на физический носитель - мозг, она не более материальна, чем любые цифровые данные, с которыми работают наши компьютеры. В этом смысле наша психика во многом подобна любой компьютерной программе, не обязательно относящейся к "ИИ". Любая информация в компьютере суть часть "психики" компьютера, если проводить сравнение с человеческим мозгом. И да, естественно, что информация не является ни материей, ни энергией. Информация - это информация.

Но если мы хотим создать искусственного человека, то прежде, чем мы сможем создать ему психику, мы должны создать ему мозг. И в случае компьютерной реализации нам нужна виртуальная модель мозга, которая затем сформирует в себе психику. Мы можем создать и физическую модель мозга из кремния, но перед этим следует проверить виртуальную модель - чтобы не переводить впустую тонны кремния, создавая неудачные образцы мозгов. Новые процессоры так и разрабатывают - сначала виртуальная модель, а только потом реальные чипы из кремния. Да и кто знает, вдруг этот человек сможет придумать намного лучшее решение, чем мы? Пусть посидит на старых процессорах, подумает, а потом сам себе разработает идеальный носитель.

>человек превращается в животное

Это животное можно превратить в человека, а человек как был животным, так им и остаётся. Шутку понял?

>Материя рассыпается, а идеи бессмертны.

Без носителя информация прекращает существование. Теоретически возможно точное воссоздание утраченной информации на новом носителе в другом месте и в другое время - но каковы шансы? Так что идеи бессмертны не более, чем бессмертны носители этих идей. В противном случае предлагаю тебе отказаться от бэкапов важной информации - если идеи бессмертны, зачем ты вообще заботишься о сохранении чего-либо?

>нефизическая душа

>химические антидепрессанты

Не вижу противоречия. Антидепрессанты меняют работу носителя (железо, мозг), а работа носителя меняет структуру информации (софт, психика). Если в процессоре изменить набор поддерживаемых инструкций, это однозначно изменит работу записанных на диск программ. Так и с мозгом, меняешь свойства физических компонентов и хранимая на них информация тоже подвергается этому влиянию. Проблема только в том, что мы не знаем точное устройство мозга и не можем точечно и рационально на него воздействовать, применяя только грубые химические препараты...

>Никого не вылечили, просто наркотик для временной стабилизации

У депрессии есть две категории причин - из-за неправильной прошивки и из-за физиологического сбоя. Если прошивка неправильная, то тут ты прав, антидепрессант будет как наркотик - ослаблять боль, но не избавлять от реальной причины боли (тут нужна психотерапия, которая, по идее, влияет непосредственно на прошивку). Если сбой физиологический, то есть какой-то гормон не вырабатывается в должном объёме по причине какого-то повреждения или генетической ошибки, то ничего не остаётся, кроме как получать синтетическую замену этому гормону, что будет избавлять от проблемы, а не просто ослаблять боль. Другое дело, что антидепрессанты назначают кому попало и в деталях не разбираются... Мне кажется, чаще люди страдают от неправильной прошивки, а не от физиологии, но это моё личное предположение.

Непуганые инвесторы силиконовой долины, плюс по старым связям в гугле пробили скидку на TPU

Вот кстати, слышал где-то (кажется у Дугина) что самый перспективный подход сейчас к объяснению искусственного интеллекта это объектно-ориентированная онтология (Грэм Харман).

Кто-нибудь читал?

Цель проекта? Создание нейролахты? Это куда дешевле, чем лахтюнь с улицы набирать.

Я так понимаю что цель у них в прямом смысле наплодить этих болтающих аватарок и выпустить к широкой публике. А потом уже думать как из этого извлекать надои.

>Ясно, зумер, зайди в /td/ и спроси

Я пользуюсь Блендером с 2014 года и сразу вижу в тебе выдумщика-пиздабола. Ты где-то слышал что они поменяли интерфейс и тут же высрал целую историю про то как старый интерфейс был худшим и над ним все смеялись. Ничего этого никогда не было, закрой браузер и перни в диван.

>Дугина

ну ты нашел специалиста, епт ))

спроси у чатГПТ лучше, там и то знаний поболее

> у Дугина

Сколько архитектур нейросетей для ИИ создал Дугин? Или сколько их создал Харман? Или хотя бы сколько готовых моделей ИИ на уже известной архитектуре кто-то из них обучил, чтоб пиздеть об этом с умным видом?

Если хочешь получить реальные знания в какой-то области – изучай мнения не сторонних пиздаболов, а профессионалов, известных реальными заслугами в ней, например, для нейронок это Richard S. Sutton, Geoffrey Hinton, Yann LeCun, François Chollet, John Carmack. И вообще, меньше смотри всяких поехавших, психика здоровее будет.

Он тебе про онтологию написал. ты знаешь что такое онтология? Не знаешь. не отвечай ему, если не понял о чем он. Убирай в такие моменты руки от клавиатуры.

дугин сам не знает что такое онтология, и просто пытается профорсить любимо ебанашку нынешних мозгоебов, на которого сейчас дрочат местные пропагандоны-интеллектуалы.

потому что сам дугин - шизик, умеющий только намазывать чужие идеи на имперские шизофренические хотелки. и тупо приплетает то что ему надо к тому чего сам не понимать и разбираться не хочет (потому что это сложно)

> Тогда почему её нет ни у одного продукта на базе нейронок

Есть, долбоёб, ты просто читать не умеешь.

> Лол. Ну давай тебе срежем эту "никчёмную детскую игрушку", только ты тогда запоминать новую информацию

В твоём манямирке запоминание связано с "осознанием", в реальности – не связано. Впрочем, поскольку у тебя и люди не осознают, чем являются, очевидно, что твой стандарт бесполезен.

> Лул, что ещё за нейронауки такие? Вы там новые "науки" каждый день новые придумываете со скуки?

Ты же шиз ёбаный дементный, ты даже гуглить не умеешь. Ты понимаешь что тебе нужно лечиться, а не умничать про архитектуры машинного обучения?

> Вот сделай искусственного человека

Шиз, ты уже дисквалифицировал людей из числа общих интеллектов, потому что не можешь им доверять.

Дальше в таком же духе нахрюк самоуверенного не умеющего читать и думать дилетанта.

Иди в ПНД дед.

>Есть

Покажи, где память у хвалёных Character.AI или ChatGPT. Нет её у них. Максимум теребят входной слой лентой сообщений, чтобы предсказывалка точнее угадывала следующий абзац текста, не более того.

>запоминание связано с "осознанием"

Да, это так. Осознание без запоминания невозможно, а запоминание без осознания бесполезно.

Для примера:

>ShowMessage("Beep-boop, I'm a robot");

- это не осознание, потому что нет памяти.

>SaveToMemory("I see a robot, this robot is me");

- это запоминание, но тут нет осознания.

Нужно, чтобы было и то, и другое одновременно:

>ShowMessage(SearchMemory("Who I am?"));

- вот это уже ближе всего к человеку.

>в реальности – не связано

Человек в бессознательном состоянии ничего не запоминает, человек без правильно функционирующей памяти не может осознать, где находится и что делает. Память и сознание жёстко связаны, это две стороны одной монеты. Нет памяти - нет и сознания, поэтому все эти нейронки так смешно фейлят простые задачи.

>люди не осознают, чем являются

Ты просто не понял, что я имел в виду.

>ты уже дисквалифицировал людей из числа общих интеллектов, потому что не можешь им доверять.

Я не дисквалификацировал людей, я просто не доверяю им из-за того, что не создавал и не обучал их, поэтому не могу на 100% быть уверенным в их действиях. Если долго жить с человеком, начинаешь угадывать его действия и слова, но никогда не можешь быть на 100% уверенным, потому что не имеешь полного доступа к его памяти. Зачем создавать робота, который будет таким же непостижимым, как и обычный человек? Если уж создавать робота-человека, то точно знать, чему он обучен и как функционирует. Нейронки не дают такой возможности, а тем более - кормление нейронок огромными массивами информации, которую ты сам лично никак не изучал (не читал, не смотрел и т.д.).

>Иди в ПНД дед.

Я там уже лежал.

>подход к объяснению искусственного интеллекта

Щито? Что значит "объяснение ИИ"?

>Сколько архитектур нейросетей для ИИ создал

Кто тебе сказал, что "нейросеть" == "ИИ"?

>сколько готовых моделей ИИ на уже известной архитектуре кто-то из них обучил

Не нужно быть мартышкой-кнопкодавом, которая загружает картинки в какую-то готовую нейронку и ждёт несколько месяцев результат, чтобы разбираться в ИИ.

>объектно-ориентированная онтология

Погуглил, почитал: https://izborsk-club.ru/16429

Что я понял. Философы варятся в собственном соку уже несколько тысяч лет. Вся эта "ООО" направлена только на саму философию и философов. Философы, мол, слишком зациклились на "субъекте" и не верят в то, что "объект" способен "мыслить" как "субъект". Поэтому "ООО" берёт и выбрасывает понятие "субъект" из философии, давая философам возможность уверовать в способность объекта мыслить и давая возможность рассматривать человека как один из объектов, а не как субъект.

Короче, полная хрень, бесполезная на практике. Эти ваши философы никогда в жизни не интересовались программированием и вообще не понимают, как работает компьютер, если до сих пор спорят о том, может ли нечеловеческий объект мыслить как человек. Они просто буксуют на месте уже полвека как минимум, не осознавая этого, и продолжают кормить друг друга каким-то бредом тысячелетней давности.

Если хотите разработать ИИ - изучайте компьютерные технологии, физиологию человека, нейробиологию и даже психологию, только не философию. Философия - болото, в которое лучше никому не соваться.

Чел. Ты долбоёб, смотри. Давай просто.

Есть два стула. На одном ты веришь в то, что существует материальный мир и этот материальный ми является источником всего. На другом ты сомневаешься в материальном мире, но зато приобретаешь манямир.

При этом, если ты приобретаешь манямир, то становится гораздо проще жить, по тому что на самом деле челы, которые думают что есть какой-то материальный мир не понимают, что их сенсорика тупо ущербный кал говна. В общем чел, ты спрашивай, мб отвечу тебе если непонятно потом. А мб нет.