Купил 3090 ти чтобы генерировать фурри хуи в 4к. Я у мамы молодец

Увожаемо.

Есть способ добавить в автоматик автовыключение компа после завершения генерации? А то хочу поставить конвеер на генерацию, чтоб он по завершении вырубил комп и не простаивал.

Синолог в треде. Заметил такую закономерность, что все уникальные и цепляющие чем-то чекпойнты SD - сделаны кектайцами. Честно тренированные, со своими фичами и так далее. Если вы видите ридми иероглифами - это марка качества. Вот несколько из недавних

https://civitai.com/models/44605?modelVersionId=112251 - пик релейтед, мне зашло на ура

https://civitai.com/models/59719/2357-200 (старая версия даже пизже, хотя это дело вкуса)

https://civitai.com/models/98018/hello25dvintageanime

Anything тоже китайская модель. Попадались даже шикарные чекпойнты, которые не известны за пределами китайской блогосферы. Копипастные мерджи, которыми завален Civitai, сделаны западными пользователями (французы и прочие), они пережевывают одно и то же по много раз. Anything v4 это неофициальный bullshit мердж сделанный троллем.

Быть может, всё это потому, что в стране с миллиардным населением больше всего юзеров с баблом и энтузиазмом, + техническая подкованность и деловая дисциплина азиатов + визуальное богатство культуры, которая получила дальнейшее развитие в ИИ-арте. Зная предприимчивость чонгов, можно догадываться что они давно внедряют ИИ в геймдев, в десигн и всё остальное, а также пилят свои аналоговнеты.

https://civitai.com/models/44605?modelVersionId=112251 - пик релейтед, мне зашло на ура

https://civitai.com/models/59719/2357-200 (старая версия даже пизже, хотя это дело вкуса)

https://civitai.com/models/98018/hello25dvintageanime

Anything тоже китайская модель. Попадались даже шикарные чекпойнты, которые не известны за пределами китайской блогосферы. Копипастные мерджи, которыми завален Civitai, сделаны западными пользователями (французы и прочие), они пережевывают одно и то же по много раз. Anything v4 это неофициальный bullshit мердж сделанный троллем.

Быть может, всё это потому, что в стране с миллиардным населением больше всего юзеров с баблом и энтузиазмом, + техническая подкованность и деловая дисциплина азиатов + визуальное богатство культуры, которая получила дальнейшее развитие в ИИ-арте. Зная предприимчивость чонгов, можно догадываться что они давно внедряют ИИ в геймдев, в десигн и всё остальное, а также пилят свои аналоговнеты.

Что характерно, Индия не совершает такого же вклада, хотя в ней тоже миллиард населения. Ведь в китайских компаниях не поощряется головотяпство и втирание очков, а индусы, они до сих пор какают на улицах, не говоря уж о состоянии науки и инноваций.

Что касается Америки, то она = соя и повесточка (при всем уважении к достижениям американских спецов, которые зачастую те же китайцы).

Что касается Америки, то она = соя и повесточка (при всем уважении к достижениям американских спецов, которые зачастую те же китайцы).

Да все они примерно одинаковые. Вообще этот SD ерунда.

Имаджинировали сколько вклада сделал этот ваня в клозет с дырой типа "очко на улице"?

Google обвинили в краже вообще всего в интернете — на прокормку ИИ

Против Google подали коллективный иск, в котором компанию обвинили в «тайном сборе всего опубликованного или созданного в интернете». Авторы иска считают, что данные используются для обучения генеративного искусственного интеллекта Google и подобных продуктов. Юридическая фирма, оформившая иск, ранее подала аналогичный, но уже против компании OpenAI, известной по ChatGPT.

В документах отмечается, что сбор информации американцев ведется компанией Alphabet без уведомления пользователей, которые даже и не подозревают о происходящем с их данными.

«Google прибирает к рукам всю нашу личную и профессиональную информацию, предметы творчества и авторские работы, наши фотографии и даже письма в электронной почте — буквально весь наш цифровой „отпечаток“», — утверждают авторы иска. По их словам, все это происходит годами и бесконтрольно.

В качестве доказательства приводятся изменения в пользовательское соглашение от 1 июля, в котором появилась отметка о том, что Google может собирать всю публично доступную информацию о пользователе для тренировки ИИ и совершенствования Google Translate, Bard и Cloud AI.

«Google должна понять раз и навсегда: она не владеет интернетом», — говорится в иске и отмечается, что публично доступное не означает бесплатное.

Против Google подали коллективный иск, в котором компанию обвинили в «тайном сборе всего опубликованного или созданного в интернете». Авторы иска считают, что данные используются для обучения генеративного искусственного интеллекта Google и подобных продуктов. Юридическая фирма, оформившая иск, ранее подала аналогичный, но уже против компании OpenAI, известной по ChatGPT.

В документах отмечается, что сбор информации американцев ведется компанией Alphabet без уведомления пользователей, которые даже и не подозревают о происходящем с их данными.

«Google прибирает к рукам всю нашу личную и профессиональную информацию, предметы творчества и авторские работы, наши фотографии и даже письма в электронной почте — буквально весь наш цифровой „отпечаток“», — утверждают авторы иска. По их словам, все это происходит годами и бесконтрольно.

В качестве доказательства приводятся изменения в пользовательское соглашение от 1 июля, в котором появилась отметка о том, что Google может собирать всю публично доступную информацию о пользователе для тренировки ИИ и совершенствования Google Translate, Bard и Cloud AI.

«Google должна понять раз и навсегда: она не владеет интернетом», — говорится в иске и отмечается, что публично доступное не означает бесплатное.

>«Google прибирает к рукам всю нашу личную и профессиональную информацию, предметы творчества и авторские работы, наши фотографии и даже письма в электронной почте — буквально весь наш цифровой „отпечаток“», — утверждают авторы иска. По их словам, все это происходит годами и бесконтрольно.

>

Пиздеж, уже давно обоссан, информация не персоанализована. Обычный пиар-иск.

>«Google должна понять раз и навсегда: она не владеет интернетом», — говорится в иске и отмечается, что публично доступное не означает бесплатное.

Как там Австралия гугол забанила уже или нет? А тут вообще ноунейм попук.

Веб-архив уже сколько лет существует и почему-то никто не пиздит на него. А ведь там есть такое, что не просто осталось после удаления, а даже то что вычищалось как нелегальный контент.

Ребзя, уже тестировали sdxl? Она сильно медленнее чем 1.5? Просто думаю потянет ли моя 3060/12gb, или нужно идти апгрейдиться.

Потянет

Ну я и предпологал, что "потянет" в смысле запустится. Там кажется достаточно и 8gb vram.

Просто думал что живые пользователи ответсят что то вроде: "работает раз в 10 медленне" или "скорость генерации почти не упала".

Квадаты потянет. Хайрезы или рефайн - нет.

Тянет и хайрез фикс и рефайн на 8Гб. Скорость генерации на 2060Super 1536х1024, DPM++ 2M Karras, 30 шагов — 40 сек.

Генерация с хайрез фиксом latent с 1024х768 до 1536х1152 при тех же параметрах — 1 минута.

Спасибо! Это обнадёживает. А то не очень хочется связываться с этими новыми видеокартами, которые размером и мощностью сравнялись со стиральными машинами.

>а даже то что вычищалось как нелегальный контент.

Например?

>40 сек

>100% врама

Драйвера слишком новые, лол.

Здравствуйте ананасы, такая проблема - когда включаю openpose, падает качество и на генерации и на апскейле, как фиксить?

> Драйвера слишком новые, лол.

Скоро™ пофиксить обещали https://github.com/vladmandic/automatic/discussions/1285#discussioncomment-6328116

Я пробовал различные версии драйверов, торчей, куды, куднн, хформерсов и сравнивал их производительность.

В итоге максимальная производительность у меня получилась на связке драйвер 528.49, torch2.1.0+cu118, CUDA11.8, cuDNN8.8, xformers 0.0.21+cu118.

Что касаемо показателя Sys VRAM, то при использовании SDP cross-attention оптимизатора у меня он практически всегда показывает 8192/8192 вне зависимости от размера картинки. Хоть 512х512, хоть 2048х1024.

Не пойму что за хрень, что не тренирую на выходе всё косоёбит. Сначала думал датасет говно, сделал всё отлично - то же самое. Дошёл до того, что скачал чужой датасет, с параметрами( там и джейсон прилагался) оттренил у себя - говно, а у чела всё нормально. Тот же эпох, те же повторения, всё то же.3060,3600 и 16 гб оперативы.

ЧЯДНТ?

ЧЯДНТ?

аноны, не уверен в тот ли тред с таким вопросом, но слезно умоляю помогите зеленому долбаебу. пару месяцев назад вполне успешно сделал модель аниме тянучки, сейчас решил попробовать сделать модель с неоновым стилем, но не нихуя получается. не вдупляю в чем собсна проблема, когда делал модель с тянучкой там уже с тысячи был неплохой результат, а тут какой-то лисий кал выходит, или при тренировки стиля так и должно быть?

>ЧЯДНТ?

Ищи проблему в железе или софте. Проверь стабильность оперативы под нагрузками, проверь версии ПО, торча, хформерс и прочего говна.

Давно не тыкался, сегодня обновился и вылезла проблема.

Инпеинтит почему-то слишком долго. Даже маленькое закрашенное пятнышко на условной пикче 1000х1500 гоняет 5 минут. Раньше это делалось точно намного быстрее, железо все то же.

Сталкивался кто-нибудь, есть идеи? Настройки пикрил.

Инпеинтит почему-то слишком долго. Даже маленькое закрашенное пятнышко на условной пикче 1000х1500 гоняет 5 минут. Раньше это делалось точно намного быстрее, железо все то же.

Сталкивался кто-нибудь, есть идеи? Настройки пикрил.

Спасибо, по ходу нашёл - дело в файле подкачки - он должен быть на одном диске.

Ща релизнут SD XL, может он будет лучше.

Ящитаю, анклип как в миджорни - топчик.

Аноны, помогите!

Удалил несколько программ через прогу Reg Organizer с "чисткой следов". После этого при запуске webui user.bat появилась ошибка: py torch can not connect with GPU и Stable Diffusion не запускалась. Сделал восстановление системы, точка восстановления каким то чудом была только одна на 16:50 сегодня, откуда она взялась я в душе не ебу, кроме неё не было ничего. Восстановился - вроде все норм, работает. Но теперь заметил следующее в консоли:

A matching Triton is not available, some optimizations will not be enabled.

Error caught was: No module named 'triton'

D:\ai\stable-diffusion-webui\venv\lib\site-packages\pytorch_lightning\utilities\distributed.py:258: LightningDeprecationWarning: `pytorch_lightning.utilities.distributed.rank_zero_only` has been deprecated in v1.8.1 and will be removed in v2.0.0. You can import it from `pytorch_lightning.utilities` instead.

rank_zero_deprecation(

Model loaded in 5.4s (load weights from disk: 0.5s, create model: 0.6s, apply weights to model: 2.5s, apply half(): 0.5s, move model to device: 1.0s, calculate empty prompt: 0.1s).

D:\ai\stable-diffusion-webui\venv\lib\site-packages\torchvision\transforms\functional_tensor.py:5: UserWarning: The torchvision.transforms.functional_tensor module is deprecated in 0.15 and will be removed in 0.17. Please don't rely on it. You probably just need to use APIs in torchvision.transforms.functional or in torchvision.transforms.v2.functional.

warnings.warn(

Что это за хуйня разъясните пожалуйста.Что за Тритон? Что за ошибки с Pytorch? Что это все блядь? Я знаю тут есть знатоки, а я на уровне хлебушка в этих вопросах.

Удалил несколько программ через прогу Reg Organizer с "чисткой следов". После этого при запуске webui user.bat появилась ошибка: py torch can not connect with GPU и Stable Diffusion не запускалась. Сделал восстановление системы, точка восстановления каким то чудом была только одна на 16:50 сегодня, откуда она взялась я в душе не ебу, кроме неё не было ничего. Восстановился - вроде все норм, работает. Но теперь заметил следующее в консоли:

A matching Triton is not available, some optimizations will not be enabled.

Error caught was: No module named 'triton'

D:\ai\stable-diffusion-webui\venv\lib\site-packages\pytorch_lightning\utilities\distributed.py:258: LightningDeprecationWarning: `pytorch_lightning.utilities.distributed.rank_zero_only` has been deprecated in v1.8.1 and will be removed in v2.0.0. You can import it from `pytorch_lightning.utilities` instead.

rank_zero_deprecation(

Model loaded in 5.4s (load weights from disk: 0.5s, create model: 0.6s, apply weights to model: 2.5s, apply half(): 0.5s, move model to device: 1.0s, calculate empty prompt: 0.1s).

D:\ai\stable-diffusion-webui\venv\lib\site-packages\torchvision\transforms\functional_tensor.py:5: UserWarning: The torchvision.transforms.functional_tensor module is deprecated in 0.15 and will be removed in 0.17. Please don't rely on it. You probably just need to use APIs in torchvision.transforms.functional or in torchvision.transforms.v2.functional.

warnings.warn(

Что это за хуйня разъясните пожалуйста.Что за Тритон? Что за ошибки с Pytorch? Что это все блядь? Я знаю тут есть знатоки, а я на уровне хлебушка в этих вопросах.

тритон в винде не работает, остальное поебать если работает. если трясешься то можешь папку venv удалить, вебуй при след запуске все перекачает.

вроде бы 23 год на дворе, а люди до сих пор сиклинерами пользуются

Ну спасибо блядь, снес venv он перекачал, теперь extensions не загружается и вся консоль в ошибках

пости ошибки, хули

Да иди ты нахуй, я чистую снова наверну чем теперь из-за тебя долбоеба с тысячей ошибок ебаться

Здесь долбоеб-неосилятор только ты

>мокрописькой поломал пути в копровинде

>поломал автоматик делолом венв

>виноваты все вокруг

Мегамозг наху

Я видел когда-то в разделе мокропиську для соревновательной сортировки пикч. Ну то есть если нагенерили 100 штук, чтобы сравнить их и оставить парочку.

Я ее не смог найти, поэтому написал свой велосипед:

https://pastebin.com/5bKfqgyw

Из зависимостей только pip install PyQt5 и pip install Pillow

Кто не умеет в питон, я скомпилил 7 килобайт кода в 57 мегабайт экзешника, наслаждайтесь (должно работать вообще без питона): https://pixeldrain.com/u/rBbu6EET

Вызов либо через командную строку, python batch_sorter.py f:\iloveass

Либо если без пути запустите, то оно спросит

По пути создаст папку discarded

В окне нажимете (на клавиатуре) левую стрелку, чтобы скинуть в discarded левую пикчу.

Правую стрелку наоборот соответственно.

Вверх - скипаются и остаются обе

Вниз - скидываются в discarded обе

Вместо стрелок можно использовать класскический WASD

Кнопки в интерфейсе не стал пилить, ну их нахуй.

Оно закончит, когда останется две пикчи. Либо когда вы окно закроете. Файлы перемещаются сразу по нажатию кнокпи на клаве. Не в конце процесса.

В консоли будет дудосить ошибками

QWindowsWindow::setGeometry: Unable to set geometry

Не обращайте внимания, мне просто лень чинить.

Я ее не смог найти, поэтому написал свой велосипед:

https://pastebin.com/5bKfqgyw

Из зависимостей только pip install PyQt5 и pip install Pillow

Кто не умеет в питон, я скомпилил 7 килобайт кода в 57 мегабайт экзешника, наслаждайтесь (должно работать вообще без питона): https://pixeldrain.com/u/rBbu6EET

Вызов либо через командную строку, python batch_sorter.py f:\iloveass

Либо если без пути запустите, то оно спросит

По пути создаст папку discarded

В окне нажимете (на клавиатуре) левую стрелку, чтобы скинуть в discarded левую пикчу.

Правую стрелку наоборот соответственно.

Вверх - скипаются и остаются обе

Вниз - скидываются в discarded обе

Вместо стрелок можно использовать класскический WASD

Кнопки в интерфейсе не стал пилить, ну их нахуй.

Оно закончит, когда останется две пикчи. Либо когда вы окно закроете. Файлы перемещаются сразу по нажатию кнокпи на клаве. Не в конце процесса.

В консоли будет дудосить ошибками

QWindowsWindow::setGeometry: Unable to set geometry

Не обращайте внимания, мне просто лень чинить.

А, еще посмотрел вашу шапку и увидел мокрописьки для ресайза

Но они все проигрывают в удобстве этой, как мне кажется:

https://www.birme.net/

Может ее стоит тоже туда хуйнуть, датасеты кропать самое оно.

А нахуя полностью удалял? Я переименовываю всегда, можно было бы откатится.

Лороделы, можно вам реквест? Несложная наверно лора, чтобы рисовала море/океан крови/LCL. Анимушные модели, что пробовал, по промпту упорно рисуют обычную воду с несколькими лужами крови, либо перса заливают кровищей. Каноничную сцену из EoE не воссоздать, на циве не нашел ничего подходящего.

Не знаю где именно спросить, спрошу тут.

Генерирую пиксель арты, если смотреть издалека и один глаз закрыть, то результат вроде бы ничего, похоже на правду.

Но на самом деле много грязи в изображении, квадраты (якобы пиксели) разных размеров, аутлайны плохие. Фиксить каждый пиксель руками - заебешься насмерть, мне быстрее с нуля нарисовать самому.

Возможна ли модель которая получив на вход пикрелейтед, преобразует его в близкое к pixel perfect?

Фильтр ближайший сосед не предлагать!

Генерирую пиксель арты, если смотреть издалека и один глаз закрыть, то результат вроде бы ничего, похоже на правду.

Но на самом деле много грязи в изображении, квадраты (якобы пиксели) разных размеров, аутлайны плохие. Фиксить каждый пиксель руками - заебешься насмерть, мне быстрее с нуля нарисовать самому.

Возможна ли модель которая получив на вход пикрелейтед, преобразует его в близкое к pixel perfect?

Фильтр ближайший сосед не предлагать!

> Фильтр ближайший сосед не предлагать!

Чего так? Если совместить одно с другим то как раз починит, тут скорее не нейронка а просто численных алгоритм нужен, скрипты фотожопа есть. Изначально генерацию делай с аутлайном но без стремления получить идеальную пикселизацию, а ее организовывай уже потом.

>Чего так?

Когда я даунскейлю картинку до четкой пиксельной сетки 1 "квардратик" генерации = 1 реальный пиксель то хорошо получается только там где квадраты большие и четкие, и там где они выровнены по сетке.

А выровнять по сетке всю картинку не получается, потому что в разных местах квадраты разного размера и формы. И поэтому картинка превращается в кашу.

При этом глазами-то я вижу где какой пиксель должен быть, вот думаю значит и нейрон очка тоже сможет.

Вот так получается, не слишком уж хорошо.

Кто-нибудь в курсе, как это чинить после обновления?

raise RuntimeError("Cannot add middleware after an application has started")

RuntimeError: Cannot add middleware after an application has started

raise RuntimeError("Cannot add middleware after an application has started")

RuntimeError: Cannot add middleware after an application has started

Это что за срань? начало вылезать просто нисхуя, в гугле ноль упоминаний

само прошло, так же нисхуя

>wsl

Нахуя?

Подскажите модель для рисования пейзажей разных психоделических, хочу себе наклепать для обоев на рабочий стол.

Есть аноны с амд карточками с линуксом? Насколько там сильно разница в скорости генерации по сравнению с виндой? На винде, на моей 6700xt на одну картинку уходит в среднем 20-40 секунд.

> На винде, на моей 6700xt на одну картинку уходит в среднем 20-40 секунд.

Не указывая размер картинки, семплер и количество шагов твоя информация абсолютно бесполезна.

Посмотри внимательно, исходная пикча не должна быть столь сильно пикселизованной если эта пикселизация поломана, тогда по ближайшим сработает уже нормально. Также палитру скорректировать в любом случае придется или заставить нейросеть изначально сделает плоские цвета. У тебя в той пикче не смотря на закос под пиксельарт есть полутона между пикселями, потому ресайз туда-собратно и ломает аутлайн, попадая не серые участки вместо черных, и сам аутлайн тонкий из-за чего при уменьшении он может потеряться.

Та пикча изначально обычная но с жирным лайном и "пиксельарт" сделан в фотожопе.

Попробуй вместо VAE использовать ApproxVAE, будет в 8 раз меньше разрешение, без попыток автоэнкодера убрать пиксели.

У тебя карта не тянет? Ну хочешь- кидай датасет с описаниями. Я у себя создам лору. Параметры тоже лучше скинь/спроси у кого-то

Бля да че оно такой хеловворд сгенерить не может-то?

Хачмодель 4/10, дримшейпер 9/10

Везде насрало фиолетовым, где не надо, хотя через запятую

Везде насрало фиолетовым, где не надо, хотя через запятую

Чел... Вроде обмазался плагинами (сборочку поставил что ли?), но базы понимания работы нейросетей это не прибавило.

Инпейнт, даунидзе.

Нет, отдельно ставил. Нету.

Ебаться с инпейнтом для такого хеловворда? Пиздец просто

>Пиздец просто

А хули ты хотел? Это не ИИ нихрена.

В принципе, можно чуть потвикать и нароллить, но лучше инпейнт, ибо сетке сложно понять, что к чему, особенно по такому короткому промту.

поебался с invoke ai (sd без фильтров) а потом подчитал в середине гайда, что он не встает на амд карты на шиновсе

ппц так обидно

есть обходные пути этой херни, или идти в магазин за видимокартой, чтоб ии прон посмотреть?

спасибо, аноны, заранее

сам полный хуй и лох, хочется посмотреть голых девок, показать другим

ппц так обидно

есть обходные пути этой херни, или идти в магазин за видимокартой, чтоб ии прон посмотреть?

спасибо, аноны, заранее

сам полный хуй и лох, хочется посмотреть голых девок, показать другим

>sd без фильтров

Чаво? Юзай автоматика, как и все тут. Он вроде кое-как дружит с радевонью.

>или идти в магазин за видимокартой

Да, самый беспроблемный вариант. Минимум 12ГБ врама, лучше сразу 24, и будешь перед всеми козырять классными картинками.

512x512, Euler a, 20 шагов

Совсем лажа, смотри мой пик выше

3080Ti-боярин.

> Хачмодель

Еблан.

> показать другим

Другие ведь никогда голых девок не видели, а тут такой ты с двух ног со своими шедеврами.

Аноны, решил потренировать Лору, скачал гуи, всё тренеруется, работает, но татуировку персонажа понять не может, хоть она и просто ромб. Рисует всё под ряд, и в линии меняет, и даже квадрат сделать не может.

Дохуя хочешь, геометрические татухи без дополнительных костылей работать не будут.

А какие костыли нужны? Я так то натренировал, и даже работает, но оверфитит модель, или зажаривает, попробовал конвертнуть в дим 8 но лучше не стало особо. Или этих костылей ещё не придумали?

Тренируй лайкорисы, они лучше для этих целей подходят

>1488

Спасибо, буду пробовать.

2 карты кто-то пробовал задействовать?

>Ебаться с инпейнтом для такого хеловворда? Пиздец просто

Ну а нахуй ты в фотожопе со слоями ебешься? Или в 3дмоделерах с полигонами? Ебать говно ниудобна! Это блядь азы работы с программой, прости, ебаный кусок говна, что она устроена не так, как ты хотел. Сделай блядь лучше или забей пасть.

Хуйня. Кот у тебя не белый. Этот дрочь в принципе не нужен, когда сенд ту инпейт и сменить цвет глаз это 3 секунды.

да не трясись ты так

Я сказал хуйня. Зачем ты споришь, блядь? Обязательно надо последнее слово сказать? Как бабе? Ты баба?

База треда: СД котика сгенерить не может.

Что вы тряску на ровном месте развели, какой-нибудь white cat with purple eyes должно сразу все сделать, если будет мешаться то использовать негативы.

Соси. Негатива нет. Миллиарда присетов как у Мочи Жоры тоже нет.

Ты прав.

Что и требовалось доказать...

Тряска - есть, нормального котика - нету.

Чем тебя этот не устраивает, мразь? Ты скаал не может - я показал что может.

> Технотред №1

> Крутим веса моделей, срёмся за тензоры, пишем гайды, организуем помойки для моделей

> Технотред №11

> Пытаемся сгенерировать кота

Технотред. Итоги.

> Крутим веса моделей, срёмся за тензоры, пишем гайды, организуем помойки для моделей

> Технотред №11

> Пытаемся сгенерировать кота

Технотред. Итоги.

Аноны с АМД на линуксе как у вас работает hires fix? На моей 6700xt на 512x1024, модель Rev animated, сэмплер DPM++ 2M Karras, 30 шагов, upscale by: 2 генерация занимает минуты 3-4, при этом в конце генерации на 100% прогресса система начинает лагать сильно. Я так понял что это происходит из-за нехватки видеопамяти? Думал на линуксе с этим будет получше, чем на винде.

> upscale by: 2

> генерация занимает минуты 3-4

Зачем так унижаешься перед Хуангом? У нормальных людей это 5 секунд.

> База треда: СД котика сгенерить не может.

Хуйню несёшь. Ещё полгода назад генерил охуенных мэйнкунов.

> На моей 6700xt на 512x1024, модель Rev animated, сэмплер DPM++ 2M Karras, 30 шагов, upscale by: 2 генерация занимает минуты 3-4

Не верю. Покажи скрин.

> На моей 6700xt на 512x1024, модель Rev animated, сэмплер DPM++ 2M Karras, 30 шагов, upscale by: 2 генерация занимает минуты 3-4

Ха-ха, амудебляди соснули

512х512, Euler A, 150 шагов, без хайрезфикса, сколько it/s?

А без medvram?

6.32

давайте соберем перечень слов, с которыми возможно делать пикчи более "восточными" (проще говоря, убрать клише и образы западной культуры). Я пользуюсь вот этими, в произвольных сочетаниях в конце каждого промпта:

oriental

eastern

therawada

mahayana

arabic

arabesque

ottoman

hindu

mughal

tantra

spicy

persian

achaemenid

babylonian

tao

sanscrit

islamic

sunnah

ramadan

wuxia

tang

ming

qing

thai

burmese

oriental

eastern

therawada

mahayana

arabic

arabesque

ottoman

hindu

mughal

tantra

spicy

persian

achaemenid

babylonian

tao

sanscrit

islamic

sunnah

ramadan

wuxia

tang

ming

qing

thai

burmese

Короче пока особой разницы не заметил, я правда Дадаптэйшном фигачил, хз какой крутой лёрн рейт для ликоризов.

На авито отдают карты б/у 3090 24гига по 50-60к

Стоит брать? В чем камни?

https://www.avito.ru/sankt-peterburg/tovary_dlya_kompyutera/inno3d_geforce_rtx_3090_ichill_x4_24gb_3153691486

https://www.avito.ru/sankt-peterburg/tovary_dlya_kompyutera/asus_tuf_geforce_rtx3090_gaming_oc_tuf-rtx3090-o24_2530308393

Стоит брать? В чем камни?

https://www.avito.ru/sankt-peterburg/tovary_dlya_kompyutera/inno3d_geforce_rtx_3090_ichill_x4_24gb_3153691486

https://www.avito.ru/sankt-peterburg/tovary_dlya_kompyutera/asus_tuf_geforce_rtx3090_gaming_oc_tuf-rtx3090-o24_2530308393

Майнеры распродают, вот тут ответы к посту смотри, все пояснено

Понял, спасибо. Ну, майнеры и майнеры, похуй, лишь бы работала

> Ну, майнеры и майнеры, похуй, лишь бы работала

Это как машину после таксиста брать.

Лучше из таксу но нормальную иномарку, чем сосквич 3 из салуна.

Как из пика 1 сделать пик 2? Получается только простой апскейл без доработанных частиц

Максимум такое выходило

Почему какой-то кореец написал прогу для генерации картинок на своем компе для ламеров (kohya_ss), но не нашлось другого корейца, который бы написал такую же программу генерации картинок для ламеров, но через Google Colab? Ну, если слово "программа" понимть максимально широко. То есть почему никто до сих пор не сделал нотбук на колабе, где нужно было поправить руками пару параметров и запустить одну ячечку, чтобы прога генерила изображение, используя мощности Гугла? Можно настроить Колаб так, чтобы он регулярно, после каждой эпохи например, сохранял на гугл.диск обученную модель. Ну да, боярам, у которых видюхи на ПК лучше тех, что дают бесплатно в колабе, использовать колаб тупо не удобно. Но кому в кайф сидеть без компа Х часов? Не понимаю

А, лол. Только сейчас дочитал шапку до того момента, где есть ссылки на колабы

Берёшь и делаешь, без задней мысли. Контролнет. Тайл.

Как бесплатно улучшить картинку? есть немноо блюеренный скрин с ютуба, хочу обдагородить дял обои

После запуска скрипта из этого гайда

https://rentry.org/2chAI_LoRA_Dreambooth_guide

начинает бешено сжираться ssd, изначально свободно 30 гб, в консоли доходит до .. epoch 1/10, далее съедает все до конца

OSError: [WinError 1455] Файл подкачки слишком мал для завершения операции. Error loading "C:\Users\user\git\sd-scripts\venv\lib\site-packages\torch\lib\shm.dll" or one of its dependencies.

Чзх, почему скрипт так сильно использует SSD, сколько должно быть свободного места?

30 оказалось впритык, надо было чуть больше, и заработало.

На сивите вижу некоторых модели в двух вариантах - обычый и inpainting.

В чем там технические отличия, почему обычная модель не может делать инпейнт?

В чем там технические отличия, почему обычная модель не может делать инпейнт?

Еще объясните пожалуйста софтварные термины, а то стек софтварный просто огромен и тяжело ориентироваться.

Что такое пайторч? Чем оно отличается от либторч? Что такое tensorflow и keras? diffusers, transformers итд.

Везде написано что это "библиотеки/фреймворки для машинного обучения", но не понимаю чем они отличаются.

Что такое пайторч? Чем оно отличается от либторч? Что такое tensorflow и keras? diffusers, transformers итд.

Везде написано что это "библиотеки/фреймворки для машинного обучения", но не понимаю чем они отличаются.

И если сможете, просяните весь процесс от "пишу промт" до "смотрю картинку"

Пишешь промпт, нажимаешь Generate, смотришь картинку.

В интернетах уже есть десятки статей, в которых по винтику разбирают внутреннее устройство stable diffusion.

Аноны, помогите, https://github.com/kohya-ss/sd-scripts/pull/271

Как передать через скрипт анона несколько параметров --lr_scheduler_args?

если один то всё нормально

$run_parameters += " --lr_scheduler_type=$scheduler --lr_scheduler_args=T_max=$T_max"

А если передаю хотя бы 2, то ошибки выдаёт.

Как передать через скрипт анона несколько параметров --lr_scheduler_args?

если один то всё нормально

$run_parameters += " --lr_scheduler_type=$scheduler --lr_scheduler_args=T_max=$T_max"

А если передаю хотя бы 2, то ошибки выдаёт.

Какие ошибки выдаёт?

Я пикрилейтед делаю. Вообще оно кривущее говно без документации.

Тренил кто LoHA/LoKR, есть к ним какие нибудь удачные основные параметры? Лоха вообще какая то не понятная, полная чушь на рангах ниже 30, локр подаёт больше надежд, несмотря на свои размеры файла в 2.5 мб, но и стиль и персонажа не до конца запоминает, в отличии от локона.

--lr_scheduler_args "T_0=400" "gamma_min_lr=0.99945" "decay=1" "down_factor=0.5" "warmup_steps=80" "cycle_warmup=40" "init_lr_ground=True"

Примерно так, просто равно убери

--lr_scheduler_args "T_0=400" "gamma_min_lr=0.99945" "decay=1" "down_factor=0.5" "warmup_steps=80" "cycle_warmup=40" "init_lr_ground=True"

Примерно так, просто равно убери

Как ускорить время генерации в коллабе? Генерю без лор, картинку 512x704 генерирует 40 секунд нахуй, пиздец. А раньше вроде быстро было.

Вот еще данные, не знаю что они значат A: 3.93 GB, R: 5.90 GB, Sys: 6.1/14.748 GB (41.1%)

Вот еще данные, не знаю что они значат A: 3.93 GB, R: 5.90 GB, Sys: 6.1/14.748 GB (41.1%)

А сейчас вот 16 секунд генерило... От чего это зависит?

Чел, это сделано для шизов, экономящих 50 мб места на диске. Они всегда будут хуже обычной лоры. Более того, и локон не обязательно лучше выдаст результат чем лора, с ним надо больше тонкой настройки. Все они дают лучше результат при одинаковых размерах файла или на низком ранге, но если тебе похуй на размер файла, то ванильная лора с 32/64/128 рангом выебет их. А ещё локоны очень плохо работают в паре с другими локонами, лору так никогда не запидорасит.

Если не знаешь что делаешь, есть всегда топовый вариант - DyLora. Шизы будут кричать РЯЯЯ ТЫ НЕ МОЖЕШЬ ВЗЯТЬ ДИЛОРУ РАЗМЕРОМ В 300 МБ И ПРОСТО НАТРЕНИРОВАТЬ ЕЁ, но по факту она будет ебать все эти локоны и при этом шанс получить кашу минимальный, а бонусом она просто работает у всех из коробки.

От нагрузки на сервера коллаба

> А ещё локоны очень плохо работают в паре с другими локонами, лору так никогда не запидорасит.

Примеры таких локонов есть? Сколько не подрубал по несколько, обычно всё нормально получалось, на больших весах чем с обычными лорами, которые как раз очень просто пидорасит, если подключать несколько.

> Шизы будут кричать РЯЯЯ ТЫ НЕ МОЖЕШЬ ВЗЯТЬ ДИЛОРУ РАЗМЕРОМ В 300 МБ И ПРОСТО НАТРЕНИРОВАТЬ ЕЁ, но по факту она будет ебать все эти локоны и при этом шанс получить кашу минимальный, а бонусом она просто работает у всех из коробки.

Ты хочешь сказать что 256 ранг обычной дилоры будет лучше например дилоры с 128+128 ранг слоёв локона? Ведь только так получится 300мб файл. Да и к чему ты вообще про ёбку локонов, это же просто дополнительные слои для любого из методов, дающие нихуёвый буст к тренировкам стилей, да и пережарить с ними сложнее. Мне как концепт то дилора нравится, сразу несколько рангов в одной модели, вот только её тренить заебёшься по времени да и лр там нужен куда больше.

> Ведь только так получится 300мб файл.

У дилоры на ранге 128 файл 300 мб. Вообще тренировка лоры на больших датасетах совсем не то что тренировать персонажа на 50 пикчах. Персонажа или стиль действительно хоть на чём можно на похуе сделать.

> просто дополнительные слои

Которые очень легко ломаются оверфитом и ты не можешь это контролировать вообще никак в отрыве от тренировки остального. В лоре не просто так их выкинули. Файнтюн - это не тоже самое что тренировка с нуля.

> по времени

Всего раза в два.

Спасибо, действительно всё дело было в = сразу после lr_scheduler_args. Причём я его добавил потому что изначально без него не работало. Короче весь день копался даже в коде, а в итоге ларчик-то просто открывался.

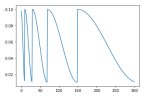

Если кому интересно, вот что нужно написать для кривой как на пикриле:

$run_parameters += " --lr_scheduler_type=$scheduler --lr_scheduler_args T_0=$T_0 T_mult=$T_mult eta_min=$eta_min "

Где $scheduler = CosineAnnealingWarmRestarts, естесна

https://www.kaggle.com/code/isbhargav/guide-to-pytorch-learning-rate-scheduling тут крч больше инфы

> через скрипт анона несколько параметров --lr_scheduler_args?

Это какой?

Вообще все также как и с аргументами оптимайзера, вечером могу пример скинуть, только ты укажи полные параметры что пускаешь чтобы проверить как работает.

> несмотря на свои размеры файла в 2.5 мб, но и стиль и персонажа не до конца запоминает, в отличии от локона.

Концепты не пробовал тренить?

> для шизов, экономящих 50 мб места на диске

Поддвачну, хотя есть нюансы, обучение идет по-разному

> А ещё локоны очень плохо работают в паре с другими локонами, лору так никогда не запидорасит

Индвидуально что там что там

> есть всегда топовый вариант - DyLora

Показывай примеры

> У дилоры на ранге 128 файл 300 мб.

У меня точно такой же размер получился с добавлением 128 ранга локона.

> Вообще тренировка лоры на больших датасетах совсем не то что тренировать персонажа на 50 пикчах. Персонажа или стиль действительно хоть на чём можно на похуе сделать.

Да я понимаю, что с большими датасетами уже и грамотная сегментация нужна с отфильтровкой и тегать придётся более тщательно. Вот только лора как раз и существует для чего то более простого, чтобы на похуях сделать не нагруженную кучей концептов модель.

> Которые очень легко ломаются оверфитом и ты не можешь это контролировать вообще никак в отрыве от тренировки остального

Опять же сколько не пытался перетренировать до жути, с локоном намного сложнее это сделать.

> В лоре не просто так их выкинули. Файнтюн - это не тоже самое что тренировка с нуля.

А зря как по мне, с ними лучше получается. Вот только лора вообще из трансформеров насколько я помню пришла, и видимо лучшей практики использования здесь и не было. А с нуля тренить это вообще не про лоры, тут уже и реги понадобятся ведь.

> Всего раза в два.

В два раза тут, в два раза там, в 3-4 раза от XL и вот уже аниме девочка запекается полтора часа на 4090.

Кстати где то вот тут есть чуть более интересная версия этого шедулера

> Концепты не пробовал тренить?

Тебе опять хвосты важнее? Я поинтереснее вещь нашёл для концептов, вот думаю попробовать на чём нибудь https://github.com/p1atdev/LECO

> https://github.com/p1atdev/LECO

> erasing

Забавно, ну и реализация с весом -1 показательная. Интересно как оно будет работать если чего-то изначально не было?

> опять

Always has been, но другого интереса не отменяет.

Там кстати некоторые результаты есть, думаю еще поиграюсь с параметрами и отпишу.

> лора как раз и существует для чего то более простого, чтобы на похуях сделать не нагруженную кучей концептов модель

С лорой можно датасет разбить на категории, а потом каждую тонко примержить по слоям. Литералли с одного захода делается если автотегер нормальный, в отличи от полноценного файнтюна, когда хуяк и всё запорото.

> У дилоры на ранге 128 файл 300 мб

> точно такой же размер получился с добавлением 128 ранга локона

Очевидно что удвоенная величина будет почти равна сумме ее с рядом младших степеней двойки

> тренировка лоры на больших датасетах

Для чего это делаешь и что хочешь получить?

> Очевидно что удвоенная величина будет почти равна сумме ее с рядом младших степеней двойки

Ты про 128+64+32...? Энивей это

> > У дилоры на ранге 128 файл 300 мб

Пиздёжь, я проверил без конв слоёв, чисто ради теста одну эпохе с одним параметром unit кохьевской реализации, она весит как и обычная с 128 рангом.

> С лорой можно датасет разбить на категории, а потом каждую тонко примержить по слоям.

Слои искать затронутые ведь тоже долгое занятие.

Кто-нибудь может помочь по этому вопросу? Как сами чинили?

Обучил лору для SDXLчерез Kohya-ss gui, на 128 dim получил файл ~800Мб против ~140Мб для SD 1.5 при тренировке скриптами онли.

Я что-то сделал не так? Для gui нужны дополнительные шаг чтобы уменьшить вес или это SDXL виноват?

Я что-то сделал не так? Для gui нужны дополнительные шаг чтобы уменьшить вес или это SDXL виноват?

Для SDXL это норма.

Можешь уменьшить там же в гуе, или через консоль. Сделай несколько штук 64/32/16/8 и выбери какая устроит. На цивитае вообще лоры на SDXL выкладывают в Dim 256 по 1.7 гига.

Да я то уменьшил.. Хотя надо попробовать еще сжать. Просто думал что-то упускаю.

А лоры в гигабайтах это пиздец

Кто успешно для XL лоры тренил скажите свои настройки.

У меня хрень странная, если выбираю размер 768 то результат весьма неплох, если с точно такими же настройками обучаю уже на 1024 то какая-то говнина полная выходит.

У ХЛ же параметров больше раза в 3, соответственно и лора будет тяжелее. Но и слоев ей надо меньше для схожих результатов. На 1.5 у меня локон на 64\32 а на хл уже хватает 16\8.

У меня хрень странная, если выбираю размер 768 то результат весьма неплох, если с точно такими же настройками обучаю уже на 1024 то какая-то говнина полная выходит.

У ХЛ же параметров больше раза в 3, соответственно и лора будет тяжелее. Но и слоев ей надо меньше для схожих результатов. На 1.5 у меня локон на 64\32 а на хл уже хватает 16\8.

> слоев

Ранг лоры - это не количество слоёв. У лоры всегда фиксированное количество слоёв. Если специально не отключал тренировку конкретных.

> хватает

Потому что 1.5 и XL должны с разными lr тренироваться. Ты отсюда можешь сделать вывод лишь о том что на 1.5 у тебя проёб по lr.

>Ранг лоры - это не количество слоёв

А что тогда этот dim означает?

>на 1.5 у тебя проёб по lr.

Получается у меня и 96% гайдов. Как фиксить?

> 96% гайдов

Все эти гайды писались шизами, тренирующих персонажей на 30 пиках с диким lr до оверфита и потом ставящих вес 0.4 для лоры. Естественно таких слушать не стоит. Если они получили хоть какой-то результат это ещё ничего не значит, обезьяна тоже может палкой постучать и что-то получится.

>Как фиксить?

Запустил обучение лоры для SDXL на тех же настройках и датасете что и для SD1.5, все завелось нормально.

Получил лору 128dim в 800Mb, там же в кохе ужал по 128dim на дефолтных настройках и получил 180Mb

> Если специально не отключал тренировку конкретных.

Оно же просто тогда зануляться будет, не? И как отключить обучение конкретных (кроме клипа офк), про послойное применение только слышал.

> что тогда этот dim означает

Когда тренишь модель у тебя подбираются значения огромной матрицы, которая описывает веса взаимодействий между нейронами, если упрощенно описывать. Эта веса - основной объем модели. Лора - тренировка нескольких матриц с размером dim x исходная размерность, которые при перемножении друг на друга дадут полную матрицу. Офк это сжатие с потерями, но для типичных задач с учетом особенностей работы нейронки работает хорошо, в ней хранится не сами веса а смещения к ним для получения нужного.

Поведай как надо

на 12G vram можно лоры для SDXL обучать? или не хватит?

Я на 8 обучаю

ну и как, нравиться то что получается? ты тестил свои датасеты 1.5 vs XL ?

Я ток 2 дня назад это обнаружил, пока что тестирую. На 768 результаты довольно неплохи, на 1024 хуже и явно видно что надо настройки крутить.

Пока что тестирую тот же датасет который использовал для 1.5, для 1024 его пропустил через самый удачный апскейлер.

Как можно заставить SD запомнить информацию из одной картинки при генерации второй? Допустим на пикче есть лицо, я хочу сгенерировать вторую пикчу но контролнетом изменить позу персонажа при этом сохранив лицо в целом, или сгенерировать ему такие же ботинки, это можно как-то сделать? Вроде txt2vid умеет что-то подобное.

Тот момент, когда тренируешь лору и в датасете есть голый персонаж, но стоит написать в промте Топлесс или no bra и вероятность увидеть грудь становится 1 к 10 :(

Опять переделывать датасет..

Опять переделывать датасет..

Так тегай нормально, а не всяким говном типа файнтюнов BLIP. В описании должно быть нормально прописано что происходит, а не просто бессвязная гора кривых тегов.

Я таггером тэгаю, все нормально. Надо добавить артов

SD можно запустить на видюхе без актуальной куды, или в таком случае только проц?

- Roop

- img2img inpainting / sketch

не актуальная это какая? люди на 1070 генерят нормально, у самого дрова 528

> таггером

Так ты бы хоть нормальную мультимодалку взял, а не непонятный кал от васянов-анимешников.

Например?

LLaVA, Llama-Adapter.

А в чём проблема взять парочку Квадр прошлых поколений и запилить на них кластер для вайф? Их специально делали под вычисления, они дешевле, у них много памяти при относительно низкой цене.

На них софт что-ли не пишут?

На них софт что-ли не пишут?

Окей, но его надо тренировать. Есть ли готовые модели?

У них много памяти, но чип говно. Плюс пока с поддержкой нескольких карт все довольно плохо

Чел вроде пробовал паскали - работает, но перфоманс слабоват. Что-то новее дороже условной 3090, если найдешь хороший вариант то вполне тема.

Приветствую, возможно не в тот тред пишу, перенаправьте если не прав.

Пишу нейронку, LTSM, ее цель - смотреть на текущую свечу и определять, пойдет ли цена вверх или вниз. Столкнулся со следующими проблемами: при трех - пяти слоях (по 10-100 нейронов в каждом) и 70.000 строк для обучения, выходит 51%-55% accuracy, при таком же количестве слоев и нейронов, но с примерно 300 строчками, получается 65%. Пробовал делать датасет еще больше: 500.000 строк и 14 параметров (против 70.000 и 5), accuracy падает до 53%, но более стабильна в процессе обучения. При большей дате пробовал делать больше слоев и нейронов (максимум - 5 слоев по 1024 нейрона), но чем больше становилась сетка, тем хуже результаты.

Скажите пожалуйста, что я делаю не так? Неужели надо тренировать нейронку на очень малом датасете? Может просто ебануть 100500 нейронов и слоев и молиться пока оно три дня обучается?

Пишу нейронку, LTSM, ее цель - смотреть на текущую свечу и определять, пойдет ли цена вверх или вниз. Столкнулся со следующими проблемами: при трех - пяти слоях (по 10-100 нейронов в каждом) и 70.000 строк для обучения, выходит 51%-55% accuracy, при таком же количестве слоев и нейронов, но с примерно 300 строчками, получается 65%. Пробовал делать датасет еще больше: 500.000 строк и 14 параметров (против 70.000 и 5), accuracy падает до 53%, но более стабильна в процессе обучения. При большей дате пробовал делать больше слоев и нейронов (максимум - 5 слоев по 1024 нейрона), но чем больше становилась сетка, тем хуже результаты.

Скажите пожалуйста, что я делаю не так? Неужели надо тренировать нейронку на очень малом датасете? Может просто ебануть 100500 нейронов и слоев и молиться пока оно три дня обучается?

>LTSM

Вот это. Сетки для трейдинга смотрят на прошлое, как и индикаторы теханала.

И асло это тред про картиночки

Можешь пояснить подробнее в чем проблема? LTSM вроде для этого используют + я скармливал для тренировки достаточно много данных, 4 года вроде как.

И если есть специальный тред для того что я пишу - перешли пожалуйста, я не нашел

Здесь с чем-то подобным ебались

Дело в том, LSTM учится по прошлым данным прогнозировать следующие данные. Для рынка это все равно что индикатор, типа EMA. Она не будет давать большой точности потому что рынок постоянно меняется, а данные 4 года назад уже не актуальны.

Чел, очевидно же что данные говно. Чем больше наваливаешь этого говна, тем хуже. Оно учится предсказывать по статистике, но статистика полностью неверна. А на минимальном датасете получаешь что-то чуть лучше рандомного результата. Ты так никогда вменяемого результата не получишь, если у тебя нет каких-то внешних данных кроме свеч.

какой таймфрейм у свеч? может не надо на 5 секундных её обучать?)

Да, только там тред умер

Да, рынок нехорошо таким образом пытаться предсказать, но был же случай когда нейронки определяли расу человека по рентгену, может и на рынке есть какие-то, недоступные людям, закономерности.

А чем они говно, не очень понимаю. В датасете где 500.000 строк, используются 3 индикатора, причем на 15, 60, 240 -минутном таймфрейме. Пробовал еще просто количеством раньше (10 индикаторов на 70.000 строк, результат 50%-53%)

15 минут, можно и на 5 секундах попробовать, не понимаю как это поможет правда

> чем они говно

Тем что статистика не работает, чел. Ты учишь сетку предсказывать по прошлым данным, но эти данные не верны. Дроч с индикаторами - это уровень похода в казино, лучше сходи на ставки. Ты реально думаешь что один такой умный и можно просто взять и предсказывать по истории как оно будет изменяться?

Если бы раса менялась так же как данные рынка, то у нас бы были эльфы, кошкодевочки и рептилоиды. Даже при налиции циклов и закономерностей, данные больше пары месяцев уже не актуальны

что значит "не работает"? Статистика не нужна же для закручивания гаек, она не может работать или нет. Что ты имеешь ввиду?

Почему данные не верны? API бинанса как то их искажает или в формате .cvs есть систематические проблемы какие то? Опять же поясни пожалуйста, я не понимаю тебя.

Да, я понимаю что не один такой умный, понимаю что наверняка пальцем в небо было бы примерно так же, но должен же наверняка быть способ сделать хотя бы 60% правильности предсказаний, этого уже будет достаточно

Почему именно пары месяцев? Почему они перестают быть актуальными?

Потому что у условной компании выходит квартальный отчет, все ждали что будет хорошо и тарили, а там плохо. Или хорошо, но все просто начали разгружаться на факте.

Потому что изменили ставку ЦБ и для банков изменилась прибыльность

Потому что в Америке/Европе холодно/жарко и газ подорожал, поставщики получили прибыль..

Слишком много факторов, чтобы делать предсказания на основании одного только графика

> она не может работать или нет

У тебя статистическая модель, а ты пытаешься предсказывать погоду в Химках по количеству говна в лотке у кота.

да, поэтому я поставил еще индикаторов на разных таймфреймах, но твою мысль понял, попробую сделать более подробный датасет на меньшем временном интервале.

Ну нет, все таки говно в лотке и погода вообще не связаны, а данные рынка с рынком связаны, да и даже если нет, то как объяснить тот случай с определением расы?

И все таки почему данные не верны или что ты имел ввиду под этим?

Протестил 2070с - 1.45. У 3070ти всего 2. Пиздец, думал намного лучше будет

Индикаторы не добавляют полезной информации, они строятся по тем же данным свечей. Грубо говоря сетка сама должна понять закономерности, если они есть.

Понял тебя, что кроме индикаторов можно добавить?

> данные рынка с рынком связаны

Это как ещё? Изменения рынка никак не связаны с историей этих изменений.

Ну история происходит от изменений, а корреляцию в обратную сторону придумает нейронка

А ничего больше и нет. Только отчеты, новости и другие котировки (индексы, цены товаров, фьючерсы, опционы..)

печально, все равно спасибо

Больше всего в тренировке лор мне не нравится выбор конечного варианта.

Алсо ныжно ваше мнение. Сам выбираю между V2 и V2C

Алсо ныжно ваше мнение. Сам выбираю между V2 и V2C

V2C однозначно лучший вариант

Все не так одназначно:(

>то как объяснить тот случай с определением расы?

Негры делали снимки в бомж районах на старом оборудовании, а белые люди на современном, и снимки сильно отличались по качеству. Мыло? Негр.

Я слегка адаптировал похожий случай, когда нейросетка определяла болезнь по тому, что в больнице снимки делал другой аппарат, лол.

В графике с разным весом ноль смысла, оставляй 0.9 или 1 и увеличь число батчей чтобы сравнивать по нескольким пикчам а не одной. Также попробуй разный фон, разные ракурсы, разную одежду.

Да, я так и делаю.

Сначала смотрю какой вес лучше, чтобы не было корявых картинок на ~1.

Интересно вышло, спасибо за ответ

А чем концептуально отличается принцип работы миджорней от stabe diffusion?

В sd я наблюдаю что изображение постепенно проявляется из рандомной каши пикселей, в мж проявляется из черного фона. Это я верно заметил?

В sd я наблюдаю что изображение постепенно проявляется из рандомной каши пикселей, в мж проявляется из черного фона. Это я верно заметил?

Аисачеры, есть разница между 7 повторами и 10 эпохами VS 25 повторов и 3 эпохи? Результат при 1500 шагах и там и там одинаковый должен получиться?

710=70, 253=75, во втором случае будет дольше обучение.

Есть факторы что повлияют, но обычно их проявление на уровне рандома сида. В 10 эпохах легче вытащить вариант до запекания, а в трех последняя может оказаться пережаренная а предпоследняя - полусырая. Больше 10 смысла нету, но есть любители делать десятки-сотни, может они расскажут зачем и чего так можно достичь.

ну я тестил и в принципе меня устраивает 25x3, но хотелось бы 7x10 и чтобы он последние три сохранил, а не создавал кучу файлов

> чтобы он последние три сохранил

--save_last_n_epochs

спасиб!

а как делать лору с тригерр словом? это тупо в тегах только одно слово использовать?

Я в промте датасете первый токен использую

да я походу разобрался, все у питонистов через жопу сделано, вроде как название папки "15_model trigger_word" делается

вот видосик в тему кстати https://www.youtube.com/watch?v=kimxha0wTbY, как промтовые и триггер слова по разному работают, в теории тригер слово надо чтобы избежать перекрытия токенов в самой модели, но я слабо понимаю почему бы уникальное слово не использовать в датасете

Просто добавляешь этот тег с текстовое описание пикч, можно на первое место поставить. Например, имя персонажа, если его модель не знала то будет запомнено, если было - будет трактовать по-новому.

> вроде как название папки "15_model trigger_word" делается

В тренере кохи название папки будет браться в качестве единственного тега только если к пикчам отсутствует текстовые описания, иначе игнорируется.

> но я слабо понимаю почему бы уникальное слово не использовать в датасете

Его и нужно использовать, и в экспериментах на видео наиболее адекватное поведение у 3й версии где триггер-слово было плавно встроено в общее описание к пикче. С одним тегом еще будет обучение страдать, что видно по результатам соответствующих лор в видео, хотя оно не самое показательное, непонятно что в датасете и насколько оптимальны параметры обучения.

Вчера был установлен Roop, для SDWebui, отработал несколько генераций в txt2img, и все было благополучно.

Сегодня при генерации любого изображения, вне зависимости от модели, использования/неиспользования Roop и режима (txt/img2img), возникает ошибка:

Traceback (most recent call last):

File "F:\SDwebui\stable-diffusion-webui-master\venv\lib\site-packages\gradio\routes.py", line 337, in run_predict

output = await app.get_blocks().process_api(

File "F:\SDwebui\stable-diffusion-webui-master\venv\lib\site-packages\gradio\blocks.py", line 1013, in process_api

inputs = self.preprocess_data(fn_index, inputs, state)

File "F:\SDwebui\stable-diffusion-webui-master\venv\lib\site-packages\gradio\blocks.py", line 911, in preprocess_data

processed_input.append(block.preprocess(inputs))

File "F:\SDwebui\stable-diffusion-webui-master\venv\lib\site-packages\gradio\components.py", line 1492, in preprocess

im = processing_utils.decode_base64_to_image(x)

File "F:\SDwebui\stable-diffusion-webui-master\venv\lib\site-packages\gradio\processing_utils.py", line 53, in decode_base64_to_image

content = encoding.split(";")[1]

IndexError: list index out of range

Сталкивался ли кто, есть ли идеи как исправить эту ошибку?

Сегодня при генерации любого изображения, вне зависимости от модели, использования/неиспользования Roop и режима (txt/img2img), возникает ошибка:

Traceback (most recent call last):

File "F:\SDwebui\stable-diffusion-webui-master\venv\lib\site-packages\gradio\routes.py", line 337, in run_predict

output = await app.get_blocks().process_api(

File "F:\SDwebui\stable-diffusion-webui-master\venv\lib\site-packages\gradio\blocks.py", line 1013, in process_api

inputs = self.preprocess_data(fn_index, inputs, state)

File "F:\SDwebui\stable-diffusion-webui-master\venv\lib\site-packages\gradio\blocks.py", line 911, in preprocess_data

processed_input.append(block.preprocess(inputs))

File "F:\SDwebui\stable-diffusion-webui-master\venv\lib\site-packages\gradio\components.py", line 1492, in preprocess

im = processing_utils.decode_base64_to_image(x)

File "F:\SDwebui\stable-diffusion-webui-master\venv\lib\site-packages\gradio\processing_utils.py", line 53, in decode_base64_to_image

content = encoding.split(";")[1]

IndexError: list index out of range

Сталкивался ли кто, есть ли идеи как исправить эту ошибку?

Усиленный гуглинг помог решить проблему.

Нужно создать папку с именем gradio в C:\Users\%юзернейм%\AppData\Local\Temp\

Вдруг будет кому полезно

Собираюсь стать боярином с 4080 (пересаживаюсь с 2070).

Какие подводные?

С полгода назад (или больше уже?) была какая-то ебля со сборкой компонентов из исходников ради значительного повышения производительности - это решили?

Какие подводные?

С полгода назад (или больше уже?) была какая-то ебля со сборкой компонентов из исходников ради значительного повышения производительности - это решили?

Двач, помоги.

Работаю с СД через runpod, раньше все было прекрасно и я был доволен как слон, но в последнее время заебала ошибка CUDA out of memory. На карте в 24 гб не вывозит больше 1200 px, один раз даже 500х500 отказывался, на карте в 48гб картинку в 800х1500 еле генерирует и тормозит. Пробовал по советам с реддита удалять процессы python launcher и webui через терминал, но это то помогает, то нет. Что делоть? Я не айтишник, вот совсем.

Работаю с СД через runpod, раньше все было прекрасно и я был доволен как слон, но в последнее время заебала ошибка CUDA out of memory. На карте в 24 гб не вывозит больше 1200 px, один раз даже 500х500 отказывался, на карте в 48гб картинку в 800х1500 еле генерирует и тормозит. Пробовал по советам с реддита удалять процессы python launcher и webui через терминал, но это то помогает, то нет. Что делоть? Я не айтишник, вот совсем.

> Какие подводные?

16гб врам вместо возможных 24х. В остальном все ок, быстро работает из коробки даже в кохе, второй торч с кудой 118 сейчас уже везде.

Подробнее распиши что и как запускаешь, обычный sd-webui автоматика или что-то еще? Как там вообще организовано, тебе дается виртуалка с линуксом или что?

Да, обычный, облако с линуксом, Jupyter Notebook, запускаю готовый шаблон SD.

> запускаю готовый шаблон SD

Похоже в этом проблема, реально для 48 гигов (если речь о чем-то типа а6000 ада без преимуществ в мощности чипа) нет задач, 6 мегапикселей помещается в 24 гига, если нужно больше - хватает tiled vae.

Проверь чтобы устанавливалась нормальная версия, запускалась с xformers и вся врам действительно была доступна изначально ( https://stackoverflow.com/questions/58216000/get-total-amount-of-free-gpu-memory-and-available-using-pytorch )

Ладно, спасибо, буду пытаться думать

> LoHa Теоретически должен давать лучший результат при тренировках с датасетом в котором будет и персонаж и стилистика одновременно.

ммм чет залупа какая то

14k шагов, вверху LoCon, внизу LoHa

ммм чет залупа какая то

14k шагов, вверху LoCon, внизу LoHa

>16гб врам вместо возможных 24х

4090 просто для моих повседневных задач шибко оверкилл.

Думал вообще 4060ti новую взять и не париться, но комп чота старый уже, плюс продать его есть кому... Решил обновиться в итоге.

>второй торч с кудой 118 сейчас уже везде.

Эт хорошо. Значит, на новую систему ставлю гит, ставлю питон, копирую текущую папку вебуя - и оно работает, так? Или для уверенности венв убить, и пусть перекачает?

4080 вполне солидный вариант, с ним посоперничать может 3090(ти) но особенно в обычной встречаются проблемы с температурой памяти плюс это не новье со всеми вытекающими. Но аппетит приходит во время еды, и если увлечешься - потом будешь ныть что не доплатил.

> Значит, на новую систему

На новой системе - гит клон, лоры-модели-эмбединги копируешь, если лень настройки выставлять - еще config.json. Ультимативный вариант, делается быстро, если что старую папку не убивай - будет бекапом.

Чел, LoHa будет всегда хуже даже обычной лоры. Сопоставимые результаты можно получить только на ультрамелком датасете и низком ранге.

>Но аппетит приходит во время еды, и если увлечешься - потом будешь ныть что не доплатил.

Он уже пришел =)

Запарило в 8 гигов моей 2070 упираться, а тут сразу двойной прирост, красота будет.

Тренить свои чекпоинты не планирую все равно, на остальное 16 гигов должно хватить.

Сколько вообще мегапикселов в 16 гигов лезет? на 8 лимит ~1.3, и это если без лор и контролнета.

В 24 лезет около 6, тут будет 3.5-4, с костылями больше. Зависимость чуть не пропорциональна потому что в любом случае у тебя сколько-то отожрут веса и прочие компоненты. Вообще с учетом tiled vae должно хватить на все, но на горизонте sdxl а у нее требования больше и там уже 12-гиговые начали волноваться.

Если это верхний порог бюджета и уже все резервы выбраны - бери, вариант хороший.

>но на горизонте sdxl

Так и не понял особо ее преимуществ, если честно.

Пальцы хоть нормально рисовать будет?

Ахаха.

Поставил эту штуку, и тупо на загрузке автоматика со включенной модель - пикрил.

Это что вообще?

Почему Lora на SDXL так медленно тренится? 2000 шагов 11 часов, на SD 1.5 с таким же количеством занимает 20 минут ЧЯДНТ?

> Пальцы хоть нормально рисовать будет?

Да (нет)

> Это что вообще?

> там уже 12-гиговые начали волноваться

Голая прунед модель овер 6 гигов весит если что.

Поставь ComfyUI, Автоматик пока сосет по памяти

Ради одной этой модели? Лень.

Ну зашибись теперь.

Не зря комп апгрейдить собрался.

>Не зря комп апгрейдить собрался.

Заранее заготовь ответ консультанту, который будет охуевать от железа, мол, беру аниме тянучек создавать да на тексты дрочить.

Да я уже оплатил. Он ничего не спросил.

Наверное, по моему внешнему около-хикканскому виду и так всё понял.

А что дает clipskip?

Скипает клипы вестимо.

Зачем?

Для некоторых моделей есть пара лишних, которые лучше скипать. В основном аниме модели и скипают 1 слой (настройка на 2).

Есть один художник, у него 400 артов.

Я хочу скопировать его стиль. Я закинул его арты в папку, раздал им веса, выставил тег

artist_name_style

Получил лору. Так вот, лора превосходно копирует его стиль рисования и цвета, но есть одно но: лора почему-то иногда рисует body horror — то две попы на теле, друг над другом, то фистинг по локоть то 2 пары рук, как у Горо.

Вопрос: можно ли мне нагенерить лорой очень много артов, затем вытащить из них арты с боди-хоррором, сложить в папку с первичными рисунками и выставить боди-хоррор теги на сгенерированных артах — чтобы потом через негативный промпт "лишние конечности" и прочее удалять такие арты из выдачи (а не фильтровать самому)?

Я хочу скопировать его стиль. Я закинул его арты в папку, раздал им веса, выставил тег

artist_name_style

Получил лору. Так вот, лора превосходно копирует его стиль рисования и цвета, но есть одно но: лора почему-то иногда рисует body horror — то две попы на теле, друг над другом, то фистинг по локоть то 2 пары рук, как у Горо.

Вопрос: можно ли мне нагенерить лорой очень много артов, затем вытащить из них арты с боди-хоррором, сложить в папку с первичными рисунками и выставить боди-хоррор теги на сгенерированных артах — чтобы потом через негативный промпт "лишние конечности" и прочее удалять такие арты из выдачи (а не фильтровать самому)?

переформулирую: можно ли удачную/неудачную выдачу добавлять к первичному дата-сету и обучать заново?

Или SD-лоры/модели нельзя обучать на выдаче SD,

Экспериментируй, хули там. Можешь ещё в регуляционные картинки залезть.

> лора почему-то иногда рисует body horror — то две попы на теле, друг над другом, то фистинг по локоть то 2 пары рук, как у Горо.

Даже до хайрезфикса?

Просто потренируй с другими параметрами, такое обычно происходит при пережарке некоторых слоев. 400 пикч врядли будут однообразны, для начала поиграйся с параметрами тренировки, посмотри что на разных эпохах и т.д.

Также можешь попробовать в послойное применение лоры вычисляя экспериментально, но это попытка снять симптом а не причину.

> выставил тег

Тег один или к полноценным тегам добавил имя художника?

>послойное применение лоры

Для этого же есть расширение название которого я забыл

я не понял, прошла неделя а контролнета для С-Д-ИКС-ЭЛЬ так и нет. кто за вас это делать будет, хули вы тут волов пинаете?

Нахуй нужен, рисобака?

Бодихоррор обычно возникает, когда ты пытаешься заставить нейронку генерить картинку в слишком большом разрешении.

В результате нейронка генерит часть картинки, потом переходит на другую часть - и генерит ее заново, а потом пытается всё "сшить".

Отсюда всякие кентавры лезут.

Уменьшай базовое разрешение генерации, 800х600 - это почти предел стабильности сейчас (ну, за пределами SDXL). Всё, что выше - либо хайрезфиксом, либо апскейлом через и2и.

Другой вариант - на артах в обучении были картинки с несколькими персонажами (особенно в сложных взаимодействиях), и ты это соответствующим образом не протэгал. В итоге и получается 1girl с четырьмя руками и двумя головами.

Появилась новая проблема: при генерации с использованием Roop (который сейчас переименовался в ReActor), генерируется со всеми моделями что-то в духе пикрила. При этом, та же самая картина при генерации уже без Roop, будто весь SD сломался. Используется Automatic1111. Обновление плагина не помогло.

В командной строке, сначала заполняется ползунок генерации до 100%, потом перед ним появляются две строчки:

00:17:16 - ReActor - STATUS - Working: source face index [0], target face index [0]████| 16/16 [01:03<00:00, 4.23s/it]

00:17:29 - ReActor - STATUS - No target face found for 0

Будто бы на картинке, откуда надо взять лицо, лица нет, но оно есть.

Кто сталкивался, как фиксить, кто знает?

Пока я занимался раздеванием одноклассниц, у меня сформировался некий очень короткий алгоритм, дающий хороший (для меня) результат:

1. Берем фото, прогоняем через TopazPhotoAI, со всеми включенными пресетами. Если лицо одноклассницы достаточно крупно изображено на фото - все равно увеличение в 2 раза, это положительно влияет на конечный результат. Нет, через img2img результат похуёвее, мне не нравится.

2. Получившийся результат прогоняем через img2img на уровне Denoising strength 0,3-0,5 и выбираем самое годное.

3. Получившийся результат начинаем гонять через inpaint. Тут все стандартно: маску на лицо, Mask mode "not masked", Denoising strength "1", можно еще попробовать Masked content поменять.

Но чего я не решил - это дорисовка изображения таким образом, чтобы оно дорисовывалось только снизу например, или только слева, нувыпонели. Если тян мне нужна в полный рост а на фото только по грудь - приходится прогонять несколько интераций между Resize and fill и уменьшением фото & обрезкой ненужных сторон. Как сделать так, чтобы Resize and fill работал только вниз, например?

1. Берем фото, прогоняем через TopazPhotoAI, со всеми включенными пресетами. Если лицо одноклассницы достаточно крупно изображено на фото - все равно увеличение в 2 раза, это положительно влияет на конечный результат. Нет, через img2img результат похуёвее, мне не нравится.

2. Получившийся результат прогоняем через img2img на уровне Denoising strength 0,3-0,5 и выбираем самое годное.

3. Получившийся результат начинаем гонять через inpaint. Тут все стандартно: маску на лицо, Mask mode "not masked", Denoising strength "1", можно еще попробовать Masked content поменять.

Но чего я не решил - это дорисовка изображения таким образом, чтобы оно дорисовывалось только снизу например, или только слева, нувыпонели. Если тян мне нужна в полный рост а на фото только по грудь - приходится прогонять несколько интераций между Resize and fill и уменьшением фото & обрезкой ненужных сторон. Как сделать так, чтобы Resize and fill работал только вниз, например?

>Кто сталкивался, как фиксить, кто знает?

SD сломался. Ты сам ответил.

детайлером мама пользоваться не научила? Какие то лишние ненужные телодвижения.

Не учила, я методом тыка дохожу.

> Тег один или к полноценным тегам добавил имя художника?

боюсь, что тег один. так как руками 400 артов разметить анриал. художник не с данбурятника, а с фанбокса.

> Даже до хайрезфикса?

я ещё не разу не видел, чтобы хайрезфикс делал что-то такое. да, без него.

> в слишком большом разрешении

512x512 / 768x512 / 512x768

> на артах в обучении были картинки с несколькими персонажами (особенно в сложных взаимодействиях)

балин... да, так и было. мне поделить картинки на персонажей, где это можно, а на остальных — протегать?

Оптимизировал настройки, вместо 13 часов обучение заняло 5

У кого то были ошибки при обучении лоры когда loss улетает в Nan или наоборот в 1? Я уже задолбался настройки крутить, оно то работает то нет.

Что за видяха? 5ч на 2к шагов довольно медленно, у меня 2ч на 4к на 3070. Ну правда с проблемой выше.

Что за видяха? 5ч на 2к шагов довольно медленно, у меня 2ч на 4к на 3070. Ну правда с проблемой выше.

У меня было 4000 шагов, видеокарта 3060. На редите многие жалуются что очень медленно обучение идет. В итоге получилось замыленное говно.

>так как руками 400 артов разметить анриал

Авто-таггеры используй. В автоматике расширение есть.

Качество порой сомнительное, иногда откровенно шизит, но все-таки лучше, чем в один-единственный тэг всё пихать.

> так как руками 400 артов разметить анриал

Автотегеры. Один тег для некоторых случаев может работать и в очень редких даже полезен, но с ним обучение всирается до ужаса, от того и весь бадихоррор.

Что тренреруешь и с какими параметрами? Такое при дикой пережарке или битых пикчах в датасете происходит.

Locon, lr 0.0002-0,0004, alpha = dim. 50 картинок которые я пропустил через сетку чтоб придать стиль, на этот же стиль уже треню лору для хл.

Заметил что при повышении лр возникает чаще но вот вообще не стабильно, то на 0.0002 дохнет на 500 шаге то проходит весь процесс в 3к шагов без проблем.

1. У меня датасет 768x768, если указать при обучении 512x512, картинки будут резайзиться или кропаться? kohya gui

2. Картинка была допустим 300x300 и при увеличении имеет заметную лесенку, есть ли смысл прогонять картинки через апскейлер и потом ужимать чтобы были ровные линии, или все равно при обучении?

2. Картинка была допустим 300x300 и при увеличении имеет заметную лесенку, есть ли смысл прогонять картинки через апскейлер и потом ужимать чтобы были ровные линии, или все равно при обучении?

множественный кроп. все части изображения попадут в обучение

Что-то мне всегда казалось, что там таки ресайз под определенное соотношение сторон, а не кроп.

Ибо я на абсурдресах тренил до 4к-6к разрешения - и получалось вполне себе. В случае кропа - что-то сомнительно, чтоб оно нормально натренилось.

это bucket надо включить?

хотя он вроде тупо резайзит под указанное разрешение https://github.com/kohya-ss/sd-scripts/blob/main/library/train_util.py#L936

а еще есть галка `Random crop instead of center crop`

чет намеков на множественный кроп я не нашел

Нейрота в датасете ухудшит результат. Сколько дим и батчсайз? Альфу убавь или снизь лр, многовато, у текстового энкодера поставь половину от юнета. Планировщик и оптимизатор какие?

Ресайзиться, если соотношение сторон странное то еще кропнется до ближайшего что стоит в настройках.

Врунишка

> чет намеков на множественный кроп я не нашел

> Врунишка

Епить. Неужели я всё это время понимал алгоритм неправильно? Ясно, понятно. Буду делать 1:1

Это для SDXL лора так что там нету ни батчей, ни обучения энкодера, планировщик естественно констант, другие жрут до жопы.

24 дим, 12 конво, адам обычный. На адафакторе та же дичь. Даже если альфу 1 поставить и немного лр задрать для компенсации.

Сейчас внезапно выяснил что продиджи довольно неплохо работает. В гайде был weight_decay=0.01 но у меня он тоже на 400 шаге ебнул, поставил weight_decay=0.1 и вроде самое то

Сделали ли какие-нибудь новые модели интеррогаторов за последние полгода?

Зачем? Это говно изначально мертво было, все мультимодалки используют.

Что?

> все мультимодалки используют.

Раз это все используют, то должны быть уже готовые решения с пакетной обработкой и готовый чекпоинт, которых я вот не нашел. Линкани если есть. Демка с сайта ожидаемо обосралась инбифо: проблема навыка

мимо

> booru tags

Буквально худший способ тегать пики. Хотя бы потому что текстовый энкодер SD лучше работает с осмысленными предложениями, а не набором бессвязных слов. В итоге получается что все пики протеганы говном типа "1girl, sitting", а базовые промпты типа позы или положения персонажа относительно окружения и камеры - почти нихуя не работают.

>Хотя бы потому что текстовый энкодер SD лучше работает с осмысленными предложениями

И поэтому сосёт на персонажах, которые нужно указывать как два тега, а не как один через _, как это сделано на бурах.

Лол. Ну опиши все детали в осмысленном предложении и чтобы оно тебя поняло. А учитывая что аниме модели тренировались на тегах данбоору, то это еще больший лол

Тогда штоделоть?

Брат, тоже генрируешь ковбоев по cowboy shot'у?

>А учитывая что аниме модели тренировались на тегах данбоору, то это еще больший лол

А ещё мержи даже реалистик моделей содержат в прадедушках (или прабабушках?) какую-нибудь новел аи...

>Брат, тоже генрируешь ковбоев по cowboy shot'у?

Не всё так плохо конечно, но определённое влияние есть.

Нужны мультимодалки, а не вот это всё с автоматом созданными тегами по частоте встречаемости.

>а базовые промпты типа позы или положения персонажа относительно окружения и камеры - почти нихуя не работают.

Так они в принципе не работают даже на чистой SD, лол.

> через _

Потому что это разделительный символ, энкодеру в целом похуй какой символ будет стоять между словами, они всё равно на этапе токенизации будут разделены и оно не будет восприниматься как цельное слово. Если в описании пикчи нормально написано что эту тян зовут так-то, то оно и будет нормально воспринимать её имя в любом формате.

> Ну опиши все детали в осмысленном предложении и чтобы оно тебя поняло.

В чём проблема? Даже NAI понимает связь между словами в предложении, с миксах так вообще можно писать как при обычных генерациях. А вот когда гора тегов, то цвета и объекты всегда рандомно по пику раскиданы.

>Потому что это разделительный символ

Но ведь нет...

>то цвета и объекты всегда рандомно по пику раскиданы

А теперь угадай, почему у тебя боксы на картинке покрашены в blue.

> нет

Пидора ответ.

Пример красивый, но в нем все элементы окрасились в оттенки зеленого, боксы не очень то калоред, и главное то же самое достигается буру-стайл тегами с чуть более развернутым описанием.

ginger girl, blue eyes, sitting on the box, yellow boxes stacked, pink pyramid on top of head, full body

Negative prompt: (worst quality, low quality:1.3)

Важно указание понятного контекста а не просто спам в навал тем что может быть двусмысленно истрактовано.

Более того, с ними можно закладывать описанием больше деталей не делая странные предложения, что только спутают сеть, а взаимопроникновение может быть даже меньше чем натуральным текстом.

Если что не топлю за обязательное задание буру тегами, просто разбавляю твою радикальную позицию.

Еще важный момент что раз наи после столь интенсивной тренировки сохранила навык восприятия натурального промта, то почему тренинг лор буру тегами должен их испортить? Интересно сравнить с разным стилем теггинга на одинаковых параметрах

> буру-стайл тегами

Но ведь у тебя не они, ты просто предложение разбил запятыми вместо грамматических связок...

У тебя буквально два тега в booru-стиле - blue eyes и full body.

Подобное разбиение помогает модели, а "не они" потому что подобных для ситуации их просто нет. Как и описал, важно простое и понятное описание без двусмысленностей,

> pink pyramid on top of head

достаточно, потому что понятно что относительно чего, и использование чего-то типа

> pink, pyramid, object over head

сожрет не меньше токенов и будет иметь много трактовок. В то же время пилить натуртекст ради натуртекста - занятие того же уровня и не даст преимуществ в типичных ситуациях. Модель распознает структуру далеко не так хорошо как может показаться.

Возвращаясь к обучению - бурутеги (если нормально проставлены офк) вполне неплохо описывают главные атрибуты пикчи, что как раз важно для тренировки. Но если у тебя есть другие данные и с плейнтекстом все стабильно тренится лучше - покажи, будем делать так и благодарить.

Ну что ты копротивляешься? Видно же, что у тебя разные результаты, хотя это как бы разделители, которые должны как бы игнорироваться.

И да, я не хочу, чтобы _ было разделителем, и было бы лучше, если бы ото воспринималось как одно_слово.

> разные результаты

В первый раз видишь смещение результата при изменении символов и порядка тегов?

Кмк идентичность восприятия при разных разделителях и поломка при написании слитно очевидно. А вообще еще с прошлого года известно что _ - пожиратель токенов и заменяем пробелом.

Можно подробнее что за t2ia и что вообще на пикчах?

> вполне неплохо описывают главные атрибуты пикчи

Но они не описывают их взаимосвязь.

> pink pyramid on top of head

Ты ведь такое только руками можешь написать, booru-таггеры в такое не смогут.

> покажи

Я все пики вот такими простынями тегаю, намного лучше чем написать 5-10 коротких тегов. Если надо на аниме треноровать, то можно с бур теги вкинуть в промпте, оно вычленит имена и самое важное, остальное выкинет.

Вообще есть очень простой способ протестить качество тегов - вкинуть их в SD. Вот если ты свои пики с ящиками протегаешь каким-нибудь DeepBooru и попробуешь сгенерировать из этого - получишь совсем не то, генерация будет фактически как при "1girl, sitting, boxes, pink". А вот с простынёй уже будет сильно ближе к тому что было. Условно, тебе не надо учить модель по промпту "1girl, sitting, boxes" догадываться что тянка сидит на коробках, она и так умеет это генерировать если попросить правильно. Если это тренировка на персонажа, то и генерации с описания этой пикчи должны отличиться только внешним видом тянки, любые отклонения в композиции будут тренироваться вместе с ней.

> разные результаты

Дефис и подчеркивание - литералли одинаковое. Так же как и пробел если убрать ничего не меняется. По смыслу они все одинаково воспринимаются.

> Но они не описывают их взаимосвязь.

Вопрос в том нужна ли она при тренировке анимелор. Даже не спорю ибо для этого нужно хотябы знать, но есть ощущение что влияние будет слабое, надо сравнивать. Что для подобных тегов используешь?

> протегаешь каким-нибудь DeepBooru

Ага, тут вообще без шансов, оно пригодно только заапскейлить чужую пикчу когда база уже есть.

> любые отклонения в композиции будут тренироваться вместе с ней

На следующей неделе попробую если с теггером подскажешь. Если это еще улучшит лоры персонажа с мелким датасетом то будет замечательно.

>Дефис и подчеркивание - литералли одинаковое

Я даже в фотошопах накладывать не буду, на глаз же видно, что немного разные.

>По смыслу они все одинаково воспринимаются.

Не спорю, в данном случае да. Но вообще нет, не всегда это работает адекватно. Впрочем если будут делать мультимодалку, то будет похуй на такие мелочи, полноценная языковая модель в составе рисовалки вытянет любое говно в любом стиле (в теории).

> немного разные

С включенными оптимизациями они и будут немного разные всегда.