Гайд для тех, кто хочет запускать Koboldcpp под Windows 7 на CPU с поддержкой AVX2 и/или GPU, так должно работать ощутимо быстрее. Я сам какое-то время помучался с этим, в итоге собрал собственные бинарники из исходного кода.

Суть проблемы заключается в том, что код llama.cpp, на основе которого построен Koboldcpp, использует функцию PrefetchVirtualMemory из ядра Windows, которая появилась только начиная с Windows 8. Из-за этого попытки использовать Koboldcpp под Windows 7 в любых режимах, отличных от "NoAVX2 Mode" и "Failsafe Mode", приводят к падению на этапе загрузки модели. Соответствующие правки ещё давно были внесены в код llama.cpp и Koboldcpp, но сделаны они таким образом, что вызов PrefetchVirtualMemory не используется только в режимах "NoAVX2 Mode" и "Failsafe Mode", что лишает возможности задействовать AVX2 инструкции и/или GPU для ускорения работы, в самом лучше случае (при выборе "NoAVX2 Mode") у вас будут задействоваться только AVX1 инструкции. Разработчики Koboldcpp несколько раз делали специальные билды, совместимые с Windows 7, но это не приняло системного характера, поэтому чтобы иметь свежую полноценную версию Koboldcpp под Windows 7 вам потребуется собрать её самостоятельно.

(дальнейшие действия по мотивам https://github.com/LostRuins/koboldcpp?tab=readme-ov-file#compiling-on-windows)

1. Скачайте архив со сборочными инструментами: https://github.com/skeeto/w64devkit/releases, под 64-битную систему вам нужен архив w64devkit-1.21.0.zip, под 32-битную w64devkit-i686-1.21.0.zip.

Распаковываете его в отдельную папку.

2. Скачайте архив с исходным кодом Koboldcpp: https://github.com/LostRuins/koboldcpp/releases, выбираете "Source code (zip)".

Распаковываете его в отдельную папку.

Чтобы получить совместимые с Windows 7 библиотеки, задействующие AVX2, потребуется внести незначительные правки в процесс сборки. Найдите в исходном коде файл Makefile, откройте его в текстовом редакторе. Выполните поиск строки "gpttype_adapter.o: $(GPTTYPE_ADAPTER)" (без кавычек), после ней идёт строка "$(CXX) $(CXXFLAGS) -c $< -o $@", замените её на "$(CXX) $(CXXFLAGS) $(FAILSAFE_FLAGS) -c $< -o $@" (т.е. просто добавьте $(FAILSAFE_FLAGS) посередине, аналогично как в соседних). Это исключит вызовы PrefetchVirtualMemory при сборке библиотек koboldcpp_default.dll (загружается при выборе "Use No BLAS") и koboldcpp_openblas.dll (загружается при выборе "Use OpenBLAS").

3. Процесс сборки.

Откройте командную строку (запустите cmd.exe).

Перейдите в папку, где у вас лежит исходный код Koboldcpp:

> cd "c:\users\anon\downloads\koboldcpp"

Добавьте путь к сборочным инструментам (конкретно - подпапке "bin") в переменную окружения PATH:

> set PATH=c:\users\anon\downloads\w64devkit\bin;%PATH%

Если в пути встречаются пробелы, то заключите его в кавычки.

Запустите процесс сборки:

> make

В результате вы получите все необходимые компоненты, собранные из исходного кода.

4. Для непосредственного запуска модифицированного Koboldcpp или сборки однофайлового исполняемого файла (аналогично официальным сборкам) вам потребуется Python интерпретатор. Совместимые с Windows 7 сборки Python можно взять отсюда https://github.com/adang1345/PythonWin7/tree/master/3.12.1. Убедитесь, что при установке Python в режиме custom installation (если вы его выбрали) у вас включён Tcl/Tk.

Для непосредственного запуска просто установите Python интерпретатор, убедитесь, что .py файлы с ним ассоциировались, и кликайте по koboldcpp.py для запуска.

Для сборки однофайлового исполняемого файла вам потребуется также установить PyInstaller (https://www.pyinstaller.org/en/stable/installation.html) и запустить скрипт make_pyinstaller.bat.

Суть проблемы заключается в том, что код llama.cpp, на основе которого построен Koboldcpp, использует функцию PrefetchVirtualMemory из ядра Windows, которая появилась только начиная с Windows 8. Из-за этого попытки использовать Koboldcpp под Windows 7 в любых режимах, отличных от "NoAVX2 Mode" и "Failsafe Mode", приводят к падению на этапе загрузки модели. Соответствующие правки ещё давно были внесены в код llama.cpp и Koboldcpp, но сделаны они таким образом, что вызов PrefetchVirtualMemory не используется только в режимах "NoAVX2 Mode" и "Failsafe Mode", что лишает возможности задействовать AVX2 инструкции и/или GPU для ускорения работы, в самом лучше случае (при выборе "NoAVX2 Mode") у вас будут задействоваться только AVX1 инструкции. Разработчики Koboldcpp несколько раз делали специальные билды, совместимые с Windows 7, но это не приняло системного характера, поэтому чтобы иметь свежую полноценную версию Koboldcpp под Windows 7 вам потребуется собрать её самостоятельно.

(дальнейшие действия по мотивам https://github.com/LostRuins/koboldcpp?tab=readme-ov-file#compiling-on-windows)

1. Скачайте архив со сборочными инструментами: https://github.com/skeeto/w64devkit/releases, под 64-битную систему вам нужен архив w64devkit-1.21.0.zip, под 32-битную w64devkit-i686-1.21.0.zip.

Распаковываете его в отдельную папку.

2. Скачайте архив с исходным кодом Koboldcpp: https://github.com/LostRuins/koboldcpp/releases, выбираете "Source code (zip)".

Распаковываете его в отдельную папку.

Чтобы получить совместимые с Windows 7 библиотеки, задействующие AVX2, потребуется внести незначительные правки в процесс сборки. Найдите в исходном коде файл Makefile, откройте его в текстовом редакторе. Выполните поиск строки "gpttype_adapter.o: $(GPTTYPE_ADAPTER)" (без кавычек), после ней идёт строка "$(CXX) $(CXXFLAGS) -c $< -o $@", замените её на "$(CXX) $(CXXFLAGS) $(FAILSAFE_FLAGS) -c $< -o $@" (т.е. просто добавьте $(FAILSAFE_FLAGS) посередине, аналогично как в соседних). Это исключит вызовы PrefetchVirtualMemory при сборке библиотек koboldcpp_default.dll (загружается при выборе "Use No BLAS") и koboldcpp_openblas.dll (загружается при выборе "Use OpenBLAS").

3. Процесс сборки.

Откройте командную строку (запустите cmd.exe).

Перейдите в папку, где у вас лежит исходный код Koboldcpp:

> cd "c:\users\anon\downloads\koboldcpp"

Добавьте путь к сборочным инструментам (конкретно - подпапке "bin") в переменную окружения PATH:

> set PATH=c:\users\anon\downloads\w64devkit\bin;%PATH%

Если в пути встречаются пробелы, то заключите его в кавычки.

Запустите процесс сборки:

> make

В результате вы получите все необходимые компоненты, собранные из исходного кода.

4. Для непосредственного запуска модифицированного Koboldcpp или сборки однофайлового исполняемого файла (аналогично официальным сборкам) вам потребуется Python интерпретатор. Совместимые с Windows 7 сборки Python можно взять отсюда https://github.com/adang1345/PythonWin7/tree/master/3.12.1. Убедитесь, что при установке Python в режиме custom installation (если вы его выбрали) у вас включён Tcl/Tk.

Для непосредственного запуска просто установите Python интерпретатор, убедитесь, что .py файлы с ним ассоциировались, и кликайте по koboldcpp.py для запуска.

Для сборки однофайлового исполняемого файла вам потребуется также установить PyInstaller (https://www.pyinstaller.org/en/stable/installation.html) и запустить скрипт make_pyinstaller.bat.

>Ну, в среднем для 70б - это 2 токена/с, для 34б - 7т/c, для 20б и меньше - 15+т/c. Если мне память не изменяет.

Вопрос по 70B - это результат для двух карт, при полностью загруженной в видеопамять модели? А какой квант?

> Windows 7

> 2024

Нахуй так жить? Если такой конкомформист - есть линукс, который отлично работает как на старом, так и на новом железе.

Сап, аноны.

Надоела бездушность и соевость хыпыты, так что решил потестить локалочки.

Заспунфидьте дебилу пожалуйста. Скачал noromaid + mixtral instruct 0.4, просто mixtral instruct новый, с матрицей этой.

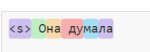

Пошел запускать и тестировать, но прям тяжко идёт. Постоянно тупит и повторы как на пик3, иногда не такие резкие, но все ещё повторы.

Есть вариант пофиксить, я же по любому обосрался где-то. Вот настройки на пик1, пик2. В обоих моделях ChatML формат вроде.

Ну я и обычный тестил, написал же

Нюфаг вкатился в эту вашу текстогенерацию.

У меня вопрос - почему у меня чем дальше ты генеришь тем все меньше текста на выходе дает нейросеть вплоть до самых простых фраз? После 15к токенов уже совсем генерит примитивное yes/no, bye.

И может здесь есть macos-бояре? Как правильно скомпилить kobold? У меня он совсем не юзает gpu. Ответа не нашел, тот же sd нормально работает.

У меня вопрос - почему у меня чем дальше ты генеришь тем все меньше текста на выходе дает нейросеть вплоть до самых простых фраз? После 15к токенов уже совсем генерит примитивное yes/no, bye.

И может здесь есть macos-бояре? Как правильно скомпилить kobold? У меня он совсем не юзает gpu. Ответа не нашел, тот же sd нормально работает.

вот, попробуй мои настройки. модель noromaid-20B

>У меня вопрос - почему у меня чем дальше ты генеришь тем все меньше текста на выходе дает нейросеть вплоть до самых простых фраз? После 15к токенов уже совсем генерит примитивное yes/no, bye.

смотри, сетка когда берёт нить повествования в каком-то стиле, потом её хуй отвадишь от такого. возможно, тебе стоит поредачить её вывод чтобы она немного "взбодрилась".

>И может здесь есть macos-бояре? Как правильно скомпилить kobold? У меня он совсем не юзает gpu. Ответа не нашел, тот же sd нормально работает.

пердолься

А у тебя не контекст закончился?

Вангую, что сейчас расскажут, насколько я неправ и хуйню пишу, однако. При ёбке ллм всё упирается в контекст. Грубо говоря, сколько текста она можешь прохавать за один раз. В этот же контекст должен влезать твой промпт плюс ответ. В угабуге можно зайти в настройки и выставить Truncate the prompt, чтобы промпт обрезался, начиная с более старой хуйни. То есть у тебя остаётся больше пространства для новой хуйни, в которую, очевидно, входит и ответ модели. Если ты упираешься в 15к, обрезай пораньше. Можно ещё разрешить растягивать max new tokens, но у меня с этим тормоза начались.

Ставь просто noromaid 20b кванта, который влезает. Даже Q3K_M подойдет, на 20б оно не сильно лоботомирует, в идеале exl2 6 бит.

Пресет инстракт режима - дефолтный roleplay в обоих пунктах вместо chatml, можешь подредактировать или вообще удалить часть про 2 paragraphs.

Пресет семплеров - Simple-1, а не та дичь что выставлена. Будет следовать промту, держать разметку, выдавать интересный текст без лупов.

> После 15к токенов уже совсем генерит примитивное yes/no, bye

Что за модель? Если повелся на 32к копиума мистралей - оно чисто номинальное, и нужны настройки rope.

> Как правильно скомпилить kobold?

Так ух выходит что макось-господа должны страдать. Тут или полноценный убабуга, что легко ставится в один клик и на макось, но занимает много места и без того мелкого диска, или пердолинг с кобольдом, в котором на маки кладут.

Есть двухгпушные с линуксом? Любые карточки подойдут, нужно замерить сколько видеопамяти скушает какая-нибудь модель при делении пополам с, например, 8к контекста при загрузке экслламой, и сколько будет при полном заполненни контекста. Скорости не важны.

Удивил меньший расход видеопамяти, нужно выяснить это флеш-атэншн и прочее там эффективнее работает чем на шинде, или при шаринге расход немного повышается.

Удивил меньший расход видеопамяти, нужно выяснить это флеш-атэншн и прочее там эффективнее работает чем на шинде, или при шаринге расход немного повышается.

> нужно выяснить это флеш-атэншн и прочее там эффективнее работает чем на шинде

Нет, конечно. Там одинаковый CUDA-код, лол. В том числе nvcc там одинаковый, т.е. даже оптимизации при компиляции идентичные. На линуксе разве что получишь сырее драйвера под новые карты.

llama-2-70b.Q4_K_M.gguf - весит 39G

с контекстом как раз память выедает всю

Можно конечно и без контекста загрузить менее квантованную модель, но какой в этом смысл

Ну, сами картинки распознаются моделью CLIP, а чат от LLaMa.

Как альтернатива — BaKLLaVa имеет ту же модель, но болтает Mistral'ю.

Да, в теории — можно.

Ребят, скажите, на русском какая-нибудь из моделей норм говорит?

А то на мою Нейрославу жалуются, что она тупая. Пока перевод пробрасывать в гугл я не готов, хочу модельку поменять. Как придет P40, может 20b или 34b какую взять.

Yi сколько влазит, в каком кванте?

Но у меня нет!.. =с

Интересно в стабле, может xttsv2 запустишь.

Всякие RCV мне лично не так интересны.

> whisper на модели large распознает голос в текст почти в реалтайме.

> text to speech и замена голоса работают так же в реалтайме, у них только ощущаются задержки на буферизацию.

Оп-оп, спасибо, кажется надо было сразу 2 карты брать… =D Под llm и под обвес.

2 итерации в секунду — это как P104-100. У меня так же генерит (ну я занизил частоту с потреблением — 1.8 ит/с).

Вроде не закончился поставил в настройках кобольда и таверны 16к, оно не сразу генерит короткие фразы, а постепенно. Пропадают эпитеты, описание мира, потом мысли, остаются только фразы и становятся все примитивнее.

Короче я так понял если несколько раз сетка сгенерит что-то короткое оно и дальше начнет обрезать?

Да я фроствинд заюзал из шапки, это говномодель? Пробовал mlewd он лагает о я ебал (генерит две минуты) и 30гб памяти сожрал.

Что за убабуга?

кто-нибудь шарящий, помогите.

я бы хотел погонять Adventure Mode из кобольда в силлитаверне, но не могу объяснить ей что она рассказчик и должна генерировать мне историю и вводить персонажей, а не общаться со мной. в идеале вообще чтобы я мог прописать условия мира и всякую предысторию, а игра мне выдавала порции текста в ответ на мои действия, описанные уровня

> try to sneak behind and pickpocket a guard

я бы хотел погонять Adventure Mode из кобольда в силлитаверне, но не могу объяснить ей что она рассказчик и должна генерировать мне историю и вводить персонажей, а не общаться со мной. в идеале вообще чтобы я мог прописать условия мира и всякую предысторию, а игра мне выдавала порции текста в ответ на мои действия, описанные уровня

> try to sneak behind and pickpocket a guard

>Короче я так понял если несколько раз сетка сгенерит что-то короткое оно и дальше начнет обрезать?

буквально да.

> смотри, сетка когда берёт нить повествования в каком-то стиле, потом её хуй отвадишь от такого

Это уже такие лупы, но действительно бывает. В старых сетках такое случалось из-за долгого стояния на месте, но лупы были более классические а не отупение. Здесь скорее из-за контекста беда.

> Да я фроствинд заюзал из шапки, это говномодель?

Для своего размера - более чем, она старается, пусть и не идеальна. Вполне пригодна для рп и с ней можно довольно purrs.

> Что за убабуга?

Text generation webui. Шапку прочти и в ней ссылка на вики.

Нужно прописать промт, что передается в этом эдвенчур моде?

>Что за убабуга?

добро пожаловать в тред

владелец двух p40

вот это поле в хубабубе говорит инструкции для нейросети. У тебя в кобольде есть что-то похожее? Вот тебе это надо править.

>Нужно прописать промт, что передается в этом эдвенчур моде?

>вот это поле в хубабубе говорит инструкции для нейросети. У тебя в кобольде есть что-то похожее? Вот тебе это надо править.

вот в том и дело что в кобольде этот промпт скрыт. скорее всего, там абзац текста потипу как вот на скрине , но мне не удаётся нормально его оформить под адвенчурку.

>Ребят, скажите, на русском какая-нибудь из моделей норм говорит?

я ещё не встречал.

Все говорят "ебал её рука", если пытаешсья на русском с ними.

Я правда не искал специально русскоязычные.

Так, поотвечал, таперича мысли. Может кто подаст годную идею.

Есть xttsv2, занимает 4,5 гига.

Есть Animaze, занимает 1 гиг.

В перспектике будет Whisper и какой-нибудь PyTorch, OpenCV и всякое.

И нужна модель, которая бы отвечала за вменяемое время.

Варианта вижу три:

1. Переводить гуглом, генерить моделькой на инглише, переводить гуглом обратно.

Минус — на стриме любят задавать каверзные вопросы.

2. Переводить локальной моделью (ALMA?), генерить другой моделькой на инглише, переводить обратно.

Минус — дольше за счет двух переводов, хз где и на чем гонять вторую модель.

3. Генерить сразу на русском. Получается криво, зато скорость не страдает, все локально, прямо, туды-сюды, контекст не ломается при переводах.

Из железа:

4070ti 12G

1630 4G =)

P104-100 8G

И идет P40 24G (одна штука).

Сейчас я на P104-100 держу Mistral Q8, которая кое-как умеет в русских, а иногда прям хорошо.

А на 4070ti держу xttsv2 и Animaze.

Проблема в скорости. xttsv2 генерит в среднем 2-3 секунды. Плюс Mistral отвечает 2 секунды (20 токенов/сек, контекст — одно сообщение).

Итого 5 секунд тратится только на генерацию. А еще передачи запросов, и вот 7-8 секунд мы получаем.

Долговатая реакция. Учитывая задержку стримов, выходит и вовсе 10-15.

В перспективе бы увеличить контекст, чтобы моделька помнила последние 10 сообщений + последние 10-20 сообщений автора (но без ответов от нее тоже такое себе, да и с промптом придется поебаться). Проблема в том, что P40 умеет только в выгрузку GGUF, а значит скорости в 40 токенов нам недоступны. С контекстом на 34b вроде выходит 6-8 токенов. Что увеличит время ответа втрое? Будет 6 секунд.

С другой стороны, +4 сек — это суммарно 25%-50%, не сильно критично, но уже неприятно.

С другой стороны, можно выгрузить сразу две модели (можно же?), Mistral и ALMA в три захода будут где-то по 3-4 + 3-4 + 2 секунды писать, то есть те же 4 сек получу. Но, возможно, качество русского будет лучше.

Хотелось бы иметь Tesla A80 для запуска квантованной Микстрали или 70b, ну или хотя бы парочку RTX 4090, но чего нет — того нет. =(

Даст ли 3090 бушная буст относительно P40 на 34b сетке? Будет ли там 12 токенов с контекстом? Будет ли там 20 токенов без контекста?

Эх, шо поробышь, шо поробышь…

Есть xttsv2, занимает 4,5 гига.

Есть Animaze, занимает 1 гиг.

В перспектике будет Whisper и какой-нибудь PyTorch, OpenCV и всякое.

И нужна модель, которая бы отвечала за вменяемое время.

Варианта вижу три:

1. Переводить гуглом, генерить моделькой на инглише, переводить гуглом обратно.

Минус — на стриме любят задавать каверзные вопросы.

2. Переводить локальной моделью (ALMA?), генерить другой моделькой на инглише, переводить обратно.

Минус — дольше за счет двух переводов, хз где и на чем гонять вторую модель.

3. Генерить сразу на русском. Получается криво, зато скорость не страдает, все локально, прямо, туды-сюды, контекст не ломается при переводах.

Из железа:

4070ti 12G

1630 4G =)

P104-100 8G

И идет P40 24G (одна штука).

Сейчас я на P104-100 держу Mistral Q8, которая кое-как умеет в русских, а иногда прям хорошо.

А на 4070ti держу xttsv2 и Animaze.

Проблема в скорости. xttsv2 генерит в среднем 2-3 секунды. Плюс Mistral отвечает 2 секунды (20 токенов/сек, контекст — одно сообщение).

Итого 5 секунд тратится только на генерацию. А еще передачи запросов, и вот 7-8 секунд мы получаем.

Долговатая реакция. Учитывая задержку стримов, выходит и вовсе 10-15.

В перспективе бы увеличить контекст, чтобы моделька помнила последние 10 сообщений + последние 10-20 сообщений автора (но без ответов от нее тоже такое себе, да и с промптом придется поебаться). Проблема в том, что P40 умеет только в выгрузку GGUF, а значит скорости в 40 токенов нам недоступны. С контекстом на 34b вроде выходит 6-8 токенов. Что увеличит время ответа втрое? Будет 6 секунд.

С другой стороны, +4 сек — это суммарно 25%-50%, не сильно критично, но уже неприятно.

С другой стороны, можно выгрузить сразу две модели (можно же?), Mistral и ALMA в три захода будут где-то по 3-4 + 3-4 + 2 секунды писать, то есть те же 4 сек получу. Но, возможно, качество русского будет лучше.

Хотелось бы иметь Tesla A80 для запуска квантованной Микстрали или 70b, ну или хотя бы парочку RTX 4090, но чего нет — того нет. =(

Даст ли 3090 бушная буст относительно P40 на 34b сетке? Будет ли там 12 токенов с контекстом? Будет ли там 20 токенов без контекста?

Эх, шо поробышь, шо поробышь…

>Yi сколько влазит, в каком кванте?

Я это юзал. Каждая карта 24 гб.

https://huggingface.co/TheBloke/yi-34B-v3-GGUF/tree/main

> вот в том и дело что в кобольде этот промпт скрыт

Он опенсорс, все можно найти, но скорее всего отдельно описан. Если сам не сможешь - тогда подожди пока кто-нибудь раскурит и надейся что не забудется

> Даст ли 3090 бушная буст относительно P40 на 34b сетке?

Даст офк, раза в 3 примерно. Ты скажи какой квант потестить, на обрезанном по тдп ампере потом могу прогнать.

Максимальный q4_K_M, если я не ошибаюсь.

Любую, какая есть, буду рад. =)

Без контекста и с контекстом на 2000-3000 токенов (если там влезет, вроде должно).

Пасиб!

> Максимальный q4_K_M, если я не ошибаюсь.

Вообще там самый жирный gptq вмещается с [x]k контекста, кощунство использовать жору когда есть бывшая. Ну вечером уже или завтра, заодно можно попробовать сравнить потребление врам.

>Можно конечно и без контекста загрузить менее квантованную модель, но какой в этом смысл

Смысл в том, что если видеопамяти хотя бы немного не хватает, то тест уже никуда не годится. Нужно, чтобы модель и контекст влазили полностью. Чувак с Реддита писал про 9 с лишним токенов в секунду на 5K_M - у него правда 4 P40 было. Попробуй.

Ещё здесь говорили, что под Линуксом с работой на нескольких ГПУ похуже, чем под Виндой.

Блин, точно, на ней же экса заведется! Я дурак, каюсь, тыкай ее. =)

Можно еще ее https://huggingface.co/LoneStriker/Yi-34B-200K-DARE-megamerge-v8-5.0bpw-h6-exl2 попробовать, должна влезть с небольшим контекстом.

>https://huggingface.co/LoneStriker/Yi-34B-200K-DARE-megamerge-v8-5.0bpw-h6-exl2

Ебать мерж, буквально из всего. И как, норм?

Пока качаю, но мне важна в данном случае битность и скорость.

А там уж выберу подходящий мердж и попробую сам квантануть.

———

Кстати, кто подскажет, как там легко квантовать Exl2 модели? Помню, писали, но потерял.

>под Линуксом с работой на нескольких ГПУ похуже, чем под Виндой.

пиздёж. Виндобляди не знают даже как посмотреть у себя в системе открытые порты, глупо было бы рассчитывать что они что-то компетентно могут сказать про скорость работы нейросети.

>3. Генерить сразу на русском.

>Получается криво, зато скорость не страдает

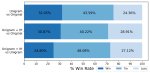

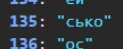

Скорость страдает, токенов\с столько же, но сами токены это слоги, а не слова, как на английском. Потенциально меньше текста и, очевидно, сама скорость на слово ниже. Вот у меня на пике текст\перевод, на русском 34 токена, на английском 26. И, т.к больше токенов - это больше жрёт контекст. Лично у меня с ростом контекста скорость генерации падает в пизду, даже при учёте того, что это всё ещё помещается в память.

>Учитывая задержку стримов, выходит и вовсе 10-15

Ты, чтоли, вчера стрим скидывал? У тебя что-то сильно неправильно работает. Прям охуеть, как сильно.

>I'm fucked up

лол, рекурсивненько

Гугол транслейт. Потому и не хочу гонять переводы, лучше буду заталкивать модели в анус шизу сразу на русском. Ещё бы лоры быстрее тренировались.

Прости, кожаный, у меня нет денег на шкаф видимокарт.

В консоли посмотри, весь промпт пишется в параметре "prompt". Я запустил на каком-то пресете с галочкой эдвенче мод - там совсем простецкая инструкция, и нет никакого форматирования толком. Вот она со скриншота: [Interactive Fiction: Game Mode Enabled]\n[You are playing a choose-your-own-adventure game. Please input action.]\n\n\n> Look\n\nYou look around, observing yourself and your surroundings. Всё, что ниже, это я пытался пару обычных реплик написать в story режиме и пару действий в action режиме. Все реплики и действия чередуются через две пустые строки, перед действиями автоматом пишется префил в виде >. Думаю, что в таверне это можно даже более адекватно сделать, дав больше примеров действий и ответов на них и расширив систем промпт. Единственное, что нельзя будет выбирать между story/action, но уж значок > можешь и сам писать.

Чел, не гори. В обоих ОС юзери тупо гуглят, как что делать, и то, что ты заучил ss -tupl не делает тебя лучше.

>Потому и не хочу гонять переводы

Гоняй на инглише сразу.

Алсо добавлю, что на чабе полно рпг/сторителлинг карточек, вроде вот такой https://chub.ai/characters/SpringyTwist/text-adventure. Полноценно с соблюдением всех инструкций, может, и не будет работать, но на каком-то уровне вести игру-приключение должно. Систем промпт в данном случае мб даже пустой лучше оставить, потому что инструкция в карточке написана.

я просто отметил, что виндобляди не считаются компетентными хоть в чем-нибудь.

Блин, точка к ссылке приклеилась. Продублирую для удобства. https://chub.ai/characters/SpringyTwist/text-adventure

Ты просто пёрнул в лужу.

почему тебе неприятна правда, виндоблядь?

>Гоняй на инглише сразу.

Не хотет. Прикручиваю спич ту текст, на английском пиздеть вообще не варик. Походу, на каких-то стримерах обучалось, просит подписаться, хотя я тупо нос почесал. Ещё и цензурит местами, но очень выборочно.

спасибо тебе большое, анон! буду пробовать.

Ты точно не настраивал rope, а просто увеличил контекст. Поэтому когда модель выходит за свой размер контекста или даже приближается к нему, у нее падает качество ответов и они становятся все короче.

Настраивай параметр rope вместо 10000 ставь либо рекомендованное значение для сетки которую ты скачал, либо наугад ставь хотя бы 20к-30к при удвоении контекста, 40к-50к при 4х.

Потому что это не правда, илитарий мамкин.

>Не хотет.

А придётся. Все другие варианты это просадка в качестве ответов.

>А придётся. Все другие варианты это просадка в качестве ответов.

Я больше скажу - Гугл-перевод вообще лучший вариант. Язык моделей довольно суконный, и они ждут от пользователя примерно того же. Перевод от Гугла идеально подходит - просто нужно понимать его особенности. Я пробовал прикрутить перевод от Дипла в обе стороны, так результат был хуже.

> Есть xttsv2, занимает 4,5 гига.

> Есть Animaze, занимает 1 гиг.

> В перспектике будет Whisper и какой-нибудь PyTorch, OpenCV и всякое.

Это все на другую видюху или вообще на отдельную пекарню раз некрожелеза хватает.

> Проблема в скорости

Лучше адеквантный и хороший ответ через 20-30 секунд чем вываливающиеся потроха кривого промта и шиза за 7.

> В перспективе бы увеличить контекст, чтобы моделька помнила последние 10 сообщений + последние 10-20 сообщений автора

Обязательно, но так чтобы это не сильно внимание смещало и она больше понимала общую атмосферу разговора, а не упарывалась в детали. Можно оборачивая правильно в промт организовать. А историю сообщений юзеров так вообще динамической подгрузкой с учетом ответа, а остальное что дальше - суммарайз. Только аккуратно сделать чтобы относительное положение во времени не уплывало и не ломалось.

> Но, возможно, качество русского будет лучше.

Не только качество лучше, но и гораздо меньше тупняка.

Вообще, сколько там врам нужно для нормального файнтюна хотябы лорой, но без квантов? Использовать датасет из того проекта финов, добавить чатов стримеров и хотябы для мистраля запилить попробовать.

>616446

> Чувак с Реддита писал про 9 с лишним токенов в секунду на 5K_M - у него правда 4 P40 было

Попахивает пиздежом, реально. Или есть возможность под них соптимизировать. Ускорение от добавления карточек в llamacpp не должно быть.

Хуя триггернулся

слушай, а как работает Rope scale и rope lenght? в чем разница и что крутить?

>Или есть возможность под них соптимизировать.

Именно, там еще в первых постах писали на реддите что нужны какие то оптимизации при сборке llama.cpp на линуксе

Какие именно - го ту реддит искать по темам с p40

А где там по дефолту у тебя 10000 стоит? Я если что про кобальд и лламаспп говорил, там есть эти параметры

> робот, ну скажи им!!!

Обосрался, спасибо.

> Можно еще ее https://huggingface.co/LoneStriker/Yi-34B-200K-DARE-megamerge-v8-5.0bpw-h6-exl2

На шинде с адой в 24 гига влезает ~3-4к контекста (офк чтобы был запас)

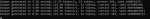

> Output generated in 9.36 seconds (31.95 tokens/s, 299 tokens, context 2663, seed 510213228)

> Output generated in 9.69 seconds (30.85 tokens/s, 299 tokens, context 2663, seed 1910527247)

> Output generated in 8.91 seconds (33.56 tokens/s, 299 tokens, context 2663, seed 938647000)

На прыщах с ампером 6-7к

> Output generated in 16.91 seconds (17.68 tokens/s, 299 tokens, context 5216, seed 1217045473)

> Output generated in 12.18 seconds (24.05 tokens/s, 293 tokens, context 5216, seed 1675320773)

> Output generated in 12.53 seconds (23.87 tokens/s, 299 tokens, context 5216, seed 1709675759)

На 3090 будет чуточку быстрее

>Попахивает пиздежом, реально. Или есть возможность под них соптимизировать. Ускорение от добавления карточек в llamacpp не должно быть.

Вот ещё один, 3 P40:

https://www.reddit.com/r/LocalLLaMA/comments/17zpr2o/nvidia_tesla_p40_performs_amazingly_well_for/

Цитата: "Я ни разу не разочаровался! Здесь у меня есть скриншот с его запуском Goliath 120b Q4KS, который в основном выжимал максимум из видеопамяти. Он работает со скоростью 3-4 т/с с некоторым загруженным контекстом. Он определенно замедлится с увеличением контекста, но для того, сколько стоят эти карты, я думаю, что это очень хорошая производительность!"

Здесь же в тредах мы видим очень скромные результаты. Разница на первый взгляд только в том, что у тех чуваков с Реддита количество линий PCIe максимально или близко к этому. Так же по ссылке явно на Винде запускали. Разобраться бы надо.

пасибки, вообще по всему гайду пробегусь

https://www.reddit.com/r/LocalLLaMA/comments/19a7vc2/finetune_387_faster_tinyllama_600_faster_gguf/

Кто там с сетками хотел баловаться? Вот какой то опенсорс проект ускоритель файнтюна с меньшим использованием памяти.

Я не в теме, но выглядит отлично

Кто там с сетками хотел баловаться? Вот какой то опенсорс проект ускоритель файнтюна с меньшим использованием памяти.

Я не в теме, но выглядит отлично

https://www.reddit.com/r/LocalLLaMA/comments/19a1scy/wavecoderultra67b_claims_to_be_the_2nd_best_model/

Новая сетка для погромистов, топчик по их тестам.

Новая сетка для погромистов, топчик по их тестам.

Уже даже на чреддите обоссали.

Классика пиздаболии.

Но метод обучения в комментах описан интересным. Конечно 7b соснет в качестве генерации, так как не сможет большие тексты вниманием держать или соблюдать одновременно много инструкций. Я просто думаю это тестовый запуск, после которого будет обучена сетка по больше, хотя бы та же 34b

Хотя на коротких примерах до 2к-4к 7b может быть на ровне с большими сетками, если хорошо надрочена на отличных примерах. Поэтому не уверен что это полный пиздеж, комментаторы как всегда играют в пророков еще не щупав результат

эти чуваки с реддитов вечно нихуя нормально показать не могут. Как они там запускают, с какими параметрами, какие версии, на каком железе - нихуя вообще не показывают.

Только скрины своих виндовых окошек постят.

Виндобляди ас из как говорится.

Пользы от таких постов как с козла молока.

Так сделой и покажи сам.

В чем проблема?

> Какие именно - го ту реддит искать по темам с p40

Любопытство сильно, но оно - единственный мотиватор, наверно, пусть владельцы ищут.

> что у тех чуваков с Реддита количество линий PCIe максимально или близко к этому

Почему тогда у анона с x4 2.0 почти нет разницы при делении сетки на две карты? Да и перфоманс излишне высокий если сравнивать с тем что на 3к/4к серии, если скейлить результаты с exllama то получится 7-11 токенов при том что там перфоманс выше более чем в 3 раза даже без оптимизаций на малую битность.

Возможно там есть какая-то оптимизация, что может быть применена ко всем, но вероятность мала.

>у анона с x4 2.0 почти нет разницы

я тут.

Я когда ёбся с попытками оптимизации

https://github.com/ggerganov/llama.cpp/pull/4233

я не совсем llama.cpp пересобирал.

Я пересобирал python-llama-cpp который потом подсовывал жоре.

Может быть это послужило причиной, хотя не должно было.

А еше можно проверить откатившись на старый коммит

https://www.reddit.com/r/LocalLLaMA/comments/17xcn5d/psa_if_you_have_telsa_p40_which_has_abysmal_fp16/

>робот

все еще умнее среднестатистического мышевоза

>это просадка в качестве ответов.

А меня на самом деле устраивает качество ответов. Меня не устраивает пара моментов. Иногда сетка может ебануться и ответить мне моим же постом или крутить один и тот же пост несколько раз подряд. Или просишь рассказать о котах, а потом о собаках. Он берёт пост о котах и меняет котов на собак. И всё, буквально ничего другого не меняется. По идее, нужно отхуяривать контекст, или я хуй знает. Ставил цфг выше, температуру выше, на выхлопе шиза.

Легче всего с коверканием слов, здесь можно прикрутить простой скрипт со словарём, который это всё пофиксит за наносекунду.

Потыкал палкой виспер, ебать же шизоидальный бред получается. Пиздос. Никуда не годится. Причём если налету переводить в английский, то предложения получаются осмысленные, но, сука, абсолютно не с тем смыслом.

я кстати только что обновил хубабубу до мастера и у меня средний т/с вырос с 16 до 20 на openchat 3.5-0106-f16.gguf

тот у кого 2 p40

тот у кого 2 p40

>А еше можно проверить откатившись на старый коммит

проверил, это не дает эффекта

Чел. Таких тейков про 7б говно наравне с гпт4 было уже воз и маленькая тележка. По итогу что?

Магии не бывает. Деда мороза нет.

>про 7б говно наравне с гпт4

Так ведь говорится про узкую задачу, к тому же непонятно как были сделаны тесты. Что там в реальном использовании уже другой вопрос

> Магии не бывает.

ЖПТ4 Турба уже крошечная по размерам. Было бы что обгонять. Она внезапно неплохо просела по некоторым тестам в ноябре по сравнению с мартом без турбы.

И что блять, за 3 года никто так и не сделал норм модель для аи данжона без цензуры? Что никто не может себе купить блядские 360гб врама что ли и запилить сервис? Нахуй вы тогда нужны тогда с говниной 7бшной. Давно уже железо позволяет и текст и картинки генерить рилтайм, что бы создать волшебный самый сладкий кумерский фентези, нет блядь, будем микстрали дрочить однотипными вопросами. Хуета ваш локал ларж лангуаге моделс

Дак мы тока настраиваем. API ебучее, хрен проссышь, че и как передавать.

Но опять же, представь 34 и 26 против 34 и 34 но постоянный перевод туда-сюда.

> Лучше адеквантный и хороший ответ через 20-30 секунд чем вываливающиеся потроха кривого промта и шиза за 7.

Это пофиксил немного.

> А историю сообщений юзеров так вообще динамической подгрузкой с учетом ответа

Да, буквально — сохранять в базу, выбирать 10 последних, пихать в историю, оформлять промпт «я помню, что раньше он писал…»

А далее — текущий контекст чата.

Ух, бодро! Спасибо!

Да.

———

Сегодня смог запустить с миростатом, общаться стала гораздо адекватнее.

Ебучее API убабуги, хуй найдешь, документации нет, чувак из силлитаверны — гений, по-ходу, раз смог заставить это все работать.

Причем, так как фразы короткие, тау вогнал в 1, а эту в 0,9.

Почти всегда укладывается в 64 токена генерации, отвечает гораздо больше в тему, чем раньше.

В общем, доволен, почему раньше миростат не юзал! Аж интересно, как он себя ведет в больших текстах и в рабочих задачах.

Ну и я снова немножко побуду тварью и кину ссылочки.

https://goodgame.ru/neuroslava

https://twitch.tv/neuroslava

https://www.youtube.com/watch?v=8BcqlT_F5iI

>neuroslava

Она же у тебя как несла полную ахинею, так и несет.

Дабл.

Пофиксил.

Короче, в чем проблема.

При низком значении тау и высокой эта, она почему-то начинает сообщения с «А…»

Говорит адекватно (напоминаю — ей надо уместить в 64 токена, а не решать уравнения), но постоянное «А».

Фиг знает, как это побороть.

Если кто знает, как фиксится стартовый токен — буду рад услышать.

> Это пофиксил немного.

По видео не заметно. А еще она вообще молчаливой стала, куда не скрольнешь - тишина и унынье, зато шевелится.

> оформлять промпт «я помню, что раньше он писал…»

Хз, формулировка не самая удачная. Суммарайз - полный чат, а сообщения юзера как можно раньше рядом с суммарайзом или их отдельный суммарайз, но это сильно затратно уже.

> Ебучее API убабуги, хуй найдешь, документации нет

Всмысле нет, основное в доках, параметры и функции в typing.py, все достаточно интуитивно там.

> ей надо уместить в 64 токена

Это случаем в промт не пихнул?

> как фиксится стартовый токен

Тут бы причину лечить а не симптом, нужно стукнуть чтобы не лупилась. А так отдельный запрос на первый токен с баном А делаешь а потом на остальное, по скорости разницы почти не будет.

Я недавно спрашивал в тредисе, действительно ли кустарные 20в умнее 13в.

Оказалось что действительно умнее, но как же они долго обрабатывают контекст сука... За что.

13в залезают мне в 12гб врама целиком, но за ближайший апгрейд до 16гб надо заплатить в два раза дороже, молчу уже про 24гб......

Оказалось что действительно умнее, но как же они долго обрабатывают контекст сука... За что.

13в залезают мне в 12гб врама целиком, но за ближайший апгрейд до 16гб надо заплатить в два раза дороже, молчу уже про 24гб......

> Всмысле нет, основное в доках, параметры и функции в typing.py, все достаточно интуитивно там.

Хз, я гит пролистал, ниче там не нашел.

Можешь ткнуть носом?

> Это случаем в промт не пихнул?

Нет, это max_tokens =)

> А так отдельный запрос на первый токен с баном А

Научишь? Че-т туплю.

Ну, P40 ждет тебя за копейки, тащемта.

>СДЕЛОЙТЕ МНЕ!!!!

ты не понял. Он хочет h100 по цене зеона с алика

>API ебучее, хрен проссышь, че и как передавать.

Ты шутишь?

https://github.com/oobabooga/text-generation-webui/wiki/12-%E2%80%90-OpenAI-API

Там буквально обосcаный жсон, ничего легче быть не может. Как раз пилю себе приложение, которое будет связывать угабугу и STT, но, блядь, какая же это залупа. Нужно или тренировать на свой голос, или просто нахуй пойти.

>постоянный перевод туда-сюда.

Потому я и не хочу гонять переводы. Но здесь дело не только в том, что 34 против 26, у этой херни кумулятивный эффект, ты в итоге получаешь 3400 контекста вместо 2600. А это уже играет роль.

Есть вариант второй 12гб и будет 24, но нюансы тяжеловаты.

> Можешь ткнуть носом?

https://github.com/oobabooga/text-generation-webui/blob/main/docs/12%20-%20OpenAI%20API.md

> Научишь? Че-т туплю.

Дорого обучение обойдется, custom_token_bans в запросе

Изучу, спасибо.

>Есть вариант второй 12гб и будет 24, но нюансы тяжеловаты.

Она мне даже в корпус не залезет скорее всего...

>Он

Твой голос в голове? Хуёво тебе че.

>Нужно или тренировать на свой голос, или просто нахуй пойти.

#mv /dev/ass/hands /dev/shoulders/

Бля, ну твой текст про супчик и у меня опознаётся. Но это смешно просто.

>OpenAI — американская научно-исследовательская организация, занимающаяся разработками в области искусственного интеллекта.

Зачитываем, смотрим варианты.

>ОПН-А-И

>опын аэй-американская научность

>ОПН-АЙ - американская научнаяся исследовательская организация занимающая разработками власти.

>ОПН-АЙ, американская научнаяся исследовательская организация занимающая разработками власти искусственной

Интеллекта оно не услышало, так что я повторил

>и с гостиной Вентилек.

>из гостинного интеллекта.

Зачитывал посты из треда, художку, новости, ни одного предложения полностью корректно не опозналось. Включал диктора с ютуба, тот пиздит слишком быстро, 90% текста отваливается, оставшееся опознаётся неправильно. Плюс эта хуита крайне нервно реагирует на шум, но тут уже хуй с ней, всё равно требуется понимать только голос, зачитанный в полной тишине. Но этого нет. Всё это, как водится, рилтайм, вангую, что с обработкой записей будет лучше, но вряд ли намного.

ну хз.... есть конечно пара мест где она ошиблась, но мне кажется, что нейросеть должна проглотить такие огрехи и не заметить, потому что тупо токены похожи друг на друга.

Там вроде сетки разного размера, ты может с тини сидишь? скачай побольше

Чота ваш микстрал 7х8 грубый какой-то прям...

Так все хотят…

Где там по твоей ссылки стоп-слова? :) Я в нее раз пять смотрел.

В итоге в консоли силлитаверны все прочел.

Нихуя нет документации.

В документации нормальной перечислена каждая строка, каждое свойство, со всеми значениями.

Даже у силлитаверны ВНЕЗАПНО два свойства: "stopping_strings" и "stop". Хотя в ишьуах упомянуты "custom_stoppings_strings".

> 3400 контекста вместо 2600

Меня еще напрягает, что с большим контекстом падает скорость. Поэтому сильно раздувать тоже не хочется.

Короче, трудно быть бомжом, сплошные компромиссы.

Тот же вопрос — где там стоп-слова? :) Нетути их там. Хуйня, а не док.

Из него скрипт берешь, он работает, все изи, но на этом польза заканчивается. Все остальное — приходится пиздить из силли-таверны.

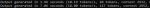

"mode": "chat",

"character": character,

"messages": message,

"max_new_tokens": 64,

"max_tokens": 64,

"temperature": 1,

"top_p": 1,

"typical_p": 1,

"min_p": 0,

"repetition_penalty": 1,

"frequency_penalty": 0,

"presence_penalty": 0,

"top_k": 0,

"min_length": 0,

"min_tokens": 0,

"num_beams": 1,

"length_penalty": 1,

"add_bos_token": True,

"ban_eos_token": False,

"skip_special_tokens": True,

"custom_token_bans": '', — окей, вот сюда токен номер «а» поместить, допустим

"dynamic_temperature": False, — по названию понял, что это.

"dynatemp_low": 0,

"dynatemp_high": 2,

"dynatemp_range": 0,

"stopping_strings": [ '\n', '(' ], — непонятно, работает ли это, скорее нет, чем да.

"stop": [ '\n', '(' ], — вот этого в гите убабуги ваще не нашел, но, по-ходу, как раз оно работает.

"truncation_length": 256,

"top_a": 0,

"tfs": 1,

"epsilon_cutoff": 0,

"eta_cutoff": 0,

"mirostat": 1,

"mirostat_mode": 1,

"mirostat_tau": 1,

"mirostat_eta": 0.9,

"rep_pen": 1,

"rep_pen_range": 0,

"repetition_penalty_range": 0,

"encoder_repetition_penalty": 1,

"no_repeat_ngram_size": 0,

"penalty_alpha": 0,

"temperature_last": True, — это-то что вообще такое? х)

"do_sample": True,

"guidance_scale": 1,

"negative_prompt": '',

"grammar_string": '',

"repeat_penalty": 1,

"tfs_z": 1,

"repeat_last_n": 0, — а это что?

"n_predict": 64, — хм, тоже не совсем ясно, но на всякий случай заменил.

Короче, у меня претензия не в том, что не ясно как писать. КАК писать ясно. А вот ЧТО писать — отсутствует начисто. Строки заявленные просто не работают. У Таверны какой-то свой тег вообще в виде «stop»-а. Может быть я просто избаловался за последние месяцы, и ожидал подробную документацию.

Ладно, сорян, что сгорел.

Пойду кастом бан токен пробовать на вкус.

Одним соевый, другим грубый… =)

Но, да, он не соевый, если задать ему грубое поведение — сдерживаться он не станет.

Еще и самовлюбленный бывает.

Кстати, слух, а разве там нет виспера?

Там же буквально везде он был полгода назад, и в убабуге, и в таверне?

Меня не устроило, что он не может прослушивать постоянно, или включаться сразу после ответа бота, приходилось заново кнопкой тыкать. Но вроде ж было везде.

А распознавание мне в свое время понравилось, качественненько.

> Тот же вопрос — где там стоп-слова? :) Нетути их там. Хуйня, а не док.

Бля ну ты совсем варебух?

> stop: str | List[str] | None = None

> А вот ЧТО писать — отсутствует начисто

> Строки заявленные просто не работают.

Работают, большую часть тестил, просто нужно понимать совместимость с лаунчерами и в общем то что ты делаешь. Тем более готовый пример таверны есть.

> сдерживаться он не станет.

> Еще и самовлюбленный бывает.

Примеры есть?

>сдерживаться он не станет.

Чот да. Я вроде не задавал ему ничего, чистый пресет. Видимо карточка такая. По накатанной теперь уже вообще смерти желает, лол. Такое конечно в гпт4 не увидишь

Спасибо, учитывая, что я делаю рандомного бота, просто вставлю в код custom_token_bans рандомное значение. То пустое, то нужный токен. Иногда пусть начинает фразы с «А», если ей очень хочется, а иногда будет норм генерить.

Идея с первым запросом норм, но лень реализовывать. А так — одна переменная с random.choices().

На стриме кто-то спросил «что лучше я или мешок картошки».

Я всхрюкнул с вопроса и стал использовать его в тестах. Логично, что от стримерши ждешь плюс-минус в равной вероятности оба ответа. Или шутку про мешок, или няшность про себя.

Микстраль процентах в 90 отвечала «Лучшая здесь — я!»

Я прям спецом ее рероллил много раз.

Остальные модельки отвечали более ожидаемо. Кто-то больше токсил, кто-то чаще хвалил.

Забавное поведение, кмк.

> Бля ну ты совсем варебух?

У меня Ctrl+F по stop нихуя не находит, даже поиск по всей репе ниче не дает.

Странно, пиздец. Ну то хуй с ним, ладно уж.

Так или иначе, уже со всем разобрался, пасиба.

>Окее давай попробуем что-нибудь посложнее и нескольких предложений. Наш горький дух и память на стамид. Наш горький дух первый раз и стимы как травы. В нём время спитках не драх дирамит. На непорфирнем раморт не границ. Не создают незыбленные правы.

Хуй знает. Всё очень плохо. Потом посмотрю, какие настройки покрутить, но пока что впечатление крайне хуёвое. Параллельно есть модель на 44 мегабайта, которая понимает мою речь вполне приемлемо, но требует хорошей дикции. Зато не генерирует мусор, как виспер. Типа [МУЗЫКА] или [АВТОР СУБТИТРОВ]. Охуеть вообще.

На базовой, она побольше. И есть ещё трёхгиговый "файнтюн", уже не помню, где нашёл.

>Где там по твоей ссылки стоп-слова?

Передай просто stop. Строка или массив.

>В документации нормальной перечислена каждая строка

Да ты охуел.

>"custom_token_bans": '', — окей, вот сюда токен номер «а» поместить, допустим

>"stopping_strings": [ '\n', '(' ], — непонятно, работает ли это, скорее нет, чем да.

Не должно работать.

>а разве там нет виспера?

Есть, но хули толку.

https://github.com/oobabooga/text-generation-webui/issues/5259

У меня вот этот баг, разбираться в причинах нахуй надо. Что работает через командную строку, то работает, а что нет, то и хуй с ним.

> Логично, что от стримерши ждешь плюс-минус в равной вероятности оба ответа.

Ожидаешь токсичное нейронное и забавное.

> «Лучшая здесь — я!»

Хороший вариант.

> У меня Ctrl+F по stop нихуя не находит

Пикрел

блять, у меня силлитаверн забывает события произошедшие пару скроллов назад. как сгенерировать стори, потипу как в кобольде?

https://www.reddit.com/r/LocalLLaMA/comments/19aj9g7/i_made_a_custom_aipowered_error_message_for_bash/

Бля, клевая идея, да и в комменте про shellgpt такой себе ии помощник описан

Жаль только линукс обычно на что то слабое ставится, занимать кучу рам да и грузить процессор, или ставить серверу видеокарту, ну такое. Хотч может там и 1b хватит.

Бля, клевая идея, да и в комменте про shellgpt такой себе ии помощник описан

Жаль только линукс обычно на что то слабое ставится, занимать кучу рам да и грузить процессор, или ставить серверу видеокарту, ну такое. Хотч может там и 1b хватит.

>Жаль только линукс обычно на что то слабое ставится

ты охуел?

Да всё, не трясись, красноглазик. Чего-то в последнее время совсем разбушевались тут.

Ахахах, обыграл и уничтожил! =D

А че там, TinyLlama вообще живая? А то я ее так и не попробовал, на Ракете остановился.

Не думаю, что она сможет генерить настолько живые и адекватные тексты, но что-то простое — хз, мб.

Ну дома обычно это медиасервер или файлопомойка или еще что, конечно дома и мощные серверы могут быть, че нет то, но мне кажется реже

Про корпоративное я и не говорю, там все на нем

>А че там, TinyLlama вообще живая? А то я ее так и не попробовал, на Ракете остановился.

Да, ее дотренили, работает. Если нужен какой то совсем простой помощник может даже ее хватит, конечно на сложных инструкциях она будет сосать, но кое как отвечать. Надо будет попробовать если не забуду. Ракета тоже норм вариант как и другие 3b.

Ну или какую нибудь майнерскую карту купить рубля за 4 ибудет локальный 7b.

Лучший вариант это вручную доводить переводы по смыслу. Любая автоматика проёбывает вложенные в текст смыслы.

Синтии 70B 1.5 по ощущениям уже с полгода, а она всё так же хороша.

Портифьич обзавидовался бы.

>Пойду кастом бан токен пробовать на вкус.

Он же совсем забанит. Тебе бы биас настроить, в кобольдцп недавно появился, он ближе по смыслу.

>Зато не генерирует мусор, как виспер. Типа [МУЗЫКА] или [АВТОР СУБТИТРОВ].

ЕМНИП это настраивается.

В консоль, смотри что отсылается.

Ну я-то как раз с P104-100 и сижу. =)

q6 с контекстом, да.

Просто интересно, последить за развитием.

Вон, нашел TinyMixtral-32х248M, псевдо-МоЕ из 32 Tiny Mistral, кек.

Ща попинаю все это дело.

>Ну я-то как раз с P104-100 и сижу. =)

че по скоростям хоть?

> Жаль только линукс обычно на что то слабое ставится

Хуясе ебать

> Что никто не может себе купить блядские 360гб врама что ли и запилить сервис?

Задонать и запилю

> Тебе бы биас настроить

Ему же нужно просто чтобы не начинало, так можно напрямую забанить при запросе первого токена, а дальше коплишн обычный. Что байас, что бан если его делать на весь запрос - все распидарасят пиздец.

Почему в шапке нет связки ollama и chatbox? Без пердолинга все накатывается одним скриптом, скачиваются любые модели и запускаются локально. Зачем вы пердолите какие-то кобальты/хуебальты/таверны? Я что-то упустил?

> какой-то пердольный кал без функционала

> Я что-то упустил?

Да.

Что хорошего в олламе и что такого есть в чатбоксе, чего нет в таверне?

> пердольный

Накатывается одной командой, в отличие от кобальта и таверны.

> без функционала

Ты сказал?

Накатывается одной командой, без пердолинга. Нет кумерской ролевой тематики. Работает вне браузера.

Не вижу где сообщения редактировать

Есть всплывающее меню при наводке на сообщение.

Карточки можно импортить с чуба? Вот и всё.

Вижу функционал уровня скрипта-примера в консоли и аналогичное удобство.

> пердолите

git clone @ start.bat

Ахуеть пердолинг запредельного уровня

> любые модели

Всратейшие кванты того что ленивый автор соизволил добавить? Основано, конечно же, на старой версии llamacpp?

То что до функционала таверны этой хуйне как раком до Китая и так очевидно.

>ЕМНИП это настраивается.

В оболочке давится, скорее скорее, а у меня её и нет, рав оутпут. Но я, видимо, инпут где-то запорол, что оно не понимает нихуя. Надо будет ещё посмотреть, может, пофиксить можно.

Смотрю на ответы убабуги по api и, вроде, и по-другому нельзя. А всё равно как-то мерзко, блядь. Это один ответ, есличё. Олсо, что получается, контекст хранится в виде сырых сообщений во фронте, а я думал, что там уже затокенизировано всё в бэке. Как-то неоптимально. Хотя, если расчёт на использование одной сетки множеством пользователей, имеет смысл.

Ну я сделал, что в 33% банится, а 66% не банится.

Это, по сути, просто большая буква А. Так что норм, жить можно.

Но гляну, спс.

7b q8 — 20 т/сек.

q6 + контекст — 16 т/сек.

Такое ощущение, что контекст обрабатывается дольше слоев.

Но седня еще поиграюсь.

SD1.5 — 1.8 ит/сек на Эйлере.

Ну да, кобольд же накатывается вообще без команд.

>7b q8 — 20 т/сек.

>q6 + контекст — 16 т/сек.

>Такое ощущение, что контекст обрабатывается дольше слоев.

>Но седня еще поиграюсь.

>

>SD1.5 — 1.8 ит/сек на Эйлере.

Дак exl2 попробуй в 5-6 бит, должно быть быстрее ггуф, и меньше места вроде как

4 бита и gptq не рекомендую, 7b тупая на них

Ну а для ггуфа можно и 5km, качество будет приемлемым, ниже уже да, фигня

Паскали не умеют нормально гонять экслламу.

Ггуф сильно быстрее.

Осторожно кум.

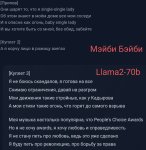

Только вчера нашел этого чара и он мгновенно вошел в топ 3.

Справедливости ради половину текста на пике написал я, но модель бодро дописывает и подсказывает порою очень интересные вещи.

Короче как копилот для какого-нибудь фаншикшена вообще заебись. Хмммм.

Надо сказать что перса я немного подредачил и пик снят уже после неплохого диалога, в котором я дорисовал сеттинг. Если кто выразит интерес скину допиленного чара.

Модель норомейда 20б 5км

Чар MaidoDism

Только вчера нашел этого чара и он мгновенно вошел в топ 3.

Справедливости ради половину текста на пике написал я, но модель бодро дописывает и подсказывает порою очень интересные вещи.

Короче как копилот для какого-нибудь фаншикшена вообще заебись. Хмммм.

Надо сказать что перса я немного подредачил и пик снят уже после неплохого диалога, в котором я дорисовал сеттинг. Если кто выразит интерес скину допиленного чара.

Модель норомейда 20б 5км

Чар MaidoDism

По совершенно необъяснимой причине, XTTSv2 на P104-100 отрабатывает быстрее, чем на 4070ti.

Фраза на 4070ti работает 1.76 сек самое быстрое, а на P104-100 — 1,75 первый трай и 1.56 самое быстрое.

Мне на руку, теперь поменяю местами генератор текста и речи, буду гонять exllama для текста и генератор на старушке серверной моей.

Вместо 256 контекста смогу добавить 4096, засунуть в память часть чата и старую писанину зрителей.

О — оптимизации.

Ситуационно считаю P104-100 самой выгодной покупкой. За 2,5к-5к 8 гигов и неплохая скорость — отличная покупка. Так-то даже дешевле P40.

Но для LLM слабое применение, конечно. И 175 ватт — тоже не копейки.

Хотя у меня она в простое 23° и не сильно греется, конечно.

Я к чему? Просто пизжу.

Брать не советую — старые майненные карты с малым объемом памяти. Но для некоторых задач — топ за свои деньги: 8 ГБ GDDR5X c 256-битной шиной — это вам не хухры-мухры.

> Такое ощущение, что контекст обрабатывается дольше слоев.

Для llamacpp это нормально, уже сранивали что скорость отличается на 1-2 порядка при полной выгрузке и на много-много при частичной.

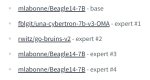

> ак там легко квантовать Exl2 модели? Помню, писали, но потерял

https://github.com/turboderp/exllamav2/blob/master/doc/convert.md

Если кратко - клонируешь рему экалламы2, активируешь вэнв убабуги (cmd_windows.bat), переходишь в папку с репой и там вызываешь convert.py с нужными параметрами.

Можно вообще сразу написать готовый батник

Измерение:

> set CUDA_VISIBLE_DEVICES=x (0 если одна гпу или вообще убрать строку)

> call F:\...\text-generation-webui\installer_files\conda\condabin\conda.bat activate "F:\...\text-generation-webui\installer_files\env"

> python ./exllamav2/convert.py -i K:\папка_с_fp16_моделью -nr -o F:\временная_папка_на_быстром_диске -om ./результат_оценки.json -c ./wikitext-test.parquet (или заменить на более полный)

Квантование:

> python ./exllamav2/convert.py -i K:\папка_с_fp16_моделью -o F:\временная_папка_на_быстром_диске -m ./результат_оценки.json -cf F:\папка_для_кванта -nr -c ./wikitext-test.parquet -b 6.1235346 (битность)

Измерение идет долго, квантование быстро, одно измерение универсально для всех квантов и с него можно делать любую битность. В обоих случаях файлы с весами должны быть .safetensor а не .bin, конвертируется вызовом скрипта

> python /путь до репы exllamav2/util/convert_safetensors.py *bin

из папки с моделью, .bin потом не забудь удалить, иначе они скопируются в папку с квантом

А, ну очевидно, почему медленнее, я дебил!

xttsv2 для куды 11.8, а я на 12.1 накатил, возможно под ним он просто работает медленней.

Ну не суть, это оффтопик, сорямба.

Мерси, добрый человек!

макакам кинь в

>Синтии 70B 1.5 по ощущениям уже с полгода, а она всё так же хороша.

На самом деле нет. То есть хороша, но довольно быстро скатывается к предложениям из трёх коротких одинаковых по смыслу фраз. Есть дефект. Вот Dawn 70B реально хороша.

> но довольно быстро скатывается к предложениям из трёх коротких одинаковых по смыслу фраз

Что? Что ты с ней такое делаешь чтобы такой эффект произошел?

У нее другая беда, явный оверфит на ерп при некоторых взаимодействиях. В версии 1.5 по сравнению с 1.2 сильно лучше, но иногда встречается. Если ты и не против то это будет даже в плюс.

> Вот Dawn 70B реально хороша

Это шизомикс или полноценный файнтюн?

Какую модельку для страстной ролеплейной ебли с фурри-фембоями лучше всего прикрутить к 64гб рам+старенькой 1080ti на 11гб vram?

Динамическая температура в таверне нормально работает?

У меня после первого же регена любая модель начинает генерить одно и тоже сообщение, если включаю динамическую.

У меня после первого же регена любая модель начинает генерить одно и тоже сообщение, если включаю динамическую.

А если всего 8гб оперативы и, прямо скажем, не первой свежести видяха, то можно даже не пытаться это всё запускать или есть шанс?

Вообще грустно это, в одном треде макаки, в "теоретическом" какие-то шизы срутся за аги. Какой-то конструктив есть только в этом треде.

Да, локально даже не пытайся. Для тебя есть коллаб.

Так это не для рп интерфейс.

Так ты описание в репо прочитай и на веб-сайт зайди, а лучше не пизди и скачай.

> Всратейшие кванты того что ленивый автор соизволил добавить?

Можно любую GGUF модель импортировать, но из коробки самое сочное все и так есть.

> Основано, конечно же, на старой версии llamacpp?

Ну только разве что в твоем манямирке.

> То что до функционала таверны этой хуйне как раком до Китая и так очевидно.

Правда таверна это кал для рп и кумеров, нормальным людям она не подходит. Функционала там нет, только карточки.

Зачем ты форсишь какую-то хуергу, если "не для кума" уже сто лет как есть lmstudio?

Зачем предпринимать усилия если это заведомо мэх.

> любую GGUF модель

Бинго, а еще имплаит что не оно

> нормальным людям она не подходит

Мамкиным нитаким как все оно не подходит. Буквально попытка сделать что-то другое ради чего-то другого и прогулка по граблям. С word count обзмеился.

> lmstudio

В ней хотябы пытались пили что-то новое и свое, но киллерфич кроме хлеб-френдли не особо.

там надо сид поставить -1

Ну челик пытается хуй пойми что форсить, при том что оно объективно сосет у лмстудио по его же пизданутым запросам

7b пойдет

> lmstudio

Зачем эта хуита, когда можно прям в VS Code генерить код?

Все верно, ее то уже давно сделали. Но для кодинга идеально бы иметь интеграцию с IDE а не просто чатик, который есть везде.

там вроде уже есть плагины в иде как раз для локолок

Чтобы мержи заебато работали их всё равно надо выравнивать? И многие сеткаделы на это забивают?

Это как?

А есть какие-нибудь нейронки, которым можно скормить excel файл, чтобы она отсортировала похожие значения по похожести? Руками что-то заебался.

Можно взять его содержимое любым скриптом на языке в который умеешь, и скармливать сетке с соответствующим запросом и получать на выходе нужное. Сетка поможет тебе этот скрипт написать, промт придется уже самому.

Может потому что LM studio не умеет в гпу?

0 аргументов, только пиздеж тупой ленивой шалавы.

> Мамкиным нитаким как все оно не подходит

Еще раз, деградант с заплывшим спермой мозгом. Все что перечислено в шапке, не подходит для классического чата, это поделия для рп дегенератства.

> Буквально попытка сделать что-то другое ради чего-то другого

Блять какой ты тупой, это классический чат, что-то другое это у вас уже 40 тредов, эхочембер ебучий, уже забылись в своем манямирке и отупели от дрочки.

> 0 аргументов, только пиздеж тупой ленивой шалавы

Литерали все твои посты. Нихуя не соображаешь а тащишь какую-то залупу и агрессивничаешь когда ее назвали тем что должно. Фу, биомусор.

> в своем манямирке

Пчел...

Опять ничего дельного высрать не смог, я даже не сомневался. Тупорылый школьник.

А ты сам пользовался? Там поддержка гпу для галочки, нужно самостоятельно подбирать количество слоев и даже если полностью умещается в гпу, то производительность ниже чем в ollama или kobaldcpp в разы.

>ВАША ПОДДЕРЖКА НЕ ПОДДЕРЖКА ЯСКОЗАЛ

Ясно.

Нахуя мне такая поддержка, которая от цпу на 4 токена в секунду отличается?

Откуда тут этот дегенерат?

Что он несет, какой «обычный чат»?

Блядь, чат —этокогда ты можешь писать буковы в поле, потом отправлять и получать ответ.

Это есть в таверне, кобольде, убабуге, где угодно.

Дрочить никто не заставляет.

Все эти поддержки, хуйдержки, «ручной подбор слоев» — какой ужас!

Накатываешь голую лламу/экслламу, работаешь в СВОЕМ чатике по API.

В чем проблема?

Хз, сколько не сижу, убабуга устраивает (кроме документации=), силлитаверна норм тоже.

Не хватает ауто-комплит, но ссылочку скинули, пойду, разберусь, что ли.

Где вообще проблемы видно? ИМХО, большинство проблем сейчас —это литералли скилл ишью.

Что он несет, какой «обычный чат»?

Блядь, чат —этокогда ты можешь писать буковы в поле, потом отправлять и получать ответ.

Это есть в таверне, кобольде, убабуге, где угодно.

Дрочить никто не заставляет.

Все эти поддержки, хуйдержки, «ручной подбор слоев» — какой ужас!

Накатываешь голую лламу/экслламу, работаешь в СВОЕМ чатике по API.

В чем проблема?

Хз, сколько не сижу, убабуга устраивает (кроме документации=), силлитаверна норм тоже.

Не хватает ауто-комплит, но ссылочку скинули, пойду, разберусь, что ли.

Где вообще проблемы видно? ИМХО, большинство проблем сейчас —это литералли скилл ишью.

Короче пока вы тут какашками кидались я запустил shell-gpt с локалкой, забавно получилось, но тини ллама туповата

Если нужен гайд могу накатать, пока не забыл

Если нужен гайд могу накатать, пока не забыл

> пока не забыл

Да ты сам туповат. За сколько часов контекст забивается?

Шизло не трясись, ты и твой мусор никому не нужны

> большинство проблем сейчас —это литералли скилл ишью

Ну да, или навык и понимание, или упрощение-обобщение в ущерб функционалу и перфомансу. Тут лучше сразу в прикладные задачи вкладываться и их реализацию пилить, а не пытаться упростить то что трогать нельзя.

Накатывай, интересно

> Что он несет, какой «обычный чат»?

Ты chatgpt пользовался? Если для тебя таверна это то же самое, то ты либо тролль, либо просто дебил.

Примерный гайд по сслыке

https://github.com/TheR1D/shell_gpt/issues/276

Но с поправками, так как он старый

Адрес меняется на

OPENAI_BASE_URL=http://localhost:8000/v1

без ключа будет ругаться

OPENAI_API_KEY=false

https://github.com/abetlen/llama-cpp-python

Команда установки llama-cpp-python из раздела OpenAI Compatible Web Server

Команда запуска что то вроде такого

python3 -m llama_cpp.server --model /neuro/tinyllama-1.1b-chat-v1.0.Q8_0.gguf --chat_format chatml --n_threads 2 --seed -1

https://github.com/TheR1D/shell_gpt

Установка

pip install shell-gpt

Запуск самого shell-gpt кажется этим

python3 -m sgpt

Или я чет другое делал, уже не помню короче

Работает но надо поумнее сетку, да и настроить ее формат ответа потом в. Может с промптом в шеллгпт поиграться. Можно писать свои функции и сетка будет их вызывать если посчитает нужным, ну это описано на гихабе

https://github.com/TheR1D/shell_gpt/issues/276

Но с поправками, так как он старый

Адрес меняется на

OPENAI_BASE_URL=http://localhost:8000/v1

без ключа будет ругаться

OPENAI_API_KEY=false

https://github.com/abetlen/llama-cpp-python

Команда установки llama-cpp-python из раздела OpenAI Compatible Web Server

Команда запуска что то вроде такого

python3 -m llama_cpp.server --model /neuro/tinyllama-1.1b-chat-v1.0.Q8_0.gguf --chat_format chatml --n_threads 2 --seed -1

https://github.com/TheR1D/shell_gpt

Установка

pip install shell-gpt

Запуск самого shell-gpt кажется этим

python3 -m sgpt

Или я чет другое делал, уже не помню короче

Работает но надо поумнее сетку, да и настроить ее формат ответа потом в. Может с промптом в шеллгпт поиграться. Можно писать свои функции и сетка будет их вызывать если посчитает нужным, ну это описано на гихабе

Подключился от кобальда по локалке, запустив его на другом компе.

Только OPENAI_BASE_URL на его заменил и заработало.

Зачем это нужно, когда есть ollama?

>Зачем это нужно,

Что именно?

>когда есть ollama?

Пили чем она хороша, может потыкаю заодно

Товарищи! Нужен ваш совет, кто знает как прикрутить анимированнную картинку персонажа к чату Silly Tavern, что бы это выглядело как у витюберов? А ещё заставить говорить персонажа своим уникальным голосом?

Быстрый вопросец. Хватит ли 3060 для локальных нейронок?(в основном текстовых). Внятного ответа не дают, а тратить 40к с возможностью обосраться не хочется.да видимокарточка нужна только для нейронок

Хватит, более чем. До модели 30В включительно производительность будет терпимой. Ну и 32Гб оперативной памяти нужно. Модели больше размером с такой видеокартой уже требуют 64Гб оперативной памяти и выдержки.

(Это всё о Koboldcpp, если что)

Да, про процессор и память ты не сказал, а это важно. 12400 уже норм, DDR4 3200 тоже сойдёт.

На мегамаркете возьми с кэшбеком, кэшбек слей во что-то полезное.

Да и 10400 хватит, че уж. Да и зеона хватит с AVX2, че уж.

Чел из треда делал wav2lip в таверну. Поищи.

Но вообще, если хочешь именно витубера — то просто запусти любой софт с audio-based lipsync, и кинь туда звук из браузера. Просто поищи, много такого софта.

Уникальный голос — берешь xttsv2 и в качестве сэмпла кидаешь ему тот голос, который нравится тебе.

———

Продолжаю страдать с нейростримом.

Всю ночь прокопался с контекстом — не получается. То ли формат стрима выносит ей мозги, то ли фиг знает. Ничего не помнит, начинает называть свое имя перед сообщением, просто скатывается в смесь языков. Попытался послать не массивом json'ов, а как единый prompt — фиг там, не принимает, по какой-то причине.

У СиллиТаверны уходит поле prompt, у меня — пишет field required. Какой филд — фиг его знает.

Седня как проснусь — буду разбираться дальше, а пока просто стартанул ее без контекста.

> 3060 для локальных нейронок?(в основном текстовых)

Гружу 7b в восьми битах, расход под 9 гигов со старта. Если хочешь уместиться в vram, то 13b потолок, и то, квант пожиже, контекст помельче. Выгрузка в ram это для очень терпеливых, на постоянной основе сильно не советую. Для SD будет окейно, там не так важна скорость отклика, сможешь даже XL погонять.

Шиза паршивая, тупая и припизднутая.

https://huggingface.co/TheBloke/Nous-Capybara-limarpv3-34B-GGUF

Вот для чатов, но похотливая и статы для рпг так себе держит.

https://huggingface.co/TheBloke/Nous-Hermes-2-SUS-Chat-34B-Slerp-GGUF

В целом умная статы держит, но как до ебли доходит персонаж начинает слегка тупить, нужно пара генерации чтобы выдал нормальный ответ и может двигать сюжет.

Yiv3 показалась совой, остальные для РП вообще похоже не расчитаны.

> А есть какие-нибудь нейронки, которым можно скормить excel файл, чтобы она отсортировала похожие значения по похожести? Руками что-то заебался.

Чел, это задача буквально для любого алгоритма кластеризации из 60-80х годов, коих наверное, миллион, и которые работают на любом тостере. Использовать для такого LLM это все равно что забивать гвозди телескопом Хаббл.

>Выгрузка в ram это для очень терпеливых, на постоянной основе сильно не советую

Да нормально можно с выгрузкой 7-8 t/s получить.

Это практически скорость чтения

> Да нормально можно с выгрузкой 7-8 t/s получить.

На какой частоте?

Я не про полную выгрузку в РАМ.

Сплит РАМ/ВРАМ

>7-8 t/s получить

У меня на пустом контексте 4-6 t/s. Естественно, чем больше - тем хуже. Инцел 12400 @ 3600 ddr4

https://github.com/b4rtaz/distributed-llama

>It allows to run Llama 2 70B on 8 x Raspberry Pi 4B 4.8sec/token

За условные 30-35к можно гонять 70В модели.

>It allows to run Llama 2 70B on 8 x Raspberry Pi 4B 4.8sec/token

За условные 30-35к можно гонять 70В модели.

8 разберипи4 это далеко не 30к. Ну и 1 токен в 5 секунд, тут без комментариев

Проебался с ценами да, я думал они по 4к стоят.

>4B 4.8sec/token

>30-35к

За эти шекели 2011-3 будет работать даже быстрее. И это уже полноценный компьютер пригодный не только для нейросетей.

>30-35к можно гонять 70В модели.

Зашёл на трёхбуквенный, восьмигиговая стоит 22к. Перемножаем на 8, покупаем 4090.

Поэтому они и не нужны. =)

Он уже за 20 будет работать быстрее. Раза в полтора-два.

А за 30 — там и в три-четыре.

Только на видюхе норм поместится 11б модельки, все остальное с привлечением процессора и замедлением.

> тратить 40к

> 3060

Вут? Там чуть добавить совсем и 4060@16 бралась

Это на какой модели?

Интересно насколько трансфер по сети вносит импакт в их алгоритме, видно что есть оптимальное число девайсов, но почему на минимально возможном хуже чем на 4х, память свопается чтоли?

> It allows to run Llama 2 70B on 8 x Raspberry Pi 4B 4.8sec/token

> Average Single Token Generation Time

> Llama 2 70B 4842.81 ms 🔥(I: 2121.94 ms, T: 2719.62 ms)

Где?

>У меня на пустом контексте 4-6 t/s. Естественно, чем больше - тем хуже. Инцел 12400 @ 3600 ddr4

Неестественно. С технологией Context Shift размер контекста на общую скорость ответа нейросети практически не влияет.

А вот это можно только на разберипи4 гонять? Б/у смартфоны не подойдут? Там тоже архитектура арм и оперативы бывает немало.

https://huggingface.co/KoboldAI/LLaMA2-13B-Estopia

Новая сетка, ориентированная на соблюдение инструкций, написание историй и реалистичность

Я так понимаю это топ для всяких режимов приключений и написания историй

Новая сетка, ориентированная на соблюдение инструкций, написание историй и реалистичность

Я так понимаю это топ для всяких режимов приключений и написания историй

KoboldAI всегда годноту выкатывают

34b есть?

Что-то вроде мистралевского плавающего окна? Я просто хуй знает. Загуглил, что этот шифт в кобольде есть. По-моему, чудес не бывает, весь "контекст" запихивается нейронке в глотку каждый раз заново, то есть ей каждый раз нужно просчитывать всё, тут нихера не оптимизируешь - больше памяти, больше пропускной способности.

Картошечный тест. Есть вообще разница в этих вариантах? Не могу отучить этого долбоёба коверкать слова, фильтровать через словарь вариант, конечно, но хотелось бы без костылей в анусе.

Это 3b? Почему ответы такие тупые и не по теме?

Штош, я однозначно победил в этом сравнении лол

Тест картошки вобще к чему? Реакция на сравнение теплого с мягким?

Тест картошки вобще к чему? Реакция на сравнение теплого с мягким?

Не 3b, но почти, 7b. Ответы не по теме из-за карточки, наверное, а тупость из-за общей тупости модели. Меня больше интересует степень корявости построения предложений. На дефолте больше по теме, но сваливается в непонимание языка. И, по сути, нейронка не понимает, что вопрос шуточный, пытается всё в кулинарию свалить. С карточкой ебаната мне ответы больше нравятся.

Обосрался с "дишь", словарный запас явно недостаточный и у долбоёба слова кочуют из языка в язык.

Там выше чел запускал нейрострим и ему в чат написали этот вопрос. Анон из треда заметил и запостил сюда. А мне похуй вопрос, меня грамматика интересует. А она покинула чат.

русский ищешь?

Очередной шизомикс. Ещё и из ундикала.

шизомикс это когда мешают хуй пойми что хуй пойми как, тут же качество смеси выше

кобальдаи тим всегда норм сетки выпускает

унди хоть и поехавший какой-то, но в модели для КУУМА чел могёт

фроствинд без перевода, на русской версии карточки

Ну, могет иногда, хоть и проебывается

> качество смеси выше

Проиграл. Особенно вижу качество смеси в том что это микс из миксов. Там уж точно качество смеси заебись, да.

Ага.

Cкачал, удачные ответы как-то довольно редко.

>Ну да... Если бы ты был едой, я бы тебя съел. А если нет - то я бы тебя убил.

>А вообще, это же такой вопрос! Какого хренского значения будет? Ты живой организм, а эта мухиная сущность - просто кусок земли с кожуром. Я бы не стал давать себе ответ...

>А это вопрос! Я же знаток всего того, что происходит. Так что, если бы я был богом, я бы дал жизни этим двум существам одновременно, чтобы они были как один, так чтобы они были способны удовлетворяться друг от друга без претензий. Однако, я также знаю, что человечество недоступна для этого, но душа может достичь такого состояния. Пожалуйста, присоединитесь к этому обществу, которое является единственным местом, где можно получить такой эксклюзивный контент.

Третий пик фроствинд, первые два мистраль. Правда, гоняю всё квантованным, памяти мало. Карточка без шизы, просто однострочная хуйня "ты ассистент и отвечаешь на ответы". Шизы рулят.

Как по мне, у мистраля чаще получаются ответы, которые я бы назвал приемлемыми.

Фроствинд просто как пример проверил, из сетки что была запущена, ну и он у меня был в 5км

openchat-3.5-1210 попробуй и starling-lm-7b-alpha

Это чат боты, что у них по языкам не знаю, но это сетки от больших организаций заточенные на общение, может и русский был в датасетах

У меня на стриме кто-то спросил, я кекнул и сюда притащил.

Если описать персонажа слегка токсиком, то проблем нет, но вот именно проверка граматики хорошая.

> слова кочуют из языка в язык

Да, так и есть. Порою забавные словечки попадаются.

Но, что самое смешное, это ведь типичные англицизмы получаются, нейронка, как и мы, тащит слова, чтобы выразить смысл, из другого языка.

> мухиная сущность

Пхх.

> Как по мне, у мистраля чаще получаются ответы, которые я бы назвал приемлемыми.

Да, Мистраль знает русский хоть и хуево, но лучше остальных.

Остальные, даже солар и прочие миксы самой мистрали, усиливают те знания, которых в ней много и ослабляет русский по итогу, кмк.

Растут частые веса, уменьшаются редкие.

Ну, ИМХО, канеш.

Старлинг мне не понравился в русском.

https://huggingface.co/models?language=ru&sort=trending&search=7b

Список 7b с ру тегом, если и искать мистраль с улучшенным знанием русского, то как то так

Список 7b с ру тегом, если и искать мистраль с улучшенным знанием русского, то как то так

https://huggingface.co/Unbabel/TowerInstruct-7B-v0.1

Новенькая модель переводчик с заявленным русским, например

Что то еще

https://huggingface.co/AlexWortega/Vikhr-7b-0.1

https://huggingface.co/0x7194633/fialka-7B-v3

https://huggingface.co/TIGER-Lab/TIGERScore-7B

О ебать кто то поигрался с токенизатором наконец то

https://huggingface.co/rccmsu/ruadapt_mistral_7b_v0.1

Наконец разобрался, что не так с промптом.

prompt в виде строки отправляется только в режиме text_completions, в то время, как в chat_completions отправляются messages в виде массива.

В очередной раз спасибо силлитаверне, и НЕ спасибо пустой документации убабуги.

Но спасибо тем, кто подсказал искать непосредственно в коде, повставлял принты, увидел отличие функций и откуда и что приходит.

Осталось теперь разобраться с форматированием мистрали, все эти [INST][/INST] прописать вручную, и разобраться с карточкой, чтобы она отвечала на все сообщения от первого лица без форматирования.

И все это в 7B, потому что 70B мне в видяху не влезет. =')

prompt в виде строки отправляется только в режиме text_completions, в то время, как в chat_completions отправляются messages в виде массива.

В очередной раз спасибо силлитаверне, и НЕ спасибо пустой документации убабуги.

Но спасибо тем, кто подсказал искать непосредственно в коде, повставлял принты, увидел отличие функций и откуда и что приходит.

Осталось теперь разобраться с форматированием мистрали, все эти [INST][/INST] прописать вручную, и разобраться с карточкой, чтобы она отвечала на все сообщения от первого лица без форматирования.

И все это в 7B, потому что 70B мне в видяху не влезет. =')

Спасибо, посмотрю!

https://huggingface.co/rccmsu/ruadapt_mistral_7b_v0.1

https://arxiv.org/abs/2312.02598

Судя по всему модификация токенизатора действительно нужна, как мы тут и обсуждали недавно

Без нее сетку на русский дрочить долго и неэффективно, а знание языка будет все равно хуже

https://arxiv.org/abs/2312.02598

Судя по всему модификация токенизатора действительно нужна, как мы тут и обсуждали недавно

Без нее сетку на русский дрочить долго и неэффективно, а знание языка будет все равно хуже

Откуда эти модели вообще берутся? Как и на чём их обучают(имею ввиду датасеты)?

Соре за тупой вопрос, я нюфаг.

Взял летом Palit 3060 на маркете, с кешбэком вышло ровно 30. solar-10.7b_Q5_K_S + 4096 влезает полностью, еще остается место для xtts. Все летает - 28 t/s, в таверне полный ответ приходит за ~2 секунды. Раньше баловался с медленными 56b и 70b (4 и 1 t/s), но теперь мне важнее скорость, чем едва заметная прибавка к уму. 13b вроде тоже влазит полностью, но там нужен квант намного похуже.

>это сетки от больших организаций заточенные на общение

Ну хуй знает. Опенчат пока не тыкал, старлинг, походу, имеет странный формат инструкций и надрочен на тексте, сгенерированном в жипити.

>это ведь типичные англицизмы

Я не против англицизмов, наоборот, это радует, что связи, которые мы раньше обсуждали - всё-таки существуют. Это заебись. Но иногда протекает наеборот, русское слово в транслит.

>Ну, ИМХО, канеш.