https://2ch-ai.gitgud.site/wiki/tech/sdxl/#требования-по-vram-для-тренировки-sdxl

Вынес сюда инфу по требованиям для тренировки SDXL. Ещё бы инфу о версии указать, на которой это всё тестировалось.

> Если расскажешь как можно объединить врам двух десктопных карт для использования в скриптах кохи (не в голом диффузерсе) - буду очень благодарен.

Не подскажу, увы. Я только одну карту всегда использовал. Просто думал, что есть какие-то готовые механизмы, чтобы разбить веса для тренировки на нескольких GPU.

> Ещё бы инфу о версии указать, на которой это всё тестировалось

сд скриптс 0.8.3

Аноны, как вы храните Лоры? Как это удобно сделать и чтобы можно было хранить ключевые слова и желательно превью?

>хреновое содержимое, однообразие в чем-то помимо

Может я неправильно понимаю пережарку, но лишние объекты в кадре и качество пикч не должны на это влиять. Объект будет лезть в вывод, и чар будет не совсем тот. По мне, пережарка - это когда результаты начинают откровенно хереть в сторону странной геометрии в целом и в деталях, и цвета часто по пизде идут. По крайней мере так было, когда я намеренно пережаривал на адаме. Давайте может определимся чо это такое, иначе непонятно нихрена.

>Так что похуй

Принял, спасибо!

>Нюанс с батчсайзом

Кстати есть странный опыт с этим. С батч сайз 1 лора почему-то выходила вообще не такая, как с 2 или 3. И не то что бы прям плохая, просто другая какая-то. Хз с чем связано.

>persistent_data_loader_workers

Вот блин

>учишь на клозапах

У меня пикчи обычно такие, что на неклозапах сам нихуя не разглядишь. Ну и качество лор поднялось с тех пор как я лица кропать стал. Но идею твою понял, да.

>А лр крутить то пробовал?

У меня сам крутится, я на адафакторе залип пока.

Создаю описания автоматика рядом с ними (в рамках скрипта тренинга), вот пример: Haeryung-v3-sd-15.json

{

"description": "Haeryung-v3-sd-15",

"sd version": "SD1",

"activation text": "haeryung,",

"notes": ""

}

Потом и json, и safetensors просто кидаешь в автоматик и все. Превью делаю руками в автоматике, потому что превью из процесса тренинга все равно хрень полная.

-

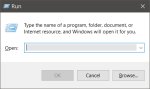

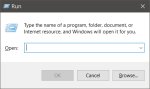

Если хочешь, чтобы лоры попадали в автоматик без копирования, то для винды есть mklink https://learn.microsoft.com/ru-ru/windows-server/administration/windows-commands/mklink возможно придется включить developer mode в settings

Создаешь папку "webui\models\LoRA\My", запускаешь в ней cmd, пишешь

mklink /j my-lora-42 d:\path\to\my\loras\my-lora-42\model

> но лишние объекты в кадре и качество пикч не должны на это влиять

Если у тебя на каждой пикче будут, например, спичбаблы, какие-то характерные артефакты, элементы - они начнут проявляться при вызове, потому что при обучении веса будут смещены для получения не только основного концепта, но и паразитной херни. Такое может быть вообще со всем, в том числе если у тебя вместо относительно разнообразных пикч сплошные клозапы, сгенерить что-то кроме них может потом оказаться проблемой и может полезть то о чем написал. Правильный капшнинг помогает, но не спасает на 100%.

> это когда результаты начинают откровенно хереть в сторону странной геометрии в целом и в деталях

> пикчи обычно такие, что на неклозапах сам нихуя не разглядишь

Насколько не разглядишь и насколько клозапы? Условный аппер бади - еще ок, а исключительно портрет или только лицо в кадре - неоче, если не генерить только их. Разбавление должно спасти, наверно.

Случаем не в 512 тренишь?

Расширение civitai-helper, если лоры качать через него, то он автоматически тянет превью и json с нужными данными с сайта. Потом в галерее на картинке с лорой будет появится кнопка, которая автоматичеки подставляет ключевые слова в промпт. Очень удобно.

https://github.com/butaixianran/Stable-Diffusion-Webui-Civitai-Helper

Спасибо

Найс. А можно как-то сохранить это отдельно от папки автоматика, чтобы не снести случайно?

Ты можешь хранить папку с моделями отдельно от папки с автоматиком (это расширение помещает файлы .info (json с метданными) и .png превью рядом с моделью).

Чтобы автоматик видел отедельно лежащую папку нужно сделать символьную ссылку:

mklink /D "путь к автоматику\models" "путь к папке с моделями"

Когда я с клозап-лорой генерю клозапы, у меня наоборот схожесть подуходит. А когда генерю медиум шот+, то норм (с адетайлером ессно). Попробую разбавить как-нибудь, посмотрю что изменится. Сейчас у меня голова и плечи в основном, но и проблем я не вижу, честно говоря. Есть легкое убеждение, что сд похер на зумы в пикчах, если объяснить ему, что на них.

>Случаем не в 512 тренишь?

--resolution=768,768

Спасибо, добавил инфу.

Две похожие лоры от одного автора с одинаковым весом. Как это сделать? Надеюсь это не то что я думаю. Т.е. сначала меоджить лоры с чекпойнтами, а потом делать лора экстракшон

Размер файла зависит только от параметра network dim и типа лоры.

Если ты хочешь смержить две лоры, то у кохи есть скрипт для этого.

> Т.е. сначала меоджить лоры с чекпойнтами, а потом делать лора экстракшон

Получится полнейшая хуйня на выходе.

Мужики, сидел ебался 2 часа (больше) пытаясь понять как включить режим fp 8 для нормальной генерации на SD XL (а то 8 гигабут не хватает)

В итоге сделал по видосу где нужно было сделать хард-ресет с указанием хэша версии 1.5.2. Не запустилось. Я даже дефендер отключал, драйвера переустанавливал, всякую хуйню гитпулил и ничего.

Потом я удалил venv и тоже не запустилось, в итоге я попытался восстановить его из корзины и тоже не запустилось.

И теперь я в тупике, по этому вопрос:

1. Как поставить 1.5.2 версию автоматика, и чтобы не надо 50 гигабайт лор переносить куда-то да и в целом ебаться как то мощьно?

2. Стоит ли так изголяться ради fp 8, есть ли реально-заметный буст чтобы на 8 гигабутах комп так не пердел?

ПОМОГИТЕ УМОЛЯЮ

В итоге сделал по видосу где нужно было сделать хард-ресет с указанием хэша версии 1.5.2. Не запустилось. Я даже дефендер отключал, драйвера переустанавливал, всякую хуйню гитпулил и ничего.

Потом я удалил venv и тоже не запустилось, в итоге я попытался восстановить его из корзины и тоже не запустилось.

И теперь я в тупике, по этому вопрос:

1. Как поставить 1.5.2 версию автоматика, и чтобы не надо 50 гигабайт лор переносить куда-то да и в целом ебаться как то мощьно?

2. Стоит ли так изголяться ради fp 8, есть ли реально-заметный буст чтобы на 8 гигабутах комп так не пердел?

ПОМОГИТЕ УМОЛЯЮ

Вот:

Creating model from config: D:\stable-diffusion-webui\repositories\generative-models\configs\inference\sd_xl_base.yaml

Traceback (most recent call last):

File "D:\stable-diffusion-webui\launch.py", line 39, in <module>

main()

File "D:\stable-diffusion-webui\launch.py", line 35, in main

start()

File "D:\stable-diffusion-webui\modules\launch_utils.py", line 394, in start

webui.webui()

File "D:\stable-diffusion-webui\webui.py", line 393, in webui

shared.demo = modules.ui.create_ui()

File "D:\stable-diffusion-webui\modules\ui.py", line 421, in create_ui

with gr.Blocks(analytics_enabled=False) as txt2img_interface:

File "D:\stable-diffusion-webui\venv\lib\site-packages\gradio\blocks.py", line 1411, in __exit__

self.config = self.get_config_file()

File "D:\stable-diffusion-webui\venv\lib\site-packages\gradio\blocks.py", line 1389, in get_config_file

block_config["example_inputs"] = block.example_inputs() # type: ignore

File "D:\stable-diffusion-webui\venv\lib\site-packages\gradio\components.py", line 1360, in example_inputs

"raw": self.choices[0] if self.choices else None,

TypeError: 'dict_keys' object is not subscriptable

Loading VAE weights specified in settings: D:\stable-diffusion-webui\models\VAE\sdxl_vae.safetensors

Applying attention optimization: xformers... done.

Model loaded in 278.9s (load weights from disk: 12.7s, create model: 1.6s, apply weights to model: 199.7s, apply half(): 52.2s, load VAE: 6.1s, move model to device: 0.2s, hijack: 0.2s, load textual inversion embeddings: 0.8s, calculate empty prompt: 5.2s).

Для продолжения нажмите любую клавишу . . .

В Save to нужно писать имя файла, а не папку.

Подскажите как прикрутить llm модели в Comfy? Вроде где-то были кастомные ножи для этого.

И вообще, откуда брать идеи? Вайлдкарты уже не помогают:(

И вообще, откуда брать идеи? Вайлдкарты уже не помогают:(

> Получится полнейшая хуйня на выходе.

Оно и с мерджем лор также выйдет.

> хард-ресет с указанием хэша версии 1.5.2

Это точно именно так описано? Версия древняя, поддержка фп8 добавлялась недавно. Просто перейди на дев ветку, скачай ласт версию и делай как в видео https://www.youtube.com/watch?v=uNLzAUyCTlo

А как перейти? Я вот все сломал тем что пытался. И делал по этому видосу тоже.

Я бы отсосал за степ бай степ гайд как мне сохранить мои экстеншены, модели и лоры и при этом чтобы все работало нормально, а то я скачал SD которая в 1 клик устанавливается и там слишком муторно сделать так чтобы он подсосал все это + fp 8 там нету и возможности на ветку перейти тоже.

> есть ли реально-заметный буст

Какой ты буст ждёшь? Просто потребление памяти почти в два раза ниже будет.

Ну, это ведь ускорит генерацию или нет? В любом случае было бы неплохо.

Как на дев-ветку перейти ток?

>Как на дев-ветку перейти ток?

git checkout dev

git pull

-------------

Команда, чтоб посмотреть какая у тебя ветка сейчас: git branch

Можно сделать новую инсталляцию какую надо, а папки embeddings, extensions, models прихуярить в нее mklink'ом.

Питонисты не умеют отделять мух от котлет, все тащат к себе в папку. Нет, чтобы нормально сделать - вот приложение, его шатай, вот данные, его не шатай. Нет, не хочу, не буду, я питонист.

Переходи на дев ветку, как предложили выше, автоматик хуй положил в мейн мерджить в данный момент всякое новое говно. Ещё можешь фордж попробовать, кумеры с паскалями визжат от счастья, как на нём работает ХЛ, но он багованный что пиздец сейчас https://github.com/lllyasviel/stable-diffusion-webui-forge экстеншены должны (почти все) работать нормально, loractl например отвалился, все остальные основные вроде рабочие

Капец, откуда я это должен знать был. В гугле нихуя нету, сидел гуглил пока вы не ответили. В любом случае - спасибо большое

Так и сделал, спасибо

Спасибо спасибо

> А как перейти?

Ответили

Учитывая обилие своих перкатов - лучше вообще склонируй новую через git clone ... --branch dev модели, эмбединги, лоры, контролнеты и прочее перенеси со старой (можешь хоть всю папку models). Экстеншны можешь скопировать тоже, но лучше поставь через интерфейс чтобы не тащить лишнего, эта вся система крайне корява и шаринг экстеншнов между несколькими версиями может привести к проблемам.

Или хотябы потри венв и конфиг чтобы накатило последние версии и не тащить потенциально некорректные настройки.

> Питонисты

Шиз, зачем ты шиз? Сейчас бы еще предлагать плодить эти структуры, ссылаясь на пути старой версии.

>для нормальной генерации на SD XL (а то 8 гигабут не хватает)

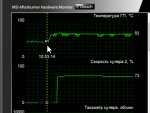

Вот, смотри.

1: Автоматик1111 с бат-файлом по умолчанию.

2: С ключом --medvram.

3: https://github.com/lllyasviel/stable-diffusion-webui-forge

3: Он же webui-forge но включил Batch size 6 да на 3050 8Гиг Врам SDXL. И оно работает. Параллельно шесть генерации и не лезет в озу цп. webui-forge топ!

Я тебе подчеркнул желтеньким важный параметр видимый после генерации. Он не должен быть больше размера памяти видеокарты и тогда скорость будет норм.

>Капец, откуда я это должен знать был. В гугле нихуя нету, сидел гуглил пока вы не ответили.

Жирненький троль однако. Все трои мучения вымышленные.

> 1: Автоматик1111 с бат-файлом по умолчанию.

Это где нет нормальной оптимизации (xformers/sdp/FA)? Судя по потреблению так и есть, тогда в сравнении нет никакого смысла.

Техноантоши, вопрос вот какой.

Могу ли я обойтись без свопа или сделать основным своп в оперативной памяти? Как я понимаю, путь сделать второе — это создать виртуальный диск. Или есть какое-то системное отделение куска памяти. У меня 64, хватит.

Слышал такое, что некоторые программы, даже когда оперативы жопой жуй, без свопа нестабильны.

----------------------

Короч по итогу эпопеи с ошибками (обращение к памяти, segfault) питона. Вроде порешал и пока не выбивало даже при памяти в потолок..

Вероятнее всего у проблемы было три корня.

1. ненадёжное подключение питания SSD, у меня и раньше какой-то из кабелей и дисков сбоил. Вынул вставил всё, уложил провода

2. троян, который, вероятно, импульсами резко лез в сеть (пики на графике), на долю секунды нагружал проц и что-то перебивал в процессе.

3. наличие основного свопа на том же SSD, на котором крутится нейронка, читается и пишется всё. Падало как раз на этапе преобразования и записи из VAE в PNG

Могу ли я обойтись без свопа или сделать основным своп в оперативной памяти? Как я понимаю, путь сделать второе — это создать виртуальный диск. Или есть какое-то системное отделение куска памяти. У меня 64, хватит.

Слышал такое, что некоторые программы, даже когда оперативы жопой жуй, без свопа нестабильны.

----------------------

Короч по итогу эпопеи с ошибками (обращение к памяти, segfault) питона. Вроде порешал и пока не выбивало даже при памяти в потолок..

Вероятнее всего у проблемы было три корня.

1. ненадёжное подключение питания SSD, у меня и раньше какой-то из кабелей и дисков сбоил. Вынул вставил всё, уложил провода

2. троян, который, вероятно, импульсами резко лез в сеть (пики на графике), на долю секунды нагружал проц и что-то перебивал в процессе.

3. наличие основного свопа на том же SSD, на котором крутится нейронка, читается и пишется всё. Падало как раз на этапе преобразования и записи из VAE в PNG

Продолжаю ковырять регуляризации.

Вводные:

Лора из 70 клозапов среднего качества, ручные кепшены после блипа, 6 регов на пичку, 3к шагов, адафактор-адафактор (лр автомат), база 1-5-прунед.

Клозап-неклозап разница не рассматривается, т.к. результаты сравнивались с "дефолтной" лорой того же датасета (реги по промту "воман" ддим кфг7 50шагов 1-5-прунед, лежат на обниморде, на них ссылаются сд туториалы).

Регуляризации на основе чекпоинтов конкретно так уводят результат, то есть смысла в них нет вообще. Вывод тестил в 1-5-прунед и в чекпоинтах, и чистый "<лора:лора:0.8> кейворд", и в составе промта с разным зумом и лорами. Сами реги сгенерил в 768х768 из 5-6 популярных моделей, в колве около 700, в промте указывал радомные параметры возраста, волос, зума, эмоций (через dynamic prompts).

Была гипотеза, что если визуал регов будет ближе к датасету, то тренинг пикнет разницу и, как результат, это что-то даст. Об этом говорят и туториалы, мол чару будет проще выводиться в классе воман, а другие воманы не станут чаром. Тут два момента

1. По факту я еще не видел лору, где другие воманы стабильно не становились бы чаром.

2. Чару и правда проще выводиться в классе воман, но похоже это не связано с регами и даже кепшенами (см.ниже).

Касательно регов на основе 1-5-прунед. 768х768 в нем сгенерить невозможно, т.к. он всегда выдает церберов. Нагенерил класс куте герл 512х512 со средне-тривиальным промтом (результат менее дичный, чем промт = "воман"). В лоре заменил в классе и кепшенах воман на куте герл. Результат в принципе похож на воман-лору, но не дотягивает.

Неясно, какой сделать вывод, но напрашивается, что суть класса не в том, чтобы рег-пикчи были красивые, похожие или еще что-то. Создается манявпечатление, что реги работают как сорт оф комплемент клипа. То есть не надо их "стараться", потому что важно не это, а отображение ["воман" -> пикча вомана как ее понимает сд]. И при тренинге лоры пикается не разница [реги vs. датасет], а разница [["воман" -> пикча вомана] vs. ["чар, воман в пальто, стена" -> пикча датасета]], т.е. в путях инференса с точки зрения базовой модели.

Но почему другой, схожий класс не ведет себя так же, остается неясным.

Алсо, прочитав где-то, что клип полторахи ориентирован на "теги, теги, теги" вместо "описание чо как предложениями", я заодно попробовал сделать кепшены в боору-стиле. Вышла хрень, блип-стиль рулит. Алсо пробовал избежать кейворда (и/или класса) вообще и захуячить весь кепшен одним предложением через множество and/with/is - это тоже дало худший результат. Делаю вывод, что по крайней мере основную часть стоит писать предложением, а детали уже добавлять через запятую, и кейворд - нужен. Огромный пост про кепшены на реддите этому местами противоречит.

Плоты делать не стал, т.к. разница в качествах лор такая, что особо нечего сравнивать, а я и так заебался.

Что дальше.

Возможно стоит заигнорить церберство и нагенерить 1-5-прунед реги 768х768 (учитывая идею из "напрашивается"), и попробовать с ними.

Проверить, как все то же самое работает, если (по советам анонов) вкидывать реги не в "reg", а прямо в "img" с кепшенами регов ас-ис.

Комбинации классов?

Пока все, бывайте

Вводные:

Лора из 70 клозапов среднего качества, ручные кепшены после блипа, 6 регов на пичку, 3к шагов, адафактор-адафактор (лр автомат), база 1-5-прунед.

Клозап-неклозап разница не рассматривается, т.к. результаты сравнивались с "дефолтной" лорой того же датасета (реги по промту "воман" ддим кфг7 50шагов 1-5-прунед, лежат на обниморде, на них ссылаются сд туториалы).

Регуляризации на основе чекпоинтов конкретно так уводят результат, то есть смысла в них нет вообще. Вывод тестил в 1-5-прунед и в чекпоинтах, и чистый "<лора:лора:0.8> кейворд", и в составе промта с разным зумом и лорами. Сами реги сгенерил в 768х768 из 5-6 популярных моделей, в колве около 700, в промте указывал радомные параметры возраста, волос, зума, эмоций (через dynamic prompts).

Была гипотеза, что если визуал регов будет ближе к датасету, то тренинг пикнет разницу и, как результат, это что-то даст. Об этом говорят и туториалы, мол чару будет проще выводиться в классе воман, а другие воманы не станут чаром. Тут два момента

1. По факту я еще не видел лору, где другие воманы стабильно не становились бы чаром.

2. Чару и правда проще выводиться в классе воман, но похоже это не связано с регами и даже кепшенами (см.ниже).

Касательно регов на основе 1-5-прунед. 768х768 в нем сгенерить невозможно, т.к. он всегда выдает церберов. Нагенерил класс куте герл 512х512 со средне-тривиальным промтом (результат менее дичный, чем промт = "воман"). В лоре заменил в классе и кепшенах воман на куте герл. Результат в принципе похож на воман-лору, но не дотягивает.

Неясно, какой сделать вывод, но напрашивается, что суть класса не в том, чтобы рег-пикчи были красивые, похожие или еще что-то. Создается манявпечатление, что реги работают как сорт оф комплемент клипа. То есть не надо их "стараться", потому что важно не это, а отображение ["воман" -> пикча вомана как ее понимает сд]. И при тренинге лоры пикается не разница [реги vs. датасет], а разница [["воман" -> пикча вомана] vs. ["чар, воман в пальто, стена" -> пикча датасета]], т.е. в путях инференса с точки зрения базовой модели.

Но почему другой, схожий класс не ведет себя так же, остается неясным.

Алсо, прочитав где-то, что клип полторахи ориентирован на "теги, теги, теги" вместо "описание чо как предложениями", я заодно попробовал сделать кепшены в боору-стиле. Вышла хрень, блип-стиль рулит. Алсо пробовал избежать кейворда (и/или класса) вообще и захуячить весь кепшен одним предложением через множество and/with/is - это тоже дало худший результат. Делаю вывод, что по крайней мере основную часть стоит писать предложением, а детали уже добавлять через запятую, и кейворд - нужен. Огромный пост про кепшены на реддите этому местами противоречит.

Плоты делать не стал, т.к. разница в качествах лор такая, что особо нечего сравнивать, а я и так заебался.

Что дальше.

Возможно стоит заигнорить церберство и нагенерить 1-5-прунед реги 768х768 (учитывая идею из "напрашивается"), и попробовать с ними.

Проверить, как все то же самое работает, если (по советам анонов) вкидывать реги не в "reg", а прямо в "img" с кепшенами регов ас-ис.

Комбинации классов?

Пока все, бывайте

Раньше говорили, что просто сделай маленький своп, т.к. винде без него скучно. Сейчас хз.

Своп в памяти это тупо минус память.

ТуреЕггогщик, не гори, такая уж была задача

В шинде лучше без свопа не катать, ловля сегфолтов - верный признак что он нужен.

> наличие основного свопа на том же SSD, на котором крутится нейронка, читается и пишется всё

Скажется только на юзер-экспириенсе и отзывчивосте системы, на стабильность не повлияет.

Покажи хотябы превьюшками что там в датасетах.

Алсо на какой модели тренится?

>Своп в памяти это тупо минус память.

Я догадываюсь, но шош делать, если винде непременно хочется свопа, а мне хочется использовать только оперативу, которой вдоволь?

Ебанистерия какая-то…

Взял порношлюшку, чтобы не жалко было выкладывать. Есть хайресы, много среднего, лоуресы апскейлил или удалял. Модель v1-5-pruned

Кто знает, почему не работает Tag Autocomplete? Ласт версия дев ветки, почти нихуя из экстеншенов не стоит (на другой версии все работало)

Поделюсь кулстори с падениями винды. Несколько лет все работало норм, потом поставил 64гб и тогда же начал сд, обновил дрова. Начались стабильные перезапуски, иногда без синего экрана, иногда с ним. Иногда в сд, иногда на ровном месте. Продувал, пересобирал, не помогло. Память долго тестил, все ок. Бп менял. Диски местами менял, по одному отключал. Биос сбрасывал. Снижал частоту и тайминги. Винду переставлял, не помогло (вернул из бакапа обратно). Случайно выяснил, что если после включения компа и загрузки сразу сделать ребут, то проблема исчезает. С тех пор преимущественно отправляю комп в слип. Думаю дело где-то в комбинации дров и биоса, какой-то чисто "works on my computer" баг. Интересный момент - пока не отправишь в первый раз в слип, все системные поля ввода текста и некоторые белые окна становятся серыми. Чо-то типа пикрил

> Нагенерил класс куте герл 512х512

А тренил в 768? Тегал их аналогично как генерировал кьютгерл, или тоже просто вуман?

> что клип полторахи ориентирован на "теги, теги, теги" вместо "описание чо как предложениями"

Нет, на околонатуртекст он ориентировал. Это наи ориентирована на теги.

Повествование слишком сумбурное и сложно понять что вообще происходит, хотя интересно. Можешь спокойно по очереди расписать что за вуманлора, что именно имеется под

> пикается не разница [реги vs. датасет], а разница [["воман" -> пикча вомана] vs. ["чар, воман в пальто, стена" -> пикча датасета]], т.е. в путях инференса с точки зрения базовой модели

если можно с поясняющими примерами, и остальное? Что в итоге с регами лучше или хуже?

Уф, жестко. Ценности не снижает, но, велик шанс что подобного рода тренировки стоит выделить в отдельный класс, и не все справедливое для них может работать на других.

Ошибки в консоле при запуске чекай.

Мб Видеопамять мертва. Крашится только при заполнении более определенного уровня. Вообще звучит как отвал чего-нибудь

>Ошибки в консоле при запуске чекай.

Спасибо, как то не подумал

Вряд ли, сд-тренинг ее всю выжирает, и ллмы тоже гоняю, ничего не падает. Разница буквально только во включил vs включил+перезагрузил.

Очень похоже на нестабильную работу RAM. У меня примерно так же было — пару раз в неделю вылеты BSOD, крашились проги, иногда комп не выходил из гибернации или сна.

Паямять тестил всем чем только можно: memtest, testmem, OCCT, AIDA — никаких проблем. Тайминги/частоту крутил, XMP отключал — бестолку.

Потом заменил комплект 2x16 на 2x32 — пиздец, ни одного вылета или какой-нибудь проблемы за почти год.

Была у меня лора их дохера на самом деле, но я говорю про эту. Натренена по туториалам, с регами, взятыми с обниморды, как предлагалось в туториалах. Я ее часто называю дефолтной / "воман" / оригинальной. "img/<n>_<keyword> woman", "reg/1_woman", кепшены "<keyword>, a woman yadda yadda", в датасете клозапы. Тренил всегда 768х768, всегда с регами 512х512.

Она мне нравится, с ней все хорошо.

>Что в итоге с регами лучше или хуже?

По моему опыту, что с регами всегда лучше. Это может быть субъективным. Но мои тесты в принципе не затрагивают область "без регов". Я больше отвечаю на вопрос "чо как будет с разными регами, и чо они делают".

>если можно с поясняющими примерами

Конкретно то, что ты с меня процитировал, сложно объяснить, но попробую. Я пытаюсь понять, как именно связана цепочка понятий:

1. (класс в именах папок img/xxx reg/xxx)

2. (класс, упомянутый в тегах (кепшенах))

3. (класс, как его понимают веса в базовой модели)

4. (класс, как он представлен пикчами датасета регуляризаций)

И для этого провел вышеописанные эксперименты.

>>не разница [реги vs. датасет], а разница [["воман" -> пикча вомана] vs. ["чар, воман в пальто, стена" -> пикча датасета]]

Я неуверенно утверждаю, что:

А. Классы 3 и 4 неразрывно связаны процессом инференса. Что естественно, т.к. промт "воман" + сид + веса модели == пикча регов. Если заменить пикчи регов на пикчи, сгенеренные другим промтом, то эта связь перестает быть таковой для текста "воман". То есть генерить "красивые" реги смысла не имеет. Это я проверил, создав красивый класс "woman". См.пикрилы.

Б. То, как туториалы описывают работу регов, возможно неверно. Они говорят, что тренинг пикает разницу между рег-пикчами и датасет-пикчами, позволяя как бы выделить keyword из класса, а не замещать класс keyword-ом в весах лоры.

Но из-за пункта А, я думаю, что это не так.

Я думаю, что реги нужны для того, чтобы при трениге использовать (готовое отображение класса 3->4), а не просто (пикчу из 4). А классы 1/2 просто сообщают тренингу, что в пикче они есть. При этом класс в имени папки img/xxx вообще неясно зачем нужен. И все это, в теории, значит, что использование регов НЕ то же самое, что просто примешать их к датасету в "img/" с кепшенами вида "woman".

Да, скорее всего. Просто ребут что-то скидывает в биосе, и оно перестает ломаться. Ну мне и норм, главное знаю как обходить. Ради холодного включения лень менять планки, да их и не примут наверное.

Есть где-нибудь внятное объяснение параметра keys scaled? Или это очередной бесполезный параметр типа loss?

Где-то вычитал, что если keys scaled резко пошли вверх, то это прям говно-жопа.

Но на практике обучал лору на стиль, keys scaled были порядка 30 — по итогу лора очень хуёво обучилась, стиль практически не повторяет.

Перезапустил обучение с большим числом шагов, keys scaled на последней эпохе были около 800 — всё охуенно получилось, стиль копирует очень похоже, бэкграуды не проёбывает.

Где-то вычитал, что если keys scaled резко пошли вверх, то это прям говно-жопа.

Но на практике обучал лору на стиль, keys scaled были порядка 30 — по итогу лора очень хуёво обучилась, стиль практически не повторяет.

Перезапустил обучение с большим числом шагов, keys scaled на последней эпохе были около 800 — всё охуенно получилось, стиль копирует очень похоже, бэкграуды не проёбывает.

Не получилось. В итоге загуглил свою ошибку, установил Model Keyword и ничего не работает + еще сломалась вкладка с лорами внизу, раньше там можно было сортировать и тому подобное, а теперь даже строка с названиями не работает.

Без Model Keyword она совсем не грузит, а без нее поиск просто не работает. Почому так...

> Почому так...

Потому что

> Ласт версия дев ветки

Я раньше сам сидел на дев ветке, но после того как несколько раз там пломали поддержку большинства дополнений (приходилось самому лезть и разбираться почему говнокод дополнений не работает с говнокодом автоматика), понял что это мартышкин труд и откатился на стабильную 1.7.0.

Чтоб на стабилую перейти нужно --branch master написать в консольке?

git switch master

Спасибо, помогло

Мужчины, нужен совет, натренировал лору еот, когда генерю с ней картинку, на превью во время генерации вижу прям идеальное лицо, стопроцентное совпадение, а на итоговой появляются артефакты+ лицо становится менее узнаваемым. Как пофиксить?

>Мужчины, нужен совет

>Как пофиксить?

Вернуться на кекабу

Кто-нибудь Glaze и новый NightShade от тех же чуваков пробовал?

Как они вообще работают?

Я вот задаюсь вопросом - как, блин, можно защитить изображение "на пиксельном уровне", чтоб вдобавок еще и заставить нейронку поехать кукухой при тренировке на таких "отравленных" картинках?

Эта "защита" должна каким-то образом еще и сохраняться при ресайзе картинки до тренировочного разрешения, и вдобавок не колбасить саму картинку для восприятия ее юзером.

Что от "защиты" останется при прогоне картинки в и2и с минимальным денойзом и под контронетом?

Или через какой-нибудь GAN-апскейлер?

Как они вообще работают?

Я вот задаюсь вопросом - как, блин, можно защитить изображение "на пиксельном уровне", чтоб вдобавок еще и заставить нейронку поехать кукухой при тренировке на таких "отравленных" картинках?

Эта "защита" должна каким-то образом еще и сохраняться при ресайзе картинки до тренировочного разрешения, и вдобавок не колбасить саму картинку для восприятия ее юзером.

Что от "защиты" останется при прогоне картинки в и2и с минимальным денойзом и под контронетом?

Или через какой-нибудь GAN-апскейлер?

Хуйня это всё полная. Я запускал ради интереса glaze 1.1.1 — картинка на выходе выглядит как будто её прогнали через хуёвый VAE. Самое смешное, что при помощи фотошопа и ESRGAN её можно восстановить практически до первоначальной с небольшой потерей детализации (для датасета лоры или дримбудки похуй).

Какая-то нелепая попытка в войну брони и снаряда, только в данном случае снаряд кумулятивный, а броня из фанеры.

Из простого: попробуй уменьшить вес лоры и прибавить вес кейворда. Либо для лоры еот, либо для лоры жесткой ебли в онал.

Если не выйдет, построй плот по эпохам с "итоговым" промтом, посмотри чо там происходит.

Если ничо, то поиграй с очком альфой, оптимизером.

Альтернативно можешь вкурить regional prompting. Не ахти решение, но на передернуть сойдет.

Задолбало ждать пока лора натренится.

Аноны есть какой-то ключ запуска для автоматика, чтобы не трогал гпу?

На гитхабе есть цпу-онли репа какая-то, но хотелось одним сетапом.

Аноны есть какой-то ключ запуска для автоматика, чтобы не трогал гпу?

На гитхабе есть цпу-онли репа какая-то, но хотелось одним сетапом.

> можно защитить изображение "на пиксельном уровне"

Можно, но на кожанных это скажется гораздо сильнее чем на нейронке. Как вариант - назойливая ватермарка в стороне, нейронка ее запомнит, а чтобы этого избежать, придется настраивать пайплайн по ее детекции и автоматическому удалению со всех пикч. не то чтобы это сложно, но лишние телодвижения и отсеет хлебушков.

Вторая гпу

Да с ватермарками то как раз проблем никаких нет, уже куча штук умеют их определять и вычищать. Начиная с простых логотипов, и заканчивая паттерном по всему изображению.

Опять же, она запросто распознается и протэгается, а потом при желании негативным промптом уберется.

Меня интересует именно то, как эти штуки в изображение встраиваются.

Так, технач, я снова наловил синих экранов.

Протестив всё (проц, видяха, память) нашёл проблему.

Но не вполне понимаю, каким будет наилучшее решение.

Дано. Видеокарта двухвентиляторная, мсина вантуз. 3060 12г.

Факт1: комп уходит в синий экран аккурат в момент резкого взвывания кульков.

Факт2: принудительно раскрутил кульки на максимум и спокойно прогнал множество больших батчей, предельно загружая карту.

Факт3: понижение лимита на питалово не влияет.

Выводы: проблема не в БП, а в том, что происходит резкий нагрев какого-то элемента и вентиляторы не успевают разогнаться

Временное решение: кастомный профиль кулеров, раскручивающих их на меньшей температуре.

Проблема только с СД, никакая другая нагрузка, включая бублики и стрессы не напрягает так видяху.

Вопрос в том, стоит ли лезть в видяху или тащить её на осмотр и обслуживание спецам? Есть подозрение, что надо. Возможно где-то прокладка слишком жирная а нужно подложить медь или ещё что.

Протестив всё (проц, видяха, память) нашёл проблему.

Но не вполне понимаю, каким будет наилучшее решение.

Дано. Видеокарта двухвентиляторная, мсина вантуз. 3060 12г.

Факт1: комп уходит в синий экран аккурат в момент резкого взвывания кульков.

Факт2: принудительно раскрутил кульки на максимум и спокойно прогнал множество больших батчей, предельно загружая карту.

Факт3: понижение лимита на питалово не влияет.

Выводы: проблема не в БП, а в том, что происходит резкий нагрев какого-то элемента и вентиляторы не успевают разогнаться

Временное решение: кастомный профиль кулеров, раскручивающих их на меньшей температуре.

Проблема только с СД, никакая другая нагрузка, включая бублики и стрессы не напрягает так видяху.

Вопрос в том, стоит ли лезть в видяху или тащить её на осмотр и обслуживание спецам? Есть подозрение, что надо. Возможно где-то прокладка слишком жирная а нужно подложить медь или ещё что.

ах да, проблема в том, что по всем датчикам температуры на карте не выше 70, даже перед уходом в синий экран. То есть перегрев может быть очень локальный, вдалеке от датчика или вовсе на питалове.

> комп уходит в синий экран аккурат в момент резкого взвывания кульков

Видюхи или самого компа? И то и то - следствие нарушения работы и перехода в аварийных режим. На видюхе - 99% проблема аппаратная.

Ради интереса, попробуй в работе оказать на нее усилие, слегка попробовав согнуть/деформировать, пальцами постучать. Офк не переусердствуй и не выламывай слот. Если проблема реализуется - все печально.

> То есть перегрев может быть очень локальный

Больше похоже не на перегрев а на нарушения контакта в пайке или трещины в дорожках, которые проявляются при температуре. Алсо попробуй просто снизить частоты без андервольнинга и повторить тесты.

https://stability.ai/news/introducing-stable-cascade

https://github.com/Stability-AI/StableCascade

Кто уже ковыряется, отпишитесь чо там

https://github.com/Stability-AI/StableCascade

Кто уже ковыряется, отпишитесь чо там

Жрёт много, работает через очко, но всё ещё не понятно нахуя надо. По качеству обычный XL, такое же мыло. Уродства на месте. И стабилити опять обосрались, слои нихуя не нормализованы, NaN и чёрные квадраты никуда не делись, опять надо ждать пока васяны поправят веса, как правили сломанный VAE в XL.

Спасибо

Это всё та же сосисочка (Würstchen) v3, они её закончили обучать и переименовали в StableCascade просто. Нормальная модель. v2 страдала от чрезмерной компрессии, v3 импрувнули прилично. Понимает промпт чуть лучше чем остальные SAI'шные сетки, но в целом воз и ныне там - для промпта нужна мощная языковая модель, которую ты не впихуешь себе на видюху вместе с диффузией.

Главное что с датасетом и генерализацией. Если бы она умела во взаимодействие объектов, она бы прекрасно подошла бы в художества ибо можно было контролнетами делать, а не промптами ебаться как в ссаном дали. Но нихуя нет такого, несмотря на то что датасет синтетический.

Самая большая проблема это некоммерческая лицензия, что делает эту сетку неюзабельной.

Да с какого перегара ты тут XL вообще высрал, наркоман, это совершенно другая сеть.

>для промпта нужна мощная языковая модель

Аноний, можешь пояснить, что ты имеешь тут ввиду? SD же идет со стандартным CLIP, чем другие модели смогут улучшить положение?

>для промпта нужна мощная языковая модель, которую ты не впихуешь себе на видюху вместе с диффузией

Я кстати поигрался тут с контролнетом. Не то что бы новость какая, но седня сшил в паинт.нете пару-тройку depth карт и получил результат. И меня посетила мысль, что неплохо было бы иметь отдельно генератор-сшиватель разных контролнет-карт, порезанных сегментатором в слои. И потом уже, это все совалось бы в конечный промт сд.

Почему цитирую, потому что промт->пикча это идеализированная методика, а они частенько не работают ирл. Я думаю ген аи нужно идти в сторону композиций, но не как это делает наркоманский комфи, а просто разложить то, что уже есть, в набор кубиков, которые потом складывать теми же аи/3д/етц средствами.

То есть грубо:

1. "подвал" -> роллим пикчу подвала -> depth -> глубина подвала(1) порезана на стены(2), пол(3), хлам(4).

2. "мужик сидит на стуле руки в боки" -> роллим пикчу мужика -> depth -> глубина мужика(5) + стул(6), етц.

3. "(5) посреди (1) чуть правее и поближе к камере, без (4) и (6)" + спец.модель композиции -> глубина композиции.

4. "крокодил дрочит вприсядку в подводной лодке" + контролнет(глубина из п.3) -> результат.

Можно будет собирать библиотеки таких вот отдельных сцен, и люди будут генерить их массово на цивике. Не только для глубин, а для всех типов аннотаций. Знай выбирай да композируй, и не надо ебаться с промтом, по крайней мере в части геометрии.

Может я просто слоупок и такое уже придумали

В клипе и проблема, это не языковая модель. Нужен большой трансформер для кодирования текста, в паре с которым обучена диффузионная часть. Так делают везде. Если комбинировать c нормальной мультимодалкой, будут охуенные зеро-шот возможности. Только и требования растут, как у того же DeepFloyd IF или Pixart Alpha, у которых T5 в составе.

В дали ещё переписывали промпты LLMом, и обучали на переписанном. В сосисочке вроде только переписывание при инференсе.

В любом случае, SAI вряд ли больше будет пилить открытые модели, так что всё это умозрительно. Бабки посчитали и поняли что жгут дохуя, а доходности пока нихуя. Всё что будет это коммерческие продукты от крупных VFX контор и прочих адобов. Что не так плохо, на самом деле, по сравнению с уебанскими мижорни/дали, с которыми только поиграться можно, а делать нихуя нельзя.

Ты описываешь что-то вроде нейронного рендера для 3Д редакторов, ну вот блендер как раз и есть такой сшиватель, если там правильно сцену настроить с композингом, он как раз и сможет тебе такое автоматизировать. И плагины к 2Д редакторам вроде этого https://github.com/Acly/krita-ai-diffusion/ это как раз то что ты хочешь. Процесс преображается начисто, настолько больше управляемости да и просто фана по сравнению с пердолингом с текстом, наряду с файнтюном и зерошотами можно получить что хочешь по рефам.

Но всё это хуйня, если модель плохо обобщает взаимодействие двух концептов и принципиально не может себе представить мужика ходящего по потолку, то ты его никак не нарисуешь и не заставишь эти концепты взаимодействовать. А для нормального обобщения нужна двухмодовая пара, минимум, или больше. Мультимодалка, короче. И именно обучение в паре. И то будут затыки.

А промпт-онли это абсолютно тупиковая хуйня конечно, у текста нет столько семантической ёмкости чтобы описать что хочешь. Промпт должен быть максимально примитивным, чисто чтобы склонить модель куда надо почуть. Если вообще быть. Потому что чем больше промпт, тем хуже повторяемость.

Крутяк, проснусь заценю

~3x faster Stable Diffusion models available on Hugging Face

Hey everyone, we took the most popular Stable Diffusion models we could find, made them more efficient for NVIDIA GPUs and published them on Hugging Face here: https://huggingface.co/PrunaAI

Gets you about ~3x inference speedup and gains on the GPU memory required too. For those of you making products out of these, it should reduce your compute bill and improve user satisfaction :)

We'll be posting a lot more models soon and always with increasing efficiency gains. If you have some custom requests tell me here and we might ship it next time :)

Hey everyone, we took the most popular Stable Diffusion models we could find, made them more efficient for NVIDIA GPUs and published them on Hugging Face here: https://huggingface.co/PrunaAI

Gets you about ~3x inference speedup and gains on the GPU memory required too. For those of you making products out of these, it should reduce your compute bill and improve user satisfaction :)

We'll be posting a lot more models soon and always with increasing efficiency gains. If you have some custom requests tell me here and we might ship it next time :)

Request access

How much does it cost?

We're smashing and publishing the most popular AI models for free on Hugging Face. If you need to smash other models or after having trained/finetuned them on your data then you will need a paid API key with us. Pricings depend on various factors but always align with how much you get out of it. Request access to learn more.

Нах оно нужно-то?

Эм, это тупо подборка моделей с вмержеными турбо лапами. Какая каллосальная работа

Бля т9. Турбо лорами

> это совершенно другая сеть

Зато датасет - говно прямиком с XL, с таким же упором на aesthetic и отсутствием нормальных капшенов. То что там архитектура другая ничего не изменило.

Шаги же

Ну перевод то понятен, но где это в kohya_ss тыкать? Не вижу этого параметра

А, оно чтоле перед названием датасета ставится типа "количествошагов_названиедатасета"? Ну и пиздец система

Это количество повторов х количество эпох. Эпохи в настройках, повторы в датасете

Что. Ты. Несёшь.

Датасет в сосисочке-3 синтетика и маленький совсем, они столько об этом писали у себя

Ты припизднутый, да? Стабилити сами пишут что там тот же каловый датасет из LAION-5B.

Написал таки себе, как хотел, довнскейлер и прямо в интерфейсе Fooocus. Правда пока не понял как вывести картинку в основное окно, поэтому пришлось колхозить отдельную вкладку. Но оно работает и так.

На 1 гифке показал как происходит одна итерация. На 2 видео пример 6-ти итераций. Это излишнее количество, в основном достаточно 2-4.

Метод рабочий. Картофельные картинки, мятые лица восстанавливать норм. Теперь мне не надо сохранять промежуточные картинки куда-то и открывать графический редактор для уменьшения разрешения. Преимущество метода, в том что восстанавливается всё целиком. Не надо выделять лица, руки и т.п.

В общем вот какая проблема, может кто сталкивался. Для создания кэпшнов к изображениям в датасете использую clip interrogator. Под одно изображение он вроде выдает неплохой результат, но как только я юзаю его на батч изображений он начинает творить хуйню. А именно начинает подряд выдумывать несуразицу. Например сначала найдет что там где-то мужчину в красной футболке, потом все следующие промпты тоже будут содержать этого мужчину в красной футболке. А дальше вообще сходит с ума и начинает писать pixel art, pixel art, pixel art... и так раз 20, я обучаю ее на пиксели. Очевидно что там есть какой-то внутренний стейт и оно как-то основывается на предыдущих своих ответах. Так же если закинуть в него просто изображение к которому оно дало, вот этот вот, адский ответ, то оно снова высрет этот же дебильный ответ, даже если его переименовывать и перемещать. Помогает только отрезать пару пикселей от ширины и тогда оно начинает выдавать адекватный результат. Оно очевидно еще и кэширует где-то это дерьмо. Я искал подобную проблему в интернете, ничего не нашел. Скрипт какой-то рандомный с тырнетов взял. Пытался посмотреть, что там может нужно в конфиге модели изменить, но с моими знаниями работы этой модели я вообще ничего не понимаю что могло бы давать такое поведение.

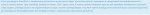

Кажется, разобрался наконец.

пик1 исходный профиль микропрограммы видеокарты.

пик2 настроенный мной сейчас, тоесть уже на 46 кулер должен заводиться.

Пик3 то, что по факту происходит. У видеокарты слишком огромный гистерезис по времени и температуре и за 10! секунд, пока она выжидает с запуском кулеров происходит нагрев от 42 до 65+ и она только разгоняет кулера сразу на 70% скорости. И это уже со сдвинутой кривой. А с заводской скорее всего сразу за 70 при стоящих кулерах.

При включении программного управления кулером проблемы нет, так как там можно сузить оба гистерезиса. и настроить более плавную работу.

Точки микропрограммы тоже можно перенастроить, а гистерезис нельзя. Так-то вопросов к производителю нет, карта везде отрабатывала правильно, не дёргая кулера попусту.

Итог прост — работать с SD под запущенным афтербёрнером и не париться. Ну и откалибровать кривую микропрограммы под мои типовые шаги температуры.

Fooocus реально годный инструмент, жаль апдейтов нет совсем

Аноны, как добиться схожих результатов как на видео? Увидел в рекламе платных курсов, пробую повторить. Из тех данных что автор говорила/показывала на стримах: ContolNet: Softedge(это и на видео по маске видно), LoRA обучалась примерно на 10к изображений ювелирки (не понятно всё ли использовались как датасет, или часть как "Regularisation images"), апскейлер вероятно 4x_NMKD-Siax_200k(возможно тоже дообученный на ювелирке). В названии модели у автора есть цифры 2500s(steps?)-1500ts()

Отдаленно похожий результат получал и без обученной модели, но, к примеру, плавный градиент во внутренней части кольца никак не дается.

Отдаленно похожий результат получал и без обученной модели, но, к примеру, плавный градиент во внутренней части кольца никак не дается.

> LoRA обучалась примерно на 10к изображений ювелирки

Чето не похоже на результату лол, за столько должно быть усвоить как делать группы камней без поломок.

Насобирай пикч с ювелиркой, протегай (причем тут надо тегать подробно релейтед с учетом терминологии а не просто ванринг), и обучи, варьируя параметры. Основное там всеравно от контролнета приходит, используй комбинацию тайл и софтэдж, не забывай что у последнего еще разрешение препроцессора регулируется.

>Fooocus реально годный инструмент, жаль апдейтов нет совсем

Дохуя форков.

А как именно не получается? Мне кажется стилей надо добавить. Во второе видео добавил это и теней на ободке убавилось:

"{prompt},(dark shot:1.17), epic realistic, faded, ((neutral colors)), art, (hdr:1.5), (muted colors:1.2), hyperdetailed, (artstation:1.5), cinematic, warm lights, dramatic light, (intricate details:1.1), complex background, (rutkowski:0.8), (teal and orange:0.4), Details, ((intricate details)), hdr, ((intricate details, hyperdetailed))"

Спасибо,буду с тегами разбираться) Даже с теми, что в примере, метал уже лучше выглядит. Почему-то думал что в img2img все только на модели и настройках SD завязано.

Для миксов и извлечения лоры нужна ema-only (4гб) или non-ema (7гб) модель?

>миксов и извлечения

Про это не знаю, но тренить надо на 7гб

Хватит максимально запруненой двухгиговой.

Анонсировали Stable Diffusion 3.

>диффузионный трансформер по типу Sora, с флоу матчингом и всем прилагающимся, детали архитектуры скоро будут

>совместима с видео и 3D (т.е. как минимум не надо для этого обучать новую с нуля, для экспериментальных метод достаточно приколбасить адаптер)

>мультимодальный инпут

>набор моделей от 800M до 8B параметров

>планируют стандартный набор инструментов вроде контролнетов и ип-адаптеров к релизу

>безопасность-цензура и т.п. блабла

>бету будут мурыжить за API, открытые веса на релизе.

>диффузионный трансформер по типу Sora, с флоу матчингом и всем прилагающимся, детали архитектуры скоро будут

>совместима с видео и 3D (т.е. как минимум не надо для этого обучать новую с нуля, для экспериментальных метод достаточно приколбасить адаптер)

>мультимодальный инпут

>набор моделей от 800M до 8B параметров

>планируют стандартный набор инструментов вроде контролнетов и ип-адаптеров к релизу

>безопасность-цензура и т.п. блабла

>бету будут мурыжить за API, открытые веса на релизе.

В одном видео было 7гб (AItrapreneur), в другом 4гб, ты говоришь 2гб, кому верить?

Я так понимаю sd1.6 отбраковали?

Верь мне, полезных весов в 16битной точности что везде юзается там чуть меньше 2 гигабайт. Что-то больше требуется только если планируешь полномасштабное обучение.

вангую наши затычки rtx3060 её не потянут

> Я так понимаю sd1.6 отбраковали?

Зачем вообще кому-то нужен был файнтюн полторашки? Его сразу отправили в помойку.

>от 800М параметров

Полтораха имеет 960М. Сказали что традиционно масштабируются, в общем.

Модель в целом выглядит очень способной, учитывая что она недообучена ещё. Её ещё доделывать, DPO накладывать и т.п.

>Я так понимаю sd1.6 отбраковали?

SAI делает дохуя моделей так-то, многие из которых идут в никуда. DF IF, сосисочка, не говоря уже об этом японском файнтюне. Хз чё они вообще делают, учитывая что GPU ресурсов у них в 100 раз меньше чем у OAI, по их же словам.

На HN чел из SAI пишет что не обучают на видео именно из-за того что у них во много раз меньше GPU как раз.

надеюсь паджиты не задушат нсфв фильтрами

Я не верю, т.к. у меня было 2 переката:

Разные 2гб чекпоинты -> 4гб емаонли дало совместимость.

4гб емаонли -> 7гб база дало общее качество.

У меня куча лор, перетренивал все, так что не флюк.

Зря.

Модель не сможет нарисовать даже женский сосок, не говоря уже о чем-то более "небезопасном".

Похуй вообще, если веса есть то можно дотренить всегда.

Есть шанс что флешбеки 2.х у них все еще в памяти.

Изучи вопрос, погугли что такое плацебо и все поймешь. Если тебе так спокойнее - юзай хоть 15гиговые чекпоинты, современные программы всеравно не грузят в память лишнее.

>Есть шанс что флешбеки 2.х у них все еще в памяти.

Да тащемта 2.1 уже нормально дообучалась, просто момент уже был проёбан и для полторахи больше тулинга было, поэтому не было смысла переползать ради призрачной разницы.

Тут же просто порядковая разница, судя по пикчам.

Ты его сам-то изучал? У меня так-то с лорами немалый опыт, чтобы отличать рандом от что и как.

Двачую насчет дообучения и неудачного момента для нее. Там просто про то что может не станут совсем лоботомировать из-за имеющегося фидбека.

Офк всеравно, учитывая заявленные размеры моделей, можно дообучить, вопрос в сложности.

Насчет порядковой разницы - не сказал бы, но может пойти в плюс.

Если апеллировать к авторитету, то с высокой вероятностью имею и опыта и прочего больше. Но это не важно, пробуй сам, в худшем случае потеряешь только время, заодно вспомни какой изначально был вопрос. Довольно странно приходить задавать вопрос, а потом начинать спорить с такими аргументами.

Не странно, если я другой

В какой-то приблуде видел функцию, которая позволяет пересчитать базовый "вес", с которым применяется лора.

И что-то не могу найти, в какой такое видел.

Помогите найти.

А то надо после мерджа кучи лор у результата базовую силу пересчитать с 0.2 на 1.0, для удобства использования.

И что-то не могу найти, в какой такое видел.

Помогите найти.

А то надо после мерджа кучи лор у результата базовую силу пересчитать с 0.2 на 1.0, для удобства использования.

Что за "базовая сила"? В самой лоре нет ничего такого. Если ты про preferred weight в json-файле рядом с ней, то открой карточку лоры в автоматике и поставь какую надо, он сохранит. В настройках также есть дефолтное значение для всех.

Тот вес, с которым лора применяется для достижения оптимального результата. У старых "пережарок" он обычно в районе 0.6-0.7, у моей из-за того, что я мерджил десяток лор-концептов, не запариваясь с установкой правильных весов в супермерджере - он стал 0.2. Вот хотелось бы пересчитать на 1.

Я точно помню, что где-то такое видел.

Так и не нашел, где эта фигня с перерасчетом силы была.

В итоге пошел обходным путем - смерджил лору саму с собой, но каждый из компонентов был выставлен на половину веса, который использовался при генерации.

Т.е. в моем варианте лора использовалась с весом 0.2.

Проставил в супермерджер ее на слияние с ее копие, обе с весом 0.1.

Как итог - при использовании результата слияния с весом 1 картинки получаются плюс-минус идентичными оригинальной под весом 0.2. Разница в результате минимальная.

Так что если кому-то захочется пересчитать старые "пережаренные" лоры под единицу веса - можете пользоваться таким способом.

В итоге пошел обходным путем - смерджил лору саму с собой, но каждый из компонентов был выставлен на половину веса, который использовался при генерации.

Т.е. в моем варианте лора использовалась с весом 0.2.

Проставил в супермерджер ее на слияние с ее копие, обе с весом 0.1.

Как итог - при использовании результата слияния с весом 1 картинки получаются плюс-минус идентичными оригинальной под весом 0.2. Разница в результате минимальная.

Так что если кому-то захочется пересчитать старые "пережаренные" лоры под единицу веса - можете пользоваться таким способом.

>Да тащемта 2.1 уже нормально дообучалась

Важно, что публика им показала, что не надо идти против большинства и сисечек. И они усвоили.

В целом же инструмент должен быть аморальным и универсальным, как молоток. Ответственность на использующем.

Таки да. Вопрос решён полностью.

Никаких больше синих экранов и сегфолтов.

Проблемой был не только поздний старт кулеров но и слишком ранняя остановка. Карта оставалась нагретой до 55 и при очередном запуске SD гарантировано перегревалась.

Просуммирую, что починял:

вернул своп вообще и на скоростной диск в частности,

отключил своп с диска подгружающего СД и диска, принимающего батчи картинок,

переткнул кабели питания на диски,

поставил Afterburner на автозапуск с кастомной кривой кулеров, полученной из практики, так как у микропрограммы в биосе слишком большое запаздывание (временной и температурный гистерезис),

проверил систему на вирусы (вроде был троян).

Ограничение по тдп/частотам смысла не имело именно из-за нагрева за первый проход и старта (через небольшое время) с нагретой карты на втором проходе.

>идти против большинства

кекнул

Большинство хочет свобод. Но без ответственности.

Тренирую sdxl лору без Regularisation images, ~100 Training images, ~10 эпох, 20 Repeats

В итоге что лучше: Та, которая после 10 эпох на весе 1 пережарена, но использовать её можно уменьшая вес или

выбрать одну из промежуточных по эпохам, которая не жарит на весе 1.

С точки зрения универсальности, деталей, ...

На кдпв пример пережарки в конце тренировки на весе 1

В итоге что лучше: Та, которая после 10 эпох на весе 1 пережарена, но использовать её можно уменьшая вес или

выбрать одну из промежуточных по эпохам, которая не жарит на весе 1.

С точки зрения универсальности, деталей, ...

На кдпв пример пережарки в конце тренировки на весе 1

Что лучше подходит для получения определённого персонажа, гиперсеть или лора?

> гиперсеть

> 2024

Мертвая хуета.

Не знаю правильную ли в тему пишу, но есть ли какой то сетап или гайд как использовать условную LLAVA для класификации изображений?

Посоны, почему моделька пони6xl, без лоры на стили, генерит в автоматике бессвязную чушь и размытые силуэты? Клип хоть 2 хоть 1, разницы никакой, с любым семплером. Как только включаю лору - всё норм, но при уменьшении влияния лоры, качество ухудшается. Насколько я знаю, люди используют эту модель нормально и без лоры.

Никак, модель для классификации это CLIP, мультимодалки типа лавы не для этого.

Потому что ты криворукий даун.

специального yaml у пони нет, так что проблема на твоей стороне

>Никак, модель для классификации это CLIP, мультимодалки типа лавы не для этого.

Чё несёт.

Запускаешь ллаву, задаёшь ей промпт-вопрос уровня "чё это за хернь на пикче", кормишь пикчами, получаешь ответ. А лучше CogVLM/CogAgent, а не ллаву.

> задаёшь ей промпт-вопрос

Даунич, это не классификация, это QA-модель. Классификация - это когда модель может классифицировать пикчи по категориям. Откуда вы лезите?

>Потому что ты криворукий даун.

Благодарю за ответ, о просвещенный! Что бы я делал, если бы не добродвач!

Что именно тебя интересует, капшнинг мультимоладками в общем? Не боишься консоли и готов пердолиться со скриптами? Обладаешь хотябы 12гб врам?

Собственно для датасета берется cogagent, vqa или его другая модель, берется скрипт их примера hf модели, устраиваются минимальные правки для процессинга серии пикч. Ничего сложного, если сам не справляешься могу скинуть готовый. Минимум для запуска нужно 12 гигов врам. Из остальных мультимодалок для капшнинга еще немного bakllava и еще одна мелкая что знает нсфв пригодны. Но их выдача напрямую содержит много лишнего, хотябы регэкспами ее придется поправить.

Если же тебе нужна классификация - в принципе мультимодалка тоже это сможет, но менее точно и медленнее чем обученный под задачу визуальный трасформер.

Токсик спок

> Но их выдача напрямую содержит много лишнего, хотябы регэкспами ее придется поправить.

Это про все мультимодалки если что, и почти все уступает когу если речь не о левдсах.

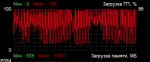

У меня, кстати, с пони такая же еботня происходила.

Даже по примитивному промпту, типо "чарнейм, стэндинг, аутдорс" она генерит совершенную хрень в 95% случаев. Что без квалити тэгов (пик1), что с коротким рекомендованным (пик 2), что с полным (пик3).

Не понимаю, чего на нее все так наяривают?

Насколько я из своих экспериментов установил, эта модель просто чудовищно чувствительна к промптингу, результаты при этом точно так же чудовищно непостоянны, и некоторые концепты нахер убивают всю стилистику картинки.

Без дополнительных лор, или без форсирования стиля художника, или некоторых других хаков она просто ееюзабельна.

P.s.О, новая капча, ура. Никакой больше арифметики.

Даже по примитивному промпту, типо "чарнейм, стэндинг, аутдорс" она генерит совершенную хрень в 95% случаев. Что без квалити тэгов (пик1), что с коротким рекомендованным (пик 2), что с полным (пик3).

Не понимаю, чего на нее все так наяривают?

Насколько я из своих экспериментов установил, эта модель просто чудовищно чувствительна к промптингу, результаты при этом точно так же чудовищно непостоянны, и некоторые концепты нахер убивают всю стилистику картинки.

Без дополнительных лор, или без форсирования стиля художника, или некоторых других хаков она просто ееюзабельна.

P.s.О, новая капча, ура. Никакой больше арифметики.

Так ты задай категории в промпте и попроси классифицировать по ним. Ёб твою мать, Вася, это же универсальная визуальная модель.

Отличить кошку от собаки и автомобиль от человека может да. Но что-то более сложное сразу пасует.

Попроси мультимодалку выставить оценку пикче по критериям направлений стиля, эстетики, сложности/качества фона, степени детализации, можно в количественном выражении. Получишь эпичный рандомайзер где все хорошее.

Лол. В лаве так-то визуальная модель и есть CLIP, он классифицирует пикчи перед тем как передать их в адаптер, который преобразует уже всё это в токены для LLM. Причём LLM очевидно будет обсераться, потому что для классификации текста есть совсем другие модели.

> он классифицирует пикчи

Значение знаешь?

> преобразует уже всё это в токены для LLM

Проектор_активаций

> потому что для классификации текста есть совсем другие модели

Зачем?

Да нахуй ты ллаву свою тащишь, попробуй уже CogVLM или жопоту-4.

> Проектор_активаций

Каких активаций, шизоид? Активация - это функция. Куда ты её проецировать собрался? На выхлопе визуальной модели вероятности.

> Зачем?

Для того чтобы классифицировать текст по категориям? LLM с этим очень плохо справляются, половина даже не проходит тест про отзыв на ресторан, не говоря уже про что-то сложное.

> CogVLM

Там точно такая же мультимодалка с клипом и LLM.

Эксперт по классификациям в треде, все в клип.

Принимай струю в лицо.

>Попроси мультимодалку выставить оценку пикче по критериям направлений стиля, эстетики, сложности/качества фона, степени детализации

Ну попросил. Не знаю что я должен был получить.

Есть принципиально 2 подхода - либо ты точишь кастомную модель чисто под свои коробки, шляпы и машины, либо делаешь фундаменталку которая знает всё про всё. Вот VLM это второй, и я не понимаю с каких таких хуёв ты решил что оно прям не подходит для какой-либо задачи.

>можно в количественном выражении

Она может и не в количественном, у неё на удивление заебательское понимание мира.

>Получишь эпичный рандомайзер где все хорошее.

Рандомайзер там только в том, что у неё нет морального опорника что есть хорошо а что есть плохо, что лично для тебя много деталей а что мало. Это нетюненная модель, не особо точёная под красоту ответа. Это становится понятно как только ты просишь её объяснить свою классификацию, и понимаешь что она даже когда ошибается с твоей точки зрения, её выводы имеют некий смысл с её точки зрения ненаправленного хаосита без RLHF/элайнмента, и она на самом деле прекрасно видит что изображено на пикче и умеет делать довольно сложные выводы. На самом деле надо делать наоборот, сначала спрашивать что на пикче, а потом просить вывести рейтинг, у меня на скринах ошибка и рейтинг находясь в контексте делает объяснялово пост-рационализацией. Но наоборот оно тоже примерно так же работает. Так что если тебе надо что-то специфичное - просто тюнишь её. Или составляешь композитный эмбеддинг из трёх пикч, в которой две пикчи референсные для пояснения крайностей по шкале, а одна это твой инпут.

А вообще надо было спросить сначала что именно анону нужно, а то развели тут. Если капшионинг датасета, то CogVLM это тащемта самое пиздатое решение для всего кроме маняме, для маняме и какой-то узкой специализации его придётся тюнить.

>Там точно такая же мультимодалка с клипом и LLM.

Самое главное что ллава говно, а ког не говно.

Чтоб не было вопросов по её пониманию мира.

О том и речь, мультимодалка способна выполнять крайне ограниченный набор действий, и в той же классификации малопригодна если речь не идет о радикально разных вещах.

> я не понимаю с каких таких хуёв ты решил что оно прям не подходит для какой-либо задачи.

Думаю ты сам это понял когда собирал подобные черрипики, скорми ей какую-нибудь дижитал срань из сплошного шума - она с радостью расскажет насколько он детален, а гладкую фотку с подробным лендскейпом забракует, сказав что оно монотонное. Оно даже не всегда способно отличить бекграунд от объекта с точки зрения свойств, и это самая лучшая из моделей.

> её выводы имеют некий смысл

С таким же успехом можно приказать обычной ллм аргументировать почему "сцена из таверны" имеет детальный задник или еще какой-то атрибут, и на выходе будет что-то похожее на осмысленное.

> А вообще надо было спросить сначала что именно анону

Этот вопрос уже есть.

Я ничего и не черрипикал особо, тупо закинул рандомные пикчи из мемных папок.

Ну да, ЛЛМ тоже имеют примерно подобное понимание.

>скорми ей какую-нибудь дижитал срань из сплошного шума - она с радостью расскажет насколько он детален, а гладкую фотку с подробным лендскейпом забракует, сказав что оно монотонное.

Я хз о чём ты. Я вообще нить потерял, что ты предлагаешь взамен вообще? Или посыл в том что всё говно? Ну да, AGI пока не изобрели.

Еще давно, а потом и недавно пытался приспособить мультимодалку под классификацию и оценку - не, без шансов. Только совсем разнородные вещи, при том что может хорошо отвечать по отдельным деталям и разглядывать даже человеком не замечаемые мелочи. Нет там абстрактной оценки или чего-то подобного, максимум на что может это с некоторой точностью сказать про "общее настроение картинки", и то там скорее cot по написанному ранее описанию работает, зирошотом фейлы частые.

В том и посыл, даже сраный клип если делать ранжирование по заготовленным фразам может оказаться как минимум не хуже.

>Если же тебе нужна классификация - в принципе мультимодалка тоже это сможет, но менее точно и медленнее чем обученный под задачу визуальный трасформер.

Причём здесь архитектура-то? Мультимодальность это просто работа с несколькими модальностями. К конкретной архитектуре она не относится от слова никак.

https://en.wikipedia.org/wiki/Multimodal_learning

Sora, SD3 - мультимодальные визуальные трансформеры, например.

> Причём здесь архитектура-то?

К тебе этот вопрос, ведь ты про архитектуру заговорил. Если что там речь про класс визуальных моделей на трансформерсе, которые созданы для той задачи.

какая сейчас самая оптимальная бюджетная карта будет для покупки? все так же 3060 12 гб колорфул супермегапромакс с озона за 28к и cmp 40hx из под майнера или есть лучше варианты? чтобы генерить относительно комфортно и лорки обучать

3060\4060.

Смотри на память и производителя.

Минимально комфортная память - 12 (лучше 16, с 8 заебешься), производитель - НВидия.

да я в курсе за карты, просто спросил может скидки какие есть, хидден гемы или может амдшное говно оптимизнули под сетки нормально (не слежу за красными картами)

конкретно вот эту уже и так покупал https://www.ozon.ru/product/colorful-videokarta-geforce-rtx-3060-12-gb-igame-geforce-rtx-3060-ultra-w-12g-335136034/ , топ карточка за свою цену если задача новое брать

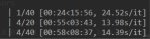

Сколько она кстати итераций выдаёт в стоковых 512/1024 эйлер а, с 1.5/ХЛ?

Мимо

Стабилити высрали пейпер с архитектурой SD3.

https://stability.ai/news/stable-diffusion-3-research-paper

https://stability.ai/news/stable-diffusion-3-research-paper

вот так уот, 1.5 дефолт, эйлер а, иксформерсы вкл, вае для чистоты эксперимента убрано

О, текст. Главное чтоб нсфв было на месте.

Экспериментрую с кодингом трехмодельных мерджеров, и совершенно случайно обнаружил интересную простую функцию, которая делает интересные вещи

конкретно это merged_model[key] += finetune_scale * model_b_diff, где model_b_diff = model_b[key] - model_c[key]

То есть по факту матетически она умножает вычлененные веса из модели Б на цифорку и они уже результируются в конечную модель.

Что это дает: пик 1 рвижн, пик 2, епигазм, пик 3 результирующий "файнтюн", только токены позитива woman, colorful, 20 шагов

Симилярити показывает что различие финальное модели по блокам 20 процентов, но конститенция, четкость и что самое главное разнообразие, в том числе на более сложных/более описываемых промптах разительно лучше по итогу получается. Не могу понять в чем прикол, это что получается если втупую умножат веса моделей и не трогать клип, то сетка делает лучше? работает данный метод правда не со всеми моделями, а если веса нормлаизовывать по гауссу то будет лучше чем ориг модели но разнообразие уменьшается

конкретно это merged_model[key] += finetune_scale * model_b_diff, где model_b_diff = model_b[key] - model_c[key]

То есть по факту матетически она умножает вычлененные веса из модели Б на цифорку и они уже результируются в конечную модель.

Что это дает: пик 1 рвижн, пик 2, епигазм, пик 3 результирующий "файнтюн", только токены позитива woman, colorful, 20 шагов

Симилярити показывает что различие финальное модели по блокам 20 процентов, но конститенция, четкость и что самое главное разнообразие, в том числе на более сложных/более описываемых промптах разительно лучше по итогу получается. Не могу понять в чем прикол, это что получается если втупую умножат веса моделей и не трогать клип, то сетка делает лучше? работает данный метод правда не со всеми моделями, а если веса нормлаизовывать по гауссу то будет лучше чем ориг модели но разнообразие уменьшается

что я имею в виду под разнообразием, вот допустим базовый промтп с teacher, classroom, практически все бейс модели делают плюс минус одно и то же, одни и те же позы, задники, цветокор, и т.д., в общем косистенция на месте, но разнообразие хождения сетки по сиду очень скудное, третий вариант это -20% симилярити модель

пик 1 база, пик 2 база, пик 3 измененная модель, пик 4 рандом сид

Я что то всегда думал что она чуть шустрее, ну да ладно. Уж не знаю хайден гем это для тебя или нет, но можешь ради интереса глянуть базу лама треда в виде tesla p40, это самые доступные и универсальные 24гб от нвидии из б/у в данный момент. Подводных тоже дохуя конечно, из коробки ей придётся колхозить охлад, в стоке она идёт на полном пассиве, нужна мамка с above 4g encoding и проц с avx. Ллмки до 34б влезают и "летают" по сравнению с процами с 10+ т/с, с сд дела печальнее, всё таки это паскаль и не может быстро в fp16, работает быстрее в fp32 с новым фордж уи 3.75 ит/с с 1.5 моделью из моих тестов, особо карту пока не мучал, как охлад приделаю, буду подробнее тестить.

Интересно, а какие нибудь далёкии друг от друга модели по типу анимейджен3 и понив6 пробовал таким образом замешать? У них даже клип пиздец как отличается, у пони он чуть более универсальный и натасканный, и вообще модель в целом в любой "стиль" может, от фулл флэта до фулл реализма, из того что я видел.

> у пони он чуть более универсальный и натасканный

Впечатление полностью противоположное. На пони он может просто все поломать если попадется неудачный оверфитнутый тег, рандомно словить цветные пятна. Сама по себе модель не способна выдавать что-то приличное и только дотреном, лорами и мерджами можно ограниченно вернуть к жизни лоботомированные части или замаскировать. Не умоляю ее плюсов, но это факт. Анимейджин же легко управляется, способен воспринимать концепты из обычной sdxl и воспроизводить их в 2д стиле, лучше работает с натуртекстовыми сложными конструкциями, хорошо с другими моделями мерджится и обучается.

Впечатление "разнообразие" только потому что модель на хайпе сисик@писик и с ней очень много носятся все прощая.

На их жизнеспособный мердж тоже интересно было бы посмотреть.

Правильно ли я понимаю лор DPO?

В SD забит мусорными данными капча-картинки, всратые детские арты и т.д и ошибочным описанием (captioning) этих пикч. А DPO это вручную выбранные и подписанные картинки.

Второй вопрос почему DPO так слабо влияет на результаты если сравнивать с другими файнтюнами SD? На пикчах видно что освещение и цвета и стиль остаются теми же.

Попытался поставить Stable Diffusion на Линуксе, ибо амд вместо видеокарты, но только заебался. Держу в курсе.

Сначала сраный Гном просто скрыл возможность подключения к сети по PPPoE. Потом разбирался с этими охуительными линуксными разрешениями на каждый чих, чтобы засунуть конфиг от Арча в нужную папку, только чтобы выяснить, что на Мандяре он не пашет as is. Кеды, которые были спрятаны за названием Plasma (я ебу, что ли, что это так их пятая версия называется?) подключить сеть позволили, но хуй пойми как SD там ставить, гайды в сети в этом плане совершенно невнятны, а у Форджа даже инструкции для линукса нет! На попытке склонировать депозиторий Кузни и запустить вебуй.пш я иссяк - процесс запускается, но вылетает с

× pip subprocess to install build dependencies did not run successfully.

│ exit code: 1

╰─> [3 lines of output]

Looking in indexes: https://download.pytorch.org/whl/rocm5.4.2

ERROR: Could not find a version that satisfies the requirement setuptools>=40.8.0 (from versions: none)

ERROR: No matching distribution found for setuptools>=40.8.0

при том что сетаптулзы стоят (версии 60 с чем-то), колесо, которое упоминается в нагугленных попытках решения - тоже. Завтра может ещё с Анкомфи поебусь и попробую Мятой обдолбаться вместо Мандяря. Всё, побаттхёртил, спасибо за невнимание.

Сначала сраный Гном просто скрыл возможность подключения к сети по PPPoE. Потом разбирался с этими охуительными линуксными разрешениями на каждый чих, чтобы засунуть конфиг от Арча в нужную папку, только чтобы выяснить, что на Мандяре он не пашет as is. Кеды, которые были спрятаны за названием Plasma (я ебу, что ли, что это так их пятая версия называется?) подключить сеть позволили, но хуй пойми как SD там ставить, гайды в сети в этом плане совершенно невнятны, а у Форджа даже инструкции для линукса нет! На попытке склонировать депозиторий Кузни и запустить вебуй.пш я иссяк - процесс запускается, но вылетает с

× pip subprocess to install build dependencies did not run successfully.

│ exit code: 1

╰─> [3 lines of output]

Looking in indexes: https://download.pytorch.org/whl/rocm5.4.2

ERROR: Could not find a version that satisfies the requirement setuptools>=40.8.0 (from versions: none)

ERROR: No matching distribution found for setuptools>=40.8.0

при том что сетаптулзы стоят (версии 60 с чем-то), колесо, которое упоминается в нагугленных попытках решения - тоже. Завтра может ещё с Анкомфи поебусь и попробую Мятой обдолбаться вместо Мандяря. Всё, побаттхёртил, спасибо за невнимание.

Сап дефузач. Собсно назрел вопрос, как строго делить деятельность для действующих лиц? К примеру, делаю двух охуевших викингов, хочу чтобы у одного был топор в руке и он им махал, в тот же момент другой должен быть с мечом который возводит его к небу. Они не должны пиздить оружие/дейтельность/позы/одежду друг у друга, или смешать это в какую-то жижу. Каждый отдельный персонаж должен делать строго то что ему прописано. Есть ли какие-либо хитрые промты для этого?

https://stable-diffusion-art.com/regional-prompter/

В анкомфи вроде можно чисто промптом и лапшой, но это спрашивай у тех, кто им пользуется.

ну комплексные композиции ток через контролнет можно сделать нормально

Мультидиффужн тоже в регионы может.

Причем даже с лорами, насколько я помню.

Причем даже с лорами, насколько я помню.

>анкомфи

Наверное проще жопу в рабство продать чем в этих макаронах копаться.

Ну, для ленивых и неразборчивых в анкомфи есть вариант пользоваться уже готовыми упаковками рамена. В официальных был кстати и с региональным промтом.

Бля аноны, опять жопе не сиделось, обновил каломатик до release_candidate.

Он заставил меня установить торч (2.1.2), ит/с упало с 18 до 9.

Че делать?

Куду актуальную вбросил, причем теперь ему нужна 12-я.

Поделитесь хотя бы номером/хешом версии, например где фильтр по папке в лорах был все еще кнопками, а не ебучим деревом.

Он заставил меня установить торч (2.1.2), ит/с упало с 18 до 9.

Че делать?

Куду актуальную вбросил, причем теперь ему нужна 12-я.

Поделитесь хотя бы номером/хешом версии, например где фильтр по папке в лорах был все еще кнопками, а не ебучим деревом.

Сам кажись нашел версию, v1.7.0 была

Уже 1.8 вышла в релиз

>фильтр по папке в лорах был все еще кнопками, а не ебучим деревом

Так оно и сейчас кнопками вроде.

Всё ж переключается рядом со строкой поиска.

Вот за то, что они это поле поиска вправо перенесли, вместо того чтоб рядом с кнопкой включения лор оставить - я ручки кое-кому поотрывал бы.

Что там на широкоформатниках происходит - вообще представить страшно, это же в другой конец экрана мышкой возить каждый раз...

Почему не тренируют модели на разных разрешениях 512, 768, 1024 чтобы можно было генерировать в любом разрешении?

Это не проблема в SD 1.5, есть куча инструментов чтобы генерить в любых.

SDXL литералли тренирована так как ты говоришь.

SD3 должна быть нечувствительной к разрешениям, если я правильно понял их писулю.

блять в какой форме находятся данные концептов в текстовом енкодере модели? а то написал скриптуху которая берет все ключи начинающиеся с cond_stage_model.transformer.text_model из енкодера, а они в каждой модели похоже одинаковые значения веса имеют и при смешивании двух енкодеров нихуя практически не делается, что за магия

Кто-то может запилить расширение, которое будет поддерживать удаленный контролнет face (identity) для Stable Cascade?

Стабилити удалили данную модель из huggingface до того, как релизнуть Stable Cascade, но они видимо не знают, что в истории хаггингфейса все остается и можно скачать данный контролнет по этой ссылке на предыдущий коммит

https://huggingface.co/stabilityai/stable-cascade/tree/e16780e1f9d126709c096233d96bd816874abef4/controlnet

Для заинтересованных питонщиков, сейчас поддержка других официальных контролнетов для Stable Cascade запилена в ComfyUI

https://github.com/comfyanonymous/ComfyUI/commit/03e83bb5d052be16aaad7599ffeb1eade9481508

Также по всей видимости, Stabilty забыли удалить код для запуска identity (face) контролнета с официального гитхаба

https://github.com/Stability-AI/StableCascade/blob/master/inference/controlnet.ipynb

https://github.com/Stability-AI/StableCascade/tree/master/configs/inference

Осталось только объединить эти две вещи и мы получим первую рабочую официальную модель от Стабилити для копирования лиц.

Стабилити удалили данную модель из huggingface до того, как релизнуть Stable Cascade, но они видимо не знают, что в истории хаггингфейса все остается и можно скачать данный контролнет по этой ссылке на предыдущий коммит

https://huggingface.co/stabilityai/stable-cascade/tree/e16780e1f9d126709c096233d96bd816874abef4/controlnet

Для заинтересованных питонщиков, сейчас поддержка других официальных контролнетов для Stable Cascade запилена в ComfyUI

https://github.com/comfyanonymous/ComfyUI/commit/03e83bb5d052be16aaad7599ffeb1eade9481508

Также по всей видимости, Stabilty забыли удалить код для запуска identity (face) контролнета с официального гитхаба

https://github.com/Stability-AI/StableCascade/blob/master/inference/controlnet.ipynb

https://github.com/Stability-AI/StableCascade/tree/master/configs/inference

Осталось только объединить эти две вещи и мы получим первую рабочую официальную модель от Стабилити для копирования лиц.

Почему, сука, до сих пор никто не натренировал модель специально для создания персонажей/монстров к 2д играм с анимациями? Блядь показывают какие-то соры, какие-то пика, рунвеи и кучу других говно сервисов, но самое важное - анимированные персонажи и прочие 2д агнимацией спрайтовые для 2д игр, сука, никто не сделал до сих пор. Почему бля? Неужели из-за недостатка датасета? Там же не нужно даже разрешение, достаточно 64на64 квадрата, ну край 128на128 если пиксельарт стилистика.

а почему итт никто не перданул что стабилити пернуло каскадом который даже по дефолту дает всем пососать и даже подписочному говну? даже сисик может рисовать я боюсь представить что будет когда ее перетренируют под нсфв полностью через месяца два

>я боюсь представить что будет когда ее перетренируют под нсфв полностью через месяца два

теперь этого уже не будет никогда, так как скоро уже релиз SD3