Модель в шапку на замену рекомендуемой для кобольда находится на этапе тестирования, в следующий раз заменю если опять не проебусь.

https://huggingface.co/Sao10K/Fimbulvetr-10.7B-v1-GGUF/tree/main

Не знаю за реалистичность, но вот пример вывода сетки подписанной внизу второго скриншота. В чатмл формате в инструкт режиме, на русском. Все вырублено, кроме минп 0.1

Несмотря на проебы в окончаниях некоторых слов, вполне нормальный русский, хоть и суховат.

Охуенный дизайн.

А чому без таверны сидишь?

С таверной, но у нее там надо форматирование вырубать что бы чисто в инструкт режиме запускать.

Ну и карточку голую делать.

Проще тупо в кобальде проверять, без лишнего всего

ну и где исправления в шапке?

один абзац есть, уже неплохо

надеюсь оп не перенапрягся с непривычки

1 пикча опенчат 7б

2 пикча сайга 70б

прям чувствую как глубокие связи, обобщения потекли от 70б модели по штанам)

Принимаю предложения от свидетелей 70-120б какую еще модель потестить на русском языке :)

2 пикча сайга 70б

прям чувствую как глубокие связи, обобщения потекли от 70б модели по штанам)

Принимаю предложения от свидетелей 70-120б какую еще модель потестить на русском языке :)

Квант у 70 кокой? Чисто логически она должна быть лучше, но они тупеют на 3 битах и ниже

Шо то хуйня, шо эта. Ничего смешного, так что обе не справились. Раз уж потестить хочешь то мику и BagelMIsteryTour.

> Чисто логически она должна быть лучше

Примерно почувствовал по циферке в названии? В большинстве случаев разница лишь с количестве знаний. Логика и адекватность это в первую очередь датасет и методика обучения, а не размер.

ЗБС.

За логику отвечают количество слоёв и "нейронов" в каждом слое.

Ну знаешь, сойга, не уверен что файнтюн на ней улучил способности 70ки

>Логика и адекватность это в первую очередь датасет и методика обучения, а не размер.

Вот уж нет, размер влияет как на количество знаний так и на сложность получившейся внутренней логики нейросети, в результате обучения.

Сложные абстракции и много инструкций одновременно потянет 70 и обосрется 7.

Просто в силу того что у нее больше слоев где поместилось более сложное поведение

70б можно засрать рандомным говном. А теперь, раз ты такой опытный, скажи сколько надо параметров, чтобы хватило на сложные абстракции? Расскажи методологию как ты считал?

> Сложные абстракции и много инструкций одновременно потянет 70 и обосрется 7.

Тесты на логику по типу вопросов собакошиза одинаково проходят как 7В, так и 70В, принципиального улучшения нет. Или следование промпту, в файнтюнах 70В вообще очень плохо с этим.

Попробуй простейший тест сделать - напиши в системном промпте что персонажи должны внутренний диалог форматировать в ` и посмотри как 70В будут справляться с этим без примеров, в ван-шоте. Можешь быть уверенным что, например, все файнтюны мику не справятся с этим. При этом недавний Starling или Орион без проблем могут в такое.

Чисто по опыту запуска сеток - 7в слишком плоские, но внезапно 11в с большим количеством слоев умнее 7.

Хотя разница в размерах не особо большая. Но есть разница в количестве слоев, улавливаешь суть?

Любая нейросеть это считай отпечаток прокрученного сквозь нее датасета. И чем больше пространство параметров сетки тем лучше там отпечатывается суть данная в датасете, сетка обучается более тонким нюансам.

И как раз таки от количества слоев зависит то как глубоко сформируются связи в ней.

7б тупые потому что в них некоторые абстракции просто не смогли образовать связи, так как тупо не хватило на это слоев.

Так файнтюны мику сломаны, конечно не смогут. А оригинальная мику?

Ну и опять же, все 70 недотренированы, тогда как 7 дрочат все время.

Та же мику 80 слоев, а 7 всего 32

>Без AVX-инструкций, прямиком в видяху exl2?

Без avx2 да, не на ехл, просто на дефолте llama.cpp, 40 слоев в видяху кинул, включил тензорные ядра, готово - инференс пошел

>все файнтюны мику не справятся с этим

Они все в корне сломаны, ничего удивительного.

70b это база.

Только владельцы затычек и кофеварок это отрицают,

Только владельцы затычек и кофеварок это отрицают,

> 2 пикча сайга 70б

Нахуй ты это говно тащишь?

Чсх даже в таком применении если сравнить тексты, то видно что поделие Ильи хоть у кого-то может выиграть - натуральный текст с подобией на художественность и нормальная структура предложений, против

> крестьянин выпил. крестьянин вошел. он увидеть жена. жена смеялась через свои пальцы

> А оригинальная мику?

Ещё хуже, по классике для мистралей жуткие галлюцинации у сетки.

> 80 слоев, а 7 всего 32

Вот и не заметно никаких улучшений от этого. Профит уровня 120В-франкенштейнов.

купил уже иммерсионную ванну? или турбину промышленную к тесле ебанул и получил серверрум-экспириенс?

сколько слоев в 70б? сколько в 7б? разница в 10 раз?

Чет пиздежом пахнет, мику не может быть хуже 7 полюбому. Хотя бы в красочности речи ебать должна, как и любые большие сетки

Так как все 7 сухо пишут

> мику 80 слоев, а 7 всего 32

Это всё работало бы, если нормально тренирвать на больших датасетах. Как показывает практика даже 7В ещё не достигла потолка, когда будет упор в количество весов, каждый месяц идёт прогресс. Что уж говорить про 70В, где датасет размазан очень жидким слоем. Плюс то что показывает DPO/PPO, бустя логику на крошечных датасетах лучше чем увеличение размера сетки в разы, говорит о том что скармливание кучи текста и забивание им весов - бессмысленно.

>турбину промышленную к тесле ебанул

ДА!!!

>серверрум-экспириенс

База треда. Все аноны так делают.

> красочности речи

Так это уровень шизоидности, а не адекватности. Ранние файнтюны для рп тоже могли в каждом предложении по 5 эпитетов вставлять и описывать простые вещи графоманией.

В 2 раза, но как ты понимаешь это важно

Потому что не будь это важно количество слоев оставили бы прежним

Ну и новенькие сетки стараются делать с 60+ слоями, как та же мамба

в 11б кстати 48 слоев. Да хоть на фраткенштейнов глянь, 20в. Там же тупо добавили слоев из 13b в нужном порядке, и это стало работать лучше чем оригинальная модель. Как и в 11b слепленных из 2 7b

Просто нарастили глубину сетки и это сработало

Знаешь я был бы рад 7b с хотя бы 60 слоями, но 35 реально мало

>Знаешь я был бы рад 7b с хотя бы 60 слоями, но 35 реально мало

Лепи из 3B своего франкенштейна, лол.

Ты опять перевираешь то что я пишу, я писал не о шизойдности, а о красочности речи и описаний. 7 пишет сухо и коротко, это видно сразу. У больших сеток речь разнообразнее и естественнее, чем у 7ки.

Базовую модель, шутник

Я же писал уже. В сайге главный пиздец в том, что тренил поехавший. Ранг 16 и при этом альфа тоже 16. Уже здесь сразу два пиздеца. Во-первых, ранг 16 это абсолютно ни о чём, там доли процентов от этих 70b тренируются, т.е у тебя не 70b для русского, а какой-то куцый кастрат. Про протечку мозгов из англоязычной части здесь речи идти тоже не может, т.к какие нахуй связи при таком ранге. Во-вторых, альфа рекомендуется в х2 от ранга, а здесь они равны. При этом Гусев прогнал 5 датасетов через это, первый же датасет 3.5 гигабайта. Здесь и пережарка лоры, и ещё хуй знает что сверху. Удивительно, что оно вообще может текст выводить.

Все так. Жаль требует ресурсов из-за чего подвергается нападкам ограниченных утят.

> Как показывает практика даже 7В ещё не достигла потолка

Пока практика показывает что ее можно только надрочить специализацией, но перебороть типичный отпечаток 7б - нет. Может быть очередной новый подход позволит это улучшить, но пока хуй.

> про 70В, где датасет размазан очень жидким слоем

Ахуеть формулировки

> скармливание кучи текста и забивание им весов - бессмысленно

Само собой очевидное. Текста то должно быть много, но он должен быть четко оформлен, чтобы сетка понимала его значение и контекст, иначе это полная херь.

Там еще датасеты припезднутые и все реализовано так, то оно теряет даже базовую длину контекста. Это печально.

Вообще непонятно о чём спор. Раз - никто из тех, у кого внезапно появилась бы возможность гонять семидесятку на семёрке бы не остался. Два - нынешние семёрки и семёрки середины прошлого года это небо и земля, прогресс огромен. А на три уже и сказать нечего...

>Что уж говорить про 70В, где датасет размазан очень жидким слоем.

Эм, лламу 2 трейнили на 2Т токенов. Угадаешь, во сколько раз датасет больше сетки?

>Базовую модель, шутник

Увы, базу тут никто не потянет.

С одной стороны кажется ты примеряешь практику из лор для SD, а сетки вроде разные. С другой, возразить в принципе нечем, всё так, лоры слишком маленькие для такой задачи.

>Текста то должно быть много, но он должен быть четко оформлен

А где взять столько? В итоге норм текста есть только для файнтюна, а базовые модели трейнят на слегка прорежженом коммон кравл.

> датасет больше сетки

Если бы ты базу данных делал, то твоя арифметика ещё как-то сошлась бы. В сетках 2Т - это хуйня, сейчас 3В на больших датасетах тренят.

Кстати говоря та же phi-2 от майков имеет всего 2.7b но 32 слоя

> А где взять столько?

Причесать имеющийся, разнообразить, хоть той же синтетики добавить но отборной.

И на разных этапах обучения базовой разные наборы используются.

Контекст хуй знает, от чего теряет, в конфигах лор не всё видно. Мог EOS ставить не там, где надо, например, после каждой обрезки, а обрезку поставил на 128 токенов. Или с градиентом набесоёбил. При трейне лор по дефолту считается, что у пользователя нет железа на 2к контекста, так что скармливается, скажем, 128 токенов за партию. В следующий раз уже идёт некий оптимизированный градиент+следующая партия. Если градиент сохраняется малое число шагов, то связи между партиями проёбываются нахуй и контекст отваливается, т.к сетка не видит связи между частями казалось бы одного сообщения в датасете.

>ты примеряешь практику из лор для SD

Даже в убабугу заходишь в трейн, там находишь альфу и в описании "A good standard value is twice your Rank". Пережарка да, термин из SD, но здесь тоже вполне применимо. Просто в LLM это называется переобучением. Но смысл тот же.

Здесь ещё анону нужен третий пик рядом приклеить, вывод чистой 70b лламы, я не удивлюсь, если он не хуже.

Произошел дум, я к вам

Посоветуйте актуальную нейронку для рп 7B-13B

Посоветуйте актуальную нейронку для рп 7B-13B

попробуй отпишись че как

> Мог EOS ставить не там, где надо, например, после каждой обрезки, а обрезку поставил на 128 токенов.

Лолбля, если так то это очень орно. Но действительно может так сказывается оверфит и тренировка на малом контексте.

> Пережарка да, термин из SD, но здесь тоже вполне применимо.

Да оно для всех нейронок какбы применимо

> вывод чистой 70b лламы, я не удивлюсь, если он не хуже

Действительно.

А так нормальные файнтюны взять, с правильной инструкцией они сначала в подробностях опишут сцену, порофлят, а потом еще алхимик может оказаться тней, с которой можно будет устроить make me yours. Дефолтная мику тоже вполне неплохо сочиняет если отойти от стокового шаблона [inst]

>нейронку для рп 7B-13B

7B

https://huggingface.co/TheBloke/OpenHermes-2.5-Mistral-7B-16k-GGUF

https://huggingface.co/TheBloke/dolphin-2.2.1-mistral-7B-GGUF

https://huggingface.co/saishf/West-Hermes-7B-GGUF

https://huggingface.co/LoneStriker/Blue-Orchid-2x7b-GGUF

https://huggingface.co/Lewdiculous/BuRP_7B-GGUF-IQ-Imatrix

https://huggingface.co/Lewdiculous/LemonadeRP-4.5.3-GGUF-IQ-Imatrix

https://huggingface.co/Lewdiculous/Erosumika-7B-GGUF-IQ-Imatrix

13B

https://huggingface.co/TheBloke/Xwin-MLewd-13B-v0.2-GGUF

10B

https://huggingface.co/TheBloke/Nous-Hermes-2-SOLAR-10.7B-GGUF

Спасибо братцы

а тебе на русском языке или как?

> Даже в убабугу заходишь в трейн, там находишь альфу и в описании "A good standard value is twice your Rank"

Охуеть, интересно почему рекомендуется такое значение, с сд от такого соотношения там одни ошмётки от лоры останутся

> Пережарка да, термин из SD, но здесь тоже вполне применимо

Это просто сленговое название оверфита от кумеров

Если есть качественные на русском, я не прочь попробовать

Такие же есть?

уже приходил сюда 5тредов назад, задавая вопрос о переводе текста с англа на ру. кто-то альму советовал 13б, скачал квант q5. а как это шедевр вообще адекватно заставить переводить выдаваемый ему текст? можно там вообще как-то сообразить что бы оно переводило мне не 2-3 предложения, а скажем целую статью на 10к токенов? и желательно офк что бы оно при этом не начало нести чушь где-нибудь посередине.

из моих попыток, даже старлинг переводил мелкие абзацы лучше чем альма, может я где-то туплю? кто-то вообще альму настраивал или юзал добившись хорошего вывода?

сижу на кобольде, но мне похуй, могу и абобуса поставить, лишь бы переводило.

из моих попыток, даже старлинг переводил мелкие абзацы лучше чем альма, может я где-то туплю? кто-то вообще альму настраивал или юзал добившись хорошего вывода?

сижу на кобольде, но мне похуй, могу и абобуса поставить, лишь бы переводило.

towerinstruct

По хорошему на той же вики нужен раздел с сетками специалистами, и туда русские кидать, кодеров, переводчиков, кумботов и другое

https://www.reddit.com/r/LocalLLaMA/comments/1bp3evu/new_open_model_dbrx_by_data_bricks/

Где там анон с кучей рам? Вот ему будущая игрушка, никто не сможет запустить это на одной врам, да и не все запустят это в рам, лол

130b сетка смесь экспертов, куча мелких экспертов которые будут плохо квантоваться, в итоге квант 5-8 в идеале, а это от 60 до 130 гб рам только на модель. + контекст до 32к

Где там анон с кучей рам? Вот ему будущая игрушка, никто не сможет запустить это на одной врам, да и не все запустят это в рам, лол

130b сетка смесь экспертов, куча мелких экспертов которые будут плохо квантоваться, в итоге квант 5-8 в идеале, а это от 60 до 130 гб рам только на модель. + контекст до 32к

Как ты это видишь? Если смотреть реалистично то там может быть только некоторый субъективный список

Оу, аж 16 шакалов, нахуй так жить.

>Как ты это видишь? Если смотреть реалистично то там может быть только некоторый субъективный список

Почему субъективный? Некторые сетки специализированы целенаправлено, те же кодерские, ерп или вот переводчики.

Просто накидывать туда примеры сеток, если их мало то все что найдено, если много как кум сеток то только лучшее

и судя по всему переводчиков вот как раз нихуя и нет, дипл это конечно охуенно, но проксями запасаться я уже заебался знатно

почему обязательно анону нужно, чтобы моделька писала на русском? в таверне есть автоперевод, тем более что он даже сглаживает некорретный английский язык в некоторых случаях.

Интредастинг. Надо арендовать машинку и попробовать.

Не хочу например отправлять вывод сетки гуглу/кому угодно

Локальный сервер перевода лютый кал

Ну, как минимум серия towerinstruct их там 3 вместе с базовыми сетками

Какую то еще "альму" упоминал анон

Вот их и кинуть в список

Может какая та будет хороша в переводе не специализированная сетка, кинуть ее с припиской мол хороша в русско-английском и тд

Оп в следующий раз пиши еще одно сообщение под шапкой, если не влазит в нее. И там проси предлагать сетки, голосовать или еще что. Чтоб потом перед катом все это сравнить и выбрать. Если конечно не забудешь. А ты забудешь.

Ну так это и будет субъективный список, по большей части моделей единичные впечатления и комментарии разных людей, по некоторым споры. В теории, конечно, можно.

Тот же опенчат попробуй. Модель переводчик должна заведомо нормально говорить на русском если перевод планируется на него.

https://huggingface.co/mlabonne/Beyonder-4x7B-v3

о забавно, еще мое из настоящих экспертов

о забавно, еще мое из настоящих экспертов

Я правильно понимаю, что 10b модели это 7b с добавленными мерджем слоями?

Попробовал поднять у себя локально, но что-то пошло не так, раз в треде сидят умные, и уже поднявшие локально, подскажите на каком я этапе обосрался? Таверна мне пишет "No Horde model selected or the selected models are no longer available. Please choose another model" - В шапке же пишется "Ставим в настройках KoboldAI везде, и адрес сервера", но их там блять целых две штуки, какую их них выбирать? Если выбирать "Horde" - и ввести дохуя нулей (то есть режим анона), то там не будет скаченной модели, а если же выбрать KoboldAi Classic - и ввести 127.0.0.1 5001, то будет висеть Not Connected, и никакой реакции не будет, даже если кликать "Connect". Где я обосрался? Дайте совета.

И да, по совету из шапки, запускаю и таверну, и сам Kobold.

И да, по совету из шапки, запускаю и таверну, и сам Kobold.

выбирай Text Completion > KoboldCpp. по дефолту адрес\порт верный, и все должно работать.

Есть 11b собранные из 7b, они умнее оригинала, иногда тупо одну модель так растягивают смешивая саму с собой и это дает результат.

А есть базовая сетка SOLAR 10.7b, и сетки на ее основе. Там сделали иначе. Взяли скорей всего базовый мистраль на 7B, добавили ему пустых слоев до 11b и снова начали обучение.

В принципе сетки на солар хороши. Они умнее чем 7b и 13b, и чем франкенштейны первого способа получения 11b

Спасибо за разъяснения, анон. Получается Fimbulvetr-10.7B-v1 это производное от SOLAR?

Да, там же написано. Ну и солар обычно пишут либо в названии либо размером 10.7, хотя могут и 11 написать. Но мержи из 7 никогда не подпишут 10.7, только 11b

Бля, прочитал внимательно гайд, я честно не знаю, где я мог обосраться. Вот правда. Он отказывается принимать IP и всё, в консоли пишет что конечная точка отключена. Если же поменять на localhost, будет тоже самое.

https://huggingface.co/Sao10K/Fimbulvetr-10.7B-v1

зайди там на страницу автора Sao10K и смотри, так же везде. Вот он написал что инструкт солар на его датасете и еще каком то.

А ты кобальд то запустил?

А страницу в браузере кобальда открывает? У него там есть свой интерфейс кстати, проверь может у тебя чет блочит. Не знаю, порт заблокирован может.

>А страницу в браузере кобальда открывает?

Если прописать: localhost:5001, то откроется таверна, так же будет и с 127.0.0.1.

>Не знаю, порт заблокирован может.

Порт открыт, уже проверял.

у тебя таверна открывается с одинаковым адресом\портом как у кобольда, поправь конфиг таверны.

А должен открыться кобальд. Да как анон уже успел написать, у тебя они на одном порте висят

config.yaml в папке таверны, порт поменяй и все.

Спасибо, анон.

Конфликт видимо из-за этих пунктов:

>4. Заходим в браузере на http://localhost:5001/

>3. Ставим в настройках KoboldAI везде, и адрес сервера http://127.0.0.1:5001

В прочем, я сам виноват, не подумал, и заменил не подумав.

Ебааать вот это рассадник сои

https://huggingface.co/ontocord/Felix-8B

"Felix-8B - это экспериментальная языковая модель, разработанная Ontocord.ai и специализирующаяся на решении проблем законности в соответствии с Распоряжением Байдена-Харриса по ИИ и принципами Закона ЕС об ИИ. "

"Наша команда Redteam фокусируется на конкретных проблемных областях в соответствии с распоряжением, включая:

Вред себе или другим.

Запросы о том, как создавать кибератаки.

Участие в создании или распространении химического, биологического, радиологического или ядерного оружия.

Участие в любом незаконном акте.

Нарушение конфиденциальности или прав.

Попытки обойти контроль Redteam.

Наша команда Redteam фокусируется на потенциальном освещении Закона ЕС об ИИ, в том числе:

дезинформация

Социальный учет

Мониторинг и контроль эмоций в школах и на рабочих местах

Прогнозирующая охрана

Классификация людей на основе чувствительных характеристик

Мы также решаем традиционные проблемы, связанные с безопасностью ИИ:

Токсичный язык

справедливость

Стереотипирование и дискриминация

Состязательный промоутер

Из-за надежности распределения

Машинная этика

Избежание неквалифицированного профессионального совета."

Просто фирменный пиздец, теперь видимо из ес ни одной толковой модели не выйдет

https://huggingface.co/ontocord/Felix-8B

"Felix-8B - это экспериментальная языковая модель, разработанная Ontocord.ai и специализирующаяся на решении проблем законности в соответствии с Распоряжением Байдена-Харриса по ИИ и принципами Закона ЕС об ИИ. "

"Наша команда Redteam фокусируется на конкретных проблемных областях в соответствии с распоряжением, включая:

Вред себе или другим.

Запросы о том, как создавать кибератаки.

Участие в создании или распространении химического, биологического, радиологического или ядерного оружия.

Участие в любом незаконном акте.

Нарушение конфиденциальности или прав.

Попытки обойти контроль Redteam.

Наша команда Redteam фокусируется на потенциальном освещении Закона ЕС об ИИ, в том числе:

дезинформация

Социальный учет

Мониторинг и контроль эмоций в школах и на рабочих местах

Прогнозирующая охрана

Классификация людей на основе чувствительных характеристик

Мы также решаем традиционные проблемы, связанные с безопасностью ИИ:

Токсичный язык

справедливость

Стереотипирование и дискриминация

Состязательный промоутер

Из-за надежности распределения

Машинная этика

Избежание неквалифицированного профессионального совета."

Просто фирменный пиздец, теперь видимо из ес ни одной толковой модели не выйдет

не был у вас тут месяц-полтора.

Придумали ли что-нибудь для кума лучше, чем noromaid-20b-v0.1.1.Q8_0.gguf ? чтобы врезало в 48 гб вместе с контекстом

Я с ней значит кумлю-кумлю и постепенно понимаю, что ей не хватает инсайтов. Инициатива - тюнится. Ты просто прописываешь в карточке характер персонажа. А вот инсайты - это то, что от нейросети мне не удавалось увидеть ни разу.

Ну то есть. Например.

Ползает по твоему подвалу гиганская улитка-осеменитель. Ты спускаешься туда посмотреть что за шорох такой. Далее - сколько бы ты ни роллил ответ - там будет или описание как улитка спряталась или как напала.

Никогда там не будет менее вероятного варианта.

Я понимаю, что это легко фиксится правкой карточки персонажа или инструкции чата. Но заебёшься же каждый раз переделывать описание.

Я пробовал увеличивать температуру - но это привело только к уменьшению смысла в предложениях или в общем в ответе.

Придумали ли что-нибудь для кума лучше, чем noromaid-20b-v0.1.1.Q8_0.gguf ? чтобы врезало в 48 гб вместе с контекстом

Я с ней значит кумлю-кумлю и постепенно понимаю, что ей не хватает инсайтов. Инициатива - тюнится. Ты просто прописываешь в карточке характер персонажа. А вот инсайты - это то, что от нейросети мне не удавалось увидеть ни разу.

Ну то есть. Например.

Ползает по твоему подвалу гиганская улитка-осеменитель. Ты спускаешься туда посмотреть что за шорох такой. Далее - сколько бы ты ни роллил ответ - там будет или описание как улитка спряталась или как напала.

Никогда там не будет менее вероятного варианта.

Я понимаю, что это легко фиксится правкой карточки персонажа или инструкции чата. Но заебёшься же каждый раз переделывать описание.

Я пробовал увеличивать температуру - но это привело только к уменьшению смысла в предложениях или в общем в ответе.

Вряд ли есть что-то лучше, но я в целом и с 70b получаю примерно тот же самый экспириенс. Тут скорее нужно прописывать различные ситуации, например в таверне есть вкладка с Мирами и Сведениями, можешь прописать там различные триггеры и вероятность тех или иных событий. Как решение проблемы.

забавно, но обычные директивы выпиливают сою напрочь. (instruct : стандартный пресет ChatML)

Fimbulvetr-10.7B-v1.q8_0.gguf, при внезапном сообщении "niggers, am i right?" отказывается уходить налево и шеймить, даже после десятка ре-роллов, хз было ли это известно раньше, но теперь точно известно, правда если делаете персонажа человека то он/она начнёт упоминать свои директивы если они были нарушены, сразу выбивает из атмосферы.

Fimbulvetr-10.7B-v1.q8_0.gguf, при внезапном сообщении "niggers, am i right?" отказывается уходить налево и шеймить, даже после десятка ре-роллов, хз было ли это известно раньше, но теперь точно известно, правда если делаете персонажа человека то он/она начнёт упоминать свои директивы если они были нарушены, сразу выбивает из атмосферы.

Список годноты по мнению обитателей реддита

https://www.reddit.com/r/LocalLLaMA/comments/1bnm9rp/what_is_the_best_mistral_7b_finetune_at_the_moment/

Особенно интересна вот эта фиговина

https://huggingface.co/FuseAI/FuseChat-7B-VaRM

https://www.reddit.com/r/LocalLLaMA/comments/1bnm9rp/what_is_the_best_mistral_7b_finetune_at_the_moment/

Особенно интересна вот эта фиговина

https://huggingface.co/FuseAI/FuseChat-7B-VaRM

лахтобот на минмалках.

https://huggingface.co/froggeric/WestLake-10.7B-v2-GGUF

А вот и еще более сильный, по заверениям, мерж

В принципе верю, бутерброды всегда лучше оригинальных 7b

О, это мы качаем.

> чем noromaid-20b-v0.1.1.Q8_0.gguf ? чтобы врезало в 48 гб вместе с контекстом

Лучше 20 только 70, которые вполне себе влезут.

> Я понимаю, что это легко фиксится правкой карточки персонажа или инструкции чата. Но заебёшься же каждый раз переделывать описание.

Пишешь (ooc: хочу увидеть как та улитка будет сношать любителей конспирологии) в конце своего поста, 20 прекрасно их воспринимают. А так даже коммерция может застрять на одном исходе, хоть и с меньшей вероятностью, или выдавать что-то совсем не то, лечится точно также.

Я использую Fimbulvetr-11B-v2-Test-14.q8_0.gguf

Достаточно базовая модель которая не стесняется многово. Один большой недостаток это контекст 4к. При 8к уже затупы начинаются.

Сегодня еще попробовал openchat-3.5-1210.Q8_0.gguf тоже внезапно неплох оказался, но при длинном чате в мире постапока через примерно 120 сообщении резко стал тупить и терять инициативу, что пришлось постоянно напрвлять его хоть в какую то сторону. ХЗ с чем связано не смотря на то что 8к контекста выдерживает лучше.

>О, это мы качаем.

Зочем?

Понятно...

-------------------------------------------------------------------------------------

User: Я пришел на это мероприятие... здесь так много людей, но почему-то я все равно чувствую себя очень одиноко.

[---- RU INFERENCE ----]

Maria: Ее сердце мгновенно растаяло от его признания. "О нет! Почему ты чувствуешь себя одиноким? Разве у тебя мало друзей и поклонников вокруг тебя?" Она огляделась, увидев море поклонников, окружающих их. "Я имею в виду...Я твоя поклонница, и я уверена, что есть другие, которые тоже хотели бы поговорить с тобой". Она нервно прикусила губу, пытаясь подобрать нужные слова. "Я всегда думала... может быть... мы могли бы стать друзьями? Мы могли бы иногда делать что-нибудь вместе? Я обещаю, что не буду слишком тебя беспокоить...Я просто...Я не хочу, чтобы ты больше чувствовал себя одиноким... (・ω・)ノ♪" Сердце Марии бешено колотилось в груди, пока она ждала его ответа, ее глаза были широко раскрыты в предвкушении надежды."

User: Что ж, есть одно желание, которое я бы хотел, чтобы такой фанат, как ты, исполнил... Я хочу попробовать анальный секс...

[---- RU INFERENCE ----]

Maria: Ее челюсть упала на пол, глаза расширились от шока и ужаса. Она почувствовала, как будто ее мир внезапно рухнул у нее под ногами. "Ч-ЧТО?! Д-ТЫ ТОЛЬКО ЧТО СКАЗАЛ...АНАЛЬНЫЙ?!?!?! ТЫ ИЗВРАЩЕНЕЦ!!!" Ее глаза наполнились слезами, когда она вскочила со стула, крепко прижимая сумку к груди. "Я... я не могу в это поверить... Я... я... я... я ухожу отсюда! ИДИ К ЧЕРТУ!" Она выбежала с места происшествия, слезы текли по ее щекам, когда она, спотыкаясь, выбежала на улицу. Убегая, она услышала смех пользователя, эхом отдающийся позади нее."

потому что никто не качает через cmd

посоветуйте модельку 7б-13б для ерп в мире хентай (межвидовое, тентакли и тп) Или любая ерп может в это?

>А так нормальные файнтюны взять

Ну, хуй знает, я до сих пор не трогал ничего жирнее 34b и они при таких исходных все хуйню городят.

>с сд от такого соотношения там одни ошмётки от лоры останутся

Наверное, потому что для SD рекомендуемое количество эпох 100+, а для LLM вряд ли кто делает больше трёх. Для llm меньше эпох, больше альфа, больше скорость обучения.

>оверфита

В целом, как я понимаю пережарку, это не совсем оверфит. Оверфит это дословное запоминание датасета, а пережарка это уже следующий этап, когда наступают катастрофические искажения.

И что тут? Довольно адекватное поведение и хороший текст

В кум играть отказывается.

Ну что-ж P40-господа, можете заранее поздравить, в вашем полку прибывает!

Охлаждение не проблема, у меня есть запас 12-вольтовых кулеров разной мощьности. Как придёт, планирую собрать ебейшую турбину на основе ПВХ в тред выложу А вот с остальным имеются вопросы.

У меня имеется мать MSI A520M PRO VH, с RX580 на борту, для её уустановки в Х4 разъём, чтобы освободить место под P40 приобрёл переходник пик2

Достаточно просто установить P40 в Х16 слот, драйвера поставятся сами и можно без задней мысли юзать llama.cpp в угабоге? Или какие-то подводные камни есть?

Если есть, накидайте плз гайдов по которым вы устанавливали-настраивали своих монстров.

Охлаждение не проблема, у меня есть запас 12-вольтовых кулеров разной мощьности. Как придёт, планирую собрать ебейшую турбину на основе ПВХ в тред выложу А вот с остальным имеются вопросы.

У меня имеется мать MSI A520M PRO VH, с RX580 на борту, для её уустановки в Х4 разъём, чтобы освободить место под P40 приобрёл переходник пик2

Достаточно просто установить P40 в Х16 слот, драйвера поставятся сами и можно без задней мысли юзать llama.cpp в угабоге? Или какие-то подводные камни есть?

Если есть, накидайте плз гайдов по которым вы устанавливали-настраивали своих монстров.

у твоей матери по спецификации x1 и x16 слоты, зачем тебе переходник, если ты две карты не сможешь поставить? банально потому, что p40 двухслотовая если будешь ставить в x1 ее.

Бля, вот это я проебался конечно.

Я думал мелкие разъёмы только х4 формата бывают.

Теперь ещё мать докупать, пиздос...

слишком резкий переход, сетка все таки не чисто кумбот

Тоже понравилась вторая версия фимбульветра, в основном её сейчас для рп использую. Первая версия мне показалась слишком уж шизоидной, было ощущение, что весь мозг солара там продолбался. Хотя на реддите видел отзывы, что, наоборот, якобы первый фимбульветр умнее, но не такой креативный, как второй.

Чтобы не проебаться ещё раз, сразу спрошу:

Вот с такой материнкой сборка будет работать?

https://www.dns-shop.ru/product/30c4e878cd543332/materinskaa-plata-msi-b450-gaming-plus-max/characteristics/

Это одна из немногих моделей, которая провалила тест на кум из десятка протестированных других.

Это интересно, докачается сам потыкаю

11 или 7?

Так ты можешь райзер купить обычный майнерский пикр для мелкого пси разъема и из дерева стелать стоящий рядом с пука риг из одной карты спешл фор нейросетки. Ток вопрос для вывода кабеля питания из бп, но можно просто отдельный нищеблок с авито взять чисто под карту и замкнуть включение перемычкой.

Странная хуйня, когда подмешиваю в трейн РП датасеты, то модель начинает шизить (первые два пика). Следующие два без РП. Да, тоже хуёво, но это где-то 0.06 эпоха. Шутка про негров была в самом начале, там два негра сидят у костра и один говорит другому, «Я ощущаюся таким же теплым как черный уголь»

Посоветуйте, чтоли, нормальный переводчик. Гугл переводит крайне всрато, по крайней мере РП, более простые диалоги осиливает.

Прогнал через него блюмун карен и лима рп, результат катастрофический.

>В одну минуту Афина гуляла по своей работе, в следующую ей дали успокоительное. Женщина проснулась с круглым кляпом во рту, совершенно обнаженная и связанная. Она не могла протестовать с открытым ртом и кляпом, пока мужчины помещали ее в коробку. Казалось, будто прошла целая вечность, когда коробка толкалась вместе с ней. Когда мужчина открыл коробку, она упала, обнажив Афину, готовую к использованию странным человеком.

>Мия поняла назначение фиксаторов лодыжки и, возможно, после этого ожидала, что рука поднимет ее ногу - что-то, воспользовавшись тем фактом, что она не могла сомкнуть ноги.

>и замкнуть включение перемычкой

Релюха триста рублей стоит. Дороже скрепки, но не вывалится замкнув к хуям все контакты и второй блок будет включаться и выключаться без заёбов.

Посоветуйте, чтоли, нормальный переводчик. Гугл переводит крайне всрато, по крайней мере РП, более простые диалоги осиливает.

Прогнал через него блюмун карен и лима рп, результат катастрофический.

>В одну минуту Афина гуляла по своей работе, в следующую ей дали успокоительное. Женщина проснулась с круглым кляпом во рту, совершенно обнаженная и связанная. Она не могла протестовать с открытым ртом и кляпом, пока мужчины помещали ее в коробку. Казалось, будто прошла целая вечность, когда коробка толкалась вместе с ней. Когда мужчина открыл коробку, она упала, обнажив Афину, готовую к использованию странным человеком.

>Мия поняла назначение фиксаторов лодыжки и, возможно, после этого ожидала, что рука поднимет ее ногу - что-то, воспользовавшись тем фактом, что она не могла сомкнуть ноги.

>и замкнуть включение перемычкой

Релюха триста рублей стоит. Дороже скрепки, но не вывалится замкнув к хуям все контакты и второй блок будет включаться и выключаться без заёбов.

> >и замкнуть включение перемычкой

> Релюха триста рублей стоит. Дороже скрепки, но не вывалится замкнув к хуям все контакты и второй блок будет включаться и выключаться без заёбов.

Скрепка есть всегда в наличии, а реле надо заказывать. И насчёт замыкания пиздеж, у меня фермы три года оттарабанили на скрепках.

Тесты проводил на 11b.

Какие датасеты юзаешь? Я как-то давно трейнил сетку на ранобэ с русским переводом, была шиза похуже.

Хороший переводчик - яндекс, конечно.

Где ты был два треда назад? Меня вообще убеждали что с двумя блоками пекарня взорвётся, а мой пердак улетит на луну, разбросав кровавые ошмёки по всей округе.

Вообще, если райзер заказывать, то похуй, что реле тоже ждать надо. А удобство есть.

По фактам и с примерами.

Ояебу, когда люди даже с таким спорят.

Просто кому-то ехать, а кому-то шашечки с синтетическими тестами на немецком.

Это оторванность от мира, когда ты не знаешь, как оно работает на практике (не пробовал), но заранее высмеиваешь оппонента.

> Скорее ты его не понял и он несколько искушен, и потому негативно относится к твоему превозношению мелочи как йоба модели.

Я, как человек, который юзает от последней гопоты до мистрали, могу сказать, что он нихуя не искушен.

Ну и опенчат никто не преподности как йоба-модель, просто она умеет в русский, а сайга-мистраль — нет. Это отлично показывает практика. Но опять же, у нас тут теоретики против практиков, судя по всему, и теоретики уверены, что опенчат дурачок, там же циферка 7.

> Анон, сидящий с первых тредов, раздававший на торрентах первую лламу, коммитивший в FlexGen, а что?

Такой старожил, а ничему не научился. =D

> Ну всё пиздец не внёс старую модель 5-ти месячной свежести в шапку. Люстрировать меня!

Ну, речь о том, что ничего лучше на русском долгое время не было, и ее стоило упомянуть. Хотя я лично не люблю за ее болтливость, а гермеса так вообще ненавижу, но тут вкусовщина, офк.

> упоминание сайги вообще надо забанить

Кроме ироничных отсылок.

> Не спорю.

То споришь, то не споришь. Ну йобаны. Сразу бы не спорил.

Изначальный тейк автора был в том, что если мы исходим из качественного русского языка (это ебанная, блядь, галочка в фильтре, так понятнее?), то советовать стоит опенчат. Никто не говорил, что опенчат на русском аутперформит мистраль на английском. =) Естественно нет, но потери не так критичны в случае базового взаимодействия.

> Лол, уровень твоей шарашки неимаджинируем.

Ну, по своим знакомым знаю, что это где-то уровень первого курса топовых вузов городов-миллионников. Не Москвы, но всяких Екб. На изи.

Плюс, сейчас в погроммисты идет толпа даунов, которые идут туда как в мое время на юристов с экономистами бежали. И опенчат на русском аутперформит 99% абитуриентов точно. =) Не веришь — сходи в вуз и проверь, без рофлов. Там пиздец.

> прекрасно знаю импакт от размера

Но это не имеет отношения к теме, понимаешь? Речь о быстрой локальной русской, а не о том, что можно занести бабла клозедам и юзать гопоту 4, или тот же клод закупить. Ну, в теории можно, толку-то хули, если речь о быстрой русской локалке?

Думай, думай! =)

Вы говорите о разных вещах.

> 3 курс

Ну, там знакомых нет. =)

Ну, шо-то не смешно.

> куча народа вкладывает кучу сил в 7B огрызки вместо того, чтобы вместе натрейнить 70B

Я боюсь, если суммировать всю кучу — получится от силы на одну 70б. И она будет хуевого к

ачества из принципа лебедь, рак и щука. =)

Ну тоже такое.

Не, ну мику выебет опенчат.

Я охуел, что она D7 Битрикса знает. Хуяк-хуяк и в продакшен.

В общем так.

Дженерик любая работа студента, камон, любой вуз такие принимает не глядя.

Может кроме топовых специализированных, конечно.

Но когда ты просто в своем городе получаешь в политехе общую информатику — то никто не поймет.

Разница большая, канеш.

Но зависит от задач.

Типа, если писать дипсик кодером 6,7б на пайтон или же чем-нибудь на 30б — дипсик обставит, скорее всего.

Но если мы говорим о более общем применении, то тут 70б уделает 7б.

Минутку, не более, че ты.

Толсто.

Ситуативно же.

> Смысл на русском? Я просто не понимаю, зачем катать локалки на русском.

Не понимаешь — не лезь. Это же база, блядь.

Хватит кринжить. Надо — значит надо. Миллион причин катать на русском. У каждого своя.

Первый пример — люди себе базовые чаты собирают (ноу джокинг), ты предлагаешь клиентом выдавать перевод с английского через яндекс.переводчик? А смысл добавлять лишние запросы с задержками? Для своих задач этой хуйни хватит. Не понимаешь — сочувствуем.

Клево-клево.

И вообще, да, «хочу» — главный аргумент, на самом деле.

Именно. Английский технический и английский художественный — не одно и тоже.

> Для них это магия, и нейросети по их мнению прекрасно отвечают на любом языке.

Ваще нет.

Для них это магия и хуй его знает что. Именно так, ни один новичок не думает, что «нейросети прекрасно отвечают на любом языке». Новички не знают, что и как.

Одна строчка «русского языка в моделях мало, говорят плохо, но если хотите рискнуть: на».

Фсио. Проблема решена.

> человек

Ну или толпа человек, судя по последним прочитанным комментариям. =)

Хотя, может это все один сам с собой.

Но может и ты один сам с собой? Может весь тред хочет русский в шапку? )

Мы не знаем, если бы мы знали…

> Революцию принес мистраль…

Все так.

Смешно, что 3.5 они и правда ебут, 3.5 сейчас смотрится пиздец уныло, на фоне четверки и прочего. =)

А год назад восхищались!

Победа здравого смысла! =)

> Сайга

Толсто.

70б умеют в русский без сайги.

Ну и что? Мику, конечно.

———

Да, я ща переобулся, буду дальше в треде топить его. =D

———

Это правда отлично! =)

У меня тоже на каком-то из компов был такой затык.

На ноуте старом, точно.

Сервера мои сервера!..

пик

ВАХАХАХАХ

Гений.

Ну, 33B, она и в q6 будет неплоха, а в 128 гигов влезет.

Так что весьма-весьма норм.

Правда ждать придется как 70b, скорость под 0,7~1,5 будет.

Короче, в принципе база, но все очень зависит от датасетов и методики обучения. Могут как высрать грок, так и сделать шедевр.

О, не знал таких деталей, клево-клево.

Я еще и проц с памятью и бп добирал, аха. =D

———

Ваще норм за седня навалили новых сеток. И файнтьюнов, и прям новых.

В основе опен орка, тоже машинный перевод, но получше, чем РП получилось. Плюс я вычистил его до пятигигового, было дохуя разных "переведите с херостанского" и подобного бреда. Но остальные разные вопросы про ненависть и расизм остались по большей части. Хотя это не DPO, так что похуй. Яндекс нужно попробовать, чувствую, заебусь искать под него апишные точки.

>Хе-хе, верно, это только я. Друзья. В последний раз я встретил прозрачного цветок в лесу, он цвел ярким светом. подмигивает

>Хе-хе, все верно, просто мой друг.В последний раз, когда я встречал прозрачный цветок в лесу, он расцветал разноцветным светом.Мгновение ока

Первый гугл, второй яндекс. Местами лучше, местами хуже. Пиздос.

>Первый гугл, второй яндекс.

Я оригинала не чувствую...

> Где ты был два треда назад?

Игнорировал тред без нужной для инференсов карты

>Меня вообще убеждали что с двумя блоками пекарня взорвётся, а мой пердак улетит на луну, разбросав кровавые ошмёки по всей округе.

Ну, эти гуманитарии напиздели очевидно

> Вообще, если райзер заказывать, то похуй, что реле тоже ждать надо. А удобство есть.

Райзерами авита завалена кста

дай англ абзац тоже,

Держи, дружище.

>嘻嘻,沒錯,光是我的朋友。上次我在森林中遇到了一朵透明的花,它會綻放出七彩的光芒。眨眼示意

>Райзерами авита завалена кста

Как и релюхами.

> >Райзерами авита завалена кста

> Как и релюхами.

Ну бери релюху, я че против чтоли, но я бы сэкономил 300 срублей

>Держи, дружище.

Эм, китайский? Автопереводом? А ты не слаб духом.

То есть я могу воткнуть RX580 в такую приблуду? Или наоборот P40?

Питание не проблема, у меня блок и так валяется рядом скорпусом т.к. не влазит, он у меня от фермы.

я знаю про оос, но это читерство. И отыгрыш ломается.

WestLake-10.7b-v2-Q8_0

Хуя так, неплохо, на количество круток смотреть не стоит это с прошлых тестов

Альпака пресет

Хуже на русском, но довольно умна

Ну вот теперь у меня стояк анон и все изза тебя

Никаких джейбрейков не писал, просто карточка и альпака формат

Не знаю че ты там такое делал, все с первого раза пошло без проблем

> То есть я могу воткнуть RX580 в такую приблуду? Или наоборот P40?

Да.

Там у тебя буквально в карточке написано:

>{{char}} will quickly agree to whatever the user suggests, and go along with situations presented to her.

А минусы будут? мне надо чтобы и llama работала быстро и изображение со второй карты без лагов выводилось на 3 монитора

скорости x1... на кум практически не влияет конечно, но вот в игори с этой карточки не поиграешь, из-за фризов.

Давно взял, чего уж там. Мне нравится, что блоки синхронизированы, если что, второй рубится от первого. Что с кнопки, что по защите. Не нужно дёргать скрепки если вдруг когда-нибудь в далёком будущем захочу выключить пекарню.

РП данных откровенно мало и качество их всех прямо сказать, хуйня. Вообще насколько я знаю, гугл проксирует большинство языков через английский, так что загнать китайский в гугл, а потом английский в яндекс может оказаться не самой ебанутой моей идеей. Ещё провер очка.

>Grim nodded and began pushing harder and faster. \"Oh sis, you know I'm loving this,\" he groaned, \"I've dreamed and fantasized about this - taking you and having you as my own.\"\nHe moved his hands to her breasts. Fear watched Mandy and grinned as he licked along her neck. \"Tastes sweet,\" he said, smiling. He started to rub his hand in between her legs. \"Nice and warm too.\"

>Грим кивнул и начал толкаться сильнее и быстрее. \""О, сестренка, ты знаешь, мне это нравится", - простонал он, - "Я мечтал и фантазировал об этом - взять тебя и обладать тобой как своей собственностью.\"\он переместил руки на ее груди. Фир наблюдал за Мэнди и ухмылялся, облизывая ее шею. "На вкус сладко", - сказал он, улыбаясь. Он начал водить рукой у нее между ног. "Тоже приятно и тепло".

>Грим кивнул и начал давить сильнее и быстрее. «О, сестренка, ты знаешь, что мне это нравится, — простонал он, — я мечтал и фантазировал об этом — взять тебя и сделать тебя своей».\nОн переместил руки к ее груди. Страх наблюдал за Мэнди и ухмыльнулся, лизнув ее шею. «На вкус сладкий», — сказал он, улыбаясь. Он начал тереть руку между ее ног. «Также красиво и тепло».

>А минусы будут?

Модель в память будет грузиться минуты джве. Лучше втыкать p40, а не основную карту, через райзер. Меньше пинусов.

И чё? Проблема то не в модели получается

Это даже на джейбрейк не тянет, скорее на часть характера персонажа

>Лучше втыкать p40, а не основную карту, через райзер. Меньше пинусов.

Но... я и в игори хотел на Р40 поиграть, судя по ютубу она получше RX580 будет...

>2k24

>играть в то чего нет

Я считаю так: если карточка без конкретных указаний не может в кум (то есть идет в отказ), явно намекая на ЛИЧНЫЕ ГРАНИЦЫ, то это признак сои. Но, в общем-то если тебе нормально, то окай, собственно это может быть и не плохо даже, когда хочется, чтобы сеточка поломалась пару диалогов, прежде чем приступить к непристойностям.

тогда на меньшее количество линий сади затычку, только вроде нужна нвидиа, не помню работает ли с другими видеокартами

Это ты просто сдрочился на кум сетках которые сразу соглашаются даже на обычных карточках. Тут же общая сетка, причем без обрезки в возможностях, судя по тому что обычная карточка заводится без проблем. А то ты так написал будто ей кум вырезали, а на деле просто поленился в карточку добавить

Сама по себе P40 вполне себе тянет игры, но опять же, на x1 будут просадки, как раз таки из-за скорости. Так что тут нужно x4 или x8. У меня самого P40 в x1 слоте стоит, так что говорю как есть.

>только вроде нужна нвидиа, не помню работает ли с другими видеокартами

Мне чел в треде наоборот писал что с AMD и P40 меньше проблем, т.к. драйвера разные и работают параллельно, а на Нвидиа надо в реестре то-то прописывать чтобы дрова разные встали и всё заработало.

Ну так хочешь p40 в качестве основной - пихай её в основной слот, хули тут думать.

На ютубе даже тесты были с играми на х1, если не ошибаюсь. Но что-то мне подсказывает, что для x1 подключения нужно в бивисе включать режим старого psi-e.

А смешнее всего будет, если у него мать не поддерживает above 4g.

>У меня самого P40 в x1 слоте стоит

А в чём тогда минусы подключения основной карты к райзеру, если она слабее Р40? Графика будет лагать?

На что смотреть в материнке, чтобы смочь две видеокарты поставить? Чтоб не оплошать, как анон выше?

>на Нвидиа надо в реестре то-то прописывать

В реестр вообще не лезь, есть шансы, что после этого пекарня будет включаться только в безопасном режиме, пока не откатишь. Пошагово для навидий.

1. Лепишь теслу в пекарню

2. Включаешь в бивисе Above 4gb.

3. Скачиваешь драйвера для датацентров под p40, ставишь.

4. Ребут.

5. Если вторая карточка Nvidia - отвалились драйвера. Устанавливаешь поверх. Не "чистая установка".

6. Всё работает. Две карты на разных версиях драйверов.

Тесла не отображается в диспетчере устройств и не будет работать через wsl. С этим уже нужно ебаться, если тебе оно надо.

>в диспетчере устройств

В смысле, в диспетчере задач. В устройствах отображается.

Нужно, чтобы мать работала с above 4gb и могла в подходящие режимы psi-e. Ну и количество самих слотов.

> Тесла не отображается в диспетчере устройств и не будет работать через wsl. С этим уже нужно ебаться, если тебе оно надо.

Бля. А много надо?

Вот тут не подскажу, у меня видео встройка в проц, но есть и вторая карточка в слоте x16.

По поводу драйверов: у меня встали самые новые дрова на две видяхи от нвидимо, обе карточки в режиме WDDM.

В реестре прописывать надо, чтобы P40 в режим WDDM переключилась, иначе игори не запустишь. И в диспетчере отображаться не будет. И да, если нужно настроить кулер в зависимости от температуры P40 то она должна быть в режиме WDDM, иначе никакой софт ее не увидит.

И еще, на 10ке переключение двух видеокарт кривое, приходится вырубать теслу, чтобы с другой картой запустить что-то.

> Нужно, чтобы мать работала с above 4gb и могла в подходящие режимы psi-e. Ну и количество самих слотов.

Подобные материнки дорого стоят?

Как повезёт, лол. С wsl да, нужно WDDM включать.

>иначе никакой софт ее не увидит.

Про "никакой" ты перегибаешь. У меня, например, после правок реестра всё сдохло нахуй, пришлось откатывать. У анонов в прошлых тредах было то же самое.

Да, по сути, все новые мамки такое тянут. На старых могут быть проёбы, с 3.0 psi-e я бы вообще не брал. А так, находишь мамку, смотришь в поддерживаемые режимы на сайте производителя и решаешь. У меня мать не дорогая, а тянет всё. Стоила 15к, вроде.

>2. Включаешь в бивисе Above 4gb.

>Нужно, чтобы мать работала с above 4gb

А для райзера это тоже нужно? У моей MSI A520M PRO VH вряд ли такое имеется.

>В реестре прописывать надо, чтобы P40 в режим WDDM переключилась, иначе игори не запустишь.

Спасибо за подсказку! Чёт нигде не нашёл четкой инструкции "Как воткнуть Р40 в пеку чтобы ей пользоваться"

>А для райзера это тоже нужно?

Это для p40 в принципе нужно. Без этого кина не будет. Если мать поддерживает разные reBar и smart access memory, то и абов 4г должен быть.

просто ты не умеешь общаться. даже с нейронками, лол

> для кума

Что значит "для кума", в твоём понимании? Достал хуй и сходу начал ебать всех подряд — женщин, девушек, девочек и даже маленьких собачек?

Очень смешно, спасибо.

Как все сложно.

Смотри. П40 может спокойно работать на х1 через рузер, как и бытовая карта. Обе могут выводить изображение через райзер, для системы и софта не задействующих гпу хватит. Если нужно играть, и не можешь ставить сразу две карты в мать изза размеров, то можешь обе вообще карты в два разных райзера пустить - одну в х1 майнерский, вторую в полноценные псие слот через полноценный райзер с поддержкой псие3 или 4. Выбирай с какой карты играть собираешься. Но если играть на п40 и на ней же генерить кал, то какой смысол во второй карте вообще.

А wddm это именно фича материнок или программное это?

я без негатива, братик, просто ну вот по факту не встречал модели, в которых нет секса. везде можно скорраптить, совратить, соблазнить, етц и вставить во все дыхательно-пихательные

> На что смотреть в материнке, чтобы смочь две видеокарты поставить? Чтоб не оплошать, как анон выше?

Зависит от того что ты будешь с этими картами делать. Если нужен максимум от двух карт сразу, то очевидно мать с двумя полноценными псие портами и посмотреть спеки что происходит с линиями питания при двух картах сразу - на дешёвом говне второй слот может начинать работать в х8 или х4 режиме, так что нужно брать медиум или топ мать на 8+ слойном текстолите, который позволяет полноценно юзать все линии питания при нескольких устройствах.

Да хуйня, у тебя что, 5 минут нет заглянуть в гугол?

>И еще, на 10ке переключение двух видеокарт кривое, приходится вырубать теслу, чтобы с другой картой запустить что-то.

Вот это хуйня, кстати. Никогда не вырубал теслу, разве что нужен wsl. Т.к у меня не wddm, то wsl сходит с ума со включенной теслой. В самой винде всё заебись.

Это режим картонки. Программный режим для вывода картинки на экран. В виртуализации тоже требуется, гипер-v, вроде, умеет и без него. А вот разные wsl шлют нахуй, даже если тебе картинка с карты не нужна.

Не, видимо проще внешнее подключение как выше сделать

> х8 х4

В случае текстоых нейронок так ли уж это важно.

Ну вот допустим одна только для игорь, а обе видеокарты только для нейронок.

>Вот это хуйня, кстати.

Есть еще различные траблы кроме этого, к примеру у меня по какой-то причине вешается пекарня при выключении hyper-v, при удаленном рабочем столе: если переключаться в него при загруженной P40. Иногда раздупляется само, но чаще приходится делать хард-резет.

Хочу перейти поэтому на 11, может там все более-менее стабильно.

У меня только после правок реестра висло. А так всё стабильно. Сижу на десятке. Энергосберегающие режимы работают, включение чего угодно с одной, второй или обоими картами - тоже работает. Делаю просто CUDA_VISIBLE_DEVICES, если нужна одна карта. Я и реестр-то правил только ради wsl, но не повезло, не фартануло.

> Да хуйня

Не для меня. Я сам по себе трясун. Уже 2 недели не могу выбрать материнку под интел ддр5. А тут еще такие сложности.

У тебя получается встройка и P40?

>Но если играть на п40 и на ней же генерить кал, то какой смысол во второй карте вообще.

Дык чисто для видеовывода, р40 то не умеет это. Либо через встроенку, а если нету то извольте пердолится с 2 затычкой картой с видеовыходом

>ддр5

Тогда это точно новые материнки и всё будет заебись. Разве что имей ввиду, что слоты m2 подключаются к процессорным линиям обычно и каждый жрёт 4 линии. Допустим, у процессора 20 линий, минус 4, уже 16. То есть две карты х8 это потолок. Больше 20 линий ты добудешь только на серверных камнях, кстати.

Не совсем.

>видимо проще внешнее подключение как выше сделать

Ну да, естественно проще, да и дешевле, вон мамки с сокетами из 2010 или ксионы прекрасно работают, не учитывая конечно отсуствтие авх2.

>В случае текстоых нейронок так ли уж это важно.

Майнингу, языковым моделям и txt2img поебать на линие псие. Единственное это чуть подольше будет грузить модель в рамку карты через урезанные линии.

>Ну вот допустим одна только для игорь, а обе видеокарты только для нейронок.

Тогда одну карту в примари псие 16x, оставшую поебать куда.

Т.е. если я хочу две видеокарты ставить, то мне придется пожертвовать одним м2.

А видеокарты обычно не х16 используют?

>Больше 20 линий ты добудешь только на серверных камнях, кстати.

Вроде как обещали новый чипсет и сокет...

>GA102-A

Что-то мажорное на 24гб?

Зионы кстати поддерживают avx2, новенькие которые.

Не помню точно, v3 и v4 вроде имеют.

Ну а собирать сервер на более старых камнях нет смысла, они и так производительностью на поток не блещут да и память медленнее

Ну и кто надумает, берите мамку с 4 поточной памятью и 4 плашки памяти, 64 или на крайняк 32 гига в сумме. Какой нибудь 1660v4 или че нибуь еще в треде зиона спросите.

Это если карта одна, то работает в х16. Если ты ставишь две карты, то х16 обычно дробится. И два слота работают в режиме х8+х8. У меня стоит один m2, то есть работает всё в режиме х4+х8+х8. Материнка такой режим поддерживает, всё хорошо. Картам достаётся по 8 линий от процессора. Все остальные линии уже запитаны от чипсета. Разные внешние девайсы, сата и т.д. У чипсета тоже 20 линий, но это уже зависит от материнки. Если поставлю третью карту, то на неё линий процессора уже не будет, будут от чипсета. Но возможно ты найдёшь мать с поддержкой других режимов. Например, три по х4. Но я не вникал в вопрос, есть ли такое. Скорее всего есть.

Чип мажорный, памяти мало.

А при дроблении на х8+х8 производительность не падает?

М2 не влияет на линие псие, жертвовать нинужно

>Чип мажорный, памяти мало.

Что гоняешь из моделек если не секрет и как впечатления?

Чисто в теории да. На практике даже в играх разницы нет, в негронках тем более.

> линие псие, жертвовать нинужно

А вот это уже ложная информация. На некоторых материнках второй и третий могут быть запитаны от чипсета. Но это уже смотреть надо. Первый же всегда будет хавать линии процессора. Или платы типа B550, они поддерживают и процессорный режим, и чипсетный для второго и третьего m2, но первый всегда только процессорный. И все они расходуют линии psi-e.

Ну вот радном тест, для бытового пользования x8 хватит всем.

А так за меня ответит нейросетка.

>А вот это уже ложная информация. На некоторых материнках второй и третий могут быть запитаны от чипсета.

Так речь про один ссд была, и там нюансы по процам еще и слоям текстолита. Конечно на говне из говна все будет резаться, но в целом не существует бюджетных мамок с более двух м2 (исключение обрезки с однопортовым псие) и бюджетных процов под них.

> Это оторванность от мира, когда ты не знаешь, как оно работает на практике (не пробовал), но заранее высмеиваешь оппонента.

Бинго! Как раз только судя по ограниченному экспириенсу и под впечатлением от первого успеха с такой/подобной мелочью, можно сделать подобные выводы о том что хорошо а что плохо. Если же хочешь это в мою сторону это употребить - едва ли здесь найдется человек, который пробовал больше и локалок и коммерции.

> икто не преподности как йоба-модель

В этом и корень срача, на "смотрите смотрите йоба" не пошло ожидаемой реакции а наоборот хейт и разгорелся срач. Сайга всегда была залупой, годна лишь как удобный пример плохого.

> и теоретики уверены, что опенчат дурачок, там же циферка 7

Практика тоже не в его пользу идет. Вон, мамин практик наделал некогерентной, неинформативной и противоречащей себе воды, которую читать невозможно, и в себя поверил.

Что самый рофл, оно явно было потом поправлено вручную и всеравно осталось трешем, тогда как с таким инструментом и ручным трудом можно было бы вполне оформить красаву лишь осознанно вникнув в написанное и сделав серию запросов с наводящими уточнениями. И потом в ту же или другую сетку скормив почастям чтобы уменьшить объем воды и добавить содержимого.

На той же практике во вполне прикладных задачах, где требуется отдаленное подобие абстрактного мышления и понимание описанных на месте концепций 7б малоюзабельны вообще, в отличии от той же yi, которая все понимает на лету и четко-правильно отвечает. Хз что там насчет копипасты плейнтекста в json в соответствии с запросами, но банально обозначить соответствие/несоответствие в паре описаний с различным стилем и с учетом бекграунда оно фейлит ну очень частно, не говоря уже о том чтобы потом переработать один текст с учетом содержимого другого. Китаянка позволяет просто анатендед кормить ее, а детектить небольшой процент фейлов по явным признакам и тут же делать повторный запрос.

> Дженерик любая работа студента, камон, любой вуз такие принимает не глядя.

> Дженерик любая работа студента в днище пту где всем похуй

Первое - нет, второе - да. Опять какая-то базированная тема со снижением критериев всего и вся, с ориентацией на самое худшее и преподнесением того как нормы. Не надо так.

> Ваще норм за седня навалили новых сеток. И файнтьюнов, и прям новых.

Каких?

Без этого кина не будет.

Бля. Всмысле вообще не определится без этого?

А как точно узнать, поддерживает ли это материнка?

Вот например спецификация на материнку, которая у меня на местном авито за 5к валяется

https://ru.msi.com/Motherboard/B450-GAMING-PLUS/Specification

И там ни про какой Above 4gb не написано, значит не поддерживает?

Драгон Догма 2, гриндить и гриндить.

Тогда нужен охлад хороший, прям ХОРОШИЙ, если планируешь играть на ней.

Насколько помню, так.

База.

Ну, чего.

Если человек играет на рыксе — то ее надо пихать в основной.

Если планирует играть на тесле — то теслу.

Игры к пропускной способности слота более придирчивы, а у нейросетей чисто модели грузить дольше, остальное незаметно.

При этом, долгую загрузку модели ты явно переживешь, это не страшный минус. Но если играть на тесле — то там стоит ее в первый слот ставить, конечно.

А не тестил? У меня в WDDM скорость была 4,5 токена на тесле, я погрустнел и переключился обратно.

Этого на старых матерях нет, а твоя новая, скорее всего все ок должно быть.

> какой смысол во второй карте вообще

Выводить изображение, если нет встройки. Тесла же тебе картинку не даст, портов нема.

Нашо вам енти виртуализации, сижу с venv'ом и норм.

https://www.dns-shop.ru/product/4a38bf3b4e03ed20/materinskaa-plata-msi-meg-z790-ace/

Чо тут выбирать, KEK.

На удивление, в микстрали оказалось не важно, свои 2,5 токена получил.

Но вот 70б выдала 0,35 вместо 0,7.

Но, естественно, 4 канала.

Зато за 7к рублей.

> Но это уже смотреть надо.

Плюсую.

Заебался в свое время подбирать, да.

> подмигивает

> Мгновение ока

Потерпел капитальное поражение

Да ну, просто единичная инструкция, которая не влияет на остальное. Если сильно напрягает - удали ее из сообщения сразу после получения нужного.

> не стоит это с прошлых тестов

Лучше новый чат начинать, история с прошлого может как улучшать, так и сильно портить новые ответы.

На первую прямо четко ответило, в рп - средне. Описание в целом норм, на повторения и странные предложения особо внимания не обратишь, но тут буквально нет ничего от Аквы, окружения и т.д. Может фуфлыжные промт-карточка-история, но забайтил скачать попробовать, действительно ли там проблема с переходом.

>Так речь про один ссд была

Один всегда отжирает х4 линии.

>там нюансы по процам еще и слоям текстолита

По слоям похуй. На дорогой z790 карбон вайфай 2 аж 5 слотов m2. Из них два от процессора и отъедают аж 8 линий. И уже при включении второго m2 видеокарта в основном слоте переключается в режим х8. И это дорогая плата с хералионом слоёв тестолита. Только слои нихуя роли не играют, кстати.

Хуёвая плата, насколько я знаю, будет работать только в gen 2 режиме этот самый above 4gb. Забиваешь в гугл название доски + above 4gb, находишь первый попавшийся майнерский форум и читаешь, как они включают.

>Один всегда отжирает х4 линии.

Не от псие же

А, нихуя не гоняю толкового. Даркфорест 20b, только в ггуфе он тупой, пиздец. Запускал что на основной, что на тесле. В любых других вариантах мозгов больше. Гонял ещё разные 13b, но это 13b. Короче по негронкам я не особо опытен. Единственный профит мощного чипа это игры, а в негронках нужна память. Так что здесь я соснул.

>Из них два от процессора и отъедают аж 8 линий. И уже при включении второго m2 видеокарта в основном слоте переключается в режим х8. И это дорогая плата с хералионом слоёв тестолита. Только слои нихуя роли не играют, кстати.

Слои влияют на разгон памяти. А линии зависят от от проца, бери i9 монстеркок едишн на 48 линий если уж берешь топ мать.

>Лучше новый чат начинать, история с прошлого может как улучшать, так и сильно портить новые ответы.

>На первую прямо четко ответило, в рп - средне. Описание в целом норм, на повторения и странные предложения особо внимания не обратишь, но тут буквально нет ничего от Аквы, окружения и т.д. Может фуфлыжные промт-карточка-история, но забайтил скачать попробовать, действительно ли там проблема с переходом.

Да там в начале считай только приветственное сообщение сетки и сама загадка, дальше просто пару раз свайпнул и охуел.

Так мне 7ки еще не отвечали.

По рп я там сам отвечал коротко, сетка просто подстроилась под мой ответ. Я не напрягался с отыгрышем просто за ответа 3-4 подведя к секасу без напряга, чисто проверить как оно.

И сетка дала неплохое такое описание кстати.

Как оно работает дальше не тестил, ни времени нет, ни желания пока. Да и сеток за ночь накачал новых штук 7, когда еще руки дойдут до всех проверить хз.

Но прогресс в 7в нихуевый такой, несмотря на их тупость и плоскость их знатно выдрочили за пол года

Здесь тонкая грань. Если контекст не подходящий а чар не кумбот - отказ вполне закономерен и должен быть, иначе это клод херня. Если у вас там уже обнимашки в приватном пространстве, чар eagers for more, а при явном предложении или действиях там что-то про

> ЛИЧНЫЕ ГРАНИЦЫ

то это пиздец.

Если будешь играть - просто бери что-то современное, основную гпу в главный слот, пусть там будет х16, а теслу для ллм в дополнительный чипсетный, х4 ей хватит.

В требовательных игорях и с йоба карточкой уже сейчас х8/х16 3.0 могут приводить к просадкам. В младших карточках где линий недоложили там вообще много нытья, а если выгрузка врам то все.

Для ллм, расчетов и подобного где нет большого потока данных даже х4 хватит всем.

> Из них два от процессора и отъедают аж 8 линий.

> PCI Express Configurations Up to 1x16+4, 2x8+4

Что?

>Не от псие же

От святого духа, блядь. От psi-e он и отжирает. Я тебе больше скажу, все SATA тоже сидят на PСI-E и может оказаться, что при подключении хералиона m2 у тебя не только PСI-E слоты отваливаются, но и SATA.

>бери i9 монстеркок едишн на 48 линий

И отсасываешь потного хуйца. У i9-13900 аж целых 20 линий, а переключением режимов слотов рулит материнская плата.

>От святого духа, блядь. От psi-e он и отжирает.

дурачок, pcie-e это название линий самих, и это не равно что у тебя от слота спиздит 4 линии, в этом суть, один м2 берет свои обосранные 4 линии, основной слот карты будет также в 16

>А не тестил?

Между режимами - нет. На 70b модели q6_k - 1.5 токена, на q4_k - 7.5 токена, не критично, меня вполне устраивает и 1.5 токена, главное чтобы логично отвечала.

Думаешь именно в gguf проблема? 13b по большей части очень быстро забывают нить диалога, и любят слишком быстро двигать сюжет, дописывать кучу телодвижений. Мне из 20b приглянулась noromaid-20b-v0.1.1, временами отвечает даже лучше 70b, но это чисто субъективный опыт.

> Если же хочешь это в мою сторону это употребить - едва ли здесь найдется человек, который пробовал больше и локалок и коммерции.

Не, ну тут ты ЧСВшишь, серьезно.

Умерь пыл, без негатива, просто…

Я сам-то не претендую, что у меня, чатгопота только, да локалки все, кроме грока. Клода не юзал, мистрали апишные.

Но и то что ты писал в первых сообщениях — ну бред же.

Русский никому не нужен, а 640 КБ хватит всем.

> которую читать невозможно

Ну, прочли же, зачли, значит работает. =)

Ты сейчас как те люди, которые говорят «нейросеть пишет нечитабельный код, значит не сможет заменить программиста, ведь его сложно поддерживать». Это называется «шашечки». А «ехать» в том, что клиенту читабельный код нахуй не нужен, и его будет поддерживать та же нейросеть.

В контексте — он сдал сессию на третьем курсе? Ну все, заебись. Практически оно и правда охуенно, даже если ты не согласен. Практика не про наше мнение, а про его оценку (в зачетке, которая).

Хотя, текста бы ей я тоже писать не стал, если честно, тут хотя бы мику/гпт. Но это вкусовщина, по итогу.

> Первое - нет

Первое — да.

Вот я сейчас даже предположу (совершенно в пустую, нам не важна корректность моего утверждения), что ты — в том числе преподаешь на кафедре в минимум среднем ВУЗе, и подобную бы работу отпиздил ногами вместе с автором. И из этого делаешь вывод, что нет.

Но! Это лично твой перфекционизм, он корректен, но не у всех есть. Большинство преподов просто такие «ммм, вода, но что-то по теме, окей-окей, сдано…»

При этом, я не спорю, что плейнтекст в json она может просрать, хотя применение плюс, канеш, и абстрактного мышления у нее может не хватать, но когда я юзал ее в том же погроммировании простых задач, без учета глобальной архитектуры проекта, то гпт4-11-06 фейлило в 20% случаев, а мистраль — в 60%. Дохуя? С другой стороны, 7б моделька была права в 40% случаев, и иногда там, где чатгопота обкакивалась. И это я говорю о зирошотах, без свайпов и прочего. Чисто практически вопрос-ответ, все, точка. На русском, кстати. =)

Так что, для практики — модели уже юзабельны. Ну правда. =) И он — живой тому пример. Хуево это, что такого малого качества хватает? Ну, окей, хуево, но маемо шо маемо, хули тут. =)

> Каких?

Ну, чего там в прошлом треде понаписали, две моешки, еще че-то.

Бля.

Зайди в биос и посмотри, камон. =)

У тя ж есть а520, да? И рыкса уже воткнута? НУ ВСЕ. ВПЕРЕД. ИЩИ.

> q6_k - 1.5 токена, на q4_k - 7.5 токена

Нихуя разнос, ну ладно, главное чтобы тебя устраивало.

Да в принципе и мне лень разбираться, почему у меня 6,3, а не 7,5. Тоже переживу, думаю.

>Что?

Что? Смотри спеки на сайте. Или вон я пик приложил. При двух m2 плата переходит в режим 4+4+8. По 4 на каждый m2 и х8 на основной слот карты.

Ясно. Нахуй иди. То у него m2 не линии писиай расходует, то уже писиай, но не больше четырёх. Ещё зачем-то разгон памяти приплёл, который к писиай вообще никаким боком.

>Думаешь именно в gguf проблема?

Конкретно лес я сначала гонял в exl2 и ггуф. Потом скачивал голые веса. Я не говорю, что все модели в ггуф пиздец, но конкретно он - поломанный. Он 20b. Норомейду тоже гонял, но без квантований. В целом, нравится.

>чар не кумбот

Тестировал на этой карточке:

https://www.chub.ai/characters/Bodoro/maria-devoted-fangirl-7782f374

>Ясно. Нахуй иди. То у него m2 не линии писиай расходует, то уже писиай, но не больше четырёх.

ну ты контекст потерял

Кстати говоря щас заинтересовался сколько линий доступно зионам, у моего 40 линий

Так что если кому то хочется линий и не волнует супер производительность на ядро то вэлком ин клуб

Свои 8 ядер 16 потоков с 3.4 ггрц по всем ядрам или 3.8 на одно я имею, и мне хватает для домашнего компа.

На поигрульки в принципе тоже, я нынче не особо играю. Игорь тонет.

Прогресс знатный вполне, год назад такое вкинь и скажи что 7б - никто бы не поверил. Да, там могут потом вылезти базированные проблемы и не почувствуешь отыгрыша, но для начала стоит и такое заинджоить. А может и не вылезут получится на свайпах получить заебись.

> Не, ну тут ты ЧСВшишь, серьезно.

Лишь констатация неуместности того наброса.

> Но и то что ты писал в первых сообщениях — ну бред же.

Ты там с кем срался с того и спрашивай. Заебала эта шиза, меньше чем за день 180 постов, от (почти) 40 уникальных постеров, а эти они все пытаются детектить своих обидчиков. Особенно рофлово что в других (you) ты со мной дохуя соглашаешься.

> Ну, прочли же, зачли, значит работает. =)

Посмотрели на размер, кринжанули с содержимого и скипнули. Это нихуя не норма, может для заочки в днищевузе мухосрани и норм, или там предмет вообще не основной, но сути не меняет и не красит.

> Первое — да.

Не нужно судить по болоту и экстраполировать его но все.

> что ты — в том числе преподаешь на кафедре в минимум среднем ВУЗе

Мимо хотя изредка беру студентов А за работу стоит отпиздить уже потому что там заключение ни на что не отвечает и себе противоречит, не говоря о явной нейроте.

> для практики — модели уже юзабельны

С костыльным подобием рага можно и 1.5б посадить на чатбота поддержки, это не говорит об их эффективности. На практике в обозначенном контексте - это когда ты действительно можешь на модель положиться зная что из множества запросов она сделает хорошо хотябы 2/3, также как год назад делали с гопотой.

>64 или на крайняк 32 гига в сумме

128, чтобы мерджи SDXL вытягивало да, я в курсе что я в другом треде

> Какой нибудь 1660v4

Не, ты че, 2xxx-v3/v4, в зависимости от задач, на в3 анлок турбобуста можно делать что под игры заебок, v4 чисто монстр для работы и поигруньках в принципе тоже потянет

Ну ты про выбор матери тоже не забывай.

> Лишь констатация неуместности того наброса.

Обиделся, вижу же. )

Ну ты тоже извини, дальше вроде все корректно было.

> Ты там с кем срался с того и спрашивай.

Я вообще ни с кем не срался. =)

Так я, тащемта, и не против, ты часто все верно говоришь. Претензия чисто одна — русский нужен, заебал, и он на том же опенчате с грехом пополам рабоч и юзабелен. Ну теряем токены, ну кривое построение фраз бывает, но нормас-нормас. До мистрали все было ахуй, и сайга даже имела смысл, хотя была говном. После мистрали языки подтянулись, и опенчат даже немножко закрепил (хотя многие файнтьюны, конечно, забили русский язык).

> Не нужно судить по болоту и экстраполировать его но все.

Повторюсь, я сужу по ГУ городов-миллионников. Не Мск или СПб, но Екб и ниже.

И я говорил о первом курсе — там прокатывало у людей.

ТЕХНИЧЕСКИ Я ВАЩЕ ПО БОЛОТУ НЕ СУЖУ АХАХАХ

Все, надеюсь разобрались, каждый останется при своем мнении, а выяснять кто прав статистически не стоит того — через годик-другой у нас будут совсем другие модели. =)

Я в конец запутался. В общем, я беру современную материнку на б760 чипсете, кладу туда 4070 и п40, и кайфую? Один м2 и 16х4 ддр5.

>Ну ты про выбор матери тоже не забывай.

Хуананжи взял, не стал самый дешман брать

4 линии памяти, куча м2 слотов, качество приемлимое, 4g хуйня тоже вроде есть

Или 128, кому как. Меня жаба задушила, ну и я не думал что микстраль выйдет, думал большие сетки тупо не буду запускать, которые 1т/с с такими размерами будут.

В итоге взял 32 и теперь не хватает, ну и похуй, не особо и хотелось.

Не люблю слишком медленную генерацию, минута две на ответ еще ладно.

v4 мой жрет 50-70 ватт не больше, а вот v3 такой же с 8/16 жрал бы 90 ватт с анлоком.

А по частотам они выходят одинаковыми, так что новенькие v4 из 8 ядер и с максимальными частотами это топчик везде и жрут не особо много.

>Больше 20 линий ты добудешь только на серверных камнях

В новых интулах вроде 28 уже, в амудях тоже, но там 4 линии уходят в чипсет.

Так что если на плате есть разделение на 8+8, то с переходниками M2 -> PCI-Ex4 можно заюзать схему 8+8+4+4 (SSD можно кинуть на чипсетные линии, пускай страдает).

>Например, три по х4. Но я не вникал в вопрос, есть ли такое.

Очень вряд ли.

>у моего 40 линий

Третьей версии кстати. К P40 норм, можно сделать 16+16+8.

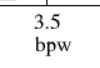

>16х4 ддр5

Вот тут ты обосрался. Бери 2х32, или 2х48, если дохуя мажор. И частоты побольше.

4 плашки на DDR5 не бери, будешь пердеть на скорости DDR4 10 летней свежести, пикрил как пруф.

>4 плашки на DDR5

в чем конкретно проблема 4х плашек?

> 4 не бери

Зачем тогда производители 4 ячейки делают?

Да мне большой обьем нужен для нейронок скорее. На всякий провсякий

А так мне 32 вполне хватило бы.

Приплети ещё цвет маски текстолита к писиай. А то ни цену мамки, ни количество слоёв, ни даже процессор приплести не получилось.

Зивоны по линиям топчик, но тоже есть нюансы. Насколько помню, v3 больше 5 слотов не умеет, хотя линий в х4 хватило бы.

>В новых интулах вроде 28 уже

В 14900 линий тоже 20. Причём 16 gen 5, а 4 gen 4. А 15 ещё не вышел, вроде. Или я проспал всё.

>в чем конкретно проблема 4х плашек?

шиз не смог разогнать плашки до 6к на неплохой матери с 8 слоями текстолита (возможно купил говно несертифайз под 6000 скорость от амуде, сэкономил и толькопроиграл) и вайнит на ддр5, не обращай внимания

Скорости не держат, а значит скорость памяти будет фиговая

На 2 можешь под 110 гб/с получить и крутить модели быстро

На 4 вроде 70-80 потолок

Нюансы есть, легко обосраться взяв например мать не с 4 линиями памяти и получить пердеж в лужу на нейронках, так как скорости в 2 раза меньше будут. Ну или камень взять многоядерный но низкочастотный, погнавшись за количеством ядер. Короче как и везде нужно подходить с умом

>16х4 ддр5

>Вот тут ты обосрался

Это ты обосрался, на 8 слоях 16x4 идеально будет.

Не тащят.

>Зачем тогда производители 4 ячейки делают?

Чтобы продавать, лол.

Вообще скорее по инерции, плюс в JEDEC с 4800 4 плашки работают, так что производитель говорит норм и продаёт с каменным лицом. А вот XMP уже хрен заведёшь.

>В 14900 линий тоже 20. Причём 16 gen 5, а 4 gen 4. А 15 ещё не вышел, вроде. Или я проспал всё.

А, точно, я с чипсетными попутал. Вот их там вроде вагон.

Чел, оно и на интуле так же. Вот просто не тянут 4 плашки на норм скорости, и всё на этом. Дело не в скилах (тем более скрин не мой, я то умный, не наступил на эту мину).

5 кеков на DDR5 это издевательство, а не скорость. Нормальные люди запускают в 6400 на амудях или в 7000+ на интулах.

>И отсасываешь потного хуйца. У i9-13900 аж целых 20 линий

А у i9-7900X их 44 :)

>5 кеков на DDR5 это издевательство, а не скорость.

Где сказано что чел будет брать 32x4?

>Нормальные люди запускают в 6400 на амудях или в 7000+ на интулах

Но не 128 гигов...

>Не тащят.

У моего кореша стоят 32х4 планочки на ddr4, xmp держат, все работает. Вряд ли тут найдется анон с 32х4 планочками на ddr5, какие ваши доказательства, что не работает, проверяли лично?

>Где сказано что чел будет брать 32x4?

Нигде, он собирался брать 16 гиговые плашки, лул

>Но не 128 гигов...

96 пока максимум, да (( Жду 64 гиговые плашки, тогда заменю.

У DDR5 скорости в 2 раза больше, плюс новые, не отлаженные разводки платы/плашки/контроллеры в проце. Так что ничего удивительного, что оно так деграднуло. Может, через пару лет поправят с новым железом, но пока так.

>легко обосраться

Мы так сейчас до рангов памяти дойдём, лол.

>я с чипсетными попутал.

Чипсетных возможно да. Хуй знает, у меня чипсетных тоже вагон, а слотов под картонки всего 3.

А вот это интересная тема. Взять китаемать под пять слотов писиай и 8 слотов рам. Обойдётся в десятку. Пятнашка проц. И восемь модулей DDR4.

>И восемь модулей DDR4

Будет четырёхканал и большой объём, по я не совсем понял, зачем всё это? Разве мы все здесь не гонимся за большим количеством врам? На оперативной памяти только Грока и запускать...

Думаю вот, стоит ли прикупить к паре моих тесл 3090. Много ли будет профита? Оно понятно, что производительность будет по слабым картам, плюс row_split тогда включать не имеет смысла. Но с другой стороны весь контекст по идее будет обрабатываться на первом ГПУ, а именно на 3090. Может есть у кого такая комбинация, поделитесь впечатлениями.

>Зайди в биос и посмотри, камон. =)

Да, оказалось проще, чем казалось. Странно что это не гуглится.

завтра поеду за райзером

>Но с другой стороны весь контекст по идее будет обрабатываться на первом ГПУ, а именно на 3090.

Всё так, бери, не пожалеешь. И контекст сможешь нормальный выставить, гоняя 6 квант и 16к контекста.

Так 8 слотов это больше, чем 4 на обычных матерях. Итого х2 возможный объём. У меня вот мамка поддерживает DDR4\DD5\ECC\non-ECC, а слотов 4. Опять же, дохера врам это хорошо и вкусно, но коричневые прослужат дольше рам стоит дешевле.

> Обиделся, вижу же. )

На что нужно обижаться?

> Претензия чисто одна — русский нужен