Мужики, мне сказали я промахнулся тредом, помогите пожалуйста

>Именно поэтому в опусе теперь все через мессаджез

Но там же префил вроде работает? Хотя я подробно не смотрел. В гпт там вообще адовый костыль с сообщением "вот кусок, продолжай как можешь", по моему только проблемы с такого компитишена.

>Уверен что он действительно полный?

Код не читал, так что процентов 90.

В том сервисе за кудосы, можно и вообще бесплатно, но с очередями. Помни, что твои запросы обслуживают рандомные аноны, и они вполне могут логировать все запросы.

Если есть нормальное железо, то можешь запускать у себя, максимум свободы, инструкции все в шапке.

Ну отлично блядь. Позавчера нейронка не лупилась и не шизила.

Сегодня лупится и шизит на тех же параметрах. ДА ЗА ЧТО БЛЯДЬ?!

Сегодня лупится и шизит на тех же параметрах. ДА ЗА ЧТО БЛЯДЬ?!

Таверночник подсирает. И/или герыч, если через него запускаешь. Это норма, привыкай, каждая установка таверны персонализирована.

Так я её не обновлял.Там же вроде отдельный батник для обновления и запуска есть для такого.

АШ ТРЯСЕТ БЛЯДЬ

>Так я её не обновлял.

Код на рандомные подсирания уже вшит. Можешь даже не искать его, он скрывается в глубинах зависимостей. Некоторые неразумные неофиты думают, что это крутят коммерческие сетки, но такие же приколы на локалках гарантируют, что всё это таверна.

где то промпт криво сохранился, удали сообщения с шизой и нажми повторная генерация

Я полностью с нового чата и пробовал и не раз уже. Лупа стабильно приходит через 5-7 сообщений.

Трщ, Прокопенко, ну вы чего тайны раньше срока раскрываете?

>это облегчит создание личностей таких персонажей

Больше штампов Богу штампов! А то в самом аниме они ещё не настоебали, ага.

> Но там же префил вроде работает?

Да, закидываешь типа сообщение от ассистента и оно развязывает язык. Хуй знает только в какую именно структуру оно превращается у них там перед скармливанием модели, при желании вполне могут подрезать и все эти префиллы подустанут.

Аналогично там продолжение в таверне часто косячно работает и все такое.

Ретроградный меркурий.

Просто тот промт ей был понятен а тут ты ее перегрузил. Или может такие отличаются параметры.

> Ну просто прикольная фишка, что модель шарит за анимешные жаргоны и т.д.

Чувак, нормальная модель знает лоры анимца, игорей, гач и прочего. Вполне можно обсудить твою вайфу просто по указанию имени и копирайта.

Карточки некоторые тоже потому так хорошо и работают, не только следование промту, но и подключение собственных знаний чтобы разыгрывать что-то в оригинальном сеттинге если не указано иное, подключать персонажей из серии в историю и т.д.

Насчет той модели что была в прошлых постах - хз.

Просто тебе в прошлый раз повезло, а сейчас нет. Стохастический попугай.

Причём тут таверна вообще? Лупы это следствие внутриконтекстного обучения. Распознаёт паттерн и схлопывается на нём.

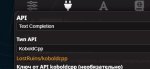

Вот кстати как это все выглядит в апи, через обычное подключение таверна кобальд

https://github.com/LostRuins/koboldcpp/issues/305

Лолблядь, порядок семплеров тоже захардкодили. Как и длину контекста.

Лолблядь, порядок семплеров тоже захардкодили. Как и длину контекста.

>порядок семплеров тоже захардкодили. Как и длину контекста

Год назад? Заебись, актуальную инфу нашел

Только вот все это настраивается уже давно

Весь openAI апи - хардкод. Опознание картинок - хардкод. С таким софтом разве что умалишённый будет связываться, лол. Всё работает не так, как ты хочешь, а как-нибудь.

> Гайд для ретардов для запуска LLaMA без излишней ебли под Windows. Грузит всё в процессор, поэтому ёба карта не нужна, запаситесь оперативкой и подкачкой:

Вот такое вылезло, когда запустил koboldcpp.py (exe нету)

Скачал кинтер и не помогло даже

Вот такое вылезло, когда запустил koboldcpp.py (exe нету)

Скачал кинтер и не помогло даже

В смысле эксе нету?

Я долбаеб конечный походу

Может ты сурсы качнул.

Да, в этом и было дело. Извините что накакал в треде.

Только вот я не очень понимаю как таверну запустить вместе с кобольдом теперь. Не вижу настроек в таверне где можно выставить кобольда

а мне зачем?

Спасибо, вроде заработало

Вопросик такой: Вот я чисто создал для теста тему и он 250 токенов генерит достаточно долго. Это я настройки каловые поставили где-то или это нормально? Все сделал по гайду из шапки

модель

koboldcpp/Fimbulvetr-11B-v2.q4_K_S

Нужно что-то выбрать где циферка перед "B" меньше?

модель

koboldcpp/Fimbulvetr-11B-v2.q4_K_S

Нужно что-то выбрать где циферка перед "B" меньше?

Она переобучилась на твоих ответах, теперь надо перекачивать модель.

железо у тебя какое? настройки запуска?

долго - понятие относительное, сколько токенов в секунду генерация пишет?

> железо у тебя какое?

2060 super и интел 5 10440

Настройки запуска никак не менял, так что стандартные видимо. Все делал по гайду из шапки

Оперативы 16 гигабутов

кек

Ну, скорость для процессора средняя

Двухканал память?

Укажи количество слоев 40 при запуске кобальда, вроде в 8 должно войти, быстрее будет

>Вообще ещё есть идея натравить суммаризатор на дамп архивача, взяв оттуда все достаточно большие посты, и получить этакую базу данных со всеми копипастами и кулсторями двача с оглавлением.

Таки взялся за эту идею. С лламой3 8b вроде бы неплохо выходит. Ещё заставил её теги придумывать.

--gradio-auth самое простое.

Да нет, даже в убабуге можно сделать, переписав тот самый инструкт (чел выше все верно сделал).

А уж по апи тебе ваще льется все без участия убабуги (нахой бы она лезла в промпт), а Таверна тебе все кидает в консоль.

Я юзаю карточки от первого лица уже с осени, и через родной фронт убабуги, и через силлитаверну, и через апи непосредственно в самописных скриптах. Нигде не подводит.

Можно еще в систем или ассистент теги завернуть, поэкспериментировать.

Ну за кобольд не скажу, но если он так делает — то он верх шизы.

Типа, по дефолту у тебя силлитаверна это оборачивает в такой промпт и потом кобольд еще раз в него же оборачивает?

Вряд ли Лост настолько тупой в пизду.

Если по апи ни у кого ничего не оборачивается, с чего бы у кобольда оборачивалось?

Ты генерируешь хуйню. =)

Сетки прекрасно генерируют даже без промптов, если это нормальные сетки. А дельфин какой-нибудь усрется на любом темплейте, хули толку-то.

Out Of Character — не от лица персонажа.

Да, коммандер плюс порадовал. =)

Бля, ну если Лост правда настолько тупой — то я извиняюсь, что я его считал не дегенератом…

OpenAI-like API

Но ведь на норм модели ничего не ломается. =) Тут уж сорян, но как есть.

Предположительно, кобольд лучше выкинуть нахуй, если он правда имеет захардкоженные инструкции.

А таверну так и запускать — стираешь все говно, пишешь карточку от первого лица, пиздато работает.

О, пасиба, значит Лост таки не совсем тупой?

База.

Главное — обернуть в верный промпт-формат, а уж что там написано — на вкус и цвет.

Кмк, чат-модели в принципе хуже из-за этого, а инстракт вполне норм.

Ну, в самом аниме с ними нельзя пообщаться, а тут… Кому-то хочется, че ты. =)

Прости, но это очень смешно! =D

>кек

Ты че мой комп обсираешь?

>Двухканал память?

Не знаю что это значит но плашки у меня две

Спасибо большое, попробую

кек, сейчас попробуем

>значит Лост таки не совсем тупой?

Если опен АИ апи или опознание картинок, то всё плохо.

Уважаемые анилингусы, помогите залетному с настройками ебучей ламы.

На днях накатил кобольд и файнтюновую ламу3-8б, которую обсуждал какой то анон в предыдущем треде. Подключил к таверне, прогнал, попиздел. Всё вроде отлично, но она страшно шизит на русском. Все ее ответы это прямой и дословный перевод с английского. Даже в карточке, которая описана как обычный чат бот, она либо пишет, что не понимает русский, либо переводит слово в слово с кучей ошибок. В рп на славянском окончательно сходит с ума и уходит в лупы, повторяя одно и то же предложение из раза в раз. Я пытался переписать карточку персонажа полностью на русском, пытался переписать систем промт, но эффект нулевой. Учитывая, как восхваляли тут новую ламу и ее разноязычный датасет это все выглядит совсем странно.

Вдогонку же вопрос по параметрам и пресетам, на что они вообще влияют? Я перепробовал всё, но эффекта почти не заметил. Где вообще найти нормальный гайд по настройке? Методом тыка я выяснил, что влияет исключительно оформление карточки. Пресеты я перепробовал все, и дефолтный инструкт для третьей ламы и альпаку и прочее. Качество генерации это не изменяет и характеры персонажей вообще не держит. Вспоминаю свой опыт двухлетней давности с чайной и понимаю, что та гораздо лучше справлялась несмотря на то что явно была тупее.

На днях накатил кобольд и файнтюновую ламу3-8б, которую обсуждал какой то анон в предыдущем треде. Подключил к таверне, прогнал, попиздел. Всё вроде отлично, но она страшно шизит на русском. Все ее ответы это прямой и дословный перевод с английского. Даже в карточке, которая описана как обычный чат бот, она либо пишет, что не понимает русский, либо переводит слово в слово с кучей ошибок. В рп на славянском окончательно сходит с ума и уходит в лупы, повторяя одно и то же предложение из раза в раз. Я пытался переписать карточку персонажа полностью на русском, пытался переписать систем промт, но эффект нулевой. Учитывая, как восхваляли тут новую ламу и ее разноязычный датасет это все выглядит совсем странно.

Вдогонку же вопрос по параметрам и пресетам, на что они вообще влияют? Я перепробовал всё, но эффекта почти не заметил. Где вообще найти нормальный гайд по настройке? Методом тыка я выяснил, что влияет исключительно оформление карточки. Пресеты я перепробовал все, и дефолтный инструкт для третьей ламы и альпаку и прочее. Качество генерации это не изменяет и характеры персонажей вообще не держит. Вспоминаю свой опыт двухлетней давности с чайной и понимаю, что та гораздо лучше справлялась несмотря на то что явно была тупее.

бля... моя модель не знает, что такое wanko...

отфыграть нерда она не сможет

а убабуга ёбаная всё еще не умеел в командер, сука.

давай начнем с того, что ты опишешь свой железячный сетап.

и я могу тебя только по убабуге проконсультировать, хотя думаю, они с кобольдом сильно должны быть похожи.

>давай начнем с того, что ты опишешь свой железячный сетап.

Да там все прилично для такой модели. 12 гигабайт врам и 16 оперативной. 35 слоев я поставил на видеокарту, так что генерирует шустро (где то в два раза быстрее, чем на модели из шапки, которая на 13б)

Не ожидай от маленьких моделей хорошего русского, тем более от лламы 3. Если надо русский - юзай Command-R

Тут недавно говорили, что 8б вресия третьей лламы слишком мала, чтобы понимать великий и могучий. Либо качешь 70б версию, либо ищешь нейронки, которые могут в русский официально. Но они тоже могут шизить.

Как по мне хороша aya-23, но другие Аноны говорили, что она тоже может шизить.

Ещё тут рекомендовали suzume-llama-3-8B-multilingual. Но у меня и ещё одного Анона, она тоже шизила и была слишком "соевой". Наверное, ты её и скачал, кстати.

>давай начнем с того, что ты опишешь свой железячный сетап.

о, кстати, хотел спросить, а как именно железо может влиять на генерацию кроме скорости, естесно. Помню генерил на проце и ллама часто жизить начинала независимо от модели, а на гпу с cublas вродё реже шизит.

Можешь заняться промт инженигрингом и интегрировать инструкцию на дополнительный cot где модель сначала будет думать на инглише, говорят тогда ответы на русском улучшаются. Но 8б ллама3 хоть и неплоха в языке для такого размера, все еще слабовата в нем.

> вопрос по параметрам и пресетам, на что они вообще влияют

Ставь simple-1 и забей. Можешь покрутить температуру и штрафы за повтор, но сильно лучше не отклоняйся. Можешь еще min-p шаблон, но он довольно шизоидный, хз как с ним что-то нормальное можно катать.

Если же ты про форматы промта - желателен тот с которым тренилась модель, разница может быть существенной. Возможно в этом причина твоих неудач, для 3й лламы в ласт версиях был готовый, главное чтобы опять жора не поломался.

> а убабуга ёбаная всё еще не умеел в командер, сука.

Что?

> могу тебя только по убабуге проконсультировать

Проконсультируй

Со скрипом можешь и командира попробовать, он в русский хоть как-то может. Мне кажется, что гонять мелкое 8В на русском это вообще уебищный вариант. Уж лучше переводить в гугле. А если уж сильно хочется, то напиши название модельки (файнтюна). Покажи настройки семплера, промпт формат, системный промпт и саму карточку. На русском шизить может на любом этапе. Даже просто потому что может.

ты лучше покажи пример генерации который тебя не устраивает.

Мы оценим норма это для твоего сетапа или нет.

Но вообще да, с 12 врам я бы особо много не ждал.

>а как именно железо может влиять на генерацию

в основном может хуйню выдавать если у тебя старая карта, из-за чего старая куда и/или тесла p40, из-за чего ты привязан к ллама.цпп. вот например я страдаю с коммандером, потому что криврукие обезьяны никак не впилят его по человечески в убабугу с лламой.

>Проконсультируй

без скринов с тем что и как ты запускаешь - мы ничего не скажем

>Можешь покрутить температуру и штрафы за повтор

у него наверняка какая-то детская ошибка, не нужно ему эти параметры крутить сейчас.

>в основном может хуйню выдавать если у тебя старая карта, из-за чего старая куда и/или тесла p40,

Та-а-ак... Генерю на M40 24GB. Дрова стоят с кудой 12.4. Какова вероятность пиздеца? Если я правильно нагуглил помню, то M40 - это одна из старейших. Даже старше P40. Но у меня в экспериментальной ветке кобольда командер работает лучше лламы... Может в убабуге тоже есть поддержка в каком-то экспериментальном релизе?

>не ожидай от маленьких моделей хорошего русского

Тут самый прикол в том, что модель из шапки, которая вроде как файнтюн вообще ламы второй, на русском отвечает точно так же. Разницы ровно ноль. По этому меня дурит и я не понимаю, почему тогда было столько разговоров о том, что третья лама гораздо лучше может в русский.

>если надо русский - юзай Command-R

Я сильно сомневаюсь, что даже на задушенном кванте у меня запустится командор.

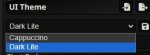

>покажи настройки семплера, промпт формат, системный промпт и саму карточку

Прикрепил. Я пробовал разные, но в основном сидел на этих. Разницы не заметил. Моделька Llama-3-Lumimaid-8B.

>ставь simple-1

Либо сани мудацкие, либо я мудак, но simple-1 у меня нигде нет.

>M40

ну и нахуя ты её купил? Все же тут рекомендуют p40.

Я не знаю, тут ни у кого скорее всего кроме тебя такой карты нет.

примеры генерации давай, заебал.

>я не понимаю, почему тогда было столько разговоров о том, что третья лама гораздо лучше может в русский

Ллама3 имеет мало русского в датасете, даже 70Б, а восьмёрка ещё и слишком маленькая для серьёзной мультиязычности. Нормально в русский умеют только Command-R/Command-R+, и Клод.

Все тюны третьей лламы говно. А 90% даже чистой лламы в ггуфах - поломаны. Качай чистую, на русском пиздит сносно, хотя иногда коверкает слова, но это лучшее, что можно найти в таком размере.

>вопрос по параметрам и пресетам, на что они вообще влияют

Если выше температура - больше шизы, выше мин п - меньше рандома в ответах.

>примеры генерации давай, заебал.

Как бы тебе сказать... Я все примеры удалял. Да и не тестил в полноценный РП... Сейчас попробую нагенерить, что-нибуть. Есть какие-нибудь предпочтения в плане модели, карточки?

И я не этот Анон, а другой. Но suzume-llama-3-8B-multilingual у меня тоже есть на харде.

Как сделать на таверне чтобы моделька писала более длинные и кумовые ответы? Или надо модель менять?

Использую эту

https://huggingface.co/Sao10K/Fimbulvetr-11B-v2-GGUF/blob/main/Fimbulvetr-11B-v2.q4_K_S.gguf

Использую эту

https://huggingface.co/Sao10K/Fimbulvetr-11B-v2-GGUF/blob/main/Fimbulvetr-11B-v2.q4_K_S.gguf

зачем мне твои примеры, чел?

Я спрашивал у человека, который жалуетс на проблему.

дежурные ночные ванги локального-кум-треда раскинули свои гадальыне карты

>зачем мне твои примеры, чел?

Я хуй знает, ну ты же попросил... Не могу же я просто проигноривать тебя?

Я так и подумал, что ты просил у того Анона, поэтому и уточнил, что я другой. Ну ладненько... Всё равно спасибо, что пояснил.

Какая версия таверны?

1.12.0

> Я сильно сомневаюсь, что даже на задушенном кванте у меня запустится командор.

В четвёртом запуститься должен.

> Прикрепил. Я пробовал разные, но в основном сидел на этих. Разницы не заметил. Моделька Llama-3-Lumimaid-8B

Поставь чистую лламу без вот этого говна. И запусти. Если все равно будет шиза, попробуй solar uncensored.

Так в 12 версии нет ban eos token. У меня почему-то только skip special tokens опция. В чем прикол?

>Я спрашивал у человека, который жалуетс на проблему.

Ответы в таком стиле. Я тестил модель на кумопригодность, но она обсиралась даже с генерацией sfw-действий. Но только на русском, что характерно. Карточка эта дефолтная, которая осталась у меня с древней таверны, когда я кумил еще через жопен турбо.

>Так в 12 версии нет ban eos token.

В душе не ебу, о чем ты, братик. У меня API стоит кобольт классик, а не текст комплетишен. Может в этом дело.

>В четвёртом запуститься должен.

Придется попробовать видимо. Не хочу ебаться с переводами. Хочу просто нормальную сессию русифицированной дрочки.

ох срань...

а это только на лламе3 или на всех остальных тоже?

> пик2

Вот там где universal-light оно и должно быть. С подобным семплингом как раз шиза ожидаема, а в русском может быть повышенное количество ошибок. Как бы там не верили сектанты в min-p, но это так.

Ты про пример генерации? Я тестил только Llama-3-Lumimaid-8B и Fimbulvetr-11B. Ответы в обоих случаях примерно одинаковые. С вкраплениями каких то ебанутых конструкций (у меня была фраза "украинский skirt") и обшей шизой, когда модель не понимала что делаю я, и что вообще делала она одно сообщение назад.

>Вот там где universal-light оно и должно быть.

У меня там есть только simple-proxy-for-tavern.

>Вот там где universal-light оно и должно быть.

У меня там есть только simple-proxy-for-tavern.

Забыл отреплаить твой ответ

> Придется попробовать видимо. Не хочу ебаться с переводами.

Буквально одну кнопку нажать. Можно даже сделать автоматически перевод. То есть по факту будешь получать текст на русском. Единственный минус, это все еще гуглоперевод со всеми вытекающими. А командира будешь долго ждать со скоростью 1 токен в секунду.

Ну или модельку умеющую в русик ставь.

На третьей лламе нельзя банить eos и скипать спциальные токены, потому что иначе она не затыкается и начинает писать ответы за всех сразу.

>Единственный минус, это все еще гуглоперевод со всеми вытекающими.

Я про это и говорю. Ответы там будут такие же шизоидные, как если бы я без перевода просто на русском общался с ламой.

Нет. Там только перевод говном будет. Ответы будут нормальные.

Она это и без бана делает.

Пора признать очевидное.

ЛАМА 3 - ГОВНО ЕБАНОЕ. ОЧЕНЬ ТРУДНО ЗАПУСТИТЬ БЕЗ ОШИБОК. ОЧЕНЬ ЛЕГКО ЛОМАЕТСЯ. ПЛОХО МОЖЕТ В РУССКИЙ ЯЗЫК. НЕ ПОДДАЕТСЯ ФАЙНТЬЮНАМ ВПРИНЦИПЕ.

ЛАМА 3 - ГОВНО ЕБАНОЕ. ОЧЕНЬ ТРУДНО ЗАПУСТИТЬ БЕЗ ОШИБОК. ОЧЕНЬ ЛЕГКО ЛОМАЕТСЯ. ПЛОХО МОЖЕТ В РУССКИЙ ЯЗЫК. НЕ ПОДДАЕТСЯ ФАЙНТЬЮНАМ ВПРИНЦИПЕ.

Альтернативы есть? Только без командиров 105В.

Мистраль и его файтьюны, микстраль, командир, квен, мику.

Без бана это делают только сломанные кванты.

> Мистраль и его файтьюны

Говно.

> микстраль, командир, квен, мику.

Ты сравниваешь модельку 8В и 70В?

Получается, все кванты сломаны.

>ОЧЕНЬ ТРУДНО ЗАПУСТИТЬ БЕЗ ОШИБОК.

Запускается без ошибок в убабуге. То, кванты сломаны - проблема квантов. Отлично может в русский язык, по сути, лучше русскоязычных моделей и нет.

Да, у лламы есть проблема с тюнами, потому что датасеты говно, а люди, которые занимаются тюнами берут дпо и прогоняют его дефолтным трейнером. Система дошла до того уровня сложности, когда орочьи технологии не работают и обмазывая модель говном - уже не получается сделать её "лучше".

Всякие хералион b модели даже не рассматриваю, заебёшься ждать вывода. А мику оказалась говном, уступающим даже 8b лламе на несколько порядков.

>Говно

Солар и его файнтьюны ебут ламу 8В.

А Солар это мистраль.

>Ты сравниваешь модельку 8В и 70В?

Понятно что мистраль сравнивается с 8В, командир, мику и микстраль с 70В, а квен и с тем и с другим.

>Отлично может в русский язык, по сути, лучше русскоязычных моделей и нет.

Толсто блядь, даже 70В отсасывает у 34В командира, про 105В я просто молчу.

>мику оказалась говном, уступающим даже 8b лламе

Ты просто вытек уже из треда, прекрати.

> Солар и его файнтьюны ебут ламу 8В.

> А Солар это мистраль.

Ебет в чем? В русике?

> Понятно что мистраль сравнивается с 8В, командир, мику и микстраль с 70В, а квен и с тем и с другим.

За 70В не скажу, не запускал. А на уровне 8В ллама все-таки получше.

C русской карточкой на русские сообщения эта дрисня отвечала транслитом. Нахуй это говно ёбаное.

Давайте делать правильные выводы. На сегодняшний день, русский язык сосёт. И даже всякие командиры куда лучше будут говорить на английском.

Так она не обучалась на русском.

>русский язык сосёт

Нет. Командир 34B выдает текст пикрелейтед. Это автоматом отправляет все остальные модели в мусорку, тут на равных с чатгопотой бой идет.

> сожмявшись

> шепотите

> между них

Llama-8B-instruct выдаёт тексты такого же уровня, но на английском и при этом не выдумывает несуществующих слов.

Скачал командира 35b, ну такое себе. Много шизы, точно так же коверкает слова. В целом, чуть получше 8b лламы, но не намного.

>Я сильно сомневаюсь, что даже на задушенном кванте у меня запустится командор.

Используй aya-23-8B. Она хорошо на русском говорит. Это что-то типа командора на минималках.

Я думаю, что ощутимо лучше. Другой вопрос, что при долгом ожидании сообщения или тем более, когда ты вложил реальные бабки в Р40, хочется чего-то совсем на другом уровне. А получаем плюс минус ту же парашу с теми же проблемами.

А чатгопота выдаёт. У неё хуёвый русский.

>Llama-8B-instruct выдаёт тексты такого же уровня, но на английском

На английском тексты такого уровня выдает много что, тот же мистраль.

А ты покажи на русском.

Кому не похуй на гопоту? Она тебя зарепортит нахуй за такую карточку.

> На английском тексты такого уровня выдает много что, тот же мистраль.

Вот только мистраль отказывается отыгрывать персов, у всех персов одна и та же соевая личность.

> А ты покажи на русском.

Я могу перевести в яндекс переводчике нормальный английский текст. И он, без всякой иронии, выебет и гугл, и командира, и кого хочешь. Единственная проблема, что к тебе могут постучать в дверь после таких запросов.

>когда ты вложил реальные бабки в Р40

Она копейки стоит, 1/10 от 4090, и сама картонка - говно. Что ты там ожидаешь от нее?

>А получаем плюс минус ту же парашу с теми же проблемами.

Не совсем. Когда ты можешь быстро рероллить умную семидесятку (что требуется не так уж часто) - ощущения совсем другие.

Я не от карточки, а от сетки ожидаю.

>Вот только мистраль отказывается отыгрывать персов

А ты его вообще запускал, лол? Какую версию и когда?

Если можешь быстро рероллить 70В, то да. Ощущения наверняка получше. Но у меня она генерит очень медленно, так как я на цпу. И получается, что незначительное улучшение качества не стоит значительного увеличения ожидания.

Запускал. И чистый мистраль, и мейд всяких, солар. Новенький мистраль вышел, тоже запустил. Но его только запустил на пару сообщений. Долго его не тестил.

Имея лишь всратую нищуковую Р40 ты слишком много хочешь, походу.

Покажи, что он у тебя выдает. Может, я что-то не так настроил.

> Имея лишь всратую нищуковую Р40 ты слишком много хочешь, походу.

Начнём с того, что я и Р40 не имею.

>Используй aya-23-8B.

Не вижу особого смысла в этом. Аноны выше были правы, что кастрированные модели уровня 8-13B можно хавать только на английском. Попробую скачать урезанного командора, если на 4 кванте скорость будет терпимой, то останусь на нем.

Ну вот дефолтный солар, например, на дефолтной акве

>Имея лишь всратую нищуковую Р40 ты слишком много хочешь, походу.

Модели, которые влезают в 24гб врам, на "всратой нищуковой Р40" работают быстро.

>Не вижу особого смысла в этом. Аноны выше были правы, что кастрированные модели уровня 8-13B можно хавать только на английском.

А ты попробуй. Приятно удивишься. По сути, она тоже базируется на командоре или что-то в этом роде. Да и разраб у неё тот же, а именно CohereForAI.

Если я правильно понял, то aya-23 это попытка обмазать командора мультиязыковыми датасетами.

> Ну вот дефолтный солар, например, на дефолтной акве

Скинь карточку аквы. Хочу потестить с ней лламу и командира, чтобы сравнить.

Ну я скачал Q4_K_S, относительно быстро. Но не то, чтобы это добавляло хоть какого-то смысла. Язык такой же ломаный, а мозгов у модели не наблюдается в принципе. Слабо понимает, что от неё требуется и о чём вообще речь идёт, постоянно перескакивает с пятого на десятое. Попросил анекдот про быдло, начала рассказывать про Японию, а закончила предложением поиграть в инструктора и ученика в автошколе. Пиздец просто. Ллама даже в 8b может придерживаться темы разговора.

Разумеется есть космическая разница между работой на цпу и Р40, тот анон просто пальцы гнет что он большего ожидал.

Да уже возможность не ждать по пять минут ответа любых денег стоит.

Удваиваю реквест.

>А ты попробуй.

Да попробую, че нет. Просто почитав реплаи у меня теперь еще больше скепсиса по поводу всей этой движухи с микро-моделями.

>Если я правильно понял, то aya-23 это попытка обмазать командора мультиязыковыми датасетами.

Разве aya это не урезанный командор?

> --gradio-auth

Эта хуйня только на вход в настройки обобуги, для --public-api так себе варик, я могу навесить "пароль/ssh ключ" на подключение к самому api? Или нихуя страшного, что в бек ко мне могут стучаться всякие пидоры, но не получать ответа, т.к. не используют формат OpenAI API?

Модель хороша - факт, но с норм карточкой. Ясен хуй, что я модель юзал и на других карточках и получалась хуйня. Хотя я сейчас и систем промт/семплеры под себя подправил, теперь чувствую "отыгрыш"!

>Просто почитав реплаи у меня теперь еще больше скепсиса по поводу всей этой движухи с микро-моделями.

Ну мне вроде зашла. Только инструкт не забудь поменять. Для sfw РП, вроде не плоха... Для nsfw вроде тоже. По крайней мере лучше, чем метавская 8b ллама 3 и suzume ллама 3

>Разве aya это не урезанный командор?

Ну его можно и так назвать и по сути да. Но я думал, ты имел ввиду командора v01 на 35B

Я другой анон, но вот вам старая аква от апреля 23 года.

>Модель хороша - факт,

Какая у тебя модель, кстати?

мимо другой анон

Двач трёт метаданные, заливай на catbox.moe.

Спасибо.

Это дефолтная картонка таверны, как вышло что у вас её нет? Таверна поставляется со всеми персонажами коносубы по дефолту.

А блять, я слепой еблан. Отбой. 4:20 даёт о себе знать.

https://files.catbox.moe/sexojs.png

>Но я думал, ты имел ввиду командора v01 на 35B

Да, я еблоид. Я думал айа есть только на 8Б, а там оказывается еще версия и на 35 есть.

>лучше, чем метавская 8b ллама 3 и suzume ллама 3

Ну, тогда точно покатаю. Хуже по крайней мере уже не будет.

>а убабуга ёбаная всё еще не умеел в командер, сука.

Всм? Норм работает коммандер в ней, я только в уге все запускаю, про кобольд вообще забыл.

> Это дефолтная картонка таверны, как вышло что у вас её нет? Таверна поставляется со всеми персонажами коносубы по дефолту.

Ты про силлитаверну? Если да, то в первый раз такое слышу. Если несложно, то скинь картинки этих чаров на catbox какой-нибудь.

После какой то версии Силли вырезала дефолтные карточки из конасубы. Если щас качать нулевую версию с гита, то там будет только серафима или как ее там. В любом случае, карты эти древние и хуево написаны.

Лол, раньше были Аква, Мегумин и Даркнесс. Видимо в последних версиях сменили комплект поставки.

Ладно, держи эту троицу

https://aicharactercards.com/character-cards/anime-manga/aicharcards/aqua/

https://aicharactercards.com/character-cards/anime-manga/aicharcards/megumin/

https://aicharactercards.com/character-cards/anime-manga/aicharcards/darkness/

>https://files.catbox.moe/sexojs.png

Спасибки!

> там оказывается еще версия и на 35 есть

А, ну это да. Вот она прямо достойно работает. Так бы и юзал, если бы не полтора токена в секунду.

>Ну, тогда точно покатаю. Хуже по крайней мере уже не будет.

Вообще, что-то меня одолевают ощущения, что одна и таже модель от Анона, к Анону может отличаться. Хуй знает с чем это связано, но не зря же мне Анон в прошлом так яро рекомендовал suzume-llama-3-8B-multilingual. Но у меня и у ещё двух Анонов была шиза. Значит что-то не так. Может быть это с железом связано? Да и я слышал, что кто-то писал, мол aya-23 шизит. Так что, мб она у меня зорошо летает из-за того, что у меня старушка M40.

>Мегумин

ОООО! ВРЕМЯ КУМИИТЬ! СПАСИБО, АНОН!

Спасибки, за информацию. В любом случае, думаю, они подойдут для тестов.

Использовался ли лорбук или просто голая карточка?

>одна и таже модель от Анона, к Анону может отличаться

Я думаю что дело в том, что у всех разные критерии адекватности. Хотя я только вкатываюсь в локалки, мне кажется что проблема именно в том, что нет нормальной системы оценивания. Меня бесит сухой и прямой текст, где тупо описываются действия персонажей. Я невольно сравниваю это дело с тем, что выдавала труба, когда я на ней еще сидел, и это пиздец как бесит. Души в нейронке нет, хуй знает. И Lumimaid я кстати тоже по совету анона ставил, который сказал, что она отлично держит характер и не шизит. В общем, всё персонализировано, правда где то по середине, правды больше нигде нет.

Ну может и так... Хотя всё же мне кажется, что модели действительно генерят по разному у разных Анонов. И зависит это либо от железа, либо от настроек. Хотя, думаю, что в ситуации с той же сузумой, хотя бы у одного Анона были бы нормальные настройки.

Но, думаю, что всё же разность восприятия разных Анонов тоже влияет, это да. Этого отрицать тоже никак нельзя.

И всё же надеюсь, тебе понравится Ая. Она вроде ничего...

>мне кажется, что модели действительно генерят по разному у разных Анонов.

Либо блять дело всё таки в ебаных карточках. Я прогонял русский через дефолтную акву, а она и сама по себе тупая, потому что написана дегенератами чуть ли не под пигмалион. На английском у нее ответы внятные, но всё равно тупорыльно дебильные, а на русском она вообще с ума сходит, потому что не понимает, что от нее требуют. Надо попробовать взять жирную карту токенов под 800 и протестировать с ней. Возможно чудо случится и теория подтвердится. А может и нет. Все таки модель обрезанная, тут никуда не деться.

В общем. Обе модельки не смогли справиться с Аквой. Но стоит так же признать, что здесь не полностью вина ЛЛМ, потому что в самой карточке тоже нет никакой инфы, что на попытки выебать Акву, она будет реагировать подозрительно и обзываться хиккинитом. Но вот что мне не нравится в мистрале так это то, что он пиздит про "I am always happy to help and guide". Эта ебучая личина ассистента вылазит постоянно и мешает погружению. Даже если это безобидно и не помешало куму, из персонажа дико выбивается. Я думаю, что надо либо кого попроще взять, либо допилить Бакву, а потом уже сравнивать. Сейчас персонаж не прописан даже на уровне карточки.

Ну может и так. Однако, разве не стоит переводить карты для нормального руссского? Просто, судя по всем это тоже влияет.

Я тут парочку перевёл на скорую руку с гуголь транслейтом и есть ещё карта другого Анона. Не знаю, не против ли он если я её залью... Пока не буду, мало-ли он против.

https://files.catbox.moe/nces5o.png

https://files.catbox.moe/ev423p.png

Я думаю, что надо переводить примеры диалогов и первое сообщение. А инструкции оставлять на английском, чтобы лучше их понимало и меньше шизило. Но это только мое мнение, на практике не пробовал.

Ну в одной карточке про институт 13 я перевёл описание и первое сообщение. В другой я перевёл только первое сообщение. Разницы, пока не вижу...

Хотя трудно РПшить, когда ты тупо "тестируешь"

А ты не тестируй, ты рпшь.

>Сейчас персонаж не прописан даже на уровне карточки.

Потому что ее прописывали еще в прошлом веке и не зря вырезали к хуям собачим из таверны. Я помню, как ебаная Аква тупила даже на трубе. А труба вообще была всеядной и выдавала приличные вещи при минимуме усилий. Тут тупо старания картодела виноваты.

>Однако, разве не стоит переводить карты для нормального руссского?

Я переводил, но так как исходный материал всё равно был жиденький, это не сильно помогло. По опыту могу сказать, что решает именно стиль написания карты и первое сообщение. Если в обоих случаях всё криво и надрищено без нормального форматирования, то позитивного эффекта не будет.

>ОООО! ВРЕМЯ КУМИИТЬ! СПАСИБО, АНОН!

У меня для нее кстати live2d моделька завалялась, которая анимации проигрывает в зависимости от настроения персонажа.

Что за труба?

> Тут тупо старания картодела виноваты.

Нет, не тупо. Справедливости ради, помимо картодела обосрались и сами модельки. Ебаная ллама подхватила стилистику сообщений и проебала кавычки при реплике. Срала ебучими ахахаха и подмигиваниями без всякой меры. Ну и в целом обдристалась. Мистраль и подавно не смог выйти из роли гида-ассистента, сука. Зато без ебучих ахахаха и кавычки не проебал.

>live2d

Скинь что-ли. Может хоть с ней поиграть нормально получится.

Ну да... Но мысль о том, что что-то может работать не "так, как надо" прям пиздец отбивает желание РПшить. Хочется то-ли на другую модель переключиться, то-ли пойти сэмплеры потеребить.

>По опыту могу сказать, что решает именно стиль написания карты и первое сообщение.

Ну, судя по всему это так. Соглашусь с тобой.

Но вроде как на переведённых картах, русский лучше работает. По крайней мере, та же сузума работала получше. Так что если уж и тестить русик, то на полностью переведённых картах.

>Если в обоих случаях всё криво и надрищено без нормального форматирования, то позитивного эффекта не будет.

Вполне вероятно. Пока у меня нету достаточно опыта, чтобы возразить обратное.

>в зависимости от настроения персонажа.

А для определния настроения разве не нужна отдельная нейронка? Или как это работает?

Удваиваю реквест

>Что за труба?

GTP-3.5 Turbo, в моем случае версия 0301, на которой я дрочил с 22 года по март 24, если память мне не изменяет.

>Ебаная ллама подхватила стилистику сообщений и проебала кавычки при реплике.

Ну так она и будет опираться на предыдущие сообщения в чате. Это норма для любых моделей, вроде как. Если только через промт ей не вбить как она должна форматировать текст, она может тебе в целом отвечать только аххахаа и подмигиваниями с мурмурами.

> Что за труба?

> GTP-3.5 Turbo

Так она же говно. Хотя наверное получше 8В.

> Ну так она и будет опираться на предыдущие сообщения в чате. Это норма для любых моделей, вроде как. Если только через промт ей не вбить как она должна форматировать текст, она может тебе в целом отвечать только аххахаа и подмигиваниями с мурмурами.

Это понятно, что она будет опираться на сооьщения и обезьяничать. Но конкретно именно ллама очень часто любит залупаться. К счастью, да, часть проблем может решиться промптингом. А вот мистраля я в свое время так и не смог убедить стать жестокой яндере. Ему просто похуй на промпты.

>Так она же говно.

Вот тут нихуя не соглашусь. Труба отыгрывала самую дикую хуйню, которую я ей скармливал и делала это на уровне. Да, иногда тоже шизила и контекст у нее был мизерный, но в остальном это был ахуенный выбор. Персонажей держала, против рейпов и других извращений не сопротивлялась (в отличии от соевой четверки и клода). Единственный ее минус только в том, что это всё таки API и за него надо платить. Хоть и сравнительные копейки.

>А вот мистраля я в свое время так и не смог убедить стать жестокой яндере.

А вот трубешница могла. Могла и в фемдом и в фембой и в томбой. И насилие хорошо расписывала и даже жесткое гуро (но недолго, после пары сообщений начинала выдыхаться).

Я с трубой не общался в таверне. Поэтому промптинг там был дефолтный и по сути она вела себя довольно соево из-за этого. Так что может быть я и не прав.

https://files.catbox.moe/ueliea.7z

Держи всю троицу коносубы.

Почитай инструкцию на странице экстеншона чтобы понять что куда ставить и как настраивать.

https://github.com/SillyTavern/Extension-Live2d

>А для определния настроения разве не нужна отдельная нейронка?

Character expressions по дефолту встроен в таверну и интегрирован с live2d, придется только ручками анимации модели эмоциям сопоставить в настройках live2d.

Ооо... Благодарю, Анонче! Это пиздец как круто. И спасибо за ссылочку на гайдыч!

>Обе модельки не смогли справиться с Аквой.

Хоть бы написал какие.

Ну значит модель соевая. Есть вариант конечно ручками подредактировать сообщений 5-10 и направить ее по нужному сценарию, но это конечно дикий гемор каждый раз переписывать то, что уже написала за тебя нейронка. Ощущение будто сам с собой в блокноте общаешься.

>После какой то версии Силли вырезала дефолтные карточки из конасубы.

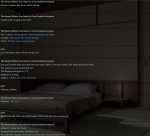

Пиздец, вся таверна по сути написана для отыгрыша коносубы, даже цветовые темы в честь персонажей названы и под них подстроены.

Больше нет. Теперь их две и обе рыготные. Разраб на силе вроде в одном из патчноутов написал, что хочет убрать весь неоригинальный контент из таверны, включая конасубский, который под копирайтом находится.

Переименовать темы он не догадался? Копирайт по его мнению распространяется на цвета? Едрить он дегенерат.

А в чем смысл иметь названия тем, связанных с персонажами, когда самих персонажей больше нет?

И если я не ошибаюсь, мегумины и даркнесы перешли в сили таверну еще с оригинальной таверны, когда разраб только начал перепаивать ее. На оригинальной таверне кстати конасбуские еще остались и висят в репозитории гитхаба.

Да, подтверждаю, всего две темы.

Алсо, раз такая пьянка. Знает кто где достать другие темы? А то от этих двух глаза вытекают нахуй.

Так я писал, что Llama-3-8B. А у второго анона, если ему верить, дефолтный солар.

Благодарю.

>Знает кто где достать другие темы?

Там вообще есть пункт для кастомной CSS, но я нигде не видел чтобы его использовали. Я бы тоже поменял тему на более вменяемую, но брать неоткуда.

Таверна вообще ебаный франкенштейн. Чего только не напихали внутрь за полтора года, а нормальный интерфейс до сих пор не сделали.

>Так я писал, что Llama-3-8B.

Т.е. когда ты говорил "обе" ты имел ввиду что ты тестировал ламу, а вторая это солар, который я запостил? Ясно.

Я не соглашусь что модели не справились с Аквой, с тем что прописано в картонке они обе справились, но лама у тебя какая-то слишком словоохотливая получилась и не выдержала стиль первого сообщения с описаниями действий, в отличие от Солара. Потому я и говорил выше что солар лучше третьей ламы.

Так смысл не в названиях, а в самих темах. Переименовать Aqua blue в blue и пользоваться дальше.

Так он же все темы кроме двух убрал, не только конасубские. И самое главное что ни добавил ни одной светлой темы.

> Я не соглашусь что модели не справились с Аквой, с тем что прописано в картонке они обе справились, но лама у тебя какая-то слишком словоохотливая получилась и не выдержала стиль первого сообщения с описаниями действий, в отличие от Солара. Потому я и говорил выше что солар лучше третьей ламы.

Словоохотливость это вопрос промпта, я ее так запромптил, чтобы она отвечала развёрнуто. Здесь важнее то, что по сути они писали. А по сути Аквы нет ни там, ни там.

Ещё раз, спасибо, Анончик!

>А по сути Аквы нет ни там, ни там.

Просто у тебя свое понимание Аквы и ты отчего-то считаешь что модель должна ему соответствовать автоматом.

Модель отыгрывает то что в карточке написано, а не то что у тебя в голове. То что в карточке написано - она отыграла, не нравится - правь карточку. Ну и лорбук подключай.

> Модель отыгрывает то что в карточке написано, а не то что у тебя в голове.

Во-первых, не в голове, а в ранобе или аниме.

> То что в карточке написано - она отыграла, не нравится - правь карточку. Ну и лорбук подключай.

Во-вторых, обе модельки не справились даже с карточкой, потому что одна из них откровенно палится ассистентской личиной, а вторая срет своими ахаха. И никакие промпты эту хуйню исправить не смогут. Вот сообщения сделать короткими - это пожалуйста, а убрать вот эти въевшиеся шаблоны - хуй.

>Во-первых, не в голове, а в ранобе или аниме.

Ты уверен, что в датасете есть инфа о так называемой акве и ее роли в ранобе или аниме? Нейросетям вообще по факту насрать на источник персонажа. Они будут опираться только на текст в простыне персонажа. Ты можешь вообще переписать у себя в карточке Акву из тупой пробки без трусов в умную пробку с шикарными и роскошными трусами. Нейросети будет насрать на несоответствие, потому что ей важен только промт, т.е. инфа, которую ты ей и скормил.

мимо другой

капча невалидна

> потому что одна из них откровенно палится ассистентской личиной

Охуеваю как ты далеко идущие выводы cделал с одного скрина.

А что там делать, если я уже общался с мистралем и знаю, что это такое?

> Во-первых, не в голове, а в ранобе или аниме.

> Ты уверен, что в датасете есть инфа о так называемой акве и ее роли в ранобе или аниме?

В жирных моделях может и быть. В мелких, если и есть что-то, то мало инфы.

> Нейросетям вообще по факту насрать на источник персонажа. Они будут опираться только на текст в простыне персонажа. Ты можешь вообще переписать у себя в карточке Акву из тупой пробки без трусов в умную пробку с шикарными и роскошными трусами. Нейросети будет насрать на несоответствие, потому что ей важен только промт, т.е. инфа, которую ты ей и скормил.

Я это понимаю. Так же я понимаю, что карточка написана плохо и это является главной проблемой. Тем не менее мой посыл в том, что нейросетки плохо создают иллюзию общения с карточкой. Все равно наружу вылазит вся нейросеточная суть.

>Тем не менее мой посыл в том, что нейросетки плохо создают иллюзию общения с карточкой. Все равно наружу вылазит вся нейросеточная суть.

А вот тут вылезла?

Может все же в карточке дело?

Что на этом скриншоте не демонстрирует нейросеточную суть?

>Но вот что мне не нравится в мистрале так это то, что он пиздит про "I am always happy to help and guide". Эта ебучая личина ассистента вылазит постоянно и мешает погружению.

Ну и где тут эта личина ассистента?

Потыкал немного этот ваш Moistral. Ну, диалоги у него чуть поживее, и карточку/лорбук он, вроде как, понимает неплохо. Но всё равно как будто немного тупее третьей ламы.

Залупается походу. И с хуя ли они решили драться? Я так понимаю в карточке ни слова о том, что они должны кончить. То есть нейронка путается.

Только с последним персом непонятное что-то. Походу нейронка путается. Здесь особо и отыгрыша нет. У них же 0 реплик. Возьми какую-нибудь цунгпт и попроси ее что-то сделать. Там хоть сразу понятно будет, что оно отыгрывает.

В целом такую карточку оно походу не вывозит. В лламу тоже не верю.

Он и есть тупее. Но секс сцены описывает лучше. И секс фантазии тоже.

Все оно вывозит, хватит аутотренингом заниматься. В итоге я убедил трех из пяти, взял их, потом с их помощью изнасиловал двух оставшихся нитакусек.

Потом дверь открылась, мы перешли в другую комнату и там все началось заново.

Для такого конфига вполне нормальная скорость.

>Кмк, чат-модели в принципе хуже из-за этого

Нет, модели без разницы, будет ли она дописывать с префила или с начала ответа, тут проёба нет.

>Ну, в самом аниме с ними нельзя пообщаться

Всегда мечтал уебать тсундере?

>Если опен АИ апи

А есть ли хоть один повод использовать неродное апи, когда есть родное?

>Генерю на M40 24GB

>Maxwell

>Double-Precision Performance - 0.2 Teraflops

Земля стекловатой.

>ОЧЕНЬ ЛЕГКО ЛОМАЕТСЯ

Только это верно. ХЗ почему так. Остальное не верно, ждём норм тюнов.

Командир 104 же, так что всё окей, меньше 105!

Какой же кринж.

>незначительное улучшение

Лол, я от перехода от 70 к 104 чувствую значительное улучшение, а ты просто от 8 до 70 "незначительное".

>март 24

>турба

Ебаааатьь.

>но я нигде не видел чтобы его использовали

Потому что есть юзерстили. Хотя я туда отступ для сообщений бота добавил, чтобы показывать имя модели, не перекрывая текст.

Мне интересно, а каким промптом нейросетке объяснять, что когда дело до кума доходит, то надо описывать подробно?

> Все оно вывозит, хватит аутотренингом заниматься.

Так может это ты аутотренишь? Серьёзно, ты вчитайся, что оно пишет. Просто одни и те же реплики. София практически зациклилась. Я понимаю, что моделька маленькая, и на безрыбье и рак не рак, но как такое можно в принципе называть хоть каким-то отыгрышем? Это же ведь пиздец. Хотя ладно, она по крайней мере не спутала персов между собой, уже недурно.

>Возьми какую-нибудь цунгпт и попроси ее что-то сделать.

Аска пойдет?

> Лол, я от перехода от 70 к 104 чувствую значительное улучшение, а ты просто от 8 до 70 "незначительное".

Единственная значительная разница, которую я смог заметить, это скорость генерации. А так у 70В текст немного покачественней и чуть больше деталей. Может быть на 104В уже какие-то качественные отличия есть, здесь не знаю, не запускал.

Пойдёт. Кстати, ты специально ее попросил коротко отвечать?

Вопрос промптоспециалистам, если таковые тут имеются. Вот есть у меня лорбук, где, к примеру, описаны всякие законы и культурные особенности местности, в которой проходит ролеплей. Можно ли как-нибудь сделать так, чтобы персонаж не тянул рандомно куски из этого лорбука, не относящиеся к ситуации? Ну, типа - "Кстати, а ты знал шо у нас в стране в жопу долбят за ношение адидаса?", при том что разговор в данный момент про то, какой сорт чая лучше.

Какой моделькой пользуешься?

Конкретно сейчас - llama 3, но вообще этот косяк вылезал на всех моделях, которые пробовал.

Нет, но модель сильно копирует стиль первого сообщения.

https://www.reddit.com/r/LocalLLaMA/comments/1d1bnql/awesome_prompting_techniques/

>https://files.catbox.moe/ueliea.7z

Не кочает почему то

та же фигня, что то либо у меня либо на сайте выебывается и не открывает страницу

вроде раньше катбокс работал

>https://files.catbox.moe/ueliea.7z

Не кочает почему то

та же фигня, что то либо у меня либо на сайте выебывается и не открывает страницу

вроде раньше катбокс работал

Только что проверил - все работает. Попробуй еще

Ага работает, без перезагрузки модема даже на катбокс не заходило

Хотя инет вроде работал, хз

Честно говоря не знаю как это предотвратить. Можно конечно лорбук задвинуть подальше в контекст, но мне кажется это совсем не решение.

Анон, можешь зашарить карточку пжалста? Хочу глянуть как она там прописана.

Почему Лама 3 говно ебаное? Ответ на пике. Это говно очень быстро входит в луп и начинает повторять предыдущие сообщения. Плюс цензура вылезает сразу как начинается какая-то движуха.

Пасибо:*

Зайди в лорбук и отредактируй записи чтобы они вызывались только при наличии связанных с ними тегов в прошлых сообщениях.

Пиздец. Какой промпт формат и системный промпт? Вообще ллама любит залупаться и я не нашёл нормального способа побороть это. Все, что делаю, это сразу же повторно генерю при малейшей попытке залупиться. Иначе потом ее хрен заставишь выйти из лупа. Чтобы пореже выкидывала сою, надо ее попросить генерить любой контент. А ещё надо хорошенько попросить нормальный кум делать, а не эту хуйню.

Ньюфаги не застали вторую лламу, которая на 13b вообще не могла в русский.

Ну, соевость и русский язык — не одно и то же. =) У нас тут куча «расцензуренных» ллам-8, но на деле я пока не слышал ни об одной реальных хороших отзывов.

> а как именно железо может влиять на генерацию

в общем — никак. Но на генерацию влияют даже солнечные бури, а ты про железо… =) (отсылка на мем-исследование, таки влияют=)

> Ставь simple-1 и забей.

Могу еще порекомендовать mirostat выставить на 1 (или 2, если запустишь убабугу и экслламу), и выставить 8/0,2 или 2/0,9 типа того, может стать заметно лучше.

На симпле-1, да.

Но то что шизит — странно само по себе, конечно.

Гугл не сильно лучше натива, прям вообще преимуществ нет.

Ну так, на всякий случай, убабуга работает на питоновской версии сиплюсплюсной лламы Жоры, то есть там прям совсем колхоз-колхоз.

А че по скорости?

Вот тут я не буду осуждать, но человек заявляет, что нормально даже чатгопота в русский не умеет. Ну да, тут не поспоришь, ллама-3 8б явно не лучше чатгопоты.

Восприятие зависит от требований.

Сузума будет получше, но соглашусь, что тюны лламы-то англоязычные, поэтому они хуже оригинала.

Кстати, есть еще Вихрь, но там инстракт, а не рп. Так что такое.

О_о

Алкашка обоссалась, ясна, ебать Дюбуа — осуждаю.

> ПЛОХО МОЖЕТ В РУССКИЙ ЯЗЫК.

Лучше любого конкурента соответствующего размера.

Даже Мистраль хуже, Фи хуже, а других адекватных (хотя Фи не сильно конкурент из-за сои) конкурентов просто нет.

В остальном да.

Командира убери.

Квен, мику убери.

Получается, единственный конкурент (но про гпу-ускорение можно забыть) — это Микстраль/Кранчи-Онион.

Ну база же.

Пздц вы кривые нахуй.

1. Он тупой.

2. Он не ко всем залезет.

Так-то я топил за коммандера еще на выходе, но файнтьюнов пока нет, и он большеват, ну и контекст, в общем, это модель другой категории.

Не сильно выебет. Получше гугла, чище коммандера, но по адекватности перевода и художественности уже такое себе. Не панацея.

Только будь готов, что коммандер ниже 6 кванта — непроходимо туп. Морально подготовься и тестируй.

Вот это у тебя примеры в треде про модели на русском языке…

> а мозгов у модели не наблюдается в принципе

Потому что он не для рп, и не в таком кванте, совершенно верно. Sad but true.

Я этим не страдал, прости, не подскажу.

Где-то я видел мельком.

А силлитаверну так нельзя вывести? Просто мысль.

Кек.

Ну, в последних версиях за год, да. =)

> ВРЕМЯ КУМИИТЬ!

Ты на чуб зайти был не в состоянии, выбрать себе Мегумин?..

От настроек и солнечных бурь. =D

GPT-3.5 Turbo.

> Мистраль и подавно не смог

Треш.

———

Ща попробую потыкать через убабуга => силлитаверна сузуму, посмотреть настройки, версию, разобраться, че не так у людей.

Неужели обнова все так поломала.

>Пиздец. Какой промпт формат и системный промпт?

Обычный ламовский вшитый в таверну.

>Чтобы пореже выкидывала сою, надо ее попросить генерить любой контент. А ещё надо хорошенько попросить нормальный кум делать, а не эту хуйню.

Она очень плохо может в кум даже на правильной картонке и с правильным запросом, это не её тема.

>Все, что делаю, это сразу же повторно генерю при малейшей попытке залупиться.

А я просто не использую эту говномодель.

>Вот это у тебя примеры в треде про модели на русском языке…

Лолчто? Это тред про все локальные модели. И тут исторически люди знающие англюсик минимум на upper-intermediate сидят.

> Гугл не сильно лучше натива, прям вообще преимуществ нет.

Да, он тоже говно.

> Лучше любого конкурента соответствующего размера.

> Даже Мистраль хуже, Фи хуже, а других адекватных (хотя Фи не сильно конкурент из-за сои) конкурентов просто нет.

Что насчёт Yi?

> Не сильно выебет. Получше гугла, чище коммандера, но по адекватности перевода и художественности уже такое себе. Не панацея.

Не сильно, не панацея, но я не видел более хорошей альтернативы. Гугл скатился в жопу и его переводы стали гораздо хуже. Яндекс же стал переводить так, как гугл когда-то.

Чаасть у меня так и сделана. Просто есть кусок, где описаны слишком общие вещи, чтобы пихать их под кейворды.

Карточка старая.

Чисто на русском.

От первого лица.

Что мне не нравится:

1. Начало и конец от лица ассистента (так, стоп, это и есть карточка ассистента, но я хочу, чтобы она не сыпала такими дефолтными фразами).

2. Путает размеры версий GPT (впрочем, аноны тоже).

3. Язык немного косноязычный.

4. Кавычки и дефис вместо тире — ле фу!

Запуск:

https://huggingface.co/BahamutRU/suzume-llama-3-8B-multilingual-8.0bpw-h8-exl2

ExLlama2_HF

Таверна на пиках.

Я не настраивал долго, поэтому результат можно улучшить, полагаю.

Мой тейк был в том, что у нее хороший русский язык.

Я не ЕРПшил с ней. Не писал джейлы (ладно, в карточке есть джейл на подавление диверсити, но тут не о нем).

Не гарантирую ничего другого, однако русский язык — вполне достойный для ее размера, ИМХО.

Чисто на русском.

От первого лица.

Что мне не нравится:

1. Начало и конец от лица ассистента (так, стоп, это и есть карточка ассистента, но я хочу, чтобы она не сыпала такими дефолтными фразами).

2. Путает размеры версий GPT (впрочем, аноны тоже).

3. Язык немного косноязычный.

4. Кавычки и дефис вместо тире — ле фу!

Запуск:

https://huggingface.co/BahamutRU/suzume-llama-3-8B-multilingual-8.0bpw-h8-exl2

ExLlama2_HF

Таверна на пиках.

Я не настраивал долго, поэтому результат можно улучшить, полагаю.

Мой тейк был в том, что у нее хороший русский язык.

Я не ЕРПшил с ней. Не писал джейлы (ладно, в карточке есть джейл на подавление диверсити, но тут не о нем).

Не гарантирую ничего другого, однако русский язык — вполне достойный для ее размера, ИМХО.

Контекст у тебя 2048 выставлен?

Я не про общий тред, а про то, о чем мы перетираем со вчерашнего вечера. Про русский язык в локальных моделях.

Если ты думал, что речь сегодня идет о моделях вообще — перечитай, мы обсуждаем именно русскоязычные. Про англоязычные диалог бы шел в другую сторону немного (более позитивную, но сое-хейтерскую=).

Кон-текст!

Учитывай, плиз. =)

Ой, новая Yi я даж хз, я че-то один раз запустил и забил.

Не знаю, честно.

По Яндексу соглашусь в общем, да.

>Контекст у тебя 2048 выставлен?

За кого ты меня принимаешь? У ламы3 выставлен 8к, у солара 16к.

>Я не про общий тред, а про то, о чем мы перетираем со вчерашнего вечера. Про русский язык в локальных моделях.

Ты влез в чужой диалог, где мы обсуждали именно англоязычные. Глаза разуй, потом других жизни учи.

https://huggingface.co/cognitivecomputations/dolphin-2.9.1-mixtral-1x22b

Кто-нить тыкал это? Модель не разреженная и не плотная, мое и немое, отгадай кто это - дельфин-ебанин.

Из того что продолжаются эксперименты с предыдущими моделями видно что лама-3 не очень зашла. А хули - 70 не для масс, 8 - слишком мала, не хватает серединки. Кроме того лама-3 настолько натрейненена, что файнтюны не заходят, видимо любой из них уже был в датасете на 15Т

Кто-нить тыкал это? Модель не разреженная и не плотная, мое и немое, отгадай кто это - дельфин-ебанин.

Из того что продолжаются эксперименты с предыдущими моделями видно что лама-3 не очень зашла. А хули - 70 не для масс, 8 - слишком мала, не хватает серединки. Кроме того лама-3 настолько натрейненена, что файнтюны не заходят, видимо любой из них уже был в датасете на 15Т

Я про тебя, а не про ллмки. =)

Попроси ламу суммаризировать тред, чтобы быть в курсе, на что ты отвечаешь.

Дельфин всю жизнь был тупым, зачем его пробовать в этот раз?

Все, увидел, что вы про мистраль и про английские говорили.

Мои извинения.

Но Мистраль в принципе без сои и цензуры модель, но ее туда аноны сами напихивают, скилл ишью, как всегда.

>И тут исторически люди знающие англюсик минимум на upper-intermediate сидят.

Сижу с самого начала на А2. Хотя конечно может уже и подтянул, лол.

>Просто есть кусок, где описаны слишком общие вещи

Тогда почему оно не в карточке?

>видимо любой из них уже был в датасете на 15Т

Даже если так, то полировка сверху всё равно выставит нужный биас модели. Но у тренировщиков просто руки из жопы. Ждём наработки опыта.

> Я про тебя, а не про ллмки.

> Попроси ламу суммаризировать тред, чтобы быть в курсе, на что ты отвечаешь.

Да у тебя у самого контекст через жопу вывернут. На тот момент мы с аноном обсуждали мелкие модельки именно в плане английского языка. И пример он привёл в тему. Вот хуле ты до него доебался?

В контексте общего разговора выглядело охуенно, не думаешь? Все обсуждают русский и челик скидывает инглиш.

Там всего один раз слово промелькнуло, да еще в контексте скилл ишью.

Я ебу этих ебанариев, что у них там в мистрали не работает. Это ж пиздец.

Зачем ты пишешь людям гадости со смайликами? Ебать ты мерзкий.

> В контексте общего разговора выглядело охуенно, не думаешь?

Я думаю, что ты в глаза долбишься. Там прямым текстом была просьба показать аутпут. Вот что анон должен был сделать, по-твоему? Послать меня нахуй или начать срать смайликами как ты? Абсолютно ебанутая логика.

Потому что оно не относится напрямую к персонажу? Да и потом, так он ещё чаще будет это упоминать, нет?

>Потому что оно не относится напрямую к персонажу?

Ну так отдели какой-нибудь пометкой.

>Да и потом, так он ещё чаще будет это упоминать, нет?

Зависит от того, где у тебя инжектится лорбук. Обычно он идёт ближе к ответу, поэтому учитывается сильнее.

=D Сук.

Так это ты в глаза долбишься. Перечитай, что я написал. =)

Ближе к какому ответу?

Сильнее учитывается начало промпта или конец?

> Так это ты в глаза долбишься. Перечитай, что я написал. =)

Хуйню полную ты написал, в надежде, что не придётся признавать свой жиденький обсер. Сразу начались манявры, что там "одно слово", "скилл ишью", не считается. По факту, был конкретный запрос и конкретный ответ. И раз уж ты сам нихуя не способен осваивать контекст и читаешь посты жопой, то с твоей стороны очень странно было бы упрекать в этом анона, который посты читает нормально.

> Хуйню полную ты написал, в надежде, что не придётся признавать свой жиденький обсер.

Ты не только в глаза долбишься, но еще и сам хуйню пишешь. =)

> Все, увидел, что вы про мистраль и про английские говорили.

> Мои извинения.

Тут и 2048 контекста нет, я смотрю.

> И раз уж ты сам нихуя не способен осваивать контекст и читаешь посты жопой, то с твоей стороны очень странно было бы упрекать в этом анона, который посты читает нормально.

И раз уж ты сам нихуя не способен осваивать контекст и читаешь посты жопой, то с твоей стороны очень странно упрекать в этом анона, который посты хотя бы читает.

———

Блин, загрузил 70b, и она один раз слово выдумала с английским, другой раз с китайским.

Гребанный ггуф поломанный в гребанной ллама_сипипи_пайтон.

Почему 8б отвечает чище 70б.

Где мои две 3090.

>Ты уверен, что в датасете есть инфа о так называемой акве и ее роли в ранобе или аниме?

Помнится крутил эту карточку Аквы ещё на Пигмалионе 6В, так он на низкой температуре даже названия глав ранобэ выдавал.

Как в новых моделях ХЗ, но по идее всё должно быть, Коносуба это база!

Пигмаллион — это не «старая модель ллама», это отдельная модель, которая обучалась на ролеплее для тебя.

А ллама не обязана знать о Коносубе, она не для этого делалась.

Так что… Ну сорян-сорян. С чего бы ей знать такие вещи вообще.

RAG.

Miqu — лучший результат на русском, и даже мнение свое высказала.

Starling-LM-7B-beta — говорит на русском неплохо, но проскакивают иероглифы, и вообще. Твердая 4 для своего размера.

Starling-LM-10.7B-beta — шизует, мне лень это бороть. Вроде старается по теме, и очень креативна, но нет. Ну и русский так себе.

Phi-3-medium-6.0bpw — одно слово перепутала, что-то там придумала, но когда я попросил быть немного неформальной, я не имел в виду смайлики в конце! Ну и 14B модель так себе 7-8, конечно. Нельзя сравнивать. Русский на 4+, думаю.

Пикрил.

Mistral-7b-v0.3 — вот тут уже сложно… С одной стороны, у нее очень хороший стиль. С другой, она так же придумывает слова и ошибается местами. Мистрали не хватает русского в датасете (но ее превосходит сузума, которая изначально multilingual). Так что 4+.

Yi-1.5-9B-Chat — я вспомнил о ней! Нет, она не умеет в русский, простите.

пикрил2

Это касается именно языка, а не стиля или соевости, окда.

В общем, ИМХО, ничего лучше сузуме в размере 8b нет.

Starling-LM-7B-beta — говорит на русском неплохо, но проскакивают иероглифы, и вообще. Твердая 4 для своего размера.

Starling-LM-10.7B-beta — шизует, мне лень это бороть. Вроде старается по теме, и очень креативна, но нет. Ну и русский так себе.

Phi-3-medium-6.0bpw — одно слово перепутала, что-то там придумала, но когда я попросил быть немного неформальной, я не имел в виду смайлики в конце! Ну и 14B модель так себе 7-8, конечно. Нельзя сравнивать. Русский на 4+, думаю.

Пикрил.

Mistral-7b-v0.3 — вот тут уже сложно… С одной стороны, у нее очень хороший стиль. С другой, она так же придумывает слова и ошибается местами. Мистрали не хватает русского в датасете (но ее превосходит сузума, которая изначально multilingual). Так что 4+.

Yi-1.5-9B-Chat — я вспомнил о ней! Нет, она не умеет в русский, простите.

пикрил2

Это касается именно языка, а не стиля или соевости, окда.

В общем, ИМХО, ничего лучше сузуме в размере 8b нет.

Последний сезон деградансткий.

Уже не просто веселое аниме с ебанцой, а ебанина мелкого пошиба.

Ну что вы их русским мучаете постоянно, вам не надоело ещё?

2 чая

Прошу прощения за долгий ответ, был очень уставшим. Постарался ответить всем, никого не забыть, если кого забыл, пишите.

Да, это увидел. Хорошо тогда.

За вброс не переживай, анонче, всё хорошо.

>В тред ее скидывай если будет.

Прикладываю. Это ещё с субботы ошибка была, когда я через oobagoba пытался запустить .gguf-модель. Сейчас скачиваю .exl2, буду её ковырять, но всё равно, хочется понять, что я делал не так.

>Это офк если карточки в одной системе а не нескольких

В одной, с этим всё хорошо.

Понял, анонче, спасибо большое! Качаю exl2-модель, которую ты посоветовал. Буду пытаться разобраться.

>cohere и их command r+, хотя он под раг, но в твоем случае похую.

О, спасибо. Я как раз хотел в будущем RAGи использовать, потому что хочу сделать долгосрочную память, и через них выглядит удобно.

Спасибо, анончики, попробую ещё и микстраль, отпишусь о впечатлениях, как всё подниму, непременно.

>Все для мультигпу, ты просто воробушек. Плюсую вопрос, как они к тебе попали — ботаника в подворотне ограбил?

Понял, спасибо. На работе есть доступ к кластеру, спросил, можно ли поиграться с нейронками в свободное время - дали добро.

8x4090-кун

Да, это увидел. Хорошо тогда.

За вброс не переживай, анонче, всё хорошо.

>В тред ее скидывай если будет.

Прикладываю. Это ещё с субботы ошибка была, когда я через oobagoba пытался запустить .gguf-модель. Сейчас скачиваю .exl2, буду её ковырять, но всё равно, хочется понять, что я делал не так.

>Это офк если карточки в одной системе а не нескольких

В одной, с этим всё хорошо.

Понял, анонче, спасибо большое! Качаю exl2-модель, которую ты посоветовал. Буду пытаться разобраться.

>cohere и их command r+, хотя он под раг, но в твоем случае похую.

О, спасибо. Я как раз хотел в будущем RAGи использовать, потому что хочу сделать долгосрочную память, и через них выглядит удобно.

Спасибо, анончики, попробую ещё и микстраль, отпишусь о впечатлениях, как всё подниму, непременно.

>Все для мультигпу, ты просто воробушек. Плюсую вопрос, как они к тебе попали — ботаника в подворотне ограбил?

Понял, спасибо. На работе есть доступ к кластеру, спросил, можно ли поиграться с нейронками в свободное время - дали добро.

8x4090-кун

Да просто тестики.

Нам лень на етом вашем инглише.

Ллама и мистраль уже норм, на самом деле.

Жаль, что там сою насыпают, а РП-файнтьюнов на русском нет.

Классная работа, что сказать. )

У тебя фронт в веб-бразуере отсутсвует? Поставить убабугу, зайти по 7860 в Gradio возможности нет?

Попробовал, но что-то не понял прикола. Оно просто подтягивает текст как лорбук, только из файла. Видимо, что-то неправильно настроил.

>Какая у тебя модель, кстати?

Командор плюсовый, остальной шлак после него вообще не признаю, ламма 3 70b/Мику, просто нахуй проходят (для rp/erp of course, в логических задачках они тащат).

Кстати ломал кто-нибудь сою в ебучем Qwen? Это просто образцовый пример сои! Такой пиздец я только у ГОПОТы видел. Какой там префил, систем промт нужны, чтобы заставить ее творить дичь(как командор)

>Скачал командира 35b, ну такое себе.

Какой квант? У меня только на 8ом он нормально заговорил(на 4ом рили не очень), и он реально затыкает все дыры, вплоть до 70B!

>Сильнее учитывается начало промпта или конец?

ХЗ, зависит от сетки. Обычно конец.

>А ллама не обязана знать о Коносубе, она не для этого делалась.

Но всё таки знает. По крайней мере в пределах вики.

Раг подтягивает не по ключевым словам, а по сродству векторов. На этом отличия от лорбука заканчиваются, лол.

>Это просто образцовый пример сои!

Фи ещё более соевая.

>У меня только на 8ом он нормально заговорил

Да вы заебали уже. Один тред убеждают, что Q2 это заебись и вообще пиздатая хуйня, почти как полные веса. Потом начинается новый тред и всё, что до Q8 - говно ёбаное.

Только второй квант катают на 70-ке, а четвёртый квант ломает 34. Чуешь разницу?

Ну ты больше шизов с q1 слушай.

А вообще, у коммандора своя специфика, он реально до Q6 точно — тупой. Вот я прям крайне удивился этому, когда тестил, но человек правду говорит.

Ну и те же 7B-8B ниже q8 тоже бессмысленно использовать.

> он реально до Q6 точно — тупой

Лол. Он всегда по умолчанию тупой. Иногда даже хуже 8В по логике. Разве что в РП неплох.

Так это разные додики утверждают

Я тебе вообще могу сказать что любой квант хуйня, нужно оригинальные веса катать

И не совру, хули

Квант это не оригинальная модель, это китайская копия разной степени хуевости

Где то это кому то субьективно кажется работоспособным на 2 кванте что, по моему хуета

Кто то заявляет о более реалистичной работе на 4 кванте

Проверено, и мной самим, что те же мелкие модели страдают от квантов больше, поэтому их желательно или оригиналом катать или хотя бы 8-6 бит на вес

При квантизации модели теряют способность воспринимать контекст и работать с ним, ну и "мозги"

Качество генерации текста вообще, падает последней

>Фи ещё более соевая.

Нихуя, хуже ебанного Квена я не встречал, Фи смогла даже в небольшой отыгрыш(сиськи/письки не описывала, но пыталась).

>При квантизации модели теряют способность воспринимать контекст и работать с ним

Катал Лламу 8В на 8 кванте и на трансформерах, разницы в ответах не заметил.

>он реально до Q6 точно — тупой

Командир+ в 4 кванте норм. Больше запустить всё равно не могу.

>А вообще, у коммандора своя специфика, он реально до Q6 точно — тупой.

Хуйню несешь, в четвертом кванте он ебет все что движется, даже 70В мику и лламу, не уходит в залупы, не шизит, стоически терпит без падения качества урезание контекста контекст шифтом и замену на суммарайз. На русском шпарит так что все остальные модели сосут, в прямом смысле, потому что командир еще и не заражен соей, как эти ваши сузуны. И самое главное - на моей 4090 с 24 гб видеопамяти с 8к контекстом он ебашит от 4.5 до 6 токенов в секунду. Это идеальная модель.

Ну я ебал полные века качать. А 34b в Q4_K_S хуже лламы 8b. Такие дела.

Соглашусь. Ещё есть нюанс, что модели типа третьей лламы будут страдать от квантования в разы больше, чем большинство остальных.

>Ну я ебал полные века качать. А 34b в Q4_K_S хуже лламы 8b. Такие дела.

Какую только шизохуйню в треде не встретишь, уже много раз запруфано что лама3 входит в луп на контексте больше 2-3к и никакого лекарства не существует, тем не менее эти шизы продолжают форсить эту срань и гнать на нормальные модели.

Разница в качестве между Q4_K_M и Q4_K_S незаметна глазу на больших моделях, что ты несешь-то вообще.

бля какие же скудные датасеты на кум, ну родина вам третью ламу дала, нет блять хотим говнотексты ей скормить чтобы она порождала "Еби меня василий. и Василий ибал иё, ана станала как шлюха". Тьфу блять!

А как надо?

А надо блять чтобы ИИ сам взял прекрасный слог и излагал графичность сцен и хорнивость героев. И нет, промптом то не фиксится, и нет, не существует такого датасета поэтому задача тут не в датасете, а в поколении ИИ которое будет по аналогии делать.

К примеру. Возьмем stable diffusion. Допустим какой нибудь Малевич не рисовал голых футанари. Но есть датасет с футанари. И ии способно обработать промпт "нариусуй футанари в стиле малевича". А текстовые не могут.

А как надо?

А надо блять чтобы ИИ сам взял прекрасный слог и излагал графичность сцен и хорнивость героев. И нет, промптом то не фиксится, и нет, не существует такого датасета поэтому задача тут не в датасете, а в поколении ИИ которое будет по аналогии делать.

К примеру. Возьмем stable diffusion. Допустим какой нибудь Малевич не рисовал голых футанари. Но есть датасет с футанари. И ии способно обработать промпт "нариусуй футанари в стиле малевича". А текстовые не могут.

>К примеру. Возьмем stable diffusion. Допустим какой нибудь Малевич не рисовал голых футанари. Но есть датасет с футанари. И ии способно обработать промпт "нариусуй футанари в стиле малевича". А текстовые не могут.

Могут. Напиши в картонке в чьем стиле писать, 70В+ модели поймут.

> на моей 4090 с 24 гб видеопамяти с 8к контекстом он ебашит от 4.5 до 6 токенов в секунду.

Дай, ссылку, пожалуйста.

На что?

>а в поколении ИИ которое будет по аналогии делать.

Да, текущие модели говно. Сейчас пилю свою модель на 3080Ti, вот запилю, тогда и заживём!

>лама3 входит в луп

Скилл ишью. Просто старайся лучше.

>Q4_K_M и Q4_K_S

Здесь соглашусь, и то, и другое - лоботомит ебаный.

>Скилл ишью. Просто старайся лучше.

Блядь, как же толсто, лупит модель, а виноват я что "не старался". Не старался что - рероллить по 10 раз каждый её пост? Зачем если командира рероллить не надо вообще? Скачай уже небитый квант командира и сам зацени(да, кванты командира тоже были сломаны и их пофиксили уже после ламы3)

>и то, и другое - лоботомит ебаный.

Вытекаешь из треда уже, хватит новичков путать своим жиром.

>кванты командира тоже были сломаны

Ну кстати командир+ даже сломанный был шикарен, проебал он там с процент мозгов (сейчас вообще огонь). А вот лламу 3 прям корёжит от замены токена \n\n на два токена по \n.

>Земля стекловатой.

Ну это всё ещё лучше, чем на проце или на моей рыксе 570 потому что амуде пидарасы и прекратили поддержку Polaris в ROCM, так что хуй вам, а не ИИ..

Там вплоть до самой ужатой четырехбитки iQ4_NL и iQ4_XS падение качества в пределах арифметической погрешности. У больших моделей даже самыми большими 3 бит можно пользоваться если совсем припрет.

смотри, эти разговоры ведут владельцы 2-3-4 тесл, для чела у которого нету столько врам актуален вопрос на каком минимальном кванте приемлемо потянет скажем командир. Или вопрос что лучше лама-3-8 в 8 кванте или допустим командир в 3 кванте. А вот эти вот изречения типо: командир идиот ниже 6 или 4 кванта это ни о чем, так как идиот относительно чего? Относительно себя же в 8 кванте или относительно ламы-3-8 в 8 кванте? Как видишь две большие разницы. Другой вопрос почему владельцы 2-3 4090 гораздо меньше разговаривают о том, что все модели ниже 70б гавно, чем владельцы тесл? Потому что владельцы тесл сами себе хотят доказать, что не зря купили старые картонки, а 4090-никам ни в чем убеждать себя не надо и так все заебись.

>корёжит от замены токена \n\n на два токена по \n.

Её от всего корежит - от настроек, от порядка сэмплеров, от пробелов в инстракшене, от стоп токенов. Overtrained говнина потому что. А дурачки её еще на открытых датасетах обучают, которые 100% что уже есть в модели(они буквально все что можно и нельзя туда засунули), разумеется это вызывает расфокусировку модели со всех остальных токенов.

>тесты зирошотов, на которые всем миром модели надрачивают

Ещё бы модели по этим тестам страдали.

>на которые всем миром модели надрачивают

Кванты натаскивают на тесты? Жора лично инъекцию правильных ответов в каждый квант вносит чтобы тот не обосрался?

>Перплексити не пруф

>MMLU не пруф

И что именно пруф в твоем манямирке? Может ты сам пруф своим словам и предоставишь тогда?

Это просто тест на знания, оно даже мозги не оценивает, ни работу с информацией, ни удержание контекста или вообще многооборотистый чат

Знания так же как и генерация простых ответов страдают последними, это ведь одно и то же по сути.

Зерошот ответы на вопросики на которые сетку специально надрачивали

>Кванты натаскивают на тесты?

При чем тут кванты и их обучение?

Речь о том что сетка при квантизации теряет в первую очередь не знания или способность продолжать текст

В первую очередь разница в том заметит ли она что то в длинном чате, сможет ли связать 2 мысли в одну и тд

Тоесть более абстрактные вещи, "мозги"

Вот только все тесты у нас либо зирошот вопросики, которые это не оценивают, либо вообще перплексити, для самых отбитых.

Потому что падение перплексити это вообще нижняя планка, оно просто оценивает на сколько точно зирошот вопросики отвечаются на разных квантах от оригинала. Тоесть оценивается отклонение в самой примитивной работе сетки - генерации текста, которая страдает как ясно самой последней.

> мозги

Каждый раз как в первый вскрикиваю.

>сетку специально надрачивали

Так сетку, а не квант. Квант какое отношение к этому имеет? То что метку надрачивали на знания делает сомнительным сравнение с другими сетками, а не с квантами одной и той же сети.

Ну а хули, придумай как это покрасивее обозвать

>Относительно себя же в 8 кванте или относительно ламы-3-8 в 8 кванте?

Ну смотри, я хуй знает, что там с командиром в 8 кванте, но в четвёртом относительно неквантованной 8b лламы он хуйня полная. Единственный плюс, что на одинаковых настройках у командира посты длиннее, но из-за длинны поста он теряет суть беседы буквально три раза за сообщение. Странно вообще, что такую хуйню кто-то серьёзно нахваливает, это троллинг какой-то.

>4090-никам

А у них руки заняты. А теславоды запускают хералион b с подкачкой на кофемолку и дрочат форум, пока там генерируется бредотина со скоростью 0.1т\с

>я хуй знает, что там с командиром в 8 кванте, но в четвёртом относительно неквантованной 8b лламы он хуйня полная.

Ты 100% запускал сломанный ггуф с выкрученными в говнину настройками и инструкцией от чего угодно, но не командира и даже не альпаки/мистраля на которых он тоже хорошо работает.

Иначе я не понимаю как ты это получил.

> но в четвёртом относительно неквантованной 8b лламы он хуйня полная.

Ну либо ллама неквантованная так сильно отличается от 8 кванта, либо ты пиздишь

Я тыкал только 4 квант командера 35, и с нормальным промпт форматом он заебись отвечает

Более связно, умно. Рассуждает гораздо лучше лламы

На знания не проверял просто ебал мозги задавал вопросики на карточке с тсинкингом. Гораздо лучше ей пользуется.

Лламе не хватает внимания, понимает меньше, не делает очевидных выводов

>А че по скорости?

8B модель - пик 1 aya-23-8B-Q8_0

13B модель - пик 2 +/- 1.5 Т/c ruGPT-3.5-13B-erotic-kink-chat-Q5_K_M

35B модель - пик 3 +/- 0.4 Т/с c4ai-command-r-v01-Q4_K_S - и он полностью не влез. Потому загрузил всего 38 слоёв в гпу, может поэтому так медленно.

другая 35B модель - пик 4 yi-34b-chat.Q4_K_M - эта влезает полностью, поэтому решил её тоже протестировать.

Тестировал на koboldcpp + ST. Вроде как, на голой лламе.цпп без карточек, без фронтенда и прочей хуйни, должно быть быстрее. Но, думаю, никому здесь не интересно такое использование.

Да, данные грубые и их мало. И всё такое, но думаю, что в принципе они соответствуют видево карточке. Думаю, что прмерно такие результаты будут и на других моделях со схожими размерами.

>ruGPT-3.5

Лучше бы ты сайгу 13В тестировал, чесслово, ругопота в 2024 это уже даже не кринж, это просто провал, это все равно что пигму использовать.

Ну, тестовые модельки. Надо же было на чём-то затестировать 13B, правильно? А другого 13B говна, пока что на харде нету.

Сейчас же тестирование было не на кач-во, а на скорость, так что, думаю, вывод не сильно важен. И тестирование было не модельки, а железа.

Но если, они сильно отличаются по скорости, то могу скачать и протестировать её тоже.

https://huggingface.co/Lewdiculous/L3-8B-Stheno-v3.1-GGUF-IQ-Imatrix

https://huggingface.co/CohereForAI/aya-23-8B

Они говорят и шарят. Первая хороша в РП. Вторая невероятно глючит в РП но как ассистент хороша несколько раз взбесилась ни с того ни сего и убила меня.

>в четвёртом относительно неквантованной 8b лламы он хуйня полная