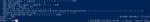

Для тех кто не увидел из-за бамплимита в прошлом треде, рекламирую еще раз. Теперь у лоры есть гуй:

https://github.com/anon-1337/LoRA-train-GUI/releases/tag/v0.2

Из основных возможностей это вкладки, которые будут обучаться последовательно и импорт/экспорт настроек

https://github.com/anon-1337/LoRA-train-GUI/releases/tag/v0.2

Из основных возможностей это вкладки, которые будут обучаться последовательно и импорт/экспорт настроек

> Теперь у лоры есть хуй

Пушисто закатился

Пурр :3

Ты же осознаешь, что ты мог просто сделать экстеншон для сд?

Делал в первую очередь для себя. У меня 6 гб врам и браузер её жрет нещадно и режет скорость достаточно сильно. +я не знаю что такое градио

>браузер её жрет нещадно

Отключить аппаратное ускорение, не?

>я не знаю что такое градио

А мог бы узнать, точно так же как узнал про dearpygui

Я могу в теории попробовать сделать расширение для сд. Но это будет куда сложнее чем сделать простую обертку для скрипта, как минимум мне нужно понять как выгрузить модель из памяти, потому что у меня лично автоматик 2 гб врам отжирает просто ничего не делая

Каво бля? Разве лора не на модели тренируется? Нахуя ее выгружать?

А, я тебя понял, скрипты с автоматиком никак не связаны. Ну хуй знает тогда.

Ну я тупанул. Все равно проще особо не становится, это получается надо форкать репо китайца и шерудить там под капотом, чтобы запускать тренировку не посылая аргументы левому скрипту, а как бы нативно из автоматика. Это очень интересная задача и я не против ей заняться, но я не уверен что моих текущих знаний достаточно чтобы это реализовать

советом лучше помоги

Уже две личные лоры есть, хороший тред. Третья лора будет по shion yorigami

Не знаю чего там все плачут по поводу китайцоскрипта версии 0.4.0, еще в прошлом треде писал что всё нормально работает и у меня лично результаты даже лучше чем раньше. Впервые я на таком малом количестве шагов оттренил Феликса с полноценным запоминанием концепта, до этого постоянно вылезали косяки типа не та одежда, не тот цвет того или иного элемента и т.д. А сейчас стренил 800 шагов и всё как было в датасете, так оно есть и в генерации

Всё что нужно на новой версии поменять, это поставить (при network_dim = 128, network_alpha = 1) learning_rate в 10 раз выше рекомендуемого (т.е. 1e-4 -> 1e-3) и всё будет работать ИЗКАРОПКИ. Дайте шанс китайцу

инби4: кохъя-лахта

Не стесняйся делиться. В шапке есть ссылка на репозиторий, если мне не лень я туда добавляю то что скидывают, но в последнее время суперлень ебаться с разметкой и заливать туды-сюды папки с датасетами и сетками, но ты можешь сам добавить туда своё пароль для редактирования 2ch

Всё что нужно на новой версии поменять, это поставить (при network_dim = 128, network_alpha = 1) learning_rate в 10 раз выше рекомендуемого (т.е. 1e-4 -> 1e-3) и всё будет работать ИЗКАРОПКИ. Дайте шанс китайцу

инби4: кохъя-лахта

Не стесняйся делиться. В шапке есть ссылка на репозиторий, если мне не лень я туда добавляю то что скидывают, но в последнее время суперлень ебаться с разметкой и заливать туды-сюды папки с датасетами и сетками, но ты можешь сам добавить туда своё пароль для редактирования 2ch

>800 шагов

У меня 3200 шагов уходит на концепт перса.

>делиться

Если бы, ты ведь меня недолюбливаешь. Уже понял кто я, да?

>1e-3

Не работает у меня.

> У меня 3200 шагов уходит на концепт перса.

Охуеть

> Уже понял кто я, да?

Нет, няш, я не помню чтоб кого-то недолюбливал. Если ты тот анон с эмбедингами и спич баблами, то я извиняюсь за тот инцидент, мне не стоило помогать когда я сам не до конца разбираюсь. Если ты не он, то возможно с кем-то меня путаешь?

> Не работает у меня.

Да как так-то блджад, что именно-то не работает, могу попробовать помочь

Тааааак, чекнем репо китайца, что он там мутит...

...

ОХУЕТЬ!

...

ОХУЕТЬ!

>анон с эмбедингами и спич баблами

Я анон с кокоро.

>textual inversion

Зачем это хуево работающее, медленное и кривое говно поддерживать? Для чего?

Нижний пост - твой? У тебя же ничего не работало на этой скорости, почему заработало?

Кек, да мне похуй в целом уже. Но все равно неприятно когда просят совета, ты его даешь, человек советом не пользуется и потом говорит всем что совет говно. Уж пойми

Как у тебя дела с сетками? Заебатые теперь получаются?

Если у китайца хорошая имплементация TI, то почему бы и нет? Это инструмент для своих задач. Даёт другие результаты. Я хоть и считаю что лора это киллерхуйня, но лора + эмбед > лора

Да, это мой пост. Как оказалось вся проблема была в ебучем автоматике, я не смотрел в консоль, а там писало что сетка не грузится, даже учитывая что я пользовался расширением китайца. Обновил автоматика и все сетки заработали. 1е-3 дал отличные результаты на малом количестве шагов, мне понравились больше чем старые до альфы на 1е-4

>Как у тебя дела с сетками? Заебатые теперь получаются?

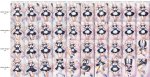

Вот такие получаются.

1 пик - Kasen Ibaraki.

2 пик - Yuuma Toutestu.

Заебатые. Тохофаг? Я тоже немного

>Тохофаг

Ага, сегодня ночью соберу датасет на Shion Yorigami и оттреню её

>Обновил автоматика

А вот я боюсь обновляться.. Из-за производительности и криворукости автоматика

Я не боюсь. Сохраняешь в блокнотик хэш текущего коммита, пуллишь, не нравится - возвращаешься

Кстати китаец для своего расширения повыкатывал фиксы, есть смысл начать с него

Да, я знаю про git checkout, но все равно тряска. Мб позже и обновлюсь. Сейчас все работает и я доволен.

как этим пользоваться?

Вот что выдает "train_network.py: error: unrecognized arguments:"

Как обучить лору на собственно перса? Есть идеи у треда? Это важная проблема SD - невозможность создания авторских персонажей. В соседнем треде анон продвинулся в проблеме решения генерации кривых рук, надеюсь, что он своё изобретение все же опубликует, а не зажмотит.

Этим не надо пользоваться, пользуйся скриптом. В гуи нет защиты от дурака, да и не удобный оне.

>собственного перса

фикс

1) Собрать датасет с персом

2) Обучить лору

3) Пользоваться

>1) Собрать датасет с персом

Вот это главная проблема, спавнит в рандомной одежде. Хер знает как это решать

Я даун, пофиксил, можешь перекачать

Скачать, открыть, заполнить поля, нажать "Запустить"

Сколько пикч в дата-сете? Зеркалил? Сколько повторений?

Игрался с скоростями. Над этим персонажем 5e-5 дала результат неплохой. Слабый-мягкий, но легко редактируемый.

В нем было 94 пикчи уникальных, cosine_with_restarts, 12 повторений, 8 эпох.

1 пик - 5e-5

2 пик - 1e-3

3 пик - на старой версии с 1e-4

4 пик - на старой версии с 1e-4 и 24 пикчи

А вот с совсем другим персонажем и дата-сетом на 26 уникальных пикчи с теми же настройками нихрена не вышло на новой версии и 5e-5. От персонажа ни одной детали не взялось. А на 1e-3 наоборот ели-ели задний фон редактируется.

Видимо для 5e-5 надо иметь большой дата сет. Минимум 100 пикч без учета отзеркаливания.

14 пикч х 9 повторений и 13 пикч х 3 повторения. Ничего не зеркалил, все пикчи уникальные. 1е-3 linear

> нихрена не вышло на новой версии и 5e-5. От персонажа ни одной детали не взялось. А на 1e-3 наоборот ели-ели задний фон редактируется.

5e-5 это крайне мало, тем более для новой версии. Если на 1е-3 сеть перетренировалась, попробуй 5е-4

> Видимо для 5e-5 надо иметь большой дата сет

Запоминание концепта вряд ли зависит от количества пикч в датасете, оно зависит скорее от разнообразия этих пикч и скорости обучения

> вряд ли

Вот на 3 не выйдет ничего обучить, тут минимум от 15-20 начинается.

>300 эпох

Ебать

Так 5 пикч же. 1.5к шагов всего

А повторений 1?

300 повторений

Блядь, а вот другая сетка на 1е-3 однозначно перетренировалась

Тю блять, забыл негативы подрубить. Но не суть, все равно что-то не то

Существует подробное объяснение принципа тренировки самого СД? Что такое "нейрон", что конкретно пишется в файл модели и т.п.

Кароче начинаю ебаторию с лёрнинг рейтом. Оттренил 3 сетки на 1е-3, все перетренированные. Начну с 5е-4 unet, 1e-4 text encoder. На том же сиде

Помацал. На пре 0.4.0 работает, найс.

По сохранению настроек - не сохраняется путь к папке sd-scripts, не сохраняется нетворк альфа с пустым значением (с обычным сохраняется) и батч сайз.

Алсо, сделай что бы по умолчанию при запуске гуи открывалась вкладка. А то без открытой вкладки настройки не импортируются, сейвит один клик, лол.

Глянул в код и мне кажется ты забыл прописать присвоение переменной батч сайза к соответствующему аргументу, т.к. оно игнорирует выставленный в гуи батч сайз.

И сделай значение "сохранять только последние n эпох" наверное 999 как раньше, а то я уже успел обосраться с этим))0))).

Анон, который сделал лору на Лейн, ты крут! Прямо потрясно работает. Спасибо.

почему она потеет?

Жарко, влажно, Азия-с

Почему лоры уже который день не пополняюца?

> Кто, я?

Аянами Рей

У меня мои лоры постоянно пополняются, если тебе надо - ты и тренируй.

А мог бы просто перейти на старую версию

>8300

Чел...

чо

Делитесь.

Ага, учел, спасибо за фидбек, буду править

На счёт сохранения папки sd-scripts я пока не знаю. Не умею работать с реестром. Поэтому остается два варианта: либо файлик текстовый генерировать в папке с гуем, из которого подхватываются начальные настройки, либо сделать так, что если гуй находится в папке со скриптом, автоматически заносить путь в необходимый инпут

Спасибо. Как разберусь с правильными настройками на 0.4.0, перетреню, вдруг еще лучше будет

Потому что мне лень, другие дела. Пароль 2ch, если хочешь добавить что-то своё

Я еще раз повторяю: МНЕ НЕ НУЖНЫ НУЛЕВЫЕ ТЕНЗОРЫ

>тензоры

Не похуй ли? Результат же норм

Глянул код GUI. Лучше бы не глядел.

Хотеть лучше!

3 дня в питоне

Зачем хранить параметры в ini файле и потом заниматься онанизмом в виде str2bool и line_split = line.split(": ", 1)?

Сделай словарь, в котором будут храниться все параметры и сохраняй его в JSON или yaml.

Сделай словарь, в котором будут храниться все параметры и сохраняй его в JSON или yaml.

Я не умею. Ты тоже с первого дня пользовался json или yaml? Сделал в соответствии со своими знаниями. В следующий раз будет лучше. Извините.

Ты мне лучше скажи как реализовать вкладки правильно, чтобы не нужна была функция append_instance_number()

Всё, сделал. Оказалось с реестром всё не так страшно, теперь после нажатия кнопки "запустить" путь к папке sd-scripts отправляется туда и после этого подхватывается при запуске. И еще если в папке с гуем есть файл "ltg_default.ini", каждая вкладка будет подхватывать значения оттуда

Только маленький нюанс: пришлось переименовать кучу переменных для удобства, чтобы их названия соответствовали таковым из китайцоскрипта, поэтому старые конфиги не подойдут. За это извиняюсь, надо было изначально нормально всё проименовать

Новую версию на тестовой сетке протестил, в этот раз не должно быть как обычно

https://github.com/anon-1337/LoRA-train-GUI/releases/tag/v0.21

Хранить настройки в реестре очень хуёвая идея

Такой вопрос есть

Зачем реестр? Положил бы рядом cfg и свободен.

Масштаб страницы измени (ctrl+колёсико мыши)

Это понятно. Я на ноутбуке, остальные элементы интерфейса тогда становятся комически крошечными. Явно же есть где-то в файлах настройки их скейлинга. Подскажите хотя бы, где искать, я совсем не шарю.

А нету их там лол. Эта хуйня зархардкожена в gradio.

Ну вообще сохранение пути сдскриптс в ини было бы норм, впрочем и так норм наверное

Теперь вылезает нюанс при импорте настроек в виде пик 1. При этом из такого же файла дефолтных настроек все подгружает без ошибок. Настройки свежие офк

Батч сайз все еще игнорируется Где?

>поэтому старые конфиги не подойдут

Это норма

> Хранить настройки в реестре очень хуёвая идея

Почему кста? Вроде дохуя 3рд пати хранят некоторые настройки в реестре

> Такой вопрос есть

Можешь через стили это попробовать решить, ватоматик объявлял поддержку

https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki/Features#usercss

Тыкаешь f12, выбираешь элемент, смотришь как он называется, теребишь длину-ширину, если работает, то создаешь свой файл css с описанием характеристик т.е. длины и ширины и кидаешь куда надо. Описал примерно, я глянуть не могу, т.к. не хочу гитпулить

Решил всё же свой старый грид до ума немного довести. Добавил в него поддержку конфига, чтобы картинки не были гвоздями прибиты. Так же левой кнопкой мыши осуществляется скролл по гриду. Грузятся только картинки, находящиеся близко к зоне видимости, так что хоть гриды довольно увесистные, они не должны долго грузиться, если у вас быстрый интернет.

Для создания своего грида у вас есть два варианта использования:

1. Вы либо делаете форк/копию и засовываете свой config.json в корень проекта

2. Либо вы ссылаетесь на мою репу (ну или на свой форк) и передаёте путь до конфига в queryParams, как в примерах ниже. Хотя не думаю, что вам имеет смысл использовать такой вариант, я его скорее для себя делал, чтобы если обновы делать буду, то сразу ко всем гридам правки применялись.

Если всё же будете использовать второй вариант, то нужно убедиться, что ваш стор не блочит cross-origin запросы. В идеале, для этого грида надо ещё добавить поддержку зума по типу того, как другой анон тут делал - https://diffai.xyz/grid/ewZc47dGmRQ

Проблема в том, что для реализации зума надо создавать несколько тайлов для разного масштаба. Я исследовал этот вопрос пару месяцев назад, и, в целом, можно провернуть трюк с тем, что тайлы можно создать полностью на фронте в момент, когда вы грид оформляете (у меня с головой всё относительно в порядке, так что я не планирую какую-то инфраструктуру для нужд двачеров поднимать) и потом выплёвывать юзеру zip архив со всеми тайлами, но для этого надо UI пилить, а мне пока лень, поскольку это никому не нужно, так что пока так.

Ридми потом оформлю, я уже задолбался на сегодня. По пику я думаю формат конфига должен быть понятен.

Грид по гиперу Сенко в стиле Римукоро для Abyss Orange Mix:

https://neurosenko.github.io/sd-grid-viewer/?configUrl=https://neurosenko.github.io/sd-grids/orange-senko-by-rimukoro/config.json

Грид по гиперу Сенко в стиле Римукоро для Anything V3.0:

https://neurosenko.github.io/sd-grid-viewer/?configUrl=https://neurosenko.github.io/sd-grids/any3-senko-by-rimukoro/config.json

Старый грид для Шинобу:

https://neurosenko.github.io/sd-grid-viewer/?configUrl=https://neurosenko.github.io/sd-grids/nai-shinobu-example/config.json

---

Публикую свои гиперы для Сенко в стиле Римукоро. Уже вкидывал их раньше в тред, но добавил описание, наконец.

Abyss Orange Mix:

https://huggingface.co/NeuroSenko/abyss_orange_mix_senko_by_rimukoro_hyper

Anything V3.0:

https://huggingface.co/NeuroSenko/any3_senko_by_rimukoro_hyper

any222trinart:

https://huggingface.co/NeuroSenko/cab_senko_by_rimukoro_hyper

По фреймам из аниме я тоже пытался тренировать модели, но мне они не особо понравились, так что, наверное, не буду их публиковать пока.

---

Так же публикую свои датасеты на Сенко.

Все арты Римукоро:

https://huggingface.co/datasets/NeuroSenko/senko_by_rimukoro

Все фреймы из аниме (773 изображения):

https://huggingface.co/datasets/NeuroSenko/senko_anime_full

Все фреймы из аниме с фильтрацией неудачных кадров (629 изображений):

https://huggingface.co/datasets/NeuroSenko/senko_anime_no_bad_frames

Фреймы из аниме с фокусом на лицо (404 изображений):

https://huggingface.co/datasets/NeuroSenko/senko_anime_face_only

Фреймы из аниме где видно одеяние мико (213 изображений):

https://huggingface.co/datasets/NeuroSenko/senko_anime_miko_visible

Для создания своего грида у вас есть два варианта использования:

1. Вы либо делаете форк/копию и засовываете свой config.json в корень проекта

2. Либо вы ссылаетесь на мою репу (ну или на свой форк) и передаёте путь до конфига в queryParams, как в примерах ниже. Хотя не думаю, что вам имеет смысл использовать такой вариант, я его скорее для себя делал, чтобы если обновы делать буду, то сразу ко всем гридам правки применялись.

Если всё же будете использовать второй вариант, то нужно убедиться, что ваш стор не блочит cross-origin запросы. В идеале, для этого грида надо ещё добавить поддержку зума по типу того, как другой анон тут делал - https://diffai.xyz/grid/ewZc47dGmRQ

Проблема в том, что для реализации зума надо создавать несколько тайлов для разного масштаба. Я исследовал этот вопрос пару месяцев назад, и, в целом, можно провернуть трюк с тем, что тайлы можно создать полностью на фронте в момент, когда вы грид оформляете (у меня с головой всё относительно в порядке, так что я не планирую какую-то инфраструктуру для нужд двачеров поднимать) и потом выплёвывать юзеру zip архив со всеми тайлами, но для этого надо UI пилить, а мне пока лень, поскольку это никому не нужно, так что пока так.

Ридми потом оформлю, я уже задолбался на сегодня. По пику я думаю формат конфига должен быть понятен.

Грид по гиперу Сенко в стиле Римукоро для Abyss Orange Mix:

https://neurosenko.github.io/sd-grid-viewer/?configUrl=https://neurosenko.github.io/sd-grids/orange-senko-by-rimukoro/config.json

Грид по гиперу Сенко в стиле Римукоро для Anything V3.0:

https://neurosenko.github.io/sd-grid-viewer/?configUrl=https://neurosenko.github.io/sd-grids/any3-senko-by-rimukoro/config.json

Старый грид для Шинобу:

https://neurosenko.github.io/sd-grid-viewer/?configUrl=https://neurosenko.github.io/sd-grids/nai-shinobu-example/config.json

---

Публикую свои гиперы для Сенко в стиле Римукоро. Уже вкидывал их раньше в тред, но добавил описание, наконец.

Abyss Orange Mix:

https://huggingface.co/NeuroSenko/abyss_orange_mix_senko_by_rimukoro_hyper

Anything V3.0:

https://huggingface.co/NeuroSenko/any3_senko_by_rimukoro_hyper

any222trinart:

https://huggingface.co/NeuroSenko/cab_senko_by_rimukoro_hyper

По фреймам из аниме я тоже пытался тренировать модели, но мне они не особо понравились, так что, наверное, не буду их публиковать пока.

---

Так же публикую свои датасеты на Сенко.

Все арты Римукоро:

https://huggingface.co/datasets/NeuroSenko/senko_by_rimukoro

Все фреймы из аниме (773 изображения):

https://huggingface.co/datasets/NeuroSenko/senko_anime_full

Все фреймы из аниме с фильтрацией неудачных кадров (629 изображений):

https://huggingface.co/datasets/NeuroSenko/senko_anime_no_bad_frames

Фреймы из аниме с фокусом на лицо (404 изображений):

https://huggingface.co/datasets/NeuroSenko/senko_anime_face_only

Фреймы из аниме где видно одеяние мико (213 изображений):

https://huggingface.co/datasets/NeuroSenko/senko_anime_miko_visible

Почему анатомию от лоры пидорасит? Есть идеи?

Надо ли вписывать --opt-split-attention или на 3060 оно автоматом включено?

Там это, ультимейт апскейлер ахуенный у нас теперь есть https://github.com/Coyote-A/ultimate-upscale-for-automatic1111

SD скейлер больше не нужен

SD скейлер больше не нужен

Его ещё в 20 наитреде обсуждали, его отличие от сдапскейла примерно нихуя

Даже объяснять лень где ты не прав и почему, иди обратно в анимушный загон.

>обсуждали

че могли обсуждать брейнлес пчелы со скопипасченными (((()))) и жереми липкингом?

Если модель норм грузится в память по дефолту и рендерит без отвалов то никакие оптимизаторы врама не нужны.

Потому что ты не прав, довен бля, его тестили прямо в треде. Результат - примерно нихуя, на уровне погрешности.

Показывай как пользоваться, умник бля.

Почему скрипт отказывается запускаться, если я прописываю путь с регуляризационными изображениями?

Анимешный черт съеби, ты своими врети там заебал, а теперь ещё и тут, я с такимт ультимейт даунами разговор не веду и не поясняю ничего, хуй саси.

Я тестил, вопросы?

Если есть 12гб и больше, то ультимейт не нужен. В то время как цель хорошего апскейла сделать как можно меньше тайлов, то ультимейт наоборот делает их много + ещё и проходится потом вторым проходом, уничтожая детали. Он нужен только, если ты не можешь штатным сделать нормально, т.е. ограничен врам.

Какой же смешной подрыв тралёнка, обнаружившего, что его любимая новая игрушка нравится только ему. Апскейлил дольше чем ты знаешь про сд, запустил лдср и принес валар в /б. Что ещё расскажешь?

>грю

гри дальше, деревня.

>запустил лдср

Ебать достижение, скопировать парочку файлов

мимо

Какой же ты сруня чсвшный анимехуесос пидорас, неиронично надо тебе в дурку.

>да я да у меня да ты уиии

ну разревись еще, анимедевка

Не слабый семенинг с утра и подрыв срак итт и в соседнем треде. В школу по субботам не надо, хорошо

Пиздец нахуй, надо сруню в спам-лист заносить, этим словом реально тупо давят всех несогласных

На любые аргументы отвечают скрином протыка а когда аргументов не имеется, пуки про "отсутствие аргументов"

Это от sd у вас так крыша потекла? Я такого даже в пораше не видел, пиздец...

> Ебать достижение

Что-то не скопировал раньше никто. Про валар вообще не слышали.

> чсвшный

Я же не пишу это в каждом посте итт, глурый, а чтобы ты понимал, что я не первый раз апскейл вижу. Конкретно к обсуждение новой мокрописьки, которую ты только увидел и решил притащить сюда. А её давно протестили и выбросили как мусор ничем не выдающуюся

по опыту на других досках когда ебанашка начинает писать "протык", то в 99% он этим "протыком" и является, так что срунька съеби ка на хуй

>чсвшный мудень продолжает строить из себя что-то хотя ему настойчиво рекомендовали завалить ебало

прикольно, говно отыгрывает маняэксперта

По опыту на других досках и на этой доске ты являешься червём-пидором.

но я не анимешный чсв гной петух эксперт по всем вопросам aka срунич

Так ты как раз анимешный чсв гной петух эксперт по всем вопросам aka срунич, орео нах.

Ладно, тут анон(-ы) жалуется что оффтоп и в принципе я согласен, буду обновлять теперь молча, если есть какие-то проблемы можно создать ишью, или на крайняк если не хочется палить гитхаб можно написать тут кратко. Следи за релизами

Меня переполняет любопытство почему?

А ты посмотри на себя со стороны, вы друг друга стоите по уровню щитпостинга и малоинформативности.

LDSR хоть и годно апскейлит, но бля, если ты стартанул, то ты уже не сможешь прервать операцию, кроме как закрыть батник и перезапустить автоматик.

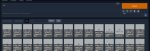

Бахнул 6 сеток ночью, 0.4.0 с разными lr: unet 5e-4, 3e-4, 1e-4

Каждое значение unet lr имеет две вариации: text encoder lr = unet lr и text encoder lr = unet lr / 2

Все остальные настройки абсолютно одинаковые, в т.ч. сид

Беглым взглядом по графикам что-то сказать сложно, да, есть закономерность что чем больше lr, тем меньше loss, но это ни о чем не говорит, тем более значения отличаются минимально

Гриды в процессе

Каждое значение unet lr имеет две вариации: text encoder lr = unet lr и text encoder lr = unet lr / 2

Все остальные настройки абсолютно одинаковые, в т.ч. сид

Беглым взглядом по графикам что-то сказать сложно, да, есть закономерность что чем больше lr, тем меньше loss, но это ни о чем не говорит, тем более значения отличаются минимально

Гриды в процессе

Йей, ватоматик сделал дпм++ карась дефолтным семплером. Наконец-то мы, мученики колаба и прочих пейперспейсов, сможем вздохнуть спокойно (еще бы починил нам линк с градио, а то достало его после каждого пакета перегружать)

Такими задницами, как справа

Такими задницами, как справа

LDSR еще вымораживает тем, что он пол часа грузится, а потом при генерации выдает ошибку, мол вае твое говно, ставь ноу халф вае.

Какой командой обновлять автоматик? А то чет он по дкфолту сам не обновляется.

>Какой командой обновлять автоматик? А то чет он по дкфолту сам не обновляется.

Я-то на колабе, я всегда делаю клон

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui

А тебе, наверное, надо делать git pull

Реально ли натренить DreamBooth-модель на позу? Хочу таки сажать тянок на шпагат :3

Или хоть на вертикальный стабильно ставить.

Кто-нибудь что-нибудь подобное пробовал?

Или хоть на вертикальный стабильно ставить.

Кто-нибудь что-нибудь подобное пробовал?

хоба

AttributeError: module 'modules.paths' has no attribute 'data_path'

Что это? Как это исправить?

Что это? Как это исправить?

Так, ну сделались гриды

1 пик, UNet LR = 1е-4: нормальные результаты, отличная редактируемость. Очень медленная скорость: у сети проблемы с отображением концепта, персонаж не похож на ГТ. Касаемо разных скоростей ТЕ: трудно сказать чем они отличаются. У меньшей скорости ТЕ проблемы с запоминанием концепта заколки на волосах персонажа (она присутствует на каждом изображении датасета) - не в том месте и не той формы. У большей скорости с этим получше, но все равно далеко. По внешности +- одинаково, трудно выбрать победителя.

Вывод. 1е-4 - не очень хороший выбор для обучения на 0.4.0, обучить сеть концепту(-ам) вероятно можно, но потребуется большое количество шагов, что немного нивелирует плюс Лоры как быстрого способа обучения. Возможно попробую еще раз на большом количестве шагов. Какую скорость ТЕ брать: трудно сказать, нужно еще тестировать. На такой маленькой дистанции (1.5к шагов) однозначно сказать трудно.

2 пик, UNet LR = 3e-4: хорошие результаты, но уже появляются следы отхода рисовки от модели в последних эпохах. Концепт намного больше похож на ГТ (оно и логично, скорость обучения UNet возросла в 3 раза). Разные скорости ТЕ: цвет волос концепта на меньшей скорости более консинстентный (субъективно). У обеих скоростей ТЕ проблемы с концептом заколки примерно одинаковые. Меньшая скорость ТЕ даёт чуть большую редактируемость + генерации меньше отходят от стиля рисовки модели (субъективно + малая выборка).

Вывод. 3е-4 хорошая скорость для обучения, но всё же не очень быстрая для Лоры, поэтому вероятно потребуется большее количество шагов. Но это будет гораздо быстрее, чем тренировать на 1е-4. Какую скорость ТЕ брать: я бы брал 1.5е-4 (субъективно).

3 пик, UNet LR = 5e-4: хорошие результаты, заметно более низкая редактируемость и bias в сторону стиля датасета, а не модели. Персонаж также достаточно сильно похож на ГТ, но не сказать что сильно обошел 3е-4, на уровне погрешности. Меньшая скорость ТЕ заметно лучше справляется с генерацией в стиле модели, меньший bias в сторону датасета (субъективно). У обеих скоростей ТЕ проблемы с редактируемостью, но у более низкой скорости она лучше (опять же, субъективно).

Вывод. Для быстрой тренировки 5е-4 подойдет. Быстро понимает основной концепт и также быстро уменьшает редактируемость и вариативность и вносит изменения в стиль рисовки модели. Какую скорость ТЕ брать: однозначно уменьшенную (имхо).

4 пик, сравнение всех финальных эпох со вчерашней тестовой сеткой (LR 1e-3): 1е-3 просто уничтожает картинку. Сеть страшно перетренирована на крупных деталях: полное отсутствие какой либо мелкой детализации, уничтоженные контуры, околонулевая редактируемость, гигантский bias в сторону рисовки датасета. Тем не менее лучше всех справилась с заколкой, хоть она и по-прежнему далека от ГТ.

Вывод. Я не нашел применения такой большой скорости. Возможно я что-то делаю не так. Возможно стоило добавить приличный warmup для планировщика, потому что сеть без него стартует с гигантской скорости. Возможно ситуацию мог спасти другой планировщик, какой-нибудь рабочий polynomial (но ни в коем случае не constant). Возможно нужно было тренировать на меньшем количестве шагов. Нужно экспериментировать а у меня слабое железо и это займет вечность

в китайцоскрипте от него никакого толку, потому что этот планировщик в его имплементации не поддерживает важные дополнительные переменные и polynomial имеет ровно такой же график как linear

Что дальше? Пока думаю. Нужные значения имхо лежат где-то в районе первых двух результатов. Несмотря на не очень большую схожесть с ГТ, мне понравились результаты 1е-4 с уполовиненной скоростью ТЕ: отличная редактируемость, отсутствие bias в сторону датасета. Если я правильно понимаю, большее количество шагов должно спасти ситуацию. У сети будет больше времени обучиться концепту и она не "задавит" своими весами веса модели из-за маленькой скорости. Минус этого варианта очевидный: увеличенное время тренировки. Раньше я мог на своём корыте натренировать персонажа за 20-40 минут и получить нормальные результаты, но с обновлением 0.4.0 это больше не так. Видимо либо качество, либо скорость. Я всё же придержусь мнения что тренировать нужно только на 0.4.0, потому что в этой версии ввели то, что должно быть изначально, альфа - это переменная которая всегда была в оригинальном репо cloneofsimo, даже изменение переменной ранка (network_dim) появилось не сразу.

Вот бы нам анона с 4090, которому не лень было этим заняться. Уже бы давно всё порешали и тренили отличные сетки без нулевых тензоров на 0.4.0.

Макаба сломала мне разметку, имелось в виду

> рабочий polynomial(звездочка)

> (звездочка)в китайцоскрипте от него никакого толку, потому что этот планировщик в его имплементации не поддерживает важные дополнительные переменные и polynomial имеет ровно такой же график как linear

Что значит "перетренирована", мне может кто-нибудь объяснить? Как сеть может быть перетренирована, как это понимать из картинки нахуй?

>Вот бы нам анона с 4090, которому не лень было этим заняться.

Чем конкретно надо заняться?

анон с 4090

сделай бочку

Да какой оффтоп, хз, как по мне это релейтед, уж точно надохуя чем срунесрачи на 50 постов

>анон(-ы) жалуется

Вахтер

Тут удобнее чем на гитхабе

> > Хранить настройки в реестре очень хуёвая идея

> Почему кста? Вроде дохуя 3рд пати хранят некоторые настройки в реестре

Потому что

1) В linux ВНЕЗАПНО нет реестра, а твоей программой в теории могут пользоваться его пользователи.

2) Эта программа подразумевает некоторую портативность. При использовании файлов с настройками ты можешь создавать сколько угодно копий программы разных версий не боясь конфликтов между ними. Так же ты можешь переносить свои конфиги с одного компьютера на другой или делиться ими с другими пользователями. В случае с реестром это будет боль.

Линукс-кун а треде все в айклоунд

Два чаю. Привязывать к реестру - не лучший выход. JSON в пихоне должен писаться и читаться одной строчкой (т.е. одной - читаться и ещё одной - писаться). И можно иметь разные версии конфигов и переключаться между ними переименованием файлов.

Дай линк на сорцы, мож чё умное присоветую.

У третьей перелом лодыжки. Опасное дело - спорт.

Можно промт и модель? Не на перелом лодыжки, а на первые две

!sudo systemctl telepathy start

Пробелы в путях? Кириллица? Прописать абсолютный путь?

Я понимаю это так, что сеть "слишком сильно обучается" тому, чему ты её учишь и ничего кроме тренируемого концепта воспроизвести не может

Ну вот этой хренью что я занимаюсь. Берется один датасет, одни настройки, один сид и хуярится пять тыщ сеток с чутка разными настройками, потом гриды где всё это дело сравнивается. Мы находим нормальный диапазон значений для тренировки и всё счастливы. Все тренят на 0.4.0, кохъялахта остается без работы, мир погружается в утопию

Ок, остаемся здесь

Бля пиздец чувствую себя как собака, мне говорят одно я делаю, мне говорят другое я делаю

Держи, анон. Если не лень и есть время, разъеби по фактам и насоветуй всего что в голову приходит, как сделать этот код нормальным. Из основного что меня тревожит, это то как реализованы вкладки и то, что каждая новая вкладка открывается дольше предыдущей до тех пор, что на плюсик приходится нажимать аж несколько раз

https://github.com/anon-1337/LoRA-train-GUI

У тебя подход изначально неправильный. Не питонический и не ООПшный.

Создай словарь, в котором будут описаны все поля и параметры вкладки по умолчанию.

Создай список, в котором будут храниться все экземпляры вкладок.

Создай класс, конструктор которого будет загружать поля из этого словаря или другого указанного:

tab_settings_dict={"input_ckpt_path": "./", "checkbox_is_sd_768v_ckpt": False, "checkbox_is_sd_2x_ckpt": False, ... и т.д.}

tabs = list()

class lora_tab():

....def __init__(self, input_dict, *kwargs):

........for dictionary in input_dict:

............for key in dictionary:

................setattr(self, key, dictionary[key])

........for key in kwargs:

............setattr(self, key, kwargs[key])

При создании новой вкладки (в начале функции add_lora_tab) просто создавай новый экземпляр:

tabs.append(lora_tab(tab_settings_dict))

Теперь ты сможешь обращаться к параметрам любой созданной вкладки через её номер(индекс в списке) и поле:

tabs[0].checkbox_is_sd_768v_ckpt

Индекс созданной новой вкладки будет последним:

tab_num = len(tabs)-1

Так же ты можешь выгрузить все параметры любой вкладки в словарь и таким образом сохранить их в файл json:

with open('tabsettings.json', 'w') as json_file:

....jsonDict = json.dumps(tabs[0].__dict__)

....json_file.write(jsonDict)

И соответственно можешь сделать наоборот — загрузить параметры из файла

with open('tabsettings.json') as json_file:

....jsonDict = json.load(json_file)

....tabs[0].__dict__ = jsonDict.copy()

Так же можешь копировать значения из одной вкладки в другую:

tabs[2].__dict___ = tabs[0].__dict___.copy()

Единственное что нужно будет написать два колбека.

Один должен будет вызываться в каждом элементе gui и при изменении его состояния должен будет изменять соответствующее поле в своем экземпляре.

Например

dpg.add_checkbox(tag = f"checkbox_is_sd_2x_ckpt{tab_num}", label = "Stable Diffusion 2.x", before = f"checkbox_is_sd_768v_ckpt{tab_num}", default_value=tabs[tab_num].checkbox_is_sd_2x_ckpt, callback=elements_callback, user_data=(tab_num, "checkbox_is_sd_2x_ckpt"))

А колбек должен будет выглядеть примерно так.

def elements_callback(sender, app_data, user_data):

....tab_num=int(user_data[0])

....tab_setting=user_data[1]

....setattr(tabs[tab_num], tab_setting, app_data)

Теперь если тыкать на этот чекбокс значение tabs[tab_num].checkbox_is_sd_2x_ckpt будет принимать значение True или False

Второй колбек должен делать всё наоборот. При загрузке параметров из файла он должен изменять состояние каждого соответствующего элемента gui при помощи dpg.configure_item

Либо при загрузке параметров из файла создавать новую вкладку с параметрами из указанного словаря.

Можно, например, у функции add_lora_tab добавить параметр input_file_dict, который по умолчанию имеет значение None

def add_lora_tab(sender, app_data, input_file_dict= None)

Параметры sender и app_data обязательны, потому что это колбек-функция.

После чтения файла создавать новую вкладку:

with open('tabsettings.json') as json_file:

....jsonDict = json.load(json_file)

....add_lora_tab(input_file_dict = jsonDict)

И дальше проверять — если параметруказан, то брать значения из него при создании экземпляра вкладки:

if tab_dict != None:

....tabs.append(lora_tab(input_file_dict))

> и то, что каждая новая вкладка открывается дольше предыдущей до тех пор, что на плюсик приходится нажимать аж несколько раз

Это из-за хинтов _help

Вообще советовать DPG была плохая идея, лол. Слишком он уж всрат. Лучше было бы использовать tkinter или PyQt. У них порог входа выше, но они гораздо лучше.

Спасибо тебе огромное что не поленился и расписал! Буду курить твои советы, читать документацию и потиху править код. Не знаю только что такое __dict__ и *kwargs.

> Слишком он уж всрат

Но кстати дизайн интерфейса у него приятный.

Еще замечание. Есть элементы gui у которых в качестве входных параметров указываются списки или кортежи:

Как сделано у тебя:

gui.add_combo(["linear", "cosine", "cosine_with_restarts", "polynomial", "constant", "constant_with_warmup"], tag = append_instance_number("combo_scheduler"),default_value = "linear", width = -1, callback = scheduler)

Так делать не надо. Создай кортеж с котором прописаны все эти элементы

schedulers = ("linear", "cosine", "cosine_with_restarts", "polynomial", "constant", "constant_with_warmup")

При создании элемента указывай этот кортеж

gui.add_combo(items = schedulers,

В default_value указывай индекс.

default_value = schedulers[0]

В колбеке так же работай со значениями app_data по индексу

def schedulers_callback(sender, app_data):

....schedulers.index(app_data)

Теперь если тебе нужно будет добавить или убрать количество планировщиков, то достаточно будет изменить только кортеж schedulers.

Как сделано у тебя:

gui.add_combo(["linear", "cosine", "cosine_with_restarts", "polynomial", "constant", "constant_with_warmup"], tag = append_instance_number("combo_scheduler"),default_value = "linear", width = -1, callback = scheduler)

Так делать не надо. Создай кортеж с котором прописаны все эти элементы

schedulers = ("linear", "cosine", "cosine_with_restarts", "polynomial", "constant", "constant_with_warmup")

При создании элемента указывай этот кортеж

gui.add_combo(items = schedulers,

В default_value указывай индекс.

default_value = schedulers[0]

В колбеке так же работай со значениями app_data по индексу

def schedulers_callback(sender, app_data):

....schedulers.index(app_data)

Теперь если тебе нужно будет добавить или убрать количество планировщиков, то достаточно будет изменить только кортеж schedulers.

Потренил 3 сетки на unet 2e-4, te 1e-4 с разными network_dim: 128, 64, 32. Очень интересно что получится, делаю гриды сейчас

Хорошо, спасибо еще раз

Хорошо, спасибо еще раз

Сколько пикч было в дата-сете? Какого разрешения?

Можно в крадце. Если ты говоришь про 2 способ, т.е. брать UNet LR 3e-4, а TE 1.5е-4, то какую основную LR ставить? А планировщик?

Планировщик я брал linear. В датасете 11 пикч 12 повторений + 15 пикч 3 повторения, итого 26 уникальных пикч, одна эпоха равна 177 шагам. Основной LR можно никакой не ставить. Значения UNet LR и TE LR переопределяют основной LR. Ты либо тренишь на одинаковой скорости и UNet и LR, выставляя только основной LR (UNet LR = LR, TE LR = LR), либо ставишь свои значения в отдельные скорости и основной LR как параметр не используется.

Оформил гит пул и тоже сгорел. Ватоматика надо пиздить палками.

Кароч, открываешь style.css в корневой папке. Ищешь там .extra-network-cards .card , после него меняешь width: 16em; height: 24em; ставишь 6em и 12em соответственно например. Это ширина и высота панели в размерах текущего шрифта.

Потом идешь .extra-network-cards .card .actions .name , под ним меняешь font-size: 1.7em; на 1.2em например, это размер шрифта названия.

Сохраняешь, рестартишь градио, получаешь такое.

Обновляться потом через гит ресет или подкидываешь забекапленный файл

Спасибо.

>Обновляться потом через гит ресет или подкидываешь забекапленный файл

Можно подробнее? Писать не git pull а git reset и потом делать то же самое в .css?

Ебать. Почему я не тестил нетворк Диму меньше 128? У меня на нетворк дим 1 (!!!) получились нормальные результаты, учитывая размер в 1.23 Мб (!!!)

Я давно писал, что на 8 норм

В натуре. 128 это оверкилл какой-то. Буду тренить теперь на 8-32. Повелся на дурачков с форча

пока мальчик трясётся за свои мегабайтики, мужчина зарабатывает на очередной трбайтный ссд.

> Можно подробнее?

Бля, сорян. Кароч если через гит пул не сможет, то пишешь git reset --hard HEAD все откатится до до последнего коммита, дальше git pull. Ну или просто возвращаешь обратно исходный файл что бы перестало ругаться и гитпулишь как обычно.

>и потом делать то же самое в .css?

Ага

С терабайтными ссд проблем нет, вопрос скорее "нахуя?"

Ну вот и что, и чего?

Делал все по гайду тренинга лоры, дошел до запуска скрипта пикрил. А как его запустить-то? Это же блокнот! На .\train_network.ps1 что в павершеле, что в командной строке выдает

>не распознано как имя командлета, функции, файла сценария или выполняемой программы. Проверьте правильность написания имени, а также наличие и правильность пути, после чего повторите попытку

>не является внутренней или внешней командой, исполняемой программой или пакетным файлом.

Делал все по гайду тренинга лоры, дошел до запуска скрипта пикрил. А как его запустить-то? Это же блокнот! На .\train_network.ps1 что в павершеле, что в командной строке выдает

>не распознано как имя командлета, функции, файла сценария или выполняемой программы. Проверьте правильность написания имени, а также наличие и правильность пути, после чего повторите попытку

>не является внутренней или внешней командой, исполняемой программой или пакетным файлом.

Ты в папку с файлом-то зашел? В powershell.

ls напиши и проверь что файл есть в списке

Вот он у меня закинут в папку сд скриптс. В списке есть. Павершел с момента выборов не закрывал.

Выйди из венв перезапусти

Че так сложно? Просто через пкм или открываешь павершелл через пуск и тупа кидаешь в него файл

Попробуй сделать

Set-ExecutionPolicy -ExecutionPolicy Unrestricted -Scope CurrentUser

Делал в самом начале, нагуглил когда начало выдавать ошибку.

>Выйди из венв перезапусти

Сделал.

>открываешь павершелл через пуск и тупа кидаешь в него файл

Без админа - просто открывает блокнот. С админом - пикрил.

.txt убери из имени файла

Пкм - свойства - подробно - имя

показ расширений надо включать

Запустил вроде.

Решение как всегда нашлось на каком-то форуме за 2011 год.

я тоже долго мучался, понять не мог, что это не расширение ps1 стоит, а просто часть имени.

Хуита вышла, на 0.3.1 персы тренируются, а стили художников - нет. Как решать - я хуй знает.

Бля, как же надоели стандартные стили моделей, а поменять не могу...

Пиши by Jeremy Limpkins и жизнь наладится.

Хуита, на стиль влияние минимальное.

Я знаю что granblue fantasy работает на аниме-моделях, но больше я ничего не знаю.

Спасибо за сравнение

Мимо тот, у кого 32мерные лоры получились лучше, чем 128, а первая, на дримбутовском дополнении, еще до всего этого хайпа, то есть размерности 4, еще и более редактируемая

Вот кстати, у этих лосей есть нисходящий тренд. Помню в обсуждениях на гитхабе все пытались добиться нисходящего тренда от имбеддингов и гиперсеток ( и ведь добились https://github.com/AUTOMATIC1111/stable-diffusion-webui/discussions/7011 ). Интересно, что будет, если продолжить тупо тренировать дальше.

Кстати да, все эти лоры меньшей размерности лучше редактируются и меньше влияют на стиль модели. Мое предположение что это из-за того что тренируется меньше параметров unet и текстового энкодера, соответственно меньше влияние на модель

Выкладывай датасет и настройки. И показывай что есть и какой результат необходим. Тут нет телепатов

Я вообще этого не понимаю, лоры эти ебаные. Даже если есть нисходящий тренд, то он просто минимальный, на уровне погрешности. А всё потому что китаец - ебаный лентяй, написал код который работает на 6 гб врам и теперь думает что он ебать какой охуенный и ничего больше имплементировать не надо. А ведь там еще немало фич вроде как в офф. репо cloneofsimo. И он добавляет новые. У китайца блядь не работает polynomial (!), потому что он принимает важный параметр, отвечающий за скорость спада кривой (или за её кривизну, хуй знает как сказать), у китайца соответственно нет и график полиномиал выглядит как линеар. А ведь правильно настроенный полиномиал - это поле для экспериментов, потому что он позволяет выставлять экстремальные значения скорости обучения без ущерба для результата (в теории). И китаец игнорирует уже который ишью с этой просьбой, лучше замерджить очередной бесполезный пул реквест с парой новых строчек в метадате сети

Ух, как печет у меня сука с него

Было бы 12 гб врам, тренил бы на оффициальном репозитории, похуй на оптимизации. Надеюсь cloneofsimo оптимизирует свое детище, он про что-то такое недавно писал

пригорел

Больше не куда писать. Анон в соседнем треде открыл мне генерацию голоса, я попытался локально установить по гайду китайца - вот он

https://www.bilibili.com/video/BV1T84y1e7p5/?vd_source=6d5c00c796eff1cbbe25f1ae722c2f9f#reply607277701

Вот демка на тест

https://huggingface.co/spaces/Plachta/VITS-Umamusume-voice-synthesizer

А проблема на пике, не знаю что и делать. Может тут сидят знающие?

https://www.bilibili.com/video/BV1T84y1e7p5/?vd_source=6d5c00c796eff1cbbe25f1ae722c2f9f#reply607277701

Вот демка на тест

https://huggingface.co/spaces/Plachta/VITS-Umamusume-voice-synthesizer

А проблема на пике, не знаю что и делать. Может тут сидят знающие?

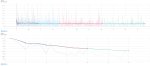

Пик 1. Вот блять потратил еще 8 гпу часов на тестовые сетки, на этот раз с разным количеством эпох при абсолютно одинаковых настройках. И не дай бог конечные эпохи визуально отличаться не будут.

Пик 2. И почему график так колдоёбит на старте эпох? Такого раньше не было, появилось с нетворк альфой 1 (окей, тут я не разбираюсь, может это особенности алгоритмов обучения).

Пик 3. Окей, выкручивая смузинг на 1 нисходящий тренд очевидно есть, но он... маленький? Или я многого прошу? Сеть как будто мало чему обучается, как будто меня опять ждёт ебатория с лёрнинг рейтами

Хоть и немного анрелейтед, но выглядит как проблема с кодировкой

Попробуй накатить LocaleEmu и запустить с китайским языком

https://github.com/xupefei/Locale-Emulator

Пик 2. И почему график так колдоёбит на старте эпох? Такого раньше не было, появилось с нетворк альфой 1 (окей, тут я не разбираюсь, может это особенности алгоритмов обучения).

Пик 3. Окей, выкручивая смузинг на 1 нисходящий тренд очевидно есть, но он... маленький? Или я многого прошу? Сеть как будто мало чему обучается, как будто меня опять ждёт ебатория с лёрнинг рейтами

Хоть и немного анрелейтед, но выглядит как проблема с кодировкой

Попробуй накатить LocaleEmu и запустить с китайским языком

https://github.com/xupefei/Locale-Emulator

Пытался, выдает пикрил. Видно проблема с noise scale, но не ясно что именно.

Может это параметр и он как-то неправильно передается или не передается вообще?

Это вот это вот хрень, не ясно где оно вообще хранится в .json его нет.

Открывается окошко по этой кнопке, если что. Эти числа сами выставлены изначально, я их не ставил.

Сори анон, я тут не помогу. Напиши в наи тред, там гораздо больше людей сидит

Попробуй точку как разделитель в порядке бреда.

Я пытался это, печатать не дает, а если скопировать 0.667 с точкой то результат пикрил.

А, не, просто меняет точку на запятую.

И то ли я вообще нашел, хз.

Да, в пизду Диму 128. Оттренил 7 сеток на 16, результаты поражают. Даже на "высоком" лр, где на 128 уже датасет выдавливал рисовку модели своей рисовкой, на 16 никаких следов от этого нет. Куда лучшая переносимость. Интересно потом будет потренить стиль на таком Диме.

не понял, стили лучше тренятся на низком диме? у тебя 0.4.0?

У меня 0.4.0

Я не тренировал на низком диме

> Интересно потом будет потренить стиль на таком Диме

Но я буду не против если потренишь и покажешь что получилось. Уже подзаебался если честно

Скорость обучения UNet 5е-4, ТЕ 2.5е-4, network_dim 16, alpha 1

Маленький дим позволил наконец-то сети понять что такое заколка, где она, какого она цвета и формы! (для тех кто читал вчерашний пост). Сетки весят по 18 мегабайт, волшебно.

Да, длительность обучения однозначно влияет на результаты. Чтобы получить похожие результаты, нужно тюнить скорость обучения или еще чего. Тренировать на одном LR разное количество эпох – нет, это так не работает.

Лучший результат для меня – 10 эпох (1770 шагов / 177 пикч с повторениями). На 20 эпохах сетка перетренировалась, на 30 перетренировалась жутко. Есть смысл понижать LR для большего количества эпох, но в пизду, меня мои 10 эпох устраивают.

Итого что я имею на данный момент, это network_dim 16, network_alpha 1, UNet LR 5e-4, TE LR 2.5e-4, 17.7 повторений на 1 пикчу датасета (учитывая повторения) пока хуй знает насчет этого. Осталось выяснить планировщик. Буду пробовать cosine и cosine_with_restarts. Первый в китайцоскрипте внезапно рабочий, второй полурабочий, но все же не такая ситуация как с polynomial, можно еще найти применение.

Потом попробую найти примерный оптимал для стилей, не удивлюсь что все настройки в итоге окажутся такими же.

Маленький дим позволил наконец-то сети понять что такое заколка, где она, какого она цвета и формы! (для тех кто читал вчерашний пост). Сетки весят по 18 мегабайт, волшебно.

Да, длительность обучения однозначно влияет на результаты. Чтобы получить похожие результаты, нужно тюнить скорость обучения или еще чего. Тренировать на одном LR разное количество эпох – нет, это так не работает.

Лучший результат для меня – 10 эпох (1770 шагов / 177 пикч с повторениями). На 20 эпохах сетка перетренировалась, на 30 перетренировалась жутко. Есть смысл понижать LR для большего количества эпох, но в пизду, меня мои 10 эпох устраивают.

Итого что я имею на данный момент, это network_dim 16, network_alpha 1, UNet LR 5e-4, TE LR 2.5e-4, 17.7 повторений на 1 пикчу датасета (учитывая повторения) пока хуй знает насчет этого. Осталось выяснить планировщик. Буду пробовать cosine и cosine_with_restarts. Первый в китайцоскрипте внезапно рабочий, второй полурабочий, но все же не такая ситуация как с polynomial, можно еще найти применение.

Потом попробую найти примерный оптимал для стилей, не удивлюсь что все настройки в итоге окажутся такими же.

Аноны, вдруг кто в курсе: есть 2060 super на 8 гигов, ее хватает на тренировку 1.5 модели файлами 512 пикселей и без текст энкодера, но хотелось бы тренировать модель 2.1 файлами 768 пикселей ну или хотя бы 1.5, но с текст энкодером. Если я поставлю вторую такую же карту, можно ли будет как-нибудь использовать суммарный VRAM этих карт для тренинга? Или лучше все же сразу мутить одну карту на 16+ гигов?

> суммарный VRAM этих карт

Нет.

Почему я на 4090 на пикче 512х512 получаю 10 it/sec? WTF автоматик?

с какими параметрами запущен webui?

Добро пожаловать в пердолинг. Потом получишь около 35 (на батче со 150шагами, иначе слишком быстро).

set COMMANDLINE_ARGS= --xformers --deepdanbooru --no-half

Причем есть две папки с разными xformers, скорость ~одинаковая

Вы тут только аниме трените? Кто-нибудь реальных людей тренил? 20 фоток достаточно? Я делал по 12 повторений на 10 эпох и как понимаю перетренировывал. Получалось 2400 шагов. То есть закидывал портреты и стабл 99% портретов выдавал, пусть и очень похожих. Вопрос соответственно, лучше больше фоток и меньше повторений тренить?

cudnn либы обновил на актуальные? Если нет, то качаешь https://developer.download.nvidia.com/compute/redist/cudnn/v8.7.0/local_installers/11.8/cudnn-windows-x86_64-8.7.0.84_cuda11-archive.zip

Потом из архива из /bin/ кидаешь dll-ки с заменой в \venv\Lib\site-packages\torch\lib\

Если перетренировал попробуй уменьшить вес

Закинул. На старом торче 14,5 , на новом 15,5. Уже лучше, спасибо. Хотя мне казалось что на новом торче уже должны быть новые либы

можешь ещё конкретно вот эту версию xformers накатить https://github.com/C43H66N12O12S2/stable-diffusion-webui/releases/download/torch13/xformers-0.0.14.dev0-cp310-cp310-win_amd64.whl

челу из трэда https://github.com/AUTOMATIC1111/stable-diffusion-webui/discussions/7135 вроде как помогло

если не поможет, можешь в корне webu, в файле webui.py после

def initialize():

check_versions()

написать

torch.backends.cudnn.enabled = False

Новый годный экстеншон https://github.com/mcmonkeyprojects/sd-dynamic-thresholding , позволяет полноценно крутить всякое на высоких CFG

Зачем?

Спасибо

Чтобы рисовал, что просят, а не что научили?

Типо откатиться на старые? Хм, попробую

> Чтобы рисовал, что просят, а не что научили?

Что ты несешь? Даже на пиках в репозитории "пофикшенный" цфг 20 выглядит убого.

>приебался к тесту

Так промт надо написать нормальный качественный, а не пиздить (((masterpiece:100500))) с айбуру, далбаеб срунявый. Понятно тебе, хуйня на CFG 3 ебаная в жопу?

Господи, сектант ебучий, съеби обратно в свой загон.

> далбаеб срунявый

> хуйня на CFG 3 ебаная в жопу

Жопа не порвалась, твёрдо и чётко.

Там изображение кота в анфас. Конечно, зачем ебаться с котами, когда модель из коробки рисует котов в любых позах в любом цфг.

Если ты не сталкивался с ситуацией, когда лора возвращает вменяемость промпту на высоких цфг, но качество заруинено полностью, а хочется его хоть чуточку вернуть - просто проходи мимо и не ставь его.

Может, оно и не сработает, но хоть за попытку разрабу спасибо

Сруня, ты че такая выебистая мразь? Кто тебя так проткнул что ты на все что не вписывается в твой уточный манямирок мастерпись агришься? Пиздов бы тебе выписать хороших.

Ребзя, подскажите почему часто при включении или при смене модели перестает работать? последнее что пишет Loading weights название модели. Может озу не хватает?

Не было такого, 32 гб рамы.

Ну у меня 16 озу и 16 подкачки

может в самом ватоматике дело, у меня последний релиз всего

надо попробовать обновить, я оч давно не обноалял

Вопрос, как гиперневорк включать через промпт?

Никак. Через промт включается лишь эмбеддинг и с недавних пор лора. Гиперсеть через настройки выбирается, как vae.

Если у тебя одна из новых версий, этот - - пиздит. Теперь можно кнопочками или набрать по памяти.

Не обновлялся неделю. Извиняюсь.

Ничего страшного, анон

Кстати, раз уж такая тем, то как туда превью заделать?

Генеришь с выбранными эмбедом/гипером/лорой картинку, нажимаешь иконку на болванке по наведению мышкой, превью запекается.

Вауу, вот это круто, спасибо

Блять арендовал гпу, стоит по дефолту 3.7 питон, не знаю как сука 3.10 накатить, без него обучалка не работает

Гпу же с блокнотами юпитера работает? Попробуй блок из колаба линакруфа, там есть апгрейд питона, может, и у тебя сработает

https://colab.research.google.com/drive/1cEk2yxPiipjl1D9jITGQEOlVYyUsLQHo?usp=sharing#scrollTo=9gQv3aDDfytc

А, это не линакруфовский, а тохуебский колаб. Ну, сорта...

Оп, пасиба, попробую

wget https://github.com/korakot/kora/releases/download/v0.10/py310.sh

bash ./py310.sh -b -f -p /usr/local

python -m ipykernel install --name "py310" --user

Нихуя, спасибо

это не рисунок, а интерполяция, нейросетка не рисует а только пиздит

всё теперь точно обновляюсь

Господи, блять, неужели. 2 часа проебался чтобы запустить это говно. Иксформерс не пашут, 8бит адам не пашет, я ебал этот линупс.

Еще раз сепсис

Еще раз сепсис

> 4.02 s/it

И стоило оно того?

train_batch_size 10, здравствуйте

Граждане, а что по поводу ускорителей на TensorRT — https://www.reddit.com/r/StableDiffusion/comments/10ntqa4/4x_speedup_stable_diffusion_accelerated/

Пробовал кто-нибудь? И можно ли как-то лёгким движением руки прикрутить к Автоматику?

Пробовал кто-нибудь? И можно ли как-то лёгким движением руки прикрутить к Автоматику?

Чтение комментариев по ссылке - для лохов?

Устраивать жирные набросы, сначала в наи треде потом здесь.

Я уже понял что это один и тот же человек. Именно один. Болезненный какой-то. Игнорируем.

Ебашу лорку на 6400 шагов на стиль худа

Кто такой худ

Или промпт и модель, или не было это нарисовано мясным мешком / img2img

HUD

Типо бля наэкранный интерфейс чи шо?

Упоролся и протестировал все методы на Top P 100 у плагина, для CFG 30.

По итогу могу сказать, что лучше всех работает в таких экстремальных условиях только

cosine up + linear down. Возможно другие варианты смогут лучше себя раскрыть если понижать Top P, но мне пока лень этим заниматься.

-- - значительный баг или непопадание, возможности фиксирования не проверялись

+- - выдает неплохой результат, но имеет значительный баг, который можно пофиксить через mimic и top p

++ - хороший результат

Общий результат:

-- cosine up + constant (distortion face)

++cosine up + linear down

-- cosine up + cosine down

+- cosine up + linear up

--cosine up + cosine up

--constant + constant

+-constant + linear down

-- constant + cosine down

+-constant + linear up

+-constant + cosine up

--linear down + constant

+-linear down + linear down

+-linear down + cosine down (black n white bug)

+-linear down + linear up (distortion face)

--linear down + cosine up

--cosine down + constant

-+cosine down + linear down

+-cosine down + cosine down (black n white bug)

-- cosine down + linear up (perfect prompt with distortions)

--cosine down + cosine up

--linear up + constant

+-linear up + linear down

+-linear up + cosine down (black n white bug)

+-linear up + linear up (perfect prompt with distortions)

--linear up + cosine up

Куда лучше залить свои лоры? На civitai или huggingface? Или по старинке на мегу?

Ничего особенного у меня нет, кроме как стилей авторов рисунков и персонажей из аниме. Хотелось бы знать за ту местную мочу. Можно ли указывать, что стиль определенного автора? И можно ли на civitai несколько версий залить на одну страницу?

Ничего особенного у меня нет, кроме как стилей авторов рисунков и персонажей из аниме. Хотелось бы знать за ту местную мочу. Можно ли указывать, что стиль определенного автора? И можно ли на civitai несколько версий залить на одну страницу?

местному анону который не обновляет репозиторий уже неделю

У меня нет желания. Пароль 2ch

это мясной нарисовал, успокойся

Почему? Хорошая же идея была.

Обновил automatic, теперь включено превью пикч пока генерятся. Вопрос на сколько сильно это замедляет и надо ли выключать?

Зависит от жирности превью и частоты вывода, на фул - сильно. Потести сам, я вообще включаю только когда нужно.

Эх, а тут ведь еще реквесты брали, но так кроме парочки и не доставили. Я еще чуть-чуть жду.

Какие реквесты?

А есть какой-нибудь гайд для тренировки ЛОР в облаке, на том же коллабе? Какие-то ссылки я видел, но пользоваться как - хз вообще.

Только гайд чтоб для совсем хлебушков, которые с этой фигней никогда раньше не работали.

А то моя 2070 и полноценно тренировку не тянет, долго сильно, да и, чую, помрет скоро такими темпами.

Только гайд чтоб для совсем хлебушков, которые с этой фигней никогда раньше не работали.

А то моя 2070 и полноценно тренировку не тянет, долго сильно, да и, чую, помрет скоро такими темпами.

Что за настройки ты накрутил, чтобы тренировка не тянулась? С 512 пикчами ест где-то 6гб. И что означает "полноценно"?

Сколько надо памяти чтоб мержить?

Долго сильно. Так то по памяти оно тянет, впритык к моим 8гб. 512px, 2 batch.

Но я в основном стили и концепты тренировать пытаюсь, а это очень долго выходит, исходя из необходимого количества материала и повторений. И не шибко стабильно.

Поэтому и думаю, куда это можно перетащить, чтоб не так медленно было.

> А то моя 2070 и полноценно тренировку не тянет

тут у людей 1060 тянет

Колабоская Т4 гораздо слабее твоей 2070

минимум 16гб ram

А какой у тебя реквест и готов ли датасет?

Да, у меня до сих пор пару датасетов валяется неоттрененных. Меня заебала вонючая лора. Не могу найти хорошие настройки. Сейчас чувствую брошу нахуй всё. Немного спасает что теперь могу в облаке тренировать

Гугл включил - и другими делами занимаешься.

Пусть и дольше будет, зато комп свободен.

Вместо того, чтоб комментировать, плохо ли, хорошо ли, а зачем тебе - написали бы, где нормальное руководство искать. Можно и на английском, у меня с ним норм. Но чтоб подробно.

Это ты написал мокропиську-гуй для скрипта?

Некоторые аноны не делятся нихуя. Другим проще повниманиеблядствовать на цивите или хагинфейсе. Я ебусь с настройками как долбаеб. Ничего не треню, ебу один и тот же датасет. Меня от её ебала уже тошнит. Блядский питухон изучаю и мне сложна, у меня задница с этого горит. В гайд есть что добавить, но мне лень и я боюсь вкинуть дезинформацию потому что сам до конца не понимаю как всё работает. Таблетки не помогают. С треда 80% людей съебало, интересные темы и вопросы не поднимаются. Настали темные времена...

да

Я в этом блокноте запускал, работает нормально

https://colab.research.google.com/drive/1bFX0pZczeApeFadrz1AdOb5TDdet2U0Z#scrollTo=Y11KimwzGQrp

Это тоже твои ресерчи?

Такое чувство что ты тут один остался кто за идею хуярит. Скинь какой-нибудь датасет, скажи настройки, я попробую какое-то сравнение из нескольких лор, сделанных на разных настройках сделать чтобы помочь, заодно получше научусь

У меня 16 и выдает ошибку. Что делать?

Что пишет?

Да, хуйней тут страдаю. Ценю помощь, спасибо. Но сейчас ничего не скину, с телефона капчую проснулся и не могу заснуть :(

Это вполне нормально что всем похуй, я не обижаюсь. Часть анонов съебала, многие судя по всему остались на версии 0.3.2 где все относительно стабильно, но мне сука хочеца выжать максимум из этой сучки

Ага, в основном доступно.

Настройки кучкой, минимум всяких окон, которые непонятно чего делают.

Третий шаг, как я понимаю, можно пропустить, если свою модель в гугл загрузить в соответствующую папку?

Большинство перегорели уже. В частности меня и пару моих знакомых, которые тоже варятся в этом котле, уже заебало одно и тоже.

Да, только все пути и имена файлов нужно будет правильно указать в полежнем шаге

А что именно

И добавить строчку с параметром альфы

То, что сейчас я залил, сделал еще дней 10 назад. Но ебался с настройками, думал вот сейчас точно лучше будет, а в итоге только первые две попытки и оказались успешнее всего. Примерно с гиперсетями у меня похожая история была. Искал 100% годные рецепты, находил не раз, а каждый раз все хуже и хуже. Остановился на том, что дефолтные лучше всего.

Рано или поздно кто-то да поделится.

Отток людей это нормально. Набегут еще. Скорее хаус упорядочился.

Понять бы еще, какая там папка корневая.

Вот, допустим, у меня лежит в корне гугл-диска папка "AI", и там уже всё остальное - сеты для тренировки, папка с моделью, папка для вывода, всё такое.

Как будет путь выглядеть?

Генерация контента уровня "аниме-тян на фоне какой-нибудь хуйни" или "реалистик-тян (с эффектом зловещей долины) на фоне какой-нибудь хуйни". Иногда не тян, а кун, неважно. И все имидж борды и дискорд серваки (российские, американские, японские, корейские) завалены на 99.9% именно таким контентом.

О, вижу залил, красава! До слёз. Прикольный стиль, надо с утра попробовать

> думал вот сейчас лучше будет

Классика :( Хочется как лучше, а в итоге как обычно. К гиперсетям я вообще боюсь притрагиваться, у кого-то на 2000 шагах вырвиглаз, у других на 50к всё нормально. А для технотреда еще настанут золотые времена! Все еще только зарождается

/content/drive/MyDrive/AI/

Да, понимаю. Грустно, кумеры победили. Поэтому люблю иногда включать сд 2.1 и генерировать всякую хуету, всякие подземные заброшенные лаборатории, ебанутые концепты всякой дичи, инопланетное говно, сооружения на марсе, весело, отвечаю

Я все еще работаю над meme-chan, coconut из некопары. В идеале хочу все же сделать всех кукл розен майден и нек из некопары одним файлом для каждых. Еще месяц-два назад видел, как кто-то с форчана запилил лору с несколькими тянками из Love Live, когда у нас про эту самую лору никто не знал.

Если я чем-то загорелся, значит все, минимум на год, а скорее на года два. Так что я здесь еще на очень долго. В процессе еще что-то придумаю.

Ну я попробовал 0.3.2, там точно работало, опыта у меня мало, сейчас вот уже перекатился тоже на 0.4.0 и хочу что-то потренить, видимо придётся самому собирать что-нибудь для датасета, раз уж и ты там в полудрёме, ничего плохого в 0.3.2 тоже ведь нету, лоры оттуда работают, да и твои на 0.4.0 уже выдают отличные результаты, так что тут можно только похвалить кохью и автоматика, что обратная совместимость есть

Ага, оно живое.

Каких-то варнингов накидало, но тренировку запустило. И вроде как побыстрее локали, видимо за счет batch 3 вместо моих 2. Число шагов все-таки пониже получается.

Спасибо.

Так ты пости результаты, будем обсуждать, корректировать что надо. Хочу коконат увидеть

Бтв съебываю из репо китайца походу, сейчас листаю гитхаб оффициальной лоры, так там пиздец, столько крутых фич чтобы улучшить результаты! Еще и вчера новая версия вышла. Там конечно 6 гб памяти не вытянут скорее всего, буду в облаке тренить, что остается

Жду ваниллу бтв

В 0.3.2 есть большая проблема, это нулевые тензоры. Впустую потраченное время гпу, неполноценные недотренированные модели, которые в теории могли быть лучше

> твои на 0.4.0 уже выдают отличные результаты

Спасибо, но я так не считаю. Есть бесячие моменты которые пока не удается исправить

Вот по этому совету сделал сегодня

И в правду редактируемость фона улучшилась.

Тестировал тег squatting. Колготки в сетку само собой глючат.

Слушай, а ведь хорошо получилось! Но на большем весе видно как рисовка датасета "выдавливает" рисовку модели. Я вот пытаюсь с этим бороться. Помогает уменьшение обоих lr до 3е-4/1.5е-4, но не панацея

Не в пустую, прямо сейчас генерил Лейн лорой созданной еще на бородатой версии каким-то здешним аноном, за что ему кстати спасибо, объединённой с лорой на йошитоши абе.

Впустую, ты наверное имеешь ввиду, когда только эту проблему решать взялись и у всех начались проблемы.

Вообще если так рассуждать, всё это время эни3 могла бы быть с пофикшенными тензорами, и пару других чисел многие генерации изменили бы до неузнаваемости, в теории лучше, но кто его знает, может быть и наоборот, однако это не отменяет того, что до выхода апельсина многие ей пользовались как основой для очень многих миксов и делали вполне неплохие арты.

Хорошо кстати, что ты эти знания выкладываешь по новой версии тренировки лор, я ими обязательно воспользуюсь в ближайшее время.

А откуда лору брал? Я просто тоже Лейн делал лору

Не впустую конечно, я просто шиз, помешанный на перфекционизме и неприятно что все что я делал до 0.4.0 как бы могло быть лучше

Ух, сегодня великий день, попробую другой репозиторий. Ожидания высокие

Нейро-ребята, подскажите нейросеть которая генерит теги по изображению

Ну я из треда скачивал, это она вроде лежит сейчас в коллекции лор? Твоя? Отлично сочетается со стилем художника из коллекци форчана.

Будешь тестить какую-то репу с более обширным функционалом?

> Твоя?

Да :3

> Будешь тестить какую-то репу с более обширным функционалом?

Да: https://github.com/cloneofsimo/lora

Оч интересно что выйдет

DeepDanbooru

Расскажешь потом что получится?

Алсо это же не нормально когда вызываемая лора начинает работать правильно только с кучей сопутствующих тегов на заколку, цвет глаз, использованных при тренировке, а не просто ее вызов в промпте? Просто простой вызов на 1.0 проебал походу вообще все элементы персонажа, кроме цвета волос. Алсо, если не менять промпт генерит как будто "на одном и том же сиде", если прописать детально промпт. Совсем маленькие отличия, даже не поворачивается персонаж особо от генерации к генерации, но фоны удивительно поддаются.

Ну так делись с народом.

Приветик гайсовсня! Как добавить триггер слово в Лору?

А как пофиксить остаточный ген после прошлой версии промта? Ну то есть допустим был рендер 1, меняем его на 11 и первый новый рендер будет рендерить прошлый промт, а второй уже новый.

> Расскажешь потом что получится?

Конечно, если получится

> Алсо это же не нормально когда вызываемая лора начинает работать правильно только с кучей сопутствующих тегов на заколку, цвет глаз, использованных при тренировке, а не просто ее вызов в промпте?

Да, но при этом в датасете должны быть изображения где этой заколки нет, чтобы сеть поняла, как рисовать персонажа когда она есть в промте и как рисовать когда её нет

> Просто простой вызов на 1.0 проебал походу вообще все элементы персонажа, кроме цвета волос.

Немного не понял, что ты имеешь в виду

> Алсо, если не менять промпт генерит как будто "на одном и том же сиде", если прописать детально промпт. Совсем маленькие отличия, даже не поворачивается персонаж особо от генерации к генерации, но фоны удивительно поддаются.

Маленький и не разнообразный датасет + возможно выключенная настройка "--shuffle_caption" при обучении

Я с таким сталкивался, брал промт из датасета и сетка старательно пыталась повторить пикчу с этим промтом

Если в датасете все пикчи как персонаж стоит и только одна как он сидит, неудивительно что на тег "sitting" будет мало разнообразия

Чем? Генерациями?

В гайде по лоре написано, поиск по странице "keep_tokens"

Не понял

6400 шагов(8 повторений, 16 эпох, 50 картинок) на стиль худа

рейт

ну хоть так словил стиль, даун ебаный, как будто гиперссеть треню, а не лору

терь хз будет ли что-то кроме поз с датасета выдавать

Нихуя, красиво. Я так и не понял кто такой худ, не могу нагуглить даже. 6400 звучит как дохуя

>худ

Это сокращение от слова художник.

Второй пик его, первый - мой

Пиздец, ну и сокращения :)

Дай угадаю, это かめぱすた? (простите мне мой японский)

https://twitter.com/kamepan44231

да

>понял

че никода такого не было?

еще раз:

1. генерим на промте zhopa

2. добавляем zhopa anus

3. после нажатия генерации будет генерить все еще промт zhopa

4. вторая генерация после будет zhopa anus

Не, не было

Всё-таки завел иксформерсы в облаке. Блять, как же они ебашут.

функция .blend() работает в pos/neg?

К этой хуйне можно иксформерсы подсосать? А локально?

интересненько, генерация с блендом на 3-4 секунды (рандом) быстрее, чем без - 41.81 vs 44.92

К какой именно? Я про аренду гпу в облаке, сначала не ставились, накатил 1.13.1 торч и последние иксформерсы и всё встало. Прирост почти 2 раза в скорости обучения

>аренду гпу в облаке

Сколько стоит?

Но блять не могу подобрать лр для батч сайза 10, либо не тренит нихуя, либо какая-то говнина с артефактами выходит

Оно включается/отключается в любую минуту, как колаб? Скинь ссыль на сайт

https://console.vast.ai/

Нет, ты платишь за пользование гпу определенную цену в час + еще немного за хранилище. Чем больше выделил себе ссд, тем больше платишь, очевидно. 50 гб у меня 1 цент в час. Ты можешь вырубить в любой момент и тогда будешь платить только за хранилище. Если не хочешь платить вообще, то можно удалить инстанс, но придется потом заново всё настраивать

Но мне судя по всему иксформерсы насрали в штаны, видимо 0.0.16 не работает с китайцоскриптом. Сейчас убрал и нету нанов

вручную обработал 500кб текста, ебать я ебнутый

А сылочку можно на АБе-лору?

Если на васт.аи поставить эту галочку, появятся неверифицированные машины в списке с очень вкусными ценами

Лол, что за домашний-тир машины? Они радмином заразили чей-то парк?

Любой может предоставлять аренду своей видеокарты на этом сайте

Сейчас бы за 14р/час свою 3090 предоставлять. Лицо согласившихся представили? Я свою точно не дал бы

Не, за тебя-то понятно я рад.

Поставил на ночь, пусть работает. Хули нет? Майнинг то уже сдох, переходим в нейромайнинг.

А после аренды, как каломатика накатывать? На колабе то все за тебя колабщик сделал, а тут...

Ноутбуки тут тоже поддерживаются. Берешь любой и копипастишь. Ячейки прожал и работаешь

3060 - 0.08$/час. Мнение?

Да 3070 дохера с такой или ниже ценой. Интересный сервис...

Господа, что прописать что бы грид выдавал 10 штук рандомных сидов? Рандомный сид это -1, а дальше?

>за хнанилище

Сколько?

Я же написал

Ой, не заметил...

Есть некоторый кек в том чтобы тренировать без текст энкодера

Где сдать свою 1060?

На металоприемке

В дом престарелых

> кек

ст энкодер

Я вас не понимаю

Я вас понял :)

чичас вкину сравнение только унет, только кекст энкодер и оба

Сам нашел -1--1[10] как-то всрато

>Ноутбуки

Что?

Ну пропиши 10 штук через запятую.

Дольше и костыльнее

Всмысле костыльнее? Это та же логика что при записи всех других штук в x\y график.

> Всмысле костыльнее?

Меня однажды отпиздили за гаражами за то что задал массив как [1,2,3,4,5] а не [1..5]

>та же логика

Мейби, но писать 0.1-1(+0.1) удобнее чем перечислять все значения например

Окупаемость за 1000 часов. В принципе неплохо.

левая верхняя лучше всего получилась

Вы наци, да?

Правильно ли я понимаю, что если у меня есть пик1 (560x536px), то из него имеет смысл по-разному вырезать куски 512x512px (пик 2-4)? Я понимаю, что это не заменит датасет. Речь идёт скорее об обработке каждой фотки в датасете подобным образом.

Есть ли готовый скрипт для этого?

Есть ли готовый скрипт для этого?

> из него имеет смысл

Не имеет

пипец долго думал почему лол

нет просто имо поза и выражение лица самые милые

Есть ли различие между batch_size и batch_count при генерации на CPU?

Короче хз, какое тут слово из спам листа, прочитай на скрине, вот ссылка на датасет: https://anonfiles.com/YaB9b7V6y6/dataset_7z

Вот следующие два

Ой бля даже хуй знает что сказать. Датасет вроде нормальный. Хуй поймешь эту лору. 10ая эпоха вообще пиздец странная, как будто из другой вселенной, втф? Возможно слишком долго обучал. Я сегодня сравнивал 10, 20, 30 эпох на одинаковых настройках, так вот чем дольше, тем нейронка "сильнее" запоминает датасет и теряется вариативность. Когда переобучаешь спасает только уменьшение веса лоры, но есть риск сделать персонажа менее узнаваемым

Щас я грид сделаю, у меня +197 лора файлов, вроде как что-то нащупал, и выглядит опрятно, и стиль от модельки к модельке меняется. И заколка в паре сеток уверенно так рисуется, прямо как в датасете, перамога кек

С десятой эпохой обосрамс с лишним нулём в гриде, она всё таки рабочая, но всё равно какая-то не оч, мне больше всего не нравится, что сид хоть и меняется с уточняющими тегами, смены положения персонажа в кадре нету, всегда слева направо смотрит, иногда в середине мелькает, наверное зеркалить всё таки нужно, но тогда беда с заколкой будет ещё больше по идее. Ну и восьмая эпоха похожа на самую стабильную.

я нихуя не понял как, но маняфункция

,,,,,blend(промт)

миксит прям перфект без дропов, экспрессия на картинах прям дышит, можно поменьше запятых, допустим одну, с точкой вначале результаты дает хуже

токен , = 267, токен . = 269

,,,,,blend(промт)

миксит прям перфект без дропов, экспрессия на картинах прям дышит, можно поменьше запятых, допустим одну, с точкой вначале результаты дает хуже

токен , = 267, токен . = 269

Поздно, я уже написал скрипт, который это делает.

https://pastebin.com/9anRu74x

Так что теперь датасет должен быть не из картинок 512х512, а из таких картинок, что любой прямоугольник 512х512 содержит заданный концепт.

Любители загнаться - велкам!

Кароче вот мои наблюдения за сегодня

1 пик AOM2-sfw, 2 пик ACertainty, 3 пик udonNoodleMix, 4 пик ГТ (референс)

Что общего у всех: основа ACertainty, датасет 59 пикч суммарно вместе с повторениями (11х4+15х1), network_dim 16, network_alpha 1, train_batch_size 10 (<- это очень важно), clip_skip 2 очевидно, keep_tokens 1, shuffle_caption (триггер токен tk первым тегом везде), lr_scheduler constant_with_warmup, 20 эпох, разгон планировщика ровно половину всех шагов (но с этим в теории можно поиграться)

Разные скорости обучения:

unet:

0.5e-3, 1.0e-3, 2.0e-3, 3.0e-3

text encoder:

0.1e-3, 0.2e-3, 0.4e-3, 0.6e-3 (т.е. в 5 раз меньше unet lr)

Что я получил:

1. Ебучую заколку на некоторых сетках, причем довольно уверенную

2. Переносимость между моделями: охуенскую переносимость между моделями. Как-то так вышло. Причем без особых тегов и кручения весов, всё в стоке, обычный промт и сразу выдает разную картинку на разных моделях. Далеко не всегда такое было, но тут прям зачёт

3. Отсутствие мыла или перешарпленности. Джизес крайст, и такое бывало

Но мне чёт МАЛА. Нужно еще что-то придумать.

Насчёт train_batch_size. Если бы у меня был батч сайз 1 то скорость была б в 10 раз меньше, но она такая гигантская потому что у меня стояло 10! Нужно всегда пересчитывать скорость под свой батч сайз. Потому что умные дяди сказали что линейная зависимость: во сколько раз относительно единицы увеличил батч сайз, во столько же раз увеличиваешь скорость обучения (обе)! А я долго ебался и не мог понять почему у меня не получается воспроизводить старые сетки, они то недо-, то перетренированные

Насчёт разгона планировщика lr_warmup_steps: на всех пиках разгон первые 50% шагов. После 50% шагов скорость обучения выходит на ровную прямую до конца обучения. Как рассчитать? Хуй знает. Я возможно проебался в нескольких моментах в скрипте и в гуе, для батч сайз стопудово он точно считает сколько ставишь, но для батч сайза больше одного не уверен. Легко проверить: настроить запустить скрипт, посмотреть сколько шагов тебе насчитала обучалка, закрыть, поставить половину от этого в lr_warmup_steps и запустить снова

Как-то так

> для батч сайз стопудово

для батч сайз 1 бля*

И еще важное про эпохи не упомянул. Их тут ровно 20 на каждом пике. Будет меньше или больше эпох, будут другие результаты. Но на 20 эпохах именно такие

ШУЕ ППШ

Да, бленд рабоатет в негативах и позитивах, проверяется через

"blend(prompt)", где " токен 1 и получается бесконечное смешивание в одноцветный градиент. То есть от токена зависит смешивание.