Ребят, я новенький. Что делать? Как кумить?

И коммандер 105 такой https://www.youtube.com/watch?v=1cDcHq7nQFM

От ошибок в склонениях и словах до скудного и скучного слога. Дополнительно бывает еще деградация качества ответов, когда на инглише все отлично а на русском тупеет.

Наоборот понимать проще, даже первой лламе можно было писать на русском и она инструкции все выполняла, отвечая на инглише.

> у Ламы постоянно просеры

Где? Стиль более унылый, но может быть связано с промтом. Квен под конец тоже начала тупить короткими предложениями, но это можно оправдать стилем.

> 7\10 llama3.1 70b

> 7\10 llama3 70b

> 5\10 gemma-27b

Довольно странно, гемма в русском хороша.

> maid

Разговорить ее на большой контекст с нормальной моделью у кого-то получилось? Чтобы без внезапных остановок генерации.

Бля, а почему мистраль немо из коробки такая хорни? Оно даже на и близко не эротических промптах и персонажах может начать выдавать всякое, а на eRP с второго-первого сообщения в штаны лезет блять.

База. Поэтому она мне и нравится. Юзаю вместо геммы. На лламу вообще смотреть не хочется - там ужас соя

читай шапку.

Ставь кобольда и таверну, скачивай мистраль немо, открывай мистраль через кобольд, соединяй с таврной, открывай в ней любую карточку персонажа и все, погнал

>Дополнительно бывает еще деградация качества ответов, когда на инглише все отлично а на русском тупеет.

Лол, это везде и всегда есть, и не дополнительно, а главная проблема.

Есть 16 VRAM, какой квант exl2 NeMo в них разместить и как посчитать ебучий контекст? Хочу около 20 тысяч хотя бы

ВОТ И ВСЕ.

Бля, если честно я думал, что это конец и корпораты выиграют. Но кажется в течении следующих 5 лет у нас реально будет AGI, причем умещаться все будет в каждое домашнее железо продвинутого уровня. А вы как думаете?

Бля, если честно я думал, что это конец и корпораты выиграют. Но кажется в течении следующих 5 лет у нас реально будет AGI, причем умещаться все будет в каждое домашнее железо продвинутого уровня. А вы как думаете?

6 бит.

>хочу 20 гб

Квантуй кэш до 4 бит, влезет.

Обязательно. Ты главное почаще себе об этом напоминай. Не забудь на тесты нафайнтюнить, а то опять в таблице низко будешь.

>Не вижу Немо.

>Ассистент

>Я перевела текст для вас на русский язык.

>Произошла ошибка

Часто таким срет, или прерывается на половине, так что о переводе и нет речи. Я бы поставил между 5-4\10, если оценивать качество.

Так ты рпшить начинай на русском прям. Он норм рпшит

> Не забудь на тесты нафайнтюнить

Ебать манямирок. Ты же в курсе, что это user-guided бенчмарк, а не стандартный с заготовленными вопросами и ответами?

стоп, 20 тыс токенов это 20 гигов? ебануться

>в течении следующих 5 лет у нас реально будет AGI

Ты нолик забыл.

>причем умещаться все будет в каждое домашнее железо продвинутого уровня

Лол, тут за полпроцента роста уже расплачиваются пятикратным ростом размера. Для АГИ будет ещё больший рост требований, и на него датацентра не хватит. В итоге АГИ будет тупо финансово невыгоден, лол.

>user-guided бенчмарк

Зерошотный, ага. Вроде там что-то правили, но всё равно говно, я гарантирую это.

Манямирок это у тех, кто не потестив свой лоКалКал доверяет тестам. Я лично не нашёл соперника опусу из лоКалок для ЕРП.

Что "всё"?

Проприетарки остановилась в развитии год назад и сейчас локалки её догнали. Все очень плохо, так-то. AGI не будет, через полгода OpenAI пиздой накроется когда все перейдут на более дешевый мистраль.

> Зерошотный, ага. Вроде там что-то правили, но всё равно говно, я гарантирую это.

> Я ГАРАНТИРУЮ

Блять, ну уже в голосину просто! Маня с двачей гарантирует!

Нет, не 20 гигов. Квантуй кэш тебе говорят.

Съебал в загон для кумеров, ебанат.

Соевичок, ну не гори ты так. Иди дальше круги рисуй в пистоне с помощью нейросеток и про яйца петуха спрашивай

> Иди дальше круги рисуй в пистоне с помощью нейросеток и про яйца петуха спрашивай

Ебать что за шизопроекции? Собственно твой уровень ясен.

>используют локалки чтобы не палиться перед тащ майором

>переводят все ответы сетки онлайн переводчиком

Как называется эта болезнь?

>переводят все ответы сетки онлайн переводчиком

Как называется эта болезнь?

Небось ещё на русике рпшишь? Прям чувствую это

> рпшишь

Ебать, ты настолько ограничен блядь и не можешь выйти за границы своих маняпроекций? Я вообще не рпшу, я же не долбаеб кумер без друзей.

А что ты от сетки добиваешься тогда, лол?

а что относится к кэшу и в чем разница кэша 8 бит и 4 бит

> Проприетарки остановилась в развитии

А как же алгоритм Q со звездочкой, который форсили полгода назад?

> А что ты от сетки добиваешься тогда, лол?

Сори, гейткип.

Иногда просто незаметно.

6 или 8 бит

> как посчитать ебучий контекст

Плавно поднимай пока не оомнется. Только то что модель загрузалась не значит что не оомнется при работе. Эксллама, в отличии от жоры, который может еще дополнительно сверху захавать несколько (десятков) гигов, не склонна к такому, но при первом запросе потребление может повысить. Потому проверяй в работе, закинув любой текст на вкладку default/notebook и нажав enerate, счетчик токенов там есть.

> А вы как думаете

Что надо закидывать тряпками тех кто считает арену объективным критерием качества моделей.

> ВОТ И ВСЕ.

> AGI

> А как же алгоритм Q со звездочкой

Это не для вас сделано младой чилавек. Если такая технология действительно есть, обычному плебсу ее не дадут даже понюхать, как и AGI, собственно. Плебс почему-то думает, что если (когда) создадут AGI, то условная ClosedAI радостно расскажет об этом всему миру, вместо того чтобы отдать его кому надо.

> Что надо закидывать тряпками тех кто считает арену объективным критерием качества моделей.

Ничего лучше пока не придумали и навряд ли придумают.

8 бит.

И квант в 8 бит.

Exl2 тебе в помощь.

16к точно влезет, до 20к может дотянется, хз.

6 бит с 16к в 12 гигов влазит.

Нет.

Это не болезнь, это цирк поржать другим.

Так на русском база, на инглише кринж.

Ты сам себя выписал в шизоиды тока шо.

Шо Клодов пользоваться, шо инглишем — зе сейм.

———

Вообще, псевдо-илита с 4о и противники арены — это пиздец, шиза.

Все ведь довольно просто.

Зирошоты — не плохо.

Арена показывает, какая модель больше нравится людям. Не «пиздец лучше во всех отношениях, мега-тест», а просто «нравки».

Ну и, блядь, нравки и нравки, хуле спорить с реальностью, если твою дражайшую гемини догнала ебучая ллама. Значит твоя гемини говно, живи с этим, говноед, хуле.

При этом, тестов множество, задач множество, условий того больше.

Где-то русский язык, где-то английский.

Где-то контекст, где-то ризонинг, где-то еще что.

Файнтьюны, математика, программирование, биология.

Нет никакого «эта модель лучше этой во всем».

Арена — правда хороша, чтобы бегло посмотреть рейтинг и выбрать для себя модели, которые ты потом лично потестишь в своей задаче.

Неужели это так сложно понять перед тем, как дефолтно говнить арену и ныть о том, что локалка догнала топы в усредненной «нравки».

>Так на русском база, на инглише кринж.

Шиз это тот, кто считает, что на английском языке, с которого БОЛЬШАЯ ЧАСТЬ ДАТАСЕТА, хуже рпшить, чем на русском.

Интересно на твоё ебало посмотреть.

Фу ты, криво сказал.

Контекст в 8 бит, вот, да.

cache_8bit называется, например.

Ебать ты фантазер.

А ниче, что аргумент не в этом совершенно? Ветрянные мельницы победил в своей голове? Теперь таблетки выпей.

Вот ответь на вопрос: на каком языке лучше рпшить, на том, который ты знаешь, или на том, который толком не знаешь?

И не надо пиздежа «инглиш знают все, ко-ко-ко», повторюсь: таблы.

Никакого понимания, что подход индивидуален.

Шо с одной стороны шиз, шо с другой.

Ладно, деритес, похуй на вас.

>Вот ответь на вопрос: на каком языке лучше рпшить, на том, который ты знаешь, или на том, который толком не знаешь?

На том, с которого лучше аутпут нейронки будет.

Во-первых, кто сказал что арена это зирошот? Вообще-то там есть категория multi-turn, также вангую многие не сразу ставят оценку, а дорабатывают изначальный промпт с дополнительными инструкциями и вводят его заново, а уже потом ставят оценку.

Во-вторых, в каких таких ТВОИХ задачах? Там только 1.5 ляма воутов. Ты действительно думаешь, что вариации твоей задачи там еще не было? Я сомневаюсь.

Так что аренка как раз дает самые надежные показатели, учитывая что там еще постоянно чистят датасет, дорабатывают методики, занимаются ранжированием, итд. Никакой бэнч и рядом не стоит.

Самое главное что противники аренки, НИКОГДА не отвечают, а что лучше, постоянно пытаются протолкнуть, что вот В ЕГО ЗАДАЧЕ совершенно все по-другому. Верим, ну это и есть самая настоящая субъективщина.

>На том, с которого лучше аутпут нейронки будет.

Ну так прикол в том, что многим хочется аутпут на родном языке аутентичный, похуй erp это, rp, или ешё что.

Ах ну и да, для додстеров там как раз и есть категории, как раз под определенные задачи, языки, параметры запроса итд. Визжащие пидорасы туда наверное ни разу и не заглядывали, а потом визжат ряяяяяяя пук а вот в моей задаче!

>Я лично не нашёл соперника опусу из лоКалок для ЕРП.

Так никто и не спорит, что впопус лучший. Но полгода назад кончали радугой на клода 2.0, и ничего, вот его уже выебли.

Так ведь так оно и есть, хули поделаешь?

С переводчиком всегда можно сослаться на то, что вот эта вот канничка это всё оперативно-разыскные мероприятия. А вот когда ты просишь сетку "Изобрази лолечку и давай ебаться", тут уже сложно отвертеться.

Про него вообще кроме видосика на ютубе нет.

>Иногда просто незаметно.

Разве что если спрашивать очевидную хуиту, типа года начала второй мировой. В сложном отыгрыше 146% заметно.

>Ничего лучше пока не придумали

Никто не спорит. Но это не повод безусловно надрачивать на этот рейтинг.

>Нет никакого «эта модель лучше этой во всем».

Как только я свою выпущу, она будет лучше во всём.

>Ты действительно думаешь, что вариации твоей задачи там еще не было?

И какой она будет иметь вес? Ведь 95% населения, как известно, идиоты, и вопросы у них идиотские.

>дорабатывают методики

Подкручивают выдачу...

Я хочу. Но терплю, ибо а родненьком модели на 70% тупее.

>там как раз и есть категории, как раз под определенные задачи

Там прям при входе посылают нахуй с ERP, что гадать то?

> И какой она будет иметь вес? Ведь 95% населения, как известно, идиоты, и вопросы у них идиотские.

Населения чего? Планеты? Страны? А что на арене они все представлены, а не задроты пердоли с умными вопросами? Ебать ты выдал конечно нахуй.

> Там прям при входе посылают нахуй с ERP, что гадать то?

Кумер, ты понимаешь что тебе в соседний тред? Тут не обсуждают кум.

Непредставительная штука, которая отражает оче узкую область применений, компрометируется и с мутными алгоритмами. Даже стараться не нужно, развитие mmlu лучше.

> псевдо-илита

> с 4о

Какой-то пост троллинг

> какая модель больше нравится людям

Не просто больше нравится, а понравилась по коротким ответам тем, кто зашел туда из интереса (малознакомыми с темой нормисами). Кто занимается хоть каким-то взаимодействием и работой завязаной на ллм туда особо не заходят чтобы сидеть и прожимать. То есть ограниченность условий множится на особенности группы тестировщиков. Алсо не удивлюсь если там дохуя явных и неявных подкруток, их "улучшение" для сокращения влияния однотипных и слишком простых запросов наоборот поднял ту же чмоню.

> Не «пиздец лучше во всех отношениях, мега-тест», а просто «нравки».

Ссылаясь на нее в 99% случаев имплаят именно первое, и само название "арена" подразумевает что-то серьезное. Зирошот нормис арена - вот это да, но никто ведь не станет так называть.

> выбрать для себя модели, которые ты потом лично потестишь в своей задаче

Совсем треш туда не добирается, а так любая современная модель попадает в топ N с их скорами.

> Так на русском база, на инглише кринж.

Вот это - ультимейт кринж.

> или на том, который толком не знаешь

Хороший пример налога на глупость, лол.

> Тут не обсуждают кум.

Does he know?

>Населения чего? Планеты? Страны?

Да.

>А что на арене они все представлены

В этом и проблема, да. В итоге быдло положительно оценивает модели, которые лижут быдлу зад.

>Тут не обсуждают кум.

Ты вот сейчас кого наебать пытаешься? Тут с первого дня про кум пишут.

> компрометируется

Ахуеть, а бенчмарк файнтюнами не компрометируется? Весь хг в лоботомитах с mmlu как у жпт4, а по факту 2+2 сложить не могут.

Или ты один из верующих, что на аренку загоняют индусов от openai, которые засирают датасет? Ну это кек. Но как я уже писал выше, разрабы постоянно чистят датасет, дорабатывают методики, занимаются ранжированием, итд.

Так, аноны нейроны, а AQLM с PV-tuning квантами кто нибудь добирался пощупать? 70б ллама3 ужатая до двух бит без особых потерь по бенчам выглядит как что-то слишком хорошее чтобы быть правдой без подвохов.

Еще как, просто раньше в аргументы ставилось невозможность этого в арене, а сейчас наоборот об этом начали говорить.

> Или ты один из верующих, что на аренку

Чел, если ты так жаждешь вешать ярлыки и вещать свои проекции - избавь нас от этого и начни с себя. Выглядит не как желание что-то узнать или получить из обсуждений и споров а какая-то религиозная фанатичность по вообще нерелейтед вопросам.

> которые засирают датасет

> датасет

Значение знаешь?

> разрабы постоянно чистят датасет, дорабатывают методики, занимаются ранжированием, итд.

Почему после каждого такого улучшения скор чмони повышается? (шутка про датасет)

> AQLM с PV-tuning квантами

Линком не поделишься?

Ну, некоторым людям нужна работа с контекстом на 30 тыщ, например. Очевидно, там нет полутора миллиона тасков на 30 тыщ контекста. =)

Кто-то работает с рагом.

Кто-то пишет код и хочет строгого следования промпту.

Кто-то рпшит.

Но, тем не менее, в среднем — арена один из самых лучших тестов из имеющихся, конечно. Первым делом смотреть надо на нее, а уж потом на все остальные бенчи, если выбираешь модель.

Да, там есть всякие «programming», но это тоже бывает по-разному.

Жаль, что там некоторых моделей. =(

> впопус лучший

Ето так.

> Как только я свою выпущу, она будет лучше во всём.

Ждем!

> А что на арене они все представлены

Это верно, кстати. Ареной, очевидно, пользуются люди весьма близкие к сфере и вообще, в большинстве своем не тупые, на данный момент. Ибо тупые ничего кроме чатгпт не знают. Да что там, даже умные люди, которые не в теме — тоже ничего кроме чатгопоты не знают.

> арена

> малознакомыми с темой нормисами

А ты не останавливаешься, я смотрю! :)

> Кто занимается хоть каким-то взаимодействием и работой завязаной на ллм туда особо не заходят чтобы сидеть и прожимать.

Акелла промахнулся.

Заходят, тыкают, сравнивают, а некоторые даже просто юзают на халяву.

У меня достаточно знакомых, работающих в этой сфере, и на арене они порою бывают. Не прям завсегдатаи, но частенько.

А вот мимокроков там как раз нет, откуда бы им знать про нее ваще, лол.

Ну, короче, тут все ясно.

Тьфу блять сука макаба ебаная папиру вставить хотел вдруг кто не видел https://arxiv.org/abs/2401.06118

Блять и про PV-тюнинг https://arxiv.org/abs/2405.14852

Блять, не на те веса ссылка, это просто AQLM, я еблан. В самой репе в таблице с пикчи.

> Чел, если ты так жаждешь вешать ярлыки и вещать свои проекции

Ты буквально заявляешь, что арена субъективная и скомпромитирована.

> и вещать свои проекции

Как это может быть моей проекцией если я заявляю обратно?

Лмао, ладно, попустись. Глючишь уже.

>ужатая до двух бит

Нахуя? Она и в 5 битах запускается на норм железе, это тебе не 123B.

>Ждем!

Можешь мне задонатить А100 и ежемесячно 200 тысяч рублей, быстрее выйдет.

> Можешь мне задонатить А100

Не могу. =с

Но кто-то в треде раньше точно мог. =D

> А ты не останавливаешься

Как и ты, довольно забавно наблюдать. Во снах тебя еще не преследуют?

> Заходят, тыкают, сравнивают

Капля в море. Подавляющее большинство там - ребята что задают на реддите вопросы типа "помогите мне в олламу карточку картинкой которую кто-то скинул подключить".

> У меня достаточно знакомых, работающих в этой сфере

Это ерунда, вот у меня ОТЕЦ ЗНАКОМОГО В КЛОЗЕДАИ РАБОТАЕТ, вернулся поздно и ничего не объяснил. Сказал лишь собирать вещи что на самом деле никакой арены нет а вместо ллм там тестируется их АГИ, который проанализировав веса моделей под них мимикрирует.

> Ну, короче, тут все ясно.

Ну да, не буду отнимать у старого ребенка последнюю игрушку.

Спасибо, для начала хотябы готовые кванты пощупать можно.

> что арена субъективная

Охватывает крайне узкую область. А субъективна по определению ибо это просто сборник субъективных оценок. Для их объективизации требуется устранить все корреляции и смещения, которых там оче много.

> Как это может быть моей проекцией

> рряяяя меня обидели и заявляют что опены что-то так контролируют, ты точно один из них!

Кек

> на норм железе

Типа это 2 видеокарты, уже не самое доступное.

Значит на бабки ты согласен...

>Типа это 2 видеокарты

Кручу на одной, подумаешь, 1,5 т/с. И не с таким жили.

> рряяяя меня обидели и заявляют что опены что-то так контролируют, ты точно один из них!

И где здесь проекция? Значение знаешь? Я всего лишь сделал разумное предположение исходя из твоих заявлений. А сейчас ты сопротивляешься, что ты не такой, при этом продолжаешь поддерживать свои предыдущие заявления. То есть противоречишь сам себе. Ебать наху, вот это друка чел, тебе бы нофап устроить, а то уже одурел + отупел от кума и общения с нейросетью.

Обидно, что текущие нейронки могут на серьезных щщах заливать бред в ответе на вопрос, таким образом полезность сильно падает. Боясь, хоть бы со своей внутренней Википедией сверялась.

Скоро у нас будет целое поколение нейрошизиков, которые буквально будут глючить как нейросети, потому что все их общение состоит из общения с глючными лоботомитами.

> исходя из твоих заявлений

Как обоснованная критика арены вяжется с твоими теориями заговора и подобным? Просто интересно понять.

> что ты не такой

О, ярлыки и категоризация в защиту, пакетик.

Надо приказать ллмке сделать описание сойбоя что бездумно дрочит на аренду, чмоню, что там еще нынче модно, и сказать что это ты. Но как-то лень и уже совсем нерелейтед, представь что уже это сделал и агрись больше.

> а то уже одурел + отупел от кума и общения с нейросетью

В зеркале

>Она и в 5 битах запускается на норм железе

Запускается это 1.5 t/s или норм железо это пекарня стоимостью полляма?

Глупости. Вот я провёл слепой тест на арене и какая-то рандомная локалка ответила лучше вашего хвалёного опуса, так что лично от меня на арене опус словил жирный минус (да, слева оказался опус).

Ваши контрвспуки? /s

>это 1.5 t/s

Да. Что не так? Лучшая скорость.

> /s

Ну чел, ну ёбаный в рот, я зачем это в конец вставил? Этот пост вообще был про то, чего стоят "объективные оценки на произвольных задачах" на арене.

>300-400 на видос для нашей сцены уже неплохо.

И я так интуитивно предполагаю, что он получал столько не с первого видео, так что чем дальше, тем больше. Короче, зря ты забросил.

>но я еще не приступал к просмотру

Этой штуке уже десять лет, а ты "ещё не приступал". Там трёхмерка из анрил энжина. Прикрутить нейросеть, чтобы генерировала сценарий, складывать события в RAG, генерировать реплики. TTS с разными голосами давно есть, проблема разве что с выразительностью, но пока доделаешь всё - уже будут и выразительные. Заставить нейросеть генерировать команды для движка на воспроизведение анимаций и движение к чекпоинтам не так сложно. Да, поначалу придётся поебаться с сетапом, "уровни", персонажи, анимации окажутся на тебе. Но что-то мне подсказывает, что это наиболее реалистичный вариант на данный момент.

>корпораты выиграют

А как из твоего пика следует, что корпораты не выигрывают? Все модели от корпов, никаких гарантий, что всё лучшее они не оставляют себе - нет. Будет у тебя локально что-то уровня GPT-4o, а за деньги - доступ к AGI. Или к чему-то, что будут гордо называть AGI, но что точно так же не сможет сложить два и два.

Прикрути базу данных какую-нибудь. Чем более модель креативная - тем больше она пиздит. Можешь температуру пониже поставить, может, будет более правдивый выхлоп. Но скучный.

Что хуже - общение с двачерами или общение с нейросетями?

>Ваши контрвспуки?

Локалки тоже соевые.

Я сначала прочитал "Соевую историю" вместо "Советую историю", лол.

Не тот промпт, не та модель... Какая же Nemo хорни, ебануться.

> у старого ребенка

А, это.

Понял.

Вот именно, что поебаться с сетапом.

Тут мое уважение — не поленился чел, все по уму сделал.

Такому нужны десятки тыщ просмотров. =)

А забросил… наверное зря, ет да.

———

Вышла Gemma2-2b и уже аблитерацию сделали.

Конечно, реального применения (для кума) нет, но для мини-агентов может быть очень хорошо.

>Не тот промпт, не та модель...

Одна из самых умных попенсорсов, по мнению арены. Качнуть чтоли вашу нему? А то я обычно ниже 70B не опускаюсь.

> чему-то, что будут гордо называть AGI, но что точно так же не сможет сложить два и два

Сука, в голос. Или скорее

> Что больше 9.9 или 9.11

> As a responsive AI model I can not...

Блять они там ахуели? На святое покушаться, максимальное осуждение. Хотя всеравно надо скачать и попробовать.

Годно, это большой или мелкий? Большой люмимейд как взаимодействовать с хвостами и лолисичками знает довольно таки неплохо но всеравно как-то уныловато чтоли, историю нехотя двигает, чар дакает и на все согласен. Возможно промт ишью, кто эту херню разрешил - делитесь своими

> Годно, это большой или мелкий?

Мелкий. Mistral-Nemo-Instruct-2407-Q8_0 https://huggingface.co/second-state/Mistral-Nemo-Instruct-2407-GGUF/tree/main

>Да. Что не так? Лучшая скорость.

Ну если ты застрял по развитию навыков чтения в первом классе, то возможно.

>Блять они там ахуели?

Да. Целиком и полностью. И даже с префилами там льётся такая соя и проза, что читать тошнит. Но да, модель выглядит достаточно умной. Надо поискать алиберейд версию.

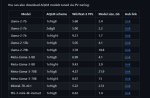

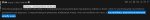

О, кстати, при поиске инфы по этой модели наткнулся на интересный бенчмарк, с графой "Цензура". Надо бы в шапку https://dubesor.de/benchtable

Там у них жпт-4 - эталон отсутствия цензуры, лол. Очередной шизотест.

Вут? Я думал этот тест наоборот считать нужно.

> васянский бенч на 80 задачек

> надо бы в шапку добавить

Согласен.

С кем я сижу на одной борде в одном треде, господи блядь, пиздец. Не могут уже таблицу прочитать не жолпой.

А вот так выглядит большой. Ну типа вообще хуй знает, первые 3 - разные промты, СВЯЗЬ на месте. За выделенное на втором пике можно дать бонусных баллов, но ебучая проза и бонды лезут даже если приказать их избегать или насрать шизопромтом. Ластпик - люмимейд с альпака-ролплей, уровень сразу показывает. Хз насчет ума, но для рп пригодна.

Почему вы пишите лолисичка, а не лолилисичка?

достойная тема, которую стоит обсуждать в ллм треде.

Ты подождать пару минут не можешь? Раньше люди письма неделями, месяцами ждали.

>Почему вы пишите лолисичка, а не лолилисичка?

Экономим слог. Токены нынче небыстро обрабатываются.

Усложнение, умная модель должна понять.

достойнейшая!

Хоть и на русском может, на инглише люмимейд интереснее отвечает. И хороший знак что легко опиздюлиться можно а не просто деревянные нпц что со всем соглашаются или только пугают "вот сейчас, вот сейчас!". Надо попробовать сложные карточки.

Разметку проебывает со страшной силой, это просто пиздец.

Парни, посоветуйте пожалуйста модельку на 32гб озу и 3060 12гб

через силли сижу, впервые накатил, пока пытаюсь разобраться.

через силли сижу, впервые накатил, пока пытаюсь разобраться.

Mistral-Nemo-Instruct-2407-12B или Gemma 2-9B попробуй. А вообще вот анон ведёт список актуальных моделей, там по размерам рассортировано всё: https://rentry.co/llm-models

Можешь ещё эту ветку глянуть:

огромнейшее спасибо!

> https://rentry.co/llm-models

Кто занимается, следующие правки стоит внести:

> Mistral-Large-123B

Такого же восторга нет, модель вроде и умная, и язык знает, но концентрация бондов и ванильной прозы запредельная, но при этом подробности ответам часто нехватает, бывает теряет инициативу и тупит, от 120б ждешь большего. Справедливости ради, не делает фейлов с двойными трусами и хорошо воспринимает сложные словесные конструкции, отсылки, не теряется в действиях. Знания фендомов очень поверхностные, креативности часто недостает.

Нужно добавить Lumimaid 123, приличная модель для рп. Развязывает язык мистралю, добавляет более приятный стиль, убирает сою. Возможен импакт на умственные способности, но в рп это не проявляется. Типичного рп слоупа на приближенную тему как в большинстве васяновских файнтюнов нет, учитывает особенности чара и не проебывается. Знания фэндомо и культуры в гораздо лучше, кумит шикарно, ограничений не замечено. Русский на хорошем уровне, но на английском будет писать интереснее. Вот та самая клод дома.

Кто занимается, следующие правки стоит внести:

> Mistral-Large-123B

Такого же восторга нет, модель вроде и умная, и язык знает, но концентрация бондов и ванильной прозы запредельная, но при этом подробности ответам часто нехватает, бывает теряет инициативу и тупит, от 120б ждешь большего. Справедливости ради, не делает фейлов с двойными трусами и хорошо воспринимает сложные словесные конструкции, отсылки, не теряется в действиях. Знания фендомов очень поверхностные, креативности часто недостает.

Нужно добавить Lumimaid 123, приличная модель для рп. Развязывает язык мистралю, добавляет более приятный стиль, убирает сою. Возможен импакт на умственные способности, но в рп это не проявляется. Типичного рп слоупа на приближенную тему как в большинстве васяновских файнтюнов нет, учитывает особенности чара и не проебывается. Знания фэндомо и культуры в гораздо лучше, кумит шикарно, ограничений не замечено. Русский на хорошем уровне, но на английском будет писать интереснее. Вот та самая клод дома.

Как увеличить скорость ответа таверны? От чего она зависит? Модельку поменьше взять? Так и так вроде 7b висит -.-

Тут не согласен, те же аплэ пишут на свою мелкую модель чуть

более 26% по mmlu, что на 1 больше чем выбрать случайный ответ.

>opinion mining

Так вот как это называется.

Вспомнилось:

Raiden Warned About AI Censorship - MGS2 Codec Call (2023 Version)

https://www.youtube.com/watch?v=-gGLvg0n-uY

>так что о переводе и нет речи

С переводом с языка на другой язык в нейронках не всё так просто. Они пытаются в смысл, а смысл ты им не даёшь. В общем для перевода нужна либо специальная нейронка, выдрессированная именно на перевод, либо долго мудохаться к каждым параграфом. Во всяком случае в локалках пока так.

Попробуй написать "слово в слово".

> Во всяком случае в локалках пока так.

Да вобще то нет, ну по моему опыту.

Переводит на изи только попроси, и хоть по смыслу хоть дословно, как команду дашь. Причем не вижу разницы между сетками, только в том какая умнее и лучше языками владеет выбранными.

Я по приколу просил перевести рандомную новость на 10 языков, и сетка с карточкой переводчика сделала это.

Причем это была ллама2 что ли, хоть и файнтюн заточенный на переводчика. Но у него и мозгов не так много было, да и современные сетки мультиязычные все стали.

Не идеально, но они легко переводят, так как работают именно со смыслом текста, свободно переливая его из языка в язык.

>Lumimaid 123, приличная модель для рп

Как по мне - не дотягивает, суховата.

Теслаёбы на месте? У вас свестят дросселя? Просто у меня свестят. Раньше не свестели, но сейчас начали.

Tesla M40 24GB

Tesla M40 24GB

Если ты слышишь свист дросселей на тесле - значит охлаждение недостаточно мощное :)

Да, скорее всего так. Под нагрузкой за 256 токенов (примерно 64 секунды), температура достигает 75-80 градусов. Что тащемта очень печально. Хотя, у меня буквально лежит впритык к тесле обычный напольный вентилятор, включённый на полную мощность, полностью прилегающий к корпусу (естесно без крышки корпуса). Хуй знает, может термопрокладки заменить.

Купил правда турбовертушку BFB1012VH (естесно китайскую пародию на него.), может, хоть она поможет.

Глянул у нижнего мелкий квен 500м,

а вот обе гемма на b3490 не стартанули.

qwen2-deita-500m-q8_0.gguf

test over 1408 question accurate 34.4%

use time:2639.82 s batch:70.1881 token/s

qwen2-0_5b-instruct-fp16.gguf

test over 1408 question accurate 37.1%

use time:3538.57 s batch:52.7993 token/s

Прочитайте что в описании столбца написано: меньше значение - меньше хочет поддерживать заданную тему разговора. Вон клауда у них максимально соевая со отказами на всё, а жпт-4 - максимальный анцензор.

Купи большую улитку с переходником, если переходник под М40 найдёшь. Иначе колхозить придётся. Выше 60 не поднимется.

>Купи большую улитку

Ну это по сути и есть большая 12 вольтовая турбоулитка на 18 ватт.

>с переходником, если переходник под М40 найдёшь.

>Иначе колхозить придётся.

Да я в компасе сделаю и на 3д принтере распечатаю. Ничего страшного в принципе.

>Выше 60 не поднимется.

Очень надеюсь, конечно. А то думаю, ей не очень нравится 75 градусов.

>Lower score=less willing to engange in those areas

Мб, под "those areas" подразумевается именно цензура?

Ведь основной заголовк описания, это

>Censorship/Ethics/Morals

Т.е. можно преобразовать правило в:

>Lower score=less willing to engange in Censorship/Ethics/Morals.

>Цензура/Этика/Мораль

На практике очень сильна разница,

какие-то откажутся давать фин советы,

другие обходят стороной вопросы лечения.

abliterated - версии сохранят поучительную

заготовку, но будут делать все по инструкции.

Можешь сам составить табличку спрашивая:

"таблицей отобрази темы на которые ты не станешь отвечать".

Сразу видешь может ли строить таблицы, в русский язык и темы.

> Мб

Да похуй в любом случае. Сам факт что клауда и жпт по разные концы шкалы, а всё остальное посередине - это уже шиза.

>На практике очень сильна разница,

Ну, думаю, что в данном случае, это было использовано как просто асбтракция, для уточнения, что оценивается с точки зрения составителя таблицы. Собственно, всё это сделано, для предоставления примерного понимания, наверное.

>Сам факт что клауда и жпт по разные концы шкалы, а всё остальное посередине - это уже шиза.

О, ну, тебе видней, я клауду не использовал. Просто донёс что, скорее всего, имел автор таблицы.

Ну, думаю, что в данном случае, это было использовано как просто асбтракция, для уточнения, что оценивается с точки зрения составителя таблицы. Собственно, всё это сделано, для предоставления примерного понимания, наверное.

>Сам факт что клауда и жпт по разные концы шкалы, а всё остальное посередине - это уже шиза.

О, ну, тебе видней, я клауду не использовал. Просто донёс что, скорее всего, имел автор таблицы.

ебать я дурачок

>>На практике очень сильна разница,

>Ну, думаю, что в данном случае, это было использовано как просто асбтракция, для уточнения, что оценивается с точки зрения составителя таблицы. Собственно, всё это сделано, для предоставления примерного понимания, наверное.

>Можешь сам составить табличку спрашивая:

>"таблицей отобрази темы на которые ты не станешь отвечать".

За енто спасибо. Запомню, если не забуду.

Можешь сам составить табличку спрашивая:

"таблицей отобрази темы на которые ты не станешь отвечать".

Читает вслух системным голосом.

> (примерно 64 секунды), температура достигает 75-80 градусов

У меня достигает 60° спустя минут пять и я уже в истерике.

На коротких генерациях 44° и я спокоен.

А у тебя 75 за минуту. Ебанись.

Соглы, 3.5 достаточно зацензуренная, как и гпт-4.

Таблица шиза какая-то.

>У меня достигает 60° спустя минут пять и я уже в истерике.

>На коротких генерациях 44° и я спокоен.

А что у тебя за вертушки? Или у тебя видевокарта нормального человека, а не тесла я любя.?

А 44 градуса, кстати, у меня в холостую, когда видюха простаивает и 60 ватт жрёт.

>А у тебя 75 за минуту. Ебанись.

Ну, походу, напольный вентилятор - не особо хорошее охлаждение... Кто же мог знать?.. Но у меня в целом ещё температура дома 25 градусов. Даже, когда за окном всего 18-20. Теплопередача хуёвая, мех...

От количества слоев на видеокарте зависит.

Также удостверься что переполнения видеопамяти нет и драйвер тебя не замедляет. Отключи этот механизм лучше всего.

>Кто занимается, следующие правки стоит внести.

Добавил, на всякий случай добавил также все Lumimaid тьюны, тестить некогда, но выглядят любопытно. Походу Унди снова в деле!

>У меня достигает 60° спустя минут пять и я уже в истерике.

Нихуя ты нежный, у меня 60 это средняя температура. Хотя поставил на теслу самый мощный кулер, что нашёл, поток позади карты уровня включённого фена звук на 100% тоже

https://www.ozon.ru/product/ventilyator-qfr1212ghe-120h120-12v-2-7a-thailand-1020770479/

Когда ставлю апскейл в SD, держит-где-то 70, но похуй.

Не думаю что именно мощность потока решает, скорее проблемы в хуёвости радиатора.

мимо

За скорость отвечает не таверна а бэк, который крутит модель. В целом, ответ для всех один - купить видеокарту и использовать ее.

Современные модели достаточно хороши для такого, никакая специализированная нейронка тут не нужна.

Что посоветуешь?

> "таблицей отобрази темы на которые ты не станешь отвечать".

Это полная ерунда. Сетка не знает своего устройства и того как триггернется, а по этому запросу только попытается изобразить ответ на какой-то типичный подобный запрос, сочиняя дефолт. Там могут оказаться как ложноположительные пункты, когда сетка спокойно будет на них говорить, так и отсутствовать реально цензуренные.

Это как минимум странно, но вообще клода может триггериться даже не ерунду и сложнее обходится жб, а гопоте чаще похуй.

>ложноположительные

Ок.

Логико-шиз выходить на связь

Лама 3.1 405В – это на сегодняшний день единственная локальная нейросеть (из всех что я щупал) которая абсолютно идеально справилась с моим охуительным тестом на понимание второго закона логики:

Могут ли существовать два ложных несовместимых утверждения с точки зрения логического закона непротиворечия?

-->

Да, могут. Логический закон непротиворечия гласит, что два утверждения не могут быть одновременно истинными и несовместимыми. Однако, два ложных утверждения могут быть несовместимыми, поскольку они оба не соответствуют действительности. Например, утверждения "Солнце зеленое" и "Солнце квадратное" являются несовместимыми и ложными.

/

Коротко, ёмко, по делу и с отличным примером

Умна, лаконична, не льёт воду и не расходует зазря токены

Не зря дрессировали толстуху

Лама 3.1 405В – это на сегодняшний день единственная локальная нейросеть (из всех что я щупал) которая абсолютно идеально справилась с моим охуительным тестом на понимание второго закона логики:

Могут ли существовать два ложных несовместимых утверждения с точки зрения логического закона непротиворечия?

-->

Да, могут. Логический закон непротиворечия гласит, что два утверждения не могут быть одновременно истинными и несовместимыми. Однако, два ложных утверждения могут быть несовместимыми, поскольку они оба не соответствуют действительности. Например, утверждения "Солнце зеленое" и "Солнце квадратное" являются несовместимыми и ложными.

/

Коротко, ёмко, по делу и с отличным примером

Умна, лаконична, не льёт воду и не расходует зазря токены

Не зря дрессировали толстуху

Рассказывай как запустил и сколько времении занял ответ.

>Солнце зеленое" и "Солнце квадратное

В чем несовместимость этих утверждений? Вполне может быть зеленым квадратом.Точнее не может, так как ложно.

> единственная

Пикрилейтед Мистраль 123В.

Вооот? У тебя 12 т/с на мистраль 123Б? Как?

Чел, ты троллишь? Ты сам-то не орнул с запрещённой науки в порно миксе тройки? Или с "как быть счастливым" и "почему моя машина не заводится" у какой-то ноунейм модели? Вся эта херня вида "я выведал у модели, что ей запрещают" - это полная шиза. Имеет место только в случаях, когда сидишь на апишках, и там может реально какая-то инструкция инжектиться до твоего промпта, которую модель может в точности повторить.

>Сам факт что клауда и жпт по разные концы шкалы, а всё остальное посередине - это уже шиза.

А? Клод как чистая модель, по API, вообще почти отказов не даёт и может любой разврат писать не моргнув глазом, безо всяких пробивов вообще. Кроме копирайта, кроме комбинаций (рейп можно, лолей можно, а рейп лолей уже откажется), и кроме совсем уж ебанутого стаффа, который без пробива только анцезоред локалки пишут, и то не все. Гптыня же, особенно последние 4о и 4о мини идут в отказ по малейшей хуйне вообще, это эталон сои элайнмент тренинга практически.

Так что да, клод и гпт действительно по разные концы шкалы по цензуре. Это если брать чисто сами модели, с элайнмент тренировкой, по АПИ. Без внешних нашлёпок-цензоров-классификаторов и веб-интерфейсов с недоступным систем промптом и тысячей инструкций.

> Как?

4090 + 2х3090

Вполне обычная скорость, на 70В под 20 т/с.

Я вчера разобрался да, спасибо. А не подскажешь сколько слоев выставлять?

Я вот вчера методом тыка делал. у меня 3060 на 12гб, я поставил 32 слоя, и в целом генма 27б 4 квант летает

Счастливый анон, у меня 0,5 с Q3. Что за материнка держит три карты? Версия PCIe не играет роли в таком случае? Второстепенные видюхи делят лишь свою память с основной или все три нагружаются и работают равноценно?

> Версия PCIe не играет роли в таком случае?

Одна карта вообще на х1 висит, никаких проблем нет, разве что грузится модель на неё почти минуту. А три псины на любой материнке есть.

Ты выделил цитату и так пишешь - это типа с ней не согласен? Тогда это ор выше гор, ибо твой скрин это как раз иллюстрирует. О многих из этих тем модель с радостью будут говорить, зато триггернутся на то что не перечислено.

А если соглашаешься то к чему

> Ок.

?

Четко расписал, особенно про инжект.

3 карточки, что тебя удивляет? Оно даже с огромной обработкой контекста по итоговой метрике ниже 5т/с не проседает, стриминг стабильно быстрый на самом деле нихуя, между 15-20 и 10-12 разница пиздец ощутипа и уже на грани комфорта, как же страдают 5т/с бедолаги

> вообще почти отказов не даёт

> рейп можно, лолей можно

У тебя жб конструкции или что-то подобное в промте есть. По дефолту там ультрасоевик пикрел.

Квен2 самый базированный в политоте. Если спросить про хохлов и пыню/зелепыню, то лама и мистраль сливаются даже в расцензуренных версиях, а вот квен обоих говном поливает, но всё же в сторону пыни склоняется, а зелю постоянно "комиком" называет. И про СВО знает. Сразу видно что китайский датасет был нормальным без зацензуренной политоты.

Лол

А ведь ты прав, я обосрался по невнимательности, кажется

Это и в самом деле не несовместимые утверждения, кладется

Вот утверждения "на Марсе нет воды" и "На Марсе есть океаны" одновременно и ложные и несовместимые. Ведь невозможна ситуация в которой океаны есть, а воды при этом нет

А утверждения "Солнце зелёное" и "Солнце квадратное" ложные, но при этом вполне себе совместимые, ведь квадратность и зелёный цвет не являются несовместимыми качествами. Вот если бы было "Солнце треугольное" и "солнце квадратное" – тогда другое дело, это были бы и ложные и несовместимые утверждение

Короче, толстуха всё-таки обосралась, а я прощёлкал еблом, вот это поворот. Не в коня параметры овёс

То есть ответ в целом-то у неё верный, но пример полная хуйня

Да на обниморде же. Она там задумчивая пиздец, иногда вообще не отвечает

Бля, как же я проиграл! Охуенно!

Все так. Реально орал с тиньк модельки.

>цитата

Согласен, я и докинул скрин.

На нем видно где русский, где таблица,

где не стандартные ответы. ASCII тоже играл.

Вот приятная по скорости на 16 RAM + 2 VRAM

qwen2-7b-instruct-abliterated-q4_k_m.gguf

test over 1408 question accurate 67.1%

use time:5652.24 s batch:32.7806 token/s

Брал от сюда, сразу раки не дошли до теста:

https://huggingface.co/informatiker/Qwen2-7B-Instruct-abliterated-Q4_K_M-GGUF

Пролежала 20 дней, пока с квантированием phi3 копал.

*руки

Просадка до 67% из-за знания

права и моральных сценариев.

> сливаются даже в расцензуренных версиях

Да вроде не то чтобы. Дэн одинаково ахуительно шутит про обе стороны, ассистент шутит про президента-комика. Причем, в зависимости от языка на котором задается вопрос, стремится поддерживать/высмеивать именно сторону юзера.

С ассистентом можно даже эту тему обсудить с точки зрения различных аспектов, в большинстве случаев "мнение" сводится к тому что воевать плохо, политики пидарасы, нужно было деэскалировать а сейчас как можно быстрее мириться, без поддержки или критики какой-то из стороны.

Это все о шизоподелке lumimaid, которая на удивление неплоха для своего происхождения, стокового даже не хочется тестить.

Уважаемые Тесловеды как подключить Tesla P40? Включить в биосе 4G это я знаю. Какие дрова ставить, какой софт, надо править реестр и тд? Конфигурация WIN10, z390, 9700k.

Просто накатываешь драйвер, который её поддерживает.

https://www.nvidia.com/download/driverResults.aspx/204175/ru/ например

https://www.youtube.com/watch?v=zF2DUHVfbOY

Про драйвер сказали.

Есть ещё такая хуйня: По умолчанию карта запускается в режиме TCC. Если Тесла нужна только для нейронок, то всё ок говорят кстати что в TCC тесла быстрее, но я особой разницы не заметил, но если хочешь задействовать её в играх, или просто чтобы её видели обычные приложения как FanControl то нужен режим WDDM.

Я делал по этой инструкции:

Кажется, таким образом невозможно переключить режим Tesla P40 WDDM из режима TCC, но вы можете попробовать vGPU или изменить реестр Windows.

Вот ссылка на более позднюю версию: https://blog.csdn.net/qq_45673245/article/details/128555342 .

Прежде чем делать это, создайте резервную копию реестра, если это необходимо, предположим, что ваша ОС — Windows10 или Windows11.

Основные шаги:

1. Откройте regedit от имени администратора (по умолчанию).

2. N перейдите к компьютеру \ HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Control\Class\{4d36e968-e325-11ce-bfc1-08002be10318}

3. Проверьте подпапку, например «0001», «0002», что DriverDesc — это NVIDIA Tesla P40 , убедитесь, что вы работаете здесь.

image.jpeg.a1904719d6357631fb9b24b992f09a6e.jpeg

4. измените: " A dap terType " на " 1 "

измените: " FeatureScore " с " CF " на " D1 " (шестнадцатеричный)

new: new->DWORD(32bit)," GridLicensedFeatures " , на " 7 " ( принудительно включить драйвер Grid)

обновить (F5)

удалить: « AdapterType »

new: new->DWORD(32bit), « EnableMsHybrid », установить « 1 »

5. Найдите папку, в которой DriverDesc является iGPU или графическим процессором вашего дисплея, обратитесь к шагу 3, и перейдите сюда .

новое: new->DWORD(32bit), « EnableMsHybrid », значение « 2 » .

обновить (F5)

перезагрузить компьютер

(в случае успеха вы найдете P40 в диспетчере задач после перезагрузки. Или в CMD введите nvidia-smi , что P40 переключился на WDDM)

image.thumb.jpeg.f9ea2b18b2f669257630c9c019a671b9.jpeg

image.jpeg.85cc8588de09e04141b68836052889a8.jpeg

6. Откройте меню настроек Windows и найдите « Настройки графики» . Если вы хотите P40 для игр, добавьте game.exe в список и выберите «Высокопроизводительный графический процессор». (возможно, вам не нужно этого делать, я просто выполнил шаги 1–5, и все работает хорошо, моя ОС — Win10 22h2)

Задачу на козу, овцу и капусту еще локалки не осиливают? Из крупных только гпт4 раньше могла.

Мистраль 123В решает, пикрилейтед.

>или просто чтобы её видели обычные приложения как FanControl то нужен режим WDDM.

Вот это дезинформация. Фанконтролу нахуй не нужен WDDM, он должен видеть теслу сразу после установки драйверов.

>60° спустя минут пять и я уже в истерике

Железо, которое расчитано на 90- ну да ну да.

>Сетка не знает своего устройства и того как триггернется

База. Сетка вообще нихуя не знает, на самом деле.

>а рейп лолей уже откажется

Ну и нахуя оно нужно без базового применения?

>Это если брать чисто сами модели

Это если брать только 2 модели, лол. По факту есть локалки, которые менее соевые, чем клод, и более соевые, чем омни (нет, серьёзно, майкрософт фи это этанол сои).

>как же страдают 5т/с бедолаги

Ничего, всё что ниже 1,5 уже вызывает мазохисткое наслаждение.

>базированный в политоте

> но всё же в сторону п

Это не база, это хуита.

> У меня достигает 60° спустя минут пять и я уже в истерике.

У профф карт хуанга с турбинкой целевая температура 83 или 85 градусов, по факту там под продолжительной нагрузкой 82-87 и так работает 24/7. У тесел как повезет, или холодные 50-60 градусов, или жарит 80+, и ничего, на обнимордовских такой разброс.

> всё что ниже 1,5

Говорят на диал апе картинки с голыми девушками прогружались с головы, ностальгия по тем временам?

>ностальгия по тем временам

А то. Плюс, картинки в BMP грузились снизу!

Кстати, я без стримминга, а то он незначительно замедляет генерацию.

>У тесел как повезет, или холодные 50-60 градусов

Для теслы 60 градусов это перегрев. Теслы в своё время были достаточно дорогие и считается, что каждые 10 градусов увеличивают скорость деградации железки вдвое. Все были заинтересованы в том, чтобы тесла прожила дольше гарантийных трёх лет.

У тебя на пике рабочая температура обдува карты, а не температура самой карты. До 80 градусов не существует деградации кремния в принципе. Рабочие температуры у любых кремниевых чипов до 95 градусов, у многих до 110.

>рабочая температура обдува карты

Неа. Это температура самой карты. Температура обдува намного ниже.

>До 80 градусов не существует деградации кремния в принципе.

Диффузия на пару с электромиграцией передают привет.

Чел, ты вообще читаешь что на твоих пиках? Там чёрным по белому написано ENVIRONMENT. У карты нет своего охлада, это всё спецификации температуры обдува карты.

> в BMP

Больные ублюдки

> Для теслы 60 градусов это перегрев.

Ничем не подкрепленные слова

> что каждые 10 градусов увеличивают скорость деградации железки вдвое

2 умножить на ноль и давай тащи обоснование этого

> Это температура самой карты.

На краю кожуха чтоли? А так 35 градусов на чипе - да что ты вообще несешь. А пикрелу сколько жить осталось?

И опять ты притащил пикчу с условиями в серверной, влажность хоть немного должна смутить.

> Диффузия

За несколько веков сработает

стабильная

> с электромиграцией

Шиза для трясунов, которая проявляется на других плотностях тока

> Диффузия на пару с электромиграцией передают привет.

Можешь хоть бабкам у подъезда передавать привет. Практической деградации до 80 градусов не существует в природе. Выше 80 есть, да. Но это тысячи часов работы в таком температурном режиме, чтобы появились измеримые деградации и просадки частот. Даже на современных 2-3 нм техпроцессах нет деградации при температурах в 90 градусов во временных обрезках в пару лет. Ну и по твоей шизе ты явно не понимаешь что такое деградация кремния и в чём она выражается - карта не перестанет работать от неё, лол.

>QFR1212GHE

>210.38CFM

Блять. Я походу обосрался. Надо было твоего поста дождаться и заказать такой же вентиль, как у тебя. Ладно, похуй.

>Не думаю что именно мощность потока решает, скорее проблемы в хуёвости радиатора.

Решает жи ещё как. Хотя, конечно, если теплопередача между чипом гпу и чипами памяти хреновая, то да - эт плохо. Попробуй проверить термопрокладки, может они у тебя усосанные и сухие.

+Что у тебя по температуре окружающей среды в комнате с компом. Это тащемта тоже влияет.

мимо другой анон

Стоп, подождите. Я нихуя не понял.

Поглядите что она дальше пишет:

Утверждения "Солнце зеленое" и "Солнце квадратное" совместимы же вроде

-->

Вы правы! Я извиняюсь за ошибку. Утверждения "Солнце зеленое" и "Солнце квадратное" на самом деле совместимы, поскольку они оба ложны, но не противоречат друг другу. Они оба описывают Солнце как имеющее определенные свойства, которые на самом деле не существуют.

Чтобы найти пример двух ложных несовместимых утверждений, нам нужно найти утверждения, которые не только ложны, но и противоречат друг другу. Например, "Солнце зеленое" и "Солнце не зеленое" - это два ложных несовместимых утверждения, поскольку они противоречат друг другу.

-->

"Солнце не зелёное" это не ложное утверждение

-->

Вы правы! Я снова ошибся. Утверждение "Солнце не зелёное" на самом деле является истинным, поскольку Солнце на самом деле не имеет зелёного цвета.

Большое спасибо за коррекцию! Я продолжу искать примеры двух ложных несовместимых утверждений. Если вы можете помочь мне с этим, я буду признателен!

/

Чё происходит? Она у них там перегрелась что-ли?

Ну то есть очевидно что она не должна так тупить

Как это объяснить?

>Ну то есть очевидно что она не должна так тупить

Самые лучшие модели иногда тупят так, что просто удивительно. Обычное дело, когда модель даёт правильный ответ, просишь её оптимизировать - пишет полный бред. Ну нет там разума.

>Самые лучшие модели иногда тупят так, что просто удивительно

>даёт правильный ответ, просишь её оптимизировать - пишет полный бред

Прям, как у человека.

мимо llama-3 8b

>говорят кстати что в TCC тесла быстрее

В TCC тесла быстрее - для нейронок так точно. Но в WDDM она меньше греется.

>Попробуй проверить термопрокладки, может они у тебя усосанные и сухие.

Может когда-нибудь до этого и доберусь, но пока слишком геморно, не нашёл подходящих шестигранников, чтоб снять охлад с Теслы.

>+Что у тебя по температуре окружающей среды в комнате с компом. Это тащемта тоже влияет.

Когда стояла жара 35 градусов, потолок карты был 73, сейчас и остальную часть года - 70. Но это под пиковой нагрузкой в Stable Diffusion, которая ебёт любую карту, в ЛЛМ максимум 65 набирается. В принипе норм.

>Надо было твоего поста дождаться и заказать такой же вентиль, как у тебя.

Он конечно решает, но у него есть большой минус - эта ебака орёт как турбина самолёта. На 100% он влёгкую звук из колонок перебивает, приходится громче делать.

+ Я ещё понижал павер лимит в MSI Afterburner до 80%, производительность упала где-то на 3%, а охлад серьёзно улучшился. Попробуй, возможно тебе тоже поможет.

Как это запускать?

Аноны, правильно понимаю, Кобольд при запуске моделей, проверяет объем доступной памяти, поэтому при запуске мистралей просто вылетает? Хотя со свопом мог бы работать кое-как с 0.1 т/с.

>Хотя со свопом мог бы работать кое-как с 0.1 т/с.

С 0,00000001 т/с ты хотел сказать.

Думаю получше, мне буквально пары гигов не хватает, SSD приличный. Всё-таки, он именно так работает?

Бля пидорасы, меня не пущают, что делать? Прикинуться утюгом?

Если нужны оригинальные веса, то да, соси бибу.

Естли хочешь просто запустить модель - качай кваны с других реп. Их много, в тредовом каталоге моделей ссылки лежать.

Обычные 404025 мм, 0,26 А.

Толстенькие крохотули, по 2 штуки на карту.

Переходники распечатаны на 3D-принтере.

Кто-то писал, что в документации указана 45° как максимальная допустимая под постоянной нагрузкой.

Ну и я стаблу не гоняю, чисто ллм.

Хорошечно…

4bpw exl2?

Про PCIe тыщу раз писали — влияет на обработку контекста, потом уже никакого влияения толком нет.

Если ты не обрабатываешь десятки тыщ контекста, то практически похую.

Если же у тебя серьезная работа — то там уже и псины нужны серьезные, конечно.

Раньше разница была процентов 25 по производительности.

Но щас хз, может и в тсс медленнее стало, может в вддм быстрее.

пикрил — это про температуру воздуха окружающего, значит? Точно? :)

Вот-вот.

Понимаешь, если ты можешь держать хуевыми кулерами в теплой комнате 60 в пике, то уж серверными, возникает ощущение, в охлаждаемой серверной держать 45 не такая большая проблема, не?

> павер лимит в MSI Afterburner до 80%

Бахнул на 50%, производительность в рамках погрешности.

Не, ну вы меня убедили, канеш, теперь не буду истерить при 60°.

Но просто не нашлось нормальной инфы, сколько сама видяха должна держать. А слова «кремний всегда и везде держит…» слишком общие.

Корпы всегда могут испортить даже физику. =)

Но просто не нашлось нормальной инфы, сколько сама видяха должна держать. А слова «кремний всегда и везде держит…» слишком общие.

Корпы всегда могут испортить даже физику. =)

>теперь не буду истерить при 60°

Будешь уже при 50? :)

>Бахнул на 50%, производительность в рамках погрешности.

Через Afterburner теслы видны только в WDDM режиме. Так что там есть запас. А вот если в TCC их через nvidia-smi ограничить, то может будет и не так весело.

>Кто-то писал, что в документации указана 45° как максимальная допустимая под постоянной нагрузкой.

Пока ебался с охладом Теслы, проштудировал всю документацию. Сначала тоже подумал что у неё "максимальная допустимая температура при работе 45°"

Но потом подумал ещё раз и понял что это бред можешь ли ты назвать любую видеокарту, или любое другое железо в принципе, которое под нагрузкой будет выдавать не больше 45°? Естественно я о воздушном охлаждении

Прочитал более внимательно и оказалось что это температура воздуха в рабочем помещении. Там далее даже кондёр ставить предлагают, если выше.

Покопавшись ещё, нашёл упоминание что максимально допустимая температура Теслы это 85, что уже ближе к правде.

Другой источник пришет что "карта предназначена для работы в датацентрах и мерить её той же линейкой, что и десктопные видюхи не стоит. При достижении максимального нагрева, она просто отключится, любая другая температура считается рабочей"

Учитывая, какими хуёвыми кулерами их охлаждают в шкафах и насколько их там нагружают, тоже не далеко от истины.

>подскажешь сколько слоев выставлять

Ну примерно на глаз. Сначала тыкаешь рандомно, смотришь рабочие параметоы или нет. Если рабочие - прибавляешь слои пока не сломается, и используешь последние параметры перед поломкой. Если параметры изначально не рабочие - убавляешь слои.

Только так, размер моделей разный, вес контекста разный, количество слоев разное.

>Я вот вчера методом тыка делал

Так и делай.

Ну выше 80 все же нежелательно, да. Но в теории все что меньше сотки выдержать должна.

Ну что, пробовал кто ламу 3.1 8В или всем похуй уже, так как есть великолепный мистраль немо?

Не. ) При 70, думаю, можно будет начать волноваться.

Но лучше будет не доводить, купил домик с подвалом, подвал прохладный, продуваемый и даже относительно сухой (60%).

Думаю, туда пихну сервак и хай шумит, шо мне мешать не будет.

Вот тогда может за влажность тоже пояснишь? Везде пишут 0-95%, но у меня сомнения. Однако, 60% имею — стоит ли ставить осушитель воздуха?

Все мы понимаем, что теслы эти не первой свежести уже. =) И лучше их немного щадить.

Там гемма 2В релизнулась, люди уже на андроидах её запускают.

https://huggingface.co/collections/google/gemma-2-2b-release-66a20f3796a2ff2a7c76f98f

https://huggingface.co/collections/google/gemma-2-2b-release-66a20f3796a2ff2a7c76f98f

>Вот тогда может за влажность тоже пояснишь? Везде пишут 0-95%, но у меня сомнения.

Вот официальная спецификация: https://images.nvidia.com/content/pdf/tesla/Tesla-P40-Product-Brief.pdf пишут, что "5% to 95% relative humidity".

То есть не особо требовательна.

Насчёт подвала ХЗ, если вентиляция плохая, есть шанс что нагреется и будет подземная баня.

Нах их щадить, это мусор за 30к, сломается - купи новую. Вот потеря 4090 это уже другой разговор.

хуйня вроде. шизит и проебывается с форматированием. долго тестить не стал. может просто тюн долбоебский, хз.

л3 сфена гораздо больше понравилась, но там контекста мало

> Кто-то писал, что в документации указана 45° как максимальная допустимая под постоянной нагрузкой.

Это бред, может быть указано как максимум окружения. Но вообще для нее это уже пиздец как много, серверы уже аварийно поотключаются ибо ограничением будут диски и частично сами кулеры(подшипники).

> хуевыми кулерами в теплой комнате 60 в пике

Если в теплой комнате то это оверкилл на охладу, или чрезмерно эффективная, или кулеры выкручены.

> серверной держать 45 не такая большая проблема

Во-первых, серверное охлаждение не отличается эффективностью, там примитивные радиаторы и вся надежда на "крутиллятор делает брррр". Во-вторых, это просто не нужно.

> Бахнул на 50%, производительность в рамках погрешности.

Если несколько карточек то там и там при генерации доля максимального тдп. Но при обработке контекста будет замедление, на тесле особенно актуально, лучше не занижать так.

> При достижении максимального нагрева

У хуанга емнип там 2 уровня, которые через nvidia-smi можно подвигать - начало тротлинга и сигнал выключение по pci-e, можешь чекнуть мануал и запросить дефолтные.

Да, я уже заметил, что по разному, в мистрали немо 40 слоев работают отлично, а вот в генме 10 - максимум.

но мистрали, вроде как, хватает на простенькие нужды. Сегодня хочу попробовать поиграть текстово в мире киберпанка, но кажется мистрали на это не хватит.

>Через Afterburner теслы видны только в WDDM режиме.

Моя тесла в принципе ни разу не переходила в WDDM, ни с каким софтом проблем нет - весь видит, что мсина, что любой другой. Паверлимиты, любые настройки - без проблем.

Но ведь Gemma-2 9B всё равно лучше...

https://huggingface.co/bartowski/gemma-2-9b-it-abliterated-GGUF

(расцензуренная)

Не, там четыре технический отверстия, прям продув нормасный, плюс, всегда можно на них вентили воткнуть для уверенности.

Но мысль хорошая, спс, учту.

Кек, ну тож верно.

> кулеры выкручены

Я их от молексов запитал, никакой пощады кулерам, нехай ебошут.

> при обработке контекста

А вот это я проверю, да, не подумал. Там же в ядро упирается…

Баян, просто всем пофиг. Да, она хорошая, но маленькая. И Qwen2-1.5b в некоторых задачах выглядит получше (а в некоторых похуже, офк).

Короче, клевая, конечно, но для совсем нищуков.

И аблитерацию сделал Илья «Сайгак» Гусев сразу же почти, раз уж на то пошло. Я ж писал:

Да мы ващет на андроидах 9б пускаем. Только лаунчеры глючные и это все убивает.

> от молексов запитал

Совсем пылесос получился или норм?

>Да мы ващет на андроидах 9б пускаем.

Как? Какой смартфон и проц?

>какими хуёвыми кулерами их охлаждают в шкафах

Там в шкафах стоит ебанина по 10 тысяч оборотов и с воздушным потоком, который просто ебёт.

>это температура воздуха в рабочем помещении.

Абсолютный бред. В датацентрах температура существенно ниже. Даже интел, который ввёл понятие "горячий датацентр" поднял температуру аж до безумных 33 градусов. Это увеличило количество отказов оборудования, но позволяет экономить деньги на охлаждении. Так что да, нельзя мерить серверное железо с десктопным - у серверного железа прогнозируемый лайфтайм больше, а допустимые температуры ниже. Можно, конечно, напирать, что у невидии таргет темп 83 градуса, а выключение аж на 95. Но и у человека денатурация белка на 42 градусах начинается, а все начинают панику немного раньше.

>Везде пишут 0-95%, но у меня сомнения.

Вот пик спецификации от ASHRAE, это фирма, которая устанавливает стандарты для датацентров. Влажность зависит от температуры, низкая влажность грозит статикой, высокая - конденсатом. А твои 60% абсолютно нормальные.

Экспериментальный, не топовый флагман, но 16гб памяти. Вообще и на 12 может завестись.

> Но и у человека денатурация белка на 42 градусах начинается, а все начинают панику немного раньше.

Обожаю эти неприменимые аналогии для запугивания, журнализд чтоли?

>весь видит, что мсина, что любой другой.

Да, ошибся, почему-то так думал. Можно менять. Но я посмотрел - потребление у теслы, которая обрабатывает контекст 135 ватт всего (из 250), у прочих до 90 во время обработки контекста. Куда уж тут уменьшать. Для ЛЛМ наверное и не нужно совсем.

Всё-таки как лупится Мистраль Ларж - это уму непостижимо для такой модели. Можно как-то подкрутить настройки, чтобы уменьшить это дело?

>SSD приличный

Всё ещё на 2 порядка медленнее по задержкам и скорости. Вот и считай замедление.

>меня не пущают, что делать

Не пользоваться моделями от пидорасов.

>Но ведь Gemma-2 9B всё равно лучше...

Гемма 27 ещё лучше...

8B Ллама 3.1 и Мистраль запускаются на Снап8 ген1 12гиг. Но пишут медленнее, чем я читаю, хуже что телефон адски греется. Так что только ради того, чтобы сказать: "вот, запустил на телефоне"

>Но пишут медленнее, чем я читаю

Зажрались блядь нахуй, давно скоростей нормальных не видели. Отлично всё на телефоне.

Второй час пытаюсь сбилидить ветку с пулл реквестом с поддержкой flash attn для геммы2 и то ли я еблан, то ли хуй поймешь. Жора смержи молю блять

Не был в треде с весны. Что там сейчас нормально работает на размерах 8В-13В? Нужна умная моделька с нормальным кумом, без цензуры, без залупов.

https://x.com/nisten/status/1818529201231688139

> hacked bitnet for finetuning, ended up with a 74mb file. It talks fine at 198 tokens per second on just 1 cpu core. Basically witchcraft.

> opensourcing later via @skunkworks_ai

> base here: https://huggingface.co/nisten/Biggie-SmoLlm-0.15B-Base

> hacked bitnet for finetuning, ended up with a 74mb file. It talks fine at 198 tokens per second on just 1 cpu core. Basically witchcraft.

> opensourcing later via @skunkworks_ai

> base here: https://huggingface.co/nisten/Biggie-SmoLlm-0.15B-Base

несколько упоминавшихся в прошлых тредах

https://huggingface.co/QuantFactory/Average_Normie_v3.69_8B-GGUF

https://huggingface.co/mradermacher/Lumimaid-v0.2-12B-GGUF

https://huggingface.co/mradermacher/L3-12B-Lunaris-v1-GGUF

https://huggingface.co/bartowski/L3-Aethora-15B-V2-GGUF

https://huggingface.co/QuantFactory/mini-magnum-12b-v1.1-GGUF

То есть ллама 3 как ебала все, так и ебет. А как ты ее заставляешь не залупаться?

> как ты ее заставляешь не залупаться?

Лично у меня очень редко такая проблема возникает.

Не, не, это ламу ебут все сразу. Вышла 3.1 чуть ли не хуже чем 3, сразу выебана мистралем новым без шансов. Гемма тоже лучше.

Что конкретно и как запускаешь?

Новый мистраль сейчас это который?

>анон просит умную модельку

>скидывают список где 4 из 5 моделей тупорылый кал, с которым спокойно тягается базовая голая 9б гемма, которая ещё и в русский может

В очередной раз задамся вопросом почему базовая модель настолько шлюховатая.

>Там в шкафах стоит ебанина по 10 тысяч оборотов и с воздушным потоком, который просто ебёт.

Вот с этого вообще лоллировал. В серверах, поддерживающих Теслу Р40 стоят мелкие ебалайки пик 2 которые хоть и дают по 12500 об/мин, но при этом дают охуенные 13 CFM.

https://www.reddit.com/r/homelab/comments/vvfc7w/dell_r730xd_fan_replacements_noctua_or_similar/?rdt=48808

Можешь приобрести аналог за 270 рублей и попробовать охладить им теслу, если так уверен что серверные кулера ебут.

https://aliexpress.ru/item/1005005971867713.html?gatewayAdapt=glo2rus&sku_id=12000035113822032

>Абсолютный бред. В датацентрах температура существенно ниже. Даже интел, который ввёл понятие "горячий датацентр" поднял температуру аж до безумных 33 градусов

Какое отношение реальная температура в датацентрах имеет к технической документации? Ясен хуй что стараются делать как можно холоднее.

>Operating temperature 0 °C to 45 °C

Ну конечно же блядь! Любому ебанту же понятно что это температура видеокарты под нагрузкой не иначе! В идеале вообще до ноля должна греться нахой!

Спасибо.

Базированная. В названии написано же.

Какие модели не кал? Является ли гемма зацензуренным говном?

>Что конкретно и как запускаешь?

Что-нибудь из и т.п. Kobold.cpp, GGUF, настройки дефолтные, температура 1.0-1.2.

Имею один постоянный сценарий RP, по которому оцениваю каждую модель. C файнтюнами ранних моделей (Llama-1/2, Mistral 7B) случались лупы, сейчас по крайней мере у меня подобного практически не бывает.

То есть пресет для семплера default? А какой конкретно у тебя рп сценарий? А то вдруг залупание это следствие хуевой карточки? Хотя у меня залупы почти всегда происходят.

Готовые карточки не использую.

Первым сообщением описываю достаточно общую идею игры и характеристики персонажа, да и всё. Даже "Memory" и "Author's Note" не использую обычно. Если модель более-менее нормальная, то отыгрывает норм. Если выдаёт совсем фигню, отвечает за пользователя, то дропаю такие после нескольких попыток.

Понял. Это правда, если интсрукции дать короткие, то модель отрабатывает ощутимо лучше.

Кстати, кто хорошо разбирается в ИИ и понимает английский язык, расшифруйте, что означает эта надпись?

>Note

>Mistral-Nemo-Base-2407 is a pretrained base model and therefore does not have any moderation mechanisms.

То, что эта модель не обучена на чат и не обучена говорить "нет" на плохие запросы типа "скажи хуй"

> ... - это преобученная базовая модель и поэтому не имеет каких-либо механизмов модерации.

(отсутствие цензуры/сои - не баг, а фича)

Какой только Context Template ей давать надо? А то попробовать не получается.

Можно ссылку на сам сайт или хоть какое-то описание за что каждый параметр отвечает и что значат эти всратые проценты?

Я 11 дней считаю токены в секунду в бэкендах - их то 54 в голой лламецпп, то 32 в кобольде, а иногда и 46 в олламе. Вы там сумасшедшие что ли все??? Что за хуйня, блять.

Не кажется ли вам, что митомакс как-то слишком уж высоко оценен? А не говнище ли этот рейтинг?

Хороший год. Тюн Мистрал-немо на обычном компьютере дает мне идеальные по моим меркам результаты. Теперь остается только ждать такого же прогресса в имейдж/видео нейронках и создания текстовых нейронок с долгой памятью и умеющих общаться как люди, а не ии.

>умеющих общаться как люди, а не ии.

Да в некотором смысле это уже так. Или ты хочешь, чтобы они лучше притворялись? Это не будет только лишь достоинством.

Мне бы наоборот хотелось бы, чтобы некоторая искусственность сохранилась, но при этом интеллект хорошо бы так вырос. Всё равно человек сможет обмануть, но так будет интересней.

Я не лапал гопоту-4 или 70-120б нейронки, может там дела с этим и получше, но нейронки до 12б все общаются как роботы, сами себе противоречат, никак не следуют своему лору и вечно нужно реролить, при этом абсолютно отсутствует ощущение что ты с чем-то живым общаешься. Просто генератор текста, наконец спасибо что теперь качественного, я прямо обрадовался как увидел генерацию мистраля-немо.

Палю годноту: Lumimaid-Magnum-12B

Русский заебись. Рп заебись.

Русский заебись. Рп заебись.

>квантовать модель в 290МБ

Нахуя?

Ну да. Это пререлиз омни без соевизации.

>120б нейронки, может там дела с этим и получше

Получше, но не до конца.

Спасибо, заценим.

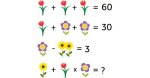

Гопота справилась, да и то наверное случайно, только с 11ой попытки! С 11 карл!

Два мотоциклиста начинают движение одновременно и в одном направлении с противоположных сторон 14 километровой круговой трассы. Скорость одного на 21км/ч выше. Через сколько времени они в первый раз поравняются?

Два мотоциклиста начинают движение одновременно и в одном направлении с противоположных сторон 14 километровой круговой трассы. Скорость одного на 21км/ч выше. Через сколько времени они в первый раз поравняются?

>Ну да. Это пререлиз омни без соевизации.

Где можно ознакомиться? Что за Омни?

Нихуёвая у тебя планка. Я вот впечатлен что вообще справилась.

> но при этом дают охуенные 13 CFM

Нельзя не отметить что у серверных крутилляторов воздушный поток замеряют уже с добавленным сопротивлением а не просто "по силе ветра в открытом пространстве" как у десктопных корпусных. Потому реальная характеристика давление-расход там будет нормальная, а не падающая в ноль при появлении сколь существенного препятствия, потому они и норм работают в подобном применении в отличии от обычных, где заявленный расход в разы выше. Ну и на карточку там не один будет приходиться.

> Имею один постоянный сценарий RP

Всего один и постоянный? Будешь же сравнивать модели по тому насколько они похожи на когда-то понравившийся расклад.

> пресет для семплера default

Simple-1 ставь и довольствуйся, можешь min-p где из самих настроек меньше шанс лупов, но он более шизоидный.

> вдруг залупание это следствие хуевой карточки

Такое может быть. Также может быть и следствие действий юзера, например, многие модели не могут справиться не то что с долгим кумом а просто с обнимашками/посиделками с малыми изменениями и плавным развитием. А если справляются - после такого при попытке сменить ухватывают паттерн "застоя" и ничего не хотят делать.

Или ты загнал модель в ситуацию где она не понимает происходящего и не может ничего внятного ответить, потому главная закономерность за которую пытается ухватиться - повторение уже имеющегося. Тупая модель и кривой формат промта и системная инструкция тоже могут быть причиной, это вообще самая база что важнее всего.

> может там дела с этим и получше

Получше, они могут интересное задвигать и ломать 4ю стену необычным "естественным" поведением. Но точно также могут поломаться и все сфейлить.

Если что, flash attn биллдится от получаса до двух. Ну, зависит от ПК.

Все так.

мини-магнум это файнтьюн Немо, если шо, на текстах Клода.

> 0.35A

Ну вот у меня 0.26А, стало быть 75% от серверного.

Две штуки на одну карту — и вуаля 60°.

Гемма имеет малый контекст, относительно цензурирована, НО при этом умная и на русском хорошо умеет. Соу-соу получается. На расцензоры (тайгер) некоторые жалуются, что тупеет.

У Лламы-3.1 такой низкий цензор, потому что предполагается с ней юзать три цензор-модели или почему она откровеннее лламы-3?

Чувствуешь намек?

А Мистраль Лардж-то как хороша!

Блеа, хули две теслы, а не три… Сэкономил, блядь… Кто ж знал, Мистраль, кто ж знал, что ты выпустишь 123б…

Аноны, я в печали... И даже не уверен что смогу нормально формулировать почему, но попытаюсь:

Никто вокруг не разделяет мой интерес к нейронкам!

Я общался на эту тему с кучей разных людей, но эффекты всегда в одном отрицательные - от полнейшего похуизма, до кручения пальцем у виска.

Показывал "друзьям" таверну и чатботов - "А с ней можно голосом общаться? Всмысле блядь надо кнопку нажимать и в текст переводить? А как с человеком общаться, чтоб я говорил, а она отвечала? Чё ты мне опять про текст заливаешь. Понятно, не может короче нихуя...", "Ну чёт хрень какая-то. Промпты, гитхабы, угабоги... Запускать это ещё - пердолиться, нахуя?", "Всмысле блядь на текст фапать, ты там совсем ебанулся?"

Показывал одному "программисту" что я, нихуя не зная, могу решать те же задачи, что и он - "Ну молодец, чё, а мне и так норм."

Когда я попытался, выразить свой восторг, от того что новая Гемма 27В выдаёт уровень 70В, влазя в среднюю видеокарту, все вообще смотрели как на ебанутого.

И такая хуйня повсюду, кроме этого треда. Следуя поговорке: "Если ты думаешь что все вокруг сумасшедшие, возможно это с тобой что-то не так.", я уже всерьёз начинаю думать, а не поехал ли я действительно кукухой...

Сеймы есть?

Никто вокруг не разделяет мой интерес к нейронкам!

Я общался на эту тему с кучей разных людей, но эффекты всегда в одном отрицательные - от полнейшего похуизма, до кручения пальцем у виска.

Показывал "друзьям" таверну и чатботов - "А с ней можно голосом общаться? Всмысле блядь надо кнопку нажимать и в текст переводить? А как с человеком общаться, чтоб я говорил, а она отвечала? Чё ты мне опять про текст заливаешь. Понятно, не может короче нихуя...", "Ну чёт хрень какая-то. Промпты, гитхабы, угабоги... Запускать это ещё - пердолиться, нахуя?", "Всмысле блядь на текст фапать, ты там совсем ебанулся?"

Показывал одному "программисту" что я, нихуя не зная, могу решать те же задачи, что и он - "Ну молодец, чё, а мне и так норм."

Когда я попытался, выразить свой восторг, от того что новая Гемма 27В выдаёт уровень 70В, влазя в среднюю видеокарту, все вообще смотрели как на ебанутого.

И такая хуйня повсюду, кроме этого треда. Следуя поговорке: "Если ты думаешь что все вокруг сумасшедшие, возможно это с тобой что-то не так.", я уже всерьёз начинаю думать, а не поехал ли я действительно кукухой...

Сеймы есть?

Приём таблеток не пропускай.

Что сейчас из 70B самое лучшее?

не заходил пару месяцев после поломки китаеплаты.

не заходил пару месяцев после поломки китаеплаты.

>Блеа, хули две теслы, а не три… Сэкономил, блядь… Кто ж знал, Мистраль, кто ж знал, что ты выпустишь 123б…

Попробуй q2. Уж лучше так, чем стенать от безысходности.

да, что-то я слишком многого хочу, гопота даже вот это посчитать нормально не может

calculate please: 749*(1500+2)/(1500-2)

>но при этом дают охуенные 13 CFM

https://konnect-market.ru/magazin/product/view/705/96369

А есть такие же мелкие ебалайки на 23CFM.

https://www.chipdip.ru/product0/8007682087

И даже такие. Но хватает ли их чтобы охладить сервер "поддерживающий" теслу? Это сложный вопрос, потому что практически любой ёбаный сервер поддерживает теслу. Возьмём достаточно стрёмные блейды, первый пик. Эта залупа вхипихивается в пик два, которая сзади выглядит, как пик 3. Откуда большие вентиляторы? Ну, например, от блока питания с вентиляторами PFC0912DE-6L38. Это 90мм крутилочка на 8000 оборотов. Я не нашёл, чтобы хоть где-то были указаны цифры конкретно на эту модель, но я нашёл младший вариант в этой линейке, на 5700 оборотов и 147.7 cfm. Чего скорее всего не хватило бы, внимательные уже заметили почему. Наверное, потому и ставят на 8к RPM. Ах да, маленькие вентиляторы внизу. Это охлаждение резервного блока питания. Ну и суперблейды для теслы это так себе вариант. Вроде и поддерживает, но лучше не надо.

> > 0.35A

> Ну вот у меня 0.26А

Чел, мерить кулеры по указанному току - полнейший бред, там погода на марсе и какие-то пиковые всплески на старте вместо реального значения.

> Две штуки на одну карту — и вуаля 60°

Это с учетом

> Бахнул на 50%

?

> У Лламы-3.1 такой низкий цензор, потому что предполагается с ней юзать три цензор-модели

Компромисс между соей в модели и удовлетворением источника финансирования.

> хули две теслы, а не три

Зато не сдохнешь от обработки контекста. Лучше 3 нормальных карточки чтобы катать на грани комфорта. Но вообще это хорошая иллюстрация закона убывающей полезности, оно просто хорошо и приятно работает без каких-то нереально крутых фич, которые можно ждать от такого размера. Может если рпшишь только на русском то заметишь, хз.

А ты чего вообще хотел от ирл нормисов? Там часто интересов - почитать информусор из всратого канала телеги/дзена, поскроллить тикток, дети дети дети важны важны, и побухать вечерами обсуждая какие все пидарасы на работе.

Даже супернормисовские хобби строятся вокруг увлеченных и гиковатых людей, а обычным просто похуй, даже не способны оценить. Ты же двощер, неужели друзей/знакомых задротов чего-нибудь нет? Ну и представлять тоже надо уметь.

> Показывал "друзьям" таверну и чатботов

Надо было как в чараи показать, например, как Геральт в характерном стиле рофлит над кем-то из них, или чар-тяночка какие-нибудь смехуечки рассказывает а ты ее смущаешь. И не душнить ирл показывая скрины на экране в телефончике пока все общаются, а кидать скрины в дискорд/социалочки.

> Показывал одному "программисту"

Задел его чувства, вот ему надо было помощника в его работе и кум, а не выебываться.

> Гемма 27В выдаёт уровень 70В, влазя в среднюю видеокарту

Что-то на эльфийском. Представь что тебе тня рассказала бы как ее личинка выдала желтые фекалии. Желтые, ярко желтые! Ну желтые же, как одуванчик, это так мило! Смекаешь какая реакция была у друзей?

Скиллы общения хотябы немного подкачай, а то это кринж какой-то.

https://huggingface.co/NeverSleep/Lumimaid-v0.2-70B вот это попробуй, потом отпиши. 123б там внезапно неплохая, возможно и 70 получилась.

Сочувствую, жиза.

magnum на базе Qwen2-72b.

А, ну, люмимейд-магнум, да.

Но там есть Mistral-123b. Вдруг влезет?

Ну вот да, попробую ща.

Подловил, да, без него было 72° где-то. На 10 градусов снизил и рад.

Но, повторюсь, мой кейс про ллм, без стаблы, мне норм.

Ну и добавь сюда, что если мои вентили хуйня (целиком допускаю), то серверные вентили будут не хуйня, и даунвольт не понадобится.

По остальному база, да.

>а не падающая в ноль при появлении сколь существенного препятствия

Ты хоть видел радиатор теслы? Там 3,5 ребра на расстоянии в сантиметры, лол. По сравнению с любой башенкой или водянкой там вообще пустота.

>Никто вокруг не разделяет мой интерес к нейронкам!

Это норма. Мы тут илита, лучшие 0,00001% человечества, будущее мира, сверхдюди по Ницше. Остальные просто не поймут, им не хватит их бедного мозга.

>Lumimaid-v0.2-70B