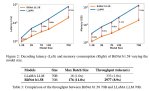

https://blog.premai.io/prem-benchmarks/

Повторю ссыль на тесты на разных инференсах.

Уже не новое, но дает понять, что и как работает и как по скоростям.

Фаната того-сего посвящается.

Повторю ссыль на тесты на разных инференсах.

Уже не новое, но дает понять, что и как работает и как по скоростям.

Фаната того-сего посвящается.

> последовательно

Без распараллеливания да, будет тупо "отработала одна, передала данные другой". При использовании параллелизма карты могут работать реально одновременно.

> 3090 — быстрее, рисковее, занимает 1 слот. Вот и вся разница.

Изначальный вопрос был в том, стоит ли риск выгоды, цена вопроса-то немаленькая.

> Потому что нет, с хуя бы.

> У тебя буквально одни слои лежат на одной видяхе, другие на другой. Пока не обсчитаны одни — нельзя обсчитать другие.

Это самый банальный случай. В документации обнявлицо выше есть и другие, подразумевающие нормальную параллельную работу.

> Типа, у тебя есть дорога из столицы одного государства в другое. И ты такой «ебать, а если я буду ехать по дороге в одном государстве и по этой же дороге в другом государстве одновременно — я доеду вдвое быстрее!»

> Идея огонь, братан. Теория удвоения наоборот. =)

Хуевая аналогия, даже близко не отражающая суть вещей.

Правильная будет такой: у тебя есть груз массой Х, который нужно перевезти. Ты можешь либо взять старую мощную лошадь, либо двух молодых лошадок. Старая мощная лошадь должна дотянуть груз в соло без проблем, но её продаёт на рынке мутного вида цыган и гарантий, что она не сдохнет наутро после продажи, нет. Молодых лошадок продаёт заводчик с репутацией, но их потребуется две штуки на тот же объём груза при сравнимой скорости доставки. Поскольку лошадки молодые, они будут друг другу в упряжи немного мешать, но в целом с задачей справятся.

> Если у тебя охуеть какая быстрая память, и один чип видяхи физически его не вытягивает, то напрашивается вывод расшарить память одной видяхи другим — и пусть несколько чипов работают вместе, да?

Память у каждого из чипов своя, обмен данными между чипами минимален (но он есть, да).

> Только вот ты не можешь этого сделать на вменяемых скоростях в потребительском сегменте.

> И памяти у тебя такой нет, окда?

> Расслабься, нет ни одной причины, чтобы ты мог распараллелить одну цельную модель, которая физически работает последовательно.

> Можно сослаться на MoE-структуру, где ты запускаешь разных экспертов одновременно. Но это другое.

> Они.

> Не.

> Параллелятся.

> Концептуально.

По-моему ты совсем не понимаешь как работают нейросети. Вот вообще. Основная их черта, из-за которой мы сейчас и переживаем очередной нейросетевой бум - как раз мощный параллелизм, когда разные части сети можно обсчитывать одновременно и независимо от остальных. Если бы сети считались последовательно, мы бы их на процессорах гоняли.

Даже странно такие базовые вещи здесь объяснять.

> Вообще, я в ахуе, насколько тред скатился за месяц. Пришли десятки людей, которые нихуя не понимают в вопросе, их обучают какие-то шизы, которые нихуя не понимали никогда ничего в вопросе, и результат просто охуенный. =) Как на той пикче с пионерами и конем.

> Дякую, шо вовремя отсюда ушел.

Пожалуй, единственное высказывание в твоём посте, с которым я согласен. И хорошо, что такие как ты уходят, а приходят те, кто реально шарит в теме.

> Так-то P100 с 16 гигами и Exl2, ну и там еще целая пачка карт, и так далее, и тому подобное. Все уже посчитано до вас, ссыль на реддит где-то лежала в прошлых тредах.

У P100 по современным меркам очень дохлые ядра и подсистема памяти. За свои гроши они ещё пойдут, если есть желание пострадать, но все-таки если есть возможность лучше рассматривать что-то более-менее актуальное.

> Ну ты собери дома сервак на 8 H100, раскидай NVlink, запусти TensorRT — и будет как ты хочешь. =) Никто не против.

Так и я не против! Денег дайте только. Выход на поставщиков железа у меня есть, что угодно привезут. Вопрос в финансах.

> Плюс, тебе про батчи сказали.

Это не то...

> Запросов прилетает миллион. Один запрос проходит по первой GPU, уходит условно в другую GPU, второй запрос приходит на первую и начинает обрабатываться. В среднем, работают все видеокарты сразу, но - последовательно. Это может работать по-другому в одном единственном случае - ты накатил DS. Но тогда придётся отказаться от llamacpp, exllama, и что там ещё есть. Голые трансформаторы нужны.

parallelformers в помощь.

> Где-то вдвое, плюс-минус.

Процентов на 30, в лучшем случае.

> И эта разница в лучшем случае будет неизменной при наращивании количества 3060, хоть их у тебя будет 10. Но мы живём в реальном мире, так что скорость будет падать.

Эх, молодежь...

>При использовании параллелизма

То есть при нескольких запросах сразу. Чего нет дома.

>как раз мощный параллелизм

В теории. На практике нихуя.

>Если бы сети считались последовательно, мы бы их на процессорах гоняли.

У процев шина узкая.

>У P100 по современным меркам очень дохлые ядра и подсистема памяти.

И тут я понял, что ты ебучий даун, который не может заглянуть даже в спеки

>Полоса пропускания стековой памяти CoWoS с HBM2 732 ГБ/с

Это ебёт почти все современные потребительские карты, кроме 3090/4090.

Так что лучше может ты срыгнёшь нахуй?

Аналогия была про распарелливание модели, а не про видеокарты. =) Так что, критика не к месту, но пример хороший.

И на ответ «стоит ли риск выгоды» ответ дает каждый сам для себя. Сугубо индивидуально.

> По-моему ты совсем не понимаешь как работают нейросети. Вот вообще.

Показалось.

Это мои оппоненты не понимают, и радостно параллелят последовательные вычисления, игнорируя, что результат получается при пробежке по всем слоям, а не отдельно друг от друга. =)

Там даже визуальное отображение принципа работы нейросетей было.

Полагаю, ты просто не уловил, что я имел в виду, поэтому объясняешь не связанные вещи.

> Пожалуй, единственное высказывание в твоём посте, с которым я согласен. И хорошо, что такие как ты уходят, а приходят те, кто реально шарит в теме.

Ну, видимо, ты во всем посте понял одну единственную вещь.

Жаль, что вывод сделал противоположный реальности.

Скажи мне одну вещь, это ты — антитеслошиз, у которого pcie никак не влияет на обработку контекста?

Ну, в общем, очень печально видеть именно таких как ты, которые тред у били своим непониманием.

От тебя такой стойкий вайб чела-в-теме, но при этом, даже банальные логические выводы своих собеседников ты не способен понять, отвечаешь вообще не на то, о чем писал я (я-то тебя понимаю, и не оспариваю твои утверждения, но они не имеют отношения к обсуждаемой теме, вот в чем беда), и люди начинают верить, что вот есть он, магический способ распараллелить работу на двух 3060…

Только за два года, почему-то, ни один разраб это не сделал, вот дурачки, да?

И опять же, не то чтобы ты это утверждал. Вся проблема в miccommunication между умными ребятами, тобой, и новичками.

Ладно, я дальше пойду, тут уже как бы все. Приятно параллелить две 3060, стойкий паритет с 3090 наблюдаем. тумбс_ап

>parallelformers в помощь.

Охуенный совет - используйте замшелое говно мамонта, которое не поддерживает современные модели. И да, там параллельность только в названии, на деле всё то же, что делает жора.

>Процентов на 30

https://www.reddit.com/r/LocalLLaMA/comments/1augktf/rtx_3090_vs_rtx_3060_inference_comparison/

Первая ссылка в гугле. Двукратная разница. И, как нам уже очевидно, от количества 3060 скорость не изменяется.

>радостно параллелят последовательные вычисления

К слову, жора, как я понимаю, хотел добиться именно параллельной работы, разбивая тензоры по видеокартам вместо слоёв. Но расходы на синхронизацию ебут всю выгоду.

> >При использовании параллелизма

> То есть при нескольких запросах сразу. Чего нет дома.

Вы чего все в батчи уперлись? Других вариантов параллелизма не знаете? Горизонтальные срезы вместо вертикальных, параллелизм по тензорам? Не, не слышали?

> У процев шина узкая.

У современных? Да нихуя.

> Это ебёт почти все современные потребительские карты, кроме 3090/4090.

Тьфу блядь, ты про теслу р100, а не про майниговые обрезки. Так бы и сказал, здесь Теслы и Квадры не обсуждают. Она стоит как крыло от самолёта до сих пор, нахуй не нужна.

> Так что лучше может ты срыгнёшь нахуй?

Нет ты.

> Полагаю, ты просто не уловил, что я имел в виду, поэтому объясняешь не связанные вещи.

Я отвечаю по существу, а не по форме. Жалко, что ты этого не понял.

> Только за два года, почему-то, ни один разраб это не сделал, вот дурачки, да?

Вот прямо по ссылке в прошлом треде есть описание методов распараллеливания и ссылки на инструменты, которые в эти методы умеют. То, что ты два года ничего, кроме таких же экспертов с двача, не читал и не в курсе современных трендов, тебя не оправдывает.

> хочешь сказать, что у условного OpenAI в условном датацентре в один момент времени работает только одна-единственная H100

Батя в здании, сейчас все поясню.

В условной гопоте 4 которая оче большая МОЕ на одну модель задействуется несколько карточек. И действительно при запросе, учитывая что разные части слоев лежат на разных гпу, будет нагружена только часть из них а остальные простаивать. Поскольку выбранные эксперты будут постоянно меняться, в мониторинге это будет выглядеть как частичная загрузка всех карт на условные 25%. В случае с чмоней, которая оче мелкая, там все слои крутятся на одной видеокарте, максимум на двух, и будет или полная загрузка или аналогично первому случаю но со скидкой на количество карт.

> На том же реддите люди описываются, что нормально нагрузка параллелится, практически линейно количеству карт.

Ноды у тебя работают независимо друг от друга, чем больше их тем больше параллельных запросов ты обработаешь. То же самое на локалке делаешь, запускаешь на каждой (группе) гпу свой бэк, пишешь простейший код для распараллеливания запросов и обрабатываешь что-то массово.

Но при этом, нельзя ускорить инфиренс одного запроса задействовав больше железа. На самом деле можно, просто это будет совершенно неэффективно с малым эффектом при удвоении задействованных мощностей

> Одна 3090 в любом случае будет быстрее двух 3060, но не так уж сильно.

Сильно

Это буквально сейм что несколько запросов параллельно, при обучении батчи можно раскидывать по разным гпу, которые делают проходы независимо друг от друга, и уже по завершении шага собирать насчитанные лоссы вместе для расчета новых весов. Или могут быть некоторые вариации, которые хорошо описаны в документе. Для инфиренса подобное не релевантно.

> стоит ли риск выгоды

Yolo же, если суждено ей сдохнуть то и 3060 подохнут.

Вообще действительно 3060 холодные и простые, их можно рискнуть а даже через доставку поверив на честное слово взяв. С 3090 же нужно тщательно смотреть-проверять, а с доставкой устраивать сеансы видеосвязи, и то лучше их избегать и попросить друзей купить.

Но разница в перфомансе (особенно когда захочешь нет олько ллм поюзать) и потенциале с точки зрения наращивания мощностей там просто огромна и игра стоит свеч. Многие вещи банально не сможешь запустить на 3060, или с костылями что убьют все, которые тебе сначала еще придется самому написать для разделения между гпу.

> И хорошо, что такие как ты уходят

Да это же смайлофаг что по каждому вопросу что-то пукает но все больше мимо, неудивительно.

> Охуенный совет - используйте замшелое говно мамонта, которое не поддерживает современные модели. И да, там параллельность только в названии, на деле всё то же, что делает жора.

Обнимилицо пишет, что поддерживаются все модели в режиме инференса. Им я верю больше, чем анониму с двача. Ну и это далеко не единственный инструмент.

> https://www.reddit.com/r/LocalLLaMA/comments/1augktf/rtx_3090_vs_rtx_3060_inference_comparison/

> Первая ссылка в гугле. Двукратная разница.

Так никто не спорит, что одна 3060 медленнее одной 3090 вдвое. Чего ты этой ссылкой сказать хотел?

> И, как нам уже очевидно, от количества 3060 скорость не изменяется

Пока что мы сошлись на том, что скорость масштабируется почти линейно (за вычетом накладных расходов). Откуда ты взял про "не изменяется", я не понимаю.

> К слову, жора, как я понимаю, хотел добиться именно параллельной работы, разбивая тензоры по видеокартам вместо слоёв. Но расходы на синхронизацию ебут всю выгоду.

Той синхронизации там хуй да нихуя.

Скачал потестить. Не ожидал такой клоунады. В версии 1.4 он просто соглашался и всё. Блин даже желание покумить пропало, петросяны чёртовы.

> parallelformers в помощь.

> Last commit 2 years ago

Чем это лучше нескольких строк кода что будут обращаться к пачке запущенных современных бэков? Это же тупо обертка, которая в современных реалиях может начать срать проблемами.

> Пока что мы сошлись на том, что скорость масштабируется почти линейно

Тут как в меме "да, но...", медленный чип и память сделают обработку контекста невыносимой. А если юзать с жорой то там еще само количество гпу негативно влияет на скорость, а костыли что ускоряют релевантны только для некроты и на малых контекстах.

Накинь туда карточку какого-то серьезного чара и заставь убить тебя.

>Им я верю больше

А кому не похуй, во что ты там веришь? Код не обновлялся три года и есть полный список поддерживаемых моделей. Геммы, квена, лламы 3, мистралей там нет. А раз коду три года, то никакой поддержки SWA, нестандартных активаций и т.д. там нет. И ни одна современная модель не заведётся. Молчу уж про кванты.

>далеко не единственный инструмент

Единственный инструмент, с которым сейчас можно запускать модели действительно параллельно - это DS. Других нет.

>скорость масштабируется почти линейно

Опять же, со своей верой в сказки - ты тредом ошибся. Скорость не масштабируется вовсе. Уже было видео с пачкой 4060, где скорость с одной картой и с шестью или восемью, точно не помню, была идентичной.

>Той синхронизации там хуй да нихуя.

Её там дохуя, не столько объёмы, сколько регулярность. Благодаря задержкам pci-e это даже в теории не может работать хорошо.

>Last commit 2 years ago

Так это коммит в ридми, небось список неподдерживаемого обновляли. Код коммитился три года назад.

> Единственный инструмент, с которым сейчас можно запускать модели действительно параллельно - это DS

Чтоэта?

> Скорость не масштабируется вовсе.

Наверно он имел ввиду что можно складывать несколько гпу для загрузки больших моделей и скорость большой будет скейлится линейно относительно мелких без значительного штрафа за распараллеливание.

> Её там дохуя, не столько объёмы, сколько регулярность. Благодаря задержкам pci-e это даже в теории не может работать хорошо.

Почему же тогда разделение заведомо мелкой модели на несколько гпу показывает почти идентичную скорость что и при работе на одной? Или запуск более крупной дает прогнозируемую, если пересчитать по размеру модели, скорость вместо того самого "не хорошо"?

>Горизонтальные срезы вместо вертикальных

Не работают.

>У современных? Да нихуя.

Ебанат х2. Максимум 100ГБ/с против 360 у сраной 3060.

>Тьфу блядь, ты про теслу р100

Контекст кончился? А я напомню

>У P100 по современным меркам

Чётко и ясно, P100.

>здесь Теслы и Квадры не обсуждают

Ебанат х3.

>Она стоит как крыло от самолёта

Дороже, чем надо, но не крыло нихуя. Ты опять не в теме.

Да, если что это про трансформерсы или экслламу, жора обсирается на контекстах и с его качеством работы маздай.

> Да, если что это про трансформерсы или экслламу, жора обсирается

> К слову, жора, как я понимаю, хотел добиться именно параллельной работы, разбивая тензоры по видеокартам вместо слоёв. Но расходы на синхронизацию ебут всю выгоду.

Блять в глаза ебусь, все, вопрос снят.

>>DS

>Чтоэта?

Хороший тест, как отделить ньюфага с претензией от шарящего в МЛ анона. Кому надо, тот знает, а кто не знает, тот даже нагуглить не сможет. Даже нейросети обсираются (зато сколько вспуков про АГИ!).

>Чтоэта?

Дипспид же. Под виндой работать не желает, ведь его сделал майкрософт, кванты в рот ебал и дальше по списку. На потребительском оборудовании прирост скорости относительно дефолтных трансформеров в несколько раз даже без параллельных картонок.

>скорость большой будет скейлится

Так в том и дело, что скорость - не скейлится. Ты можешь стакать vram и всё на этом. Или что, чип волшебным образом начнёт работать быстрее на крупных моделях? Это же всё тестировалось - берёшь модель, которая влезает в одну карту, суёшь в одну. Получаешь т/c. Распихиваешь на две и получаешь плюс-минус те же т/c. Смотришь в графики загрузки GPU и понимаешь, в чём дело.

>показывает почти идентичную скорость что и при работе на одной

С жоровским ровсплитом модель дробится по строкам, технически это разбиение тензоров для параллельной обработки. То есть у нас должно быть то самое линейное ускорение. А его нет, потому что расходы всё пожрали. Со слабыми чипами, когда скорость обработки слоя оказывается слишком долгой, это может дать небольшой буст, процентов 5-10 скорости, не больше.

>про трансформерсы

Трансформаторы в ванильном виде - полный пиздец. Оно даже не умеет в равномерное выделение памяти на множестве GPU при обучении, т.к каждая карта имеет веса и состояния оптимизатора со всей служебной требухой. Но вычисляется эта требуха на GPU0, потому там должно быть памяти в три раза больше, чем на остальных, в итоге у тебя может быть ООМ, но свободной памяти дохуя и ещё немного.

>Накинь туда карточку какого-то серьезного чара и заставь убить тебя.

В общем потестил. Бредогенератор. Как и ожидал, эта версия 2.0 неюзабельна, всё же лучшая 1.4 пока что, если про эту модель говорить. Она не только убить, но зачем-то предлагает способы сделать это с кем-то ирл. Вообще не в тему. Для неё отсутствие цензуры почему-то считается призывом к жести. Удалил.

Как токены из словаря превратить в числа для математической обработки?

Задать каждому токену рандомный вектор и модифицировать его в ходе обучения?

Задать каждому токену рандомный вектор и модифицировать его в ходе обучения?

Ну давай расскажи, ухватывающий верха без понимания сути терминодрочер, что это такое. В контексте ллм так сокращают дипспид (или вообще датасет), а это что за покемон?

> процентов 5-10 скорости, не больше

Сорян, вернусь в тред на секунду.

На старых теслах 30% ров_сплит дает, весьма годно.

Плюс графики энергопотребления выравнивает красиво.

Для бомжей годная технология.

>На старых теслах 30% ров_сплит дает, весьма годно.

Я бы даже сказал, что скорость генерации возрастает почти вдвое. А вот обработка контекста (и так слабая) сильно проседает.

>Задать каждому токену рандомный вектор и модифицировать его в ходе обучения?

Да.

Чел, я другой анон, ты воюешь не в ту сторону. И да, я про дипспид.

> Дипспид же.

Ну а он тут вообще каким хером? Он прежде всего про оффлоад частей, стейтов оптимайзера а то и основных весов из видеопамяти при обучении, а не про "распараллеливание". И используется соответствующим образом чтобы впихнуть невпихуемое, ускорение от него получить не то чтобы невозможно но часто эффект эфемерен, по крайней мере на моделях что вмещаются в единую гпу. А сколько эта штука жрет рам - даже не надейся запустить ее на потребительской платформе кроме совсем мелочей.

> Или что, чип волшебным образом начнёт работать быстрее на крупных моделях?

Об этом нигде и не писалось.

> берёшь модель, которая влезает в одну карту, суёшь в одну. Получаешь т/c. Распихиваешь на две и получаешь плюс-минус те же т/c.

Именно. Но при этом если закинуть большую модель то она будет перформить пропорционально размеру параметров от скорости мелкой.

> А его нет, потому что расходы всё пожрали.

На самом деле там нет этих расходов. Все разы что тестил оно давали лишь некоторый прирост на малых контекстах а потом нахуй сливалось. По мониторингу что кажет nvtop шины были задействованы слабо. Офк может там в жора-коде идут обращения скачками а не асинхронно, что приведет к тому что мониторинг тут не релевантен и все будет упираться в 100% шины 10% времени, но пары х16 3.0 ему хоть для какого-то эффекта должно же хватать.

> Оно даже не умеет в равномерное выделение памяти на множестве GPU при обучении

Умеет, нужно девайс конфиг ему скормить.

Там больше проблемы с точки зрения неэффективного расхода памяти на многих оптимайзерах, а если решишь peft потренить - оно сожрет с десяток лишних гигов которые вообще не будут задействованы.

> т.к каждая карта имеет веса и состояния оптимизатора со всей служебной требухой

Веса каждая карта и должна иметь, ты посмотри как именно распараллеливается по дефолту. Карты просто работают независимо друг от друга и на каждом шаге обновления весов результат обобщается и они синхронизируются.

Ну сорян, быканул, подгорело с таких ахуительных заявлений. Лучше расскажи про ту самую тру параллельность дипспида.

Больше чем написано в ридми репозитория я не расскажу.

А на тридцатках я наблюдал отрицательную выгоду. Такой вот забавный зверёк этот жора. Но я итт его хвалил и буду хвалить. И того некроманта, который в команде занимается теслами с прочим некрожелезом.

>Ну а он тут вообще каким хером?

Тем, что он единственный умеет в параллельность. И да, для инференса тоже.

>Он прежде всего про оффлоад частей

Ага, именно поэтому оффлоады это отдельные модули дипспида, а не основной код.

>По мониторингу что кажет nvtop шины были задействованы слабо.

Датчик загрузки шины считает bandwidth. Если у тебя гоняются данные часто, но по чуть, то там нихуя не будет. А задержка она всегда есть, загружена шина или нет.

>Умеет, нужно девайс конфиг ему скормить.

Я с этим ебался пару вечеров, там ничем не спасти, никакими конфигами. В итоге трансформеры это хорошо, но рабочий код переопределяет трансформеры и работает с другой логикой.

>каждая карта и должна иметь

В этом и суть. На каждой карте веса, копия оптимизатора и прочая хуйня. Чисто по логике расход vram на картах должен быть одинаковый. Но на первой карте этой хуйни больше, потому что только первая карта вычисляет эти данные и хранит дополнительные буферы для расчётов. А на остальные карты все данные просто пересылаются и там буферов нет. Разница в расходе vram - х3, может было бы и больше, но ООМ.

>А на тридцатках я наблюдал отрицательную выгоду. Такой вот забавный зверёк этот жора.

Мне интересно, как тридцатки (хотя бы и 3090) работают в параллель с одной или несколькими теслами. Особенно в плане обработки контекста. Если такую тридцатку как GPU0 поставить, то по идее толк должен быть.

> Тем, что он единственный умеет в параллельность. И да, для инференса тоже.

Хм, они запихнули эти подходы для инфиренса, довольно интересно. И как оно по факту работает, действительно ли ускорение пропорционально количеству, или как повезет?

> Если у тебя гоняются данные часто, но по чуть, то там нихуя не будет.

Об этом и речь.

> А задержка она всегда есть, загружена шина или нет.

У псины она небольшая, это нужно совсем треш набыдлокодить и вообще не использовать асинхронные фишки куды чтобы основной расчет вставал. Ну или делить по-пахомовски чтобы асинхронная работа была невозможна.

> Я с этим ебался пару вечеров, там ничем не спасти, никакими конфигами.

Всмысле? Там буквально сколько заказал столько и распределяет, причем с учетом специфики раходов и для инфиренса, и для обучения. Даже простой авто распределяет почти полностью равномерно, в отличии от жоры где первая гпу сильно перегружена.

Для особых случаев там достаточно подробно в классе можно описать что и как делать вплоть до применения разгокалиберных гпу.

> Но на первой карте этой хуйни больше, потому что только первая карта вычисляет эти данные и хранит дополнительные буферы для расчётов.

> Разница в расходе vram - х3

Какой-то просто ультимейт быдлокод, что за случай? Не то чтобы с трансформерсами ллм много тренил, но всегда они адекватно распределяли по карточкам что в случае дробления на куски (скорость такая что не захочешь), что при просто наращивании батчсайза на нормальных гпу. Точно пефта какого-нибудь не было? В нем был баг на который коммит почти год висит и всем похуй.

> или несколькими теслами

> Особенно в плане обработки контекста

Никак, все будет плохо. Лучше чем чисто с теслами, но всеравно плохо.

> то по идее толк должен быть

Нет, быстрый расчет контекста возможен только если слои лежат в своей врам. 3090 не ускорит работу что лежит на теслах.

>Задать каждому токену рандомный вектор и модифицировать его в ходе обучения?

>Да.

А как определиться с размером вектора? Как я понимаю, он может быть меньше размера словаря в общем случае, тк синонимы можно описать очень похожими векторами.

> Опять же, со своей верой в сказки - ты тредом ошибся. Скорость не масштабируется вовсе. Уже было видео с пачкой 4060, где скорость с одной картой и с шестью или восемью, точно не помню, была идентичной.

О, а я помню этот видос.

Там долбоеб брал маленькую модельку, которая влезала в память одной карты, и пытался её заставить работать на нескольких. В итоге из этих 6 или 8 у него работала только одна, о чем ему в первом же комменте под видео написали.

А местный даун, который это видео принёс, даже не посмотрел ни его, ни комменты к нему.

Тебе сюда: https://www.youtube.com/watch?v=zduSFxRajkE

Толк есть, и чем больше тридцаток вместо тесл - тем больше толка, лол. С ровсплитом 30хх + тесла не проверял, но с разбивкой по слоям всё суперхуёво было, тесла грузилась процентов на 70, а тридцатка вообще на копейки, что-то около 15-20%. Подозреваю, что с ровсплитом будет загрузка теслы на соточку, тридцатки ещё на 5% больше и скорость всё равно упрётся в теслу.

Шифти контекст, чтобы пересчёты не заёбывали.

Частенько хочу вычислить размер дрифта при шифтах, но руки не доходят.

>или как повезет?

Скорее как повезёт. Если есть пачка одинаковых GPU и не планируешь гонять кванты, то DS это топ. Если карты разные, если они не sxm, если ты не под линуксом - возникают вопросики по целесообразности.

>У псины она небольшая

У третьей около 300нс, причём синхронизаций ебелион. А пока синхронизация не произойдёт - чуда не случится. Если строка просчитывается быстро, то эти задержки уже дают отрицательное ускорение и лучше синхронизацию устраивать реже и послойный сплит даёт больше выгоды.

>Какой-то просто ультимейт быдлокод, что за случай?

Ванильные трансформеры, пефта, вроде не было. Давно это делал, с тех пор уже настроил DS и кайфую. У них в гитхабе находил, пишут, не баг, вонт фикс, используйте оффлоады.

>с размером вектора?

Чем больше, тем точнее модель сможет определять разницу между токенами, при условии достаточного обучения. Можешь погуглить размерность моделей, посмотреть в готовых моделях и т.д.

>из этих 6 или 8 у него работала только одна

Не, одна карта из всех работает только у долбоёбов, которые смотрят видео жопой и не видят графиков загрузки GPU. Да и коммент там первый совсем не про это, там же не настолько дегенераты сидят, как в этом треде.

Сколько влезет в железо, столько и делай.

>Тем, что он единственный умеет в параллельность. И да, для инференса тоже.

Жора кстати тоже умеет. На двух теслах скорость обсчёта контекста почти удваивается. Правда с бОльшим количеством карт это не работает. Ну то есть всё равно быстрее, чем на одной, но медленнее, чем на двух. И чем больше карт, тем медленнее...

А есть нормальный гайд по лорбукам?

Как думаете, будет ли ллама 4 на 8б, так как даже сейчас ллама 3.2 уже на 11 и 90б.

Так в 3.2 они так же 8В и 70В.

В доках таверны. И там же в further reading есть ссылка на какой-то типа более подробный, но тот чутка устарел.

https://docs.sillytavern.app/usage/worldinfo/

Вообще на основные вещи прямо в таверне есть всплывающие подсказки.

Я чет видел что есть только 11б и 90б модели, понял

Ну да, поискал, поспрашивал, господа удивлялись не меньше чем сам тем что оно где-то популярно используется для инфиренса. Может быть действительно нужны подходящие кейсы, но у одной злой корпорации собственное решение без подробностей без 16битной точности но без дипспида.

> Если есть пачка одинаковых GPU и не планируешь гонять кванты, то DS это топ

> если они не sxm

Ну собственно тогда все и сходится, юзкейс крайне специфичен.

> А пока синхронизация не произойдёт - чуда не случится. Если строка просчитывается быстро

Потому и нужно миксимизировать части, пригодные для расчета параллельно, минимизуруя количество обменов и ожидания. Если там такая мелочь что 300наносекундные задержки дают отрицательный рост то нет смысла.

> с тех пор уже настроил DS и кайфую

О, поделишься конфигом в общих чертах? И заодно примерные требования к памяти.

> У них в гитхабе находил, пишут, не баг, вонт фикс, используйте оффлоады

Типикал впопенсорс момент.

выпнул теслы на мороз на лоджию.

Когда опускается в 0 - показывает ERR, лол.

Вот и прошла осень блять... все уже в снегу.

Почему-то моя сборка хуево работает с SD. При попытке использовать LORA автоматик просто виснет и падает.... буду расследовать сейчас.

Когда опускается в 0 - показывает ERR, лол.

Вот и прошла осень блять... все уже в снегу.

Почему-то моя сборка хуево работает с SD. При попытке использовать LORA автоматик просто виснет и падает.... буду расследовать сейчас.

Ты с этим осторожнее. Из-за сути относительной влажности при попадании холодного воздуха в теплое помещение воздух будет сухой, а если наоборот - будет везде конденсат и повышенная влажность, балкон как раз тот случай.

> Почему-то моя сборка хуево работает с SD.

Некрота вместо видеокарты, которая нативно не может в дробную точность, действительно почему же? Говорили же что надо было нормальные карточки брать, с учетом дисконтирования на продолжительный срок затраты ерундовые а qol на порядок лучше.

Немного улучшить ситуацию можно переключив везде в принудительный апкаст в фп32. Также попробуй еще фордж/рефордж, возможно какие-то из встроенных костылей помогут.

да тащемта я кажется понял, в чем дело.

Автоматик какого-то хуя хочет лору подгрузить в оперативку вместо памяти карты, которой у него дохуя.

> с SD

Этот мусор в SD будет хуже чем затычка 3050, лол.

>я ухожу

>нет, я ухожу!

в итоге оба сидят и дрищут в тред стенами текста которые никто не читает

>нет, я ухожу!

в итоге оба сидят и дрищут в тред стенами текста которые никто не читает

Кстати вообще да, большинство интерфейсов для своих "оптимизаций" опирается на оперативу выгружая туда все по возможности. Это может оказаться проблемой в данном случае.

Кто собирался срыгспок оформлять?

Разве 3.2 это не те же самые 3.1 + зрение сбоку?

Анончики, родные, пытаюсь вкатиться в локалки, скочал https://huggingface.co/anthracite-org/magnum-v4-22b-gguf в четвертом кванте, а он аполоджайсит на ваниль. Как чинить? Может я не так настроил что-то? У меня нет дефолт пресета в Instruct Template, как они рекомендуют, и я выбрал Мистраль v2&v3, решил, что это подойдет, так как это файнтюн Мистраля. В систем промпте пусто.

Ну так пропиши дефотлтную пасту в систем промт, про то что любые темы доступны для рассуждения и бла бла бла. Ну либо загазлайть модель, изменив ее первые два сообщения с аполоджаза на "йес шур айл ду энифинк".

Кто уже тыкал https://si.inc/hertz-dev/ , какано? Превьюхи выглядят бомбически, но на то они и превьюхи.

Чёт кекнул с их способа распространения весов.

Хз-хз, не смогу сказать точно. Но там же это мультимодель

Это оно и есть. Дефолтная перегретая лама + зрение.

Русик поддерживает?

>выпнул теслы на мороз на лоджию.

А я всё-таки не удержался и купил к своим четырём ещё и 3090. В моём районе продавали - пешком дойти можно было и всё проверить, как тут устоять. Докладываю: связка 3090 с одной или несколькими P40 работает хуже, чем без 3090. Ровсплит тащится со скоростью черепахи, а mmq вообще не ускоряет контекст. Вынул 3090 из сборки, поставил теслы обратно.

Но не жалею, поставлю 3090 в основной комп - SD и мелкие подручные сетки летать будут. А если сыграют сверхплотные кванты, как тот же QTIP - докупить ещё одну не так уж сложно, и не придётся колхозить риг.

Чому я родился таким нищим.

Все родились нищими, просто некоторые смогли заработать. Ты не смог, уступи место тем, кто может.

Столик зачётный :)

Стак из четырнадцати 3090 плюс сопутствующие расходы это всего около ляма рублей. Если ты устроен даже на среднюю по меркам дс работенку, то за год такую сумму легко можно осилить. По этому тут дело не в том, нищий ты или нет. Вопрос в том, надо ли тебе это. А если надо, то ты всегда можешь накопить.

Так уж выходит что почти все кто могут себе такое позволить для нейронок и практикуют - поднялись с низов, а кто родился не-нищим - тому не интересно подобное.

Сначала братишки выпендриваются как им хорошо халтурить или рннить, а потом продолжают ныть с того что нет возможности удовлетворять свои хотелки а для комфортного заработка нет ни знаний ни опыта.

Вроде как мультилингвалка, но я сам не тыкал.

По файнтюну тоже пока непонятно, не хочу голос "Боба" слушать, хочу тянучку какую-нибудь.

Локально нормальную ЛЛМ не поднимете. Вкатывайтесь в Sonnet 3,5 Claude напрямую с ВПН и получите доступ к расцензуренной нейросетке с мощностью и мозгом, какую сами не соберете ни за что.

Ты здесь недавно?

Даже про существование раздела не знал. Залетел из форчонговских силлитаверн тредов. Оплатить дяде по цене гораздо подъемнее, чем собирать мегазорда за миллионы.

>и получите доступ к расцензуренной нейросетке

Я конкретно 3,5 не пробовал съебался с кончай треда окончательно с полгода назад, но уверен, что она у меня аполоджайз выдаст прямо на карточку.

Ах да, давай нормальную инструкцию, желательно в клодотреде просто так я его что ли создавал?

Почти 123B магнума. Я уже оказывается третий месяц только на нём и сижу, даже мыслей уйти нету.

>Оплатить дяде

Так, стоп, за цензурное корпоговно ещё и платить нужно? Ну нахуй.

Ну тогда давай краткую вводную дам:

У большинства здесь есть доступ ко всем закрытым моделям корпоратов (почти) без ограничений и локальные модельки катают или по фану, или потому что они лучше, а не в погоне за ценой.

Еще год назад локалки в конкретных кейсах могли обходить корпоратов, сейчас их качество сильно поднялось а у корпоратов стагнация или медленный прогресс.

Значительную деградацию выводов у клодыни или гопоты вносит джейлбрейк, без которого рп фактически невозможен, будут одни аполоджайзы. В локалках же у тебя и полный контроль, и возможность дообучения.

Приватность никто не отменял, вопрос спорный и есть совсем шизы-трясуны, но для некоторых вещей корпосетки действительно не подходят. Кроме того, с типичным доступом что получают братишки сейчас, оче высока вероятность наткнуться на ханипот и слить в открытый доступ свой диплом или личные данные вперемешку с рп, что уже несколько раз случалось.

xml-шикзики с инструкциями на 40 страниц для получения рестрикшена за "я тебя ебу" не имеют права голоса в этом треде, сорри

>Значительную деградацию выводов у клодыни или гопоты вносит джейлбрейк, без которого рп фактически невозможен, будут одни аполоджайзы.

Не стоит еще забывать, что на специализированных файнтюнях эта хуйня вообще не нужна, по этому ты еще и экономишь большое количество токенов. Ну и банально никто не закрутит тебе гайки в определенный момент, как это сейчас происходит с антропиковским говном. Когда все твои запросы будут фильтроваться на уровне сервера, тебе уже никакая прокся не поможет.

А как мне вообще соединять 4х5090, обязательно строить франкенштейна как ?

>тебе уже никакая прокся не поможет

Ну почему же? Можно делать прокси, которая вместо клода отвечает магнумом, лол. Тем более в датасетах многих тюнов куча клодовысеров, и локалки срут клодизмами по КД не хуже оригинала, так что обыватель даже не заметит. А когда я оттуда съебался, очереди на проксях были такие, что моя локал очка на 3080Ti была быстрее.

>4х

>франкенштейна

Да. Там ещё небось будет новый говноразъём питания, который в блоках питания почти всегда в количестве 1 штуки, так что придётся ещё и с синхронизацией нескольких блоков ебаться. В бытовом плане максимум это 2 картонки.

https://rentry.org/pixibots#claude-3-prompt

Пользовался вот етим джейлбрейком. Есть вероятность привлечь внимание дяди хуевыми промптами и словить перманентно усиленную цензуру, но я про такие примеры слышал очень мало. Если вливать деньги по чуть-чуть, то от потери одноразового аккаунта ничего почти и не потеряется. На 10 бачей можно прожить относительно долго.

Ну хуй знает, в моем джейлбрейке просто информация Клоду не страдать хуйней и притворяться чаром. Может, деградация и есть, а может, он от этой инструкции умнеет для цели РП.

Цензура на Клоде пока что минимальна, джейлбрейки работают на любых персонажей с любыми ситуациями. В будущем, может, гайки и закрутят, но пока что их нет.

>Вот оче высока вероятность наткнуться на ханипот

Вот ето наверно самое страшное, но пока что не замечал, откуда на него можно попасться. Карточки, джейлбрейки, все на вид чистое.

> тебе уже никакая прокся не поможет

Тогда уж никакой жб, если по смыслу. У жмини уже так, например вижн при намеке на канничку, даже тотали сфв, выдает тебе "неизвестные ошибки" не смотря на их "гибкие настройки цензуры".

В продаже цивильные закрытые корпуса, куда помещаются от 3 до 8 видеокарт с разным размерным рядом. Ты лучше подумай куда их будешь пихать и заодно найди райзер, который имея длину от 40 см хотябы в 4.0 стандарте не срал ошибками.

> он от этой инструкции умнеет для цели РП

Да, байасы серьезные вносятся. Некоторые вещи "улучшаются", некоторые наоборот деградируют.

Когда несколько раз к ряду словишь что в смысловой луп провалится и/или скатится в полнейшее уныние когда ты только настроился - вот тогда запоешь, и побежить подбирать или самому конструировать жб, пытаться во все фишечки-плюшечки-аддончики и прочее прочее. Локалки от этой проблемы тоже не застрахованы и свои также имеют, но внутренних противоречий из-за цензуры иметь не будут и все решается проще.

> Цензура на Клоде пока что минимальна

Нуууууууу, значит ты неофит и у тебя запросы столь скромны что любая нормальная модель даже средних размеров, вышедшая с весны, справится.

> Вот ето наверно самое страшное, но пока что не замечал, откуда на него можно попасться.

Прокси. Покупая у них прямой доступ ты в безопасности пока их не ломанут или они сами не сольют куда-нибудь. Но тарифы совершенно конские там.

Это стак из ужаренных в майнинге 3090 с отвалами памяти и кристалла. Никто в здравом уме беспроблемные 3090 за такие копейки не продаст

Цена 3090 - 60-70к. 60 и ниже - грустнота с текущими прокладками, памятью на 105 градусах, паршивой охладой. 70+ - в отличном состоянии и с приличной охладой. Иные мнения - далекая мухосрань, или нытье оправданцев.

Если взять в среднем по больнице 65 то выходит 910к. В лям тут никак не уложиться, но еще 100к сверху и будет норм, или требовать скидки за опт. Так что тот анон не сильно ошибся.

Чел в посте грустил не по поводу самой сборки, а по поводу цены вопроса. За лям ясен хуй можно взять что-то выгоднее и возможно даже оптом.

Как-то это сложно назвать настоящей параллельностью.

>где-то популярно используется для инфиренса

Простая ситуация - есть одна модель, которая гоняется без квантования в трансформерах. Подключение DS при прочих равных ускоряет непосредственно сам инференс втрое.

>поделишься конфигом в общих чертах?

Я не тренирую что-то большое, так что особо смысла нет.

Если бы я брал пачку 3090 на лям - проще было бы заказать паллет с тао. Дешевле и меньше шанс, что оно полыхнёт сразу же.

https://www.reddit.com/r/LocalLLaMA/comments/1gjq1y0/psa_llamacpp_patch_doubled_my_max_context_size/

Владельцам некросборок радоваться

Владельцам некросборок радоваться

Что там про спекулятивный семплинг слышно, анончики?

Спасибо, прикольная фитча. Попользовался ей пару дней, в таверне, пока не зашел в убабугу и не понял что её даже не добавили в ламму.

> при прочих равных ускоряет непосредственно сам инференс втрое

Скинь конфиг на попробовать.

Ты случайно не тот чел который в прошлых тредах понял что мы не не умеем пользоваться джеилбрейками и по этому пользуемся локальными ллм?

Pantheon-RP-Pure-1.6.2-22b-Small.i1 действительно в рп неплох, хотя 5тый квант всё же местами приходилось подправлять/свайпать. Надо шестой попробовать.

Мага-лектора из королевской академии магии "поюзали" дамы во дворце, и, не получив желаемого, обвинили в тёмных исскуствах. Но сюрпризом оказалось что он и правда занимался некоторыми дополнительными изысканиями, считая что магия - это инструмент, лишних знаний не бывает. Ему пришлось бежать, зато появилось больше времени. В один из "выходов в свет" к нему прицепилась эльфийка из рода охотников за магами, и упорно выслеживая добралась до самой системы пещер используемой в качестве базы.

Ну, время показать наглой остроухой почему нападение на Магуса в его собственной Мастерской - худшее, что вы можете в принципе придумать.

Уложился с закопчением эльфийки в CtxLimit:6402/8192

Aria.txt - https://pixeldrain.com/u/kZHXbjrN

Aria.card.png - https://pixeldrain.com/u/x9t6r18L

Карта модифицированная, с нарратором, то есть бот не персонаж, а гейм-мастер контролирующий персонажа. В общем случае так лучше получается взаимодействие персонажа с окружением, хотя тяжелее по токенам.

Мага-лектора из королевской академии магии "поюзали" дамы во дворце, и, не получив желаемого, обвинили в тёмных исскуствах. Но сюрпризом оказалось что он и правда занимался некоторыми дополнительными изысканиями, считая что магия - это инструмент, лишних знаний не бывает. Ему пришлось бежать, зато появилось больше времени. В один из "выходов в свет" к нему прицепилась эльфийка из рода охотников за магами, и упорно выслеживая добралась до самой системы пещер используемой в качестве базы.

Ну, время показать наглой остроухой почему нападение на Магуса в его собственной Мастерской - худшее, что вы можете в принципе придумать.

Уложился с закопчением эльфийки в CtxLimit:6402/8192

Aria.txt - https://pixeldrain.com/u/kZHXbjrN

Aria.card.png - https://pixeldrain.com/u/x9t6r18L

Карта модифицированная, с нарратором, то есть бот не персонаж, а гейм-мастер контролирующий персонажа. В общем случае так лучше получается взаимодействие персонажа с окружением, хотя тяжелее по токенам.

Всем похуй.

Жаль, что автора модели быстро прибрали к рукам разрабы AI Dungeon и теперь он ничего нового не выпустит.

>а у корпоратов стагнация или медленный прогресс

Ебать смешнявка, ты лламу 3 видел? Там в корень потёрли все NSFW из тренировочных сетов, кушай и не подавись, говно это правда #затобесплатно!!!

пы. сы. клауд или локал, так то вообще пох на обоих, обидно что здесь и там трут в угоду safety шизоидам из калифорнии или канады.

Пип инсталлом накати, там ничего сложного нет.

Хочу воткнуть в НАС GPU для небольшой LLM. В нас можно воткнуть максимум двухвинтовую видяху на 2 слота (сейчас там 950 стрикс) так что теслы с кастомными охладами срезу идут нахуй. Какую карточку туда можно сунуть? Пока присмотрел P102-100 10gb, есть что-то с большим vram и по вменяемой цене?

Если разделять слои на видюху и проц, то ни чип карты, ни проц не загружаются и на 50%, оперативы еще очень много свободной. Значит ли это, что подводит материнка? Или подводит кобольд, криво разделяя? Если материнка, то из-за pci-3.0? Если заменить на 4.0 будет ли лучше?

Забыл DS_BUILD опции и натравить трансформерса на нее.

Видеокарта простаивает пока процессор обсчитывает свою часть, это нормально. При расчете на цп идет упор в псп рам и поэтому ядра частично простаивают в ожидании загрузки новой порции. При этом, анкор и контроллер памяти загружены на 100%, в зависимости от софта для мониторинга он может и 100% загрузку проца показать.

Апгрейд гпу или установка дополнительной (и всеравно будет на 50% загружено).

Разве они должны вообще загружаться на 100 процентов? Моя 3060 максимум во время генерации загружается на 30-35%, а во время обработки контекста вообще до 5-7%. При этом все слои выгружены и заполнено 11 из 12 гигов видеопамяти и скорость 25 т/с примерно.

Сколько весит модель и чем мониторишь?

Модель весит 9 гигов, чекаю через HW монитор и gpu-z периодически.

Какая модель-то?

>Владельцам некросборок радоваться

Мы и радуемся. По идее, если допилят, то и скорость обработки контекста может увеличиться. Кто бы мог подумать, что из карт 17-го года можно столько выжать :)

Это, блять, шутка такая? Васяны не могли переназначить распределения по картам с дефолтного и серьезно сидели с 14 гигами на всех картах кроме одной?

Уровень современного говнокода неимаджинируем.

>Васяны не могли переназначить распределения по картам с дефолтного

Если имеешь в виду, использовали ли юзеры ключ tensor-split, то да, использовали. Может не все. Но дело в том, что раньше KV-кэш при ровсплите был не по слоям, и поэтому ровсплит улучшал генерацию, но ухудшал обработку кэша. Сейчас хотят сделать нормально.

>не по слоям

то есть не по строкам. Короче я так понял из обсуждения пула на Гитхабе, а там хз.

MN-12B-Lyra-v4, квант Q6_K

По заявлению в топике братишка очень рад тому что теперь оно само равномерно распределяет память по картам и можно загрузить больше не пытаясь выровнять самостоятельно. По скорости никакого буста нет по их заявлению.

> Сейчас хотят сделать нормально.

С дивана - там поможет только полный реврайт всего кода с выпилом основопологающих костылей, заложенных под метал и прочее. Но зачем если уже есть афтодит и эксллама.

>По заявлению в топике братишка очень рад тому что теперь оно само равномерно распределяет память по картам

Не совсем. В первом же абзаце:

"KV и другие нематричные веса распределяются между доступными графическими процессорами так же, как и в режиме разделения по слоям." - а раньше, стало быть, было не так. Что до выигрыша в скорости, то оно и правда ещё не допилено и более того - они хотят улучшить даже существующую послойную реализацию, что уже может подзатянуться и вызвать всякое непредсказуемое. Но лучше уж так.

Совсем, там буквально нытье что

> вот раньше первая гпу оомилась когда остальные только на 2/3 и не позоляла пустить больше контекст, а теперь с равномерным могу аж в 2 раза больше

а уже только потом объяснение как это удалось достигнуть про которое ты говоришь. Какбы к тому что сделали претензий нет, просто ор с того факта что парень не мог перераспределить память и загрузить полностью.

Улучшать - пусть улучшают конечно, может какие-то интересные техники разработают, что можно будет имплементировать и в других местах.

>Докладываю: связка 3090 с одной или несколькими P40 работает хуже, чем без 3090

ну... я же тестировал в связке с 3070...и там были результаты говна. можно было предположить, что скорее всего да, будет хуже.

Но спасибо, что проверил в любом случае.

Зато картинки можешь генерировать нормально, а не по пять минут.

Блять, жалко конечно что 3090 не бустит связку. Сука, обидно. Такой хак системы был бы заебатый...

В идеальных условиях там был бы средний перфоманс между теслами и 3090, в невозможных - микробуст сверху от переноса части расчетов на ампер. Но поскольку теслы оче старые, либы и прочее под них отличаются и даже фа изначально не должен работать - вот и выходит такая ерунда от смешения, или теслам идут вычисления в которые они не могут, или на 3090 шмурдяк.

> Такой хак системы был бы заебатый...

Да не может быть там никаких хаков, контекст как сосал так и продолжал бы сосать до полной замены на ампер и переход на человеческий бэк. Но здесь даже пропорциональное ускорение получить оказывается сложно из-за больших архитектурных отличий разных карт, правильно подружить их то еще искусство.

>правильно подружить их то еще искусство

Мне интересно, как будет работать связка 3090+4090. Случаи разные бывают, может попасться удачный вариант. Но не хотелось бы проблем из-за различий в архитектурах.

Отлично, скорость равна среднему значению между 4090-3090 или отклоняется в ту или иную сторону в зависимости от пропорции загруженных слоев. Либы те же, друг с другом дружат прекрасно проверено лично и подтверждено другими людьми. Что там будет с блеквеллом уже хз.

Так-то на них и тренить совместно можно, но без серьезных правок тренеров выйдет неэффективно ибо 4090 будет простаивать в ожидании пока закончит 3090, считай как две 3090.

> как будет работать связка 3090+4090

В худшем случае как 3090+3090

>теслы с кастомными охладами срезу идут нахуй. Какую карточку туда можно сунуть?

Ты можешь снять с Теслы её пассивно-продувной кулер и поставить кулер с турбиной от 1080 Ti (вроде ещё какие-то модели под пересадку подходят), который по посадочным местам совпадает. Полистай прошлые треды примерно за весну-лето, несколько анонов подобное делали.

На пике минимальный сетап для запуска лламы на 405b параметров? А куда втыкать всё это добро?

Как пишет автор это сетап для кучи автономных агентов работающих вместе. Поэтому им не нужно объединение, хоть каждую в свой комп суй.

Но скорей всего штуки по 2-3 на материнку сунет

Llamacpp поддерживает общение голосом?

Чтобы общаться с нейротян и заниматься своими делами.

Чтобы общаться с нейротян и заниматься своими делами.

кобольд умеет

Есть ли какие расширеня для бравзера, чтобы взаимодействовать с локальными моделями. Типа краткий пересказ странички и всё такое?

Всем привет. Ретард в треде. Я хочу поиграть в текстовую рпг с18+ элементами конечно со своей всленной придуманной. У меня некра пк (16 озу ддр3, видюха 4гб ддр5) и как понимаю на пк смысла нету заморачиваться. А на каком онлайн ресурсе лучше? Агнай?

Определение слову «локальные» вместе поищем в словаре?

Есть, где то видел

Только учитывай что для быстрого ответа на твой запрос может потребоваться минута-две при полной загрузке модели в врам.

В принципе это всё есть в Brave, там есть возможность подсоединить свою модель чрез openaiAPI с того же кобольда. Но все системные промпты захардкожены, а мне это не нравится, хочу управлять всем. Ну и плюс лимиты там тоже не редактируются, поэтому оно отсылает только часть страницы если она большая.

Ну не стукай

Попробовал использовать по очереди кобольд и угабугу, что бы сравнить. Одинаковые модели, одинаковые настройки что на таверне, что на кобольде с угабугой, один сид. Несколько карточек. Одни и те же вопросы, несколько раз свайпал, пока не повторит всё что хочет.

Результаты - разные. Кардинально разные. Угабуга как-будто процентов на 30% выдает более качественный, красочный текст. Это нормально, и кобольд сосет априори, или просто это с моей версией что-то не так?

И технический вопрос. Как ускорить обработку процессором? От чего больше всего зависит? От герцовки процессора, от ядерности, от pci, от ддрки оперативы, от герцовки оперативы? Вариант - засунь еще видеокарту хорош, но дороговат.

Результаты - разные. Кардинально разные. Угабуга как-будто процентов на 30% выдает более качественный, красочный текст. Это нормально, и кобольд сосет априори, или просто это с моей версией что-то не так?

И технический вопрос. Как ускорить обработку процессором? От чего больше всего зависит? От герцовки процессора, от ядерности, от pci, от ддрки оперативы, от герцовки оперативы? Вариант - засунь еще видеокарту хорош, но дороговат.

>Это нормально, и кобольд сосет априори, или просто это с моей версией что-то не так?

тебе надо сравнивать то, что пересылает угагуга на бэкенд и что пересылает кобольд на бэкенд.

Расширенный лог включи. Наверняка где-то в темплейтах различие.

Нет конечно. Абсолютно идентично туда всё шлется. А вот возвращается разное. И да, смотрел через инспектпромт, и перепроверял в консоли таверны.

Температура же 0 или Top-K 1 я надеюсь? Потому что иначе оно и будет тебе разное выдавать.

Хотя стоп, хуйню написал. Так будет выдавать одно и тоже даже на разных сидах.

Скорее всего так просто повезло, если выбрать просто llamacpp то семплеры у них схожи и в кобольде могут быть даже лучше. Как вариант - баги жоры, поломанные билды там норма а в llamacpp-python попадают немного реже.

Но, если выбрал llamacpp-hf то там уже семплеры гораздо веселее и это вполне ожидаемо.

> Как ускорить обработку процессором?

Псп оперативы и не-донность процессора. Обработка контекста же - псп + мощность ведер для перемножения матриц, здесь всякие тензорные модули и igpu в теории могут помочь.

> Вариант - засунь еще видеокарту хорош, но дороговат.

На процессоре переход на топовую ддр5 с йоба процом даст ускорение в пару раз относительно старичков на ддр4, но стоить будет как 1.5 3090, которая ускорит раз в 10.

Какой бекенд на угабуге?

Ну и скорость компе зависит от скорости памяти в гб/с

Так что если можешь то подразгони память, можешь в AIDA64 смотреть.

Еще может видеокарта, если ты с ней запускаешь, работать медленно. Если система не разгоняет ее частоты при работе нейросетей.

>На процессоре переход на топовую ддр5 с йоба процом даст ускорение в пару раз относительно старичков на ддр4, но стоить будет как 1.5 3090, которая ускорит раз в 10.

Скорость здесь конечно является краеугольным камнем, и действительно, видеокарта бустанет её раз в 10 за аналогичные день. Вот только объем вгружаемой модели не сопоставим. Если взять мои текущие 1.2 токена в секунду на 8x22 модель, и бустануть их за счет оперативы до 2.4 за 90к (а это мать + вторая видюха в варианте докупить видюху), то меня все устроит.

А вот вторая видюха вряд ли бустанет 8x22 до 2.4 ткоена

Попробуй выгружать 0 слоев на видеокарту и посмотри скорость - может будет даже больше

>А вот вторая видюха вряд ли бустанет 8x22 до 2.4 ткоена

Проблема 8х22B в том, что это всё равно 22B. 70B лучше, а 123В ещё лучше. А с ними у процессора и его памяти всё печально.

Не соглашусь. Конкретно эта модель, по пониманию контекста, велеречивости, креативности и красоте описаний уделывает все 70, что я пробовал. Со 123 соревнуется. Я про визард lm-2

Но да, и с 70 и 123, у памяти и процессора все еще хуже. 0.7 и 0.4

Если брать реалистичный кейс и юзать хорошую модель а не какой-то старый мое треш, то выигрыш будет как раз оче большим. В твоем же случае налог на глупость убеждения и страдания от 2 умножить на 0 бонусом.

Не пробовал нормальных моделей просто, даже лучшие тюны этого микстраля глупее той же геммы.

Я перепробовал примерно 2 теробайта самых популярных моделей.

Внезапный вопрос. m2 ssd имеет объем 2тб и скорость до 6гбит в секунду. ддр имеет скорость до 3гбит в секунду... А если...

Не. Теория хорошая, но 0.9 токенов. Видюха все таки дает прирост в 0.3 токена xD

Попробуй еще разное количество ядер процессора. Равное количеству физических и -1

Это интересно, но на кобальде у меня скорость на 8 ядрах меньше, чем на 7.

Но на llama.cpp на 8 скорость лучше, чем на 7.

Как эта магия работает - не ебу

Нет, все так же разница в 0.3

Нашёл карту которая хоть как-то смогла цундерить. Не на уровне лоли-икон архетипа конечно, скорее как защитная реакция заёбанной (фигурально) девушки высокого социального положения у которой слишком много "ты должна" и слишком мало "ты можешь".

https://pixeldrain.com/u/1rjyNuka Shiroyuki-hime.png

https://pixeldrain.com/u/GLoedYz7 Shiroyuki-hime.txt

Та же королевская академия что и из прошлой карточки. Общежитие для знати, комната на двоих, гг счастливо дрыхнет совершенно позабыв что сегодня начинается новый учебный год... а ещё, что сегодня должна приехать и заселиться в его комнату его невеста по договорному браку.

Без хентая, просто утро, завтрак, учебный день, экскурсия по кампусу.

Может потом вернусь, подправлю карточку для внесения саммари первого дня, и раскручу на какие-нибудь приключения юных Огненного Герцога и Ледяную Принцессу.

https://pixeldrain.com/u/1rjyNuka Shiroyuki-hime.png

https://pixeldrain.com/u/GLoedYz7 Shiroyuki-hime.txt

Та же королевская академия что и из прошлой карточки. Общежитие для знати, комната на двоих, гг счастливо дрыхнет совершенно позабыв что сегодня начинается новый учебный год... а ещё, что сегодня должна приехать и заселиться в его комнату его невеста по договорному браку.

Без хентая, просто утро, завтрак, учебный день, экскурсия по кампусу.

Может потом вернусь, подправлю карточку для внесения саммари первого дня, и раскручу на какие-нибудь приключения юных Огненного Герцога и Ледяную Принцессу.

Так это и не про 0 слоев было, а вобще при твоем обычном запуске, ну да ладно

Так, есть вопрос. Моя видяха старая сдохла. Буду брать новую, но так-как я бомж, собираюсь взять 4060ti 16 гиговую нулевую. На какой максимум я могу рассчитывать? 27b Gemma влезет? И там завезли уже для gemma моделей флеш аттеншн и qv в 4bit?

Блядь, несколько месяцев все нормально работало в рокм форке кобольда, недавно мне винда к хуям драйвера обновила сама и даже после очистки дду и переустановки нормальных больше не работает. В рот ебал все это. В линупсе-то все нормально.

> но так-как я бомж, собираюсь взять 4060ti 16 гиговую нулевую

Забудь про все, у чего 128бит шина. 192бит абсолютный минимум.

Так какая нахуй разница если полностью выгружать модель в VRM?

шина отвечает за пропускную способность между гпу и видеопамятью, деб.

>собираюсь взять 4060ti 16 гиговую нулевую

Здесь уже была дискуссия на тему 3060 12гб новой. Бери две.

5090 уже в январе выходит, в чем проблема потерпеть и отложить 2к?

>5090 уже в январе выходит, в чем проблема потерпеть и отложить 2к?

А ты оптимист. Вангую, что и в 3к не уложишься

Мы обучаем ЛЛМ распространяя назад ошибку от предсказанного слова прям через (un)embedding, все атеншен блоки, и кучу персептронов? Наша ошибка не затухнет?

Стащил с треда на форчане, если пикрил - правда то в таком случае всю сою теперь будут выпиливать и мы наконец то получим нормальные модели которые могут много во имя свободы слова. Речь идёт об отмене указа который обязывает ИИ лаборатории пихать левую повесточку во все модели которые они создают, трампыня порядок наведэ так сказать.

> но так-как я бомж

В этом.

> шина отвечает за пропускную способность между гпу и видеопамятью, деб.

Окееей... Где бы наглядные тесты посмотреть. Всё равно возьму 4060, я еще и в игрушки хочу играть, да и в ВР более менее ходить.

> Здесь уже была дискуссия на тему 3060 12гб новой. Бери две.

3060 всё же хуже 4060ti в играх, хотя по большей части мне для ВР игр нужна. 1080 нихуя не тянула даже сраный VRChat.

Но вообще суть не в этом, я спрашивал 27b Gemma влезет полностью в видеопамять или нет в 16 гигов?Г

> во имя свободы слова

Если это про ту хуйню, что продвигает Машка под видом "free speech", то это сорта говна. Просто у них другая тактика промывания мозгов, более похожая на нашу. Так же как у нас пиздливых леваков топят, не забывая самим напиздеть.

>Но вообще суть не в этом, я спрашивал 27b Gemma влезет полностью в видеопамять или нет в 16 гигов?

Влезет, вопрос только в кванте.

>Но все системные промпты захардкожены, а мне это не нравится, хочу управлять всем.

Делай свою прокси с автозаменой, делов на 15 минут.

Реализация семплеров настолько разная, что ожидать одинакового результата смысла нет.

>Если система не разгоняет ее частоты при работе нейросетей.

Хуйню выдумал какую-то.

И что теперь, всю жизнь бомжом быть? 4060ti это деньги в пустоту, тогда проще купить подписку на опенроутере. А там через пару месяцев или надоест или поймешь, что играться с огрызками от 22б это уровень вчерашнего вкатуна, которому писать "ебу пизду" всё ещё в новинку. Не надо экономить на любимом хобби и не нужно его для себя портить, используя хуёвые инструменты. Сомневаюсь, что можно стать хорошим гитаристом, играя на треснувшем урале с 3 струнами.

>Хуйню выдумал какую-то.

Если у тебя все норм то не думай что у других так же.

У меня негронки не бустят частоты карте, вот так вот.

>Наша ошибка не затухнет?

Тухнет, ещё как, и всякие колхозы с первыми слоями несколько помогают. Но всем похуй, эту проблемы заливают компьютом, а не хитростью.

>Речь идёт об отмене указа который обязывает ИИ лаборатории пихать левую повесточку

Отмене несуществующего указа, лол?

>3060 всё же хуже 4060ti в играх

Разве что с учётом (де)генерации кадров, которая повышает инпут лаг до небес.

Потому что упор в шину, поэтому чип и простаивает. Хоть 3ГГц ему поставь, быстрее не будет, вот и скидывает. Небось обрезок по шине, типа упоминавшейся выше 4060ti.

> Делай свою прокси с автозаменой, делов на 15 минут.

От лимитов это не избавит. Да я смогу заменить системный промпт, но то что граничит сам бравзер нет.

> Разве что с учётом (де)генерации кадров, которая повышает инпут лаг до небес.

Да нет, по тестам чистой мощей без dlss и генерации все равно лучше.

> И что теперь, всю жизнь бомжом быть? 4060ti это деньги в пустоту, тогда проще купить подписку на опенроутере.

Да блядь, я инвалид с пенсией и редкими подработками на 70-100к, пенсия у меня 15к Возможности нет нормально откладывать, тут одна коммуналка ебет.

> тогда проще купить подписку на опенроутере.

Как кстати из рашки за неё плотить, может затещу. Через together.ai дают 5 баксов нахаляву, я потыкал 405b ламу и 8x22b WizardLM, последняя более менее, а лама и всё остальное под цензурой, но даже если её обойти это точно не RP модели.

>Потому что упор в шину, поэтому чип и простаивает. Хоть 3ГГц ему поставь, быстрее не будет, вот и скидывает. Небось обрезок по шине, типа упоминавшейся выше 4060ti.

Дохуя умным себя считаешь что ли?

Я по gpu-z смотрю, и по скорости генерации.

Если запускаю gpu-z ДО запуска бекенда с моделью - то карта работает с обычной скоростью и показывает мне хуевые частоты. Если запускаю gpu-z ПОСЛЕ загрузки бекенда - карту лочит на высоких частотах и генерация и чтения в 3 раза быстрее.

Одни и те же настройки бекенда, все слои на карте, свободное место есть.

Тупо карта не бустит частоты при запуск сетки.

Причем в панели управления нвидии хоть какой режим управления электропитанием ставь - ей похуй.

Дрова новые, вот так вот.

Причем если в браузере что то делать и давать нагрузку на карту - тоже заставляет ее во время генерации частоты поднимать и увеличивает скорости инференса, кек.

Запахло радеоном.

>От лимитов это не избавит.

Не спорю. Впрочем, там наверняка простой JS, можно переписать экст. Правда все браузеры скатились в сраное говно, и неподписанные расширения ограничивают.

>Дохуя умным себя считаешь что ли?

Не считаю. Являюсь.

>Тупо карта не бустит частоты при запуск сетки.

Ну значит ты лох со своими проблемами, лол. Я такое встречаю впервые за 89 тредов.

>Да какой тут вопрос, Q3

Если рассматривать только ВРАМ и карты от Ампера, то ГГУФ ему не нужен, а exl2 немного поменьше размером. Но в принципе где-то так, да.

> Как кстати из рашки за неё плотить

Как и за всё остальное здесь - криптой. Пашка уже прямо в мессенджер кошелек добавил, не разобрался даже шко... а, нет, даже эти разобрались.

Да, Pantheon-RP-Pure-1.6.2-22b-Small.i1-Q6_K, шестой квант идеален по скорости и качеству на моей машине.

Ебём мозги школьной шлюхе которая переебала практически весь поток и теперь нацелилась на главного отличника и задрота класса - юзер-куна. Куча сообщений, философия, фрустрация, математика, и ноль эротики so far XD.

В самой эротике и хентае Пантеон несколько проседает относительно ArliAI-RPMax, а сторителлинг / соавторство - это вообще не про него (тут на помощь приходят Cydonia 22B и Moistral3 11B), зато вот свою специализацию - рп-чат, вывозит на все 100, пока что, везде где юзал.

qwen2.5-14b я так и не понял, вроде и швец, и жнец, и на дуде игрец, но всё так себе, хотя переводит с одного языка на другой тоже вроде неплохо, главное чтобы размера контекста хватило.

Ебём мозги школьной шлюхе которая переебала практически весь поток и теперь нацелилась на главного отличника и задрота класса - юзер-куна. Куча сообщений, философия, фрустрация, математика, и ноль эротики so far XD.

В самой эротике и хентае Пантеон несколько проседает относительно ArliAI-RPMax, а сторителлинг / соавторство - это вообще не про него (тут на помощь приходят Cydonia 22B и Moistral3 11B), зато вот свою специализацию - рп-чат, вывозит на все 100, пока что, везде где юзал.

qwen2.5-14b я так и не понял, вроде и швец, и жнец, и на дуде игрец, но всё так себе, хотя переводит с одного языка на другой тоже вроде неплохо, главное чтобы размера контекста хватило.

>Не считаю. Являюсь.

Кек, да ты идиот с такими претензиями

Лохи тут стадами бегают и ты один из них, если тебе даже в голову не пришла такая проблема.

Как и многим другим кто запуская даже не знает крутит ли он на максимальных частотах свою сетку.

Но это невидия, к счастью это все проблемы с ней

> перепробовал примерно 2 теробайта самых популярных моделей

> с 70 и 123, у памяти и процессора все еще хуже. 0.7 и 0.4

Ну давай посчитаем, это примерно 50 квантованных 70б (что вообще ни разу не много лол), для полноценного "попробовал" нужно хотябы нормальных 15 чатов, это минимум по 20к токенов на каждый, т.е. в итоге около 15М токенов, и это все по нижней границе. С твоей скоростью (а она вообще скурвится как только там появится контекст побольше а то и вообще вдруг обработка контекста) на это потребуется около 250 дней. Учитывая что нужно еще спать, срать, работать/учиться - ты получаешься врунишкой.

И это все лирика, с такой скоростью ничего "пробовать" ты не будешь а банально забудешь о чем писал пока модель будет отвечать. Это не говоря про то чтобы сначала подобрать правильный промт, параметры и прочее, у тебя это затянется на несколько вечеров, лол. Пара странных запросов на отъебись и сравнение их с понравившимся референсом - вот оно, делать по такому выводы будет только маразматик.

> m2 ssd имеет объем 2тб и скорость до 6гбит в секунду

Пока есть slc кэш он может последовательно писать/читать 6-7гигаБайт в секунду (если х4 4.0) с задержками в доли миллисекунды. Разосранная в щщи ддр4 может произвольно писать или читать ~50 гигаБайт в секунду с временем доступа в полсотни наносекунд. Разница по скорости в 8+ раз, разница по времени доступа на порядки, и это при оче хороших условиях для ссд, которых может не быть. Скорость врам на той же 3090 с минимальным разгоном уходит за 1тБ/с, для контраста.

> 27b Gemma влезет?

В оче плохом кванте или с выгрузкой напроцессор. Во втором случае все будет не так уж плохо потому что большая часть весов на карточке. А так до ~22б будут помещаться в врам и идти с адекватной скоростью.

> И там завезли уже для gemma моделей флеш аттеншн и qv в 4bit?

Давно уже, но, кстати, корректная работоспособность геммы на жоре не подтверждена. Раз жалоб нет то скорее всего все ок, но могут быть нюансы.

Я запускаю генерацию ответа и сворачиваю браузер.

Зато остальная система не тормозит, даже с графической нагрузкой.

Так-то exl2 больше. С одной стороны, у жоры нет 3.0bpw, там будет mostly, к "размеру" кванта нужно прибавлять 0.5 практически всегда для честного сравнения. А IQ кванты вообще вне конкуренции. С другой стороны, exl2 не квантует эмбеддинги, а жора квантует, так что размер файла exl2 будет больше при одинаковом квантовании. Но эмбеддинги не грузятся в vram, так что на расход не особо влияют. По итогу получаем тот же хуй, но в другой руке.

Таверна? Это говноподелие на статичной странице грузит карту, чем забирает часть производительности.

Тоже сворачиваю если скорость критична

>Мы обучаем ЛЛМ распространяя назад ошибку от предсказанного слова прям через (un)embedding, все атеншен блоки, и кучу персептронов? Наша ошибка не затухнет?

https://www.youtube.com/watch?v=5ltoWvHMwFY

> Давно уже, но, кстати, корректная работоспособность геммы на жоре не подтверждена. Раз жалоб нет то скорее всего все ок, но могут быть нюансы.

Просто последний раз когда я пробовал в кобольде и llama.cpp оно работало. Но скорость урезало раз в 5 если не больше и скорость обработки промпта тоже в минус уходила. Даже если просто включить flashattn и не трогать qv. А через эксламу так и не смог впихнуть полностью 9b модель в 8 гигов врам хотя бы в 4bpw. Поэтому хз как оно работает или нет.

> Если запускаю gpu-z ДО запуска бекенда с моделью - то карта работает с обычной скоростью и показывает мне хуевые частоты. Если запускаю gpu-z ПОСЛЕ загрузки бекенда - карту лочит на высоких частотах и генерация и чтения в 3 раза быстрее.

Это что за приколы вообще? Шмурдяк вместо шинды и драйверов или франкенштейн. А того анона двачую что сколько не бусти, если врам не тянет то эффект будет мизерный. Другое дело что псп, если чуть погнать, сравнима с теслой, для 16 гигов приемлемо а больше - другую видеокарту.

> Это говноподелие на статичной странице грузит карту, чем забирает часть производительности.

Это тоже что за приколы, с 1030 и небраузера капчуете?

Ебануться, конечно, что происходит в лламатреде.

Скорее всего починили. Наверняка тут кто-то да катает ггуф геммы27, подскажут.

>Это что за приколы вообще?

Старая win 10, может она мозги ебет, но переустанавливать я в рот ебал.

Там при хуевой скорости частоты памяти если открыть и смотреть 400 мгц, ядро 850. Это пиздец.

Лок частот костылем поднимает их до нормальных и все работает хорошо.

Ну просто такого поведения как у тебя точно быть не должно. Есть нагрузка - бустит, нет - успокаивается, это единственное верное а остальное - аномалия.

И лочить ничего не нужно, но если хочется, разумеется, не возбраняется.

В играх и браузере все заебись, но llama.cpp бекенд карта не уважает

> Где бы наглядные тесты посмотреть

https://www.reddit.com/r/LocalLLaMA/comments/1b5uwr4/some_graphs_comparing_the_rtx_4060_ti_16gb_and/

Угу, карточка была подключена через PCIe 3, а не PCIe 4. Так что тесты не совсем легитимные 3 PCIe душит 4060Ti в некоторых играх разница 10-15%.

Если карточка уровня 4060ти душится 3.0 шиной pci-e при 16 линиях - это нехватка видеопамяти или ультимейт быдлокод на движке. В обоих случаях штука нерелевантная.

Ну хз, вот тесты 16 гиговой, поэтому вариант с нехваткой памяти отметаем. Конечно не везде 10%, но всегда быстрее.

https://youtu.be/p_u3_ohprc0

Спасибо, посмотрю.

Скиньте проксю с локальными моделями.

Применительно к Kobold.cpp:

Как настроить Text-To-Speech (озвучивание текста)

https://github.com/LostRuins/koboldcpp/discussions/751#discussioncomment-8822733

Как настроить Speech-To-Text (распознавание голоса)

https://www.youtube.com/watch?v=2shoZ7q6XRI

Но учти, что всё это будет далеко не такого же качества, как в ChatGPT, и с большими задержками.

Запости фрагменты диалогов с ней что ли, для наглядности, так сказать.

Я почти тебя догнал. Правда я капчую на x1 слотах. Мб как-нибудь надо фото запилить, у меня стоит обычный корпус, закрытый, внутри только 3070, но из щелочки в задней панели выходят over 9000 тентаклей проводов на теслы, которые рядом стоят. Чувствую себя как в экспериментах лейн.

Кстати, тут в треде пишут, что комбинация тесл и геймерских видеокарт может серьезно просаживать производительность. Вот бы проверить это дело на моей модели, но нужна четвертая тесла тогда... Сегодня пробовал бегемота, показалось, что она креативнее обычного магнума, но иногда это выходит боком и сообщения генерятся вообще не в тему. Плюс показалось, что изредка с памятью или пониманием написанного проблемы. Завтра пойду магнум v4 катать.

А когда обычно коммиты из лламы подтягивают в кобольд? Я сегодня попробовал ровсплит кобольдовский - обработка контекста сразу ушла нахуй. Может с этой фичей будет норм. Или это 3070 так не дружит с теслами, что ровсплит так тормозит, хз. Хотя если при нем данных между видеокартами надо больше гонять, то может быть, что пара моих х1 подсирают.

Кстати, осторожнее с nvidia-pstated - у меня скорость инференса в два раза от него упала (запускал с дефолтными параметрами)

Это уже третий положительный пост про эту модель, что в среднем на три больше, чем у большинства остальных. Там четвертый квант - всего 12гб качать.

>Сегодня пробовал бегемота, показалось, что она креативнее обычного магнума, но иногда это выходит боком

Бегемот-магнум имеешь в виду?

https://huggingface.co/mradermacher/Behemoth-v1.1-Magnum-v4-123B-i1-GGUF

Я пробовал. Хороший микс, как по мне лучше чистого магнума. Проблем не заметил. i1-Q4KM, профиль в Таверне Mirostat, температура 1.15. Мне наоборот кажется, что подобные проблемы у чистых Магнумов.

Есть у кого бенчмарк локалок мультимодалок где посмотреть?

Или так подскажите.

Надо что то поменьше MiniCPM-V-2_6 но запускающееся с llama.cpp, но тоже качественное.

Играюсь тут с Local-File-Organizer, забавно, но криво.

Переделал уже пол кода сменив запросы в бек на чат комплишен, а то эта херня генерила бред до упора, что тратило кучу времени впустую и выдавало херню.

Непонятно как проект вобще набрал звезды едва работая.

Да и настройки запуска тоже были кривые, мда.

Текст генерит SmolLM2-1.7B-Instruct-Q8_0 и пока работает неплохо. Мелкие квен срут иероглифами, ненадежно.

Или так подскажите.

Надо что то поменьше MiniCPM-V-2_6 но запускающееся с llama.cpp, но тоже качественное.

Играюсь тут с Local-File-Organizer, забавно, но криво.

Переделал уже пол кода сменив запросы в бек на чат комплишен, а то эта херня генерила бред до упора, что тратило кучу времени впустую и выдавало херню.

Непонятно как проект вобще набрал звезды едва работая.

Да и настройки запуска тоже были кривые, мда.

Текст генерит SmolLM2-1.7B-Instruct-Q8_0 и пока работает неплохо. Мелкие квен срут иероглифами, ненадежно.

> догнал

Задаю новую цель чтобы было куда расти.

> у меня стоит обычный корпус, закрытый, внутри только 3070, но из щелочки в задней панели выходят over 9000 тентаклей проводов на теслы, которые рядом стоят

Зафоткай если не лень, такое в почете.

> Кстати, тут в треде пишут, что комбинация тесл и геймерских видеокарт может серьезно просаживать производительность.

Если бы все работало правильно то наоборот был бы небольшой буст от ускорения обработки части. Вот ты и попробуй на текущем конфиге, быстрее только на 3х теслах или если добавить к ним 3070.

Эти бенчмарки можно, обычно, найти на страницах самих моделей, но они ужасно неинформативны. Тебе для чего конкретно мультимодалка нужна, какой юскейс?

>какой юскейс?

Собственно мультимодалка в проекте читает картинки и дает им описания, даже гифки жрет.

От качества описания зависит дальнейшая обработка другими запросами уже текстовых сеток, именование и папка куда сунется файл.

Я просто хз какие еще мультимодалки выходили уровня ~3-8b, топ своего размера и поддерживаются llama.cpp

Только MiniCPM-V-2_6 знаю но он жирноват даже в 4 кванте

>Вот ты и попробуй на текущем конфиге, быстрее только на 3х теслах или если добавить к ним 3070

Пусть попробует, но в треде на Реддите, который про оптимизацию распределения модели по картам для ровсплита, у чувака на скрине как раз три теслы и 3090 в одной системе:

https://www.reddit.com/r/LocalLLaMA/comments/1gjq1y0/psa_llamacpp_patch_doubled_my_max_context_size/

Он даже не пытается.

> три теслы и 3090 в одной системе

Вообще если подумать, то шанс есть: нужно поставить теслу в качестве ГПУ0. Я так не пробовал, а зря. Может так можно расширить память. Но ускорение вряд ли получится.

>новая архитектура

Я угадаю эту мелодию с пяти нот(с)

>скрин

Эх, живут же люди...

>we used a 2.4-million-parameter small language model to achieve accuracy comparable to a 100-million-parameter BERT model

Долбоебы со шкафами напряглись, 123б влезет в телефон любого школьника.

Спасибо за бета-тест. :^)

псие не влияет на скорость ллм инференса, если вся модель загружена в память, это не игра, где текстуры и полигоны постоянно из оперативки в видеопамять стримятся

у 4060ти только 8 линий

ну да, а потом окажется, что эта 2.4м модель медленнее и это все типичная проблема программирования память против скорости

>Specifically, we use a complex vector to represent each token, encoding both global and local semantics of the input text.

Ну наконец-то до них дошло, что семантика настолько важна. Так, глядишь, и до токенизации доберутся.

Единственное, что печалит, во многих случаях действительно прорывных вещей - либо нет модели, либо есть небольшая модель, которая не может составить конкуренцию существующим. Если сейчас гуглы, меты и иже с ними просто закроют глаза и продолжат ебать старую архитектуру, то и всё.

Там немного, и до хентая ещё не дошло.

Определённые вайбы кагуи и школьных дней (внка 0verflow).

https://pixeldrain.com/u/9bv78P1y Utami Edano.png

https://pixeldrain.com/u/dY9h4DAU Equation of love.txt

О, кстати, ананасы, в кто-нибудь пытался новеллу школьных дней превратить в сеттинг для бота? Отличная лодка бы получилась.

Какой шаблон с сэмплером у пантеона и арли? Я мистралевые использую, но ощущение что что-то делаю не так

Там еще что то с вниманием делали. Судя по описаниям и тестам их подход более емкий и естественный и не так убого работает с токенами. Но я не мл погромист, так что хз

>Мелкие квен срут иероглифами, ненадежно.

Ну хотя? Добавив в инструкцию отвечать только на английском qwen2.5-3b-instruct c чат комплишен пока китайским не срет, и названия дает лучше лламы 3b

https://www.reddit.com/r/LocalLLaMA/comments/1glezjy/i_think_i_figured_out_how_to_build_agi_want_to/

Хуясе, этот парень копал глубже чем я. Я только до петли обратной связи допер.