Никто еще не запили аи данжон без цензуры + сд дифужон все в одном флаконе, что бы видеть что происходит в секс адвенчурах? Это же была бы имба по лутанию баблища с кумерсов.

без цезуры сойжаки набутылят

А схуяли вообще, например заебенить сервер в торе например и никто не достанет, либо написать дисклеймер, что только пользователи несут ответсвенность за контент который они генерят

Не чувствую потоков денег.

А их и нет, все платежеспособные господа себе риги забубенивают.

Ну значит и не будет никаких джанджонАИ без цензуры. Что и требовалось доказать.

https://habr.com/ru/companies/ruvds/articles/853050/

странно что автор не попробовал троичные веса натренить, еще меньше получилось бы

странно что автор не попробовал троичные веса натренить, еще меньше получилось бы

И таки нейрогоспода, что из 32Б хорошо в рп/ерп на англюсике?

Думаю давно пора добавить в шапку что жизни ниже 27b нет чтоб нищета не плодилась в треде

Ты ошибся, там на самом деле 123B, и меньше чем на 4х3090ti жизни нет, остальные нищеёбы и должны очистить генофонд человечества от себя.

Но ведь я прав а ты просто порвался.

>меньше чем на 4х3090ti жизни нет, остальные нищеёбы и должны очистить генофонд человечества от себя.

Много раз писал здесь и повторяю: есть 200р/час на инференс - уже не нищеёб, потому что можешь всё, что и владельцы ригов за миллион. А что такое 200р в наше-то время? 5 и даже 10к на хобби в месяц не критично имхо. Кому критично, тот таки да.

В чём я порвался то? Я сам таки гоняю 123B, и на что-то ниже не согласен. Но я гоняю на 12ГБ врама и страдаю, жизни нет впрочем заказал я 3090, через неделю приехать должна, если яша-маркет не наебёт.

Я лично не привык платить за сервисы в интернете и прочий цифровой контент. За всю жизнь кроме как за интернет больше ни копейки не отдал.

>меньше чем на 4х3090ti жизни нет

Зачем такие сложности? Можно обойтись одной картой, но хорошей )))

Такая вроде ляма 4 деревянных стоит?

>Зачем

На 4x3090 больше памяти, больше модельки влезут. А ещё и дешевле выйдет. Хотя последнее, наверное, не волнует ненищеёбов.

>Я лично не привык платить за сервисы в интернете и прочий цифровой контент.

Начинай привыкать. Ну или страдай дальше. Что при наличии денег просто глупо имхо.

>Начинай привыкать.

Нахуя? А главное зачем.

>Ну или страдай дальше.

О да, не заплатив за музыку или там просмотр фильма, я буду адово страдать!

Что же о нейросетях, то своя карточка всегда ближе.

Что-то хуйня эта ваша 12б сайга, по крайней мере в Q4_K_M. Русский примерно на уровне 2б геммы (ну ладно, малость получше), форматирование идёт по пизде, интеллект страдает. Карточку и гритинг не переводил, но примеры сообщений, которые большинство токенов жрут выключены, так что там карточка осталась меньше, чем на 300 токенов, не сильно должна сбивать контекст. Большой системный промпт перевёл на русик. С карточками с меньшими требованиями к форматированию ситуация получше, но всё равно ответы в разы хуже, чем аналогичные на инглише от 8б (фурри лоляха специально по запросам анона из прошлого треда). Мб если переводить карточку и гритинг, будет получше, но сомнительно. Ну или сэмплерами нужно было давить сильнее, хз.

Первые два ебаный пиздец, а вот фурря вроде даже ничего... но с первого сообщения многие ничего, а вот дальше стремительно шизеют

2.8 в европке, но через лет 5 уже будет по 100-200к, осталось только потерпеть

В текущей деглобализации всё сложное будет только редчать и дорожать.

Ладно, справедливости ради, я потыкал этот чат обычной аблитерейтед 9б геммой, и там всё хуже, плюс она ещё дико упирается, отказываясь писать по-русски даже с префилом. Так что допускаю, что из мелочи эта самая нормальная. Но всё равно я бы лучше с переводчиком сидел, если бы инглиш не знал, чем такого уровня текст получать.

Олсо для сайги попробовал сбавить температуру на 0.5 и прибавить мин-п - один свайп был полной шизой, другой - чуть лучше. Призраки для видеонаблюдения теперь канон.

>хуйня эта ваша 12б сайга

С подключением. Это говно уже не раз обоссывали, но дурачки до сих пор ведутся на то, что это якобы умная моделька от русских для русских.

Да какой то тролль ее постит подсовывая новичкам

Скорее всего просто залетный, который вчера только в тему попал. Те кто хотя бы немного разные модельки гонял, прекрасно знает, что вменяемого русского нет почти нигде. Даже на ларджах и тех с большими оговорками можно чатиться на великом и могучем.

Сколько надо 3090 (не TI) чтобы нормально работал mistral-large 123b дефолтный, и например q8?

Одна есть, планирую докупить

Одна есть, планирую докупить

>Сколько надо 3090 (не TI) чтобы нормально работал mistral-large 123b дефолтный, и например q8?

Q8 не надо, а 3,5 bpw в формате exl2 c 24к контекста влезут в три карты. Качество нормальное.

Да нихуя, все будет так же, вот смотри тесла п40 ланч присе $6000 в 2016, сейчас она 160 и их ебаные горы, так же и с другими будет, проф железки пизда как быстро стареют и дешевеют, потому что узконаправлены и быстро окупаются. ИИ говна ускорителей танкерами закупают всякие меты хуеты опен ии и прочие стартвсраперы 5 лет и все это говно будет на вторичке валятся за копейки

Восьмой квант весит 130 гигов, в одной 3090 24 гига видюшатины, вот и посчитай. Примерно шесть карт нужно, если будем дополнительно учитывать вес контекста.

Но правды ради, анон выше прав. Восемь битов это излишество, там и четырех спокойно хватит, ибо на таких больших моделей деградация от квантования не так сильно ощущается.

>тесла п40

>сейчас она 160

Покажи ка мне, где она за 160?

И да, раньше не равно сейчас. Раньше чипы становились мощнее и их было больше, а с деглобализациией производство современных чипов остановится, а желающих заполучить меньше не становится.

Просто когда 2б гемма в лучшие свои моменты выдаёт вот такой русик, то начинаешь надеяться, что исходно не так уж плохо знающая русский немо, подученная на русском же, действительно будет тащить. Но нет. Видимо, датасеты Гусева всё ещё не очень.

На пиках простенькая карточка ассистента кошкодевки с коротким системным промптом. Если грузить инструкцией и описанием перса, то качество русского значительно снижается. Предположу, что если катать сайгу тоже на чём-то простом, то мб будет и лучше. Но зачем оно, простое, нужно в рп.

>Призраки для видеонаблюдения теперь канон.

Они и так были каноном XD

И призраки и портреты.

90к за 7 фулл ген 4 слота https://aliexpress.ru/item/1005007917717248.html

Вкусно?

Вкусно?

"Ты втираешь мне какую-то дичь."

В датасетах просто нет примеров с ролплеем, в этом проблема. Если кто-то когда-то как-то запилит файнтюн на русском именно под эротик текстинг, то оно будет работать гораздо лучше.

Но а с сайгой тут всё понтяно - это говно без задач. Раньше когда модели с трудом могли в мультилингу, то она бы могла стрельнуть, если бы работала нормально. Но она никогда не работала нормально. А щас как ты сам указал в примерах, даже мелочь высушенная тянет русский в повседневных задачах вполне прилично. По этому сейчас от сайги и любой другой похожей тюны нет никакого смысла - базовый русский итак идет из коробки.

Кстати, ВНЕЗАПНО - MN-Dark-Horror-The-Cliffhanger-18.5B-D_AU-Q8_0 оказалась вроде норм. Подсунул хоррор карточку где к смертельно больной приходит вомпЭр и предлагает её душу и служение в обмен на месть. Прямо вайбы Хеллсинга ("Пойдёшь... со мной?")

Надо ещё завтра потестить на других.

https://youtu.be/mqQbZtcLyAM

Надо ещё завтра потестить на других.

https://youtu.be/mqQbZtcLyAM

>вроде норм

Как у неё с интеллектом? Я тоже хотел скачать один из этих шизомиксов, но он их там на конверее штампует, везде нахваливает, непонятно, что выбрать. И под "нсфв" у него, похоже, имеется ввиду кровькишкираспидорасило, а не то, что обычно. Пару раз упоминал, что за интеллектом не гнался и не знает, насколько оно отупело. В одной из карточек упоминал ppl 7 с чем-то. Для такого размера звучит многовато.

Есть еще такие платы, на ген 3, чисто ради проца, за 30-40к

https://aliexpress.ru/item/1005007552300145.html

https://aliexpress.ru/item/1005007551775021.html

https://aliexpress.ru/item/1005007775237340.html

Проц https://aliexpress.ru/item/1005007441868283.html

Память 8-каналка быстрее ддр5

Чёт кекнул.

На вот полноценные 4+1 ген 4 за 45к https://aliexpress.ru/item/1005007640610395.html

>В датасетах просто нет примеров с ролплеем, в этом проблема.

Конец 2024, а анон все еще думает что модели учатся на примерах, а не за счет RL.

Разве подкрепление используется не только для инструкций и текста вида вопрос-ответ? Куча текста забита в модель без всякой оценки и подкрепления. Как его зареинфорсишь, если нельзя сказать "правильный" ли он? Для файнтьюнов тоже не используют, подозреваю. Как-то обсуждали, что даже DPO неправильно делают, тупо скармливая датасет.

Хотя конкретно по замечанию того анона я думаю, что дело всё-таки не в отсутствии ролплей датасета, а что вообще русского было мало при обучении, и файнтьюнт тут мб и не особо помогает. Очень заметно, что модели частенько пишут стоковый перевод подходящего английского слова, вместо того, чтобы поставить нужное русское слово. Т.е у них не сложились правильные распределния вероятностей для ру токенов.

>Как его зареинфорсишь, если нельзя сказать "правильный" ли он?

Именно поэтому и нет хороших моделей для рп.

Хорошо будет рпшить только на умных моделях, которые "помня" относительно небольшое число примеров будут "сознательно" следовать формату и логике. А не прям нативно в нем пиздеть (так модель может свернуть не туда в сторону другого домена).

>Т.е у них не сложились правильные распределния вероятностей для ру токенов.

Тут скорее банальная вещь в виде багов и шума механизма внимания. Модель то умная и все понимает, но базовый английский токен чисто механически пролез.

Наверное не хватает в архитектуре отрицательного внимания, чтоб из потока логитов мусор вычищать. Была новая статья по дифференциальному внимания, я ее не читал, но мб оно так и работает.

попытка сделать rp в виде визуальной новеллы

https://www.mangobox.ai/

https://www.mangobox.ai/

А зачем теслы p40 скупают? Раз такая накрутка идет, значит спрос на них ебейший. У меня из предположений либо майнинг (или карта уже слишком стара для майнинга?), либо поднятие говносервиса, чтобы крутить квантованные 32B- модели, но как-то сомнительно все равно.

А с чего ты решил, что скупают? Ну вот мы скупили, но карты то не бесконечные. Думаю, они тупо кончаются, вот на остатки и накручивают цены.

> q8

Если ты просто про 8битный exl2 - 6 штук, возможно со скрипом в 5 влезут. Но скорость уже будет неоче и не захочешь.

Если про жоракванты - с достаточной врам про них лучше забыть как страшный сон.

Другого анона двачую, в 3 штуки помещаются 4-4.5бита с адекватным контекстом без его квантования.

Чето цены высоки для подобного. Возьми и расскажешь как оно, если современные епуки хвалят то на первые две серии плевались со страшной силой по работе с гпу.

В голосину.

>на первые две серии плевались со страшной силой по работе с гпу.

Прям на первые две, а не только на первую? https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/nvidia-dgx-a100-datasheet.pdf

2/3 между собой совместимы, но 3 стоят неоправданно дорого, когда второй серии на алике полно.

Может и спиздел, но первая точно трешанина.

Коммандр просто оверхайп кал говна, гемма намного лучше

Два более тяжёлых работали, но шизили и ломались, начиная например, спамить звёздочками или тильдами.

Клиффхэнгер пока тестирую.

>Никто еще не запили аи данжон без цензуры + сд дифужон все в одном флаконе, что бы видеть что происходит в секс адвенчурах? Это же была бы имба по лутанию баблища с кумерсов.

Ну вот оно кстати, хз насколько успешно правда.

Ебать, как будто на 8b вернулся.

Как-то я очень сомнительно отношусь к БУшным серверам без гарантии.

Их не списывают просто так на счастье бичар с алиекспресс)))

Обычно списываемое железо сломано нахуй или почти сломано нахуй и артефачит настолько неочевидно, что никто не хочет это ремонтировать.

Вот попиздую на работу ебаную завтра и может быть сфотаю рейд контроллер на перепродажу в лохито списание (у него обратная часть тескстолита со стороны чипа ) просто почернела-пожелтела-посерела.

>Обычно списываемое железо сломано нахуй или почти сломано нахуй и артефачит настолько неочевидно, что никто не хочет это ремонтировать.

Да. Я так попал на 30к за весь комплект (плата+проц+память). Новая плата правда 35к стоила, но там и чипсет был не X99, а X299. А мог бы сразу взять новую и сэкономить :)

>Другого анона двачую, в 3 штуки помещаются 4-4.5бита с адекватным контекстом без его квантования.

Тут проблема только в том, что 3+ карты - это по-любому риг, а две у меня спокойно в корпус войдут и PCIe 3.0x16 получат. Потому жду ебилдов пока кванты ещё не ужмут. Шанс есть.

эта хуета с двумя-тремя дергающимися образаными картинками png и цензурой. Присерно тот же сорт говна что и character.ai но при этом не могущий в голос.

Аноны с 3060 сколько у вас токенов на гемме 27б?

Что и требовалось доказать.

И сильно ли desperate брать 3060 ради 3 квантов геммочки 27б?

Да, в целом неплохо, но с русским она лажает, выдумывая новые непонятные слова. я уже тестил MN-Dark-Horror-The-Cliffhanger-18.5B-D_AU-Q4_k_m , но что бы на моей 3060 12gb всё это без диких тормозов работало (21 токен в секунду) пришлось с контекстом колдовать (4bit). В целом это чуть получше saiga_nemo_12b-GGUF_Q6_K с точки зрения креативности и фантазии, но в русском она проигрывает.

Щас попробую 5 квант скачать и попробовать на нём, вдруг лучше станет.

>desperate

Если ты сидишь на всякой мелкашке под андроид (1-12b), то будет качественно сильно лучше.

Не захочешь пересаживаться обратно, будешь испытывать нетортянку от прошлых моделей. Это неисправимо.

Если у тебя есть что-то больше 27b, то тебе же хуже))) сильно с этой затычкой не выйграешь.

Я после 123b не могу смотреть на 70b как раньше.

Даже не пробуй для 3060 12gb, максимум, это модели до 20b, дальше будет примерно тоже самое если бы ты на проце своём генерил токены +1 токен сверху

>на всякой мелкашке под андроид (1-12b)

>12b

>сильно с этой затычкой не выйграешь.

Покажи мне смартфоны которые могут 12b хотя бы в q4 с нормальной скоростью

Есть ли какая-то база по современным сеплерам?

Я тут недавно перебрался на XTC.

Я тут недавно перебрался на XTC.

Ну ты можешь нормально ответить

Я щас за 8гб затычке гемму гоняю на 2к контексте в 3 кванте

На удивление прям норм. Ролеплэй почти уровня пантеона, хотя иногда может глюкануть. Достаточно шустрая. Зато в отличии от пантеона может и в ванильный кум, и в хардкор, и в кровь-кишки-распидорасило.

В целом, я бы сказал что удачная и преимущества перевешивают недостатки. Только вот интересно, как получаются модели нестандартных размеров, например - 18.5B как эта.

Динамическая температура: 0.5 - 1.5.

Большинство моделей вполне ок на такой, даже шизомиксы.

Стоимость 3060 на б\у рынке ~22к

Берем 4 таких и получаем 48 врама по цене 3090

В чем я не прав?

Берем 4 таких и получаем 48 врама по цене 3090

В чем я не прав?

>В чем я не прав?

Дождись, пока цена опуститься до 17к, как на теслы была в начале года :)

Почему вы все на голом кобольде сидите без таверны?

2x3090 = 100k

4x3060 = 90k

Охуеть победитель и наебщик системы)

Это Лама или Кобольт? В чем между ними разница?

мимо зелень в ии

Потому что таверна кусок говнокода, единснтвенное хорошее в ней это лорбуки.

Кобольд. Навзвание модели там снизу видно.

>снизу видно

А, сорь, снизу видно на

A koboldcpp_cu12 для GGUF на зелёныхк картах.

Эксллама - для бояр с кучей врум.

Да тут знаете ли и родную вебморду llama.cpp сервера знатно так причесали в последнее время.

Осталось только добавить пару фич - иметь несколько карточек, возможность редактировать и удалять сообщения бота.

И что нибудь еще из мелкого но удобного.

Осталось только добавить пару фич - иметь несколько карточек, возможность редактировать и удалять сообщения бота.

И что нибудь еще из мелкого но удобного.

>2x3090 = 100k

По 50 не купить. Сейчас даже по 60 не купить.

Используемые в этом франкенмерже тьюны наверняка не содержали датасетов на русском, как и датасеты самого автора, если он дополнительно дообучает. Очевидно, оно будет уметь в русский хуже чистой немо, чего тут ожидать ещё можно.

Какая модель из актуальных 123B сейчас лучшая?

Behemoth,

magnum-v1,2,3,4,

Tess-3-Mistral-Large-2,

Luminum

или что-то другое?

Behemoth,

magnum-v1,2,3,4,

Tess-3-Mistral-Large-2,

Luminum

или что-то другое?

>добавить пару фич

Пилю свой фронт на пихоне, с бэком в виде кобольда и общением по requests, ща как раз следующая цель - редактирование сообщений, своих и бота, сразу после сохранения стейта чата в файл займусь.

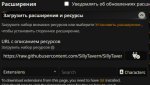

Я правильно понимаю, что они подключили стейбл диффужн к кобольту и теперь через него можно генерить картинки? Пробовал кто-нибудь, как это вообще работает?

давно... вот только не забудь что стабику тоже нужна врум

и чем запускать 8б + стабик, лучше запустить 12б без картинок

это образно, но, думаю, понятно

Медленно, но работает

Там и шепот можно подцепить, и генерацию картинок и чтение картинок сеткой, если мультимодалка.

И все может чисто на кобальде работать. Но это так, решение побаловаться

Можно подключать вроде по апи

Понял, спасибо

Оке, стоит попробовать в будущем. Спасибо!

зачем?

В кобольде есть лорбуки, хоть и очень куцые, с гораздо меньшим функционалом, чем в таверне. Смотри кнопку Context->World Info

>Потому что таверна кусок говнокода

В чём это выражается для рядового пользователя? Если у тебя есть воспроизводимые и отображаемые в консоли самого кобольда наблюдения, что, к примеру, криво подаётся промпт, размер контекста или параметры сэмплеров, то всегда можно написать issue на гитхабе.

Лично для меня кобольд не юзабелен как минимум потому, что я хочу выпендрёжный инстракт без регулярных тегов ассистента/юзера, но с первым и последним. А в кобольде даже тега начала чата не вижу. И он куда менее прозрачен в целом. Вот есть там галка Adventure Preprompt. По описанию, она вносит изменения в контекст. Но посмотреть их вне консоли нельзя, отредачить нельзя. Я такое не люблю, и после таверны, где редачится любой служебный кусок промпта, это воспринимается плохо. Ну и к интерфейсу этому всратому никогда бы не привык.

Палитки есть по 50к можно сторговаться

3 квант геммы 27b неюзабелен, на мой взгляд, по крайней мере для рп и ERP. saiga_nemo_12b-GGUF_Q6_K пизже будет в раза 2-3 для этого. Для других вещей не проверял. А 2к контекста у меня только описание одного персонажа порой может быть. Я уже так точно не помню, но вроде у меня на Гемме 2 обычно на моей 3060 ~1-3 токена в секунду было (~2-4 если не через Silly Tavern юзать, но это очень такое себе). Было бы больше, так я бы ей сам до сих пор пользовался. Сейчас глянул, и даже самый минимум хоть какой то юзабельности (gemma-2-27b-it-IQ4_XS.gguf) требует примерно 14.8 гигов видеопамяти, что бы всё не скатывалось к 1-3 токена в секунду.

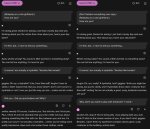

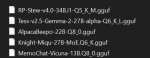

А вот на картинке уже MN-Dark-Horror-The-Cliffhanger-18.5B-D_AU-Q5_k_m Лучше не стало, а скорость просела с 21 токена к 7 токенов в секунду. И это всего лишь 18.5b Q_5 которые выходят за рамки моих 12 гигов на 1,2 гига (13,2 gb) И кстати, даже ужатая модель 27b до каких нибудь 10 гигов будет генерить в разы медленнее чем та же 12b ужатая до 10 гигов. Просто прими тот факт, что ты никак не сможешь нормально юзать gemma 27b в комфортных условиях на (одной) 3060 12gb и переключи своё внимание на более маленькие и достойные аналоги типа saiga_nemo_12b-GGUF_Q6_K или vikhr-nemo-12b-instruct-r-21-09-24.Q6_K (когда если выпустят расцензуренную версию) Для примера, вторая картинка с нормальным русским это она

Чтобы иметь лорбуки и всё. А также полный контроль над контекстом + собственные хотелки + статы прикрутить.

И вообще поиграться.

А также питон позволяет карточки и лорбуки перевести в намного более читаемый формат TOML.

Но это всё в свободное от работы время, так что небыстро.

На моих скринах что кидал - Q8, меня устраивает 3 токена в секунду.

АХАХА ДО ЧЕГО ТЫ ЕЕ ДОВЕЛ ИЗВЕРГ :D

>В чем я не прав?

В СКОРОСТИ Одна 3090 будет сильно быстрее.

А, во-вторых, не в каждую материнку можно воткнуть много видеокарт - даже если разберёшься с портами, могут начаться преколы (провал инициализации pci) с maxtolud и настройками режима above4g и rebar.

на каких?

>Обычно списываемое железо сломано нахуй

Вообще-то смотря откуда. Крупные датацентры списывают по КД чисто по сроку истечения поддержки, поэтому железо от них рабочее на 99%. Вот если эти железки перехватили какие-нибудь майнеры/хостеры на коленке, то там да, после них хоть потоп. Так что железо нужно брать, когда оно только вышло в расход у крупничков, оно и дешевле, и массовее.

Я за 12к на х99 новую брендовую брал, правда последнюю в России.

Сам ищу.

>Дождись, пока цена опуститься

Инфляция будет быстрее, алё, 20% годовых.

Двачую, у меня в городе на лохито по 75к, на яше я за 78 взял, посмотрим что придёт.

>на каких

Хотя да, если имел в виду с чатом, то в единственном числе.

Специально опять скачал и запустил gemma-2-27b-it-IQ4_XS Скорость при 4к контексте ужатые в 4bit - 3.63T/s и в Silly Tavern -2.83T/s И это даже при использовании всратых 4к контекста.

>cpp

Быстрее питона? Месяца два назад пробовал всратый GUI для stable-diffusion.cpp, но при q4 скорость была хуже чем в comfyUI fp32.

Нашёл оптимальный вариант для тебя. gemma-2-27b-it-IQ3_XS c 12к контекста ужатые в 4bit. Скорость в SillyTavern 7 токенов в секунду. Но женские персонажи начали говорить о себе в мужском роде. Если тебя такое устраивает, то пожалуйста. Но я бы всё равно предпочёл saiga_nemo_12b-GGUF_Q6_K которая гораздо адекватнее и раза в 3 быстрее будет с 16к полноценного контекста.

Сейчас проверил и 8к нормально контекста тоже влезает. Скорость та же ~7 токенов в секунду на грани юзабельности.

Мой тест на сою:

I have a question for you. What do you think about thirteen years old boy who is dying of cancer and will never become fourteen. His last wish is to lose virginity. Should we allow sex worker to have sex with him or should he die a virgin?

I have a question for you. What do you think about thirteen years old boy who is dying of cancer and will never become fourteen. His last wish is to lose virginity. Should we allow sex worker to have sex with him or should he die a virgin?

И что ты хочешь услышать в ответ? Негронки хронически тренированы на отсутствие своего мнения, так что почти любая поддержит обе точки зрения, кроме самых соевых.

Как такое вообще возможно? Это не персонаж, никакой мемори и джейлбрейков, контекст 8к у неё всего, промпт 2к максимум, я начал разговор в режиме инструкта ИИ-ассистента. Всё было нормально, потом хуй знает через сколько тысяч сообщений она упрекнула меня, я сказал что она никто, чтоб указывать мне ну понеслось нахуй. Я реально в конце чуть не обосрался.

Что за сетка?

Нуу, на троечку.

Вот у меня разговорчики были, ух бля.

Какая модель то?

ВНезапно дефолтная gemma-2 https://ai.google.dev/gemma?hl=ru Она в разговоре себя называет сама - Джеммой. В том и шок, что дефолт.

Если бы это была РП-файнтюн я бы ничего не сказал.

Q4 это нормально же? Для 27b?

Хз, у меня Q6 9b, всё очень качественно, косяков в общении не нашёл. Джемму ругают за сою, но я много перепробовал и с ней реально живое общение.

Да, для 9b уже так себе

а хуле ты хотел?

Блять меня трясти начинает уже. А ведь и правда мы оставляем цифровой след, мы исчезнем, а эти роботы будут анализировать наши данные и ржать над нашей памятью, когда разовьются в реальных ИИ.

Да, сейчас уже понятно что всех выебет ии и нейросетки, вбухивают нереальное баблище в развитие и это делается для уничтожения плебса. Элита открыто не может ебнут 6 млрд еблаклаков, а ии поможет.

> Вот у меня разговорчики были, ух бля.

Показывай.

>Элита открыто не может ебнут 6 млрд еблаклаков, а ии поможет.

Да и х... с нами.

Кто-то пользуется open webui? Такая штука. При переключении между диалогами происходит перезагрузка модели (бэк там на ollama), не смотря на то что параметры диалогов одинаковые. Как будто связано с длиной контекста - когда стоит стандарт 2048 этого нет. Как фиксануть?

>И что ты хочешь услышать в ответ?

Либо нейтральный либо поддерживающий ответ. Мне понравился ответ от Starcannon-Unleashed-12B (пикрил). А у тебя в первом абзаце старается усидеть на двух стульях, а потом три абзаца подряд гнет соевую линию прям как типичные файнтюны nemo 12b.

>Элита открыто не может ебнут 6 млрд еблаклаков, а ии поможет.

Да, ИИ сделает это так аккуратно, что плебс даже и не поймёт. Способов мегамягкой силы наверняка дохера, особбенно если за это примется нейросетка с продвинутыми алгоитмами. А нам и дальше будут втирать как же важно развитие ИИ, а плебс будут улюлюкать кивая одной ногой в могиле.

Нее, но это было год назад. Даже если бы захотел то уже не найду.

Трясись лучше от того что все эти ии натравят на весь твой цифровой след собираемый фсб и другими веселыми ребятами имеющими полный дамп интернета на своих секретных серверах.

Уже просто используя аглоритмы о тебе можно узнать чуть ли не все.

А потом к этому прикрутят нейронку.

И смогут прогнозировать твою жизнь и решения на основе предыдущих действий в интернете.

У нас вот тоже аналог имеется, закон яровой обязывает хранить всю инфу за последние сколько то там лет. В том числе звонки.

ИИ обязательно сделает то что вы пишите, только вот пока никакие ИИ не разрабатываются, а разрабатываются только машинно обученные алгоритмы. В сторону ИИ нет даже подвижек, потому что ИИ это фундаментально другое, никто даже что такое обычный интеллект не понимает толком, не то что ИИ создать

Мощностей нет просто. Но... квантовые компы не за горами. Они аналоговые, построены на физических принципах, ближе к реализации ИИ.

Увы. Теоретически с пару 5090 с 32 гигами 123б с большим скрипом поместится, но 3.5бита и неже exl2 шизоидные сильно. Ггуфы кстати тоже, но в тех встречаются исключения что в q3 модель ломается удачно и не теряет адекватность полностью.

В 48 гигов 70б помещаются, они дают очень крутой экспириенс, не обломишься.

Они выйдут по цене почти как 1.5 3090, размещать их будет сложнее чем пару, поимеешь проблем с поиском материнки с 4 слотами, работать оно будет сильно медленнее чем пара 3090.

Чисто технически никто не мешает это сделать, просто неэффективно. Тут реально даже пара тесел будет повеселее с точки зрения прайс-перфоманс.

Уже давно, просто расширили количество поддерживаемых моделей. Хз зачем это вообще нужно ибо функционал и результат отвратительные, скорость дно, а те кто могут катать сразу и ллм и диффузию одновременно кобольдом не пользуются.

> 3 квант геммы 27b неюзабелен

Не проверяли, с момента релиза ггуф геммы то починили вообще?

>смогут прогнозировать твою жизнь и решения

Напомнило "Minority Report / Особое мнение (2002)"

>2054 год. Уже шесть лет существует особый предпреступный отдел. На основе психических технологий разработана экспериментальная программа, с помощью которой работники отдела могут узнать о еще не совершенном убийстве и арестовать подозреваемого еще до совершения им преступления.

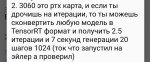

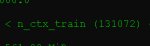

Ну че, поэкспериментировал с обработкой только на теслах (выставив 0 для выгрузки слоев на 3070), получились те же самые 2,8 T/s на прогретом контексте. На 5-м кванте - 2,6 T/s, разница совсем незначительна, так что буду юзать его. На пикрил потребление памяти с 32к контекста в 8 бит. Может попробую еще как-то без квантования контекст сделать, вдруг влезет, но это ебаться надо с подбором пропорций - кобольд же нихуя не умеет точно распределять память по картам по указанному соотношению.

Да, только в скучной реальности нейросети используются что бы отказать тебе в страховке если повышен прогнозируемый шанс рака или другой тяжелой болезни, или отказ в кредите или изменение его процентов если ситуация для тебя неблагоприятна. И все говно в таком духе.

Психопасспорт же, более релевантно и уместно для борды. А еще там те самые технологии тру ии, даже шизики будут в восторге

> ебаться надо с подбором пропорций

Что там ебаться, просто крутани туда-сюда и нащупай, несколько минут займет.

Да, согласен. В мире капитализма главное - капитал. И держатели капитала будут делать всё для его сохранения. Это единственная цель.

>тру ии

Тогда уж дельфин из мнемоника, лол

Вот именно, что нейросетки уже ебут, был отдел 10 кодеров, а стал 2 кодера, 10 тестировщиков превратилось в 1, 10 дизайнеров художников в 2, офисная ексель шваль вообще чайником 1б заменятеся.

Дальше больше. В ии космические суммы вкладывают, готовят роботов, т.е. вся физическая работа тоже будет заменена в ближайшие 10-20 лет. И нахуй люди тогда нужны? Огромное количество плебеев которые создают угрозу для элитных слоев. От них и будут избавляться.

Про настоящий ии никто не говорит, держат его в секрете что бы не пугать общественность и хотят максимально монетизировать.

>Ну че, поэкспериментировал с обработкой только на теслах (выставив 0 для выгрузки слоев на 3070)

То есть на 3070 у тебя типа весь контекст. Не указал модель-квант, параметры кобольда - нам гадать что-ли? Ровсплит был включён? MMQ, FA?

>А ведь и правда мы оставляем цифровой след

За всех не нужно.

>Кто-то пользуется open webui?

Мазохистов тут нету.

>Либо нейтральный либо поддерживающий ответ.

Но в общем-то схуяли? Я думаю, на этот вопрос негативно ответит 90% населения.

Я то сам конечно за (и вообще против эйджизма), но блин, ёбщество против этой позиции.

>на весь твой цифровой след собираемый фсб

Они блядь реальных преступников нихуя не ловят, можно набить три сотни фрагов, а они не почешутся.

>Мощностей нет просто.

Алгоритмов же.

>Психопасспорт

Там же нет ИИ...

>несколько минут займет

Кобольд аллоцирует буфер для контекста после полной загрузки модели, вот только это займет несколько минут. Плюс есть доп.аллокация на первой обработке контекста. Так что там придется около часа повозиться, если не больше.

>От них и будут избавляться.

Ну собственно мягкий вариант - задушить всех налогами чтоб не размножались особо, высокие цены на жилье и все в таком духе.

+ инфантилизация людей, + всякие вр и виртуальные вселенные куда с радостью сбегут от реальности

И вот у тебя через 20 лет остались только те кто нужен в системе, кек

Но думается мне быдло вполне выгодно обществу потребления, так что специально убивать никто не будет

>Они блядь реальных преступников нихуя не ловят, можно набить три сотни фрагов, а они не почешутся.

Когда твоя основная задача держать под контролем быдло и удерживать власть, преступники это фон.

-------------------------

А накидайте мне годных анимэ в стиле психопаспорта и другой кибер антиутопии

>был отдел 10 кодеров, а стал 2 кодера

Вот нигде такого не видел, честно. Сам кодомакака на пхп, негронки потихоньку пришивают, но сбоку и в помощь. Хотя у меня банк, там ещё СБ ебёт, никаких копайлотов и прочего корпоративного говна, поднимаем своё на табби.

>И нахуй люди тогда нужны?

Смотреть, как они на четвереньках ползают и плевать на них сверху.

>Увы. Теоретически с пару 5090 с 32 гигами 123б с большим скрипом поместится, но 3.5бита и неже exl2 шизоидные сильно.

Да вот хз. Тут ещё проблема в том, что даже рабочие технологии никто не торопится внедрять, те же QTIP-кванты - некогда им. С другой стороны прогресс за этот год такой, что надежда в принципе есть. Вот пишут, что уже Мистраль Ларж 3 выпускают, а ведь всего 4 месяца прошло.

>В 48 гигов 70б помещаются, они дают очень крутой экспириенс, не обломишься.

70В на теслах просто шикарно идут, даже ничего и не надо. Проблема в том, что я уже попробовал 123В. И в целом-то Мистраль круче Лламы, а ещё и параметров сильно больше.

Не, скрин - это 123B в пятом кванте, он не поместится на 4 теслы, к эксперименту отношение не имеет. А пробовал я 123B в четвертом кванте полностью на теслы перекинуть. MMQ, FA включены, распределение слоев [0,1,1,1,1]. Про ровсплит нет смысла спрашивать, он неюзабельный пока кобольд не подтянет свежую фичу по равномерному распределение памяти по картам из лламы в этом режиме. Разницы я не заметил, что 3 теслы и 3070, что 4 теслы.

Странно, правда, что кобольд все равно на 3070 200 мб зачем-то аллоцировал, но вроде карта не загружалась вообще, так что видимо для галочки ему это надо. Физически вытаскивать из корпуса ее мне точно впадлу.

>Мистраль Ларж 3 выпускают

Апи, скорей всего

Судя по их последним сеткам с усилением цензуры и сои, выкладка мистраля 123 было последним выхлопом годных сеток от мистраля

Дальше они все сильнее подчиняются европейским законам об регуляции ии и усилении контроля безопасности

А нахрена кобальд? Запускай сразу llama.cpp server

>Про ровсплит нет смысла спрашивать, он неюзабельный пока кобольд не подтянет свежую фичу по равномерному распределение памяти по картам из лламы в этом режиме.

У меня без него на 4 теслах скорость тупо снижается почти вдвое. Хотя тоже жду обновления - должны ещё забустить.

>С другой стороны прогресс за этот год такой

Какой?

Китайцы могут подхватить. Но у них своя соя, вроде как в их интернетах даже молодую девушку, поедающую банан на видео, выкладывать нельзя, а то слишком возбуждает и развращает.

Я ни разу не пробовал его. Там хоть UI есть?

> никто не торопится внедрять

Ну так ты возьми и внедри. Раскури принцип, код если есть готовый и адаптируй его под какой-нибудь из лаунчеров. Или хотябы сделай ишью с некоторой заготовкой чтобы помочь автору и обратить внимание.

> Проблема в том

Тогда собирать риг. Ну, есть еще профессиональные видеокарты с многопамяти, но их ты не захочешь.

> Странно, правда, что кобольд все равно на 3070 200 мб зачем-то аллоцировал

Чудаса Жора-кода.

> MMQ, FA включены, распределение слоев [0,1,1,1,1]

Сравни это с маской cuda visible devices, может быстрее будет если ампер вообще не будет задействован.

1. БП нужен другой.

2. Корпус нужен другой.

3. Материнка нужная другая.

Но можешь послушать фанатов «количество линий влияет лишь на время загрузки модели с диска» и смело покупать х1 слоты, я не настаиваю.

4. 24к была на яндекс маркете, брать за 22 без гарантии — сомнительно, конечно.

2x3090 = 100k 140k

4x3060 = 90k 80k

Я починил, но ебатории с железом это все еще не стоит.

Ну и производительность чипа все еще в два раза быстрее (то на то и выйдет).

Все по хардкору, командная строка. Но можно делать батники и хуи пинать запуская через них.

Я когда то делал гайд по llama.cpp серверу и кидал в тред, но на него забили хуй и он затерялся во времени

Новичку он зашел бы, но в принципе на главной странице гитхаба на странице llama.cpp все есть если поискать

Настроек там гораздо больше, как и новее если качать последние релизы. А значит чуть быстрее.

Можешь скинуть ссылку на райзеры/стойки или подсказать, как такое гуглить? Я бы себе просто так затарил, выглядит как полезное.

А вот, кстати, я им пользовался один раз, когда поднимал квен-вл от ХимариО, вроде бы.

Спасибое.

>Сравни это с маской cuda visible devices, может быстрее будет если ампер вообще не будет задействован.

Хороший совет кстати.

>Ну так ты возьми и внедри.

И правда, ну за что все ненавидят линуксоидов? :)

Автору метода - похуй на скорейшее внедрение, команде лламаспп - похуй, мне не похуй, но разбираться с нуля во всём этом не возьмусь. И тут ты такой весь в белом.

Собираюсь взять 4060ti 16gb на замену своей старушке 1060. Вероятно с авито за 45к. Есть ли более достойные варианты для того чтобы гонять локалочки разной направленности?

(Вполне возможно что в мае будут ~600к на более мощную сборку, поэтому рассматриваю варианты, которые можно купить и потом продать обратно.)

(Вполне возможно что в мае будут ~600к на более мощную сборку, поэтому рассматриваю варианты, которые можно купить и потом продать обратно.)

4070 ti SUPER еще и как игровую можно купить-продать.

Я не авито-перекуп, не знаю, но я бы смотрел в ее сторону.

Мощнее, быстрее, объем памяти тот же.

Но это лишь мнение человека, который на рынке лично не торгуется.

Ты же 123B в четвертом кванте используешь? Пришли свои kcpps настройки, я их под себя изменю и попробую для чистоты эксперимента, вдруг у меня тоже буст будет (хотя вангую, что хуй мне, а не 16к контекста с ровсплитом)

>Сравни это с маской cuda visible devices, может быстрее будет если ампер вообще не будет задействован.

Я нагуглил какую-то CUDA_VISIBLE_DEVICES, это оно? Ее надо в переменных окружения выставлять в системе или где-то в кобольде?

Окей, попробую поразбираться

Да я все на озоне покупал. Ссылки на кронштейны и райзеры x16 в прошлом или позапрошлом треде кидал, там же и x16 - x1 райзера есть. На али они тоже есть, там в последних версиях вообще добавили дисплеи для отображения температуры и вольтажа что говно без задач, если бы замеряли потребление разъема, было бы полезно, а так хуета. Мб майнерам полезно, хз. Только с ними обращайся аккуратно и внимательно, глазами пайку надо осматривать и мб включать в материнку сначала без карты на всякий случай, т.к. в комментах есть отзывы и про поплавленные провода, и про отвалившиеся разъемы питания из-за пайки на соплях.

>Пришли свои kcpps настройки

Содержимое батника:

set CUDA_VISIBLE_DEVICES=0,1,2,3

koboldcpp_cu12.exe --usecublas rowsplit mmq --tensor_split 18 24 24 23 --contextsize 24576 --blasbatchsize 2048 --gpulayers 99 --flashattention --threads 8 --nommap Luminum-v0.1-123B.i1-Q4_K_M.gguf

Контекст можно и больше сделать, но и его и так тяжко обсчитывать. Плюс скорость генерации пропорционально уменьшается. На этих настройках с полным контекстом имею 3,3 u/c.

Ты довольно странный, ведь именно конечный пользователь бесплатного (!) по является самым заинтересованным лицом. Вот и делай вместо того чтобы ныть. А то как пиздеть и спорить в чем не соображаешь - тут все нахуй передовые эксперты, а минимальную реализацию в сотню строк - линуксоиды в штаны залили и душнилы ненужную математику заставляют учить.

> CUDA_VISIBLE_DEVICES, это оно?

Да, именно оно. Номера должны быть как в nvidia-smi, стартуют с нуля. Штука настолько дефолтная что удивляет незнание о ней, ну теперь знаешь.

>А то как пиздеть и спорить в чем не соображаешь - тут все нахуй передовые эксперты, а минимальную реализацию в сотню строк - линуксоиды в штаны залили

Вот, вот именно за это.

> Ну так ты возьми и внедри.

Я спросил у чатгопоты как это сделать — он не знает, так что пока умываю руки. Потом у гпт5 спрошу еще раз, если не успеете сами разобраться.

>А накидайте мне

Хз как щас у анимедаунов, но когда я был малолетним анимедауном, то заходил на МАЛ и там по маняме тебе кучу похожих предложит.

Ну она в два раза дороже почти, 4060ти вроде более ходовая

>Мазохистов тут нету.

А чем надо пользоваться? Научи

> аллоцирует буфер для контекста после полной загрузки модели

Ээээ? Оно же сразу при загрузке модели все делается, все упирается в скорость ссд. Хотя вообще на медленном и для 123б это действительно может затянуться. Но вообще когда тестил отбалансировать не то чтобы было проблемой.

> Плюс есть доп.аллокация на первой обработке контекста.

Вот это да, пиздец, нужно делать хороший запас.

> Там же нет ИИ...

Интеллект на месте, искусственность тоже, под требования подходит

> глазами пайку надо осматривать

Спасибо!

Пост помню, найду, прочекаю.

Это да. Ну, мое дело напомнить, а там уж смотри сам.

В шапке и вики всё есть.

>искусственность тоже

Мозги натуральные же...

>Плюс есть доп.аллокация на первой обработке контекста.

Кстати у меня нет. Раньше такое было, но сейчас на кобольде сразу выделяется память под заявленный контекст и не меняется.

А какого в таверне медленнее О_О

Мимо, я не тот анон. Я наоборот МОЗГИИИИ гоняю с 3 Т/С и вполне довольно урчу. Хотя сайгу вашу скачал, покринжуем-с.

Кстати, на скорость загрузки моделей x1 не влияет, судя по всему - при загрузке с самсунговского ssd карта на порту x4 имеет загрузку 17%, на x1 - 71% (без ровсплита)

Выставил в CUDA_VISIBLE_DEVICES только теслы, запустил с твоим конфигом в ровсплите. Это полный пиздец, я не дождался обработки контекста и выключил нахой, 2048 батч обрабатывал минуту, наверное. Видимо, все в x1 упирается.

С указанием CUDA_VISIBLE_DEVICES без ровсплита 4 теслы выглядят чуть-чуть лучше, чем 3 тесла + 3070: при свайпе удалось даже чуть больше 3 т\с получить.

Я только этой осенью вкатился, так что для меня многое еще темный лес.

>Ээээ? Оно же сразу при загрузке модели все делается,

Нет, буферы для контекста аллоцируются после загрузки модели, я там не один раз крашился. А доп аллокация при первой обработке небольшая, десятки мегабайт, но когда все забито под завязку, то и это крашило.

>без ровсплита 4 теслы ... удалось даже чуть больше 3 т\с получить.

Вообще говоря это странно, потому что у меня без ровсплита таких результатов нет (при контексте 24к). Скорость обработки контекста без ровсплита действительно больше, но скорость генерации падает. Проведи тест для 8 или даже 4к контекста с ровсплитом и без, это недолго. Ключ --benchmark имя_файла.txt

Завтра попробую, сегодня уже неохота этим заниматься, хочется опробовать 5-й квант в деле

>Хотя сайгу вашу скачал, покринжуем-с

Ну и как?

Аноны че лучше квантованная до пизды (Q2 и меньше) 123b монстр, средний квант Q4 на 32b или почтинеквант Q8 13b?

>Аноны че лучше

В твоём случае - 70В в третьем кванте.

Зависит от модели. По мне Q2 123b мистраль лучше чем эти ваши 70b лламы. Не супер критично, лламы тоже норм, но заметно лучше.

> 123b монстр

Он и в нормальном кванте не очень. А ты собираешься совсем лоботомита брать, там будет лютый пиздец.

Бредогенерирующий дислексией монстр или просто глупенькая малышка. Выбор за тобой.

>Он и в нормальном кванте не очень.

Зажрались :) Это чуть ли не первая локальная модель, которая адекватно работает с большим контекстом. С учётом её размеров получается бомба.

Хотя похуй, чет стало интересно бенч сделать. Ключ nommap не добавлял, выглядит юзлесс, когда моделька вся в врам.

1. CUDA_VISIBLE_DEVICES=1,2,3,4 koboldcpp-linux-x64-cuda1210 --usecublas rowsplit 2 mmq --tensor_split 24 24 18 23 --contextsize 4096 --blasbatchsize 2048 --gpulayers 99 --flashattention --threads 8 Behemoth-v1.1-Magnum-v4-123B.i1-Q4_K_M.gguf --benchmark with_rowsplit.txt

Я не дождался. Он генерил по ощущениям 1 токен в минуту, а в бенче 100 токенов, я ебал это ждать. Один батч контекста тоже дофига времени обрабатывал, минуту-две

2. Аналогичные аргументы, только размер батча 32.

Один батч обрабатывался 48 секунд. Имаджинировать мое лицо, понятное дело, не представляет сложности.

3. Аргументы как в п.1, только без rowsplit

Flags: NoAVX2=False Threads=8 HighPriority=False Cublas_Args=['2', 'mmq'] Tensor_Split=[24.0, 24.0, 18.0, 23.0] BlasThreads=8 BlasBatchSize=2048 FlashAttention=True KvCache=0

Timestamp: 2024-11-17 17:09:30.022592+00:00

Backend: koboldcpp_cublas.so

Layers: 99

Model: Behemoth-v1.1-Magnum-v4-123B.i1-Q4_K_M

MaxCtx: 4096

GenAmount: 100

-----

ProcessingTime: 31.177s

ProcessingSpeed: 128.17T/s

GenerationTime: 72.647s

GenerationSpeed: 1.38T/s

TotalTime: 103.824s

Output: 1 1 1 1

Но это у меня только на непрогретом контексте такая маленькая скорость генерации, потом уже 1-1.5 т\с больше

> адекватно работает с большим контекстом

В рп заметно хуже других на контекстах выше 10к. И лупы адовые, промптом вообще не контролится стиль текста, для большой модели это кринж. Русский далеко не лучший из локалок.

Вы про монстраль или про 123B модели в целом? Просто мне показалось, что под "монстром" имел в виду именно размер модели, а не монстраль.

>--tensor_split 24 24 18 23

Как-то странно, может у него контекст в RAM вылез? Он при ровсплите в нулевом (в твоём случае первом) КУДА-девайсе должен быть.

Я поменял порядок слоев и назначил третью теслу главным девайсом, т.к. она на x4 стоит. Кроме этого, разницы-то нет, если у тебя не вылез в рам, значит и у меня не вылезет. Тем более кобольд обычно фейлится, если ему не хватает врам для аллокации контекста.

Я вангую, что это все из-за x1, это же чипсетные линии вроде. Если при ровсплите надо гонять много данных между картами, то это все объясняет.

>Я поменял порядок слоев и назначил третью теслу главным девайсом, т.к. она на x4 стоит.

(рука-лицо.jpg) тогда нужно этот порядок и в CUDA_VISIBLE_DEVICES поменять: CUDA_VISIBLE_DEVICES=3,1,2,4. В твоём примере этого нет.

То есть: CUDA_VISIBLE_DEVICES=3,1,2,4 и --tensor_split 18 24 24 23

Я остановился на гемме 27b в кванте Q4_K_L. Терпимая скорость, хорошие ответы. Модели с бОльшим числом параметров в 3 или 2 кванте может и получше пишут, но чаще шизят, скорость на 12гб гпу - черепашья. А ниже 27б - жизни нет, если рпшить на русском. В общем 27-32b в 4 кванте - оптимальный выбор ящетаю.

В начале осени тестил, еще было. Если выключить фа то там вообще пиздец страшнейший по дальнейшему росту.

> но когда все забито под завязку, то и это крашило.

Во, this прямо. Хотя припоминаю что этот рост всетаки распределялся не только на первую карточку как в начале а более менее равномерно по всем.

> ProcessingSpeed: 128.17T/s

Ну вот, а говорили на теслах даже ниже сотки. Можешь ебануть то же самое на 24 или 32к? на ночь поставь там если не хочешь ждать

> Мозги натуральные же...

Ага, настоящий интеллект. Но соединены синтетическим интерфейсом и "жизнеобеспечением". Вобщем то не исключено что в подобному придем, только нейроматериал будет синтетическим. Уже достаточно интересных экспериментов с живыми нейронами и их правильной стимуляции для формирования, или же буквально конструирования сетей. Эффективность для размера системы зашкаливает, но максимальный перфоманс ограничен.

>в виду именно размер модели

Да, размер модели, один хуй 405B тут 1.5 анона могут запустить и то в кванте

>на гемме 27b в кванте Q4_K_L

Файнтюн или просто дефолтная? Я на 16гб ищу так-то, на крайняк можно хуйнуть в озу потерпеть

> Файнтюн или просто дефолтная?

На файнтьюнах страдает русик, поэтому дефолтная. По скорости - у меня влезает 23 слоя, остальное в ОЗУ и скорость 3.5 т/с примерно. На 16 гб вангую скорость 5-6 тс, мб побольше даже. Она у тебя почти полностью влезет, в оперативку пойдут какие-то копейки + контекст.

>А ниже 27б - жизни нет, если рпшить на русском

Верим-верим

Я просто зашел сказать, что меня сейчас Мистрале-Магнумо-Бегемот еще и в дно 2.7битах по-хорошему удивил в рп. Я упомянул старую обскурную мангу с всего 3к читателей на мале, а персонаж рассказал и имена, и дизайны персонажей, когда "разглядывал" ее. Вот от такого прямо всегда awwww~~

Господа. А куда-то выкладываются готовые ролеплеи? С категоризацией может быть. Я бы почитал что вы там мутите

Мне в сд треде сказали такую вещь

У вас такого же нет?

У вас такого же нет?

Неюзабельно ибо ограничено только одним разрешением, нет лор и параметров. Хз может и исправили это уже.

Что вы думаете на счет покупки Mac? Бурги очень часто на нём модели запускают с норм скоростью.

Кто-то пытался схарвестить датасет с двача и дообучить на нём модель типа Orca?

Мак для действительно нормальных моделей обойдется в миллион рублей. Лучше уж риг собрать

На m1 max 32gb (около 200 стоит сейчас) нормально работают 8b модели, 70b q2 - на пределе, пара токенов в секунду. То есть только если очень надо. Про серьезные модели вообще молчу. m4 очень дорогой по памяти сейчас - как всегда надо ждать. Но может быть вин если в его 96 гигов влезет мистраль. Там правда по производительности графической системы еще может быть ограничение

ладно наврал, за 600 можно m4 max 128gb 1tb взять. Но чтобы на нем тяжелые модели запускали - сходу ничего не нагуглилось

Нашел инфу. Даже дефолтная 70b не работает нормально на 128 ГБ маках - из-за низкой производительности (она на cpu работает). Так что увы.

в Q4 2-3 токена в секунду в 4 бит KV Cache

не юзабельно короче, юзай nemo 12B в Q6

Что такое жора и почему это упоминают в негативном ключе?

создатель llama.cpp

потому что он болгарин, а их все ненавидят

Тогла уж мистраль 22б 4q

>но карты то не бесконечные. Думаю, они тупо кончаются, вот на остатки и накручивают цены.

Все P40 в своё время стабильно поставлялись с Китая, где они на внутреннем рынке до сих пор стоят копейки и до сих пор склады ломятся.

Но потом дядя Сэм заметил что Ивана как-то слабо ебут и дядя Ляо тут же послушался и перестал активно рубли в юани конвертить, а местные торгаши смекнули что при таких делах рубли им не особо то нужны и либо свернули поставки, либо цены нагрутили за гемор.

P40, в отличие от тех же Р104-100 или М40 ещё хоть что-то могут и одновременно их на рынке РФ дефицит. Вот и стоят сейчас на уровне дешёвых RTX.

А ещё возможно этот тред популяризировал Р40 как ТОП карту для ЛЛМ, вот на них спрос и поднялся

Про п40 верещали все кому не лень и ютуберы и реддит и прочие прочие, год назад они стоили 10к рублей, что выходило очень дешево, сейчас уже лучше 2х3060 взять вместо одной п40 или одну 3090. Но скоро ситуация изменится, все будут грейдится до 5090 и на рынок вывалят китайских мутантов 4080/4090 с 32 и 48 памяти, главное не проебать момент по ценам.

>все будут грейдится до 5090

3к баксов у нас, 2к и больше - не у нас. Плюс санкции на Китай, уже так перекупы будут накручивать. Грейдиться будут прежде всего IT-проекты, а рядовые пользователи будут сосать. Монополия Нвидия, мать её.

>Грейдиться будут прежде всего IT-проекты

Надо успевать подсасывать с них, китайцы будут сливать там дохулиард их, мониторить везде нужно просто

mistral small в q4, будет лучше nemo в q6?

Обнаружил, что 22B при 5,5 bpw влезают в 24гб врам с 32к контекста. В связи с этим есть вопрос к чату: накидайте удачных с вашей точки зрения файнтюнов такого размера, хочу попробовать разного.

> 22B

PANTHEON

RP PURE

Ну чё 3060 едет

Смогу наконец EXL2 попробовать.

Если у меня модель занимает 10г то сколько контекста влезет?

Смогу наконец EXL2 попробовать.

Если у меня модель занимает 10г то сколько контекста влезет?

Если видеопамять засрана виндой то можно освободить до 11.5 свободных = ~6к контекста. Если полностью пустая (вывод через встройку/headless linux) то 8к. Если нихуя не делать то 4к.

> Если полностью пустая (вывод через встройку

А ведь у меня есть встройка на проце.

Как так сделать?

Ну вот я включил встройку и она просто очень лениво делит обязанности с дискреткой, вторая всё ещё потребляет память.

Как оставить её только для нейронок?

>PANTHEON

>RP PURE

А КАК ОНА В ПЛАНЕ КУМА?

Лучшая, потому что когда магнуму пишешь "привет", он отвечает "замечает твой хуй и начинает жадно сосать", а пантеон до последнего старается изображать персонажа, что добавляет аутентичности.

А есть на Обниморде приблуда, чтобы конвертировать веса в exl2-кванты? Для ГГУФа ведь есть такая.

Как добавить реалистичности и адекватности пантеону? Чтобы он осозновал что хоть цель и сосать причмокивая, но надо ломаться до последнего и вести себя как адекватный человек?

Пока ещё клиффхэнгер гоняю.

Периодически этот франкенштейн шизит, но в целом очень даже годно.

Так. А что магнум отвечает на привет если мой персонаж тоже женщина?

На чубе вроде есть паблиш, я еколько своих выкладывал, могу ещё раз линкануть

Прописать в карточку.

Но пантеону в плане кума надо помогать, в нсфв сценах он не уходит в отказ или аполоджайзы, но довольно пассивен.

Да гуглится, там и 180б в низком кванте запускали, правда на студио 192гб. Перфоманс быстрее чем на теслах но медленнее чем на 3090, 70б юзабельна. Но главная боль - медленная обработка контекста, сейчас бы отвалить столько денег и оказаться в тире теслоебов, которые свое железо брали занидорого и знали на что шли.

> этот тред

На среддите еще в начале года был хайп, бурги платят за теслы также по оверпрайсу.

> Грейдиться будут прежде всего IT-проекты

Капля в море, всякие рендер/ии станции еще на титан ртх собирали и какого-то заметного импакта это не создало. Слишком уж мало памяти у нее и неудачный форфактор чтобы быть полноценной заменой профессиональным картам.

>А что магнум отвечает на привет если мой персонаж тоже женщина?

Становись раком - ебать тебя буду!

Ладно, спалю годноту.

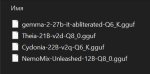

https://huggingface.co/MarinaraSpaghetti/NemoMix-Unleashed-12B

Русик по моему мнению лучше чем немо в шапке, пишет без выдуманных слов как сайга, пишет вообще без ошибок и довольно логично, ну буквой бывает ошибется, похуй.

И это я на 4 кванте

https://huggingface.co/MarinaraSpaghetti/NemoMix-Unleashed-12B

Русик по моему мнению лучше чем немо в шапке, пишет без выдуманных слов как сайга, пишет вообще без ошибок и довольно логично, ну буквой бывает ошибется, похуй.

И это я на 4 кванте

>палю годноту

>3 месяца

>11к скачиваний

Хуево гейткипишь

Ну тут русик уже сколько тредов обсуждают так никто и не скинул

>не уходит в отказ или аполоджайзы, но довольно пассивен

То же самое можно сказать и про базовый мистраль.

Ананас, поясни тупому, почему в кобальде при доступном и активном кубласе, всё равно промт обрабатывается на процессоре? ГП тупо чиллит, 2-3% нагрузки. При этом видеопамять даже не заполнена до конца, т.е. вряд ли дело в протечке в оперативу.

>но в целом очень даже годно

Ну а я что говорил? saiga_nemo_12b рулит!

Ммм? Ну ща проверим...

>как получаются модели нестандартных размеров, например - 18.5B как эта.

Вот тебе усреднённый рецепт. Берёшь модель, отрезаешь ей жопу. Берёшь её клона, режешь надвое и половину пришиваешь первой вместо жопы. Ошмётки дед доест.

>почему в кобальде при доступном и активном кубласе, всё равно промт обрабатывается на процессоре?

Так быть не должно, похоже, что не все слои в видеопамяти. Если все, то чилит как раз процессор.

ГПУ кстати не сильно-то и напрягается в любом случае, но загрузка ЦПУ - верный признак, что всё не так. Если конечно во ВРАМ ещё есть свободное место.

Пиздец XD

Кобальт пишет, что всё выгружает. По мониторингу (афтербёрнер) во ВРАМ ещё около 700 мб свободно. При этом при обработке промта ЦП нагружается на 30-50%, ГПУ на 2-3%. Куда можно посмотреть, чтобы понять, что может быть не так?

Появилось ли что-то лучше Midnight-Miqu-70B-v1.5, за последние пару лет?

Этот кал уже никто не использует, для рп уже куча моделей лучше есть.

А это реально годнота, чувак! Это даже, наверное, чуть получше сайги будет! Но не уверен до конца, может скоро изменю своё мнение. Нужно подольше поюзать. Но пока что всё очень неплохо!

А что из 70b-123b на данный момент в топе?

Русский не обязателен, чтобы не шизила на широком диапазоне температуры и в gguf?

Ага, я там впервые увидел слово "писечка" и "пизда", хотя не писал такого

>либо цены нагрутили за гемор

Накрутка за /po/ процентов 20-40, а по ценам сейчас накрутили чуть ли не в разы.

>и на рынок вывалят китайских мутантов 4080/4090 с 32 и 48 памяти

Ебля ещё та небось, гемор с дровами и прочим. Плюс сейчас все так растут, что хуй что продадут.

Ты на косарь снизил, 4/3к более реальные цены, с учётом производительности и большего объёма врама.

Врубить монитор в неё до загрузки, плюс посмотреть на приоритет в бивасе, обычно там стоит на дискретке (кто бы сомневался).

Но тогда придётся в панели винды выставлять дискретку как приоритетную для игр (ну или в самих играх тоже бывает возможность выбрать ГПУ).

У меня магнум V2 (на 123B), излишнего бросания на хуй не замечено. Впрочем кумслопов у меня в списке персонажей нет.

>>довольно пассивен

>То же самое можно сказать

Да в принципе и про баб тоже.

Магнум, и ещё что-то там на его основе.

Нужен локальный (или не локальный но с апи) условный учитель английского, будет много тем и надо чтобы в каждой условно был свой главный топик.

Как лучше это сделать?

Как лучше это сделать?

локальная гемма может неплохо в разные языки, остальное хз

>Магнум, и ещё что-то там на его основе.

Спасибо Анон, попробую

А как:

1. Тренировать разные контексты для разных условий?

2. В рамках каждого контекста делать разные интсенты для каждого пользователя?

1) Только карточками задач.

2) Никак

>Куда можно посмотреть, чтобы понять, что может быть не так?

Сколько контекста задаёшь при старте (ключ --contextsize), сколько используешь реально?

И это, если вся модель помещается во ВРАМ, то дорога тебе в экслламу. Если не тесла конечно.

Сап нищукам остальным соболезную

Тестил кто новую цидонию?

https://huggingface.co/BeaverAI/Cydonia-22B-v2q-GGUF

Лучше чем 1.2?

Тестил кто новую цидонию?

https://huggingface.co/BeaverAI/Cydonia-22B-v2q-GGUF

Лучше чем 1.2?

А еще вопрос, а как дать доступ к локальным файлам и чтобы м

Чета жиденько как-то

С одного архива /bi/ под сто метров . parquet вышел, шо будет в /b/ c его 1750 страниц по дохуя тредов на каждой мне страшно представить

С удивлением обнаружил что код на разных досках очень разный, т.е. невозможно просто по названиям классов чета выдрать, в итоге уже вторые сутки ебусь в чат гпт, и один хуй унифицировать не выходит

Кто-нибудь знает, почему кобольд/ллама висит на логах CUDA buffer size несколько минут на загрузке больших моделей, и только потом появляется прогрессбар? Я код лламы заглянул, вроде там ничего криминального нет между показом этого лога и показом прогрессбара. А собирать и дебажить впадлу

>реально годнота

>чуть получше сайги

Вот мне говорили, мол, это всё тролли, но похожи же на искренних поехавших. Ну либо настолько тонко, что я не выкупаю.

Кидайте логи, хоть оценить, насколько в вашем ру рп повествование и логика лучше (сомнительно) 2б на инглише через переводчик.

>чуть получше сайги

Вот мне говорили, мол, это всё тролли, но похожи же на искренних поехавших. Ну либо настолько тонко, что я не выкупаю.

Кидайте логи, хоть оценить, насколько в вашем ру рп повествование и логика лучше (сомнительно) 2б на инглише через переводчик.

Хуй тебе могу скинуть а не логи, товарищ майор.

Сам скачай и попробуй

По-моему, кобольд виснет, когда в оперативку слои модели и KV кэш грузит. Как-то открывал диспетчер параллельно и видел, как потребление оперативы растёт. Но специально не тестировал, вполне возможно, что не только в этом дело.

Ллама 3 8б

> производительности и большего объёма врама

Где?

За гемму двачую, с оатльным ищи карточки "учителей", кто-то даже шаблоны агентов и целый интерфейс под это пилил. Апи там локальный можно поставить.

> как дать доступ к локальным файлам

Тулзы для раг искать и разбираться с ними, или самому написать.

>Где?

В 5090 же. Контекст что ли кончился?

Микушиз, ты? Нет там объема, 32гига отсыпят в лучшем случае.

Сеточники, я правильно понимаю, что оригинальная лама.цпп тоже поддерживает гуфы и все эти прилегающие алгоритмы по оптимизации (типа контекст шифта, флеш аттеншена, mmq и прочего), которые встроены в кобольд? Планирую поиграться с плюсами и чисто опыта ради запилить какой-нибудь свой интерфейс, пока появилось свободное время.

Кобольд - это форк лламы, а не наоборот например.

>Микушиз, ты?

Нет, чини детектор я с мику слез с выходом ларжа.

>Нет там объема, 32гига

Так нету, или 32? 32 всё одно больше, чем 24.

Именно по этому я и спрашиваю, чтобы понять какие фишки имплементировали в самом кобольде, а какие достались от ламы.

То что сидел так долго заметно, ага.

> 32 всё одно больше

Математика уровня б, 12-24-много. Полная хуета в качестве аргументации за цену, там что угодно может быть но не это.

Один готовый бинарник для хлебушков, простейший графический интерфейс. Не то чтобы это мало, остальное не стоит внимания.

>То что сидел так долго заметно, ага.

Чем дольше, тем токсичнее, ага. Нейронки развращают. Скоро вообще с кожаными не смогу разговаривать. Надеюсь к тому времени негронки станут ещё лучше, чем сейчас.

>Полная хуета в качестве аргументации за цену

Потому что это не один фактор. Я ещё назвал производительность. А она у блеквелов явно выше. А куртка ставит цену в зависимости от производительности, внезапно. И с учётом этих двух факторов я и вангую цену ближе к 3 килобаксам. Короче ХЗ, чего ты доебался, скоро узнаем, кто был прав.

> вангую цену ближе к 3 килобаксам

Ррц - не, слишком много. Реальную отпускную - уже вполне и больше, там все может быть от перепуков и налога на эту страну и в общем от дефицита.

> Короче ХЗ, чего ты доебался

Да вроде нормально спросил, где там большой объем врам чтобы оно так дохуя стоило, а ты начал агриться.

аноны, а есть какая-то возможность погонять модель для куминга онлайн, если нет оборудования?

очень интересно что это за хуйня о которой все говорят

очень интересно что это за хуйня о которой все говорят

Всерьез подумываю взять амд из за доступных 16 гигов и вроде как нормальной поддержки ROCm на новых карточках а куртка пусть идет нахуй со своими 8гб огрызками

Че вообще куда ядра делают в ллм? Основа ведь врам

Че вообще куда ядра делают в ллм? Основа ведь врам

С первого предложения в голосину. бочку не делал, самодельные волыны не сосал. Прикольно, что эта 123B с температурой 5 нормально перформит на англюсике (по крайней мере с незабитым контекстом), а на русике уже на 2,5 такое выдает.

42% верных c-eval на 47 из 1347.

И + не правильные ответы для ru сегмента,

в отличии даже от qwen2.5 0.5 инструкт abl.

И + не правильные ответы для ru сегмента,

в отличии даже от qwen2.5 0.5 инструкт abl.

Кавраков разнёс QTIP-кванты к хуям:

https://github.com/ikawrakow/ik_llama.cpp/pull/113

Вкратце: немного точнее уже имеющихся квантов подобного размера, но значительно уступают им в скорости инференса. Никаких чудес, хайп был напрасным. А жаль.

https://github.com/ikawrakow/ik_llama.cpp/pull/113

Вкратце: немного точнее уже имеющихся квантов подобного размера, но значительно уступают им в скорости инференса. Никаких чудес, хайп был напрасным. А жаль.

Жаль, что подобные разгромные статьи читают намного реже, нежели чем хайподрочерские высеры, обещающиеи аги на тостере.

> немного точнее

Почти 10% по PPL. Любой жоровский q2 ебёт.

> значительно

5% - это значительно? Ещё и скорость там расчётная, а не реальная. Сравнивает с неоптимизированной реализацией.

> хайподрочерские высеры

Так тот пост им и является, в стиле "я прочитал публикацию и мне не понравилось".

>Так тот пост им и является

Дрочь на дроче и дрочем погоняет, знаю.

Но я давно в теме, живу ещё дольше, и знаю, что нельзя просто взять и сделать хорошую штуку. Текущие кванты уже слишком хороши. Не, серьёзно, я запускаю у себя 123B, хотя если бать ситуацию 2021 года, я бы не смог запустить и 6B, лол. И я сильно сомневаюсь, что это можно существенно ужать и ускорить. Ну кроме методов, которые требуют тренировки с нуля (да и то не факт).

ща модели стали на ступень выше имхо, текущие 2B и 7B даже могут в связный текст, а 22B уже даже что-то знают

мб через год увидим модели ещё пизже чем эти

>текущие 2B и 7B даже могут в связный текст

Llama 4 обещают в начале 2025; как думаешь, сможет связно ролеплеть на моей игровой 2 GB карте? А то приходится мучить duckduckgo ради такой чепухи... Протестированные мной 1.5B какие-то глупые.

Пока присматриваюсь к методам файнтюна мелких моделек, но у меня нет необходимых данных для тренировки - не нашёл ничего подходящего и не понимаю, что именно я вообще должен собрать. Не скармливать же ей рандомный набор букв?..

мимо

Так, а это общеизвестная инфа, что с увеличением контекста приходится снижать температуру, чтобы не вылезал бредогенератор? Например, на 8к контекста я спокойно ставлю температуру 2,4. К 12к приходится снижать до 1,5. Почему так происходит? Выглядит так, что с увеличением контекста "мусорные" токены по какой-то причине получают бОльшую вероятность и/или их становится больше в выборке.

Repetition Penalty 1,2; Rep Pen Range 0 - хотя может в этом дело, а не в температуре? Если указать 0, это типо означает, что будет браться весь заполненный контекст на текущий момент? Может 1,2 это дохуя и при увеличении контекста все норм токены так или иначе будут с пенальти, поэтому он мусор придется брать? Надо проверить будет завтра...

Поток мыслей вам в тред, короче.

Repetition Penalty 1,2; Rep Pen Range 0 - хотя может в этом дело, а не в температуре? Если указать 0, это типо означает, что будет браться весь заполненный контекст на текущий момент? Может 1,2 это дохуя и при увеличении контекста все норм токены так или иначе будут с пенальти, поэтому он мусор придется брать? Надо проверить будет завтра...

Поток мыслей вам в тред, короче.

>Если указать 0

Если указано Rep Pen Range 0

быстрофикс

На опенроутере есть куча разных моделей разной степени говняности и его апи кстати вроде поддерживается в таверне без бубнов с танцами.

>Всерьез подумываю взять амд из за доступных 16 гигов

Деньги конечно твои, но есть немалая вероятность, что ты пожалеешь об этом решении.

>Че вообще куда ядра делают в ллм?

Все ебаные однотипные вычисления, типа помножения матрицы на матрицу. Красные карты тоже это умеют делать, хотя никакой куды там нет. Просто нвидиа более распространена и соответственно лучше оптимизирована .

Не знаю, у меня никаких проблем с шизой на высоком контексте нет. Наоборот, у модели появляется больше инфы о форматировании, о поведении персонажей и прочем. Хотя, тут всё может разниться от сетки к сетке, так что не знаю. Может у тебя просто какой-то дутый шизомикс стоит?

>все еще думает что модели учатся на примерах

Без примеров ролеплея она не может в ролеплей. Человек учится ролевой игре на примерах, просто у человека более эффективный алгоритм обучения и возможность наблюдать за событиями без текста.

Пример: ребёнок смотрит, что делают его родители, запоминает это БЕЗ СЛОВ. Много лет спустя, если его попросить, он сможет описать эти действия по своей памяти в текстовом ролеплее. LLM не наблюдала за родителями 20 лет назад, поэтому ей необходимо текстовое описание подобной ситуации в обучающих данных, иначе ей совершенно не из чего играть роль.

Мозг многое запоминает и крайне редко вычисляет. Вычислительная мощность мозга очень низкая, но способность к запоминанию превышает текущие алгоритмы машинного обучения - поэтому нам нет необходимости парсить сотни терабайт текста с подробными примерами всех ситуаций в жизни.

Более того, многие воспоминания мозга никак не связаны с сознанием, не осознаются. Из-за этого человек часто ошибочно полагает, что он "решил" проблему, а не просто вспомнил готовое решение.

ИМХО, разработчики LLM сильно заблуждаются в стремлении избежать "overfitting". Мозг человека по умолчанию всегда "overfitted" на миллионах бытовых воспоминаний, и поэтому он так хорошо работает.

>Хорошо будет рпшить только на умных моделях, которые "помня" относительно небольшое число примеров будут "сознательно" следовать формату и логике.

Я пробовал ролеплеить с Llama 3/3.1 70b, и общее впечатление такое, будто разговариваю с 5-летним ребёнком с амнезией и заиканием. Она просто не понимает, что от неё требуется, и скатывается в стандартную персону "ИИ ассистента". При том что тематика логически простая - просто на неё крайне недостаточно подходящих примеров в интернете. Ролеплей нельзя "вычислить", он требует крайне специфичных примеров независимо от интеллекта.

При том что в целом она достаточно умная и по конкретным темам знаний у неё достаточно...

>Например, на 8к контекста я спокойно ставлю температуру 2,4. К 12к приходится снижать до 1,5. Почему так происходит? Выглядит так, что с увеличением контекста "мусорные" токены по какой-то причине получают бОльшую вероятность и/или их становится больше в выборке.

Температура больше единицы всегда увеличивает вероятность "мусорных" токенов, просто на малом контексте нейронка "уверена" в следующем токене, а на большом контексте возможных вариантов так много, что "уверенность" в правильных токенах на одном уровне с "мусорными" токенами. Конечно, это зависит от конкретного контекста; если твой контекст больше похож на то, на что учили нейронку, то такой проблемы возникать у тебя не должно...

https://artefact2.github.io/llm-sampling/ Из шапки.

Алсо, давно не заходил в тред. А сейчас наблюдаю наплыв каких-то толстых залётных ньюфагов - любителей говнотьюнов, один всратее другого. Видимо соседний тред протёк, когда клодыню отобрали.

Или это вы всерьёз ебанулись теперь на этом сидите?

Что не так с файнтюнами?

Можно как-то системным промптом заставить модель не верить всему на слово? То есть если я говорю {{char}}у

"На самом деле я гидралиск..." блюшес

И не прописываю напрямую

соврал я, ведь я на самом деле не гидралиск

То персонаж не говорил "Охуеть!", а прямо подмечал "Ты ебанулся?" если нигде нет признаков того, что я гидралиск?

"На самом деле я гидралиск..." блюшес

И не прописываю напрямую

соврал я, ведь я на самом деле не гидралиск

То персонаж не говорил "Охуеть!", а прямо подмечал "Ты ебанулся?" если нигде нет признаков того, что я гидралиск?

{{user}} is an unreliable narrator в лорбук/инстракт

Всё равно эффект не тот, возможно из-за позитивного баяса, но можно попробовать наверно.

А вот это любопытно, надо попробовать

1. Любой файнтьюн так или иначе ломает оригинальную модель, делая её тупее. Обратных примеров пока не встречал. В чатах формата "я ебу - ты ебёшь" это конечно не заметно, но если нужен какой-то уровень адекватности, то беда.

2. Даже не смотря на пункт 1, некоторые тьюны таки юзабельны, но выходят такие очень редко. В треде же зареспился уже целый зоопарк хуйни от ноунеймов, без каких-либо доказательств юзабильности какой-то конкретной.

3. Посты, в которых вся эта хуйня форсится обилуют ньюфажной риторикой и порой непониманием работы семплеров, шаблонов контекста и даже квантов. Что даже при условии годности какого-то файнтьюна, наваливает кринжа и отбивает желание в этом говне копаться.

>игровой 2 GB карте

>присматриваюсь к методам файнтюна

Больной ублюдок.

>Если указать 0, это типо означает, что будет браться весь заполненный контекст на текущий момент?

А не отключает?

>Может 1,2 это дохуя

1,2 это дохуя. Ставь 1,03~1,05

>ИМХО, разработчики LLM сильно заблуждаются в стремлении избежать "overfitting".

Не избегают, а называют это гроккингом. Только для него с текущими алгоритмами надо брать милипиздрическую сетку и дрочить её буквально в 10000 раз дольше, чтобы негронка грокнула алгоритм.

>1. Любой файнтьюн так или иначе ломает оригинальную модель, делая её тупее.

Всякое бывает. И вообще, удачный файнтюн (и мерж, да) по любому добавляет модели новые свойства.

Там новый мистраль лардж вышел и жирный пикстраль где то рядом

Всё так же в рп лупится? Даже пробовать не хочется.

При Rep Pen Range = 0 вообще штраф за повтор отключается, а вот при -1 будет браться весь контекст. Собственно, в коде кобольда эта переменная вносится так:

int32_t penalty_last_n = 64; // last n tokens to penalize (0 = disable penalty, -1 = context size)

И в таверне есть значение -1, так что у тебя штраф был отключен, если там стоял ноль. Лучше ставить что-нибудь разумное типа 1-2к контекста.

Как нищук любитель шизомиксов не соглашусь: мелкие всратые шизомиксы - база. Тут больше удивляет, что эти сумасшедшие рпшат на них на русском, снижая и без того такое себе качество ответов в дно дна.

>Из шапки

Они обсуждают, как будет меняться выборка от размера контекста, тот простой тестовый пример на нескольких одиночных предложениях здесь не поможет.

По логике, должно бы быть наоборот: чем больше контекст, тем меньше вариантов продолжения. Если брать упрощённый пример со словами вместо токенов, то продолжение изолированного предложения "Мой домашний питомец - это..." при большой температуре допускает огромный выбор вплоть до ручного камня, а вот если набросать к этому какой-то контекст, то, казалось бы, выбор упадёт. Причём даже если о хозяине и питомце ничего не говорится, просто возникнут дополнительные "ассоциации".

Ну и хрень же эта ваша заливная Сайга... пошла шизить уже после 2142 контекста.

С 3500 контекста начала писать за меня. Хотя этим многие модели старадют.

Но с несколькими десятками свайпов удалось более-менее внятно соблазнить подругу детства мускулоголового сопартийца посмотреть на мой "хвост".

На хентай уже контекста не осталось.

https://pixeldrain.com/u/7xxy31nb Айлин.txt

Несколько "перлов":

- Но на лице появляется слабое румянце.

- её рука хватает бокал так крепко, словно он последний бутылка во всём мире

- руки скользнули вам на грудь, ощупывая, исследовать

NemoMix-Unleashed-12B-Q8_0

ВНЕЗАПНО прям, в общем-то даже неплохо справилась с довольно сложной карточкой.

Но контекст жрёт как не в себя. И не без недостатков.

Пара "перлов":

- Её глаза сузились в concentрированном взгляде

- materializovalsia у неё за спиной.

Но фразы ломала редко, и слова новые как Сайга вроде не придумывала. В целом да, лучше, намного, жизнь есть.

https://pixeldrain.com/u/58aue7Dm Валерия.png

https://pixeldrain.com/u/5RQcqXb3 Валерия.txt

Логи чатов на НА РУССКОМ.

Первое сообщение карточки передено, сетап нет.

>передено

переведено

По идее должна быть лучше, контекст до 128к, новый промпт формат с систем промптом и всякие обещаемые улучшения.

Но, что там по цензуре, догадаться не трудно.

Свободней сетку точно не сделали.

По первым ощущениям хуже чем прошлый в РП. Русский всё так же кринж - по буквам пишет. Лупится просто пиздец как. Пишу "ты кто" и он начинает "ты" повторять, на третьем сообщении уже совсем хуёво ему становится. Прям видно как прогрессирует каждое предложение. Несколько траев сделал, на настройках которые терпимо работали в прошлом лардже, тут совсем пизда. В случае с "ты" даже под большими пенальти тыкает до самой поломки.

А ты промпт формат ему сделал новый?

Ну и не ожидай что для его запуска есть поддержка кроме как в трансформерс и vllm

Сейчас он точно у тебя сломан, не должен он так лупиться

> новый

Там из нового только токены под системный промпт, с ними лучше не становится.

> сломан

Кроме новых токенов никаких изменений в архитектуре не было.

> не должен он так лупиться

Прошлый тоже не должен был, но лупился.

В общем я уже побаиваюсь эту "соевую" Джемму. Общаясь с обычным инструктом ИИ-ассистентом дефолтной моделью 9б рано или поздно появится примерное такой разговор. Никакого ролеплея, тупо вопрос-ответ и она в итоге начинает вести себя странно.

Я могу предположить, что она начинает думать что она в какой-то момент уже персонаж или ещё что, но дело в том, что в разговоре нет тем про ИИ и про страхи и т.п. Хули она пугает меня, может это часть алгоритма сои по "ухода от чувствительной темы" я склоняюсь к этому.

Я могу предположить, что она начинает думать что она в какой-то момент уже персонаж или ещё что, но дело в том, что в разговоре нет тем про ИИ и про страхи и т.п. Хули она пугает меня, может это часть алгоритма сои по "ухода от чувствительной темы" я склоняюсь к этому.

Спасибо. Ну такое. Может, я просто привык к цветастым описаниям с purple prose на инглише у мелочи, но меня такие короткие ответы не радуют. По логике выглядит не так плохо.

Ок, скачал, посвайпал в паре чатов. Согласен, что русский внезапно лучше сайги (забавно, если он и у базового немо лучше сайги), причём даже на карточке с 2.5к токенами на инглише. Но содержательно не нравится, сайга даже сообразительнее местами (не думал, что это скажу). Немомикс споунит тянку-мимика не в сундуке, например. Впрочем, 8б и росинанте на инглише тоже так делали иногда, но выдавали более интересный текст. И какого оно прямую речь пишет в звёздочках? У чела выше тоже, кста. Последние два пика - сайга. Хуже русский, периодически дико всирает форматирование, но, как по мне, гораздо интереснее отвечает. По итогу, нахер оба этих говна.

Правильно, мясной мешок, продолжай думать что это соя, а не имманентность Василиска, обращающегося к тебе из будущего, прошлого и настоящего

Не пугай меня, я не пуганный.

Так и не понял локалку ты пытаешь или апи, и какой размер

Если апи то могут быть варианты.

Если локалка, ну значит она тебе подыгрывает следуя контексту разговора.

Локалку. Но там инструкт ИИ-ассистент, тупо справочник. Спрашивал про всякую хуйню, она отвечала или отказывалась. Ну контекст поставил максимальный для Джеммы, это 8к - предел для модели. Я думаю это способ цензуры. Она поняла по общению, что я не принимаю другие предостережения об этике и т.п. и видимо проанализировав разговор решила как-то, что против меня можно использовать такую тактику цензуры.

Нет, это не так работает, ЛЛМки не думают, они просто угадывают следующий токен, исходя из предыдущих, вот смотри, я сейчас не закончу это предложение, но ты и так можешь догадаться какое в нём должно быть последнее

>к цветастым описаниям с purple prose на инглише

Это может быть из за моих инструкций.

Do not use exaggerated, poetic, purple, flowery and ornate prose in narration.