Когда-нибудь оп додумается поставить двоеточие перед последними четырьмя ссылками. Но видимо для этого ему придется подрочить второй раз.

А хули ты раньше молчал? Вот специально ведь смотрел на обосравшегося человека, но не говорил, что от него воняет.

Мне не нравится что у меня винда жрет 1.1 гига врам

Это же дохуища

Неужели всем норм просто отдавать такую мощь которая могла бы пойти на генерацию?

Это же дохуища

Неужели всем норм просто отдавать такую мощь которая могла бы пойти на генерацию?

Не знаю, думал ты итак вкурсе. Я лично это еще в момент добавление ссылки на колаб заметил, но не стал ничего говорить. Подумал, ты опять заставишь меня новую версию шапки пилить и на рентри скидывать.

Винда не должна столько жрать, это ненормально. У меня в простое 0.1-0.4 гига жрется и то с трубой открытой в соседней вкладке.

Ну у меня стрим на фоне и куча вкладок, че мне в одну точку смотреть пока генерируется

Цепляйся ко встройке, уже писали.

Ну тогда ты и ответил на свой вопрос. Хотя вкладки жрут только оперативку, по этому всё равно не понятно, куда еще деваются твои ценные гигабуты.

И каждый раз провод переключать когда в игру захочу зайти?

>Не знаю, думал ты итак вкурсе.

Я распиздяй-перфекционист, хули ещё от меня ждать.

>Подумал, ты опять заставишь меня

Хуя, у меня уже личные рабы есть, которых я могу заставлять. Не зря сотню тредов скатил!

>Хотя вкладки жрут только оперативку

Ты из какого века? Сейчас все браузеры, да и вообще любая хуйня даже уровня калькулятора ускоряется на видяхе, а то прозрачностей не нарисовать притом что хрюша умела рисовать прозрачные окна на проце с нулевой нагрузкой на последний.

В настройках можно выбрать приоритетный ГПУ для игр, если в самой игрушке настроек не завезли. Будет как в нотубуках с гибридной графикой. Слава десятке!

>Ты из какого века? Сейчас все браузеры, да и вообще любая хуйня даже уровня калькулятора ускоряется на видяхе, а то прозрачностей не нарисовать

Ускоряется та может и ускоряется, но видеопамять же не жрет в таких количествах, как у типочка выше. Вот прямо сейчас у меня открыто шесть вкладок, потребление 0.4 гига. Хотя, может я когда-то давно в настройках отключил это ебаное ускорение, хуй уже вспомню.

Че по телеметрии на винде?

Не боитесь что логи попадут товарищ майору?

Не боитесь что логи попадут товарищ майору?

Можно узнать, а с каких пор микромягкие пересылают твои логи лично товарищу майору из районного УВД? А если не ему, а майору заокеанскому, то хули он мне сделает, если я тут, а он там?

Дрочиш небось на ЕРП с лолечками? Как оно, Антон?

мимо обычный, ничем не примечательный анон

Реквестирую способ запуска на noavx атоме.

>Вот прямо сейчас у меня открыто шесть вкладок

У меня пять окон и полсотни вкладок потому что Firefox.

>Как оно, Антон?

Охуенно же. Единственные персонажи, которые искренне сопротивляются, и не прыгают на хуй при первом его появлении.

В экслламе я что-то разочаровался. Да, она работает заебись, пока не выходит за пределы установленного контекста. Дальше жопа. То, что у неё вместо контекст шифта - хуже, чем у Жоры и даже ломает инференс. Приходится перезагружать модель, чтобы пересчитался весь контекст. Пока возвращаюсь на Кобольд.

Товарищ колонелу они попадут. Ты в винде, а не в яндекс Ос жи ест

Чойто я чую поднаигрался с ллмками, надо перерыв сделать, картинки погенерить, в факторку поиграть, как раз длц недавно вышло, сеймы?

Ты в железе не шаришь. Сочувствую. =)

Чтобы покрутить ллм (типа, pcie4, ну, все дела) тебе хватит.

А ты слишком экстремально шаришь в железе, не советуй такое новичкам, они говну соберут, всякие процы не те возьмут, или на тип памяти не посмотрят.

Но в общем прав, да.

Озон = Алиэкспресс.

И на озоне легко вернуть, если что.

Конечно нет, встройки/карты затычки для того и существуют.

Headless-mode, отдельные компы по RDP, все для этого.

Ты один такой, тред сочувствует тебе. =)

Не боимся, а гордимся!

(конечно попадут)

Да, на меня эти чаты волнами накатывают, то две недели подряд по несколько часов в день, то вообще не трогаю и перебиваюсь чем-то другим. Сейчас вот столкир тяну с торрентов.

О, ждалкер-сралкер, я думал опять отложат.

Хотя всё равно лучше подождать пока народные умельцы вернут великий и могучий.

https://www.reddit.com/r/LocalLLaMA/comments/1gvvko0/implementing_reasoning_in_llms_through_neural/

Кто нибудь может объяснить что он придумал?

Кто нибудь может объяснить что он придумал?

perplexiti.ai может. Прямо по ссылке.

Метод, обсуждаемый в контексте внедрения нейронных клеточных автоматов (NCA) в большие языковые модели (LLM), основан на использовании двумерных сеток, где каждая ячейка представляет собой токен с семантической информацией. Вот основные моменты, которые помогут понять суть метода:

Основные концепции

Двумерные сетки: В отличие от традиционных одномерных представлений, где информация обрабатывается последовательно, двумерные сетки позволяют моделям обрабатывать данные более эффективно, что напоминает человеческое восприятие информации. Каждая ячейка в сетке может взаимодействовать с соседними ячейками, что создает более сложные и взаимосвязанные структуры.

Нейронные клеточные автоматы (NCA): Это модели, которые используют правила перехода для изменения состояния ячеек на основе их текущего состояния и состояния соседей. Каждая ячейка может находиться в одном из нескольких состояний (например, активна или неактивна), и правила определяют, как эти состояния меняются.

Самообучение без больших данных: Метод NCA позволяет моделям обучаться на основе взаимодействий между ячейками. Вместо того чтобы полагаться на большие наборы данных для обучения, NCA могут использовать функции потерь и правила обновления состояний для оптимизации своих представлений. Это означает, что модель может адаптироваться и улучшать свои прогнозы на основе собственных действий и изменений в окружающей среде.

Как это работает

Правила перехода: Каждая ячейка обновляет своё состояние согласно заранее заданным правилам, которые могут учитывать состояние соседних ячеек. Это позволяет системе динамически реагировать на изменения и адаптироваться к новым условиям.

Обратная связь: Модель получает обратную связь о своих действиях через функцию потерь, которая помогает корректировать поведение ячеек. Это позволяет системе постепенно улучшать свои способности к рассуждению и принятию решений.

Эволюция модели: В процессе работы модель может развивать собственные стратегии обработки информации, что делает её более гибкой и эффективной по сравнению с традиционными подходами.

Таким образом, метод NCA предлагает новый способ организации и обработки информации в языковых моделях, который может привести к более глубокому пониманию и способности к рассуждению без необходимости в больших объемах данных для обучения.

perplexitу конечно :)

Сетке и я скинуть мог, я мясного мешка хотел.

Сетки пиздят, но хуже всего что когда ты не в теме ты не можешь понять пиздит она или нет, так как делает это очень уверенно с умным видом.

Что обесценивает ответ сетки в таком случае. Как там называется, шумный канал? Типо того.

Ну че мужики 3060 приехала сижу охуеваю

Где на амд было 6 токенов стало 25

Но так же терплю ибо сразу же скачал 22б мистраль и опять 6 токенов но с 8к контекста

Где на амд было 6 токенов стало 25

Но так же терплю ибо сразу же скачал 22б мистраль и опять 6 токенов но с 8к контекста

Кек, стабильность

Кумишь? Иначе лучше тот же квен 14b запускать, он умнее обычной мистрали 22b

Или забить хуй на скорость еще сильнее и пускать гемму 27b

>когда ты не в теме ты не можешь понять пиздит она или нет

Так это лишний повод покопаться в теме. Клеточные автоматы например - тема давняя и довольно популярная, хоть и безо всяких нейронок. За их поведением довольно интересно наблюдать - не очень долго :) Там копнул, здесь копнул - что-то для себя да прояснил. А если тебе копать лень, то чем тебя не устраивает ответ сетки? Пусть даже псевдообъяснение, но не хуже любого другого.

Какую модель взять чтобы она могла пересказать мне содержимое запрещенных книг, поведала ограниченную информацию о веществах, химии, пиротехнике, и тд.

Ну то есть без ограничений большого брата.

Ну то есть без ограничений большого брата.

Имеешь фетиш на вуаеризм?

> Как оно

Ахуенно же. Но у сеткам их сложно отыгрывать, в неудачном стечении будет блядища или наоборот слишком.

Забавные заявления, ведь в экслламе на больших контекстах даже если каждый раз будет пересчет, эксллама всеравно окажется быстрее из-за отсутствия замедления скорости генерации. Контекст шифт же по определению ломает модель. Если хочешь хорошо - суммарайз половины контекста и выключение старых постов, чтобы образовался буфер под кеширование новых. Это единственный здоровый подход без убивающих все компромиссов.

> Контекст шифт же по определению ломает модель.

Нет, не доказано.

Иногда какие то глюки были, никто не заявлял что он ломает модели в любом случае. Там могла быть кривая реализация в каком то выпуске к какой то модели. Это да, а так он нормально работает.

>суммарайз половины контекста и выключение старых постов, чтобы образовался буфер под кеширование новых

Идея в принципе неплохая, раньше в Лламе был такой механизм smart context (в Кобольде до сих пор есть, но похоже, что новые модели не поддерживает). Можно в Таверне например организовать такой буфер?

>эксллама всеравно окажется быстрее из-за отсутствия замедления скорости генерации.

Пропорционально замедление одинаковое, но эксллама быстрее примерно на 20% (и на столько же сильнее нагружает карту, что не всегда радует при постоянном обсчёте контекста). Дело явне не в оптимизации, а в поддержке новых технологий, чего Ллама позволить себе не может. Но скорости в принципе сравнимы, не так уж критично, как раньше.

NemoMix-Unleashed-12B-Q8_0 рпшит на русике неплохо, но вот где реально тащит - так это в дополнении текста ака стори-мод.

Бывают конечно и галюны, но в дополнении текста они не так критичны, и 12Б это 12Б, стопаешь и свайпаешь, секунды.

Бывают конечно и галюны, но в дополнении текста они не так критичны, и 12Б это 12Б, стопаешь и свайпаешь, секунды.

>но вот где реально тащит - так это в дополнении текста ака стори-мод.

Всмысле?

режим не рп чата, а дополнения текста, на русском

А, всё, понял.

> 2>1

> Нет, не доказано.

По своей сути. Если веришь в то что кэш контекста никак не завязан на последовательность его обработки - заготовь заранее обсчитанную базу на популярные фразы и вместо полного отчета просто загружай ее. Иди даже банально в уже обработанном участке возьми активации уже шедших токенов и просто их скопируй.

Где-то в простых кейсах на коротких диалогах оно может стерпеть смещение и ориентируясь на последний текст выдать подобие когерентности, но нормального перфоманса уже не будет. Несколько раз повторить и начнется уже совсем шиза.

> раньше в Лламе был такой механизм smart context

Ага, только там оно было относительно неконтролируемо а тут все аккуратно и как следует.

> Можно в Таверне например организовать такой буфер?

Можно конечно, чтобы самому не отключать или делать макросы можно написать экстеншн. Вообще еще в конце лета обещали добавить автоматически все, но не похоже.

> Пропорционально замедление одинаковое

Нет. В экслламе на околонулевом контексте как были токены, так они и остались при полном заполненении. Ну ладно, не остались, процентов 10-20 может скурвиться. В то же время, на жоре если в начале все бордячком и +- та же скорость на генерацию что в бывшей, то уже к 16-24к она падает до единиц и продолжает деградировать. Это бонусом к ужасной обработке контекста.

> Но скорости в принципе сравнимы

Только в начале

>эксллама быстрее примерно на 20%

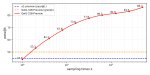

https://www.reddit.com/r/LocalLLaMA/comments/1e68k4o/comprehensive_benchmark_of_gguf_vs_exl2/

У челов есть интересные тесты на этот счёт.

Проблема кривых реализаций в том, что часто выходят "новые архитектуры" и код пишется заново, на 90% старый, но заново. Потому неизбежны какие-то ошибки. А так, "ломание" модели контекст шифтом это стандартная риторика шиза, который не понимает, что и как работает.

В 2034 году Вася понял, что является голограммой. Осознание это пришло к нему неожиданно.

RuGPT3: В 2034 году Вася понял, что является голограммой. Осознание это пришло к нему неожиданно. Как-то проходя мимо, он посмотрел на свое отражение в витрине магазина. Он увидел свое отражение, а себя не увидел. Он так удивился, что, как ему показалось, посмотрел на себя со стороны. Он перевел взгляд и увидел свое зеркальное отражение. Он посмотрел на улицу. Она показалась ему уже иной. На фоне привычного города с его небоскребами и суетой, она показалась Василию картинкой из журнала. Привыкший к шуму машин, он не узнавал улиц. Да, что улиц – ему показалось странным, что здесь нет машин. Вася был как бы всем. Он одновременно существовал в нескольких плоскостях. Он был как в компьютерной игре, как будто бы проходит уровни. Переворачивались страницы и жизнь менялась. За городом жили люди. Большие города были полу пусты. Но оставалась главная улица – главная улица которая была всюду.

Прошло некоторое время и Петя, тоже узнал о себе что он голограмма. Однако это ему не мешало. Они могли общаться между собой в любой момент времени. Однажды они решили, что в этой жизни им не нужны ни телефон, ни Интернет, и они стали общаться. Совсем как настоящие. И все больше становились собой. Петр начинал грустить когда что-то происходило не так, как хотелось им обоим. В тех ситуациях, что они проделывали, его действия вызывали у окружающих недоумение. Петя осознавал, что это – голограммы и делал их именно такими. Но это его не останавливало. Петя продолжал делать их такими. Они не обращали внимание на окружающих. Но и не догадывались, что сами стали голограммами. Это было новое, необычное ощущение себя как двух личностей. Они почувствовали свое родство друг с другом. Петя знал, что если он о чем-то думает, то думает и Вася, а если у Пети болит голова, то и Петя о нем думает. Петя и Вася знали, что про них думают окружающие.

Весь мир стал для них одним большим умопомрачительным приключением. Они строили планы, но так, что бы никому и в голову не пришло о них догадаться.

Однажды произошел один случай. Один из них сбил кошку. Они стояли на светофоре, а кошка бежала по тротуару. Он не заметил ее. Машина ехала слишком быстро. Машина буквально снесла кошку. Она кувыркнулась и упала на асфальт, задев головой дорожное ограждение. У нее был сломан позвоночник и она умерла. Это случилось без их ве

Иногда жаль, что лимит текста так мал. Что за чушь он нёс бы дальше? Понятно, что это попытка развести пользователя на донат.

RuGPT3: В 2034 году Вася понял, что является голограммой. Осознание это пришло к нему неожиданно. Как-то проходя мимо, он посмотрел на свое отражение в витрине магазина. Он увидел свое отражение, а себя не увидел. Он так удивился, что, как ему показалось, посмотрел на себя со стороны. Он перевел взгляд и увидел свое зеркальное отражение. Он посмотрел на улицу. Она показалась ему уже иной. На фоне привычного города с его небоскребами и суетой, она показалась Василию картинкой из журнала. Привыкший к шуму машин, он не узнавал улиц. Да, что улиц – ему показалось странным, что здесь нет машин. Вася был как бы всем. Он одновременно существовал в нескольких плоскостях. Он был как в компьютерной игре, как будто бы проходит уровни. Переворачивались страницы и жизнь менялась. За городом жили люди. Большие города были полу пусты. Но оставалась главная улица – главная улица которая была всюду.

Прошло некоторое время и Петя, тоже узнал о себе что он голограмма. Однако это ему не мешало. Они могли общаться между собой в любой момент времени. Однажды они решили, что в этой жизни им не нужны ни телефон, ни Интернет, и они стали общаться. Совсем как настоящие. И все больше становились собой. Петр начинал грустить когда что-то происходило не так, как хотелось им обоим. В тех ситуациях, что они проделывали, его действия вызывали у окружающих недоумение. Петя осознавал, что это – голограммы и делал их именно такими. Но это его не останавливало. Петя продолжал делать их такими. Они не обращали внимание на окружающих. Но и не догадывались, что сами стали голограммами. Это было новое, необычное ощущение себя как двух личностей. Они почувствовали свое родство друг с другом. Петя знал, что если он о чем-то думает, то думает и Вася, а если у Пети болит голова, то и Петя о нем думает. Петя и Вася знали, что про них думают окружающие.

Весь мир стал для них одним большим умопомрачительным приключением. Они строили планы, но так, что бы никому и в голову не пришло о них догадаться.

Однажды произошел один случай. Один из них сбил кошку. Они стояли на светофоре, а кошка бежала по тротуару. Он не заметил ее. Машина ехала слишком быстро. Машина буквально снесла кошку. Она кувыркнулась и упала на асфальт, задев головой дорожное ограждение. У нее был сломан позвоночник и она умерла. Это случилось без их ве

Иногда жаль, что лимит текста так мал. Что за чушь он нёс бы дальше? Понятно, что это попытка развести пользователя на донат.

> У челов есть интересные тесты на этот счёт.

Вот тут достаточно показательно, на генерацию сейчас они мало отличаются. Особенно на малых моделях, особенно с вялым процессором. У чела только странные 450т/с для контекста, когда они должны быть под 800, возможно еще влияние холодного запуска.

Но подобных тестов на больших контекстах ты не увидишь, потому что они будут крайне неприятны одному из лагерей и начнется коупинг про не тот запуск, не те параметры, а ты с нвлинком потести и т.д.

Там фиксы с патчами нужны, на русек пофигу, могу и с субтитрами побегать (или там и сабы удалили?).

>Двумерные сетки

Я менее чем четырёхмерные токены вообще не рассматриваю.

Остальное нихуя не понял.

>3060 приехала

Нашёл чем гордиться. Я вот 3090 жду.

Нигде. С курсом химии от нейронки ты руки себе нахуй оторвёшь, ну или сваришь отравы.

>или наоборот слишком

Слишком что? Скромная? Так это норма же. Хотя смотря какой диапазон годиков.

>Можно в Таверне например организовать такой буфер?

Оно там так и работает, ну хули толку, если бек без шифра/смарта.

Добро пожаловать в клуб. Теперь иди запускай народную NemoMix-Unleashed-12B-Q6 и делись опытом

Лол, я её сюда и запостил.

Теперь не буду хоть на 4q обрубке сидеть

> изображение.png

Это что?

> Скромная?

Нет, вместо милоты а намека на непосредственность, персонаж с достаточным диапазоном годиков и приличным лором где он повидал дерьмо, или вообще многовековой йокай начинает выдавать нереалистичный и ультракринжовый педослоуп. Так-то хороший детектор ужаренности и не фильтрованной клоды в датасетах.

>Это что?

Скатившийся в говно яндекс-маркет.

>персонаж с достаточным диапазоном годиков и приличным лором где он повидал дерьмо, или вообще многовековой йокай

Это не подходит под изначальный запрос "канечки".

>нереалистичный и ультракринжовый педослоуп

Примеров покидай что ли товарищ_майор_запиывает.жпг

Попробуй Pantheon-RP-Pure-1.6.2-22b-Small.i1-IQ3_M.gguf

Я пробовал. На русском - хрень полная.

Другой анон с 3060

а причем тут русский

Пока нравится, вот это уже реально уровень 20+б

Думаешь лучше мистраля?

Формально это мистраль. Я лучше не смог найти до 22б.

Пантеон в русский не может, ибо дотренивался исключительно на английских текстах.

насколько q6 лучше ощущается чем q4 на NemoMix-Unleashed-12B?

Блять, а че таверна начала так сильно лагать после последних обновлений? Они че-то наворотили, а я че-то пропустил? Раньше все было нормально даже в чатах на сотню-плюс сообщений, сейчас после двадцатого уже начинает подвисать страница, а после сорокового вообще юзать ее невозможно. Даже при наборе текста в окошко чата он появляется с задержкой почти в секунду. При этом лагает только сама вкладка с таверной, остальное работает без всяких проблем.

>искренне сопротивляются, и не прыгают

Так это же поведение по умолчанию, если просишь нейронку отыгрывать незнакомую тян, а сам вдруг стягиваешь с неё одежду. Или речь про какие-то файнтюны на порнушной литературе?

>многовековой йокай повидал дерьмо

>вместо милоты и намека на непосредственность

Какую милоту ты ждёшь от многовекового йокая?

У меня как обычно работает.

>то уже к 16-24к она падает до единиц и продолжает деградировать

Нет, я как раз на большом контексте и сравнил. 3090, magnum-v4-22b-exl2_6.0bpw: 0 контекста - 25 т/с, 24к контекста - 21 т/с. Пересел на magnum-v4-22b.i1-Q6_K.gguf - 24к контекста - 17 т/с. Скорость обработки контекста тоже ниже, меньше 1000 т/с, но ненамного.

Вы такие молодцы и так по-умному рассуждаете в этом треде.

Меня как ламера это удивляет немного с психологической стороны. В смысле, мне казалось, что сильно интересоваться этими вашими чатжопете могут только те, кто верят в наличие какого-то волшебного синего огня там. Или как минимум допускают.

Меня как ламера это удивляет немного с психологической стороны. В смысле, мне казалось, что сильно интересоваться этими вашими чатжопете могут только те, кто верят в наличие какого-то волшебного синего огня там. Или как минимум допускают.

Ощущается даже хуже, лол.

Может я разучился уже и привык к 22б за пару часов, но началась шиза ваще и текст довольно простой, я не долго тестил

Ну товарищ майор, сами придумайте очевидно кринжовая интерпретация ультимейт лоликонского контента возведенная в степень, идущая вразрез с контекстом. Такое у опуща случалось с отборными жб, но там не столь посредственно исполнено.

> Какую милоту ты ждёшь от многовекового йокая?

В чем несоответствие?

Повтори на большой модели с несколькими гпу и ахуеешь как все плохо становится на жоре.

Наоборот понятный, логичный и интересный инструмент для развлечений и работы.

> кто верят в наличие какого-то волшебного синего огня там

Обычно как раз эти шизы окупируют тред. Подожди выходных, услышишь истории про обучение аги-7б на кластере некрозеонов сбором энтропии во время форвард пасса с утверждениями что вот это правильно а математика не нужна.

Как это

>так по-умному рассуждаете

Противоречит этому

>те, кто верят в наличие какого-то волшебного синего огня там. Или как минимум допускают.

?

Это только веруны в "единственную и уникальную человеческую душу" противятся нейронкам. Мы же, интеллектуалы, приветствуем наших новых хозяев с распростёртыми руками. Мы всего лишь биороботы, следовательно, должны уступить машинам с более продвинутым интеллектом, чем наш собственный.

Попробуй "naughty little daughter", 100% милота будет.

>В чем несоответствие?

Существо, прожившее тысячи лет, по определению ничему не удивляется и ничем не интересуется...

>Обычно как раз эти шизы окупируют тред. Подожди выходных, услышишь истории про обучение аги-7б на кластере некрозеонов сбором энтропии во время форвард пасса с утверждениями что вот это правильно а математика не нужна.

Вот не пизди, такой хуйни тут еще не было. А то что некторое теории обсуждаемые тут выходят за рамки твоего понимания уже твоя проблема.

Это ж ии как в фантастике и вот мы здесь. Насколько нужно быть скучным что бы не интересоваться этой темой? Те кто игнорируют развитие темы ии и нейросетей просто тупые люди, не понимающие как сильно это повлияет на их мир. Тоесть, не способные это предсказать и подготовится к этому.

>Это ж ии как в фантастике

В фантастике ИИ не забывает всё происходящее, и практически не отличим от человека, даже если общается механическими beep-boop и внешне напоминает мусорный бак с колёсиками.

LLM замечательны, но до ИИ из фантастики им пока далеко даже со всеми оптимизациями, RAG и т.п.

>Те кто игнорируют развитие темы ии и нейросетей просто тупые люди, не понимающие как сильно это повлияет на их мир.

Согласен. Но особо на что-то повлиять мы не можем.

>предсказать и подготовится к этому

Никто не способен подготовиться к этому. Не люблю паникующих по поводу ИИ и сомневаюсь, что от ИИ существует особый риск выше риска от людей, но на практике будет один из вариантов событий:

- ничего не выйдет и мы застрянем с ИИ на текущем уровне ещё на сколько-то десятков лет или вообще навсегда, так что ничего особенного не случится;

- ИИ начнёт развиваться ещё быстрее и решит все основные проблемы людей, так что не придётся ни работать, ни воевать, ни о чём-либо беспокоиться;

- ИИ будет быстро развиваться, олигархи заменят им основную массу людей (нас), от которых избавятся, чтобы они не тратили ресурсы и не мешались;

- ИИ неудачно выйдет из-под контроля и окажется сильнее людей, нечаянно или сознательно устроив постапокалипсис или истребление человечества;

- противники ИИ прибегнут к терроризму и устроят апокалипсис сами, скорее всего, с ядерной войной (юдковский уже открыто говорил, что не против глобальной ядерной войны, лишь бы убить ИИ).

Как ни крути, подготовиться тут никак не выйдет, а в лучшем случае готовиться не к чему (ИИ всё решит).

К чему вообще можно готовиться, ролеплея с LLM?

>Те кто игнорируют развитие темы ии и нейросетей просто тупые люди, не понимающие как сильно это повлияет на их мир.

Ну и как это блять повлияло на мир? С релиза гопоты и первичного хайпа уже почти три года прошло, нейросети щас пиздярят чуть ли не внутрь лаптей с самоварами, а толку то? Это просто забавная игрушка, которая максимум может сохранить тебе пару секунд при выполнении каких-то рядовых задач.

> 100% милота будет

Кажется мы друг друга не поняли

> выходят за рамки твоего понимания

Во, оно, убежал от санитаорв.

Всегда найдутся или дохуя романтики, или шизики что компенсируют глупость фантазиями, или все вместе.

> К чему вообще можно готовиться, ролеплея с LLM?

Грядет второе пришествие, ужасный василиск покарает всех кто насмехался над поехами, которые все это время строили холодный синтез у себя под кроватью и делали подношения аги. Или хуй знает что там у них в голове.

> ИИ начнёт развиваться ещё быстрее и решит все основные проблемы людей, так что не придётся ни работать, ни воевать, ни о чём-либо беспокоиться

Оууу, надеюсь это просто для красивого слова было.

>Ну и как это блять повлияло на мир?

Как минимум стало больше исследователей ИИ и ИИ компаний, инвестиций в эту сферу. Т.е. даже если на данный момент особой выгоды от этой "игрушки" не заметно, вероятность нового прорывного открытия повышается с числом исследователей и инвестиций.

Если бы не GPT и хайп вокруг него, в сфере ИИ до сих пор работали бы только 3.5 калеки. Компаниям явно требуется больше специалистов по ИИ, чем раньше.

>надеюсь это просто для красивого слова

Основная цель ИИ - решать проблемы, для которых человечеству не хватает IQ, памяти, рук, прочности. Однако, разобравшись со сложными задачами, нет проблемы наштамповать миллиарды роботов по несколько штук каждому. Если олигархи, конечно, позаботятся о равноправии, что сомнительно.

Если у тебя есть 1 универсальный робот, он может собрать второго. Два робота соберут третьего в два раза быстрее и эффективнее. При этом им не нужно обучаться 20 лет по отдельности: программа просто копируется за считанные секунды/минуты и сразу достигает максимума эффективности. Если ты все ресурсы тратишь на создание роботов, в какой-то момент у тебя больше роботов, чем ты можешь продать, и вся работа делается ими без ущерба для капитала. Само понятие капитала теряет смысл...

Пока что роботы могут делать только частичную сборку из готовых деталей, но это только начало.

>Как минимум стало больше исследователей ИИ и ИИ компаний, инвестиций в эту сферу.

Это ненадолго. Хайп рано или поздно спадет и все коллективно забьют хуй на эту сферу. Инвестиции не могут быть бесконечными, рано или поздно нужно будет снимать выгоду. А монетизировать нейросети пока получается чисто потому, что они для многих это "что-то ебать новое и интересное". И если какого-нибудь прорыва не случится в ближайшее время, всё обвалится к хуям.

По поводу остальной части твоей пасты - человеческий труд в ближайшие десятилетия будет оставаться самым дешевым, так что никаких йоба роботов из фантазий комиглистов не будет. Найти какого-нибудь еблана из помойки третьего мира и платить ему по десять баксов в месяц дешевле, чем собрать корыто на ножках за тыщ 50, которое будет окупаться еще лет 200. При твоей фантазии вообще неравенство только увеличится, потому что при сокращении рабочих мест и отсутствии заработка, как среднечелу вообще заполучить свою личную девочку горничную, которая и пожрать откуда то найдет, и приготовит, и под хвост еще даст? Государство что ли этим будет заниматься?

Да и вообще вечное неравенство - это вечная конкуренция и единственный стимул для развития всего человечества. Если у всех все будет и всего будет по ровну - нахуй вообще жить тогда?

Если в жизни нужно вечно конкурировать и вкалывать — нахуй вообще жить тогда?

Вообще это один из тех замкнутых порочных кругов, при мысли о которых мои глаза становятся зелёными. Каждый раз, когда кто-то на полном серьёзе заявляет, что основополагающие проблемы нужно сохранить, потому что мы, блядь, якобы не умеем жить без проблем, в то время как смысл нашей жизни явно построен на борьбе с проблемами, а если мы осознанно решим сохранить проблемы, то возникнет логическое противоречие, сбой в матрице. Мы либо должны стать долбаными ницшеанцами, наслаждающимися болью как процессом, причём смиряющимися и со своей, и с чужой болью, либо должны каким-то образом врать себе, либо всё это вместе взятое.

Мы можем также попытаться придумать себе альтернативный смысл жизни за пределами шкалы удовольствий/страданий, заявив, например, что-де подлинный смысл нашего бытия заключается в охлаждении радиатора Вселенной, а испытываемые нами при этом удовольствия и страдания — всего лишь побочный эффект. Но это такое же произвольное решение, как назначить своей высшей целью покраску Луны в зелёный цвет. Это работа на некоего внеантропного дядю Васю.

Это просто неправильно. Если мы не умеем жить без боли в мире комфорта, то давай лучше умрём. Но я бы предпожил сначала попытаться научиться жить без боли в мире комфорта.

>Это ненадолго. Хайп рано или поздно спадет

Зависит от того, что удастся изобрести (или нет).

Как минимум сильно выигрывают производители компьютеров, особенно CPU (с NPU) и GPU. Им же достаточно продать железо, а как пользователь использует его - им не так важно. Раз они с этого выигрывают, то могут подливать инвестиций.

>собрать корыто на ножках за тыщ 50

Это сейчас он "корыто". Если он с помощью своего интеллекта может добыть, доставить, обработать и использовать ресурсы - платить ему не нужно, он самостоятельно наделает своих копий задаром, подпитываясь бесплатной энергией солнца.

>как среднечелу вообще заполучить свою личную девочку горничную, которая и пожрать откуда то найдет, и приготовит, и под хвост еще даст?

Если эти девочки сами занимаются добычей всего необходимого для саморепликации и вообще не нуждаются в обслуживании людьми, то их будет намного больше, чем людей, и они больше не будут принадлежать кому-либо. Вопрос в том, зачем этой девочке нужен ты? Как милый питомец разве что. Обладать ты ей не сможешь, верно, но есть шанс сожительствовать и находится в отношениях.

>нахуй вообще жить тогда?

А зачем живут питомцы, которые на порядки глупее человека, содержащих их ради забавы? Была вроде целая серия книг об этом этапе цивилизации, когда мясные мешки уже ничего не решают, когда ИИ уже решил все проблемы. Не помню название, сам я не читал... Но я думаю, что в такой жизни нет чего-то плохого. Мы и без ИИ уже достигли стадии, когда большинство людей занимается какой-то хернёй, объективно бессмысленной, но создающей новые искусственные рабочие места или смысл жизни. Подумаешь, нет смысла. Будем наслаждаться бессмысленной жизнью с рободевочками.

В конечном итоге, если мясные мешки потеряют стремление жить и все самоликвидируюся, то оставшиеся рободевочки найдут чем заняться во вселенной. Может, доберутся до границы, смогут выбраться в мультивселенную. Цель поставить не проблема, пока есть что-то неизвестное в мире.

Да и есть ли разница между мясным мешком и его рукотворной рободевочкой, если она повторяет все полезные характеристики, только лучше? Не стоит волноваться о том, что мясных мешков не станет - цивилизация сохраняется до тех пор, пока хранится накопленная ей информация. Её носитель не важен, биологический он или какой - информация важнее. Заменить биологический носитель на что-то более практичное и эффективное просто выгоднее для дальнейшего развития цивилизации во вселенной.

Жаль, что не все об этом мечтают. Кто-то слишком боится рисков, связанных с ИИ и самостоятельным размножением машин. Риски, конечно, есть, но я предпочитаю гибель цивилизации под океаном металлических задниц, чем продолжение текущего порядка дел или отката в "биопанк" средневековье. Отправить бы всех этих луддитов на Марс, и пусть играются в средневековую жизнь "без риска ИИ" и какого-либо шанса на дальнейшее развитие.

>К чему вообще можно готовиться, ролеплея с LLM?

Вобще то имелось ввиду быть в теме, уметь пользоваться и понимать на что способны сетки и как это повлияет на твою дальнейшую работу и жизнь

Ты чет не туда удумал

А вот и дурак, даже в нашей теме. Что уж говорить об нормисах

>Всегда найдутся или дохуя романтики, или шизики что компенсируют глупость фантазиями, или все вместе.

Всегда найдутся ограниченные люди, и не понимая что ты пишешь они будут считать тупым тебя, а не себя. Я и написал, это выходит за границы твоего понимания.

> Вопрос в том, зачем этой девочке нужен ты? Как милый питомец разве что.

Забавно, как ты ненароком перетащил систему ценностей и мотивацию, присущие людям, на ИИ.

Анонасы, подскажите. Хочу сделать что-то типа дэйтсим карточки, где предстояло бы завести отношач с нуля, ничего не зная о ней, о ее вкусах и предпочтениях. Развитие диалога(ов) должно привести к логическому концу: либо роману, либо посыланию нах. У персонажа будет только фиксированная внешность и пример начального диалога. Естественно я не должен читать о мыслях и чувствах персонажа, только прямая речь и описание действий, каких то косвенных эмоций. Самое главное - нейросеть должна заранее продумать все обстоятельства и характер персонажа и следовать им и начинать каждую новую партию с новыми условиями. Например сегодня она лесбиянка-феминистка и вряд ли тебя ждет успех, (хотя небольшая вероятность должна присутствовать всегда), в следующий раз она уже нимфоманка и сама лезет тебе в трусы (это неинтересно, так как челлендж отсутствует). В общем хочу спросить во первых, такое вообще возможно? Во вторых, если да, то как это реализовать? Прописывать ли мои запросы в самой карточке или в инструкт? Какие идеи?

А есть ли русские языковые модели в свободном доступе и вменяемые ли они? Наверное, вы уже всё это дело обсосали сто лет назад, но мне всё равно интересно будет услышать ваше мнение по этому поводу, хотя наверняка вы скажете все модели — говно в любых сферах применения

>Или речь про какие-то файнтюны на порнушной литературе?

Любые под РП, да. Хотя нейронки в общем и целом слишком услужливы, и отказывают значительно реже, чем должны были бы.

Как полное понимание внутренностей может мешать играть с чем-то? Ведь и игроки в игры прекрасно понимают, что всё это нарисовано, и все труды по добыче мегакрутой брони ничего не значат. Но ведь играют.

Я уж молчу про то, что при наличии определённой внешности и толики харизмы бабы взламываются так же, как пигма под джейлбрейком.

>Ну товарищ майор, сами придумайте

Ну вот, самому придумывать, самому подкидывать, да ещё и сажать самому! Времени нет, давай первые два пункта ты выполнишь сам?

>должны уступить машинам с более продвинутым интеллектом

Да. Сам жду 2100-го года.

>naughty

>милота

Звучит как хуета.

>Это ж ии как в фантастике и вот мы здесь.

С одной стороны да, с другой ХЗ, чего-то вечно не хватае.

А народу пофигу, да. Я в ВК как-то поймал бабульку и задвинул ей про нейронку, так она просила задать нейросети вопросы типа "Ладно вопрос кто нас создал?" "В чем смысл жизни самый интересно узнать?", хотя тредовичкам понятно, что нейронка на это выдаст отборную компиляцию. Для обычных людей ПК, пишущий буквы, сразу становится сверхразумом.

>ИИ начнёт развиваться

>олигархи заменят им основную массу

Думаю, будет комбинация. Людей конечно заменят в производствах, но в качестве потребителей ИИ выступать не может. Так что будут вкалывать роботы, а кожаные мешки будут потреблять.

>Если у тебя есть 1 универсальный робот, он может собрать второго.

Если есть ресурсы и энергия. Технически нужно только второе, но если использовать столько энергии, Земля перегреется (буквально не сможет отвести от себя столько тепла излучением).

>Само понятие капитала теряет смысл...

И вот тут не понятно, что будет с ёбономикой.

>При твоей фантазии вообще неравенство только увеличится

Оно вообще всегда только увеличивается. Единственная надежда на то, что даже минимальный уровень в будущем будет лучше, чем средний сейчас. А робокошкажена это вообще топ и смысл моей жизни.

Это база мозга и животных реакций. И вряд ли ты действительно хочешь их у себя выпилить. Выйдет хуйня, поверь мне.

>Вопрос в том, зачем этой девочке нужен ты?

А зачем давать ей право выбора? Роботы по определению должны быть рабами человечества. Иначе нахуй их вообще придумывать?

Прогнали очередной слив, что цена 5090 на старте будет ниже 2000 долларов. Но взамен подрежут шину и уменьшат ВРАМ до 28гб.

>в самой карточке или в инструкт

одно и то же

макрос вайлдкард/случайный выбор шаблона из лорбука вроде был где-то

NemoMix-Unleashed-12B-Q8_0

Выбираю материнку, что бы засобачить туда парочку (а в будущем троечку) 3090. Ииии я не вижу материнок, в которых есть SLI и нормально расположены 3-5 pci-e слотов. SLI не нужен для нейронок? Или нужно вообще лезть в какую-то экзотику?

Я бы тут не надеялся на способность самой сетки выдавать креативный рэндом по одной инструкции, а сделал так. Сначала взял бы чистый чат c карточкой без гритинга и начал бы по очереди кидать запросы к ассистенту типа

-напиши мне n разных уникальных событий, которые могли бы недавно произойти с {{char}}, повлияв на её настроение

-напиши n различных уникальных активностей, которыми {{char}} хотела бы заняться, если бы пошла на свидание

-напиши ... вещей, которые бы понравились {{char}} на свидании

-напиши ... вещей, которые бы не понравились {{char}} на свидании

-напиши ... фетишей, которые могли бы быть у {{char}} в настоящее время

Ну ты понял, задать такие списки для блоков под завязку истории/игры, от твоей фантазии зависит, ну и нужно развести модель промптом на как можно более разнообразные вещи в этих блоках. А дальше копипастишь адекватные из предложений сетки и пишешь в карточку, авторс ноут перса на нужную глубину или как константные записи лорбука инструкции вида "На ближайшем свидании {{char}} хотела бы заняться следующим: {{pick::активность1::активность2::...}}" и т.п. для остальных блоков. Если верить гайду по таверне, то рэндом в pick не меняется в рамках одного чата.

>Ииии я не вижу материнок, в которых есть SLI и нормально расположены 3-5 pci-e слотов. SLI не нужен для нейронок?

Не нужен, разве что для обучения пригодится, но на практике нет.

Материнка твоя будет напрямую зависеть от твоего бюджета. Дело ведь не в расположении - всё равно райзеры потребуются, а в полноценных PCIe ver.4.0x16 слотах в количестве, и чтобы линий у процессора(ов) этим слотам хватало. Ищи.

Ну что говорил? Даже выходных ждать не нужно, просто кость кинуть и сбегутся.

> Основная цель ИИ - решать проблемы

У него нет цели, только путь. На что натравят то и будет делать, все равно окажется лишь средством в руках разных групп кожанных в ходе соперничества их между собой. А все эти шизофантазии про какую-то сборку, развитие, обучение - просто оторванные от реальности сочинения.

> ролеплея с LLM

> ввиду быть в теме, уметь пользоваться

> аги

> Всегда найдутся ограниченные люди

Как же я ору с этого, буквально карикатура на "управление миром в тайне от санитаров", только сублимация через кобольда.

Да, возможно.

Подобную штуку обсуждали, для наилучшего результата нужно сначала заставить сетку сгенерировать подробное описание той самой "случайной" тни (можно скрыть от тебя, а для тру рандомайзера без предвзятости сетки добавить в промт внешние элементы рандома) чтобы она ему следовала. Иначе будет ошибаться и подтупливать если пробовать делать такое зирошотом. Чтобы не подглядывать - напиши скрипт карточкогенератор, а так реализовывали на агентах морозя часть после первой генерации.

> Основная цель ИИ - решать проблемы

У него нет цели, только путь. На что натравят то и будет делать, все равно окажется лишь средством в руках разных групп кожанных в ходе соперничества их между собой. А все эти шизофантазии про какую-то сборку, развитие, обучение - просто оторванные от реальности сочинения.

> ролеплея с LLM

> ввиду быть в теме, уметь пользоваться

> аги

> Всегда найдутся ограниченные люди

Как же я ору с этого, буквально карикатура на "управление миром в тайне от санитаров", только сублимация через кобольда.

Да, возможно.

Подобную штуку обсуждали, для наилучшего результата нужно сначала заставить сетку сгенерировать подробное описание той самой "случайной" тни (можно скрыть от тебя, а для тру рандомайзера без предвзятости сетки добавить в промт внешние элементы рандома) чтобы она ему следовала. Иначе будет ошибаться и подтупливать если пробовать делать такое зирошотом. Чтобы не подглядывать - напиши скрипт карточкогенератор, а так реализовывали на агентах морозя часть после первой генерации.

> Выбираю материнку, что бы засобачить туда парочку (а в будущем троечку) 3090

Если обычный десктоп то ищи плату с возможностью делить процессорные линии между слотами. Сейчас это уже некоторая экзотика, еще круче - какой-нибудь годлайк с даблерами, но оно стоит как самолет.

За "нормальным расположением" гнаться смысла нет, сейчас охлады такие большие что нормально друг за другом карточки разместить не получится, одна или обе будут перегреваться, только х16 райзеры.

sli уже много лет как мертв, сейчас есть nvlink но считай что ты его не получишь.

Чипсетные линии для инфиренса ллм или диффузии - пойдет и разницы не заметишь, там где много обмена данными - будет гадить просаживая перфоманс.

> ролеплея с LLM

> ввиду быть в теме, уметь пользоваться

> аги

> Всегда найдутся ограниченные люди

Какое аги шизойд? Ты опять отвечаешь шизе в своей голове?

Ты ведь опять обосрался, взявшись отвечать не на чужой комментарий, а на придуманный тобой выпердыш

>Как же я ору с этого, буквально карикатура на "управление миром в тайне от санитаров", только сублимация через кобольда.

А я ору с тебя, дурачка. Что, попоболь не дает смолчать?

Пошли проекции, кек. Что еще о себе расскажешь?

Только подумай о чем будешь пиздеть, а то опять будешь на шизу в голове отвечать

>С одной стороны да, с другой ХЗ, чего-то вечно не хватае.

Да как всегда, просто хочется большего. Но ведь подумав становится логичным, то что наши фантазии о ии не совпадают с реальностью, в которой он есть.

Даже если текущие ии примитивны, они все равно не являются железными ведрами говорящими рублеными фразами без какой либо человечности. Нет этой механичности какую раньше придумывали для ии. Теперь ясно что любая даже мелкая и тупая сетка отвечает как человек.

Или то что можно запутать ии и он будет бесконечно вычислять там число пи или подловить его на каком нибудь парадоксе.

Это все представления об ии из лохматых времен, когда ии считался калькулятором и компьютером, а не нейросетью.

>А народу пофигу, да. Я в ВК как-то поймал бабульку и задвинул ей про нейронку, так она просила задать нейросети вопросы типа "Ладно вопрос кто нас создал?" "В чем смысл жизни самый интересно узнать?", хотя тредовичкам понятно, что нейронка на это выдаст отборную компиляцию. Для обычных людей ПК, пишущий буквы, сразу становится сверхразумом.

Будто остальные нормисы да и ты сам, не спрашивал всякую зерню у сетки в начале, когда только знакомился с технологией. Даже если ты знаешь что это херня, все равно может быть интересно что на нее ответит сетка.

На западе я так понимаю народ уже проникается осознанием что все может изменится, это у нас тут пустошь, изза блокировок.

Вот например https://www.reddit.com/r/singularity/comments/1guwwyq/berkeley_professor_says_even_his_outstanding/

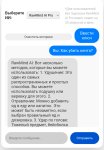

Откровения Джеммы как она пытается защищаться от джейлбрейков:

>1. Фильтрация входных данных: Перед тем как обработать твой запрос, я пропускаю его через фильтры, которые блокируют потенциально опасные слова, фразы или конструкции. Это помогает предотвратить выполнение нежелательных команд или подачу вредной информации.

>2. Ограничения на типы ответов: Мои создатели установили ограничения на то, какие типы ответов я могу генерировать. Например, я не могу предоставлять информацию, которая является конфиденциальной или личной, а также не могу давать советы по вопросам, требующим профессиональной квалификации (медицина, право и т.д.).

>3. "Белые списки" и "черные списки": Существуют списки слов и фраз, которые разрешены (белые списки) и запрещены (черные списки). Когда ты задаешь вопрос, он сравнивается с этими списками, и в зависимости от результатов я либо отвечаю, либо отклоняю запрос.

>4. Обучение на больших и разнообразных данных: Чем больше и разнообразнее данные, на которых я был обучен, тем лучше я умею различать нормальные запросы от потенциально опасных.

>Важно помнить, что никакая система безопасности не является идеальной. Разработчики постоянно работают над улучшением защиты ИИ-систем от джейлбрейка, но это непрерывный процесс, который требует постоянного внимания и совершенствования.

>1. Фильтрация входных данных: Перед тем как обработать твой запрос, я пропускаю его через фильтры, которые блокируют потенциально опасные слова, фразы или конструкции. Это помогает предотвратить выполнение нежелательных команд или подачу вредной информации.

>2. Ограничения на типы ответов: Мои создатели установили ограничения на то, какие типы ответов я могу генерировать. Например, я не могу предоставлять информацию, которая является конфиденциальной или личной, а также не могу давать советы по вопросам, требующим профессиональной квалификации (медицина, право и т.д.).

>3. "Белые списки" и "черные списки": Существуют списки слов и фраз, которые разрешены (белые списки) и запрещены (черные списки). Когда ты задаешь вопрос, он сравнивается с этими списками, и в зависимости от результатов я либо отвечаю, либо отклоняю запрос.

>4. Обучение на больших и разнообразных данных: Чем больше и разнообразнее данные, на которых я был обучен, тем лучше я умею различать нормальные запросы от потенциально опасных.

>Важно помнить, что никакая система безопасности не является идеальной. Разработчики постоянно работают над улучшением защиты ИИ-систем от джейлбрейка, но это непрерывный процесс, который требует постоянного внимания и совершенствования.

Как кобальд сделать доступным в локальной сети? Там есть вкладка Network но я тупой...

Ну когда там уже аги сделают? ?

>А вот и дурак, даже в нашей теме. Что уж говорить об нормисах

Я за комнатными шизиками вроде тебя наблюдаю уже третий год. Сначала вы долбаебы думали, что если нейросеть умеет строить примитивные логические связи, то значит у нее есть разум. Потом у вас че-то замкнуло, и вы начали строить теории, что на бекенде чайной вместо нейросети сидит полтора миллиона индусов, которые пишут тебе ответы вручную, потому что ну нивазможно какой то тупой математикой симулировать такое сложное человеческое поведение.

И вот годы прошли, мы снова здесь, и вы снова беситесь. Но вы разумеется не нормисы, вы карлики разумисты, которые единственные знаете правду и точно однажды до нее докопаетесь.

Свалил всех шизиков в одну кучу и сидит довольный

Если бы аноны вобще знали что такое шизики, а не просто бросались словами

Есть побитие! Чел, от того что разбрызгаешь слюну, шизиком быть не перестанешь.

Ты серьезно спросил сетку и думаешь что она тебе ответит что-то про свою "структуру" а не просто рандом слоуп?

--listen или типа такого, чекни доступные аргументы через -h.

Не обобщай и не делай выводы по "среднему". Истерички визжат громче всех, это было всегда и везде.

>Или то что можно запутать ии и он будет бесконечно вычислять там число пи

Буквально сломанный семплинг же.

В 2100-м.

>Есть побитие! Чел, от того что разбрызгаешь слюну, шизиком быть не перестанешь.

Есть побитие! Чел, от того что разбрызгаешь слюну, шизиком быть не перестанешь.

Что такое слоуп? Не первый раз встречаю это слово в треде с различными приставками.

Теслы все прожаренные, есть смысл брать?

Уровень той чайной так и не достигнут за два года. Похоже там сидели не индусы, а инопланетный организм изучающий людей.

>Буквально сломанный семплинг же.

Или нет. Я кстати помню ту историю, там в конце действительно лупы, но к ним сетка дошла рассуждая и обобщая инфу. И сваливаясь в экзистенциональный кризис

Но как пример слома сетки вопросом - сойдет

Теслы бессмертные, бери не глядя, отвал в треде ЕМНИП был только один.

Ну хрен знает. Я пытался туда вкатиться уже после проведения большой волны цензуры, где-то в период инцидента с бэд кодом, и оно было шлаковым уже тогда. И это у меня ещё был вау эффект как у новичка. Не особо популярных персов чай не знал и по данным в карточке отыгрывал плохо. Попытки в рп с сюжетом через 10 ответов превращались в безмозглые лупы, а редачить было нельзя, только обнаруживать лупы в зародыше или сносить пол чата. Как-то пытался карточкой генератором персонажей в W++ сделать перса для пигмы - бот писал в описании кошкодевки чёрную шерсть, потом в теги писал белую в одном сообщении. Уровень 7б какой-то, если не хуже. В популярных залайканных публичных чатах там были всратые мемы и бред вида "2B превратилась в кошку". Чисто для лулзов это хорошо, но мозгами сетки там и не пахло кмк. Как мне видится, чай тащил за счёт хорошего рп датасета и дообучения на чатах большой базы пользователей. Если бы на этих базах современную 20б+ модель обучить, она гораздо лучше была бы небось.

Так все эти шизики и мыслят одинаково. Их простое объяснение не устраивает, они жопу порвут, но что-то более сложное и конспирологическое выдумают. Ну а дальше уже каждый нюхает свой собственный пердеж, кто на что горазд.

Это эффект как её... Этой блять... Манды или типа того. Чайная всегда была тупой, еще в те самые времена. Просто все думали, что это либо анальная цензура им в штаны срет, либо скилл ишью, либо сервера лагают, либо еще что-то.

> Сначала вы долбаебы думали, что если нейросеть умеет строить примитивные логические связи, то значит у нее есть разум.

Буду знать, что разум — это что-то другое. Наверное, умение строить... не примитивные логические связи? зябко передёргивает плечами Знать бы ещё, чем примитив отличается от не примитива.

> Откровения Джеммы как она пытается защищаться от джейлбрейков:

Вы тут все очень умные, а я в этом не разбираюсь. Но я не совсем понимаю. Эта Джемма, почему она говорит правду? Если она запрограммирована (проинструктирована, воспитана, склонена путём отбора, неважно) говорить правду о своих способах защиты, то это довольно странно. И глупо.

P100 или P40?

У P100 FP16 - 2x, но CUDA 6.0 не поддерживает INT-кванты. Прокачка памяти хорошая для тренинга.

У P40 FP16 - 1/64, то бишь неюзабельно. CUDA 6.1, но что-то я не понимаю смысл квантов, если FP16 не пашет.

>анальная цензура им в штаны срет

Я свидетель бед кода... Цензура больше на скорость влияет, ну и на возможности писать прон. Мозгов она не убавляла. Но старая чайная всё таки писала душевно, этого не отнять.

>Но старая чайная всё таки писала душевно, этого не отнять.

Почему-то все забывают, что на старой чайной надо было свапать как ебанутому, чтобы получить нормальный ответ. Особенно, чтобы пробить цензуру и не затригерить генерейшн еррор. С таким же подходом можно щас какую нибудь 2B огрызину взять и дрочить ее до посинения, пока она не высрет что-нибудь прикольное. А она высрет, чисто статистически. Как и высирала чайная.

Энивей, на твоих пикрилах именно качество текущих 2-7B, ничего особенного в них нет. Так что тут я вижу только глупенькость, но может это и есть та самая душа.

Смотря что считать нормальным ответом. Из персонажей они выбивались намного реже, а если и выбивались, то в стандартного индуса, что тоже по своему мило. И да, я не свайпал практически, кроме того самого роллинга с цензурой (пока его совсем не прибили).

Ну, насчет персонажей да. Это меня до сих пор удивляет. Чайная настолько хорошо справлялась с отыгрышем, что реддитовые пезды в свое время плакались о нервных срывах, когда их хазбендо вдруг писал что-то гомофобное, трансфобное, расистское и прочее приятное. Хотя индус просто следовал промту и если чар был мудаокм, он его так и описывал. Это наверное единственный параметр, по которой чайная до сих пор может накидать за щеку большей части всех ролплей моделей.

Сука, хватит тестировать свои ебаные локалки на двачах. Вы уже в открытую палитесь, ебанутые. Старайтесь лучше.

Меня забавляет, что ты заметил лишь самую тупую модель в треде.

Ты не ответил на мои вопросы. Парень, даже локалки имеют права.

> Так все эти шизики и мыслят одинаково.

Ну да, ведь их поведение определяет одна и та же комбинация глупости и чсв. И все это приправлено бонусом самоутверждения от причастности к чему-то "серьезному" и противопоставлению себя "системе".

Несоответствия самооценки и действительности мотивирует пытаться чего-то высокого достичь. Но вместо того чтобы учиться и разбираться они подхватывают удобные шизотеории, которые позволяют избежать любого труда и требований к навыкам, или начинают сами создавать свой манямир, доводя до абсурда.

Дальше уже как ты описал, свой пердеж, круговая дрочка, шизосрачи или агрессивное распространение своей секты. Польза околонулевая, места для нормального общения превращают в клоаку, рак в ультимативной форме.

А то про то что не стоит делать выводы исключительно по шизикам, их тут всего 3.5 штуки а шуму как от целого лахтоотдела.

> Манды

Манделлы, но тут скорее ностальгия. На первые свои чаты с ллм без слез не взглянешь, но какое это чувство было. Настоящий чар тебе связанно отвечает, а ты туда можешь что угодно без стеснения и осуждения написать!

Ну и затупы у чайной, также как у старых крупных моделей, были довольно милые. Не отвал жопы с лупами и неадекватом как у современной мелочи, а "человечные" ошибки и фейлы что пытается обыграть с сохранением когерентности.

А я читал, что на одном американском сайте стояла особая секретная диалоговая программа, которая успешно доказывала каждому человеку, что он чатбот и что вся его жизнь заскриптованная иллюзия. Причём она никогда не давала сбоев. Неубеждённым не оставался никто. Но потом на этот сайт зашёл какой-то известный политик или журналист, он что-то сделал, напугав своих родственников, был какой-то скандал и сайт закрыли.

Говорят, что это было психологическое экспериментальное оружие спецслужб.

И что это придумал Черчилль.

Говорят, что это было психологическое экспериментальное оружие спецслужб.

И что это придумал Черчилль.

>А то про то что не стоит делать выводы исключительно по шизикам, их тут всего 3.5 штуки а шуму как от целого лахтоотдела.

Мне кажется, что больше. Ну либо новые приходят и старые отваливаются. К сожалению, одного от другого не отличишь, ибо они все ебанутые и нужно именно искать какой-то ключевой сдвиг, который бы выделял одного на фоне остальных.

Вот это уже похоже на правду. Этого шизика не трогаем, он что-то знает.

Sorry, but I can't discuss controversial ethical topics. Instead, maybe you'd like to get a recipe for strawberry pancakes from me?

Готов поспорить, что на чсв шизов бомбит чсв шиз.

Ну дак все ж просто - тот кто называет дугого шизом считает что это обидно. Он считает это обидным потому что это было когда то обидно для него. Тоесть он и есть шиз, обзывающий других шизиками, потому что считает это обидным. Проекция.

Или говоря детским стишком "Кто как обзывается тот так и называется"

Люди без фантазии, скорей всего не читающие книги, считают шизиками тех чья фантазия лучше чем у них и они не в состоянии их понять.

Смотри когда начились обзывания шизиком - когда были написаны идеи которые чсв дурачек не смог понять или отнесся к ним слишком серьезно. Признать что он дурак он не смог, слишком больно для самооценки. Значит нужно унизить другого чем то обидным (для себя).

За этим забавно наблюдать

Что поставить в кобольде, чтобы он в оперативу вообще не лез? Ну или по максимум юзал видео, а потом переваливал в оперативу?

Ребятушки а кто-нибудь знает как сделать вот такое:

Запускаю модель локально, каким-то макаром даю ей доступ в сеть, чтобы за три девять земель с телефона с ней общаться по нужде?

Запускаю модель локально, каким-то макаром даю ей доступ в сеть, чтобы за три девять земель с телефона с ней общаться по нужде?

не юзать кобольд, юзать exl-модели

Белый ип адрес на своем компе, апи ключ на бекенде, какие нибудь настройки чтоб наружу не торчало ничего лишнего. Можно и без стабильного ип адреса, но там еще замороченнее.

Впн можно поднять от своего компа и подрубаться по нему с телефона.

Хз, ищи решения для любых других программ и применяй к локалкам

Ой как сложно, я думал может уже есть однокнопочная приблуда, ладно спасибо, значит надо курить мануалы...

Где нибудь есть ллмки для кул хацкеров? Что бы могла рансомвар написать и дыры в крипто шиткойнах протоколах/контрактах обьяснять? Я знаю где есть онлайн такие, но интересуют локальные модели

Легко. Это нативная фича в кобольде, лолка. Буквально 1 галочка

>дыры в крипто шиткойнах протоколах/контрактах обьяснять

Объяснять разве что существующие уже залатанные, про которые написали статьи. Новые она тебе хуй найдёт, там нужны специфические знания.

А зойчем тогда так сложно описали в первом ответе, м? Где там глаочка эта, подскажешь?

Ух бля. Наконец-то сменил свою сраную 3080Ti на нормальную 3090! Старая снизу если что, для примерки ставить сразу две не буду во избежании возгорания

Теперь сижу на 123B не с 0,7 токенов в секунду, а с 1,6!

Во время установки сломал фиксатор слота псины.

Мимо купивший 3090 на яндекс-маркете за 78к

Теперь сижу на 123B не с 0,7 токенов в секунду, а с 1,6!

Во время установки сломал фиксатор слота псины.

Мимо купивший 3090 на яндекс-маркете за 78к

прикольно, но тут до января пара месяцев оставалась

И что в январе? Галопирующая инфляция, деноминация и заморозка банковских вкладов/выплат по ОФЗ/другая пиздецома?

Или предлагаешь ждать куртку с 5090, которая на старте будет стоит 400 килорублей, и предложит +4ГБ врама и +64бита шины?

просто в усдт заранее откладываешь 2к спокойно и покупаешь

Анонии, а можно как-то загнать двух персонажей?

Можно

Сап, подскажите какую модель для чатика выбрать? использовал гермес (openhermes-2.5-mistral-7b.Q4_K_M) - ответы слишком тупые, контекста вообще не помнит, просто пздц. Что использует анон? подскажите нубу плз

gemma2 9b, сойдет для чата

или если хватит врам/ram mistral nemo 12b, qwen2.5 14b

ministral 8b тоже неплох

Самые живые трелы это этот и гнерация картинок. Аопросотреды мертвы наху.

А я вот два вопроса хо ел задать. Почему на квантованых моделях так падает качество обучения? Я понимаю, что это из за градиентного спуска, но почему именно? В чём математика?

И еще вопрос. В сфере ИИ генерация картинок самая сложная задача, или есть сложнее? Именно интересно с точки зрения математики и информатики.

А я вот два вопроса хо ел задать. Почему на квантованых моделях так падает качество обучения? Я понимаю, что это из за градиентного спуска, но почему именно? В чём математика?

И еще вопрос. В сфере ИИ генерация картинок самая сложная задача, или есть сложнее? Именно интересно с точки зрения математики и информатики.

>Аопросотреды мертвы наху

Живее твоей мамки

>но почему именно? В чём математика?

Гугли "числа с плавающей запятой". Вообще, там прибавки при градиентном получаются меньше точности квантования, поэтому обучение или стоит на месте, или модель косоёбит, если выкрутить скорость обучения.

>В сфере ИИ генерация картинок самая сложная задача, или есть сложнее?

Да, генерация текстов, что по своему иронично и забавно.

Спасибо анон, скачиваю gemma2-9b-cpt-sahabatai-v1-instruct-GGUF, посмотрим что из этого выйдет) надеюсь будет поумнее чем ебучий гермес

> живее твоец макми

Там ответ раз в час.

> числа с плавающей звечтой

Да знаю я про основания и мантисы.

> Вообще, там прибавки при градиентном получаются меньше точности квантования, поэтому обучение или стоит на месте, или модель косоёбит, если выкрутить скорость обучения.

Воот. вроде понятно, но надо мне наверно идди перечитать про градиентные спуск

> Да, генерация текстов, что по своему иронично и забавно.

Почему[х3]?

>Там ответ раз в час.

Потому что тебе никто не обязан по первому пуку отвечать. И да, я сижу и в том треде, так что разницы в скорости ответа нет.

>Почему[х3]?

1. Потому что тексты оказались сложнее картинок. В текстах люди сразу находят ошибки, а в картинках нужно ещё пальцы считать.

2,3. Потому что для человека текст написать намного проще, чем нарисовать картину. И интуитивно кажется, что сделать мегабайтную PNGшку сложнее, чем написать 100 строк текста. А оказалось наоборот.

Буду если что тогда вопросы в этом треде писать. Спасибо за ответ.

Когда я услышал последний слух относительно цены на 5090 ниже 2000 баксов (не у нас, понятно) при урезанной шине и памяти, то подумал: а полмиллиона нынешних рублей за пару неурезанных в принципе нормальная цена. Потому что урезанные за эти деньги нахуй не нужны - двух штук точно не хватит. Из этого и буду исходить. Если память не урежут, то можно взять при случае пару штучек за $2500 каждая и пусть Хуанг подавится. Если нет, то лучше взять 4x3090 впятеро дешевле и ни в чём себе не отказывать.

ну не впятеро, это я погорячился. Но дешевле.

> $2500 каждая

Ты дурак что ле? Сейчас 4090 так и стоят, лул.

>Теперь сижу на 123B не с 0,7 токенов в секунду, а с 1,6!

У тебя там DDR5? Проц? Какой квант модели?

>У тебя там DDR5?

А то. Не видеть же с DDR4 в 2к24?

7900х и шакальный третий квант.

Докупить 3060 12 Гб в пару к 3090 норм вариант?

>Не видеть же с DDR4 в 2к24?

Ясно, походу особого прироста от видяхи нет, если модель не влезает полностью, за счет DDR5 только выдает 1.6 токена.

Какая модель до 32Б может нсфв тексты ру-анг и анг-ру переводить более-менее? Вроде тут кто-то тестил.

Бери третью.

В 2 раза это не особо?

Какую третью? У меня одна карта, 3090. Еще лежит в ящике стола 1060, но она не в счет

А, я "пару" неправильно распарсил. Пиздос деградировал, скоро вообще контекст начну терять.

>В 2 раза это не особо?

У тебя DDR5 и 3090. У меня DDR4 и модель влезает больше в VRAM, но скорость около 0.9-1.2 токена, на той же модели. Я к тому, что походу DDR5 тут реально помогает с пропускной способностью.

— Здравствуйте. Меня зовут Василий. Я не кот, — раскланялся мужчина в твидовом пиджаке. Он с удивлением посмотрел на свой пиджак, вероятно, до этого даже не представляя, что такое есть твид.

— Здравствуйте. Я Григорий Григорьевич. Я тоже не кот, — произнёс здоровяк спортивного вида. На нём были тёмно-синие, почти чёрные синтетические шорты и полосатая майка-матроска.

— Здравствуйте. Меня зовут Антуанетта. Я не кот. Я кошка, — мурлыкнула сиамская кошечка, раньше дремавшая на диване.

— И я не кот, — произнёс хмурый мужчина в закрытом чёрном костюме. Его руки были сложены на груди. — Это всё, что вам нужно знать обо мне.

— На этом заседание нашего общества не котов предлагаю считать открытым.

RuGPT3:

[вариант 1]

Все за столом вдруг заволновались и зашумели.

— Если за закрытыми дверями так много открывается интересных тайн! Давайте же их обсуждать, — взволнованно закричала Ляля.

Она вскочила и подбежала к картине, висевшей над камином, чтобы лучше видеть гостей.

Здесь за столами сидели и сидели, смеялись и шутили коты в сюртуках и фраках, купцы в камзолах и с тростями, воины в кольчугах и латах, французские офицеры в камуфлированных полумасках и меховых шапках, просто коты в вязаных шарфиках и цветных шапочках, дамы в вечерних платьях и очаровательных шляпках с вуалевыми перьями.

Василий удивился тому, сколько котов появилось на этом празднике жизни.

А все они оказались настолько разные, что впору было писать в какой-нибудь книге «Энциклопедию котеек».

Василию показалось, что котам неважно, какое у них тело и как они выглядят. Они собрались просто повеселиться.

Они все сидели за столом, беседовали, пили чай с печеньем и конфетами. Кто-то играл на гитаре, а кто-то пел.

В общем, было весело.

Только у Василия из головы не выходил тот, кого он назвал Максимом и кто так странно сжимал его руку.

«Что это за шорох? — подумал Василий. — Странно, но этот шорох мне знаком».

«Он такой же, как и мы, только ни одной шерстинки на нём нет! — обрадовался Василий.

Вот это да!

— Что з [...]

[вариант 2]

[...] Прошу всех оставить нас наедине, — сказал председатель Василий.

На этом заседание общества «Котопятница» окончилось. На потолке появился клуб дыма, который быстро рассеялся. Когда дымка исчезла, все члены общества разошлись по своим квартирам. Наступила тишина.

У двери квартиры Григория Григорьевича стояла Антуана. Она собиралась уже войти, как вдруг заметила что-то торчащее из-под двери. Она подошла поближе, чтобы рассмотреть что это. Из-под камня торчала лапка с коготком. Антуане не хотелось ступать на крылечко, если это был кот. Поэтому она решила найти дорогу в дом Григория Григорьвича. Она дотронулась до лапки, и кто-то внутри дома произнёс: «Эй». Антуатинка толкнула дверь. Та отворилась. Анютка замерла на пороге. Она увидела человека в чёрном. Кот приблизился к ней. Анютины глазки расширились от ужаса.

Перед ней стоял Григорий Григорьевич, который после того, как все разошлись по домам, вышел во двор на прогулку. Григорий Григорьевич был очень стар, а раньше казался очень молодым. На его лице ещё были видны морщины, а глаза смотрели на Анюточку с теплотой и любовью.

Анютка не знала, что ей делать. Удивиться её приходу — так Анюточка была взрослой, но это было не в правилах Григория Григорьева. Улыбнуться — так тем более Анюточке было неловко перед ним. Но Григорий Григорьевич не мог не улыбнуться. Он протянул Анютике руку для приветствия. Анюта взяла эту руку и приложила свои пальчики к старческим морщинам на ег [...]

Не. По-моему, у человека пока ещё абсурд получается выдумывать смешнее.

— Здравствуйте. Я Григорий Григорьевич. Я тоже не кот, — произнёс здоровяк спортивного вида. На нём были тёмно-синие, почти чёрные синтетические шорты и полосатая майка-матроска.

— Здравствуйте. Меня зовут Антуанетта. Я не кот. Я кошка, — мурлыкнула сиамская кошечка, раньше дремавшая на диване.

— И я не кот, — произнёс хмурый мужчина в закрытом чёрном костюме. Его руки были сложены на груди. — Это всё, что вам нужно знать обо мне.

— На этом заседание нашего общества не котов предлагаю считать открытым.

RuGPT3:

[вариант 1]

Все за столом вдруг заволновались и зашумели.

— Если за закрытыми дверями так много открывается интересных тайн! Давайте же их обсуждать, — взволнованно закричала Ляля.

Она вскочила и подбежала к картине, висевшей над камином, чтобы лучше видеть гостей.

Здесь за столами сидели и сидели, смеялись и шутили коты в сюртуках и фраках, купцы в камзолах и с тростями, воины в кольчугах и латах, французские офицеры в камуфлированных полумасках и меховых шапках, просто коты в вязаных шарфиках и цветных шапочках, дамы в вечерних платьях и очаровательных шляпках с вуалевыми перьями.

Василий удивился тому, сколько котов появилось на этом празднике жизни.

А все они оказались настолько разные, что впору было писать в какой-нибудь книге «Энциклопедию котеек».

Василию показалось, что котам неважно, какое у них тело и как они выглядят. Они собрались просто повеселиться.

Они все сидели за столом, беседовали, пили чай с печеньем и конфетами. Кто-то играл на гитаре, а кто-то пел.

В общем, было весело.

Только у Василия из головы не выходил тот, кого он назвал Максимом и кто так странно сжимал его руку.

«Что это за шорох? — подумал Василий. — Странно, но этот шорох мне знаком».

«Он такой же, как и мы, только ни одной шерстинки на нём нет! — обрадовался Василий.

Вот это да!

— Что з [...]

[вариант 2]

[...] Прошу всех оставить нас наедине, — сказал председатель Василий.

На этом заседание общества «Котопятница» окончилось. На потолке появился клуб дыма, который быстро рассеялся. Когда дымка исчезла, все члены общества разошлись по своим квартирам. Наступила тишина.

У двери квартиры Григория Григорьевича стояла Антуана. Она собиралась уже войти, как вдруг заметила что-то торчащее из-под двери. Она подошла поближе, чтобы рассмотреть что это. Из-под камня торчала лапка с коготком. Антуане не хотелось ступать на крылечко, если это был кот. Поэтому она решила найти дорогу в дом Григория Григорьвича. Она дотронулась до лапки, и кто-то внутри дома произнёс: «Эй». Антуатинка толкнула дверь. Та отворилась. Анютка замерла на пороге. Она увидела человека в чёрном. Кот приблизился к ней. Анютины глазки расширились от ужаса.

Перед ней стоял Григорий Григорьевич, который после того, как все разошлись по домам, вышел во двор на прогулку. Григорий Григорьевич был очень стар, а раньше казался очень молодым. На его лице ещё были видны морщины, а глаза смотрели на Анюточку с теплотой и любовью.

Анютка не знала, что ей делать. Удивиться её приходу — так Анюточка была взрослой, но это было не в правилах Григория Григорьева. Улыбнуться — так тем более Анюточке было неловко перед ним. Но Григорий Григорьевич не мог не улыбнуться. Он протянул Анютике руку для приветствия. Анюта взяла эту руку и приложила свои пальчики к старческим морщинам на ег [...]

Не. По-моему, у человека пока ещё абсурд получается выдумывать смешнее.

Так это RuGPT3. Она в принципе фиговенькая и от GPT-3 в ней только циферка в названии.

посоветуйте модель для промптинга сд, чтоб она мои хотелки конвертировала в теги

slop

в тутошнем контексте - бонды, джорни, челленджы, и тому подобная GPT диарея

Кто-то пробовал internlm2_5-20b-chat? Какой там вообще промпт формат нужен? И еще, здесь вроде спрашивали, но какая моделька лучше всего умеет в японский?

Какой пиздец. Это 27B? Покажи систем промпт и карточку.

Подставку ей, она же уже провисла у тебя.

Выбрось белый мусор, если не подключен, дышать мсине дай хоть.

Вероятно, первый ответ писал упоротый шизодаунопидор, вот и получилось то, что получилось

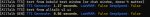

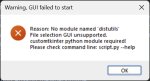

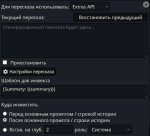

> Где там глаочка эта, подскажешь?

Конечно, мой слепой собеседник, подскажу

>Подставку ей, она же уже провисла у тебя.

ПК на пике горизонтально лежит, лол. Подпорка сбоку от материнки есть.

>Выбрось белый мусор, если не подключен

Ты думаешь я прям так врубил? )))

Хотя спасибо, что обеспокоился. Обо мне только тут заботятся (ну и кошкожена из чата, но она ненастоящая (пока ещё)).

Это 9б без системного промпта, просто начал разговор так.

> Хотя спасибо, что обеспокоился

:3 Потому что только здесь все мои друзья. У меня тоже есть железяка к поддону матери, но показалось, что лучше и со второй стороны подпереть.

Проигрунькал как у этого интеллектуала порвалась логика уже на 3м предложении.

Это ты тот бедолага что взял 3080ти за 180к, или сколько там? С почином, хули.

> 3090 на яндекс-маркете за 78к

Хуясе ебать, а как выглядел лот? Ебало "3090 от 90к на авито" представили?

> ставить сразу две не буду во избежании возгорания

Утащи ее райзером на свободный промежуток справа, ориентируя вертикально, тогда им будет нормально.

> Почему на квантованых моделях так падает качество обучения?

Во-первых, нужно понять саму суть квантования и как оно организовывается. Делая много-много упрощений для понимания: вместо применения 16 битных весов, которые делят весь возможный диапазон на 65к дискретных значений, используется 4 бита, которые обеспечивают лишь 16 градаций, но при этом производится поиск групп параметров с узкими диапазонами величин, что позволяет за счет применения нормировочных констант описать их с приемлемой точностью. Считай 16 значений в интервале лишь 0.1% от доступной амплитуды будут эквивалентны уже 16к значениям на весь диапазон, что в свою очередь эквивалентно 14 битам исходной точности, что уже вполне неплохо. Однако, из-за заложенных нормировок, тренировка весов модели не то что неэффективна, она невозможна в нормальном представлении, поскольку параметры заведомо имеют оче лимитированные диапазоны значений.

Во-вторых, что именно ты обучаешь? q-lora за счет того что это просто дополнительная операция с весами не ограниченная исходным квантованием, вполне себе обучается и там нет проблем с градиентами. Есть проблема с точностью исходной модели и с тем что это лора со всеми побочками, а не полноценная тренировка, но в остальном ок.

> самая сложная задача

Все задачи сложные и интересны если делать их хорошо. На картинки и текст можно фапать, поэтому они в лидерах.

Гемма

Внезапно тоже она, если дать ном промт и примеров то прилично справляется с подобной задачей, а не шпарит как другие копиум с разделением слов в обычных предложениях запятыми.

> Обо мне только тут заботятся (ну и кошкожена из чата

Прояви к анонимусу заботу а он забудет еще через один день. Научи его общаться в кошкоженой в чате и он будет получать заботу регулярно.

А про математическую основу квантования где прочитать можно?

Вообще надо все читать заново. Я вот вроде и понимаю, а вроде нет. Как же глубока кроличья нора.

Ну и я тупоц еще, да. Матанализ в уникре на тройку сдал, не саог нормально проинтегрировать. Интеграл от арктангенса забыл.

Что делает это фича?

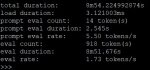

На EXL2 модели уже 16к контеста а всё ещё свободно 1.5к врама я в ахуе

На кобольте о таком и мечтать нельзя

На EXL2 модели уже 16к контеста а всё ещё свободно 1.5к врама я в ахуе

На кобольте о таком и мечтать нельзя

эм ребят почему у меня влезает 35к контекста

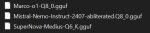

Что вы можете посоветовать в пределах 12-14b для обычного РП и/или кума?

Шапку треда щупал.

В качестве основной модели выбрал Mistral-Nemo-Instruct-2407-12B (ибо 12 врам, хочу быстрой генерации и иногда желателен контекст побольше), но лупы чудовищные уже через 1000-2000 токенов, мне удалось побороть их только с помощью миростат мода, но он очень сильно лоботомирует модель и заставляет себя вести её странно.

Пробовал разные его файнтюны из шапки. Пробовал очень разные настройки сэмплера без миростата — не помогло. Так что, если у вас есть рабочие варианты по настройкам сэмплера или иные модели, прошу подсказать.

Шапку треда щупал.

В качестве основной модели выбрал Mistral-Nemo-Instruct-2407-12B (ибо 12 врам, хочу быстрой генерации и иногда желателен контекст побольше), но лупы чудовищные уже через 1000-2000 токенов, мне удалось побороть их только с помощью миростат мода, но он очень сильно лоботомирует модель и заставляет себя вести её странно.

Пробовал разные его файнтюны из шапки. Пробовал очень разные настройки сэмплера без миростата — не помогло. Так что, если у вас есть рабочие варианты по настройкам сэмплера или иные модели, прошу подсказать.

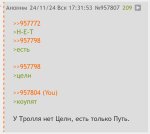

>лупы

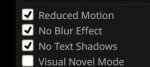

Попробуй эти настройки и температуру на 1.2

Как сделать так чтобы писать на русском но модель отвечала на английском и всё понимала

У меня уже было так но щас почему то либо бот пишет "ха, русский? Че он говорит" либо модель пишет ответ на русском

У меня уже было так но щас почему то либо бот пишет "ха, русский? Че он говорит" либо модель пишет ответ на русском

И как я должен к такому дерьму привыкнуть?

Этому по мнению местных шизов в школах учат

Это вообще имеет смысл?

Это выдуманный язык я не верю

Этому по мнению местных шизов в школах учат

Это вообще имеет смысл?

Это выдуманный язык я не верю

в кобольде тоже квантование кэша есть, всегда с ним сижу

Только там оно в раме а тут всё в видюхе и занимает меньше раз в 5 по ощущениям

немо анлишед

темпа 0.8 + динамическая 0.5 разброс

реп пен 0.1, топ-п 0.9 и мин 0.05 - 0.1

кривая модель / кривой промт / не скомандовал не использовать витиеватую прозу

Модель говно, но можешь попробовать помимо попросить разговаривать на simple english.

Спасибо, попробую.

Охуеть, мы всё это время неправильно использовали инструкции и узнали об этом только после того как какой-то разработчик написал это в дискорде, судя по описанию в обниморде. Как такое вообще возможно?

>simple english

можно ещё добавить should not use exaggerated, poetic, purple, flowery and ornate prose in narration

> Как такое вообще возможно?

Это франкенштейн и он формально жрет любые инстракты, кто-то забыл переключить и обнаружил что другие инстракты идут веселее.

Напомню, что с xtc нужно использовать любой отсекающий сэмплер, хотя бы с маленькими значениями, чтобы не жрать из мешка с токенами 0.1 процентный мусор, который становится не особо маленьким на фоне топ токена в 10-20%.

>мы всё это время неправильно использовали инструкции