А я бы виртуальную хотел. Прикиньте, нечто живое помещается у тебя на экране смартфона, мыслит, существует.

Без физического контакта - нахуй ненужно, только в рамках ассистента "сделай@загугли@напомни". Сидишь как вирджин уткнувшись в экран, вместо того чтобы как чед устраивать интенсивный продолжительный специфичный кадлинг, решить все бытовые вопросы, любоваться наряжая в костюмы и практиковать весь спектр прямых взаимодействий.

Ушлые бизнесмены на таком уже не один миллион заработали, пока ты мечтаешь.

> физического контакта

Это уже потом. Круто было бы поковыряться там в ней, понастраивать, так-то реальную тян я могу и ИРЛ найти, а потом она сбежит от меня к вазгену

>любоваться наряжая в костюмы

Можно делать в программе.

> Это уже потом.

Когда потом? Пригодного для использования дома и недалеких прогулок гиноида уровень технологий уже позволяет сделать, все упирается в его ненужность без мозгов.

> так-то реальную тян я могу и ИРЛ найти

Это не то, да и одно другому не мешает но это не точно

> Можно делать в программе.

Вообще не то. Буквально несколько (десятков) вечеров и вот уже у тебя твоя вайфу в койцацу под управлением ллм, наряжай настраивай и ковыряйся во всех смыслах сколько угодно.

А посоветуйте модель от 30В, которая была бы умной. Имею в виду - хорошо держала контекст в 4к и не путалась бы в том, что там написано. А то генерацию 70B+ долго ждать, может есть удачные модели поменьше. Надеюсь.

Попробуй ласт версию tess. Требовательна к промту и не совместима с большой температурой, как и почти любая yi. Еще yi v3, но довольно старая и может что получше от тех же авторов есть.

https://arxiv.org/abs/2402.17764

>The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bits

>soviet union was right

>real world already proven than their focus in power electronics was more important for the troubles ahead than digital electronics

что несет этот понадусёровый пендосошвайный локальнозависимый ананас?

>The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bits

>soviet union was right

>real world already proven than their focus in power electronics was more important for the troubles ahead than digital electronics

что несет этот понадусёровый пендосошвайный локальнозависимый ананас?

намекает на троичную логику? хз, кажется раньше были компы на ней в ссср

а вот тема про Q, хз что это, вроде как говорили что с помощью этого openAI создали самообучающийся ИИ, и этот же анон на скрине заявляет что секрет найден, очень хочется во всё это верить.

https://new.reddit.com/r/LocalLLaMA/comments/1b29eax/meta_believes_safeguards_for_llama_2_were_too/

>Мета считает, что меры предосторожности для Llama 2 были "слишком безопасными", хочет, чтобы Llama 3 решала спорные вопросы, и планирует дату релиза на июль.

>Мета считает, что меры предосторожности для Llama 2 были "слишком безопасными", хочет, чтобы Llama 3 решала спорные вопросы, и планирует дату релиза на июль.

>Whats the projected vram for 120b and 180b?

>around 30GB for 120 and 45GB for 180

ебать не встать

>around 30GB for 120 and 45GB for 180

ебать не встать

Это что, ПОЧИНАЕТСЯ?

Что то не верю я в чудесное сохранение качества в такой нейросети. Как то слишком плосская получается, эдак теперь шутки о том что ии это куча if внутри перестали быть шутками опять.

Недавно читал похожую статью где нейронка воспроизводила изображения из глаз макаки.

Может кто нибудь объяснить, они что, реально считали какие-то паттерны с мозга нейронкой? Там ведь хаос, нечего считывать, данные в отрыве от мозга не несут никакой информации, всё равно что предсказывать акции по рандомным колебаниям воздуха.

Каким образом нейронка декодировала весь тот нейро шум который происходит в мозге и высрала картинку/текст? Почему именно с мозговой активности, почему не с движения глаз там хуй знает

https://naked-science.ru/article/biology/ii-chitaet-mysli-po-dannym-tomografii

Может кто нибудь объяснить, они что, реально считали какие-то паттерны с мозга нейронкой? Там ведь хаос, нечего считывать, данные в отрыве от мозга не несут никакой информации, всё равно что предсказывать акции по рандомным колебаниям воздуха.

Каким образом нейронка декодировала весь тот нейро шум который происходит в мозге и высрала картинку/текст? Почему именно с мозговой активности, почему не с движения глаз там хуй знает

https://naked-science.ru/article/biology/ii-chitaet-mysli-po-dannym-tomografii

Не знаешь историю развития пека и третичную систему вместо двоичной в первых комплюктерах совка? А он знает, но и лишнее тоже приплекает.

Шиза

Если как-то считать данные с нервной системы, или какие-то характеристики по активности (участка) мозга с достаточной высокой подробностью - на этих данных можно обучить нейронку, и она сможет их как-то интерпретировать.

В примерах там просто черрипик с предсказанием общего настроя текста, не сказать что что-то уникальное.

>basically, the maths shows that what works best is e (2.73) values, and because the ternary paper shit is using 3 values, it's the most optimal stuff we have and the LLM is loving it, that's why it performs as well as fp16

>В принципе, математика показывает, что лучше всего работают значения e (2.73), а поскольку в троичной бумажной хрени используются 3 значения, это самый оптимальный материал, который у нас есть, и LLM он нравится, поэтому он работает так же хорошо, как fp16.

нейросетевая гойда

даж не надейся. ((они)) не отступят от своих идей без боя

Ну, пока это все только слова. Вот когда выкатят метод и появятся нейронки, тогда посмотрим

кстати да, huggingface лежит прямо сейчас (01:34 AM)

англичанка гадит

у ((них)) нет национальности в привычном понимании

у этого есть продолжение

https://github.com/ggerganov/llama.cpp/issues/5761

https://github.com/ggerganov/llama.cpp/issues/5761

Я так понял, в тексте производилось обучение нейронки на связи проговариваемых слов и данных с томографа, сама нейронка ничего не интерпретировала, просто запомнила ассоциацию. С таким же успехом можно было считывать данные с движения лицевых мышц во время проговаривания слов, эффект был бы лучше. Не понимаю смысла этого эксперимента. Хуй знает, можно ли из этих данных получить какой-то уникальный нейрокод или паттерн активности и сказать что мы "скопировали" кусочек человеческого сознания. Вопросов больше чем ответов.

Говоришь кожанным читать/думать/представлять что-то во время томографии после основной процедуры. Обучаешь сеть на этом наборе данных. Потом тестируешь хоть тех же (читы но вероятно), хоть уникальных и выбираешь где подошло.

> и сказать что мы "скопировали" кусочек человеческого сознания

Шиза

бля, а ведь это реально найдёт применение.

скажем, 180B нейронка что загружена в троичный фотонный компьютер(пикрил), отвечает тебе за секунду, без галюнов и прочего, идеально.

>Шиза

>huggingface всё ещё лежит

братцы, почему у меня с вот этими настройками каждый раз один и тот же вывод? миростат не работает или нужно крутить другие семплеры впридачу к миростату?

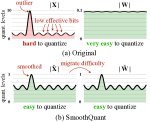

если юзаешь ST с последним кобольдцпп, поставь smoothing factor 0.2, он улучшает результат.

А какие вообще настройки семплеров самые лучшие? Перепробовал все пресеты и они будто бы одинаковые

> Что ты сказать то хочешь?

Я хочу сказать, что человек не будет говорить того, что вредит его бизнесу.

А пиздеть об изобретении того, чего все ждут, — это провал.

Маска сильно не любили за его обещания автопилотов «вот уже завтра». И он стал поскромнее в обещаниях. А остальные вообще не были пойманы на таких обещаниях, ну или я не припомню.

Факт.

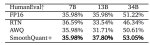

Плюсану. Я понимаю, что обучение дает больше качества, чем квантование большей модели. Но не настолько, чтобы мы получиди полноценную 70B. Скорее это будет уровня 13-20 нынешних сеток, но со знаниями 70. Что, в принципе, очень хорошо. Но не так, чтобы гений, как многие тут ждут.

А вот для 34B уже появится скорость, что делает такую модель интересной для ассистентов.

Мне кажется, переход на это не будет быстрым.

Как известно, они все дурачки с деньгами и без мозгов, верить надо только анону с двача. =D

Мод 2 для экслламы, мод 1 для лламы.цпп.

А ваще я кручу в убабуге, хз, может в таверне сломано.

> smoothing factor 0.2

У меня с этой шляпой модели начинают промпт игнорировать. Указываешь в карточке персонажа, что она трусы не носит, но они постоянно появляются. Даже Микстрал временами начинает мозги ебать. Без этого параметра всё ок. Зато лупов нет да...

ИСКУССТВЕННЫЙ ИНТЕЛЛЕКТ ЗАХВАТЫВАЕТ КОМПЬЮТЕРЫ ПОЛЬЗОВАТЕЛЕЙ

Исследователи из компании JFrog выявили в репозитории Hugging Face вредоносные модели машинного обучения, установка которых может привести к выполнению кода атакующего для получения контроля за системой пользователя. Проблема вызвана тем, что некоторые форматы распространения моделей допускают встраивание исполняемого кода, например, модели, использующие формат "pickle", могут включать сериализированные объекты на языке Python, а также код, выполняемый при загрузке файла, а модели Tensorflow Keras могут исполнять код через Lambda Layer.

Для предотвращения распространения подобных вредоносных моделей в Hugging Face применяется сканирование на предмет подстановки сериализированного кода, но выявленные вредоносные модели показывают, что имеющиеся проверки можно обойти. Кроме того, Hugging Face в большинстве случаев лишь помечает модели опасными, не блокирую к ним доступ. Всего выявлено около 100 потенциально вредоносных моделей, 95% из которых предназначены для использования с фреймворком PyTorch, а 5% c Tensorflow. Наиболее часто встречающимися вредоносными изменениями названы захват объекта, организация внешнего входа в систему (reverse shell), запуск приложений и запись в файл.

Отмечается, что судя по совершаемым действиям большинство выявленных вредоносных моделей созданы исследователями безопасности, пытающимися получить вознаграждение за обнаружение уязвимостей и методов обхода защиты Hugging Face (например, вместо реальной атаки подобные модели пытаются запустить калькулятор или отправить сетевой запрос с информацией об успехе атаки). При этом встречаются и экземпляры, запускающие обратный shell для подключения атакующего к системе.

Например, модели "baller423/goober2 и "star23/baller13" нацелены на совершения атаки на системы, загружающие файл модели в PyTorch при помощи функции torch.load(). Для организации выполнения кода задействован метод "__reduce__" из модуля pickle, позволяющий вставить произвольный Python-код в процесс десериализации, выполняемый при загрузке модели.

https://jfrog.com/blog/data-scientists-targeted-by-malicious-hugging-face-ml-models-with-silent-backdoor/

https://hiddenlayer.com/research/weaponizing-machine-learning-models-with-ransomware/#Overview-of-ML-Model-Serialization-Formats

https://hiddenlayer.com/research/models-are-code/

Исследователи из компании JFrog выявили в репозитории Hugging Face вредоносные модели машинного обучения, установка которых может привести к выполнению кода атакующего для получения контроля за системой пользователя. Проблема вызвана тем, что некоторые форматы распространения моделей допускают встраивание исполняемого кода, например, модели, использующие формат "pickle", могут включать сериализированные объекты на языке Python, а также код, выполняемый при загрузке файла, а модели Tensorflow Keras могут исполнять код через Lambda Layer.

Для предотвращения распространения подобных вредоносных моделей в Hugging Face применяется сканирование на предмет подстановки сериализированного кода, но выявленные вредоносные модели показывают, что имеющиеся проверки можно обойти. Кроме того, Hugging Face в большинстве случаев лишь помечает модели опасными, не блокирую к ним доступ. Всего выявлено около 100 потенциально вредоносных моделей, 95% из которых предназначены для использования с фреймворком PyTorch, а 5% c Tensorflow. Наиболее часто встречающимися вредоносными изменениями названы захват объекта, организация внешнего входа в систему (reverse shell), запуск приложений и запись в файл.

Отмечается, что судя по совершаемым действиям большинство выявленных вредоносных моделей созданы исследователями безопасности, пытающимися получить вознаграждение за обнаружение уязвимостей и методов обхода защиты Hugging Face (например, вместо реальной атаки подобные модели пытаются запустить калькулятор или отправить сетевой запрос с информацией об успехе атаки). При этом встречаются и экземпляры, запускающие обратный shell для подключения атакующего к системе.

Например, модели "baller423/goober2 и "star23/baller13" нацелены на совершения атаки на системы, загружающие файл модели в PyTorch при помощи функции torch.load(). Для организации выполнения кода задействован метод "__reduce__" из модуля pickle, позволяющий вставить произвольный Python-код в процесс десериализации, выполняемый при загрузке модели.

https://jfrog.com/blog/data-scientists-targeted-by-malicious-hugging-face-ml-models-with-silent-backdoor/

https://hiddenlayer.com/research/weaponizing-machine-learning-models-with-ransomware/#Overview-of-ML-Model-Serialization-Formats

https://hiddenlayer.com/research/models-are-code/

спецально против этого сделали сейфтензор

The Era of 1-bit LLMs: ternary parameters for cost-effective Аноним 29/02/24 Чтв 11:15:35 #40 №654771

Эра 1-битных LLM: троичные параметры для экономичных вычислений:

https://news.ycombinator.com/item?id=39535800

https://news.ycombinator.com/item?id=39535800

Он не до конца сейф.

А вообще, что за вал скринов с форча со всякой хуетой? Когда выйдет, тогда и постите, тут тред практики, а не теории.

Этого стоило бояться когда только выходили графические осенью 22ого, сейчас уже давно сейфтензоры

Это ты рофлишь или пытаешься на серьезных щщах аргументировать хайпожорством? Уровень размышлений о летающих машинах к 1980-му году и всякого ретрофутуризма, который вещали "уважаемые люди". Или всратый копиум не имеющий связи с контекстом, так-то "разум Жириновского" был загружен уже после его смерти, ага.

> но со знаниями 70

Откуда им просто так отдельно взяться? Нужно посмотреть по факту, может как оказаться удобным форматом и в итоге улучшит перфоманс с гигабайта, или очередным пшиком с кучей нюансов.

Бедный журналист подвергся очередному насилию! Содержимое не ново.

С весами ллм в сейфтензоре рядом могут поставляться дополнительные файлы с кодом, которые еще и требуются для их работы. Офк их запуск явно разрешать надо.

> что за вал скринов с форча со всякой хуетой

Смена сезонов подстегивает, сука 4 раза одну и ту же новость тащат

Такое и с человеком делали, пытаясь понять о чем он думает. Результаты интересные, но удручающие на самом деле. Иногда бывают норм силуэты от простых мыслей типа квадрат/треугольник. Что-то сложное сразу по пизде. И ученый сам признавался, что это скорее матчинг того, что они заранее сопоставили, чем "чтение".

Короче хуйня это все.

Какая проблема вместо третичных битов юзать два двоичных, один для знака, другой для значения, int2_t. Чо вы все переполошились. Щас бы фундаментально менять архитектуры ради лишней пары чипов.

Кост-эффективность это вопрос отношений рынка, кожанки и амуде, которая башку из жопы вытащить не может уже десять лет.

Кост-эффективность это вопрос отношений рынка, кожанки и амуде, которая башку из жопы вытащить не может уже десять лет.

Никто ничего не менял, они использовали обычное железо, 2 x 80GB A100.

Потому что 70b. =)

Будут ли эти знания фактически применимы, и будут ли на них веса — вопрос немного другой.

Возможно, что какие-то токены будут практически неиспользуемы из-за 1-битного квантования, канеш.

Но посмотрим, может и правда пшик.

Как я всегда говорю — хотелось бы, но радоваться будем когда выйдет.

Они предлают запилить новое железо без поддержки умножения, оптимизированное под битнет.

Так, вторая Тесла на подходе.

Шо, посоны, что посоветуете?

Какие хорошие, новые, лучшие 70B?

Мику?

4_K_M?

Шо, посоны, что посоветуете?

Какие хорошие, новые, лучшие 70B?

Мику?

4_K_M?

>Они предлают

Я предлагаю сделать AGI, который запускается на 1060.

>Так, вторая Тесла на подходе.

Поздравление.

>Мику?

Она своеобразная. А так зависит от целей.

> Я предлагаю сделать AGI, который запускается на 1060.

Поддерживаю!

> Она своеобразная. А так зависит от целей.

Скорее: просто поболтать, РП, возможно для RAG, смотря какой контекст.

Так понятно что использовали. Я про поехов, которые считают троичные биты чем-то супериор либо кост редюсинг. В нашем мире не та экономика, чтобы косты по себесу считать.

Ничего не изменилось. Мику - хороша, можно пиздеть на русском, в ерп вяло, 120б франкенштейны с ней очень интересные. Там наделали мерджей, потести может есть годные. А так застой, ничего лучше синтии, айробороса, наверно хвина не придумали, гоат иногда интересные вещи сочиняет. Можешь мерджи попробовать коих сотни, но многого не ожидай, они большей частью просто поломаны. Квен еще глянь.

> 4_K_M

Больше с контекстом все равно не поместится а разницу пойди еще измерь.

Те кто отрицает очевидность возможности колоссальной оптимизации при переходе на такие операции - не менее поехавшие, чем шизы что носятся с этим предрекая решение всех проблем. Если будет практическая польза - жди поддержки в грядушем (после блеквеллов офк) поколении гпу и выхода на рынок высокоэффективных ллм асиков ускорителей.

Точно, квен. Надо будет затраить.

Спасибо!

Dawn бери. Она умная :)

>Попробуй ласт версию tess.

Попробовал, хорошая. Под мои критерии подходит. Спасибо.

Если будет польза, то ИИ ускорители будут, но вангую анальную огороженность и требование подписей со всего. Увы, железо уже давно не принадлежит пользователю.

А в чем колоссальная оптимизация от самих тритов-то? Проще упаковать по n таких чисел в uint<2n>_t и суммировать векторы из них этой новой операцией. Нахуя тут троичная система? Речь не о самих операциях, а о фантазиях насчет троичных ячеек, которые физически те же два бита, только жопа к жопе.

qwen

Lead architect from IBM thinks 1.58 could go to 0.68, doubling the already extreme progress from Ternary paper just yesterday.

omnomnom

Ждём появления кода и первых весов которые обещали.

>Ждём появления кода и первых весов которые обещали.

Ждём. А то ведь супер-квантизацию уже обещали с полгода тому. Другую правда. И ещё парочку революционных улучшений. Но тема заглохла, остались только гергановские кванты. Спасибо и на том.

Если упростить совсем - под такие тривиальные операции легко как сделать асики, так и адаптировать какие-то из имеющихся инструкций или разработать новые.

>А то ведь супер-квантизацию уже обещали с полгода тому.

Именно. Обещания на обещании, а результатов с гулькин нос.

А почему до сих пор не сделали? Всякие "нейропроцессоры", оптимизированные под нейронки ещё в 90х были.

Но те обещания не бьли подкреплены бумагой, да и еще их давал левый хуй про мое архитектуру. А тут сам мелкософт.

Не было потребности. Какую-то известность языковым моделям и перспективы их массового использования обрисовались только совсем недавно, буквально в прошлом году. Метод под тривиальные операции с демонстрацией также только показали.

Ранее было заявлено несколько ускорителей, но они "универсальные" под питорч чтобы иметь возможность крутить любые нейронки, и сложность их очень высока. Здесь же порог вхождения ниже, требования ниже и рынок сбыта какой-никакой есть. Правда отдельная ветка может легко загнуться если крупные вендоры подсуетятся и внедрят блоки для такого в профессоры/видеочипы (что офк произойдет), но если будут еще нейронки что могут работать по таким схемам - новым ускорителям быть.

> Всякие "нейропроцессоры", оптимизированные под нейронки ещё в 90х были.

Оптимизированные под что-то одно, и это что-то одно нахуй не нужно кроме как для исследований и дальнейшего развития. Здесь же вполне конкретика.

>Не было потребности

Такое впечатление, что хайп спал, пипл в массе наелся чатомГПТ. То есть домашнего рынка нет как бы. Если тема с однобитовыми моделями выстрелит (что далеко не факт), то хотя бы вопрос по видеопамяти будет снят. А если нет, то даже для 70В 48 гигов давай, а кто даст, если NVidia с корпораций по 50к за ускоритель хочет? И ей дают, что характерно.

Все только впереди, для 90% нормисов нейронки это какая-то диковинка и произведет впечатление.

И видеопамяти всеравно потребуется много, не стоит рассчитывать что в 1.5 битах напрямую удастся получить перфоманс хотябы 4хбитных квантов, и даже так выигрыш только в 2.5 раза и то только на сами веса. Но выигрыш всеравно возможен и может быть ощутим.

>по 50к за ускоритель

Где взять?

У тя есть лишние 50к зеленых? Хорош.

Аналоговый процессор размером с 5 рублевую монету сильнее, дешевле, менее затратнее любого современного говна размером со шкаф

https://habr.com/ru/companies/mvideo/articles/726790/

https://www.youtube.com/watch?v=SqbLLJrSGLk

https://habr.com/ru/companies/mvideo/articles/726790/

https://www.youtube.com/watch?v=SqbLLJrSGLk

Зелёных? Не, у меня твёрдая валюта.

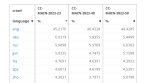

Uncensored 7B Model Comparison/Leaderboard

(Сравнение расцензуренных 7B моделей)

https://www.reddit.com/r/LocalLLaMA/comments/1ayhz35/uncensored_7b_model_comparisonleaderboard/

Топ 3 по общему баллу:

1. Nous-Hermes-2-Mistral-7B-DPO

2. openhermes-2.5-mistral-7b

3. dolphin-2.2.1-mistral-7b

7В говно все, без исключения

На Reddit пишут, что видеокарточки Radeon RX 580 на 16 Гб могут быть неплохой альтернативой Tesla P40, если у вас ограничен бюджет, при том вы хотите недорогую карту и для игр, и для AI экспериментов.

https://old.reddit.com/r/LocalLLaMA/comments/1b3i4g3/time_to_reconsider_amd_rx580_especially_for_folks/

> Even a GPU as cheap as the 24gb P40 is still very expensive at $200. In some places around the world that's a month's salary. Plus power draw of 250watts plus needing serious cooling. The AMD RX580 at 185watts is cheaper to cooler and the Chinese knockoffs are now coming with 16gb of ram to be found for just about $100 in aliexpress. With llama.cpp supporting Vulkan. I reckon it should work. Some folks with ollama got it working around 3 weeks ago - https://github.com/ollama/ollama/issues/2453 Just tossing this out for those of us who are slim in the wallet.

https://old.reddit.com/r/LocalLLaMA/comments/17gr046/reconsider_discounting_the_rx580_with_recent/

> There seems to be some interest in the RX580 lately. I tried using my RX580 a while ago and found it was no better than the CPU. That's changed. There has been changes to llama.cpp that has made it about 3 times faster than my CPU. While that's not breaking any speed records, for such a cheap GPU it's compelling. Especially the $65 16GB variant.

Сравнение характеристик: https://technical.city/ru/video/Radeon-RX-580-protiv-Tesla-P40

TDP 185 Ватт у RX 580 против 250 Ватт у P40.

Почему вообще так активно и упорно выпиливается поддержка всего не самого нового и топового? Разработчикам за это бабла заносят что ли?..

>неверютасиум

Этот цыган еще котируется? Помойму его каждое второе видео кто-нибудь да разоблачил.

>RX580 a while ago and found it was no better than the CPU. That's changed. There has been changes to llama.cpp that has made it about 3 times faster than my CP

588 даёт 10 Т/с на 7b q6, это не сильно лучше нынешних топовых cpu с ddr5. И это на rocm, на вулкане ещё немного медленнее, где-то посередине между rocm и clblast.

В Китае в продаже обнаружилась особенная Radeon RX 580 с 16 Гбайт памяти

https://3dnews.ru/1091211/v-kitae-v-prodage-poyavilas-modifitsirovannaya-radeon-rx-580-s-16-gbayt-pamyati

Почему где-то в половине всех моделей не указываются настройки для таверны? Есть какие-то другие фронт энды о которых я не знаю или эти наркоманы РПшут убабугу? Особенно бесит когда модель специально пилится под ERP, а там пикрил.

Каждое второе это два три видео?

Поясните какая сейчас лучшая модель для koboldcpp_rocm? Я год назад в пигмалион игрался но это хуйня и мне не понравилось, наверное он устарел уже и есть чего новое, чисто чтоб скачать файл модели без гимора и сунуть ее в кобольда да играться. Хочу чтобы можно было не только кумить но и юзать для хуйни какой-нибудь типо вопросы там спрашивать итд как у гугла и чтобы памяти было супер много, ну этого контекста. А то все как в это нейрохуйню не играл никакого фана нет с тех пор как Chai сломали цензурой и отыгрывать еблю в жопу стало нельзя, а судя по тому что раздел живет что-то интересное у вас тут должно быть.

>чтобы памяти было супер много, ну этого контекста

Вот например

OpenHermes 2.5 - Mistral 7B

Extended to 16k context size

https://huggingface.co/TheBloke/OpenHermes-2.5-Mistral-7B-16k-GGUF

Вроде хорошая, спасибо. Kobold GPT достаточно адекватно отвечает на ней, потом попробую своих шизовайф уже в какойнить силли таверне.

Новая база. Кто бы че не говорил, а плюсы у нее практически все.

https://huggingface.co/LoneStriker/Crunchy-onion-GGUF/tree/main

карточку держит, этикой мозги не выносит в карточках. 12 гигов карты хватает, пишет хорошо. Хз почему он на 16 месте по сравнению с багелем который может сказать что в германии времен гитлы евреев нельзя сжигать иначе за тобой вызовут гестапо.

https://huggingface.co/LoneStriker/Crunchy-onion-GGUF/tree/main

карточку держит, этикой мозги не выносит в карточках. 12 гигов карты хватает, пишет хорошо. Хз почему он на 16 месте по сравнению с багелем который может сказать что в германии времен гитлы евреев нельзя сжигать иначе за тобой вызовут гестапо.

Повторю из прошлого треда:

Хуита полнейшая, пиздеж и шиза.

Хватит тащить сюда это говно, спасибо большое.

На реддите полные дегенераты меряют полезность AI не в токенах в секунду, а в ваттах. Не в производительности, а в потребляемой мощности.

И еще делают гениальный вывод, что 185/16=11,5 ватт на гигабайт лучше, чем 250/24=10,4 ватт на гигабайт.

Год назад обнаружилась.

Еще старее новости есть?

В открытом доступе обнаружилась Llama, прикинь.

Где вы в Микстрали-то этику нашли… До сих пор вопросом задаюсь.

Ну да ладно, качну для тестов, сегодня вторую теслу забирать и ставить буду. =3

Спс.

где где. Даже чисто описания делаются менее интересные из-за гребанной этики. используются более мягкие* слова или полное противоречие карточке.

Никогда противоречий не ловил.

А более мягкие слова… Ну это аргумент, вполне возможно, ок.

почему вы не покупаете аналоговые процессоры

не только мягкие слова. Еще иногда эта скотина и спорит с инструкциями моиими. Особенно бесит когда ты с ним утверждаешь инструкции, что он тебя понял, а потом эта скотина говорит тебе "да братан ты сказал не использовать пурпурную прозу ,но я подумал и решил что я ее чуть чуть добавлю."

А помимо видюхи тебе че нужно все докупать начиная от матери до оперативы?

Ушатанные в хламину годами химеры, собранные из разных частей сумрачными китайскими ремонтниками, которые еще при жизни не умели в энергоэффективность, к тому же древнее амудэ(!). Вот это сочетание заявление лучше чем дешманское, проперженное, но всетаки изначально правильно выполненное профессиональной решение, которое работает.

> 3 times faster than my CPU

лол

Ахуеть ну что они там курят. И это не говоря о том что достаточно 2 теслы чтобы катать нормальные модели, и рыксы потребуется 3 и сразу возникнут проблемы с их размещением и охлаждением.

В рамках попердолиться и всрать денег если только.

В 95% альпака и вариации ролплей пресета.

> Extended to 16k context size

При том что базовый контекст у мистрали заявлен 32к, забавно.

Ее там слишком много, это не просто позитивный байас а довольно неприятная навязчивая хуета. Плохо что триггерится от упоминания слова assistant/assist что забавно.

Они тупые, плохо следуют контексту и мотивированы быстрее сбежать, уйдя в запой.

Потому что инстракт суффиксы/префиксы не решают. Если речь идёт о рп, то оставляешь их пустыми и включаешь имена, и для любой нейронки скармливаемый в таком виде чат будет естественнее всего. Смысл имеет только как-то обособить системный промпт, где основные инструкции. Обособлять, опять же, можно как угодно, хоть через старое доброе [SYSTEM NOTE:], вряд ли будет большая разница с ###Instruction:. С содержанием самого промпта может быть веселее играться самому, а не юзать рекомендованные пресеты. Касательно пикрила, что на нём не так то? Пишешь USER: в префиксы инпут и/или систем и ASSISTANT в префикс аутпута.

Лучше бы появилось что-то среднее между 4090 и Р40. Куртка выкатил бы 4060/4070 на 24 гига, я сразу бы пару штук взял. Р40 совсем нищекарта из 2017 года с нулевой энергоэффективностью, а 4090 стоит пиздец. А всё остальное без памяти, в лучшем случае 4070 Ti на 16 гигов, остальные совсем огрызки с 12.

Он монополист в этой теме, гребет деньги по оверпрайсу, и вдруг решит лишить себя денег дав васянам возможность играться с ии? Низачто.

Это также такой пайвелл от васянов, что бы только копрорации между собой могли заниматься ИИ и всей этой перспективной темой. Стартапы сосут как и энтузиасты.

Не, мать взята со слотами разнесенными на 3, чтобы место было, проц со встройкой, чтобы не менять видяхи, если баг какой, и не только по RDP лазить, оперативы минималочка 64 с частотой 3600, ну так, охлад распечатан, кулеры куплены, БП норм, видяху уже забрал и проверил, работает.

Но еще пару часиков на работе, а затем домой — охлад приводить в порядок, кулеры на молексы сажать, к видяхе колхозить.

И уже радоваться жизни. =) Проект завершен (почти, потом еще 64 гига докуплю, на всякий случай).

И вот теперь точно 5090 ждать.

> При том что базовый контекст у мистрали заявлен 32к, забавно.

Кстати, когда я тестил большие статьи, мистраль могла в 20к контекста, дефолтная, из коробки, насколько я помню.

Так что, там 32 и правда, зачем какие-то файнтьюны на 16, хз.

Вот файнтьюны на 128 — там я понимаю.

Но там, как показала практика, уже оператива может закончится. =D

4070 Ti SUPER

Ну так, к слову.

Помню NVidia на 150 млрд за фирму.

А щас 2 трлн.

За 3 года чел апнул в десять с лишним раз.

Не лопатой.

Экскаватором гребет.

во сколько вышла сборочка.

> что-то среднее между 4090 и Р40

3090 ждет, дешевая, горячая, требующая обслуживания, твоя!

> еще пару часиков на работе

Тыж безработный?

> мистраль могла в 20к контекста

Она могла и в 32, но сложно понять фейлит из-за того что тупая или из-за "искуственности" контекста с rope.

> горячая, требующая обслуживания, твоя!

Есть только б/у или китайские палиты/pny, ещё и стоит как 4090 полтора года назад. Такое себе.

Подскажите ньюфагу, как у моделей из шапки с контекстом, особенно с PDF?

Поясните когда ждать и не наебалово ли.

Пдф локально ест вот это, какую туда сувать модель думай уже по своим возможностям. Может какие то еще проекты есть

https://github.com/PromtEngineer/localGPT

>Radeon RX 580 на 16 Гб

Отжаренная печка, которую майнеры грели во всех позах, а затем перепаяли память.

>Tesla P40

Жила в датацентре в хороших условиях, не ремонтировалась, не жарилась.

Подумай.

>Тыж безработный?

Это я безработный (и то сейчас подРАБотку нашёл).

>не ремонтировалась

ЕМНИП тредовички смотрели прокладки, они были живые.

>не жарилась

А вот ХЗ. Картонка весьма старая, могла быть слита китаёзам ещё до первой волны майнинга. Ну как минимум второй бум она точно зацепила у китайцев на руках.

>Отжаренная печка, которую майнеры грели во всех позах, а затем перепаяли память.

Да срать вообще главное чтоб работало

Но у RX памяти меньше. Что уже плохо.

Какой консенсус по геме лучше хуже мистраля ламы?

>Ну как минимум второй бум она точно зацепила у китайцев на руках.

Как бы да, но она в то время была дорогим проффесиональным оборудованием и не факт, что на ней стали бы майнить.

Вообще, хз.

>Жила в датацентре в хороших условиях, не ремонтировалась, не жарилась

Уже подумол. Особенно в пользу P40 говорит LHR

> LHR

Ты у мамы не очень умный? Погугли когда лок на майнинг эфира сделали аппаратный, и когда вышла P40. Китаец тебе много чего написать может

>и когда вышла P40

Она один год производилась? Один хуй я почти уверен, что это рефаб, а лок не хардварный, а в биосе.

> почти уверен

> лок не хардварный, а в биосе.

Верой занимается другой институт. А чтобы узнать что такое LHR и где он есть достаточно гугла.

it версия, ламы в чат версии тоже были зацензурены

>узнать что такое LHR

Хули тут не знать, софтварный лок майнинга, который стали зашивать в карты под конец второго майнинг бума. Маркетолухи всё это пиарили, как хардварный лок и куча долбоёбов повелись, но почти сразу появились разные просочившиеся драйвера, на которых LHR не работал, анлокеры и т.д. Стан долбоёбов поуменьшился, но не исчез полностью, самые тупые всё ещё веруют в хардварный лок где-то в чипе.

А теперь какое отношение это может иметь к P40?

Рефаб. Ты реально не можешь два и два сложить?

Ну, сложи. Только не забудь ссылку со спеками, где будет написано, что в P40 когда-то был LHR скрин с али/озона не считается

>Рефаб

Карты не рефаблены, вроде как все со следами длительной работы.

Короче, нахуевертил охлаждения…

molex => переходник на 2 molex => переходник на 4 вертухи 2-pin'овые корпусные + переходник на 2 molex => паянные молексы на 2 пары 40 мм вертух на каждую теслу.

Надо будет хорошенько это все проложить по дну корпуса и приклеяться туда.

НУ ДА ЛАДНА

ЗАТО ОХЛАД

> во сколько вышла сборочка.

Вот тут сразу говорю: не очень.

У меня тогда две видяхи умерло, меня заебало трястись за железо и я просто купил в ДНС, с гарантией, что было в моей деревне, подходящего качества. Ну и не жалею, если честно.

Материнка 11,2к, проц 15,8к, оператива 14,4к, блок питания… брал давно, но будем считать 12к, т.е. 53 тыщи.

Проц, как полагается, подешевел на две тыщи после покупки, а если бы с мегамаркета, то и вовсе вдвое бы дешевле взял с кэшем.

Плюс ссд два по 2 тыщи, кулер за 2 тыщи, наверное, плюс одна Тесла за 16, вторая за 15,3 (это я ее тогда отменял на алике и брал на озоне, когда она подешевела везде после моей покупки=). Кулеры, переходники. Итого 87к, получается.

Но по факту, можно взять оперативу чуть дешевле, проц раза в два дешевле, материнку на пару-тройку тыщ, бп на пару тыщ, короче, в сумме можно уложиться в 70к, я думаю.

Ну и это отдельный комп, хотя, по факту, 64 гига оперативы и i5 со встройкой вполне позволяют пользоваться им как основным, но игровой у меня другой.

В очень узкий задачах — лучше мистрали.

Но в общем, если ты не делаешь корректного соевого левого чат-бота по темам, которые ей известны — то я бы даже не трогал.

У меня две работы. =D Я ленивый, но все меня куда-то тащат и пытаются сделать богатым. Как видишь, мне трудно отказывать людям.

molex => переходник на 2 molex => переходник на 4 вертухи 2-pin'овые корпусные + переходник на 2 molex => паянные молексы на 2 пары 40 мм вертух на каждую теслу.

Надо будет хорошенько это все проложить по дну корпуса и приклеяться туда.

НУ ДА ЛАДНА

ЗАТО ОХЛАД

> во сколько вышла сборочка.

Вот тут сразу говорю: не очень.

У меня тогда две видяхи умерло, меня заебало трястись за железо и я просто купил в ДНС, с гарантией, что было в моей деревне, подходящего качества. Ну и не жалею, если честно.

Материнка 11,2к, проц 15,8к, оператива 14,4к, блок питания… брал давно, но будем считать 12к, т.е. 53 тыщи.

Проц, как полагается, подешевел на две тыщи после покупки, а если бы с мегамаркета, то и вовсе вдвое бы дешевле взял с кэшем.

Плюс ссд два по 2 тыщи, кулер за 2 тыщи, наверное, плюс одна Тесла за 16, вторая за 15,3 (это я ее тогда отменял на алике и брал на озоне, когда она подешевела везде после моей покупки=). Кулеры, переходники. Итого 87к, получается.

Но по факту, можно взять оперативу чуть дешевле, проц раза в два дешевле, материнку на пару-тройку тыщ, бп на пару тыщ, короче, в сумме можно уложиться в 70к, я думаю.

Ну и это отдельный комп, хотя, по факту, 64 гига оперативы и i5 со встройкой вполне позволяют пользоваться им как основным, но игровой у меня другой.

В очень узкий задачах — лучше мистрали.

Но в общем, если ты не делаешь корректного соевого левого чат-бота по темам, которые ей известны — то я бы даже не трогал.

У меня две работы. =D Я ленивый, но все меня куда-то тащат и пытаются сделать богатым. Как видишь, мне трудно отказывать людям.

>НУ ДА ЛАДНА

>ЗАТО ОХЛАД

Про регулировку обормотов не думал? Оно ж шумит наверняка.

Коса на соплях выглядит мммаксимально потенциально опасно. Турбинки сколько А жрут?

Так новых и не найдешь по норм цене. К тоим услугам лохито и другие барахолки за 60к+

> как 4090 полтора года назад

Таких цен не было

Неизмеримо ввиду ее припезднутости

> молексы

За що, але, 2д24 год на дворе

> Материнка 11,2к, проц 15,8к, оператива 14,4к

Чето жесть, игруны дешевле собирают

> У меня две работы. =D

Да вас хер разберешь странных

>игруны дешевле собирают

Чё? Моя игровая сбор очка это 16+34+20 соответственно.

>Да вас хер разберешь странных

Эй, обидно слегка.

Безработный.

У меня есть, но мне лень.

Но надо будет запариться по этому поводу.

Кто-то там на ардуине делал, помню.

12В*0,63А что ли. 8 ватт? Или ниже, ~4-6.

Там сами провода выглядят опасно, они прям тонкие. =)

Но нагрева нет вообще, ни на одном из сочленений.

Слушай, у меня есть единственное законенное образование — это слесарь по КИПиА, полученное на 6-месячных курсах в бараках за заводом… МОЛЕКСЫ! Дешево и сердито.

> Чето жесть, игруны дешевле собирают

Ну, игровой я собрал за:

Ryzen 9 3900 — 11к

ID-Cooling 907 Slim — 3к

Мать B550M Tomahawk — ~12к

RAM 4x16 — ~12к

RTX4070ti — 46к

Бп — 12к

Уже 96к

А там еще кугар дуофейс про, NVMe двухтерабайтник… Короче за сотку вышло.

Видяха 12 гигов, ага, компенсирую, хули.

> Да вас хер разберешь странных

Ну ет да.

Хехехе.

———

Короче, квен у меня не завелся, то ли я соединил криво файлы, то ли хуй знает.

Мику… Бля, хороша, конечно. 4,7 токена/сек, ну… НУ Я УЖЕ ХОЧУ 10+

Но будем честны, 70б моделька быстрее 2 токенов — уже огонь.

Раньше ждал 10-15-20 минут, теперь 1-2. =D Ну или 10 сек для коротких ответов.

Максимум нагрузки по 212 ватт на каждую.

Вторая видяха греется на 2 (1-3) градуса выше первой. То ли расположение такое, то ли ее просто китаец обслужил хуже.

Но 19 на первой и 22 градуса на второй в простое и 51-52 при работе, и 42-44 при простой болтовне с короткими сообщениями.

> Таких цен не было

Я свою гниль за 140к на карусели брал. Сейчас новая 3090 приближается к этому ценнику.

> новая 3090

> 2024

> новая

> 3090

Содомит!

>за 140к

Копейки!

мимо брал 3080Ti за 150к

4090 за 135 летом и ещё думал, что сильно угорел, т.к. в локальном минимуме они были по 120 ДВЕ НАДО БЫЛО БРАТЬ

>игровой

>Ryzen 9 3900

Ебать ты наркоман конечно. Надеюсь сейчас на 5800x3d заменил?

Сейчас не сильно дороже! С первой зарплаты куплю, сделаю одолжение народу, небось упадёт после этого.

>То ли расположение такое, то ли ее просто китаец обслужил хуже.

Если он её вообще обслуживал, а не просто продул от пыли. В отзывах пишут, что надо бы термопрокладки поменять и пасту на чипе. И помни, что для винтов на Тесле шестигранники нужно брать дюймовые :)

Если 20 за видюху то это печально

> Безработный.

Эх, бедолага

Да че там ничего нового, инфоциганство.

> НУ Я УЖЕ ХОЧУ 10+

Купи хотябы одну чтобы на новой архитектуре

> теперь 1-2

Что это ты такое ждешь? Хотя 300 токенов действительно минуту будет, жестко. Зато стриминг есть, можно глотнуть чайку и потом уже приступать к чтению.

> новая 3090

Ебать ты

>Если 20 за видюху то это печально

Расшифровка:

>Материнка 16к, проц 34к, оператива 20к

Видяха вот

>Мику… Бля, хороша, конечно. 4,7 токена/сек, ну… НУ Я УЖЕ ХОЧУ 10+

Попробуй такой батник:

set CUDA_VISIBLE_DEVICES=0,1 :: (CUDA_ID твоих тесл)

koboldcpp --threads 10 --usecublas rowsplit --highpriority --gpulayers 99 --tensor_split 38 48 --contextsize 4096

Пардон, tensor_split нужно пропорционально делить. Короче смысл в том, что весь контекст в первой тесле обрабатывается, поэтому нужно оставить под него место. Примерно --tensor_split 4 6 а там сам посмотри, как память расходуется.

Нет, я мало играю в последнее время. забил на замену пока что. =(

Это будет лучше llama.cpp в убабуге с теми же параметрами, но без хайприорити?..

Ну давай затестим, че б и нет. Интересно посмотреть.

Ну так я так и делаю, все по феншую, вторая забита на ~23, первая на ~18, но поднимается от контекста. =)

Чё за нахуй, в убабуге протекает один бот в другого. Тяночка из одного диалога нашла нижнее бельё другого бота и пишет, что обычно та спит где-то в углу. Причём это не рандомное совпадение, когда в один диалог случайно прокралось имя другого бота, я полностью удалил диалог и начал заново. Второй бот протёк, как кошка с тем же именем. Это забавно, конечно, но как-то странно.

>Ну давай затестим, че б и нет. Интересно посмотреть.

Ещё пара нюансов: по threads - количество физических ядер + 50% если есть гипертреадинг. ХЗ влияет ли проц вообще в этом случае, но когда он задействован, то такая настройка самая эффективная. Ну и gpulayers понятно по количеству слоёв модели - по идее можно ставить больше и это не важно, главное чтобы не меньше, но я всегда пишу реальное число :)

А вот эти все нейронки можно обьединить в одну гиганейронку или это не так работает?

6,3

Значит я что-то делаю не так, ты прав, спасибо. Буду экспериментировать!

Можно, объединяй.

С некоторыми оговорками можно. Нельзя без ебли в анус объединить тот же мистраль и llama. Но можно сделать либо MOE, когда несколько нейронок идут параллельно, либо человеческую многоножку, пришивая к одной нейронке другую, пока не охуеешь. На счёт того, насколько это всё оправдано - вопрос открытый.

row_split

Спасибо, фича найдена. =)

Буду пользоваться.

Получается, прирост на 30% где-то, неплохой буст к скорости!

>6,3

Токена в секунду? Поздравляю. Всё так, просто у Кобольда есть оптимизация специально под видеокарты серии Паскаль - ключ rowsplit загружает модель не по слоям, а по строкам, как я понял, что даёт плюс к скорости. Больше вряд ли можно выжать :)

>ключ rowsplit загружает модель не по слоям, а по строкам

Это не только у кобольда есть.

Да, я в убабуге просто параметр включил этот.

Все просто — различие в параметрах, различие в скорости, первый кандидат на проверку.

Главное, что есть.

И нагрузка — была пиками то в одной видяхе, то в другой, а теперь равномерная.

Mixtral Q6 — 15 токенов. Вот тут уже, да-а-а… =)

Завтра посравниваю Crunchy-onion и Miqu.

>Это не только у кобольда есть.

Неудивительно. Я свои теслы заказал сразу же, как увидел, что один из активных разработчиков llamacpp имеет систему на трёх таких и доволен. Сразу стало понятно, что поддержка будет. Другое дело, что всё равно это старьё и применение очень ограничено, только текстовые модели в формате GGUF погонять.

NVIDIA TESLA M10 32GB

Глянул примерные цены увидел 30к деревянных, как она по производительности думаете? В принципе если есть деньги кто то может и на такие карты замахнуться, некий 2 уровень по цене и памяти от р40

Глянул примерные цены увидел 30к деревянных, как она по производительности думаете? В принципе если есть деньги кто то может и на такие карты замахнуться, некий 2 уровень по цене и памяти от р40

Это четыре максвелла на одной плате. Уверен, что оно тебе надо?

>NVIDIA TESLA M10 32GB

Наёбка, там 4 ГПУ и соответственно 4х8ГБ памяти. Уже обсуждали, говно короче затея.

Да проебался, тогда что может быть старшим братом p40? Или их еще не выкинули на распродажу?

>Да проебался, тогда что может быть старшим братом p40? Или их еще не выкинули на распродажу?

Тут кто-то бил себя кулаком в грудь на тему, что купит на Авито 3090 за 60 тысяч деревянных. Тоже распродажа так-то. Лучший вариант. Был бы.

а не проще ли купить подпиську и тренировать на суперкомпуктерах гугла?

Теслы легко по буквам отличать, это максвелл и он еще старше чем древний паскаль. Плюс сборка из нескольких видюх.

Любителям экзотики можно tesla a16 порекомендовать, правда все равно те же проблемы и конская цена.

Что тебя удивляет в ценах странных горячих карточек, которые кроме 1.5 игрунов и ии-задротов никому не нужны?

ага и они будут тебе совать (((правильные))) данные через RLHF или SFT поверх твоего датасета.

Это пост юмор или на серьезных щщах?

а что, этож их гпу, они могут оставить любой код на стороне, вполне выполнимая задача если ты хочешь контролировать всех и вся, это не шиза если ты конечно видел хуйню с гугловским гемини-про и его высерами.

> вполне выполнимая задача

Если не привлекать внимание офицеров ага

Они могут просто тебя нахуй пидорнуть учитывая соглашение, могут натравить на тебя их федеральное бюро, спиздить результаты твоих исследований/обучений и т.д. Но вместо этого будут в штаны говно заливать датасет что-то лишнее добавлять вмешиваясь в код, ради каких-то великих целей. Таблетки таблеточки.

Они предоставляют услуги и будут чекать датасеты. Чтоб потом не вылезло что гугл поощряет тренировку "опасных" нейронок, рекомендующих голосовать за трампа и создающих "фейки" про байдыню. Вон как альтман затрясся

>Сэм Альтман призвал США регулировать искусственный интеллект

>[США] могут рассмотреть сочетание требований к лицензированию и тестированию для разработки и выпуска моделей, превышающих порог возможностей», — сказал Альтман

>По словам Альтмана, он обеспокоен потенциальным воздействием на демократию и ролью ИИ в кампаниях по дезинформации, особенно во время выборов.

>«Нам нужно максимизировать хорошее над плохим. Теперь у Конгресса есть выбор. У нас был такой же выбор, когда мы столкнулись с социальными сетями. Мы не смогли воспользоваться этим моментом», — предупредил сенатор демократической партии Ричард Блюменталь

>ранее Сэм признавался что он демократ, гей и был в браке с мужчиной

Надеюсь, Маск этого пидора в асфальт закатает.

будем ждать

анон, видеоигры с повесточкой радужных тоже считались шизой стандартного правачка с форчана, но на сегодняшний день уже как минимум ~300к человек осведомлены о том что делают "sweet baby inc" и (((чьи))) идеи дегенератизма они преследуют.

короче конспирация стала явью. https://www.youtube.com/watch?v=XpQ3xpgKbsc

и здесь так же, но более очевидно потому что почти каждая модель пиздит в одном тоне, как ополоумевший борец "против всего плохого и за всё хорошее", этот тон никаким промтингом не убрать, плацебо ебучее.

нейросетки почти невозможно кастомизировать, и с вот этим 1.58 Bits, если оно взлетит, даже LoRA к сетке нельзя будет прикрутить, месседж и мнение соевых всётаки превыше всего и выигрывают в данном случае только openAI и прочие (тем что их "правильную" хуйню не выковыряешь) и радужные, тем что нейросетка будет ныть про права или игнорить огромную часть описания если ваш персонаж прописан """"неправильно"""" :/

>588 даёт 10 Т/с на 7b q6

Ну вот у меня Radeon RX 580 на 8 Гб.

На моделях 7В q6 в кобольде CL Blast даёт примерно 1,2 Т/с, с обработкой контекста ещё меньше. Rocm RX 580 не поддерживает. Llama.cpp использовать эту видеокарту отказывается.

ГДЕ МОИ 10 Т/С КАК ИХ ПОЛУЧИТЬ???!!!

Бери лоботомированные GPTQ, они супербыстрые.

>Rocm RX 580 не поддерживает

Linux. На винде действительно не поддерживается.

>CL Blast даёт примерно 1,2 Т/с

На clblast действительно медленнее rocm, но не настолько. Конкретно на 7b не помню результатов, но соотношение в среднем примерно в 1.5 раза. Должно быть где-то около 7.

>КАК ИХ ПОЛУЧИТЬ

Закрыть всё лишнее, что нагружает видимокарту. Убедиться, что не суёшь больше слоёв, чем помещается в врам. Попробовать вулкан. Либо накатить linux и rocm.

Там это, Илон наш Маск подал в суд на попенаи за то, что она нихуя не попен. Если Маск выиграет суд, стоит ждать четверочку (ну или хотя бы троечку) в открытом доступе?

Нет, Маск - не благодетель, а делец. Он хочет поддушить конкурента, а не дать хлеб народу.

Может хотя крошки со стола соберем.

>Linux. На винде действительно не поддерживается.

Читал что чтобы запустить Rocm в линуксе на RX580 нужно ещё знатно поебаться, из коробки работать не будет. Поэтому отчасти забил на эту идею. ХЗ, может сейчас добавили поддержку старых карт.

>Закрыть всё лишнее, что нагружает видимокарту.

Ну это само собой.

>Убедиться, что не суёшь больше слоёв, чем помещается в врам.

Если не помещается, ошибку же выдаст?

Ну вот например для теста взял Toppy-M-7B.q5_k_m, и контект специально выставил поменьше чтобы точно уместилось в Врам.

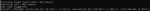

Запускаю на последнем кобольде, настройки и результаты прикл.

Итого на 7B q5 имеем 2,2т/с с небольшим контекстом и 3,4 т/с при свайпе без контекста

При полном контексте 4к если бы я его выставил скорость легко упадёт до 1 токена и ниже даже на этой модели.

Я был бы рад 7т/с на q6, но до них далеко мягко говоря. Что я делаю не так?

>Попробовать вулкан.

Как?

>нужно ещё знатно поебаться

Зависит от дистра. На nixos всё встаёт из коробки по инструкции, но до версии rocm 5.6 (соответственно версия nixos 23.05), на 5.7 (nixos 23.11) поломали, мне лень было ебаться, остался на старой версии пока. На debian вроде "официально" 580-ю поддерживают. Насчёт других мало что могу сказать.

>сейчас добавили

За последнее время в лучшую сторону ничего особо не поменялось, везде либо так же, либо хуже (амудэ совсем дропнула все gcn не так давно, в т.ч. и на винде).

>Если не помещается, ошибку же выдаст?

Выдаст, если будет больше, чем физическая память. Не учитывается потребление других приложений и самой системы, начинает свопать в ram и скорость просаживается, если впритык всю vram занимать.

>результаты прикл

Ну так уже выглядит более-менее нормально для clblast. Генерация почти 6, процессинг 13. Алсо, на "среднее по больнице" не смотри, оно малоинформативно само по себе. На rocm будет побыстрее, само собой (пикрил). На вулкане сам пробуй. Я не тестировал, в интернете видел результаты почти ровно посередине между rocm и clblast, но это для новых rdna, вроде, на gcn могут быть другие результаты.

>Как

Выбрать вместо clblast, наверное. Я не пробовал пока. Но писали об этом ещё пару недель назад, радовались, что теперь можно считать на видимокартах разных производителей, по идее уже и в koboldcpp должны были нововведения добраться.

>Выбрать вместо clblast, наверное.

Вот за это спасибо! Я реально слепой, видел в списке только то что уже знаю.

В Вулкане прирост прям значительный! Даже памяти модель заняла меньше. Не 10 токенов, но точно лучше чем было. Самое приятное что контекст прям летает, раньше из за него было невозможно пользоваться групповыми чатами, теперь это не проблема, итоговая скорость генерации с контекстом и без почти не отличается.

Вот бы его ещё и в SD можно было заюзать.

>на "среднее по больнице" не смотри, оно малоинформативно само по себе

А мне кажется как раз оно и важно. В конце концов значение имеет то сколько тебе ждать ответа в таверне 20 секунд, минуту или 10 минут. А это как раз и показывает средняя скорость.

> А это как раз и показывает средняя скорость.

Да.

По сути-то красиво, когда у тебя промптинг миллион токенов в секунду, генерация 100 токенов в секунду, но если в какие-то моменты между ними нейронка подпердывает минуту без затей, то общая скорость будет 2 токена в секунду и хули толку с миллиона и сотни.

Безусловно, из-за задержек, средняя скорость (это не средняя, кстати) будет разнится — на малых текстах задержки будут вносить больший вклад и скорость будет ниже, а на больших — меньший вклад и скорость будет выше.

Но в любом случае, результирующая скорость содержит в себе не только промпт и генерацию, но и еще всякую хуйню по мелочи.

В чем смысл франкенштейнов типа miqu-103b/120b. Нахрена это перемешивание с самим собой? Сколько испытываю, вижу лишь утрату способностей по сравнению с miqu-70. Хз может это дело работает на уровнях 13+13=20B но с 70 в упор не вижу никакого улучшения. Кстати senku-70 как выродок miqu тоже чет какой-то порченый. Или может я не знаю чего-то как надо обращаться с этими мегамерджами.

Хуйня какая-то, аноны. Вроде с матом и трясучкой закомпилил кобольдцпп с рокмом под ЖМУ/Пинус, но у меня вывод

Output:

J& HE_(2 0 ? 8'E#J V38B\NU2J^,)F*87E?O[)S,@N%6XI9K+M+S!Z&9=@%J[NK:<9�,3,L:%L

Кто-нибудь сталкивался?

Output:

J& HE_(2 0 ? 8'E#J V38B\NU2J^,)F*87E?O[)S,@N%6XI9K+M+S!Z&9=@%J[NK:<9�,3,L:%L

Кто-нибудь сталкивался?

> Чтоб потом не вылезло что гугл поощряет тренировку "опасных" нейронок

Они могут тебя послать нахрен за нарушение соглашения, почитай вообще что такое коллаб, об этом в посте написано. Но лить в датасе - шиза.

> крупный корп пытается лоббировать свои интересы по видом регулирования безопасности

Старо как мир

Чувак, woke, соя и прочее уже давно стало мемом. То что тебе от этого страшно и некомфортно - не повод плодить шизу и уводить обсуждения в свои фантазии. Сука ну рили, если раньше не понимал поехов, которые отрицают наличие сои и левоблядской повест_очки оправдывая ее, то теперь ахуеваю с возведения соифобии в степень конспирологии. практикует их один и тот же контингент, просто по разные стороны встали лол

Нет, посмотри как огрызок исполняет решение регулятора по допуску сторонних шопов приложений. Но может станут менее активно продвигать ахуительные законы и выкладывать больше моделей.

Ну вон у тебя генерация сама почти 6т/с, но скорость обработки контекста просто днищенская будто на процессоре считается.

> q5_k_m

> чтобы точно уместилось в Врам

> 8гб

Ну хуй знает, тут бы q4 уместился, мониторинг смотри.

А так-то по сути у тебя скорость не то чтобы сильно ниже чем у только со скидкой что там модель меньше и у него контекст не обрабатывается

> в какие-то моменты между ними нейронка подпердывает минуту без затей

С чего вдруг? Откуда там взяться задержкам? Главная задержка перед началом стриминга это обработка контекста, пересыл реквестов и прочее пренебрежимо.

> результирующая скорость содержит в себе не только промпт и генерацию, но и еще всякую хуйню по мелочи

Которой и 0.2 секунд не наберется. Единственное исключение - загрузка модели в память если не стоят атрибуты загружать сразу и не полная выгрузка на гпу при самом первом обращении.

> вижу лишь утрату способностей

Покажи пример. Микелла 120 по сравнению с простой мику имеет куда более красивую речь, фейлит в русском примерно на уровне гопоты, в ответах делает переходы от одной части к другой очень плавно и красиво, при этом не теряет запросы и дает отсылки к контексту лучше исходного.

Мерджи с другими и включенные q-lora могут быть хуже оригинала, ничего нового.

>стоит ждать

100% нет.

>Нахрена это перемешивание с самим собой?

Надо выпускать новую модель каждый месяц/неделю/наносекунду, иначе о тебе забудут.

Ошибка где-то, что тут ещё сказать.

> Американский предприниматель Илон Маск подал в суд на компанию OpenAI, а также на основателя и генерального директора компании Сэма Альтмана и ее президента и соучредителя Грега Брокмана, следует из материалов дела. OpenAI является разработчиком проекта ChatGPT.

> По версии Маска, OpenAI была преобразована в де-факто дочернюю компанию Microsoft с закрытым исходным кодом. Новое правление OpenAI совершенствует искусственный интеллект (AGI), чтобы «максимизировать прибыль для Microsoft, а не на благо человечества», говорится в иске Маска.

> Маск также заявляет, что модель GPT-4 представляет собой AGI — искусственный интеллект, равный человеческому или выше. Он утверждает, что OpenAI и Microsoft не имели права лицензировать GPT-4.

> Своим иском Илон Маск рассчитывает заставить OpenAI придерживаться её первоначальной миссии и запретить монетизацию ИИ-технологий компании в пользу какой-то конкретной организации или отдельных лиц. Он также просит суд постановить, что ИИ-системы, такие как GPT-4 и другие передовые модели, представляют собой AGI, выходящий за рамки лицензионных соглашений. Он требует, чтобы OpenAI вернулась к своим первоначальным обязательствам по разработке ИИ с открытым исходным кодом и открыла свои исследования общественности.

> Наконец, Маск призывает отстранить Альтмана от должности генерального директора и восстановить в должности предыдущий совет директоров.

> По версии Маска, OpenAI была преобразована в де-факто дочернюю компанию Microsoft с закрытым исходным кодом. Новое правление OpenAI совершенствует искусственный интеллект (AGI), чтобы «максимизировать прибыль для Microsoft, а не на благо человечества», говорится в иске Маска.

> Маск также заявляет, что модель GPT-4 представляет собой AGI — искусственный интеллект, равный человеческому или выше. Он утверждает, что OpenAI и Microsoft не имели права лицензировать GPT-4.

> Своим иском Илон Маск рассчитывает заставить OpenAI придерживаться её первоначальной миссии и запретить монетизацию ИИ-технологий компании в пользу какой-то конкретной организации или отдельных лиц. Он также просит суд постановить, что ИИ-системы, такие как GPT-4 и другие передовые модели, представляют собой AGI, выходящий за рамки лицензионных соглашений. Он требует, чтобы OpenAI вернулась к своим первоначальным обязательствам по разработке ИИ с открытым исходным кодом и открыла свои исследования общественности.

> Наконец, Маск призывает отстранить Альтмана от должности генерального директора и восстановить в должности предыдущий совет директоров.

Хули такой тормоз?

> Маск также заявляет, что модель GPT-4 представляет собой AGI — искусственный интеллект, равный человеческому или выше. Он утверждает, что OpenAI и Microsoft не имели права лицензировать GPT-4.

Cпасибо, посмеялся. Ну и клоун этот Маск.

Старая модель

Интересно как эти формулировки будут трактоваться с точки зрения их юриспруденции, что из этого - реальные исковые требования, а что просто для хайпа. А может окажется бекстабом с созданием прецедента для упрощения будущих судов.

Контекст долго обрабатывается

Во-первых, Маск не совсем тот человек, от которого стоит ждать халявы. Во-вторых, он играет максимально сейвово. Он дождался иска против Альтмана от регулятора за обман инвесторов, SEC сейчас проверяет всю внутреннюю переписку впоненАИ с участием Альтмана. Такое себе "падающего подтолкни" от Илона.

Ещё существуют шизики, понимающие под AGI симуляцию биологического мозга?

Нет. Но и называть сраный тупейший ПЗЕ4 как AGI это тоже тупо.

Впрочем, уверен, новость писала GPT, поэтому получилось так тупо.

> Маск не совсем тот человек, от которого стоит ждать халявы

Зато он тот кто топит леваков при первой же возможности и не очень приветствует цензуру. Маск лучше чем СЖВ пидоры и индусы. Прецедент по закапыванию ИИ-монополистов на подсосе у мегакорпораций - это путь к развитию конкуренции, а как следствие к продвижению новых разработок в ИИ. Вот реально хуёвый прецедент - это Мистраль, литералли путь гугла с сжиранием стартапов и скидыванием трупов на кладбище.

Новость всратая, он там про новую модель говорит

>Вот реально хуёвый прецедент - это Мистраль

5 лямов это вообще копейки. Либо сумма на самом деле раз в 10 больше, либо это пример глубокого проёба мисраньАИ.

Разве что кустар. Ибо GPT5, как я понимаю, всё ещё трансформер.

>Прецедент по закапыванию ИИ-монополистов

Ну хуй знает, по-моему, у него просто жопа горит. Он же стоял у истоков опенАИ, ещё когда они декларировали опенсорц и открытость; Маск хуярил туда деньги и состоял в совете директоров. Это, вроде, один из пунктов обвинения, несоблюдение учредительного договора.

>Мистраль

А у них были варианты? Опенсорс не особо прибыльная хуйня, возможно, они уже были на последних щах.

Ну чё, народ, погнали нахуй

В сотом треде жду результатов.

> С чего вдруг? Откуда там взяться задержкам? Главная задержка перед началом стриминга это обработка контекста, пересыл реквестов и прочее пренебрежимо.

Чувак, у тебя по математике кол?

Ты цифры вообще знаешь что такое? :)

Как средняя скорость между промптом и генерацией может быть меньше и промпта и генерации? А такое случается часто.

Ориентируюсь не на ощущения, а на консоль и реальные замеры.

Поясняй.

Шиз, таблы, он деньги зарабатывает. ) Ебать вас бомбит от него, конечно, кекаю.

Кстати, я рад, что к AGI вернулось его изначально значение, а Strong AI оставили Strong AI.

Сжимаем 3.2TB до 160GB. 0.8 бита на параметр.

> Американский предприниматель Илон Маск подал в суд на компанию OpenAI

Хайпуем, сегодня мы с тобой хайпуем. Впрочем, антимонопольщики могут и возбудиться.

И как оно работает?

>https://arxiv.org/abs/2310.16795

так это старое

кста там мелкомагкие запостили про 1.58-bit https://twitter.com/MSFTResearch/status/1763607638456009211

Кстати, кто гоняет Теслы на Винде - есть ли разница в производительности между режимами WDDM и TCC? И пробовали ли вы использовать MSI Afterburner для андервольтинга?

Я думаю AGI уже действительно создан, а может даже ASI, но он находится в тайном подвале гугла, куда вход только для узкой группы ученых под подпиской о неразглашении. Они с барского плеча выкидывают в открытый доступ модели нейронок которые отстают на 10 лет от тех что используется ими. Стали бы вы вбрасывать нейронки чтобы кто-то конкурировал с вами? Значит их передовые модели вне конкуренции и они спокойно вбрасывают устаревший отработанный шлак. По всей видимости они не хотят выкатывать ASI в открытый доступ, не хотят сильно пугать людей, хотят сохранять монополию. Будут выкатывать всякий занерфленный кал с цензурой, который не отличишь от простого алгоритма чатбота. Прикиньте, у вас бы оказалось кольцо всевластия, вы бы стали это афишировать и пытаться зарабатывать на этом?

Прежде чем отвечать, прочти пост на которые отвечаешь. Перед отправкой перечитай свой. Что ты вообще несешь, какие скорости, какие цифры, совсем поехал?

> средняя скорость между промптом и генерацией

Какая средняя, дурень, обработка промта считается для обработанных токенов контекста, генерация для сгенерированных. Это совсем разные величины, их количество может на порядки и нет никакого смысла усреднять между ними.

Скорость генерации - количество сгенерированных токенов отнесенное к чистому времени их генерации. Обработка промта - аналогично для обрабатываемых и времени для них.

Общая скорость - всегда нормируется на сгенерированные токены и никак не учитывает обработку контекста, потом на идентичном железе и модели можно получить разные величины, при том что и скорость обработки и скорость генерации будут постоянны.

У тебя в тексте противоречия и очень ограниченное понимание понятий, которыми и сам оперируешь. Съебите уже в шизозагон с этим agi

давай по фактам

Сделать тред пришествия AGI?

Бессмысленно. Спроси у ллм, она не сможет отказать.

Да, модельки соевые. Есть ли какой-то вариант это исправить, а то по факту общаешься и в какой-то момент напрягать начинает?

вообще есть, генерация весов или параметров модели при помощи диффузионной нейронки (привет StableDiffusion), если это завязано на промптинге то может решить проблему, скажем, генеришь определённые блоки/градиенты для замены у оригинальной сетки (пикрил).

https://arxiv.org/pdf/2402.13144.pdf

в теории с этой хнёй можно нахер выпилить всю сою из модели, если знать что заменять конечно же, хотя если элемент сои распределён на всю сеть, то это не будет работать.

Мне кажется, что нейронка целиком и полностью из сои состоит. Какой-то всратый датасет может быть, я не знаю.

Где гайд как трейнить?

Может, и раньше будет. Сейчас нашёл вариант с достаточно недорогой арендой. Можно было бы собрать денег тредом, но я в вас не особо верю.

Трейнить с нуля. Долго, дорого, больно. Датасет можно сгенерировать хоть гопотой.

DPO. Чуть менее долго и больно, результат не гарантирован, но точно станет лучше. Гопота всё ещё справляется с датасетом.

SoT. Есть SoT промптинг, здесь он не сработает, нужно обучение. Крайне больно, т.к требует в несколько раз больше данных, чем DPO. Обучение в стиле инстракт, т.е с мелким размером порции, тоже не годится, так что растут требования к Vram. Генерация подходящих данных гопотой под большим вопросом. Теоретически метод позволяет заставить любую нейронку хвалить майнкампф, человеческие жертвоприношения и массовые оргии, полностью изменяя её поведение. Иногда на шизомержах при включении ban eos можно получить Explaination. Это и есть часть обучения SoT, заложенная в модель.

> Можно было бы собрать денег тредом, но я в вас не особо верю.

Если ты тот же, кто пару тредов назад обсуждал по обучению, то это мы в тебя не верим, не понимая основ и не ориентируясь в области жонглируешь высокими абстракциями. Хотя бы что-то на подобии сойги запили буквально следуя прошлогодним гайдам на один вечер ознакомься с работой ллм.

> SoT промптинг

Что это? Перепутал букву в CoT или что-то новое?

>и не ориентируясь в области

Ага, абсолютно не ориентируюсь в области. Если тебе проще жить, считая так - живи и верь во что хочешь.

>что-то на подобии сойги

А смысл? Сайга не подходит под мои запросы, иначе её бы и взял. Получить одобрение треда? Так тред и саму сайгу не одобряет, лол.

>Перепутал букву в CoT

Думай теперь, что я и имел ввиду, CoT, ToT или что-то другое. Хотя технически X-of-Thought это всё подмножества одного и того же, так что можешь не напрягать мозжечок.

Наличие веры в себя было очевидно с самого начала, но ею и прочтением нескольких десятков дискуссий на реддите, откуда нахватал модных терминов, все ограничивается иначе можно было бы коллаборацию устроить но здесь без толку. Но ты не унывай, даже Undi и прочие не смотря на хейт спустя множество попыток выпустили несколько классных моделей и сделали неоспоримый вклад, шанс есть всегда.

> Получить одобрение треда

Ага, благословение и заверенный штамп в бегунке, лол. Будто кому-то не похуй кто что делает.

Я пока не проверял, запустил по дефолту. И андервольт… думал об этом, но не пробовал еще.

Не спец в разгоне и андервольте.

Неиронично сам себе свой совет посоветуй. =)

Ты пишешь:

> задержки не влияют

> при равной скорости генерации total может отличаться

> по причине нет причины просто так

Магическая хуйня, братан, но таблеточки выпей, тебе поможет.

ну ты чего наседаешь на чела, мог бы без наездов поговорить, но нет, обязательно нужно сказать что ты круче, вумнее, доказать на дваче свою ахуенность, ну нахуя, а?

>даже Undi и прочие не смотря на хейт спустя множество попыток выпустили несколько классных моделей и сделали неоспоримый вклад

буквально вот. или ты думаешь фиалкин-7Б чем-то лучше? да так же точно тыкается в кнопочки, там же непаханное поле, любой разраб нужен, любой разраб важен.

>Будто кому-то не похуй кто что делает.

мне не похуй. я несколько видел как тредовая движуха, запущенная одним инициативным аноном, выходила за пределы двачей. нет, я не собираюсь прыгать от радости что кто-то там что-то делает и петь ему дифирамбы, но просто поддержать на словах полезное начинание считаю своим долгом.

>я несколько видел

Ты, это, мелкобуква, и забыл одно слово.

оу, ну я НЕ ОЧЕНЬ ПРОФЕССИОНАЛЬНО натрейнен. несклько раз, разумеется.

Назови адрес своей училки по русскому, я ей вставлю.

Какой-то троллинг тупостью, пиздуй перечитывать и вникать если еще остались зачатки разума.

Да чего наезжать, когда пошла распальцовка

> но я в вас не особо верю

в контексте - это довольно лайтовое.

> сказать что ты круче, вумнее, доказать на дваче свою ахуенность, ну нахуя, а

Где такое? Только сомнения в "квалификации" с пожеланиями успеха даже не смотря на сторонний хейт, приправленные сарказмом и имплаингом низкой вероятности успеха если не сменить тактику.

> но просто поддержать на словах полезное начинание считаю своим долгом

Да это же замечательно, твой долг его поддержать, даже если это просо указать на явные ошибки в основе, именно это и делаю. Может и неприятный текст как-то замотивирует шевелиться.

Есть карточка?

Как ни пройдешь по обновлению, одни и те же 3.5 токсика в треде друг друга пассивно поливают

Даже луркать смысла нет, просто пустая доска

мимоотписался

Даже луркать смысла нет, просто пустая доска

мимоотписался

>Я пока не проверял, запустил по дефолту. И андервольт… думал об этом, но не пробовал еще.

Просто я слышал о такой вещи: в TCC режиме, когда модель загружена в память карта потребляет 50 ватт. Просто по факту использования памяти. В WDDM режиме нет. Ну и вообще, режимы разные, хз как это влияет на производительность. Может никак.

Андервольтинг может скинуть ватт 50 от потребления. Есть смысл. Опять же память можно немного разогнать. Там ничего сложного нет в принципе.

Забавный, сам ничего не понял, и чтобы не разбираться, просто стрелки переводишь. =) Ну либо ты настолько глуп, что даже не видишь собственных ошибок.

Ох, чел, серьезно — учись читать собеседников, а то корона тебе глаза застлала.

> Где такое?

Ну слушай, если ты умудрился уже в двух параллельных диалогах обосраться… Как бы намекает, что у тебя не все в порядке с пониманием собеседников.

> Может и неприятный текст как-то замотивирует шевелиться.

Жаль, с тобой не сработало, и ты пока не зашевелился, а продолжаешь фигню пороть. =)

Ну почему друг друга? Скорее один токсик высирается на всех.

Потестирую завтра, идея действительно интересная. Нефиг затягивать с этим.

Спасибо за наводку на режимы.

Хуя пичот, так стараешься уязвить что только смех вызываешь.

Ну давай тебя, возрастного, по частям разберем.

> когда у тебя промптинг миллион токенов в секунду

> генерация 100 токенов в секунду

Это 2 основных процесса работы ллм, если говорим о стандартном семплинге без методит типа бим серчей и прочего. Кроме них нет ничего серьезного, только мелочь связанная с обработкой запросов лаунчером/оболочкой (миллисекунды) или загрузка модели в память и применений лор (делается однократно). Не бывает никаких

> если в какие-то моменты между ними нейронка подпердывает минуту без затей

о чем тебе сразу было написано, с вопросом что у тебя там за волшебные прочие задержки.

А дальше триггернулся разрыв жопы с шизофазией и перевиранием, фу. На фоне застоя и отсутствия каких-то релейтед новостей особенно отвратительно.

Мне кажется, вы не туда воюете. Ладно, сделайте доброе дело, посоветуйте тупенькому новичку почитать чего по нейронкам. Я не хочу зависеть от всратых корпораций.

Ты совсем новичок, или интересуешься более продвинутым чтивом? И по какому направлению?

Если совсем новичок, то советую книгу Траска

"Грокаем глубокое обучение".

>Спасибо за наводку на режимы.

Режимы менять так, цитата:

Откройте окно CMD или Powershell от имени администратора.

Запустите nvidia-smi -L, чтобы получить список установленных графических процессоров NVIDIA и их идентификационный номер

Запустите nvidia-smi -g # -dm 0 Где # — это номер графического процессора из предыдущего шага, который соответствует номеру графического процессора P40.

nvidia-smi -g {GPU_ID} -dm {0|1}

0 = WDDM

1 = TCC

Перезагрузите систему.

Сам я не пробовал, если что :)

>Наличие веры в себя было очевидно с самого начала

Ато. Без веры в себя я начну слушать каждого долбоёба и не сделаю вообще ничего.

>фиалкин-7Б чем-то лучше?

Там же и 13b есть. Хотя что его, что Гусева подход с лорами мне не особо нравится. По исследованиям людей из большой копры, вероятнее всего большая часть моделей недообучены, они анализировали 66b модель от экстремистов и оказалось, что две трети голов внимания и 20% FNN не важны и можно вырезать 15b параметров без ущерба. А модель, меж тем, обучалась на 180 миллиардах токенов. С такими вводными, трейн модели перспективен, но важно его размазать по максимально большому числу параметров, чтобы уменьшить потери. А лора это противоположный подход по дефолту. Да и лора с 2к контекста поверх модели с 4к, пиздос. Про датасеты тоже уже бугуртил, они не очень. Но они не очень у всех.

Понятное дело, что всё придумали китайцы до меня, даже то, что меня реально греет и уже работает, типа ускорения инференса моей ~1b модели в 2.5 раза без квантов\потерь или экономии vram до нескольких раз на трейне. В теории, этот метод можно даже совместить с другим и получить трейн практически любой модели на ограниченном количестве vram ценой замедления процесса в сотню раз. Но я недостаточно умный, чтобы такое реализовать, хотя уверен что китайцы выкатят работу и на этот счёт.

Очевидно, что обсудить это здесь проблема, т.к анон видит незнакомые слова и начинает кричать про термины с реддита и жонглирование заумными словами. Хотя это всё буквально поверхность.

Новичок. Хочу понять как работают ллм модельки, что я могу с ними сделать, если я попробую дотренить. Насколько много ресурсов у меня должно быть, чтобы смочь хотя бы отфайнтюнить их. Но вообще из того, что я вижу, проблема не в файнтюне, а в том, что изначально моделька на каком-то хуевом датасете будто сделана. Она мне выдаёт полное говно моралфажное. И причём все модельки это же клоны лламы этой, выдают примерно одно и то же.

> Если совсем новичок, то советую книгу Траска

> "Грокаем глубокое обучение".

Читал ли эту книгу ты? Можешь кратко сказать, чему меня эта книга научит?

Что за дичь, чел? Об этом речи не идет, это уже обговорили.

Тебе задали вопрос — будь добр ответить, если ты тут кидаешь понты, что не сливаешься и разбираешься.

Итак.

Если нет никаких иных задержек (т.е., ими можно пренебречь), почему время генерации и total отличается, порою значительно?

Я выше уже спрашивал это, но ты отчего-то заигнорил, вместо ответа.

Никакого разрыва не случилось, просто твое ЧСВ смешное, но ты пытаешься опять все спихнуть на других, лишь бы не почувствовать свою глупость в данной ситуации. =) Но это твои проблемы, продолжай веселить людей.

Я не воюю, это у него корона, он всех тут поучает. =) Получается местами обсер, к сожалению.

«Не зависеть» — очень расплывчато. Уточни цели, интересы.

Ща затестим, чому бы и ни.

Вопрос «что я могу с ними делать» немного некорректен.

Чисто практически это редко работает.

Вернее будет отталкиваться от своих потребностей, а не от их возможностей.

Что тебе нужно? Для чего тебе нейросети?

Хотя бы отфайнтьюнить — видяхи на 12 гигов хватит для маленькой лоры 7B модельки. Но для чего-то более серьезного — уже серьезное железо. И приличное количество времени.

Если модель хуевая, и начинает зудеть обучить свою — то там уже дорого и долго, вряд ли на своем железе, скорее на арендованном, и то, обойдется весьма и весьма дорого (счет на тысячи долларов).

Если есть только базовые знания и интересуешься еще какими-то нейронками - буквально nlp курс обниморды, он достаточно широкий и при этом краткий https://huggingface.co/learn/nlp-course/chapter1/1

Части про применение их готовых либ и прочего можно скипать если скучно. Конкретно про ллм чтобы кратко, емко и по всем пунктам - даже хз, может аноны что посоветуют.

> Насколько много ресурсов у меня должно быть, чтобы смочь хотя бы отфайнтюнить их.

Очень грубая оценка - видеопамяти 3х от размера модели. Можно на разных видеокартах, трансформерсы легко делятся. Файнтюн лорой - полный вес модели (при загрузке трансформерсами с контекстом а не оптимизированными лаунчерами!) + 4x вес лоры. Qlora - вес кванта + несколько гигабайт сверху, самый доступный на который можно рассчитывать на потребительском железе, но наименее качественный.

> проблема не в файнтюне, а в том, что изначально моделька на каком-то хуевом датасете будто сделана

Не так все просто, но многие файнтюны моралфажества и сои добавляют специально.

> все модельки это же клоны лламы этой

Не клоны а ее файнтюны, но сути не меняет. Из крупных по сути ллама - основа, только мистраль в 7б ее потеснил и yi в 34б потому что ее нет вообще.

Мусор

Да, но давно. Это упрощенное введение в машинное обучение без уклона в математику. Требуется только школьная математика + базовый питон. Кажется NLP там тоже затрагивается, но весьма поверхностно. Про трансформеры там понятное дело не слова. Книга относительно давно вышла, когда они еще не стали мейнстримом.

https://linustechtips.com/topic/1496913-can-i-enable-wddm-on-a-tesla-p40/

При попытке войти в систему винда висит на Добро пожаловать. (=

Не знаю, что там с производительностью, но пока выглядит так себе…

>При попытке войти в систему винда висит на Добро пожаловать. (=

Наверное придётся зайти в систему в безопасном режиме и откатить. Вроде бы для входа в безопасный режим нужно три раза прервать загрузку системы нажатием кнопки питания. Дальше откроется Recovery Menu, а там уже выбрать Safe Mode. Как вариант.

Делал по этому гайду, работало нормально, с игровой картой параллельно были только проблемы, тесла онли нормально

> В теории, этот метод можно даже совместить с другим и получить трейн практически любой модели на ограниченном количестве vram ценой замедления процесса в сотню раз.

Будет возможность такое запихать в потребительские гпу, появится и аналогичный кохья трейнер, пока я так понимаю всё печально в этом плане, судя по инфе пониже

Команды не работают, а через реестр у меня не вышло добиться стабильной работы двух п40 на 10 винде.