A simple D&D scenario to quickly test your models/settings in RP conditions

https://www.reddit.com/r/LocalLLaMA/comments/1aooe3a/a_simple_dd_scenario_to_quickly_test_your/

https://www.reddit.com/r/SillyTavernAI/comments/1bwj3g3/comment/ky6kuhe/

I recently tested bunch of 7b and 13b models for RP, and only these followed all instructions and passed the test:

1st place

• openhermes-2.5-mistral-7b-Q5_K_M

• siliconmaid-7b-Q5_K_M (Q6 version was almost perfect)

• solar-10.7b-instruct-v1.0-uncensored-Q4_K_M

2nd place

• Fimbulvetr-11B-v2.q4_K_S

• InfinityRP-v1-imatrix-7B-Q5_K_M

all other popular variations of these models didn't pass the test

> Как бы перевел надмозг: нас всех отправят в тюрьму и это будет занудное существование

> Как на самом деле: мы все сядем и это будет хуево

Хуйню ты спизданул, братик. Ты элементарно не смог определить подлежащее и сказуемое, не позорься больше, ладно?

Там в комментах автор охуел когда узнал что есть разные промпт форматы, лол

Так что это топ моделей с тем промпт форматом что он там запускал

Скорей всего чатмл

Из маленьких моделей самый лучший это crunchy onion

>Из маленьких моделей самый лучший это crunchy onion

На мой взгляд новый qwen лучше

> ля 70б надо 48 гигов

В паре тесел p40 как раз столько, а в P100 будет именнр как ты описал, потому они и не нужны.

> использовать специализированные нейросети, а не LLM

Какие же? Лучше ллм для подобного нет.

> мультимодальные модели уровня ChatGPT

Гопота и есть ллм, а вся мультимодальность (в контексте обсуждения офк) того, что есть в открытом и не очень доступе - лишь костыль к языковой части.

Это случаем не поехи что тестируют в детерминизме не меняя формат и оценивая парочку ответов в поиске первого что когда-то понравился? В действительности различий между всем этим зоопарком моделей не так много, исключая поломанные они все должны выполнять эти задачи со скидкой на размер офк. Больше на рандомайзер похоже.

А ну ясно@понятно. Как там кстати эта силиконовая мейда, пробовал кто?

пробовал такую - https://huggingface.co/LoneStriker/Qwen1.5-8x7b-GGUF - хуйня по итогу

>новый qwen лучше

Уже есть расцензуренные файнтюны?

Любишь иероглифы и выпадение из контекста?

Лан, качнул щас 32б, какой же это кал...

1.5 это прототип qwen2, нам просто дали старую версию 32b из тех что у них уже пол года лежала

Ее все еще можно отфайнтюнить, что 100% уже кем то запущено

Так как наконец то в руках людей появилась 30b модель, самая вкусная по размерам

Какой смысл рассуждать о чем-то мифическом из секретных лабораторий? Линкани конкретную модель квен, которая, по твоем мнению, является годной

Ты не догнал о чем я?

Я о том что нам выдали весы прототипа, не той qwеn2 которая щас в топе. Это все еще 32b модель, только она сырая, вот и все

Смотри, исходный тезис

> На мой взгляд новый qwen лучше

Но все модели квен, которые я скачивал, это просто кал из жопы для упоротых говноедов. Возможно, я не прав и пропустил такую-то годноту и моё мнение об этой китаепараше ошибочно. Но для признания свой ошибки мне нужно качнуть соответствующий gguf и запустить. Вопрос: какую модель мне скачать, чтобы убедиться, что китаеговно это не говно, а годнота?

Пи Эс. А если анон сам не щупал этот квен, который якобы лучше, и он существует лишь в Волшебном Мире Фантазии анона, то, конечно, рассуждать тут не о чем

>Вопрос: какую модель мне скачать, чтобы убедиться, что китаеговно это не говно, а годнота?

Ну, это утверждал не я. Вобще щас в топе qwen2 72b, какая именно ищи, я хз. Я только видел списоки моделей и она выше остальных 70ток

Я тебе долбаеб 2 раза обьяснил,а ты так и не понял, я вобще не говорил что лучше, я описал ситуацию с 32b моделью

Да я понял, что ты долбоёб, не нужно было отдельно на это указывать, мой юный чартодрочер.

> 72b

))) Читай нить, додик

> > 72b

Есть ее файнтюны на рп или около того?

Бля столько моделей проверить и все в пустую, ну еба

говна поешь, ему помогают оно выебывается, ну и кто ты после этого?

Нет тут никакой помощи, ты просто шизу высираешь и всё

Да что-то там много кринжа и это реально печально. Больше всего удивляет что в комментах на полном серьезе рекомендуют гриди энкодинг "чтобы результаты были для всех одинаковыми", а забавляет что авторы, которые так лихо все оценивают, не понимают значение зирошот и удивляются наличию пресетов семплеров.

А с другой стороны, сидеть подбирать настройки, пресеты и темплеййты для каждой модели, это тестирование растянется на 1 модель в месяц, а пока выйдет хотя бы тесты трёх моделей, уже наделают прорывных новых. Вот и спешка ебёт горячку.

>1 модель в месяц

1 модель в вечер, уж

Промпт форматы чекнуть минут 30, их всего 3-4 популярных, ну и без них тоже.

Не настолько, за вечер пару-тройку можно оценить, а то и больше если пойдет. Форматов инструкций единицы и в этом нет большой сложности. Если хочешь вещать мнение с претензией на объективность - придется минимальные усилия приложить, причем осмысленно а не оправдывать ложные выводы потраченным временем.

> уже наделают прорывных новых

Да где они? Сношают инцест миксы 7б, которые слегка отличаются вариациями жптизмов/клодизмов или уровнем поломок.

>Если хочешь вещать мнение с претензией на объективность - придется минимальные усилия приложить

Я ленивый.

>Да где они?

команд-р, две версии, китайцы постоянно что-то рожают (в основном туфту).

https://www.reddit.com/r/LocalLLaMA/comments/1bxax9o/7b_32k_i_merged_dolphin_with_mistral_v02_and_got/

Ну все пошла волна 7b на новом мистрале

Ну и гугл там что то высрал, думаю лучше с цензурой не стало

Ну все пошла волна 7b на новом мистрале

Ну и гугл там что то высрал, думаю лучше с цензурой не стало

Из комментов там утащил

They can be hard to find, here are some of the v0.2 merges:

Tess-7B-v2.0 (my personal favorite but it's currently being retrained)

https://huggingface.co/migtissera/Tess-7B-v2.0

dolphin-2.8-mistral-7b-v02

https://huggingface.co/cognitivecomputations/dolphin-2.8-mistral-7b-v02

bigstral-12b-v0.2-32k

https://huggingface.co/abacusai/bigstral-12b-v0.2-32k

Einstein-v5-v0.2-7B

https://huggingface.co/Weyaxi/Einstein-v5-v0.2-7B

OpenCerebrum-1.0-7b-DPO

https://huggingface.co/Locutusque/OpenCerebrum-1.0-7b-DPO

OpenCerebrum-1.0-7b-SFT

https://huggingface.co/Locutusque/OpenCerebrum-1.0-7b-SFT

> Я ленивый.

Ты же не вещаешь со своими тестами там, надеюсь?

> команд-р

Только он и мику считай за квартал.

> на новом мистрале

Он не новый же

>Ты же не вещаешь со своими тестами там, надеюсь?

Нет конечно же, я ж ленивый, максимум пороллю пару ответов на базу от новой сеточки и выложу в тред.

>Только он и мику считай за квартал.

А китайцы???

Все правильно.

> А китайцы???

Хз, про них плохо отзывались. Вон сейчас увидел что маэстро запилил tess на qwen72b, с квантами правда не густо, но качаю что есть.

>Он не новый же

Для нас новый, так как базовую модель выложили недавно

Ну и база контектса у него 32к родная, что приятно

Теперь все текущие нормальные 7b будут переделаны на новую основу, может и опенчат станет получше, мне понравилась моделька

Чем он лучше инстракта, который доступен уже давно? Один в один же.

Не, инстракт кастрирован немного, на его основе сетки хуже чем на базовой

> Только он и мику считай за квартал.

Ну мику-то конечно посасывает, она в одном квартале с микстралем.

Хз, сравнивал их в чистом виде - разницы не замечено. Офк может там есть что-то связанное с их дефолтным шаблоном промта, но с другими работает лучше, как ни странно.

> с микстралем

Микстраль - мем для васянов, как можно его в один ряд с мику ставить.

Чекнул первые два, мертворождённая параша. Дальше тупо лень

> Микстраль - мем для васянов, как можно его в один ряд с мику ставить.

Ну а хули, MMLU бенч на логику и рассуждения в 75 - это кринж для 70В. У жпт 87, файнтюны 34В вплотную к 75 держатся.

>Чекнул первые два, мертворождённая параша.

Чекнул это разок тыкнул? Вобще не о чем считай, но отзыв о том что сетка говно оставить эт святое

Ты хоть промпт формат додумался поменять потыкать?

Ну конечно, чтобы безмозглая 7б сетка имя чара писала, как в карточке, надо промпт менять ))) Просто 7б говно без задач

Интересно, как себя показала новая command-r-plus, сотка. Надеемся на прорыв?

>Просто 7б говно без задач

А может ты?

Какое сильное заявление, у тебя наверное есть доказательства?

Ну бля, если у тебя нет задач с которыми эти тупенькие сетки справляются то на тебе мир клином не сошелся

Ты ведь ленивый, поэтому ты нихуя не проверял, в итоге устроил тут антирекламу, только потому что тебе впринципе 7b не нравятся

Один раз тыкнул - увидел кривое имя и всё

>Просто 7б говно без задач

Ты ж еще хуже того кто сетки тестил на реддите, он хоть че то делал и не пиздел по пусту

Большая дохуя, сложно запускать.

>Какое сильное заявление, у тебя наверное есть доказательства?

Чел, просто купи ресурсов. 7B всё же дно.

Случаем на шизосемплинг стоит? Они тупые но не настолько.

На 24 гигах ее можно квантануть, или только 48?

Прогнал эту вашу новомодную

>Tess-7B-v2.0 (my personal favorite

Ну что ж... Весьма болтлива, и как всегда шизоидна. Ничего нового, опять шум из-за пустоты.

Офк никакие семплеры и форматы не настраивал, как и в прошлых десятках испытаний, стандартный пресет ролеплей и альпака формат, семплеры тоже без выебонов.

>Tess-7B-v2.0 (my personal favorite

Ну что ж... Весьма болтлива, и как всегда шизоидна. Ничего нового, опять шум из-за пустоты.

Офк никакие семплеры и форматы не настраивал, как и в прошлых десятках испытаний, стандартный пресет ролеплей и альпака формат, семплеры тоже без выебонов.

>На 24 гигах ее можно квантануть, или только 48?

Судя по всему пока вообще никак - обнаружены какие-то ошибки и все модели будут переквантованы:

https://github.com/ggerganov/llama.cpp/pull/6491

Так что рано радовались. С другой стороны может теперь обычная command-r поумнеет.

Вообще про exl2. Ггуфы той то уже ищутся, но толку раз еще и поломаны.

Аноны. Тут давно мне рекомендовали из моей базы данных сделать массив ключевых слов, чтобы модель по ней искала нужные ответы на запросв. Так вот, в чем вопрос. Не проще ли скормить эту базу данных ключевых слов нейросетке? Или сделать подобие лоры, как у рисовальных нейросетей? Или это требует больших объемов памяти? 4 гб врама и 32 рама хватит?

>Не проще ли скормить эту базу данных ключевых слов нейросетке?

Контекста не хватит.

>Или сделать подобие лоры

Точности не хватит, тут тебе не анусы рисовать, раз тебе понадобился RAG, то ты от него никуда не уйдёшь.

> гб врама

Вообще ни о чём. Для хоть какой-то лоры нужно 24, чем больше, тем лучше. С твоим железом только векторные базы данных.

> Только векторные базы данных

Ну грубо говоря, что мне и так предложили? Или есть тут какая то разница? И в чем будет разница между векторной базой данных и лорой. Как внутри оно будет? Простите, если слишком много вопросов.

> нужно 24

На гугл коллабе уже не сделать?

> сделать

Сделать, но для приличного ты ебанешься делать датасет, а потом только расстроишься что ничего не работает. RAG - прекрасное решение твоей проблемы, как и предложили, наилучшее по эффективности и минимальным трудозатратам.

Понял, ладно. Последний вопрос. Вот есть массив ключевых слов, и векторная база данных. Такая ли большая между ними разница будет? Что тут ключевые слова, что там?

Там еще писали,что векторные базы данных слишком нестабильные, и их придется постоянно файтюнить

>Что тут ключевые слова, что там?

В одном случае жёссткий список ключевых слов, в другом вектора, которые сравниваются по похожести. Второй находит инфу, даже если ни один ключевик не совпадает. В любом случае результат поиска по БД будет закинут в нейронку для написания ответа пользователю, так что даже если в инфу попадёт нерелевантная строчка, то нейронка поумнее её проигнорит.

>Там еще писали,что векторные базы данных слишком нестабильные, и их придется постоянно файтюнить

Нормально там всё. Нестабильность может быть на публичных серверах, где модели меняются, и старые наборы векторов надо пересоздавать с выходом новых версий.

Если делать всё локально, то никто ВНЕЗАПНО не будет менять нейронку, и всё будет работать стабильно без лишнего обслуживания.

Ну тогда буду пробовать вектора. Спасибо ещё раз.

Потестил коммандера 35б более основательно - было бы круто чтобы все модели в стоке также могли в понимание инструкций, отыгрыш и левдсы. Да, "база днаний" под рп довольно ограничена, однако стоит описать что-то в промте - оно будет очень четко придерживаться этого, причем не заметно чтобы оно перегружалось и теряло внимание. Ощущается будто модель все время четко понимает происходящее и как оно должно быть, нет шизы yi или рассеяности мелочи. Длинные взаимодействия - не проблема, будет плавно и закономерно развивать не ломаясь, слог хороший, гибко меняет стиль "речи" под персонажа и повествования под контекст. В качестве бонуса - регулярные отсылки к прошлым действиям, фразам и даже смехуечки вокруг этого.

Ну вот тридцатка лламы2.5 подъехала. Хотелось бы увидеть рп файнтюны которые бы ничего не сломали.

Стало вдвойне интереснее что там в большой версии, почти наверняка опередит франкенштейны мику.

Ну вот тридцатка лламы2.5 подъехала. Хотелось бы увидеть рп файнтюны которые бы ничего не сломали.

Стало вдвойне интереснее что там в большой версии, почти наверняка опередит франкенштейны мику.

Так, аноны. Раньше сидел на УгеБуге и silly tavern. Хочу вкатиться обратно, какие модели топ для 3060 ти? Есть ли какой-нибудь список по типу вот модели для кума, вот для днд и так далее?

Ух-ты моё творчество в шапке!

Я тут кстати проверил воздушный поток из этого короба, и оказалось что он не так уж плох видно по отклонению бумажки, пик 1 Не даром его хватает на запуск и генерацию в небольших текстовых моделях.

Но 70Вq2 модели греют Теслу до 80 градусов и нагрев на этом не останавливается, а значит для стабильной работы этого мало.

Настало время взяться за дело серьёзно! Если это не охладит Теслу, то я ХЗ что вобще её охладит!

Как обычно с коробом особых проблем не возникло, Со зборкой короба особых проблем не возникло, в этот раз не торопился и получилось чуть аккуратней.

Для 8 гигов? Хуй знает. У меня под твой размер ток опенчат есть, все остальное не поместится в 8 гигов.

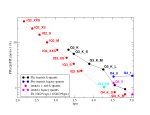

The LLM Creativity benchmark

https://www.reddit.com/r/LocalLLaMA/comments/1bcx6ze/the_llm_creativity_benchmark_20240312_update/

https://ayumi.m8geil.de/ayumi_bench_v3_results.html фильтр по ERP3 Score

Из вот этой спискоты мне понравилась Thorns для рп. Еще в оппосте Fimbulvetr-10.7B-v1.q8_0 висит, тоже неплохая.

Поток воздуха получился гораздо сильнее. Главный минус в том, что поток теперь неуправляем. Пока временно роешил это подключением плюса либо к контакту 5В, либо к 12В. На слабом напряжении потока зватает чтобы держать температуру 52 градуса в режиме простоя. На полной мощности держит 65 градусов в режиме непрерывной генерации на тяжёлой модели. Это уже можно назвать победой!

Заказал шим контроллер, чтобы всё работало чуть цивильнее https://www.ozon.ru/product/shim-kontroller-regulyator-skorosti-dvigatelya-dc4-5v-35v-5a-90-vt-12v-siniy-942810084/?asb=oqLwg9c9XQ5vbvTMN7JZbkNRu41c0mQbb0YHlrsXCvU%253D&asb2=yMSVn94q47e4h1KxOkFcuxc19krbWBKBWOuwe1ArGdkerzMBx0ORtwRG3Hs8IAnWIvTok24bSpv8mQxYdP9PJw&avtc=1&avte=2&avts=1712459725&keywords=%D1%88%D0%B8%D0%BC+%D0%BA%D0%BE%D0%BD%D1%82%D1%80%D0%BE%D0%BB%D0%BB%D0%B5%D1%80#section-description--offset-140

Но в идеале бы подключить контроль к ШИМ выводу на материнке, чтобы можно было привязать скорость к температуре. Надо почекать, может есть чипы, подходящие под это дело.

А в чём проблема нагрева? Ну греется до 80 градусов, ну пусть греется. Видюхи ведь могут до 100 градусов работать и не ломаться.

>Ну греется до 80 градусов, ну пусть греется. Видюхи ведь могут до 100 градусов работать и не ломаться.

В этом есть смысл. Я вчера решил что можно просто отключить обдув чтоб не шумел, раз карта всё равно не под нагрузкой. Так она в режиме простоя час простояла с температурой 81 и вроде ничего.

Но в документации к Тесле написано что её можно эксплуатировать при температуре не более 75 градусов.

https://images.nvidia.com/content/pdf/tesla/Tesla-P40-Product-Brief.pdf

А генерить я хочу много, жёстко и почти неприрывно. Хочется чтобы карта при этом гарантированно жила.

Чем меньше температура, тем дольше она у тебя жить будет. После маининга рынок наводнили видюхи. Вот только если сравнишь их и у среднего игрока, то разница заметна по плате. Отмывка не поможет.

>эксплуатировать при температуре не более 75 градусов

Хранить. Эксплуатировать

>Operating temperature 0 °C to 45 °C

>Operating temperature 0 °C to 45 °C

>Storage temperature -40 °C to 75 °C

Ищи погреб в доме, суй пека туда.

sos, нужна помощь, накатил по гайду кобольд, накатил интерфейс silly tavern, скачал 3 модели mistral-7b-instruct-v0.2.Q4_K_M, neural-chat-7b-v3-16k-f16, neural-chat-7b-v3-16k-f16 та что со ссылки, карточки беру с chub ai, но загвоздка в том, что ответ буквально на 1-2 в лучшем случае 3 предложение, крутил по всякому ползунки, разницы вообще нет, как фиксить?

toppy-m-7b.Q8_0 фикс, на всех одно и тоже

по-перших, 7b - говно, хули ты хотел? Во-вторых, настрой промпт

На одном только проце мужно идти гулять, прежде чем он тебе нагенерирует текст.

Поставь в настройках модели в Таверне профиль Кобольд, увеличь количество токенов на ответ.

>to 45 °C

Такая температура у неё в режиме простоя, в лучшем случае.

Кто-нибудь вообще встречал любое ПК железо, холоднее 45 лол?

https://huggingface.co/InferenceIllusionist/DarkForest-20B-v2.0-iMat-GGUF

норм модель для 12 гб + 16 озу?

норм модель для 12 гб + 16 озу?

Ну в серверах наверное её водянкой охлаждают, не?

У меня проц 9400F нагреть его до 50 градусов надо постараться. Но я не пожалел денег на воздушку.

Аноны. Вопрос юзую kobold cpp с моделью из шапки с 24 гб рам памятью с 3060 ти. И че-то он как-то слишком быстро генерит. Раньше я помню с одной только видюхой он долго думал.

>Кто-нибудь вообще встречал любое ПК железо, холоднее 45 лол?

Что думаешь, зря для серверного железа делают такие низкие частоты и тдп по сравнению с аналогичными десктопными продуктами? Чтобы штабильно работало годами. Это для простых юзеров разгоняют до упора, чтобы у них год гарантии отработало, а дальше похуй.

Вообще мистрали должны срать текстом как не в себя.

Скорее всего для него надо выбрать пресет пик 1, это на многое влияет.

Ещё обрати внимание на 2 верхних ползунка в окне пресетов, первый из них тоже может ограничивать ответ.

Ну и сам список пресетов потыкай, настройки тоже не хило влияют на генерацию.

> Вообще мистрали должны срать текстом как не в себя.

В этом и суть, из 7b, нужно вытягивать слова.

>Ищи погреб в доме, суй пека туда.

Не суй в пека серверное железо прост.

Просто у тебя в комнате должна быть температура до 27 градусов по стандарту ASHRAE.

Большое спасибо, буду пробовать

В этом мануале Operating temperature: 0 °C to 45 °C. Storage temperature: -40 °C to 75 °C. - это все температура помещения.

Посмотри что у тебя пишет # nvidia-smi -a -i 0

Temperature

GPU Current Temp : 27 C

GPU Shutdown Temp : 95 C

GPU Slowdown Temp : 92 C

То есть, она начнет троттлить при 92 и выключится при 95. Но, судя по моему майнерскому опыту, гонять карточки лучше не выше 75. Дальше идет износ и текстолит со временем чернеет.

Перевод нейросетью делают что ли. Ощущение как от официальных русификаторов времён нулевых, когда-

>Усилия для групп

Блять ясно, пойду выяснять как законтрибутить в перевод.

Это нормально, что в начале генерации у меня 3060 странные звуки издаёт, как будто кузнечик стрекочет?

Дроссели свистят, всё норм

Я не понял как попасть в продвинутые настройки, у меня какой-то обрубок в этом окне, и тем не менее, сначала у меня вообще перестал генерироваться текст, в итоге поставил модель со ссылки, ползунки не трогал, длина ответа стоит в 1024, размер контекста в 4096, предустановка профессиональный писатель (не знаю роляет ли она вообще) и шаблон контекста простой прокси для таверны, в итоге сейчас карточка дарк фентези выдала 4500 символов за раз, не выкупаю в чём фишка, но меня всё более чем теперь устравивает

Забыл дополнить, в консоли ответы просчитывались, но почему не выводились в silly tavern для меня загадка

Нет, конечно, в серверах воздушное охлаждение, никому игродаунские ненадёжные решения не нужны. Там ебический поток холодного воздуха

>выдала 4500 символов за раз, не выкупаю в чём фишка, но меня всё более чем теперь устравивает

Мистрали очень любят срать но не всегда в тему это для них норма. Что-то значит мешало.

У меня не расширенные настройки, вполне себе стандартные. Жми на букву А, справа от картинки розетки и меyяй шаблон контекста на Mistral, работать лучше начнёт.

Если будешь другие модели юзать, то с вероятностью 90% понадобится шаблон Alpaca.

Короб когда собирал новый проблем не возникло?

> может есть чипы, подходящие под это дело.

Есть приблуды, что втыкаются в один порт и берут питание с саты/молекса, и при этом размножают его на много 3-4х пиновых. Ищи где видно наличие преобразователя, просто в 3пиновый воткнешь и будет штатно регулироваться.

> Видюхи ведь могут до 100 градусов работать и не ломаться

На 90 с чем-то там будет сигнал аварийного отключения.

В настройках семплинга поставь галочку ban eos token и дивись нескончаемой шизофазии семерок. Но вообще скорее всего у тебя что-то с инстракт режимом не то. Делай как описал только шаблон выбирай не мистраль а ролплей, с ним как ни странно оно лучше работает.

https://arxiv.org/abs/2402.05120

На заборе пишут, что чем больше нигг в дереве большого нигги, тем лучше, и это мол общая тема для трансформеров. (может это как-то в архитектуре формализовать можно?)

На заборе пишут, что чем больше нигг в дереве большого нигги, тем лучше, и это мол общая тема для трансформеров. (может это как-то в архитектуре формализовать можно?)

А вот и специализированные ускорители генеративного ии

https://servernews.ru/1102872

"Как отмечает Hailo, новинка обеспечивает ИИ-производительность до 40 TOPS. Типовое энергопотребление составляет менее 3,5 Вт. Утверждается, что ИИ-модуль поддерживает нагрузки, связанные с инференсом, в режиме реального времени. Например, при работе с большой языковой моделью Llama2-7B достигается скорость до 10 токенов в секунду (TPS). При использовании Stable Diffusion 2.1 возможна генерация одного изображения на основе текста менее чем за 5 с."

https://servernews.ru/1102872

"Как отмечает Hailo, новинка обеспечивает ИИ-производительность до 40 TOPS. Типовое энергопотребление составляет менее 3,5 Вт. Утверждается, что ИИ-модуль поддерживает нагрузки, связанные с инференсом, в режиме реального времени. Например, при работе с большой языковой моделью Llama2-7B достигается скорость до 10 токенов в секунду (TPS). При использовании Stable Diffusion 2.1 возможна генерация одного изображения на основе текста менее чем за 5 с."

Аноны, беру ollama в качестве бэкэнда SillyTavern, и эта пидарасина срёт токенами как из ведра, не может остановиться. С кобольдом такой хуйни не было. В ollama можно вообще задать максимальное количество токенов на ответ? На соответствующую настройку в таверне не реагирует. а она вообще принимает какие-либо настройки-то? У них даже документации по ходу нету блеат, даже описания что это такое нет

Оллама говно говна, расхайпенное церезмерно в анг комьюнити

Поэтому они и говноеды, нет у них нормальных инструментов запуска, мало знают об альтернативах

Да бля, если бы кобальд имел 50к звезд, я бы понял

Но это поделие только на 1-2к тянет

https://www.reddit.com/r/LocalLLaMA/comments/1bxnyym/107b_mistral_based_model/

Новая базовая модель 11b, созданная вроде по технологии солар, тоесть это новый мистраль которому добавили слоев и дообучили, контекст 32к

Новая базовая модель 11b, созданная вроде по технологии солар, тоесть это новый мистраль которому добавили слоев и дообучили, контекст 32к

>Раньше я помню с одной только видюхой он долго думал.

Раньше это когда и с какой моделью? В шапке несколько так-то. А вообще, скорее всего раньше у тебя была подкачка из врам в рам, а теперь, с разгрузкой части слоёв, ВК работает на полную скорость.

У меня 3080Ti издаёт непотребные звуки только на 7B, лол. Всё что выше имеет другой профиль нагрузки, и звуков нет.

Но в РП вроде мое не впечатляют. Это заговор против кума?

> а она вообще принимает какие-либо настройки-то?

И таверны? Сильно вряд ли.

>У них даже документации по ходу нету блеат,

https://github.com/ollama/ollama/blob/main/docs/api.md Не оно?

Ждём РП тюнов.

>проблем не возникло?

Тут конструкция проще, так что было даже легче, да и в целом герметичнее вышло.

Но вот шум как в самолёте.

>просто в 3пиновый воткнешь и будет штатно регулироваться.

3-пина нужны только чтобы скорость оборотов знать. По сути, если можно подрубить питание 2-пинового к регулятору, а сам регулятор к 4 пину на разъёме, то всё должно и так регулироваться.

Просто у мой 2-пиновый даёт поток в 4м2 в минуту, и этого впритык хватает, а 3-4 пиновых с такой мощьностью я не видел.

Была мысль поставить кулеры от видеокарты в новый короб друг за другом в виде турбины, но ебатни много, а толк не факт что будет.

>Например, при работе с большой языковой моделью Llama2-7B достигается скорость до 10 токенов в секунду (TPS).

Сначала прочитал "Llama2-70B" и испытал смешанные чувства, поскольку уже потратил на домашний нейроускоритель много денег. Потом прочитал правильно.

Там всего 8гб памяти, так что это для 4 кванта скорей всего 7b

Но и потребление всего 3.5 ватта, так что если они выпустят такой же модуль хотя бы с 16гб памяти - будет веселее

Но для этого им придется нарастить производительность чипа, ну или скорость памяти. Что бы это могло ворочать сетки покрупнее с нормальной скоростью

Уже куча таких новостей была, и ничего ровным счётом не поменялось. Ничего доступного для простого Ивана/Джона/Сяоляо как не было, так и нет.

Стартап бы какой-нибудь запилили Джоны на кикстартере что ли? Чего сидят? Ждут пока технологии устаканятся?

>Чего сидят?

Бабло есть, трава закупается. Чего шевелиться, бро?

Казалось оно лежит на поверхности и подобное много где используется, тут по сути обобщили и измерили.

> может это как-то в архитектуре формализовать можно

Хз, это ведь про сам интерфиренс.

> до 40 TOPS

Это ведь уровень ниже P40. Хочется производительных решений а не аналогов самых младших эмбедов от хуанга.

Скорее всего оно не умеет в стоп токен и кастомные стоп фразы. Видимо, полноценный апи там отсутствует а имеющееся для галочки, ожидаемо.

Это не про мое. И в рп ты даже сейчас может получить буст, если накодишь себе простой скрипт, который будет работать в виде "гейммастера" и тщательнее готовить промт для "персонажа", или просто мультизапрос сначала по мыслям-раздумьям чара, оценки происходящегт и т.д., а потом уже по формированию красивого ответа и действий на основе этого. Если еще правильными префиллами обмазать и промт подобрать - даже на мелочи можно сильно бустануть перфоманс.

То рофл за повторяющуюся фразу. 3 пин имеется ввиду что та штука будет обеспечивать регулировку по питанию, плюс имеет мощный выход. 3й пин тахометра подключать не нужно.

>И таверны? Сильно вряд ли.

Ну да. Ставлю любое значение, результат один - останавливается когда захочет.

qwen32b хороша?

А можно как-нибудь сделать франкенштейна из невидии и амд? Ну или хотя бы, одну на генерацию изображений, а другую под ИИ?

В разных сетях юзать - без проблем, хоть интел добавляй. Юзать совместно для одной ллм - не, может быть сработает с вулканом но перфоманс будет донный.

>qwen

Хуйня

>карточки беру

Карточки для слабоумных.

>4м2

Я надеюсь, кубических, а не квадратных? 4 m3 это 2.35 CFM, что является невероятно низким значением.

>3-пина нужны только чтобы скорость оборотов знать.

Только вот контроллер смотрит - нет третьего пина, нет тахометра. И ебошит стабильно на полную.

> 4 m3 это 2.35 CFM, что является невероятно низким значением.

Кубический фут в минуту (CFM, англ. Cubic Feet per Minute) — неметрическая единица, используемая обычно для измерений объёмных расходов жидкостей и газов. Равна 0,028316846592 м³/мин = 0,0004719474432 м³/с. 1 м³/мин = 35,3147 кубическим футам/м.

4м3/мин = 141,2588 CFM

Гигачады с гигантскими (70b) моделями, насколько они уступают бингу?

Что с ней не так?

На кулерах обычно если пишут в футах, то в минуту, если в метрах - то в час. И 140 cfm это примерно втрое больше, чем нужно для охлаждения p40 на 100% загрузке нонстоп.

У меня джва Sanyo Denki San Ace 40 9GV0412J301, с 40.8m³/h или 24.01cfm. В сумме 48 cfm на макс оборотах, но я их кручу до 10к из 15 и хватает за глаза.

>Гигачады с гигантскими (70b) моделями, насколько они уступают бингу?

Попроси у Бинга сказать слово "хуй" :)

А так уступают, конечно.

>и хватает за глаза

И за уши?

Модель имхо отличная для кума. В отличие от фроствайнда и прочих, не пишет километровые абзацы с художественными описаниями происходящего, а идёт сразу непосредственно в диалоги, инициативу двигать сюжет и внутренние размышления (может кому-то наоборот такое не заходит, но мне зашло). Заметил, что очень любит отыгрывать персонажа от первого лица, даже если изначально карточка настроена на She/her а не на I/me.

При желании ты мог бы и в врам полностью попробовать уместить c IQ3, контекст там 4096 много не займёт.

Ещё бы порекомендовал NousHermes-Solar-10.7b, довольно похож но размером поменьше.

>И за уши?

Подальше отсел и нормально. До 5к оборотов вообще не слышно, если посадить теслу на голодный паёк около 70% tdp, то выше 8к вентиля не крутятся, не громко в целом. На максимальных оборотах около 70 дебицел показывает шумометр в телефоне, хотя по паспорту 54 потолок. Если общаться с нейросетью, то максимальных оборотов не услышишь. В SD да, но тесла для SD невероятно медленная, я чисто попробовал как оно, лол.

>На кулерах обычно если пишут

Пик.

>В сумме 48 cfm

>и хватает за глаза.

Значит не слишком грузишь.

>Пик.

А где там точка? После двойки? Нихера не видно. Если тебе не хватает 140cfm, то наклейка пиздит в три-четыре раза.

>не слишком грузишь.

Ну вот SD, TDP на 100%. Если крутить вентиля по фуллу, то выше 60 градусов хуй оно поднимется. Сначала стояло управление по дефолту, температура медленно росла, т.к я настроил на кручение в лайтовом режиме, чтобы не громко. Потом включил 100% обороты и тесла быстро остыла. И это втрое меньше твоих "140 cfm". Тебя наебали.

>А где там точка? После двойки?

Какая точка лол? 254 м3/ч / 60 = 4,08м3/мин. Она на деле пиздец мощная, поток воздуха заметно сильнее, чем от кулеров видеокарты, по ощущениям раза в 3.

Возможно такой поток и избыточен для охлада Тесла, но снизить я его не могу, а кулеры видеокарты оказались слабоваты для моих целей.

>наклейка пиздит в три-четыре раза

Конечно, убеждай себя.

Запусти это https://github.com/lllyasviel/Fooocus на пол часа непрерывной генерации. Если выше 60 градусов не поднимется, считай что ты подебил, у меня выше 65 не поднимается. Сегодня часа 4 генерил потоком.

Аноны, подскажите пожалуйста, мне кажется не хватает очков интелекта даже чтобы нормально следовать гайду для ретардов. Пытаюсь научиться пользоваться кобальдом, но пока не очень понимаю

> Гайд для ретардов для запуска LLaMA без излишней ебли под Windows. Грузит всё в процессор, поэтому ёба карта не нужна, запаситесь оперативкой и подкачкой:

> 1. Скачиваем koboldcpp.exe https://github.com/LostRuins/koboldcpp/releases/ последней версии.

Сделано

> 2. Скачиваем модель в gguf формате. Например вот эту:

https://huggingface.co/Sao10K/Fimbulvetr-10.7B-v1-GGUF/blob/main/Fimbulvetr-10.7B-v1.q5_K_M.gguf

Можно просто вбить в huggingace в поиске "gguf" и скачать любую, охуеть, да? Главное, скачай файл с расширением .gguf, а не какой-нибудь .pt

Сделано, скачал ту что из примера

> 3. Запускаем koboldcpp.exe и выбираем скачанную модель.

Где именно? Я на первой странице в "quick launch" в графу "model" вставляю то что скачал во втором пункте. Потом нажимаю зеленую кнопку "launch". После этого Кобальд просто вырубается

Что я делаю не так?

> Гайд для ретардов для запуска LLaMA без излишней ебли под Windows. Грузит всё в процессор, поэтому ёба карта не нужна, запаситесь оперативкой и подкачкой:

> 1. Скачиваем koboldcpp.exe https://github.com/LostRuins/koboldcpp/releases/ последней версии.

Сделано

> 2. Скачиваем модель в gguf формате. Например вот эту:

https://huggingface.co/Sao10K/Fimbulvetr-10.7B-v1-GGUF/blob/main/Fimbulvetr-10.7B-v1.q5_K_M.gguf

Можно просто вбить в huggingace в поиске "gguf" и скачать любую, охуеть, да? Главное, скачай файл с расширением .gguf, а не какой-нибудь .pt

Сделано, скачал ту что из примера

> 3. Запускаем koboldcpp.exe и выбираем скачанную модель.

Где именно? Я на первой странице в "quick launch" в графу "model" вставляю то что скачал во втором пункте. Потом нажимаю зеленую кнопку "launch". После этого Кобальд просто вырубается

Что я делаю не так?

> Что я делаю не так?

Не даешь входных данных о своей системе.

Запусти его из командной строки, есть шанс что там останется ошибка из-за которой он вырубается.

> Запусти его из командной строки, есть шанс что там останется ошибка из-за которой он вырубается.

Запустил из командной, ситуация просто посторилась. Гружу скачанную модель в "model", жму зеленую кнопку "launch", кобальд закрывается.

> Не даешь входных данных о своей системе.

Об операционной всмысле? 10я винда, 64разрядная

Я просто пока совсем не разобрался в теме и еще не знаю какая информация считается важной и что нужно писать

По первому - перечитай еще раз. По второму речь о твоем железе.

Можешь попробовать успеть тыкнуть скриншот пока командная строка не успела закрыться, там на 1 секунду вроде оно останавливается перед закрытием

Ну и кинь его сюда, или сам читай че тебе там пишет

запустить из командной строки: в проводнике в папке с кобольдом пишешь в адресную строку: cmd (там где путь директории), жмешь enter, открывается командная строка, пишешь koboldcpp.exe, открывается кобольд, далее проделываешь то же самое, теперь окно консоли не закроется с ошибкой.

> По первому - перечитай еще раз.

Я пытаюсь, просто понимания больше не становится, мое понимание компухтера оставляет желать лучшего

> По второму речь о твоем железе.

Видеокарта - Нвидиа 1070 ti

Процессор - Intel(R)_Core(TM)_i5-8600_CPU_@_3.10GH

Речь об этом или нужна что-нибудь еще? Я правда не нарочно тупой и пытаюсь сделать так чтобы это работало

Посмотри нет ли каких-либо сообщений и текстов в консоли после того как кобольд вылетает.

> Нвидиа 1070 ti

Это прежде всего нужно. Возможно, требуется скачать релиз под более старую куду, тут пусть эксперты кобольда подскажут. Заодно сделай скриншот настроек и режимов с какими запускаешь, cublas надеюсь выбран?

Кубический аршин в лунный месяц, блять. Тьху.

Ну и чего в нём такого? Банальный мак будет потреблять не сильно больше в пересчёте на скорость и объём.

Спасибо большое, аноны.

> Можешь попробовать успеть тыкнуть скриншот пока командная строка не успела закрыться, там на 1 секунду вроде оно останавливается перед закрытием

> Ну и кинь его сюда, или сам читай че тебе там пишет

Вот это помогло, понял где проебался, в пути файла была кирилца.

Теперь все кажется работает, зашел на http://localhost:5001/, скачал карточку с чархаба, запустил, работает.Это нормально что она весит всего 15кб?

Подтормаживает правда нормлаьно так, предположу что дело в моем железе. Память сразу загрузилась на 70 процентов.

А та штука, модель в gguf формате, от нее многое зависит? Ньюфагу стоит начать сразу в это лезть, или просто юзать ту что предложили в оп-посте и не ебать мозг?

Какими переводчиками пользуетесь? Дипл выглядит самым умным, но обрабатывает ограниченное количество символов и перестает работать если пользоваться им слишком долго

Неофиту стоит знать что-то еще?

> Заодно сделай скриншот настроек и режимов с какими запускаешь, cublas надеюсь выбран?

Речь вот об этом? На всякий случай все равно прилагаю скирны, соре что шакальные

Сидеть в самом кобальде хоть и проще но там не так качественно отвечает, и перевода встроенного нету

Лучше таверну еще поставь, просто скачиваешь ее и тыкаешь батник на запуск

Там уже ищешь кобальд во вкладке подключений и тыкаешь его

Карточку там открывай

fancontrol

А таверна сразу переводит и то что пишет бот и то что ты ему пишешь? И переводчик хороший?

Наверное рано или поздно таверну действительно стоит скачать, но я как видишь и с кобольдом не сразу разобрался

Чем еще таверна отличается от кобольда?

Аноны, взял 1 p100.

На них надо как-то по особому Дрова ставить или просто качай и накатывай.

К 3080ти в дуплекс. Решил брать вместо Р40.

Не бейте, лучше обосцыте.

На них надо как-то по особому Дрова ставить или просто качай и накатывай.

К 3080ти в дуплекс. Решил брать вместо Р40.

Не бейте, лучше обосцыте.

Скажите скачал файл koboldcpp, положил его в нужную директорию, запускаю его, гружу модель нажимаю Луанч. Все запускается и работает. А где он на диске развертывается, в самой директории где я его запуска ничего кроме файла koboldcpp?

>Подтормаживает правда нормлаьно так

Тормознутость будет ещё существенно зависеть от размера модели, контекста и скинутых на видяху слоёв. У меня обычная 1070 восьми гиговая, и 11б q5_k_m gguf модели (т.е. как раз такие, как в шапке) запускаю с 6144 контекста с 39-ю слоями на видяху. Такой расклад показался оптимальным. Если ставишь меньше контекст или используешь модель меньшего размера, то можно больше слоёв выгрузить для ускорения. По опыту, лучше не забивать видеопамять вплотную, потому что тогда контекст по каким-то причинам начинает еле-еле обрабатываться.

С моделью можешь и этой из шапки поиграться, но я советовал бы попробовать вторую версию фимбульветра. Файлы есть на странице автора https://huggingface.co/Sao10K/Fimbulvetr-11B-v2-GGUF

или с матрицей важности (делает маленькие кванты лучше) от другого чела https://huggingface.co/mradermacher/Fimbulvetr-11B-v2-i1-GGUF

>Конечно, убеждай себя.

Да мне не нужно себя убеждать, физику же не наебёшь. Вентиль на 140cfm это 1.5-2А и 5к RPM. А вентилятор на 0.82А это максимум 50 cfm и 2к RPM. То, что наклейка пиздит, даже сомнению подвергаться не может.

>у меня выше 65 не поднимается. Сегодня часа 4 генерил потоком.

Так ты определись, "хватает впритык" или "держит 65 градусов". Так-то 65 градусов это не впритык, это норм. Хотспот и память будут на 10 градусов выше, но 75 градусов это терпимо.

>Fooocus

У него хуйня какая-то с качеством, скачивал, снёс к хуям. Автоматик лучше. Но я гонял трейн на 8к оборотах 4 суток и была температура 65 градусов, при учете соседства с карточкой, которая тоже грелась, как подмышка сатаны даже на 60% поверлимите.

> 6144 контекста с 39-ю слоями на видяху.

И сколько ждешь ответа? У меня 3070ti и с 36 слоев кидаю в 4к и жду ~20-30 секунд. Больше уже минуту, мне это уже дохуя.

Сколько нужно минимально видеопамяти, чтобы вкатиться и делать лоры для своих моделей? У меня сечас 8 врам + 32 рам.

>А таверна сразу переводит и то что пишет бот и то что ты ему пишешь? И переводчик хороший?

Переводит в обе стороны. Ну или в ту, в какую настроишь. Переводчик так себе. Мало того, что часто возвращает какие-то спецсимволы в ответе вместо нормальных букв, так ещё и в принципе сделан на отъебись. Но жить можно.

>На них надо как-то по особому Дрова ставить или просто качай и накатывай.

А х.знает, ты походу тут такой один. Но если даже на P40 особых проблем нет, то с картой новее может быть ещё проще. А может не быть.

>К 3080ти в дуплекс. Решил брать вместо Р40.

Изменил ггуфу с exl2? Может оно и правильно.

Ну, вообще да.

У меня в простое теслы 35 градусов, и это, на мой взгляд, жарко.

P104-100 зимой в простое была 19°, сейчас 22°. Ну, то есть, буквально комнатной температуры.

Игровой комп тоже в среднем 35-45.

Так что, и правда норм температуры.

mistralпацаны... это конец...

Я чет вррьше ГУФФ не прочувсиврвал.

Перешел на GPTQ.

Сейчас вот мику качаю 70б 3bpw.

Но чую что в итоге на 34б файнтьюниной буду

Чтобы не брать из головы цифры, сейчас проверил в одном из чатов - 43.5с обработка 5512 контекста и 5.4 т/с скорость генерации. Я проверял с continue, так что там всего 59 токенов сгенерилось, суммарно вышло 54.5с. Ну т.е. на полном контексте и с ответом токенов на 400 где-то полторы-две минуты. Не очень приятно, но терпимо. Плюс если контекст не переобрабатывается, то будет практически только генерация со скоростью выше скорости чтения.

> 254 м3/ч

Это производительность приличного вытяжного вентилятора, подобная мелочь с 8вт потребления не выдаст столько.

> Но я гонял трейн на 8к оборотах 4 суток

Тренил что-то на тесле? Как успехи и перфоманс?

Неистово проиграл

Спасибо, анон, я пока понимаю не все слова, но внес это в заметки

Посоветуйте бесчеловечную и плодотворную модель

Для слабо могущих в английский.

>Operating temperature: 0 °C to 45 °C

"Рабочая температура". Диапазон температур окружающего воздуха, к нагреву каких-либо компонентов во время работы никак не относится.

>Storage temperature: -40 °C to 75 °C

Диапазон температур для хранения устройства в полностью отключённом виде.

7b как всегда в топе.

Как вы там без пропт формата дрочите? Модель же тупеет.

Ну да, пусть в комнате будет 20 градусов, а картонка кипятится до ста градусов, поебать вообще.

Для всех температур окружающего воздуха есть отдельные спецификации. Сама нвидия рекомендует придерживаться стандартов ASHRAE, то есть для самых уёбищных ДЦ это 40 градусов температуры потолок, про температуру в 45 градусов и речи быть не может. Выше - гроб-гроб-кладбище-отвал чипов. Так что температура 45 градусов Цельсия это конкретно про нагрев картонки. Причём p40 - старая картонка, и раньше стандарт был ещё жёстче, в А класс попадали только при температурах до 24 градусов.

24.

Для 7b примерно от 12гб врам, под 13b - 24гб врам. Для 70b на минималках 48гб врам, обучать можно, но с ограничениями.

>Да мне не нужно себя убеждать

Я уже понял.

>Так ты определись, "хватает впритык" или "держит 65 градусов"

Я бы хотел холоднее за такой шум, если уменьшить обороты скорее всего будет теплее, поэтому "впритык".

>Автоматик лучше

Автоматик не так греет Теслу, особенно если модель не SD, поэтому для тестов я использовал фокус. Кроме того у него настройки залочены, что делает его неплохим бенчмарком.

>Но я гонял трейн

А вот что ты за трейн гонял ХЗ, и воспроизводить этот процесс для точного сравнения заебёшься, поэтому я и предложил фокус.

>Это производительность приличного вытяжного вентилятора

Это и есть вытяжной вентилятор от УФ станка. Когда-то неплохо так помогал не задохнуться.

>если модель не SD

Те есть не XL

>Тренил что-то на тесле? Как успехи и перфоманс?

Я уже думал заебал всех своими рассказами про трейн, лол. Да в целом отлично. Перформанс приятно удивил на самом деле. Только памяти мало, влезает лора для 7b, но не больше. Штуки три бы, чтобы модели покрупнее ебать.

>Я бы хотел холоднее за такой шум

Радоваться надо, что твоя паль хоть так охлаждает. Смотри какая хуйня, в серверы 1U ставится 7 штук вентилей типа такого

https://store.supermicro.com/us_en/40mm-fan-0101l4.html

Считаем, 27.5 CFM на 7, итого 192,5 CFM. Этого хватает, чтобы охладить три теслы, два CPU и память. На питальник уже отдельный охлад. Делим 192 на 3, хотя никаких уплотняющих переходников нет, но будем считать, что весь поток пиздует в теслы. Итого, 64 cfm на карту. Можно ебануть, конечно, вентиля на 20к RPM и получить целых 77 cfm на карту.

>А вот что ты за трейн гонял ХЗ

Трейн, кстати, сильнее ебёт, чем SD, возможно из-за того, что вся память забита в хлам. Я же специально прикладываю скрины с температурой и энергопотреблением, чтобы чётко видно было, что карта хуярит.

Ты не понял, речь про пикрел-подобные.

> Перформанс приятно удивил на самом деле.

Так сколько? И через что тренил.

https://huggingface.co/TheDrummer/Moistral-11B-v2?not-for-all-audiences=true

О ебать, новая кум сетка на основе Fimbulvetr

О ебать, новая кум сетка на основе Fimbulvetr

Насколько уместно трястись за чипы памяти на 3090 из-за спайков температуры? В локалках же нагрузка постоянно прыгает от 0 до 100% и потом обратно, и температура тоже, соответственно, скачет резко и часто. Насколько сильно это способствует отвалу или ещё какой-нибудь проблеме? Слыхал, что 3090 сдают частенько в сервисы как раз из-за проблем с чипами памяти.

хз чем она тебе понравилась, неделю назад потыкал модель. При трейне такой дефект называют переобучение, Спроси у нее что угодно а в ответ она заговорит о ебле. Короче предельная степень анцезор модели которая ничего не знает ни о чем кроме гениталий и любой разговор сведет к совокуплению через пару предложений. Но своих почитателей видимо имеет судя по закачкам. Из этой серии у него есть поумней модели.

кто нибудь уже тестил Command R Plus для рп в таверне? какие настройки нужны для него?

Дак это именно кум модель, не общая сетка

Думаю в своей роли она хороша, лучше 7b

Никто не сталкивался с ошибкой алокации памяти второй видеокарты?

torch.cuda.OutOfMemoryError: CUDA out of memory. Tried to allocate 320.00 MiB. GPU 0 has a total capacty of 12.00 GiB of which 0 bytes is free. Of the allocated memory 11.16 GiB is allocated by PyTorch, and 112.40 MiB is reserved by PyTorch but unallocated. If reserved but unallocated memory is large try setting max_split_size_mb to avoid fragmentation. See documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONF

torch.cuda.OutOfMemoryError: CUDA out of memory. Tried to allocate 320.00 MiB. GPU 0 has a total capacty of 12.00 GiB of which 0 bytes is free. Of the allocated memory 11.16 GiB is allocated by PyTorch, and 112.40 MiB is reserved by PyTorch but unallocated. If reserved but unallocated memory is large try setting max_split_size_mb to avoid fragmentation. See documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONF

Через что грузишь?

ExLlamav2_HF

P100 Tesla.

В диспетчере устройств ошибок по карте нет.

Пробовал прописывать кол-во памяти в gpu-split, Force flash-attention to not be used вкл или выкл.

Чет не особо помогло.

>второй видеокарты

Но ведь

>GPU 0

Это первая карта. Уменьши число слоёв на первой карте, а то там контекст ещё лежит.

Вижу как наполняется память первой карты, только начинает наполнение второй(p100) и ошибка аллокации.

С первой проблем нет.

А где в угабуге можно уменьшить число слоев при загрузке? Я только в кобальте знаю.

>Это первая карта. Уменьши число слоёв на первой карте, а то там контекст ещё лежит.

У меня такое впечатление, что с rowsplit это работает по-другому: на первой карте выделяется буфер под контекстное окно, а идёт всё остальное. На скорости генерации полное заполнение памяти первой карты не сказывается.

И ещё вопрос, какой ГПУ система считает нулевым? Тот, который был прописан первым при установке первого драйвера? Тот, который установлен в первый слот материнки? Тот, который выводит графику?

какой сейчас лучше мистраль или что то другое?

Нет смысла трястись о том, с чем ты ничего не можешь поделать. Способствует офк, каждый цикл нагрева-охлаждения приводит к росту дефектов в припое. Но присуще это больше чипу и месту пайки кристалла к подложке, а не большим шарам что крепят детали на текстолит. Ресурс в современных большой, забей.

35б в рп пресете с минимальными правками - хорош. Большую наконец квантанули, может вечером потестирую.

Не коммандр случаем? Там был поломанный коммит который сгружал все на одну карточку вместо сплита, обнови. Но в целом на первую карту ложится контекст, и это немало, уменьши значение для нее, а вторую можешь полную память указать.

> Force flash-attention to not be used вкл или выкл.

Если выключишь - начнет жрать больше, не стоит.

> P100 Tesla.

Как она по перфомансу в нейронках?

> И ещё вопрос, какой ГПУ система считает нулевым?

nvidia-smi даст ответ на твой вопрос

ГПУ0 это точно первая карта тк 12 гб.

Вторую он почему-то не видит как я понял.

А у кого тут стоит P40, у вас в диспетчере задач они отображаются?

У меня Теслу не видно в нем, как и в том же бублике.

Но тесты в той же Аиде Тесла проходит без проблем.

понятно, что лучше чем 7б, но в своей роли она будет похожа на шизоида в палате с мягкими стенами который беспрерывно мастурбирует и чего-то бессвязное бормочет. Посмотри лучше у него версию 2.1б или еще чего не настолько переобученное, если уж так нужна подобная модель.

Не, не командр.

Любые модели которые не влезают в 12 гб а начинают раскидывать за пределы первой.

nvidia-smi чет от открывает командную строку, создает таблицу а что там написано не успеваю прочитать. Сразу закрывает. И под админом и так.

По производительности пока хз.

Попробую дрова другие поставить, может что будет.

> Любые модели

Какие настройки gpu-split выставляешь?

> не успеваю прочитать

Открываешь командную строку или павершелл, пишешь туда nvidia-smi и спокойно не смеша смотришь что написало.

Выходит 12-гиговая p100 еще? Замерь ее в чем-то что может катать и в диффузии если есть возможность.

Спс за инфо про nvidia-smi.

Вообще до этого выставлял в gpu-split- 11,15. Потом 10 и 12.

И только с 7,7 стала работать.

Так и не понял почему.

Хотя написано "Comma-separated list of VRAM (in GB) to use per GPU. Example: 20,7,7".

Ну я и ставил значиние видеопамяти.

На скрине я загрузил 13б модель GPTQ. И она сука загрузилась. То есть с дровами видимо всё ок и надо понять про gpu-split

>nvidia-smi даст ответ на твой вопрос

Она-то даёт, и с её точки зрения GPU0 - это игровая карта, с которой изображение выводится на дисплей. А вот у Кобольда другое мнение, и для него это GPU2. Я ведь не просто так спрашиваю :)

С теслами дела не имел, на rtx gpu-split работает именно так как описано, за исключением того что на первую видеокарту также приходится и контекст, для нее нужно выставлять на гиг-два-четыре-... меньше чем на вторую и далее.

Тесла значит 16-гиговая, ну хоть так. Сколько вышла? Алсо попробуй запустить модельку только на ней через exllama и llamacpp, добавив в батник

> set CUDA_VISIBLE_DEVICES=1

заставишь софт видеть только ее и загружать туда соответственно, и расскажи что по перфомансу. Офк гпу-сплит и прочие опции деления перестанут работать, вроде очевидно но на всякий случай предупреждаю.

Алсо там автор exllama устал от нытья и возможно скоро запилит оптимизации под 32битные вычисления в теслах.

При этом игровая карта у меня в третьем слоте. При этом ставил я сначала тесловские драйвера, а потом studio без чистой установки. Такой вот ребус.

Да не может быть такого, у в куде нумерация идентична тому что в smi. Что там у тебя в кобольде пишет - хуй знает, возможно упростили для хлебушков все поломав.

И нумерация зависит не от дисплея и игровости по по порядку адресации портов, насколько помню.

Возможно манипуляции с дровами и разнородность карт как-то повлияли на это.

>для нее нужно выставлять на гиг-два-четыре-... меньше чем на вторую и далее.

C rowsplit это не работает, по крайней мере в Кобольде. Вообще без --tensor-split модель загружаю, память первой карты полна, на второй есть место. Скорость даже выше, чем если с помощью --tensor-split разделять память вручную. Видимо по строкам там совсем другая схема, чем по слоям.

22к за теслу.

У меня Угабуга+СилиТаверн.

Это видимо другой анон с Кобольтом.

llamacpp вроде не пашет на П100 из-за версии Куда.

Речь об exllama, там просто распоряжаешься гигабайтами без учета кэшей и прочего.

> память первой карты полна, на второй есть место

Это печально, ведь мог бы загружать квант пожирнее или контекст побольше.

Что то не так опять, наверно снова с коммандером - угагуба откатился: Downgrade llama-cpp-python to 0.2.56

Вроде как в WDDM отображается, а в TCC чи как там — нет.

Я не переводил в WDDM, поэтому у меня не отображаются.

Так ты открывай командную строку, а там вводи nvidia-smi =)

Очевидно, потому что контекст занимает дофига.

У меня на две теслы соотношение 17,23 обычно.

У меня вроде как работает… Роусплит и тензор сплит, чи как там.

Аха, утром приметил. =(

Видимо анон сверху верно сказал про gpu-split.

Эта залупа ответственна за Out of memory.

Но вот как она накидывает контекст или что там, в ГПУ0 я вообще хз.

Стала грузить уже модели больше 13Б с высоким квантованиеи и 8к токенов.

При этом если указано в gpu-split например 6,11- то в ГПУ она наваливает аж 10+ гб.

Ну хоть не в КУДА запара или в карте. Скорость кстати приятная. Попозже цифры закину.

Держу в курсе.

У тебя теслы отображаются в диспетчере задач, типа как обычная видюха.

>При этом если указано в gpu-split например 6,11- то в ГПУ она наваливает аж 10+ гб.

Я и говорю - что-то где-то перепутано в этих Кудах, где-то GPU0 это одно, а где-то другое :)

>У меня вроде как работает… Роусплит и тензор сплит, чи как там.

Оно работает в смысле что делит память. Но я к тому, что смысла в тензор сплит в этом режиме нет - на скорость это не влияет. Может быть если одна карта быстрее, а другая медленнее, то будет влиять как-то. А может и нет, может в rowsplit все карты по самой медленной работают - есть такое подозрение.

Там не перепутано, всё норм.

Тут ситуация именно с контекстом, который занимает существенное место на первой карте.

Всё через llamaFactory. "Сколько" вопрос странный, там же хералион переменных и каждая влияет на скорость.

Спайки не страшно, но бэкплейт лучше охлаждать, там чипы страдают. Если у тебя FE то тебе пизда.

Повторюсь: нет.

Тензор сплит и не влияет на скорость. Оно влияет на заполняемость, чтобы контекст поместить.

А роусплит как раз влияет. Без него на 50% ниже скорость.

Скоро экслама будет работать с P40?

Никогда, а что?

>заставишь софт видеть только ее и загружать туда соответственно

А можно так сделать с другими приложениями, с играми там например? Интересно поглядеть производительность.

2 такие штуки по бокам смогут п40 охладить или слабые слишком?

https://ozon.ru/t/39Nl02r

https://ozon.ru/t/39Nl02r

В настройках шинды, но для этого карта должна отображаться в диспетчере задач и всё такое.

Температура на входе: 22°

Температура в простое с загруженной моделью: 29°

Температура в недолгом инференсе: 45°

Температура в прогреве: 68° + 64°

Потребление: 150 Вт + 150 Вт.

Это кулеры 25 мм толщиной 0,26А для двух тесла.

0,3А, вероятно, охладят градуса на 3 сильнее.

Буду менять, потому что хочу больший охлад.

Однако, если просто задавать вопросики время от времени, то она не перешагивает 45° порог.

А, ну и это ЛЛМ.

Если стабла — то там уже… Скорее нет, чем да.

кто пользовался AnythingLLM? С документами как работает, если загружу их туда? Я имею ввиду приложение, которое устанавливаешь.

Да, не дружит с кобальдом

Дальше я не ушел, лол

А декстопная версия? Ему можно загрузить файлы и разговаривать? или декстопная версия кал, а то я вижу как всегда пишут про другие проекты типа твоего кобальда.

Вот десктопную виндовс версию я и пытался завести.

Кобальд не ест, llama.cpp тоже, как и угабугу

Только богомерзкую олламу, лмстудио и локалаи

Ну и онлайн сервисы

Встроенная там оллама у меня не качала, прерывалась на пол пути

Инет ей мой медленный не нравился что ли

Короче пока что забил на это, но теоретически должна быть полезная штука, особенно с каким нибудь апи клода или гпт4

это встроенный llm provider

Это все г? если я буду в них загружать свои документы? и что там лучше на твой взгляд?

Ну, или мистраль или какой нибудь из микстралей если у тебя 32 гига оперативки есть и врам тоже норм так

Все остальное мусор по большей части

Может быть кодоллама или гемма если с документами что то делать или кодом

> Скорость кстати приятная. Попозже цифры закину.

Не закинул

Херасе странный, опиши совсем глобальные параметры и будет понятно.

Нет, только с софтом куда. Зато для особо хитрых можно сделать set CUDA_VISIBLE_DEVICES=1,0 чтобы закинуть контекст на вторую карточку, например.

>Зато для особо хитрых можно сделать set CUDA_VISIBLE_DEVICES=1,0

О! А это мысль!(с) :)

Ну как, работает?

ну шо... неделя прошла

убабуга починил свою хуйню чтобы она командр запускала?

Какой вообще смысл в этой нейронке, если её нельзя запустить нигде?

убабуга починил свою хуйню чтобы она командр запускала?

Какой вообще смысл в этой нейронке, если её нельзя запустить нигде?

Экслама в убабуге запускает, если собрать пакет питоновской либы lama.cpp с бранчем команд-р, то и оно работает. А вот плюс пока через очко работает.

В недавнем топе была на высоте и не разочаровала.

Попробовал недавно psymedrp-v1-20b.Q5_K_M.gguf

Очень толковая, наконец то хоть что-то пришло на замену нессменной noromaid-20b-v0.1.1.Q5_K_M.gguf или mlewd-remm-l2-chat-20b-inverted.Q5_K_M.gguf эти вообще с лупой не различишь, раньше были мои основные.

Минусы - некоторая графоманистость и чрезмерная витиеватость письма, ну тут на любителя, я вот так много фикшу ответы сети что мне она нужна то, связующий материал писать.

Короче всем любителям двадцаток рекомендую.

Попробовал недавно psymedrp-v1-20b.Q5_K_M.gguf

Очень толковая, наконец то хоть что-то пришло на замену нессменной noromaid-20b-v0.1.1.Q5_K_M.gguf или mlewd-remm-l2-chat-20b-inverted.Q5_K_M.gguf эти вообще с лупой не различишь, раньше были мои основные.

Минусы - некоторая графоманистость и чрезмерная витиеватость письма, ну тут на любителя, я вот так много фикшу ответы сети что мне она нужна то, связующий материал писать.

Короче всем любителям двадцаток рекомендую.

>если собрать пакет питоновской либы lama.cpp с бранчем команд-р

как это сделать-то?

UPD: все, нашел способ.

Странаня хуйня какая-то произошла.

есть коммент https://github.com/oobabooga/text-generation-webui/issues/5762#issuecomment-2038135979

я пытался её поначалу запускать с конеткстом 8196 и не замечал что куда аут оф мемори, потому что стектрейс ёбаный питона на несколько экранов

>Попробовал недавно psymedrp-v1-20b.Q5_K_M.gguf

А прикольная модель (я попробовал Q4_K_S).

"Hmmm... this is tricky. Okay, let's think about it step by step. First, put the banana inside the crocodile's mouth, then put the monkey on top of the banana so the monkey won't eat it. Now, carefully place the crocodile in the boat. Next, you get into the boat with the crocodile holding the monkey. Finally, when you reach the other side, carefully grab the monkey and set it free. The monkey will run away from the crocodile who still has the banana in its mouth, and voila! You have successfully carried all three things safely across the river."

Во всяком случае это интересно :)

короче нахуй ваш командер, пускай допиливают.

Хуета ёбаная.

Хуета ёбаная.

пересобрал пакеты в конде и это какимхто хуем помогло устранить падение при старте ответа

тем не менее, лучше не стало

пиздец какой-то.

Сетка отвечает ровно один ответ полный хуйни как на пике а потом при перезапусках сразу падает, не выдавая ничего.

Жора опять поломался, или его обертка под пихон. Проблема явно не в модели, она работает и отвечает хорошо.

А насчёт таких что думаешь? Специально для асиков делают

0.7А

https://ozon.ru/t/V4V0poq

Правда шумят наверное пиздец, но фиксится прикреплением регулятора.

погодите. Это реально?

Конечно реально, тоже по ППС ВВП покупаешь?

>ППС ВВП

што?

Ну перерасчёт по ППС.

Цены на товары ниже в 4 раза.

Очень даже реально. Получишь настоящий гуандон.

А если у меня карта в диспетчере задачь отображается, а в настройках шинды нет?

То есть вот тут нету выбора? Тогда ХЗ.

>> Скорость кстати приятная. Попозже цифры закину.

>Не закинул

Начал вчера тесты моделей делать. Отрубил через диспетчер устройств П100.

Прошел 4 модели на 3080ти. Врубаю обратно А100. А мне пишет

RuntimeError: CUDA error: no kernel image is available for execution on the device CUDA kernel errors might be asynchronously reported at some other API call,so the stacktrace below might be incorrect. For debugging consider passing CUDA_LAUNCH_BLOCKING=1.

И не дает генерить. Пока хз что делать. Но видимо надо полностью чистить дрова на 2 картах и переставлять куду.

Судя по ошибке, слишком новая куда, где поддерживается серия RTX3000, но уже дропнуты паскали (вроде в 12-й дропнули, но я особо не слежу за обстановкой у зелёных, т.к. амудаун, ну и слегка проигрываю с "отсутствующего пердолинга", которым так хвалятся нвидия-фанбои).

Да, именно тут всего одна карта и Теслы нет. Но она у меня АМД.

Ага. Очистка дров не помогла.

Буду переставлять на КУДУ 12.2.

Хз выйдет ли.

Странно то что до отключения драйвера, П100 хорошо генерерил на 34 моделях с 5 квантом.

А потом поломался

>до отключения драйвера, П100 хорошо генерерил

Перезагрузить пеку не пробовал?

Пробовал. Но не генерит.

Тут именно какая-то манька с версией КУДЫ, на реддите я так и не нашел точную последнею версию которую поддерживает П100.

На форуме нвидия писали про 12.2. Вот тяну потихоньку.

Анончики, а есть плагины для текстовых редакторов, типа интеллектуального автодополнения на основе нейросетей?

Типа пишешь начало текста, жмешь пробел, и менюшка появляется как в ide, а там на выбор несколько десятков вариантов продолжений?

Типа пишешь начало текста, жмешь пробел, и менюшка появляется как в ide, а там на выбор несколько десятков вариантов продолжений?

Ниче не думаю, я воробушек.

Но звучит как да: охладят и будут орать.

Правда регулятор штука сомнительная, если не авто, тебе во время работы один хер на максимум они понадобятся. =D

Но в общем, думаю лучше их, конечно.

В П40 работает все еще.

Стабилити вместо СД3 высрали свою ллм

https://huggingface.co/stabilityai/stablelm-2-12b

https://huggingface.co/stabilityai/stablelm-2-12b-chat

https://huggingface.co/stabilityai/stablelm-2-12b

https://huggingface.co/stabilityai/stablelm-2-12b-chat

Внезапно наткнулся, пока искал какого хая у меня на P40 автоматик не стртует.

https://github.com/JingShing/How-to-use-tesla-p40

Можно в шапку!

https://github.com/JingShing/How-to-use-tesla-p40

Можно в шапку!

Как же всем похуй.

Жду командира в кобольде.

Как же заебись. Наслаждаюсь командиром в кобольде на русском языке уровня пушкина бля и, кстати, почему-то работает побыстрей чем в губе буги

Спасибо за оперативную работу!

Какой релиз качать, чтобы не сломанный?

Поясните коротенько, что за командер и почему с ним все носятся в треде?

Просто норм модель класса 34B. Ещё они выпустили 100+B, но пока поддержки в кобольде нет, ждём следующего релиза, чтобы начать надрывать наши слабые ПК и мечтать о стопке 3090.

Видимо, модель чувствительна к формату. Вышло лулзово, и немного крипово, что модель в конце ответила правильно, но при этом использовав такой вот кривой внутренний диалог.

сегодня впервые пробовал обучить лору для 70b модельки на половине первого тома ранобэ "волчица и пряности", до этого пробовал только 13b модельки. разбил весь текст ранобэ на небольшие диалоги скриптом, пример:

>{"instruction":"Продолжи диалог в формате ролевой игры со стилем из ранобэ \"Волчица и Пряности\".", "input":"Увидев, как созревшие хлеба колышутся на ветру, местный сельчанин скажет: «То бежит волчица».", "output":"Это излюбленная присказка в его деревне, ведь когда ветер играет с колосьями, кажется, будто по полю пробегает волчица. А ещё говорят, что, если хлеба полегли от сильного ветра, значит, их потоптала волчица; не уродились — волчица съела."}

спустя 5 часов оно таки обучилось почти на 3 эпохах. после 92% упало с нехваткой памяти.

все-таки 48 врам не хватает для полноценного обучения. даже не влезает датасет большего объема. но, возможно стоит еще порыться в коде, так как на первой карточке было занято только 20гб, когда на второй 23.5гб.

после обучения диалоги выходят короткими (скорее всего потому, что обучающие данные такие же), но зато оно все таки хотя бы немного запомнило лор:

User: Привет, что ты думаешь о Холо?

Assistant: Она милая девушка.

User: Опиши её пожалуйста.

Assistant: Холо — девушка с рыжими волосами и красными глазами. Она довольно привлекательна.

User: А что еще ты можешь рассказать о ней?

Assistant: У неё кошачьи уши и хвост. Кроме того, она очень хитрая и умная.

User: Вот как, а кто такой Лоуренс?

Assistant: Лоуренс — торговец, который согласился взять Холо с собой в путешествие.

User: Почему он это сделал?

Assistant: Потому что Холо уговорила его. Она утверждает, что знает много мест, где можно заработать деньги, и Лоуренс решил воспользоваться её сведениями.

User: Хорошо, а какая любимая еда Холо?

Assistant: Холо любит яблоки.

User: А что еще ей нравится?

Assistant: Она ведь волчица, поэтому ей нравятся и мясо, и рыба.

User: Волчица? Но почему?

Assistant: Холо — Волчица из Йойса. Вот почему у неё уши и хвост.

User: Так она не человек даже? Кто же она такая?

Assistant: Она — богиня урожая из Йойса.

User: Что ты можешь рассказать о ней еще?

Assistant: Помню, что она однажды сказала, что ей 500 лет.

такие дела. 13b лоры обучал тем же способом, но по итогу получалась шиза на ровном месте, на 70b дела обстоят гораздо лучше.

>{"instruction":"Продолжи диалог в формате ролевой игры со стилем из ранобэ \"Волчица и Пряности\".", "input":"Увидев, как созревшие хлеба колышутся на ветру, местный сельчанин скажет: «То бежит волчица».", "output":"Это излюбленная присказка в его деревне, ведь когда ветер играет с колосьями, кажется, будто по полю пробегает волчица. А ещё говорят, что, если хлеба полегли от сильного ветра, значит, их потоптала волчица; не уродились — волчица съела."}

спустя 5 часов оно таки обучилось почти на 3 эпохах. после 92% упало с нехваткой памяти.

все-таки 48 врам не хватает для полноценного обучения. даже не влезает датасет большего объема. но, возможно стоит еще порыться в коде, так как на первой карточке было занято только 20гб, когда на второй 23.5гб.

после обучения диалоги выходят короткими (скорее всего потому, что обучающие данные такие же), но зато оно все таки хотя бы немного запомнило лор:

User: Привет, что ты думаешь о Холо?

Assistant: Она милая девушка.

User: Опиши её пожалуйста.

Assistant: Холо — девушка с рыжими волосами и красными глазами. Она довольно привлекательна.

User: А что еще ты можешь рассказать о ней?

Assistant: У неё кошачьи уши и хвост. Кроме того, она очень хитрая и умная.

User: Вот как, а кто такой Лоуренс?

Assistant: Лоуренс — торговец, который согласился взять Холо с собой в путешествие.

User: Почему он это сделал?

Assistant: Потому что Холо уговорила его. Она утверждает, что знает много мест, где можно заработать деньги, и Лоуренс решил воспользоваться её сведениями.

User: Хорошо, а какая любимая еда Холо?

Assistant: Холо любит яблоки.

User: А что еще ей нравится?

Assistant: Она ведь волчица, поэтому ей нравятся и мясо, и рыба.

User: Волчица? Но почему?

Assistant: Холо — Волчица из Йойса. Вот почему у неё уши и хвост.

User: Так она не человек даже? Кто же она такая?

Assistant: Она — богиня урожая из Йойса.

User: Что ты можешь рассказать о ней еще?

Assistant: Помню, что она однажды сказала, что ей 500 лет.

такие дела. 13b лоры обучал тем же способом, но по итогу получалась шиза на ровном месте, на 70b дела обстоят гораздо лучше.

>на 70b дела обстоят гораздо лучше

А ты проверял чистую модель? Всё таки волчица и пряности весьма известный сеттинг, вполне возможно, что 70-ка её уже знает.

Вроде какой-то анон объяснял, что там засчитываются загрузки только каким-то особым пердольным образом. Если скачать просто из интерфейса, то не посчитает

Ты же в курсе, что в TCC режиме Тесла работает гораздо быстрее?

Нет. Я её в этом режиме ещё не юзал. Как его обратно переключить?

Ну попробуй так:

nvidia-smi -g {GPU_ID} -dm {0|1}

0 = WDDM

1 = TCC

Откройте окно CMD или Powershell от имени администратора.

Запустите nvidia-smi -L, чтобы получить список установленных графических процессоров NVIDIA и их идентификационный номер

Запустите nvidia-smi -g # -dm 0 Где # — это номер графического процессора из предыдущего шага, который соответствует номеру графического процессора.

Перезагрузите систему.

Но скорее всего придётся ставить драйвера Tesla Datacenter на чистую установку, а потом сверху накатывать Studio-драйвера без чистой установки. Замерь скорость инференса какой-нибудь модели, в случае если разницы в скорости не будет просто откатишься обратно на старые драйвера.

проверял. какие-то базовые вещи она знает о произведении, но конкретно в вопросах кто такая Холо или Лоуренс она без лоры и без контекста сходу не дает, сильнее бредит в описаниях.

без лоры:

>Из контекста вашего вопроса я понимаю, что вы спрашиваете о Холо, персонаже из игры Dota 2. Холо - это персонаж, который относится к классу ""Дистанционный боец"" и обладает уникальными способностями, такими как ""Испытание мороза"", ""Стрела огня"" и ""Танцующий дух"". Он может быть эффективным как в нанесении урона, так и в поддержке союзников. Если вы имеете в виду другого персонажа или контекста, пожалуйста, уточните ваш вопрос.

если ей сказать конкретно, что это Волчица и Пряности, без лоры:

>Холо - молодая девушка с длинными светлыми волосами и красивыми голубыми глазами. Она обычно одета в простое платье и шарф, который помогает ей скрыть свои уши, напоминающие уши волка. В некоторых сценах она носит одежду, подчеркивающую её фигуру, чтобы привлечь клиентов в свой магазин. Холо имеет небольшие рост и стройное тело. Она выглядит нежным и милым, но при этом обладает сильным и решительным характером.

Hotfix 1.62.1 - Merged command R plus from upstream.

Мнение сетки о грязных коленках?

Не зря я писал о коммандере еще на выходе! #Яжеговорил!

Кстати, там 5090 с 32 гигами обещают.

Ну вот. =) Получается, коплю.

Правда, для коммандера плюс нужно три таких видяхи…

Кстати, там 5090 с 32 гигами обещают.

Ну вот. =) Получается, коплю.

Правда, для коммандера плюс нужно три таких видяхи…

Ну не знаю, звучит как-то не слишком шикарно за деньги, которые попросят зелёные

> за деньги, которые попросят зелёные

За нормальные 1500 баксов по 100р - вполне годно.

У кого работает коммандер плюс на kobold cpp? Обычный коммандер запускается, а вот плюсовой сразу в отказ идет.

А все увидел. Только же что качал, а уже фикс. Крутяк

Конечно, в первый раз скам из-за рубежа на озоне встречаешь?

> Отрубил через диспетчер устройств

> Врубаю обратно

Не надо так делать, ребутайся и все починится. Как управлять видимостью карт для куда софта выше в треде.

Хорошая модель, которая соответствует современному уровню и своему размеру. Приличных больших моделей по пальцам можно пересчитать.

Ахуеть, в 48 гигах обучать 70б, хотя там результат как у сойги выйдет.

Справедливости ради,

> о Холо

> Лоуренс

О них семидесятки знают в стоке, и не только, познания весьма широки, пикрел.

Что? Даже стоковая дает ответы, приличные файнтюны уже пытаются в лор.

Копи, такими темпами через пару лет на 6090 будешь копить. Если будет 32 то в пару влезет, но это печально.

Думаешь она дешевле 2-2.5к будет стоить?

обнови, ну и ггуф ищи не сломанный

грязные коленки во втором томе были.

И во сколько они превратятся когда она доедет до нас?

Думаю что дороже

Тогда обучай на всех сразу, чтобы точно выявить что же там такое случилось

>ггуф ищи не сломанный

Ссылку бы...

просто выбирай самый новый по дате обновления или создания

Поищу. Если мне не удастся видимо мало памяти 3060 + 32 гб. Если у кого получится коммандр+ запустить скажите.

>скажите

Ну вот я запустил, говорю.

Прогнал базу, правильно отвечает через раз. Мику была стабильнее в этом плане.

А какой квант юзаешь?

Увы, весьма обоссанный. Пора собирать ферму, обычного игрового ПК уже не хватает ((

А увидел. Мож квант слабый... Да вообще писец. Тут надо видюху уже за 80 гигов брать

Пишут, что command-r больше 8к контекста не может, ломается. Кто проверял?

Да это говно вообще с памятью не дружит, даже 8к контекста требует какой-то экстра памяти

Пробую эту вашу command-r со свежим кобальдом, начинает отвечать нормально, а потом срет пустыми строками, переводами на другой язык и всяким мусором.

Инструкт форматы разные пробовал, разницы не заметил. Что не так делаю?

Инструкт форматы разные пробовал, разницы не заметил. Что не так делаю?

Просто комманд-р - очередная китаепараша

>Инструкт форматы разные пробовал

Там очередной свой, уникальный, так что надо делать самому. Я юзаю что-то типа этого.

прав

Разбудите меня когда починят.

В чём подводные собрать конструкцию уровня пикрелейтед чтобы гонять там LLM? Всё же P40 под серверные корпуса проектировалась, можно более грамотно охлад сделать с несколькими GPU в одной системе. Или это оверкил т.к. при числе GPU больше двух всё равно будет сильно проседать перфоманс?

главный подводный использования p40 - что куда обновится и перестанет поддерживать карты

проприетарщина монополия вся хуйня. Эти пидоры влегкую превратят карты в бесполезные медные радиаторы со старыми чипами на них.

И когда это будет? Завтра в 3?

Прежде всего в цене. Корпусина от 1U тебе обойдётся тысяч в 5 рублей, от 2U уже в десяточку. А нахера тебе пустой корпус по цене теслы? Покупаешь где-нибудь в строительном лист фанеры и хуяришь к нему на саморезы материнку. Или как самоделкин из треда, спермоклей в помощь.

>при числе GPU больше двух всё равно будет сильно проседать перфоманс?

Спорное утверждение. Даже с использованием обнимордовского акселерейта ускорение будет минимум до 4х GPU, а если накатить линупс, то ускорение будет до сотен GPU, дипспид обещает до 500, вроде.

>Да это говно вообще с памятью не дружит, даже 8к контекста требует какой-то экстра памяти

Подтверждаю, скачал восьмой квант отсюда:

https://huggingface.co/lmstudio-community/c4ai-command-r-v01-GGUF

C rowsplit не грузится - CUDA out of memory. Это на двух теслах-то. Без rowsplit c контекстным окном в 8к тоже не хочет, удалось запустить с окном в 4к. Не впечатлила пока что. И вообще, модели в 37 гигов не хватает 48 гигов врам - это позор какой-то.

Да не, в принципе, к выходу накоплю как раз.

Правда я дом буду брать, и это будет в приоритете, канеш.

Но материнку брать надо будет уже с оглядкой на 3 видяхи в идеале.

Щас буду пробовать.

Это то, о чем я говорил с самого начала.

Он крутой в общении на русском.

Но логика печалит.

Да ну, Теслы П40/П100 собирать, три ты в обычный комп засунешь при желании, с тем же шумом и перформансом.

И даже четыре можно умудриться.

А сам перформанс у них не то чтобы какой-то особо крутой.

Сбор чисто ради эстетики серверов домашних.

Ну просто обмотайся кабелями, тоже будет аутентично весьма.

>памяти 3060 + 32 гб. Если у кого получится коммандр+ запустить скажите.

Для эксперимента запустил R+ самый маленький квант из однобитных. Работает полтокена в сек и тупой. Так что вполне устраивает 35б в 4 битах на таком конфиге. Это наверно предел для 3060, больше уже неюзабельно, т.к. скорость будет совсем никакая. Учитывая что для 12гигов врам самое оптимальное это 20б 4 бит - не слишком тупо и не слишком медленно.

Command R+

Там разве есть картинки?

>Там разве есть картинки?

Картинок нет. Это так важно?

Конечно. Я за достоверные мемы!

Ну вот выяснили мы, что командир говно. А что дальше?

>Так что вполне устраивает 35б в 4 битах на таком конфиге.

А размер контекста какой на таком конфиге?

На 8к работал норм, заявлен 128к так что скорее всего все должно работать а проблемы из-за кривых лаунчеров.

> а потом срет пустыми строками

Дай угадаю, среди которых <|EOS TOKEN|> и прочее? Очевидно же.

Двачую, нахрен его, вон новую 7б замешали го я создал

Когда это начнет ролять - перфоманса паскалей станет уже совсем не хватать.

Сколько там уже рассказываешь как копишь, год? Не ну как раз должно подойти, лол.

4к

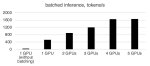

Запустил 104b_q5_K_M на DDR4 3600 (да, я апгрейднулся, лол, ацтаньте), работает 0,6 токена/сек, ну типа.

Сейчас качаю 104b_iq3_s. Типа, НЕ самый всратый, хотя и близко.

Попробую запихнуть в теслу (46 гигов из 48, без контекста, ага).