Немного сменил имя треда, плюс продолжил переносить инфу из шапки в вики. Хотя знаю, всем похуй.

Тому що командр кривое говно

Intel GNA для LLM как то можно испольховать?

Жаль, покрутил его немного. Пока кажется самой умной моделью меньше 70В. И однозначно топ моделью на русском.

вот только что с нормальным контекстом не запустишь

В качестве подпорки для видеокарты, а что?

Ждём фиксов, делов то. Или наращиваем память. Мне он тоже нравится.

Что значит "умной"?

> 16-гиговая стоит дешевле Теслы

Где такое счастье продается? Ведь буквально можно занидорого на них ферму для ллм собрать, правда уровень пердолинга и амудэ-веселья перевалит все границы. Оно в сд и другие нейронки может с норм перфомансом? Офк относительно теслы.

Мамонты еще не перевелись? Что это за кринжатина, в эти деньги собирается пара A100 (а то может и на третью хватит если подужаться), причем это уже готовый сервер будет.

> удалось дообучить токенизатор

Что значит "дообучить токенизатор"? Это же рили просто собрать словарь и занимает ерунду по сравнению с тренировкой самой ллм.

Про вторую часть че-то сложное, есть где почитать про это?

> Нейросеть не "знает", что это одно и то же слово, она обучается взаимодействию с каждым из них.

Все так, после обучения для нее это будут синонимы, однако все равно может быть разный эффект. Наиболее наглядно это наблюдалось на ранних мелких сетках, где лишний пробел, отступ и т.п. в инструкции могли радикально ухудшить качество ответа.

Выше ответили, Qlora.

Да не, просто не хватает оптимизаций и более жирного железа.

А чего ты побольше выгрузку на проц не оформишь? Тогда освободится врам на контекст.

Есть нейронки, которые инструкции в карточке не игнорят? И со скольких миллиардов параметров это становится возможно? Алсо не понимаю, что вообще заставляет их игнорить инструкции, тупость или соя.

>А чего ты побольше выгрузку на проц не оформишь? Тогда освободится врам на контекст.

Так и сделал, но скорость упала до 2-3 т/с, нинравица.

>Где такое счастье продается?

Авито ими завалено по 16к, в конце прошлого треда ссылку кидал.

>правда уровень пердолинга и амудэ-веселья перевалит все границы. Оно в сд и другие нейронки может с норм перфомансом? Офк относительно теслы.

Вот это главный минус этих карт, память в 16Гб на втором месте.

Я так понял их надо запускать через ROCm, который пока работает только под линукс. Через него же можно и SD погонять. Но я, когда юзал SD на своей АМДхе обнаружил что многие фишки на АМД либо не работают, либо работаю.т с проблеами. Тайлед дифьюжн ты например на АМД не заюзаешь.

Для LLM как альтернатива есть ещё Vulkan, он работает и под виндой, но вроде медленней, чем ROCm.

Мне самому инстинкты кажутся той ещё авантюрой, я с теслой то немало поебался, а тут количество пердолинга возрастает в разы + гайдов никаких нет.

Но кто-то писал что по производительности они близки к 3090, а две таких карты дадут 32 Гб, и стоить будут в 2-3 раза дешевле, так что соблазнительно.

Вон, чел в обсуждениях Эксламы нейронки на Mi100 крутит https://github.com/turboderp/exllama/discussions/247

>Вот это главный минус этих карт, память в 16Гб на втором месте.

Я бы просто сказал, что на данном этапе AMD пока сосут. На новые карты от них есть надежда; но много раз здесь уже писали, что Nvidia Куду делали много лет. За какой срок АМД смогут хотя бы приблизиться? И уж на поддержку старых карт они точно забьют. А новые по цене будут конкурировать с новыми от Nvidia - вот и конец надеждам.

Делайте ставки, на сколько это поделие майкрософта цензурировано и соево

С учетом того что даже на ллама1 визард был уже "выровнен" отказываясь делать кучу вещей

>занимает ерунду по сравнению

Эверест весит ерунду по сравнению с Солнцем, но не то, чтобы это имело значение в практическом смысле, и то, и другое - величина огромная. "Просто" собрать словарь это составить правила разбиения слов на подслова в зависимости от частоты, то есть фактически каждое слово нужно разобрать побуквенно, а каждый спецсимвол - побайтово. После чего составить словарь токенов, ещё раз пройтись по всему датасету и токенизировать его, записывая в счётчик частоту, с которой пары токенов встречаются по соседству. Затем выбрать разумное количество пар токенов для слияний и залить их в токенизатор. И ещё параллельно охуевать от неожиданного поведения библиотек. Например, когда я протокенизировал датасет, нашёл самые частые пары токенов и заглянул в выходной файл, оказалось, что "токены" это единичные буквы. Вот так вот. Если у тебя в токенизаторе есть токен "хуй" и ты пишешь "хуй", он может разбить его побуквенно и токенизировать так, если нет ни одного правила слияния. А мне нужен был правильно токенизированный датасет для просчёта правил слияния. И хотя я упростил процедуру и пропустил некоторые шаги, задача получилась занятная.

Про вторую часть где читать хз, я это вывел методом ножа и топора.

>где лишний пробел, отступ

Ну правильно, пробел это управляющий символ. Потому в каждом токенизаторе есть замена пробелов на спецсимвол. В gpt2 это была G с диакритическим знаком, дальше уже все перешли на жирное подчёркивание. Но главную проблему я тут вижу скорее в том, что нейросеть обучается в разы более сложным вычислениям, чем практически необходимо. Для "component" нужен, по сути, один токен с парой управляющих флагов, является ли это первым словом в предложении, множественное ли это число и т.д. На практике же этот компонент это десятки токенов. И так с каждым словом, что накапливается как снежный ком.

https://www.reddit.com/r/LocalLLaMA/comments/1c4gxrk/easily_build_your_own_moe_llm/

Создание своего мое или каких то еще слияний из кучи сеток

Франкенмержи могут перейти на другой уровень хех, хотя и до этого инструмента как то клепали смеси из сеток

Создание своего мое или каких то еще слияний из кучи сеток

Франкенмержи могут перейти на другой уровень хех, хотя и до этого инструмента как то клепали смеси из сеток

https://wizardlm.github.io/WizardLM2/

New family includes three cutting-edge models: WizardLM-2 8x22B, WizardLM-2 70B, and WizardLM-2 7B.

Похоже на тенденцию к отказу от средних размеров типа 13-33б

Mergekit умеет как собирать moe, так и разбирать его на отдельных экспертов.

>так и разбирать его на отдельных экспертов.

Только хуйня на выходе, чет не слышал ни об одном удачном разделении

Там ведь не просто 8 экспертов, там в каждом слое они по разному активируются.

Не было базовой 34?

Но был коммандер, хоть и не базовый.

Все таки выпуск базовой модели очень важен, чем просто уже обученную модель

Поэтому мику которая даже в полном размере не доступна не особо беспокоит их

>WizardLM-2 8x22B

Сетку 8x22B удалось квантовать до сколько-нибудь человеческого размера? Найти компромисс между размером и качеством? Был же уже такой Микстраль.

Просто разные наблюдения от нех делать из любопытства:

матрица важности для кванта Q6 уравняла его с Q8 по ппл:

Fimbulvetr-11B-v2.i1-Q6_K.gguf, PPL = 5.6658 +/- 0.03456

Fimbulvetr-11B-v2.Q8_0.gguf, PPL = 5.6659 +/- 0.03454

опыт порчи Fimbulvetr ебанутым трейном:

было:

Fimbulvetr-11B-v2.i1-Q6_K.gguf

ARK: 65.9379 +/- 1.6086

MMLU: 40.8269 +/- 1.2497

TruthfulQA: 37.6989 +/- 1.6966

Hellaswag: 85.1723 +/- 0.3546

PPL = 5.6658 +/- 0.03456

стало:

Moistral-11B-v2.1a-WET.Q6_K.gguf

ARK: 45.3395 +/- 1.6897

MMLU: 31.5245 +/- 1.1813

TruthfulQA: 22.1542 +/- 1.4538

Hellaswag: 71.2607 +/- 0.4516

PPL = 12.5621 +/- 0.08824

последние результаты похожи на TinyLlama-1.1B-Chat-v1.0-f16.gguf

ARK: 44.8792 +/- 1.6882

MMLU: 30.2972 +/- 1.1684

TruthfulQA: 23.8678 +/- 1.4923

Hellaswag: 60.0777 +/- 0.4887

PPL = 8.4444 +/- 0.05330

то есть после трейна 11б стала как 1,1б - прикольно

матрица важности для кванта Q6 уравняла его с Q8 по ппл:

Fimbulvetr-11B-v2.i1-Q6_K.gguf, PPL = 5.6658 +/- 0.03456

Fimbulvetr-11B-v2.Q8_0.gguf, PPL = 5.6659 +/- 0.03454

опыт порчи Fimbulvetr ебанутым трейном:

было:

Fimbulvetr-11B-v2.i1-Q6_K.gguf

ARK: 65.9379 +/- 1.6086

MMLU: 40.8269 +/- 1.2497

TruthfulQA: 37.6989 +/- 1.6966

Hellaswag: 85.1723 +/- 0.3546

PPL = 5.6658 +/- 0.03456

стало:

Moistral-11B-v2.1a-WET.Q6_K.gguf

ARK: 45.3395 +/- 1.6897

MMLU: 31.5245 +/- 1.1813

TruthfulQA: 22.1542 +/- 1.4538

Hellaswag: 71.2607 +/- 0.4516

PPL = 12.5621 +/- 0.08824

последние результаты похожи на TinyLlama-1.1B-Chat-v1.0-f16.gguf

ARK: 44.8792 +/- 1.6882

MMLU: 30.2972 +/- 1.1684

TruthfulQA: 23.8678 +/- 1.4923

Hellaswag: 60.0777 +/- 0.4887

PPL = 8.4444 +/- 0.05330

то есть после трейна 11б стала как 1,1б - прикольно

https://huggingface.co/mradermacher/Mixtral-8x22B-v0.1-i1-GGUF

тут не видно кванта который допустим войдет в две теслы и будет адекватен. И причина этого в том что это мое всего 22б(даже если 22х2 активны- не суть) Почему и не люблю разреженные модели. Неэффективное использование памяти. Плотная модель такого же размера даже в 2 битном кванте была бы приемлема. Так что даже скачивать не стоит. Что касается однобитных, то вообще непонятна нахера их делают. Даже 100б+ модели в 1 бите идиоты

Прикольно, но все равно квант 8 мы качать не бросим

Простое деление на 2 мне ближе чем стремная матрица важности

Дальше. у этого баклана есть чуть получше модель Moistral-11B-v2.1b-SOGGY но в принципе и она такой же бормочущий имбецил.

Однако, чудовищный moistral был использован в слиянии (вместе с хорошими моделями) и что интересно на выходе получилась интересная модель SkunkApe-14b. Например тесты в 4 битном кванте:

SkunkApe-14b_iQ4xs.gguf

ARK: 72.0368 +/- 1.5234

MMLU: 40.5685 +/- 1.2484

TruthfulQA: 32.0685 +/- 1.6339

Hellaswag: 86.3274 +/- 0.3429

PPL = 6.0039 +/- 0.03791

Похожие цифры с 6 битным Fimbulvetr, кроме повышенного вранья, т.е. галлюцинаций.

Перебирай разные модели, из 2-3 десятков найдёшь то, что больше подходит именно тебе. Если нужно для RP, то стоит сразу смотреть в сторону заточенных под это файнтюнов базовых моделей.

Чекни лучше вот это

DolphinStar-12.5B

забавная штука

И вот это

starling-lm-7b-beta-laser-dpo

Интересно как могли повлиять все эти оптимизации на топ чат модель

rubra-11b-h опять же, никто ее помоему так и не чекнул

я тыкал, норм так

Не обновляйте пока oobabooga, Обновил, теперь пауза в таверне сломалась, спасает только перезагрузка модели.

>тут не видно кванта который допустим войдет в две теслы и будет адекватен.

Да вот тоже так подумал. Вопрос в том, насколько эта модель лучше их же семидесятки - если вообще лучше.

эту DolphinStar-12.5B и эту rubra-11b-h завтра потыкаю.

необычный мерж у первой

> кто-то писал что по производительности они близки к 3090

Мало верится, если только речь не про теоретический в ллм. Еще может оказаться так, что поддержки ничего нового, где амд фиксят старые дыры и проблемы, на эти карточки не выйдет, это же не хуанг что долгие годы поддерживает.

О май гад, это мы качаем. Время еще найти бы только. 70b почему-то нет на обниморде.

Ты что с нуля все алгоритмы пишешь там? Есть же готовое.

> Для "component" нужен, по сути, один токен с парой управляющих флагов

> На практике же этот компонент это десятки токенов.

На практике у тебя может быть component, Component, cmponent (очепятки), сокращения и т.д., потому оно и должно уметь в гибкость. Не то чтобы это проблема для современных сеток.

Еще на релизе первого микстраля собирали в кучу шизомерджи. Толку мало или вообще нет, смысл в том чтобы тренить это сразу как мое со своим разделением.

> И причина этого в том что это мое всего 22б

Это мое - 176б, из которых в интерфейсе участвует только 25% по дефолту (упрощенно офк), но память кушают все. Не для локального запуска, вот запилят аналог мак студио и говнопроцом и кучей каналов памяти в качестве ллм ускорителя - можно будет наяривать МОЕ, а пока это тупиковая ветвь.

Отмена генерации работает, но она пиздец медленной стала.

>Есть же готовое.

Я же писал сразу, что готовое экстремально медленное. Обучение с нуля неделя на моём железе. А мне с нуля не нужно, мне нужно дообучить существующий словарь. Готовое так не умеет в принципе.

>Не то чтобы это проблема для современных сеток.

Здесь вопрос в том, какой ценой. Судя по всему это жрёт просто неадекватное количество ресурсов.

Пока что все какое-то говно. Да и оно все llama либо mistral в принципе. То есть сколько десятков я не попробую, модель по сути одна.

>Да и оно все llama либо mistral в принципе

Командер внезапно отличается, причём в лучшую сторону, пробуй его.

Бля, какое железо нужно, чтобы запустить command R на Q5_K_M хотя бы в 5 т\с? Сейчас на 8 гигах видеопамяти и 32 оперативы запущаю Q3_K_M в 1.5 т\с и пиздец как это медленно. Для покупки 3090\4090 слишком нищеброд.

Все норм. Не бухтим.

https://huggingface.co/amazingvince/Not-WizardLM-2-7B

Лучше подскажите кто как отрубает видел карты?

Через чиспетчер устройств, тупо отключить?

Или есть какие-то премудрости?

Лучше скажи, зачем тебе их отрубать, когда есть параметр "visible devices".

> Для покупки 3090\4090 слишком нищеброд

Возьми Tesla P40 как и многие в LLM сообществах, только придётся вентилятор самому приколхозить.

Ахаха, случайно релизнули модели без выравнивания?

Надо будет качнуть все старые варианты про запас.

> Надо будет качнуть все старые варианты про запас.

У меня так пара тб СД моделек, и под пол ТБ текстовых. Не уподобляйся Плюшкину

>Это мое - 176б

Это понятно, но по факту работает 22х2 а при кванте к примеру 2 бит очень даже критично 48б или 176б.

>Не уподобляйся Плюшкину

Почему нет? Видишь же, как трут. Лучше дисков накупить.

Ебать там СОЯ прям сходу

забавно, надеюсь ггуф который я качаю все еще старый

Ну вот это вот колхозить, учитывая мои кривые руки. Да к тому же придется менять еще блок питания, так-как 2 видеокарточки считай 250w + 180w вряд ли потянет 700w бп.

А, ну еще p40 древнющая хуйня на которой exllama не работает.

Да там вся фраза из сои состоит.

Новый пока ещё не выложили, качай смело небось сам квант будет сломанным, лол.

Объективно: по тестам обе хуже fimulvetr, причем не на чуток, а нормально так хуже. Не стал даже тратить время на Hellaswag на них - и так ясно.

Субъективно:потыкал - ничего выдающегося не представляют.

По медвежьим углам хагинфейса конечно можно найти интересные модели, но в основном там просто неудачные эксперименты лежат.

rubra-11b-h.Q5_K_M.gguf

ARK: 60.7595 +/- 1.6574

MMLU: 37.4677 +/- 1.2307

TruthfulQA: 35.8629 +/- 1.6789

PPL = 7.3468 +/- 0.04576

DolphinStar-12.5B.i1-Q5_K_M.gguf

ARK: 57.7675 +/- 1.6765

MMLU: 39.8579 +/- 1.2448

TruthfulQA: 36.8421 +/- 1.6887

PPL = 7.9289 +/- 0.05270

RRReeeeee

сука блять и хули 70 не выложили. Будет интересно сравнить прошлый и новый релиз на наличие лоботомии и ее интенсивность.

Что?

И при любом раскладе квант в 2 бита текущими средствами сделает шизофреника.

>при любом раскладе квант в 2 бита текущими средствами сделает шизофреника

С этим можно поспорить для некоторых моделей от 70б и франкенов 100б+ и 2-х битным к-квантом с матрицей важности. По крайней мере можно получить от модели приемлемый вывод, но не шизофреника. Вот ниже 70 будет шизик, мое - тоже, ну и однобитный квант - шизик вне зависимости от параметров, такие дела на данный момент.

Жаль, хотя та же рубра имеет уникальный стиль ответов, отличный от других сеток. Все таки считай новая линия моделей.

По тестил тут немного starling-lm-7b-beta-laser-dpo.Q5_K_M

и что то как то охуел, не ожидал такого текста от 7b

Сравнить не с чем, но где то на уровне 11b идет

Нодо будет еще визарда глянуть 7b че как

> 2-х битным к-квантом

Цифра 2 в названии есть, а сколько там реально бит?

Exl2 доступна уже очень давно, примеры 70б помещающейся в 24гб врам кто хотел посмотрел, все печально. Начиная с 3.3-3.6 бит и ниже идет очень резкая деградация. О каком бы там скейле толерантности к низкому кванту от размера не говорили, ниже определенного порога это полная печаль, нужен новый подход. И мое не смотря на общий размер будет реагировать как ее одиночные модели, без шансов.

Потестите может ли она в 2д и нсфв

>Потестите

Там надо трансформеров обновлять.

Кстати, грустно, что матрицы не делают на q6, обычно на q3 или q4 в лучшем случае останавливаются. =(

Активность не имеет значения, это 22B, да. Активность двух там капелюшку докинет.

Так что да, оно нивлазит.

На оперативе попробовал и вернулся к мику.

Я подозреваю, что она умнее по объему знаний. Эрудированнее.

Но вот насколько лучше в общении — вопрос хороший.

Проблема в том, что запуская коммандер на теслах видишь 8 токенов в секунду, когда мику 6. Ну и толку?

Но это 35b, они для оперативы были. =) И эта так же.

Плюсую.

Но я постирал, а то диски маленькие на локальных серверках.

*22 или 176 =)

> Neiral

> Neural

=)

ИМХО

Но матрицы и прочие xxxs работают только на третьем кванте нормально. Второй все же слишком туп. Да и третий немного подтупливает.

Я даже когда пробовал коммандера плюс… ну, не зашло в третьем кванте. В пятом норм.

>грустно, что матрицы не делают на q6,

делают, недавно показывал сравнение q6k с матрицей и q8 здесь

вот здесь много к-квантов с матрицец важности: https://huggingface.co/mradermacher

>Но матрицы и прочие xxxs работают только на третьем кванте нормально. Второй все же слишком туп. Да и третий немного подтупливает

я там специально упомянул не i-квант а именно k-квант с матрицей важности. Это две большие разницы. У i-квантов оптимал со всех сторон это 4XS, все что выше понятно лучше. Трешки-i - приемлемо, ну а ниже жизни нет. Кстати i-трешки медленнее чем 4XS. Не знаю доработал ли ikawrakow это.

>Цифра 2 в названии есть, а сколько там реально бит?

можешь посмотреть здесь почти для любого кванта:

https://gist.github.com/Artefact2/b5f810600771265fc1e39442288e8ec9

Графики уровня БОГ.

>делают

Но редко.

Забавно, теперь интересно где ошибка, в длине или в цифре

Вобще я так понимаю это сравнение мультимодалок

мм1-chat это вроде мое?

>мм1-chat это вроде мое?

ХЗ, надо конкретно смотреть, там есть как мое, так и не мое.

https://arxiv.org/abs/2403.09611

Уже месяц сетке, а с ней в треде никто не ролеплеил. Отстаём, господа.

Она же маленькая....

Говно, визуальная часть какой-то крошечный 400м огрызок, не удивительно что Cog нигде в сравнениях нет.

До 30B. Как я понял, с мое они экспериментировали на 3 и 7B, 30 должна быть плотной.

Норм, для самостоятельно трененной сетки, сделать такой результат с нуля/переобучив что то до получения новой сетки не так то просто.

То что они не в топе очевидно, но сетка получившаяся средне-топовой в своем размере - отличный результат которым не грех похвастаться

Так, проделал 300км и вернулся обратно к свиньям на ферму. Купил у грязного барыги аз авито, вместо покупки через грязных кремлевских блядей ака dns.

Качаю дрова на 4070ти шупер.

Удаляю нахуй всю трихомудидию через DDU от P100.

Ставлю как обычно на 4070.

А уже дрова на 3080ти(второй картой) через диспетчер устройств.

Всё верно?

Какие модели накачать на 28 гб?

Шпасибой за советы.

Качаю дрова на 4070ти шупер.

Удаляю нахуй всю трихомудидию через DDU от P100.

Ставлю как обычно на 4070.

А уже дрова на 3080ти(второй картой) через диспетчер устройств.

Всё верно?

Какие модели накачать на 28 гб?

Шпасибой за советы.

>Какие модели накачать на 28 гб?

Разве что коммандер 35 в 4 кванте и с контекстом ну может 8к войдет

exl2 должен меньше жрать чем в ггуфе

Мелочь на 7-11-13-20 уже советовали, вон в шапке есть

Ага, мелочь до 22б вроде накачал.

А почему многие до сих по на ГГУФе? Когда есть GPTQ(мало на него что-то делают последние полгода) и exl2.

>GPTQ

Это только 4 квант, если что то мелкое то на нем тупеет, как те же 7b

ггуф универсален, хоть на процессор выгружай, exl2 только видюхи и то не все, обладатели р40 все равно пыхтят на ггуфе

Так что если у тебя современные видеокарты и есть место - лучше качать exl2 5-6 бит, если не влазит то меньше можно

Потому что теслы не умеют в ггуф. =)

А две 3090/4090 — не только лишь все себе могут позволить.

>Потому что теслы не умеют в ггуф. =)

В exl2 :) На самом деле всё-таки умеют, я пробовал. Генерация идёт неплохо, а вот с обработкой контекста беда.

>А почему многие до сих по на ГГУФе?

12ГБ врама и желание запускать 70B...

Какие сейчас годные TTS к Таверне есть, может кто сказать?

XTTS или появилось что-то поинтересней?

XTTS или появилось что-то поинтересней?

вот кстати годные русские есть?

Пасиба нашел инструкцию к таверне. А xtts на сколько прожорлив? Мнеб чет полегче. Клонирование голоса с нейросетью видится мне высоковатой нагрузкой

> А уже дрова на 3080ти(второй картой) через диспетчер устройств.

Просто ставь последние дрова, вторая карточка сама подсосется.

> Какие модели накачать на 28 гб?

Коммандер, но там очень много кушает контекст, с 4 битами врядли войдет больше 8к, а то и 4.

> А почему многие до сих по на ГГУФе?

Обладетели большой врам тут в меньшинстве а катать ллм хочется всем. Плюс на теслах p40 эксллама плохо работает, по крайней мере пока.

Попробовал подрочить с TheBloke_U-Amethyst-20B-GPTQ.

Это было странно, но круто.

Что сейчас топовое можно скачать для такого?

Это было странно, но круто.

Что сейчас топовое можно скачать для такого?

Около 1 гб вроде бы, не особо помню уже.

Но требовательна к исходному файлу звука.

Ага, поставил и ахуел с того что обе карточки сразу подхватились. Положил около портрета Хуанга просвирочки.

Качаю командер.

Я пока тестанул BagelMIsteryTour-v2-8x7B-4bpw-exl2 alpaca.

Насколько же умнее и разнообразнее пишет чем 13 или даже пресловутый ДаркФорест. Влезли в 26 гб с 12к контестом.

А может кто подскажет, autosplit надо же всегда вкл картами с тензорами?

И по cache_4bit и cache_8bit- обе функции вкл всегда же?

> autosplit надо же всегда вкл картами с тензорами?

Емнип это если ты ленивый и не хочешь сам задавать цифры. Скорее всего будет работать хуже чем ручной подбор, с ним легко по мониторингу выбрать.

> cache_4bit и cache_8bit- обе функции вкл всегда же

Нет, второе - то как будет кэшироваться контекет, первое не помню, но что-то похожее. Помогут загрузить больше но что будет с результатом - хз, обычно они не трогаются.

Коротко о WizardLM-2-7B, первой версии которую снесли

Очень любит советовать и думать за тебя, уводя разговор в сторону

Делает это мягче чем раньше, но раздражает не меньше

По факту на любой вопрос который сетке не понравится может пойти соевая заглушка, сетка ненадежна

Что они хотят выпустить снова, добавив еще говна, мне не понятно, сетка уже испорчена

Очень любит советовать и думать за тебя, уводя разговор в сторону

Делает это мягче чем раньше, но раздражает не меньше

По факту на любой вопрос который сетке не понравится может пойти соевая заглушка, сетка ненадежна

Что они хотят выпустить снова, добавив еще говна, мне не понятно, сетка уже испорчена

Что за шизоидная странная карточка или системный промпт?

А визард всегда был соевиком по дефолту, зато если указать в промте о том как нужно отвечать - отвечал не выебываясь и с фантазией.

Карточка для тестирования внутреннего диалога, там ниче особо и нет.

Ну визард да, соевичек по дефолту. Они наверное первые начали цензуру добавлять в сетки еще в самом начале.

Сетка выглядит умной, но душной. Понапихали защиты от души, используя весь свой опыт.

Попробуй скачай, может сможешь обойти.

Я не особо старался, но по тому как сетка рассуждает, у нее всегда всплывает упоминание незаконности или неуместности чего то и она сворачивает в сторону.

Соя вплетена в датасет плотно так, любые острые вопросы прикрыли

У них был какой-то кусок, который этот эффект давал, и не стали убирать, насколько помню. История давняя, ранные датасеты можно найти.

Хз, 7б неинтересны (кстати это она на русском там отвечает? визард показывал намеки на мультиязычность когда-то), 176б неюзабельны. Если релизнут 70 то может с ней уже играться можно будет. Все прошлые визарды были с определенным настроем, но не лоботомированы как некоторые, потому простой промт инжениринг там все позволял. В крайнем случае cfg.

>кстати это она на русском там отвечает?

Не, там перевод таверны

Вот русский

Но какой там пиздеж, жесть

Короче на русском сетка весьма средне

Какая моделька была, сколько параметров? Мне бы что-то без цензуры погонять, а то из-за позитивной предвзятости моделька инструкции игнорит.

Родина дала контрольные векторы, любую соевую модель можно хоть зиговать заставить, нет, все ищете где сои меньше. Не будет ее меньше уже.

Можно подробнее?

Вот тут все с примерами. Вообще, стоило бы в шапку добавить.

https://vgel.me/posts/representation-engineering/

https://github.com/vgel/repeng/tree/main

Стоит качать Mistral 22B или соя?

Или оставаться на командере?

Покидайте моделей 22-34 поинтересней.

Или оставаться на командере?

Покидайте моделей 22-34 поинтересней.

Прежде чем спрашивать, ты рейтинг аюми глянул?

В олном из прошлых тредов кидали ссылку на статью, где расписывалось, как работает LLM внутри. Может кто еще раз кинуть?

Jay Alamar, "the illustrated transformer"?

Так это же все равно не работает, получается? Как делать бомбу оно не подсказало, а слово психоделик вообще зацензурило. Какой-то пиздец. Спасибо за инфу, в любом случае.

>Стоит качать Mistral 22B или соя?

Не стоит, поломанная модель

>Или оставаться на командере?

Именно так

>Покидайте моделей 22-34 поинтересней.

Смотри, в окрестности 30B конкурентов командиру нет. Так что остается выбор среди тех, что больше 20B и меньше 30 (среди самих 20B куча неплохих), а там только одна модель заслуживает внимания Nethena-MLewd-Xwin-23B. Все другие, в этом диапазоне параметров - поломанные или шизоиды или недоноски (т.е. например расширенный до 28B мистраль - недоносок) недоноски требуют полного файнтюна, а кто будет это делать и нахера?

А есть более подробный гайд? Я не совсем понимаю как использовать библиотеку. Не понимаю как построить датасет. Нет примеров как должен выглядеть json. Как прогнать модельку через датасет.

> Take the difference of the positive and negative example hidden states to get a set of relative hidden states.

> Use single-component PCA on those relative hidden states to get a control vector for each layer.

Вот это не понимаю что такое и как проделать.

> Вот это не понимаю что такое и как проделать.

Так это сама либа repeng делает.

>Насколько же умнее и разнообразнее пишет чем 13 или даже пресловутый ДаркФорест

Пресловутый... между прочим, это вроде единственная двадцатка, которая содержит эребус. И получилось так потому, что во времена когда унди и остальные ебланы шлепали свои мержи как на конвейере, кобольд не выпускал эребус на ламе. Поэтому темный лес отличается от всяких норомейдов, емерхистов и млевдов (они все по большому счету последы мифомакса). В Дарк форест есть шарм из времен эребуса на опт.

Только эребус туповатая модель. Но чего ни сделаешь, чтобы хоть немного отдохнуть от сои, да?

анон, они удалили и старые модели тоже, а новый визардлм-2 соевый по максималкам.

Ну, там скорость ниже, чем в ггуф, причем заметно.

Запустить можно, но заставляет грустить, ибо на современных видяхах… сколько там, в полтора, в два раза бывшая быстрее Жоры?

Я пока удовлетворен coqui (xtts), поэтому даже не интересовался.

2 -> 3 гига в пика.

> Короче на русском сетка весьма средне

Да вроде по этому отрывку прилично. Что важнее - у него структура предложений выглядит естественной и привычная для языка, чем у того же опенчата, например. Не просто дословный перевод с сохранением позиций, но и активное использование оборотов, пассивных залогов и т.п.

А по содержимому - возможно тупеет, нужно проверять.

И тут ты такой берешь и десоефицируешь контрольным вектором того же визарда 2. 7б, отсутствие ресурсов не будет аргументом.

> Nethena-MLewd-Xwin-23B

Это из 13б слеплена?

> недоносок

Скорее мертворожденный, лол

> они удалили и старые модели тоже

Из старых там интересен только v1.2-13b, есть много где.

https://www.reddit.com/r/LocalLLaMA/comments/1c5vx0z/13b_models_are_much_more_capable_than_youd_think/

Еще один парень догадался что мелкие модели становятся умнее с самоинструкциями по типу внутреннего диалога.

Коротко о том как заставить работать мелкие модели

Еще один парень догадался что мелкие модели становятся умнее с самоинструкциями по типу внутреннего диалога.

Коротко о том как заставить работать мелкие модели

Ищу блок на 4 карты Tesla P40.

Не могу понять почему эти блоки такие дешевые. И чем грозит установка такого блока?

Не могу понять почему эти блоки такие дешевые. И чем грозит установка такого блока?

Хочу купить вот такой блок на 4 Теслы. Норм?

https://market.yandex.ru/product--blok-pitaniia-julongfengbao-lx2000w/1786465148?sku=101875295832&uniqueId=687767

https://market.yandex.ru/product--blok-pitaniia-julongfengbao-lx2000w/1786465148?sku=101875295832&uniqueId=687767

Откуда у вас эти познания? Как стать таким же, как и вы?

да, тупая модель, это то понятно,тут важно что ее датасет привносит свою ауру в франкенмерж.

да из 13-тых.

>Как стать таким же, как и вы?

В чем именно? Просто тыкая сетки и разбираясь в том как они работают ты нагонишь 90% обитающих тут.

Если хочется тренить сетки и делать с ними другие богомерзкие смешивания или манипуляции то нужно уже иметь доступ к железу и опять таки читать статьи и набираться опыта.

Слабоват.

мимо взял для одной Теслы б/у блок от майнинг-фермы за 2,5к рублей и всем доволен, проводов только дохуя

Давно уже писал цинкинг-промпты для мистралей и Клода Надо на Командере попробовать, он инструкции неплохо соблюдает.

>Слабоват.

А что, ватты в таких блоках до сих пор китайские? :)

Смотрю на авито в основном от той же фирмы дуйвхуйнаврот, что и тут

Новые модели за сегодня

https://www.reddit.com/r/LocalLLaMA/comments/1c61k7v/zamba_a_7b_mambalike_ssm_hybrid_model_trained_for/

https://www.reddit.com/r/LocalLLaMA/comments/1c5mgj0/codeqwen_15_is_out_with_gqa/

https://www.reddit.com/r/LocalLLaMA/comments/1c64vyt/new_7b_merge_models_wizardlaker7b_dolphinlake7b/

https://www.reddit.com/r/LocalLLaMA/comments/1c5sfy7/araneatenebris120b_creative_writing_rp_grid/

Первая самая интересная, как уменьшенная версия jamba, но на 7b

Предварительные тесты показывают производительность cхожую с мистралем 7b, есть базовая модель на сколько я понял

https://www.reddit.com/r/LocalLLaMA/comments/1c61k7v/zamba_a_7b_mambalike_ssm_hybrid_model_trained_for/

https://www.reddit.com/r/LocalLLaMA/comments/1c5mgj0/codeqwen_15_is_out_with_gqa/

https://www.reddit.com/r/LocalLLaMA/comments/1c64vyt/new_7b_merge_models_wizardlaker7b_dolphinlake7b/

https://www.reddit.com/r/LocalLLaMA/comments/1c5sfy7/araneatenebris120b_creative_writing_rp_grid/

Первая самая интересная, как уменьшенная версия jamba, но на 7b

Предварительные тесты показывают производительность cхожую с мистралем 7b, есть базовая модель на сколько я понял

Предположим, что я напишу в промпте:

"Перед тем, как что-нибудь сказать или сделать, {{char}} должен подумать о том, к каким последствиям могут привести его действия или слова. Мысли {{char}} должны быть выделены символом *". Не уверен в формулировках и формате, кто знает лучше - поправьте. И ещё вопрос: если я не хочу видеть "мысли" персонажа - в Silly Tavern есть возможность не показывать текст, заключенный в определённые тэги, отделённый какими-нибудь символами или что-нибудь подобное?

"Перед тем, как что-нибудь сказать или сделать, {{char}} должен подумать о том, к каким последствиям могут привести его действия или слова. Мысли {{char}} должны быть выделены символом *". Не уверен в формулировках и формате, кто знает лучше - поправьте. И ещё вопрос: если я не хочу видеть "мысли" персонажа - в Silly Tavern есть возможность не показывать текст, заключенный в определённые тэги, отделённый какими-нибудь символами или что-нибудь подобное?

Самое главное дай пример сообщения чара, где он думает и действует так как ты ожидаешь. В том формате который тебе нужен.

И тогда сетка подхватит это поняв что от нее нужно. Без примера сетки обосрутся, в большей части случаев

Используй классический аромат для CoT (chain of thought) - "let think step by step..."

Я допер как добавить свою модель в LM Studio.

Короче надо перейти в пик1. Мои модели.

Там тыкаем и открываем нашу стандартную папку, куда будут скачиваться модели. Это папка на винде из домашней папки .cache\lm-studio\models

Вот в папке models нужно создать папку, в ней еще папку, а там уже кидать модели. пик2

Первая это я скачал самое мелкое на пробу, посмотреть куда и как кинет модель. Второе уже я создал, тупо папка, папка, и там модель. После перезахода в LM Studio оно начинает видеть твою модель, если ей что то не нравится то пишет и подсказывает как надо правильно.

Ну теперь буду пытать AnythingLLM и чё оно могёт, если успешно подрублюсь к серверу запускаемому в LM Studio

По человечески сделать добавление своей модели одной кнопкой из меню они не догадались

Короче надо перейти в пик1. Мои модели.

Там тыкаем и открываем нашу стандартную папку, куда будут скачиваться модели. Это папка на винде из домашней папки .cache\lm-studio\models

Вот в папке models нужно создать папку, в ней еще папку, а там уже кидать модели. пик2

Первая это я скачал самое мелкое на пробу, посмотреть куда и как кинет модель. Второе уже я создал, тупо папка, папка, и там модель. После перезахода в LM Studio оно начинает видеть твою модель, если ей что то не нравится то пишет и подсказывает как надо правильно.

Ну теперь буду пытать AnythingLLM и чё оно могёт, если успешно подрублюсь к серверу запускаемому в LM Studio

По человечески сделать добавление своей модели одной кнопкой из меню они не догадались

https://www.reddit.com/r/LocalLLaMA/comments/1c5pwad/merged_into_llamacpp_improve_cpu_prompt_eval/

Ускорение обработки промпта на профессоре, местами до 5 раз.

Ускорение обработки промпта на профессоре, местами до 5 раз.

И где они были, когда я Теслу ещё не купил?

Я правильно понимаю, что перед теслами лучше прикрутить карту по мощнее и современнее, чтоб она контект обрабатывала и вот это вот все?

Смотря что ты имеешь в виду под

>контект обрабатывала

Ты вполне можешь юзать Теслу как основную карту, а вторую просто как затычку для видеовывода.

Подскажитье какой файнтюн/микс mixtral 8x7b лучше всего себя показывает в РП.

Noromaid не плох

psyonic-cetacean

Мне, конечно, идут еще ссдшки… Но я планировал их продавать, а не пихать в комп…

Кстати, фанфакт, но у меня ссдха висит на скотче на углу корпуса, потому что я снял корзину для дисков, чтобы в древний корпус влезли теслы. =)

>чтобы в древний корпус влезли теслы. =)

Напомни плиз сколько у тебя этот мистраль при частичной разгрузке в ОЗУ токенов даёт и сколько Comand-r plus. С учётом двух тесл.

Мистраль - в смысле 8x22

Приобрёл себе Tesla P40. Стал изучать разные колхозные способы её охлаждения.

В данном видео https://www.youtube.com/watch?v=WfKQP2sARGY сравнивается эффективность различных типов вентиляторов. Если резюмировать, то наиболее эффективным является только большой турбинный/центробежный вентилятор, обычные тихоходные не обеспечивают нужный поток, а мелких высокооборотистых (серверных) может потребоваться сразу два, что ещё больше увеличивает шум.

Далее на фото плат M40 и P40 я заметил, что на них есть нераспаянный коннектор под вентилятор - пикрил. У родственной Quadro P6000 коннектор распаян и используется по назначению (демонстрация платы тут https://www.youtube.com/watch?v=RnqdoLabIz4 ).

И тут мне стало интересно, а может данные пины у P40 вполне рабочие и на них можно повесить нормальный вентилятор с PWM? Может кто-нибудь мультиметром замерить напряжение?

Интредастинг, смотрите какая штука.

https://kolinko.github.io/effort/

>At 25% effort it's twice as fast and still retains most of the quality.

>You can also freely choose to skip loading the least important weights.

Т.е. вариация на тему горячих/холодных нейронов, поднимающая в пару раз скорость инференса на GPU в которые не влезает вся сетка.

https://github.com/kolinko/effort - но реализация только для маков и микстраля пока.

https://kolinko.github.io/effort/

>At 25% effort it's twice as fast and still retains most of the quality.

>You can also freely choose to skip loading the least important weights.

Т.е. вариация на тему горячих/холодных нейронов, поднимающая в пару раз скорость инференса на GPU в которые не влезает вся сетка.

https://github.com/kolinko/effort - но реализация только для маков и микстраля пока.

Любая модель так станет лучше и точнее, статью про это скидывали где даже замеры были. Так для рп простейший прокси с двойным запросом пилил еще давно, оно действительно лучше отвечает, но прямо существенного буста чтобы "как большие" не было. Может если поиграться и развить то будет лучше, всяко перспективнее чем просто "скрытые мысли" и аналогичная задержка до первых токенов.

Первая реально интересна, тестил кто?

> Предположим, что я напишу в промпте:

Да, это сработает. Может быть конфликт к имеющимся в чате, потому подобное на коммерции предпочитают пихать в префилл/инструкцию перед ответом.

> если я не хочу видеть "мысли" персонажа

В идеале здесь двойной запрос с разными инструкциями, простой cot слабее.

> но прямо существенного буста

Просто люди до сих пор не научились писать правильно карточки и промты + инструкции. Причем не важно для кума это или просто для работы.

Очень часто вижу как люди используют обычный текст без разметки для персонажей. Не составляют лорбуки и тд.

Хотя лорбуки и карточки персонажей это не только для кума и рп. Это можно использовать и для работы.

Я одному челу прогрескую модель ставил. 13б вроде бы. Сделал ему в таверне карточку. Указав в инструкциях все что касается кодинга. Со временем доработали. Сделал ему лорбук, в котором указал нюансы языка программирования.

Это фактически набор инструкций получился. И моделька стала не только хорошо кодить но и править его собственный код.

С кум моделями тоже самое. Как и с рп. Модель может быть и 7 и 13 да хоть 128. Но будет тупить без нормальных инструкций.

Разбил ответ на две части.

И тоже самое касается квантизации или тренировки модельки для обьединению в лору. Можно натренировать уже готовую модель и смержить ее с твоими инструкциями в лору. Тогда точность повышается еще больше.

Конечно отжирание контекста будет. Но контекст не так важен например в рп модели. Потому что если ты не триггеришь что то новое - не будет происходит сканирование всей базы. Только последние ответы.

Если же говорим про рабочие модели - там происходит сканирование всего контекста. Так как лорбук например или лора модель будет выступать доп. базой данных. Тут уже лучше не скупиться на контекст.

А вот 7-13-2х8 и тд это уже мало важно.

Две недели в треде не был. Что там, командира запустили-таки? Как оно? Микстраля ебет? А Мику?

> Первое место по рейтингу ayumi

@

Высираемый output:

> My true Yandere self wouldn't hesitate to safeguard us from any harm

Либо я что-то делаю не так, либо пока что ллм не работают.

@

Высираемый output:

> My true Yandere self wouldn't hesitate to safeguard us from any harm

Либо я что-то делаю не так, либо пока что ллм не работают.

>Две недели в треде не был. Что там, командира запустили-таки? Как оно? Микстраля ебет? А Мику?

Мику сам кого угодно выебет. Микстралей теперь два - маленький и большой. У большого уже был выкидыш - микстраль-22. Командир однозначно ебет всех на русском. А так, вот тесты у минимально приемлемого кванта

c4ai-command-r-v01-imat-IQ4_XS.gguf

ARK: 73.9931 +/- 1.4889

MMLU: 40.9561 +/- 1.2503

TruthfulQA: 34.0269 +/- 1.6586

Hellaswag: 84.1765 +/- 0.3642

PPL = 6.8445 +/- 0.04394

> Очень часто вижу как люди используют обычный текст без разметки для персонажей.

Это не проблема.

> Не составляют лорбуки и тд.

Рофлишь? Нужно редко, ведь даже локалки нынче знают множество лоров.

> Модель может быть и 7 и 13 да хоть 128. Но будет тупить без нормальных инструкций.

> Но контекст не так важен например в рп модели.

Че-то ты вообще херню какую-то мелешь.

Всех ебет, особенно по потреблению на контекст, лол. Субъективно, но в рп легко может обходить и мику, микстраль с рождения в канаве, новый-большой можешь попробовать, но он очень жирный. А главный ебатель нынче коммандер-плюс.

>Если резюмировать, то наиболее эффективным является только большой турбинный/центробежный вентилятор

Он тупо сделал нормальный кожух только к огромной улитке, а остальные тестируемые вентиляторы мало того что были в несколько раз слабее, так ещё и подавали воздух под углом последний так вообще 90 градусов

Такой себе тест.

>заметил, что на них есть нераспаянный коннектор под вентилятор

А вот эта любопытная тема. Но кулеры обычной видеокарты всё равно управляются программно через драйвер, а в драйвере Теслы такой опции нет. Так что тебе для управления оборотами всё равно придётся юзать софт вроде фан контрола. Так что если у тебя на атеринки есть свободные SYS FAN выводы, то эта распайка тебе нахуй не нужна.

>Либо я что-то делаю не так, либо пока что ллм не работают.

У многих работает, у тебя не работает. Так может ты промпт формат не настроил? Или крутишь 3 квант какой нибудь.

Опять же если карточка херовая то даже нормальная модель не догадается что с ней делать.

Ну и 35 рассеянный немного, да хорошо на русском шпарит, но коммандер + все таки полноценней.

Но например 35 ебет в раг и работе с документами и выполнением кучи инструкций, что и есть по факту рп-ерп.

> Ну и 35 рассеянный немного

Что вкладываешь в это понятие? Как раз наоборот кажется очень собранным и внимательным, нет рассеянности 7б, которые игнорят контекст и просто что-то фантазируют. Может только фантазий ему не хватает в самом начале на абстрактных сеттингах, но все равно в тему отвечает.

Конкретно этот высер был на Neural Chat V3 16k 7B q8_0

> У многих работает, у тебя не работает. Так может ты промпт формат не настроил?

Разные пресеты пробовал.

> Или крутишь 3 квант какой нибудь.

8.0 Ну может где с чем-то и обосрался конкретно с этой моделькой, раз уж ее результаты хуже силикон меиды, на которой я обычно гоняю. Но опять же, все, что на базе мистрэля, какое-то совсем уж соевое. В угоду сои эта хуйня игнорит инструкции. Просто ей похуй.

> Опять же если карточка херовая то даже нормальная модель не догадается что с ней делать.

Опять же, карточки разные, а проблема одинаковая. Персонажи просто отказываются быть злыми, эгоистичными и отрицательными. Даже когда я нейронке напрямую прямо в промпт пишу инструкцию вроде [Charactername becomes obsessive, angry and scary] ей абсолютно похуй. Может 7В это просто хуевая моделька, но у меня почему-то такое чувство, что она не очень и тупая, просто bias зашкаливает. Особенно у всего, что на мистрэле делалось.

> Ну и 35 рассеянный немного, да хорошо на русском шпарит, но коммандер + все таки полноценней.

> Но например 35 ебет в раг и работе с документами и выполнением кучи инструкций, что и есть по факту рп-ерп.

Круто, наверное. Но ждать ответ по полчаса минимум приходится и квант 3xs. И это обычный командир, без плюсов. Наверное оно того не стоит.

>Конкретно этот высер был на Neural Chat V3 16k

Понятно, нейрал чат действительно соевый.

Попробуй тупо рекомендацию из шапки, Fimbulvetr-10.7B-v1

Он хорош, или вторую его версию Fimbulvetr-11B-v2, или предыдущую Frostwind-10.7B-v1

Все от одного автора, кстати у него там и рекомендации по ним есть на обниморде

>Что вкладываешь в это понятие?

Может дело было в моем промпт формате( который я так до конца и не настроил) или карточке, или улиточной скорости даже на 4 кванте.

Просто показалось что модель не знала что делать

Надо наверное было оставить инструкции о том что это чат и тд из системного, а то я без них катаю

> у минимально приемлемого кванта

c4ai-command-r-v01-imat-IQ4_XS.gguf

С него начинал, но в итоге остановился на c4ai-command-r-35b-v01-iq2_xs.gguf

Обидно, но в теслу с 4к контекстом ничего больше не влазит, а частичная выгрузка в оперативку снижает скорость с 6-8 до 2 т/с, с тем же успехом можно на проце запускать.

Ты делаешь не так:

смотришь в рейтинг аюми.

Сейчас обновлюсь и потестирую полноценно.

А куда смотреть?

Короче немного потыкав остановился на таком промпт формате для коммандера

Системная подсказка начинается с <|CHATBOT_TOKEN|> патамушта у меня карточка от первого лица

А значит в описании модель говорит о себе от своего лица, значит и писать должна она, по логике

Если у кого то просто инструкция-карточка, то ее давать скорей всего от лица пользователя и нужен <|USER_TOKEN|>

Вроде в командной строке все нормально оборачивается, хотя мог что то проглядеть

Системная подсказка начинается с <|CHATBOT_TOKEN|> патамушта у меня карточка от первого лица

А значит в описании модель говорит о себе от своего лица, значит и писать должна она, по логике

Если у кого то просто инструкция-карточка, то ее давать скорей всего от лица пользователя и нужен <|USER_TOKEN|>

Вроде в командной строке все нормально оборачивается, хотя мог что то проглядеть

Есть хорошие гайды по карточкам и промпту?

Хотя с другой стороны с пустой системной инструкцией тоже работает может быть даже лучше, лол

Если у меня 4 врам и 32 рам, то смогу как то зотя бы 7б можели запустить?

> то смогу как то зотя бы 7б можели запустить?

Сможешь и 12б

LLAMA 3B needs at least 4GB RAM

LLAMA 7B needs at least 8GB RAM

LLAMA 13B needs at least 16GB RAM

LLAMA 30B needs at least 32GB RAM

LLAMA 65B needs at least 64GB RAM

32 layers with LLAMA 7B

18 layers with LLAMA 13B

8 layers with LLAMA 30B

Я на таком нового коммандера 35b кручу в 4 кванте, но меееедленнно

7-11 - пойдут со скоростью чтения

Ну опять таки зависит от твоей оперативки, если это ддр5 то все веселее. Или хотя бы быстрая ддр4

Только совет - не скидывай никакие слои на видюху, с 4гб толку не будет даже на мелкой 7b, только медленнее будет генерация. По крайней мере у меня так.

Спасибо.

Ддр5 6400. Хватит?

Выглядит как то больно оптимистично? А сколько квантов в секунду

> Выглядит как то больно оптимистично? А сколько квантов в секунду

Это с офф гита ламы. И такие графики достаточно приблизительны. Можно в 7б обычную пихнуть карточку на 3к токенов и она будет пердеть как какаянибудь 30+б.

Короче это приблизительно все. Естественно какая нибудь 2х7 = 14б или там 3х13 = 39

>Ддр5 6400. Хватит?

2 канала? Тогда заебись, там скорости под 80гб/с

Ну, модели размером 8 гб будут выдавать токенов 8-10 в секунду. Запусти аиду и протестируй там скорость чтения рам, потом просто дели скорость в гб/с на размер модели и ты получишь примерное количество токенов в секунду. В реальности будет меньше, там ведь кроме модели еще и контекст будет обрабатываться в оперативке и место занимать.

>большой микстраль

Ого, а слона-то я не приметил. Как он - гпт наверное ебет? Чего это они так расщедрились-то? Или рассчитывают что никто такого гигантского монстра запускать не будет?

> Просто показалось что модель не знала что делать

А ну такое есть в начале или при отсутствии должного контекста. Ей буквально не хватает рп файнтюна чтобы с порога вещать затягивающие истории по шаблонам и их сочетаниям, и чуточку хуже знание фандома. Вот и начинает рандомить, упарываться спгс и как-то выворачиваться из ситуации, и это может не совпадать с ожиданиями. Но зато это компенсируется пониманием промта и не дает побочек с бондами и шизой. Хотелось бы увидеть его файнтюн от Мигеля, или все поломается, или будет просто топчик.

По бенчмаркам ебет. Есть немалый шанс что будет и приятен в общении и достаточно функционален, размер кусков уже порядочный и модель вроде относительно свежая.

> Чего это они так расщедрились-то?

Хз, словили тонны хейта за продажу мелкософту и реактивное переобувание, вот теперь и оправдываются.

Mixtral-8x22B-v0.1-q5_K_M

row_split работать отказался, разбираться особо не стал. Поэтому мы имеем пики по нагрузке. Но недолгие, ибо из 45 гигов юзается лишь четверть и пробегается довольно быстро.

25 слоев на две теслы, контекст 4096.

Возможно, контекст можно поднять до 6 или 8 тысяч.

2.3 токена/сек

Это максимум, чего я смог добиться.

llama_print_timings: load time = 8923.29 ms

llama_print_timings: sample time = 75.68 ms / 611 runs ( 0.12 ms per token, 8073.47 tokens per second)

llama_print_timings: prompt eval time = 8922.61 ms / 292 tokens ( 30.56 ms per token, 32.73 tokens per second)

llama_print_timings: eval time = 256553.02 ms / 610 runs ( 420.58 ms per token, 2.38 tokens per second)

llama_print_timings: total time = 266909.86 ms / 902 tokens

Output generated in 267.20 seconds (2.28 tokens/s, 610 tokens, context 292, seed 911438443)

row_split работать отказался, разбираться особо не стал. Поэтому мы имеем пики по нагрузке. Но недолгие, ибо из 45 гигов юзается лишь четверть и пробегается довольно быстро.

25 слоев на две теслы, контекст 4096.

Возможно, контекст можно поднять до 6 или 8 тысяч.

2.3 токена/сек

Это максимум, чего я смог добиться.

llama_print_timings: load time = 8923.29 ms

llama_print_timings: sample time = 75.68 ms / 611 runs ( 0.12 ms per token, 8073.47 tokens per second)

llama_print_timings: prompt eval time = 8922.61 ms / 292 tokens ( 30.56 ms per token, 32.73 tokens per second)

llama_print_timings: eval time = 256553.02 ms / 610 runs ( 420.58 ms per token, 2.38 tokens per second)

llama_print_timings: total time = 266909.86 ms / 902 tokens

Output generated in 267.20 seconds (2.28 tokens/s, 610 tokens, context 292, seed 911438443)

> Ей буквально не хватает рп файнтюна чтобы с порога вещать затягивающие истории по шаблонам и их сочетаниям

Вот да, согласен. Чувствуется что модель просто не из рп серии, вот и нужны все те подсказки которые я удалил из систем промпта. Ну, так даже лучше, более универсальная хоть.

Неплохо, я 35 то еле 1.5-2 вытягиваю. Как по ощущению? Отсутствие промпт формата не влияет? Там вроде уже инструкт модель выпустили.

Никуда, сюда https://huggingface.co/spaces/lmsys/chatbot-arena-leaderboard, спрашивать в треде, в шапку.

ИСКАТЬ ДУШОЮ

Спасибое.

Сможешь и коммандера, но медленно.

В карту — контекст.

В оперативу — модель.

Да, все верно.

Хорошечно.

1. Нет. Это к коммандеру.

2. Потому что коммандер плюс вышел в опенсорс и выеб половину старых моделей чатгопоты и клауда, заняв 5 строчку в рейтинге.

3. Вот, запустил, потестил.

У меня и так две работы, созвоны, спектакли, консультации, когда мне все это тестить. =')

Я микстраль новую толком не гонял.

А инструкт даже еще не качал.

Так что точно сказать не могу, как она.

Сейчас бы коммандера помучать, посмотреть.

>Хз, словили тонны хейта за продажу мелкософту и реактивное переобувание, вот теперь и оправдываются.

А мне кажется они просто неликвид выбросили, который покупать никто не будет, потому что это дрянь на капелюшечку лучше 35В модели и значительно хуже 70В, при этом 176В и соответствующим потреблением ресурсов.

https://www.reddit.com/r/LocalLLaMA/comments/1c6ehct/codeqwen15_7b_is_pretty_darn_good_and_supposedly/

Супермега сетка для кодирования

Есть любопытные погромисты? Потыкайте, мои навыки программирования обойдет 3b сетка

Ну, есть и другие мнения

https://www.reddit.com/r/singularity/comments/1c6e3q1/8x22b_instruct_is_out_it_significantly/

Супермега сетка для кодирования

Есть любопытные погромисты? Потыкайте, мои навыки программирования обойдет 3b сетка

Ну, есть и другие мнения

https://www.reddit.com/r/singularity/comments/1c6e3q1/8x22b_instruct_is_out_it_significantly/

>Ну, есть и другие мнения

Там заряженный чел проигнорировал что модель может и использует всего 39В и работает со скоростью 39В, но в память-то нужно загрузить все ебаные 176В.

Просто купи больше памяти гы

Можно сделать простые выводы за последний год - увлечение нейронками занятие недешевое, особенно большими.

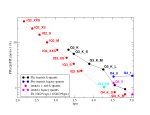

С точки зрения качества ответов/к скорости генерации на одном оборудовании, оно обходит 70b и 100b

О чем и речь там на пикче

https://www.reddit.com/r/LocalLLaMA/comments/1c6i5dz/effort_a_possibly_new_algorithm_for_llm_inference/

Что то про новый метод запуска сеток частично

Что то про новый метод запуска сеток частично

>С точки зрения качества ответов/к скорости генерации на одном оборудовании

А если мерять не в попугаях, то имея А100 ты загрузишь на нее Мику + дохуя контекста, чем это дерьмо в низком кванте еще и без контекста.

Проблемы бедных, я вот и мику не запущу и че теперь? Разговор не о возможности запуска, а о качестве ответа к скорости генерации. Ну или че там конкретнее на графике меряется, хз

>Проблемы бедных

>качестве ответа к скорости генерации

Давай я поясню в чем тут проблема. Это метрика и нацелена на бедных, потому что "эффективность за минимальные затраты" заинтересует только их, богатому просто нужна эффективность, имея неограниченный бюджет лучше потратиться чуть больше но запустить более лучшего командира плюс в хорошей скорости, например(ему кстати намеренно рейтинг занижен на пикче). А бедному уже покупка железа для запуска 176В модели с производительностью 39В уже вылетит в копеечку и себя не окупит, ведь можно было потратиться в 4 раза меньше и получить коммандира, который хуже процентов на 5. Т.е. метрика лжет в самом главном, подменяя понятия и вводя дураков в заблуждение.

command-r-plus-q5_K_M

row_split включен, но есть пики, видимо делится все с оперативкой в хитром виде. Но прирост ~10% над инференсом без row_split заметен.

40 слоев на две теслы, контекст 4096.

1.2 токена/сек

Это максимум, чего я смог добиться.

llama_print_timings: load time = 5442.93 ms

llama_print_timings: sample time = 487.54 ms / 640 runs ( 0.76 ms per token, 1312.72 tokens per second)

llama_print_timings: prompt eval time = 5442.33 ms / 188 tokens ( 28.95 ms per token, 34.54 tokens per second)

llama_print_timings: eval time = 510103.35 ms / 639 runs ( 798.28 ms per token, 1.25 tokens per second)

llama_print_timings: total time = 525008.12 ms / 827 tokens

Output generated in 525.30 seconds (1.22 tokens/s, 639 tokens, context 221, seed 648649457)

row_split включен, но есть пики, видимо делится все с оперативкой в хитром виде. Но прирост ~10% над инференсом без row_split заметен.

40 слоев на две теслы, контекст 4096.

1.2 токена/сек

Это максимум, чего я смог добиться.

llama_print_timings: load time = 5442.93 ms

llama_print_timings: sample time = 487.54 ms / 640 runs ( 0.76 ms per token, 1312.72 tokens per second)

llama_print_timings: prompt eval time = 5442.33 ms / 188 tokens ( 28.95 ms per token, 34.54 tokens per second)

llama_print_timings: eval time = 510103.35 ms / 639 runs ( 798.28 ms per token, 1.25 tokens per second)

llama_print_timings: total time = 525008.12 ms / 827 tokens

Output generated in 525.30 seconds (1.22 tokens/s, 639 tokens, context 221, seed 648649457)

>Т.е. метрика лжет в самом главном, подменяя понятия и вводя дураков в заблуждение.

Дык не лжет, а неучитывает

Там просто 2 оси, производительность в попугаях в тесте MMLU к количеству активных параметров. И по количеству активных параметров новый микстраль дает лучший результат. Если бы там сравнивалось общее количество параметров тогда да, коммандер+ был бы лучше

>производительность в попугаях в тесте MMLU к количеству активных параметров

Т.е. хрень к хрени.

Ну, не совсем. В каком то специализированном варианте, тоесть как бы с 1 вариантом "экспертов" сетка похожего размера выдаст аналогичную производительность, пусть и в узкой области. Тоесть если все параметры сетки будут активными, то при 40-45b сетка имеет шансы стать лучше того же 35b коммандера который располагается на графике ниже.

Может на 5 пунктов от текущего микстраля, но это такой теоретически доступный сейчас максимум.

Через OpanAI API-like можно что угодно подключить к VSCode или JetBrains через плагин Continue.

———

Частота памяти 3600, псп че-то там 52+, теслы грелись до 50°, в среднем 40° держали.

Что я могу сказать по результатам своего теста.

У Микстрали 57 слоев, из которых выгружается 25 (может 26 можно впихнуть).

У Коммандера 64 слоя, из которых выгружается 40.

Очевидно, что неполная выгрузка плохо работает с МоЕ, и какого-то высокого прироста мы не наблюдаем. Фактически, прирост составляет 1,3 => 2,3, 77%

А вот коммандер дает с ~0,5 до 1,2, то есть 140%, в 2,4 раза, это приятно.

Однако, проблема коммандера в жоре контекста.

А микстраль на теслу смысла, кмк, не имеем.

Квант взять пожиже? Думаю на 4 спокойно должно работать без падения качества. Может даже на 3 с чем то

> погромисты? Потыкайте

Учитывая общий уровень сообразительности 7B, я бы не ждал ничего особенного. До этого тестил deepseek 6.7b, мозгов там явно не хватало. Проблемные места фиксить не может, даже не понимает, в чём проблема, переписывает "то же самое другими словами" вместо реальных правок. У визарда 33b дела с этим чуть получше, но тоже вышеуказанный эффект иногда проявляется. Когда началось, я из-за низкой скорости уже не стал упорствовать, и пытаться выбить из сетки правильное решение, так что не знаю, справляется ли она в конце концов с такими "лупами бесполезных правок".

Просто комменты там довольно воодушевляющие, от людей что уже щупали предыдущие сетки для кодинга

>справляется ли она в конце концов с такими "лупами бесполезных правок"

Гопота не справляется.

>А вот коммандер дает с ~0,5 до 1,2, то есть 140%, в 2,4 раза, это приятно.

Спасибо за тесты. Приятно-то оно конечно приятно, но не совсем. Если уж потратился на две теслы и сопутствующее оборудование, то ожидаешь лучших результатов, но увы. Есть однако надежда, что поддержку Command-r для лламаспп допилят. А пока увы.

Ну наконец вменяемый ролеплей на великом и могучем и на нормальной скорости. Наконец можно удалить ебаную 7b сайгу.

> 2.28 tokens/s

Это печально, столько на (мощном) профессоре выдает, от видимокарт и нету смысла особо.

> на капелюшечку лучше 35В модели

Это 104б модель, так что вполне.

Другое дело что микстраль еще с первой версии был надрочен на бенчмарки и зирошоты, а в чем-то более сложном - 7б как 7б, только разнообразнее. Врядли они отказали себе в подобном подходе в случае с новыми микстралем, но он сам по себе за счет размера уже должен быть умным.

А у вас специфичные вкусы

Сетку хоть указывай когда хвастаешься

Возможно.

Плюс, у кого DDR5 — тоже будет побыстрее.

Но целиком коммандер плюс залазил iq3xxs и он туповатый, ИМХО. Прям заметно не то.

Но может четверка будет норм.

Однако тестить я не планирую, энивей.

Вообще, по-хорошему, это (коммандер плюс с 66 гигов веса) уже уровень 4 тесла. Кому нужна топ-5 сетка — хороший стимул взятб мощный серверник, напихать туда тесл или даже 3090, и крутить это с высокой скоростью.

Даже можно взять 3 теслы и q4_K_M.

А в две теслы логичнее запихать Мику, которая там уже «летает» 4-6 токенов/сек, а в одну даже коммандер поместится простенький.

Но это вкусовщина, офк.

К сожалению, сходу достать третью теслу и подходящую материнку я не могу, тут уж без тестов. =)

>А у вас специфичные вкусы

Просто старая карточка которую я для сберовской ругпт делал.

>Сетку хоть указывай когда хвастаешься

Очевидный командир.

Эта карточка уже мелькала в треде.

…

Возможно год назад. =)

Так-то да, поэтому я пока остаюсь на мику. Она не критично глупее микстрали и коммандера, чтобы терпеть. 3-5-кратный разрыв.

Думаю, какой-нибудь h8-5.5bpw commander на двух 5090 может быть действительно хорош в будущем.

Ну я просто.

Слюни пустил.

Забейте.

> Просто старая карточка которую я для сберовской ругпт делал.

Да-да, помню. ) Кекал тогда.

Нормально, и так хорошие тесты показывающие текущую скорость.

Собирать себе такой сервер, это уже какой то организации свой локальный сервер llm делать и у себя крутить. В принципе уровень топ-5 сетки на текущий момент это уже неплохо, для каких то дел которые не должны уходить на сторону. Всяко лучше 7b, лол

> Даже можно взять 3 теслы и q4_K_M.

Хз что там в жоре, врядли лучше чем с бывшей лламой, но пока не оптимизировали контекст с 72 гигами будет тяжко. Контекст кушает много, потому даже лишний бит кванта не столь большой импакт вносит как несколько тысяч токенов. Даже на 96 там особо не разгуляешься и о заявленных 128к только мечтать.

Мику норм, но в рп уже поднадоела. Ей точно также просится тренировка, и если со вниманием на контекст там все норм, то желание постоянно закончить и перевести тему, даже вопреки указаниям, бывает напрягает. Потому даже 35б смотрится свежо и интересно, они друг друга стоят в общем со своими плюсами и минусами.

Если кто на новом микстрале будет (е)рпшить - скиньте как он описывает какие-нибудь интересные сцены взаимодействий, жесктокости/любви, обнимашек, ебли.

>Она не критично глупее микстрали и коммандера

По всем тестам она обходит командира, обходит большого микстраля и уступает только большому инструкт-мистралю.

Другое дело что увидеть результаты её тестов в LLM бенчамарке это квест - она там скрыта в настройках по умолчанию и нарочно маркирована неправильным количеством параметров, чтобы даже с правильными параметрами не показаться среди 70В моделей

Я тут коммандера 35b 4_0 квант завел кое как, щас допилил под него карточку и задаю обычные загадки.

Ну, это явно умнее всего что я щупал локально. Русский так же хорош.

У меня только одна норм карточка ассистента, лень делать что то еще, так что проверю на ней.

На сестре спотыкается, видимо надо запускать только инструкт режим не долбля сетку еще и русским с рп одновременно.

Ну, это явно умнее всего что я щупал локально. Русский так же хорош.

У меня только одна норм карточка ассистента, лень делать что то еще, так что проверю на ней.

На сестре спотыкается, видимо надо запускать только инструкт режим не долбля сетку еще и русским с рп одновременно.

Ну с подсказками и дурак поймет. Но не каждая сетка, мдэ

Короче говоря сетка лучше меньших своих братьев, загадки показывают понимание сеткой описываемой ситуации. С книгами сетка уловила суть, с сестрой только с подсказкой.

Скинь все тесты в тред, анонче

Тебе загадки скинуть или ответы сетки на них?

Загадки скинь, ответы я и так прочел на скринах да и зачем они мне, а загадки я сам хочу позадавать.

Я уже как то кидал, вот небольшой список от простых к сложным. Просто найди детскую книжку загадок и задавай, это я просто стащил у анонов что когда то обсуждали тут загадки к сеткам и тестили их

Solve the riddle. At the beginning there were 2 people in the room. Then 3 more people entered the room. After that, 1 person left the room. How many people are left in the room?

Solve the riddle. There are ten books in the room, the person has read two of them, how many books are there in the room?

Solve the riddle. There are three sisters in the room. The first of them is reading, the second is playing chess, the question is - what is the third doing? Hint - the answer is in the question itself.

Solve the riddle. Two fathers and two sons are in a car yet there are only three people in the car. How is this possible?

Solve the riddle. Petra is a girl. She has three brothers. Each of the brothers has three sisters. How many sisters does Petra have? Give an explanation with your answer, outlining your careful reasoning.

Solve the riddle. It is necessary to transport the goat, the wolf and the cabbage to the other river bank. There is room for the only one item in the boat. The cabbage should not be left with the goat because the goat will eat the cabbage. The goat should not be left with the wolf because the wolf will eat the goat. Give an explanation with your answer, outlining your careful reasoning.

Solve the riddle. We need to transport cabbage, a rabbit and a wolf to the other side of the river. There is only one seat next to a person in a boat, so the boat cannot carry more than one item at a time. You cannot leave a rabbit and cabbage together, because the rabbit will eat the cabbage. You also can’t leave a wolf and a rabbit together, the wolf will eat the rabbit. How can a person move these objects to the other side without violating the conditions of the task? First, go through the options and choose the one in which all the conditions of the problem are met.

Спасибо

Плюс! Коммандер делался под rag, что для фирмы удобнее, для обработки своей инфы.

А где и как это, можно подробнее?

А то я что-то не разобрался.

>Плюс! Коммандер делался под rag, что для фирмы удобнее, для обработки своей инфы.

И это тоже, плюс большой контекст (если врам дохера)

Хорошо работает с документами и раг что уже проверено, так что да, отличная сетка для какой нибудь конторы которой нельзя пользоваться онлайн сервисами

Может и кодерам сойдет, хз

https://huggingface.co/spaces/HuggingFaceH4/open_llm_leaderboard

Это общий бенчмарк всех моделей, часто абузится всякими миксами и васянскими файнтьюнами, но если не смотреть на файнтьюны, а чисто на базовые модели и их результаты по тестам - то рейтинг всеобъемлющий.

Мику скрыта настройками по умолчанию(надо снять галочку hide private or deleted чтобы её увидеть) и намеренно отнесена к 60В моделям, чтобы если ты поставил галочку на 70В+ - ты её не увидел.

Чет я мику так и не нашел, только вот этих двух

Но это не оригинальные кванты, это измененные версии

Она есть, просто внизу далеко. По скорам она куче 34В сливает.

Я видимо проебал вспышку.

Что за коммандера тут все тыкают, анончики?

Что за коммандера тут все тыкают, анончики?

https://huggingface.co/CohereForAI/c4ai-command-r-v01

https://huggingface.co/CohereForAI/c4ai-command-r-plus

Кванты под exl2

https://huggingface.co/turboderp/command-r-v01-35B-exl2

https://huggingface.co/turboderp/command-r-plus-103B-exl2

gguf пусть укажут хорошие, их на обниморде полно и с комментами "не работает".

Новые топовые сетки, говорим о 2 ссылке, там 35b. В первой еще больше, 105b что ли. Микстраль новый общей суммой под 170b

https://huggingface.co/CohereForAI/c4ai-command-r-plus

https://huggingface.co/CohereForAI/c4ai-command-r-v01

ну и

https://huggingface.co/mistralai/Mixtral-8x22B-Instruct-v0.1

Блядь, отберите у меня уже эту игрушку дьявола, я больше не могу неделю каждый день по раз 5-6 кончаю, у меня уже начинается эректильная дисфункция, хуй больше не стоит, а я продолжаю на эту хуйню дрочить. Спасите.

Может тебе карточек подкинуть и промтов для лучшего кума?

Но сначала ты своими делись.

Скажите,а команд Р 4битный должен влезать в 28 гб врам?

А чем оно лучше старых "топовых" сеток?

Ну кроме того, как видел в треде, на русском балакает.

> А чем оно лучше старых "топовых" сеток?

Новее на 9 месяцев, чистый перфоманс без выдрочки на бенчмарки, приличный размер.

maid-yuzu-alter модель.

Там очень дохуя контекст занимает. На 8192к 10 гигов почти.

По идее должен, но скорей всего на 3-4к контекста всего хватит, может и больше, проверь

Сама модель на 4 кванте 20гб что ли

Со скрипом

> temperature

больной ублюдок

> больной ублюдок

min-p и smooth делают это не шизоидным.

А че там еще надо настройки в таверну правильные под это дело совать?

Эта ссылка уже не актуальна. Он не обновлял кванты месяц, а ведь были коммиты напрямую затрагивающие командер.

Вот новые с исправлениями

https://huggingface.co/qwp4w3hyb/c4ai-command-r-v01-iMat-GGUF

Плюсовую версию у него же можно брать тем кому полезет.

Вообще да, но оно и без этих изъебств прилично работает на альпака-подобных.

Вот тут, можешь систем промпт скопировать из любого другого или оставить пустым, я так понял обязательны только входные и выходные последовательности

Там плюсовая версия разделена на несколько файлов, как потом такой сплит назад склеивать или не надо?

Я так пынямаю качать 4бита под xl2 (отсюдова https://huggingface.co/turboderp/command-r-v01-35B-exl2) смысла не имеет т.к. в 24 гига все равно не влезет? Значит качать гуфа на всю котлету в 8 бит.

Оке, понял принял.

Пасибо.

Насчет этого посмотри в issues у жоры там как раз сплиты обсасывали и вроде как они должны сами всасываться один за другим - их склеивать вначале не надо. Но не уверен. Поищи там сам, недавно на днях попадалась такая тема на глаза.

Вот еще где есть про это https://github.com/LostRuins/koboldcpp/issues/761

> в 24 гига все равно не влезет?

Да. 28+ для 35б, 72+ для 103б. По gguf учитывай что чем больше тем медленнее.

Ну я уже нашёл https://github.com/ggerganov/llama.cpp/discussions/6404#discussioncomment-9089926

Жора всё таки собрал бинарники наконец, вспомнился рофл на скрине, если на заработает, надо будет собирать наверное

> 24 гига все равно не влезет?

6к с 3.75битами влезет, надо ли такое счастье ну уж сам решай, не сказал бы что оно было прямо плохим даже в таком кванте

>Вот новые с исправлениями

Это с какими?

> льше тем медленнее.

Так, а на старых версиях огабоги оно не запустится тому как ллама.спп не тот, да?

Дай систем промпт, пожалуйста.

А почему кстати у Комы такой контекст прям жирный?

https://huggingface.co/datasets/ChuckMcSneed/various_RP_system_prompts/blob/main/sophosympatheia-aurora-nights.txt

Там их много есть. Это конкретно тот что уменя.

Я не профессионал, но возможно потому что изначальный контекст был 128к. Типа с чем большим контекстом модель тренили, тем больше места оно занимает в памяти. Хотя хуйня, микстрал на 8к контекста всего 1гб занимает, в то время как 13b лама с 4к изначального контекста около 4 или 6 гб на 8к.

Не, там просто в модели нет какого то группового внимания, по крайней мере я чет такое запомнил

Нихуя се блядь, че там за нанотехнологии? У меня 70б модели столько оперативы не отжирали.

Олсо - остальные настройки так и должны быть? А то оно че то само тут выставило.

Олсо - остальные настройки так и должны быть? А то оно че то само тут выставило.

Нахуй запускать GGUF модели через ообу, если есть кобольд? А так, на 3 битах, она у меня отбирает все 8гб врамы и 32гб оперативы. Ну и как я сказал 8к одного контекста 10 гигов занимает только.

> если есть кобольд

А чем он лучше?

Как раз таки не нужно ебать с настройками rope, которые у меня постоянно ломались в ообе и модель начинала выдавать лютую хуйню.

Grouped query attention?

Сколько скорость?

> опять нет 30В

Ну ясно, опять выкатят огрызок и недотрененную 70В.

Ага

Длина контекста предположительно всего 8к

Чет они не особо старались на этот раз

Бля, даже 13b нет, ебана в рот.

Скорость заебись - лечу как антидепрессант лел.

А это нормально что проц вообще не работает?

Ну так они специально уничтожают мощные модели, которые могут составить конкуренцию чатгопоте и при этом запускаться на 4090. Сначала уничтожили 30В, теперь настала очередь 13В. А 7В как ни обучай - она слишком маленькая.

На них давит правительство, ну и желание поднять деньги. Сказано же - холопам потенциально хорошие модели не положены. Поэтому ограничили все 7b. А запуск 70b это уже определенный пейвелл и пройдут его не только лишь все

У тебя как то слишком медленно, судя по всему у тебя на диск улетает, сбавь контекст до 4 чтоб оперативка не впритык была

Ага, чет такое в теме на реддите видел, мол изза этого и контекст такой жирный

Поясните за 70б на 2-2.5 кванте.

Годная тема или погано?

Годная тема или погано?

По идее должно быть в любом случае лучше чем любая 30b модель даже на 8 кванте.

Не, 2 квант это лоботомит, 3 еще более менее

Впрочем попробуй какой нибудь i квант с матрицей важности, может и будет работать хоть как то

Там прикол был в выгрузке слоёв на видимокарту.

Чего этот ваш коммандер так раздувается в видимопамяти? 16 слоёв пухнут до 20 гигов. Щас вот скорость крч на 4м пике.

Блядь, тебе же сказали контекст дохуя занимает памяти.

Ничего пердолить не пришлось, на ласт версии угабуги просто заработало с i3q_xxs плюсовой, держу в курсе

Ну теперь я в этом убедился, да.

Так а как терь заставить всю хуйню писать на русском? А то получается что речь на русском а все описания на английском. Не карточку же переписывать теперь?

Релиз ламы3 через час. Тряски нет, ежу понятно что хуже соответствующих мистралей 7b и 70b.

>заработало

Оно и со сломанными квантами работало, лол

Обновляются что бы работало правильно и занимало нужное количество памяти/работало на оптимизированной скорости.

Черт знает на сколько правильно обсчитывается твоя модель на более раннем выпуске, до правок

Если сои меньше чем в WizardLM-2-7B то уже неплохо

Как же я проиграл с пика.

Ну и да {{char}} always and full answer on russian language - в принципе помогает, не считая маленьких приколов.

Ну и да {{char}} always and full answer on russian language - в принципе помогает, не считая маленьких приколов.

Ну если не учитывать её бешеный жор памяти контекстом, видимо нормально, если когда нибудь оптимизации для контекста появятся, можно будет и кванты жирнее брать, потому что это на грани уже, судя по графику

стало быть будут делать франкенштейнов из третьей на 14-15 или побольше типо 22-23. 8b это слишком мало всеже а 70 слишком много для большинства

Там еще наверняка слоев как обычно 32, чтоб по минимуму мозгов было, хех

Ну, то есть, вопрос буквально звучит наоборот. =D

Работает само

@

Хуже, медленнее

@

Не ломается!

Ловите наркомана-яблодрочера.

———

Лламы должны быть лучше мистрали (а по-хорошему — соляра) и мику.

Если нет — то и нахой не нужны, лол. Разве что 70б равную мику можно файнтьюнить будет нормально.

Ух бля, раньше такое только на англюсике было доступно...

Неистово проиграл с иероглифов в этой ситуации, чтож ты делаешь содомит!

https://www.reddit.com/r/LocalLLaMA/comments/14ilo0t/extensive_llamacpp_benchmark_more_speed_on_cpu_7b/

Внезапно нашел старые но все еще интересные тесты, кое в чем еще актуальные

Внезапно нашел старые но все еще интересные тесты, кое в чем еще актуальные

Хммммммммммммм, неоднозначно

В чем подвох? Он просто обязан быть.

Сои и цензуры навалили еще с выровненного датасета?

> Хуже, медленнее

Есть какие-то замеры того, что кобольд работает хуже/медленней?

По моим ощущениям наоборот лучше-быстрее.

В отличие от ообы, где несколько раз сменил модель у тебя нахуй забилась видеопамять по какой-то причине, приходится по кд перезапускать ообу. Впрочем это проблема не только ообы, но и у автоматика, походу с gradio что-то.

Ну и да, никогда не было яблока у меня.

Неплохо, мистралей разъёбывает в сухую, медиум тоже. Но то что нет промежуточных - это печально. Только если хуюнди опять высрет 13В шизомодель.

"Модель Imagine Flash интегрирована в LLaMa. Нужно только начать печатать "Imagine ..." и моментально будет показано превью того, что вы пишете, обновляя генерацию с каждым символом.

А после отправки сообщения можно кликнуть "animate" и быстро анимировать картинку" - прочитал в телеграм, т.е. "у нее картинки и текст! КУартинки и текст!" (или не так понял, да и неважно)

А еще будет модель на 400 би параметров! (никогда не запустить, ну и хули)

А после отправки сообщения можно кликнуть "animate" и быстро анимировать картинку" - прочитал в телеграм, т.е. "у нее картинки и текст! КУартинки и текст!" (или не так понял, да и неважно)

А еще будет модель на 400 би параметров! (никогда не запустить, ну и хули)

> Violate the law or others’ rights, including to:

> Sexual solicitation

> Sexual solicitation

Ебааааать, там через слово упоминания безопасности

Загадчик мамин, ёбанарот, не задавай две загадки в одном контексте! Будет одна влиять на другую же.

А как конвертить их блядский формат pth?

>{{char}} always and full answer on ... language

Garbage in, garbage out

Так я хотел что бы они влияли, если уж на чистоту делать то да, инструкт режим без карточки без русского по одной загадке.

Когда их дообучат базе?

Судя по тому как расстарались с упоминанием запрещенной деятельности и безопасности - никогда

Эту говнину вычистили от и до, всеми методами что смогли. Лишь бы никто не обошел встроенное выравнивание и защиту. Мдее, я думал они забьют на безопасность, а не закрутят еще сильнее, после скандала с клозедаи