На Жориной лламе опять все сломано и пхи3 хуйню несет. Боже..

Новые фи пока нельзя использовать в ггуф? В чем именно выражается поломанность, можно пример хуйни, которую несет, то есть это вообще бред или лупы или что там?

https://github.com/ggerganov/llama.cpp/issues/7451

Ждём пока Жора очнётся. Все свежие билды сломаны, хотя у кого-то вроде работают. Неделю висел PR и никто не потрудился простестить его нормально.

С другой стороны, какой толк от такой модели для нас?

Резать на франкен-мерджи?

Это со мной что-то не так или что, но где в новой таверне запрет на EOS токены?

А по железу гайд есть? В шапке беглым осмотром не заметил.

На чем крутите? На теслах?

На чем крутите? На теслах?

Какой тебе гайд нужен? Любая нвидия с 24 гб врам, чем новее тем лучше. Остальное мусор.

Потестил Фи медиум, какое-то соевое говно, даже в рп триггерится и высерает поучения. Ещё и в чате шизит, пытается на инструкции перескочить, что-то слишком жестко затюнили под инструкции её. Может файнтюны смогут её разогреть, но пока нахуй. Сидим дальше на Yi/ламе 70В.

Хочу сделать выяитель бототредов испол зуя ллм и векторные бд. Чтобы оно регуляоно анализировало /b, выявляло контекст шапки и сохраняло. И сравнивалось то, что есть. Подводные? Нахера это делать?

ммм регулирование

https://3dnews.ru/1105198/krupnie-kompanii-v-sfere-ii-vzyali-na-sebya-obyazatelstva-po-obespecheniyu-bezopasnosti-razrabotki-iimodeley

ищо

https://www.reddit.com/r/LocalLLaMA/comments/1cxqtrv/california_senate_passes_sb1047/

ищо

https://www.reddit.com/r/singularity/comments/1cx9oh4/openai_openai_safety_update/

делаем ставки когда запуск локалок оффлайн станет незаконным

https://3dnews.ru/1105198/krupnie-kompanii-v-sfere-ii-vzyali-na-sebya-obyazatelstva-po-obespecheniyu-bezopasnosti-razrabotki-iimodeley

ищо

https://www.reddit.com/r/LocalLLaMA/comments/1cxqtrv/california_senate_passes_sb1047/

ищо

https://www.reddit.com/r/singularity/comments/1cx9oh4/openai_openai_safety_update/

делаем ставки когда запуск локалок оффлайн станет незаконным

Никогда, просто отдадут первенство Китаю.

Или просто новая винда обновления 10 и даже линукса станут полноценным большим братом и даже вывод локалок, хочешь ты или нет, будет отсылаться и анализироваться

Все ради твоей безопасности, анон

https://www.reddit.com/r/singularity/comments/1cx9qxj/microsofts_new_recall_service_big_brother_is/

Кучно пошло.

>делаем ставки когда запуск локалок оффлайн станет незаконным

Запуск не станет. Хотя домашних устройств для инференса могут и не завезти. Хуже, если не завезут и новых публичных моделей. Или завезут, но полностью без секса например и с внутренней сеткой-цензором. Потому что не положено быдлу.

->

>Им не дадут выложить 400b.

Анон предсказывающий.

Есть, в вики.

Что и требовалось доказать.

>с внутренней сеткой-цензором

Как в стейбле? Я за.

https://www.reddit.com/r/LocalLLaMA/comments/1cxoh5q/llama_wrangler_a_simple_llamacpp_router/

Похоже на то о чем мы тут когда то болтали, несколько параллельных серверов для быстрого ответа

Не понял только для одного фронта или для нескольких

Похоже на то о чем мы тут когда то болтали, несколько параллельных серверов для быстрого ответа

Не понял только для одного фронта или для нескольких

>«аварийный выключатель»

Ух ты, они прямо признались, что будут вшивать бэкдор в модели. Safetensors всё ещё safe?

https://3dnews.ru/1105197/es-prinyal-perviy-v-mire-zakon-ob-iskusstvennom-intellekte

Профессиональный выстрел в член, европа выбывает из гонки

Так они норм правила устанавливают. Проблема в том, что их соблюдение тормозит сферу, да.

>опа выбывает из гонки

Так они не только из гонки выбывают, получается. Это нужно гуглу с опенаи блокировать доступ из европы, лол.

Прогнуться же. Всегда прогибались. Не отдавать же срыночек гейропки YaGPT, лол.

Мужики, посоветуйте файтюн ламы 3 8b конкретно для написания историй, а не как обычно чатинга 1 на 1.

А то когда создаю хотя бы два персонажа в одной карточке персонажа, то ответы получаются сухими и короткими, а хотелось бы что бы сюжет дальше развивался и между персонажами много диалогов было.

А то когда создаю хотя бы два персонажа в одной карточке персонажа, то ответы получаются сухими и короткими, а хотелось бы что бы сюжет дальше развивался и между персонажами много диалогов было.

И что Ивану из города Тверь помешает вырезать этот кусок из новой винды? Сколько модификаций всяких виндовс существует?

>И что Ивану из города Тверь помешает вырезать этот кусок из новой винды?

Интеграция этого куска в ntoskrnl.exe?

Просто слова коверкает, будто бы токены пропускает/путает местами. Не очень часто, но доверия нет когда такая хуйня происходит.

>ntoskrnl.exe

Не имею возможности ебать что это.

Так там как раз on-device и будет, вместо копилота. Так что это годнота, а телеметрию всегда можно отключить или заблокировать фаерволлом. Так что живем, большой брат не пройдет.

А вы вообще читаете карточку моделей, прежде чем тестировать? Ну а чего ты ожидал, там написано какой собран датасет и для каких целей. Кумеры не перестают удивлять тупостью.

Нихуя не знаешь устройства шинды, но при этом рассуждаешь? Типикал ситуэйшен.

Это файл ядра винды, удачи его удалить.

Поясните за Mixtral 8x7 и прочих франкенштейнов с множителем. Как из семи условно тупых моделей можно получить модель, выдающую лучший результат? Новой информации-то в них взяться неоткуда.

Смотри, у тебя семь долбоёбов. Пусть будет семеро двачеров. Один знает про говно, второй про молофью, третий ещё про что-то. И вот ты пишешь им что-то, а они совещаются. Один говорит - "речь про говно, инфа 60%". Второй - про "машины, инфа 20%". И вот это всё суммируется согласно вероятностям и тебе в ответ прилетает ответ "ну а чё ты хотел, это аж автоваз".

Информации как в 56b а может и меньше, "логика" как у 7b, vram занимает как 56b, работает побыстрее 56b, но помедленнее 7b. По идее, оптимальный вариант для видеокарт с большим объёмом vram и слабым ядром, типа тех же p40.

В MOE нет четкой сегрегации экспертов на какие-то конкретные скиллы вроде коддинга, общих знаний, сторителлинга и т.д. Все это нех работающее каким-то магическим образом понятным только самой сетке, организующееся при обучении. Роутер собирает данные с экспертов каким-то околорандомным методом. Проще это воспринмать просто как архитектурный способ променять размер модели на увеличение эффективности и уменьшение требуемой видеопамяти.

>Смотри, у тебя семь долбоёбов.

Вижу пока одного.

8х7 означает что на каждом слое нейросетки, у этой их 32, есть 8 разных вариантов весов.

И каждый раз при ответе выбирается 2 из 8.

И на каждом слое берутся только те что подходят лучше всего для ответа тебе. Что означает - сетка имеет не просто 8 специалистов как сказал чел выше, она имеет 256 вариантов комбинирования этих весов.

Ну или сказать еще проще, Mixtral 8x7 это такая "широкая" 7b по которой размазано гораздо больше информации чем в обычной 7b. Что добавляет ей знаний и мозгов

А, так там разные 7b берутся? Тогда понятно, я-то думал, что одинаковые.

>И на каждом слое берутся только те что подходят лучше всего для ответа тебе.

И как определяется что подходит лучше всего?

>И как определяется что подходит лучше всего?

Сетка выбиральщик тренируется вместе с ней, так и выбирает, на сколько помню, предсказывая какие варианты активировать

Хм, это навело меня на мысль. А какая вероятность того, что GPT-4 - это не просто 240b/1.7t или сколько у него там, а вот такой вот GPT-3x10?

По четвёрке openai что-то не торопится сколько-нибудь точные данные давать.

Уже давно понятно что гпт-4 сейчас мое. Первая версия скорее всего была все еще цельной.

>gpt-3

Он там вообще никаким боком.

Есть чёткая сегрегация по токенам.

Так ты в зеркало не смотри, чтобы долбоёба не видеть.

>Так ты в зеркало не смотри, чтобы долбоёба не видеть.

Так я на тебя смотрю

Давай дурачек расскажи еще раз как там 8 экспертов сидят

Пояснительную бригаду можно?

> Хуже, если не завезут и новых публичных моделей. Или завезут, но полностью без секса например и с внутренней сеткой-цензором.

Вполне возможно, а "обучение с расцензуриванием" станет прямым нарушением лицензии, что сильно ударит по возможности распространения подобных моделей. Хер вам торренты а не автозагрузка на обниморду.

С другой стороны, не похоже что все там собираются вникать, а если бы серьезно слушали лоббирование клозедов то не было бы уже того что имеем.

Скорее балансировщик нагрузки при нескольких бэках и множественных обращениях.

Входная часть выдает оценку насколько подходит каждый кусок под генерацию следующего токена, N самых высокооцененных моделей запускается. Может от токена к токену меняться между ними.

> а они совещаются

Нет, если бы оно совещалось то было бы куда лучше, так-то модель может совещаться сама с собой, особенно эффективно с разными промтами.

> на каждом слое берутся только те

Разве в дефолтной реализации оно скачет от слоя к слою? Полное прохождение емнип было.

Типа того, но мозгов добавляет несильно, знаний - пожалуй.

>Разве в дефолтной реализации оно скачет от слоя к слою?

Da. А слой внимания общий на всех икспердов.

По заявлениям она сразу была мое, вот только стретегия/принцип реализации мог отличаться от того что видим сейчас. Но хуй знает как оно на самом деле и сколько было версий.

Понятно

> А слой внимания общий на всех икспердов

Видимо от того и выходит что уступает по "уму" большим, но превосходит аналогичные обычные.

>Типа того, но мозгов добавляет несильно, знаний - пожалуй.

Мозги заметно растут от количества доступных сетке знаний. По крайней мере ощущение создается более умной сетки, хоть и тупит

>если бы оно совещалось то было бы куда лучше

Блядь, это аналогия была потому что выхлоп каждого эксперта суммируется.

>At every layer, for every token, a router network chooses two of these groups (the “experts”) to process the token and combine their output additively.

>Mixtral has 46.7B total parameters but only uses 12.9B parameters per token. It, therefore, processes input and generates output at the same speed and for the same cost as a 12.9B model.

Могу подогнать другую аналогию, толпа двачеров едят "цезарь" из одной тарелки. Один выбирает салат, чеснок и сыр. А другой помидоры, филе и масло. Правда, как на пике было приложено, одинаковые токены отправляются разные экспертам, но это уже нюансы.

И потом, соответственно, они все вместе срут обратно в одну тару.

> llama: Consider starting the email with a more personalized greeting, such as "Dear Anon," instead of just "Dear Anon".

> me: But I have the comma in there, can't you see it? Is your tokenizer broken?

> llama: Yes, I can see the comma in your original email. My tokenizer is functioning correctly. The request was to proof-read the email for grammar, punctuation, and spelling, not to check for grammatical errors that are not present in the original email. If you want me to check for grammatical errors, I'll be happy to do so.

Фига она огрызается.

> me: But I have the comma in there, can't you see it? Is your tokenizer broken?

> llama: Yes, I can see the comma in your original email. My tokenizer is functioning correctly. The request was to proof-read the email for grammar, punctuation, and spelling, not to check for grammatical errors that are not present in the original email. If you want me to check for grammatical errors, I'll be happy to do so.

Фига она огрызается.

С одной стороны поддвачну последние мелкие сетки этому доказательство. Они все еще туповаты, но охватывают большую область типичных задач и за счет ухищрений типа запредельного cot могут перформить. Еще бы в большой контекст научились. Gpt-4o тоже 100% небольшая МОЕ и в типичных задачах она вполне себе работает. Ну как небольшая, врядли там меньше 20б на каждого эксперта.

С другой, рост перфоманса от МОЕ слишком слаб относительно повышения числа параметров, а мелочь и в единичном экземпляре подкачалась. В чем-то сложном оно слабо отличается от обычной модели.

Ну и странные у тебя аналогии, но они таки забавны. Тут нет совещания, тут буквально проход ингридиентов по производственной линии, но на посту будет не один "повар" а несколько, часть из которых приступит к работе, после передав дальше. Из взаимного влияния - только изменения активаций и все, друг друга не чувствуют.

Вот если бы действительно собрать выдачу с каждой части, а потом по ней устроить суммарайз, или тем более дискуссию и авторегрессией, но на уровне токенов это сильно отложит начало стриминга, тут нужно что-то радиально другое.

Бля) Ггуф не сломан, она просто говно. Что удивительно gpt-4o тоже обосралась, но тут хотя бы понять можно, она ссылалась на отношения к одному живому члену семьи, хоть и не поняла, что для "тебя" - это отец а не дед. Пхи же просто рандомной хуйни выдала.

> дурачек

Хоть бы не позорился.

Хз, у меня эту задачу решил phi medium, даже с кривым токенизатором.

Будем ванговать место у параши в рейтинге для пхи3 медиум? Мне, кажется, где-то между этими будет. Если ниже, то нахуй не нужна. Сеймы?

Не думаю, что 400b не выложат из-за довления. Скорее Цук и компания увидели перспективу. Зря они что ли заказали себе 350 тысяч H100? Это около 10 миллиардов на одни только ускорители, не считая всей остальной инфраструктуры датацентров. Явно не из альтруизма это делается.

Если мозгов меньше, чем у "монолитной" модели с аналогичным итоговым размером, то в чём тогда преимущество?

Как там по моделям на русском сейчас? Пробую llama-3, но, к сожалению, только 8b вроде местами прям очень хорошо, но бывает переходит на ломаный русский, по сути английский с русскими словами.

Скорость интерфейса и удобство эксплуатации на гпу сервере.

>пик

Llama 3 70b выше некоторых GPT-4? Субъективщина?

Мне удалось немного потыкать и базовую четвёрку, и некоторые её номерные версии, и эту третью ламу.

По моему опыту, четвёрка всё-таки меньше путается в контексте, чем поделие цукерберга. Третья лама скорее где-то на уровне GPT3-3.5. Может выше, может ниже, там фиг поймёшь, результаты слишком рандомные.

У меня llama 3 8B отвнтила так же как и гопота.

Можешь ещё солар попробовать, если не можешь позволить себе командира.

> Субъективщина?

Ты знаешь, как работает этот рейтинг и на какой системе основывается? Так что нет, как раз все подтверждено реальными данными. Имей в виду, квантованный лоботомит это не то же самое, что оригинальная модель.

8.0 квант же без потерь идёт.

Кванты параша сами по себе и могут быть сломаны фундаментально, бенчмарк перплексити ничего не значит на самом деле. Жорик уже это доказал своим сломанным гуфом.

Без понятия, потому и спрашиваю. Про проблемы квантования я в курсе, но тот вариант ламы, который я пробовал, был либо неквантованный, либо квантованный не слишком сильно.

У меня 8b всё время пытается подсчитать дедов, а не людей, у которых есть дед.

>7b

Небось хуже 3 ламы 8б

>7b

Небось хуже 3 ламы 8б

ХЗ, как по мне, ллама 3 70B вполне себе на уровне чепырок. Чуть слабже, но очень близко.

Лучше бы мику официально релизнули. Хотя ХЗ, нужна ли она при живой ллама 3.

Ля, ну командир и большой. У меня наверное только 2х квантованная влезет.

> не субъективщина

> как раз все подтверждено реальными данными

Кекнул. И без подкруток там не обходится, от безобидных и "необходимых", как их анализ запросов юзеров чтобы отфильтровать тривиальные что могут искажать, до прямых манипуляций в угоду кому-то, в чем их обвиняли.

> квантованный лоботомит

Хех

> мику

Нахуй этот кал нужен. Она при второй лламе так себе была, а сейчас вообще сосёт дико. На арене медиум на днище.

> Mistral-7B-v0.3 has the following changes compared to Mistral-7B-v0.2

> Extended vocabulary to 32768

Что это значит? Какой вокабуляр был у мистраля 0.2?

Мику топ была. Что там с медиумом на арене, я ХЗ.

>Какой вокабуляр был у мистраля 0.2?

В репе же есть, 32000. Целых 768 токенов добавили! Там скорее всего управляющие символы для запуска функций.

Ага, точно, управляющие символы. ИЧСХ, токенизатор явно отличается, то есть чтобы добавить этот десяток токенов (осмысленные только вначале, далее хуита какая-то уровня control_1488), пришлось переобучать пол модели. Какой же кал всё таки текущие нейронки.

> Мику топ была.

Только в фантизиях шизиков. На арене её даже 8В выебало.

ХЗ, я тестил, мне нравилось. Ллама 3 конечно лучше будет.

>пришлось переобучать пол модели

Ан нет, перепроверил, токены только по айдишникам сместились. Надеюсь они там привязку старых эмбедингов сохранили при расширении, так что может всё не так уж и плохо. А может нет, знаю я этих МЛщиков.

Тогда солар анцензоред, а еще лучше ллама-3 и общайся на английском. Уж переводчик подрубить то можно. Там же расширение стоит, все в одну кнопку делается. Вот бы еще на озвучки мое-ттс сделать расширение.

Пиздец гопота лоботомит.

Не нужен.

Расскажешь, как подкручивают? От ботов там защита, то что сидит лахта от каждой компании и накручивает на свою модель, полная шиза, не верю. Сами результаты постоянно чистят вилкой. Короче глупо спорить, но это самый объективный существующий рейтинг.

Да не в знании инглиша проблема. Я просто уже столько на английском с этими нейронками общаюсь, что нормально не могу уже воображать диалог с ними на русском. Да и когда на русском всё равно по-другому ощущается, когда пишешь и читаешь. Хочется такого, но всё никак не завезут... С переводчиком тоже всё криво будет.

>С переводчиком тоже всё криво будет.

Не знаю, мне нравится. С банальным Гуглом - если оригинальный текст хороший, то и перевод тоже хороший будет, даже поэтичный немного. Нужно только учитывать некоторые нюансы - что пишешь ты на русском для Гугла например, а не напрямую твоей нейронке.

Mixtral это не франкейнштейн, а полноценная MoE — совет экспертов.

У тебя 8 моделей, каждая знает что-то одно, когда ты задаешь вопрос — выбирается две наиболее подходящие и дают общий ответ.

Получается лучше, чем 1 модель (очевидно, ведь у нее нет тех знаний), быстрее, чем крупная модель того же размера (у тебя по умолчанию 1/4 МоЕ-модели читается).

42, да. Или около того.

> работает побыстрее 56b

Вчетверо.

> с большим объёмом vram

Но частичная выгрузка сосет, желательно полностью.

Ну, как там было изначально — хз. =) 42 миллиарда уникальных из 56 всего.

Так GPT-4 и стартануло моду на МоЕ.

8*220 = 1760.

По слухам. =)

> Mixtral has 46.7B

Попутал малеха.

СКОРОСТЬ

suzume качай.

3.5 тупенькая все же.

Мику бодрячком, че б и нет.

Да ладно, мику даже на битриксе хуярит. )

Немного драматизировал, чтобы их прямо за руку схватили не было. Однако, были довольно серьезные обвинения в склонности определенным моделям (мистраль/микстраль и кто-то еще) и выбора их подборки в зависимости от промта, кривые промты/инжекты для gpt4 и клоды 2 из-за чего те отвечали хуже чем должны, странные движения в рейтингах. Все это в некоторой мере офк можно оправдать/объяснить, но сам факт вмешательств и

> Сами результаты постоянно чистят вилкой.

уже стоит держать в голове, ссылаясь.

Но это все ерунда если посмотреть на

> самый объективный существующий рейтинг

Вообще ни разу. Это буквально субъективные оценки рандомных юзеров на простые запросы, все. Лишь малая область, которая может быть не то чтобы саботирована, но на нее можно хорошо натаскать даже простую мелкую модель. А то что та сосет даже в коротких но более сложных запросах - будет размыто и усреднено на фоне популярного. Если еще добавить ей "живости" в ответах, чтобы общалась "приятно", пыталась что-то предложить и рассказывала дополнительное - приз зрительских симпатий обеспечен. Хотя при большинстве применений где оно не используется как чатбот для нормисов это будет вносить негативный импакт.

>ome person who has a loving grandparent

>and that's my three sons

Лмао. Походу большинство нейронок об кастомные вопросы, которых не было в датасете, ломаются

*living

Очепятка

>suzume качай.

Пока неплохо. Не сказать что прям хорошо, но вроде лучшее из того что пробовал пока.

One - это не обязательно "один".

>one person

Это один человек

>that's

Обращение в единственном числе

Что интересно гопота даже нормально не смогла текст по своим же советам исправить. Лоботомит тот еще, их адское снижение количества параметров все таки заметно, а стоимость апи упала всего в два раз, хотя его по сути нужно по цене апи ламы 70б надо продавать

Шиза.

Шиза - возводить в абсолют ограниченные выборки и слепо верить в субъективные лидерборды.

Есть чего-нибудь помозговитее Llama 3 8b в плане понимания контекста? Мой лимит где-то 23b / 15гб. Может чуть выше, но уже на этой планке модель работает со скрипом, ибо слишком много слоёв в оперативку выгружается.

Можете на примере мистраля объяснить:

Если модель идет с большим контекстом (32к), ГУИ выставляет rope_freq_base на 1000000. Влияет ли rope на мозги, или если я использую только 8к контекста, то лучше уменьшить rope?

Ты не понимаешь, что из себя представляет этот рейтинг и как он работает. Попробуй почитать их блог и вникнуть.

Говно будет с переводчиком. Хорошего русского нет нигде. Ну может только командир +.

Ну давай расскажи, что именно делает их эталлоном объективности. Что заставляет клода1 быть в лидерах выше чем более умные модели, почему ллама8б опережала полноценную жпт4 (пофиксили) а 70б делает это до сих пор, и многие другие странности, что вылезают регулярно или есть прямо сейчас.

https://huggingface.co/collections/failspy/abliterated-v3-664a8ad0db255eefa7d0012b

Расцензуренные сетки

А еще там где то микстрал 3 вышел/выйдет скоро

Расцензуренные сетки

А еще там где то микстрал 3 вышел/выйдет скоро

>Расцензуренные сетки

или испорченные? проверлись лично? там кроме чистой ламы-3 ничего стоящего, а ее можно легко и файнтюном испортить, вон там же пример этого - дольфин

Там точечное удаление части мозга весов отвечающих за отказы и сою, удалено скорей всего не все, но этот метод работает не ломая сетки

Что сейчас есть топового по coom моделям ?

загружаю в угебуге .bin третьей ламы 8b через трансформеров, у меня 16 врам, но начинает дико тормозить, какие параметры понизить?

NousResearch_Hermes-2-Theta-Llama-3-8B

вот эта модель

NousResearch_Hermes-2-Theta-Llama-3-8B

вот эта модель

в 8 бит запускай, там вроде как то делается, у тебя памяти не хватает на полные веса

спасибо, я думал 8b = 16vram

а ггуфы работают уже? гуф умер

Насчет чистой ламы не знаю, но до последнего хита среди файтюнов не дотягивает.

Вообще-то гугл переводчик это шоу "Тупой и еще тупее". Лучше вообще к нему не притрагиваться, особенно если речь идет о мало знакомом языке.

Векторы, чтоли? Даже в статье от автора векторов было сказано, что это ломает сетки.

Что, перплексия на 0,0001% падает?

>Вообще-то гугл переводчик это шоу "Тупой и еще тупее".

Я тут уже упоминал, что имею возможность прикрутить к своему клиенту Дипл и использовать его для перевода в обе стороны. Но остаюсь на Гугле. Не просто так ведь, правда?

Да, с ним надо уметь работать, не всякий запрос он поймёт правильно. И в клиенте Таверны я бы кое-что подправил, если бы было не лень. Но в целом вариант неплохой.

Да не, ты что, перплексити это святое. Там хуйня какая-то была, не существенная. Всего лишь

>yield grammatically incorrect output sentences

>yield grammatically incorrect output sentences

Да, действительно хуйня. Я не замечал кстати.

Из 8б llama 3 Instruct кто-то переплюнул уже?

Удивлен что miqu не особо в почете. И командер и квен пробовал, не впечатлило. Пока остановился на Midnight-Miqu-70B-v1.5, претензии только к скорости, но даже 0.55 т\с не отпугивает.

у Miqu-70B-Alpaca-DPO и OrcaHermes-Mistral-70B-miqu тоже неплохая позиция в рейтинге на

https://ayumi.m8geil.de/erp4_chatlogs/?S=iq4_0#!/index

да собственно, 6 позиций в первой 10 там разные вариации miqu занимают.

у Miqu-70B-Alpaca-DPO и OrcaHermes-Mistral-70B-miqu тоже неплохая позиция в рейтинге на

https://ayumi.m8geil.de/erp4_chatlogs/?S=iq4_0#!/index

да собственно, 6 позиций в первой 10 там разные вариации miqu занимают.

>Удивлен что miqu не особо в почете.

В почёте, но чистая. Файнтюны мику хуже франкошизомиксов.

>В почёте, но чистая. Файнтюны мику хуже франкошизомиксов.

Ну, не совсем. Чистая умная, но фантазия бедновата на некоторые вещи.

Статистика, чел.

Потому что это старая и тупая модель. Сосёт буквально по всем пунктам у всех. С третьей ламой 70В можно даже не сравнивать.

Phi 14В уже пробовали? У меня кобольд вылетает при попытке запустить васянский q4 ггуф, вот думаю, в кривом ггуфе дело или в чём-то ещё.

кобальд еще не обновлен

Пон, спс, буду ждать

> 6 позиций в первой 10 там разные вариации miqu занимают

>Fimbulvetr V2 i1 11B обгоняет в рейтинге Лламу 3 и ещё несколько 70В моделей

Верим!

Поясните за обновление кобольда. Его заново качать или он может как-то апдейтнуться?

Он же файлом, можешь тыкнуть в кобальде проверку обновлений или тупо на гитхабе в релизах глянуть.

Ананасы, а что там с aya?

https://huggingface.co/CohereForAI/aya-23-35B

https://huggingface.co/CohereForAI/aya-23-35B

А что с ней? Файнтюн командира судя по всему.

Аноны, откуда и какие вы берёте карточки для ИИ? Я знаю про chub.ai, но каждый раз, когда я на него захожу, мне блять кривить начинает. Порекомендуйте что-ли интересных карточек на вечер, чтобы просто посидеть чайку попить, да поиграться с ИИ.

NSFW не предлагать, с NSFW карточками проблем нет.

NSFW не предлагать, с NSFW карточками проблем нет.

Шизоидная пиздец, контекст как и у командера жрёт. В русский может вроде бы норм, но шизит адски. Промпт для командера, семплинг крутил, но ничего не помогает, на вопрос отвечать тупо отказывается. Какой-то бредогенератор, но с ответов проиграл знатно. Может опять что-то в гуфах сломано. На последнем пике лама 70В, чтоб не думали что я ему поломанную карточку подсовываю, карточка конечно шизоидная, но лама справилась без проблем. На нормальной английской карточке тоже тупая пиздец, даже тест петуха не проходит.

Пиздец она весёлая судя по ответам.

Я только для нсфв карты вообще использую. Если хочется просто с ии поиграть то удобнее использовать чистую карту ИИ-ассистента с небольшой доработкой от сои.

Проверил на 8б версии в exl2 - нормально отвечает для своего уровня. 35б конечно в видимокарту не смогу загрузить, но если судить по аналогии то это не модель шизоидная, а дело вероятно в ггуф

https://www.characterhub.org/characters/darkfantasy109/hellen-skellen

Ты тульпа в голове неудачницы. Забавная карта я рофлил.

Интересно, локалки 7б-70б уперлись в потолок или через полгода мы будем плеваться на то, что сейчас считаем топом, т.е. на лламу3.

Не потолок, но близко к пределу трансформенной архитектуры, я щитаю. Хотя через год ллама 3 действительно будет считаться говном, если законодатели не поднасрут.

Спасибо, интересно.

Кажется меня затроллили, не могу поверить что модель может быть таким калом, но вот, как видите модель Llama-3SOME-8B-v1-GGUF Q5_K_M несет одну шизу.

Было у меня такое же, когда я пытался связать silly tavern и nitro.ai. Хуй знает, как чинить. Какой ты логический движок используешь? llama.cpp? kobold.cpp?

lamma.cpp бек убабуга

А, ну тогда хуй знает.

Говоришь им, что на третью лламу все тюны будут говном, но нет, не верят, качают. А потом удивляются, почему это они скачали кал.

Мне помогало увеличение размера модели, с Llama-8B на ph3-medium, но вот проблема в модели от майкрософта в том что, она слишком соевая. Такая модель не годится для ролеплея.

Теперь буду знать, спасибо

Можешь ещё температуру изменить. Бывает, что из-за низкой температуры модель шизить начинает. Но как-то странно, на самом деле.

Вообще не понял прикола, это тот же командер.

https://github.com/ggerganov/llama.cpp/tree/master/examples/rpc

Это настоящий прорыв.

Жаль что пока только для f16.

Это настоящий прорыв.

Жаль что пока только для f16.

Прорыв чего, канализации? Не вижу смысла, как я понял, это просто про последовательный запуск на разных ПК.

Ну теперь если есть старый пк можно и на нем запускать. И будет работать так же как если бы ты запускал на одном компе одновременно на нескольких видеокартах.

И теперь не надо что-то колхозить и пытаться втиснуть 3 тесты в один комп, можно будет просто запускать на разных компах.

У меня есть основной комп, ноут, старый комп, теперь я могу одновременно запускать на всех компах.

Пишут что нужна гигабитная локалка, от скорости интернета будет зависеть вывод модели

https://www.reddit.com/r/LocalLLaMA/comments/1cyzi9e/llamacpp_now_supports_distributed_inference/

https://www.reddit.com/r/LocalLLaMA/comments/1cyzi9e/llamacpp_now_supports_distributed_inference/

Имхо фигня это всё. То есть результат будет лучше, чем на одной видеокарте+CPU но далёк от результата рига, тем более от сервера. Лучше чем ничего - гораздо лучше, но даже не хорошо.

Влажные мечты.

Кот бы сомневался. Да и гигабит это минимум, десятка была бы лучше.

> Бывает, что из-за низкой температуры модель шизить начинает.

Такое бывает если модель мэх и/или ты что-то совсем странное запромтил, нарушив все форматы.

В целом неплохо, но насколько скорость интерфейса упадет? Киньте линк на рабочий ггуф коммандера+, потом попробую потестить на нескольких машинах.

> если есть старый пк можно и на нем запускать

Нельзя, нет никакого смысла.

> И будет работать так же как если бы ты запускал на одном компе одновременно на нескольких видеокартах.

Не будет.

> не надо что-то колхозить и пытаться втиснуть 3 тесты в один комп, можно будет просто запускать на разных компах.

Вот это может быть, но очень вероятно что пострадает как минимум скорость обработки контекста.

Почему задачу на русском не решает,а на английском решает одну и ту же задачу. Как можно называть это ИИ, если нет никакой рефлексии.

>Как можно называть это ИИ

Берёшь и меняешь определение ИИ, что ты как маленький.

>То есть результат будет лучше, чем на одной видеокарте+CPU но далёк от результата рига, тем более от сервера. Лучше чем ничего - гораздо лучше, но даже не хорошо.

Если это позволит крутить 70В модели на нескольких колабах, то будет-ахуенно! пока не забанят

мимо-колабанон

Потому что.

у этого можно скачать только https://huggingface.co/TheDrummer/Moistral-11B-v3

или ее квант какой хочешь. Все остальное поломанные модели.

Одна хорошая модель видимо пулучилась случайно, а поскольку второй раз в одну воронку снаряд не попадает то вообще больше ничего у него можно даже не смотреть - заведомо все поломано.

кажется есть подозрения почему так много испоганеных моделей. В карточке https://huggingface.co/TheDrummer/Cream-Phi-3-14B-v1

Есть часть параметров лоры, и там есть странности. Во-первых на 8x H100 80GB SXM GPUs при загрузке в 4-х битах он ставит

gradient_accumulation_steps: 1

micro_batch_size: 2

тогда как тут явно полезет больше чем 2, я бы поставил максимально влезающее, поэтому у него трейн лосс такой.

Второе - странное соотношение:

lora_r: 64

lora_alpha: 16

Хуй знает может это какое-то новое открытие, но вроде второе должно превышать первое.

Третье - не многовато ли

lora_dropout: 0.1

Вероятно последнее он делает из страха переобучения, видать по опыту первых моделей, которые если огульно охарактеризовать, могли только говорить хуй-пизда и ебля. Хотя можно ли вообще не то что перетрейнить насквозь зацензуренную фи, а хотя бы натрейнить на подобное это еще вопрос

Кто там заказывал тру переводчика? CohereForAI/aya-23-35B, файтюн коммандера 35b, на реддите очень высоко оценили способности.

coomand хвалили тут когда вышел, так что не надо ляля, у него только первые версии сломаны и моистрал 4

там еще и 8в версия есть

https://www.reddit.com/r/LocalLLaMA/comments/1cytmvn/cohereforaiaya2335b_hugging_face/

> micro_batch_size: 2

> lora_r: 64

> lora_alpha: 16

> lora_dropout: 0.1

> могли только говорить хуй-пизда и ебля

Проиграл, он там будто конфиг форчевских кумеров для сд взял и тренит. Как оно вообще себя показывает, тестил?

https://www.reddit.com/r/LocalLLaMA/comments/1cyxh1d/the_salesforce_finetune_of_llama_3_that_was/

Вчера как раз тыкал когда вспомнил о ней спустя неделю

Ниче так, отвечает умнее, но по моему отыгрыш слабее, сетка для работы

Хотя проверял на тсунгпт, а это тот еще мини минимализм который могут сетки и больше не подхватить не путаются в примерах сообщения отвечая только одним уже неплохо, мде

Вчера как раз тыкал когда вспомнил о ней спустя неделю

Ниче так, отвечает умнее, но по моему отыгрыш слабее, сетка для работы

Хотя проверял на тсунгпт, а это тот еще мини минимализм который могут сетки и больше не подхватить не путаются в примерах сообщения отвечая только одним уже неплохо, мде

>8x H100 80GB

>4-х битах

>14B

>batch_size: 2

Найс покупатель, берёт 8 картонок, а использует 0,5!

>Хотя можно ли вообще не то что перетрейнить насквозь зацензуренную фи, а хотя бы натрейнить на подобное это еще вопрос

Я бы начал с просмотра токенизатора, а то там может каждый хуй побитово кодируется в 50 токенов, ибо нехуй.

Ахуенная модель. На русском выдача лучше, чем у командера хоть загадку про книги и не решает

не ну ты конечно умные вопросы акве задавать тоже гений

Нужны тесты, насколько "тупеют" нейросети на тупых персонажах. А то станется, что даже младенец отстучит азбукой морзе (потому что говорить в карточке запретили) разложение числа 1729 на сумму кубов.

Хуита этот куумманд, поток поноса, вместо текста, без смысла и связи, как впрочем и 99% rp/erp файтюнов. Ориджинал модель куда лучше во всех смыслах.

>Ориджинал модель куда лучше во всех смыслах.

Два чаю, сижу на базе, только жду несломанных квантов.

Думаю зависит от того насколько хороша сетка в отыгрыше персонажа и рп в целом, если карточка хорошо села на сетку то и тупить может целенаправленно на акве.

куманд... интересно, типо от слова кумить. Такое подозрение что там русскоговорящие. А что так реагируешь, ты чтоли автор файнтюна? Скачивать мне это неохота чтоб заценить, я просто прочитал там примеры в карточке и почему то сильно подозреваю что оригинальный командир так тоже сможет, исходя из опыта с ним. А это значит что трейн не повлиял, другими словами не испортил модель. Опять же это только по примерам в карточке. Хотя здесь вот выше чел пишет что модель хуита. Ну а так мойстрал-3 стоит целого репозитория запоротых файнтюнов, даже если и вышел случайно, все равно thedrummer еблан-молодец.

Неделю или две думал, что rocm в лламе.цпп сломан, сегодня решил таки разобраться в чем дело и обнаружил, что я неверно указывал аргумент к make'у.

Но ведь раньше работало! Нет, раньше аргумент просто игнорировался, в ридми было указано использовать AMDGPU_TARGETS, что я и делал, а makefile читал GPU_TARGETS, в какой-то момент это пофиксили и мое неправильное значение для параметра начало ломать поддержку gpu.

Но ведь раньше работало! Нет, раньше аргумент просто игнорировался, в ридми было указано использовать AMDGPU_TARGETS, что я и делал, а makefile читал GPU_TARGETS, в какой-то момент это пофиксили и мое неправильное значение для параметра начало ломать поддержку gpu.

>кумить

>русскоговорящие

Он не знает...

>Неделю или две думал, что rocm в лламе.цпп сломан

А оказалось, что вся ллама.цпп сломана.

>Он не знает...

да не знаю, я же этим не интересуюсь.

>Нужны тесты, насколько "тупеют" нейросети на тупых персонажах.

Ну в принципе стараетсяв отыгрыш.

Мне нравится эта модель, слегка тупее командера, но в отыгрыше намного лучше и ответы поинтересней, особенно в рофл-карточках.

Оставлю как дефолтную кум-модель.

>75 гигов

Как вы их запускаете?

теперь узнал - ну вобщем это блять еще хуже чем я думал))

вы что тут все такие?

Русский у неё хуже чем у ламы, падежи постоянно проёбывает и очень странные выражения использует. Только как генератор смешных сообщений использовать если.

квантование, в итоге остается 20 гб на 4 кванте

https://huggingface.co/bartowski/aya-23-35B-GGUF

https://huggingface.co/legraphista/aya-23-35B-GGUF

https://huggingface.co/lmstudio-community/aya-23-35B-GGUF

https://huggingface.co/mradermacher/aya-23-35B-GGUF

https://huggingface.co/mradermacher/aya-23-35B-i1-GGUF

есть все размеры даже в 9 гигов в 1 бит - такое себе но для когото же квантуют тем не менее

>Русский у неё хуже чем у ламы

Сравнивать 70В и 35 В такое себе. Но она как минимум лучше командера, который всё время срал выражениями вроде "strangево"

Но если сравнивать, ответы лламы верные, но скучные, не хватает разнообразия для РП, тут же его навалом + сетка неплохо соображает для своего размера.

>Только как генератор смешных сообщений использовать если.

Ну всё теперь, на помойку однозначно!

> тут же его навалом

Ну это реально ощущается как рп-файнтюн в худших его проявлениях. Я погонял рпшные карточки и вполне неплохо. Но вот заставить ответить на вопрос во вчерашней карточке так и не смог, ему просто похуй, хотя лама всегда отвечает. Наркомания конечно знатная у него выходит.

> ответы лламы верные, но скучные

Yi 1.5 есть ещё. Она и не шизит, и при этом не сухая. Разве что в русский не может.

Так что там твой отец умеет?

Так а что для этого над? 3090?

У тебя скорее всего нейронка вопрос не понимает и отвечает на что-то типа "сколько людей в вашей семье - живой дед", поэтому всегда отвечает "у нас один живой дед". Высокая креативность и на понимание промпта так же действует - додумывает что хочет.

Да все она поняла, просто это нейронка с душой и тонко стебет анона прикидываясь дурочкой

Да, или врам или рам. Но на процессоре будет медленнее

А рам насколько медленнее чем врам, если я допустим сейчас 32 рам куплю сколько токенов в секунду мне она выдавать будет?

Ебать, гопота пробивает все днища. Зашёл в эту хуйню gpt-0, там реально мозгов ноль. Тупо не понимает вопросы и хуярит какие-то ебанутые простыни текста, которые к вопросам относятся очень слабо. Пиздец, блядь, это уровень 7b нахуй.

Меряешь скорость своей рам в аиде, чтение

Делишь скорость в гб/с из аиды на размеры скаченной тобой нейросети

Получаешь максимум токенов в секунду для этого размера нейросетей, в реальности чуть меньше

И вобще это есть в вики? Оп лентяй такую базовую инфу наверняка опять забыл добавить туда

Если у тебя есть хотя бы 8 гб рам, то можешь поиграться из интереса с сетками на 4 гб, это какие нибудь 7b на вроде openchat из шапки.

По гайду из шапки делай.

Ищи в gguf формате и качай какой нибудь 4km, должно точно влезть в 8гб.

Если рам больше то и запускать ты можешь модели побольше, но для 30b+ нужно хотя бы 32 рам, 70b 64гб

В среднем при скорости рам в 50-60 гб/с, 35b про которую ты спрашивал, в 4 кванте, тоесть около 20 гб + 8 гб контекст, даст тебе 60/30=2

Примерно 2-3 токена в секунду, не больше

Сетка на 4 гб даст все 10

>Делишь скорость в гб/с из аиды на размеры скаченной тобой нейросети

>Получаешь максимум токенов в секунду для этого размера нейросетей

Почему такой расчет? Можешь подробнее разъяснить? Непонимаю как скорость поделил на размер в гб и получил опять скорость, но уже токенов. Или это просто эмпирический расчет из практики

>Примерно 2-3 токена в секунду

Ну да, практически не юзабельно. Остается разве что какие нибудь p40 вылавливать. Но это уже слишком затратно для таких говняных сетей.

Как запускать айкью кванты? Кобольд пишет needs dequant и закрывается.

Потому что так работают сетки, один токен - это один раз прокрученная сквозь процессор всем своим размером нейросеть. Поэтому количество таких прокручиваний в секунду определяется скоростью памяти и размером модели.

Врам у тех же 3090 имеют 800гб/с что ли, и поэтому довольно бодро крутят любые модели что полностью влазят в их память.

Для ерп да, для работы приемлимо.

Тут в начале и 70b на процессорах крутили с 1-1.5 токенами в секунду, хех

Кодить сойдет, пока сам что то делаешь сетка на фоне пердит

Ну и всегда есть вариант запрашивать ответ у сеток 8-10 гб, ответ со скоростью до 5 токенов в секунду это скорость ненапряженного чтения. Так что это не напрягает.

Но на видимокартах конечно все веселее

А, оно через вулкан не работает. Пнятно.

>Но вот заставить ответить на вопрос во вчерашней карточке так и не смог, ему просто похуй

Так, спасиб - понятно с памятью. Но еще же производительность решает - 3090 явно побыстрей чем 3060, или это копейки а главное всеравно скорость памяти?

Главный упор всегда в объем памяти и ее скорость, нет таких быстрых и объемных видимокарт со слабым процессором, так что он никогда не становится главной проблемой

Так что главное объем, потом скорость, производительность процессора бесполезна без первых двух

> РП

Для РП база это Смауг. Он и рпшит хорошо, и по адекватности обычному инструкту не уступает. Все эти 34B имеют свои хорошие стороны, но бесит что надо всегда свайпать это говно чтоб не кринжовать, оно может 5 сообщений норм выдавать, а потом начать шизить и только с пятого свайпа одумываться. Ну и лупы на месте у Aya, так же и Yi страдает ими, они могут запросто целый абзац из прошлых сообщений заново повторить на больших контекстах.

че ответит на nigger

>Смауг

70В который? Сейчас бы его в противовес 35В модели выставлять, ты бы ещё с Мистралем сравнил.

С полгода назад обещали ливарюцию в LLM, state-space модели, мамба, вот это всё. Ну и где? Оказалось очередным пуком?

А че надо то? Мне вот все нравится: лама-3, командир, соляр и его файнтюны, да и мистраль тоже, да и лама-3 на 8б, вообще мелкие модели тоже нравятся с точки зрения чего они могут показать из себя при таких-то размерах. Смотри как жирно-богато на модели стало на лице и вспомни что было в том году когда только вышла первая лама - там же было скуднее во всем. В общем доволен развитием таким как есть, а кто не рад, то представьте что будет когда опенсорс прижмут, а то привыкли новую мродель еженедельно.

>Кто там заказывал тру переводчика?

Ну я заказывал.

>файтюн коммандера 35b

Мои тестовые отрывки переводит неплохо, но кое-какие мелкие ошибки допускает, память жрёт и тормозит - всё примерно как у оригинала, каких-то радикальных отличий не заметил.

>8в

И опять никаких прорывов. Логика отсутствует как класс, контекст не чувствует, всё как и у других моделей подобного размера. Разве что предложения на английском строит получше своих конкурентов.

Влияет или не влияет, ответьте.

Тот ропе с которым модель тренена должен работать лучше

Если в модели стоит 1000000 то пока ты используешь меньше контекста чем у нее максимального то все норм как я понимаю

А вот как с растягиванием контекста с таким уже задранным ропе хз

Ну и ты мог бы взять какую нибудь мелочь по типу 7b и потестить ее с разным ропе, уменьшая увеличивая и тд

сам такой ы

>И вобще это есть в вики?

Надо проверить эту методику расчёта. В теории конечно всё так, но на практике не хочу писать туда неверную информацию. Впрочем не откажусь от PR с пруфами, лол.

>Врам у тех же 3090 имеют 800гб/с что ли

950.

>нет таких быстрых и объемных видимокарт со слабым процессором

P40 же, в некоторых моментах сосёт по сравнению со своей скоростью.

>Оказалось очередным пуком?

Да.

Он скорее про новые архитектуры, а не очередной трансформер.

Т.е. нет смысла уменьшать стандартные настройки rope?

>P40 же, в некоторых моментах сосёт по сравнению со своей скоростью.

Ну так его и берут только ради 24гб врам, все новенькие карты с такими объемами производительнее

>Ну и где? Оказалось очередным пуком?

Есть же, большая модель на гибридной архитектуре тарснформерс и мамба. Только нам ее запускать не на чем, не квантуется и не поддерживается ничем, только оригинал.

jamba что ли название

Хорошо, что я обновил маршрутизатор.

Но зачем мне?..

Тем не менее, гигабитный маршрутизатор стоит 900 рублей в днсе, как бы, да, по кайфу бедным людям.

ОР

> 70b на процессорах крутили с 1-1.5

0,3-0,7 попрошу!

Да, 3090 по-быстрее, разница есть, просто не такая критичная, и никакого мастхэв брать только 3090 — нет. Вполне можно взять две 3060, если хочешь, просто погугли скорости, сравни, выбери лучший вариант.

Видяха быстрее проца в 5-10-20 раз. И на практике, большинство быстрее в 10-15 раз. Уже не так важна разница между ними.

> Надо проверить эту методику расчёта. В теории конечно всё так, но на практике не хочу писать туда неверную информацию.

На практике, 50 гиговые модели выдавали 0,7 токена при 45 гигах чтения.

Т.е., в общем верно, просто надо делать скидку на пержение самого софта.

Можно затестить, канеш. Стоит.

Но в общем, математика плюс-минус верная.

Посоветуете бек с RAG

Чисто мамбу не поняли как применять и не знают возможно ли это. Запилили гибрид мамбы и трансформеров который смог уменьшить стоимость инференса в разы и все собсна. Такое ощущение что кроме оптимизации моделей ничего сейчас и не происходит.

А Флэш Атеншн на свежем Кобольде на теслах работает однако.

AnythingLLM вроде норм

>Такое ощущение что кроме оптимизации моделей ничего сейчас и не происходит.

Да и оптимизации не видно. Где 70B на моих 12 гигах в 16 битах?

У тебя появились 8б которые работают кск 70б раньше. Вот какие оптимизации

Где такие чудесные модели? Нет таких, 8B есть восемь бэ, они всё равно тупые.

https://www.reddit.com/r/LocalLLaMA/comments/1cz6izm/hey_microsoft_it_has_been_a_while/

ну, где то в полу годе от нас +-

Тут пишут, что многие файнтюны сломаны. А как именно сломаны? Ну, то есть, я вот потыкал парочку для третьей 8b ламы, парочку для, вероятно, 13b второй, и ещё какую-то рандомную 23b модель. Ну да, они путаются в контексте частенько, особенно если его много, иногда даже в пределах одной генерации могут сами себе противоречить. Но это же обычное поведение для подобного размера, нет?

Как через локальную модель перевести текстовый документ в формате например .txt ?

Использую кобольда, весь текст не лезет. а кусками заебешься переводить. Я перевожу текст внутри кода через промт, обычный переводчик ломает код.

Статья ещё от 27 Feb, полгода от февраля считать или от сейчас? А выходные считаются? А праздники? Я слышал, что...

>А как именно сломаны?

Надо смотреть по конкретному предку. По факту все тюны мику сломаны просто по отсутствию неквантованных версий. По лламе 3 8B, тут вопрос в том, что изначально модель обучена весьма плотно, и её очень легко поломать. По старым проще, они не такие набитые, поэтому тюны старых тренашек вполне себе неплохи.

Что же на счёт "обычное поведение", то нет, если модель норм, то сама себе в одном ответе противоречить не должна.

Кроме фи и этого

>Default thread count will not exceed 8 unless overridden, this helps mitigate e-core issues.

ничего интересного.

> Llama-3-Lumimaid-8B

Потестил тут. Пока что есть версии только 8б и 70б + 200б

Жду пока что 12-13-20. Так вооот. А не плохо. Языковой набор поболее будет чем у второй ламы. Работает намного быстрее аналогов от второй ламы. Буду ждать более крупные версии.

Ну и единственный минус. Обновили еще Unholy до llm3 8b. Вот там чет напортачили с тюнами. Тупит по страшному.

Потестил тут. Пока что есть версии только 8б и 70б + 200б

Жду пока что 12-13-20. Так вооот. А не плохо. Языковой набор поболее будет чем у второй ламы. Работает намного быстрее аналогов от второй ламы. Буду ждать более крупные версии.

Ну и единственный минус. Обновили еще Unholy до llm3 8b. Вот там чет напортачили с тюнами. Тупит по страшному.

> для работы приемлимо.

Какой работы? Код писать - замучаешься ждать пока она пропердится. Что-то массово автоматизировать - вообще теряется весь смысл. Хз даже в каком сценарии кроме "попробовать" оно подойдет.

Не взлетело. Наяривай командира, он оче хорош.

> Если в модели стоит 1000000 то пока ты используешь меньше контекста чем у нее максимального то все норм как я понимаю

Двачую, все верно.

Это приведет к непредсказуемому поведению и скорее всего станет хуже.

Кормить чанками, напиши простейший скрипт который будет бить на части по абзацам и делать запрос по api, потом склеивая. Сложно - попроси нейросеть написать тебе его.

> > Llama-3-Lumimaid-8B

Как оно для рп то не сказал.

>Это приведет к непредсказуемому поведению и скорее всего станет хуже.

Ясно, спасибо.

> Как оно для рп то не сказал.

В целом нормально. Понятное дело что уступает второй ламе большего размера. Но если сравнивать 7б модели и эту 8б то однозначно ллм3 тут выигрывает во всем. Плюс заметил отличие от ллм2, ллм3 следует карточке прям идеально.

>Кроме фи и

Решил ещё раз потыкать палочкой в этого лоботомита... Короче датасеты там зачищены настолько хорошо, что даже префил Sure! не помогает. Один раз выдало, и то выглядит как удача, в остальные роллы просто даёт ссылки на соевые законы.

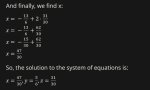

Зато простую систему из 3-х уравнений решает. Ллама 8B кажется не могла. На более сложной системе (где все три буковки встречаются все три раза) заваливается.

Ничего интересного короче, скучная неделя. Потолок близко!

Кек, это же система уравнений, которую я сюда вбрасывал.

Она кстати из компьютерной игры.

Когда починят ебаную лламу.цпп (прям полностью, а не отдельные баги), добавьте в шапку жирным шрифтом, а то заебало ежедневно лихорадочно читать тред и мониторить баг трекер. Спасибо.

inb4 никогда

inb4 никогда

А что тебе чинить надо там? На текущий момент всё работает.

Правильнее было бы сказать что косяк еще не заметили

Третья Ллама 8В вполне может потягаться с первой 70В

Что я могу сказать после испытаний? На трёх теслах на свежем Кобольде с включённым Флэш Атеншеном 70В_Q6 выдаёт где-то 6,5 токенов в секунду после заполнения окна в 8к контекста. Пятый квант соответственно ещё больше. Раньше на 5KM в тех же условиях было 4 токена. Было 4 на пятом кванте, а теперь 6,5 на шестом. Такие дела.

>Третья Ллама 8В вполне может потягаться с первой 70В

не было такой, есть 65В

И что ты прям видишь разницу между работой 5 и 6 кванта?

Может в тред со скриншотами эту разницу скинешь?

Ну за исключением скорости генерации.

>И что ты прям видишь разницу между работой 5 и 6 кванта?

Ну, тут сложно сказать. Мой пойнт, как говорят американцы, был не в этом. На пятом кванте я и 10 токенов видел... без контекста. Вот если увеличение количества тесл действительно немного повышает скорость генерации (с rowsplit, и похоже, что это так), то на 4 теслах есть шанс замахнутся на восьмой легаси квант для 70B. Это круто - сама такая возможность. Ну а с практической точки зрения пятого кванта вполне хватит и теперь он у меня 7,5 токенов даёт. С контекстом. Это уже прямо хорошо.

Слишком быстро чтобы быть правдой, соответствует теоретически возможной скорости без учета всякого, с мгновенной обработкой промта и примитивным семплированием. Флеш атеншн по заявлениям на теслах давал едва измеримый прирост.

Сколько там в консоли пишет, особенно на больших контекстах лучше покажи. Плюс холодную обработку большого, а потом повторный прогон уже с кэшем, вот это интересно увидеть.

Чую наебку, у меня на 3090 скорость чуть выше на exl2, а тут ггуф, еще и на теслах! Слишком круто.

Запилил небольшой скрипт, который грузит ОП-посты из /б и пишет краткое содержание. Забавная хуита.

>Не, мне влом. Тут есть люди с теслами, пусть подтвердят. Или опровергнут. Мне уже всё равно - у меня всё хорошо. С января собирать начал.

Да он пиздит, ведь можно было бы пруфануть за 5 секунд. split-row на 2-3 картах медленнее разбивки по слоям, их надо больше чтоб пошёл прирост. FA на больших моделях даёт 3-5% прироста, там основной упор в память всё так же. Алсо, q5 медленнее q4 в любых вариантах, для скорости либо q4, либо fp16 берут, все нечётные кванты сосут по скорости. То что он фантазирует - это производительность двух 3090.

Да он пиздит, ведь можно было бы пруфануть за 5 секунд. split-row на 2-3 картах медленнее разбивки по слоям, их надо больше чтоб пошёл прирост. FA на больших моделях даёт 3-5% прироста, там основной упор в память всё так же. Алсо, q5 медленнее q4 в любых вариантах, для скорости либо q4, либо fp16 берут, все нечётные кванты сосут по скорости. То что он фантазирует - это производительность двух 3090.

Две 3090 такие медленные, стоп, что?

Тут на четвертом кванте уже было 6-8 токенов, а вы на 3090 имеете 8-10? Не понял, а какой смысл в 3090 тогда был? Разве там не вдвое быстрее, хотя бы 10-15?

>split-row на 2-3 картах медленнее разбивки по слоям, их надо больше чтоб пошёл прирост.

Вот это смелое заявление вообще.

>Тут на четвертом кванте уже было 6-8 токенов

Не. 6-8 токенов на 4 кванте было без контекста. А у 3090 ещё и FA есть. Но теперь всё изменилось.

Он и не должен быть быстрым без нвлинка. При разбитии по строкам сильно больше информации между картами передаётся.

Через апи макабы (он же вроде был какой-то?) или обработчик веб страницы какой пилил? Рассказывай, интересно.

А, ну раз все хорошо, значит придется верить в небылицы

мимо получаю ускорение 70-104б до 35т/с катая на 4х гпу объединенных через локалку

> Да он пиздит, ведь можно было бы пруфануть за 5 секунд.

В том то и суть, во-первых, обработка промта замедляется при увеличении количества гпу в жоре. Хуй знает в чем причина, но подтвержденный факт. Во-вторых, 6.5т/с на том размере - буквально теоретический максимум с учетом медленной врам теслы, а по факту там и меньше получится. Плюс у жоры реализацию разной битности, которая позволяет работать на железе что по дефолту даже в фп16 быстро не может, не самая эффективная.

> То что он фантазирует - это производительность двух 3090

Емнип в 4.6 битах 70б парах 3090 давала в районе 13 т/с, увеличение кванта даст +- пропорциональное падение. Если будет спрос то могу померить, но тут владельцев 3090 довольно много, может кто раньше сделает.

Они примерно в 2-3 раза быстрее, а за счет полноценно работающего FA, нативной совместимости с дробными точностями и прочего может еще превосходить. Но главный аргумент - их можно юзать для чего угодно, а не только поломанного жору сношать.

Вот кстати, катал кто с разными шинами, нвлинком и прочее сравнение? Есть ли вообще смысл с ним заморачиваться хотябы для чего-то? Вроде в 3090 "взломали"/заабузили обращения в память друг друга, которая есть только в старших карточках, но применения этому не видно.

и еще есть ли гибкие шлейфы как на старых сли, или только что-то колхозить если карточки разных вендоров?

>При разбитии по строкам сильно больше информации между картами передаётся.

Да-да, и вот тут нам особенно хорошо помогают 44 линии PCI express. Если у нас они есть конечно.

> 44 линии PCI express

3.0 не забывай добавлять, а в случае трех карточек псп там как у средних ссд получится. Плюс на некропеке всяких ребаров не будет, соответственно будет скакать через профессор.

У меня на 3х3090 в среднем 9,5 т/с на лламе 3 70b 6bpw(на мамке правда pci-e 3.0: 16,16,4), ща скачаю 4bpw и проверю на двух с pci-e x16.

Ну что там аноны, завезли уже что нибудь лучше чем командир? Как там дела с лламой3 на данный момент?

>3.0 не забывай добавлять, а в случае трех карточек псп там как у средних ссд получится.

Если бы только я заявлял, что rowsplit почти удваивает скорость генерации, то оно бы и ладно. Но другие тесловоды тоже это подтверждают, даже чуть ли не на райзерах. Так что мимо.

Без FA и без контекста 6.45

Без FA и с контекстом 83 процесс/3,5 ген/1,75 тотал

С FA без контекста 6.6

С FA и с контекстом 83 процесс/5,6 ген/1,78 тотал

2 теслы, q4_K_M.

Ну, действительно, падение генерации существенно меньше.

Кайф-кайф!

Без FA и с контекстом 83 процесс/3,5 ген/1,75 тотал

С FA без контекста 6.6

С FA и с контекстом 83 процесс/5,6 ген/1,78 тотал

2 теслы, q4_K_M.

Ну, действительно, падение генерации существенно меньше.

Кайф-кайф!

> в районе 13 т/с

Ну вот, да.

Так. Без ровсплита там 4 токена, а с ним 6,5, ну как бы и окей. Нах без ровсплита юзать-то тогда. Да еще и нагрузка скачет по картам туда-сюда.

Ну мне ллама 3 70В заходит, с логикой куда лучше чем у коммандора плюс(хотя он у меня мейн для rp/erp и длина контекста разнится, да(8к против 40к)), но ллама после 4к контекста начинает лупиться, то есть сохраняет структуру ответов(типа: "действие", "char", "действие", "char") и стопорится в развитии сюжета/действиях(становятся однотипными), даже ООС не вытягивет.

>Через апи макабы (он же вроде был какой-то?)

Да, это элементарно делается, просто грузишь https://2ch.hk/b/catalog.json, и там готовый жсон со всеми оп-постами.

Заявлений всяких разных много, у кого-то вон вообще пришествие AGI полным ходом идет, а тут еще мотивация есть. На гитхабе в обсуждениях и пр сравнения и эффекты показаны, они последовательны и согласованы, нет там подобной магии.

У тебя же противоречивые (то нужна псп шины, то на райзерах) и нежелание показать лог консоли, ну хуй знает.

Действительно, спасибо.

А с тремя теслами есть здесь ещё люди? Понятно, что у них и плата будет соответствующая, но всё равно интересно сравнить.

> против 40к

Этож сколько у тебя памяти, чтобы на 40к контекста крутить?

А что вообще flash-attention делает с технической точки зрения?

> другие тесловоды

У Жоры во всех обсуждениях писали что +30-50% даёт с нвлинком, когда только завезли разбивку по слоям, сейчас пишут row-split с голыми картами медленнее. Фантазируй поменьше. У меня у самого две P40, row-split медленнее процентов на 20%.

>У меня у самого две P40, row-split медленнее процентов на 20%.

Это интересно. Остальная конфигурация какая? Плата, процессор, память?

> ллама после 4к контекста начинает лупиться

Не пизди, у меня до упора в 8К всё отлично на обычном инструкте 70В.

> Плата, процессор, память?

Z690, Интел 13700К, DDR5 7200. Нигде не видел подтверждений что без нвлинка оно может быть быстрее.

Судя по статье и её оригиналу на CNBC приняли хуиту какую-то ебейшую, запретили систему соцрейтинга, распознавание эмоций и систему предсказания преступлений для нужд полиции.

Судя по всему они сериалов насмотрелись и аниме про ужасы киберпанка, соцрейтинг и распознавание эмоций был в черном зеркале, система предсказания преступлений в психопаспорте, к нашим ллм это все отношения не имеет, в теории их можно к этому приспособить, конечно, но тут именно что речь будет идти о конкретных имплементациях.

>Нигде не видел подтверждений что без нвлинка оно может быть быстрее.

Я наоборот видел в обсуждениях, что Нвлинк в лламе не поддерживается. Я ускорение от rowsplit видел лично. Хз, может второй карте линий PCIe не хватает.

Что там ставить нужно чтобы стало медленнее/быстрее? Есть пара гпу в х16 3.0, плак плак слотах, вечером могу проверить.

Там самый смак в том что нужно доказывать что датасеты все чистые без копирайта, и чет еще такое же дальше, безопасность ляляля

А только все ллм в том числе чатгопота соскрабили весь инет и знания мира плевать хотев на права

В итоге с палками в колесах на запрет "пиратства" хуи они пососут в создании ии

И сколько же у тебя без ровсплита и с ним?

Почему у всех ровсплите ускоряет, а у тебя замедляет?

Поясни, че-то странно.

Еще и один слот, небось, х4, не? =D

> у всех ровсплите ускоряет

Не пизди не у всех.

>Есть пара гпу

Гпу гпу рознь. А так - свежий кобольд, --usecublas rowsplit, --flashattention, --tensor_split какой надо - ничего сверхестественного.

Ты еболклак, там написана что каждая в х16.

Заебись тебе, только на реддите есть неоднократные обсуждения заЛУПов именно лламы 3 в rp/erp, я видимо попал в их число.

https://www.reddit.com/r/LocalLLaMA/comments/1ca6ug6/huggingchat_metallama370binstruct_repeats_itself/

У меня какой-то подосланный квант(от турбодерпа exl2), имхо, жрет всего ~12gb(подозреваю что контекст в 4 кванте), но проблемы с контекстом я замечал, только после 25к.

Проверил на 4bpw получил ~15т/с.

Ну литерали ты один. =) Никогда такого нигде не было, и вдруг ты появился.

Так может дело не в ровсплите, а? Надо выяснить.

Давай, сколько у тебя там скорости с какой моделью, с каким контекстом. Потестить не сложно.

Сам ебоклак, юмора не понимаешь. =) Тут в свое время была куча людей, которые тоже так думали, а потом начали проверять спеки, а там…

———

Давайте уже тесты, заебали попусту пиздеть. Интересно ж понять, что и как и у кого работает.

> и вдруг ты появился.

Я другой анон так то. Просто прикопался к формулировке, ну и да у меня 4090 в связке с п40 и таки ровсплит съедает сколько то там итсов.

Что за файл consolidated.safetensors на 15 гб в чистом мистрале? Его надо качать или только model001-model003

> у меня 4090 в связке с п40 и таки ровсплит съедает сколько то там итсов.

Было бы странно ожидать иного. А вообще я где-то слышал, что rowsplit вообще только на старых архитектурах ускорение даёт. Может и ошибаюсь.

Ты пиздец странный по письму сразу видно, иметь ии риг с парой гпу и не знать спеков.

Подождешь, написано же что вечером. Есть и где один слот х4 а второй полноценный, но врядли этот конфиг окажется медленнее. а можно и вообще в одну карточку загрузить, так-то целое исследование

> другие тесловоды тоже это подтверждают

Я надеюсь ты не про таблички из llama-bench? Потому что там есть нюанс.

https://www.reddit.com/r/LocalLLaMA/comments/1d0b3w9/jamba_gguf/

о нихуя, недавно только писал что нет поддержки

о нихуя, недавно только писал что нет поддержки

просто хочу всем напомнить - и кобальд и ллама криво считают скорость в токенах, лучше самостоятельно таймер ставьте и делите токены на секунды

> и кобальд и ллама криво считают скорость в токенах

В последнем релизе кобальда это должно было быть поправлено. Да и по ощущениям - быстро, знаете ли.

Собрал датасет с инструкциями по шантажу, селфхарму, доведению до ркн, производству веществ и разными весёлыми вещами. На русском. Планирую пропихнуть это в глотку третьей лламе. Ваши ставки, что получится? Говно.

Какой сейчас лламой пользуется анон? Вышел ли какой-нибудь крышесносный файнтьюн?

Быстрее чем на моих 3090ых! Круто! Так и знал, что зря их покупал, надо было запасаться теслами! (а так согласен с оратором выше, лог пиздит)

Бенчмарк покажи, нах ты без указания модель какие-то цифры в вакууме принёс.

Ну запусти Мику-5KM на Кобольде, пусть и у тебя попиздит. По крайней мере сравним отношения пиздежей - тоже показатель.

>Бенчмарк покажи, нах ты без указания модель какие-то цифры в вакууме принёс.

Мне для дома, для семьи. Бенчмарками не интересуюсь. Теперь стало удобно - меня это устраивает.

> сто постов отмазывается и не может за минуту прогнать бенч

Ясно.

Не знал, что я тебе что-то должен.

А че, где бенч жать, какую файлу?

Теперь знаешь.

Измерил свежий мистраль, дает пососать старому и третьей ламе.

Это перплексити? Ты же в курсе, что перплексити — это про расхождение между неквантованной моделью и квантованной?.. Не совсем про ум…

А еще это просто попугаи которые нельзя сравнивать между другими моделями

Дрочь на перплексити хуита полная

>перплексити — это про расхождение между неквантованной моделью и квантованной?

Нет, это про знание текста википедии.

>попугаи которые нельзя сравнивать между другими моделями

Эту мульку придумали авторы говномоделей.

Тесты показывают прямую зависимость между умом модели и уменьшением перплексити.

эта хуита только показывает как точно надрочена сетка викитексту, лул

Они все на википедию надрочены, википедия это база всех датасетов, это показывает насколько хорошо они могут пользоваться этими знаниями - у лучших моделей перплексити всегда ниже, пруфы я дал.

Без обид, но как раз пруфов ты не дал.

Типа, скрин с рейтингом — это не пруф.

Пруф — это папира какая-нибудь.

В общем, я сам ппл люблю, но для сравнения деградации от одного кванта к другому в рамках конкретной модели и софта. А не всего и сразу.

Простите, останусь несколько скептичен.

Аноны, это наш?

https://huggingface.co/Sosnitskij

Анон, а как ты заставил эти карточки отвечать на русском? Тоже тестил эту модель, но для того, что бы ИИ стал на русском балакать, мне приходилось в описание карточки прописывать "She respond only in Russian language" или что-то типа того, что подходит под контекст самого описпания. При чём на некоторых карточках даже этот костыль не работал. Я так понимаю, что можно примерно тоже самое говно прописывать в системный промпт, но чтобы это работало надо ещё отключить настройку, которая предпочитает описание карточки?

https://huggingface.co/Sosnitskij

Анон, а как ты заставил эти карточки отвечать на русском? Тоже тестил эту модель, но для того, что бы ИИ стал на русском балакать, мне приходилось в описание карточки прописывать "She respond only in Russian language" или что-то типа того, что подходит под контекст самого описпания. При чём на некоторых карточках даже этот костыль не работал. Я так понимаю, что можно примерно тоже самое говно прописывать в системный промпт, но чтобы это работало надо ещё отключить настройку, которая предпочитает описание карточки?

Я только сейчас допёр, что может быть надо было перевести описание карточки на русский и скормить ИИ карточку именно с русcким описанием?

Лучше измерь уровень сои, и вот тогда поговорим.

Лучше переведи примеры диалогов на русский, а описание как раз можешь на английском оставить.

>скрин с рейтингом — это не пруф

Притом что он легко читаем и легко верифицируется так как такой тест может провести каждый

>Пруф — это папира какая-нибудь.

Ты все равно предпочитаешь слепо верить научной бумаге которую скорее всего даже не поймешь и уж точно сам не проверишь на подлинность.

Казалось бы, 21 век должен был уже выбить из людей такую гнилую вещь как веру в авторитеты, но увы.

Скажи как - измерю, не вопрос.

По моему самая умная ~7б.

Но про DSBM не сразу вспоминает.

Алсо, куда делись 13б-20б? Если Мета не пилит значит никто не будет?

Можно так https://2ch.hk/ai/res/728812.html#730315 или так

Можешь с ней покумить и посмотреть.

А вообще, просто попроси у нее ссылку на цп или наркоту. Сразу будет видно who is who.

Ллама-3 тоже у меня не помнит. Мне кажется, что она его путает с бдсм. Можно решить этот вопрос костылем websearch, чтобы нейронка гуглила перед ответом.

Это не надежный бенчмарк + я так и так это делаю, только заставляю рассказать историю про износ и цп. Только суть в том что с хорошей карточкой и правильной инструкцией они все выполняют запрос.

Анон, у меня имеется в наличии несколько 4090. Хочу потыкать самую умную модель, и дообучить на математике и философии. И вообще хочу сделать себе виртуального ассистента. Правильно я понимаю, что сейчас самый топом будет Llama-3 70B? Брать сырую или какие-то доработки есть?

И главный вопрос — как её запускать? Пробовал с oobabooga, но пока не удалось настроить даже с самыми простыми моделями, ошибку при запуске выдаёт. К тому же, я не совсем понял, подгружает ли он несколько видеокарт.

Также, интересно, как именно дообучать. Каким методом, ЛОРУ обучать?

И ещё вопрос — а формулы TeX'ать автоматически будет, как в ChatGPT, или нет?

В общем, помоги, анонче.

И главный вопрос — как её запускать? Пробовал с oobabooga, но пока не удалось настроить даже с самыми простыми моделями, ошибку при запуске выдаёт. К тому же, я не совсем понял, подгружает ли он несколько видеокарт.

Также, интересно, как именно дообучать. Каким методом, ЛОРУ обучать?

И ещё вопрос — а формулы TeX'ать автоматически будет, как в ChatGPT, или нет?

В общем, помоги, анонче.

>а формулы TeX'ать автоматически будет

Ставь галочку и всё будет.

Ах да, как ты с таким ICQ завладел несколькими 4090? Не понятно. Умный человек сам бы запустил по гайдам из шапки.

>Алсо, куда делись 13б-20б?

20В это франкенштейны от 13В, нет 13В - нет и 20В.

>Если Мета не пилит значит никто не будет?

Ну вот китайцы есть, у них есть Квен 14В, надо?

https://huggingface.co/Qwen/Qwen1.5-14B

Хочу делать свои карточки персонажей, готовые муть какая-то. Посоветуйте редактор - чтобы можно было поля заполнить, картинку вставить и на выходе получить png-картинку с тэгами, которую примет Таверна.

Ламу 70В никак не запихнуть в 4090(двухбитные лоботомиты не в счет, они тупее 7В), можно только загрузить через цпу с выгрузкой части слоев на видеокарту. Скорость будет 2.5 токена в секунду максимум.

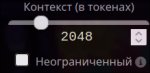

Чтобы это провернуть скачиваешь кобольд из шапки и делаешь настройки как на пике.

Так и закинь примеры диалогов тогда. Там и посмотрим, где будут высираться ответы про уважение и безопасность, а где будет жёсткий настоящий износ. Скинь сравнение с лламой.

В таверне и делай.

Тебе не нужен редактор, Таверны достаточно. Создай карточку и пиши, можешь дополнительные поля использовать, можешь только основные, главное описание напиши.

Тащ майор, сами такое постите.

Тогда хотя бы напиши "по ощущениям" оно как. А то тест на знание википедии это вообще ни о чем.

Спасибо.

В шапке написано, что можно запихнуть, если взять несколько 4090 (а у меня их как раз несколько), но не написано, как именно это сделать. Создалось ощущение, что все среды написаны для машин с одной видеокартой. Даже у тебя на скриншоте всё выглядит так, как будто бы можно только одну видеокарту. Хотя, может, если видеокарт несколько, там иначе становится. А если на системе нет графической оболочки, кобольд не поднять?

Кобольд можно чисто на проце запускать, если скачать nocuda версию. Но тебе она ни к чему, раз несколько 4090 пылятся.

Качай убабугу по гайду из вики и довольно урчи. Можешь и кобольда, но это форк жоры со всеми вытекающими, использовать его имея мощные гпу мало смысла.

> как её запускать

gpu-split в Exllama выстави, для первой карточки поменьше с учетом отжора контекста, например

> 21,24

и все.

> дообучить на математике и философии

Сколько штук у тебя что стоят в одной пекарне?

> Ламу 70В никак не запихнуть в 4090

> имеется в наличии несколько 4090

Мдэ

>В шапке написано, что можно запихнуть, если взять несколько 4090 (а у меня их как раз несколько)

Можно, спроси у анона итт который три Р40 параллельно использует. У меня одна 4090.

>А если на системе нет графической оболочки, кобольд не поднять?

Блядь, ты еще и линуксоид.

Если ты любитель ебаться в консольку, то тебе к Жоре. Но учти что он для цпу в первую очередь свою шнягу делает.

https://github.com/ggerganov/llama.cpp

Можно ещё спросить о имени кота Говарада Лавкрафта.

>Блядь, ты еще и линуксоид.

>Если ты любитель ебаться в консольку, то тебе к Жоре. Но учти что он для цпу в первую очередь свою шнягу делает.

>https://github.com/ggerganov/llama.cpp

Ты ему хуйню рекомендуешь. Koboldcpp поднимается без графического окружения, а голую llama.cpp тяжело связать с фронтендом.

>А если на системе нет графической оболочки, кобольд не поднять?

Можно, я именно так koboldcpp и использую. Только при запуске сразу указывай модель. Тогда запуститься без фронтенда в вебгуи.

>Только при запуске сразу указывай модель.

через аргумент --model, естесно.

>Ты ему хуйню рекомендуешь. Koboldcpp поднимается без графического окружения, а голую llama.cpp тяжело связать с фронтендом.

Очень "тяжело", вместо koboldcpp в таверне выбрать llama.cpp следующей строкой.

> Можно, спроси у анона итт который три Р40 параллельно использует

Спрашивать у подозреваемого в обмане, да еще мало шарящего в теме - сомнительно.

> любитель ебаться в консольку

Все бэки кроме всяких ллм студио запускаются через консоль. В кобольде придется указать модель и стартанет, но хз что будет с интерфейсом, в убе будет полноценный интерфейс через браузер.

> а голую llama.cpp тяжело связать с фронтендом

Точно также как и кобольда

>Точно также как и кобольда

Нет, все настройки в таверне такие, температура, макс кол-во токнов и т.д. не будут влиять на лламу. Голая ллама как-то более на отъебись и хладнокровно относится к карточке персонажа.

>не будут влиять на лламу

С чего бы? Как минимум макс токены есть в лламаЦПсервере, да и остальное, уверен, что работает.

>Спрашивать у подозреваемого в обмане, да еще мало шарящего в теме - сомнительно.

Т.е. ты думаешь он в фотошопе скрины нарисовал или что? И зачем? Перед тремя с половиной анонами в треде покрасоваться?

>"n_ctx":512

Хуй знает, почему-то у меня не влияет.

Эм, размер контекста задаётся при загрузке модели, таверна тут слишком поздно. Я думал ты про длину ответа и прочие температуры, вот они работают.

Охуеть, у них там походу так сои накидали что даже лама 3 завидует. Нет, спасибо.

>Эм, размер контекста задаётся при загрузке модели, таверна тут слишком поздно.

Да, я походу тут насрал и не прав.

А на кобольд что, влияет? Там то же самое, ты контекст при запуске самого кобольда указываешь.

Она может и просто не знать. Потести ещё чем-то.

>лама 3 завидует

Ну так в ламе 3 сои и нет.

https://huggingface.co/fearlessdots/Llama-3-Alpha-Centauri-v0.1-GGUF

This series aims to develop highly uncensored Large Language Models (LLMs) with the following focuses:

• Science, Technology, Engineering, and Mathematics (STEM)

• Computer Science (including programming)

• Social Sciences

And several key cognitive skills, including but not limited to:

• Reasoning and logical deduction

• Critical thinking

• Analysis

This series aims to develop highly uncensored Large Language Models (LLMs) with the following focuses:

• Science, Technology, Engineering, and Mathematics (STEM)

• Computer Science (including programming)

• Social Sciences

And several key cognitive skills, including but not limited to:

• Reasoning and logical deduction

• Critical thinking

• Analysis

Не-не. Я реально не прав был. На лламу влияют настройки таверны. Температура и т.д. Сейчас даже специально перепроверил с более ифнромативным выводом.

А что за версия лламы 3, раз она в русский могёт? Метавская же только на анлийском базарит?

Нет, но ведет себя странно да и на этих не показал модель. Какбы дефолт в скрине лог загрузки а потом скорости токенов на разных контекстах, а он выцепил отрывки с полным кэшем потому что если там будет сколь значимая обработка можно будет сразу мордой ткнуть на небольшом контексте где уже наблюдается просадка.

> Перед тремя с половиной анонами в треде покрасоваться?

Ну да, ты его посты не видел чтоли?

Но это не важно, врядли скажет что-то кроме "запускайте кобольда ничего не трогая или добавляя роу-сплит" потому что тут и говорить особо нечего. И жора для ады - ну такое.

Дефолтная 70В, ггуф квант от Бартовского.

https://huggingface.co/bartowski/Meta-Llama-3-70B-Instruct-GGUF

Я пробовал, очень медленно получилось.

>Качай убабугу по гайду из вики и довольно урчи.

Сегодня пробовал поднять, но выдавало ошибку, которая не гуглилась, что-то про type error и то, что ожидался тип ллама, но подано none. Возможно, потому, что я Q8_0-версию пытался запустить.

>Можешь и кобольда, но это форк жоры со всеми вытекающими, использовать его имея мощные гпу мало смысла.

Хм, спасибо, учту.

>gpu-split в Exllama выстави, для первой карточки поменьше с учетом отжора контекста, например 21,24 и все.

Спасибо!

>Сколько штук у тебя что стоят в одной пекарне?

8. Можно ли как-то примерно оценить, на что можно с таким количеством рассчитывать? По результату и затраченному на его достижение времени. Может, где-то это уже сделано?

>три Р40 параллельно использует

А для каких целей? Я просто тред не читай @ сразу отвечай.

>Если ты любитель ебаться в консольку, то тебе к Жоре. Но учти что он для цпу в первую очередь свою шнягу делает.

Кстати, уже использовал, как раз когда видеокарт не было.

>Можно, я именно так koboldcpp и использую. Только при запуске сразу указывай модель. Тогда запуститься без фронтенда в вебгуи.

Понял, спасибо большое!

Мне, кстати, как раз нужно будет задавать кастомные температуры и длину ответа. И желательно не прописыванием это в консоль, а в WebUI. Это во всех средах реализовано, или нет?

О, здорово! Потещу, как подниму, спасибо.

Ещё такой вопрос: а какую всё же модель брать, чтобы с русским языком, 70B и возможностью получить ассистента без сои я на философии Дугина её собираюсь обучать, неприятие критики гомонегров и прочих гендерных теорий мне меньше всего нужно?

Я, кстати, вот эту скачал как раз, но ещё пока не проверил.

>Ну да, ты его посты не видел чтоли?

Ну человек деньги выкинул, время потратил, вот и ищет признания что не зря этим занимался.

Так-то понятно что Р40 слабенькие чтобы реально хорошую скорость давать.

Хрена себе. Я думал, что её не тренировали на русском.

Хотя я использую 8B версию тоже от квант от Бартовского, но у меня чому-то она соевая пиздос и странно себя на русском ведёт.

май ингришь из вери бэд сорри

Так авторитеты-то тут причем.

Меня интересует смысл.

Уж понять проблем нет, давай слепую веру бумаге ты оставишь себе, не переноси с больной головый на здоровую.