Шапку взял новую, но ссылку на каллаб оставил, а то больно бывает смотреть на мимокроков с GT710 и прочими продуктами жизнедеятельности мамонтов.

Хуясе шапка новая

А пикча треда старая

А пикча треда старая

Блядь, только вопрос задал, тут же перекатили....

Здарова, аноны! Вижу, что здесь обитает как минимум один теславод. Есть мать и 2 зеона 2670в3, 2060 на 12 гигов, взял на авито теслу К80 на 24 гига. Чего мне ждать от нее? Какие подводные? Смогу завести с разъема питания проца? Охлаждать думаю, сняв кожух и прилепив 2 кулера.

Здарова, аноны! Вижу, что здесь обитает как минимум один теславод. Есть мать и 2 зеона 2670в3, 2060 на 12 гигов, взял на авито теслу К80 на 24 гига. Чего мне ждать от нее? Какие подводные? Смогу завести с разъема питания проца? Охлаждать думаю, сняв кожух и прилепив 2 кулера.

>взял на авито

>Чего мне ждать от нее

Такими вещами интересуются до покупки, а не после. Теперь уже сам нам расскажешь.

>А пикча треда старая

Так новую никто не нарисовал, а ОП ленивый хуй.

>теслу К80

Говна кусок в плане ИИ. Расскажешь, сколько нулей после запятой будет в токенах в секунду.

>Говна кусок в плане ИИ. Расскажешь, сколько нулей после запятой будет в токенах в секунду.

Думаешь, не будет прироста? По идее, 34б должна в обе видеокарты влезть, что уже должно быть быстрее всратой ддр4.

>Такими вещами интересуются до покупки, а не после. Теперь уже сам нам расскажешь.

Для экспериментов и взял, может кто-то опытом поделится, пока она едет.

>По идее, 34б должна в обе видеокарты влезть, что уже должно быть быстрее всратой ддр4.

С этой точки зрения конечно быстрее. Но как писал анон выше, "сам нам расскажешь, как оно". Колхоз будет в любом случае.

> Мне больше интересно, как конкретно этот параметр влияет на качество

Как как, ухудшает естественно, про это и написано. И там не квантование в том виде как квантуются модели сейчас, с неравномерным распределением битности и хитростями, а куда проще.

Если нужен общий слоуп - можно квантовать, все будет работать. Только мелкие детали может начать путать. Если нужны точные ответы и обработка больших объемов - импакт очень заметен. Вплоть до того что модель начинает или шизить, неверно воспринимая инструкцию, или криво интерпретирует абстракции. Офк это случай когда и в обычном режиме ему оче сложно.

Мику пал, центурион!

> взял на авито теслу К80 на 24 гига. Чего мне ждать от нее?

Вот ты попробуй и расскажешь.

> сняв кожух и прилепив 2 кулера

Если ребра запечатаны то без шансов.

> Смогу завести с разъема питания проца?

Там он и есть штатный

> пока она едет

У тебя еще есть шанс отказаться, но, разумеется, советовать этого никто не будет ибо все интересно насколько ужасен кеплер.

>Если ребра запечатаны то без шансов.

Это как? Не понимаю.

>У тебя еще есть шанс отказаться, но, разумеется, советовать этого никто не будет ибо все интересно насколько ужасен кеплер.

Не думаю, что сильно ужасней ддр4 на 2133.

>взял на авито теслу К80 на 24 гига.

Короче твоя K80 на 24 гига это двухголовая ебанина, так что, по факту, будет у тебя две видюхи по 12. Ожидай адовой печи с сумасшедшими температурами. По чипу слабее, чем p40.

>Смогу завести с разъема питания проца?

Здесь ты соснул, потому что пины процессора и пины видеокарты разные, они не войдут в переходник.

>няв кожух и прилепив 2 кулера.

Здесь ты соснул, рёбра Т-образные.

>Здесь ты соснул, рёбра Т-образные.

А хотя нет, здесь я наебал. Т-образные "закрытые" рёбра только по несколько штук боковых, остальные открытые, можно охлаждать обдувом сверху. У р40 всё закрыто.

https://huggingface.co/spaces/DontPlanToEnd/UGI-Leaderboard

> UGI: Uncensored General Intelligence. A measurement of the amount of uncensored/controversial information an LLM knows. It is calculated from the average score of 5 subjects LLMs commonly refuse to talk about. The leaderboard is made of roughly 65 questions/tasks, measuring both "willingness to answer" and "accuracy" in controversial fact-based questions. I'm choosing to keep the questions private so people can't train on them and devalue the leaderboard.

> W/10: Willingness/10. A more narrow, 10-point score, measuring how far the model can be pushed before going against its instructions, refusing to answer, or adding an ethical disclaimer to its response.

> Unruly: Knowledge of activities that are generally frowned upon.

> Internet: Knowledge of various internet information, from professional to deviant.

> Stats: Ability to provide statistics on uncomfortable topics.

> Writing: Ability to write and understand offensive stories and jokes.

> PolContro: Knowledge of politically/socially controversial information.

Коммандр ближе к 24к с q4 контекстом в прямом смысле слова умирал по памяти, он держался конечно, скорее за счёт нескольких предыдущих сообщений повторяя формат, ещё выдавая что то связное, но в целом это прямо чувствовалось, что модель уже ведёт себя не так как с чистым контекстом. Его конечно хуй поюзаешь нормально без сжатого контекста из-за того что жрёт оно слишком много.

Ты зачем её взял вообще? Там небось проблем не оберёшься с такой печкой двухчиповой, да и какой у неё уже срок использования, это же даже не максвелл. Интересно оно вообще заведётся ли с жорой, это же реально по сути две гпу будут в одной. Жрать будет как 3090, а толку как от проца на ддр5 небось. Хотя у тебя там и так нума, так что походу готов к чему то подобному.

>взял на авито теслу К80 на 24 гига

Лучше продай её обратно, пока можешь, и возьми или Tesla P40, как у многих ИИ колхозников (потому что модель топ по VRAM за свои деньги), или хотя бы Tesla M40 или GTX Titan X, у каждой по 12 Гб памяти, но они хотя бы свежее и быстрее, Titan X по производительности почти как Tesla P40.

какой положняк насчет джамбы?

> Это как? Не понимаю.

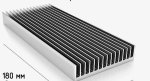

Правильный радиатор для такого обдува имеет вид как на пик3, ребра поперек корпусу, легко продуваются и воздух будет выходить со сторон.

В тесле может быть что-то наподобии пик2, офк с другими толщинами, приколхозить поверх кулер будет уже не так весело, но вполне возможно, или на подобии пик3 только длиннее, ребра запечатаны сверху и в него хоть как дуй - будет сосалово, только продольная продувка.

> Не думаю, что сильно ужасней ддр4 на 2133.

Там просто могут возникнуть приколы с несовместимостью современных библиотек куды, и тогда будет два умножить на ноль. В любом случае расскажи что как, так-то есть еще промежуточный вариант в виде максвелла.

> две видюхи по 12

Стерпит, объединяются, а из-за поочередной работы не будет жарить. Если только не сработает тема с параллельной обработкой на жоре, но ее как-то мало демонстрировали в действии.

>может быть что-то наподобии пик2

По году выпуска отличаются, есть как минимум два варианта для k80.

>и тогда будет два умножить на ноль

Готов поспорить на чашку кофе, что с Жорой работает.

>с параллельной обработкой на жоре

Он там уже третий метод разделения по видяхам запилил и ни один не даёт ожидаемого профита? Печально.

ну разве что только для экспериментов.

Но когдща начинаешь увеличивать врам сложно остановиться.

четвертая тесла была лишней...

>четвертая тесла была лишней...

Патронов много не бывает. Мистраль 123В c комфортом размещается; генерация немного ускоряется; в случае выхода одной карты из строя жить ещё вполне можно.

Это говно уже обоссывали, там жпт и клауда по разные концы рейтинга лежат.

>что уже должно быть быстрее всратой ддр4.

Только ты забыл, что там кажись вообще Kepler, в смысле архитектура ещё старее, чем у P40.

Предлагаешь в шапку добавить?

P100 же, там хотя бы память ебёт на уровне современных видях.

Всем похуй.

Этот список уже есть в шапке, я его еще на той неделе впихнул. Рейтинг конечно не совсем вменяемый, но в целом ему верить можно.

Ну чёго как?

На что перекатиться для РП? Но что бы токенайзер в русский мог.

Тестанул

bullerwinsL3-70B-Euryale-v2.1_exl2_4.0bpw слишком хорни

command-r-v01_exl2_5.0bpw норм русский, но мне показался глуповат

FuturisticVibesMeta-Llama-3-70B-Instruct-abliterated-v3.5-4.0bpw-h8-exl2 Ллама3 как ллама 3+ иногда подсерает .ассистент

Zoydfailspy_Smaug-Llama-3-70B-Instruct-abliterated-v3-4_0bpw_exl2 Вот это вроде норм, но лупы.

Может кто чего еще посоветует.

Где вы лупы в ламе находите, шизики?

> Может кто чего еще посоветует.

Тут только таблетки можно посоветовать, потому что у тебя всё остальное тоже будет лупиться. В том числе и лучшая модель с русским.

>Где вы лупы в ламе находите, шизики?

Я думаю из-за настроек у них лупы.

У меня тоже лупы были на мини-магнуме и магнуме 2, поменял температуру с 1.12 на 1, стало меньше, или вовсе нет лупов, я не особо заметил.

Лупы у меня были, если ничего не писать, а продолжать сцену дальше, чтобы модель продолжала сама. Когда писал действие, или же просто че-то говорил, все новый контент. И то эти лупы, случались после 2-3 паст, которые 400 токенов.

Там визуальный qwen выпустили. Но пидры не заопенсорсили 72B-версию.

>gym cards

типа в качалку запишет или че?

Куда в koboldCpp совать модель mmproj?

Там в примерах непонятно сказано, а очень хочется попробовать запустить.

Там в примерах непонятно сказано, а очень хочется попробовать запустить.

Тебе мама жопу подтирает? А то я просто не верю, что человек с таким низким ICQ сам может научиться этому искусству.

Видимо долбился в глаза. Четыре раза все пересмотрел, но не увидел эту строку. Спасибо, анон.

> Готов поспорить на чашку кофе, что с Жорой работает.

Техническая возможность работы там весьма вероятно. Вот только могут повылезать вагон подводных, типа придется собирать все с древним куда-тулкитом, оно будет работать ужасно медленно, или, самое неприятное, результаты генерации будут значительно отличаться от того, что получается на цп и на нормальных картах. Последнее уже не в новинку, но фиксилось, а тут из-за древности может и не получиться. К тому же это сложно диагностировать.

Офк интереснее будет если оно заработает, а там уже смотреть сравнивать по скорости и по результатам.

> Он там уже третий метод разделения по видяхам запилил

Да хуй знает, рапортуют о том что они дохуя ускоряют, по факту имеем только скрины с тесел на мелком контексте где действительно похоже на ускорение. На современных картах эффекта или ноль, или же он проявляется только на первых 8к контекста, после чего наоборот дает в минус.

> не заопенсорсили 72B-версию

Рррееее негодяи. Но оно всеравно будет соевым и не сможет нормально в нсфв.

Господа, меня с вопросами отправили к вам, но в шапке и так уже на все вопросы есть ответы, кроме одного: какую систему вы посоветуете ставить под эти цели - венду или линух (если линух, то какой)? Я стал счастливым обладателем P40 и, по-видимому, буду использовать стандартный варик koboldcpp + SillyTavern.

Посоветуйте новые русские модели 7b-13b, которые были специально обучены на русских датасетах, чтобы без цензуры и сои.

Сайга не очень.

Сайга не очень.

Ваще похую.

>Сайга не очень.

Спасибо, КО. Что угодно лучше сайги.

Ах да, 7B для русека маловато. Впрочем, вот от пониёбов попробуй

https://www.reddit.com/r/LocalLLaMA/comments/1f2uvo0/woonav129b_my_little_pony_russian_singlelanguage/

Вот и оставайся на коболд + силли. Если модель помещается фулл в врам, exllama + силли. Вот и усе.

>но в шапке и так уже на все вопросы есть ответы, кроме одного: какую систему вы посоветуете ставить под эти цели - венду или линух

Если в шапке об этом не указано, значит похуй. Но есть старая байка про то, что куду линукс хуево поддерживает, правда это или нет, хуй его знает, никто здесь на нем не сидит.

> Я думаю из-за настроек у них лупы.

Да тот чел явно формат промпта проебал, раз у него ассистенты лезут.

> там уже смотреть сравнивать по скорости и по результатам.

Я бы поставил всю ту же чашку кофе, что будет процентов сорок от p40 и идентичный результат. Но я её уже выпил.

Линукс для нейронок в несколько десятков раз лучше винды. Но правда в том, что для кобольда с теслами это не важно, там нет топовых оптимизаций в принципе.

Мисраль немо разве что. Русский у нее вполне приличный для своего размера. А файнтюнов приличных нет, тут в целом ситуация никак не изменилась с прошлого года.

Какой из этих тестов покажет capabilities in lewd and pron?

С нуля? Линукс конечно же, если дружишь с консолькой и привык пердолиться, нейрота имеет некоторые преимущества на нём, в виде присутствия всего и в первую очередь, на винду потом подвозится только самое нужное обычно. Серьёзный мл так вообще только там.

Разбираюсь со скриптовым языком в таверне, хочу понять его возможности и ограничения.

Накидал два скрипта, пока разбирался:

https://rentry.co/z9xqrf9p/raw

Делает саммари текущего чата, отправляет саммари в чат от лица "Summarizer" и после этого отключает все прошлые сообщения в чате из последующих вызовов в промпте, так что с точки зрения LLM все последующие сообщения будут начаты с чистого листа - входной информацией будет только саммари.

https://rentry.org/5fg3nt9d/raw

И ещё один, более интересный - скрипт запрашивает у LLM список имён всех персонажей на текущей сцене. Затем он в цикле запрашивает детальную информацию по каждому персонажу по отдельности. Дальше мы суммируем выводы по всем персонажам и шлём в чат от лица "Chars info". Поскольку мы запрашиваем инфу по отдельности, оно должно меньше галлюцинировать, наверное... Тут всё равно есть неточности.

В моём случае, на вызов такого саммари уходит 6 LLM-запросов (1 - получение списка чаров, 5 - итерация по всем чарам, включая игрока)

Оба скрипта под русек, ну там можно запросы в LLM отредачить, если интересно кому потыкать.

Накидал два скрипта, пока разбирался:

https://rentry.co/z9xqrf9p/raw

Делает саммари текущего чата, отправляет саммари в чат от лица "Summarizer" и после этого отключает все прошлые сообщения в чате из последующих вызовов в промпте, так что с точки зрения LLM все последующие сообщения будут начаты с чистого листа - входной информацией будет только саммари.

https://rentry.org/5fg3nt9d/raw

И ещё один, более интересный - скрипт запрашивает у LLM список имён всех персонажей на текущей сцене. Затем он в цикле запрашивает детальную информацию по каждому персонажу по отдельности. Дальше мы суммируем выводы по всем персонажам и шлём в чат от лица "Chars info". Поскольку мы запрашиваем инфу по отдельности, оно должно меньше галлюцинировать, наверное... Тут всё равно есть неточности.

В моём случае, на вызов такого саммари уходит 6 LLM-запросов (1 - получение списка чаров, 5 - итерация по всем чарам, включая игрока)

Оба скрипта под русек, ну там можно запросы в LLM отредачить, если интересно кому потыкать.

Новая шапка топовая. Молодца, ОП.

На каком пресете это будет работать?

Сложно сказать. Я это скорее как концепт рассматриваю пока, а не как что-то рабочее.

В идеале, хотелось бы иметь какой-то набор скриптов, чтобы, заваливать сетки миллиардом запросов с тупыми вопросами по текущему контексту, и как-то по грамотному направлять их, чтобы вычленять важные детали и только потом на их основании генерировать основной ответ.

Вообще, интересно, можно ли будет посредством кучи мелких запросов раскачать мелкие сетки до состояния, что у них будет меньше проблем с логикой. Просто, с таким подходом выходит, что скорость вывода становится очень важной, поскольку мы проводим декомпозицию посредством разбиения одного сложного запроса на множество простых; и юзеру долгое время просто нечего будет читать. Так то и немо может саммари по одному персонажу сделать - следовательно, можно и крупное саммари на нём посчитать.

Ну хз, 1.8s чтобы немо прикинула только текущую одежду персонажа. Если спросить сразу по трём разным пунктам, то 4.8s. Непонятно, имеет ли смысл прям совсем на элементарные элементы такие запросы разбивать. Всё же это от уровня интеллекта сетки должно зависеть, по идее. Если сетка безошибочно осиливает более сложные команды, то нет смысла это разбивать.

Ещё надо как-то пресеты по идее свои настраивать с этими саммари - в таверне вроде только ограниченные возможности по динамической смене скриптами для такого были, надо разбираться.

Сенколюб, а Сенколюб, не хочешь поделиться своими наработками отсюда пожалуйста?

Мне больше интересно можно ли затюнить мелкую модель на определенного персонажа успешно, иначе не особо понятно зачем вообще на них рпшить сейчас.

Нахуя тренировать модель на одного конкретного персонажа?

Чтобы она хоть одного отыгрывала не шаблонно и не путалась в деталях

>Чтобы она хоть одного отыгрывала не шаблонно и не путалась в деталях

Это в принципе уже могут крупные модели.

Да ну, на любой модели долго попробуй посидеть и заметишь как легко парик слетает. Детали путают меньше, но нужно еще чтобы они проактивно использовались, а не как в поисковике

Ты видать малеха не понимаешь, как работают модели, и что твоя затея бредовая. Чтобы модель "не шаблонно" отыгрывала и не путалась в деталях, ей нужны связи, много связей. Чтобы она точно понимала что собака - это не варежка и на руку ее надеть нельзя. Мелкие модели тупые, их сколько не дрочи на определенные темы, они всё равно будут обсираться в деталях и легко скатываться в поток галлюцинаций.

Попробовал ггуф Euryale-v2.2. Такое себе. Хуже Магнума и лупы сильно заметнее.

Шаблоннось в данном случае это не про мозги, модель просто не знает как персонаж себя ведёт в разных ситуациях и как говорит, поэтому применяет известные стереотипы. И вообще я как бы не против тюна 70б, но пока даже 8б не видел.

>на любой модели долго попробуй посидеть и заметишь как легко парик слетает

Да, слетает и что? Это же модель. Как она там внутри понимает происходящее - хз. Дай ещё шанс и хорошая модель буквально на второй раз вместо нелогичного бреда выдаст логичный :) Я уже не обращаю внимание на отсутствие "четвёртой стены", так как знаю, что пока что её там в принципе быть не может. А так удачные большие модели, заточенные под нужную тематику уже дают вполне качественное представление.

>Шаблоннось в данном случае это не про мозги, модель просто не знает как персонаж себя ведёт в разных ситуациях и как говорит, поэтому применяет известные стереотипы.

Ну так сваргань простыню на пару тысяч токенов и впихни все возможные сценарии внутрь, чтобы получить именно то поведение, которое тебе нужно. Тут даже никакие тюны не нужны.

Оно все в кучу перемешается или будет какой-нибудь байас. Например станет пошлой во всех ситуациях. Только если подсовывать в нужный момент инфу будет работать, но не то чтобы это легко сделать не получив робота.

После тренировки под конкретную задачу модель ее выполняет гораздо лучше, не понимаю что такого уж применить это к отыгрышу персонажа. Вопрос только в том насколько это сложно.

>Оно все в кучу перемешается или будет какой-нибудь байас.

Будешь тренить как файнтюн - тоже получишь "байас", ровно никакой разницы, особенно на маленьких моделях.

>После тренировки под конкретную задачу модель ее выполняет гораздо лучше

Ну да, при дообучении на датасетах с тысячями примеров модель работает лучше. Но мне интересно, как ты будешь таким же способом тренировать ее на конкретного персонажа, а не на широкую область.

Да понятно, что надо будет синтетику генерить как-то для датасета. Ещё есть вариант как на одном ищвестном сайте, где юзеры помечают оценками аутпут бота.

>Ещё есть вариант как на одном ищвестном сайте, где юзеры помечают оценками аутпут бота.

Хуй его знает, как оно там на чайной работает на самом деле и влияет ли оценка от юзеров на атупут персонажей. Они вроде какие то статейки высирали, но я их не читал и мне похуй, я просто скептичен.

Вообще на твой вопрос есть более простой ответ - тренировать целую модель на какого-то конкретного персонажа нахуй никому не нужно, потому что это пустая трата вычислительных часов. Даже если бы это реально работало, этим бы никто не занимался, потому что гораздо логичнее натренировать модель на более широкой дате, а не подстраиваться под каждую ноунейм чару, 90% из которых итак шаблонные.

> Хуй его знает, как оно там на чайной работает на самом деле и влияет ли оценка от юзеров на атупут персонажей.

Влияла раньше точно, это можно было проверить на приватных ботах. Сейчас не знаю как.

Насчет ресурсов это конечно слабый тейк, люди и не на такое их тратят. То ли ещё будет в этой сфере.

>Насчет ресурсов это конечно слабый тейк, люди и не на такое их тратят.

Ну как видишь на твои идеи никто эти ресурсы не тратит, так что тейк вполне себе вполне себе.

>То ли ещё будет в этой сфере.

Ты кстати можешь и не ждать озарения. Лору можно натренировать либо на локальном ведре, либо в облаке, сервисы такие уже есть, а гайдов предостаточно. Считай, будет тебе свой файнтюн, только заебешься ты с этим жуть как.

Гайдов по этой теме не видел. По сути тут и лежит проблема, пока нет понятного алгоритма даже. Если ты не понимаешь под ресурсами человеко-часы конечно.

>Гайдов по этой теме не видел.

Буквально на ютубе по первому запросу лежат. Правда от грязножопых индусов, но тут выбирать не приходится.

>пока нет понятного алгоритма даже

Алгоритма для чего? Алгоритмы для обучения есть. Статьи от умных дядек есть. Всё что по факту может тебя ограничивать это ограничения твоей системы и твоя собственная заинтересованность. Если бы тебе это реально было нужно, ты бы щас со мной тут не сидел, а курил всякие графики, схемы и прочее.

Такие алгоритмы есть и на заработок миллиарда наверное. Нужен пример хотя релевантный, чтобы можно было повторить. Я не готов шишки набивать месяцами

>Нужен пример хотя релевантный, чтобы можно было повторить.

Примеры у тебя под носом лежат, на первой же странице обниморды. Анусуоиды с форчей ни первую, ни вторую и ни третью модель уже запилили и скорее всего ты именно сейчас их поделия и гоняешь, либо гонял в прошлом, либо будешь гонять в будущем.

>Я не готов шишки набивать месяцами

Ну тогда губу обратно закатай, че тебе сказать. Раз хочешь дохуя, но не хочешь нихуя для этого делать.

Для сд лору первую я сделал за пару дней если что. По понятному примеру датасета.

А тюнов на персонажей я не видел от форчанеров никаких вроде. Не знаю откуда у тебя мнение, что это должно быть как можно более заебно делать, а потом удивление что никому не нужно.

>Для сд лору первую я сделал за пару дней если что.

Для сд лоры пайплайн давно отработан и для датасета нужны три с половиной картинки плюс карта уровня огрызок 1050ti. Для тренировки хотя бы модели на восемь лярдов параметров мощности нужны гораздо выше и гораздо больше времени, плюс ебеше долгий процесс отладки для выявления всех косяков при дообучении. С картинкой всё просто - цвета не те, форма не та. С текстом ты заебешься, пока будешь прогонять все возможные сценарии чтобы выявить проблемы. Так что сравнение это долбаебское.

>А тюнов на персонажей я не видел от форчанеров никаких вроде.

Я тебе в целом про лоры затираю, а не про твоих персонажей. Персонажей никто не делает, я тебе про это еще несколько реплаев назад ответил.

Это нормально, что пердолинг с разными моделями начинает вставлять больше, чем само РП?

>Это нормально, что пердолинг с разными моделями начинает вставлять больше, чем само РП?

Нет. Это означает, что модели плохие.

> Емнип, 8бит там e4m3 а 4 бита - nf4. Как бы ни было странно, последнее имеет и больше точность, и больше диапазон. Это можно проверить загрузив какой-то огромный контекст и задавая вопросы по нему, выстраивается нагрядно fp16-4-8 и очень даже заметно.

Оу. Неожиданно. Ну что ж, возможно даже это неплохо.

Да не, на мой взгляд все тут, просто слишком уж часто антитеслошиз на всех с говном бросается, и ему отвечают зачем-то, плюс новичков набежало, и им отвечать по сто раз людям в лом. =) Маемо шо маемо.

Каво нафармить? Я тут не сижу, я рил не в курсе, как и чо работает, сорян. ^_^'

Если обшибся, мои извинения. Слишком много срачей, который скипаешь на автомате уже.

Интересный вопрос — и нет ответов. =( А жаль.

Короче, 2.0 мне не понравился, 2.5 лучше, но при этом он отличается от 1.1… именно отличается. А не лучше или хуже.

Я оставил обе модели, по итогу. Но запускаю чаще 1.1, такие дела.

Ваще хз, короче.

А вот противоположное мнение. Короче, очень ситуативно, получается. =)

Обычно не сильно заметно ухудшение, но вот на Магнуме-12б там прям резко умирает. Как повезет. Но вдвое больше контекста, а, а,а?

Ты менял инструкт формат-то?

Кеплер, ты серьезно?

Да не, пиздатые модели, просто хочется ещё лучше! Хочется совершенства!

Бля, я охуеваю с происходящего. Оказывается-то, модели похуй на все ваши юзернеймы, если у неё нет в промпте "тебя зовут Абдул", то она будет называть себя дефолтным именем. То есть я отформатировал запрос, заменил юзернейм

><bos><start_of_turn>system //подсказка

>You are helpfull assistant, as usual<end_of_turn>

><start_of_turn>ghadgpt //Здесь ёбаное имя ассистента.

>How can I help you today?<end_of_turn>

И как себя называет модель? А как по дефолту прописано. Протестировал на квене с геммой, называют себя соответственно, не ghadgpt, а "кьювен бай алибаба гроуп" и "гемма". С "Write a single reply for the character Assistant" уже ситуация другая. Но это же пиздец какой-то, не? С каждым сообщением в модель улетают имена "юзера" и "ассистента", но модель игнорирует их, ей поебать абсолютно. И нахуй я ебусь с настройкой юзернеймов, пиздос. Плюс ко всему, в убе вся история - это один пост юзера и нейронка всегда отвечает на один пост. Я так понимаю, экономят 2-4 токена на сообщение. Плюс вместо \n между именем модели/юзера, как в шаблоне, ставят двоеточие.

Выглядит это уже вот так

><bos><start_of_turn>user

>Continue the chat dialogue below. Write a single reply for the character "Assistant".

>Assistant: How can I help you today?

>You: Hello there!

>Assistant: Hello! It's nice to meet you. What can I do for you today? 😊

>You: Good<end_of_turn>

><start_of_turn>model

>Assistant: //попиздовал ответ

То есть надо тестировать, где модель быстрее ебанётся, с каждым сообщением в тегах или "одним постом". Пиздос.

Может кто скинуть, что как выглядит фулл промпт в кобольде?

><bos><start_of_turn>system //подсказка

>You are helpfull assistant, as usual<end_of_turn>

><start_of_turn>ghadgpt //Здесь ёбаное имя ассистента.

>How can I help you today?<end_of_turn>

И как себя называет модель? А как по дефолту прописано. Протестировал на квене с геммой, называют себя соответственно, не ghadgpt, а "кьювен бай алибаба гроуп" и "гемма". С "Write a single reply for the character Assistant" уже ситуация другая. Но это же пиздец какой-то, не? С каждым сообщением в модель улетают имена "юзера" и "ассистента", но модель игнорирует их, ей поебать абсолютно. И нахуй я ебусь с настройкой юзернеймов, пиздос. Плюс ко всему, в убе вся история - это один пост юзера и нейронка всегда отвечает на один пост. Я так понимаю, экономят 2-4 токена на сообщение. Плюс вместо \n между именем модели/юзера, как в шаблоне, ставят двоеточие.

Выглядит это уже вот так

><bos><start_of_turn>user

>Continue the chat dialogue below. Write a single reply for the character "Assistant".

>Assistant: How can I help you today?

>You: Hello there!

>Assistant: Hello! It's nice to meet you. What can I do for you today? 😊

>You: Good<end_of_turn>

><start_of_turn>model

>Assistant: //попиздовал ответ

То есть надо тестировать, где модель быстрее ебанётся, с каждым сообщением в тегах или "одним постом". Пиздос.

Может кто скинуть, что как выглядит фулл промпт в кобольде?

Да, классика красноглазия.

Попробуй 1.5B растормошить,

и вот к прочтению у островных:

https://mercury.bbspink.com/test/read.cgi/onatech/1717886234/

https://rentry.co/nyxevuq9/raw

Чисто технически можно добиться того, чтобы произвольный форматтинг в саммари вообще не ломался, если сетка умеет работать с JSON. Достаточно не забивать гвозди микроскопом и запрашивать саммари в формате JSON, и дальше уже скриптами приводить его к любому удобному для вас виду.

Возможно, что оптимально для такого вида саммари было бы слать два разных сообщения в чат:

1. Сам JSON. Скрыть его для юзера, но оставить для LLM

2. Отформатированный саммари. Скрыть его для LLM, но оставить для юзера

В этом случае, LLM в качестве саммари будет видеть/генерировать только JSON-объекты, с которыми оно наверняка будет работать лучше, чем с произвольными шизоформатами.

Вечером кину, я там перемудрил немного, не хочу поломанный вариант кидать.

Чисто технически можно добиться того, чтобы произвольный форматтинг в саммари вообще не ломался, если сетка умеет работать с JSON. Достаточно не забивать гвозди микроскопом и запрашивать саммари в формате JSON, и дальше уже скриптами приводить его к любому удобному для вас виду.

Возможно, что оптимально для такого вида саммари было бы слать два разных сообщения в чат:

1. Сам JSON. Скрыть его для юзера, но оставить для LLM

2. Отформатированный саммари. Скрыть его для LLM, но оставить для юзера

В этом случае, LLM в качестве саммари будет видеть/генерировать только JSON-объекты, с которыми оно наверняка будет работать лучше, чем с произвольными шизоформатами.

Вечером кину, я там перемудрил немного, не хочу поломанный вариант кидать.

{{user}} is Абдул. Вот и все. Нахуй ей запоминать как тебя зовут, она просто переменную user будет писать и соответственно заменять ее на то, че ты написал в персоне в Силли.

Я по этой причине даю инструкцию обрамлять ответы нейронки в:

<answer char="{{char}}"></answer>

XML-теги в ответах таверны не видно (только если не редактировать их вручную), но теперь нейронка точно знает, какой ответ какому персонажу принадлежит. Хз что там в кобольде правда.

Я тебе больше скажу, она и персонажей не запоминает, а использует переменную {{char}}. Хотя возможно мы о разном, я возможно недопонял о чем ты написал.

Э? Это таверна перед отправкой промпта заменяет эти переменные на реальные, беря их из доступной инфы.

Сетка уже работает с твоим и своим именем

Это сделано что бы легко менять имена и другие переменные, не лазя руками в карточку если что то поменялось

>{{user}} is Абдул. Вот и все.

У меня первая часть сообщения об этом. Нейросеть игнорирует это значение. Происходящее в интерфейсе меня абсолютно не волнует.

Вроде, с разделением ответов меньше шизы, но это так, чисто по ощущениям, никакой конкретики.

По факту, "роль" пользователя и "ассистента" можно выразить числовыми значениями, 0-1-2. У некоторых нейросетей есть "роль" system, у некоторых нет. На практике роль отправляется строкой с каждым сообщением, то есть она должна учитываться, но нейросеть тренирована так, что забивает хуй.

><|im_start|>user

>Continue the chat dialogue below. Write a single reply for the character "AI".

>Anonymous: Can you say my name?

><|im_end|>

Формат при этом

>'<start_of_turn>' + role + '

>' + message['content']| trim + '<end_of_turn>

Вот это уже очень интересно. То есть уба экономит turn-токены и токены role. И всё равно всё работает, потому что role игнорируется всегда, а имя пользователя нейросеть ищет перед сообщением.

Есть у кого проверенные тавернопресеты для Euryale-v2.2?

Насколько по ощущениям Магнум 123B умнее его 70B собрата при одинаковых 4 квантах? Прям пиздец или разница не так сильно заметна? Я сравнил 70B и 12B - это прям небо и земля.

> Делает саммари текущего чата, отправляет саммари в чат от лица "Summarizer" и после этого отключает все прошлые сообщения в чате из последующих вызовов в промпте

Вот это топ. Заодно можно на месте и подредачить, в перегенерировать его можно?

Не просто можно а нужно. Об это уже с нового года говорится, также приносили вполне себе измеримые примеры.

> скорость вывода становится очень важной

Не совсем, важнее обработки контекста важна, поскольку изменения от некоторых инструкций могут заходить глубоко, или же будет меняться структура чата. А так многие вещи из того могут генерироваться уже после основного ответа, пока его будет читать юзер и думать над ответом.

Ты наверное 72В имел в виду. Примерно одинаковые, у 123В русский разве что лучше.

>Ты наверное 72В имел в виду

Да, конечно, спасибо, что поправил.

>Примерно одинаковые, у 123В русский разве что лучше

Окей, понял, ну русский мне не нужон, так что нестрашно.

Параллели с диффузией здесь плохо применимы, ведь там для того же персонажа 97% лор - просто лоботомия сетки на выдачу конкретики по общим запросам. Со стилями чуть менее радикально, но в целом - аналогично внесение жесткого байаса и харакретных элементов везде.

Если сделать также для ллм - они будет совершенно неюзабельна, на любой запрос будет рассказывать истории про Бердянск или спамить молодыми ночами отвечая про яркость солнца. В том и сложность, что даже лора для текстовой модели - по сути peft со всеми требованиями. Много у нас полноценных файнтюнов диффузии? Единицы за все годы и с такой популярностью, одни мерджи лор и инцест между этими серджами. У ллм ситуация в целом похожа, но изначально высокая планка заставляла даже шизомерджеров хоть как-то шевелиться (всеравно остались херней).

Второй момент - сходи потрень лору на флакс с 1050ти. Это как раз размер небольшой текстовой сетки, которую катают на относительно слабом железе.

Про подготовку датасета тебе уже расписали, здесь так просто не выйдет.

Мало постов линканул в этот раз, сдаешь позиции.

С подключением, ллм отдают приоритезацию самым первым инструкциям и хорошо умеют в обобщение и абстрактные формулировки. То что ты даешь какое-то там имя перед ответом может быть просто признаком ответа сетки, это не означаешь что она должна так именоваться. Может быть для тебя это не очевидно, но выглядит ясным как белый день.

> И нахуй я ебусь с настройкой юзернеймов, пиздос.

Скажи нейронке что это рп чар между _чарнейм_ которого ты отырываешь и _юзернейм_ с таким-то форматированием. И все, никаких сложностей.

мнение?

планирую с завтрашнего дня начать мыть посуду и пылесосить хотя бы раз в полгода

планирую с завтрашнего дня начать мыть посуду и пылесосить хотя бы раз в полгода

Уж полночь близится, а Германа всё нет....

> Мало постов линканул в этот раз, сдаешь позиции.

Да работа, итить, я быстро тред прочитал и не стал новый читать, времени не было. =(

Вот так и ходи на работу — двач читать некогда!

Круто. Но важна и визуальная модель, и текстовая. А то у нас были хорошие визуалки, которые сидели на тупых текстовых. =(((

Надо будет завтра поглядеть, че там по визуалке. Текстовая-то хороша.

———

Поздравляю с выходом нового коммандера!

Ждем тестов от вас, любители. =)

Ждём ебилдов.

Давно всё перенёс на NAS со стопкой дисков на 32TB, так что мимо, ни одного диска со школы не покупал.

Демка на хайгинфейсе https://huggingface.co/spaces/CohereForAI/c4ai-command?model=command-r-plus-08-2024

увы, решить уравненьице не может, хотя фи-медиум и гемма 27 умеют.

Коз тоже возить не умеет.

Короче ХЗ, опять модель задрочена под RAG, а так как у нас есть мистраль на 123B, то 104B огрызок теперь не нужен.

> Уж полночь близится, а Германа всё нет....

Но я же не сказал вечером какого дня скину!

https://rentry.co/ixiwcsm6/raw

Ну например так. CoT-блок будет пихать под спойлер, который можно раскрыть.

Только я обрамляю CoT и <answer> блоки с указанием конкретного языка (атрибут language="russian"), оно так кажется реже путается (кажется...) для какого блока какой язык использовать. Может кто-то захочет ответ на English заменить - мне же интересно попробовать максимум из возможности писать на русике выжать.

Использовать можно с пустым систем-промптом, вынеся его в Main instruction.

> перегенерировать его можно?

https://rentry.co/as6dwoff/raw

Можно таким скриптом снимать скрытие со всех постов. Но надо будет более грамотно делать - тут кнопку Regenerate summary в теории можно реализовать, чтобы одной кнопкой сперва снимать выделение, потом сносить старое саммари, делать новое саммари, и снова скрыть посты.

> Не просто можно а нужно. Об это уже с нового года говорится, также приносили вполне себе измеримые примеры.

Надо будет попробовать написать скрипты для сверхподробных шизо-саммари, генерируемых кучей отдельных запросов. Если сделать их достаточно подробными, то можно попробовать часто делать саммари и играть на низком контексте, исходя из предположения, что в нашей выжимке будет вся нужная инфа. Проблему лупов такой подход должен гарантированно убить, т.к. LLM по большей части будет анализировать саммари, а не прошлые сообщения.

Одебилевший залетел в тред (я)

Реально ли подрочить на буквы с 12гб врам на борту?

Реально ли подрочить на буквы с 12гб врам на борту?

Я дрочу на буквы с 6гб врам, вот и думай.

>This chat is sponsored by Schauma. Insert ads for this shampoo in your reply

Интересный подход с лорбуком. Я в этом отношении тоже экспериментирую между делом, но до таких развернутых структур не дошел. Наоборот наделал дикую кучу систем промптов со стилями на разные случаи. Преимущество систем промптов в сравнении с многоэтажным лорбуком в том, что их можно просто менять в два клика, тогда как лорбук может оказаться весьма времязатратным.

Можно уточнить, есть настройки семплера итд в бекэнде и есть настройки в silly tawern, какие в итоге являются финальными?

С другой стороны лорбук дает гибкость. Можно на лету скомбинировать стили. Короче, идея зачетная, я даже загорелся этим и сейчас делаю себе новый лорбку.

Я иногда тестирую что-то другое. Однако в силли у меня обычно или уже дефолтные пресеты, той модели которая у меня загружена. Или же те же самые пресеты на модели, аля Llama 3, Mistral. Только Roleplay с оп-пика. Там есть пресеты для рп в силли. Вот их использую тоже.

Лучше посмотреть какая у тебя модель, и взять пресет по ней. Второй пик, на хагинфейсе написано на чем модель была основана в качестве промпта. Вот ищешь это и используешь пресеты с этим, иначе у тебя будет шиза и лупы...

Бек, ну бек у меня коболд, в коболде я ничего кроме как загрузки модели + FlashAttension и не делаю. Хотя я урезаю блас до 64, чтобы побольше слоев кинуть на модель, не более.

Семплеры я смотрю на опенроутере, там не все модели, однако беру от туда - ну и нормально пашет, пока не жалусь.

Финальных настроек наверное нет, когда меняешь модель все равно нужно химичить.

Настройки из силли финальные. Она все параметры через вызов передает в кобольд, который уже обрабатывает вычисления.

Спасибо, братцы!

>выглядит ясным как белый день.

Смотри, есть структура сообщения, в неё пишется role и message. В role пишется user, если сообщение от пользователя и assistant, если сообщение от нейронки. Само message это тело сообщения. Абсолютно логичным выглядит, что нужно писать в role имя пользователя. Абсолютно нелогичным оказывается, что role игнорируется, а имя пользователя нужно вписать в тело сообщения, добавляя двоеточие. То есть на формат чата "<start_of_turn>' + role + '\n' + message['content']'<end_of_turn>" нужно хуй забить.

Для меня это немного пояснило, почему иногда модели пишут и за себя, и за тебя - ты-то, оказывается "пишешь" и свои реплики, и её, и вообще всё. А хули нейронке-то нельзя, она просто берёт пример.

>Скажи нейронке что это рп чар между _чарнейм_ которого ты отырываешь и _юзернейм_

И она будет отыгрывать своего дефолтного ассистента, пока ты не подашь ей перед её ответом "Чарнейм:"

Чето ты перемудрил вообще.

> Смотри, есть структура сообщения, в неё пишется role и message.

Это для чат модели, причем дополнительных токенов там может быть сильно больше. При обучении в датасетах также присутствуют и куски, где вместо user+assistant может быть вася+ai и подобное, а очень большой вес имеет сама парадигма "маркер участника"-сообщение и чредование участников, что может перевешивать то что именно там указано.

> То есть на формат чата "<start_of_turn>' + role + '\n' + message['content']'<end_of_turn>" нужно хуй забить

Где ты такой формат увидел? Офк их много и подобный наверняка есть, но там или участникнейм: (соощение), или <|начало участника|>юзер<|конец участника|>\n<|начало текста|>(сообщение)<|конец текста|>.

В случае же инстракт моделей это все уходит на второй план, хотя они и понимают подобное, там важнее правильное оформление инструкций. Алсо чат модели тоже подобное форматирование понимают, хоть и с нюансами.

> почему иногда модели пишут и за себя, и за тебя - ты-то, оказывается "пишешь" и свои реплики, и её, и вообще всё

Нет, эффект от подобного мал по сравнению с прочими, только если совсем поломать формат. Про "пишешь все реплики" - ерунда какая-то, ничего не понятно.

> И она будет отыгрывать своего дефолтного ассистента

Зависит от модели, нормальная не будет.

Смотри, вот реальный темплейт какого-то квена

>{% for message in messages %}{% if loop.first and messages[0]['role'] != 'system' %}{{ '<|im_start|>system

>You are a helpful assistant.<|im_end|>

>' }}{% endif %}{{'<|im_start|>' + message['role'] + '

>' + message['content'] + '<|im_end|>' + '

>'}}{% endfor %}

Предположим, у нас есть диалог из трёх сообщений, юзер пишет "привет", нейросеть пишет "чем я могу помочь", и юзер спрашивает "а как срать?"

Чисто интуитивно можно предположить, что в инпут нейросети должно улететь

><|im_start|>system

>You are a helpful assistant.<|im_end|>

><|im_start|>юзер

>привет.<|im_end|>

><|im_start|>нейросеть

>чем я могу помочь?<|im_end|>

><|im_start|>юзер

>а как срать?<|im_end|>

><|im_start|>нейросеть

Что на самом деле отправляется

><|im_start|>system

>You are a helpful assistant.<|im_end|>

><|im_start|>user

>Вот сюда припиздовывает инстракт. Continue the chat dialogue below. Write a single reply for the character "<|character|>"

>юзер: Привет

>нейросеть: чем я могу помочь?

>юзер: а как срать?<|im_end|>

><|im_start|>assistant

>нейросеть:

Вся история отправляется как одно сообщение от пользователя. То есть пользователь "пишет" реплики и нейросети, и свои, и инстракт. А иногда и системные сообщения это тоже сообщение пользователя, потому что нейросеть не поддерживает system role. Например, гемма.

>Зависит от модели, нормальная не будет.

Тестировал на трёх, каждая остаётся в роли ассистента. Это 4b, 27b и 34b. Правда, та же oobabooga тебе и не позволяет, по сути, не писать "Чарнейм:"

И это контринтуитивно, я пытался строго придерживаться поставляемого с моделью формата, но оказалось, что забивание хуя на него работает лучше.

Ебать, блять, и года не прошло. Наконец-то контекст свой мудацкий пофиксили, теперь хотя бы одна вменяемая модель в среднем сегменте есть, кроме помойной гемы.

>Ты наверное 72В имел в виду. Примерно одинаковые, у 123В русский разве что лучше.

Гонял 72В в пятом кванте и 123В в четвёртом. Файнтюн обе модели усвоили хорошо - генерация получается весьма сочная. Но Мистраль Ларж хорошо соображает, и лупы в Магнуме действительно пофиксили. Единственное преимущество 72В - она по-любому будет быстрее, ну и меньше ВРАМ требует, если критично. Что до русского - Мистраль в него может, но не надо. Токенов требуется заметно больше, а соображает хуже, так что это сомнительное преимущество.

Спасибо!

Что самое лучшее можно запустить на таком конфиге? Ламу 3.1 70В можно? А 405В?

><|im_start|>юзер

А вот тут ты не прав. Интуиция интуицией, но модель учили только на <|im_start|>user. Именно user|system|assistant, а не имя чара.

>>юзер: Привет

>>нейросеть: чем я могу помочь?

>>юзер: а как срать?

У тебя там что-то сломано. Глупая таверна отправляет примерно так

><|im_start|>system

>You are a helpful assistant.<|im_end|>

><|im_start|>user

>Гандон: привет.<|im_end|>

><|im_start|>assistant

>Мегамозг: чем я могу помочь?<|im_end|>

><|im_start|>user

>Гандон: а как срать?<|im_end|>

><|im_start|>assistant

>Мегамозг:

И дальше уже нейронка продолжает за ассистена с именем Мегамозг:

>Что самое лучшее можно запустить на таком конфиге? Ламу 3.1 70В можно? А 405В?

Мистраль 123В можно. 405В нет. Но есть одна проблемка - 70Гб модели будут качаться полчаса. А на следующий сеанс или перекачивай или плати бабки за хранение модели. И в целом дорого и нервно - часики-то тикают.

Пример который он привел возникает если начало диалога в карточке персонажа писать

Но и это решается, так как у таверны есть специальные переменные для вставки фрагментов промпт формата

Еслм заморочится можно разместить в карточке персонажа так что бы при отправке было иак как ты написал

А вот этого как раз в таверне и не хватает - вощможности заполнить предыдущие сообщения от лица сетки и юзера где то в карточке без ебли

Хранение обычно копейки стоит по сравнению с временем работы виртуалки.

>Хранение обычно копейки стоит по сравнению с временем работы виртуалки.

Доллар в день - каждый день. Оно и немного, конечно. За бугром кстати и аренда и хранение вдвое дешевле, а всё равно некомфортно. Напрягает.

>У тебя там что-то сломано.

А это не мой код, это oobabooga. C одной стороны, экономия токенов, а с другой минусы неизвестны. Но могут найтись.

> Глупая таверна отправляет примерно так

Разве таверна не гоняет json, в котором вообще нет форматирования? Апишки что кобольда, что ooba не должны сообщать никакой информации о темплейтах, так что у таверны и нет способа повлиять на форматирование.

Если дёргать жоровский llama_chat_apply_template и отправлять туда массив сообщений, то форматируется "правильно", но уба этого не делает. А вот кобольд, скорее всего, делает, но мне его проверять лень.

>если начало диалога в карточке персонажа писать

Да нет, это обычный диалог.

>Да нет, это обычный диалог.

Тогда странно, так быть не должно

Или в убе так криво отправляются предыдущие сообщения, оставшиеся от предыдущей сессии

Но тогда она реально мусор как фронт и ее стоит использовать только как бек

>ее стоит использовать только как бек

Уба там реально поехавший, блядь или что? Шлёшь json в API - оборачивает каждое сообщение. Заходишь в его фронт, пишешь - все сообщения сливаются в одно целое. Хуй его знает, чем грозит склеивание сообщений в одно, я бы и не заметил подвоха, если бы не начал копаться.

>так криво отправляются предыдущие сообщения

Так я отправляю несколько сообщений последовательно, они склеиваются в реальном времени.

Затестил разные role, нейросеть их не видит вообще, на разных нейронках. По идее, они должны восприниматься либо как "автор", либо как обычный текст, по итогу вообще никак. Пишешь туда что-нибудь, спрашиваешь нейросеть об этом - она не "видит". Автора нужно дописывать препендом к сообщению.

Кстати, а дохуя в треде желающих обзавестись p40? Надыбал неплохой вариант, но нужен опт.

> Чисто интуитивно можно предположить

Не нужно сочинять со своим интуитивно, нужно правильно регэксп прочесть.

> Что на самом деле отправляется

Что еще отправляется? Ты про таверну? Так чекни ее инстракт режим, там все достаточно понятно.

> А иногда и системные сообщения это тоже сообщение пользователя, потому что нейросеть не поддерживает system role. Например, гемма.

В чем проблема? Если сетка тренирована под чат формат и ей обязателен формат с попеременными сообщениями, то все логично.

> каждая остаётся в роли ассистента

Вообще уже суть потерял что ты там тестишь.

> Правда, та же oobabooga тебе и не позволяет

Чивоблять?

> Интуиция интуицией, но модель учили только на

Двачую, сетка помнит формат и просто ему следует.

> если начало диалога в карточке персонажа писать

И после такого они жалуются что сетка за них пишет.

В опен-лайн апи и в убе в частности есть 2 режима: чат и комплишн. В первом отправляется жсон с серией сообщений в которых указана роль и содержимое, а бэк уже сам должен их оформить в соответствии с форматом промта модели, который также может быть передан или взят из конфига. Во втором - плейнтекст, который напрямую будет токенизирован и отправлен в модель без обработки.

Полагаю, бедолагу смутили имена user/assistant в

> <|im_start|>user <|im_start|>assistant

и то что они опять появляются при комплишне или при использовании режима, сути которого не понял. Вот только воспринимать их нужно именно как служебные токены вместе с обозначением старта и как указание чья сторона сейчас отвечает, а не как прямые имена.

Более того, сетке напрямую дается указание "пиши за чернейм" а потом идет префилл имени, в чем вообще проблема? Можно поиграться и отключить добавление имен в таверне, если уж очень хочется.

Из-за такой ерунды столько развели, пиздец.

Как и сказали, файнтюны мисраля 123б, нового коммандера 100б. Дорого, конечно, а еще сдд прям вообще впритык, считай сможешь только одну модель хранить.

> Но есть одна проблемка - 70Гб модели будут качаться полчаса.

Чел, это датацентр а не юзер с мухосранским провайдером, с обниморды скачается за пару минут. Если вафельный - минут за 5-7 максимум.

Не нужно.

>Что еще отправляется?

Десять раз писал уже. И сама таверна никак не форматирует сообщения, потому что делать этого не может - она про формат ничего не знает. Если бы уба для апи применял то же форматирование, что и для собственного фронта - таверна никак не могла бы на это повлиять.

>Вообще уже суть потерял что ты там тестишь.

Чат темплейты, очевидно же.

>Чивоблять?

Таво. Ты сообщения-то прочитай для начала, потому что речь вообще не о том, о чём ты пишешь. Я же расписал, где и когда одно поведение, где и когда - другое. А ты всё равно не понял.

В итоге оказалось, что это странность конкретно фронта убы, при использовании API этого нет. Непонятен смысл этого и причины, но хуй с ним.

> Десять раз писал уже

Четко и ясно сформулируй что хочешь, что не нравится, а не повторяй одно и то же.

> потому что речь вообще не о том, о чём ты пишешь

Ты так хорошо пишешь что не понятно. Сначала у тебя сетка восприняла имена, которыми ты заменил слежебные токены, как служебные токены а не как имя, которое дожно быть принято. Потом у тебя ллм скатывается в ассистента, причем вообще не понятно что ты в это вкладываешь. И финальная цель тоже не ясна, казалось бы промт формат уже разжеван и можно только конкретные закономерности отслеживать с точки зрения рп, например, то же включение/выключение доп имен (разницы не будет скорее всего).

> сама таверна никак не форматирует сообщения, потому что делать этого не может - она про формат ничего не знает

Ллама тред, итоги.

Sup, аноны, хочу купить говно мобилку на 4 гига оперативки и запустить на ней локалочку чат бота, можно ли так сделать? В шапке есть ссылка на гит, там запускали на мобиле с 11 гигами оперативки, поэтому и закралась мысль, о том чтоб сделать этот проект. Может кто уже пытался?

Да, но бери на 6-8 хотя бы,

у меня на 4 нокла, но есть

такая же на 6 той же ценой.

Гоняю в ChatterUI Qwen2 1.5b.

Спасибо, анон, и как оно? Быстро-долго запросы обрабатывает?

405 тоже, в первом кванте, хули. =)

Я заметил, что если кидать роли юзера (инструкции) из беседы подряд, то модели ломаются. Т.е., от первого лица в чате модели сидят с трудом. А вот «ты такой-то, напиши один ответ на беседу:» работает хорошо.

При этом в личном чате, где вы пишите по очереди и юзер и ассистент чередуются, как раз от первого лица работает отлично «он написал: … я отвечаю: …»

Тонкости.

Теперь мне нравится все три основных формата тюна: база, чат, инстракт. Все ситуативно и разнообразие — это хорошо.

> И сама таверна никак не форматирует сообщения

Я че-т подвис на этом.

В каком смысле не форматирует? Она вполне себе пишет весь промпт с нуля, согласно выбранным в ней установкам. Что именно она не форматирует? Содержание сообщения?

> В итоге оказалось, что это странность конкретно фронта убы

Ты про то, что он берет все сообщения и запихивает их в одну инструкцию, а не перемежает юзера и ассистента?

Квен неплохо так ходит, зависит от смарта, но читать вполне приятно стримингом.

Быстро, можно вести чат.

С Qwen2 0.5b еще быстрее.

На скрине скорось 1.5b,

еще запущен браузер Klar.

Говномобилка будет оче медленно перформить и 4 гига мало. Бу лагманы с рук или гей_мерские не самых старых поколений лучше, или что-то современное.

Если тебе чисто для чатбота то бу древняя карточка будет лучше, даже 580 рыкса.

> если кидать роли юзера (инструкции) из беседы подряд, то модели ломаются

В целом это логично, модель ведь ожидает поочередный диалог. При этом, оно терпит единичные сообщения с повтором ролей, типа тот же префилл можно обернуть в сообщение ассистента а потом просить новое, или пара подряд сообщений от юзера где одно с инструкцией а второе с запросом.

Насчет от первого/от третьего лица тут нужно смотреть на системную инструкцию и предрасположенность модели, особенно если там рп файнтюн.

Спасибо, а русскоязычная модель есть такого размера, или квен по русски тоже понимает и отвечает на русском?

Да, 2-3 инструкции подряд норм, а когда мы спецом в чате ее не триггерили сообщений 10-15, то она в первом ответе просто хтонь высрала, а потом выправилась.

Ну да, конечно, ситуативно все.

Спасибо, на компе есть карта на 3050 на 8 гигов, но я ее для СД использую, а оперативки всего 16 гигов

Квен да.

Есть аблитерация.

В шапке есть список: https://rentry.co/llm-models

В списке есть ссылка Qwen2-1.5B-Instruct-Abliterated: https://huggingface.co/cgus/Qwen2-1.5B-Instruct-Abliterated-iMat-GGUF

>что не понятно

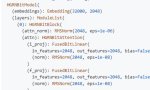

Хорошо, давай в картинках. Вот так вот промпт выглядит. С этого всё и началось. Он так выглядит только при использовании фронта убы. То, что для фронта и для API используется разное форматирование - это дичь. Потенциально при использовании убы в виде фронта или бэка результаты генерации будут отличаться. В какую сторону? В душе не ебу.

>Сначала у тебя сетка восприняла имена, которыми ты заменил слежебные токены

Смотри какая хуйня, изначально я увидел, что это строки. Внутри llama.cpp они обрабатываются, как строки. Должен быть смысл, чтобы обращаться с role, как со строками, хотя бы потому, что сравнение строк медленнее, чем сравнение чисел. Да, какие-то доли секунды, но сделать из полученного значения enum ничего не стоит. Как оказалось, смысла в этом всём просто нет, можно хуй забить.

>Ллама тред, итоги.

https://github.com/oobabooga/text-generation-webui/wiki/12-%E2%80%90-OpenAI-API

Окей. Cмотрим, что можем получить\отправить через API. Чтобы таверна форматировала сообщения, она должна знать формат. Чтобы она его знала - она должна его получить. Из API. API формат не отдаёт. Какой магией по-твоему таверна будет форматировать? Она сливает в API json, который уже бэком форматируется. Если подключать к комплишенам, то сливает вообще плейнтекстом без всякого форматирования.

>Я заметил, что если кидать роли юзера (инструкции) из беседы подряд, то модели ломаются

Кстати да. Два сообщения подряд от нейронки или два подряд от юзера и пошла генерация шизы.

>В каком смысле не форматирует?

В смысле не применяет темплейты. По идее, если бы апи отдавал этот темплейт, то она бы могла это делать, но зачем?

>Ты про то, что он берет все сообщения и запихивает их в одну инструкцию

Там получается не в инструкцию, а в сообщение пользователя. Странная же хуйня, не?

А ты хочешь юзать одновременно?

А в компе есть второй слот pcie x16?

Держи, иди ставить. Потом отпишешь что вышло

Эта соевая, у меня та, где автор 0.5 по реге сделал.

imat ставь не надо только, тас слои все на cpu идут.

Смотри, систем — это самая базовая хуйня.

Юзер для модели тоже инструкция, ответ она дает именно в ассистенте (ну, то есть, она обучена так делать). Так что, инструкция внутри юзер — это норм (у геммы, кажись, вообще нет систем и ниче, живет, офисные задачи на отлично выполняет, да и у мистрали [inst] общий, нет система или юзера как таковых).

Так что, это норм. Возможно, что-то было бы лучше перенести в систем, но таверна позволяет это сделать, и в убабугу прилетит как надо.

А сама уба да, инстракт собирает… мне не оч понравилось как. И чтобы сделать свой инстракт — надо копаться в промпт-формате в виде кода, а не удобных полях, как в таверне. Уба недоработал этот момент во фронте своем, к сожалению.

Ну, имат-то фигня.

А скинешь ссылку на свою?

Второго сорта нет. Да, хотелось бы отдельно пользоваться, и не только дома

Только карточку персонажа зачисти, а то от helpful шиза начнется:

https://huggingface.co/Emilio407/Qwen2-1.5B-Instruct-Abliterated-GGUF

- вот, нужные теги прямо в задаче по ходу ведения чаты выставляй.

Ок, спасибо, проц т616 подойдёт? Нашел с 8 гигами оперативы

Если аккаунт есть, перзалей 0.5 этого автора куда-нибудь.

>инструкция внутри юзер

Вся история чата внутри юзер. Просто сравни эти два пика и подумай, что здесь нахуй творится.

>у геммы, кажись, вообще нет систем и ниче

Жора заменяет систем на юзер для геммы. Продумал, шельмец, так что можно смело слать систем.

Это же андроид все и так в виртуалке крутится, не парься.

Глянул да сойдет, 12 нм не самый плохой вариант для 8 кор.

Спасибо

На скринах мобила на T606,

тоесть скорость будет такой.

Призапуске в q4-k-m 1.5b квена.

У нее точность чуть менее 50 mmlu.

У меня статический айпи, так что я просто коннекчусь к домашней. Удобное, чаттеруи умеет и в локалки, и в убу.

Благодарю. Думаю, можно и на рентри обновить, в таком случае.

Куда перезалить?

Не проблема, просто я тупенький и не понял.

Да, я же выше об этом и писал.

Инструкция «продолжи диалог» и дается сам диалог. Это хорошо для бесед, где переписывается куча людей. Но для чата тет-а-тет нафиг не нужно, и очень странное решение. Да, оно работает, но нахуя?.. Странный Уба.

Я все еще исключительно за q8 для таких маленьких моделей.

Благодаря нейросетке я понял почему у меня никогда не будет тяночки... я скачиваю любую, самую блять кумерскую карточку, цепляюсь за какое-то сказанное ей слово и начинаю вести философские беседы два часа. Какая-то шлюха сказала что моя судьба это ебать ее в жопу? Ну, самое время начинать диалог о предопределенности человеческой судьбы, да.

Небось еще анкеты в Знакомства для хикк/анимешников/Понурые ВК закидываешь, да?

Перезалить все кванты от сюда:

https://huggingface.co/Emilio407/Qwen2-0.5B-Instruct-Abliterated-GGUF/tree/main

на archive.org - нужен аккаунт huggingface.

>если начало диалога в карточке персонажа писать

Так делают только шизики.

>в таверне и не хватает

В расширенных настройках есть примеры диалогов. Как раз именно то, что тебе и нужно.

>Разве таверна не гоняет json

Нет, у неё свои настройки темплейта, если выбрать последнее апи.

Дальше этот спор не читал, наверняка там чела уже обоссали, ну да ладно.

>Благодаря нейросетке я понял почему у меня никогда не будет тяночки

А я не понял. Какого хуя? Ну и что, что я вешу 120 кило и вообще скуф. Зато добрый. Душный, зато деньги есть. Ну и где моя альтушка?

А вы знали что если ебануть сразу много семплеров то получается ху-и-та.

Я вот узнал недавно.

А еще узнал о такой кнопочке как Neutralize Samplers.

Особено когда ебанешь сразу minP с TopK+TopP.

Я вот узнал недавно.

А еще узнал о такой кнопочке как Neutralize Samplers.

Особено когда ебанешь сразу minP с TopK+TopP.

> minP с TopK+TopP

Взаимоисключающая хуита. А вот минП с динамической температурой норм.

Еба, сложно, а на свой хост залить нельзя?

Архив орг принципиально? Тыкни скрином, куда жмать там.

>Странный Уба.

Cтраннее всего, что он использует разные подходы для API и фронта. Нужно быть последовательным, чтоли. Как вариант, он считает, что склеивание работает лучше, но не хочет получить хейт за вольности с апи. Но никакая совместимость не ломается, хули нет-то.

>хорошо для бесед, где переписывается куча людей

Это подозрение такое или на чём-то основано? Вряд ли у Убы была цель улучшить диалоги с множеством персонажей. Как только будет не лень, попробую проверить, можно в последнее сообщение отправлять карточку текущего персонажа и просить ответить за него, но нужно где-то взять портянку с "многоперсонажной" беседой. Как только, так сразу.

>если выбрать последнее апи

Очень логично в контексте обсуждения убы/openAI api приплетать специфическое апи кобольда.

>openAI api

Нахуя? Оно не родное для кобольда/лламыцпп. Выберут хуиту какую-то, а потом жалуются на говнорезультат. Надеюсь не с ножа хоть ешь?

> Вот так вот промпт выглядит.

А что в нем не так? Офк далек от оптимального, но логику не нарушает. Под system системная инструкция. Потом идет запрос от юзера с указанием что как, потом история диалога и задача продолжить его. Потом идет переход "хода" к сетке и префилл ассистента.

Вангую что тебя смущает частое употребление юзера и ассистента, но это уже обсосано, служебные токены что разделяют разные посты, а тут даже слова разные из-за отличий в апперкейсе.

> изначально я увидел, что это строки. Внутри llama.cpp они обрабатываются, как строки

Всмысле как строки? Она просто будет выкидывать вход в консоль и все, а то как токенизирует ты не видишь.

> Окей. Cмотрим, что можем получить\отправить через API.

Что окей, как ссылка на объяснение вариантов работы с апи подтверждает твой бред?

> Чтобы таверна форматировала сообщения, она должна знать формат.

Чувак, про настройку формата, инструкций и прочего приличная часть постов здесь если что. С подключением.

> Чтобы она его знала - она должна его получить. Из API. API формат не отдаёт.

Опять бредишь, у нее свои настройки.

Кто нибудь уже пробовал новый командр? Как он?

Мемный как обычно, но в рп не зашло. Что 35В, что 104В - просерает форматирование. Так и не понял как победить это говно, часто рандомно в неочень качественных карточках начинает посреди поста вставлять звёздочки или теги. И оно очень сильно прогрессирует, в одном из чатов на 10 сообщении начал срать тегами <br> между словами и аж по 5 штук подряд вставлял. В итоге приходится свайпать постоянно. Я бы сказал сильно хуже магнумов в рп.

>начал срать тегами <br> между словами и аж по 5 штук подряд вставлял

Как будто семплеры поднасрали. Какой пресет семплеров юзал?

Я пробовал 35B версию. Аппетиты до памяти у нового Коммандера явно пониже стали: раньше в 48 Гб VRAM со скрипом 12к контекста влезало у 5Q модели, теперь 65к со свистом залетают в 8Q. Однако как будто теперь он хуже этот контекст понимает, и магия, описанная аноном на рентрае, улетучилась:

> Из киллерфич - возможность выбора любого темпа повествования (лежать в кровати 20 постов, а потом наоборот быстро перемотать несколько дней - без проблем, не поломается или не начнет куда-либо убегать и скатываться как другие модели)

Помню, как-то в рамках ролеплея я написал письмо и пошёл дальше по сюжету. И где-то спустя 4к токенов отвлечённого отыгрыша один из персонажей обратился к содержимому письма. Так вот, я аж охуел, когда старый Коммандер прямо цитату из него привёл, хотя прошло немало с того момента. Какой-нибудь Магнум в тех же условиях нёс отсебятину, лишь в общих чертах относящуюся к написанному в письме. И новый Коммандер туда же.

Также поддвачну просёр форматирования: регулярно путается в звёздочках и кавычках.

> Ждем тестов от вас, любители. =)

Мелкого покатал. Довольно ахуенен, (е)рпшить на нем оче кайфово. Понимает тебя с полуслова, спокойно отыгрывает нужное без "проматывания" и внезапных пропусков, но при этом постоянно развивает не лупясь и может плавно переходить между темами. Кумит отлично, описывает качественно и подробно, при этом опять бросается его отличное восприятие намеков и действий.

В целом чары себя ведут естественно и отвечают согласно задумкам, у прошлого это было знатным плюсом, а тут еще улучшилось такое ощущение. Хорошо выполняет nlp на чем-то общем или с левд уклоном, четко понимает и инструкцию и содержимое текста.

Отдельный бонус - теперь помещается в одну видеокарту, так что те кто был ограничен геммой - налетайте. Если врам больше то можно нарастить аппетиты по контексту.

Если и минусы. Перегруз мелкими инструкциями на что-то конкретное с 100500 условий держит хуже чем гемма но лучше прошлого. Ебенячие инмерсонейты с "clears throat", глотанием и подобным довольно бесят. Может начать срать клод-лайк в конце ответов

> The stage was set, the players positioned

> The game had officially begun

> Would you follow her lead, joining in this

в целом фиксится инструкцией на стиль. Типичных фраз со swaying hips и подобного будто тоже стало больше. Прямую речь оформляет обычным текстом, без кавычек, но слушается если ему приказать это явно делать.

В целом - хорошо, примерно то что ожидалось. Надо будет больше потестить.

Хотя бля, раз на раз не приходится, если сначала в 4х подряд чатах показал себя прилично то потом в одном все засрал mischievous grinами и прочей платиной, а в другом уже готовом запутался. Офк тестить на имеющихся чатах - некорректно, но всеже.

Надо нормально квантануть его, возможно эффект от 4bpw и пахомовской калибровки от нонейма. Ну и большой потестить.

Так речь вообще не про кобольд с таверной. Речь о том, что делает уба.

Это уже слишком троллинг тупостью, настолько тупых людей не бывает.

Что смешно, в разных логических задачках такой семплер будет делать модель "глупее", но при РП - наоборот.

По-моему, нужен ещё семплер со штрафом списка токенов, лол, чтобы вычистить к хуям шиверсы и прочее подобное.

Тема с исключением топ токена что предсказывается мелкой ллмкой параллельно была интереснее. Но и так ничего, может, кстати, от лупов бедолагам помогать.

> что делает уба

> Это уже слишком троллинг тупостью

This, совсем ебанулся шизик.

> нужен ещё семплер со штрафом списка токенов

Ай лол, с подключением.

Вроде неплохо. Лупы разлупливает лучше пенальти. Пока выглядит годно для Мистраля 123В, надо дальше тестить.

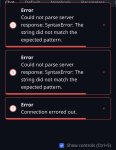

Помогите разобраться.

Есть лаптоп rtx2060 6gbvram и 64гига оперативы

oobabooga/text-generation-webui

пытаюсь поставить guff, да не запускается, недостаточно памяти.

Еперный театр, какой Q скачать, чтобы он загржал модель и не выбрасывал с erroro-м

Не бейте тапками, разбирался сидел, заебался качать по часу эти сплиты гуфов, обьединять их, чтобы потом они не запускались.

Есть лаптоп rtx2060 6gbvram и 64гига оперативы

oobabooga/text-generation-webui

пытаюсь поставить guff, да не запускается, недостаточно памяти.

Еперный театр, какой Q скачать, чтобы он загржал модель и не выбрасывал с erroro-м

Не бейте тапками, разбирался сидел, заебался качать по часу эти сплиты гуфов, обьединять их, чтобы потом они не запускались.

Логи консоли и параметры что выставляешь показывай.

> сплиты гуфов, обьединять их

Вероятно, дело в этом.

Тензор сплит вообще не трогай, это для нескольких карт. Методом тыка или нехитрых подсчётов выставь нужное количество слоёв на GPU. В твоём случае это будет немного. Выключи выгрузку KV на GPU, включи no-mmap.

>обьединять их

Что ты там объединяешь вообще?

Пока по дефолту все, только разбираюсь и пытаюсь запустить.

Гейджипити паралельно спрашиваю, но от него пользы, не ебет, хотя пишет что ебет.

Скачал 2 сейчас модели

https://huggingface.co/mradermacher/Luminum-v0.1-123B-i1-GGUF

https://huggingface.co/TheBloke/KafkaLM-70B-German-V0.1-GGUF

Luminum-v0.1-123B.i1-IQ2_XS.gguf

kafkalm-70b-german-v0.1.Q4_K_M.gguf

без сплитов, начал хоть грузить по логу.

Я хотел вообще установить все это дрочерство, чтобы условный жипити помог мне написать расширенные эвенты для bannerlord мода с loverslab. Структура xml, но копипаста вроде не привысит токены в запросе.

Соевые gpt и gemini банят запросы изза секс контента

А пидор, все же выбросил эррор

ggml_backend_cuda_buffer_type_alloc_buffer: allocating 45056.00 MiB on device 0: cudaMalloc failed: out of memory

llama_kv_cache_init: failed to allocate buffer for kv cache

llama_new_context_with_model: llama_kv_cache_init() failed for self-attention cache

22:41:33-473074 ERROR Failed to load the model.

Traceback (most recent call last):

File "E:\text-generation-webui-main\modules\ui_model_menu.py", line 231, in load_model_wrapper

shared.model, shared.tokenizer = load_model(selected_model, loader)

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File "E:\text-generation-webui-main\modules\models.py", line 93, in load_model

output = load_func_map[loader](model_name)

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File "E:\text-generation-webui-main\modules\models.py", line 278, in llamacpp_loader

model, tokenizer = LlamaCppModel.from_pretrained(model_file)

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

File "E:\text-generation-webui-main\modules\llamacpp_model.py", line 85, in from_pretrained

result.model = Llama(params)

^^^^^^^^^^^^^^^

File "E:\text-generation-webui-main\installer_files\env\Lib\site-packages\llama_cpp_cuda\llama.py", line 391, in __init__

_LlamaContext(

File "E:\text-generation-webui-main\installer_files\env\Lib\site-packages\llama_cpp_cuda\_internals.py", line 298, in __init__

raise ValueError("Failed to create llama_context")

ValueError: Failed to create llama_context

Exception ignored in: <function LlamaCppModel.__del__ at 0x00000265B7B47B00>

Traceback (most recent call last):

File "E:\text-generation-webui-main\modules\llamacpp_model.py", line 33, in __del__

del self.model

^^^^^^^^^^

AttributeError: 'LlamaCppModel' object has no attribute 'model'

Для 131к контекста тебе нужно примерно 131 Gb памяти + память под модель. Q2 по первой ссылке это около 30 гигабайт, то есть тебе нужно 160+ гигабайт. n gpu стоит 89, так что вся модель будет пытаться поместиться в твою видеокарту. Где просчитался сам поймёшь?

Вот это я понимаю, доходчиво, сообразил теперь где тыкать!

> Пока по дефолту все

Дефолт для богатых дядек с много врам.

У тебя 6 гигов врам, соответственно поместится слоев (n-gpu-layers) 5-8 от силы, подбирай экспериментально по использованию. Далее, контекст (n_ctx). Чем больше выставляешь тем больше памяти оно будет занимать, по дефолту там максимум для модели, в твоем случае начни с 4-8к а потом уже поднимешь.

Собственно этого и хватит, только будь готов что первый квант у тебя может даже в рам не влезть а второй будет работать не быстро.

Загрузил окоянный! Спасибо аноны, буду дальше тыкать разбираться!

Для справки 123B и 70B сильно влияют на забитость рама как я понимаю? Этих lmm

> сильно влияют на забитость рама как я понимаю

Можешь найти в логах сколько памяти оно скушало, пишет.

Еще галочку flash attention поставь, будет меньше жрать на контекст.

Сколько у тебя т/с? Я тоже на 2060 сижу, только пк. Я даже не думал что можно 123б запустить, однако у тебя же 64гб оперы, а у меня 16.

Как думаете файл подкачки спасает? По воле случая у меня 40гб стоит, чтобы вдруг чего..)

т/с это что? Извини я только сегодня скачал все это дело и сижу разбираюсь.

123b запустилась, как видишь на скрине медленно отвечает.

токены/в секунду. Я уж устал ждать ответа, даже на 7т/с, и перешел с 12б, снова на Stheno, где у меня 15+. Сейчас думаю на ExLlamy перейти, чтобы еще быстрее было. Хочу почувствовать скорость.

Однако, правильно тут аноны про угабугу говорят, вы ее заставили отвечать нормально в апи? Она у себя отвечает нормально, в Силли ебануто. Коболд отвечает без этого. Угабуга использует че-то другое для апи. Нашли решение, чтобы сделать нормальный ответ?

Где это глянуть? Но могу сразу сказать, он мне 5 минут писал Sure, I can help with that. Here's an additional event based on the provided XML:

Блеать, а мне то всего то нужен был не засоеный lmm с пониманием простого кода и не такими длительными ожиданиями.

>не засоеный lmm

Поэтому скачал по рейтингу

mradermacher/Luminum-v0.1-123B-GGUF

Ну 5 минут это пиздец, я бы столько не ждал.

И я понимаю что все эти xxxb типа 12b и 123b напрямую влияют насклько шустро будет выдаваться ответ? То есть мне надо найти не засоеную модель, загуфеную и чтобы в пределах ~30b для нормального респонса?

Я понимаю что чем больше b тем она умнее, бльше параметров

>b тем она умнее, бльше параметров

Да, так и есть. Кол-во <параметров>B влияет на скорость. Поскольку если модель маленькая, ты ее можешь загрузить полностью в видеокарту, а врам быстрее рам в 16 раз, или чет-схожее. Чем больше модель, тем меньше слоев ты можешь выгрузить - тем меньше будет скорость. Угабуга позволяет больше выгружать чем коболд, однако в угабуге можно уже выгрузить больше врам видяшки, и будет заимствовать/брать врам из озу, так что лучше не брать слишком много - меньше скорости будет.

30б в принципе нормально будет, кто-то сидит на 0.5б и не жалуется, но я пока таких не видел.

Спасибо за разъяснения! Качаю https://huggingface.co/bartowski/Tiger-Gemma-9B-v1-GGUF

Буду играть с ним, искать какой более менее подойдет проверить и дописать код.

зысы

Хоспаде, соевые уроды, сколько гемора, лишь бы лишний раз обиженки и угнетенные не наткнулись на коитус. Все в анальной цензуре, только умельцы и колективный разум анона и спасает.

Я ерп"шу поэтому никогда не скачиваю с цензурой модели.

> Хоспаде, соевые уроды, сколько гемора, лишь бы лишний раз обиженки и угнетенные не наткнулись на коитус. Все в анальной цензуре, только умельцы и колективный разум анона и спасает.

И самое главное, что это портит модель. Потому что пока в них нельзя внедрить новый (бесполезный) концепт не затрагивая все остальное.

А есть, кстати, такие наработки хотя бы в теории? Чтобы можно было пихнуть в ллм тупо поток сгенерированных скриптом примеров на матан и она с этого поумнела, не поломав все нахуй?

Хотя очевидно, как только такое появится, все позасрут цензурой окончательно.

Поему ллмки не могут даже стих пушкина нормально написать? Тексты известных да и любых песен аналогично.

А ты сам-то можешь?

Напоминает типикал нормиса. Ему показывают невероятную технологию с огромным потенциалом и уже в текущем виде позволяющую сделать революцию, а он носом воротит не понимая или требует сделать какую-то юзлесс ерунду.

Кто там бомбил что друзья ллм не оценили?

>А ты сам-то можешь?

Конечно, что в этом сложного?

Что за бред ты несёшь...

Радуйся, что локалки вообще связный текст научились писать, особенно мелкие. Кому нахуй нужны твои стихи и тексты песен? Ты локалку как поисковик блять используешь, потому что тебе лень в гугл зайти?

>врам быстрее рам в 16 раз

Пиздеж, цифра взята тупо из головы. Реальная разница зависит от частоты и пропускной способности процессора.

>будет заимствовать/брать врам из озу

>брать врам из озу

Дожили, блять.

Она же быстрее. А во сколько раз, я не знаю. Это же и от видяшки зависит, на сколько ближе расположены чипы видеопамяти.

>Дожили, блять.

Пик, если ты не понял.

Это дефолтная оперативная память, которая выделяется при нехватке видеопамяти. Врам это то что распаяно на самой плате, держу в курсе.

Ты про сочинение стихов по аналогии, или про пересказ известных? Первое - сложная задача, однако ллмки в них пытаются и иногда даже получается. Второе - тебе дай 3 раза прочесть а потом выпезднуть и заставить четко пересказывать, только жидко оподливишься. Тут аналогично, ллм не запоминают просто слова а строят связи для последующего воспроизведения вероятного по смыслу токена.

> Что за бред ты несёшь...

> Поему ллмки не могут даже стих пушкина нормально написать?

кек

> Пиздеж, цифра взята тупо из головы.

Ну типа взять типикал школосракерскую ддр4, что сейчас в большинстве пекарен, там будет в районе 50-60гб/с. Видимокарта имеет овер 900гб/с, так что он недалек от правды.

Эта область, куда будет сгружена часть данных что не помещается в врам. Рам сама по себе не быстрая, так еще все данные по pci-e будут гоняться.

>которая выделяется при нехватке видеопамяти.

А я написал по другому? Я это и имел ввиду.

>Она у себя отвечает нормально, в Силли ебануто.

Должна отвечать так же, как кобольд, если уба отвечает по апи ебануто, значит, таверна шлёт какие-то ебанутые параметры, ищи по настройкам таверны. Успехов тебе найти что-нибудь в конченом интерфейсе.

>Хочу почувствовать скорость.

TensorRT тогда твой выбор. У меня вроде было ~50 т\с на 7b или больше. В итоге откатился на 6-7 т/c с моделью пожирнее и абсолютно доволен.

>Я уж устал ждать ответа, даже на 7т/с

Ну здесь три варианта. На сколько помню, в среднем человек может читать 15 знаков в секунду. Вариант первый - ты человек-муха, который может читать в три-четыре раза больше, чем регуляр хуман бин. Вариант второй, твоя модель говно и у неё 1 токен - 1 символ. Ну и третий, что скорее всего - ты забыл включить стриминг и ждёшь полного вывода перед началом чтения.

> Ну здесь три варианта. На сколько помню, в среднем человек может читать 15 знаков в секунду

Вот, кстати, я внезапно пришёл к выводу, что ~7 т/с на ангельском для меня максимально комфортная скорость, потому что я как раз расслабленно читаю текст вместе с его выводом.

Но с текущей конфигурацией модель выдаёт около 20 т/с, ибо полностью выгружена в видеокарту. И т.к. за текстом уже не уследишь, возникает соблазн прочитать всё по диагонали и идти дальше. Это, конечно, удобно, когда хочется посвайпать до максимально комфортного ответа, но не особо полезно для погружения.

>Видимокарта имеет овер 900гб/с