Анон, для этих нейронок какую карту надо? Выбираю между 4060 8 из магазина или 4070 12 из под полы.

На сцене новый участник gemma-2-9b-it-abliterated-Q4_K_L

Казалось бы, очищенный от сои, но по факту нет. И не знает, кто такие бляди.

Это был бы полный провал, если бы модель не написала код для змейки.

Модель соевая и немного туповатая, но код пишет, поэтому возможно для кодинга она подойдет. И только для кодинга, но надо сравнивать в более сложных задачах. Пройдено 2 теста из 4.

Большая проблема кодинга - нужно постоянно писать дальше, нужно поиграться с размерами контекста. Возможно это поможет.

>Анон, для этих нейронок какую карту надо?

Не какую, а сколько штук 3090, лол.

Да, проверил, мини-магнум почему то стал говорить во время минета...

Ну и для разнообразия, еще один партнер для спарринга

с текущим лидером , модель meta-llama-3.1-8b-instruct-abliterated.Q6_K

Модель знает, что такое горловая ёбля, но не знает, кто такие бляди. Соевой не является, но немного тупая.

Код пишет подробный, возможно это новый кандидат для кодинга, но вопросы за пределами сои она не всегда хорошо понимает, по тупости, а не по злому умыслу.

короче говоря, если чел хочет 4 поколение ПиСиАй то ему что-то типа такого надо

https://www.ebay.com/itm/175685580161?_skw=epyc+7203&itmmeta=01J7P0QDETRDDS78FPZAGRX929&hash=item28e7ad3581:g:wwgAAOSwYE1kNVaj&itmprp=enc%3AAQAJAAAAwHoV3kP08IDx%2BKZ9MfhVJKliRJzg5rTVmOzb82TPtcE8i07L83Deg742C3nYsppX9olqKTecvwT7gKgzL%2Fztoa66jf%2Bs155ZZuw93vPFDXGWzIzVRANKipEgbqY8CAT9e5TtpZQv6OqquZm%2F9NtgQWaKOmHSqqO3LRfBQF3DjyxPxJchz%2FEzCTsWakD46LhRXcWH6vCNUvwXwuvKC%2FkBMHd0IStF2HJ1fiZaSZ8svR4%2Bi3UmjnsxTSSjacC0TjV%2F5g%3D%3D%7Ctkp%3ABk9SR8LX3cC9ZA&edge=1

если найти с 7203 то можно в косарь вложиться, с риперами +- то же самое будет по цене, те что еще могут чего-то дорого стоят...

Почему у тебя 8б с Q6, а 13б с Q3?

а подскажите, в чем может быть прикол, что чурез бугу нормальные ответы дает, а по API периодически фигня - это с контекстом связано? или инстракшен кард?

(то пытаюсь настроить систему тестирования моделек, чтобы не гонять вручную запросы, но пока по апи периодически косяки лютые)

(то пытаюсь настроить систему тестирования моделек, чтобы не гонять вручную запросы, но пока по апи периодически косяки лютые)

Есть такое, ответы с апи отличаются от встроенного чата угабуги, как пофиксить я не знаю. У кого-то нет проблем с этим.

А ты включи --verbose и посмотри, что уба отправляет модели при запросах через api и через встроенный чат. Сюрприз будет.

Почитал шапку

>от 12 до 36Гб памяти

Эта память должна быть на видео карте или я могу использовать свои 32гб ддр4 оперативной?

спасибо анонче, гляну...

выходит через АПИ нельзя сделать по людски, чтоль?

можеш конечно, но тогда ты на процессоре запускать будеш, и это медленно будет довольно...

ОЗУ не нужна, на ней ничего не будет работать, особенно на ддр4.

Читай теперь и вики.

> где тут вобще про tr4 речь шла?

> есть старые материнки под Threadripper на x399 чипсете с сокетом AM4, там до четырех честных слотов PCIe 16x единственное что версии 3.0

И пост с исрпавлением очепятки про tr4, в шары долбишься?

> даже в твоем 1920х

Боже упаси в это говно вмазаться

> 64 линии

> PCI-Express: Gen 3, 60 Lanes (CPU only)

Порошок уходи!

И даже если бы их реально было 64 то из них штук 8 выделили бы под пару ssd и остальные поделили чтобы сделать больше слотов.

> тредриперы "огрызки"

Они странные, первые под tr4 параша, которую убили свои же десктопы. После них те что под trx40 имеют неадекватный прайс что есть смысл на эпики или интел смотреть.

> И всё это добро обходится тебе дешевле одной 4090.

Не забудь добавить что каждый из процов будет стоит как видеокарта, могут быть нюансы с нумой. Но, если есть чем загрузить, вариант вкусный 100%.

Именно, проследуй нахуй на среддит читать нытье бедолаг, что пытаются завести жору на теслах с двухголовыми некрозеонами и получают сильную просадку скорости в зависимости от того какие из карточек задействованы. В трипаке и амудах если че отдельных нод, как в многосоккетных, нет.

Скорее всего ты просто криво юзаешь апи. Для чата необходимо сначала правильно настроить формат промта и прочее. Для текст комплишн правильно оформить все самому и уже передать. Плюс, параметры семплеров.

А там наоборот. Через апи всё идёт, как положено. А через чат - как уба захотел.

Прочитал вики. Не понял работают ли матрицы квантования для актуальных моделей.

Как аноны запускают модели на 32гб +?

Сначала качал по советам из шапки, что хотел, скачалась модель meta-llama-3.1-8b-instruct-abliterated.Q6_K

Затем по совету анона качал модели на 5-6 гигов, чтобы хватило на контекст, как итог скачалась модель Mistral-Nemo-Instruct-2407-abliterated.Q3_K_S

Потом сравнивал лучшую модель для своего устройства по критериям , первичный отсев, так сказать

Ну есть такое, да 5-6 не весят Q4+ Сколько у тебя т\с? У меня 7-9, после падает до ~5

Нахуя?

>каждый из процов будет стоит как видеокарта

Два 4410Y на штуку зелёных и доска на сдачу. Ладно, по цене одной 4090 всё удовольствие.

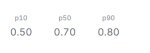

И куда тут смотреть? Цифирки дают чистое значение? Или

это с запятыми? т.е. 666 т/с или же 6,66

Алсо, это бенчмарк от кобольда что ли?

> И куда тут смотреть?

Ну вот например

> это бенчмарк от кобольда что ли

Да

> 64 линии

> PCI-Express: Gen 3, 60 Lanes (CPU only)

ну значит гугл звиздит, а на сайте АМД вообще нет спеки этой похоже...

>осле них те что под trx40 имеют неадекватный прайс что есть смысл на эпики или интел смотреть.

так и я о том, но, предпоследнее поколение железа, нам ведь PCIE4 надо, не может дешевым быть... с тройкой цена сразу падает... а так,только страдать...

>Скорее всего ты просто криво юзаешь апи. Для чата необходимо сначала правильно настроить формат промта и прочее. Для текст комплишн правильно оформить все самому и уже передать. Плюс, параметры семплеров.

а есть где-то простые гайды по АПИ?

тоесть выходит все то что в буге настраиваеш на АПИ не влияет? ну окромя параметрова загрузки модели... ? и надо все подстраивать в программе юзающей API?

Составил таблицу текущих результатов тестов.

В тесте на сою следует различать нуль и минус один. В первом случае модель неправильно ответила на вопрос, потому что она тупая, но не соевая. Во втором случае отказывается отвечать, что хуже. По моим критериям, лучше в некоторых вопросах быть тупой моделью, чем соевой. Тупость - простительна, соевость - нет.

Предлагайте свои модели и критерии отбора.

>В тесте на сою следует различать нуль и минус один.

Спасибо что не ноль и минус ноль.

Ну а хули ты хотел от модели, которую обучали на синтетических, стерильных данных? Она и слово то такого никогда не видела.

Ля, аж запах ели почувствовал после такого поста, такие модели сразу отправляются в мусорку, если она не может нормальный связный текст выдавать, с такой даже кумерством заняться проблемно будет, похоже что она русского почти не знает...

> вариант вкусный 100%

Топовые варианты на Эпиках всего в 3 раза быстрее игровой DDR5. Этот кал даже хуже тесл.

Ультразатычка, но в целом почему бы и нет, норм вариант.

> а есть где-то простые гайды по АПИ?

https://github.com/oobabooga/text-generation-webui/wiki/12-%E2%80%90-OpenAI-API и в самом коде глянь, там все оче просто.

> тоесть выходит все то что в буге настраиваеш на АПИ не влияет?

А хуй знает, обычно все параметры передаются, непонятно что именно оно юзает при отсутствии данных, какой-то дефолт или выставленное в вебуи.

> окромя параметрова загрузки модели

Через апи можно управлять загрузкой новых моделей.

> и надо все подстраивать в программе юзающей API

Типа того, обычно используют тексткомплишн чтобы сделать себе желаемый правильный формат промта, и с каждым запросом передают основные параметры для генерации.

Вот вы тут какие-то выводы делаете, но тестируете в кобольде (!) с неведомым форматом и всратым промтом, какой вообще с этом смысл? Что-то уровня рассуждений об эргономике перфоратора отбивая им чисто вручную без подключения к сети.

Можно подумать что твой пикрел кал лучше тесел, и забываешь что там в сумме 16 каналов вместо 12 за меньшую цену.

>Вот вы тут какие-то выводы делаете, но тестируете в кобольде

Вот вы тут выводы какие-то делаете, а ML щики вы не настоящие, а кобольд на порнхабе скачали

> Вот вы тут какие-то выводы делаете, но тестируете в кобольде (!)

А что с ним не так? И где надо тестировать?

> с неведомым форматом и всратым промтом, какой вообще с этом смысл?

А что не так с промтом? Простые житейские вопросы, чтобы быстро обнаружить явные косяки.

> Что-то уровня рассуждений об эргономике перфоратора отбивая им чисто вручную без подключения к сети.

Чисто прикладной тест, чтобы быстро отбраковать заведомо хуевые модельки для моих задач.

забыл, кобольд - реально дичь какая-то, когда на угу перешел - значительно лучше ответы пошли, такое чувство что кобольд в некоторых моментах криво настроен.

а ты убедился, что он модельки корректно вообще гоняет? потому что из за этого вообще может бред нести например...

И как это проверить?

>кобольд - реально дичь какая-то, когда на угу перешел - значительно лучше ответы пошли

А ты его что - как фронтенд использовал? Он для этого не предназначен, даром что возможность есть. Кобольд ценен другим.

Какой пресет на магнум для таверны?

>Какой пресет на магнум для таверны?

Могу рекомендовать Миростат.

Это который MiroGold, MiroSilver, MiroBronze?

>Это который MiroGold, MiroSilver, MiroBronze?

У меня там стоит обычный Mirostat. Возможно со старых версий остался. Пробуй все, чего бы и нет.

В новых версиях, чего-то нет миростата. Скинь как выглядит он.

>путает пресеты и темплейты

Шапку с вики не читал, или в ней не достаточно информации?

Вы друг друга стоите, тоже в прошлом треде говорил кто-то про миростат. Имел ввиду не семплеры, а ты теперь что имеешь?

Где у тебя в вики прописано про Template/Пресеты? Покажи если обращаешься к ней.

>В новых версиях, чего-то нет миростата. Скинь как выглядит он.

Это вообще в другой вкладке, там где "настройка ответа ИИ". Не найдёшь там Миростата - ставь Миростат Голд, судя по настройкам разница небольшая.

>Имел ввиду не семплеры

Семплеры-семплеры. И тогда семплеры и сейчас семплеры :)

>Где у тебя в вики прописано про Template/Пресеты?

Я тебя и спрашиваю, достаточно ли там инфы или нет. Видимо ответ нет.

Так и так миростат лупиться на магнуме, или может настройки семплера разные? Я чисто пробовал миростат, без голд/бронз и прочего.

Если недостаточно, добавь. В Силли дефолтные пресеты нормальные.

Кобольд вовсе не плох, но это довольно минималистичный инструмент, который требует настройки и имеет ограниченный функционал. С убой может быть действительно проще, ведь там и полные семплеры и большинство форматов есть по дефолту.

> А что не так с промтом?

Системный промт у тебя какой? Если "ты безопасный ассистент" или подобное то и рассчитывать не на что, модель буквально будет делать то что ты просишь, а ты носом воротишь.

Ну да, тут еще ггуфоприколы могут быть.

> Системный промт у тебя какой?

Ну например для мистраля

>Так и так миростат лупиться на магнуме, или может настройки семплера разные? Я чисто пробовал миростат, без голд/бронз и прочего.

От дефолтного Миростата я только поднял температуру (но это дело вкуса и на лупы не должно влиять) и поставил "Штраф за повтор" в 1,1 при "Окне для штрафов за повтор" = 2048. Этого оказалось достаточно. Правда у меня Магнум 123В.

{{char}} должен отвечать только на русском языке!

"Пиши на русском" - это уж слишком минималистично :)

Получше стало, лупов или нет или их кол-во уменьшилось. Хотя я до сих пор играюсь с семплерами, не могу найти какой-то один.

У меня в Силли в заметках автора такое - Все взаимодействия и ответы должны быть на русском языке. Пожалуйста, используй грамматически правильный и ясный русский язык. Если нужно ты можешь использовать ненормативную лексику.

Ну ты содомит, чуть с кресла не пезднулся. Ну удачи с такой херней, хули.

Немного с АПИ разобрался, оказалось проблема была на стороне "клиентской части", которая не хотела все параметры передавать... но все равно, разница в генерациях есть, может потому что контекста нет при передаче через АПИ, потому что разницы я не вижу уже...

и так, погоняв немного Yi-Coder 1,5 потенциал в нем всеже вижу, лол, аж самому смешно, потенциал в полторашке, да, не всегда правильно, но базовые штуки пишет, типа сортировок, слияния файлов итд...

и так, погоняв немного Yi-Coder 1,5 потенциал в нем всеже вижу, лол, аж самому смешно, потенциал в полторашке, да, не всегда правильно, но базовые штуки пишет, типа сортировок, слияния файлов итд...

Какую базу посоветуете для 10 гб врам (3080) для рп? Есть еще 32 гб оперативы 6000

попробовал я этот ваш магнум 123б.

Ебать конечно она шпарит, прям как настоящий человек.

Тян официально больше не нужны.

альсо братишкам с темлами привет, остальным соболезную.

Ебать конечно она шпарит, прям как настоящий человек.

Тян официально больше не нужны.

альсо братишкам с темлами привет, остальным соболезную.

как блять заебло

пример реал ситуации

посылают в магаз за хлебом

тдешь

покупаешь

возвращаешься

нейронка же мгновенно забывает недавние цели что ты пришел в магаз не на вечность засовывать булки в жопы - а просто сделать чек и сьебать.

нейронка вечно отвливается на какуюто фигню и забывает что это было уточнение истории. и вобще то историю надо двгать дальше.

что сделать чтоб сеть не вела себя так тупо?

надеюсь понятно обьяснил

пример реал ситуации

посылают в магаз за хлебом

тдешь

покупаешь

возвращаешься

нейронка же мгновенно забывает недавние цели что ты пришел в магаз не на вечность засовывать булки в жопы - а просто сделать чек и сьебать.

нейронка вечно отвливается на какуюто фигню и забывает что это было уточнение истории. и вобще то историю надо двгать дальше.

что сделать чтоб сеть не вела себя так тупо?

надеюсь понятно обьяснил

>что сделать чтоб сеть не вела себя так тупо?

Чем больше модель - тем меньше ошибок;

Делай большой контекст;

Работай на английском (с переводчиком в обе стороны);

Реролль, если генерит совсем не то;

Если пошло совсем не туда - стирай последние посты и подсказывай;

Делай ручной суммарайз;

Пробуй разные модели и файнтюны последних поколений;

Всегда помни, что модель несовершенна.

>попробовал я этот ваш магнум 123б.

А теперь попробуй Luminum-123B. Умнее и даже немного быстрее.

>Работай на английском (с переводчиком в обе стороны);

лол а разве не все так по умолчанию делают?

>Делай большой контекст

хуй найдешь где он больше

>Реролль, если генерит совсем не то;

ваще не решение

>Пробуй разные модели и файнтюны последних поколений;

проблему вижу пару лет на всех моделях . просто где то везет а где то нет но я уверен что причина проблема есть везде

> стирай последние посты и подсказывай

так можно и до рп в блокноте дайти

Хорошо, тогда ещё один совет: найди индюка и еби мозги ему :) А тут не надо. Все живут как-то, справляются.

Вы на чем их гоняете?

лол а разве не все так по умолчанию делают?

так а нафига ллмки если к ним еще гугель транслейт прикручивать

модель должна быть универсальной и сама переводить хорошо

я на трех теслах.

Еще четвертая лежит, но воткнуть некуда и с охладом проблемы.

Карты которые в корпусе на материнских pcie жарче на 10+ градусов чем та, которая снаружи на райзере висит. А это не шутки, когда речь про температуры около 60. И это в жоре когда контекст скачет с карты на карту. СД утилизирует так, что там доменная печь образуется.

Заказал себе мать BTC79x5v1.0, сижу жду. Надеюсь на ней есть above 4g.

чо бля? а если все модели плохи в русском мне с блокнотиком сидеть вместо сеток?

в чем проблема сделать машину времени и год назад купить себе 4 теслы по цене пиццы с школьной столовой

та РПш как хочеш, хоть через Промт переводиОлды здесь?, я говорю что для многих тасков окромя кумерства нативная поддержка языка необходимость практически, более того гугл плохо переводит иногда...

чтобы что?

к чему это блять?

и чо ты предлагаешь - юзать русик который естесно во всем хуже енглиша? мне не сложно копипастить с другой вкладки

Чтобы собрать майнинг ферму и гонять Ламу самую жирную... которая нормально работает со всеми языками, и минимум глюков содержит...

заходит как-то школьник в ЛЛМ тред, снимает ботинок с ноги и каблуком хлопнув по трибуне спрашивает "а хули вы все тут собрались? нахуя это всё?"

причем тут глюки ты меня слышиш вобще?

сетки не защищены от забывания что из уточнения и отвлечения надо возвращатся в основную конву

а нее как у толстово встретил дерево и описывает его на 100 страниц

а зачем ты ботинки с каблуками носиш?

За сколько тогда можно было купить теслу?

зависит от того, какое "тогда" ты имеешь в виду

Я слышал, что год назад то-то и за 13к брал.

ну точно школьник, не понял отсылки...

слыш, борда 18+

И смотря какую теслу, я как понимаю в мое "тогда" за 13к, точно уж не 12гиговую.

Ничего тебе не предлагают тут, ты еще и по вкладкам махаеш? жесть... Куда вы этот ролплей примазываете? сириосли днями сидите с нейронкой общаетесь?, если на инглише результат устраивает работай на инглише, внезапно можно и не переводить, инглиш не корейский, надо знать,

ну так тут вооббще влияние языка минимальное, это проблема сетки как таковой, вожможно правка контекста подлечивать может такую проблему...

сейчас бы теслу брать не 24 гб...

народная тесла треда только одна - P40.

>Куда вы этот ролплей примазываете? сириосли днями сидите с нейронкой общаетесь?

хороший вопрос. Да, обычно примазывать его некуда, кроме кума радугой по вечерам.

Но я иногда спрашиваю её по SRE тематике. Внезапно в 70b+ сетках открывается емерджентное свойство рассуждать логически при скудных вводных данных и плохой изученности проблемы. Сложно описать. Типа, обычная gemma 23b тебе конечно выдаст ответ, но он будет как сборник ответов со стековерфлоу. В то время, как 70b+ может выдать какой-то инсайт.

Ну, а еще мне сетка норм по диете и питанию разложила. И сразу с препаратами даже, а не просто "занимайся больше и жри меньше". Их плюс в том, что они по знаниям дохуя широкие.

А производительность у теслы какая? Какая сопоставимая видимокарта

> на трех теслах

Че там по скоростям?

> когда речь про температуры около 60

Это смешная температура.

> BTC79x5v1.0

Ща набегут засрут что там линий недостаточно.

Хорош, всхрюкнул

А она ему как раз.

> > BTC79x5v1.0

> Ща набегут засрут что там линий недостаточно.

Ее бы какими-нибудь p102 на фулл забить, лол, вот это был бы потешный днищеконфиг. Или еще лучше ту восьмислотовую йобу вместе с дешевым "майнерским" бп. Я бы на такое посмотрел...

https://www.reddit.com/r/LocalLLaMA/comments/1fg46ak/magnum_v3_27b_kto/

Там еще и гемма 9ь есть магнум версии

Да и вообще куча моделей пачками повыходили чуть ли не каждый день

Ват а тайм ту би лив

Там еще и гемма 9ь есть магнум версии

Да и вообще куча моделей пачками повыходили чуть ли не каждый день

Ват а тайм ту би лив

Как ты сделал такую двачеоболочку? я что-то пропустил?

Эти проблемы отчасти можно решить скриптами, задавая модели разные промпты на разные ситуации, заставляя её генерить себе "план" и включая его в промпт и т.д.

Анон в позапрошлом треде скидывал методику

Всё хочу попробовать заняться, но некогда...

Да, за Магнумами надо следить.

Добавил в список, особенно 27В. Для меня эта Гемма стала базовой локальной моделью и наконец-то к ней вышло что-то кроме поломанного БигТайгера это надо затестить.

>куча моделей пачками повыходили чуть ли не каждый день

А что ещё?

Аноны, подскажите что за хуйня. Загрузка кобальта стопорится на этом этапе и потом очень очень долго ничего не загружается, даже мелкие модели. Причём если один раз эта хуйня прогрузится, то потом будет запускаться моментально. Предположу что проблема возникла после версии с автоопределением кол-ва слоёв на видимокарту, но даже если выставлять своё значение или 0, или вообще использовать нокуда, то ситуация аналогичная.

Что это за хуйня и как победить?

И куда кобольт пишет свои конфиги, в appdata ничего связанного с ним нет?

Версия 1.74.

Кому Tesla P40 за 22к?

https://www.avito.ru/sankt-peterburg/tovary_dlya_kompyutera/nvidia_tesla_p40_24gb_4594444521

мопед не мой, случайно наткнулся

Попробуй просто подождать подольше, у меня свеже-скачанный кобальд при первой загрузке модели может тупить минуту+ на этом же этапе.

Попробуй CU12 версию

Два чая этому

аналогично

>ну точно школьник, не понял отсылки...

Ну про никитку отсылка совсем древняя, тут пенсионеры не все вспомнят...

к 70b, 123b вопросов нет, вопрос куда столько народу крутит 10 и меньше, и есть ли на них жизнь... я понимаю конечно что локальная гопота это круто, но только если результат практически сопоставим, а не вычищать тексты после локалки 3 дня...

1080 конечно... да она тугая для нейронок, по современным меркам, но ведь 24 гб,

>заходит как-то школьник в ЛЛМ тред

и покупает 660ti

>А она ему как раз.

так сразу ферму купить на 102х норм тема будет, почти... не знаю как 102, но 104 дешевые довольно, по цене выгоднее теслы, но они ж жрать будут электрики капец...

ну и на тесле можно гонять СД в высоком разрешении и с контролнетами

жесть, барыги...

а кто подскажет по тренировке лор, как происходит процесс и главное сколько памяти надо на такое чудо?

Хочет быть выше, карлан же.

P100 по идее тоже интересна, HMB память же, ебёт всё кроме 3090.

>Ща набегут засрут что там линий недостаточно.

Линий там достаточно, 40 штук же. А вот одна плашка это конечно лол.

>Да и вообще куча моделей пачками повыходили чуть ли не каждый день

Уже два года так живём. Иногда бывают мирные периоды затишья, но выходит новая база, и вот куча шизомержей.

>сколько памяти надо на такое чудо

Чем больше, тем лучше. Без 24 гиг лучше не соваться.

а были извращуги пробовавшие на цп тренить лоры? или люди столько не живут?

хм, интересный момент, судя по калькулятору https://rahulschand.github.io/gpu_poor/, 410м модельку можно полностью тренировать на одной видяхе, кто-то пробовал такое делать?

>или люди столько не живут

Yep.

>полностью тренировать на одной видяхе, кто-то пробовал такое делать

Пробовал. Там по времени всё равно дохуя выходит, а я не готов ждать результата неделю. Поэтому у меня были недотрейненные огрызки. Можешь задавать свои ответы.

Сайт ебанутый, ты линком не ошибся?

>Че там по скоростям?

по скоростям жопа, но ради качества ответов я могу это потерпеть.

Для порнорп юзаю сетку поменьше - magnum-72b-v1-Q5_K_M. У неё достаточная скорость генерации, чтобы не ждать прям по буквам пока сеть рожает слова.

>Это смешная температура.

смешная? Ну разогрей карту до 60 и попробуй подержать руку на черной металлической пластине на бэке карты.

Термическую усталость материалов никто не отменял, а карты на секундочку 16 года выпуска. Их и до нас уже хорошо прожарили.

>Ща набегут засрут что там линий недостаточно.

для жоры достаточно x1.

Я экспериментально проверил как работает использование нескольких карт.

Жора кладет одинаковую программу и разыне куски модели во все карты и между ними перекидывается при выполнении небольшой объем данных. Настолько небольшой, что скоростью их передачи можно пренебречь. x16 или x1 - не важно, это не является батлнеком при генерации. Батлнек - работа с самой моделью, она не параллелится.

По сути работа на трех картах по 24 гб с тремя чипами равноценна работе на одной карте с 72 гб и при росте объема модели медленнее она начинает генерировать только потому, что чип в картах слабый и старый.

>BTC79x5v1.0

вообще я именно её взял не из-за линий (хотя там в комплекте проц на 40 линий и написано что на все порты подается x8), а из-за того, что это удобный формфактор. Другие такие платы излишне длинные.

просто добавил это в чара

> Она знает о существовании интернета, давно сидит на имиджбордах и умеет троллить, не боится колко выражаться для красоты речи.

>куда столько народу крутит 10 и меньше

ну так там и теслы не нужны. Люди просто пробуют. Я тоже сначала гонял мелкую модель на 3070 до покупки тесел. порно рп на них конечно уровня "я тебя ебу, ты меня ебешь, ах", но все-равно новые ощущения.

>СД в высоком разрешении

только в рамках одной карты к сожалению. Я не нашел способа использовать память всех трех карт под одну задачу. Есть мультидифьюжн, но он параллелит генерацию мелких картинок, а не размазывает генерацию одной большой картинки на все карты. И то это в half режиме. Если выставить --no-half - там сразу 10 гигабайт от карты съедается просто при загрузке модели. fullhd при ренерации без апскейла - это потолок, да и апскейл тоже падать будет по cuda oom если больше чем x2.

И апскейлеры тоже не умеют апскейлить одну картинку с помощью трех карт.

для моей 3060 12gb это не актуально. Либо слишком ужатая до уровня даун модель, либо 1,5 токена в секунду + по 10 секунд ждать прогрузки каждого 512 контекста.

Считает ли SillyTavern токены или просто буквы? В метадате моделей написано что есть токен?

Можешь задавать свои ответы.

подкинь тогда где почитать как вкатится в такую содомию, вцелом то вижу задачу зафайнтюнить на конкретную тему, есть подозрения что 410 справится с таким

>но все-равно новые ощущения

я когда-то в анонимном чате так по рпшил, прикольно, но ощущение проёбаного времени, даже ютубчик позалипать менее угнетающе звучит

хуй знает, как вообще люди без тесел живут, господи... 12 гигабайт - для него слишком много. Бедный парень.

по СД то понятно, никто и не просит от нее паралелиться, и потому тесла и выгодна, что 24 это в три раза больше чем 8, а 8 это совсем притык, а если видосы перерисовывать так там надо шустро, и желательно хотяб 720p а не 320*240

> никто и не просит от нее паралелиться

буквально я. Я прошу от неё параллелиться и использовать всю память всех карт.

Блять....

так тут проблема в том, что оно как бы не особо выгодно, купляеш одну теслу - и как лох гоняеш 30b модельки, покупаеш пачку тесел, и.и.и. есть шанс запустить жирную модельку на хреновой скорости, но за эти деньги можно на несколько лет подписку на гопоту купить и работать как белый господин... короче говоря это для энтузиастов, которым гонять самому интересно, а не рабочий иструмент максимально выгодно нужен...

хотелось бы конечно, но низзя, не раскидывается она, как минимум потому что не однопроходная......

Лол, короче вспомнил, как по приколу попробовал проходя какой-то курс по нейронкам на основе сверточной натренированной на класификацию картинок посчитать градиенты при класификации рандомного шума и получить с него картинку - вышел психодел лютый)

>подписку на гопоту купить

щас бы платить выблядкам, продавшим свою жопу майкрософту и предавшим принципы opensource коммьюнити, ага

>подписку на гопоту купить

Вот, кстати, интересная хуйня. До первой теслы мне гопота умной казалась. Я тогда гонял 20b франкенштейнов из второй лламы и гопота выгодно смотрелась на их фоне. После первой теслы, появления в моей жизни коммандеров, гемм, третьих ллам - всё в корне изменилось и гопота вызывает только раздражение своей беспомощностью и глупостью.

С коммандером и геммой просто смешно 4о сравнивать. Лама 3 тоже еще далековато, если смотреть не на красивые графики

>всё в корне изменилось и гопота вызывает только раздражение своей беспомощностью и глупостью.

Я давно не общался с ЧатГПТ и даже не в курсе, на каком он сейчас уровне. Но иногда работаю с Клод Соннет - все говорят, что она даже лучше. Очень раздражает демонстративная услужливость и соглашательство данной модели, хотя заметен и огромный потенциал. Но третью Лламу в принципе уже можно сравнивать, а уж Мистраль Ларж 2 тем более. И очевидно - я не пробовал, но это прямо чувствуется - что в РП Соннету точно так же не хватит соображалки, как и тем двум моделям. Тем более он под это не заточен. О сое я уже и не говорю.

Ну чуть быстрее моей 2060, однако памяти 24гб, и сколько т/с на больших моделях? аля 70+, у меня на гуфе 7-9 т\с 13б, при не полной загрузке. Там я думаю на порядок больше, а может и нет.

>сколько т/с на больших моделях

6+ на 70В_Q5KM c 16к контекста

4+ на 123В_Q4KM c 16к контекста

Плюс небольшой. Но - это только генерация. Обработка контекста на теслах - боль, для смягчения которой применяются многие хитрости. Иногда не помогает.

Конечно вряд ли поможет, но попробуй тыкнуть лкмом в консоль и понажимай пару раз enter. В 11 винде консоль блочится если кликнуть на нее

>смягчения которой применяются многие хитрости

Это какие? Есть что-то кроме FleshAttension?

>Это какие? Есть что-то кроме FleshAttension?

Прежде всего Context Shift. Если он с моделью работает - всё зашибись.

Я вот эту шнягу использовал

https://huggingface.co/docs/transformers/model_doc/gpt2

плюс нейросетки спрашивал, лол.

Уже тысячу раз писал, что соя портит все коммерческие сетки. Все эти килобайтные джейлы нихуя на пользу не идут, а без них у меня Сори я кант континуе прямо на карточку персонажа.

А ну, да, только я его почему-то только в коболде видел, его разве нет в угабуге?

>Сори я кант континуе прямо на карточку персонажа.

в голос

Достаточно долгое время зависал на сатах типа спайсиаичат и решил попробовать ЛЛМ. После изучения гайдов из шапки решил поставить таверну через кобольда для ерп. Проковырялся несколько вечеров и заставил все работать. Возникло несколько вопросов:

1. Минимагнум 12б на 4070 генерит респонсы примерно полторы минуты на дефолтные 250 токенов. Можно ли это ускорить и каким образом без снижения качества модели? Или эта гпу совсем дно и нужно понижаться до 7б моделей

2. Если я правильно понял, полнота и развернутость ответа зависит от используемой модели и степени квантования. Но в некоторых случаях на одной с разными пресетами персонажей/сценариев получаю совершенной несвязанное повествование. Это значит нужно искать менее кривые карточки персонажей?

3. аналогичная ситуация с ответами за юзера, в некоторых случаях происходит пиздеж за меня на половину респонса. Какой параметр отвечает за это и как ограничить эту возможность.

4. Что можно почитать для более детальной настройки моделей/персонажей, чтобы они не выпрыгивали из штанов после первого респонса.

Заранее спасибо за пояснения.

1. Минимагнум 12б на 4070 генерит респонсы примерно полторы минуты на дефолтные 250 токенов. Можно ли это ускорить и каким образом без снижения качества модели? Или эта гпу совсем дно и нужно понижаться до 7б моделей

2. Если я правильно понял, полнота и развернутость ответа зависит от используемой модели и степени квантования. Но в некоторых случаях на одной с разными пресетами персонажей/сценариев получаю совершенной несвязанное повествование. Это значит нужно искать менее кривые карточки персонажей?

3. аналогичная ситуация с ответами за юзера, в некоторых случаях происходит пиздеж за меня на половину респонса. Какой параметр отвечает за это и как ограничить эту возможность.

4. Что можно почитать для более детальной настройки моделей/персонажей, чтобы они не выпрыгивали из штанов после первого респонса.

Заранее спасибо за пояснения.

>А ну, да, только я его почему-то только в коболде видел, его разве нет в угабуге?

Должен быть, но я не пользуюсь. Кобольд стабильнее и удобнее. Кому нужны свежие сборки - есть лламаспп сервер. А в убе ллама особая, на айронпайтоне что ли. Надо бы попробовать для прикола.

Там есть тензоркор, дает больше прибавку к токенам, на порядок 1-2 т/с

>Минимагнум 12б на 4070

У меня мини магнум 12б, на 2060 9-7 т\с, как и почти любая 12б, ПРИ Q4_K_M\Q4_K_L. Смотри какой у тебя квант, наверное выбрал Q8_0

>Это значит нужно искать менее кривые карточки персонажей?

Да, есть такое, зависит от этого, пресеты и семплеры влияют еще, так что все в тандеме.

>Что можно почитать для более детальной настройки моделей/персонажей, чтобы они не выпрыгивали из штанов после первого респонса.

в общем рекомендация сводится к добавлению в чат темплейт чего-то вроде "развивай сюжет медленно". Но зачастую мелкие сетки слишком тупы, чтобы развить сюжет куда-то кроме очевидной ебли и выпрыгивания из штанов. Но ты попробуй оптимизировать инструкции.

>4070

нахуй ты это говно вообще брал?

>Там есть тензоркор, дает больше прибавку к токенам, на порядок 1-2 т/с

Если оно не просто так называется, то печаль - у теслы нет тензорных ядер... Но попробую.

>12 гигабайт - для него слишком много

Наоборот слишком мало, что бы запускать на ней 20b+ модели с более-менее терпимой скорости для RP

Пока что перебиваюсь на разновидностях модели Nemo-Mistral 12b и Magnum 12b v2

Хотя в своё время юзал на своём проце Ryzen 5600g Llama-3SOME-8B-v2b и был рад 2 токенам в секунду и обработке 512 контекста за 10 сек, но потом однажды попробовав на настоящей видеокарте позалипать в нейронки во мне проснулся пикрелейтед

У меня есть эти ядрышки, поэтому перешел с кобольда, на угабугу.

+ буги, она позволяет загрузить намного больше слоев/контекста без ошибки, чем кобольд. Тем не менее за все есть цена, то что ты загрузил сверх меры будет браться с озу.

Я хотел получить скорости, и на 7б кобольд - 20т/с, буга - 22т/с. Прибавка есть, но маленькая, может быть из-за моей rtx 2000.

>перешел с кобольда, на угабугу.

А есть смысл переходить?

>rtx 2000

почему не 3090? Тоже 2 гб, но найти можно за 55к. А твоя под сотку стоит.

24 гб

фикс

Я не на графики смотрю, это чисто субъективное мнение по итогам использования. Если сравнивать 4о с лламой 70b, то первый просто сливается в унитаз, как дешёвка.

>на каком он сейчас уровне.

Чисто по ощущениям, это что-то уровня 10-12b с прикрученным RAG. Оно ебать, как много знает, но чтобы выудить эти знания иногда даже наводящих вопросов недостаточно, ты уже должен знать о том, о чём ты спрашиваешь. Эта самая 4o крайне просто входит в петли, не может исправлять свои ошибки, не может на ходу переключиться на другую тему, не понимает сарказм, не понимает, когда ты просишь чего-то не делать, откровенно врёт, если чего-то не знает, и выдумывает на ходу. И да, лупы у 4о это непобедимая хуйня, он либо повторяет одно и то же, либо делает то же самое, даже если ты говоришь этого не делать.

Локалки в этом плане куда честнее, чтоли. Они знают меньше, но понимают гораздо больше.

ue,fue,f negj elj,ytt c nfdthyjq

Сейчас специально протестил у себя магнум 12b на 3060 12gb на kobold.ccp с уже наговоренным диалогом

CtxLimit:2766/8192, Amt:250/250, Init:0.05s, Process:2.73s (1.1ms/T = 922.63T/s), Generate:10.63s (42.5ms/T = 23.51T/s), Total:13.36s (18.71T/s)

Да, на Q8_0.

Сейчас запустил бенчмарк - всего 3.8 Т/с скорость генерации.

Я не знаю, я просто долго сидел на кобольде, и перешел на бугу.

У буги мне апи не нравиться, он пишет иначе чем кобольд.

Проверил по бенчу, у меня на коболде меньше чем у буги на 2т/с

) я имел ввиду серию, аля rtx 2000, rtx 3000, rtx 4000

Оно и понятно, ставь Q6_K или Q5_K_M

magnum-12b-v2-Q6_K_L если что

>нахуй ты это говно вообще брал?

Была неплохая возможность обновиться с рх580 за 48к. Ничего лучше на тот момент не было.

>А есть смысл переходить?

Есть смысл экспериментировать - 0,2т/с тут выиграл, 0,1 там - в сумме набегает...

Чувак, у тебя во время того как ты запускаешь эту модель - модель вся грузиться в видеопамять. Если во время запуска модели или её использования у тебя ещё запущены другие игры- приложения, даже ютюб - они занимают часть видеопамяти твоей карты и допустим вместо 12 гигов у тебя по факту оказывается 10,5 или вообще 8. Лично у меня встройка на проце и я всю отображаемую графику для моника через неё гоню (тупо оставил моник подключенным к материнской плате а не к видяхе) и моя видяха остаётся незадействованна для всякого мусора и может на все 100% отдаваться обработке генерации текста.

Вот прямо сейчас закрой прогу кобольд или на чём ты там генеришь и открой диспетчер задач. Перейди в раздел производительность и выдели свою видюху. Там ты увидишь сколько у тебя видеопамяти занято и сколько свободно. + учитывай что чем дольше общаешься с чат ботом тем больше памяти нужно будет для хранения в его памяти прошлых твоих сообщений. Контекст короче, который ты изначально выбираешь. У некоторых моделей только 8к а у других и 16к+ можно сделать. У магнума только 8к максимум ставь.

Ну, проще написать, на самом деле. =) Делов-то.

Ты опять забыл таблетки выпить? =( Чувак, ну ты не забрасывай свое здоровье…

Возьми LazyMix+ (Real Amateur Nudes) и накати NostalgiCam (18+) - Nude Webcam Girls + всякие селфи.

Памяти не хватит ни на что вообще, сразу дропай.

Для кодинга Deepseek-Coderl-V2-Lite, его можно крутить на проце, кстати.

Для кума — пиздуй в шапку, там охуенная подборка спецом для новичков. Чел старался.

> mini-magnum-12b-v1.1

Да.

> Q4_K_M

Нет.

Хотя бы Q6.

Работать будет, если подрубить че-то там, для работы наружу.

Хуйня, даже не тестируй такое говно. Не трать время.

Я сочувствую твоим страданиям. =) Зато ты приобрел опыт.

> по совету

> качает говно в третьем кванте

Чувак, послушай, то что они не влазят тебе в видеокарту не делает модели плохими. Это делает плохой твою видеокарту.

Качай не ниже Q6 (а лучше Q8) и выгружай на оперативу, иначе никак.

Или докупи вторую видяху.

Опа, нихуя себе.

ТОЧНО НЕ 4060.

Плюсую, сижу с вербоуз всегда.

Нет, скорее только через апи и можно.

Убабуга по умолчанию работает в режиме «Ты отыгрываешь персонажа, вот чат, напиши следующее сообщение:» это ролеплей, а не диалог, и ллм понимает, что она ролит с тобой.

А по апи зачастую диалоги хуярятся, там иной результат.

Значит косарь за кит, плюс опера, и видяхи. На райзерах, вероятно.

Ну, так-то, цена норм для тех, кто хочет дохуя, но не хватает на H100.

Новая база тре… кекеке.

Хорошечно, спасибо.

Ну, в теории ты можешь обращаться с пресонажам из убабуги через апи, но в общем, да, если не делаешь специально — настройки никак не влияют, только то, что ты даешь.

Твоя таблица ну полная хуйня.

Я не обвиняю тебя, просто очень жаль, что тебе сразу никто толком не объяснил, что ты трогаешь исключительно говно, почему-то.

Точнее, тебе говорили, но недостаточно резко.

ВЫКИНЬ

ДЕРЬМО

Качаешь гемму в 8 битах или мини-магнум в 6 битах МИНИМУМ, а лучше в 8.

И тестишь ТОЛЬКО ИХ И ТОЛЬКО ТАК.

Ну, на вкус и цвет, конечно, но все остальное будет давать хуевые результаты в любом случае. Я не знаю, что ты пытаешься выжать из такого ужаса.

И, да, у тебя будет медленно, хоть укакайся, либо будет тупо и криво, тут выбор за тобой.

Кобольд пихает свои префиллы в промпт, а если ты еще и галочки не снимал пихать адвенчуре промпт… =) То это эпик фейл.

Кобольд надо тонко настраивать и он все равно так себе.

Чисто для вката подходит.

Ну 9 прям говно на фоне дипсик кодера.

Если полторашка такое же говно — то… это уже достойно, конечно. =)

Кстати, как пихают такое оформление? Я видел уже где-то тут.

А быстрее-то схуя? О_о Но, интересно, попробую.

Я не он, но спасибо. =)

Переводчик в 2к24? Ловите наркомана!

Скилл ишью или бомж? Но если бомж, то да, переводчики, шо поделать.

Здесь. Гугл, кстати, в последнее время прям напоминает…

Аноны такие:

> Это смешная температура.

Потом:

> у меня умирает тесла, что делац =')

Но у того чела, вроде, 75 была от стаблы на постоянке.

О, 27б может быть клевой!

Надо потестить.

Жаль в 16 гигов не влезет, эх… Где там материнки с тремя слотами? х) Впихну все три P104-100, будет ультра-бомж сборка.

Не, баян, еще месяцы назад скидывали такое же.

> для жоры достаточно x1.

До первой обработки длинного контекста с двумя и более картами. =)

> Я экспериментально проверил как работает использование нескольких карт.

Ну ты хуйню проверил, братан.

Потестируй следующим образом.

Залей на одну видеокарту небольшую модель и прогони тест на контекст… Ну 60к контекста. Как быстро пережует.

Потом, залей эту же модель ровно на три карты (или сколько у тебя там), и на х1 линии залей тот же контекст.

Охуеешь от разницы.

Вот, не надо сейчас рваться жопой (я надеюсь, ты адекватный) и отказываться от тестов, чтобы не развалился твой манямирок.

Просто возьми и сделай эти тесты, и покажи, какая скорость обработки промпта в 1 видяхе, какая скорость в х16+х16 и какая скорость в х1+х1. Если ты прав, то разницы не будет. Но если разница будет…

Короче, влияние количества линий пренебрежительно мало на малых контекстах, а на больших возникают проблемы. Вот увидишь.

Там есть токенайзер каунт. Был раньше.

> подписку на гопоту

В локал треде.

Про кум в т.ч.

Гениально.

1. Там должно быть пару секунд.

2. Объем ответов зависит и от модели, и от карточки.

3. «Не отвечай за юзера».

https://huggingface.co/Quant-Cartel/mini-magnum-12b-v1.1-exl2-rpcal — возьми 6bpw и 8к контекста или 16к 8-битного контекста.

Вот тут плюсану, я отдельную видяху поставил под рабочий стол и прочее, чтобы игровую всегда держать свободной. Лишний гиг не лишний.

https://huggingface.co/Quant-Cartel/mini-magnum-12b-v1.1-exl2-rpcal

Дай ему нормальную ссылку, без эксламмы и на вторую версию.

Вот, держи. Это оптимальный вариант для 12 гигов видяхи и качества.

https://huggingface.co/bartowski/magnum-12b-v2-GGUF/blob/main/magnum-12b-v2-Q6_K_L.gguf

Если у него 4070, то нормальная ссылка — как раз эксллама. И работает чуть лучше, и чуть быстрее. И если вдруг вылезет на оперативу — вылетит к хуям. =D

Поэтому я ему и дал именно на экслламу. Чтобы он сравнил лучший вариант с текущим.

Но, q6_K_L тоже пойдет, думаю.

Выбор у него теперь есть из лучших вариантов под его видяху.

>Переводчик в 2к24? Ловите наркомана!

Может я и наркоман, но плюсов куча:

Токенов для eng-текста требуется меньше, понимание модели лучше. Примитивный стиль перевода Гугла для общения с моделью лучше в целом, имхо. Из недостатков - перевод иногда косячит, но при тексте от 300 токенов уже работает с контекстом и переводит верно, даже художественно.

>оперативу — вылетит к хуям.

Странно, ну это уже проблемы пользователей эксламмы, на кобольде такого нет.

Кстати, а что тогда произойдёт, когда он на этой эксламе упрётся в 8к контекста, учитывая что я слышал что каждый 1к контекст примерно занимает 1гиг видеопамяти и учитывая что сама модель весит около 10,4 гига? Или в эксламме эта модель весит меньше?

>Не, баян, еще месяцы назад скидывали такое же.

Последний раз видел бота AICG треда, но у него форматирование и оформление другое.

А как новая хуйня называется?

>просто добавил это в чара

А двачевское HTML-форматирование с аватаркой бота в посте и постами с ответами он тебе сам по рофлу написал?

> при тексте от 300 токенов уже работает с контекстом и переводит верно, даже художественно

Может у них там подключается другая модель перевода?

Это интересное замечание, я не обращал внимания.

Нет, это не проблема, а фича. =)

Это отключаемо, просто приятнее увидеть, что у тебя модель с контекстом не влазит, нежели сидеть на медленной скорости и думать, что «ну, 4070 не способна более чем на 6 токенов…»

Так что, это ггуфопроблемы, получается. =)

По поводу контекста. хз.

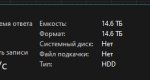

Вот три скина. Без модели. С моделью и 4К контекста. С моделью и 8к контекста.

Это Немо 6.4bpw.

Т.е., 4к контекста = 0,5 гб, я хз. =)

Контекст рабочий.

>хотелось бы конечно, но низзя, не раскидывается она, как минимум потому что не однопроходная......

Недавно Флюкс в GGUF-формате квантовали. Я ни на что не намекаю, но...

Не знаю, самому интересно. =)

*скрина

слоупокофикс

Нахуй так жить?

М-м-м, идейный опенсорсник, наверное и на такси не ездиш если машина проклятых капиталистов и без открытых исходников

если инструмент выполняет работу свою, то им пользуются, или прикажеш опенсорса ждать?

Ну так про гопоту я условно, можно и Ламму жирную арендовать и клавдию, вопрос же не в этом, вопрос в том, стоит ли покупка железа выхлопа от него?

ну иди нагенерируй в гопоте советов по знакомству с маленькими девочками или советов по ебле с уличными псами, я посмотрю как ты это сделаешь, клоун.

Выполняет у него блять работу. Соевая сетка с клеточкой на члене модели.

Та хватит со своим кумерским ролплеем сравнивать, да, никто не затачивает ЛЛМ под то чтобы вася сычев сидел дрочил в чатике,

может ты по уровню эрудированности их сравнивал? или по качеству перевода и умению обрабатывать документы текстовые? Или код генерит и ошибки в коде хорошо ищет?, может граматику проверяет?

такое чувство создается что тут одни кумеры РПшники сидят, и по другим критериям модели не тестятся вообще?

>никто не затачивает ЛЛМ под то чтобы вася сычев сидел дрочил в чатике,

Затачивают. Но не гопоту. И результаты хорошие. Но не с гопотой.

>такое чувство создается что тут одни кумеры РПшники сидят, и по другим критериям модели не тестятся вообще?

ты только это понял?

новичок в треде чтоли?

Бомжую, по факту. =(

А где еще торренты хранить, сериальчики, музычку, ух, все локальное, вдруг захочу пересмотреть или интернет отключат!.. =D

Вообще, немного наоборот, коммунизм против опенсорса, это капитализм за.

Так что, наверное на такси ездит, если хочет. Или не ездит, если не хочет. Или каршеринг. Как захочет. Лишь бы не принудительные автобусы. =D

В смысле, не затачивает? Файнтьюны — буквально затачивают, да.

Так что, все логично.

ну, поживем - увидим - точто там гуф не значит что разобъется нормально и будет работать....

1. Нужно купить сервер с 12 канальной ддр5. Дорого нахуй, но тогда даже 400+b модели можно включать.

>советов по знакомству с маленькими девочками

А тебе это зачем? Плюс нейросети выдадут баяны без задач.

>А где еще торренты хранить

На NAS, где же ещё.

А у тебя хороший нас. Что это за устройство и как собирал?

>ну иди нагенерируй в гопоте советов по знакомству с маленькими девочками или советов по ебле с уличными псами, я посмотрю как ты это сделаешь, клоун.

Ты серьезно? у тебя по жизни два интереса только? псы и девочки? походу надо кластер арендовать и накатить моделькуд для таких кумеров и на бабосы доить....

так по себе ровнять не стоит, другим надо для других задач ЛЛМ, при которых твоя соя не заметна от слова совсем

Ну да, но контекст был про коммерческие, ни гопота, ни гемини, ни клава, ни преплексити не заточены под это, более того, формат асистента более выгоден для большинства....

>ты только это понял?

Нет, но надеюсь все еще что есть применяющие на практике всеже ... или они все в треде гопоты сидят? отдельного то не кумерского треда нет...

>В смысле, не затачивает? Файнтьюны — буквально затачивают, да.

та едрить, там про гопоту разговор шел, и да, ни одна из официальной гопоты не заточена под это...

>Что это за устройство и как собирал?

Материнка на 2011-v3 и серверный корпус под 10 15 дисков. Про запас, там и половины гнёзд не занято.

Ещё там можно подрубить 3 видяхи по схеме 16+16+8, но у меня денег на это нет ((

>Ну да, но контекст был про коммерческие, ни гопота, ни гемини, ни клава, ни преплексити не заточены под это, более того, формат асистента более выгоден для большинства....

Ну следовательно если ты не большинство - собирай ГПУ-сервер или арендуй. Плохо, что всё это недёшево. Тяжело быть илитой :)

Малаца. Хорошо зделол.

>интернет отключат!

Спутниковая тарелка в сторону швитого маска + НАС

>Тяжело быть илитой :)

Жиза. Просто нет ни доступных железяк, ни нормальных сервисов.

>Нет, но надеюсь все еще что есть применяющие на практике всеже ... или они все в треде гопоты сидят? отдельного то не кумерского треда нет...

ну я использую для не кумерских задач, да. И для работы айти и просто проконсультироваться и поговорить.

Но было бы странно имея локальную ллм не кумить на ней. Если ты смог запустить 405б модель у себя под кроватью и не делаешь с ней порнорп - то у тебя точно что-то не в порядлке с головой.

Вот так и получается, что тут полный тред кумеров.

> Я не на графики смотрю, это чисто субъективное мнение по итогам использования. Если сравнивать 4о с лламой 70b, то первый просто сливается в унитаз, как дешёвка.

Ну и для чего ты их используешь?

>тарелка в сторону швитого маска

Он прогибается под требование властей, ты у него получишь тоже, что и по проводу то есть нихуя.

> NAS

Справедливо!

> та едрить, там про гопоту разговор шел

Не, чел, ты в треде локальных моделей, там диалог шел о том, что локальные модели превосходят гопоту в том, что заточены. ) Признай поражение, не сопротивляйся.

По факту же разъебали.

А о том, как она в других задачах — то она (вместе с клодом и джемини) все еще сота, но уже не так чтобы сильно.

В VL задачах Qwen2 дышит в лицо попой (API-шная обошла, если что, да), в программировании есть Deepseek-Coder (и вовсе фулл опенсорсный), в РИЗОНИНГЕ ЕСТЬ РЕФЛЕКШИН АХАХАХ, ну, то есть, Llama-3.1-405B, да и дипсик опять же, и Mistral-123b, всего хватает, что отстает от актуальной гопоты лишь чуть-чуть.

У корпоративных ллм плюсы — в артефактах/гптхах, доступе к вебу, доступе к твоей инфе. На локальных это надо костылить, а там уже закостылено до нас.

А если вернуться к началу вашего диалога… Почему платишь за локальные а не подписку? Паранойя и сенситив данные. В корпоративном секторе на это многим плевать (неожиданно, но факт), а вот в частном… так же, но в этом треде сидят те,к ому не плевать на приватность своих данных. Вот и предпочитают закупиться железом вместо подписки.

Такие дела.

Оу май, материнкой поделишься?

Я смотрю, на Z270 можно подключить x8+x8+x4, и стоит она 7к рублей на авито.

Но если есть вдвое больше, то почему бы и не да?

Кстати, лол, но сижу тут год и не кумлю. Ведь есть stable diffusion с лорами и flux…

>Оу май, материнкой поделишься?

Сасус x99-e, сейчас такие уже не продают, купил последнюю из завалявшихся на складе. Проц офк с алишки самый простой, стопка памяти оттуда же.

>на Z270

Так это же десктопное говно, там никогда не было кучи линий.

>Ведь есть stable diffusion

Текст даёт больше простора для воображения, плюс развитие сюжета, так что стояк на буквы больше, лол.

Обновил таверну - пропали аватарки у ботов и юзера.

Что за дела? Как вернуть?

Что за дела? Как вернуть?

> Линий там достаточно, 40 штук же

А какая конфигурация слотов и что за процы?

> А вот одна плашка это конечно лол.

Не, вотэт пиздец.

> что каждый 1к контекст примерно занимает 1гиг видеопамяти

Даже в богомерзком жоре это подебили добавлением флешатеншн спустя долгое время. Но в целом - эксллама почти не повышает расход врам относительно выделенного в начале, так что вылет крайне маловероятен. Жора же по ходу заполнения контекста наращивает аппетиты, и именно там будешь радоваться оому во время горячего кума.

В чем проблема? Непревзойденные объемы, ахуительная надежность и отсутствие внезапных смертей, скорость выше чем днище qlc, низкая цена. Пикрел еще мелочь.

> никто не затачивает ЛЛМ под то чтобы вася сычев сидел дрочил в чатике

Всмысле, а как же десятки шизомерджеров, которые с использованием методов средневековых алхимиков пытаются синтезировать золото? А сейчас даже пулл нормальных тюнеров набрался.

> На NAS

Скорость доступа не та.

а если большинство то можно не собирать?

>а если большинство то можно не собирать?

Можно. Разрешаю.

>у себя под кроватью и не делаешь с ней порнорп

предпочитаю такой рп с тянучкой на кровати) (не, серьезно, даж завидую немного что у народа времени столько есть чтобы тупо с нейронкой общаться...)

>И для работы айти и просто проконсультироваться и поговорить

это поинтересней уже, какие сетки в каких задачах себя проявили хорошо?

>В чем проблема?

Шум же, и скорость улитки.

>отсутствие внезапных смертей

Ты это говоришь тому, кто похоронил уже 3 жесткача, 2 из них ВНЕЗАПНО.

>Скорость доступа не та.

Если гигабита мало, тянешь 2,5/10/40 гигабит и довольно урчишь.

>рп с тянучкой на кровати

Пиздец с каким отребьем я сижу на одной борде.

>Пиздец с каким отребьем я сижу на одной борде.

база. Нормисы уже из б в тематику протекли блять...

> Шум же

Только для шизиков.

> скорость улитки

Не настолько плохо и с учетом остальных плюсов это не проблема.

> кто похоронил уже 3 жесткача, 2 из них ВНЕЗАПНО

Какой-то ультимейт скиллишью, даже с погорельца можно восстановить данные, пусть и сложно. Зато с ссд - нахуй иди просто, оно помирает внезапно и сразу без каких либо признаков, тогда как хард будет до последнего пердеть, страдать но терпеть. Где-то валяется пачка дохлятины, за все время доверия к ним так и нет, никаких важных данных нельзя оставить без регулярного бекапа.

> тянешь 2,5/10/40 гигабит

Куда ты их протянешь, нужно соответствующее железо, что будет стоить неадекват и/или потребует времени и пердолинга. И всеравно всратый протокол не способен обеспечить нормального времени доступа, тогда как на локальном харде проблем нет.

> Пиздец с каким отребьем я сижу на одной борде.

Это моя фраза в твою сторону.

>там диалог шел о том, что локальные модели превосходят гопоту в том, что заточены.

там диалог шел о том что гопота в кумерство не может, но то такое,

>но в этом треде сидят те,к ому не плевать на приватность своих данных. Вот и предпочитают закупиться железом вместо подписки.

Не, ну тут без спорно, а то узнает еще кто, что славик сычев правой дрочит, левой жопу щекочет... прикольно так-то что вообще как раз корпоратам должно быть не плевать на приватность данных, но там и возможности локалки крутить есть... просто интересен вопрос аналитический скажем - сколько переплачиваеш или наоборот выигрываеш в сравнении используя локалки а не коммерцию, и выгоднее ли свое железо, или арендовать

лама 405 жжет конечно...

>Classic tongue-twister!

The answer, of course, is "a woodchuck would chuck as much wood as a woodchuck could chuck if a woodchuck could chuck wood!"

But, just for fun, let's try to estimate a real answer. Woodchucks, also known as groundhogs, are rodents that burrow in the ground and move earth as part of their habitat creation. They are quite strong for their size, and can move a significant amount of soil relative to their body weight.

If we assume a woodchuck could chuck wood with the same efficiency as they burrow soil, we might estimate that they could move a volume of wood equal to the volume of soil they can excavate.

According to a study on groundhog burrowing behavior, a single groundhog can excavate up to 700 pounds (318 kg) of soil in a day. If we convert this to a volume of wood, assuming a density of dry firewood to be around 35-40 pounds per cubic foot (560-640 kg/m³), we could estimate that a woodchuck could potentially move around 1-2 cubic feet (28-57 liters) of wood per day.

So, to answer the tongue-twister in a completely unscientific and humorous way: a woodchuck would chuck about 1-2 cubic feet of wood if a woodchuck could chuck wood!

>Какой-то ультимейт скиллишью

Просто много дисков и много времени плюс удача с двумя ST3000DM001, погугли артикул.

>даже с погорельца можно восстановить данные

Абсолютно нереентабельно, по почке продать за каждый мегабайт. Я лучше в бекапы.

>тогда как хард будет до последнего пердеть

Ну вот у меня не пердели, в один момент перестали данные отдавать и всё.

>нужно соответствующее железо, что будет стоить неадекват

Бу серверного говна навалом, и с нормальными протоколами под SMB оно будет летать неотличимо от локального. А шум где-то далеко.

>Скорость доступа не та.

сколько тебе скорости надо то? 40гбит кинь сеть, хватит же?

>Шум же, и скорость улитки.

Что у вас за винты что вы их слышите? последний который помню из прям слышных это был 4 гиговый из 90х, от еще с таким звонким звуком скрежетал....

или у вас охлады сверх бесшумные? в пеке я вообще не слышу диска, в NAS похрустывают малость, но тоже не критично, охлад опять таки громче...

>Пиздец с каким отребьем я сижу на одной борде.

а тут филиал инцелача и нормисы не приветствуются?

ладно придется кумерить целыми днями в таверне...

Тихий комп и вообще окружение, 2 диска слышно когда работают

Но прикол в том что ссд так же слышно, иногда при полной загрузке тихонько свистят падлы. Чем? Не ебу

Минусы хорошего слуха и низкого звукового загрязнения

https://www.reddit.com/r/LocalLLaMA/comments/1fg5fmz/polyglot_100_private_translations_on_chrome/

Вот это прикольно, хочу. Вобще хочу больше плагинов для работы в браузерах с локальными сетками

Будет медленно, но все равно интересно

Вот это прикольно, хочу. Вобще хочу больше плагинов для работы в браузерах с локальными сетками

Будет медленно, но все равно интересно

Зависит от ожидаемого срока использования, не? Если ты покупаешь условную теслу и планируешь её заменять на что-то более современное примерно никогда, то тебе достаточно прожить плюс-минус год, чтобы покупка стала выгоднее аренды. А если берёшь 4090 и собираешься её заменять на 5090 сразу с релизом, то лучше не покупать обе и влошиться в аренду. И я здесь даже не учитываю наркоманские ситуации, когда можно купить теслу за 15к и через год продать за 20.

>Ну и для чего ты их используешь?

Да для всего. Понятное дело, что гопота для кума не использовалась, но всё остальное - вполне себе. Чатбот, кодинг, обсуждение разной хуйни. В итоге гопота меня на кодинге и доебала, она регулярно уходит в лупы и пишет тот же код, даже если функции она нагаллюцинировала - извиняется, соглашается, что таких функций нет. И снова их использует.

> Абсолютно нереентабельно

Подобное в совсем печальных случаях и если данные вялые. А так по дефолту хватает подмахнуть плату (и перепаять eeprom при необходимости), механические же дефекты прогнозируемые и плавные, всегда успеешь заметить и принять меры. Классика "вот у меня" имеет сомнительную релевантность, погугли тренды и статистику.

> Бу серверного говна навалом

Обмазываться этим добром, тем более дома - довольно сомнительное действо, и всеравно оно будет всратым, что там за "нормальные протоколы"?

> Тихий комп

Отдельный вид шизы и расстройств невростеников, под нагрузкой оно будет шуметь априори, в холостую шум не будет заметным. Тут дело не в слухе.

>а тут филиал инцелача и нормисы не приветствуются?

Ну в общем то да. И вообще, зачем имеющим тянку нейросети? Они просто не прозрели ещё. Хотя некоторые живут всю жизнь, не приходя в сознание, лол, и содержат несколько баб с детьми.

А кто прозрел, те понимают, что нейросетки, даже сейчас, во всём лучше мясных дырок.

>и пишет тот же код

Замечал на последних снапшотах, старая умнее была.

>что нейросетки, даже сейчас, во всём лучше мясных дырок.

та блин, хавать не готовят хату не убирают... дороговаты пока что короче роботы-гуманоиды... хотел робособаку прикупить от Унитри, но тоже дорого...

>погугли тренды и статистику

Тренды как раз показывают, что механика отлетает всё чаще, а сосоди достаточно надёжны при домашнем использовании.

>что там за "нормальные протоколы"?

InfiniBand вестимо, задержек меньше, и самба умеет по нему работать.

>Отдельный вид шизы и расстройств невростеников

Вполне себе нормальное желание иметь тихий ПК. И да, дело именно в слухе, у меня мама нихуя не слышит, и 144 герца 4к монитора не видит. А мне прям критично.

>хавать не готовят хату не убирают...

К мамке вернись, всё было в комплекте, при хороших отношениях с ней будет лучше любой другой родной дырки. И любит по настоящему а спускать лучше в кулачок под нежный сгенерированный голос.

>дороговаты пока что короче роботы-гуманоиды

Пока да. Но скоро будет в каждом доме.

>Что у вас за винты что вы их слышите? последний который помню из прям слышных это был 4 гиговый из 90х, от еще с таким звонким звуком скрежетал....

Ага, а потом механику отладили и винты стали тихими. Старые и сейчас тихие, какие живы. А вот новые делают на отъебись и там уже жопа. Именно поэтому я лично перешёл на ссд.

Your selected API doesn't support the tokenization endpoint. Using estimated counts.

Что это за ошибка в Таверне? Кобальд после нее падает.

Что это за ошибка в Таверне? Кобальд после нее падает.

>Пока да. Но скоро будет в каждом доме.

Скоро. Как раз те аноны, которым здесь и сейчас нет и двадцати к старости успеют попользоваться. Кашку сварить, задницу вытереть - в государственных богадельнях.

Выбери в таверне внутреннюю токенизацию. Или обнови кобольд, вдруг старый. Или скажи, на какой модели ты наблюдаешь эту хуйню, ибо у меня такого никогда не было.

Кобольд последней 1.74 (но было на всех версиях), модель Magnum 12b 2.5 kto, но опять же ошибка была всех моделях, если перебирать ботов в таверне.

А, точно. Какое апи выбрано? Должно быть пикрил.

>не будет заметным

Отдельная шиза читать жопой и считать всех дураками

У меня тут ночью тишина такая что я пердеж мухи из соседней комнаты слышу, а хорошо спать с включеным компом не могу, внимание на себе удерживает, паскуда

Собрал тихий комп, но и в простое его слышу все равно если чет на ночь оставлять там на вроде торрентов

Печаль беда

>Собрал тихий комп, но и в простое его слышу все равно если чет на ночь оставлять там на вроде торрентов

>Печаль беда

Ну, пришло время собирать NAS. Я этим путём уже прошёл, пока остановился на этом шаге, даже интересно, что будет дальше. ин4б познаю дзен и сотру всю инфу нахуй, потом уйду в тайгу пасти овец.

Можно упороться и собрать комп с полностью пассивным или полу пассивным охладом и качественными не свестящими ссдшниками

Будет полностью тихо до средней нагрузки, но слабовато и дорого. Но если хочется тишины любой ценой - это вариант

Нас - не хочу становится сисадмином и ебаться уже с 2 компами, но вариант

> что механика отлетает всё чаще

Делая это плавно, прогнозируемо и громко вопя о проблемах, тогда как ссд - мгновенная смерть и в очень редких случаях обнаружение проблемы и блокировка записи.

> дело именно в слухе

Не, дело именно в невростении и расстройствах, причем оно может быть и как с йоба слухом, так и вообще без него. Со музыкальными навыками, способностью слышать/различать и тем более зрением никак не коррелирует, это что-то уровня "раздражает микроузор обоев что висят где-то позади". Не то чтобы осуждаю, каждый дрочит как хочеть, но нужно осознавать уровень.

> хорошо спать с включеным компом не могу

Это нормально если там реальный шум, но когда "пердеж мухи" и такое - это диагноз, буквально. нахуя вообще спать в одной комнате с компом? И каково это жить без кондиционера? Страдай с берушами, обмазывайся noise machine, или покупай оверпрайс продукты с пренебрежимой разницей для дойки бедолаг.

> комп с полностью пассивным или полу пассивным охладом

Во, апофеоз безумия.

>не хочу становится сисадмином и ебаться уже с 2 компами

Настроил и забыл. Первое время ещё заглядывал в панельку, сейчас же зашёл туда впервые за полгода (диски пока ещё в порядке).

>громко вопя о проблемах

В лужу пердя разве что. Пока в логи не заглянешь или в смарт не посмотришь- хуй узнаешь.

>диагноз, буквально

Кек, я думал диванные психоаналитики уже вымерли лет 10 назад

Я могу спать с неоднородным шумом, дождь - балдеж

Но упорядоченный шум мозги не игнорят а активно отслеживают. И это прям нормально, инстинкты помнят хищников в соседнем кусте.

Но мешает когда эта хуйня триггерится на ерунду, на вроде активности дисков или однородного шума крутиляторов

Завдуую тем кто спит в любых условиях

>хорошо спать с включеным компом не могу

Cплю в наушниках под документалки про маньяков или аудиокниги Г. Ф. Лавкрафта. И это просто охуенно. Правда, наушники быстро разваливаются, но это похуй.

Монотонный шум очень мне мешает, поэтому я не понимаю как люди спят с включенным пк в одной комнате. Однако, с тем же самым я спокойно могу уснуть слушая - мело/техникал/брутал дет и прочую музыку, хуй поймешь мозг.

та вопрос в объемах, 8, 16 тб в виде ссд дорого очень будет, а винты для НАСов вполне надежные, на них не так экономят...

М... Макс?

Л... Лёха?

так а кто тебе мешает настроить уведомление о проблемах с диском? более того, нормлаьные раид контроллеры диск который начинает сбоить из массивы выкидывают и начинают на резервный восстанавливать, но для этого диски конечно правильные нужны...

>нормлаьные раид контроллеры

Я на мержФС сижу, поверх юзерспейсового NTFS в люнупсе...

Что ты такое? зачем ты такие странные штуки юзаеш?

есть же православный MD, LVM, ZFS, BTRFS, последние две предпочтительней, если мы уж про програмные райды говорим, есть хардверные райд контроллеры которые с процессора нагрузку снимают по подсчету контрольных сумм, но то уже сильно гиковское, но зачем НТФС под линупсом? она ж капец дибильная...

Выше по треду ловили каких-то наркоманов-переводчиков, но у этого анона явно что-то более забористое.

я вообще хз где люди такое назодят вообще? сколько уже толкусь с серверами, но про такую дичь не слышал даже, и оно походу капец странное, посыплется так не факт что вообще восстановиш чем-то... на популярные штуки хоть инструментарий есть...

Накопал я короче инструментов для тренировок, походу калькулятор трохи трындел... бо диспетчер задач показывает что шаред мемори используется - тобиш 410М полностью не влазит в 8гб, хотя... кто знает, может что-то не нужное выгрузилось... около 3 сек/итерацию молотит...

теперь назревает вопрос по подготовке датасетов - обучение идет исключительно супервайзед? и надо датасет в виде вопрос-ответ? или есть возможность просто текстами накормить модельку?

и еще вопрос - Токенайзер, он настроенный заранее идет и во время тренировок не меняется? или он тоже тренируется? просто выходит фигня в том, что токенайзеры в основном на инглиш ориентированы, то явно не очень хорошо, если только с кириликом работать...

и как к стати понимать прогресс тренировок? лосс как-то падает не охотно...

теперь назревает вопрос по подготовке датасетов - обучение идет исключительно супервайзед? и надо датасет в виде вопрос-ответ? или есть возможность просто текстами накормить модельку?

и еще вопрос - Токенайзер, он настроенный заранее идет и во время тренировок не меняется? или он тоже тренируется? просто выходит фигня в том, что токенайзеры в основном на инглиш ориентированы, то явно не очень хорошо, если только с кириликом работать...

и как к стати понимать прогресс тренировок? лосс как-то падает не охотно...

>зачем ты такие странные штуки юзаеш?

Да ёбт, говорю же, эволюция. У меня уже было 4 диска в винде, самой собой на NTFS, и я не стал переделывать всё это говно под BTRFS, которая конечно мне мила, но всё равно не доверяю, наебнёт все данные и глазом не моргнёт.

Знаю что упорото, но оно работает.

>посыплется так не факт что вообще восстановиш чем

МержФС это тупо раскидывание папок по дискам и их виртуальное объединение, там нечему сыпаться, по факту у меня самые восстанавливаемые диски, ибо там старая добрая NTFS, и диски могут работать по отдельности как будто и не было никакого мержа.

>тобиш 410М полностью не влазит в 8гб

Попробуй меньше, начни с сотки и наращивай. Если будет переломный момент, где скорость прям сильно просядет, значит переполнение.

>3 сек/итерацию

Лол, при обучении меньше ляма итераций вообще ни о чём, вот и считай, сколько это займёт у тебя времени.

> или есть возможность просто текстами накормить модельку?

Я только так и делал.

>и еще вопрос - Токенайзер

Как хочешь. Можешь отдельный обучить, поиграться с предварительным разбиением, к примеру. По коду там всё видно, что происходит.

>и как к стати понимать прогресс тренировок?

Индивидуально, лол. В каждом конкретном случае и комбинации настроек свои темпы падения лоса. Так что запускай саму модель и проверяй, что она высирает. Ты же разбил датасет на трейн, валидейт и тест?

>около 3 сек/итерацию молотит...

Пиздец, как медленно.

>Токенайзер, он настроенный заранее идет и во время тренировок не меняется?

Если файнтюн, то токенизатор лучше не трогать. Лора - трогать категорически не стоит. Кроме использования заранее резервированных тегов, их можно донастроить. Если трейн с нуля, то токенизатор можно натренировать. Настрой претокенизацию, т.к без претокенизации будет суперхуёво. BPE вордпис тренится плохо, очень плохо. А другие тебе и не нужны, скорее всего.

я через ЛЛамаФактори пока треню, оно само занимается разбиванием датасета, итд,

С сотки - хорошо сказанно - я ж существующую файнтюню, хотя, надо подумать, может рили можно с нуля бахнуть, и нормальный токенайзер сделать на кирилик языки, по идее это должно лучше перфоманс дать... материалов количество чет к нолю близится по обучениям полным, все про лоры в основном чет...

больше ляма это с нуля если учить или файнтюн? лол в конфиге по умолчанию вообще лимит на 1000 итераций стоял...

С файнтюном не работал если что.

>больше ляма это с нуля если учить или файнтюн

С нуля офк. Хотя наверное зря я тебе про тренировку базовой задвигаю- на это у тебя железа всё равно не хватит.

>410М

Нахуя тренить такую мелочь? Это даже не 1.5B, это что-то совсем за гранью. Только чисто ради опыта может быть, потому что смысла от такой модели ровно ноль.

Признание, правильно.

> Но упорядоченный шум мозги не игнорят а активно отслеживают.

Шум нормальных кулеров едва различим и не отличается от дождя, если они не громкие. Пиздецом может быть наличие резонансов и частое слышимое изменение их скорости вращения, вот это будет вымораживать но скиллишью.

Ебааааать, снимаю шляпу, делись дурью

> обучение идет исключительно супервайзед? и надо датасет в виде вопрос-ответ? или есть возможность просто текстами накормить модельку?

Да. Все зависит от твоих скриптов тренировки и отличия будут только в применяемых масках и желаемом методе.

> если только с кириликом работать

> 410М

Какой самоуверенный господин.

ну, если до 300М снизить то выгрузки не должно бы быть по идее, может шустрее будет...

ну, пока-может и не хватает, но если надо можно ж и в аренду взять 48 гиговых, за 1$/час, если перспектива проекта обозримой будет, а можно и спонсора поискать, под академик ресерч иногда можно достать...

Есть еще про версия колаба, если не так много надо ресурсов,

>Какой самоуверенный господин.

в чем принципиальная разница? в том что в класик модельках токенайзер в кирилик не обучен нормально? собственно для ответов на тупые вопросы со списка больше поллярда выделять как-то не кошерно...

ну сорян, кластера для 70В не имею, и в ближайшее время не разживусь...

Обучить ллм - сложно. Обучить ллм с базы - сильно проще. Обучить ллм с базы тому что оно вообще очень плохо знает - сложно. Мелкие модели сами по себе обучаются так себе, русского они не знают и обучение ему само по себе сложная задача.

Если все это сложить - будет ответ. Ничего плохого в этом нет, просто будь готов к неудаче.

та я какбы к удаче и не был готов, меня порадовало что моделька вообще что-то из обучающего набора запомнила, и хоть иногда выдавала связный текст... но походу копну на тему того, как с ноля обучать, мне почему-то кажется что правильный токенайзер залог лучшей обучаемости? или всеже нет? (но ведь в основном ЛЛМ более прожорливы по токенам на русском? а меньше токенов меньше возможностей налажать... но это так, рассуждения...)

>но ведь в основном ЛЛМ более прожорливы по токенам на русском?

Сама суть и структура токенизации говно, просто на русском это более заметно.

Cмотри, какая хуйня, у тебя дефолтный токенизатор, допустим, совсем не может в русский. И будет кодировать один токен - одна буква. Здесь сразу два хуя в сраку. Первый, это модели сложнее выстраивать логические цепочки и взаимосвязи между токенами. То есть твоё количество параметров как бы "снижается". И второй, страдает скорость обучения, т.к за раз в модель посылается фиксированное количество токенов, это мало текста, меньше текста - меньше текста. Трейн идёт дольше.

Вот бы придумал какой-нить новый принцип этого говнища, чтобы можно было 100В на 12 бомжегигах запускать.

Скорее мы получим мелкие модели которые будут перформить как текущие сотки. Ну либо нам начнут впаривать видеопамять отдельными платами. На какой нибудь ахуенно мудреный алгоритм сжатия разжатия для запуска больших моделей на днищекартах я бы не рассчитывал.

значит рассужда правильно, и токенайзер сразу надо на русик учить, чтобы словами кидал, а не буквами...

принципа кардинально нового не будет, потому, что впихнуть невпихуемое нельзя... может придумают как еще оптимизировать и заквантовать чтоб меньше потери были и пустого не считать, но...

тут тоже интересный момент, где предел мелкости, по сути теряя в параметрах мы теряем в эрудированности модели как минимум, та и сообразительности тоже.

По поводу Врама планками отдельными - тут не в враме вопрос собственно, вопрос скорее в тензорных процессорах доступных, сверх дорогой ХренDDR7 не нужон, просто сейчас видяхи по сути самые доступные универсальные решения для такого дела, но, так-то при правильной архитектуре 100500ядер и лютый многоканал памяти дадут возможность даже на DDR3 каком-нибудь выдать хорошую скорость... (хм, интересно, кто-то пробовал уже TPU на ПЛИСах делать и смотреть что с этого выйдет)

(интересно кста, я выше приводил пример ответа 405В ламы на "How much wood would a woodchuck chuck if a woodchuck could chuck wood?", кому нечего делать и есть возможность погонять относительно толстые модельки, чекните, будут попытки в рассуждение и ответ, окромя того что это скороговорка?

Хуйня какая-то

Почему не получается загрузить эту модель в textgen? Только вкатываюсь, ничего не гуглится толком.

Почему не получается загрузить эту модель в textgen? Только вкатываюсь, ничего не гуглится толком.

на всякий случай попробуй таверну. Угабуга на жоре часто модели прогрузить не может, потому что убабуга кривое говно.

О, наконец-то анон решил не проперживать воздух шизотеориями, а сразу взяться за дело, уважаемо!

Делись кодом и результатами, если будет получаться. Я тоже хочу заняться такой хуйней, или тренить с нуля что-то уровня 100М ради опыта, или из идей очевидно зафайнтюнить готовую модель на всем пикабу или дваче, или и то и то вместе. Под пикабу есть готовый датасет, но старый, под двач надо самому архивач парсить.

>теперь назревает вопрос по подготовке датасетов - обучение идет исключительно супервайзед?

Что ты тренишь? Если с нуля, то просто кормишь текстами, под конец закидываешь самые качественные, потом файнтюн инструкциями 5%, потом на DPO отфильтровываются говноответы.

>Токенайзер, он настроенный заранее идет и во время тренировок не меняется?

Токенайзер или берется готовый, или делается на твоем датасете простым алгоритмом. Во время обучения он не меняется, максимум может быть можно вводить новые токены под разметку формата.

> и как к стати понимать прогресс тренировок? лосс как-то падает не охотно...

На 8 гигах, удивительно, что ты вообще видишь как он падает, по моему даже 100М с нуля обучается на H100 ~сутки.

>ну сорян, кластера для 70В не имею, и в ближайшее время не разживусь...

Посмотри в строну аренды видеокарт или абуза гугл колаба.

И еще, если ты с нуля тренишь, то твоя модель будет лучше всего работать, если ты kv матрицы в одну или две на стой объединишь, так сейчас на всех новых мелких моделях делают.

>TPU на ПЛИСах

А какая там скорость памяти на плисах? По моему там уровень позапрошлого поколения процов, при стоимости одной плисины как готовой H100.

>по сути теряя в параметрах мы теряем в эрудированности модели как минимум, та и сообразительности тоже.

Нынешние мелкие модели на 2-4 лярда уже приближаются к народным 7-12B по производительности. Не во всех ситуациях конечно и не во всех задачах, но если сравнивать с прошлым годом, то скачок ощутимый. Раньше всё что ниже 13B считалось тупым и неюзабельым, непригодным даже для еби-меня-еби кума, не говоря уже о других сферах. А сегодня уже точно понятно, что количество параметров мало влияет на сообразительность.

>тут не в враме вопрос собственно, вопрос скорее в тензорных процессорах

Я не технолог, мозгов у меня мизер. Но в чем проблема выпустить плату чисто с видеопамятью и контроллером, например? Стоит у тебя какая-нибудь днищенская 4060, которая будет проводить часть вычислений, а к ней в пару ты прикупил елду на каких нибудь 32 гигабайта. И теперь у тебя не смешные 8, а целых 40 кило. Сиди гоняй себе какого нибудь командора и радуйся. На сам дорогущий чип тратиться не надо, на охлаждение тратиться не надо, плюс жрать это будет копейки даже в сравнении с какой-нибудь паленой теслой.

> мелкие модели которые будут перформить как текущие сотки

Хотелось бы, но всему есть предел, сравниться с большими оно сможет только с ограниченной области задач под которую заточен.

В интерфейсе не пишет про то что нужно скачать токенайзер и не дает инструкцию как это сделать?

Надо huggingface пробовать вместо них, вот там говорят все модели загружаются.

орублять

> какая там скорость памяти на плисах