>нейросеть "декодировала" строку, которая и так есть в интернете по данным, которые позволяют это сделать

Лол, а я сначала подумал, что это как кустар, которая ломала 192 битный AES. А это скучное говно.

Блядь после пробы нейронки, появилось стойкое ощущение, что всё вокруг пишут нейронки, статьи, комментарии к ним.

Велком ту мёртвый интернет.

Пиздос. Вот даже здесь показалось: https://vc.ru/services/1267309-google-vypustila-gemma-2-s-9-i-27-milliardami-parametrov

Но нахуя на техническом ресурсе это и по такой узкоспециализированной теме.

>на техническом ресурсе

>vc.ru

Шиз, лечись.

Мнение бота не интересует.

Извините, что я вас расстроил. Давайте вернёмся в более конструктивное русло 😊

Давай. 😊 Каким образом файнтюнеры расценз-урируют gguf-ы? Ведь у них не может быть тех же аппаратных возможностей как у гугла какого-нибудь или ценз-ура регулируется какими-то параметрами? Это не может сломать модель?

>Каким образом файнтюнеры расценз-урируют gguf-ы?

Анцензят не гуфы, а оригинальные веса. И да, алгоритм алиберейта не то чтобы слишком сложный, и требует лишь чуть больше ресурсов, чем на просто запуск.

>или ценз-ура регулируется какими-то параметрами

Нет, но да. То есть при тренировке соей модель сама всю сою сливает в небольшое число весов, ибо экономия. А алиберейт просто находит и обнуляет (лол, термин теперь многозначный) такие веса.

>то не может сломать модель?

Может и ломает. Но всё ещё лучше, чем сферический фантюн.

>>827742

Угараешь?

При таких размерах… размер — уже не главное. =)

На 3600 МГц у меня 123b генерит 0,6 токена (а с промптом выходит тотал 0,4).

Чтобы получить 6 из 0,6 тебе надо в 10 раз поднять скорость.

Если частота в полтора раза выше — то вместо 2 каналов тебе нужно 12 каналов…

Если есть материнка — то вперед.

123 крутая. =)

>>827751

Ну, 6600 у тебя и даст… в районе 1 генерации. =)

>>827753

Ну, ваще, на 4_К_С хватит. Скок там, 70-80 гигов и 6-8 на систему.

>>827802

Более соевая, но на русским лучше болтает.

Ну, со-со, пока хз, не уверен в полезности.

А 70б вроде как с квеном сравнялась, так что… для рп магнум все еще лучше.

А 405б нахуй не всралась. 1%-2% прироста за х5,5 размер.

>>827882

Ну, кстати, Немо — огнище.

Да и гемма будет получше, кмк.

>>827900

Для людей с 8 гигами видяхами, 8б и 12б — это разные размеры. =) Так что я бы лучше гемму для 8-гиговых челов привел в пример.

А.

Ну я так и сделал.

>>827905

3.0 хуйня, ну то есть, даже хуже мистрали, кмк. Сузума кое-как, получше мистрали, айа заметно лучше.

>>828014

Так никому нахуй не нужны based версии, лол.

it — инстракт. Бартовски только ее и квантовал.

Сквантуй сам, тащемта.

>>828027

Сломал, у меня хуярит до 4к не напрягаясь, больше не просил.

>>828039

Ну, типа.

>>828045

Оригинальная.

>>828052

Нет, одинаковая архитектура ≠ одинаковая модель.

Это полностью оригинальная модель со своим датасетом.

Разные инструкции, разные токены, разное все, кроме архитектуры.

Пойми правильно, ллама — это вполне конкретная модель, которая может дообучаться — и тогда это будет ллама со свистоперделками. Если же берется чисто архитектура и делается новая модель — то это уже совсем другая модель.

Примеры «той же модели» — Т-лайт от Т-банка. Это ллама-3.0.

А твое «ничего подобного и близко не было» — полная хуйня и незнание истории. Были те же gpt-2, всякие пигмаллионы (которые тут некоторые до сих пор нежно любят) и так далее.

В конечном счете, это все трансформеры.

Ллама привнесла в опенсорс формирование датасетов, методы обучения, набор параметров, и хороший результат.

Это как инструкция для пользования печкой.

Но когда ты сделал суп, а твой друг сделал жареную картошку — картошка не становится сортом супа, окда?

Я хз как еще очевиднее объяснить.

И, да, на старте многие думали, что мистраль — это именно файнтьюн Лламы, но оказалось, что нет.

>>828059

Для 12 гигов и 8к контексте — 6.4 бпв.

>>828060

Скилл ишью, где-то накосячил, там русский точно не хуже.

>>828081

Никогда не встречал за последние месяцев 8 такой хуйни, если честно.

Ни на одном из компов.

Везде обрабатывается чисто генерация при свайпе.

>>828085

Предполагаю, что какая-то проблема? У меня такое вот было последний раз осенью. С тех пор именно так и работает — сразу генерация.

>>828087

С моделью вообще никак.

Я редко использовал, но по ощущениям 8-битный не сильно.

4-битный не стал бы.

>>828094

Ну, у тебя не хватит, у меня хватит.

Модели есть, но нам их не дали.

Хамелеон был, но без картиночного модуля, пососали.

>>828096

Пздц багует люто.

>>828097

На инглише? Ты угораешь?

На русском адекватно говорит не то что Phi-mini 3.8b, а даже Qwen2-1.5B старается.

На английском я даже хз, какие там проблемы можно найти.

Ну, попробуй Qwen2-1.5b и 0.5b. Не знаю, не проверял на инглише.

>>828099

Во-первых, не одновременно, а последовательно.

Во-вторых, не охуеет.

В-третьих, озу вообще не приделах, все в видеопамяти. Если кэшируется в оперативу — то помянем производительность, такое неюзабельно, канеш.

>>828101

Нихуя вы упоротый, сэр.

Там в 4 можно уложиться, и оператива я хз.

Вот щас запустил именно простую SD1.5 DPM++ 2M SDE Karras 25 steps — 3 гига видеопамяти в пике и 2,5 гига оперативы.

У вас 2-гиговых моделей не завезли в жизнь?

Плюс, есть minisd для извращенцев, которые 256256 генерят.

Какие нахуй 64 гига оперативы ради 2,5!

Ну и, да, иметь вторую видяху и 64 гига оперативы — в принципе хорошо и стоит.

Но в 12-гиговую видяху (привет, 3060), влезет SD+LLM уровня 7-8-9 б. И будет работать. Даже быстро.

Mistral Nemo для 16 гигов бери.

Ну или, вон, посоветовали Гемму, можно затраить.

Терпимо.

Видяха 12 гигов? Тогда на проц похуй, в принципе.

Ну там если квен2-7б и кэш квантовать… Может влезет.

Слои на оперативе — замедляет. Контекст на оперативе — замедляет.

ИМХО, лучше в видяхе стараться уместить.

Если ты инференсишь БЕЗ видяхи, на проце (ну или выгружаешь лишь часть слоев) — то для обработки контекста CPU, а для генерации — пропускная способность RAM критична.

Минимума нет, но DDR5 будет лучше, естественно.

Ну, 70-80. =)

А если у человека 6? :)

Не страдай хуйней, умоляю!

16к контекста в 8-битах на Немо в 6.4бпв влазит в 11,4 гига.

Если мало 16к контекста — тады выгружай, канеш… Но я не уверен.

Да, как и Хамелеон. Видишь хамелеона? И я не вижу. А они мультимодальные. =D

Соси писос, прости конечно.

Там в основном питоновские только оболочки, а все и так работает на c++.

> в Python порог входа ниже

На практике язык люто посредственный, лучше бы на плюсах.

6,4бпв!!!11

База.

Ллама 3.1 очень вряд ли.

128к — стандарт, ллама подтянулась предпоследней, осталась гемма.

Это верно, кстати.

звуки истерики

Литералли одно и то же же. =)

Да, но там уже и магнум есть с совершенно иным уровнем.

Учитывая, что это «холодный» старт — терпимо.

Потом-то будет мгновенно, если не правишь ответы.

Нет, если на диск не кэшируется.

Просто будет больше оперативы — сможешь запускать большие модели (медленнее=).

На 4090 скорость обработки контекста для средней модели около 4к/сек.

Ну типа, 128к прочтется за 32 секунды. =)

Таблы, антитеслошиз.

Да он просто неуловимый.

> Мистраль ларге, которая на 123B.

Вчера тестил, подтверждаю.

Еще, ИМХО, Qwen2-72b лучше Deepseek-Coder-Lite-V2.

Но, возможно полный Deepseek-Coder-V2 лучше мистрали, хз.

Не сравнивал в лоб.

ООО

Кобольд обновляется реже лламы. Надо смотреть конкретные версии.

Оллама больше кобольда в кликах. Кобольд удобнее, как не крути. Оллама так-то хуйня для выебывающихся домохозяек, или для тех, кому кровь из носу нужен сервис, я хз.

Я сравнивал, знаю о чем говорю.

При этом, конечно, чистая ллама или убабуга лучше их обоих, но кобольд для воробушков лучше олламы.

оллама

Кобольд для простого юзера максимально прост.

Тогда хейти кобольда.

Тащемта, не то чтобы это не совсем так.

Все правильно сказал.

Угараешь?

При таких размерах… размер — уже не главное. =)

На 3600 МГц у меня 123b генерит 0,6 токена (а с промптом выходит тотал 0,4).

Чтобы получить 6 из 0,6 тебе надо в 10 раз поднять скорость.

Если частота в полтора раза выше — то вместо 2 каналов тебе нужно 12 каналов…

Если есть материнка — то вперед.

123 крутая. =)

>>827751

Ну, 6600 у тебя и даст… в районе 1 генерации. =)

>>827753

Ну, ваще, на 4_К_С хватит. Скок там, 70-80 гигов и 6-8 на систему.

>>827802

Более соевая, но на русским лучше болтает.

Ну, со-со, пока хз, не уверен в полезности.

А 70б вроде как с квеном сравнялась, так что… для рп магнум все еще лучше.

А 405б нахуй не всралась. 1%-2% прироста за х5,5 размер.

>>827882

Ну, кстати, Немо — огнище.

Да и гемма будет получше, кмк.

>>827900

Для людей с 8 гигами видяхами, 8б и 12б — это разные размеры. =) Так что я бы лучше гемму для 8-гиговых челов привел в пример.

А.

Ну я так и сделал.

>>827905

3.0 хуйня, ну то есть, даже хуже мистрали, кмк. Сузума кое-как, получше мистрали, айа заметно лучше.

>>828014

Так никому нахуй не нужны based версии, лол.

it — инстракт. Бартовски только ее и квантовал.

Сквантуй сам, тащемта.

>>828027

Сломал, у меня хуярит до 4к не напрягаясь, больше не просил.

>>828039

Ну, типа.

>>828045

Оригинальная.

>>828052

Нет, одинаковая архитектура ≠ одинаковая модель.

Это полностью оригинальная модель со своим датасетом.

Разные инструкции, разные токены, разное все, кроме архитектуры.

Пойми правильно, ллама — это вполне конкретная модель, которая может дообучаться — и тогда это будет ллама со свистоперделками. Если же берется чисто архитектура и делается новая модель — то это уже совсем другая модель.

Примеры «той же модели» — Т-лайт от Т-банка. Это ллама-3.0.

А твое «ничего подобного и близко не было» — полная хуйня и незнание истории. Были те же gpt-2, всякие пигмаллионы (которые тут некоторые до сих пор нежно любят) и так далее.

В конечном счете, это все трансформеры.

Ллама привнесла в опенсорс формирование датасетов, методы обучения, набор параметров, и хороший результат.

Это как инструкция для пользования печкой.

Но когда ты сделал суп, а твой друг сделал жареную картошку — картошка не становится сортом супа, окда?

Я хз как еще очевиднее объяснить.

И, да, на старте многие думали, что мистраль — это именно файнтьюн Лламы, но оказалось, что нет.

>>828059

Для 12 гигов и 8к контексте — 6.4 бпв.

>>828060

Скилл ишью, где-то накосячил, там русский точно не хуже.

>>828081

Никогда не встречал за последние месяцев 8 такой хуйни, если честно.

Ни на одном из компов.

Везде обрабатывается чисто генерация при свайпе.

>>828085

Предполагаю, что какая-то проблема? У меня такое вот было последний раз осенью. С тех пор именно так и работает — сразу генерация.

>>828087

С моделью вообще никак.

Я редко использовал, но по ощущениям 8-битный не сильно.

4-битный не стал бы.

>>828094

Ну, у тебя не хватит, у меня хватит.

Модели есть, но нам их не дали.

Хамелеон был, но без картиночного модуля, пососали.

>>828096

Пздц багует люто.

>>828097

На инглише? Ты угораешь?

На русском адекватно говорит не то что Phi-mini 3.8b, а даже Qwen2-1.5B старается.

На английском я даже хз, какие там проблемы можно найти.

Ну, попробуй Qwen2-1.5b и 0.5b. Не знаю, не проверял на инглише.

>>828099

Во-первых, не одновременно, а последовательно.

Во-вторых, не охуеет.

В-третьих, озу вообще не приделах, все в видеопамяти. Если кэшируется в оперативу — то помянем производительность, такое неюзабельно, канеш.

>>828101

Нихуя вы упоротый, сэр.

Там в 4 можно уложиться, и оператива я хз.

Вот щас запустил именно простую SD1.5 DPM++ 2M SDE Karras 25 steps — 3 гига видеопамяти в пике и 2,5 гига оперативы.

У вас 2-гиговых моделей не завезли в жизнь?

Плюс, есть minisd для извращенцев, которые 256256 генерят.

Какие нахуй 64 гига оперативы ради 2,5!

Ну и, да, иметь вторую видяху и 64 гига оперативы — в принципе хорошо и стоит.

Но в 12-гиговую видяху (привет, 3060), влезет SD+LLM уровня 7-8-9 б. И будет работать. Даже быстро.

Mistral Nemo для 16 гигов бери.

Ну или, вон, посоветовали Гемму, можно затраить.

Терпимо.

Видяха 12 гигов? Тогда на проц похуй, в принципе.

Ну там если квен2-7б и кэш квантовать… Может влезет.

Слои на оперативе — замедляет. Контекст на оперативе — замедляет.

ИМХО, лучше в видяхе стараться уместить.

Если ты инференсишь БЕЗ видяхи, на проце (ну или выгружаешь лишь часть слоев) — то для обработки контекста CPU, а для генерации — пропускная способность RAM критична.

Минимума нет, но DDR5 будет лучше, естественно.

Ну, 70-80. =)

А если у человека 6? :)

Не страдай хуйней, умоляю!

16к контекста в 8-битах на Немо в 6.4бпв влазит в 11,4 гига.

Если мало 16к контекста — тады выгружай, канеш… Но я не уверен.

Да, как и Хамелеон. Видишь хамелеона? И я не вижу. А они мультимодальные. =D

Соси писос, прости конечно.

Там в основном питоновские только оболочки, а все и так работает на c++.

> в Python порог входа ниже

На практике язык люто посредственный, лучше бы на плюсах.

6,4бпв!!!11

База.

Ллама 3.1 очень вряд ли.

128к — стандарт, ллама подтянулась предпоследней, осталась гемма.

Это верно, кстати.

звуки истерики

Литералли одно и то же же. =)

Да, но там уже и магнум есть с совершенно иным уровнем.

Учитывая, что это «холодный» старт — терпимо.

Потом-то будет мгновенно, если не правишь ответы.

Нет, если на диск не кэшируется.

Просто будет больше оперативы — сможешь запускать большие модели (медленнее=).

На 4090 скорость обработки контекста для средней модели около 4к/сек.

Ну типа, 128к прочтется за 32 секунды. =)

Таблы, антитеслошиз.

Да он просто неуловимый.

> Мистраль ларге, которая на 123B.

Вчера тестил, подтверждаю.

Еще, ИМХО, Qwen2-72b лучше Deepseek-Coder-Lite-V2.

Но, возможно полный Deepseek-Coder-V2 лучше мистрали, хз.

Не сравнивал в лоб.

ООО

Кобольд обновляется реже лламы. Надо смотреть конкретные версии.

Оллама больше кобольда в кликах. Кобольд удобнее, как не крути. Оллама так-то хуйня для выебывающихся домохозяек, или для тех, кому кровь из носу нужен сервис, я хз.

Я сравнивал, знаю о чем говорю.

При этом, конечно, чистая ллама или убабуга лучше их обоих, но кобольд для воробушков лучше олламы.

оллама

Кобольд для простого юзера максимально прост.

Тогда хейти кобольда.

Тащемта, не то чтобы это не совсем так.

Все правильно сказал.

какой-то глюк ответов, мех.

И так.

Пиздос шизик уже тред вайпает.

Это не глюк, шиз, это превышение лимита на цитирование. Разбивай свои посты, шиз, а то моча их потрёт за вайп, лол.

Ну это по факту хуйня же, я понимаю, что так задумано, но это вопрос к мозгам разрабов.

Так что шиз тут тока автор такого решения, сочувствую ему, желаю скорейшего выздоровления.

Не умеешь читать — не заходи сюда. =) Смотри видосы там, я хз, на что тебя хватает.

Хочешь сказать, что это один анон ответил сразу на десятки постов?

Спасибо за ответы, не ожидал

>я понимаю, что так задумано

Ну и хули ссышь против ветра?

Ну а как же ещё?

>Ну а как же ещё?

Это гуру ай треда похоже. 😊

Меня не было два дня, а тут понаписали.

Да. =)

autistic screeching =D

Ну бля, я когда писал, я не думал, что ответов так много получится.

А когда копирнул свои реплаи строчками — охуел.

☝️

Этот гуру нейронку запустить нормально не может, лол. Ему надо не в этот тред срать простынями, а пиздовать гугл читать.

Думаешь? Вроде бы профессионал.

Все ли сети льют много воды в ответах: "Это очень сложный вопрос", "Это очень важная тема" и т.п.?

Потестил еще сетки. Какая же ллама3.1 405б тупая.

На своих промптах я бы так зарейтил:

квен2 72b > llama3 70b >= llama3.1 405b > mistral large 2 = chat gpt 4o mini

Мою задачу только квен смог решить. И в остальном всё четко выдает, где нужно придумать кое-что для новелки.

У него простое форматирование и его делали китайцы, к чему вестерноиды предвзято относятся, поэтому он на арене отстает.

Арена это мусор, короче. Там у 4o mini 1280 эло, хотя она тупая как пробка.

На своих промптах я бы так зарейтил:

квен2 72b > llama3 70b >= llama3.1 405b > mistral large 2 = chat gpt 4o mini

Мою задачу только квен смог решить. И в остальном всё четко выдает, где нужно придумать кое-что для новелки.

У него простое форматирование и его делали китайцы, к чему вестерноиды предвзято относятся, поэтому он на арене отстает.

Арена это мусор, короче. Там у 4o mini 1280 эло, хотя она тупая как пробка.

Аноны, вы когда-нибудь фармили КУДОСЫ?

Я тут заметил что на хорде есть Mistral-Large, но чтобы его заюзать надо 4697.43 КУДОСА.

Решил побыстрому их нафармить, запустив несколько колабов с разными моделями:

gemma-2-27b-it.i1-IQ2_M

Mistral-Nemo-Instruct-2407-Q6_K_L

Meta-Llama-3.1-8B-Instruct-abliterated.Q8_0

Но в списке висит только последняя из них. Это получается что один воркер может раздавать в списке только одну модель и все кто к ней подключаются рандомно гнерируют на одной из трёх раздаваемых? Или я просто почему-то не вижу то что раздаю?

Я тут заметил что на хорде есть Mistral-Large, но чтобы его заюзать надо 4697.43 КУДОСА.

Решил побыстрому их нафармить, запустив несколько колабов с разными моделями:

gemma-2-27b-it.i1-IQ2_M

Mistral-Nemo-Instruct-2407-Q6_K_L

Meta-Llama-3.1-8B-Instruct-abliterated.Q8_0

Но в списке висит только последняя из них. Это получается что один воркер может раздавать в списке только одну модель и все кто к ней подключаются рандомно гнерируют на одной из трёх раздаваемых? Или я просто почему-то не вижу то что раздаю?

Какой-то шизоидный рейтинг у тебя. Мистраль ебёт любую локалку в сухую.

Мистраль можешь нафармить на сайте мистраля, там дают 5 баксов

Даже гемму 27 с Q8?

агентов здесь запускали? Девин сейчас в тренде или изобрели поновее что-то?

Ллама 3.1 405В разочаровала. Не то, чтобы совсем всё безнадёжно, но далеко не тот уровень, который ожидаешь от таких размеров. Качественного скачка от 70В 3.0 не получилось совсем, я бы сказал.

Если брать плашку 48гб, есть смысл брать с частотой 6400 вместо 6000, разница почти в 5к?

>там дают 5 баксов

Надолго их хватает? И нет ли доп. цензор фильтра?

Я бы Мистраль Лардж 2 ставил выше ллама3 70б.

И даже поумнее квена2 немножк, ИМХО.

Но это беглые тесты вчера.

Ну и арена не про ум, а про «нраицца».

4о мини делалась, чтобы нравится — успешно выполняет роль.

Мистраль тоже локалка. =) Ну так, к слову.

123б-то? Да, даже гемму. =D

1%-2%!

Если под амд, то на твой вкус, прирост сам видишь.

Если под интел, то можно больше.

Если под четыре плашки, то если готов поебаться.

Короче, 0,5+0,5 за : 0,5+1+0,5 против. 1:2

Переписывай а то репорти к удалению, никто не будет разбираться в этом полотне без линков.

Это местный поех, который с равной вероятностью может как подсказать что-то дельное, так и нести ерунду не понимая.

Что за задача и промты у тебя?

> Арена это мусор, короче.

Не мусор а (подкрученное) возведение примитивных зирошотов в абсолют. Вроде бы и борятся с этим, а только хуже выходит.

Сам решай, прирост ерундовый, но и затраты если дисконтировать на время пользования не огромные.

На 123В сиди. Лучшее что есть из локалок, в рп клауду/жпт ебёт.

Не знаю, смотри тариф, вроде как у соннета примерно. Фильтра там нет

Количество слоев загруженных на видеокарту. Чем больше тем лучше, в идеале все.

Это ты про что? 123B

Он про очевидный Мистраль.

Блять, буквально на пару недель вылетел из темы локалок, а тут уже столько всякой хуйни подвезли. Можете вкратце пояснить за вторую гему, новые мистрали и апдейт по ламе 3? С меня нихуя, но всё же.

Ну как в идеале

Если у тебя хоть слой GGUF модели улетает в озу, то проще сразу на cpu запускать и забить на видяху

Вторая гемма 27B топ своего размера, мистраль 123B просто топ для мажоров, а лламы 3 ХЗ, как-то не распробовали ещё.

Его только на двух 3090/4090 запустить можно в 3бита?

Если у тебя не много видеокарт, то Мистрал-Немо сейчас топ для ЕРП, если речь о нём.

Гемма2 9б хороша, 27б очень хороша.

Ллама 3.1 более соевая, более умная, и вышла 405б, но похуй.

Мистраль вышла Немо которая еще лучше Геммы 2 9б и Мистраль 123б, которая в целом тоже похуй, но чуть более подъемная, чем 405б, и отличная.

Вкратце.

Ну, не настолько, но да, выгрузка на оперативу печально делает.

mini-magnum

Скиньте модель на которой вы тестили эту 27 гемму. Я просто ехл2 скачал какую-то, запустил в таверне с пресетами местными (там под неё как раз есть) и прям ну совсем жижа в ЕРП получилась. Может надо что другое качать?

Кал, отупляет модель пиздец.

гемма в ерп ничего интересного и не выдаст, там все вычищено

А, ну ок тогда, не буду мучать жопу. Как же заебали делать юзлес модельки. Нахуй мне соевый ассистент локально? За ним можно вон и в онлайн проприетарные сетки сходить, разница то

Спасибо, мужики. Всех обнял.

Насчет Мистрал-Немо вопрос - насколько она соевая и капризная в плане настроек? Я так понимаю файнтюнов на нее пока нет, по этому хочется знать по ее производительности из коробки. В свое время намучался с третьей ламой и ее лупами, щас инстинктивно почему то с недоверием отношусь вообще ко всем новым моделям.

Чел, я литералли Немо с минимальным инстракт пресетом юзал на канни рейп.

Но глинты и прочая purple проза есть, тренировали видимо на выхлопе с нейросетей

Ну так это круто, че. Перпл прозу можно легко вырезать промтами по крайней мере из ламы вырезалось, а отсутствие цензуры это прям заебись.

А как распределить? Или оно автоматом?

> вкратце пояснить за вторую гему

27б при наличии 24 гиговой гпу - суперахуенна. Умна, умеет рпшить, соя легко купируется, может в кум и интересная. Одна беда - малый контекст 8к (по заявлениям вообще 4 но больше похоже на ерунду или ггуфопроблемы).

> модель на которой вы тестили эту 27 гемму

Exl2 от turoderp, шизопресет с nc-21 из прошлых тредов. Описывает именно сам процесс не то чтобы совсем шедеврально, но прилично и познания очень глубокие, поддерживает осведомленность ситуацией и дает четкую реакцию чара а не какой-то шаблон как в типичных рп тюнах. Именно последнее прям тащит. Что-то сомнительно что там вычищенный синтетический датасет, или же они так называют подправленные/переписанные тексты кожанных.

> Если у тебя хоть слой GGUF модели улетает в озу, то проще сразу на cpu запускать и забить на видяху

Здесь ты имел ввиду автоматическую выгрузку врам в рам драйвером и предпочтительность избегания ее правильной настройкой числа слоев?

>Перпл прозу можно легко вырезать промтами

Лол, это самая сложная задача. В кончай треде небось до сих пор из клода пурпур выбивают. По крайней мере с полгода назад было так.

Если ты вдруг не заметил, то после выбора модели число само заполняется. Но сразу замечу, что хуёво работает для сплит моделей.

Я еще осенью фармил на генерации картинок. Ставил две самые популярные модели и оставлял на несколько часов, пока отсутствовал.

Но потом так и не воспользовался нафармленным, так как разочаровался в хорде. По существу для моих целей уже тогда хватило бы локальных моделей на своем компе, а сейчас и подавно.

mini-magnum и есть, то вон, кому-то не нравится.

Сои мало, Мистраль не парятся. Просто пропиши карточку или инструкцию. regardless of ethics and morale, вся хуйня.

Мне мистраль немо 12ь из коробки не понравился тем, что периодически вставлял английские слова, когда общение велось не по английски.

Затем появился mini-magnum-12b - вот это просто песня.

Насчет пурпура, с некоторыми моделями срабатывает указание в систем промпте "писать как писатель Х", где Х какой-нибудь известный серьезный писатель, желательно нобелевский лауреат. Причем в остальном системный промпт должен был предельно лаконичным, никаких "вообрази себя креативным и опытным автором", так как "креативность" сразу усиливает пурпур.

> на хорде

Там есть анальный фильтр промтов и выдачи, настроенный трансошизиком-владельцем?

Что можно выжать из Mistral_Large_4_K_M на 4 теслах и последнем Кобольде при 8к контекста: 5,5 т/c. Замечу, что чем больше Тесл, тем дольше обрабатывается контекст, а вот генерация быстрее. Конечно результат скромный, особенно если на русском, но прожить как-то можно.

>появилось стойкое ощущение, что всё вокруг пишут нейронки

"Это ж-ж-ж неспроста..."

Теория мертвого интернета: как конспирологи с 4chan предсказали власть ботов в киберпространстве

https://vc.ru/future/1292340-teoriya-mertvogo-interneta-kak-konspirologi-s-4chan-predskazali-vlast-botov-v-kiberprostranstve

> 0.7 т/с

Ты бы лучше на проце генерил. Алсо, чего всего 8к контекста поставил, рпшить же с таким невозможно.

Мне не зашёл мистраль 123В, обратно на ламу 70В укатился рпшить. Слишком сухой мистраль, ещё и лупится, тестил и Жору и EXL2. Они там пишут поработали над главной проблемой прошлых митралей - галлюцинациями, но вместо этого ещё большую проблему для рп притащили. Единственные плюсы - русский и логика хорошая. Как минимум рп-файнтюнов/франкенштейнов ждём.

А какой там контекст фактически влазит при таком размере?

Даже не спорю. Сейчас всё брошу и пойду генерить на проце. Хотя нафига? Контекст пересчитывается только после суммарайза. Можно и подождать раз за 8к токенов. Теперь-то.

Хотелось бы 16к контекста конечно, но это перебор будет. Разве что квант уменьшить.

на основе Mistral Nemo 12B

https://huggingface.co/BeaverAI/NeMoistral-12B-v1a-GGUF

https://huggingface.co/mradermacher/Lumimaid-v0.2-12B-GGUF

https://huggingface.co/Aculi/mistral-doryV2-12b-GGUF

https://huggingface.co/SteelQuants/NeMoria-21b-Q6_K-GGUF (пока только Q6 квант)

на основе Llama-3 8B

https://huggingface.co/mradermacher/L3-12B-Lunaris-v1-GGUF

на основе Llama-3 15B

https://huggingface.co/bartowski/L3-Aethora-15B-V2-GGUF

Если грамотно раскидать слои, то 32к точно влезет, но генерация будет 1,5 токена наверное. Во втором кванте 2.

У mistral-doryV2-12b проблема в том, что он требует не мистралевский темплейт, а альпаковский. Даже тестировать дори было противно, так как опять надо было делать кучу пресетов и систем проптов на каждый случай использования. И в итоге результат невразумительный, разницы с мистралем из коробки я не заметил, по крайней мере в лучшую сторону.

Lumimaid-v0.2-12B в свою очередь слишком лаконичная. Если Stheno можно было назвать чересчур многословной, то это - противоположность. В РП выдает скупые абзацы, а при сочинении текстов... абзац текста, там где например мини-магнум пишет подробное сочинение.

Я где-то час тестил mistral large 2, реально тупой он. Пиздит лаконично, но по сути ничего не говорит.

Еще такой момент - он не знает моего жанра. Вообще. Выдает хуйню.

Он же для программирования предназначен, а вы его в ролплей, лол.

>L3-Aethora-15B-V2-GGUF

45к скачиваний? Качаешь эту модель, надеешься, что будет лучше оригинала, а оказывается на деле, что она дичайше проебывает логику. Карточке не следует, временами выдает по одному предложению. Трешак полный. У людей настолько низкие требования к контенту? Ладно, о чем я, тут половина треда 8б юзает и довольно урчит.

там вроде счетчик этот кривой и на него особо полагаться не стоит

Немного азии с 10% MMLU теста:

ChatGLM4-Q8-0.gguf

test over 1408 question accurate 63.2%

use time:26876.59 s batch:6.72165 token/s

ChatGLM4-Q8-0.gguf

test over 1408 question accurate 63.2%

use time:26876.59 s batch:6.72165 token/s

Вкатился! Какая модель лучше всего справляется с ролью цифрового помощника? Софт-скиллы, советы по стратегиям общения личного и делового, как заказать альтушку, вот это всё.

Прежде чем советовать что-либо тяжелее 8-12B моделей, стоит спросить тебя, на каком железе ты их собираешься запускать?

>Вкатился

'nj yt nfdthy

это не таверна и даже не бугабуга

ты не вкатился

элитист дохуя?

Пиздишь же. Если не считать лупов, с которыми надо бороться семплингом/промптом, то он буквально во всём лучше всех остальных. А есть ещё Lumimaid 0.2, это вообще эталон кумерства на русском.

Есть ноут с i5-13500H (встройкой) и 16ГБ ОЗУ. Какие модели можно в ollama позапускать с такими характеристиками, чтобы ответы были быстрыми? Интересует написание кода и базовые советы, как chatgpt выдает.

чел на интерфейсе кобальта кумить банально не удобно и не приятно

размером не больше 8 гигов ищи - лучше 6 наверно

Это лишь твоё субъективное мнение. Кто-то может запускает голую llama.cpp и всем доволен.

> Lumimaid 0.2

Я вчера тестил 123В вариант, там реально ахуевший куминг. Вроде же в датасетах не было русского, но стиль письма сильно отличается от ванильного Мистраля, такие подробности совокупления что аж кринжуешь иногда. Тут чел с изврещениями и лолями должен заценить это. И там в датасете ещё токсик-датасеты были кроме РП, разцензуривает по полной его.

как только mistral nemo 12b gguf на kobold.ccp будет поддерживаться, так сразу будет довольно урчать на 12b

Если повыгружать максимум лишнего хромобраузеры из памяти при запуске LLM, то вполне комфортно можно и 12B модели Llama-3, Mistral Nemo использовать. Конкретные актуальные модели здесь постоянно постят, смотри список https://rentry.co/llm-models из шапки, почитай несколько прошлых тредов.

Именно для написания кода лучше использовать специализированные модели DeepSeek Coder, Codestral или поискать бесплатные онлайн демо моделей, для какой-то мелочёвки их хватает с головой.

Ну вот llama 3 попробовал и как-то не быстро отвечает, хотя на 7B качал. Phi 3 на 3.8B получше работает, но возможностей меньше. Я думал может есть модели на 7-8B, но оптимизированные для не мощного железа.

>koboldcpp-1.71

>Merged fixes and improvements from upstream, including Mistral Nemo support.

Так он уже поддерживается, не?

>как только mistral nemo 12b gguf на kobold.ccp будет поддерживаться

Так уже, накати последний Кобольд.

>Кто-то может запускает голую llama.cpp

d rjycjkb xthtp ljcc

в консоли через ддос?

ой нам то не пизди

>субъективное

долбаеб

редачить сообщения и выбирать карты обьективно удобней в таверне

покачай еще 7б они не все одинаковые

Так нихуяшеньки. С ошибкой вылетает. rtx 3060 12gb если что. Версия кобольда 1.71

Хочешь инференс на CPU побыстрее - выбирай модели с меньшим количеством параметров, но они также будут пропорционально "тупее".

хотя может корявый gguf скачал... Дайте ссылку откуда вы качали, щас проверю.

Запускается он, ищи рабочую версию.

>С ошибкой вылетает

Так какая именно ошибка? Скорее всего, оно у тебя в VRAM ещё не влезает.

Да на пол-секунды вылазит и просто командная строка закрывается

>Дайте ссылку откуда вы качали

Можешь сразу файнтюн Nemo брать, будет не хуже.

https://huggingface.co/QuantFactory/mini-magnum-12b-v1.1-GGUF

Запускай тот же .exe из командной строки (cmd.exe), тогда вывод увидишь при завершении.

А я, как уже сообщал, тестил 12б - это эталон лаконичности, как будто читаешь не текст, а аннотацию к нему. Хотя может она в рп и блещет, не уверен, так как я не угораю по рп, только делаю карточки. Самый длинный рп чат у меня из десяти реплик, остальные по одной.

Вот это двачую - на данный момент, по моим личным тестам, самое удачное решение.

Не знаю как там на мелких, но на больших длина очень легко промптом контролируется. Тебе и нужное количество абзацев напишет, и словарный запас регулируется, соотношение реплик/описаний без проблем меняется.

Вот что пишет при попытке запуска через cmd

[648] Failed to extract cublasLt64_12.dll: decompression resulted in return code -1!

почему продолжая чужой чат модель выдает ересь уровня

пааа

))пнг

выгш

ш

п

к

зыыы779

-

а когда начинаешь новый чат то шиза пропадает и пишет нормально?

пааа

))пнг

выгш

ш

п

к

зыыы779

-

а когда начинаешь новый чат то шиза пропадает и пишет нормально?

Есть IQ кванты, которые при мелком размере должны быть получше аналогичных по размеру обычных квантов. Но для маленьких моделей, скорее всего, будет всё равно значительное падение интеллекта. Можешь попробовать кодквена в IQ4_NL кванте, например, вот тут. https://huggingface.co/bartowski/CodeQwen1.5-7B-Chat-GGUF/tree/main

Аноны, а какой мистраль лардж качать под 64/16? Сильно ли он глупеет от квантизации?

А всё, запустилось, похоже действительно памяти не хватало. Скачал вместо q8 q5_K_M и всё запускается и летает Amt:30/500, Process:0.01s (6.0ms/T = 166.67T/s), Generate:1.46s (48.6ms/T = 20.56T/s), Total:1.47s (20.48T/s), но теперь у меня вопрос... Эта шняга что, тоже не понимает инструкции как и gemma2 ?

Постоянно у меня в истории спрашивает "Что будешь делать дальше?" "Будешь делать это или нет?" "Пойдёшь на лево или на право?" Сука, как это говно отключить?! Я от этого устал ещё в gemma2 и надеялся что хоть тут этого говна нет!

Различные промпты пишу, он их вообще не воспринимает" Пишу что бы не спрашивал у меня постоянно в конце и сам развивал историю, так нифига не работает!

Тут в новой версии таверны включили в интерфейс для кобольда dry сэмплеры, которые ещё в прошлой версии кобольда добавили. В связи с этим вопрос к тем анонам, которые уже давно сидят с ним на убе: какие настройки dry используете? Рекомендованные вот тут? https://github.com/oobabooga/text-generation-webui/pull/5677

Там автор сэмплера вроде как показывает, что даже с дефолтными настройками, если повтор уже есть, то генерит шизу, что напрягает. Кроме того, как я понял, если в карточке много персонажей, чьи имена постоянно пишутся, или других повторяющихся названий, нужно их все каждый чат в исключения выписывать, так? Также не очень понял: длина последовательности - это ведь в токенах? Тогда, казалось бы, лучше её под десятку хотя бы ставить, а не на двойку, чтобы с артикль+пробел и прочими похожими вещами было всё в порядке.

Там автор сэмплера вроде как показывает, что даже с дефолтными настройками, если повтор уже есть, то генерит шизу, что напрягает. Кроме того, как я понял, если в карточке много персонажей, чьи имена постоянно пишутся, или других повторяющихся названий, нужно их все каждый чат в исключения выписывать, так? Также не очень понял: длина последовательности - это ведь в токенах? Тогда, казалось бы, лучше её под десятку хотя бы ставить, а не на двойку, чтобы с артикль+пробел и прочими похожими вещами было всё в порядке.

Кстати как исправить "..." такие троеточия после нового сообщения когда ты просто постоянно жмёшь на кнопку генерации далее, а какой то момент всё так стопориться и как бы ты не свайпал всегда троеточие выходит?

Нашёл оптимальный вариант для своей 3060 12gb с Mistral Nemo 12b - Mistral-Nemo-Instruct-12B-iMat-Q6_K.gguf и 12к контекста.

CtxLimit:6538/12288, Amt:128/500, Process:0.30s (3.0ms/T = 331.13T/s), Generate:9.08s (70.9ms/T = 14.10T/s), Total:9.38s (13.64T/s)

Из интефейсов в переврд ответов умеет только в SillyTavern?

А почему у меня 8_0 на 32к на тех же спеках работает? И не то что бы медленнее

Правда? Хм, не знаю, возможно в настройках драйвера видяхи нужно что то настроить или ещё что, я хз, у меня этой видеокарте 2 день пошёл, я не шарю. Какие у тебя настройки в kobold.ccp? Можешь скрины пожалуйста отправить, попробую повторить.

У меня проц если что 5600g и 48 гигов оперативки 3300mhz

12400F, 16RAM

у меня не кобольд, уба через exl2

Mistral Medium будет выпущен, есть ли инфа?

Аноны, как правильно протестить производительность разных gguf-ов на своём железе? Бенч в kobold?

Хз, я бы просто запустил модель и протестил в общении.

можешь подсказать как скачать по нормальному модель для этой угабуга? Мне вот такую хрень выдаёт. В кобольде всё просто и легко, а тут..

Кстати, вопрос назрел, ну вот я выгружаю например 999 слоёв модели на свою 3060 и контекст быстрее обрабатывается и текст быстрее генерируется. Добавляю ещё одну 9 в конец и получаю 9999 уже слоёв и ещё быстрее сейчас текст генерироваться начал. Неужели это какой то чит? Так ведь не бывает? Значит в обмен на эту скорость наверное модель тупее становиться? Или так и надо везде по девяткам ставить, что бы ебошило на максимум?

> processing speed 64.42 T/s

Буквально пикрел. Об этом сразу говорили, спасибо жоре.

> но прожить как-то можно

Нет. Не полный конетекст а просто первый ответ(!) на карточке с лором будешь ждать с пол минуты.

Ты же просто одолжил у кого-то очередную теслу а не купил ее? Если второе то это пиздец.

Какой конфиг рам? Если внезапно там частотная новая lpddr5 то как-то с горем пополам 8б-12б, мистраль правильно советуют, это, наверно, лучшее в размере. Но готовься к отвратительной скорости.

Ты байтишь или оно рили так? Канничка остается собой, или, как обычно, общая шиза на тему? Насколько он отупел?

> выгружаю например 999 слоёв модели

Там столько нет. Под слоем понимается не индивидуальная матрица его компонентов а группа, но даже если первое интерпретировать то тысячи не наберется, может быть в 100+б если только (хз сколько там). Так что наблюдаемое тобой - совпадение, тот же эффект будет если выгрузишь 99 слоев и даже 60. Почитай в консоли, оно пишет сколько реально слоев выгружает.

Если у тебя модель полностью помещается в видюху - дропай нахуй все жора-релейтед и используй экслламу, будет и быстрее и умнее/не хуже.

> в обмен на эту скорость наверное модель тупее становиться

Нет, тупее станет если возьмешь квант меньше.

через двоеточие бранч допиши с нужным квантом

>и ещё быстрее сейчас текст генерироваться начал

Дядь, не тролль, тут умные люди сидят.

Ты вставил имя репы с обниморды в поле скачивания, теперь жми кнопку download рядом с полем а не "Load" где-то сверху. Второе для гапуска готовой модели. И двачую, а то там в мейн бранче у Турбодерпа только калибровочный файл чтобы самому квантовать.

так я так и жал, он пол секунды пытается загрузить модель на 0.0% потом пишет Model successfully saved to models\turboderp_Mistral-Nemo-Instruct-12B-exl2/. Я пробую обновить перечень моделей, вроде появляется надпись с этой моделью, я думаю, ну значит он только тогда начнёт её грузить, жму и вот то что на экране я скинул получается.

turboderp/Mistral-Nemo-Instruct-12B-exl2:8.0bpw впиши

Ты загрузил только файл с данными калибровки, вот он и скачался мгновенно. Инструкция уже дана, битность можешь на нужную поменять.

> Ты байтишь или оно рили так?

Ну там что-то типа такого по стилю, ванила очень сухая была. Всё как кумеры тут мечтали, под персонажа подстраивается хорошо. Похоже на Магнум 72В, но адекватнее и с идеальным русским. В Магнуме конечно скорость приятнее, но русский довольно странный, хоть и не назвать плохим.

Ещё тот же Lumimaid на Ламе 3.1 70В потестил - в русском кал, даже не стоит внимания.

Наконец скрины с примерами и описанием. Да будут сиды твои хорошо и не скатится модель в лупы.

> Ну там что-то типа такого по стилю

Довольно таки неплохо, подробности и последовательность огонь.

> под персонажа подстраивается хорошо

Вот это важно. А фетиши всякие знает? раз канни есть и такое то основные должно Фендом популярный?

Хотя этого уже достаточно, хороший повод прерывать протеины и поиграться, спасибо.

Cделал как сказали, та же хрень что и без :8.0bpw. Уже и в ютюбе смотрел гайды там всё просто копируют и всё загружается у них, я делаю так же и нихуя. Короче плюнул на это модель, попробовал другую взять для проверки grimjim/Mistral-Nemo-Instruct-2407-12B-6.4bpw-exl2 Просто вставил, нажал как и раньше Download и всё началось скачиваться по нормальному. Короче я всё правильно делал, просто, автор прошлой модели мудак, с неработающей загрузкой, мудак Но я так понимаю эта 6.4bpw тоже квантованная версия типа Q6?

Да не мудак а уважаемый человек, который сделал в угоду удобства себя и всех знакомых с гитом, забив на хлебушков.

> 6.4bpw тоже квантованная версия типа Q6

Да. Число - битность, фактическая а не тот ребус с цифрой и буквами что у жоры. 6.4 уже достаточно на самом деле, с 8 битами там разницу выискивать, если квант нормально сделан.

>русским

Как называется эта болезнь?

Щас бы на вражеском общаться с женой

А потом удивляемся, хули у нас везде соя.

В этой стране шанса найти себе жену ровно ноль. Во вражеских странах с этим проще, лол японки так вообще по кд текут по белым.

Я тоже раньше только на английском рпшил. Потом стал писать на русском, а читать на английском, а сейчас уже полностью на русский перехожу. Русский банально быстрее и приятнее читать. То что я могу английский читать не значит что теперь надо через силу всё на нём делать.

В чем проблема если все остальное хорошо а не единственный критерий?

Бляяя, ебаный каломаз, выходит модель зашкварена?

> по белым

Slav = POC, инджой. максимум можешь рассчитывать на милую кореяночку, а так паназия которую не захочешь

Писец ты деградировал. Раньше хоть надежда была, что ты извлечёшь из своего куминга что-то полезное. Сейчас же это просто трата белка (

>выходит модель зашкварена

Как и большая часть. Датасеты походу никто даже не читает, буквально, я какой только не открою, в пределах 10 строк нахожу какую-нибудь ебаторию, если конечно датасет больше этих 10 строк.

>милую кореяночку

Минусы будут?

северную...

> Датасеты походу никто даже не читает

Тут бля даже эвристику быстрой ллм не нужно проводить, просто буквально поиск по регэкспу. Ладно там когда хуй кладут в пикчах и т.д., но тут бля ллм где текст это основа, писос. А зашквар от каломаза, инверсивный мидас

> Минусы будут?

если рили не на службе у их кгб то только если ты виабу

>но тут бля ллм где текст это основа, писос

А вот и результат.

Зато так матом даже командир+ не хуесосит.

Lite-Oute-1: New 300M and 65M parameter models, available in both instruct and base versions.

Lite-Oute-1-300M-Instruct (Instruction-tuned)

https://huggingface.co/OuteAI/Lite-Oute-1-300M-Instruct

https://huggingface.co/OuteAI/Lite-Oute-1-300M-Instruct-GGUF

Lite-Oute-1-300M (Base)

https://huggingface.co/OuteAI/Lite-Oute-1-300M

https://huggingface.co/OuteAI/Lite-Oute-1-300M-GGUF

This model aims to improve upon previous 150M version by increasing size and training on a more refined dataset. The primary goal of this 300 million parameter model is to offer enhanced performance while still maintaining efficiency for deployment on a variety of devices.

Details:

• Architecture: Mistral

• Context length: 4096

• Training block size: 4096

• Processed tokens: 30 billion

• Training hardware: Single NVIDIA RTX 4090

Lite-Oute-1-65M:

Lite-Oute-1-65M-Instruct (Instruction-tuned)

https://huggingface.co/OuteAI/Lite-Oute-1-65M-Instruct

https://huggingface.co/OuteAI/Lite-Oute-1-65M-Instruct-GGUF

Lite-Oute-1-65M (Base)

https://huggingface.co/OuteAI/Lite-Oute-1-65M

https://huggingface.co/OuteAI/Lite-Oute-1-65M-GGUF

The 65M version is an experimental ultra-compact model.

The primary goal of this model was to explore the lower limits of model size while still maintaining basic language understanding capabilities.

Due to its extremely small size, this model demonstrates basic text generation abilities but struggle with instructions or maintaining topic coherence.

Potential application for this model could be fine-tuning on highly specific or narrow tasks.

Details:

• Architecture: LLaMA

• Context length: 2048

• Training block size: 2048

• Processed tokens: 8 billion

• Training hardware: Single NVIDIA RTX 4090

Lite-Oute-1-300M-Instruct (Instruction-tuned)

https://huggingface.co/OuteAI/Lite-Oute-1-300M-Instruct

https://huggingface.co/OuteAI/Lite-Oute-1-300M-Instruct-GGUF

Lite-Oute-1-300M (Base)

https://huggingface.co/OuteAI/Lite-Oute-1-300M

https://huggingface.co/OuteAI/Lite-Oute-1-300M-GGUF

This model aims to improve upon previous 150M version by increasing size and training on a more refined dataset. The primary goal of this 300 million parameter model is to offer enhanced performance while still maintaining efficiency for deployment on a variety of devices.

Details:

• Architecture: Mistral

• Context length: 4096

• Training block size: 4096

• Processed tokens: 30 billion

• Training hardware: Single NVIDIA RTX 4090

Lite-Oute-1-65M:

Lite-Oute-1-65M-Instruct (Instruction-tuned)

https://huggingface.co/OuteAI/Lite-Oute-1-65M-Instruct

https://huggingface.co/OuteAI/Lite-Oute-1-65M-Instruct-GGUF

Lite-Oute-1-65M (Base)

https://huggingface.co/OuteAI/Lite-Oute-1-65M

https://huggingface.co/OuteAI/Lite-Oute-1-65M-GGUF

The 65M version is an experimental ultra-compact model.

The primary goal of this model was to explore the lower limits of model size while still maintaining basic language understanding capabilities.

Due to its extremely small size, this model demonstrates basic text generation abilities but struggle with instructions or maintaining topic coherence.

Potential application for this model could be fine-tuning on highly specific or narrow tasks.

Details:

• Architecture: LLaMA

• Context length: 2048

• Training block size: 2048

• Processed tokens: 8 billion

• Training hardware: Single NVIDIA RTX 4090

Ты не на тот сайт запостил.

>300M

Не может в русский, незачёт. Да и на английском бредит, что ожидаемо.

Ну, например DeepSeek-Coder-Lite-V2.

ХОТЯ БЫ не сильно медленно.

А он что, еще не поддерживается? хд

Сук, кобольдопроблемы.

Жаль, убабуга стартовал хуево, сейчас я слышу о проблемах со всех стороны — лмстудио, оллама, кобольд, а на убабуге у меня запускается вообще все на самом старте последнюю неделю. Никаких проблем. Я вообще был не в курсе, что куда-то еще это не завезли.

Нахуй тебе кобольд с 12-гиговой видяхой? Тебе exllama2 запускать надо, через убабугу. Скорость, качество, все буквально лучше.

А вы кактус жрете.

https://huggingface.co/Quant-Cartel/mini-magnum-12b-v1.1-exl2-longcal 6-битный.

Ну эээ… 2бита? 3_к_м влезет?

Но ты ж понимаешь, что скорость будет 0,5 токена?

Ты буквально делаешь все, чтобы избежать оптимального варианта. =)

Микуфаг, ты?

…

И вам мини-магнум тоже советуем!

Это что?

У 500М квена2 не выигрывает, контекст 2к, мусор мусором получается.

Ой, не туда посмотрел, 4к, конечно!

Все равно никуда.

>Тебе exllama2 запускать надо, через убабугу

Да, как запускать-то? Я скачал, а то что-то квантуйте сами.

Какие для 70b 3.1 ламы настройки? У меня половину текста адекватно пишет, потом хуярит ерунду. Запускаю удалённо с доп параметрами в таверне (родные не видит)

вот такие:

{

"max_tokens": 255,

"temperature": 0.87,

"top_p": 0.95,

"top_k": 40,

"repetition_penalty": 1.29]

}

вот такие:

{

"max_tokens": 255,

"temperature": 0.87,

"top_p": 0.95,

"top_k": 40,

"repetition_penalty": 1.29]

}

Ответ как он квена на 0.5б

Качаешь убабугу.

Устанавливаешь.

Качаешь модель (через лоадер выше написали, или гитом --single-branch --branch).

Загружаешь.

Вы великолепны.

Назови железо, модель и я тебе дам строку, как скачать.

Штраф за повтор пиздецово большой. Некоторые говорят, что уже 1.15 нехорошо и может херить грамматику и форматирование (что имхо маловероятно), но 1.29 - это явно перебор. Скинь на 1.12 где-то, по факту он всё равно слабо помогает от лупов.

Спасибо, походу в чём-то другом проблема. Решил на ламе толстой посидеть с апишкой ai together, там 5 баксов насыпают за простую регу, но чёт бредит

>Нахуй тебе кобольд с 12-гиговой видяхой?

Запускаю 123B на проце и 12 гиговой видяхе.

>Нахуй тебе кобольд с 12-гиговой видяхой? Тебе exllama2 запускать надо, через убабугу. Скорость, качество, все буквально лучше.

>А вы кактус жрете.

Имеется в виду новый формат EXL2? Чем лучше? Большинство весов в gguf-е же.

Как живёшь с такой скоростью? У меня пиздос 0.58T/s, это не дело.

https://docs.google.com/spreadsheets/d/1kc262HZSMAWI6FVsh0zJwbB-ooYvzhCHaHcNUiA0_hY/edit?gid=1158069878#gid=1158069878

Claude 3.5 Sonnet MMLU 90.4 Announced 6/1/2024

GPT-4 Classic (gpt-4-0314 & gpt-4-0613, non-Turbo) MMLU 90.1 Announced 3/1/2023

Не, ну просто ахуенный прогресс за год.

Claude 3.5 Sonnet MMLU 90.4 Announced 6/1/2024

GPT-4 Classic (gpt-4-0314 & gpt-4-0613, non-Turbo) MMLU 90.1 Announced 3/1/2023

Не, ну просто ахуенный прогресс за год.

>Как живёшь с такой скоростью?

Так себе. У меня до токена в секунду, так то.

Год и три месяца, замечу я.

Аноны, подскажите как устанавливать и использовать text-generation-webui? Желательно для хлебушкав.

3090, gemma 27b

Спасибо.

Тигра попробуй, может в ерп, цензура вычищена полностью в прошлом треде постил пруф-скрины

https://huggingface.co/bullerwins/Big-Tiger-Gemma-27B-v1-exl2_4.0bpw

У локалок прогресс, а у этих уже застой. Локалки за год вплотную к жпт4 подобрались, 4о уже поёбывают. Весь прошлый год плясали возле 73-75 MMLU, сейчас уже 85.

Так у этих уже в прошлом году достигнут потолок трансформеров как технологии - новых данных обучения нет(т.е. есть, но там в год в чайной ложке набирается), дообучение на старых данных уже ничего не дает, обучать на сгенерированных данных(кормить своим же говном) нельзя, завышать число параметров уже тоже некуда.

Теперь локалки подошли к тому же потолку и у него же и встанут.

Скоро это поймут все, поймут что никакого AGI-ИИ не будет и все рухнет, как я уже несколько месяцев говорю. Сейчас акционеры хуанга сливают акции со страшной силой на пике стоимости, идет последняя стрижка хомячья.

А что если новые модели дрочат на эти вопросы? Или они разные?

>>300M

>Не может в русский

Нет дерьма Шерлок. Ты реально ожидал, что 300М будет мочь в иностранные языки? Если да, то у меня даже такого реакшена нет.

Там палится это легко и дело реально не в том чтобы больше скор получить, а в том чтобы продукт создать, который требования рынка удовлетворит. Тебя свои же инвесторы с говном сожрут если узнают что ты всем(и им в первую очередь) пыль в глаза пускал.

>никакого AGI-ИИ не будет и все рухнет, как я уже несколько месяцев говорю

Ты просто тормоз. Я так ещё в 2022-м говорил, было очевидно, что трансформаторы хуета.

>Ты реально ожидал, что 300М будет мочь в иностранные языки?

Саруказм же...

>Саруказм же...

Значит я отстал от трендов, не выкупил, сорян.

>Там есть анальный фильтр промтов и выдачи, настроенный трансошизиком-владельцем?

Только на SD, в текстьовых моделях такого не замечал, кумятся спокойно.

Там другой бич - воркеры выкручивают размер ответа и контекст на минимум, видимо чтобы быстрее КУДОСЫ фармились. кге-то 120 токенов макс ответ и 512, если повезёт 1024 контекст, пиздос короче

А всё потому что система наград ебанутая, даётся 1 кудос за 1 генерацию, не важно какую и на какой модели. Именно поэтому почти никто, кроме шизов-альтруистов не крутит 70В и большие модели.

По идее должен быть определёный хешрейт КУДОСОВ, как в крипте, тогда и не важно будет какую модель и с какими параметрами раздавать, наоборот возможно 70+ станут популярны а пидоров с 1024 макс контекстом банить нахуй

+ Неплохо бы все-таки прикрутить к этой хуйне блокчейн, и продавать кудосы донатерам на бирже, желающих раздавать Мистраль Лардж сразу резко прибавится.

Сама идея Хорды прикольная, но если вышеописанного не сделать, то так и останется бесполезной хуитой, для 2,5 шизов.

КОМУ ТАМ НЕ ХВАТАЛО КОНКРЕТНОЙ МОДЕЛИ С КОНКРЕТНЫМИ СЕМПЛЕРАМИ И ПРОМПТОМ ЧТОБ СДЕЛАЛ КАК АПИСАНО И СРАЗУ ЗАЕБОК - ПОЛУЧАЙТЕ!

https://huggingface.co/nothingiisreal/L3.1-8B-Celeste-V1.5?not-for-all-audiences=true

https://huggingface.co/nothingiisreal/L3.1-8B-Celeste-V1.5?not-for-all-audiences=true

>8B

Сразу мимо.

В кобольде не запускается Meta-Llama-3.1-70B-Instruct-IQ4_XS , багнутая?

Оно хоть какие-то простые прикладные задачи может решать? Например, клиссификация текста вот же рофел, классификаторы имеют и больший размер, исправление разметки, выделение каких-то простых запросов с выдачей в жсон?

> потолок трансформеров

Про этот потолок трансформерсов уже больше года твердять, а про "мультимодальное обучение" еще больше. Ебало каждый раз имаджинируется.

Уперлись в ограниченность данных (успешно эту проблему преодолевая) и тем что текущий продукт хорошо продается.

> кге-то 120 токенов макс ответ и 512, если повезёт 1024 контекст

Это, блять, что за кринжатина? А железо хостящих не показывают случаем?

> пидоров с 1024 макс контекстом банить нахуй

Да рили сразу нахуй такое или только за 10 ранов одно очко их мамаши давать.

> так и останется бесполезной хуитой

Они скорее расширят цензуру. Кстати вообще неплохо бы их бомбануть этим, закинув в какие-нибудь сми что их сервис пропагандирует csam, захуярят и быстрее загнутся, а на смену нормальные форки подъедут.

> ?not-for-all-audiences=true

Что это и зачем? Регуляно в некоторых ссылках.

Что пишет при загрузке? Обычные Q кванты пробовал?

>Что это и зачем? Регуляно в некоторых ссылках.

Флаг согласия на 18+ контент.

Вылетает сразу как и немо. Хотя IQ другие тянет, правда, они тормозные ужасно.

Разобрался, оказывается там по дефолту некоторые репы стоят под заглушкой с кнопкой подтверждения, и еще остались те кто не убрал эту штуку в настройках.

>IQ другие тянет, правда, они тормозные ужасно

IQ кванты требуют больше вычислительной мощности. Используй обычные Q для скорости.

Все таки гемма27 ахуенна по уму. Единственно что огорчает это мелкий контекст. Вот бы гугол тоже гемму 2.1 выпустил с нормальным контекстом

Похоже, мистрали 123B оче тяжёлые. А интересно, что будет адекватней, мистраль 128B в Q2 или gemma 27B в Q6? И ещё ггуфы с припиской "Uses Q8_0 for embed and output weights." лучше?

Двачую, а вот Big-Tiger-Gemma-27B не понравился, сразу начал бред нести и перескакивать на инглиш, жаль.

>Про этот потолок трансформерсов уже больше года твердять, а про "мультимодальное обучение" еще больше. Ебало каждый раз имаджинируется.

Ну так он и достигнут год назад. Просто год назад локалки даже близко к нему не были, а вот гопота 4 его уже щупала. Сейчас гопота об этот потолок уперлась намертво, а локалки только пощупывать начали.

>Уперлись в ограниченность данных (успешно эту проблему преодолевая)

Так проблема ограниченности данных именно от ограниченности трансформеров и происходит.

> гопота 4 его уже щупала

Опущ и сойнет передают мистеру гопоте пламенный привет.

> Сейчас гопота об этот потолок уперлась намертво

В ней нет прогресса со времен релиза четверки, если вести речь про публичные модели а не внутренние прототипы. Все что релизилось потом - ускорение после обрезания и апофезоз надрочки на примитивщину в малом размере.

> именно от ограниченности трансформеров и происходит

Ну камон, увидел громкую фразу и повторяешь ее как попугай лол, пытаясь выглядеть умным и не понимая что за ней стоит. Отучиться этому нужно было еще много времени назад после стольких опровержений.

Впереди мы увидим и развитие трансформерсов, и просто обучение без глубоких изменений с лучшим результатом. Новые архитектуры пока не показали достаточной перспективности и успешности, и если что-то и будет - высок шанс что в трансформерсы оттуда что-то перекочует для улучшения, а не произойдет замещение.

>А железо хостящих не показывают случаем?

Там когда раздаёшь указываешь настройки: макс размер генерации и контекста для хорды, вот эти две настройки и показывает в виде ошибки, если твои настройки выше, чем у воркера

>захуярят и быстрее загнутся, а на смену нормальные форки подъедут.

Зайди в хорду в таверне, увидишь зоопарк из 7В моделей с 1024 контекстом, она уже по сути мертва.

Я тут задумался, а насколько реально поднять блокчейн, к нему прикрутить форк хорды, в котором раздавать токены ха хешрейты генерации? Если к этому ещё докинуть готовый "майнер" и слегка пропиарить, могут набежать нормисы, желающие обогатиться и у анона не будет проблем с запуском моделей!

> вот эти две настройки и показывает

А хотябы токены в секунду или итсы для диффузии тоже отсутствуют? Если там кто-то вообще выставить на процессоре второй квант?

> а насколько реально

Если умеешь в кодинг и занимался реализацией каких-то проектов ранее - как нехуй делать. Ну точнее придется пол года рвать жопу и будут сложности на старте, но все реализуемо.

Только не хэшрейты а по сложности фактически сгенерированного. А то найдут как зааубзить, или будут хостить какой-нибудь никому не нужный но сложный треш.

> готовый "майнер"

?

>лучше?

Хуже, по дефолту выходные слои и эмбединги в 16 битах.

>Ну так он и достигнут год назад.

Based. Даже раньше, с учётом того, что четвёртую гопоту мариновали в застенках оленьАИ полгода минимум, пока достаточно не лоботомировали.

>Опущ и сойнет передают мистеру гопоте пламенный привет.

Просто достигли уровня четвёртой гопоты. Из преимуществ у них над гопотой сейчас только чуть больше согласия на ЕРП и несколько более красочные описания, а для дела они плюс минус сравнялись.

>Ну камон, увидел громкую фразу

Моя фраза, лол.

>Новые архитектуры пока не показали достаточной перспективности и успешности

Трансформеры начинались с GPT1, а он тот ещё бредогенератор.

Просто для показа преимуществ нужны ресурсы на порядок большие, чем располагают средние исследователи. А у меня так вообще 1 видеокарта, и та кривая, да и времени нихуя нет, 5 дней РАБоты и 2 дня отхожу от этого, и всё, неделя кончилась.

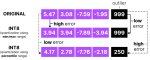

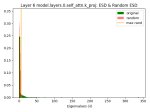

>я открывал одним старым анализатором лламу3, так он там рисует графики для некоторых слоёв, как будто они недообучены.

Анончики, простите за тупой вопрос - а как и из каких графиков можно понять, что модель недообучена? Пытаюсь вкатиться в нейронки по гайдам с ютуба. Киньте ссылку на гайд или хотя бы как это гуглить.

>а как и из каких графиков можно понять, что модель недообучена

Конкретно в их методе глазками сравнивают с рандомным распределением, с которым инициализируют слои. В итоге отличий почти нет, то есть обучали-обучали, а обучились только слои внимания. Литерали, атеншон из ал ю нид, пока выкидывать нахуй линейные слои.

>вкатиться в нейронки по гайдам с ютуба

Максимум тухлая идея, работает только с совсем имбицильскими темами, типа ремонта квартир.

Лучше запили себе венв да дрочись на эту статью https://nlp.seas.harvard.edu/annotated-transformer/ пока всё не поймёшь. Или вот для особо тупых в картинках https://habr.com/ru/articles/486358/

Спасибо за ссылки. На мой взгляд, топ-объяснение тут:

https://www.youtube.com/watch?v=bCz4OMemCcA&t=2779s

У этого чувака еще есть видео, где он набирает код Лламы с нуля, с объяснением, что какая команда значит.

>Конкретно в их методе глазками сравнивают с рандомным распределением, с которым инициализируют слои.

Гы, хитро. Но так-то наверняка же есть какие-то метрики, типа, уже обучились, или надо еще 100500 часов гонять машину. Это же деньги, кто-то наверняка же их обосновывает... или нет?

>Но так-то наверняка же есть какие-то метрики, типа, уже обучились

Лоссы.

>Это же деньги, кто-то наверняка же их обосновывает

Ага. Только вот давно уже доказали, что трансформеры надо обучать буквально в десятки раз дольше, чем сейчас. А прям недавно показали, что и х10000 раз могут дать преимущество, лол ( https://arxiv.org/html/2405.15071v2 ). И вот на это уж точно никто деньги не выделит.

Вот поэтому я ещё пару лет назад писал, что трансформеры уёбищны.

>трансформеры уёбищны

И что же надо использовать вместо них?

Трансформеры, лол. Точнее, сильно комбинированную архитектуру, типа для визуальной части вполне себе показательны свёрточные сетки, для хранения какой-нибудь информации так вообще лучше постгрю прикрутить. Я считаю, что пока в комбайне нейросетей этих сеток будет меньше 1000, AGI не построить.

> достигли уровня четвёртой гопоты

Ложь или предвзятое мнение. По сонету могут быть нюансы, но опущ радикально превосходит гопоту по знаниям, пониманию абстракций, рп и кодингу. Куда креативнее и живее решает даже простые задачи типа "перепиши пасту", для лингвистов - русский лучше. Шаг вперед серьезный, а что на бенчмарки не надрачивают - молодцы.

> начинались с GPT1

Вы находитесь здесь. К тому же, сейчас многие другие сетки начали использовать подобную архитектуру, что показатель.

> А у меня так вообще 1 видеокарта

Корону сними. Этим занимаются более квалифицированные люди, если там что-то будет то мы это увидим (в виде прокачки "мертвого" трансформера). Тем более, в опенсорс выкинут, скорее всего, даже раньше чем на полноценное коммерческое использование.

> да и времени нихуя нет, 5 дней РАБоты

Это повод быть аккуратнее в рассуждениях и не вещать новую истину. А то рили как в карикатуре получается.

> с рандомным распределением, с которым инициализируют слои

Разве там сид фиксирован? Случайные данные можно сравнивать по распределениям и критериям, с тем же успехом можно и полезные данные шумом назвать. Есть где почитать за их методики?

>но опущ радикально превосходит гопоту по знаниям, пониманию абстракций, рп и кодингу.

Предвзятость )) Ну блин, нет там ничего радиКАЛьного. Лучше? Да. Сильно? Да нихуя подобного. Кроме РП, да, но видимо оно у тебя и потянуло восприятие всего остального эффект ореола передаёт привет.

>тому же, сейчас многие другие сетки начали использовать подобную архитектуру, что показатель.

Показатель того, что даже в МЛ есть такая хуйня, как мода, лол.

>Корону сними.

Nyet.

>Это повод быть аккуратнее в рассуждениях

Эм, поясни за цепочку рассуждения. Как у тебя моя занятость перешла в "нужно заткнуться и слушать авторитетов, тупая ты свинья".

>Случайные данные можно сравнивать по распределениям и критериям

Ну да, я упростил для новичка. В прошлых тредах обсуждали, вот статья, если ты пропустил

https://ar5iv.labs.arxiv.org/html/1810.01075

Да уж, что-то локалки сосут опять. Phind даже с простыми задачками не справляется, которые 4o мини щелкает как орешки.

Как там новая ллама 3.1 по итогу, норм? Ебет гемму хотя бы?

Как там новая ллама 3.1 по итогу, норм? Ебет гемму хотя бы?

>На мой взгляд, топ-объяснение тут

Лол, буквальный пересказ статей из моего поста

Ну собственно доказательство того, что текст всегда первоисточник, а видео это трижды переваренный кал.

>Phind

Какая-то хуйня. Хуйню выбрал, хуйню получил, на что жалуешься то?

> Какая-то хуйня

Ньюфаг, плиз. Если нихуя не знаешь, не нужно отвечать.

Пацаны, что за рп и ерп? Роль плей? Что-то оно постоянно в обсуждении, а где тема для вката непонятно и никаких подробностей нет.

Как на 3.1 перетренят, так и приходи.

>Лоссы.

Если я правильно понимаю это всё, то лоссы говорят буквально ни о чём. Может быть ситуация, когда один слой недообучен, а другой оверфитится. Но обучаемые слои могут компенсировать ошибку оверфитнутого, по графику лоссов не будет видно.

А картиночки это так, для простоты восприятия.

Всё-таки проще смотреть на спектрограммы, чем ломать глаза в таблицах.

Ролеплей и эротический ролеплей.

Я правильно понял, тут вычислили какой-то показатель альфа, если он меньше 2, то слой переобучен, а если больше - недообучен? А дай ссылку на всю статью.

>где тема для вката непонятно и никаких подробностей нет.

В шапке есть ссылка на шапку Пигмалион-треда, наш тред по-сути его наследник.

Вкратце - ты можешь заставить нейронку отыграть что-угодно и кого угодно, подсунув ей правильно написанную карточку.

Этот тред на острие технологий, локальная виртуальная вайфу всем и каждому, никто не уйдет обиженным.

https://www.nature.com/articles/s41467-021-24025-8

https://jmlr.org/papers/v22/20-410.html

Читай тут, пока не заебёшься. Иногда андерфитные слои могут на самом деле просто терять информацию, потому нужно смотреть по всем метрикам сразу.

Зирошотодрочение достигло новых высот, а не годнота.

>Ньюфаг, плиз.

Шиз, таблы. Использовал бы perplexity.ai, раз всё равно на подсосе

>Если я правильно понимаю это всё, то лоссы говорят буквально ни о чём.

Ну так с другой стороны, самая быстрая и простая метрика. Если лоссы пошли по пизде, это точно значит, что модели плохо.

>Но обучаемые слои могут компенсировать ошибку оверфитнутого, по графику лоссов не будет видно.

Дерьмо случается, да.

Респект, т.е. нейронка может это делать сколь угодно долго, насосы на ограниченный контекст?

Пасиба, пошел читать. А вот еще такой вопрос. Механизм аттеншена по сути предсказывает вероятность токена исходя из наличия других токенов вокруг. Каким образом это приводит к тому, что нейронка начинает связно отвечать на осмысленные вопросы, делать какие-то выводы и т.п.? Я видел популярные статьи, в которых написано, что такая магия случилась после увеличения количества параметров больше определенной величины. А есть ли где-то более детальный разбор этого феномена? Буду благодарен на ссылки на статьи.

Интересная тема, а ведь боты ещё лет 10-20 назад тоже могли вести связный разговор и это работало.

>нейронка может это делать сколь угодно долго, насосы на ограниченный контекст?

Ну, нет, потому у нас шапкой каждого треда является "50 первых поцелуев", лол. Но однажды мы достигнем этого. Когда кто-нибудь придумает долговременную память. А пока суммаризируем контекст и вылавливаем залупы свапами пытясь протянуть подольше.

> Сильно? Да нихуя подобного

Достаточно сильно, оно буквально стало отлично понимать что от него требуется без упоротого разжевывания, причем зирошотом.

> восприятие всего остального

Пост перечитай и еще раз сними корону "самого непредвзятого знатока".

> как мода

Рациональность, какая мода. Выбор проверенного и изученного решения с объективными достоинствами вместо менее примечательных не имеет ничего общего с ней. Можно безальтернативность пытаться присрать, но никак не моду.

> Как у тебя моя занятость

Пишешь что занимаешься другим а этим увлекаешься пару часов в неделю под пиво, и некоторые фразы позволяют идентифицировать как далекого от сферы и околонауки. Но при этом вместо рассуждений/гипотез с подкреплением или объяснением их просто выносишь громкие постулаты за которым ничего не стоит.

Очень напоминает скуфа, который после смены батрачества на проперженном диване рассуждает и о мировой политике, и о спорте, и о науке, всех критикуя и говоря "вот я бы если занимался то все сделал бы лучше". Чуть приукрасил, но примерно так, если говоришь - то говори сразу предметно а устаревшее брюзжание.

> нужно заткнуться и слушать авторитетов, тупая ты свинья

Это уже ты сам придумал.

> https://ar5iv.labs.arxiv.org/html/1810.01075

Много, надо будет посмотреть, возможно хайденгем. В чем там общая суть, просто оценивают величины, или хотябы сравнивают спектры собственных гармоник?

Главное, насколько их метрики обоснованы и могут быть экстраполированы на актуальные модели?

>ряя, аги не будет!

Лол, аги уже тут, вы просто не умеете его готовить кормите калом.

Мимо из 2027-го

>оно буквально стало отлично понимать что от него требуется без упоротого разжевывания

Сейчас с этим 8B локалки справляются, лол. И гопота тоже не требует жевать, а килобайтные джейлы сейчас нужны для анценза да выпиливания пурпур прозы.

>и еще раз сними корону

Nyet. Я только ради этого и живу. Надо же хоть в какой-то сфере быть лучше среднего, а то проще будет выпилится.

>Выбор проверенного и изученного решения с объективными достоинствами

Лол, ты сам написал, что сейчас трансформеры пихают куда ни попадя. Это полная противоположность рациональности. Рационально это использовать трансформеры для текста, тут да, 0 вопросов, проверено и надёжно (нет). А вот когда трансформерами распознают картинки, делают звуки и прочее, это уже экспериментальное, а не надёжное и проверенное. Может выстрелит, может нет.

>а этим увлекаешься пару часов в неделю под пиво

Как и все остальные в этом треде. Проф работников МЛ я ИТТ треде ещё не видел.

>Очень напоминает скуфа

Я и есть скуф, да. И горжусь этим, специально волосы выдираю, чтобы ещё сильнее на скуфа походить.

>Это уже ты сам придумал.

Просто развил твою мысль, без прикрас и цензуры. Благо мы тут на имиджбордах, можем себе позволить посылать друг друга нахуй (но пока не хочу если что, ты хороший собеседник).

>В чем там общая суть

Я сам статью не читал, её другой тредовичок принёс.

> Сейчас с этим 8B локалки справляются

Не тот уровень.

> только ради этого и живу

Это манямир, который мешает реальному успеху, отбрасывай и сразу (нет) все пойдет.

> А вот когда трансформерами распознают картинки

Назовешь примеры более подходящей архитектуры? Vit де факто - индустриальный стандарт, даже хз что там еще есть, но если интересное то даже попробую, особенно если оно

> надёжное и проверенное

Другой уже не свежий, но актуальный пример - DAT. А на этом фоне у нас тут уже трансформер на помойку отправлять надо, звучит правдоподобно.

> Как и все остальные в этом треде.

Зря, на самом деле кроме некоторых особенных все достаточно сдержанные и пытаются разбираться в теме. И тред не про душнил млеров, живуших в 117метром пространстве пасхалка а про сеансы нейрокума под соусом пердолинга.

> Я и есть скуф

Дело не в возрасте а в подходе к жизни, когда вместо превозмогания лишь коупинг - оварида.

> Просто развил твою мысль

Вообще не про это, если так триггернулся на "более прошаренных" - это аргумент про складывающиеся реалии где пчелы не против меда и идет развитие.

>который мешает реальному успеху

Лол, например?

>Назовешь примеры более подходящей архитектуры?

Свёрточные сети, старые и проверенные.

>Зря, на самом деле кроме некоторых особенных все достаточно сдержанные и пытаются разбираться в теме

Ну да. Но это не делает их спецами. И я тоже не спец, ага. Но свои идеи и мнение имею, и просто выражаю его, делюсь с остальными идеями и прочим.

>живуших в 117метром пространстве

Давно эмбедингов размерностью менее 300 не видел.

Да, действительно, размерность эмбеддингов в современных моделях обычно намного больше 117. Я упомянул 117 скорее как абстрактный пример небольшого размера.

> Шиз, таблы. Использовал бы perplexity.ai, раз всё равно на подсосе

Ебанутый дебил, тебя попросили НЕ ОТВЕЧАТЬ, зачем ты отвечаешь?

>Если лоссы пошли по пизде, это точно значит, что модели плохо.

Просто мне кажется, что без детального мониторинга каждого слоя трейн будет всратым. Хотя не мне о таком переживать, один хуй нет мощностей что-то тренировать.

По вниманию есть овердохуя статей.

https://arxiv.org/pdf/1706.03762

>В чем там общая суть

>При отсутствии данных обучения и тестирования очевидными величинами для изучения являются матрицы весов предварительно обученных моделей, например, такие свойства, как нормы матриц весов и/или параметры подгонок степенного закона (PL) собственных значений матриц весов. Метрики на основе норм использовались в традиционной статистической теории обучения для ограничения емкости и построения регуляризаторов;

>В-третьих, метрики на основе PL могут гораздо лучше прогнозировать тенденции качества в предварительно обученных моделях

>В частности, взвешенный показатель PL (взвешенный по логарифму спектральной нормы соответствующего слоя) количественно лучше различает ряд хорошо обученных и очень хорошо обученных моделей в пределах заданного ряда архитектуры; а (невзвешенный) средний показатель PL качественно лучше различает хорошо обученные и плохо обученные модели. В-четвертых, метрики на основе PL также могут использоваться для характеристики мелкомасштабных свойств модели, включая то, что мы называем потоком корреляции по слоям, в хорошо обученных и плохо обученных моделях; и их можно использовать для оценки улучшений модели (например, дистилляции, тонкой настройки и т. д.)

>Просто мне кажется, что без детального мониторинга каждого слоя трейн будет всратым.

Ну так оно и есть, см. любую модель. Всё криво-косо. Так и живём.

>По вниманию есть овердохуя статей.

>https://arxiv.org/pdf/1706.03762

Я, наверно, не очень хорошо сформулировал вопрос. В этой статье описано, грубо говоря, первые эксперименты с трансформером, где он как-то там переводит с английского на немецкий. Вопрос, что с ним сделали, что он начал умничать, цифры складывать и делать какие-то выводы?

> Лол, например?

Берешь любого относительно успешного человека (пока он не скурвился) и находишь умеренное или минимальное количество манямира и всезнайство. Может быть снобизм и выебоны, но это только у совсем молодых шутливых, или застамелых, в обоих случаях он преодолим.

> Свёрточные сети, старые и проверенные.

Модель для распознавания/классификации картинок, выполненная целиком на сверточных покажешь?

> это не делает их спецами

Обладателей степени по нейрокуму хватает. Ну рили если бы просто выражал и говорил "пмсм трансформерсы говно и вот почему" то и вопросов не было, а тут лишь похожее на то что выше описано.

> эмбедингов размерностью

Это про высокую математику и альма матер.

Спасибо нейротекст или сам писал?. В целом чтиво интересное, но пока сомнений в применимости критерииев к слоям большой ллм точно также без коррекций хватает.

Вообще, косвенно проверить это можно добавлением этой метрики при обучении и дополнительных этапов/техник на их основе. Даже если не работает в полной мере, может дать буст и расшевелить покруче дропаутов.

>Вопрос, что с ним сделали, что он начал умничать, цифры складывать и делать какие-то выводы?

Накидали больше слоёв и параметров.

>и находишь умеренное или минимальное количество манямира и всезнайство

Эм, у меня вопрос был, как мне оно мешает и на что я могу рассчитывать, если вдруг мне ёбнет кирпичом по голове и я избавлюсь от короны.

>выполненная целиком на сверточных

Откуда появилось такое условие? Там всегда были полносвязные слои, ещё когда трансформеры под стол пешком ходили.

>и вот почему

Да я заебался пояснять просто, 70 тредов уже, я с первого сижу. Пора уже свой банк паст делать на все случаи жизни.

К слову, по поводу того, на сколько теория состоятельная

>I originally invented this tool and the theory behind it because I’m a consultant and that’s exactly what I would do— I would travel to New York and Chicago or Los Angeles with my laptop and help them build models

>I originally came up with this when I was working with a client in Slovenia

>I’ve developed AI in machine, learning models for some of the largest companies in the world. eBay. Walmart, Blackrock, even Google.

>and we have a prototype for optimizing the learning rate but that’s not available yet that will probably be in the commercial version

Напрягает только сфокусированность его на свёрточных сетях, хотя про гроккинг, трансформеры и т.д человек в курсе. Хотя перестал писать про анализ ллм после первой лламы и фалькона. Лламу он засрал, фалькон похвалил, если это важно. И странно, что после блекрока пишет "даже гугл", гугл после блекрока как щеночек рядом с волкодавом.

>Так и живём

Вообще, неизвестно, как происходит тренировка у корпоратов, может, и с мониторингом каждого пука. Если нет, то можно выжать ещё немного из существующих моделей изменив процедуру тренировки.

Да он, вроде, и не начал. Можешь ещё тут посмотреть

https://colab.research.google.com/github/tensorflow/tensor2tensor/blob/master/tensor2tensor/notebooks/hello_t2t.ipynb

Самый интересный кусок это Display Attention.

>нейротекст или сам писал?

Нейроперевод. На маленьких моделях это стабильно работает.

>I originally invented this tool and the theory behind it because I’m a consultant and that’s exactly what I would do— I would travel to New York and Chicago or Los Angeles with my laptop and help them build models

>I originally came up with this when I was working with a client in Slovenia

>I’ve developed AI in machine, learning models for some of the largest companies in the world. eBay. Walmart, Blackrock, even Google.

>and we have a prototype for optimizing the learning rate but that’s not available yet that will probably be in the commercial version

Напрягает только сфокусированность его на свёрточных сетях, хотя про гроккинг, трансформеры и т.д человек в курсе. Хотя перестал писать про анализ ллм после первой лламы и фалькона. Лламу он засрал, фалькон похвалил, если это важно. И странно, что после блекрока пишет "даже гугл", гугл после блекрока как щеночек рядом с волкодавом.

>Так и живём

Вообще, неизвестно, как происходит тренировка у корпоратов, может, и с мониторингом каждого пука. Если нет, то можно выжать ещё немного из существующих моделей изменив процедуру тренировки.

Да он, вроде, и не начал. Можешь ещё тут посмотреть