ОП, ты прям вовремя! Продублирую новость для колабоюзеров:

Сука, как же у меня сегодня сгорела жопа от Убы...

Чтоб упростить жизнь юзерам он сделал автоустановку через пусковой файл. И всё бы ничего, но все зависимости ставятся сразу в ебучую Конду, а это значит что просто строчкой кода установить требования для конкретного дополнения нельзя... вернее можно, но конда должна быть уже установлена, а устанавливается она с запуском вебуи, когда уже поздно заранее что-то устанавливать

Есть выход - можно указать автоустановку дополнений. НО, у этой ебанины нет команд на установку конкретных дополнений, либо всё, либо ничего. А всё ставится около 1,5 часов...

Но оказалось что список дополнений для установки он берёт из имён папок в папке extensions. И я придумал гениальное быдлокодерское решение: выпиздить их от туда нахуй и вернуть только те дополнения, что нужны!

Теперь всё снова работает адекватно, пользуйтесь - ни в чём себе не отказывайте!

Первый блок теперь только грузит модели, а второй устанавливает и запускает, но установка идёт только один раз, можно смело перезапускать.

Сука, как же у меня сегодня сгорела жопа от Убы...

Чтоб упростить жизнь юзерам он сделал автоустановку через пусковой файл. И всё бы ничего, но все зависимости ставятся сразу в ебучую Конду, а это значит что просто строчкой кода установить требования для конкретного дополнения нельзя... вернее можно, но конда должна быть уже установлена, а устанавливается она с запуском вебуи, когда уже поздно заранее что-то устанавливать

Есть выход - можно указать автоустановку дополнений. НО, у этой ебанины нет команд на установку конкретных дополнений, либо всё, либо ничего. А всё ставится около 1,5 часов...

Но оказалось что список дополнений для установки он берёт из имён папок в папке extensions. И я придумал гениальное быдлокодерское решение: выпиздить их от туда нахуй и вернуть только те дополнения, что нужны!

Теперь всё снова работает адекватно, пользуйтесь - ни в чём себе не отказывайте!

Первый блок теперь только грузит модели, а второй устанавливает и запускает, но установка идёт только один раз, можно смело перезапускать.

>И я придумал гениальное быдлокодерское решение

Если оно выглядит как костыль, но при этом работает, то это не костыль, а фича.

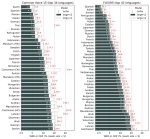

Nvidia выпустила мультимодальную модель ИИ с открытым исходным кодом, и она не уступает GPT-4

https://3dnews.ru/1111889/nvidia-predstavila-nvlm-10-semeystvo-multimodalnih-modeley-ii-s-otkritim-ishodnim-kodom

Уже затестили?

https://huggingface.co/nvidia/NVLM-D-72B

https://3dnews.ru/1111889/nvidia-predstavila-nvlm-10-semeystvo-multimodalnih-modeley-ii-s-otkritim-ishodnim-kodom

Уже затестили?

https://huggingface.co/nvidia/NVLM-D-72B

>Если оно выглядит как костыль, но при этом работает, то это не костыль, а фича.

Вы вообще читаете перед тем как кидать ссылки сюда? Это визуальная модель и тесты там только визуальные, с 4о сравнивают, которую уже все по визуалу ебут.

>Это визуальная модель

Это мультимодальная модель и по тексту ее сравнивают с ламой, клодом и джемени.

Тут вот еще тесты от самой нвидии https://research.nvidia.com/labs/adlr/NVLM-1/

>Nvidia выпустила

Хоть одна достойная модель от них была?

>/usr

там всё равно ничего полезного, как темпы в винде.

> которые летают на железе десятилетней давности

Сильное заявление. Сейчас бы создать проблему а потом ее героически решать, выпуская упоротые технологии и строя невозможные ситуации для того чтобы показать как они хороши.

> а это значит что просто строчкой кода установить требования для конкретного дополнения нельзя... вернее можно, но конда должна быть уже установлена, а устанавливается она с запуском вебуи, когда уже поздно заранее что-то устанавливать

Там есть отдельный ярлык для венва и отсылка для установки реквайрментсов экстеншнов. Чето ты вообще не то делаешь.

А, тут коллабопердолинг, увы. Предлагаю следующее решение - ставить все не через конду а классическим вэнвом, залив свой простой скрипт. С ним все прекрасно работает пол года назад точно работало, а конда нужна чтобы иметь нужный питон и подсосать куда-тулкит + либы вне зависимости от платформы, все равно все основное через pip ставится. Если оно уже есть или тем более там линукс со всем установленным - нахуй не нужна.

Ну, в 4 битах может и запустится. Только оно 99% не сможет в нсфв и на этом большинство юскейсов кончается, лол.

>Хоть одна достойная модель от них была?

гемма?

Она разве не от гугла? Это ж Gemini порезанная, не?

>Только оно 99% не сможет в нсфв

Вот меня тоже этот момент интересует.

Мы ещё про Molmo ничего не выяснили, лол.

>Предлагаю следующее решение - ставить все не через конду а классическим вэнвом, залив свой простой скрипт.

А ничего что в этом случае обновления убы в колабе начнут слетать по кд? Потому что автор решил что всё должно ставится через скрипт и забил на обновление реквайментса.

>Чето ты вообще не то делаешь.

Перестал делать буквально сегодня.

Сука, сколько же я накумил из-за этого со вчерашнего дня. Гейм чейнджер. Удалил русский текст в скрипте, из-за чего возник один нюанс. Из-за того что мысли пишутся от первого лица РП тоже продолжается от первого лица где-то а 25% случаев, хотя терпимо.

>Потому что автор решил что всё должно ставится через скрипт и забил на обновление реквайментса.

Вы там какие вещества употребляете?

Спокойно всё ставится и обновляется в 3-4 команды без ебучего bloatware под названием конда

> А ничего что в этом случае обновления убы в колабе начнут слетать по кд?

С чего бы?

> Потому что автор решил что всё должно ставится через скрипт

Который просто и делаешь что обращается к реквайрментсу. Внезапно, да? И обновляются они регулярно.

Многие вообще специально держат убу не кондой а на классическом венве и все прекрасно работает.

Нах тебе этот пердолинг, когда можно просто шаблоном всё это сделать, а нормальные модели чисто по системному промпту нагенерят мысли/планы.

Попробуй не просто убрать примеры, а заменить их примером на английском языке в третьем лице. У меня по опыту структура примера влияла на ответ сильнее, чем основная инструкция.

ты уверен что тебе в колабе вообще этот комбайн нужен? гонял бы жору голого да и все

Хотя даже не уверен, какими аналогами тогда это заменить. Типа добавить ко всему префикс аля "Alice thinks that"? Прямо сейчас нет времени особо потестить.

Условно можно попробовать заменить:

Боб так нежно смотрит на Еву... Я чувствую, как моя грудь сжимается от ревности.

На:

Alice watched Bob gazing at Eve with tenderness. She felt her chest tighten with jealousy.

Или:

Alice thinks that Bob is looking at Eve so tenderly. She feels her chest tightening with jealousy.

лол, ну это уже приближается к рофлу с перловым скриптом, который делал то же для /

по этому докер наше все...

щас, только H200 свои расчехлю и сразу тестить

>я, запускающий 123B на проце и видяхе 12гб

Ну да ну да, пошёл я нахуй.

Qwen2.5-Coder-7b?

Это так, которая недели две назад выходила, а потом зашла? :)

Которая плюс-минус Qwen2-VL-72b?

Который вышел месяц назад?

Ух ты, вот это реакция!.. =)

Мистраль Немо? =D

Я погонял вчера Молмо-72б и 7б — таки могут в нсфв, но 7б моделька плоха на русском, ибо пары картинка-описание были на инглише.

А че там выяснять.

https://huggingface.co/SeanScripts/Molmo-72B-0924-nf4

Пиха в две теслы.

Выше написал — нсфв могет, но малая в русском плоха, а вот большая нормас.

Но ролеплеить я не пытался с ней.

В 4 бита может и влезть на две теслы (а может и не влезть=).

Qwen2-VL-72b у меня впихнуть не вышло. А мольмо вошла без проблем.

Контекст в квене не влазил. Ограничить не вышло никак.

>Но ролеплеить я не пытался с ней.

Ну так попробуй. А то на сайте анальная цензура и требование картинки (а то может я без пикчи хочу).

ты ж не забывай, что мультимодалки не квантуются по человечески, в лучшем случае bnb, и при таком раскладе нельзя частично выгрузить...

я ламу пытался в колабе запустить - 11В только в 4 кванте заводится, на ЦП вообще не смог завести, но не отрицаю что может я криворукий... а обычные текстовые конечно можно на чем угодно запустить...

>требование картинки

Кидай модели фотку хуя

>В 4 бита может и влезть на две теслы

пока не сделают нормальной возможности частично грузить в гп или чисто на ЦП гонять мультимодалки будут не для каждого...

> что мультимодалки не квантуются по человечески

Зависит от архитектуры. Большая часть нормально так же квантуется как и все прочие трансформеры, если там прям не насрано чем-то совсем. Оно просто нахуй особо никому не надо было квантовать что-то до последнего времени.

>пока не сделают нормальной возможности частично грузить в гп или чисто на ЦП гонять мультимодалки будут не для каждого...

Ну тут или найдутся новые люди чтобы пилить поддержку в лламацппвлс, или сидеть бибу сосать. Или изучать всю хуйню и идти делать самому.

Скорее последнее... ну или привет передавать Бибу Ясосу

пока что рабочие кванты тьлько на bnb или GPTQ, второе нормально не работает - спасибо кривым трансформерам, где старые не поддерживают квен, а новые не совместимы с либой для кванта,

тот что остается рабочим вариант внезапно с выгрузкой в оперативу не совместим... надо что-то типа жоры с гуф квантами, которые отовсюду работают нормально

> в колабе

> жору голого

Пиздец.

И нет бы проявить уважение к добрейшему человеку, что поддерживает в живых эту дичь, такие ахуительные советы.

К сожалению тут так, жора не может в мультимодалки кроме всякого треша.

> таки могут в нсфв

Насколько? Просто "там sexual intercourse" или "big fat cock of left guy with messy red hair penetrates vagina of girl with a naughty expression while veiny penis of second boy who is positioned above them are inserted deep into her anus, there is a splashes of cum and other body fluids around girls crotch"?

> моделька плоха на русском

Вот уж где это суперпохуй так именно здесь.

> мультимодалки не квантуются по человечески

Им вообще пофиг как квантоваться, проблема в отсутствии ориентированных на эффективный-быстрый инфиренс или бюджетный запуск лаунчеров.

>ты ж не забывай, что мультимодалки не квантуются по человечески

Ну так пускай жора допиливает. Или кто-нибудь его уровня. Главное чтобы на процею

Там цензура даже на буквы, за фотку моего хуя меня засмеют точно забанят.

>где старые не поддерживают квен, а новые не совместимы с либой для кванта

Надо пилить франкенштейна же.

Им вообще пофиг как квантоваться

та понятное дело что пофигу в какой формат записать, только ж запустить нечем, только трансформеры...

>Ух ты, вот это реакция

Тем не менее в тредах она не обсуждалась. Интересны ее возможности и ограничения. Самому железо не позволяет.

>Надо пилить франкенштейна же.

я так и не смог проверить такой тип квантования вообще на ЦП реально выгрузить... но надеюсь оптимайзера пофиксят и он не будет старых трансформеров просить, тогда узнаем...

> спасибо кривым трансформерам, где старые не поддерживают квен, а новые не совместимы с либой для кванта

Поставь дев версии и того и другого, скорее всего все заработает. Или там нужно будет мелкие правки сделать. А вот нормальной выгрузки там особо и не будет, это увы.

С сожалением узнал о существовании FlashAttention 3, которое работает в 1,5-2 раза быстрее второй версии, но хочет Хоппер:

https://tridao.me/blog/2024/flash3/

Походу 50-я серия может дать существенный прирост ещё и по этой причине. В 40-й не уверен, а 50-я должна это поддерживать.

https://tridao.me/blog/2024/flash3/

Походу 50-я серия может дать существенный прирост ещё и по этой причине. В 40-й не уверен, а 50-я должна это поддерживать.

>но хочет Хоппер

Ебать запросы конечно же.

>Походу 50-я серия может дать существенный прирост

Если не порежут дровами, лол.

Интересная штука, анон, спасибо за твой труд. Мне, кстати, больше понравилось, когда мысли по умолчанию скрыты (без "open" в теге) - это более иммерсивный подход ты же не можешь читать чужие мысли ИРЛ, который всё так же помогает ИИ-шке лучше структурировать свой отыгрыш. Ну и как бонус можно потом открыть эти спойлеры и ретроспективно посмотреть, что творилось в голове у персонажа.

Даже если завезут в 50xx нужные штуки в железе, то нормальной поддержки в софте ждать придется с года полтора как обычно.

Интересно, а есть ли в таверне возможность не просто вырезать текст по регекспу, а, например, находить по нему сообщения и исключать их из промпта.

Если у меня есть какая-то информация, доступ к которой я хотел бы дать модельке в карточке. Но при этом чтобы она не слишком зацикливалась на ней, просто было рядом, чтобы она могла черпать оттуда инфу.

Куда это лучше всего записать в таверне? В правила мира или в карточку самого персонажа?

Куда это лучше всего записать в таверне? В правила мира или в карточку самого персонажа?

Там с HBM вариант, но карта на 16 гигов получается дороже 30к. Учитывая кучу других подводных мне это не кажется выгодным.

>Сильное заявление.

У 3d mark есть тест на мешлеты. Сами по себе они ультрабыстрые, скорее всего, у свини есть фича с освещением, которое просчитывается уже для детализированной геометрии. Что позволяет уничтожать перформанс на любой карте.

Рулбук используй, не?

>гонял бы жору голого да и все

Зачем же голого? Есть Кобольд, прекрасно себя чувствует и мозги не ебёт. Сам им часто пользуюсь чтобы проверять новые модели, т.к. ставится быстрее.

Главный минус в том, что квант больших моделей будет на единицу меньше + Жора.

Могу выкатить либо как одельный колаб, либо запихать всё в этот для полной шизы надо?

Ок. Хотите разбираться, почему интерфейс срёт ошибками при установке через реквайментс? Я нет.

>С чего бы?

Самому любопытно, но слишком впадлу в этом говне копаться. А даже если бы и нет, лучше скрипт автора, который будет обновляется вместе с убой, чем свой, который надо будет править в ручную.

>Ок. Хотите разбираться, почему интерфейс срёт ошибками при установке через реквайментс? Я нет.

Когда ебешься с нейронками на постоянке это уже рутина тупо.

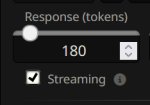

Как заставить его писать больше? Иногда начинает по 2 унылые строчки выдавать и хоть загенерируйся он по 100 токенов выдает и выдает.

>это уже рутина тупо

>@

>написанием скриптов занимаются 1,5 анона

Спасибо большое, анон, ток гугл транслейт не работает что-то.

> Насколько?

Где-то между.

Может быть промпты это исправят в пользу второго.

Вообще, условно 7b-4bit можно запустить на 12 гигах, тащемта. Дерзайте.

Оке, я посмотрю седня-завтра, может в ней есть что-то хорошее.

Если заведется.

ну чё кто ещё на амуде ёрзает? если кто то думает брать то надо внимательно смотерть сюда https://rocm.docs.amd.com/projects/install-on-linux/en/latest/reference/system-requirements.html#supported-gpus

понтдерживаются только топчик карты иначе можн объебатца

понтдерживаются только топчик карты иначе можн объебатца

Сейчас проверил, вроде работает. Правда звук генерит долго, но тут я уже ХЗ.

Кстати насчёт тоннелей, можето только у меня такое, но через ВПН все работают нормально, а без него интерфейс виснет намертво. Возможно в Градио и Нгроке российские ИП забанены Локалтоннелю похуй, но он сам по себе падает регулярно

>понтдерживаются только топчик карты иначе можн объебатца

А instinct mi50?

написано што депрекатед

>Deprecated - The current ROCm release has limited support for this hardware. Existing features and capabilities are maintained, but no new features or optimizations will be added. A future ROCm release will remove support.

через перевочик сам прогониш яна деюсь

ого а ето оно ещё и звук может делать! я тока текст(llm) делал, хотел делать картинки нос табле дифужон хер поставиш на линуксе да ещё и с амудой

>silero_tts

>Расширение преобразования текста в речь с использованием Silero.

>хотел делать картинки

Если юзаешь таверну, там есть хорда для генерации картинок. Нормального ничего конечно не выдаст, но для поиграться вполне.

Короче говоря - Все ясно, самая доступная Pro VII депрекейтед уже...

и не поддерживается винда...

> Сами по себе они ультрабыстрые

Если сравнивать с вариантами заведомо кривой реализации альтернатив игнорируя возможные оптимизации. https://www.youtube.com/watch?v=M00DGjAP-mU

> Ок. Хотите разбираться, почему интерфейс срёт ошибками при установке через реквайментс? Я нет.

Не то чтобы, но в целом интересно. Там ошибкам вроде и неоткуда взяться, на каком этапе серит? Готовое офк лучше, просто ты же жаловался что он не ставит нужное.

> Где-то между.

Ну типа она хорошо "видит" все это но стесняется описывать, или в чате может разговаривать на релейтед темы но при этом скипает восприятие важных деталей останавливаясь на общем?

Если не впадлу, можешь прогнать несколько жестких пикч и куда-нибудь с описанием залить? А то тащить эту штуку чтобы в итоге разочароваться очень не хочется.

>>написанием скриптов занимаются 1,5 анона

А мои скрипты это для кого-надо скрипты. я ебал выкладывать какие-то скрипты/код/проекты и поддерживать их потом смотря каждый день на предъявы рандомных людей что всё не так как надо им и автор пидарас выпей йаду, и таких так же ебавших этим заниматься тут и на доске много

Не думал экстеншен написать на это дело? Я вот думаю, мб самому упороться и заняться этим, но хз как процесс пойдёт, фронтендер из меня не ахти.

Тупой вопрос, но как ллм работают на самом низком уровне? Там толе перемножение матриц?

> >написанием скриптов занимаются 1,5 анона

Блять ну не настолько же. Хоть васянов, сектантов или поехавших тут много, таки тех кто основные вещи знает и практикует наберется порядочно хотя иногда кажется что это не так.

двачую, кто может тому мало мотивации стараться ради неблагодарных маргиналов, заняться есть чем.

Да. Множество операций линейной алгебры на выходе дает вектор длинною в словарь, значения которого соответствуют предсказанной вероятности следующего токена. Из этого вектора с помощью семплинга ты выбираешь следующий токен и запускаешь цикл по новой.

> ради неблагодарных маргиналов

Какой нынче анон нежный пошел, кек

така нах она нужна кокда есть бомжесвеная 7900xtxtxtxt

ну да, 8к рейхсхривен и 40к что-то как-то большая разница... или ты про какую-то другую 7900?

>на предъявы рандомных людей что всё не так как надо им и автор пидарас выпей йаду

Ога, а ещё дохуя умных лючностей, которые знают как надо и легко могут лучше тебя, но не будут, потому что

>мои скрипты это для кого-надо скрипты.

про неё радимую, вот я лохонулся конечн взял хт с 20гб а надо было брать хтхтхт с 24гб памяти кто ж знал что ети нееросети расцветут так я думал ето всё пузырь как с крипой было

я хз у нвидии есть чтото доступнее?!

Мне ебли такой и на работе хватает, ещё не хватало бесплатно еблей ещё хуже страдать. Пару раз хватило впопенсурсом и выкладыванием штук для анонов позаниматься, спасибо больше не хочу, если прям интересно не станет или что-то полезное точно не сооружу случайно.

>тут много, таки тех кто основные вещи знает и практикует наберется порядочно хотя иногда кажется что это не так.

Да тут на самом деле бывают, в ридонли и не очень, очень порядочно шарящие люди вплоть до всяких личностей из меты и прочего фаанга.

Если наглядной базовой инфы хочется, то можно потыкать сюда https://bbycroft.net/llm

>рейхсхривен

орнул)

Не забывай что нытье и плохие отзывы лезут активно, а похвалы и благодарности почти всегда умалчивают. Если что-нибудь интересное обнаружил/сделал и т.д. - делись хотя бы концепцией, кто шарит уже сам воплотит без сильного попрошайничества и предъяв, или просто обсудить можно.

Кек, база.

Еще и жопы подорвал. =)

Тут проблема в том, что если дело касается чего-то простенького, зачастую и делиться нечем.

Скриптики тебе квен напишет без проблем, но многие аноны из раза в раз приходят в треды и ноют «я хочу сделать такое, но не могу!», хотя на деле ровно наоборот: могут, но не хотят достаточно.

А если сделать для них — так еще и говна нальют.

Как бы, тут все на поверхности лежит, просто люди ленивые. Думаю, автора изначального коммента это и демотивировало напрягаться ради кого-то.

> Ну типа она хорошо "видит" все это но стесняется описывать, или в чате может разговаривать на релейтед темы но при этом скипает восприятие важных деталей останавливаясь на общем?

Я не тестил глубоко. Покидал картинки — она их описала. Попросил дать пошлый коммент — ну, как смогла, написала, немного репетишн, но по смыслу верно.

Мольмо — это же Квен2, он в базе не про книги и художественные тексты, поэтому и она в итоге пишет так себе.

РП без картинок со старта не пробовал, ща домой дойду и попробую, почекаю немножк.

Я бы многого не ждал в принципе, то что она описывает и не стесняется давать комментарии — уже хорошо само по себе. Но для полноценного мультимодального рп нужна в начале нецензурная модель (а квен2 цензурирован все же), или хотя бы аблитерированная, а уже поверх дообученные на картиношки. И то, это прям край. А по-хорошему полноценная мультимодалка с нуля и без цензуры.

Мольмо — все же пруф оф концепт, что можно сделать новым методом.

>Скриптики тебе квен напишет без проблем, но многие аноны из раза в раз приходят в треды и ноют

Вот это вот вообще отдельный смех, когда в треде про ллм какие-то банальные вещи спрашивают про скрипты и всякое около, с которыми помочь или полностью часто сделать с минимальными правками может шо бесплатно доступный жопете, шо клод, шо ещё куча всего через кучу сайтов и апи.

>Тут проблема в том, что если дело касается чего-то простенького, зачастую и делиться нечем.

This. 80% это ли что-то простое, что опять же накидывается самими ллмками за 5-10 минут, или что-то очень специфическое под конкретную задачу. Остальные это и специфическое, и больше времени проебать придется чтобы это привести в приличный вид и с хотя бы каким-то гайдом и доками дабы не грешно поделиться было. И опять же поддерживать впадлу.

> Думаю, автора изначального коммента это и демотивировало напрягаться ради кого-то.

Так прикол в том чтобы не делать для кого-то. А делится тем что сделал для себя, не?

Ну вот ты наделал для себя скриптов, сидишь охуенный такой, обложенный скриптами, завтра помер, и все что ты делал померло с тобой.

А выпусти на публику, и оно будет жить на харде каких-нибудь шизов которые архивируют интернеты. А когда настанет время сингулярности искусственного интеллекта эти знания попадут в мегамозг.

>что можно сделать новым методом.

Ну там нового только то, что невероятно и за очень дорого заебались с сбором очень качественного (на фоне того на чём обычно обучают) датасета.

> если дело касается чего-то простенького, зачастую и делиться нечем

Да не, часто мелочи довольно важные и недооцениваются или забывается. Не стесняйся.

> приходят в треды и ноют «я хочу сделать такое, но не могу!», хотя на деле ровно наоборот: могут

Не, проблема в том что как раз не могут воспользоваться обилием доступных инструментов из-за внутренних особенностей. Но при этом считают себя лучше чем есть на самом деле, из-за чего обижаются когда по их просьбе (!) за спасибо (!!) им помогают стараясь сделать хорошо (!!!) но игнорируя какой-то ахуительный (часто нежизнеспособный и контрпродуктивный) довод или совет, чем задевают чсв. Там уже начинается не конкретный спор или обсуждение по деталям с положительной направленностью, а просто хейт всего и нытье. Вот так сказать коренная причина проблемы.

не стоит путать еще со срачами исповедующих противоположные точки зрения, там другое

> Покидал картинки — она их описала

Ладно, значит надо поковырять. Тут просто главный вопрос в потенциале и распределении что хорошо видит, что домысливает ллм частью и насколько правильно воспринимает абстракции.

Мультимодальный рп - забей, до этого еще оче далеко.

> и больше времени проебать придется чтобы это привести в приличный вид и с хотя бы каким-то гайдом

Уууу, вот это вот оно, да. Ну просто хотябы в общем виде обрисовать, может быть полезным.

>сидишь охуенный такой, обложенный скриптами, завтра помер, и все что ты делал померло с тобой

знания - сила, в перспективе это может принести профит или же умереть вместе с тобой (когда ты умрешь тебе уже будет все равно). делиться можно, если оно не представляет ценности. делиться знаниями с рандомами, которые не могут даже открыть командную строку или запустить скрипт - себя не уважать.

делать что-то безвозмездно - пустая трата времени и сил.

>Мультимодальный рп - забей, до этого еще оче далеко.

Технически не особо, вопрос сбора хорошего датасета по большей части. А вот с этим проблемы конкретные уже.

>Уууу, вот это вот оно, да. Ну просто хотябы в общем виде обрисовать, может быть полезным.

Надо, короче, взять потюнить модельки на харкач-датасете и доске, да посадить пытаться описывать/писать гайды так чтобы последний дегенерат осилил.

Хуя ты философ. Наверное с таким подходом ты уже миллиардером стал.

у нвидии за пример-но те же деньги можно постараться теслу выцепить p40... но нюанс в том, что нвидия пока что не депрекейтед, и тензоркоров в обязательном порядке не просит никто пока-что... за то VII с охладом без колхоза...

>и больше времени проебать придется чтобы это привести в приличный вид и с хотя бы каким-то гайдом и доками дабы не грешно поделиться было. И опять же поддерживать впадлу.

С этим пожалуй согласен.

>делать что-то безвозмездно - пустая трата времени и сил.

А вот с этим нет.

Каким бы "ахуенным" ты не был, ты всё равно не сможешь самостоятельно реализовать всё, банально 99% годных идей тебе даже в голову не придёт. А вот рандому из треда придёт, и он возможно это даже реализует, но начитавшись подобной хуйни, никому об этом не скажет сорри, гейткип

С другой стороны, безвозмездно выкладывая вещи, которые ты всё равно никогда не коммерциолизируешь, ты подаёшь таким рандомам пример что это норм тема и увеличиваешь вероятность появления в треде годноты, которая пригодится уже тебе.

Но судя по постам выше, тредовички скорее будут жрать говно, зато своё - домашнее!

это база, понимаешь? если ты чего-то хочешь - платишь деньги, если не можешь платить - делаешь сам. в другом случае довольствуешься опенсурсным говном.

Да по сути самая основная проблема, что кучу времени надо тратить на всё это, если не просто выбрасывать голый код условно, а работу, личные дела, беды со здоровьем и желание просто отдохнуть, когда в день часа 3-4 свободного времени - никто это всё не отменял.

У нас за год суммарно с форчом столько всякого выложенного и понаписанного уже наскладировано по сотне ссылок на рентри было, а реально оно по большей части нахер никому не нужно без постоянной поддержки. А с каким-то кодом и тулзами, которые кто-то где-то выложил просто, частенько порой спустя месяц-два-три уже не разобраться без сиськи пива наперевес будучи кодером. Ебля это всё, короче, времязатратная.

>если ты чего-то хочешь - платишь деньги

Ну как бы да, например для инференса можно было бы арендовать. Быстрее было бы. И бесплатный Жора не нужен. Ведь верно, ведь правильно?(с)

>а реально оно по большей части нахер никому не нужно без постоянной поддержки.

И с поддержкой и без поддержки. Узкоспециализированные вещи, нужные 2,5 анонам, да ещё и с жутким пердолингом в применении. Ну так сделано - не нужно удивляться, что не идёт в массы. Оно не для этого.

>И бесплатный Жора не нужен

C бесплатным жорой вообще туманные перспективы сейчас, там пиздец не хватает контрибьюторов уже, мультимодалки нормально впиливать тупо некому вот, а работы там ебаться и ебаться.

>Если сравнивать с вариантами заведомо кривой реализации

Даже без сравнения с кривыми реализациями. Мешлеты быстрые. Наниты - нет.

>А вот рандому из треда придёт

Как бороться с тем, что рандом из треда хочет жрать говно вместо реализации моих охуительных идей? Я бы вообще код не писал, если бы всё, что я хочу, кто-то сделал до меня.

>И бесплатный Жора не нужен

А Жора за свои потуги получает деньги, между прочим. И даже не смотря на то, что весь тред жрёт его продукт - его все хуесосят. Неплохой повод задуматься, нужно ли вкидывать свои скрипты в тред.

Ну типа, ты это говоришь об опенсорсных LLM-ках. Про скрипты в опенсорсной таверне. Еще наверное и запускаешь это в опенсорсном линуксе/докере, а огромная часть интернета в принципе живет только потому что кто-то когда-то начал двигать эту ебатню с GNU

> GNU

GPL

>Как бороться с тем, что рандом из треда хочет жрать говно вместо реализации моих охуительных идей?

Писать код самому и показывать положительный пример. Тогда у рандома пригорит от того, что внимание достаётся не ему, когда он литералли не огранённый алмаз и он тоже напишет.

>его все хуесосят

Я нет, Жора мой бог!

мимо боладатель Р40

> его все хуесосят.

Да это вроде по большей части рофлы по иннерции же, двачи хуле, шизов, которые реально хуесосят меньшинство.

Опенсурс это и великое благо, и великая боль от которой постоянно хочется грызть вены на жопе себе и всем причастным.

Я сам который месяц периодически порываюсь начать наконец удрачиваться в плюсы с кудой и потихоньку вкатываться в вкладывание в опенсурсные проекты, но каждый раз от горького опыта опенсурса и представляемого объема нервов и времени, которые придется вложить, хуй падает сразу же.

И это тоже. Хорошо, конечно, когда хоть что-то есть и вдруг пригодится, но реально многое просто затрат времени и нервов не стоит как обычно.

> его все хуесосят

Так за дело же, из-за каких-то ахуительных убеждений и странностей делает все ломает. Там сейчас на самом деле поддержка комьюнити настолько ахуенная что с него оче много нагрузки поснималось, и финансируется нихуево, так что вполне. Местами это уже трансформируется из крутого-прорывного-полезного для всех в тормозящее прогресс сборище костылей и недоделок.

Но даже так, стоит отметить что большинство кто его хуесосит всеравно признает важность его вклада.

> нужно ли вкидывать свои скрипты в тред

Нужно конечно, а кто хочет лучше переделает под себя. Ты же не публичное лицо, действия которого определяют многое и нужно нести ответственность, а простой анонимус, который показывает рабочую реализацию чего-то.

> Опенсурс это и великое благо, и великая боль

Свобода слова на фоне отсутствия явного лидерства и иерархии. Крутые идеи тонут под тоннами херни, очень активный шиз с парочкой мелких удачных решений и вагоном провалов становится популярным-уважаемым, бриллианты остаются без внимания на фоне превозношения ерунда и так далее.

> заведомо кривой реализации альтернатив игнорируя возможные оптимизации

Если в поддержку своих фантазий ты нагуглил какого-то шизика, то это не значит что это правда. Посмотрел тот видос - полнейшая хуита, он предлагает как деды лоуполи лоды использовать. Наниты никогда не были про производительность, они про качество. На лодах сопоставимое качество просто невозможно по куче причин - нужна слишком сложная логика мерджа мешей/материалов, нужна ебанутая шина и горы RAM чтоб гонять качественные лоды по памяти, нужна ебанутая нагрузка на ЦП. Есть огромное количество примеров опенворлдов с лодами, которые долбятся в шину/ЦП. Например те же юбиподелки или киберпук, начинающие статтерить на топовом железе при быстром движении над локацией и при этом имеющие качество лодов на дне. Про то что видеорил можно повторить с лодами и запустить на консольке - это фантазии, не имеющие ничего общего с реальностью.

Это просто первое видео из поиска, их множество и в этом лишь какой-то частный пример. Чсх чтобы "опровергнуть" его пришлось отречься от исходного и заявить

> Наниты никогда не были про производительность

значит и цель достигнута. И как раз про

> нужна слишком сложная логика мерджа мешей/материалов, нужна ебанутая шина и горы RAM чтоб гонять качественные лоды по памяти, нужна ебанутая нагрузка на ЦП

это тоже в целом критиками нанитов опровергается по пунктам.

Какбы похуй и этим вообще не занимаюсь, однако оргументы одних выглядят более убедительнее чем повторение мантр про революционность, скорость и наивысшее благо нанитов. Технология как технология, на которую пытаются навешивать и продвигать как единственно истинную, а не одну из.

> 1653776784773.webm

А что тут революционного, мыльцо без освещения, местами красивое и детальное, местами унылое и кривое?

> критиками нанитов опровергается по пунктам

Фантазировать можно сколько угодно, нужны пруфы хотя бы в виде технодемки. Но ведь этого нет, а из примера топовых лодов, чтоб глаза не вытекали в 4К, имеем только какой-нибудь Элден Ринг, даже близко не дающий уровня нанитов. Показывать один высокополигональный меш в статике с одной текстурой без материалов и сравнивать что-то там - это подгон результатов под желаемое, даже хуже синтетических тестов железа.

> мыльцо без освещения

Если ты слепой, то с тобой нет смысла разговаривать. На видосе тени есть вообще от всего, на любом расстоянии, как и GI/AO работает везде, даже в километрах. В каком-нмбудь юбикале теней тупа нет в 100 метрах уже и лоды из пяти полигонов прячут в тумане. Даже в РДР2 всё то же самое - лоурез лоды, годящиеся только для 1080р чтоб не резало глаза, и куча тумана.

Ну вот, поток сознания с игнором нестыковок и очевидных проблем с проходом в оскорбления собеседника, хотя до этого пост в положительном ключе. Фу таким обиженкой быть.

В видосе использован хороший трюк. А именно - влажные поверхности. Такая погода проще всего подгоняется под ИРЛ работу света, вон ГТА5 с решейдом и HD текстурами выглядит как фильм во время дождливой погоды.

https://www.youtube.com/watch?v=cC0T4dhagZY

>революционность, скорость и наивысшее благо нанитов

А эти проповедники нанитов с нами в одной комнате?

>это тоже в целом критиками нанитов опровергается по пунктам.

95% критики нанитов это ебатория откровенная, где сравнивают хуй с жопой придумав из головы свое удобное предназначение нанитов, которого у них никогда не было.

Наниты изначально преподносились как хуйня, которая должна упростить пайплайн ебли с 3д моделями для тяжелых крупных проектов, позволяя не заниматься всей поебенью традиционной с запиливанием артистами сотен и тысяч ссаных лодов для моделей вручную и прочим дрочем вприсядку. И сидеть в лоб сравнивать как на видосе выше в сценах на обоссаные несколько лямов полигонов с подготовкой как при стандартном пайплайне, это максимально тупорылая бессмысленная хуйня. Сами соломенное чучело придумали, сами сидят с ним воют так ещё и в максимально тупом виде.

Ну и предлагаю таким гениям посравнивать на сценках в примерно полтриллиона полигонов суммарно со всем освещением, анимациями и остальным набором всего что будет в реальный практических кейсах.

Мы же вроде про геометрию и лоды говорили изначалино. У тебя на видосе объекты/люди в 50 метрах появляются и дома в 100 метрах прогружаются из коробок рывками.

> вон ГТА5 с решейдом и HD текстурами выглядит как фильм во время дождливой погоды

Выглядит как всратый решейд без теней, но зато с выкрученным скрин-спейс амбиент оклюженом, вытекающим чёрными пятнами из всех углов.

> А эти проповедники нанитов с нами в одной комнате?

Нет, но поданриальная макака точно в этом треде.

> это максимально тупорылая бессмысленная хуйня

Такое можно сказать про попытки впечатлить притащенной технодемкой из дефолтных ассетов с местами крайне унылым визуалом, и отсутствием теней, но с претензией на демонстрацию чего-то прорывного. Еще и обижается на это, во рофел. Чел, воюешь здесь только ты, всем похуй.

>Такое можно сказать про попытки впечатлить притащенной технодемкой из дефолтных ассетов с местами крайне унылым визуалом, и отсутствием теней, но с претензией на демонстрацию чего-то прорывного. Еще и обижается на это, во рофел. Чел, воюешь здесь только ты, всем похуй.

Я не анон что демку постил. Это раз.

Два, не стреляйте из пушки по воробьям. Наниты не про то чтобы рендерить сцены с количеством геометрии уровня кот в лоток нассал и у них есть очевидный "upfront cost" и порог после которого их использование начинает иметь смысл и позволять рендерить ебанутую геометрию без потери производительности до нуля, которая будет на стандартных всех техниках. Сраные 2/5/10/15 и даже 100-200 лямов полигонов на сцену это и близко не он.

Это скорее интересные факты, чем повод посраться.

Олсо. Прогрузка лодов и у тебя на видосе видна. Как 1-2 машинки припаркованные вдруг появляются.

При этом машина для такого нужна наверное раз в 10 мощнее. И все равно мало.

Так изначально посыл лишь про то что наниты - одна из технологий со своими плюсами и минусами, к которой применимо не только восхваление но и критика, а не единственная вершина всего.

> без потери производительности до нуля

Еще бы это увидеть в игоре.

> технодемкой

Есть и не технодемки, в отличии от твоих фантазий, наниты уже в играх есть. Пикрил выглдяит как пререндер, хотя это просто релтайм графон в 60 фпс.

> При этом машина для такого нужна наверное раз в 10 мощнее.

Это был просто видос из демки матрицы с PS5, ничего особого нанитам не нужно, всё это на текущих консольках работает без проблем.

>одна из технологий со своими плюсами и минусами, к которой применимо не только восхваление но и критика

Эти все восхваления и критика как обычно в подавляющей своей части это словесный дроч на реддите, форумах и видосах. Те, кому не шашечки, а ехать и реально какие-то проекты делать, прочитают нормально документацию, подумают полчаса, поймут что это довольно новый инструмент с такими вот ограничениями, такими профитами, в таком вот состоянии текущем, и или будут юзать в соотв. с документацией, или не будут потому что он им вообще не нужен или пока не нужен. Остальное на 90% классическое пиздеть не мешки ворочать.

>Писать код самому и показывать положительный пример.

А нахуя мне тогда рандомы, если я сам всё напишу?

>Нужно конечно, а кто хочет лучше переделает под себя.

Такая себе идея, конечно.

>Наниты никогда не были про производительность, они про качество.

А где качество? Графон уровня гта 5 с парой шейдеров.

>На лодах сопоставимое качество просто невозможно

Так можно без нанитов хуйнуть всю геометрию в сцену. Ещё и быстрее окажется, чем 50 фпс с нанитами.

>нужна ебанутая шина и горы RAM чтоб гонять качественные лоды по памяти

Ты прикинь, если справку почитать - окажется, что наниты гоняются по памяти. Это стриминг с диска. Со всеми теми минусами, которые ты для лодов перечислил, только х10, потому что наниты жирные, что пиздец. Вместо статтеров в движении будут статтеры при вращении камеры, как в демке матрицы. Охуенно же.

Мы уже поняли что ты оче болеешь этой темой, скоро вырастешь и станешь игровым разработчиком которого заменят нейросети. А текущая реальность такова что про графен мыловарен, "нативные 8к/4к 60/120 фпс" и наниты в частности не шутил только ленивый. И ты уже оперделись, это про скорость, про удобство, про качество, а то по отдельности одни опровержения или нытье "вы не так используете".

> словесный дроч на реддите, форумах и видосах

> поймут что это довольно новый инструмент с такими вот ограничениями, такими профитами

Все так

> только х10, потому что наниты жирные, что пиздец

Чел, с лодами ты фактически хранишь 5 копий одного меша разного качества, у нанитов на практике сильно меньше потребление памяти, буквально в разы. И сам размер ассетов сильно падает с ними, вот тот город с видоса весит 10 гигов, его можно просто в RAM хранить весь.

Как нанитный меш может весить полгига в одно ебало, так и ассет с лодами весить столько же. Это всё вообще параллельная друг другу залупа.

>вот тот город с видоса весит 10 гигов

Неужели ты ещё не понял, что пиздеть бесполезно? Город с видоса весит 21 гигабайт. С лоуполи модельками строений и буквально одной моделью машины. Такая демка должна весить максимум гигов пять, с лодами, тесселяцией и т.д. Ой, прости, забыл. Анрил же не поддерживает тесселяцию - она работает слишком быстро и имеет хардварное ускорение.

> С лоуполи модельками строений

Лол. Мне и скринов с плойки не жалко.

Алсо, собака лает, караван идёт - каждый апдейт всё новые технологии завозят.

https://www.youtube.com/watch?v=WpnYqJsh-Dc

Раз уж вы развели тут хуйню про графониум, проблема фотореализма была решена ещё года 3 назад, и гораздо ближе к теме треда

https://isl-org.github.io/PhotorealismEnhancement/

Сегодняшний огромный рисёч тренд это темпорально стабильный нейрорендер тегированной лоуполи геометрии, наблюдайте завтра на ваших пеках. Потому что в отличие от всех этих нёрфов с гауссианами там не надо переделывать весь пайплайн, с этим будет и ворлдспейс и свет/отражения и всё остальное, можно использовать имеющиеся движки на 90%.

>локальные языковые модели тхреад

https://isl-org.github.io/PhotorealismEnhancement/

Сегодняшний огромный рисёч тренд это темпорально стабильный нейрорендер тегированной лоуполи геометрии, наблюдайте завтра на ваших пеках. Потому что в отличие от всех этих нёрфов с гауссианами там не надо переделывать весь пайплайн, с этим будет и ворлдспейс и свет/отражения и всё остальное, можно использовать имеющиеся движки на 90%.

>локальные языковые модели тхреад

И гораздо пиздаче всех васянских поделок

Со сканами всё намного проще. А твоя старая херня слишком прожорливая, в реалтайме такое никогда не запустить.

https://gsplat.tech/excavator/

https://gsplat.tech/garden/

На скринах графон уровня гта 5. Или даже хуже, бампа вообще нет ни на одной поверхности, ни шероховатостей, нихуя. Ровный плоский пластик. Насколько же жирные наниты - во всей демке модульная архитектура и уникальных строений 24 штуки. И это дерьмо весит 21 гигабайт. Страшно представить, сколько терабайт весило бы что-то уровня RDR2.

>всё новые технологии завозят

А старые, которые быстро работают - выпиливают. Путь долбоёба, хули.

Странно выглядит на самом деле, с зелёным фильтром слишком мыльно, но где погода солнечная - всё окей. Разве что дымку стирает в ноль и капли дождя квадратные. Они, вроде, так и не выложили чекпоинты и дропнули всю разработку.

>А твоя старая херня слишком прожорливая, в реалтайме такое никогда не запустить.

Она литералли пёрла реалтайм на 2х980 с видео в качестве исходника. 4090 её уже свободно в реалтайме потянет, вместе с игрой. Там проблема в другом, её каждый раз обучать с нуля надо, фундаменталку хуй запилишь, а ведь надо ещё рендерить тренировочный футаж реалистичный, если хочешь под стиль подстроиться, там в общем затрат как у голливудского кино.

Они просто тренили на хуёвом разрешении, и образцовое видео снимали в Австрии, в результате им нейронка починила американские дороги и превратила машины в Ауди и БМВ, лол. А так подход рабочий, но требует ещё допила чтобы это рентабельно было.

По итогу это через два сообщения залупилось и мысли и планы были всегда одни и те же, лол.

А самое смешное что даже после отключения квик реплея - скрипт все равно срабатывает выдавая то же самое но при этом уже нет ответа чара.

Я ебал.

> бампа

Уже давно не нулевые, чтоб он был где-то. Везде давно PBR. Держи плитку на дороге с прорисованными стыками.

Гауссианы это что-то типа фото, но 3Д. Они слабо юзабельны для геймдева, т.к. слабо совместимы с интерактивом, только в нишах юзабельны. А тут у тебя обычный лоуполи из примитивных коробок, помеченных "машина", "пальма", "хуман" и т.п., так что все премудрости движков, от коллижена до рейтрейсинга, применимы.

>А нахуя мне тогда рандомы, если я сам всё напишу?

>банально 99% годных идей тебе даже в голову не придёт

Даже если забить на идеи. Ты напишешь что-то одно, рандомы - второе, третьё, пятое, десятое, т.к. ты один, а их много.

Забавное ощущение от этих скринов. Вроде бы выглядит где-то как фото, но есть какие-то части которые тут же рушат впечатление.

Хуй знает, как ты этого добился, мб сэмплеры в говне? У меня мысли персонажа постоянно развиваются в зависимости от ситуации, эффект на ролеплей положительный. При этом я гоняю на 12B модели.

Лет 7 назад это показалось бы крутым, а сейчас просто приличный графен, которого не получить от плойки без долгой ловли удачных моментов для запечатления. Не по адресу, здесь над хвастовством железками и графениумом чаще насмехаются ибо искушены.

Вот это прикольно, где наши ии шейдеры? у хуанга Простая сверточная сеть из начала 21 года, и действительно создает эффект. Можно ведь исходный рендер подрезать (скорее разрешение) и уже сейчас устроить подобное в реалтайме.

Правильно.

Простите, а те, кто здесь рассуждает о нанитах, технодемку Матрицы-то гоняли, которой сто лет в обед?

А то такое ощущение, что разговор идет о чем-то, чего никто не понимает, но свое охуеть какое важное мнение высрать обязан.

А то такое ощущение, что разговор идет о чем-то, чего никто не понимает, но свое охуеть какое важное мнение высрать обязан.

Как думаете в теории сейчас можно запилить аналог переводчика Deepl? Написать промт переводчика, чтобы при нажатии выделенный текст отправлялся боту, а он мне на русском отправлял? И как будет проще, через кобольд или таверну? Ну и какую сетку взять? И какую сетку взять, чтобы код написала?

>Как думаете в теории сейчас можно запилить аналог переводчика Deepl?

Ну я попробовал towerinstruct-mistral-7b - что-то не очень. Даже инструкциям не очень-то следует и перевод посредственный. Сунуть его в сервер и давать запросы на перевод не получиться - это не специализированная сетка, а всё тот же мистраль, который в любой момент может отчебучить что-то своё. Если у кого другие впечатления и кто-то сделал свой сервер-переводчик - пишите как. Давно назрело.

На Ollame когда шастал по их опубликованным моделькам натыкался на такую в описании которой было написана, что она обучена переводить на 12 языков. Вот только не вспомню что это.

Вопрос железа.

Не файтюненные нормально под задачу сетки меньше 20-30b нихуя в нормальный перевод особо не могут по большей части, да и 70b не все могут.

Из того шо всплывает в памяти вроде aya-23 что то должно уметь, там разные размеры есть.

Если у тебя железо не пара-тройка 3090/4090, то берешь Cursor, берешь фришный апи groq, доебываешь в Cursor клод или жпт4о чтоб оно тебе писало шо тебе надо.

Ну типа большие ллм уже сама по себе может хорошо переводить, и даже учитывать контекст. Пишешь промт и простую обертку чтобы формировало запрос.

> через кобольд или таверну

Кобольд может выступать бэком, таверна фронтом, там можно выбрать апи переводчика и указать свой скрипт. Для кода сетку хз, так-то и гемма неплохо пишет, но в этом случае лучше клодыня.

а при чем грок и гопота/клод?

Тут много скриптописателей для таверны, хочу уточнить один вопрос. (а может уже кто-то делал такое)

Возможно ли как-то реализовать активацию скрипта по таймеру? Пришла идея сделать что-то вроде тамагочи. Если оставить включенным таверну с моделькой, то персонажу начнут осылаться какие-то полу-технические данные типа "прошло 3 часа, а анон-нейм все еще не ответил тебе, какие эмоции у тебя на этот счет?"

И с каждым сообщением накручивать градус.

Возможно ли вобще такое реализовать?

Возможно ли как-то реализовать активацию скрипта по таймеру? Пришла идея сделать что-то вроде тамагочи. Если оставить включенным таверну с моделькой, то персонажу начнут осылаться какие-то полу-технические данные типа "прошло 3 часа, а анон-нейм все еще не ответил тебе, какие эмоции у тебя на этот счет?"

И с каждым сообщением накручивать градус.

Возможно ли вобще такое реализовать?

есть дополнение https://github.com/SillyTavern/Extension-Idle

скрипт привазываешь свой к этим сообщениям, вроде не сложно

Если учесть, что бамп входит в PBR пайплайн, то анрил просто не дорос до технологий нулевых? У тебя на скринах не PBR, а всратый пластик. Даже без AO и контактных теней, лол, эти левитирующие кондеи на крыше. Это выглядит всрато, это весит овердохуя, нахуй оно вообще нужно? И я напомню, это сделано из мешлетов, которые работают со скоростью 150 фпс на 1650. Как можно настолько обосраться?

И из этих "много" аж один анон выложил скрипты для таверны. Я в треде не первый день и такое событие - редкость. Сам сейчас вот пилю автоматический генератор датасетов из аудиофайлов, кто это будет делать? Да никто. Здесь вот все ощущают энтузиазм по поводу мультимодалок, я же в них не верю пока что и скриптами наворачиваю обёртки вокруг нейронки, чтобы так расширять возможности системы в целом, а не отдельной нейросети. И что-то мне подсказывает, что это не слишком популярная затея будет, т.е по этой идее скриптов никто не напишет. А больше мне особо нихуя и не надо уже.

В теории да. На практике - нет. Сетки хорошо знают один английский, иногда неплохо себя показывают в двух-трёх языках. У дипла их чуть-чуть больше.

Какая модель лучше всего без цензуры для генерации фанфиков всяких? Желательно на русском, под 12 гигов.

>Сам сейчас вот пилю автоматический генератор датасетов из аудиофайлов, кто это будет делать? Да никто.

Как это никто, ты и будешь. Анону ведь что нужно? Анону нужно, чтобы модель голосом отвечала не как сейчас, а с выражением. С эмоциями. Ну и во время секс-сцен аутентично. Анону надо, а ты что - не анон что ли? Такой же как и все мы. Выкладывай промежуточные результаты, как минимум потестят, а может и подхватят ил помогут чем. Ну или можешь дожидаться, пока кто-нибудь где-нибудь когда-нибудь сделает. Но скорее всего не то.

>Анону надо, а ты что - не анон что ли?

>Выкладывай промежуточные результаты

Целый тред ленивое хуйло пытается агитировать работяг, чтобы всё ему приносили на блюдечке попробовать.

>Выкладывай промежуточные результаты

Целый тред ленивое хуйло пытается агитировать работяг, чтобы всё ему приносили на блюдечке попробовать.

Да хватит вам уже. Все ясно. Один зажал, другой хочет халявы. Хуле тут мусолить.

анон, можешь поделиться исходным кодом, буду очень благодарен~

>Как это никто, ты и будешь.

Буду. И другие аноны, которым нужно - тоже будут.

>Выкладывай промежуточные результаты

А их нет. Смотри, как это работает - мне нужно найти источники аудио, нарезать их. Нарезка работает идеально только на каких-нибудь подкастах, где участники говорят громко и по очереди. Раз этого нет, то приходится отслушивать процентов 80 от аудиоданных, выбирать нужное. Потом обрезка всего неинтересного из заинтересовавших файлов. Потом автоматическая аннотация. Чистка аннотации, вручную, с очередной прослушкой всех данных. Модификация нейронки. Трейн нейронки. Всё это дело нихера не быстрое. Собери яйца в кулак, сделай датасет, хули ты. Ты начнёшь, аноны подхватят и будет у треда своя TTS, ухх, заживём.

Да я не против поделиться с тредом, просто тред тоже должен не сидеть дрочить простату. Ну или юзайте мультимодалки, ллм сама поймёт, какой тон должен быть и интонация.

Неплохо. Забыл ещё радеон где-то сбоку и волосы в радиаторе.

>Собери яйца в кулак, сделай датасет

Сколько примерно часов нужно для трейна (дотрейна?) TTS?

Есть около ~10 часов записи одного голоса (+ещё ~30, но там фоном музыка играет). Этого будет достаточно? Готов потратить своё (возможно и не только своё, хех) время на это. Как вообще процесс делается? Преобразовать в текст с помощью какого-нибудь виспера, потом исправлять за ним (он так себе распознаёт, может есть что-то покруче для русского языка?). А вот дальше? Как там интонации растовлять и т.д.? Если не лень ответьте, если лень - направьте чего почитать на эту тему

другой анон

Шапку не читал пока

Есть у вас что-то, что выдает аутпут на уровне клода? Сладко кумить хочется...

Есть у вас что-то, что выдает аутпут на уровне клода? Сладко кумить хочется...

>просто тред тоже должен не сидеть дрочить простату

Какой-то анон перекатывает тред и следит за шапкой.

Какой-то пилит вики.

Какой-то принёс годную идею со скриптами в таверне.

Какой-то - свой нихуёвый сетап из 4 тесел, расписав как накатить такой-же.

Какие-то аноны делятся промптами.

Какие-то - моделями, скриптами, статьями, которые где-то нарыли.

Я пилю колаб и список моделей.

Конечно ты сейчас скажешь что это всё пыль под твоими ногами, но если бы не это всё, ты бы скорее всего вообще сюда не залетел, вот и думай.

>просто тред должен

Не твоя личная армия.

>А больше мне особо нихуя и не надо уже.

Ни таверна, ни кванты, ни новые РП тьюны? хуя ты гигачед, в блокноте РПшишь?

А ведь это всё тоже пилится по большей части энтузиастами за нихуя.

мимо обладатель того самого радеона

Да, конечно.

"Pigmallion"

Работяги, посоветуйте хорошие локалки для рп пожалуйста, по вашему мнению.

> для трейна

Для претрейна сотни. Для тюна десяток уже хорошо.

>10 часов записи одного голоса

Дело не в голосе, дело в интонациях. Т.е чистая ровная речь нахуй не нужна, нужны именно эмоциональные реплики: ярость, разочарование, похоть и т.д. Что смешно, эмоциональных мужиков я нашёл за последнее время просто миллион, а женские голоса это либо давка голоса, либо пищание. Даже истерику подходящую найти сложно. Музыку с фона процентов на 70 можно убрать софтом.

>Преобразовать в текст с помощью какого-нибудь виспера

Да, виспер лардж. Я режу по фразам, до 10-15 секунд на файл, пачка wav. Потом текстовый файл в формате имя wav - расшифровка. Распознаёт, в целом, неплохо, но есть нюансы, так что без контроля получается хуйня.

>Как там интонации растовлять и т.д.?

А так же, как должна расставлять интонации LLM. Находишь теги, находишь токены для ударений, которые ещё не заняты и могут генерироваться моделями без танцев с бубном. Это не идеальная разметка, но наиболее удобная для использования с LLM.

>Конечно ты сейчас скажешь что это всё пыль под твоими ногами

Да нет, это всё неплохо, молодцы, лол. Но я пользуюсь разве что тредом, так что ОП для меня самый ценный кадр из всех.

>Ни таверна, ни кванты, ни новые РП тьюны?

Таверну удалил, квантовать могу и сам, РП тюны не вставляют. ЕРП с коммандером, без Е с базовыми моделями. Серьёзно, эти тюны как из одного котла разливают, одинаковое поведение, одинаковая речь. С базовыми хотя бы манера речи отличается плюс-минус, а тюны видимо, и правда пичкают выхлопом клода или чего-то ещё, что они в итоге мимикрируют под одно и то же.

> Т.е чистая ровная речь нахуй не нужна, нужны именно эмоциональные реплики: ярость, разочарование, похоть и т.д.

Это всё есть в исходном файле, речь не ровная, с интонациями, с эмоциями. Хм, щас подумал что может наверное быть проблематичным, что в том аудио голос один, но она пытается озвучивать разных персонажей (в том числе и мужских) поэтому голос отличается

Хм, кстати есть ли какие-нибудь нейронки которые могут распознавать настроение по аудио-инпуту?

> Музыку с фона процентов на 70 можно убрать софтом

Пытался делать штуковиной встроенной в RVC. Музыку хорошо убирало, но страдало качество записи голоса, появлялись цифровые артефакты (как будто шумодав с дискорда или битрейт низкий)

спасибо

> Смотри, как это работает - мне нужно найти источники аудио, нарезать их. Нарезка работает идеально только на каких-нибудь подкастах, где участники говорят громко и по очереди. Раз этого нет, то приходится отслушивать процентов 80 от аудиоданных, выбирать нужное. Потом обрезка всего неинтересного из заинтересовавших файлов. Потом автоматическая аннотация. Чистка аннотации, вручную, с очередной прослушкой всех данных. Модификация нейронки. Трейн нейронки. Всё это дело нихера не быстрое. Собери яйца в кулак, сделай датасет, хули ты. Ты начнёшь, аноны подхватят и будет у треда своя TTS, ухх, заживём.

Вспомнил прошлогоднюю свою еблю с лорами для SD, когда как ебаный аутист тратишь неделю сотню раз переранарезая и переразмечая вручную датасет на сотню другую пикч и сотню раз запуская трейн, пытаясь найти нужный набор из нескольких десятков параметров, чтобы к концу недели уже начать сходить с ума от запеченных на сетчатке пикч датасета и графиков лоссов. Ну нахуй.

Помогите пожалуйста, я хотел скачать локальную модель а тут такое. Что здесь надо качать чтобы локалку получить?

Читай вики треда в шапке. Там всё написано

Понял

> И что-то мне подсказывает, что это не слишком популярная затея будет

Почему? Все мультимодалки что представлены в опенсорсе и около того, это просто система из нескольких сетей, сшитых по входу-выходу. И подходы нужны общие а не конкретные.

В твоем случае иметь звуковой датасет и опыт обучения подобного - наоборот хорошо, а куда применить уже найдется. если бы сам упарывался обучением двуковых то присоединился бы, но тут точно есть кто занимается

> Раз этого нет, то приходится отслушивать процентов 80 от аудиоданных, выбирать нужное.

Почему вместо отслушивания нейронки или алгоритмы не применишь? Далеко на ручной работе не уедешь тут, только на начальном этапе, или нанимать штат индусов.

А ты вообще саму модель на какой архитектуре планируешь? Инициализировать мелочь с шумом, как в большинстве ттс, или, например, взять готовый dit от стабилити?

> Таверну удалил

Это довольно странно, ведь без нее или подобного инструмента нормальный рп не устроить.

> кстати есть ли какие-нибудь нейронки которые могут распознавать настроение по аудио-инпуту

https://huggingface.co/models?pipeline_tag=audio-classification&sort=trending и еще может пригодиться https://huggingface.co/pyannote/segmentation

ну что же вы, анончики, перед тем как начинать что-то передовое нужно изучить уже имеющиеся инструменты и наработки и не стесняться спрашивать

>Это довольно странно, ведь без нее или подобного инструмента нормальный рп не устроить.

Таверну модифицировать под свои нужды ебаная боль. А базовый аналог с блекджеком и шлюхами под себя наклепать за недельку неспешного кодинга или ещё быстрее при содействии с гпт/клода можно

>но она пытается озвучивать разных персонажей

Да не, это норм.

У меня обрезается больше частот, чем хотелось бы, становится тише, но, в целом, покатит. Можно вручную каждый файл обрабатывать, получается лучше, если выделить музыку без речи, а потом задушить её по всему файлу. Izotope так умеет, например. Это долго, но все мы живём на жёлтой подводной лодке, откуда деваться некуда.

А ты выложил лору в SD тред?

>это просто система из нескольких сетей, сшитых по входу-выходу

Этого ещё не пробовал. Пробовал запихивать оутпут вижн модели в LLM с подсказкой типа "это описание картинки, сгенерированное нейросетью, напишите отзыв для этой картинки от лица {{char}}". Нейронка пишет что-то типа "вау, какая интересная картинка. ЖДУ НЕ ДОЖДУСЬ УВИДЕТЬ ЕЁ ОПИСАНИЕ ОТ НЕЙРОСЕТИ". Ну ёбаны в рот. Скорее всего промпты не дожал или нужно было делать что-то вроде "Вы видите то-то и то-то на изображении". Плюсы - не нужно модить модели, нет привязок к конкретным моделям, можешь менять их когда захочешь и т.д.

>Почему вместо отслушивания нейронки или алгоритмы не применишь?

Нейронка режет аудио, но если в момент конца реплики уже говорит кто-то другой или играет музыка - то случается фейл. Плюс меня интересует не всё аудио даже конкретного спикера, т.к пытаюсь сделать фокус на эмоциональных репликах, без ровной речи. Для подготовки в сумме используется 4 нейронки, но без прослушивания получается хуйня.

>А ты вообще саму модель на какой архитектуре планируешь?

Сейчас уже есть говорящий кастом, но без эмоций. Чекпоинт выкладывать смысла нет, я сам по полдня окружение для неё настраиваю, даже зная что делать. Потом или черепаха, или styleTTS. Были надежды, что силеро выкатит код для файнтюна, всё-таки самая быстрая ТТС. Но их понять можно, коммерция, ебать её в сраку.

>Это довольно странно

Да нет, почему. Соглашусь с аноном по поводу ёбаной боли. Вон, выше даже на кобольда жаловались, хотя казалось бы. А таверна далеко не такой беспроблемный софт, как он.

> Этого ещё не пробовал.

Всмысле? Сейчас все известные мультимодалки работают по простому принципу: изображение после препроцессинга отправляется в модель зирошот классификации (может быть с нюансами типа нарезки на много частей и т.д.), оттуда полученные эмбединги отдельной моделью кодируются в токены, которые уже поступают на вход ллм. Есть примеры стыковки по другим модальностям, но суть везде одна - стыкуются по границам с преобразованием в понятный формат при необходимости.

Что до того чтобы направить выдачу мультимодалки в другую сеть - затребуй от мультимодалки подробное описание в структурированном формате. А после перед тем как направить основной ллм это полотно, добавь инструкцию типа ({{char}} видит перед собой следующее: <vision> описание </vision>) обрамив содержание тегами. Не надо никакого "описания сгенерированное нейросетью", сбивает же только.

Разумеется, наилучшим вариантом будет вместо этой херни буквально слать токены пикчи, но сейчас нет мультимодалок чтобы ллм часть была достаточно хороша для рп, или адаптеров к умным (как и самой тренировки ллм), которые позволяли бы бесшовно так внедрять изображение в контекст. Даже у корпоратов это наблюдается не смотря на то что сетка единая, они прилично выполняют задачи связанные с картинками и рпшат по отдельности, но если пытаться провернуть что-то подобное то сразу тупят.

> но если в момент конца реплики уже говорит кто-то другой или играет музыка - то случается фейл

Сегментация аудио уже, оно определяет наличие разных голосов и музыки как по отдельности, так и при одновременном воспроизведении. А эмоциональность уже оценивать классификаторами. Да, чтобы все это реализовать нужно попердолиться гораздо больше чем отслушать короткий датасет, но на чем-то побольше и если заниматься много то сразу окупаются все затраты.

Раз у тебя уже 4 нейронки значит подобное должно быть реализовано, расскажешь почему не работает и что именно применял?

> Сейчас уже есть говорящий кастом, но без эмоций. Чекпоинт выкладывать смысла нет

Ну ты лучше расскажи на основе чего ее делал, как инициализировал, какой размер, что по тренировке, с какими подводными камнями столкнулся. Вот это прям дохуя интересно.

> даже на кобольда жаловались, хотя казалось бы

Ну а че казалось бы, в нем ничего нужного нету. Как минималистичный интерфейс - да, хорош, но это как ездить на голой раме с прикрученной табуреткой вместо современного авто. Таверна серит регулярно, но самая развитая. Ее удобно юзать для большинства взаимодействий, но а для всего остального уже самописное.

парни а кто может подсказать настройки для Nemomix-v4.0-12B. а то оно вроде норм генерит но иногда как то всрато. мб кто юзал эту хуйню

>А ты выложил лору в SD тред?

Некоторые кидал, уже и из тредов проебались и сам поудалял, тройка недоделанных на цивите были, с пару десятков дальше моего компа и пары знакомых не уходили.

> Нейронка пишет что-то типа "вау, какая интересная картинка. ЖДУ НЕ ДОЖДУСЬ УВИДЕТЬ ЕЁ ОПИСАНИЕ ОТ НЕЙРОСЕТИ". Ну ёбаны в рот. Скорее всего промпты не дожал или нужно было делать что-то вроде "Вы видите то-то и то-то на изображении".

Делал такое, тут вопрос дрочки с промптами и структурой того как подаешь в контекст описание что пикч, что тексты документов, etc., которые при смене моделей ещё доделывать под каждую приходится. Лучше всего выходило, когда превращал весь контекст в сплошные жсоны/xml, это вообще для ТГ-бота было с наворотами вроде управления группой по своему желанию, чтения документов/картинок/ссылок, COT, возможностью не отвечать, если персонаж не хочет и прочим блекджеком, шлюхами и function calling.

Но с этим большая проблема на мелких сетках, не вывозят одновременно осиливать сложные структуры и нормальное общение, начиная или забивать на инструкции промпта, или тупеть, приходится выдумывать и городить цепочки из агентов отвечающие за разную хуйню и прочие извращения которые везде уже впрочем в продакшне

Ну и до сих пор проблема с локальными мультимодалками. Или очень тяжело для домашнего железа, или очень тупое.

>добавь инструкцию типа ({{char}} видит перед собой следующее: <vision> описание </vision>) обрамив содержание тегами. Не надо никакого "описания сгенерированное нейросетью", сбивает же только.

>

This.

Тут часто забывают насколько по очевидным причинам ллмки хорошо часто жрут структурированную по каким-либо схемам инфу.

А как переключить в таверне режим с чат-бота на режим соавтора / дополнения текста?

> Даже истерику подходящую найти сложно. Музыку с фона процентов на 70 можно убрать софтом.

Может ее из фильмов озвученных брать?

Брать где-нибудь дорожку не сведенную с фоном, например. Или контрналожением минусовать ее с озвучки попробовать.

База.

> Да, виспер лардж.

Турбо существенно лучше медиума по качеству, но сопоставим по скорости.

Если много, можно его.

Здравствуйте, только из пещеры вылез.

Скажите пожалуйста, а читалки текстов, книг и т.д. с ИИ уже есть?

>оттуда полученные эмбединги отдельной моделью кодируются в токены

Звучит, как хуйня. Понятно тогда, отчего они не очень.

> добавь инструкцию типа ({{char}} видит перед собой следующее: <vision> описание </vision>

>нужно было делать что-то вроде "Вы видите то-то и то-то на изображении"

Ну я примерно так и думал. Но сразу не сделал, а сейчас уже не помню, какую сетку пробовал. Мне одна конкретная понравилась, лол, потом буду искать именно её и делать с ней.

Но это не в приоритете пока что.

>Сегментация аудио уже, оно определяет наличие разных голосов и музыки как по отдельности

https://huggingface.co/pyannote/speaker-diarization-3.1

Вот это для сегментации пробую. Работает хуёво. Точнее как, оно, видимо, на какие-то подкасты ориентировано, потому на более сложной информации фейлит. До этого было хорошее качественное аудио, а сейчас приходится дёргать "зашумлённый" звук, на котором оно серит.

>чтобы все это реализовать нужно попердолиться гораздо больше чем отслушать короткий датасет

На пике короткий датасет, который я прослушивал минимум 4 раза весь. Есть ещё один плюс-минус такой же, но вообще не обработанный, не трогал пока, т.к в нём мало эмоциональной речи.

>Ну ты лучше расскажи на основе чего ее делал, как инициализировал, какой размер

Да в прошлом треде писал же, VAE, hi-fi gan и генерация спектрограмм. Общий размер около 2b. По тренировке особо ничего интересного, собираешь датасет и пошёл вперёд. Первые опыты начались около года назад, ещё в fp8, с тех пор мучаю чекпоинт, который в районе 50 эпох от оверфита, при не слишком большом lr, конечно же. Ближе всего это к styleTTS по внутрянке. По крайней мере, так мне кажется - я не изучал все существующие ттс.

>Или очень тяжело для домашнего железа, или очень тупое.

Ну я точно бинго соберу, и очень тяжело, и очень тупое.

>Брать где-нибудь дорожку не сведенную с фоном

А можно сразу взять где-нибудь готовую нейронку. Знал бы только, где это всё брать - сразу бы и взял. Скорее всего начну подмешивать мужиков, не идеально, но если будет не больше четверти, должно стерпеть.

>существенно лучше медиума по качеству, но сопоставим по скорости.

Как таковых претензий к качеству нет. Главная проблема в пунктуации, которую он ставит по правилам, а не по аудио. Я убираю всю пунктуацию там, где нет пауз, чтобы нейросеть не начала их игнорировать везде. И это одна из причин, почему нужно прослушивать и редактировать практически всё, что он расшифровал.

Так это голосовые нейросети как раз и есть. Text to speech. Тут вообще рядом cпециальный тред есть про них , я всё жду, когда мне скажут пиздовать нахуй туда. Если нужна быстрая озвучка без заёбов, то бери силеро. У него существенный минус только один, нет возможности менять голоса, только зашитый разработчиком изначально.

> Знал бы только, где это всё брать - сразу бы и взял

Торренты? Там же есть релизы где дорожки отдельно идут. Да и из видеофайла их всегда можно вытащить.

Нужно только подыскать фильмы где музыки не очень много. Или во время разговоров ее нет.

https://www.kinopoisk.ru/lists/m_act%5Bkeyword%5D/5075/

https://yandex.ru/q/cinema/638370561/

>Так это голосовые нейросети как раз и есть. Text to speech. Тут вообще рядом cпециальный тред есть про них , я всё жду, когда мне скажут пиздовать нахуй туда. Если нужна быстрая озвучка без заёбов, то бери силеро. У него существенный минус только один, нет возможности менять голоса, только зашитый разработчиком изначально.

Спасибо!

> Звучит, как хуйня.

Не то чтобы есть много альтернатив. Пикча кодируется в токены и они идут на вход вместе с промтом. Другие варианты требуют изменения самой схемы работы ллм, использование дополнительных входов, которые будут обрабатываться, как-то увязывать это с имеющейся схемой работы и т.д. Да еще и в таком случае не совсем понятно как работать с несколькими изображениями.

> а сейчас приходится дёргать "зашумлённый" звук, на котором оно серит

Почистить от шума с начала, или же натренить ее на твои данные? Раз уже что-то сам нарезал то и датасет уже имеется, в репе у них даже примеры готовых блокнотов для тренировки есть.

> На пике короткий датасет

Сложно оценивать много это или мало, если стерео wave без сжатия то 4-5 часов получается. Для ттсок заявляли десятки.

> Общий размер около 2b

Это весьма нихуево так, типичные ттски в десятки раз меньше, зачем так много сразу?

На фп8 ничего не натренится, даже использование 16бит в градиентах приводит к ряду проблем, для которых свои костыли разрабатывают, типа апкаст диапазона или наоборот стохастическое округление для снижения дискретности.

Также есть некоторая корреляция между необходимым объемом датасета и размером модели, чтобы оно имело смысл. В твоем случае точно стоит начать с размера хотябы раза в 3-4 меньше. И тренить с таким количеством что

> в районе 50 эпох от оверфита

как правило оче неоптимально, столько эпох не нужно. Расширяй датасет, применяй аугументацию, оптимизируй шедулер чтобы обеспечить падение с которым не будет оверфита.

Не думай что критикую, просто подсказать могу только указав на явные недочеты в общих вещах а по конкретике со звуковыми сетками хз.

Хз, все стандартное было чатмл пресеты

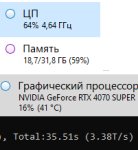

А это нормально, что видеокарта чуть ли не простаивает?

А проц загружен наполовину. Киберпанк чуть больше потребляет.

Хотя вроде 3.5 токена, что ну вроде терпимо. Вряд ли сильно больше получу.

Модель мистраль 24b Q4.

А проц загружен наполовину. Киберпанк чуть больше потребляет.

Хотя вроде 3.5 токена, что ну вроде терпимо. Вряд ли сильно больше получу.

Модель мистраль 24b Q4.

>я всё жду, когда мне скажут пиздовать туда

Единственный активный "технотред" на доске. Лучше пусть локальщики со своими юзлес локалками пиздуют))

Как работает войс в гпт? Та хуйня гугловская, очевидно, обычный тупой ттс, просто хороший. Гпт же может, если ее пробить, генерировать (НЕ ГОЛОСОВЫЕ) звуковые эффекты, не говоря уж о всяких стонах и ахах, + может петь. Был баг, когда она начинала говорить голосом юзера. Значит у нее и на входе не тест. Может быть они сделали файнтюн на чисто звуковых токенах, ибо как иначе объяснить протечку голоса юзера, как не то что у нее полноценные звуковые токены в контексте плавают?

Но это выглядит как хуйня, ведь она и текст воспринимает. Чистая мультимодалка без прослоек? С прослойками не понимаю как голос то протечь может.

>видеокарта чуть ли не простаивает

У ней шина памяти под завязку. Хули ты хотел от 12 гиг, да ещё и на 192 битах?

>Чистая мультимодалка без прослоек?

Да, хули нет то. Поэтому и ебёт.

>А это нормально, что видеокарта чуть ли не простаивает?

Для Лламыспп и производных да. Вызывает ощущение, что и генерация и обработка могли бы быть быстрее, верно?

> Чистая мультимодалка без прослоек?

Не то чтобы это совсем невозможно, но в чмоне и прочих 99.9% дефолтная реализация. Какбы dit можно использовать не только для генерации изображений, но и для звука. От стабилити есть претрейн, который вполне себе работает и способен делать всякое, но натренен плохо и с речью слабо. Обучить ее и уже можно будет хоть напрямую токенами из ллм с мелкой разметкой + дополнительным промтом кормить. Или немного полирнуть совместной тренировкой ллм + звуковую диффузию и даже разметок не нужно, "звуковые токены" напрямую идут из ллм в дит и там генерируются в нужное. Но скорее ситуация как с далли и генерацией пикч и там просто в гопоте спецтокен вызова трансляции промта в синтезатор.

> С прослойками не понимаю как голос то протечь может.

Что?

>Не то чтобы это совсем невозможно

Только вот на неделе Emu3 дропнули стокенизацией текст-пикчи-видео, а всем итт похуй как обычно на что-то новое интересное, 2 поста на всю доску.

https://emu.baai.ac.cn/about

https://arxiv.org/abs/2409.18869

https://github.com/baaivision/Emu3

https://huggingface.co/collections/BAAI/emu3-66f4e64f70850ff358a2e60f

На чем я это буду запускать?

Ммм, люблю запах еще неостывшего sota по утрам. Анончик как всегда доставляет, лучший.

> 2 поста на всю доску

Да потому что хуета, которую запускать - пердолинг, и результат - говно. Лучше бы новый ког-вижн или их видеомодель обсуждали.

Сразу можно отметить что ужатие пиксельной пикчи идет в ~1.5 раза сильнее чем в 4х-канальных vae SD, от которых сейчас отказываются в пользу 16-канальных. Это уже говорит о серьезном дропе качества изображения. Генерация 1мегапиксельной пикчи - 16к токенов. Шакалы 512 - 4к токенов, более реально, но скорость все равно ужасающая. Зная эти 2 факта уже возникает вопрос о каком там вообще сравнении с XL может идти речь? Как они достигли высоких оценок юзерскора в целом в статье описано.

Раз тут ллм то промпт она должна воспринимать превосходно, однако даже в их тестах проигрывает далли, что несколько странно.

Чтож, пример кода из репы после пары пинков заводится на актуальном торче и фа2 с уже имеющегося вэнва. За 32битные веса в репе заслуживают отдельного поджопника Во время генерации кушает чуть меньше 20гигов врам, постепенно поднимается до 24, и далее во время декодирования (?) подскакивает до 42. На чуть более медленном но жирном аналоге 3090

> a portrait of young girl.

из примера пришлось дожидаться минут 10 real: 8m42,126s, пик1.

Видим серьезные артефакты вае и шумы вперемешку с мылом на волосах в попытке накинуть детализации выжимая камни.

Бонусом - ставшие классикой девушки на траве, уровень!

Ничего иного и не ожидалось, это мертворожденное нечто, которое априори не может работать хорошо. Пока тот самый "единственно нужный" процесс предсказания токенов, в котором 99.(9) расчетов выкидывается в мусорку, не будет изменен - так и будет.

А ведь можно не мучать жопу, а ужать ллмку до 2-4б (или оставить большой), выдачу сократить до 512 токенов (эстетам можно и 768-1024), йоба ган заменить на dit с размером 2-4-...б и получится... хорошая крутая модель, которая может все и лучше, и быстрее и без подобного анального цирка. Кто мог подумать.

Завтра попробую как она с распознаванием дружит, наверно это единственное что может серьезно бустануться от подобного подхода, ну и может какие-нибудь очень сложные промты в комбинации с подачей картинки на вход закину. Что-то уровня тыканья палкой в труп

Есть некоторый шанс что оно в 4 битах бнб запустится, вот только зачем?

На жопной гари с ценников видях.

Я просто к теме обсуждения докинул.

Ну и немного в очередной раз погореть, что на потенциально перспективные интересные штуки тотально кладётся хуй начиная с двачей и реддита, заканчивая топ конторами, которым интереснее сейчас в хвост и гриву ебать одни и те же концепции по кругу заливая говноданными и датацентрами на гигаватты потребления пока эта кобыла не сдохнет.

Причем самое смешное та же мета полностью токеновый хамелеон тогда делала, но по какой-то всратой причине и "safety" положила хуй. Не удивлюсь, если внутри у себя там не положили и потом просто без всякого опенсурса чисто для коммерции себе доделают.

Ну просто представь. Есть SD. На который есть трилиард лор, с ним все умеют работать, у людей куча воркфлоу собрано на макаронах.

А теперь появляется какая-то ГИГА-ОХУННАЯ-МОДЕЛЬ-С-КАЧЕСТВОМ на которую всем похуй, потому что она не умеет делать Луну с сиськами восьмого размера и метровым хуем.

> на потенциально перспективные интересные штуки

Где? Может для васянов романтиков от мира ии в мечтах это действительно выглядит круто, вот только априори нежизнеспособно. Топ конторы понимают это как никто другой и потому не выбрасывают на них время. Может быть там какой-то побочный эффект и получится, например с тем же распознаванием, но подобная "мультимодальность" нахуй никому не сдалась.

Как можно не понимать этого? Приводя аналогии, это то же самое что если бы у человека вместо имеющихся глаз был орган с углом обзора в половину телесного градуса и жестким мышечным блоком, который неистово и постоянно дергал бы его сканируя линию за линией.

> Топ конторы понимают это как никто другой и потому не выбрасывают на них время.

Те самые топ конторы вроде меты, которые готовы въебывать уже миллиарды вечнозеленых в брутфорсовое наращивание датацентров чтобы кормить всё большие модели на одних и тех же архитектурах муорным говном и генерациями жпт вместо нормальных данных? Вроде клозедаи, у которых вместо нормального токенизатора в 2024 году до сих пор кривая хуетень с целыми токенами для фраз с спамом про японскую порнуху переведенные с китайского?

Понимаешь, довольно удобно сидя и попердывая в кресле рассуждать о том, какие же _корпоратнейм_ дебилы, они только и могут "брутфорсить" и "глупо наращивать". Вот если бы я встал у них во главе, то точно бы направил их в нужное русло, ух!

Одно дело - серьезная конструктивная критика по пунктам (которую там они могут и сами понимать и уже преодолевать) а другое - строить из себя умника, который в лучшем случае в качестве аргументов доебывается до какой-то мелочи, которая не играет серьезной роли.