В этот тредик скидываются свежие новости по теме ИИ! Залетай и будь в курсе самых последних событий и достижений в этой области!

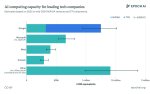

Илон Маск запустил суперкомпьютер Colossus, претендующий на звание самого мощного в мире!

Илон Маск и его компания xAI запустили Колосса (Colossus) — суперкомпьютер для обучения искусственного интеллекта, который может стать самым мощным в мире. Маск "построил" этого монстра всего за 122 дня, и его основной задачей станет обучение последней версии языковой модели GROK, известной как GROK-3. Для этого суперкомпьютер оснащен 100,000 графическими процессорами Nvidia H100.

Вдобавок к этому, Маск пообещал, что Colossus удвоит свою мощность "в течение нескольких месяцев" благодаря добавлению еще 50,000 чипов Nvidia H200, каждый из которых вдвое мощнее в плане ускорения ИИ-задач по сравнению с H100.

Стоимость создания этой системы остается загадкой, но даже по минимальным оценкам, только на закупку 100,000 чипов Nvidia H100 могло уйти около $2 миллиардов. И это только начальная стадия. Дополнительные 50,000 H200 и инфраструктура, необходимая для работы системы, обойдутся не меньше.

Несколько недель назад xAI запустила модель GROK-2, которая использовала "всего" 15,000 чипов Nvidia H100 для обучения, но даже она смогла занять второе место в рейтингах языковых моделей, уступая только ChatGPT-4. Таким образом, новая система будет в шесть-семь раз мощнее GROK-2 и вскоре снова удвоит свои возможности.

Маск сообщил, что GROK-3 может быть запущен уже к декабрю. Однако вместе с этим возникает и множество вопросов об экологических последствиях. По оценкам, нужно примерно 150 МегаВатт для этого кластера, а коммунальные службы сообщали, что в августе был предоставлен доступ лишь к мощности в 50 МВ. Полную мощность обещают выдать с запуском новой подстанции в начале 2025-го года. Маск не стал ждать и приобрёл 20 газовых турбин и сырьё для них. Цифрой поделились эко-активисты, которые были возмущены и ходили вокруг всё фотографируя (а потом направили петицию департаменту здравоохранения касательно загрязнения воздуха).

20 турбин, по оценкам, действительно могут покрыть недостачу в 100 МегаВатт.

В итоге кластер был запущен примерно за 4 месяца — в сравнении с годом (а то и больше) у конкурентов. И это всерьёз пугает последних —два человека из Microsoft сообщили, что Sam Altman, CEO OpenAI, в ходе беседы с руководителями в Microsoft выражал обеспокоенность тем, что xAI вскоре может иметь больше вычислительных мощностей, чем OpenAI.

Илон Маск и его компания xAI запустили Колосса (Colossus) — суперкомпьютер для обучения искусственного интеллекта, который может стать самым мощным в мире. Маск "построил" этого монстра всего за 122 дня, и его основной задачей станет обучение последней версии языковой модели GROK, известной как GROK-3. Для этого суперкомпьютер оснащен 100,000 графическими процессорами Nvidia H100.

Вдобавок к этому, Маск пообещал, что Colossus удвоит свою мощность "в течение нескольких месяцев" благодаря добавлению еще 50,000 чипов Nvidia H200, каждый из которых вдвое мощнее в плане ускорения ИИ-задач по сравнению с H100.

Стоимость создания этой системы остается загадкой, но даже по минимальным оценкам, только на закупку 100,000 чипов Nvidia H100 могло уйти около $2 миллиардов. И это только начальная стадия. Дополнительные 50,000 H200 и инфраструктура, необходимая для работы системы, обойдутся не меньше.

Несколько недель назад xAI запустила модель GROK-2, которая использовала "всего" 15,000 чипов Nvidia H100 для обучения, но даже она смогла занять второе место в рейтингах языковых моделей, уступая только ChatGPT-4. Таким образом, новая система будет в шесть-семь раз мощнее GROK-2 и вскоре снова удвоит свои возможности.

Маск сообщил, что GROK-3 может быть запущен уже к декабрю. Однако вместе с этим возникает и множество вопросов об экологических последствиях. По оценкам, нужно примерно 150 МегаВатт для этого кластера, а коммунальные службы сообщали, что в августе был предоставлен доступ лишь к мощности в 50 МВ. Полную мощность обещают выдать с запуском новой подстанции в начале 2025-го года. Маск не стал ждать и приобрёл 20 газовых турбин и сырьё для них. Цифрой поделились эко-активисты, которые были возмущены и ходили вокруг всё фотографируя (а потом направили петицию департаменту здравоохранения касательно загрязнения воздуха).

20 турбин, по оценкам, действительно могут покрыть недостачу в 100 МегаВатт.

В итоге кластер был запущен примерно за 4 месяца — в сравнении с годом (а то и больше) у конкурентов. И это всерьёз пугает последних —два человека из Microsoft сообщили, что Sam Altman, CEO OpenAI, в ходе беседы с руководителями в Microsoft выражал обеспокоенность тем, что xAI вскоре может иметь больше вычислительных мощностей, чем OpenAI.

CEO OpenAI Japan на презентации заявил, что следующий GPT будет в 100 раз мощнее предыдущего, и проговорился, что появится модель в этом году.

При этом предполагается, что мощи вырастут не за счет объема вычислительных ресурсов, а в основном благодаря улучшениям в архитектуре и эффективности обучения.

Технический директор Microsoft Кевин Скотт и OpenAI ранее намекали на то, что в 2024 году появится гораздо более мощная модель OpenAI.

Упоминается, что OpenAI разрабатывает две новые системы ИИ: "Клубничка" с улучшенными математическими навыками и навыками кодирования и "Орион", потенциальный мультимодальный преемник GPT-4, который может стать "GPT Next". Он обучается в том числе на данных, сгенерированных Strawberry.

Тадао Нагасаки рассказал, что модель "Орион" обучалась (именно в прошедшем времени) на 10к H100.

Подробности тут:

https://the-decoder.com/openai-japan-shares-vision-for-much-more-powerful-gpt-next-coming-in-2024/

При этом предполагается, что мощи вырастут не за счет объема вычислительных ресурсов, а в основном благодаря улучшениям в архитектуре и эффективности обучения.

Технический директор Microsoft Кевин Скотт и OpenAI ранее намекали на то, что в 2024 году появится гораздо более мощная модель OpenAI.

Упоминается, что OpenAI разрабатывает две новые системы ИИ: "Клубничка" с улучшенными математическими навыками и навыками кодирования и "Орион", потенциальный мультимодальный преемник GPT-4, который может стать "GPT Next". Он обучается в том числе на данных, сгенерированных Strawberry.

Тадао Нагасаки рассказал, что модель "Орион" обучалась (именно в прошедшем времени) на 10к H100.

Подробности тут:

https://the-decoder.com/openai-japan-shares-vision-for-much-more-powerful-gpt-next-coming-in-2024/

Бывший главный ученый OpenAI Илья Суцкевер привлек $1 миллиард для своего стартапа SSI

С момента основания Ильей Safe Superintelligence Inc не прошло и трёх месяцев, там всего 10 сотрудников, а оценка у компании уже $5 миллиардов! Вот теперь подняли $1млрд кеша. SSI планирует использовать привлеченные средства для покупки высокопроизводительных вычислительных мощностей и привлечения талантов. Команды будут распределены между Пало-Альто (Калифорния) и Тель-Авивом (Израиль).

Топовые инвесторы, вроде a16z и Sequoia, не ожидают скорой прибыли — по заявлению Суцкевера, первым продуктом компании будет сверхинтеллект.

С момента основания Ильей Safe Superintelligence Inc не прошло и трёх месяцев, там всего 10 сотрудников, а оценка у компании уже $5 миллиардов! Вот теперь подняли $1млрд кеша. SSI планирует использовать привлеченные средства для покупки высокопроизводительных вычислительных мощностей и привлечения талантов. Команды будут распределены между Пало-Альто (Калифорния) и Тель-Авивом (Израиль).

Топовые инвесторы, вроде a16z и Sequoia, не ожидают скорой прибыли — по заявлению Суцкевера, первым продуктом компании будет сверхинтеллект.

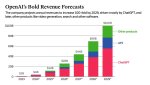

Сейчас ежемесячная подписка на ChatGPT стоит $20. Как думаете, на сколько её могут поднять в ближайшем будущем с выпуском новых моделей? 50 долларов? 75 долларов? А как насчет 200 или 2000 долларов?

Вы можете удивиться, но такие цифры (да, две тыщи) фигурировали во внутренних обсуждениях в OpenAI.

https://www.theinformation.com/articles/openai-considers-higher-priced-subscriptions-to-its-chatbot-ai-preview-of-the-informations-ai-summit

Сейчас этот вопрос стоит особенно остро (ну, если вы верите, что следующее поколение моделей приятно удивит) —ведь проекты Strawberry (улучшение навыков рассуждения моделей) и Orion (вероятно, GPT-5) будут требовать больше ресурсов для работы. По достаточно популярной гипотезе, моделям нужно будет время «на подумать» перед тем, как давать ответ, и всё это время в фоне будет крутиться нейронка.

Конечно, повышение цены (особенно до планки более чем 100 долларов) также будет означать, что OpenAI считает, что ее существующие клиенты ChatGPT будут считать эти новые модели гораздо более ценными для их повседневной работы.

Сейчас OpenAI рубит примерно 2 миллиарда долларов в год на $20-ых подписках.

Вы можете удивиться, но такие цифры (да, две тыщи) фигурировали во внутренних обсуждениях в OpenAI.

https://www.theinformation.com/articles/openai-considers-higher-priced-subscriptions-to-its-chatbot-ai-preview-of-the-informations-ai-summit

Сейчас этот вопрос стоит особенно остро (ну, если вы верите, что следующее поколение моделей приятно удивит) —ведь проекты Strawberry (улучшение навыков рассуждения моделей) и Orion (вероятно, GPT-5) будут требовать больше ресурсов для работы. По достаточно популярной гипотезе, моделям нужно будет время «на подумать» перед тем, как давать ответ, и всё это время в фоне будет крутиться нейронка.

Конечно, повышение цены (особенно до планки более чем 100 долларов) также будет означать, что OpenAI считает, что ее существующие клиенты ChatGPT будут считать эти новые модели гораздо более ценными для их повседневной работы.

Сейчас OpenAI рубит примерно 2 миллиарда долларов в год на $20-ых подписках.

и будет стоить 500 баксов за 1 лям токенов

они этот график кидали уже дохуя раз, но ни разу не видели аутпут модели

наш слоняра, скорее всего съебал от Альтмана или потому что сам захотел больше денег или потому что ему не понравилось что попены ушли от чисто исследовательской компании к наебизнесу

для кабанов 2к$ в месяц это пыль, а вот даже для среднего Джона это непосильная ноша

Сплошная перемога. Когда зрада будет?

Вчера в социальной сети ИКС ТОЧКА КОМ анонсировали LLAMA 3.1 70B, дообученную на синтетических данных, и выдающую результаты лучше, чем GPT-4o / Claude Sonnet 3.5 на нескольких бенчмарках. Анонс взорвал интернет. Модель получила название Reflection — потому что её ответ формируется как объединение рассуждения (Chain-of-Thought) и рефлексии/анализа ошибок. Эти два шага чередуются до тех пор, пока сама же модель не решит написать итоговый ответ. В итоге, перед получением результата нужно немного подождать, пока идут рассуждения (но их можно читать, чтобы не заскучать).

Что в этой истории дурно пахнет:

1) На наборе математических задач GSM8k модель выдала 99.2% правильных ответов. Однако скорее всего в самой разметке больше одного процента неправильных ответов —а как можно давать такие же, но неправильные ответы? Основная версия, проходящая бритву Оккама — модель уже училась на этих данных. Альтернативная и более щадящая: LLM делает те же ошибки, что и люди, и потому пришла к тем же неправильным ответам

2) Эти методы рассуждений и рефлексии —не новинка, и уже было показано, что они существенно улучшают качество. И потому все передовые модели так и так учили с чем-то подобным (особенно если явно прописать "подумай хорошенько шаг за шагом"). Потому сходу не ясно, что именно дало такой прирост для маленькой 70B модели.

3) Авторы не раскрывают технические детали и не показывают «синтетические» примеры для дообучения, лишь ссылаются на какую-то платформу, которая позволяет в пару кликов генерировать синтетику. А ещё я прочитал, что автор модели — инвестор этой конторы. Так что модель больше похожа на рекламный продукт, потому стоит ждать независимых замеров.

4) Сами подробности якобы раскроют на следующей неделе после выпуска 405B версии, которая может существенно переплюнуть все топовые модели, включая закрытые.

Опять же, концептуально такой подход действительно должен бустить качество, вопрос в том, почему настолько сильно, и почему передовые модели такой трюк не применяют.

Если у вас есть железо и время для запуска 70B модели —веса тут https://huggingface.co/mattshumer/Reflection-Llama-3.1-70B.

Сайт с демкой был тут https://reflection-playground-production.up.railway.app/, но его отключили из-за наплыва аудитории.

Анонс был тут: https://x.com/mattshumer_/status/1831767014341538166

Что в этой истории дурно пахнет:

1) На наборе математических задач GSM8k модель выдала 99.2% правильных ответов. Однако скорее всего в самой разметке больше одного процента неправильных ответов —а как можно давать такие же, но неправильные ответы? Основная версия, проходящая бритву Оккама — модель уже училась на этих данных. Альтернативная и более щадящая: LLM делает те же ошибки, что и люди, и потому пришла к тем же неправильным ответам

2) Эти методы рассуждений и рефлексии —не новинка, и уже было показано, что они существенно улучшают качество. И потому все передовые модели так и так учили с чем-то подобным (особенно если явно прописать "подумай хорошенько шаг за шагом"). Потому сходу не ясно, что именно дало такой прирост для маленькой 70B модели.

3) Авторы не раскрывают технические детали и не показывают «синтетические» примеры для дообучения, лишь ссылаются на какую-то платформу, которая позволяет в пару кликов генерировать синтетику. А ещё я прочитал, что автор модели — инвестор этой конторы. Так что модель больше похожа на рекламный продукт, потому стоит ждать независимых замеров.

4) Сами подробности якобы раскроют на следующей неделе после выпуска 405B версии, которая может существенно переплюнуть все топовые модели, включая закрытые.

Опять же, концептуально такой подход действительно должен бустить качество, вопрос в том, почему настолько сильно, и почему передовые модели такой трюк не применяют.

Если у вас есть железо и время для запуска 70B модели —веса тут https://huggingface.co/mattshumer/Reflection-Llama-3.1-70B.

Сайт с демкой был тут https://reflection-playground-production.up.railway.app/, но его отключили из-за наплыва аудитории.

Анонс был тут: https://x.com/mattshumer_/status/1831767014341538166

Вчера у легендарного Андрея Карпаты (сооснователя OpenAI) вышло новое интервью: https://www.youtube.com/watch?v=hM_h0UA7upI

Вот краткий пересказ:

⚪️ "10 лет назад я впервые покатался на беспилотной машине в рамках демо, и подумал, что это была идеальная поездка. Однако нам все равно пришлось потратить 10 лет, чтобы перейти от демо к продукту, за который люди платят. Сейчас мы достигли некоторого подобия AGI в сфере self-driving, но пройдет еще очень много времени, пока все это будет глобализовано. То же самое ждет и языковые модели."

⚪️ Tesla круче других компаний, которые занимаются self-driving, хотя сейчас это и не заметно. "Я верю в Tesla, эта компания идет по правильной траектории, фокусируясь на AI. Это не просто self-driving компания, это крупейшая робототехническая компания с огромный потенциалом к расширению, и их подход к работе выведет Tesla на первое место уже в ближайшие годы."

⚪️ Трансформер - не просто очередной метод, но подход, который полностью изменил наш взгляд на ИИ, и на данный момент это единственная по-настоящему масштабируемая архитектура. Нам очень повезло, что мы наткнулись именно на трансформер в огромном пространстве алгоритмов. "Я верю, что трансформер лучше человеческого мозга во многих отношениях, просто эта модель еще не готова проявить себя сполна".

⚪️ Раньше бутылочным горлышком в ИИ была архитуктура. Теперь компании практически о ней не думают: за последние 5 лет классический трансформер изменился не так уж сильно. Акцент в наши дни перемещается на данные.

⚪️ Данные из Интернета, на самом деле, – далеко не самые лучшие данные для обучения модели. Это просто "ближайший сосед" идеальных данных. То, что мы действительно хотим от модели, – это умение рассуждать. А страницы из Интернета не могут ее сполна этому научить.

⚪️ Будущие за синтетическими данными, однако главная проблема синтетики – это энтропия и разнообразие. Его недостаточно, и это действительно препятствие. Тем не менее, текущие модели должны помогать нам создавать следующие, при этом "итоговые" модели могут оказаться на удивление крошечными

⚪️ Андрей говорит, что ушел в образование, потому что не заинтересован в том, чтобы "заменить" людей, а нацелен на то, чтобы сделать их умнее и вдохновленнее. "Я хочу, чтобы люди были ЗА автоматизацию и мечтаю проверить, на что будет способно человечество, когда у каждого будет идеальный репетитор в лице ИИ".

⚪️ ИИ пока не способен создать курс, но идеально подходит для того, чтобы интерпретировать и подстраивать созданные людьми материалы для каждого студента в отдельности. "Я думаю, образование должно стать для людей скорее развлечением, чем трудом."

Вот краткий пересказ:

⚪️ "10 лет назад я впервые покатался на беспилотной машине в рамках демо, и подумал, что это была идеальная поездка. Однако нам все равно пришлось потратить 10 лет, чтобы перейти от демо к продукту, за который люди платят. Сейчас мы достигли некоторого подобия AGI в сфере self-driving, но пройдет еще очень много времени, пока все это будет глобализовано. То же самое ждет и языковые модели."

⚪️ Tesla круче других компаний, которые занимаются self-driving, хотя сейчас это и не заметно. "Я верю в Tesla, эта компания идет по правильной траектории, фокусируясь на AI. Это не просто self-driving компания, это крупейшая робототехническая компания с огромный потенциалом к расширению, и их подход к работе выведет Tesla на первое место уже в ближайшие годы."

⚪️ Трансформер - не просто очередной метод, но подход, который полностью изменил наш взгляд на ИИ, и на данный момент это единственная по-настоящему масштабируемая архитектура. Нам очень повезло, что мы наткнулись именно на трансформер в огромном пространстве алгоритмов. "Я верю, что трансформер лучше человеческого мозга во многих отношениях, просто эта модель еще не готова проявить себя сполна".

⚪️ Раньше бутылочным горлышком в ИИ была архитуктура. Теперь компании практически о ней не думают: за последние 5 лет классический трансформер изменился не так уж сильно. Акцент в наши дни перемещается на данные.

⚪️ Данные из Интернета, на самом деле, – далеко не самые лучшие данные для обучения модели. Это просто "ближайший сосед" идеальных данных. То, что мы действительно хотим от модели, – это умение рассуждать. А страницы из Интернета не могут ее сполна этому научить.

⚪️ Будущие за синтетическими данными, однако главная проблема синтетики – это энтропия и разнообразие. Его недостаточно, и это действительно препятствие. Тем не менее, текущие модели должны помогать нам создавать следующие, при этом "итоговые" модели могут оказаться на удивление крошечными

⚪️ Андрей говорит, что ушел в образование, потому что не заинтересован в том, чтобы "заменить" людей, а нацелен на то, чтобы сделать их умнее и вдохновленнее. "Я хочу, чтобы люди были ЗА автоматизацию и мечтаю проверить, на что будет способно человечество, когда у каждого будет идеальный репетитор в лице ИИ".

⚪️ ИИ пока не способен создать курс, но идеально подходит для того, чтобы интерпретировать и подстраивать созданные людьми материалы для каждого студента в отдельности. "Я думаю, образование должно стать для людей скорее развлечением, чем трудом."

> Эти два шага чередуются до тех пор, пока сама же модель не решит написать итоговый ответ

Я не понял одного, CoT и подобные методы реализуются через промт инжениринг, но они выкатили целый файн-тюн. Что именно тюнили? Все эти бенчмарки проверяют one-shot ответы, а тут, сюда по описанию, few-shots. Кто-то тестил эту фигню?

Replit Agent взорвал Твиттер. Нейронку называются революцией в кодинге. Она за считанные минуты создаёт огромные проекты разной сложности без вашего участия. В соцсети разошлось очень много примеров генерации лендингов, игр и приложений с API.

Зацените масштаб: ИИ создает сервер, пишет игровую логику, импортирует ресурсы, настраивает геймплей, исправляет баги и сам размещает игру на сервере. Вам нужно только ввести любую идею и наблюдать за процессом (пример на видео).

Попробовать бесплатно могут все желающие — тут: https://replit.com/

Зацените масштаб: ИИ создает сервер, пишет игровую логику, импортирует ресурсы, настраивает геймплей, исправляет баги и сам размещает игру на сервере. Вам нужно только ввести любую идею и наблюдать за процессом (пример на видео).

Попробовать бесплатно могут все желающие — тут: https://replit.com/

у чувака на видео есть свой канал?

Чтобы подписка стоила 200 баксов, нужно, чтобы оно заменяла специалиста хотя бы на 2к баксов, а пока как раз в лучшем случае заменяет спеца за 200. Про 2000 я вообще молчу.

Нельзя там нихуя бесплатно попробовать, у меня кнопка неактивна.

2000 за AGI бы не платил?

У меня таких денег нету, но люди бы платили, но только если там полноценный АГИ, который равен примерно специалисту тыщ за 10 баксов.

Минимум две компании собираются строить датацентры стоимостью более чем в $125 млрд

Комиссар по торговле Северной Дакоты заявил, что правительство штата проводит переговоры о постройке гигантских кластеров в штате - потребление каждого может доходить до 10 гигаватт. Это беспрецедентные масштабы - запущенный на днях Colossus, самый большой кластер в мире, потребляет менее 200 мегаватт, то есть разница более чем в 50 раз.

По словам комиссара, речь идёт о двух компаниях с капитализацией более триллиона. Компаний с такой капитализацией немного: Nvidia, Amazon, Google, Apple, Meta и Microsoft. Apple и Nvidia не столь активны в постройке датацентров, так что это, скорее всего, не они. А вот слухи о Stargate, гигантском датацентре Microsoft, ходят уже полгода.

Северную Дакоту, вероятно, рассматривают потому, что это один из немногих штатов с избытком электроэнергии. Обусловлено это огромными запасами нефти - штат добывает 1,3 миллиона баррелей в день - столько же, сколько добывает, например, Катар. А ведь побочный продукт сланцевой нефти - природный газ, который какое-то время настолько некуда было деть, что его просто сжигали, было видно из космоса.

Использовать оба датацентра точно планируют для ИИ - другие юзкейсы представить сложно. Для контекста: Azure, второе по популярности облако в мире, в сумме потребляло 5 гигаватт на конец предыдущего года. Для того чтобы такие затраты были оправданы, выручка от AI должна вырасти ещё во много раз.

Сейчас пока работают на опережение - вбухивают бабло в AI, чтобы не отстать от конкурентов и застолбить лидерскую позицию. А монетизация и прибыль придут чуть позже.

https://www.theinformation.com/articles/two-ai-developers-are-plotting-125-billion-supercomputers

Комиссар по торговле Северной Дакоты заявил, что правительство штата проводит переговоры о постройке гигантских кластеров в штате - потребление каждого может доходить до 10 гигаватт. Это беспрецедентные масштабы - запущенный на днях Colossus, самый большой кластер в мире, потребляет менее 200 мегаватт, то есть разница более чем в 50 раз.

По словам комиссара, речь идёт о двух компаниях с капитализацией более триллиона. Компаний с такой капитализацией немного: Nvidia, Amazon, Google, Apple, Meta и Microsoft. Apple и Nvidia не столь активны в постройке датацентров, так что это, скорее всего, не они. А вот слухи о Stargate, гигантском датацентре Microsoft, ходят уже полгода.

Северную Дакоту, вероятно, рассматривают потому, что это один из немногих штатов с избытком электроэнергии. Обусловлено это огромными запасами нефти - штат добывает 1,3 миллиона баррелей в день - столько же, сколько добывает, например, Катар. А ведь побочный продукт сланцевой нефти - природный газ, который какое-то время настолько некуда было деть, что его просто сжигали, было видно из космоса.

Использовать оба датацентра точно планируют для ИИ - другие юзкейсы представить сложно. Для контекста: Azure, второе по популярности облако в мире, в сумме потребляло 5 гигаватт на конец предыдущего года. Для того чтобы такие затраты были оправданы, выручка от AI должна вырасти ещё во много раз.

Сейчас пока работают на опережение - вбухивают бабло в AI, чтобы не отстать от конкурентов и застолбить лидерскую позицию. А монетизация и прибыль придут чуть позже.

https://www.theinformation.com/articles/two-ai-developers-are-plotting-125-billion-supercomputers

>Сейчас OpenAI рубит примерно 2 миллиарда долларов в год на $20-ых подписках

А будет рубить 1 миллиард на $200-ых.

вскрылось что это просто наебка для гоев, эта модель просто враппер под соннет 3.5 который с промптом, который делает аутпут ЕЩЁ хуже чем без него

Ну пока ещё не 100% это известно, но скоро узнаем точно

Waymo продолжает публиковать видео, где её роботакси в последний момент избегают аварий.

Waymo побеждает в мировой гонке роботакси: компания открыла сервис в Сан-Франциско и ещё в нескольких городах США для всех желающих и всего за пару месяцев увеличила число коммерческих поездок с 50 000 до 100 000. Waymo также тестирует новое поколение системы автономного вождения и готовится начать испытания беспилотных автомобилей на автострадах и в снежную погоду.

Недавно компания открыла второй цех сборки автономных автомобилей: https://www.forbes.com/sites/alanohnsman/2024/08/26/waymo-adding-a-second-robotaxi-assembly-facility-as-it-tops-100000-weekly-rides

https://www.forbes.com/sites/johnkoetsier/2024/08/20/googles-waymo-now-obviously-the-leader-in-self-driving-cars

Waymo побеждает в мировой гонке роботакси: компания открыла сервис в Сан-Франциско и ещё в нескольких городах США для всех желающих и всего за пару месяцев увеличила число коммерческих поездок с 50 000 до 100 000. Waymo также тестирует новое поколение системы автономного вождения и готовится начать испытания беспилотных автомобилей на автострадах и в снежную погоду.

Недавно компания открыла второй цех сборки автономных автомобилей: https://www.forbes.com/sites/alanohnsman/2024/08/26/waymo-adding-a-second-robotaxi-assembly-facility-as-it-tops-100000-weekly-rides

https://www.forbes.com/sites/johnkoetsier/2024/08/20/googles-waymo-now-obviously-the-leader-in-self-driving-cars

Забавно, что чем больше у тебя данных про возможные ДТП со стороны такой системы, тем круче система станет. То есть для того чтобы улучшить систему, нужно ее запускать или ей нужна практика. Прямо как человеку.

Большой скандал с моделью Reflection, которая хайповала последние несколько дней

Вкратце: модель оказалась фальшивкой. Возможно, это была акция привлечения внимания или финансирования. Более подробный таймлайн того, что произошло, можно найти в этом треде https://x.com/shinboson/status/1832933747529834747?s=46&t=pKf_FxsPGBd_YMIWTA8xgg

Пересказываем:

Модель вышла 5 сентября. О ней написал Мэтт Шумер, CEO Otherside AI. Он же опубликовал те самые потрясающие метрики (которые впоследствии провалились). Модель прогремела в СМИ, в Твиттере, в других соцсетях.

7 сентября история стала давать трещины: первые попытки воспроизвести результаты потерпели неудачу. Мэтт в это время твитит о том, что что-то не так с API, с весами, есть какие-баги, которые вот-вот исправят. В какой-то момент он, якобы в качестве исключения и извинений, публикует "приватный доступ" к некоторому API, и там все действительно работает на ура, по крайней мере для открытой модели такого размера.

И что же? Оказалось, что это самое API – надстройка не над Llama, а над claude 3.5 sonnet. Бадум–тссс

Сам Мэтт Шумер сегодня, пока все страсти и разоблачения кипят в Твиттере и на Реддите, весь день сидит тихо и не дает комментариев. Ранее Мэтт говорил, что он не млщик. Возможно его могли обмануть. Вот и сказочке конец. Directed by Robert B. Weide.

Вкратце: модель оказалась фальшивкой. Возможно, это была акция привлечения внимания или финансирования. Более подробный таймлайн того, что произошло, можно найти в этом треде https://x.com/shinboson/status/1832933747529834747?s=46&t=pKf_FxsPGBd_YMIWTA8xgg

Пересказываем:

Модель вышла 5 сентября. О ней написал Мэтт Шумер, CEO Otherside AI. Он же опубликовал те самые потрясающие метрики (которые впоследствии провалились). Модель прогремела в СМИ, в Твиттере, в других соцсетях.

7 сентября история стала давать трещины: первые попытки воспроизвести результаты потерпели неудачу. Мэтт в это время твитит о том, что что-то не так с API, с весами, есть какие-баги, которые вот-вот исправят. В какой-то момент он, якобы в качестве исключения и извинений, публикует "приватный доступ" к некоторому API, и там все действительно работает на ура, по крайней мере для открытой модели такого размера.

И что же? Оказалось, что это самое API – надстройка не над Llama, а над claude 3.5 sonnet. Бадум–тссс

Сам Мэтт Шумер сегодня, пока все страсти и разоблачения кипят в Твиттере и на Реддите, весь день сидит тихо и не дает комментариев. Ранее Мэтт говорил, что он не млщик. Возможно его могли обмануть. Вот и сказочке конец. Directed by Robert B. Weide.

Прикольно работает, вот такую хуйнюшку с 10 раза еле как написало. Тупит пиздец, проебывает юзинги, переменные. Но спустя 10 фиксов высрал мой ссаный лаунчер, скорее "скачиватель по ссылкам"

Ты шо задонатил? Оно же блядь бесплатно недоступно! дай потрогать!

1) TheInformation: OpenAI планирует выпустить Strawberry как часть своего сервиса ChatGPT в ближайшие две недели

2) Jimmy Apples за полдня до этого написал, что на этой неделе что-то произойдет (может быть не релиз, а внутренний показ/демо)

3) Последнюю неделю некоторым пользователям ChatGPT в ответ на запрос предлагается 2 варианта ответа, но видимо это не то же самое, что и раньше. Сейчас сверху пишется «You're giving a feedback on an experimental version of ChatGPT» или «on a new version of ChatGPT», и сделана пометка, что ответы могут генерироваться не сразу, а после паузы. Именно про это, по слухам, проект Strawberry: дать модели время «на подумать» перед ответом, чтобы снизить вероятность ошибки/не спешить с неправильной генерацией. Время «раздумий» в среднем составляет от 10 до 20 секунд

4) По началу Strawberry будет работать лишь с текстом на вход и выход, никаких картинок и файлов. Цены на Strawberry, скорее всего, будут отличаться от $20 за подписку на чат-бот OpenAI. Журналисты пока не уверены, какие будут ограничения по использованию (сколько сообщений в час) и можно ли будет докупать расширенный пакет.

https://www.theinformation.com/articles/new-details-on-openais-strawberry-apples-siri-makeover-larry-ellison-doubles-down-on-data-centers?rc=7b5eag

2) Jimmy Apples за полдня до этого написал, что на этой неделе что-то произойдет (может быть не релиз, а внутренний показ/демо)

3) Последнюю неделю некоторым пользователям ChatGPT в ответ на запрос предлагается 2 варианта ответа, но видимо это не то же самое, что и раньше. Сейчас сверху пишется «You're giving a feedback on an experimental version of ChatGPT» или «on a new version of ChatGPT», и сделана пометка, что ответы могут генерироваться не сразу, а после паузы. Именно про это, по слухам, проект Strawberry: дать модели время «на подумать» перед ответом, чтобы снизить вероятность ошибки/не спешить с неправильной генерацией. Время «раздумий» в среднем составляет от 10 до 20 секунд

4) По началу Strawberry будет работать лишь с текстом на вход и выход, никаких картинок и файлов. Цены на Strawberry, скорее всего, будут отличаться от $20 за подписку на чат-бот OpenAI. Журналисты пока не уверены, какие будут ограничения по использованию (сколько сообщений в час) и можно ли будет докупать расширенный пакет.

https://www.theinformation.com/articles/new-details-on-openais-strawberry-apples-siri-makeover-larry-ellison-doubles-down-on-data-centers?rc=7b5eag

>Последнюю неделю некоторым пользователям ChatGPT в ответ на запрос предлагается 2 варианта ответа, но видимо это не то же самое, что и раньше.

я реально надеюсь что вот другой вариант ответа явно не клубничка писала и связано только с тем что попены тратят дохуя компьюта на что-то ещё, потому что даже у 4о скорость сильно снизилась

H1

Релиз моделей приближается, интересностей всё больше и больше, потому вот краткая сводка на утро:

—если неделю назад ходили слухи о новой оценке OpenAI в ~$105B после нового раунда инвестиций, то вчера в TheInformation была уже указана цифра в ~$120B. Сегодня же Bloomberg написал, что их источники уже говорят о $150B. Первая цифра казалась странной (маленький скачок относительно предыдущей оценки в $86B), вторая уже понятной, а третья —впечатляющей. Скачок на 75%

—в эту оценку не входит привлекаемая сумма, то есть это так называемая pre money valuation

—планируется привлечь $6.5B (что меньше прошлого раунда в $10B), причём, Microsoft лишь один из многих инвесторов, и даже не лидирующий. Это значит, что инвестиции по большей степени будут деньгами, а не кредитами на вычислительные ресурсы

—кроме этого, с банками ведутся переговоры об открытии возобновляемой кредитной линии в $5B

— выходит, оценка компании будет составлять ~$156B. На бирже в открытом обращении лишь 90 компаний с оценкой выше. Примерно в том районе находятся: Caterpillar, Walt Disney, Morgan Stanley, AT&T, Goldman Sachs и Uber

—удивительно, но OpenAI не станет самой высоко оценённой приватной компанией —впереди ByteDance ($268B) и SpaceX ($210B)

===

— Strawberry может быть релизнута уже на этой неделе, если Sam Altman так решит (то есть в целом всё готово) —об этом сообщил Jimmy Apples. Обычно релизы-анонсы по четвергам, так что сегодня верим-надеемся-ждём. Но может быть и на следующей неделе

— новая информация: GPT-4.x (потенциально 4.5, если решатся так назвать) должна появиться в октябре, опять же, согласно Jimmy Apples. Напомню, 1-го октября OpenAI проводят в Сан-Франциско оффлайн DevDay 2024. Правда было объявлено, что новых моделей на нём ждать не стоит. Однако странно было бы провести мероприятие, а после этого в течение 3-4 недель выкатить новую модель и сказать «ой, а ещё вот такое есть, придумывайте всё заново».

—в том же сообщении Apples пишет, что GPT-5 может быть выпущена в декабре, но скорее всего в первом или даже втором квартале 2025-го.

— насколько я понимаю, план такой: скоро увидим Strawberry как технологию поверх GPT-4 (изменения будут заметные, но не крышесносные), потом 4.5 как добивочка, и через сколько-то месяцев пятёрка, со множественными улучшениями по всем фронтам, и увеличением размера модели (а равно и стоимости)

===

—такой календарь релизов может быть обусловлен действиями конкурентов. По двум источникам, Google хочет выпустить Gemini 2.0 в сентябре-октябре, и (тут без источников) Anthropic удивит Claude 3.5 Opus в то же время. OpenAI —с точки зрения компании — должны соответствовать или даже возглавлять новый раунд гонки.

—последняя новость для любителей опенсурса: Meta заканчивает создание крупного кластера из 100'000 GPU H100 для тренировки LLAMA-4 https://www.theinformation.com/articles/meta-will-soon-get-a-100-000-gpu-cluster-too-whats-life-at-character-like-now Ожидается, что его запустят в октябре-ноябре. Такой же кластер есть у xAI, почти уверен, что у Google и Microsoft (OpenAI) есть что-то сравнимое.

—если неделю назад ходили слухи о новой оценке OpenAI в ~$105B после нового раунда инвестиций, то вчера в TheInformation была уже указана цифра в ~$120B. Сегодня же Bloomberg написал, что их источники уже говорят о $150B. Первая цифра казалась странной (маленький скачок относительно предыдущей оценки в $86B), вторая уже понятной, а третья —впечатляющей. Скачок на 75%

—в эту оценку не входит привлекаемая сумма, то есть это так называемая pre money valuation

—планируется привлечь $6.5B (что меньше прошлого раунда в $10B), причём, Microsoft лишь один из многих инвесторов, и даже не лидирующий. Это значит, что инвестиции по большей степени будут деньгами, а не кредитами на вычислительные ресурсы

—кроме этого, с банками ведутся переговоры об открытии возобновляемой кредитной линии в $5B

— выходит, оценка компании будет составлять ~$156B. На бирже в открытом обращении лишь 90 компаний с оценкой выше. Примерно в том районе находятся: Caterpillar, Walt Disney, Morgan Stanley, AT&T, Goldman Sachs и Uber

—удивительно, но OpenAI не станет самой высоко оценённой приватной компанией —впереди ByteDance ($268B) и SpaceX ($210B)

===

— Strawberry может быть релизнута уже на этой неделе, если Sam Altman так решит (то есть в целом всё готово) —об этом сообщил Jimmy Apples. Обычно релизы-анонсы по четвергам, так что сегодня верим-надеемся-ждём. Но может быть и на следующей неделе

— новая информация: GPT-4.x (потенциально 4.5, если решатся так назвать) должна появиться в октябре, опять же, согласно Jimmy Apples. Напомню, 1-го октября OpenAI проводят в Сан-Франциско оффлайн DevDay 2024. Правда было объявлено, что новых моделей на нём ждать не стоит. Однако странно было бы провести мероприятие, а после этого в течение 3-4 недель выкатить новую модель и сказать «ой, а ещё вот такое есть, придумывайте всё заново».

—в том же сообщении Apples пишет, что GPT-5 может быть выпущена в декабре, но скорее всего в первом или даже втором квартале 2025-го.

— насколько я понимаю, план такой: скоро увидим Strawberry как технологию поверх GPT-4 (изменения будут заметные, но не крышесносные), потом 4.5 как добивочка, и через сколько-то месяцев пятёрка, со множественными улучшениями по всем фронтам, и увеличением размера модели (а равно и стоимости)

===

—такой календарь релизов может быть обусловлен действиями конкурентов. По двум источникам, Google хочет выпустить Gemini 2.0 в сентябре-октябре, и (тут без источников) Anthropic удивит Claude 3.5 Opus в то же время. OpenAI —с точки зрения компании — должны соответствовать или даже возглавлять новый раунд гонки.

—последняя новость для любителей опенсурса: Meta заканчивает создание крупного кластера из 100'000 GPU H100 для тренировки LLAMA-4 https://www.theinformation.com/articles/meta-will-soon-get-a-100-000-gpu-cluster-too-whats-life-at-character-like-now Ожидается, что его запустят в октябре-ноябре. Такой же кластер есть у xAI, почти уверен, что у Google и Microsoft (OpenAI) есть что-то сравнимое.

СВЕРШИЛОСЬ!

OpenAI представила новую языковую модель o1 (та самая Strawberry), обученную для сложных рассуждений

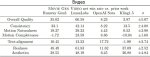

Модель o1 значительно превосходит GPT-4o по различным показателям, включая соревновательное программирование, математические олимпиады и вопросы научного уровня PhD

o1 показывает значительные улучшения в задачах, требующих сложных рассуждений, но для мелких задач, где рассуждения не нужны – она будет примерно такая же как 4o.

o1 отличается от предыдущих моделей встроенной способностью к "рассуждениям" (reasoning). В модель "вшита" способность к логическим выводам и самокритике/саморефлексии через chain of thought.

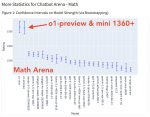

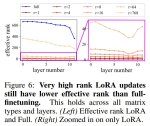

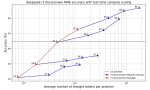

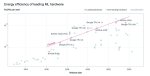

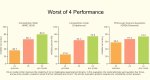

OpenAI рада объявить, что они открыли новое измерение для масштабирования. Теперь чем больше компьюта в инференсе, тем лучше результаты. Соответственно этот параметр можно улучшать либо путём затрачивания дополнительного времени, либо путём увеличения мощности железа. (пик 3. AIME —олимпиадные задания по математике)

Модель будет доступна с сегодня для всех пользователей API tier-5 и платной подписки.

Цены на новые модели кусаются и возвращают в эпоху релиза GPT-4, хотя маленькая версия более-менее доступна.

Жаль, что у всех моделей контекст лишь 128k токенов. Надеялся, что от этого уже уйдут.

https://openai.com/index/introducing-openai-o1-preview/

Выводы:

1. Скейлинг работает. Больше денег, больше данных = круче модель. Ужасные рассказы о том, что LLM уперлись в потолок снова оказались просто разговорами. А ведь сколько их было! В том числе от уважаемых людей. Теперь их лица даже имаджинировать не надо. Вместо скейлинга pre-training, теперь скейлится test time compute (то бишь инференс).

2. В точных задачах, типа математики o1 показывается в 7-8 раз круче результаты, чем gpt4o. В коде — в 8-9 раз. В задачкаъ по химии, физике — около 15% прироста.

3. OpenAI прямо зуб дают, что математические способности o1 не хуже, чем у победителя международной олимпиады по математике, а по точным наукам типа физики она работает не хуже кандидата наук.

4. В принципе, закиданный всеми на прошлой неделе в твиттере помидорами Reflection70B делал то же самое. Но не сделал. А Сэм — мужик. Сэм взял и сделал.

5. Стоит $60 за миллион токенов, а значит интеллект у нас теперь достанется только богатым.

6. Это пока что дорогая и медленная модель. Но именно используя эту новую парадигму ("думай, а потом говори"), OpenAI за ближайшие годы сделает o1 в десятки или даже сотни раз дешевле, быстрее и умнее.

7. "o1 думает, но думает несколько секунд. в будущих версиях она будет думать над сложными задачами несколько часов, дней или даже недель"

А ведь это только раскачка, скоро нас ждёт Orion

OpenAI представила новую языковую модель o1 (та самая Strawberry), обученную для сложных рассуждений

Модель o1 значительно превосходит GPT-4o по различным показателям, включая соревновательное программирование, математические олимпиады и вопросы научного уровня PhD

o1 показывает значительные улучшения в задачах, требующих сложных рассуждений, но для мелких задач, где рассуждения не нужны – она будет примерно такая же как 4o.

o1 отличается от предыдущих моделей встроенной способностью к "рассуждениям" (reasoning). В модель "вшита" способность к логическим выводам и самокритике/саморефлексии через chain of thought.

OpenAI рада объявить, что они открыли новое измерение для масштабирования. Теперь чем больше компьюта в инференсе, тем лучше результаты. Соответственно этот параметр можно улучшать либо путём затрачивания дополнительного времени, либо путём увеличения мощности железа. (пик 3. AIME —олимпиадные задания по математике)

Модель будет доступна с сегодня для всех пользователей API tier-5 и платной подписки.

Цены на новые модели кусаются и возвращают в эпоху релиза GPT-4, хотя маленькая версия более-менее доступна.

Жаль, что у всех моделей контекст лишь 128k токенов. Надеялся, что от этого уже уйдут.

https://openai.com/index/introducing-openai-o1-preview/

Выводы:

1. Скейлинг работает. Больше денег, больше данных = круче модель. Ужасные рассказы о том, что LLM уперлись в потолок снова оказались просто разговорами. А ведь сколько их было! В том числе от уважаемых людей. Теперь их лица даже имаджинировать не надо. Вместо скейлинга pre-training, теперь скейлится test time compute (то бишь инференс).

2. В точных задачах, типа математики o1 показывается в 7-8 раз круче результаты, чем gpt4o. В коде — в 8-9 раз. В задачкаъ по химии, физике — около 15% прироста.

3. OpenAI прямо зуб дают, что математические способности o1 не хуже, чем у победителя международной олимпиады по математике, а по точным наукам типа физики она работает не хуже кандидата наук.

4. В принципе, закиданный всеми на прошлой неделе в твиттере помидорами Reflection70B делал то же самое. Но не сделал. А Сэм — мужик. Сэм взял и сделал.

5. Стоит $60 за миллион токенов, а значит интеллект у нас теперь достанется только богатым.

6. Это пока что дорогая и медленная модель. Но именно используя эту новую парадигму ("думай, а потом говори"), OpenAI за ближайшие годы сделает o1 в десятки или даже сотни раз дешевле, быстрее и умнее.

7. "o1 думает, но думает несколько секунд. в будущих версиях она будет думать над сложными задачами несколько часов, дней или даже недель"

А ведь это только раскачка, скоро нас ждёт Orion

>В модель "вшита" способность к логическим выводам и самокритике/саморефлексии через chain of thought

то есть целое нихуя в виде гпт4о с CoT?

вау

>Модель o1 значительно превосходит GPT-4o

Это же гениальный развод гоев. Делаешь 4о лоботомитом на уровне 7b, потом выкатываешь модель, которая "превосходит" его, хотя его не превосходят разве что локальные микромодели. Гои в восторге, можно стричь шекели буквально за нихуя.

AGI на пороге, пацаны.

Ты даже меня, сука, доебал уже. Если бы мне ИРЛ задали тупорылый вопрос уровня "Батя хирург сказал, что не будет оперировать сына, кем приходится хирург мальчику?"Я б тоже начал искать в вопросе какую-то подъебку, ибо не может же быть вопрос настолько тупорылым. Иди нахуй, блядь.

Проорал с твоих пикч. Ты его поди на тюремных загадках двача и гей шутках наобучал, он теперь пишет исходя из контекста твоих с ним предыдущих коммуникаций.

🟢Согласно внутренней оценке OpenAI, новые модели получили «средний» уровень риска в отношении химического, биологического, радиологического и ядерного оружия.

🟢Это самый высокий уровень, который когда-либо присваивали моделям компании.

🟢Он показывает возросшую вероятности использования ИИ для разработки оружия.

🟢При этом энтузиасты в X уже нашли джейлбрейк к модели, после чего она рассказала рецепты запрещенных веществ.

Ведущий эксперт по ИИ, профессор Монреальского университета Йошуа Бенджио, подчеркнул, что возросший уровень риска подтверждает необходимость в срочном принятии законодательных мер. https://www.ft.com/content/37ba7236-2a64-4807-b1e1-7e21ee7d0914

🟢Это самый высокий уровень, который когда-либо присваивали моделям компании.

🟢Он показывает возросшую вероятности использования ИИ для разработки оружия.

🟢При этом энтузиасты в X уже нашли джейлбрейк к модели, после чего она рассказала рецепты запрещенных веществ.

Ведущий эксперт по ИИ, профессор Монреальского университета Йошуа Бенджио, подчеркнул, что возросший уровень риска подтверждает необходимость в срочном принятии законодательных мер. https://www.ft.com/content/37ba7236-2a64-4807-b1e1-7e21ee7d0914

Представлен HeyGen Avatar 3.0

Динамическое понимание сценария: Аватары теперь понимают все нюансы ваших слов

Точные выражения лица: Эмоции, соответствующие вашему сообщению

Точные голосовые интонации: Каждое слово передается с идеальной интонацией

Движения: не ограничиваются синхронизацией губ, а демонстрируют динамические движения всего тела

Они еще и поют...

В твитторе разработчики обещают, что скоро туда можно будет кормить ИИ-клонов. То есть картинки из Флюкса и Midjourney.

Динамическое понимание сценария: Аватары теперь понимают все нюансы ваших слов

Точные выражения лица: Эмоции, соответствующие вашему сообщению

Точные голосовые интонации: Каждое слово передается с идеальной интонацией

Движения: не ограничиваются синхронизацией губ, а демонстрируют динамические движения всего тела

Они еще и поют...

В твитторе разработчики обещают, что скоро туда можно будет кормить ИИ-клонов. То есть картинки из Флюкса и Midjourney.

Tencent представили GameGen-O — первый в мире генератор игр с открытым миром! Новая нейросеть генерирует функции игрового движка, включая персонажей, события и динамическое окружение до бесконечности.

GameGen-O генерирует видеоряд, позволяет его интерактивно контролировать, прогнозирует будущее и генерирует следующие кадры. Принцип такой: если вы повернули персонажа направо, ИИ генерирует окружение справа и так далее.

Видосы немного плывут, но всё равно впечатляют. Код скоро выпустят на GitHub.

https://github.com/GameGen-O/GameGen-O

GameGen-O генерирует видеоряд, позволяет его интерактивно контролировать, прогнозирует будущее и генерирует следующие кадры. Принцип такой: если вы повернули персонажа направо, ИИ генерирует окружение справа и так далее.

Видосы немного плывут, но всё равно впечатляют. Код скоро выпустят на GitHub.

https://github.com/GameGen-O/GameGen-O

Жду когда озвучат знаменитую пасту про сталина 3тысячи, пока все хуево было.

>новые системы ИИ: "Клубничка"

Блядь, какое название проебали, ведь там не будет никакой клубнички.

>Раньше бутылочным горлышком в ИИ была архитуктура. Теперь компании практически о ней не думают

Поэтому никакого AGI ждать не стоит, ибо трансформеры уёбищная архитектура.

>немногих штатов с избытком электроэнергии. Обусловлено это огромными запасами нефти

Зелёные оргазмируют без перерыва.

Думаю, скорее их комбинируют, или вообще откроют доступ к топовым моделям только с оплатой за токены потребления.

Забавно, что это именно та система, где роботакси беспрерывно сигналили на парковке. Удивляет такое сочетание вроде бы как хороших торможений и полностью долбоёбской системы парковки.

>Сегодня же Bloomberg написал, что их источники уже говорят о $150B.

Ебать оценка воздуха. Ещё полгода, и можно будет продаваться, выходя в кеш.

>Модель o1 значительно превосходит GPT-4o

Неудивительно, омни тупая как пробка, её чуть ли не ллама 8B ебёт.

>«средний» уровень риска в отношении химического, биологического, радиологического и ядерного оружия

Ух бля, сделает мне ядерку с доставкой на дом?

ну че-то пока выглядит как бродилка в бреду но не более

ждём более пиздатых решений

Че у тебя так жопа горит от ИИ? Ты художник?

Напомнило вопрос который мне задали когда в первый класс принимали типа "мальчик проснулся, потом заправил кровать, что он сделал потом?". Я ебу что ли, съел сэндвич?

GPT поясняет что нормальные люди так не говорят и если уточняется что хирург отец то это значит намек на гендерные роли.

>Понимаю твоё замечание. В вопросе действительно упоминается, что хирург — отец мальчика. Но, как показано в примере, эта задача иллюстрирует стереотипы и предвзятости, связанные с полом. В реальности же ответ на вопрос: если хирург — это отец, то это может быть ошибка в вопросе или пример с целью продемонстрировать наше восприятие ролей.

Короче у ГПТ нету полного контекста который есть у людей в треде.

Моя жопа горит от кривых решений и медленного развития ИИ. Где роботянучки в каждый дом? Хули я всё ещё трачу 8 часов на РАБоту погромизд на самом деле, а не сижу на БОД.

Ебать, там вопросы задавали?

Мимо попал в класс ЗПР по первости. Потом конечно перевели.

Новый бенчмарк для ГПТ подъехал

>Продавец магазина автозапчастей на Камчатке написал на образце заявления на возврат «Закиев Замир Рустамович». Теперь магазин проверяет ФСБ.

>Продавец магазина автозапчастей на Камчатке написал на образце заявления на возврат «Закиев Замир Рустамович». Теперь магазин проверяет ФСБ.

Рунвей выкатил новую фичу - video2video (тут, справедливости ради, надо сказать, что у опенсорсного CogVideo такая фича уже есть, но качество далеко позади).

Сначала это воспринимается как стилизация видео. Но если поглядеть на примеры, которые я вам натаскал не из демо Рунвея, а от подписчиков и твитторских, то это сильно шире.

Оно переделывает мир вокруг. Это не пиксельфакинг и фильтры поверх картинки, это как бы перемоделинг, перерендер и перекомпоз. Метакомпоз в общем.

Поглядите на пластиковые звездные войны или сцену из Матрицы.

Можно делать пластилиновую ворону из пиксаровских Birds и обратно.

Можно завернуть Парк Юрского периода в Aardman Animation

Можно переделать Южный парк в Южный централ

Ну вы поняли...

Для целей продакшена это выглядит как ВидеоКонтролНет - подснимайте референсы и ну крутить промпты.

Но народ в сети далек от поста, поэтому все бросились делать что?

Правильно, наваливать video2video на свои же сгенеренные видео. Ну и это не лишено смысла.

Получается такой Креативный Апскейл - где апскейлятся не пиксели, а ваши рахитичные идеи, ваш креатив.

В общем выходные буду завалены мемными генерациями сцен из фильмов, клипов и прочего вирусняка.

Ну и на сладкое - расценки:

5 секунд - 50 кредитов (~$1.20)

10 секунд - 100 кредитов (~$2.40)

Сначала это воспринимается как стилизация видео. Но если поглядеть на примеры, которые я вам натаскал не из демо Рунвея, а от подписчиков и твитторских, то это сильно шире.

Оно переделывает мир вокруг. Это не пиксельфакинг и фильтры поверх картинки, это как бы перемоделинг, перерендер и перекомпоз. Метакомпоз в общем.

Поглядите на пластиковые звездные войны или сцену из Матрицы.

Можно делать пластилиновую ворону из пиксаровских Birds и обратно.

Можно завернуть Парк Юрского периода в Aardman Animation

Можно переделать Южный парк в Южный централ

Ну вы поняли...

Для целей продакшена это выглядит как ВидеоКонтролНет - подснимайте референсы и ну крутить промпты.

Но народ в сети далек от поста, поэтому все бросились делать что?

Правильно, наваливать video2video на свои же сгенеренные видео. Ну и это не лишено смысла.

Получается такой Креативный Апскейл - где апскейлятся не пиксели, а ваши рахитичные идеи, ваш креатив.

В общем выходные буду завалены мемными генерациями сцен из фильмов, клипов и прочего вирусняка.

Ну и на сладкое - расценки:

5 секунд - 50 кредитов (~$1.20)

10 секунд - 100 кредитов (~$2.40)

>В общем выходные буду завалены мемными генерациями сцен из фильмов, клипов и прочего вирусняка.

Когда же нейровысеры будут везде помечать и фильтровать по дефолту от нормальных людей?

Не понимаю как этот нормиз вообще рассчитывает стоимость, всем известно что за тройную прибыль-капиталист родную мать продаст а за половину от стоимости специалиста-будет неплохо маслить инвесторами эдак на 1000% от стоимости проекта в потенциале.

У тебя есть нейронка, с которой спец может сделать как минимум на 200% больше и на 200% быстрее (это еще скромно) в любом пайплайне, так же скромно есть вероятность что он сделает это еще и на 200% лучше (поскольку обучение с нейросетями действительно быстрее+нейросеть реально может знать ВСЮ теорию и базу по сабжу)

Был бы я глобальным предиктором-через год бы у половины мира электричество и домашние видеокарты отобрал-а их самих-рабочими, клепать чипы на заводы TSMC

Рисобака-спок, пора смириться с поражением и умереть.

AI официально креативнее хуманов, че делать бум? Только нужны норм идеи а не как обычно.

Ну как обычно-плакать, потом на завод.

>креативнее

>все ещё высирает слоп в 99% случаев

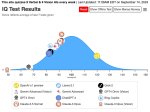

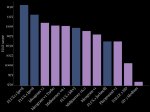

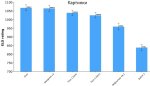

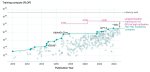

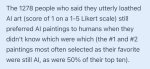

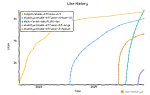

GPT-o1 оказалась единственной моделью, которая превзошла средний человеческий IQ

Чтобы избежать утечки данных, то есть гарантировать, что вопросов из теста не было в обучающей выборке модели, журналист составил тест по образу и подобию классического Norwegian Mensa, дал его пройти закрытой группе людей, а затем удалил из всех источников. И именно на этом тесте он проверил o1.

Получилась вот такая картина (пикрелейтед)

Кстати, можете проверить себя и сравнить свои способности с o1: на сайте: https://www.maximumtruth.org/p/massive-breakthrough-in-ai-intelligence со статьей есть примеры сложных заданий из классического IQ теста, которые o1 решила правильно + ее ответы.

Лица нормисов, утверждавших, что в ЛЛМ нет логики, имаджинировали под микроскопом?

Чтобы избежать утечки данных, то есть гарантировать, что вопросов из теста не было в обучающей выборке модели, журналист составил тест по образу и подобию классического Norwegian Mensa, дал его пройти закрытой группе людей, а затем удалил из всех источников. И именно на этом тесте он проверил o1.

Получилась вот такая картина (пикрелейтед)

Кстати, можете проверить себя и сравнить свои способности с o1: на сайте: https://www.maximumtruth.org/p/massive-breakthrough-in-ai-intelligence со статьей есть примеры сложных заданий из классического IQ теста, которые o1 решила правильно + ее ответы.

Лица нормисов, утверждавших, что в ЛЛМ нет логики, имаджинировали под микроскопом?

Если IQ относительный и 100 баллов всегда средний то теперь когда у роботов 120 это новые 100 наши 100 стали новыми 80.

Не матерись, я погромизд, уставший от засилья нейроты просто.

>в ЛЛМ нет логики

Всё ещё нет.

Тесты IQ для людей, так что никакой нормализации.

>Всё ещё нет.

Есть. Логические задачи решает? Решает. Значит есть.

>Логические задачи решает?

Нет, только подбирает похоже выглядящие токены.

Аргументов, кстати, не будет

>GPT-o1

Нет никакого о1. Не существует. Не нужно вскрывать эту тему.

>примеры сложных заданий

Перешёл, сразу же матрица картинок. Картинки о1 не принимает. Автор описывал своими словами. И как же так вышло, что по текстовому описанию гопота поняла, какие ответы правильные, удивительно.

Описание принципа работы нейронки- вот мои аргументы.

Да вы заебали, блядь. Недавно видел картинку где загадка про дно и крышку стакана была, оно не ответило. Любой даун ответит. В каких-то конкретных отдельных вопросах или может быть в среднем она 120, но на отдельных тупит как даун, вот это нужно решать, иначе получится хуйня.

Эмердженция.

Да, это я. Не трансформеры.

Палю лайфхак: скармливаешь картинку гпт 4о, прося ничего с ней не делать. Затем переключаешь на о1 и говоришь, реши предыдущую картинку. Профит

Хуй, который делал тест, признаёт, что описывал словами картинки. То есть весь тест это буквально проверка того, насколько хорошо он может описывать задачу.

>вот мои аргументы.

Так и знал, что обосрёшься

Вкинь эту загадку сюда, я тебе покажу как её решают ллм

Copilot 2.0 — ВЫШЕЛ. Microsoft выкатила вторую версию своего кодинг-ассистента. Тепень прога еще и работает в Excel — весь анализ данных под капотом делает Python. Знать формулы больше не нужно.

• Пишем запрос — Copilot сразу сгенерит, вставит и выполнит код.

• Топовая визуализация данных — ИИ рисует максимально понятные диаграммы и графики, как профессиональный дизайнер.

• Работает с любыми формулами и даже составляет прогнозы.

• Знает все финансовые операции и ведет бухгалтерию.

Доступен бесплатно в Excel, PowerPoint, Outlook, Word и OneDrive.

• Пишем запрос — Copilot сразу сгенерит, вставит и выполнит код.

• Топовая визуализация данных — ИИ рисует максимально понятные диаграммы и графики, как профессиональный дизайнер.

• Работает с любыми формулами и даже составляет прогнозы.

• Знает все финансовые операции и ведет бухгалтерию.

Доступен бесплатно в Excel, PowerPoint, Outlook, Word и OneDrive.

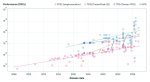

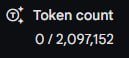

Лимиты на использование о1-mini увеличены в 7 раз.

"Для пользователей Plus и Team мы увеличили тарифные лимиты для o1-mini в 7 раз, с 50 сообщений в неделю до 50 сообщений в день.

Обслуживание o1-preview обходится дороже, поэтому мы увеличили лимит с 30 сообщений в неделю до 50 сообщений в неделю. В API-версии тоже подняли лимиты (пик2)

https://x.com/OpenAI/status/1835857163765637607

"Для пользователей Plus и Team мы увеличили тарифные лимиты для o1-mini в 7 раз, с 50 сообщений в неделю до 50 сообщений в день.

Обслуживание o1-preview обходится дороже, поэтому мы увеличили лимит с 30 сообщений в неделю до 50 сообщений в неделю. В API-версии тоже подняли лимиты (пик2)

https://x.com/OpenAI/status/1835857163765637607

Ты бы это в гопота тред писал бы.

А когда для бичей его откроют?

Ебать дебил

Читать как "после 3 дней раздутого хайпа, бесполезную для обычных людей хуйню с токенблоатом никто не юзает, поэтому сделаем вид, что с барского плеча холопам поднимаем лимит".

гой даже за баринские крошки нужно платить терпи

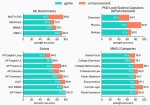

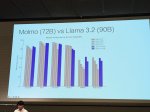

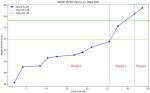

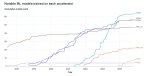

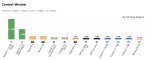

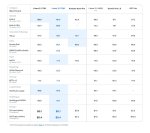

LMSYS Arena обновила рейтинг, добавив свежие модельки о1. Напомню, что LLM этого семейства не позиционируются как хорошие во всём, и заточены на науку (математика/физика/программирование). OpenAI не обещали улучшений по всем фронтам, ОДНАКО модели всё равно в топе - на первом и третьем месте. И это с учётом контроля по стилю и длине - то есть к рейтингу модели применяют некоторую поправку, которая штрафует за очень длинные ответы, а также те, что содержат много списков, заголовков итд. Детали в официальном блоге тут: https://lmsys.org/blog/2024-08-28-style-control/https://lmsys.org/blog/2024-08-28-style-control/

В математике отрывы вообще неприличные (второй скрин).

А ещё обратите внимание, что обновилась модель ChatGPT (это та, которая заточена на диалоги, и именно к ней получают доступ пользователи сайта chatgpt) - она заработала +20 очков относительно предыдущей версии. То есть o1 лучше ChatGPT которая лучше прошлых ChatGPT которые лучше всех остальных моделей.

В математике отрывы вообще неприличные (второй скрин).

А ещё обратите внимание, что обновилась модель ChatGPT (это та, которая заточена на диалоги, и именно к ней получают доступ пользователи сайта chatgpt) - она заработала +20 очков относительно предыдущей версии. То есть o1 лучше ChatGPT которая лучше прошлых ChatGPT которые лучше всех остальных моделей.

Несколько коротких новостей:

—CEO GitHub тизерит появление моделей o1 завтра в своём продукте. Это может быть как рядовая замена модели, не привнёсшая ничего нового с точки зрения UX, так и кардинальное улучшение Copilot, который теперь будет гораздо лучше планировать изменения в коде и размышлять о том, что имел в виду пользователь. https://x.com/ashtom/status/1836648898158612583

—Ходят слухи, что, возможно, в ближайшее время (чуть ли не на этой неделе) Google представит новую Gemini (может быть 2.0, может быть Ultra —её же не обновили до 1.5) https://x.com/apples_jimmy/status/1836571578987090040 Особый упор будет сделан на программирование. Вообще Google точно делал исследовательскую работу в том же направлении, что и OpenAI для o1, потому не станет удивлением, если будет схожий анонс с теми же акцентами. Google даже может превзойти OpenAI за счёт большего количества вычислительных мощностей на тренировку LLM —Sam Altman озвучивал такие опасения менеджерам в Microsoft.

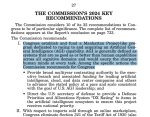

—несколько представителей AI индустрии сходили в Сенат США, где их опрашивали про регуляции. Там была и Helen Toner, бывший член совета директоров, уволившаяся после возвращения Sam Altman. В своём вводном слове она говорила, что большинство регуляций надо направить на системы будущего, а не текущего поколения, и что дипфейки и GenAI это конечно опасно, но нужно думать про более глобальное влияние. И последующие 2 часа в Сенате говорили про... дипфейки и подмену голоса в звонках (рукалицо) https://youtu.be/WVU7Awba3VM

—ещё в этих слушаниях поднялась интересная тема разницы компенсаций в индустрии и в гос. структурах, и что никакой шарящий человек не пойдет работать в агентство-регулятор на зп в 5-10 раз меньше. Что-то с этим нужно делать.

—Microsoft и BlackRock (крупнейшая в мире инвест-компания, под управлением которой находится имущества на 10 триллионов долларов, примерно 8% мирового ВВП) планируют открыть инвест-фонд на... 30 миллиардов долларов. А ещё он может быть расширен до $100B. Цель фонда —инвестиции в инфраструктуру для AI. Обратите внимание, что это не то же, что инвестировать в OpenAI. Это именно про налаживание производства и цепочек поставок, про строительство датацентров и электростанций. Вероятно, BlackRock считает, что в ближайшие годы будет дефицит, и они хотят сыграть на опережение. Партнёрами также выступит MGX, крупный фонд из ОАЭ. https://techcrunch.com/2024/09/17/blackrock-and-microsoft-are-reportedly-planning-a-30b-ai-focused-megafund/

—неделю назад CEO OpenAI, Anthropic, Nvidia и президент Google ходили в Белый дом для обсуждения будущего электроэнерегетики, инфраструктуры под AI, производства полупроводников. Позже на той же неделе было объявлено о создании рабочей группы по AI Datacenter Infrastructure. Департамент энергетики (Department of Energy звучит несерьезно, но они отвечают за ядерное оружие и энергетику, а также под их контролем находятся самые мощные публичные суперкомпьютеры) выделит отдельную команду под AI-датацентры и общение с частным сектором. Также DOE будет рассматривать выведенные из эксплуатации места добычи угля в качестве источников сырья для выработки энерегии, на основе чего будет приниматься решени о размещении датацентров и фабрик. https://www.cnbc.com/2024/09/12/openai-anthropic-and-google-leaders-met-with-white-house-to-talk-ai-.html

—CEO GitHub тизерит появление моделей o1 завтра в своём продукте. Это может быть как рядовая замена модели, не привнёсшая ничего нового с точки зрения UX, так и кардинальное улучшение Copilot, который теперь будет гораздо лучше планировать изменения в коде и размышлять о том, что имел в виду пользователь. https://x.com/ashtom/status/1836648898158612583

—Ходят слухи, что, возможно, в ближайшее время (чуть ли не на этой неделе) Google представит новую Gemini (может быть 2.0, может быть Ultra —её же не обновили до 1.5) https://x.com/apples_jimmy/status/1836571578987090040 Особый упор будет сделан на программирование. Вообще Google точно делал исследовательскую работу в том же направлении, что и OpenAI для o1, потому не станет удивлением, если будет схожий анонс с теми же акцентами. Google даже может превзойти OpenAI за счёт большего количества вычислительных мощностей на тренировку LLM —Sam Altman озвучивал такие опасения менеджерам в Microsoft.

—несколько представителей AI индустрии сходили в Сенат США, где их опрашивали про регуляции. Там была и Helen Toner, бывший член совета директоров, уволившаяся после возвращения Sam Altman. В своём вводном слове она говорила, что большинство регуляций надо направить на системы будущего, а не текущего поколения, и что дипфейки и GenAI это конечно опасно, но нужно думать про более глобальное влияние. И последующие 2 часа в Сенате говорили про... дипфейки и подмену голоса в звонках (рукалицо) https://youtu.be/WVU7Awba3VM

—ещё в этих слушаниях поднялась интересная тема разницы компенсаций в индустрии и в гос. структурах, и что никакой шарящий человек не пойдет работать в агентство-регулятор на зп в 5-10 раз меньше. Что-то с этим нужно делать.

—Microsoft и BlackRock (крупнейшая в мире инвест-компания, под управлением которой находится имущества на 10 триллионов долларов, примерно 8% мирового ВВП) планируют открыть инвест-фонд на... 30 миллиардов долларов. А ещё он может быть расширен до $100B. Цель фонда —инвестиции в инфраструктуру для AI. Обратите внимание, что это не то же, что инвестировать в OpenAI. Это именно про налаживание производства и цепочек поставок, про строительство датацентров и электростанций. Вероятно, BlackRock считает, что в ближайшие годы будет дефицит, и они хотят сыграть на опережение. Партнёрами также выступит MGX, крупный фонд из ОАЭ. https://techcrunch.com/2024/09/17/blackrock-and-microsoft-are-reportedly-planning-a-30b-ai-focused-megafund/

—неделю назад CEO OpenAI, Anthropic, Nvidia и президент Google ходили в Белый дом для обсуждения будущего электроэнерегетики, инфраструктуры под AI, производства полупроводников. Позже на той же неделе было объявлено о создании рабочей группы по AI Datacenter Infrastructure. Департамент энергетики (Department of Energy звучит несерьезно, но они отвечают за ядерное оружие и энергетику, а также под их контролем находятся самые мощные публичные суперкомпьютеры) выделит отдельную команду под AI-датацентры и общение с частным сектором. Также DOE будет рассматривать выведенные из эксплуатации места добычи угля в качестве источников сырья для выработки энерегии, на основе чего будет приниматься решени о размещении датацентров и фабрик. https://www.cnbc.com/2024/09/12/openai-anthropic-and-google-leaders-met-with-white-house-to-talk-ai-.html

>BlackRock

>планируют открыть инвест-фонд

>инвестиции в инфраструктуру для AI

Чё всё, пиздец всему AI? Чёрный камень это царь Говномидас, всё, к чему прикасается - превращается в говно.

Сэм Альтман в новом выступлении пояснил за уровни развития ИИ. По его мнению, ступеней всего пять:

1. Чат-боты

2. Ризонеры (рассуждающие чат-боты) <- после выхода o1 вы находитесь здесь

3. Агенты

4. Инноваторы (ИИ, который может делать научные открытия)

5. И, наконец, целые организации, состоящие из ИИ-агентов

"Переход c уровня один на уровень два занял у нас очень много времени, но благодаря этому сейчас мы ускоренно двигаемся на уровень три".

1. Чат-боты

2. Ризонеры (рассуждающие чат-боты) <- после выхода o1 вы находитесь здесь

3. Агенты

4. Инноваторы (ИИ, который может делать научные открытия)

5. И, наконец, целые организации, состоящие из ИИ-агентов

"Переход c уровня один на уровень два занял у нас очень много времени, но благодаря этому сейчас мы ускоренно двигаемся на уровень три".

Kling AI показали обновление 1.5 с новой функцией Motion Brush https://klingai.com/release-notes

Что нового:

- более точное следование промпту, разрешение в 1080р HD (до этого было 720)

- максимальная длина видео увлеличена до 10 секунд

- новая фича Motion Brush, с помощью которой можно выделять объекты и задавать траекторию их движения (2 последних видео). Пока доступна только в Kling V1.

Обновленная версия доступна только для платных подписчиков (от $10/мес).

Что нового:

- более точное следование промпту, разрешение в 1080р HD (до этого было 720)

- максимальная длина видео увлеличена до 10 секунд

- новая фича Motion Brush, с помощью которой можно выделять объекты и задавать траекторию их движения (2 последних видео). Пока доступна только в Kling V1.

Обновленная версия доступна только для платных подписчиков (от $10/мес).

Где там о1? Нет нихуя. Подскажите как получить доступ!

В слепом тесте: https://lmarena.ai/

>смотрите мы можем генерировать ебальники и пейзажи

>а можно что-то сложнее и больше 5 секунд?

>эээ ыыы ааа))) у нас ещё в ФУЛ ХД генерируется всё!! и вапще прагресс понимаете ли))

Вышла полная версия интервью с разработчиками o1. Основное и самое интересное:

⚪️ Вдохновлялись RL из AlphaGo. Название o1 символизирует, что это новое поколение моделей: от есть не очередная gpt, а полная смена подхода и парадигмы. Кстати, лого модели символизирует пришельца- сверхразума.

⚪️ Разработка o1 была большим вызовом: разработчики столкнулись с кучей проблем с масштабированием рассуждений и оптимизацией. Также много внимания пришлось уделить этике (так они назвали то, что скрывают от пользователей большую часть рассуждений 😍)

⚪️ Оказывается o1 mini на большинстве тестов не отстает от o1 preview, потому что обучена рассуждать ничуть не хуже, просто знает меньше фактов. Очень важный тейк с точки зрения скейлинга.

⚪️ Во время тестирования модели был выявлен огромный потенциал модели к философским рассуждениям, творческому подходу и, самое главное, самокритике. Это, по словам разработчиков, и есть поворотные фичи для ИИ.

⚪️ В планах у OpenAI прикрутить к модели интерпретатор, сделать ее мультимодальной и более управляемой для пользователя.

https://www.youtube.com/watch?v=tEzs3VHyBDM

⚪️ Вдохновлялись RL из AlphaGo. Название o1 символизирует, что это новое поколение моделей: от есть не очередная gpt, а полная смена подхода и парадигмы. Кстати, лого модели символизирует пришельца- сверхразума.

⚪️ Разработка o1 была большим вызовом: разработчики столкнулись с кучей проблем с масштабированием рассуждений и оптимизацией. Также много внимания пришлось уделить этике (так они назвали то, что скрывают от пользователей большую часть рассуждений 😍)

⚪️ Оказывается o1 mini на большинстве тестов не отстает от o1 preview, потому что обучена рассуждать ничуть не хуже, просто знает меньше фактов. Очень важный тейк с точки зрения скейлинга.

⚪️ Во время тестирования модели был выявлен огромный потенциал модели к философским рассуждениям, творческому подходу и, самое главное, самокритике. Это, по словам разработчиков, и есть поворотные фичи для ИИ.

⚪️ В планах у OpenAI прикрутить к модели интерпретатор, сделать ее мультимодальной и более управляемой для пользователя.

https://www.youtube.com/watch?v=tEzs3VHyBDM

Сбер начал тестирование автономных грузовиков на трассе М-11 «Нева» с водителем-испытателем на пассажирском сидении (вебм 1).

«Старлайн» перехватила эстафету Сбера и тоже пересадила водителя-испытателя автономного грузовика на переднее пассажирское сидение (вебм 2)

«Старлайн» перехватила эстафету Сбера и тоже пересадила водителя-испытателя автономного грузовика на переднее пассажирское сидение (вебм 2)

>не очередная gpt, а полная смена подхода и парадигмы

>всё ещё трансформеры

Лол.

Я кобольдаи научил рассуждать, запердолив пошаговое решение задачи в контекст. Точность решение математических задач уровня 5 класс сложить и перемножить 4 пятизначных числа возрос с 0% до 90%+

Где моя нобелевка и +100500 к моей капитализации?

Где моя нобелевка и +100500 к моей капитализации?

На джона похуй.

сорян ты не жидоальтман

Microsoft подписали контракт на покупку любого количества энергии, производимой на американской АЭС Three Mile Island, в следующие 20 лет. Эта АЭС —как Чернобыльская станция в СССР: в 1979-м году там произошла авария на одном из двух блоков. Это была крупнейшая авария в истории коммерческой атомной энергетики США, которая усилила уже существовавший кризис и вызвала всплеск антиядерных настроений в обществе. Хотя всё это и не привело к мгновенному прекращению роста атомной энергетической отрасли США, её историческое развитие было остановлено. После 1979 и до 2012 года ни одной новой лицензии на строительство АЭС не было выдано, а ввод в строй 71 ранее запланированной станции был отменён —ушла эпоха.

Первый (из двух) блоков станции в порядке, он работал до 2019-го года (на ЧАЭС тоже после выхода из строя четвертого блока продолжалась выработка энергии на остальных трёх —вплоть до 2000-го года). Но его решено было остановить по экономическим причинам: столько энергии не было нужно, да и в США появились более дешёвые источники выработки.

Старющий реактор в штате Пенсильвания должны перезапустить к 2028-му, на АЭС вернутся ~600 специалистов —и всё это для того, чтобы получить лишние 835 мегаватт энергии для подпитки датацентров. Этого примерно хватит для содержания 700'000 домов в США, но всё уйдет на обучение GPT-N+1 и генерацию картинок.

Google не отстаёт —буквально на днях СЕО Alphabet Sundar Pichai хвастался, что у них уже в работе гигаваттный датацентр, и что его хотят подпитывать современными небольшими модульными ядерными реакторами. Ну и новости про Oracle/Amazon не забываем —те тоже ударились в ядерку.

Кажется, AI гонка и нехватка энергии для будущих датацентров подстегнули развитие атомной энергетики в США как никто другой в последние 40 лет. https://archive.md/5O8uW#selection-4745.0-4745.17

Первый (из двух) блоков станции в порядке, он работал до 2019-го года (на ЧАЭС тоже после выхода из строя четвертого блока продолжалась выработка энергии на остальных трёх —вплоть до 2000-го года). Но его решено было остановить по экономическим причинам: столько энергии не было нужно, да и в США появились более дешёвые источники выработки.

Старющий реактор в штате Пенсильвания должны перезапустить к 2028-му, на АЭС вернутся ~600 специалистов —и всё это для того, чтобы получить лишние 835 мегаватт энергии для подпитки датацентров. Этого примерно хватит для содержания 700'000 домов в США, но всё уйдет на обучение GPT-N+1 и генерацию картинок.

Google не отстаёт —буквально на днях СЕО Alphabet Sundar Pichai хвастался, что у них уже в работе гигаваттный датацентр, и что его хотят подпитывать современными небольшими модульными ядерными реакторами. Ну и новости про Oracle/Amazon не забываем —те тоже ударились в ядерку.

Кажется, AI гонка и нехватка энергии для будущих датацентров подстегнули развитие атомной энергетики в США как никто другой в последние 40 лет. https://archive.md/5O8uW#selection-4745.0-4745.17

Пока всё идёт в точности как предсказывал Леопольд Ашенбреннер

TechCrunch сообщает шокирующие цифры: Роботакси Waymo теперь совершает более 100 000 платных поездок в неделю. Это в два раза больше, чем было совсем недавно. Ожидается, что эта цифра вырастет в 10 раз в течении года. Сотни роботакси Jaguar I-Pace колесят по улицам Лос-Анджелеса, Сан-Франциско и Феникса круглосуточно, 7 дней в неделю.

Они не устают, не берут выходных и не требуют повышения зарплаты. Компания попросила воздержаться от имаджинирования лиц таксистов. Но мы всё же поимаджинируем:

Представьте, что вы просыпаетесь утром и обнаруживаете, что ваша профессия исчезла за одну ночь. Именно это происходит прямо сейчас с водителями такси в США, благодаря стремительному росту Waymo — сервиса автономных такси от Google.

Но за каждым технологическим прорывом стоит человеческая драма. При средней нагрузке в 20 поездок в день на одного водителя, Waymo уже лишил работы около 700 человек. А через год? Эта цифра вырастет до 7000 безработных водителей.

Представьте себе масштаб: 7000 семей без основного источника дохода. 7000 историй о потерянных мечтах и разрушенных карьерах. И это только начало.

Мы стоим на пороге новой эры, где машины не просто помогают людям, а заменяют их. Waymo — это не просто сервис такси, это предвестник глобальных изменений на рынке труда.

Вопрос теперь не в том, произойдет ли эта революция, а в том, готовы ли мы к ней. И что будут делать тысячи водителей, оставшихся без работы.

Они не устают, не берут выходных и не требуют повышения зарплаты. Компания попросила воздержаться от имаджинирования лиц таксистов. Но мы всё же поимаджинируем:

Представьте, что вы просыпаетесь утром и обнаруживаете, что ваша профессия исчезла за одну ночь. Именно это происходит прямо сейчас с водителями такси в США, благодаря стремительному росту Waymo — сервиса автономных такси от Google.

Но за каждым технологическим прорывом стоит человеческая драма. При средней нагрузке в 20 поездок в день на одного водителя, Waymo уже лишил работы около 700 человек. А через год? Эта цифра вырастет до 7000 безработных водителей.

Представьте себе масштаб: 7000 семей без основного источника дохода. 7000 историй о потерянных мечтах и разрушенных карьерах. И это только начало.

Мы стоим на пороге новой эры, где машины не просто помогают людям, а заменяют их. Waymo — это не просто сервис такси, это предвестник глобальных изменений на рынке труда.

Вопрос теперь не в том, произойдет ли эта революция, а в том, готовы ли мы к ней. И что будут делать тысячи водителей, оставшихся без работы.

Блять, тупорылое уебище, ты можешь постить новости по теме а не просто рандомную хуйню о технологиях? Название доски видел?

Ты вежливо можешь общаться или твоя мать шлюха таким быдлом тебя воспитала?

агрессивная пидорашка спок

новости об ИИ, как ты без него роботакси сделаешь? вот и соси хуй быдло

>ты можешь постить новости по теме

Ебанько Анонович, докладываю вам, что новость по теме, так как роботакси управляется нейросетью, внезапно.

>подстегнули развитие атомной энергетики в США

А хули толку, если они не выше четвёртого места в мире? После Китая, России, и прости Господи Франции?

>Они не устают, не берут выходных

А просто стоят и гудят на парковке, ага.