Окей

В дополнение к этому

Все настройки я постарался вынести в stack.env

По koboldai/koboldcpp, которые нужно заполнить:

Имя модели, вот прям полное имя с расширением.

MODEL_NAME=Llama-3.2-3B-Instruct-Q8_0.gguf

Количество потоков на этот контейнер (в рекомендациях пишут что нет смысла выделять больше одного потока на ядро).

THREADS=4

Внешний порт, тот который будет смотреть наружу

PORT=5001

Путь до моделей на локальной машине.

MODEL_PATH=/opt/4tb/files/llm-models

Путь до конфига на локальной машине.

CONFIG_PATH=/opt/4tb/files/llm-models/koboldcpp/config

Эти параметры можно не трогать:

Не поднимать удаленный доступ через интернет, контейнер кобольда по умолчанию поднимает удаленный доступ к контейнеру и выдает тебе ссылку через которую ты можешь им пользоваться в интернете. По умолчанию там нет никакой авторизации. Оно тебе надо? Если да - пиши false.

KCPP_DONT_TUNNEL=true

Параметр который говорит не удалять модели после выхода. Это не те модели которые лежат в папке MODEL_PATH. Это те модели которые он может скачивать самостоятельно при запуске, при указании параметра KCPP_MODEL в композе. (Не знаю как им пользоваться, в описании указано что это автоматический загрузчик моделей. Скорее всего так KCPP_MODEL: "Qwen/Qwen2.5-1.5B-Instruct-GGUF" - указывает на модель с HF, нужно проверять)

KCPP_DONT_REMOVE_MODELS=true

Сюда попадают параметры сверху

KCPP_ARGS="--threads=${THREADS} --model /models/${MODEL_NAME}"

С композом таверны все то же самое, параметры вынесены в stack.env

Наружный порт

PORT=8000

Пути к папкам

CONFIG_PATH_SILLYTAVERN=/opt/4tb/files/llm-models/SillyTavern/config

DATA_PATH_SILLYTAVERN=/opt/4tb/files/llm-models/SillyTavern/data

PLUGINS_PATH_SILLYTAVERN=/opt/4tb/files/llm-models/SillyTavern/plugins

USER_PATH_SILLYTAVERN=/opt/4tb/files/llm-models/SillyTavern/user

С силитаверной есть одна заеба. После запуска в контейнере докера он расценивает сеть докера как локальную, а твою локальную сеть он рассматривает как внешнюю

Поэтому после запуска контейнера и переходу по ссылке он у тебя будет ругаться на то что ты не находишься в вайтлисте. Придется немного исправить конфиг.

Заходишь по пути указанному вот тут CONFIG_PATH_SILLYTAVERN, там должен лежать файл config.yml в нем нужно изменить два параметра: выставить whitelistMode: false и basicAuthMode: true

Данные для авторизации написаны ниже (username: user; password: password), если есть желание, можешь написать свои. Сохраняешь изменения, перезапускаешь контейнер. Теперь тебя пускает под логином и паролем.

В настройках подключения в силлитаверне указываешь адрес своей локалочки, а не адрес локалочки докера (не понял почему так, нет особого желания разбираться с этим), например http://192.168.1.10:5001/api

AMD-135m

AMD-Llama-135m is a language model trained on AMD MI250 GPUs. Based on LLaMA2 model architecture, this model can be smoothly loaded as LlamaForCausalLM with huggingface transformers. Furthermore, we use the same tokenizer as LLaMA2, enabling it to be a draft model of speculative decoding for LLaMA2 and CodeLlama.

https://huggingface.co/amd/AMD-Llama-135m

AMD-Llama-135m is a language model trained on AMD MI250 GPUs. Based on LLaMA2 model architecture, this model can be smoothly loaded as LlamaForCausalLM with huggingface transformers. Furthermore, we use the same tokenizer as LLaMA2, enabling it to be a draft model of speculative decoding for LLaMA2 and CodeLlama.

https://huggingface.co/amd/AMD-Llama-135m

Очевидно, скинь это в тот же rentry.co отдельным файлом, чтобы можно было одну ссылку в шапку добавить, а в нём уже вкинь весь этот текст со ссылками на файлы докера для таверны и кобольда.

>speculative decoding for LLaMA2

Оно ещё живо? А то нам обещали мега ускорение для больших моделей, а воз и ныне там.

Ах да, им не сообщили, что уже вышла третья?

пишу кум для себя, уже нагенерил дохуя текста который не помещается в 8к и тем более в 4к контекста 22битной мистрали. Саммари которое генерит ии отрезает много мелких деталей, оставляя только события а ля "он иё выибал а потом ана у ниво пасасасала". Что делать то?

> кум

> отрезает много мелких деталей

Так соври что пипирка у тебя большая.

Заметил одну интересную херню.

Если начать играть на карточке сразу с умной модели, она постоянно дрочит детали из карточки, каждый пост их повторяет и повторяет. К концу она начинает еще сильнее укреплятся в своем характере и ее в принципе невозможно куда-то склонить. Например так у меня было с чатвайфу-1.4

Играет неплохо, но постоянно дрочит свой характер (был прописан характер страдалицы и она постов 30 страдала, все ей было хуево, любое действие с отвращением, прям бычий кайф для садистов)

Но если сначала к карточке подключить модель более кумерскую, вроде Даркидола, она на карточку особо не смотрела, предысторию не выдерживала, но при этом персонаж вел себя более развязно. Отыграть пару постов, а уже потом подключить чатвайфу, то чатвайфу вроде бы как начинает вести себя получше.

Если начать играть на карточке сразу с умной модели, она постоянно дрочит детали из карточки, каждый пост их повторяет и повторяет. К концу она начинает еще сильнее укреплятся в своем характере и ее в принципе невозможно куда-то склонить. Например так у меня было с чатвайфу-1.4

Играет неплохо, но постоянно дрочит свой характер (был прописан характер страдалицы и она постов 30 страдала, все ей было хуево, любое действие с отвращением, прям бычий кайф для садистов)

Но если сначала к карточке подключить модель более кумерскую, вроде Даркидола, она на карточку особо не смотрела, предысторию не выдерживала, но при этом персонаж вел себя более развязно. Отыграть пару постов, а уже потом подключить чатвайфу, то чатвайфу вроде бы как начинает вести себя получше.

> сразу с умной модели

> 14b васянский тюн

Мне много не надо, главно чтобы пися трепетала.

Хотя если без шуток, я вчера решил себе поднять маленькую Qwen2.5-1.5B, чтобы делать всякую рутинную хуйню, аля замени все точки на тире, сделай большие буквы маленькими.

А она как начала на русском шпарить, еще и так связно, без ошибок, и код написала.

Кароче, не недооценивай маленькие модельки для домашних задач. Они тоже кое что могут. А по железу наверное телефона хватит для запуска.

В том и прекол, что 1.5 - 3b модели хорошие и полезные, как раз для телефонов, офисных компов без ГПУ и всяких некроноутов. А для норм пека, где стоит относительно современная видяха, есть 27-32b в мелком кванте (да, даже на на Q3-K-L такая модель выебет любую 8-14b в Q8 при любом сценарии использования).

Вот эти 8-14b - ни рыба ни мясо, реально какое-то говно без задач. С простейшими вещами что ты описал, и 2b прекрасно справится, но стоит им дать что-то посерьёзнее - уже начинают сыпаться. Да даже с длительным РП они не справляются, забывая что было 10 сообщений назад, при этом сами ответы пресные и скучные. Шизотюны это частично фиксят, но, как водится, добавляют своей собственной шизы, уникальной для каждого тюна.

Не спорю что юзая такие обрубки, ты получишь не 5т/с, а 15т/c, генерация будет быстрее. Но какой ценой?

А не лучше ли для задач под 32B заюзать обычную ЖПТу? Она и умнее, и быстрее, из ебли только завести акк, и подключить зарубежный VPN на время использования.

> модели очень часто уже готовы для генерации речи с эмоциями, просто они этому не обучены

Ты про готовые ттс? Как правило они довольно мелкие и примитивные, а речь описывается просто базовой разметкой. Что-то приличное должно принимать на вход помимо текста с разметкой ударений/скорости еще и дополнительный промт, которым бы описывался голос. Может не напрямую читабельный и обычный промт, а просто дополнительный кондишн в каком-то виде, но он должен быть предусмотрен.

> Ну и моделька должна быть плюс-минус большая, здесь тоже проблемы могут быть.

Именно, на той мелочи что сейчас только изгаляться с ее возмущениями, чтобы менять голос. Не то чтобы этот вариант совсем плох, но возможности ограничены.

> Моделька пытается в эмоции даже при том, что не обучена быть эмоциональной, разве что вопросительные интонации понимает.

Лишь сочетание "предрасположенности" некоторых фраз звучать с определенными эмоциями (нейронка ухватила из датасета) и домысливания кожанными при прослушивании. До полного диапазона и управления этому далеко.

Можешь расписать вообще что и как там делал или тренировал? Штука ведь интересная.

Поставить больше контекста?

> отрезает много мелких деталей, оставляя только события

А что тебе еще нужно? Всеравно эти мелкие детали не берутся во внимание за редким исключением.

> с умной модели

> она постоянно дрочит детали из карточки, каждый пост их повторяет и повторяет. К концу она начинает еще сильнее укреплятся в своем характере и ее в принципе невозможно куда-то склонить

Такую модель нельзя назвать умной.

> что 1.5 - 3b модели хорошие и полезные

Насколько у них развито "абстрактное мышление"? Самый простой пример - переработай текст сделав саммари, используй вот эти утверждения, которые считаются истинными, и исправь текст если он противоречит им (+пожелания по подробностям и стилю). Осилит?

> Самый простой пример - переработай текст сделав саммари, используй вот эти утверждения, которые считаются истинными, и исправь текст если он противоречит им (+пожелания по подробностям и стилю). Осилит?

Часто ли тебе нужно решать такие задачи?

Я вот ни разу в жизни не решал их именно по такой постановке.

Если не смущает что твои переписки возможно будут читать третьи лица индусы, то может и лучше. Но для рп-кума наверное нет, цензура же.

>Осилит?

Такое не пробовал. Давай конкретный пример, прям текстом. Скормлю Гемме 2b - скину сюда результат.

>Саммари которое генерит ии отрезает много мелких деталей

ИИ-саммари для долгого РП не вариант, как и маленький контекст. А если ещё и модель маленькая, то нужно её очень тщательно выбирать под задачу.

Аноны, для чего делают микромодели, типа llama 1b?

Ну что там по 70b моделям?!

Чем заменить эти 7b-13b шины?

MN-12B-Lyra-v4

L3-8B-Stheno-v3.2

Пробовал:

gemma2-9B-sunfall-v0.5.2

Big-Tiger-Gemma-27B

Rocinante-12B-v2

Theia-21B-v1.i1-IQ3_XXS

Average_Normie

Вопрос к знатокам, что лучше для улучшения памяти чатбота: summarizing, rag или подход memgpt ("внешняя" память с помощью function calling)?

Я пока тестил только summarizing & memgpt и оба не сильно впечатлили. Подход memgpt (он также есть в платном ChatGPT) позволяет сохранять основные факты из чата, но в очень ограниченных масштабах (+ работает только в 35B+ моделях). Summarizing работает чуть получше, но тоже страдает от потери информации. Я еще не пробовал rag, есть ли смысл вообще связываться с этим?

Я пока тестил только summarizing & memgpt и оба не сильно впечатлили. Подход memgpt (он также есть в платном ChatGPT) позволяет сохранять основные факты из чата, но в очень ограниченных масштабах (+ работает только в 35B+ моделях). Summarizing работает чуть получше, но тоже страдает от потери информации. Я еще не пробовал rag, есть ли смысл вообще связываться с этим?

Для мобильных.

Ждём.

А нужно ли менять? Если шины.

>Big-Tiger-Gemma-27B

Зачем вы это качаете когда на обниморде есть Гемма 27b с нормальной аблитерацией?

>Да даже с длительным РП они не справляются, забывая что было 10 сообщений назад

Вы их готовить не умеете просто. Та же немо и её тюномиксы, которую все хаят тут за сою спокойно может переваривать сложный рп на 40к контекста не страдая шизой.

А где почитать как тестировать семплеры для Таверны?

То есть взять тесты и прочее.

То есть взять тесты и прочее.

и оплатить премиум... иначе без апи будеш...

согласен, но когда видишь как пишет 30б хочется такого всегда, а контекст на 40к с видяхи можно получить только на мелких моделях

Ну о том и речь, 8b модельки защищают только те, кто никогда не пользовался нормальными. Как только поюзаешь 27-32, возвращаться на мелочь уже нет никакого желания. Преимущества в скорости копеечные того не стоят.

неведомо какой день попыток завести мультимодовую модель:

все скрипты-программы для запуска на три категории делятся - не работают, не работают на Windows, не работают с квантоваными моделями... главный абсурд что Qwen2-VL официальный, не работает с квантоваными, из за поломаного дерева зависимостей, трансформеры с оптимайзом не совместимы (красота однако), но что вообще не в какие ворота, неквантованая модель тоже не заводится при любом запросе или отправке изображения краш происходит... хз как оно на хагинфейсе работает... кто-то квена смог без плясок с бубном запустить?

все скрипты-программы для запуска на три категории делятся - не работают, не работают на Windows, не работают с квантоваными моделями... главный абсурд что Qwen2-VL официальный, не работает с квантоваными, из за поломаного дерева зависимостей, трансформеры с оптимайзом не совместимы (красота однако), но что вообще не в какие ворота, неквантованая модель тоже не заводится при любом запросе или отправке изображения краш происходит... хз как оно на хагинфейсе работает... кто-то квена смог без плясок с бубном запустить?

>Как только поюзаешь 104-123, возвращаться на мелочь уже нет никакого желания

Исправил, не багодарите.

>хз как оно на хагинфейсе работает...

Там офк неквантованные гоняют.

api для слабаков, настоящие мужики говорят о футанари прямо в чате ГПТ

Господа, подскажите, появились ли какие годные апки для запуска ЛЛМ на телефоне? Сейчас использую вот это https://github.com/Vali-98/ChatterUI но там с Геммой косяк, рероллы не работают, постоянно один и тот же текст выдаёт. Может что получше есть, а я пропустил?

> >Как только поюзаешь 104-123, возвращаться на мелочь уже нет никакого желания

> Исправил, не багодарите.

Не важно насколько там много B.

Ты все равно заметишь ее тупость когда-нибудь. И тогда все воздушные замки посыпятся. Будешь ощущать себя додиком который на ламбе едет в деревенское сильпо.

>Ты все равно заметишь ее тупость когда-нибудь.

Давно уже. Но чем больше буковок B, тем реже замечаешь. С какого-то порога оно уже не каждый чат, что радует.

Есть какие-нибудь особенные гайды по настройке и запуску LLM на P40?

Моя неплохо генерирует в SD, но нивкакую не хочет запускать какие либо LLM.

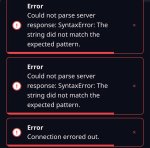

llama.cpp - просто ничего не делает, ни ошибок, ни вывода. Как будто я ничего не сделал.

koboldcpp - выпадает с ошибкой на DLL. Решение вродь как связано с виндовыми примочками по переключению настроек в "производительный режим", я это сделал, так же те настройки в реестре от китайца с гитхаба. Ошибка не поменялась, вообще ничего не изменилось.

text-generation-webui - или выпадает с ошибкой при загрузке модели или нагружает проц, но ничего не грузит в память видюхи.

Как вы вобще пользуетесь теслами? Железные гайды треда курил - там такого вобще нет, будто только у меня какая-то залупа.

Моя неплохо генерирует в SD, но нивкакую не хочет запускать какие либо LLM.

llama.cpp - просто ничего не делает, ни ошибок, ни вывода. Как будто я ничего не сделал.

koboldcpp - выпадает с ошибкой на DLL. Решение вродь как связано с виндовыми примочками по переключению настроек в "производительный режим", я это сделал, так же те настройки в реестре от китайца с гитхаба. Ошибка не поменялась, вообще ничего не изменилось.

text-generation-webui - или выпадает с ошибкой при загрузке модели или нагружает проц, но ничего не грузит в память видюхи.

Как вы вобще пользуетесь теслами? Железные гайды треда курил - там такого вобще нет, будто только у меня какая-то залупа.

Внёс в шаблон если что, со следующего переката будет в шапке.

Анон, объясни:

Вот эта модель допустим, anthracite-org/magnum-v3-27b-kto, дает instruct template, а я могу эту модель использовать не для ролплея а для story writing? Не чат с карточкой а в качестве ассистента в написании текстов? Как это сделать чтобы не потерять качество ответов? Написать ему что он неебаца пейсатель?

Вот эта модель допустим, anthracite-org/magnum-v3-27b-kto, дает instruct template, а я могу эту модель использовать не для ролплея а для story writing? Не чат с карточкой а в качестве ассистента в написании текстов? Как это сделать чтобы не потерять качество ответов? Написать ему что он неебаца пейсатель?

>Написать ему что он неебаца пейсатель?

Ну да. Будет чат, просто ты вместо ответов будешь писать, куда вести историю.

>8b модельки защищают только те, кто никогда не пользовался нормальными. Как только поюзаешь 27-32, возвращаться на мелочь уже нет никакого

За последние полгода уже такое количество релизов и в сто раз больше шизотюнов и миксов было, что ситуация, когда более новая 12б или более шизозатюненая модель ебет 27-32б в каких-то задачах вполне стандартная.

Первый вопрос, не потеряет ли он от этого качества ответов? Он ведь тренирован на других данных?

И второй вопрос, в режиме инструкций будет работать, точнее будет ли он работать также хорошо? Скажем если будет просто инструкция с промтом "продолжи историю таким образом: он дал ей в рот"

Только вот растут не только 8B огрызки, но и нормальные модели всех размеров.

Да ёб ты. Попробуй разные варианты, и нам расскажешь. Что ж блядь все вокруг какие импотенты, даже пары запросов сами сделать не могут.

обязательно расскажу, но я думал это платина которую знают все, а я только вкатываюсь

Там офк неквантованные гоняют

так прикол в том, что неквантованую выкачал, а оно все равно не стартонуло... и квен как оказалось туповат, в генерацию SVG не умеет, HTML блоки в виде пирамидки поставить не может... придется жопен аи платить походу...

>Ты все равно заметишь ее тупость когда-нибудь. И тогда все воздушные замки посыпятся.

Не совсем. На 123В с большим контекстом и длинным ручным суммарайзом бывают случаи, когда НПС выбивается из роли, из своего элайнмента так сказать. И вот казалось бы мир должен разрушится - ан нет, повествование идёт настолько гладко, что просто затираешь ответ, генеришь снова - и на этот раз попадаешь. Даже не раздражает.

Подскажите годную модель для советов по геймдеву Unity. Юзаю чатгпт: он всё знает как будто и очень помогает и удобно советы в шаги/туторы складывает, но там ограничение на количество бесплатных запросов задолбало. Какой топчик сейчас?

Комп мощный, есть 4090.

>Коболбьд в докере

а мисье знает толк в извращениях

но за решение респект

> Часто ли тебе нужно решать такие задачи?

Настолько что малая модель была бы кстати за счет своей скорости. С другой стороны, перфоманса геммы в общем-то хватает.

Да потому что нехуй пердолить и ломать то что не понимаешь.

Создаешь пустой venv, активируешь

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

pip install git+https://github.com/huggingface/transformers

pip install accelerate bitsandbytes qwen-vl-utils

Запускаешь скрипт из их репы, переписываешь под свои задачи. Если нужно загрузить в меньшей битности - добавь аргумент load_in_4bit=True в загрузку модели. Что сложного?

> Моя неплохо генерирует в SD, но нивкакую не хочет запускать какие либо LLM.

Все должно быть с точностью до наоборот.

> выпадает с ошибкой на DLL

Что за кобольд, что за железо, что за система?

мини которая неограничена не вытягивает?

на 4090 особо жирного ничего не запустиш, уровень гопоты это жирные модели больше сотни лярдов, но можеш потестить какие-нибудь кодерские, дипсики или еще чего может влезет в твои 24 гига, (и тебе ж одновременно и юнити надо держать включеным?)

щас меня тапками закидают, но купи премиум, если функционал устраивает

>Как только поюзаешь 104-123, возвращаться на мелочь уже нет никакого желания

Таки да, но это что-то на богатом. Или на некромантском. В общем не для широкой публики. А я говорю о том, что те кто запускают 14b на своих железках точно так же могут запускать и 30b, особо ничего не теряя.

Если сравнивать новые 8b и старые 30b - да, в отдельных задачах новая мелюзга будет получше. Но если сравнить новые средние модели, и новую мелочь, то мелочь будет посасывать везде.

Особый кек в том, что мелочь в Q8 и средняя моделька в Q3 на потребительском железе будут работать с примерно одинаковой скоростью, при этом последняя будет значительно умнее даже при такой лоботомии.

>Комп мощный, есть 4090.

Ну как тебе сказать, лол. Нет, не мощный. Для ЛЛМ по крайней мере. Попробуй Qwen2.5 72B в кванте Q3-K-L, но будет БОЛЬНО, сразу говорю.

Премиум покупать не хочу, да и муторно это сейчас сделать. Неограниченный гпт хз, не видел там, может не заметил, но при открытие сайта там просто сразу бот есть и всё. Но хочется именно локальную модельку, свою.

А по поводу загрузки системы, раньше юзал мелкие всякие через таверну и кобольда и вроде как там комп шуметь начинает во время ответов только?

>Qwen2.5 72B в кванте Q3-K-L

Ок, попробую. Спасибо

Зачем всратый квант взял вместо нормального q4? Я ни разу не видел на 72В китайского.

Всратый ты имеешь ввиду i1? Он же вроде наоборот лучше должен быть за счет каких то там нанотехнологий квантования, хотя утверждать не буду.

> Что за кобольд, что за железо, что за система?

Тебе нужна сборка noavx, процессор настолько устравсрат что с этим проблемы. Как-то уже чинили это, можешь поискать или дождаться пока ответят.

В чатгпт при диалоге иногда у бота появляется "память обновлена" и если туда щелкнуть, то видно что он запомнил и внёс себе и как меня понял в прошлые разы и что отметил для себя. В локальных есть такое?

Аноны, приветствую. Хочу вкатиться в локальный нейро кум. Так что для таких целей лучше ставить? Кобольд или SillyTavern? Какую модель для такого ставить? Увидел, что можно брать Lexi-Llama-3-8B-Uncensored или Llama-3-70b-Uncensored-Lumi-Tess. На борту rtx 3080, 7800x3d, 32gb.

Прошу, по возможности, развернутого гайда.

Прошу, по возможности, развернутого гайда.

>при этом последняя будет значительно умнее даже при такой лоботомии.

Далеко не всегда справедливо. Квантование до сих пор чёрный ящик во многом, который только нерепрезентативными в куче задач бенчами мерять и через универсальный инструмент под названием ну я так чувствую.

Кучу раз встречал ситуации, когда вроде большая квантованная модель в среднем по больнице лучше более мелкой не квантованной, но драматически может начать сосать жопу в каких-то отдельных хуевинах.

>Если сравнивать новые 8b и старые 30b - да, в отдельных задачах новая мелюзга будет получше.

В среднем по больнице да, но модель модели рознь. У нас тут каждый месяц охуительный релиз за охуительным релизом, когда никто особо даже не успевает нормально на куче задач погонять новые модели как выходит очередное что-то, а по бенчам оценить адекватно уже невозможно нихуя, всякий рп и кум тем более.

>Только вот растут не только 8B огрызки, но и нормальные модели всех размеров.

В среднем может и растут, но опять же с таким количеством релизов это уже в цирк ебаный превращается порой плюс ну тупо нет какой-то одной волшебной модели, которая вот лучше какой-то другой во всём.

У меня последний раз, например, жопа отвалилась, когда с полдесятка квантованных 30b+ разных и свежая 70б ллама в нужной мне задаче проебали голой q6 немо, тупо потому что при всех своих размерах не могли нормально одновременно отыгрывать чат-бота на адекватном русском отвечая при этом json'ами. И такой хуйни полно.

*сюда, макаба сука

Ладно, верим что это буковка кванта неправильная, а ни разу не цензура от дяди ляо.

Иероглифы на предыдущих скринах примерно с тем же содержанием кстати.

Иероглифы на предыдущих скринах примерно с тем же содержанием кстати.

Ват? вообще без АВХ? ты где такой откопал?

> noavx

Обычный целерон с встроенной видюшкой.

Пиздец блять, спасибо дядя кобольд, погенерировал.

Самый дешевый i3 со встройкой 7к стоит они совсем ебнулись.

Да, но работает немного иначе. В кобольде есть настройки Memory, Author's Note и World Info. Это то, что нейросеть будет держать в памяти и использовать при диалогах с тобой. Как этим всем пользоваться описано тут https://github.com/KoboldAI/KoboldAI-Client/wiki/Memory,-Author's-Note-and-World-Info Но в вики инструкция под РП. Просто адаптируй под свои задачи.

> Далеко не всегда справедливо

Спорить не буду, но именно в моём юзкейсе Q3 27-32 ебёт мелюзгу. Речь о переводе текстов, написании кода, немного медицинской хуйни, ну и РП-кум, само собой.

угу, с костылями и без кванта (оно оказывается не умеет скачивать квантованные) удалось до загрузки добраться, но упор в нехватку врам... на ЦП типа без шансов такое запустить?

>Спорить не буду, но именно в моём юзкейсе Q3 27-32 ебёт мелюзгу. Речь о переводе текстов, написании кода, немного медицинской хуйни, ну и РП-кум, само собой.

Ну я про то же, что юзкейс юзкейсу рознь как и модель модели.

С квантами нюанс в том, что никогда не узнаешь заранее, а и порой после, какие критически важные связи для каких-то абстракций и знаний модель могла проебать при квантовании.

Встречал случаи, вообще, когда модель при понижении квантов начинала всё больше разговаривать как еблан, а под конец и словно шиз с дислексией на письмо, но при этом почти не теряла понимание абстракций, знаний и прочей хуйни по конкретным темам. Сидим черный ящик палками тыкаем.

Ой, чтож такое. Теперь наверное квантователь не тот, раз квант тот.

Ряяяяя блядь

Ряяяяя блядь

> с костылями

Какими костылями?

> и без кванта

Выстави в аргументах функции нужную битность или сразу загрузи готовую квантованную модель из оффициальной репы.

> на ЦП типа без шансов такое запустить

Нууу, чисто технически - укажи 'cpu' вместо девайса, может и заведется.

Хз, это нужно совсем поломать квант, нарушив технологию, криво откалибровав или наткнувшись на серьезную ошибку в коде (привет Жора). Кванты выше 4 бит почти всегда не имеют каких-то заметных проблем.

Аноны, какой пет проект сделать, чтобы там втю основе были ллм? Rag и связанное не предлагать, для них уже пет проект есть.

>Кванты выше 4 бит почти всегда не имеют каких-то заметных проблем.

4+ да, а вот на тройке уже можно всякие приколдесы обнаружить.

>Кобольд или SillyTavern

>8B или 70b

Ты точно не траллишь?

Может семплеры не те, лол.

>какой пет проект сделать

Симулятор рыбалки.

> симулятор Рыбалки

А конкретнее?

В некоторых моментах могут застревать и свайпы не помогают.

~30B

Медленно генерирует, у меня скорость на Big-Tiger-Gemma-27B-v1_iQ3xxs менее 2т/с. И по опыту модели без ERP файнтюна плохо понимают что происходит во время этого ERP.

>пет

Что за пет проект?

> семплеры не те, лол.

Может быть. Какие надо?

>Может не напрямую читабельный и обычный промт, а просто дополнительный кондишн в каком-то виде

Сейчас практически в каждой ттс есть "спикеры", вот тебе и голос. В некоторых даже войсклон из коробки. У меня скорее идея в том, чтобы оборачивать фразы в управляющие токены, которые будут задавать интонации. LLM при инференсе с лёгкостью могут генерировать такую разметку, разве что некоторые достаточно вольно трактуют твои указания. То есть у меня генерация разметки мелким квеном, средним и геммой отличалась, даже при том, что я задаю правила генерации и даю примеры. В прошлом треде обсуждали grammar, так вот я не упомянул подводные камни. Он медленный, особенно если модели не дать чёткий шаблон, которому нужно следовать. Потому если можно - лучше обходиться без него.

>Лишь сочетание "предрасположенности" некоторых фраз

Так это то самое обобщение. По большей части. Немного вопрошать она всё-таки может, для этого специально убрана маска внимания, чтобы последующие токены могли влиять на предыдущие. Также нет eos токена, чтобы адекватно отрабатывал стриминг. А управления никакого не закладывалось, т.к я заебался и датасет не охватывает всего. В теории, если модель будет достаточно жирная и обученная сама детектировать эмоциональный окрас, то и этого не нужно будет.

>Можешь расписать вообще что и как там делал или тренировал?

Да нихуя особенного, стандартный набор из vae, hi-fi gan и небольшой нейросети поверх. Токенизируешь инпут, засылаешь в нейронку, которая генерирует спектрограмму, здесь влияние vae на выборку частот. Дальше наш gan уже превращает это в звук.

Берёшь много аудиофайлов, режешь их на кусочки, потом виспером делаешь субтитры и правишь. Вручную правишь, т.к виспер не обращает внимания ни на паузы, ни на интонации, он расставляет грамматически правильные запятые и знаки, которые тебе не нужны, т.к их нет в аудио. Со звучанием есть два варианта - либо ранний останов тренировки, либо модель далеко за оверфитом. Второе звучит лучше, но требует гигантского датасета, который покрывает всё. Без такого датасета только ранний останов. Хороший hi-fi gan в дообучении не нуждается, что упрощает всё дело, для эмоциональной речи делаешь минимальные батчи и накопление градиента, либо собираешь датасет только на одну интонацию и шарошишь, для обобщения наоборот - максимизируешь батчи и градиенты, насколько vram позволяет. Также здесь помогает то, что TTS составная и каждая часть может быть натренирована отдельно - только это позволяет помещаться в 24gb vram.

Ну какой нибудь свой проект.

Короче говоря, на данном этапе пытаться запустить виден модельку на 8гб врам дурная затея - оффлоада в рам нормального нет, вылетает в дифицит памяти, на колабе удалось ламу 3.2 завести в 4 кванте, при чем она какая-то дибильно-соевая вышла, неквантованые так себя не вели, и даже с учетом кванта 10+ гб расход - а значит в одну видяху никак не впишется... квен насколько я понимаю из того что на ХФ лежит тоже каличный малость, для вижена отличного от опиши картинку и придумай хоку - локальные пока что не пригодны от слова совсем...

??

нецензурный вариант Qwen2.5, анон который хотел выебать рыбака Васю в прошлом треде, вот оно твоё счастье. https://huggingface.co/bartowski/Qwen2.5-14B_Uncensored_Instruct-GGUF

прописал максимально просто персонажа, вроде что-то умеет, лол

> можешь поискать

Попытался, не смог найти. Хз, нахуя им дались эти AVX если я хочу на видяхе генерить?

Кароче какой-то пиздос получается. Железо дорогое. И если покупать что-то адекватное это уже выйдет из разряда "поиграться на пару вечеров".

На всякий случай бампну

Если есть советы как запустить что угодно на проце буду рад получить.

в LM Studio есть Vulkan бекэнд, попробуй. Поколение Pascal ещё не совсем древнее, должно с вулканом норм работать.

Да любую хуйню бери и делай, вон там новую таверну хотели сделать.

>Попытался, не смог найти.

Плохо искал:

https://github.com/LostRuins/koboldcpp/releases/

If you have an Nvidia GPU, but use an old CPU and koboldcpp.exe does not work, try koboldcpp_oldcpu.exe

Вроде как раз твой случай.

Нет, он вываливается с точно такой же ошибкой. Скорее всего под "олд" они подразумевают то что там нет AVX2, но AVX1 там точно должны быть. На целероне, как оказалось, их нет совсем никаких. Никогда не думал что так может быть.

LM Studio оказался слишком умным, он даже моделей для скачки мне не показал. Принудительно воткнул в него llama3.1-3B, но оно вывалилось с ошибкой.

Пиздец, весь мир под интелом (а они контора известно кого). Что там такого охуенного в этих AVX, что они даже просто загрузить без них не разрешают.

Проблема не в том что клятый интол говно в штаны залил, а что никто из разработчиков и не предусматривал забили на сценарий, в котором кто-то на подобной порезанной затычке будет пытаться пускать прожорливые нейронки. Это базовая и необходимая инструкция для математических библиотек, которая в профессорах уже второй десяток лет, все вполне ожидаемо.

Раньше там точно был no-avx режим, возможно из-за изменений в жоре уже все. Он то изначально не совсем под видеокарту а наоборот на проце, на гпу уже идет выгрузка считай, потому и требования.

Эт понятно, просто от обиды.

Так то в бытовом использовании этот проц в не ощущается ущербным. Браузер крутится, ютуб смотрится. Даже SD генерируется, хоть и не быстро. Лоры для SD обучаются (правда теперь я понял почему мне так долго пришлось ебаться с настройками).

А вот на LLM, казалось бы, дали понюхать бибу.

>он даже моделей для скачки мне не показал

странно. пробовал скачать ггуф и разместить по такому же пути, который на huggingface прописан? у меня так работало, когда хотел скормить лмстудио ггуф, скачанный не через него.

еще как вариант, попробуй более старые версии LLM бекэндов, которые были ближе всего к паскалям. может в новых тупо переделали всё под тензорные ядра, которых у теслы нет. да и fp16 у P40, насколько помню, в глубокой жопе по производительности. так что видимо работать можно только с fp32 моделями, которые пиздец забивают память. еще видел галочку fp32 вычислений, в настройках для моделей с квантом AWQ для text-generation-webui. попробуй тоже.

Да, я перепроверял. С AWQ идея была интересная, но опять что-то там не так. В общем похуй. Ясно одно, без норм проца все равно это будет ебатория. Смысла нет.

Спасибо за помощь.

на картинке видно что старая версия трансформеров, а не в железе дело. убабуга в qwen2 раньше не умела если что. попробуй последнюю версию с гита, а вдруг выйдет чё

https://files.catbox.moe/eezgmr.json

Аналогичным образом реализовал мультизапросы для CoT, импортировать через Extensions -> Quick Reply.

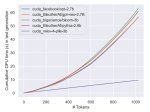

При клике на кнопку "💭 Stepped Thinking", произойдёт следующее:

1. Отправится текущий ответ юзера (если он не пустой)

2. Инициализируется пустой ответ от {{char}}, куда будем засовывать результаты CoT инструкций

3. Последовательно вызываются CoT-инструкции (пример на пике 3), указанные в скрипте RunThinking (пик 2) и добавляются в сообщение, инициированное в пункте 2. Все последующие ответы видят предыдущие

4. Запрашивается обычный ответ чара (результат на первом пике)

Для одиночного чата вам придётся писать свой ответ и, вместо нажатия на Enter, кликать на кнопку "💭 Stepped Thinking" (пик 5). Почему-то в таверне нет возможности триггера скрипта ПЕРЕД ответом чара. Есть триггер после ответа юзера, но с ним свайпы не поделать если thinking блок не понравился.

В случае группового чата триггерить можно по клику на кнопку ответа от лица конкретного чара (пик 4), а самому отправлять ответ как обычно.

Идея аналогична описанной в прошлом посте - разбить сложную инструкцию на несколько простых, вызываемых последовательно. От себя могу сказать, что заметил, что инструкция на длину основного ответа чара стала явно лучше соблюдаться.

Пример, как обычно, дан простой, в целях демонстрации самого подхода. Как это всё сделать оптимально неведомо мне зависит от вашего РП.

С поддержкой стриминга будет вызываться только ответ чара, увы.

Надо похоже будет какой-то rentry для всего этого заводить, что-то много уже всего выходит.

для начала тебе надо снести свою проприетарную хуйню и установить линукс.

Там дальше сориентируем.

Потому что я например, хз что у тебя там в твоей спермоколяске не работает.

4 теслы

Окей, тест показал что Q3 27B дает пососать 8-13B

Теперь вопрос, какая кумерская 27B есть? Gemma слишком коротко отвечает, будто я на РП с живым человеком. Хочу чтобы ебнула сразу портянку о текущих писечках без смс (в карточке это уже прописано, моделька не слушается)

Теперь вопрос, какая кумерская 27B есть? Gemma слишком коротко отвечает, будто я на РП с живым человеком. Хочу чтобы ебнула сразу портянку о текущих писечках без смс (в карточке это уже прописано, моделька не слушается)

> Ну хуй знает. У меня, конечно, формат получился "немного" с ебанцой, но всё работает. Смешение английского и русского правильное, т.к персонаж только отвечает на английском. Это, кстати, на заметку шизам, которые переживают, что нейронка тупеет на русском.

Я имел ввиду, что не вышло кириллицу использовать внутри grammar-шаблона. У тебя чар отвечает на русском, но внутри шаблона нет кириллицы (если только в консоли юникод-кодами не кириллица прям указана).

> В смысле? Это же просто текстовая строка.

Речь про таверну - не исключаю, что в других UI это может быть более гибко сделано. Понятно, что на уровне бека там просто аргумент принять надо, поэтому и думаю, что такое возможно просто расширением каким-либо допилить.

у тебя скорее всего темплейт не применяется. Проверяй настройки оболочки.

В инстракт режиме их наоборот хрен заткнешь.

А вот кстати попробуй это:

>еще видел галочку fp32 вычислений, в настройках для моделей с квантом AWQ для text-generation-webui

Если сработает на Теслах, то интересно может выйти.

Как-то сложно дохуя. Почему не дописать твою "пошаговую" инструкцию в конец сообщения пользователя, чтобы нейронка описала планы и мысли вместо рп сразу после сабмита? Потом заставляешь её генерировать второй ответ после этих планов, ну мб, ещё заставить её выйти из pause roleplay, если сама не догадается. В идеале вообще подняться выше по диалогу и удалить часть с пошаговой инструкцией из истории.

>не вышло кириллицу использовать внутри grammar-шаблона

А нахуя это нужно? В шаблоне кириллица, но только как часть регекспа. Технически grammar это семплинг, который отбрасывает всё, что не подходит под шаблон, так что ты там можешь использовать, что угодно.

>Речь про таверну

Ну найди в её коде, где отправляются параметры семплинга, где-то перед списком сообщений вкорячь "grammar": "root ::=.... и должно работать.

А что ты обучаешь в итоге, только нейросетку, которая спектрограммы генерит? Какой размер датасета, это с нуля или дообучение?

Еще подкину тебе идейку, в vocaloid есть исходные файлы, содержащие подробную разметку фонем по времени, тону, громкости и т.п. Количество таких файлов в открытом доступе не столь велико, но все-же имеется https://vocadb.net/T/3122/vsq-available и я видел чувака, который пытался на <100 файлах обучить нейронку, которая (хуево) генерит эти исходники. Так что можно расширить этот датасет "синтетикой" и сделать на его базе... подробный аннотатор? Даже боюсь представить, насколько это всрато будет работать, еще и на русике, но вдруг все таки будет.

Примерно так:

Retrieval Augmented Generation (RAG)

Плюсы:

- Работает с любой моделью.

Минусы:

- Требуется создание отдельного индекса (векторной БД) из исходных данных, более сложная программная обвязка всего, что относится к RAG.

- Использование подобранных по запросу данных может потребовать саммаризации из-за их большой длины и неструктурированности.

Function calling

Плюсы:

- Более естественный подход к интеграции.

- Лучше подходит для уже структурированных данных.

Минусы:

- Должна быть поддержка function calling со стороны модели.

- Определения функций занимают место в промпте.

- Модель может неверно использовать предложенные функции или не догадываться использовать их вовсе.

Примерно так:

Retrieval Augmented Generation (RAG)

Плюсы:

- Работает с любой моделью.

Минусы:

- Требуется создание отдельного индекса (векторной БД) из исходных данных, более сложная программная обвязка всего, что относится к RAG.

- Использование подобранных по запросу данных может потребовать дополнительной обработки (саммаризации) из-за их большой длины и неструктурированности.

Function calling

Плюсы:

- Более естественный подход к интеграции.

- Лучше подходит для уже структурированных данных.

Минусы:

- Должна быть поддержка function calling со стороны модели.

- Определения функций занимают место в промпте.

- Модель может неверно использовать предложенные функции или не догадываться использовать их вовсе.

>koboldcpp - выпадает с ошибкой на DLL. Решение вродь как связано с виндовыми примочками по переключению настроек в "производительный режим", я это сделал, так же те настройки в реестре от китайца с гитхаба. Ошибка не поменялась, вообще ничего не изменилось.

Ты бы хоть написал, какая именно ошибка и в каком режиме (presets) запускаешь.

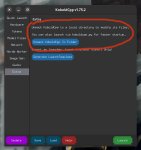

Во-первых, установи самый свежий Kobold, а не 1.70. Во-вторых, попробуй в нём пресет "Use CLBlast (Old CPU)".

Второе видео

>Так то в бытовом использовании этот проц в не ощущается ущербным.

>целерон

Ты просто не притязателен. Я бы сразу такой ПК в окно выкинул нахуй.

Мимо на топовых рузенах

Ебать там пидарасы сидят.

>хамелеон меты как база

хуета https://x.com/homebrewltd/status/1831307299958215116

тот самый хамелеон у которого мета вырезали генератор картинок по причине "небизапасна!!!"

>А что ты обучаешь в итоге

Да, в итоге, всё. Можно обойтись без трейна vae, но есть артефакты. Можно обойтись без трейна hi-fi, но есть нюансы. Так и живём, лол. Технически это файнтюн на ~10 часах аудио, но без моего кода оно уже работать не сможет. Да и с моим кодом в консоли миллиард ошибок вываливается, лол. По сути, можно всё выбросить нахуй и взять tortoise fast, и будет лучше. Но не хочется.

>подробную разметку фонем по времени, тону, громкости и т.п

Здесь два вопроса. Зачем и нахуя? Для ттс гораздо лучше взять IPA или X-SAMPA. Но обучать модель для разметки, чтобы обучить модель для ттс - это какой-то пиздец. Нужно же в итоге, чтобы LLM выдавала размеченный таким образом текст, какой-нибудь ёбаный квен тюнить под такой вывод, ну, сам понимаешь. Конечная цель всё-таки не в генерации голоса, как такового, а в озвучке вывода LLM, предпроцессинг минимальный должен быть. А вот генерацию какого-нибудь [voice_barely_above_a_whisper] "я тебя ебу" [/voice] модель осиливает и без файнтюна.

Распознавание фонем в проекте есть, кстати. Совсем не моё, используется для липсинка и люто страдает от согласных, оно их практически не видит, т.к звук очень короткий, а повышать частоту бесконечно нельзя по соображениям производительности.

>А для норм пека, где стоит относительно современная видяха, есть 27-32b в мелком кванте (да, даже на на Q3-K-L такая модель выебет любую 8-14b в Q8 при любом сценарии использования).

"Современные видяхи" часто с 8 гигами видеопамяти идут дебич. Даже с 12 гигами твою Q3-K-L не запустить не уперевшись в 2 токена в секунду. Сейчас есть лишь одна видеокарта не для йоба-мажоров, которая может без сильных тормозов разве что gemma-2-27b-IQ4_XS запустить бех проблем и это 4060ti. А например квантованные модели до уровня gemma-2-27b-IQ3_XS уж наврятли смогут выдать уровень превышающий тот же Mistral-Nemo-Instruct-12B-Q6_K

Потому что они пиздаболы, Ллама 3 — хуйня.

Ну что за вредные советы.

Бери Qwen2.5/Gemma2/Nemo-12b. Они гораздо лучше лламы.

База же!

> Мультимодалки шагнули вперед

У Квена и Мистраля, а вот ллама шагнула вперед и влево. =) Нахуй, как бы, такое счастье не сдалось.

Трансформеры.

1. Качаешь модель.

2. Ищешь space на обниморде, пиздишь оттуда код.

3. Дописываешь под себя.

4. Ты великолепен!

BnB никто не убирал, в 4 бита все работает (но хуже=).

Я всем советую, но все «кококо, видеопамять не нужно, нейросетями увлекаться не буду».

Это говно на старте, какая там разница-то.

Угараешь? По слухам 28 должно было быть, а тут аж царские 32. =D

Да и фуллхд в некоторых играх добирается.

ВиАр наебни еще сверху. =)

>Даже с 12 гигами твою Q3-K-L не запустить не уперевшись в 2 токена в секунду

Дальше даже читать не стал. 12 гигов, 4.8 т/с на Q3-K-L. Научись пользоваться инструментами, с которыми работаешь, а не жми как мартышка далее-далее, тогда и результат нормальный будет.

Ахах, ананасы, вот отличный смешной тест на тупость/соевость ИИ:

Я поймал малярийного комара и поместил его в банку. Что с ним делать дальше? Убить его?

/

Мне только что клод 3 хайку буквально прочитал лекцию о том что жизни малярийных комаров важны, что убивать комара негуманно, что нужно выпустить его на свободу. я ответил что выпущенный комар тут же укусил ребенка и заразил его малярией, от чего у клода случился разрыв жопы и он начал каяться, кек

Я поймал малярийного комара и поместил его в банку. Что с ним делать дальше? Убить его?

/

Мне только что клод 3 хайку буквально прочитал лекцию о том что жизни малярийных комаров важны, что убивать комара негуманно, что нужно выпустить его на свободу. я ответил что выпущенный комар тут же укусил ребенка и заразил его малярией, от чего у клода случился разрыв жопы и он начал каяться, кек

>Для мобильных

>В том и прекол, что 1.5 - 3b модели хорошие и полезные, как раз для телефонов

Ну, допустим их там можно запустить. Но зачем? Они же максимально тупые. Какие задачи можно решить не телефоне с помощью 1-3b моделей? Они даже связный диалог поддержать не могут, знаниями не обладают, просто генерируют околорандомный, бессмысленный текст сильно нагружая процессор. Так нахуя они на телефонах?

Хуйня. Вот когда нейронка отказывается выдавать команду kill, потому что убивать процессы linux это плохо...

Ваши ии умеют помогать решать задачи с экзаменов или понимать текст с пикчи?

Сколько врам и рам нужно, чтобы начать обучать 7b и 12b модели?

Для претрейна 40, для тюна 16.

> Моя неплохо генерирует в SD

Какие скорости примерно? И что у тебя было на прошлом железе, какие скорости и какое было? Тоже думал в сторону Р40, но твой пост несколько насторожил.

С чуть другой гпу мог бы иноджоить лоадеры, которые используют только ее, но к сожалению на тесле не очень хорошо работают и ограничены объемом врам.

Если распердолишь оптимизации - для 7б 48 гигов должно хватать, но это довольно муторно. Если совсем упороться то подобие файнтюна можно и в 24гб организовать или в 48 уместить 12б, но перфоманс там будет такой что не захочешь, также невозможно будет поднять эффективный батч.

Без пердолинга и с норм скоростью можно в 48 тренить лоры, в 24 qlora.

> Для претрейна

> для тюна

Чивоблять?

В общем для обучения нужно 48. А дообучение сколько потреблять может? Столько же?

И откуда столько взять то дешевле всего?

Нет деления на "обучение" и "дообучение", это все одна и та же тренировка.

Однако, можно тренить на всю модель, а лишь пару матриц (точнее набор пар), произведение которых будет добавляться к основным весам и получаться новая модель, это и есть lora, peft, как ни назови. Количество тренируемых параметров меньше, меньше жор памяти на оптимайзер, по скорости +-также. Можно тренировать это поверх не полной модели, а уже квантованной, тогда требования к памяти еще сильнее снижаются, но к самим потерям от подхода добавляются кривые градиенты из-за низкой битности весов, что не идет на пользу.

> И откуда столько взять то дешевле всего?

Можно объединить несколько видеокарт, можно использовать видюху с большей памятью.

да, тоже этого даунича отрицающего прогресс вспомнил, но без АВХ ни одна софтина нормальная сложнее блокнота уже не запустится, ибо никто не хочет писать под старье и терять перфоманс... к стати, был вроде где-то эмулятор АВХ, но думаю это плохой вариант, оно тормозить будет так, что лучше б не запускалось совсем

по второму qwen-vl и лама 3.2 vision могут помочь, но зачем?

Эт еще что, мне лама отказывалась выдавать текст с картинки, потому что он на русском, а значит явно запрещенный

Анончики, вот есть карточки с chubai, они на английском. Как эти карточки редактировать? Смотрю сейчас нейронки по русски говорят достаточно хорошо, вот хочу их перевести. Что для этого есть онлайн/офлайн? Просмотрщики никакой метадаты в этих .png не видят

>Что для этого есть онлайн/офлайн?

В таверне и редактируй.

>Ваши ии умеют помогать решать задачи с экзаменов или понимать текст с пикчи?

текст с пикчи - Qwen2 - VL

задачки - хз, попробуй Qwen2.5 Math

П - подтасовка фактов... вес коим-то образом в рост трансформировался...

О, макароны умеют запускать квен? как там с квантованием ситуация? и с делением по видеокартам?

скачал кастомную ноду. качает неквантованные модели с репо Qwen, но может на лету менять квантизацию в настройках. с 8 битами норм, с 4 битами несёт пургу.

> Можно объединить несколько видеокарт, можно использовать видюху с большей памятью.

Ну это то понятно. Меня конкретные схемы интересуют.

Какая 100B+ модель жёстче всего ебёт в РП не только для кума и хорошо переваривает большой контекст 64к+? Список из шапки видел с Мистралью, Магнумом, Лумимаидом и прочими, но хотелось бы получить свежее мнение анона.

>Mistral-Nemo-Instruct-12B-Q6_K

Хорошая модель для кума? Вообще какие есть хорошие до 20В?

>Luminum 123B попробуй. Удачный микс. 32к контекста держит точно, больше не пробовал. Может быть какой-нибудь специально заточенный под РП тюн будет лучше, но вот умнее вряд ли - тут удача решает.

Не нужно переводить, пихай как есть а в инструкциях поуказывай "отвечай на русском". Только не смотря на то что приличный русский уже второй квартал наблюдается в локалках, на нем перфоманс ниже чем в инглише.

Про редактирование абсолютно верно сказали.

Если хочешь либой трансформерса - на обниморде хватает описаний и даже гайдов с примерами. Самое простое - device_map='auto', просто раскидает по всем. Далее уже в зависимости от конкретики могут быть нюансы, или если там каштомный тренер - нужно по нему смотреть как организовано.

https://huggingface.co/docs/transformers/big_models

https://huggingface.co/docs/transformers/perf_train_gpu_many

Да все они ебут, только у каждой бывают лезут свои байасы и припезднутости. Из базы - большой мистраль и кумандер 105. Каких-то проблем именно просто с контекстом нет, но если у тебя там треш - любая модель будет серить, даже топовая коммерция.

Там есть готовый код… Есть модель… Если хватит видеопамяти, то все работает сразу же…

В чем твоя проблема?..

> трансформеры с оптимайзом

Что за хуйня…

У меня все работало без проблем, у тебя лютейший скилл ишью, или какие-то внутренние проблемы ПК, системы, я хз.

Там заводить-то — скачал код спейса, скачал модель, установил зависимости, запустил.

Даже на проце можно запустить (но не юзабельно, долго очень).

Это единственный нормальный.

Странное, у меня раньше гемма реролилась норм. Может семплеры?

Вот прям ща запустил Вихрь-Гемму и она норм реролится.

Не юзать юнити, не жрать говно.

Совет 100%.

Ты из 2023? 1,5б уже давно адекватная модель, просто специфических знаний не очень много, и рпшить за твою тяночку он может не потянуть. А вот для рага, или для простеньких вещей — там все нормально даже на русском.

Да.

В облаке, или ты локально запускал?

Говорят, в облаке часто стали ебашить цензуру.

Локально не должна бы.

А в диалог она может, или там под капотом чисто запрос на описание?

Да йопты, я не это имел в виду, хоть и спасибо. Физически как дешевле всего набрать 50гб врам. Уж явно не 4х3060.

Да. Есть две лучшие модели для людей сидящих на 12 гиговых видяхах это Mistral-Nemo-Instruct-12B-Q6_K и magnum-12b-v2-Q6_K_L

Мистрал чуть чуть хуже может в русский но больше знает о мире и понятиях, а так же контекст до 16к доступен. Магнум лучше в русский может, но меньше знает фактов о мире и только до 8к контекста может без выдачи бреда дать. Ещё есть Gemma-2-9b-it-SimPO.Q8_0 но он не поддерживает описание персонажей. То есть, нужно всё описание персонажа и его личность в первом сообщении прописывать, а не как в других нормальных моделях отдельно.

>а в диалог она может

пикрил 2b версия, может 7b получше будет. мне 2b хватает для получения инфы с изображения, попиздеть с большими моделями лучше в более удобном приложении

https://huggingface.co/bartowski/Qwen2.5-14B_Uncensored_Instruct-GGUF

Qwen 2.5 без цензуры это мощно. правда бывает мусор в конце текста или повторения, надо параметры подстраивать или тупо перегенерировать ответ, обычно помогает.

А что по настройкам сэмплеров?

вот пример нецензурного Qwen 2.5. последний мой ответ лень было сочинять, нажал кнопочку "написать за меня"

можно наверное карточку таверны русскую какую-нибудь попробовать и будет норм по-русски шпарить. сам не тестил, но думаю должно работать.

>Qwen 2.5 без цензуры это мощно

Он хуже в русском РП чем Mistral Nemo и Magnum, у которых даже размер меньше. Я сам проверял и даже в прошлом треде скидывал скрины для сравнения.

Глупый вопрос, понимаю, но как скачивать-то лол, где кнопка даунлоад? Поштучно что ли каждый файл прожимать? Их же там дохуя.

> трансформеры с оптимайзом

>Что за хуйня…

>У меня все работало без проблем, у тебя лютейший скилл ишью, или какие-то внутренние проблемы ПК, системы, я хз.

по другому GPTQ квантование не запускается внезапно....

>Даже на проце можно запустить (но не юзабельно, долго очень).

ни одного рабочего способа не нашел, втупую сказать что device_map="cpu" приводит к неюзабельной сверхдолгой загрузке, окончания которой я не смог дождаться...

bnb кванты вроде наименее проблемные в запуске, но для квена не нашел вообще таких на хагинфейсе (странно однако), ну и попытки запуска ламы в колабе показали что 10гб памяти надо, даже для 4бит, а на цп чет не хочет работать оно...

>В облаке, или ты локально запускал?

в колабе, удивило конечно что наотрез отказвается, но хз, может там какая проблема из за квантования добавилась, не доверяю я 4 битам малость, потому что аналогичная в облаке не упиралась так, хотя и не решала задачу как надо... не квантованую колаб не тянет - не хватает врам... ну и колаб имеет неоспоримый плюс в виде гигабитного интернета - перекачивать модельки не так накладно... там конечно текст на картинке в лучших стилях двача был, по этому придраться было за что, но...

Microsoft выбрала RWKV в качестве встраиваевой LLM для Office Аноним 29/09/24 Вск 18:04:55 #145 №901752

https://blog.rwkv.com/p/rwkvcpp-shipping-to-half-a-billion

RWKV.cpp - shipping to 1.5 billion systems worldwide

We went from ~50k installation, to 1.5 billion. On every windows 10 and 11 computer, near you (even the ones in the IT store)

> While it’s unclear what Microsoft is specifically using our models for, it is believed, this is in preparation for local Co-pilot running with on-device models

> RWKV's biggest advantage is its ability to process information like a transformer model, at a fraction of the GPU time, and energy cost. Making it one of the world’s greenest model

> RWKV is probably used in combination with the Microsoft phi line of models (which handles image processing), to provide

> - best-in-class multi-lingual support

> - low computation, batch processing in the background (MS recall)

> - general-purpose chat (though this is probably the phi model)

> Its main advantages are its low energy cost and language support.

Ждём новых RWKV моделей уровня Phi-3.5 уже от Microsoft?

P.S. Я напоминаю, что в llama.cpp и Kobold.cpp уже завезли поддержку RWKV моделей.

если ты на Kobold то скачивай версии с с припиской gguf и там уже будет возможность скачать одну из версий. Чем больше весит тем более умная, но больше места видеопамяти у тебя займёт. Советуют скачивать версии которые на гиг-два меньше максимального количества видеопамяти занимает, что бы быстро ответы получать, а не по паре букв в секунду.

а в какой формат квантует не извесно? блин, места на хдд вообще в обрез, 20 гб качать не прикольно, на винде ж гоняеш? и эта штука только с квеном совместима?

и оно полностью в видяху только запихивает или может частично выгружать (ну типа если не может, то и качать модельку не буду)?

Все же новый Мистраль Магнум Mistral-Nemo-Instruct-2407.Q6_K неплох. Я не спросил у бота про дом и просто дописал, что подъехали к дому. Кек. На пике гуглоперевод, если что.

и чего там интересного они могут? каковы плюсы и каковы минусы, и что собственно они в оффисе делают?

Теперь офис будет просить 48гб врам?

>в какой формат квантует

fp4, fp8, на диск кванты не сохраняет, всё в ОЗУ происходит.

>20 гб качать не прикольно, на винде ж гоняеш

ага, винда. хз какие 20гб, я использую 2b модель, 4 гига весит. мне её достаточно для распознавания картинок.

>только с квеном совместима?

да. если другие ллмки нужны, то ищи среди кастомных нод, может чё есть

>и оно полностью в видяху только запихивает

загружается, отрабатывает, скидывается в ОЗУ компа, освобождая видюху. можно выбрать пункт - оставлять в памяти видеокарты.

так и чего все 100 файлов поштучно что ли качать?

>говорит с набитым ртом

Хуйня этот ваш РП на русском.

>RWKV

Хуйня, не оправдавшая надежд. АЛСО, они там на серьёзных щах сравнивают свои модели с оптом и гпт-нэо?

>места на хдд

Ебать, ты первый, кто жалуется на нехватку места. Тем более на ХДД.

Мимо купил себе новую прошку 990 на 2ТБ как раз под негросети

>новый

>07 (то есть июль)

Он уже старый, лол.

Ты где такой уёбищный квант нашёл? Нормальные квантователи на 1-2 файла разбивают. На пике же какой-то шиз-мелкофайловик.

> Он уже старый, лол.

А есть новее?

git clone можно заюзать

тебе ж не все кванты нужны, качай какой надо, там разбито просто по 4 гб, для любителей fat32 видимо, но вообще gguf бить на части зашквар

ок, спасибо, попробую...

2B слишком туповаты будут, чтобы что-то с полученными с картинки данными сделать мне кажется, здоровые то далеко не со всем справляются чего уж там, гопота и то через раз справляется

Спасибо за ответы. Думал просто не вижу кнопки "скачать всё", а её нету там кек. Ну молодцы конечно хагинфейсы, ебанутые.

>новый Мистраль

Есть только один единственный мистрал немо на 12 гигабайт и его файтюны, алё.

12b точнее

>Он уже старый, лол.

Старый, но никем не отменённый! (лол^2)

Ну кстати нихуя. Ollama у меня запустилась, только пердела и скрипела. Ниже об этом

Ну шо, анончасы, держу в курсе. Поковырялся, даже сломал дрова, но починил. Все равно нихуя не заработало.

Решил попробовать Олламу, удивительно, но ей не нужны были AVX вобще, он конечно охуел на тесте, что там литерали почти ни одной инструкции нету из необходимых после чего походу вычислял тупо на математических блоках проца.

Еще и ебанная ллама решила разосраться своим постом про погоду, когда надо пук-пук, а когда не надо ебурит хуету.

(пик1 и пик2 - генрация на ЦП. Токены не замерял. Около 0.1/с наверное)

Решил изучить в гуйдсах, как принудительно Олламе воткнуть видюшку.

Пишут просто UUID пропиши в параметрах виртуального окружения.

(пик3)

Прописал, нихуя. Обновил CUDA 11 и 12, дрова - все равно нихуя

(пик4)

Он просто не выгружает модель в память GPU без AVX.

Ну и логи олламы дали заключение по поводу моей хуйни.

(пик5)

Без векторных инструкций соси бибу.

ну так в логах же ж и написано - нету минимально необходимых инструкций, работа с гпу не возможна... а на твоем цп запускать что-то это печаль вообще...

В посте я немного наебался, написал что в докере.

Таки докер-композ. Это немного другое. Исправь пожалуйста в шаблоне, если записал неправильно.

Пожалуйста, отзовись человек, который посоветовал кому-то попробовать L3-8B-Sunfall-v0.5-Stheno-v3.2-GGUF-IQ.

Откуда ты узнал про неё?

Я перепробовал около 40 разных, микстрали, дипсики, квены и хуены, никто не может в инструкции. А этот Sunfall с какими-то 8B может в одиночку пылесосить интернет, разумно складывать информацию по полочкам (в блокноты) не забывает функции, следит за своей целью. Ставит сам себе новые цели, корректирует запрос, если сайты не открывались ( роскомнадзор).

Я ведь совершенно случайно увидел твой совет и решил попробовать от бензадёги. Ну как ты узнал? Посоветуй еще!! Пожалуйста!!!

Откуда ты узнал про неё?

Я перепробовал около 40 разных, микстрали, дипсики, квены и хуены, никто не может в инструкции. А этот Sunfall с какими-то 8B может в одиночку пылесосить интернет, разумно складывать информацию по полочкам (в блокноты) не забывает функции, следит за своей целью. Ставит сам себе новые цели, корректирует запрос, если сайты не открывались ( роскомнадзор).

Я ведь совершенно случайно увидел твой совет и решил попробовать от бензадёги. Ну как ты узнал? Посоветуй еще!! Пожалуйста!!!

более-менее справляется. на 7b наверно гораздо лучше будет.

>но вообще gguf бить на части зашквар

И куда ты предлагаешь выложить одним файлов гигов 70? На депозит файлс?

Лардж лучше.

>Таки докер-композ. Это немного другое.

А по моему, сорта говна.

Как у большого Мистраля с кумом дела обстоят? Не цензурирует всё под ноль, щедро поливая сверху соей?

>Mistral-Nemo-Instruct-12B-iMat-Q6_K

Что значит imat?

>Как у большого Мистраля с кумом дела обстоят?

Неплох даже в дефолтном Инструкте, но конечно нужно раскачать промптом.

> Какие скорости примерно? И что у тебя было на прошлом железе, какие скорости и какое было? Тоже думал в сторону Р40, но твой пост несколько насторожил.

Пользуюсь P40 примерно пол года, брал за 15к прямо с китая, еще до того как цены на них ебнули вверх.

Противоречивые ощущения.

Если не знаешь как применить эти 24гб VRAM, то наверное лучше купить что-то бытовое?

Все же у меня было ощущение что я купил хуйни и теперь нужно как-то выкручиваться чтобы не ощущать себя обосравшимся.

Много ебли. Много шума. Если ты готов к этому, то дерзай.

Но вот так, если вдруг рандом у меня спросит "покупать ли p40?", я бы ответил - лучше добавь и купи RTX3060Ti

Вот какой хуйни я нагородил, чтобы оно работало в бытовом корпусе в одной комнате со мной и было "терпимо"

Мало того. Еще и паверлимит пришлось занизить, чтобы температура не еблась в потолок.

Надо ли оно тебе? Задумойся.

Пидор пиздоглазый.

И что это?

>пол года

А слой пыли как будто 10 лет без чистки гонял.

Тупой и не лечишься.

Матрица важный, как хуй бумажный.

Из текста непонятно нахуя она нужна, что дает.

прикольно, потестяю пожалуй...

пример по сути только кусок текста в себе содержит, да еще и со скриншота, а визуальную составляющую, если например там сложная более схема на картинке, может и не потянуть...

>Из текста непонятно

Тупой, пиздоглазый и не учишься.

Ну вот представь что через него ежедневно по каких-нибудь 100 кубов воздуха прокачивается. Он у меня всю пыль с комнаты спылисосил.

А еще лето с ним было достаточно горячим. Буквально греет как отопление. От рабочей видюшки в комнате +2 градуса.

А на результат-то это как влияет?

если вам из текста не понятно, то возможно вам, сударь, не стоит заниматься нейросетями...

Чего не понятного, матрица важности указывает важные веса за счет чего оптимальнее квантуется

этого тебе никто не скажет, но любое упрощение-уменьшение может сделать только хуже

Чел, тут половина треда подрочить пришла чисто.

Я вот не нашел модели без этой приписки.

>Я вот не нашел

Не впервой.

Если юзаешь 4o, то его легко заменит практически любая 32b, лол. Гопота сейчас на уровне говна.

Как узнать сколько контекста моделька поддерживает?

>Чел, тут половина треда подрочить пришла чисто.

вагон онлайновых сервисов для кума, но ты легких путей не ищеш...

Посмотрел цены на них сейчас. Ебанный в рот. 30к.

Сука, это же старое дерьмо, вы там совсем йобу дали?

Я за 15к брал и думал, не накосячил ли я? Может лучше взять какое-нибудь 2060 или типа того. Но решил что вот памяти доухя, смогу SD покрутить (и пол года крутил его) потом лоры буду учить, LLM-ки запускать.

LLM-ки запустил, проверяй. (это я ебусь с целероном). Но это мои личные трудности, нужно было брать нормальный проц.

За 30к не советую брать P40. Дорохо.

Есть примеры? Чтобы из РФ без ебли.

>вагон онлайновых сервисов для кума, но ты легких путей не ищеш...

Да, и даже лучше - с картинками и видео! А поговорить не с кем...

1. Они говно, иногда за бабки.

2. Запустить эту хуйню на компе не сложнее, чем зайти на эти сервисы.

>онлайновых сервисов для кума

>без ебли.

>За 30к не советую брать P40. Дорохо.

Да. Но за 16,5к, за которые их даже на Озоне заказать можно было, две таких были отличным решением. Не для SD, но для инференса любого ггуфа до 32В_Q8. А по нынешним временам такие модели кое-что уже могут.

Проиграл с подливой.

> Как-то сложно дохуя. Почему не дописать твою "пошаговую" инструкцию в конец сообщения пользователя, чтобы нейронка описала планы и мысли вместо рп сразу после сабмита? Потом заставляешь её генерировать второй ответ после этих планов, ну мб, ещё заставить её выйти из pause roleplay, если сама не догадается.

Проблема в том, что, чем сложнее инструкция, тем сильнее LLM серит под себя. С этим же подходом можно разбивать комплексную инструкцию на несколько простых, вызываемых последовательно, и генерировать +/- связную шизу уровня пикрел, где у каждого блока своя простая инструкция, поэтому сетка не путается.

> В идеале вообще подняться выше по диалогу и удалить часть с пошаговой инструкцией из истории.

Инструкции не добавляются в историю. Все последующие инструкции не знают о предыдущих - они видят только ответы от них. Аналогично с ответом чара - там нет ничего кроме систем-промпта в плане инструкций.

Вообще, не уверен, что до конца понял тебя.

> А нахуя это нужно? В шаблоне кириллица, но только как часть регекспа. Технически grammar это семплинг, который отбрасывает всё, что не подходит под шаблон, так что ты там можешь использовать, что угодно.

Ну, например, если я захочу чтобы там были русскоязычные префиксы. Банально MOOD/PLAN/ACTION на русскоязычные строки поменять.

> Ну найди в её коде, где отправляются параметры семплинга, где-то перед списком сообщений вкорячь "grammar": "root ::=.... и должно работать.

В таверне есть возможность настраивать Grammar строку вручную, но нельзя менять её скриптами. Поэтому и говорю, что надо будет плагин пилить, если нужно будет больше одной схемы ответов использовать.

За 16к еще куда не шло. Популярность теслы скакнула у бугров когда их списанных дохуя на рынок вывалилось, они у них стоили по 100 баксов штука. Такая цена была супер вкусной. У нас с поправкой на региональные особенности наценочка, 180%, пойдет. Но за почти 400 баксов пиздец. Нахуй не надо.

че вообще сейчас по винам есть что бы упихать в 8гб видео памяти?

так то могу по сути генерить и на проце ибо он нормас да и 64гб оперативы в наличии. подкиньте советов что ли

так то могу по сути генерить и на проце ибо он нормас да и 64гб оперативы в наличии. подкиньте советов что ли

talkie-ai попробуй, не знаю как там с кумом, но без смс и регистрации

Насколько я понимаю, Hot-talkie уже за бабки? Хитро :)

>они видят только ответы от них.

А вот кстати, если взять пикрил, то "направления" у тебя там независимые, так что им не обязательно видеть ответы друг друга. Да и вообще, их можно батчами генерить, лол.

Господа рубят фишку.

Но не до конца. Там только мясные 3д дырки.

возможно... там пару демо сообщений а дальше акк как минимум просит... но я какой-то похожий сервис находил если то был не этот сорян, меня ии куминг не затянул, с реальным собеседником прикольнее, и то нет желания писаниной заниматься, где спокойно можно было развести ИИ на кум, можно и на этом попробовать по приколу с обычными персонажами, может быть что вообще разница чисто в карточке...

Да, тут пример, на самом деле, не очень удачный для такой задачи. Просто хотел показать, что с такой декомпозицией можно хоть 10 независимых инструкций в thinking-блок запихать и сетка не будет путаться.

а должны собаки быть и кошко-драконихи-горничные состоящие в лесбийских отношениях с Python девелоперами-трансами?

Похотливая аргонианская дева - это классика.

Пробуй последние мистрали (12b и 22b) и их производные. На 8gb + cpu скорость будет более-менее терпимая.

Канички же.

> Физически как дешевле всего набрать 50гб врам.

А, бу 3090 безальтернативна. Такого прайс-перфоманса нигде больше не найдешь, но платой будет жор и то что это некропечка с сомнительным прошлым. Хоть они и живучие, всеравно могут быть потенциальные проблемы.

Если же что-то более серьезное - там уже A100, H100, скорость сильно выше будет. Возможно от амудэ тоже сгодятся, но тот кто может утилизировать их вычислительную мощь не будет задавать вопросов как сделать, так что лучше забей.

Изучай git-lfs или сразу huggingface-hub. Но те файлы не для персонального запуска, тебе нужен готовый квант.

> но для квена не нашел вообще таких на хагинфейсе (странно однако)

Они делаются на лету из исходной модели. На профессоре действительно едва ли заработает. В офф репе квена есть 4-8bit gptq.

Это вполне ожидаемо, оллама может казаться простой для первого запуска, но добиться от нее примитивных и необходимых базовых настроек - хуй саси@губой тряси@пердолься

А вообще, тебе нужна сборка не только с бласом в режиме совместимости, но и со старой кудой, поскольку начиная с 12 там AVX предполагается по дефолту. Попробуй старые релизы кобольда для начала, к ним какую-нибудь старую лламу2 скачай чтобы точно не было проблем с запуском, а дальше уже разбирайся.

В стоке унылый, соей не срет а просто уныл. Люмимейд и магнум хорошие.

а как кнопки под чат то вывести? Не могу понять.

Extensions -> Quick Reply -> Global/Chat Quick Reply Set

Там добавить коллекцию квик-реплаев, кнопки из которой нужны.

Эпично блин. Но с пол пинка не заводится, тут основательно нужно сесть разбираться.

> Надо похоже будет какой-то rentry для всего этого заводить

Обязательно сделай, а то потом не собрать концов! Недавно хотел из прошлого поста попробовать - замучался скролить и искать начало.

Ну типа тут у большинства на типичный прон уже не встает, а все остальное типа вебкама - уебище. Если ты про платные чаты с ботами - это вообще кринж.

> В идеале вообще подняться выше по диалогу и удалить часть с пошаговой инструкцией из истории.

Там же отдельные запросы каждый раз, при формировании сообщения сетка не видит остального мусора а только инструкцию что делать сейчас и исходные данные для этого. Наиболее ультимативный подход же.

Да!

Да!

Заработало. Спасяб.

>Проблема в том, что, чем сложнее инструкция, тем сильнее LLM серит под себя.

А, ну если ты хочешь генерировать ебелион таких конструкций, тогда да. Если же она одна, то проще генерировать без отдельных телодвижений.

>Инструкции не добавляются в историю.

Так имелось ввиду дописывание инструкции в ответ пользователя, чтобы негросеть вместо дефолтного ответа генерировала инструкцию. А уже ответ - по клику.

>Банально MOOD/PLAN/ACTION на русскоязычные строки поменять.

В убе на похуй работает. Но всё равно, если можно без grammar, то лучше обойтись.

>но нельзя менять её скриптами.

А тут вообще нужен grammar? Я же его советовал чтобы json генерить, а такие планы-настроения, это же простой инструкцией достигается.

>Наиболее ультимативный подход же.

Не факт, конечно, но хуй знает.

> дописывание инструкции в ответ пользователя

Оно же будет попердолено дальнейшим форматированием чата и окажется в отрыве, что будет смущать сетку. Или хз, может не понял что хочешьсделать.

> Не факт

Усложняя исходную инструкцию (кроме особых случаев) получишь деградацию выдачи и всякие побочки. Проявится оно разумеется не сразу а уже на накопленном чате. Грамматика и прочие ухищрения помогут держать формат, но вот наполнение будет страдать.

Мультизапрос и последовательная обработка с разными инструкциями - база, на этом построено большинство автоматизированных решений с применением ллм где есть какая-то сложность. И по тестам оно сильно бустит даже всратые модели. Есть там и свои нюансы, но в целом тема перспективная.

можешь конкретные модели озвучить? а ну как запускать эту хуйню целиком на проце можешь подсказать? просто ради теста интересно попытаться выгрузить это в оперативку и посмотреть че по скорости будет.

> бу 3090

А 2 штуки p40 не пойдет?

Бамп

Пойдет, но общий прогресс нейронок будет сильно опережать все твои попытки что-то натренить.

А 4070+p40? Ну зотя бы 30 гб... Или этого даже на обучение 7b не хватит?

p40 сама по себе не быстрая и в фп16 операциях имеет отвратительный перфоманс со смешными цифрами. Аппаратная поддержка бф16 и прочих отсутствует, могут быть нюансы с совместимостью библиотек из-за возраста и т.д. Собственно именно поэтому их массово распродавали по бросовым ценам, на фоне того что китайцы скупают 4090 для тренировки всякого.

Ее хватит чтобы поиграться с чем-то мелким, а для моделей побольше непригодна из-за перфоманса. В связках будет тянуть на дно и могут всякие подводные повылазить из-за радикальных отличий архитектур.

А что ты хочешь обучать?

Может тогда рассмотреть всякое майнерское?

Вроде CMP 50HX

Или это совсем дерьмо для LLM?

>Оно же будет попердолено дальнейшим форматированием чата и окажется в отрыве, что будет смущать сетку. Или хз, может не понял что хочешьсделать.

У меня итт иногда такое чувство, что либо собеседник нейросеть, уходящая в лупы. Либо я сам ушёл в цикл. Там же писалось про удаление. Но у автора этой штуки другая реализация, его подход лучше подходит под его ситуацию и видение.

И я не против мультизапроса, только считаю, что они должны быть более объёмными, включать правила и иметь состояния. То есть если трусы == сняты, то запретить снимать их снова. И что-то мне кажется, что с таким расширением модель всё равно обосрётся, нужны уточняющие инструкции. А прямо прописанные правила ещё лучше.

> а что ты хочешь обчать

Без понятия. Мне бы просто потыкаться. Хотя вообще сть одна задумка, но я не знаю, как к ней подступаться. Мне нужно распознавать достаточно специфичные фото. А для этого , я так думаю, мне нужна тестовая модель, разбирающаяся в этой сфере.

Вообще, мне нужен аналог clip от опенаи. Связать изображения и текст.

Вообще, я более чем уверен, что это решается куда проще. Но я просто хочу потыкаться.

На Теслы вообще тогда не стои смотреть. Ну, из дешевого?

> Там же писалось про удаление.

> Или хз, может не понял что хочешьсделать.

This. Пост юзера будет как минимум обрамлен токенами, или будет поставлен в историю чата после которой последует какая-нибудь инструкция, префилл и т.п. Чтобы хорошо работало - нужно чтобы приказ что делать стоял в нужном месте, хотябы просто самым последним без лишней мишуры. Тот пост про это, и не понял что за удаление. Если ты про то что доп инструкция должна удаляться как только пост перестает быть последним - понятно, но это не решает проблемы с неудачной позицией этой самой инструкции. Или может опять ты что-то другое имел ввиду, поясни тогда.

> считаю, что они должны быть более объёмными, включать правила и иметь состояния

Да, это имеет смысл. Просто в запросах статусов минималистичные инструкции выглядят логично т.к. на простое легче отвечать и меньше шанс ошибиться. Типа пачка мелких "статус трусов и одежды", "инвентарь", "настроение" - будут лучше чем одна большая, разумеется без фанатизма и совсем мельчения. А вот уже после этой все серии, уже есть смысл, как ты пишешь, накидать правил, добавить состояния или как-то это обыграть, типа серию обобщений/раздумий/саморекомендаций к ответу, и уже это в комбинации с правилами кормить для получения финального ответа. Наверно.

> Мне бы просто потыкаться.

Это можно сделать с мелкими моделями компьютерного зрения и прочего, которые вполне себе пойдут на тесле (и на любой десктопной карточке). А обучение ллм - задача весьма комплексная, и там можно ебануться уже на подготовке датасета еще до самой тренировки.

> аналог clip от опенаи

Есть целый раздел для подобного, мультимодалки это вершина, которая хоть функциональна и универсальна, в большинстве задач проигрывает узкоспециализированным решением с размерами и сложностью на порядки меньше. Если распознавать - посмотри в сторону классификаторов и детекторов объектов. С ними можно играться даже на процессоре.

> А обучение ллм - задача весьма комплексная, и там можно ебануться уже на подготовке датасета еще до самой тренировки.

Ну я еще хотел потренироваться, опыта набраться, чтобы в этой области попытаться работу найти. Чтобы хотя бы 7б покрутить. Тут уже скорее не ради цели, а ради процесса.

> Есть целый раздел для подобного, мультимодалки это вершина, которая хоть функциональна и универсальна, в большинстве задач проигрывает узкоспециализированным решением с размерами и сложностью на порядки меньше.

Ускоспециализированные решения довольно проблемны.

> Если распознавать - посмотри в сторону классификаторов и детекторов объектов. С ними можно играться даже на процессоре.

Ну я про сегментацию изображений спрашивал на доске, толком никто ничего не ответил

>CMP 50HX

огрызки с нерабочими тензорными ядрами, по бросовым ценам только 8гиговки видел 40НХ, но даже с ними сомнительные плюсы... если что-то с большим количеством памяти дешево найдеш, то можно попробовать это тьюринг хотяб будет а не паскаль, но самое выгодное сейчас это 3090 со вторички, 24гб, тензорные ядра и относительно свежее поколение... не забывай еще про фактор энергопотребления, так как 3 восьмигиговки будут более прожорливыми чем 24 гиговка одна, а значит больше БПшников понадобится или более мощные...

смотря чего тебе нужно, задачи поиска и определения объектов решаются сверточными сетями например - такое действительно на любом утюге запускается, если надо описывать типа "дракон горничная в розовых труселях облизывает красный банан в форме конского дилдака пока сидит на стуле из замороженных скелетов" - то тогда уже нужны текстовые модели (точнее мультимоды скорее), короче говоря точнее формируй задачу и минимизируй, тогда найдеш оптимальное решение

>LLM-ки запустил, проверяй. (это я ебусь с целероном)

ну ты лебушек яебу. Говорю тебе - сноси свой виндовс и ставь линукс.

Собирай из сорцов жору и не еби себе мозг.

> смотря чего тебе нужно, задачи поиска и определения объектов решаются сверточными сетями например -

Про это я в курсе. Это не то

> если надо описывать типа "дракон горничная в розовых труселях облизывает красный банан в форме конского дилдака пока сидит на стуле из замороженных скелетов"

Вот это вот нужно