Анонче, подскажи, можно ли как-то с помощью SD сменить стиль уже готовой картинки? Гайды, которые я находил, подразумевают что ты уже до этого генерил её, и чтобы не проебывать рисовку нужно копировать промпт и сид.

А если это вообще левая картинка? Попытаться описать что на ней и просто надеяться что с низкими Denoising strength и CFG он не напридумывает лишнего?

Да, там даже описалка BLIP встроена для такого. Ну и контролнетом можно обмазаться, от канни до тайлового, в зависимости от того, как близки стили визуально.

Понял, благодарю

Помогите пожалуйста, поиск ничего не выдает.

Как вообще гуглить артефакты тренировок?

Сап, аноны. Обоссыте мне ебало, выебите мать, но только подскажите как мне генерить в заданной палитре цветов? Мне нужны только конкретные цвета в txt2pic, но я вообще не понимаю как добиться этого. HALP

Ты эмбед тренируешь? Лучше смотри на финальный результат, в каком то старом гайде читал что на пробные сэмплы во время тренировки эмбеда лучше не смотреть, там наверное нужно как то настроить генерацию, а то оно скорее всего генерит с пустым промптом.

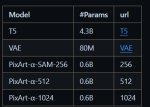

VAE

Ты эмбед тренируешь?

Да.

>Лучше смотри на финальный результат, в каком то старом гайде читал что на пробные сэмплы во время тренировки эмбеда лучше не смотреть, там наверное нужно как то настроить генерацию, а то оно скорее всего генерит с пустым промптом.

Пик1 результат шаг 1000. (слева промпт (без эмбедда), с права с эмбеддом). В этот раз тренировал на своем ПК.

А скинь его, буду использовать для розовых волос. Не баг а фича так сказать.

Подсказать правда нечего.

Что ты от него получить то в итоге хочешь? Ты же в курсе что он просто те тренит?

https://dropmefiles.com/gQN3Q

>Что ты от него получить то в итоге хочешь?

Стиль одежды и приблизительную внешность.

>Ты же в курсе что он просто те тренит?

Вы смысле не тренит? Нет, не в курсе. Но в пустом промпте он всегда генерирует тянок - чему-то он научился.

Пробовал с черно-белого фотографа треннировать вроде стиль понимает. (у фотографа очень мыльные фотки с сильным DOF что заметно.)Пик1

Вообще нет никаких туториалов про то как нужно интерпретировать результаты тренировки. Еще хоть как понятно с overtrained - это когда оно пихает определенные детали ко всем или большинству генерируемых пикч, а undertrained это когда эмбеддинг оказывает слишком слабое влияние. А все остальное это просто дикий лес.

1 Текущий датасет:

Пик2

2 Embedding Learning rate:

0.05:10, 0.02:20, 0.01:60, 0.005:200, 0.002:500, 0.001:3000, 0.0005

3 Steps:

1000

> Вы смысле не тренит?

Всмысле TE - text encoder тренит, посмотри в пик1 в шапке, это не замена полноценному файнтюну или лоре с новой инфой, просто как лазерная указка что генерить.

> Стиль одежды и приблизительную внешность.

У тебя же там датасет просто рандомных тянок, понятия не имею как ты из такого хочешь стиль одежды или внешность вытянуть, но получится просто что то среднее.

> Вообще нет никаких туториалов про то как нужно интерпретировать результаты тренировки. Еще хоть как понятно с overtrained - это когда оно пихает определенные детали ко всем или большинству генерируемых пикч, а undertrained это когда эмбеддинг оказывает слишком слабое влияние. А все остальное это просто дикий лес.

В гайдах по лорам есть. Вкратце овертрейн отлично будет отличим по артефактам на итоговой картинке, а андертрейн недостаточностью результата на дефолтном весе лоры.

>просто как лазерная указка что генерить.

Это то что мне нужно.

>В гайдах по лорам есть. Вкратце овертрейн отлично будет отличим по артефактам на итоговой картинке, а андертрейн недостаточностью результата на дефолтном весе лоры.

Про овертрейн и андертрейн я понимаю, а как свою проблему загуглить, да и вообщем-то любые с проблемы с тренировкой особенно эмбеддов очень проблемно. В основном "embedding is not woriking" пишут что выходит ошибка в консоли, а у меня цвета добавляются. "Embedding training pink colors" вообще никаких релевантных результатов не выдает.

решил попробовать sdxl, обновил SD, кинул базовую модель и еще какую-то на пробу. При переключении периодически получаю ошибку как на скрине. Чего ему надо? Модельки ведь лежат

Модель не загружается, поэтому webui сбрасывается на предыдущую модель aresmix.

Попробуй перезагрузить автоматик.

Аноны, что лучше при тренировке лоры: 50 изображений и 10 повторений или 100 изображений и 5 повторений?

20-30 изображений и 100 повторений

Оно же пережарится, лол

1 изображение 500 повторений

А если 500 изображений и одно повторение?

Зависит от изображений.

Если у тебя получилось 100 собрать, на которых именно то, что тебе надо, да еще и протэгать всё правильно - будет лучше 100.

Кто-нибудь может сказать, какого черта автоматик генерит разную картинку на одном и том же сиде, если генерить не по одной, а батчами по несколько?

Типа, при Batch count = 4 и Batch size = 1 получаем 4 картинки, потом ставим на том же сиде Batch count = 1 и Batch size = 4 - и получаем уже другие картинки. Похожие, да, но не идентичные.

Как его заставить выдать одну и ту же картинку независимо от этих настроек?

Типа, при Batch count = 4 и Batch size = 1 получаем 4 картинки, потом ставим на том же сиде Batch count = 1 и Batch size = 4 - и получаем уже другие картинки. Похожие, да, но не идентичные.

Как его заставить выдать одну и ту же картинку независимо от этих настроек?

Не подтверждаю, у меня абсолютно одинаковые картинки генерятся.

Version: v1.6.0-78-gd39440bf, xformers: 0.0.21

В итоге первый вариант оказался лучше

1girl, solo focus

Одна батчем в 4, вторая последовательно по 1-й картинке 4 раза.

SDE-карась.

Версия автоматика, правда, старая была.

Обновился - и оно перестало запускаться.

Ожидаемо.

Перекачиваю всё заново, напишу по результатам.

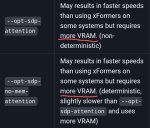

У тебя старые иксформерсы, в которых выходные изображения недетерминированы. В версии 0.0.19 это пофиксили. Либо ты использовал SDP-attention.

Всю папку убил, заново качнул - одна фигня.

>Либо ты использовал SDP-attention.

Где смотреть?

Settings — Optimizations — Cross attention optimization

Стояло на automatic, переставил на x-formers.

Сохраняется.

Отключить надо чтоль? На производительности не скажется?

Отключил - вообще ппц.

Всё медленно, батч 4 не влез в память =)

Что-то фигня какая-то нездоровая.

Попробуй поставить None и посмотреть, что получится.

Смотри выше.

Картинки в батче 2-2 получились заметно более различными, чем с auto\x-formres, кстати.

Странная хуйня, с отключенными оптимизаторами картинки по определению должны быть одинаковыми. А с другими семплерами пробовал, DPM++ 2M Karras например?

Так же проверь не стоит ли галочка "Do not make DPM++ SDE deterministic across different batch sizes" в Settings — Compatibility

В последней версии были затронуты батчи, что позволило гонять по 8 768х768х2 пикч сразу и умещаться в 16гб врам. У меня тоже не генерит идентичные, причём степень отличий ещё и зависит от сэмплера. Пик 1-2 эйлер а, сначала batch size 8, потом batch count 8. 3-4 тоже самое с 2м каррасом. Xformers достаточной версии, чтобы был детерменистик xformers: 0.0.21+c853040.d20230624

Нет, не стояла.

ЧСХ эта галка меняет аутпут даже без батча, в одной картинке, и очень серьезно.

Я это вообще на 1.5.6. чтоль заметил, до того, как обновился.

Т.е. оно давно началось.

Заметил, главное, чисто случайно - никогда раньше батчами не генерил, только последовательно. А тут решил попробовать, и офигел с того, что картинки разные начали вылезать.

На нем тоже.

И на DDIM различия тоже есть, но гораздо менее заметные.

Одна из четырех так вообще идентичная сгенерилась.

Надеюсь в той теме спрашиваю.

Хочу примерно оценить сколько времени /мощности может понадобится для обучения своей модели с нуля под узкоспециализированую не широкую тему изображений

На 11 гигах врам 1 видяхи это совсем космическое время или там неделя/месяц/полгода

Наверно есть ориентиры на других анонов которые себе чот обучали типо аниме тян

Хочу примерно оценить сколько времени /мощности может понадобится для обучения своей модели с нуля под узкоспециализированую не широкую тему изображений

На 11 гигах врам 1 видяхи это совсем космическое время или там неделя/месяц/полгода

Наверно есть ориентиры на других анонов которые себе чот обучали типо аниме тян

>обучения своей модели с нуля

>На 11 гигах врам 1 видяхи

Ебать шиза. Годы чувак, годы, отлетит твоя 1080Ti за это время.

А на 4090 получается полугоды?

> с нуля

Советую передумать, если ты не глава какой-либо мегакорпорации с крупными бюджетами. Представитель StabilityAI говорил, что для обучения SD1 они использовали кластер из 256 видеокарт A100, суммарная длительность обучения была 150k часов (17 лет, если делать на одной A100).

Существующие модели можно дообучать на домашней ПеКе (Dreambooth, надо 24GB VRAM для дообучения SD1.X моделей). Так же возможно обучать свои микромодели под названием Lora и LyCORIS, которые будут взаимодействовать в паре с другой крупной моделью. Подавляющее большинство тех, кто тренирует нейронки для рисования картинок на этой доске, выбирают этот вариант. На твоей видюхе это без проблем можно сделать; обучение лор, как правило, идёт меньше часа.

> для обучения SD1 они использовали кластер из 256 видеокарт A100, суммарная длительность обучения была 150k часов

Индус пиздит как дышит, пытаясь наебать дурачков-инвесторов. CompVis за 3 месяца допилили модель и обучили её. Там даже 1000 часов не было, в просто 150 я ещё поверил бы. Я уж молчу про то что если взять в руки калькулятор и посчитать сколько займёт обучение всего датасета LION Aesthetics на 256хА100 - там меньше трёх суток получится. Даже языковые модели с размером 13В в 20 раз больше параметров чем у первой SD и датасетом под лярд токенов столько не обучают - в пределах нескольких недель на таком количестве А100.

Анонасы, кто-нибудь юзал вундервафлю LoRA_Easy_Training_Scripts?

https://github.com/derrian-distro/LoRA_Easy_Training_Scripts

UI выглядит охуенно удобно, но туториала по тому что именно делают те или иные опции и как вообще использовать это вот всё я не нашёл. Я так понимаю что это всё делалось для людей которые уже пилили лоры, просто собрано в более удобный вид, а я только-только решил вкатиться

Если у кого есть ссыль или время на написание поста с объясненим как юзать, был бы благодарен.

Ну или хз, можете посоветовать альтернативу

https://github.com/derrian-distro/LoRA_Easy_Training_Scripts

UI выглядит охуенно удобно, но туториала по тому что именно делают те или иные опции и как вообще использовать это вот всё я не нашёл. Я так понимаю что это всё делалось для людей которые уже пилили лоры, просто собрано в более удобный вид, а я только-только решил вкатиться

Если у кого есть ссыль или время на написание поста с объясненим как юзать, был бы благодарен.

Ну или хз, можете посоветовать альтернативу

>Индус

Это бангладешец, причем мусульманин. Хз к чему ты это сюда приплел.

Там вообще всплывающие подсказки есть почти на всё, довольно круто сделано.

По поводу чего и куда - в шапке есть туториалы для тренировки лор, там параметры описаны. Названия везде одни и те же, так что прочитай - и понятно будет (почти всё).

я как-то тренировал для себя на фотках одной девушки. по итогу въебал почти сутки на это. больше как-то не хочется самому этим заниматься

> подразумевает что бенгальцы не индусы, когда треть Бенгалии в Индии

Чего, блять?

А они обучали с нуля или дообучали?

Тогда Алекс Шоненков и Бабушкин хохлы, ну а чо, Донецк тоже там был.

Когда научишься индусов от индуистов отличать, тогда пасть и раскрывай.

Анончики, как эта одежда называется? Пилю лору на Наточку, скоро с вами поделюсь.

Если ошибка несколько эпох не уменьшается, значит ли, что датасет или тэги плохо подобраны? lr 1e-4, количество эпох 10, всего шагов 2100.

long sleeve

Куда выложишь?

Спасибо.

На обменник залью. Но пока так себе выходит, положил в долгий ящик. Будет настроение, вернусь.

Аноны, скажите пожалуйста, если я пдросто возьму и перекину папку с SD с одного харда на другой, оно будет работать?

Просто место на диске С заканчивается, а второй хард пустой стоит.

Просто место на диске С заканчивается, а второй хард пустой стоит.

Будет.

На нее хороших фоток хуй да маленько.

мимо тоже пробовал тренить

Тебе нужны фотки с acursednat-исты или с модельного агенства?

Как генерировать нюдсы бывшей?

Хватит на коллаб заходить и пытаться в нем что то запустить.

И да, я вижу, если вы пытаетесь запустить «мой» код в своем блокноте

Дай ссылку

Неплохо, если скинешь пак, будет полезно.

Да хуй знает, иногда выходит нормально, но только меняешь модель или промт, выходит говно.

Спасибо.

Аноны, на мой взгляд существующие 3д модели одежды и волос обычно выглядят всрато, особенно лоупольные. Поэтому генерации с ControlNet Depth получаются крутыми только для порно-картинок без одежды.

А что если начать генерировать голого и лысого персонажа с ControlNet, а потом отключить его и генерировать одежду/волосы уже без? Это вообще в Автоматике1111 возможно сделать?

Алсо, может кто-нибудь видел хорошие туторы по эффективному использованию Depth модели? На ютубе одно говно с персонажами подозрительно похожими на примитивную болванку. Я бы за хороший тутор даже денег не пожалел бы. Хотелось бы научиться ставить своего персонажа в самые разные и сложные позы с помощью 3д модели.

А что если начать генерировать голого и лысого персонажа с ControlNet, а потом отключить его и генерировать одежду/волосы уже без? Это вообще в Автоматике1111 возможно сделать?

Алсо, может кто-нибудь видел хорошие туторы по эффективному использованию Depth модели? На ютубе одно говно с персонажами подозрительно похожими на примитивную болванку. Я бы за хороший тутор даже денег не пожалел бы. Хотелось бы научиться ставить своего персонажа в самые разные и сложные позы с помощью 3д модели.

На каждый отдельный модуль можно задать начальный и конечный процент от общих шагов, где контролнет будет работать.

Плюс то, насколько сильно этот модуль влияет.

Плюс можно подключать больше одного модуля.

Например, задать позу, подключить сверху depth, чтоб он на первых 15% шагов поработал, а потом пусть нейронка сама рисует. Только с болванкой тут врядли что получится, а вот одетого перса - уже нормально может обработать.

Экспериментируй, вообщем.

Спасибо, анон, я и забыл про этот ползунок.

>Только с болванкой тут врядли что получится, а вот одетого перса - уже нормально может обработать.

Проблема в низком качестве моделек одежды. Пикрелейтед, например. Вообще даже плохие 2д рисоваки намного лучше справляются с одеждой чем даже самые крутые 3д модделлеры и системы симуляции ткани. С этим вряд ли что-то можно поделать.

Было бы круто если бы нейросеть дорисовывала одежду сверху на голого персонажа.

Поставь для depth поменьше значимости (или вообще нафиг выруби), подключи сверху canny или lineart, чтоб по контурам больше руководства было.

Плюс tile с низкой силой, типа 0.25 или около того, с быстрым отключением, чисто для контроля цвета.

Ну и денойз повыше, прям в 0.8 или даже 0.9.

Там, где канни ничего не нарисует, нейронка с высоким денойзом будет сама что-то придумывать. В итоге что-то типа пикрила получится.

Плюс не забывай, что картинки контролнета можно редачить.

Вот, например, что получилось, если отключить тайл, закрасить часть контролнетовского файла, и немного пошаманить с промптами.

И чем я только занимаюсь?..

Вот что бывает, когда у человека слишком много свободного времени =)

Крутая штука всё-таки, этот контролнет.

Вот что бывает, когда у человека слишком много свободного времени =)

Крутая штука всё-таки, этот контролнет.

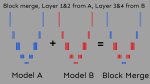

Добавьте в шапку смешивание моделей.

В крайнем случае, можно, хотя бы, добавить ссылку на гайд:

https://rentry.org/BlockMergeExplained

У тебя чисто по скриншоту 3д-модели получилось лучше чем у автора пикчи, который и Depth карту рендерил и OpenPose вроде тоже.

Забавно, может быть в самом деле для аниме, где преимущественно плоский стиль, canny будет лучше работать чем depth.

>если отключить тайл

Что за тайл?

>закрасить часть контролнетовского файла

Если тебе одну картинку нужно, то норм так лицо стирать. Если больше, то каждый раз разное лицо будет небось.

Теоретически, можно натренировать лору на лицо какого-нибудь персонажа по набору 2д картинок и тогда будет норм. Это должно будет помочь с типичными косяками 3д-аниме, когда 3д модели в профиль выглядят странно.

Анон могу ли я обучить нейросеть генерить контент для себя с моей бывшей, она была вебкам моделью и в целом онлифанс девочкой ?

Кал дабы всё. Как быть то. Платным вроде тоже нельзя

>Забавно, может быть в самом деле для аниме, где преимущественно плоский стиль, canny будет лучше работать чем depth.

Оно и на реалистиках хорошо работает.

Но там, правда, лайнарт модуль должен лучше себя показывать, он не настолько жестко на контуры давит, больше свободы для интерпретации дает.

>Что за тайл?

Модуль контролнета tile. Много где полезен - в и2и или в т2и для задачи цветов и общей композиции, при многотайловом апскейле с полным промптом для уменьшения галлюцинаций, при использовании мультидиффужн, и хз где еще. Работает как референсная картинка, короче, не позволяет ИИ сильно далеко от входящих данных отклоняться.

>Теоретически, можно натренировать лору на лицо какого-нибудь персонажа по набору 2д картинок и тогда будет норм.

А можно просто рулетку подольше покрутить, что-то похожее рано или поздно срендерится. Если, конечно, там не что-то прям шибко специфичное.

Можешь.

Если качественных фоток нужное количество насобираешь.

Гайды на тренировку лор в шапке лежат.

Есть еще модули, которые могут на тело от ИИ или из интернета лицо твоей бывшей налепить, тут даже тренировка не нужна.

просто покажи что ты хочешь сделать

Тренькнул на своем старом датасете новой пердолькой, лично мне результат нравится. Правда, не юзаю абсолютный реализм, сижу на дримшейпере или чем-нибудь типа epic25d. Смотри, может, тоже пригодится.

https://www.upload.ee/download/15694277/f1cb26dbdd671d8d6c4a/notcursednat.safetensors

Почему не загрузишь модель на цивитай?

Не умею и мне лень.

А там не ЗОБАНЯТ за такое? А то натренировать ЛоРЫ на всяких камвхор по слитым фоткам и пустить их с помощью ИИ в тираж - это вполне себе легко и вызовет просто ядерное полыхание пуканов и у модели, и у её пиздолизов, которые за тоже самое денег отваливали.

Максимум удалить могут. И то если персона, на которую лора натренена, пожалуется.

Ну, насколько я помню, и если у них там ничего не поменялось с тех пор.

Персоне может и похуй будет - даже лучше - дополнительная реклама НАСТОЯЩИХ фотачек. Но вот армию боевых куколдов никто не отменял.

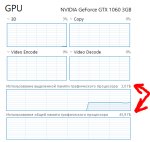

Сап технач, есть ебаный вопрос. Посравнивал бенчи своей 4080 с другими и чет какое-то говно у меня. В 512x512 в 1 батч на ейлере максимум что видел 12 it/s в SD.Next, в обычном вебхуе последнем не выше 8 it/s, а на хайрез проходе просто пиздец, 1-1.5 it's. Без токен паддингов и прочей хуйни, дефолт конфиг. У всех 15-20+ а то и 25, а у меня насрано. Нихуя не пойму в чем дело. Может кто подскажет куда копать?

Либы torch:2.0.1+cu118 Autocast half xformers:0.0.20

device:NVIDIA GeForce RTX 4080 (1) (compute_37) (8, 9) cuda:11.8 cudnn:8700 driver:536.67 16GB, проц 5800x

Либы torch:2.0.1+cu118 Autocast half xformers:0.0.20

device:NVIDIA GeForce RTX 4080 (1) (compute_37) (8, 9) cuda:11.8 cudnn:8700 driver:536.67 16GB, проц 5800x

Попробуй sdp вместо xformers.

Скачай свежую версию cudnn и подмени библиотеки в торче.

Webui, надеюсь, запускаешь без всяких no-half и no-half-vae?

На sdp ещё хуже в среднем.

cudnn и прочее подрочить попробую, но сомневаюсь что толку будет.

>без всяких no-half и no-half-vae?

Офк.

в диспетчере задач нагрузку на GPU и VRAM во время генерации смотрел? ничего необычного?

Ничего, всё чисто.

>cudnn и подмени библиотеки в торче

Где оно там лежит? Забыл чёт.

stable-diffusion-webui\venv\Lib\site-packages\torch\lib\

Файлы cudnn64_8.dll, cudnn_adv_train64_8.dll, cudnn_cnn_train64_8.dll, cudnn_ops_train64_8.dll, cudnn_adv_infer64_8.dll, cudnn_cnn_infer64_8.dll, cudnn_ops_infer64_8.dll нужно подменить.

Спасиб. Вроде чуть получше стало, но один хер выше 17its в моменте не поднимается. Но хоть что-то.

И да, еще посмотри чтобы Hardware Accelerated GPU Scheduling (Планирование графического процессора с аппаратным ускорением) было отключено в настройках винды.

Вот оно чё блять оказывается. Ебать, спасибо за помощь, анон, инфу хуй нагуглишь сам.

А как быть тем, у кого таких настроек и вовсе нет?

Значит его тупо нет в твоей винде, не беспокойся.

>Webui, надеюсь, запускаешь без всяких no-half и no-half-vae?

Так оно на какие-то десятые доли процента вроде тормозит, не критично вообще, не?

У меня с ним на 4080 25its на настройках как у анона рядом.

>У меня с ним на 4080 25its на настройках как у анона рядом.

Вот какого хуя у меня после выключения шедулинга и с последними либами максимум 20its и это на разогнанной видяхе, куда ещё 5 проебались. Или в общем конфиге пекарни дело, или какие-то приколы вебуя.

Проц тут тоже влияет, насколько я помню.

Дрова еще. НВидия там какие-то оптимизоны периодически выкатывает, попробуй обновиться.

cudnn-файлы я, кажется, в этот раз не ставил отдельно именно для автоматика. Только для кохай-вебуя для лор.

Чому у меня получается либо лицо фотографичное, но портрет на полтела, либо full body с обувью, но лицо по пизде?

Deliberate 3.

Restore face стоит.

Deliberate 3.

Restore face стоит.

>Restore face стоит.

Убери. Только хуже делает.

>либо full body с обувью, но лицо по пизде?

А ты прикинь, какой процент картинки занимает лицо на "портретной" картинке, и на "фуллбоди". Нейронке просто разрешения не хватает, чтоб его нормально детализировать.

Отправляй картинку в инпэинт, и улучшай лицо там. Гайд с правильными настройками легко загуглишь.

>НВидия там какие-то оптимизоны периодически выкатывает

Скорее деоптимизоны, лол.

>Отправляй картинку в инпэинт, и улучшай лицо там.

Или Adetailer, или как его там.

>Или Adetailer, или как его там.

То же самое, только в автоматическом режиме.

Если кучу картинок генеришь - оно лучше подойдет. А вот если какую-то конкретную хочешь - лучше инпэинтом.

какая-то фигня творится, у 4070ti было 18-19 it/s, теперь же 13-14, дрова последние и аппаратный планировщик отключен. пробовал разгон, ничего не меняется. в диспетчере задач показывает загрузку гпу ~70%. с одной стороны и так сойдёт, не минуты уходят как на 1050ti, с другой - раздражает что всё начинает замедляться без видимых причин.

установил SD на manjaro, всё быстро работает, хз что не так с 11 виндой

Подскажите пожалуйста, --opt-sdp-attention и xformers можно вместе использовать?

Нет

А что из этого лучше? Видеокарта 3060

если последняя версия xformers то разницы нет в скорости

Дайте сылку на телеграм групу анона по гугл-колабу.

>Нейронке просто разрешения не хватает

А ты прав. Спасибо.

Достаточно было высоту картинки увеличить на ~60%

Обновляю сейчас пеку и стоит выбор между 3060 12 GB и 3070. Смотрел всякие тесты и по ним 3070 очевидно лучше, но все говорят про нехватку VRAM. Так вот, что лучше взять и для чего в основном нужно больше рамы?

>для чего в основном нужно больше рамы?

От памяти зависит то, насколько большое полотно ты сможешь захайрезить или апскейльнуть.

То есть, если мне важна детализация, то лучше будет 3060 взять?

Да между ними разница минимальна, если 3060 возьмешь с 12гб памяти, ты разве что секунд на 20 дольше будешь свою простыню апскейлить. Плюс если ты юзаешь лорыхуёры, не прунед модель и хочешь ебенить с кастомными апскейлами, которые весят не мало, то их явно легче будет утрамбовать в 12гб. Если тебе для счастья достаточно сгенерить пикчу 512х512 и просто захайрезить её х2 без наворотов и и2и, то тебе можно брать и 3070 (сколько там памяти хоть?).

8 там. Мало.

Очень неудобно с 8, если честно. Постоянно бьешься в верхний лимит памяти. Так что если есть возможность - бери побольше.

Хотя я слушал, что НВидия вроде бы какой-то "оптимизон" на нейронки накатывала, который позволяет еще и оперативку подключать - но ценой значительного снижения скорости.

Хз, как оно точно работает, может аноны с треда подробнее объяснят.

Понял, спасибо

Когда про память читал, писали, что это деоптимизон какой-то, потому что при нехватке памяти начинает жрать оперативку и генерация может замедляться в десятки раз

Вот и я то же самое читал.

Но генерация всё же идет. А без такой "деоптимизации" - вообще бы не шла. Всё-таки прогресс.

Насколько вообще заебись обучать стиль, не трогая текстовую часть модели? Минусы есть?

Если смотреть чисто для работы на дифуззии, основанной на sd1.5 - 3070 будет лучше. Она быстрее а ограничения памяти можно победить через tiled vae. Но если взять sdxl, дополнительные костыли, или, не дай бог, ллм - там 12гигов сильно предпочтительнее и 3060@12 уже будет доминировать.

Так что смотри, если применение узкие и еще игрун или в ближайшем будущем будешь апгрейдить видюху - бери 3070, а так 3060 на 12 сильно лучше и дешевле.

Оно уже есть, просадки дикие но зато возможно делать картинки даже на 1030.

Хуйня на пике. Мало того что у разный моделей разные слои за отрисовку объектов отвечают, так ещё и нигде нет такого чёткого разделения.

узнали, согласны

Для тех, у кого трудности с локальной генерацией. Кастомный UI для генерации манямэ 512x512 через бесплатный веб сервис, чисто чтоб тестировать промпты. Работает достаточно шустро, цензура отсутствует, + возможность сохранения по правому клику. Регаться нигде не требуется.

https://pastebin.com/raw/NYExP1Ux

На сайте есть в наличии и реалистичные модели, но поленился добавлять.

https://pastebin.com/raw/NYExP1Ux

На сайте есть в наличии и реалистичные модели, но поленился добавлять.

Не нужно, когда на цивитаи уже давно прикрутили возможность генерить на моделях прямо там, без скачки. Пока только без хурезфикса.

>на цивитаи

Трут модели, лоры, комментарии, небо и Аллаха.

Всё, чем пользуюсь не терли. Видимо ты педофильское что-то использовал.

Из педофильского я только делиберейт использую.

Он кстати на основен Бстабера сделан, отсюда и педофилия. А бстабер тренировали на сырной пицце. Уровень работы мозга Хача имаджинировал? Надо мразулину на него натравить.

Сгенерируйте, пожалуйста по промпту

wooden fireplace, stove, Scandinavian style, in perspective

Раньше генерил на гугл колабе, т. к. своей видюхи нет, а сейчас приходится просить у вас помощи

Помогите, пожалуйста, если можно, несколько вариантов

> технотред

> ИТТ делимся советами, лайфхаками, наблюдениями, результатами обучения, обсуждаем внутреннее устройство диффузионных моделей, собираем датасеты, решаем проблемы и экспериментируем

Реквесты в других тредах, братишка.

> Сгенерируйте, пожалуйста по промпту

> wooden fireplace, stove, Scandinavian style, in perspective

> Раньше генерил на гугл колабе, т. к. своей видюхи нет, а сейчас приходится просить у вас помощи

> Помогите, пожалуйста, если можно, несколько вариантов

Сорри, не туда запостил

Ну попробуй погенерь там одетых лолек по тегу loli

Твои педофилопроблемы никого не волнуют, съебался в страхе, изврат.никто в здравом уме не использует этот педофильский тэг для педофилов

Я не он, но у меня есть сфв персонаж-лоли, для которой мне нужны спрайты с эмоциями и цг.

Это правда, что начиная с сд 2.0 теперь нельзя генерить детей?

>теперь нельзя генерить детей

Конечно, лично товарищ майор приезжает и пиздит за каждое loli в позитивном промте.

Нормально всё работает даже на сдохле, только голых не делай, а то умрёшь от кринжа.

Короче нашел какой-то гуид на дваче, по всем шагам прошелся, но чет при запуске выходит ошибка по установке торча

RuntimeError: Couldn't install torch.

Command: "E:\StableDiffysion\stable-diffusion-webui\venv\Scripts\python.exe" -m pip install torch==2.0.1 torchvision==0.15.2 --extra-index-url https://download.pytorch.org/whl/cu118

Error code: 1

кто-то сталкивался? Как фиксить? Если я тупо руками его накачу - нихуя не заработает же, потому что не в виртуальной среед ставлю

RuntimeError: Couldn't install torch.

Command: "E:\StableDiffysion\stable-diffusion-webui\venv\Scripts\python.exe" -m pip install torch==2.0.1 torchvision==0.15.2 --extra-index-url https://download.pytorch.org/whl/cu118

Error code: 1

кто-то сталкивался? Как фиксить? Если я тупо руками его накачу - нихуя не заработает же, потому что не в виртуальной среед ставлю

соре мужики - я даун, сначала вкинул, потом пошел гуглить - по итогу помогла вот эта статья - https://stackoverflow.com/questions/73817772/stable-diffusion-couldnt-install-torch-pip-version

обновил pip и удалил папку venv из корневой - по итогу вроде установка пошла

нашел более подходящий тред для своего вопроса

зачем нужен ComfyUI? я работаю с нодовыми редакторами больше 10 лет, и ни разу не встречал настолько бессмысленного инструмента

вижу единственный плюс в том, что процесс более "продакшеновый". можно настраивать узкие сетапы, сохранять их и открывать впоследствии. в вебуи не завезли файлового воркфлоу. в комфи он хотя бы есть, правда всё равно неудобен

сама творческая работа с нейронкой в комфи занимает в 10 раз больше усилий и времени, чем в вебуи

в вебуи: отключил галку HRFix, чтобы быстрее найти интересный сид

в комфи: отсоединяешь четыре сопли, потратив секунд 5

в вебуи: тыкаешь в галку обратно. 1 клик

в комфи: присоединяешь все сопли на место. 4 драгндроп операции

всё делается через переплетение нод... но зачем?

авторы в курсе, что эти переплетения нод в нормальных редакторах схлопываются в подграфы и выставляют наружу интересующие их крутилки со внутренних нод, превращая всё в одну ноду? и да, при этом получатся подобие вебуи. и по сути является функцией

вебуи это аналог гигантского комфи нетворка с вынесенным наружу интерфейсом для удобства... только в комфи нет возможности выносить интерфейс, потому что авторы комфи не знают как работают нодовые редакторы? не знают, зачем нужны функции?

зачем нужен ComfyUI? я работаю с нодовыми редакторами больше 10 лет, и ни разу не встречал настолько бессмысленного инструмента

вижу единственный плюс в том, что процесс более "продакшеновый". можно настраивать узкие сетапы, сохранять их и открывать впоследствии. в вебуи не завезли файлового воркфлоу. в комфи он хотя бы есть, правда всё равно неудобен

сама творческая работа с нейронкой в комфи занимает в 10 раз больше усилий и времени, чем в вебуи

в вебуи: отключил галку HRFix, чтобы быстрее найти интересный сид

в комфи: отсоединяешь четыре сопли, потратив секунд 5

в вебуи: тыкаешь в галку обратно. 1 клик

в комфи: присоединяешь все сопли на место. 4 драгндроп операции

всё делается через переплетение нод... но зачем?

авторы в курсе, что эти переплетения нод в нормальных редакторах схлопываются в подграфы и выставляют наружу интересующие их крутилки со внутренних нод, превращая всё в одну ноду? и да, при этом получатся подобие вебуи. и по сути является функцией

вебуи это аналог гигантского комфи нетворка с вынесенным наружу интерфейсом для удобства... только в комфи нет возможности выносить интерфейс, потому что авторы комфи не знают как работают нодовые редакторы? не знают, зачем нужны функции?

В нормальных нодовых редакторах можно еще "мутить" хоткеем выделенные ноды не нарушая само древо, сродни твоей этой галочки в веб уи. Может и тут есть, прочекай хоткеи

>в комфи: отсоединяешь четыре сопли, потратив секунд 5

Там разве нет какой-нибудь ноды-переключателя?

> Может и тут есть

Есть, конечно.

> ноды-переключателя

Есть, конечно.

Ну так в чём проблема? Настраиваем и не тыкаем 4 сопли.

Как тренировать сетку если у тебя нет видеокартовых мощностей

В калабе.

Смотри. Покупаешь видеокарты, а потом делаешь по инструкции "Как трейнить нейросети, когда у тебя есть компутаторные мощностя".

Народ, вкорячил лора лоадер в комфли юай, и оно начало срать ошибками

RuntimeError: mat1 and mat2 shapes cannot be multiplied (924x2048 and 1280x768)

как говорится, ЧЯДНТ?

RuntimeError: mat1 and mat2 shapes cannot be multiplied (924x2048 and 1280x768)

как говорится, ЧЯДНТ?

Отбой, сам дурак, забыл к рефайнеру присобачить

Аноны, когда использовать регуляризацию при обучении лоры, я так и не разобрался как это работает и поэтому так и не понял в каких случаях её юзать и какие пикчи для регуляризации юзать, а так же в каком количестве, кто то говорил что так можно отделить стилистику от персонажа, но можно более конкретное применение

>в вебуи: отключил галку HRFix, чтобы быстрее найти интересный сид

>в комфи:Mode>Never

Лично для меня это единственный полноценный ГУИ который работает сразу из коробки. С каломатиком уже посидел пока искал оптимальные настройки 6 гб нищеёб и в документации и среди устаревших и среди советов которые не работают на текущей версии. Еще классная ебля с xformers которая тупо, блять, не устанавливается. В итоге А1111 не может даже 2 пикчи 512х512 в батче обработать, уходит OOM, в то время как комфи ебашит 8.

>в то время как комфи ебашит 8.

Я так думаю, это с апдейтами дров НВидии связано, которые теперь научились оперативку подключать, если в видеопамять всё целиком не лезет.

Потому что 8 картинок 512х512 - это 2.1 мегапиксела. В автоматике без этого апдейта на восьми гигах до недавнего времени больше 1.3 не помещалось. Даже с иксформерсами.

Яхз, что там за чудо-оптимизация должна быть, если оно чисто через видеопамять на 6 гигах столько пропускать умудряется.

Это еще в NORMAL_VRAM, в full precision потому что если переполнить память то он переходит в lowvram mode или как там. И нет общая память не используется, как видно во время генерации озу освобождается.

Мне это кажется, или Heun самый лучший сэмплер? (для манямэ 1.5 моделей, на XL не тестировал)

Конечно, он и самый неудобный: более рассыпанная композиция, медленно работает, с ним нужно минимум 50 шагов и выше риск запороть изображение - но в этом и состоит вся суть ИИ для генерации изображений. Это лутбокс, как в мобильных играх - крути ручку, вращай мельницу, тряси дерево. Одна крутая пикча лучше ста посредственных, поэтому разброс в качестве выигрышнее посредственной стабильности.

Еще хороши ancestral сэмплеры, когда делаешь хайрез с низким денойзом. Ancestral означает что он дорабатывает изображение вплоть до 150-го шага, поэтому детали будут годными даже с denoise 0.4 + 4x-ultrasharp.

Конечно, он и самый неудобный: более рассыпанная композиция, медленно работает, с ним нужно минимум 50 шагов и выше риск запороть изображение - но в этом и состоит вся суть ИИ для генерации изображений. Это лутбокс, как в мобильных играх - крути ручку, вращай мельницу, тряси дерево. Одна крутая пикча лучше ста посредственных, поэтому разброс в качестве выигрышнее посредственной стабильности.

Еще хороши ancestral сэмплеры, когда делаешь хайрез с низким денойзом. Ancestral означает что он дорабатывает изображение вплоть до 150-го шага, поэтому детали будут годными даже с denoise 0.4 + 4x-ultrasharp.

Ну т.е. такой лайвхак автоматический, что если видюха не тянет - то комфи в лоу-врам переходит?

Интересно, в автоматике это так же теперь не работает случайно?

Чот сколько не тестил, с моими моделями не получается ничего лучше dpm++ 2m karras на 25 шагах.

> Ancestral означает что он дорабатывает изображение вплоть до 150-го шага

Это у которых "a" в названии? Интересно. Жалко каломатик не умеет раздельный сэмплер на хайресфикс ставить.

> даже с denoise 0.4

Чем больше генерю, тем сильнее скручиваю денойз.

>Жалко каломатик не умеет раздельный сэмплер на хайресфикс ставить.

Умеет.

И даже промпт с негативом умеет.

И чекпоинт менять тоже, прикинь?

В настройках всё устанавливается.

Что за ControlNet Hooked - Time = 61.062315940856934

Раньше такого дерьма не было, чтоб целую минуту ждать приходилось, пока он тайл обработает.

Раньше такого дерьма не было, чтоб целую минуту ждать приходилось, пока он тайл обработает.

Пока писал, он принялся за третий и последующие тайлы и теперь обрабатывает их по пол секунды. Что за херня?

Как видишь, обновляют и улучшают.

С какого калькулятора дифузишь?

Пару месяцев назад пользовался прогой, потом удалил, а сейчас решил скачать обратно. Выдает ошибку, а в чем проблема не понимаю, в программировании не шарю от слова совсем. Как пофиксить и в чем проблема?

Хуясе.

RTX 2060. И да, раньше быстрее было. Что они там улучшили, что дольше стало?

Лень разбирать эту простыню, но очевидно же что тебя провайдер ебет. Включай/отключай впны, днс проверяй.

Моё имхо, лоры - костыльная хуйня (как и всё остальное в SD):

1. Полноценная модель должна знать всё из коробки и уметь в любые стили.

2. Если некий концепт все же слишком нишевый - ИИ должен подхватить его с одного-двух рефов, без какого-либо трейнинга.

>Полноценная модель должна знать всё из коробки

Увы, анусов твоей матери слишком мало в интернете, чтобы модель о нём знала.

Переписал старый гайд по лорам от 1060 анона, актуализировав инфу, кому не похуй, укажите в чем не прав https://rentry.co/2chAI_hard_LoRA_guide

Посаны мне всегда говорили, что коха лох и мёрджить надо супермёржером прям из каломатика.

> укажите в чем не прав

Буквально во всём.

> Суть любой тренировки лоры заключается в попадании в свитспот сразу двух составных частей Stable diffusion модели, Unet и TE.

Невероятная шиза. На SDXL вообще не тренируют текстовый энкодер. На полторашке только в особо тяжёлых случаях, когда нейросеть вообще не знает таких слов. 2/3 поломок лор как раз из-за шизов, тренирующих текстовый энкодер на lr почти как у unet.

Соответственно вся последующая шиза про поломки и подбор эпох на глаз - высер.

> network_dim=network_alpha=64-128

Опять же совет как сделать хуже. При том что рекомендуемая альфа как у кохи, так и у ликориса - 1.0 или меньше. Альфа размером с ранг - ещё одна причина поломок.

> constant (default)

Отвал пизды просто.

> Если есть RTX3000 и выше, оба значения нужно ставить в BF16. FP16 подойдёт для владельцев других карт, но этот формат имеет слишком мало бит на экспоненту и из-за этого в итоговой лоре может получиться очень много нулевых тензоров.

Как будто бред сумасшедшего читаю.

> --noise_offset

> Ужасная заплатка

А альфу ебашить под 64-128 - это конечно же другое, да.

> Normal train

> loss не уменьшается

С такими высерными конфигами другого и не ожидал.

Да и вообще через строчку ересь какая-то. Ты бы хоть это перевёл, а не высерал шизу - https://rentry.org/59xed3

> На SDXL вообще не тренируют текстовый энкодер.

Как же тогда привязать чара к тегу? Ладно ещё стиль, но для перса.

> 2/3 поломок лор как раз из-за шизов, тренирующих текстовый энкодер на lr почти как у unet.

Ну а какое значение ты считаешь нормальным? Сколько не тренил, 1/3 от юнета иногда даже недожаривается, не то что перетрен.

> При том что рекомендуемая альфа как у кохи, так и у ликориса - 1.0 или меньше.

Ещё скажи что ты готов по рекомендациям кохи тренить, у него там как раз был пиздец типо 4е-7 адафактор без те для хл файнтюнов, результатом был вдхл.

> Отвал пизды просто.

А вот это с прошлого гайда скопировал не заметив, надо поправить.

> Как будто бред сумасшедшего читаю.

А ты сам натренеть сначала с одним, потом с другим и сравни, или тебе именно формулировка не понравилась?

> А альфу ебашить под 64-128 - это конечно же другое, да.

Согласен, что для перса этого многовато, но стиль на низкой альфе нихуя не улавливает.

> С такими высерными конфигами другого и не ожидал.

Скинь свой конфиг, я не против узнать как можно лучше.

> https://rentry.org/59xed3

Да, это охуенный гайд, я его читал, но там автор больше фокусится на трене чаров.

Последняя версия супермерджера какая то багнутая кстати, может смерджить поломанную модель.

> к тегу

Чел, в SD frozen clip, т.е. его вообще не тренируют изначально. Если банально по имени персонажа модель рисует любую тянку - значит тестовый энкодер уже понимает о чём идёт речь, надо только научить как рисовать это.

> Ну а какое значение ты считаешь нормальным?

Я тебе уже написал - на SDXL его вообще нельзя тренировать, на полторашке самый минимум или вообще выключить, если как я выше написал работает.

> по рекомендациям кохи

А ты предлагаешь по рекомендациям васянов, даже не понимающих что делают эти параметры? Отсутствие скейла весов - это альфа 1.0. Всё что выше - это костыли ничем не лучше кучи других костылей. Бездумно втыкать костыли куда не надо - это вообще за гранью.

> результатом был вдхл

Результат был закономерный для тренировки ванильной полторашки на рандомном кале с бур, точно такой же результат получали с любым другим способом обучения, потому что проблема в датасете. На SDXL аналогичные результаты получали с датасетом такого же уровня.

> А ты сам натренеть сначала с одним, потом с другим и сравни

От альфы у тебя веса пидорасит, а ты потом удивляешься почему же модель ломается. fp16 всегда лучше по скорости и памяти, а поломок модели вообще никогда не бывает если тренируешь нормально. Особенно учитывая что NaN это в первую очередь про кривые градиенты от идущего вверх loss, поломка весов уже следствие.

> стиль на низкой альфе нихуя не улавливает

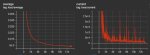

И самое лучше что ты придумал - просто скейлить веса до поломки модели? При том что у тебя всякое говно для демпфирования обучения стоит, типа больших батчей/лимита гаммы SNR/weight decay. С loss как пила естественно нихуя не тренируется нормально, тебе только и остаётся скейлить веса и потом на этих волнах высматривать где же изображение поломано меньше. Когда у тебя средний loss идёт вниз без пилы, то и результат стабильный без поломок модели и распидорашивания картинки. Пикрилейтед как loss должен выглядеть, на больших однотипных датасетах вообще как на втором пике.

> Пикрилейтед как loss должен выглядеть, на больших однотипных датасетах вообще как на втором пике

С какими параметрами и что именно тренилось?

Можете пожалуйста мой рисунок улучшить, чтобы реалистично было?

Слизни на фоне Фудзи

Слизни на фоне Фудзи

Он неплох уже как есть, за этим в nai/sd тред с развернутым описанием реквеста.

Понял, спасибо

Брах, чего ругаешься, посоветуй лучше стартовые параметры, чтобы стиль на 1.5 натренить. Я думал с продиджи начать, но не уверен...

мимо

> Чел, в SD frozen clip, т.е. его вообще не тренируют изначально. Если банально по имени персонажа модель рисует любую тянку - значит тестовый энкодер уже понимает о чём идёт речь, надо только научить как рисовать это.

Не помогая тегами, просто вжарив юнет? В чём смысл так делать?

> на SDXL его вообще нельзя тренировать

Чтобы не иметь возможности промптить персонажа? Как просто ты собираешься рисовать чаров на хл, если она их изначально не знает? А разделять как собираешься, исключительно юнетами от лор? Ладно там ещё 1.5 с её наи, в которой есть знания как приблизительно чаров многих рисовать, такую и тренить долго обычно не надо, там и 1/10 хватит для те.

> А ты предлагаешь по рекомендациям васянов, даже не понимающих что делают эти параметры?

Я предлагаю то, что не один раз срабатывало.

> Отсутствие скейла весов - это альфа 1.0.

В гайде, на который ты же ссылаешься:

> This is used to scale weights (the model's actual data) when saving them by multiplying them by (alpha/net dim) and was introduced as a way to prevent rounding errors from zeroing some of the weights.

> Alpha 0 = Alpha 128 = 128/128 = x1

Альфа 1 = отсутствие скейла весов, будет верным, только если дим тоже будет 1.

> От альфы у тебя веса пидорасит, а ты потом удивляешься почему же модель ломается.

Ты про нулевые значения? Ну так они литералли из-за выбранной точности становятся такими.

> fp16 всегда лучше по скорости и памяти, а поломок модели вообще никогда не бывает если тренируешь нормально. Особенно учитывая что NaN это в первую очередь про кривые градиенты от идущего вверх loss, поломка весов уже следствие.

Вот натренил, как ты предлагаешь с 1 альфой и фп16. Не особо то график меняется, NaN'ы в отличии от бф16 присутствуют, 103 штуки. В каком месте это быстрее тоже не понятно, такая же скорость как и всегда.

> И самое лучше что ты придумал - просто скейлить веса до поломки модели? При том что у тебя всякое говно для демпфирования обучения стоит, типа больших батчей/лимита гаммы SNR/weight decay.

Я их наоборот не скейлю, а дампенеры как раз стоят чтобы эта хуйня не сжарилась вусмерть.

> С loss как пила естественно нихуя не тренируется нормально, тебе только и остаётся скейлить веса и потом на этих волнах высматривать где же изображение поломано меньше. Когда у тебя средний loss идёт вниз без пилы, то и результат стабильный без поломок модели и распидорашивания картинки. Пикрилейтед как loss должен выглядеть, на больших однотипных датасетах вообще как на втором пике.

Ты лучше расскажи, что ты делаешь, чтобы лосс стал не бесполезной метрикой.

> В чём смысл так делать?

Чел, я тебе в очередной раз напишу - в SD текстовый энкодер не тренируется, он оригинальный от LAION. Это как раз нет смысла тренировать его. Это текстовая модель, она ничего не рисует, ей не надо знать ничего про то как выглядит твой персонаж. В лорах есть тренировка только как костыль из-за хуёвого CLIP, когда например логические цепочки в промпте, на SDXL уже жирный CLIP и от его тренировки только хуже становится. Даже у кохи об этом написано, чтоб дурачки не пытались его тренировать.

> Альфа 1 = отсутствие скейла весов, будет верным, только если дим тоже будет 1.

Ты только половину понял. У тебя веса сначала умножаются на альфу, тренируются, а потом делятся перед сохранением. При альфе 128 у тебя веса в 128 раз больше, костыль чтоб не округлялись до нуля. Но у тебя из-за этого и колебания значений весов выше.

> лосс стал не бесполезной метрикой

Loss не метрика, по нему градиенты для весов считаются. Если у тебя он идёт вверх - значит тренировка идёт в обратную сторону от референса. Нет забора - нет пережарок и поломанных лор, так же как и NaN никогда не будет, не будет проблем с подрубанием кучи лор, можно будет вес лоры хоть до 2 поднимать и генерация не будет в кашу/шум превращаться.

В душе не ебу что ты там нахуевертил что он у тебя не падает. Если у тебя датасет протеган как попало или текстовый энкодер ломает кривыми тегами, то это запросто может быть причиной пилы вне зависимости от настроек.

Покажи пример как надо делать чтобы было пиздато, чтобы запоминались вайфу, чтобы ухватывался стиль и получался красивый, убывающий на порядки лосс как из учебника. Не общие рассуждения как вы с кохой против дедов тренировали а конкретику. Будем тебе очень благодарны.

> на SDXL уже жирный CLIP и от его тренировки только хуже становится. Даже у кохи об этом написано, чтоб дурачки не пытались его тренировать.

Да я видел. Я только понять не могу как тогда модель должна будет догадаться что чар А это чар А, а чар Б это чар Б, как их потом промптить?

> У тебя веса сначала умножаются на альфу, тренируются, а потом делятся перед сохранением. При альфе 128 у тебя веса в 128 раз больше, костыль чтоб не округлялись до нуля.

Ну ок, но в том же гайде про такое не упоминается, а вот про rounding errors есть, которые бывают только на фп16.

> Но у тебя из-за этого и колебания значений весов выше.

Но я же поставил без колебаний, ты ведь видел конфиги, я менял лишь то, про что ты писал, то бишь альфу и точность, но это не помогло, судя по графикам.

> Loss не метрика, по нему градиенты для весов считаются. Если у тебя он идёт вверх - значит тренировка идёт в обратную сторону от референса. Нет забора - нет пережарок и поломанных лор, так же как и NaN никогда не будет, не будет проблем с подрубанием кучи лор, можно будет вес лоры хоть до 2 поднимать и генерация не будет в кашу/шум превращаться.

> В душе не ебу что ты там нахуевертил что он у тебя не падает. Если у тебя датасет протеган как попало или текстовый энкодер ломает кривыми тегами, то это запросто может быть причиной пилы вне зависимости от настроек.

Ну если я нахуевертил, скидывай хороший, по твоему мнению, конфиг. Потреню без ТЕ вообще, если он так мешает.

> Чел

Маркер долбоеба, дальше не читал

>>

Маркер долбоёба: >, дальше не читал.

Какую модель стоит использовать для тренировки лоры на реального человека?

Чистый SD

Понял, спасибо.

Памахите, можно как-нибудь заюзать апскейлеры из вкладки Extra и с ними Codeformer из командной строки? Из UI не подходит, нужно апскейлить очень много разных файлов батчем, потом удалять, для этого даже вкладка Batch from directory не подходит. Апскейлером пользуюсь Remacri с upscale.wiki. По идее же их должно быть можно как-то запускать с командной строки, если они там в вики без SD лежат. Настройки юзаю как на пикрелейдед. В документации по автоматику не пишут, как их с командной строки можно запустить.

https://www.chub.ai/characters/XanaduMio/sd-chan-60958867/main

ИИ-ассистент для claude, чтобы генерировать промпты

ИИ-ассистент для claude, чтобы генерировать промпты

https://github.com/KohakuBlueleaf/LyCORIS/blob/document/docs/Guidelines.md

Что за algo=full, это просто тренировка чекпонита?

Что за algo=full, это просто тренировка чекпонита?

Чот ебался с этой парашей, ебался, а она так и не запустилась, ошибка сыпет при попытке мёрджа. Что этот реп, что бета. Кто-нибудь пользуется, как оно вообще, когда работает? Может альтернативные какие-нибудь похожие штуки есть?

https://github.com/Xerxemi/sdweb-auto-MBW

https://github.com/Xerxemi/sdweb-auto-MBW

Поясните за AnimateDiff почему оно нормально генерит при разрешении 512х512, но если взять выше, те же 768х768, то видюха отказывается разгоняться и ползет на 1% мощностей.

>Да и вообще через строчку ересь какая-то. Ты бы хоть это перевёл, а не высерал шизу - https://rentry.org/59xed3

Чет попробовал настройки автора с автоматическим ЛР на Prodigy - и какая-то фигня вместо стиля натренилась. Похожесть была, но очень отдаленно. Почти 2000 шагов - мало, чтоль?

Ты сам не видишь что ли что на твоём скрине?

Ладно, я тупой, сравнил ГПУ на арте и щас, когда генерирую 512х512. Разницы нет, но я не понимаю, почему при попытке генерить 768х768, видеокарта начинает работать медленно, бесшумно и генерация замедляется в 100 раз.

> почему

Видеопамять у тебя забивается, ну.

Не хватает объема, переходит в режим low-vram, отчего и замедление.

Анончики, помогите расшифровать что чат-жопа с японского перевела: https://rentry.org/bp87n

В общих чертах как он это делает? Так что ли:

1) Тренерует Лору на скриншотах дефолтного болванчика из Хани Селект.

2) Болванчик-Лору он как-то мержит вместе с требуемой моделью, модель у него под аниме стиль.

3) Тренирует Лору своего персонажа.

В общих чертах как он это делает? Так что ли:

1) Тренерует Лору на скриншотах дефолтного болванчика из Хани Селект.

2) Болванчик-Лору он как-то мержит вместе с требуемой моделью, модель у него под аниме стиль.

3) Тренирует Лору своего персонажа.

Да, можно ещё отдельные части выбирать https://github.com/KohakuBlueleaf/LyCORIS/blob/e4259b870d3354a9615a96be61cb5d07455c58ea/lycoris/config.py

Всё так, про нюансы только хз, не пробовал

Понял-принял, благодарю.

Можно и без хани-селекта обойтись было.

Перс же примитивный, промптом задается.

А если он промптом задается - тупо генеришь штук 300 картинок, из них отбираешь сколько тебе надо, где чар на себя похож, апскейлишь, инпэнтишь лицо (если надо), и на этих картинках сразу и тренируешь.

>можно ещё отдельные части выбирать

Отдельные части тела? Типа он только на лицо обучал, а можно было тело полностью?

Алсо, кто-нибудь вообще пробовал мержить Лору с моделью? Какие скрипты для этого нужно использовать?

>Перс же примитивный, промптом задается.

В целом да, но промптом ты не сможешь тонкие нюансы прописать. Типа размеры, формы и разреза глаз, расположения прядей волос и т.д.

Хотя сейчас вроде бы можно такую мелочь с помощью Ip-adapter модели пофиксить.

>А если он промптом задается - тупо генеришь штук 300 картинок, из них отбираешь сколько тебе надо, где чар на себя похож, апскейлишь, инпэнтишь лицо (если надо), и на этих картинках сразу и тренируешь.

Это дохуя работы. Для тренировки сколько картинок надо? штук 10 минимум. Их из этой кучи достать нужно, а потом еще выдрачивать каждую до идеала.

А тут он просто скриншотов наделал за несколько минут и все, можно обучать.

> Отдельные части тела?

Отдельные части сд модели

> Алсо, кто-нибудь вообще пробовал мержить Лору с моделью?

С сд-скриптс прямо скрипты лежат для мерджа. Можешь вот этот гуй ещё юзать, он и локоны умеет примердживать https://github.com/bmaltais/kohya_ss

>ты не сможешь тонкие нюансы прописать.

Вот для этого и надо генерить много пикчей. Выбираешь то, что попало в образ - и норм.

>выдрачивать каждую до идеала.

Зачем? Вообще не надо. Главное, чтоб образ был ухвачен, и особых/повторяющихся косяков не было.

>А тут он просто скриншотов наделал за несколько минут и все, можно обучать.

Он сначала поставил хани-селект, сделал дизайн персонажа, наделал с ним скриншотов, обучил на них лору, смерджил с моделью, нагенерил картинок с персом на таком мердже, и уже на них тренировал финал.

Это далеко не несколько минут =)

По факту весь первый этап с хани-селектом и лорой на нем - это чтоб модель более стабильно тебе сравнительно похожего персонажа выдавала. И то там с попаданием в образ не очень получилось.

Почему и говорю - там, где можно чисто промптом справиться - такой изврат не нужен.

Ещё вопросец по AnimateDiff.

Если я использую больше 75 токенов в позитивном промпте, то это приводит к тому, что AnimateDiff не способен сохранять ту же композицию, больше чем на 16 кадров. Кто-нибудь нашел решение?

Если я использую больше 75 токенов в позитивном промпте, то это приводит к тому, что AnimateDiff не способен сохранять ту же композицию, больше чем на 16 кадров. Кто-нибудь нашел решение?

> Он сначала поставил хани-селект, сделал дизайн персонажа, наделал с ним скриншотов, обучил на них лору, смерджил с моделью, нагенерил картинок с персом на таком мердже, и уже на них тренировал финал.

Ты последовательность перепутал. Здесь смысл что он от стиля избавлялся, он сделал рандомного персонажа и натренил с ним, чтобы стиль впитать и примерджить к модели и уже с этого тренил, того которого хотел, чтобы стиль 3дшный не подхватывало.

Есть какие-то подвижки по дистилляции XL моделей? Чекпойнты по 12 с копейками гигов это чет как-то дохуя.

Как в теории допилить SD до уровня Dall-e 3?

Кодировщик текста чрезвычайно велик (вероятно, он мог бы даже использовать в качестве входных данных встраивания размера GPT3.5). Для т екстового кодировщика SD 1.5 используется 123M параметров, GPT3 — 150B параметров.

Нет ничего, что Stability AI не смогут сделать, просто такие вещи не будут работать на потребительском оборудовании, за исключением, возможно, загрузки/выгрузки кодировщика текста при каждом изменении промпта и кэширования после промпта. Даже в этом случае использование огромного встраивания может увеличить размер Unet без улучшения качества изображения.

С точки зрения качества изображения и того, как проработаны руки или согласованность изображения (освещение, тени), Unet (или что-то еще, что используется для обработки изображений) вовсе не является революционным по сравнению с SDXL или MJ.

Кодировщик текста чрезвычайно велик (вероятно, он мог бы даже использовать в качестве входных данных встраивания размера GPT3.5). Для т екстового кодировщика SD 1.5 используется 123M параметров, GPT3 — 150B параметров.

Нет ничего, что Stability AI не смогут сделать, просто такие вещи не будут работать на потребительском оборудовании, за исключением, возможно, загрузки/выгрузки кодировщика текста при каждом изменении промпта и кэширования после промпта. Даже в этом случае использование огромного встраивания может увеличить размер Unet без улучшения качества изображения.

С точки зрения качества изображения и того, как проработаны руки или согласованность изображения (освещение, тени), Unet (или что-то еще, что используется для обработки изображений) вовсе не является революционным по сравнению с SDXL или MJ.

В Дейли три походу насколько баз на ТЕРРАБАЙТ

Палю лайфхак. Генерируешь изображения нужного персонажа с Dall-E 3, трейнишь на них лору для SD

Спасибо, анон, если гуи есть то разобраться смогу скорее всего.

>Зачем? Вообще не надо. Главное, чтоб образ был ухвачен, и особых/повторяющихся косяков не было.

Вангую что эти косяки тебе потом аукнутся когда будешь Лорой пользоваться. Не думаю что прямо говно будет, но качество будет хуже чем у обычных Лор которых тренировали на картинках от рисовак.

К тому же, мне вот хочется персонажа в одежде, а не просто лицо. При твоем способе даже на 300 картинках одежда будет пиздец какая разная. А в 3д хоть одежда и хуже по качеству, но она везде одинаковая.

>Для т екстового кодировщика SD 1.5 используется 123M параметров

У кодировщика SDXL в сумме уже около 800M параметров. Мало, но все же какие-то подвижки вперед есть.

Ничего не получится. Как ты сгенеришь несколько картинок одного персонажа?

Хотя я для SD видел один способ в котором чувак при помощь ControlNet openpose и эмбеддинга генерировал одну картинку типа Character Sheet с персонажем в разных позах и ракурсах. Потом апскейлил картинку, резал ее на части и ебался с каждой частью отдельно.

Или ты думаешь что с помощью очень подробного промпта можно в Dall-e получить постоянного персонажа?

Ничего я не перепутал.

Если генерить просто с лорой, тренированной на 3дшном персе - ИИ будет генерить тебе 3дшного перса.

А вот если с моделью замерджить - перс (ну, какая-то часть) останется, зато 3дшный стиль должен забиться почти полностью. И на втором шаге, когда уже на таком аутпуте тренируют - он уходит вообще.

Надо будет, кстати, самому попробовать. Посмотреть, что получится. Есть у меня лора, на 3дшных рендерах разных персов тренированная. Если ее просто подключать - она этот 3д стиль и выдает в точности.

Основная тренировка лоры на 3д-персонаже у него была для того, чтоб после мерджа модель этого перса более стабильно выдавала.

>которых тренировали на картинках от рисовак.

Ты картинки рисовак то давно видал? =)

Лишних руг-ног нет, лицо не поехало, глаза не вкось? Всё, в тренировку сгодится.

>При твоем способе даже на 300 картинках одежда будет пиздец какая разная. А в 3д хоть одежда и хуже по качеству, но она везде одинаковая.

Так это ж наоборот хорошо! Нейронка лучше концепт перса от одежды отделить сможет, особенно если одежду протэгать как следует. Если у тебя будет 300 картинок перса в одинаковой одежде, как ты ее не тэгай, а она намертво с персонажем будет ассоциироваться. Ты просто не сможешь его ни во что другое без сурового гемора потом переодеть.

Не, если тебе как раз такое и надо - то окей. Но вообще для гибкости нужен разнообразный датасет.

Опять же, генерить можно с вилдкардами на 3-5 сетов одежды. закрытый Купальник, бикини, какой-нибудь кэжул, униформа, всё такое. Это вообще в идеале, чтоб потом с тэгами для второго этапа не париться.

Далл-Е 3 далеко не всех персов знает, и не всегда в образ попадает.

Даже Рей или Аску точно сгенерить - и то проблема, через раз промахивается. Хотя казалось бы, артов с ними в интернете ну просто максимально много.

Зачем?..

>Как ты сгенеришь несколько картинок одного персонажа?

Пикрил. Видел на одном дискорд серваке, картинка не моя.

Качество говно, конечно.

Before|After в промпте или что-то типа того, очень хорошо работает. Прям зацени, насколько точно совпадение по лицу получается.

(выше твой пост не протэгал в ответе, эх).

Далли3 - мультимодалка, в этом и секрет.

Действительно текстовая часть там больше, а сама тренировка была с фокусами на концепты, причем четко и правильно обозначенные.

> Для т екстового кодировщика SD 1.5 используется 123M параметров, GPT3 — 150B параметров.

Врядли там даже 1 миллиард параметров есть, столько не нужно. Но вот отдельная llm там очень даже участвует, через нее проходят все юзер промты и она уже их переводит/достраивает/модифицирует для приведения к формату, который понятен, заодно выдает подходящие параметры генерации. Потому и результаты могут разительно отличаться на вроде похожих промтах, или случаются казусы.

Далее, если понаблюдать за генерацией и поведением - за текст и логотипы отвечает отдельная сеть. Оно получается криво-всрато как или даже хуже чем в сд, если запрос пошел не туда, или классно-четко если она задействуется. То же самое может быть в другими запросами тех же концептов или стилей, о чем свидетельствует рандомайзер реакции при смене последовательности в промте. Как именно оно сделано, заранее формируется маска с отдельными частями промта, используются заранее заготовленные разные модели, проходит несколько этапов обработки, используются техники как в контролнете - возможно все сразу, врядли подробно расскажут.

> Нет ничего, что Stability AI не смогут сделать, просто такие вещи не будут работать на потребительском оборудовании

Ерунда, с точки зрения качество самих пикч и т.д. оно вообще не далеко от 1.5 ушло, а то и проигрывает в чем-то конкретном. Считай требования как для XL, но сверху еще 2-4-6 гигов памяти на дополнительную сеть, что делает препроцессинг и асист. Только сразу полезут проблемы с управляемостью и рандомом, потому эту часть целесообразнее запускать заранее, а потом контролировать/править то что она выставила. В этом случае требования мало изменятся.

SDXL то вообще тоже не простая сеть, но в ней фокус сделали на "качество пикч", используя пост-обработку рефайнером.

Хочешь реализовать - двигайся в этом направлении, для начала научив llm по запросу составлять тебе идеально отформатированный промт(ы) и пачку json с параметрами, картами и прочим.

Внимание платиновый вопрос.

С чем-нибудь из всех этих ликорисов стоит вообще ебаться для стиля? Или лучше обычной лоры так ничего и не придумали?

С чем-нибудь из всех этих ликорисов стоит вообще ебаться для стиля? Или лучше обычной лоры так ничего и не придумали?

Поменял в шаблоне гайд по лорам от 1060 на твой.

Спасибо за твой труд.

Нет. Это говно придумали для шизов, дрочащих на размер файла. На деле всё это говно имеет очень плохую переносимость между моделями. Обычные лоры уже давно умеют обучать те же слои, что и ликорис.

> дрочащих на размер файла

> плохую переносимость между моделями

> Обычные лоры уже давно умеют обучать те же слои, что и ликорис

Слои обучать не надо и даже плохо, но обычные слои их могут обучать. Что хотел сказать то?

> обычные слои

обычные лоры офк, фикс

Пиздец, там 30 слайдеров крутить в разных комбинациях, ебясь с моделью долгими зимними вечерами. Это какой-то садюга аутист изобретал.

Не, слайдеры как раз не надо трогать, но настроек всё равно больно дохуя для "сделать пиздато" модуля. Но у меня один хуй не работает.

Почаны, а гугл теперь блочит колабы с SD?

Долго не дифузировал. Сейчас снова хотел вкатиться, но на колабе, где я сидел, висит сообщение, что гугл лавочку закрыл. Но в калабе от того же Христа такого нет.

Так Гугл сворачивает SD'шников или нет?

Долго не дифузировал. Сейчас снова хотел вкатиться, но на колабе, где я сидел, висит сообщение, что гугл лавочку закрыл. Но в калабе от того же Христа такого нет.

Так Гугл сворачивает SD'шников или нет?

С возвращением. Давно уже. И аккаунт могут забанить, ибо нехуй. Покупай своё железо.

Мне одному было очевидно, что лавочку прикроют?

Ок, бро, я-то комп обновлю так и так. А почему вы в шапке не пропишите такую важную инфу? Мало того, что нет предупреждения об удалении аккаунта, так еще и висят ссылки на гугл-колабы.

>Если у тебя будет 300 картинок перса в одинаковой одежде, как ты ее не тэгай, а она намертво с персонажем будет ассоциироваться. Ты просто не сможешь его ни во что другое без сурового гемора потом переодеть.

По мне, так это хорошо. Это же самая большая проблема нейронок - невозможность рисовать персонажа в одной одежде на разных генерациях.

Если нужно переодеть, то я бы лучше еще одну Лору обучил. Постоянная одежда в разных кадрах - это бесценно.

>Пикрил. Видел на одном дискорд серваке, картинка не моя.

Увы, фигня полная, для тренировки Лоры этого и близко не хватит. Хотя да, совпадение по лицу есть очень точное. В общем, если использовать метод анона выше который про генерацию 300 картинок в СД говорил, то думаю что толку больше будет.

Пиздец, аноны, SDXL в автоматике1111 оказывается не умеет нормально в img2img.

https://github.com/AUTOMATIC1111/stable-diffusion-webui/discussions/12187

Точнее умеет, но нужно запускать модель с --no-half что поднимает требования по видеопамяти в небеса. У меня под завязку жрет 16 гигов видеопамяти на 1024 х 1024 картинку без ничего.

Если у вас нет 24 гигов то можете даже не вкатываться в сдхл, разочаруетесь.

https://github.com/AUTOMATIC1111/stable-diffusion-webui/discussions/12187

Точнее умеет, но нужно запускать модель с --no-half что поднимает требования по видеопамяти в небеса. У меня под завязку жрет 16 гигов видеопамяти на 1024 х 1024 картинку без ничего.

Если у вас нет 24 гигов то можете даже не вкатываться в сдхл, разочаруетесь.

Чел, проблемам с VAE уже год, SDXL тут не при чём. Всё нормально работает в fp16, если у тебя нормальная карта.

Что значит нормальная? У меня Quadro P5000, 16 гигов видеопамяти.

Ты хотел сказать достаточно новая видюха?

Ну хорошо, 24 гига не нужно, нужно просто быть мажором и купить новую видюху за тыщу баксов.

Чел, твоей картонке чуть ли не десятилетие, там архитектура уже всё.

Купи 3060 12ГБ, она быстрее будет, лол.

>По мне, так это хорошо.

Нет, не хорошо. Ибо в идеале надо совмещать.

300 картинок с персом, 100 в его фирменном костюме, 100 в разных простых костюмах, 100 чисто голым. И будет красота вообще - и костюм натренится, и переодевать можно будет запросто.

Куча лор так натренирована.

>Увы, фигня полная, для тренировки Лоры этого и близко не хватит.

Да понятно, это была просто демонстрация того, как эта нейронка концепты понимает. Сколько лор на подобное в СД не видел - всегда лажа выходит, никакого постоянства ключевых моментов между картинками. А тут прям из коробки.

>on Jul 31

Обновиться пробовал?

>в автоматике1111

Комфи пробовал?

Это не совсем моя карта, я ее в аренду у Paperspace на пару часов взял. Алсо, сегодня по твоему совету взял нормальную: A4000.

Пиздос, ровна такая же проблема.

Но на ней уже с --medvram --no-half по крайней мере работать img2img может. Правда у этой виртуальной машины 45 гигов оперативки, поэтому все помещается.

Короче, нужно очень хорошее железо. А вот в text2img почти на любом старье можно генерить (если есть хотя бы 8 гигов видеопамяти).

>Сколько лор на подобное в СД не видел - всегда лажа выходит

Лоры не пробовал, но вот ембеддинг и просто промпт сharacter sheet, multiple views of the same character СД вполне понимает. Без помощи контролнета правда сложно будет. Вот он очень неплохо Лору обучал на основе чарактер щита: https://youtu.be/iAhqMzgiHVw?si=aRD4g-K7TPZOQHhp

Пикрелейтед я сам генерил, правда это для 3д модели было.

>Обновиться пробовал?

Я через Gradient блокнот запускаю, хз как его обновить, думаю что там и так последняя версия автоматика.

>Комфи пробовал?

Нет, но думаю попробовать. Вроде там более щадящие требования к железу.

>Но на ней уже с --medvram --no-half по крайней мере работать img2img может.

Ещё бы. Я на 12 гигах работаю, и таких проблем нет, хватило --no-half-vae.

В целом норм в текущей ревизии. Доебаться можно по мелочам:

Изображения нужно сделать кликабельными (обязательно), а в последовательностях где 1-2 выставить их подряд а не таблицей, ненужное ужимание и шакалит (на усмотрение).

В самом начале нужно обозначить что нужен питон такой-то версии и куда тулкит.

Начало где использование, к способ 3 ставь не рекомендуется или для справки, а то начнут так портить модели.

Пример хорошего датасета - серьезно? Одни ковбойшоты с сомнительным качеством, в тегах к которым нету имени персонажа. Папка 20 вообще отборная. Присутствуют регуляризации, хотя дан совет их не делать. Везде из раза в раз повторяется эта структура 10_x 20_x, что создает впечатления что именно так надо делать. Стоит прояснить как именно выбирать и ставить эти цифры, и сказать что в большинстве случаев можно обойтись одной папкой.

В разделе Easy way пункт 5

> Внимание, в настройках Additinal networks нужно указать дополнительный путь для сканирования лор, чтобы они подхватывались из дефолтной директории вебуи.

тогда как выше написано что все по дефолту ок, и ласт коммит ищет в стандартной папке webui.

Там же, какой смысл тестировать при весах 1.3-1.5? Куда важнее сделать несколько вариантов изображений чтобы оценивать не по одному сиду а хотябы по 4-8. Для этого лучше отказаться от варьирования веса, оставив его 0.8-1.0, выставить батч сайз-батч каунт а в webui изменить число строк или столбцов в гридах (лучше вынести его в квиксеттингс). Тогда можно будет сравнивать и видеть сразу много вариантов. Аналогично не помешает использовать вайлкарты на фон/позу/... и оценивать также косвенное влияние на окружение.

--unet_lr - лучше не значение а просто что равно LR

> conv_dim - тоже самое, что и network_dim, только для этих слоёв. Размер этих слоёв складывается с размером network_dim в выходном файле. Хорошим значением будет network_dim/2-4

Откуда?

> Есть разные мнения использовать вае во время тренировки или нет

Без него сама тренировка невозможна, здесь речь о том будет ли использоваться встроенное в модель или внешнее.

> что если и использовать то только вот это

Ты же на базе тренируешь, что там по дефолту? 840к с kl-f8 и наи сравнивал (только при тренировке офк)?

Сап тренеры.

RAM дохуища (93 гига), а вот VRAM в 1063 не завезли. --lowvram оно сожрет, или я зря надеюсь?

RAM дохуища (93 гига), а вот VRAM в 1063 не завезли. --lowvram оно сожрет, или я зря надеюсь?

Оно ведь не работает с общей памятью, да? Только с хардварной?

Аноны, есть сейчас какие-нибудь виртуальные окружения вроде Колаба гуглавского, чтобы БЕСПЛАТНО вот зайти в окружение, нагрузить своих моделей и питоновских скриптов и генерировать?

Пробовал ещё сервис Paperspace, но там всё обмазано завлекалочками "FREE FREE FREE !!11". а как доходит дело до подключения к мощностям - а-тя-тя-тя, подключите свою кридиточку.

Как быть?! Раньше делал всё в колабе, горя не знал, но вот вернулся после 2х месячного перерыва и с ужасом обнаружил что гугл ВСЁ, а цены там неприемлемые, особенно учитывая курс. В общем покупать подписку не вариант.

Пробовал ещё сервис Paperspace, но там всё обмазано завлекалочками "FREE FREE FREE !!11". а как доходит дело до подключения к мощностям - а-тя-тя-тя, подключите свою кридиточку.

Как быть?! Раньше делал всё в колабе, горя не знал, но вот вернулся после 2х месячного перерыва и с ужасом обнаружил что гугл ВСЁ, а цены там неприемлемые, особенно учитывая курс. В общем покупать подписку не вариант.

на новых драйверах работает и с общей памятью, но где-то в 10 раз медленнее

купи rtx 3060 12gb

Норм, годится.

>купи

Не куплю.

>СД вполне понимает

Понимать то понимает, но чтоб важные моменты были точно ухвачены - этого в 90% случаев уже не будет.

Типа тот же before\after, или sequence - будут тебе два разных (но похожих) перса вместо одного с изменениями. В character sheet тоже не слишком много постоянства без кучи неудачных генераций.

> Изображения нужно сделать кликабельными (обязательно)

Сделал на самые мелкие, которые было не видно.

> В самом начале нужно обозначить что нужен питон такой-то версии и куда тулкит.

Про куду было, перенёс повыше с питоном.

> Начало где использование, к способ 3 ставь не рекомендуется или для справки, а то начнут так портить модели.

Ну добавил, но этим уж заморачиваться будут наверное только те, кто с чекпоинтами постоянно пердолится.

> Пример хорошего датасета - серьезно? Одни ковбойшоты с сомнительным качеством, в тегах к которым нету имени персонажа. Папка 20 вообще отборная. Присутствуют регуляризации, хотя дан совет их не делать. Везде из раза в раз повторяется эта структура 10_x 20_x, что создает впечатления что именно так надо делать. Стоит прояснить как именно выбирать и ставить эти цифры, и сказать что в большинстве случаев можно обойтись одной папкой.

Реально полная хуйня, со старого гайда, я хотел было это переписать, но походу пока про параметры писал забыл. Что думаешь, так пойдёт?

> тогда как выше написано что все по дефолту ок, и ласт коммит ищет в стандартной папке webui.

Поправил.

> Там же, какой смысл тестировать при весах 1.3-1.5?

Ну в том же гриде что я тренил видно недожар, после кстати ещё всякие тестовые тренировки были и как раз на бОльшем лр сетка получилась лучше, без этого графика я бы хуй это узнал, я её даже юзать стал.

> выставить батч сайз-батч каунт а в webui изменить число строк или столбцов в гридах (лучше вынести его в квиксеттингс). Тогда можно будет сравнивать и видеть сразу много вариантов.

Не пойму зачем эта гимнастика с батчами нужна? Можно же просто сиды рандомные поставить.

> Аналогично не помешает использовать вайлкарты на фон/позу/... и оценивать также косвенное влияние на окружение.

Ещё сложнее определить по такому влияние на бекграунд, если честно. Лучше для начала просто оценивать насколько хорошо вышел тренируемый концепт, но я всё же допишу.

> --unet_lr - лучше не значение а просто что равно LR

Уверен? Просто лр можно вообще указать произвольным, он нихера не влияет, если разделяешь и указываешь правильные значения для юнета и те по отдельности с адамом.

> Откуда?

Тестил с этими значениями, выходило хорошо. Есть другие предложения?

> Без него сама тренировка невозможна, здесь речь о том будет ли использоваться встроенное в модель или внешнее.

Да ты прав, плохо сформулированно, переделал.

> Ты же на базе тренируешь, что там по дефолту? 840к с kl-f8 и наи сравнивал (только при тренировке офк)?

А сам не знаешь насколько ужасное в наи вае по дефолту? Сравнения в старых тт кидал, наи вае, не то что в модели, и 840к, kl-f8 не тестил, 840к это энивей его файнтюн, на собственно 840к шагов https://huggingface.co/stabilityai/sd-vae-ft-mse-original#decoder-finetuning , 840к выигрывал в детализации даже на 512

Спасибо за совет, кстати. Заменил --no-half на --no-half-vae и уже не так сильно память жрет. Работает даже на P5000

Расскажи получилось ли генерить с сдхл моделями. Вангую что постоянные вылеты будут.

Кстати, аноны, а кто-нибудь пробовал генерить на основе 3д рендеров, но так чтобы стиль получился 2д?

Мне раньше было это неинтересно из-за низкого разрешения SD1.5, но на SDXL можно любопытные результаты получить если несколько controlnet моделей добавить. Пикрелейтед я генерил без Лоры на персонажа, тупо img2img с денойзом 0.6.

>низкого разрешения SD1.5

>несколько controlnet моделей добавить

С контрол нетом можно хоть 4к пикчи делать на полторашке, никаких проблем не будет, кроме памяти, лол.

>никаких проблем не будет

Не все так просто. Даже с контролнетом при увеличении размера картинки ИИ имет свойство чрезмерно засирать нейрошумом пустые пространства. Даже там, где это не требуется.

Если, конечно, тебе не простой апскейл нужен на денойзе 0.25, а именно обработка картинки с увеличением детализации.

>генерить наоснове 3д рендеров, но так чтобы стиль получился 2д?

Выше тред почитай, я кидал несколько картинок, забодяженных на основе карточки из койкатсу.

>ИИ имет свойство чрезмерно засирать нейрошумом пустые пространства. Даже там, где это не требуется.

Так оно всегда так работает, просто при размере с почтовую марку это незаметно.

>Так оно всегда так работает

Ну, не совсем прям всегда.

Но контролировать эту тенденцию трудно.

Я пока стабильного способа не придумал.

Насрать в картинку нейрошумом - это вот запросто, это завсегда пожалуйста.

>Выше тред почитай, я кидал несколько картинок, забодяженных на основе карточки из койкатсу.

Ага, нашел тот пост.

Даже не верится что у тебя с таким высоким денойзом (0.8) получается похоже на оригинальный 3д рендер. У меня даже на 0.6 цвета жестко проебывает.

Сколько ты примерно ставил веса depth и canny? И tile примерно на каком шаге отключал?

Хотя ведь тайл модели вроде нет еще в сдхл, то есть цвет контролировать я не смогу.

Можно, но в родном разрешении работать проще. Если мне не нужен арт в высоком разрешении, то я тупо могу 1024 х 1024 рендер сделать и на его основе генерить картинку в том же разрешении. Никаких апскейлов вообще не нужно.

На тайл есть много вариаций, как я заметил.

Можно поставить 0.25 силы и отключать на 0.1 (24 шага всего, это как раз вариант с картинки). Задаст базу и спокойно отключится, дальше нейронка будет сама думать.

Можно поставить 0.25 силы и вести до конца. Тут более точный контроль будет, ради сохранения деталей и цвета, но меньше фантазии.