Перекатил вопрос.

Почему всякие гайды по обучению лоры на определенный ебальник (одного человека) рекомендуют использовать 10-30 фото? Разве закинуть 100-200 фото не лучше для обучения?

Почему всякие гайды по обучению лоры на определенный ебальник (одного человека) рекомендуют использовать 10-30 фото? Разве закинуть 100-200 фото не лучше для обучения?

Принцип необходимости и достаточности

ты б еще спросил почему в зерошот моде достаточно 6 ебальников

https://huggingface.co/collections/ptx0/terminus-xl-65451893a156b3b1d1456514

Я непонел шоэта? Файнтюн или модель с нуля? Он так пишет будто с нуля тренил.

>Terminus XL Gamma is a new state-of-the-art latent diffusion model that uses zero-terminal SNR noise schedule and velocity prediction objective at training and inference time.

>Terminus is based on the same architecture as SDXL, and has the same layout. It has been trained on fewer steps with very high quality data captions via COCO and Midjourney.

Я непонел шоэта? Файнтюн или модель с нуля? Он так пишет будто с нуля тренил.

>Terminus XL Gamma is a new state-of-the-art latent diffusion model that uses zero-terminal SNR noise schedule and velocity prediction objective at training and inference time.

>Terminus is based on the same architecture as SDXL, and has the same layout. It has been trained on fewer steps with very high quality data captions via COCO and Midjourney.

Я просто не могу использовать влад автоматик или а1111, на амуде 7900 в убунту крашится драйвер на мгновение, и все графические программы перестают работать до полной перезагрузки

Комфи работает, но не нравится он мне. Признайтесь, у кого на амуде 7900 все работает, и можно генерировать два часа, какие версии, какие гайды?

Комфи работает, но не нравится он мне. Признайтесь, у кого на амуде 7900 все работает, и можно генерировать два часа, какие версии, какие гайды?

У меня есть товарищ, казуал полный,и ставить ручками эти ваши питоны-диффузеры в рот ебал, так что скачал уан-клик-инсталл модную молодёжную оболочку для нейросетей: https://github.com/LykosAI/StabilityMatrix

У неё внутре неонка Комфи, но интерфейс белого человека, а не макаронного монстра. На интерфейс комфи тоже можно переключиться в случае чего, обычным заходом по айпи.

А вообще я бы охлаждение проверил и мб андервольтинг сделал у видюхи.

Все зависит от задачи. Если цель - буквально воспроизводить фейс с минимальным изменением ракурса то такого вполне достаточно и заодно упростит подготовку датасета. Если нужно что-то более сложное или генерация остального тела то больше фоток предпочтительнее, с другой стороны здесь качество важнее количества.

А так кто знает этих шизохайперов с их вбросами и ахуительными историями. Будет неудивительно если братишки продемонстрировали где-то в статье саму возможность такого обучения, не задумываясь об оптимизации результата, а дурень увидев это принял за абсолютную истину и всюду тащит.

Файнтюны офк.

Логи хоть глянь что с драйвером ним происходит.

>Логи

Не знаю, полез, и уже 20 минут нет вылетов. Нечего добавить. Блин, а вчера ни одного нормального рана не было. Ладно, пока закрываю тему

Спс, гляну. Насчет параметров видюхи, нашел Corectrl, но в нем как-то криво настраивается, не рискну трогать

> Файнтюны офк.

Нет, это именно обученные с нуля модели на архитектуре SDXL. Но так как у них всратый датасет, то они соответственно нихуя не могут.

Просто технодемка для проверки технологий.

А зачем тогда? Как тренить модели уже известно, ничего нового. У них там линки на скрипты для файнтюна, в них что-то такое особенное - уникальное?

Применение zero-terminal SNR не ново и есть и на 1.5. Последовательный тренинг xl в разрешениях с 512 до 1024? Ну наверно норм, честно хз как тренилась оригинальная модель, сразу или с повышением. В чем суть то?

Ну очевидно что это попытка попробовать к чему приведёт

>very high quality data captions

>zero-terminal SNR noise schedule and velocity prediction objective

в архитектуре SDXL.

Это просто следствие того что цены на тренировку фундаментальных моделей резко упали (пиксарт альфа, DiT уже тренировали за копейки), вот уже отдельные энтузиасты балуются.

>Применение zero-terminal SNR не ново и есть и на 1.5.

В SDXL они не осилили ни ztsnr, ни vpred. По каким-то техническим причинам, кажется. Этот чел вот делает.

> По каким-то техническим причинам, кажется.

Вот это довольно странно, учитывая что в 2.х оно было. Возможно xl на самом деле старше чем 2.х и начала трениться до ее релиза.

На 1.5 эти вещи относительно легко добавляются файнтюном базовой модели, велика вероятность что здесь сработает тот же трюк.

Другое дело что тренировка с нуля отличается, написано о предпочтительности обширного и разнообразного датасета в начале тренировки, а смещение к качеству и усложнение наилучшим образом работает уже на более поздних ее этапах. Пока что их результат это подтверждает и усложняет оценку остального.

Кстати кто-нибудь на xdxl пробовал будку запускать, оно вообще реально без A100?

Далеко не уехал. В гугле нашел открытые проблемы, пишут про разные причины

ERROR MES failed to response msg=14

[drm:mes_v11_0_submit_pkt_and_poll_completion.constprop.0 [amdgpu]] ERROR MES failed to response msg=2

amdgpu: failed to add hardware queue to MES, doorbell=0x1216

amdgpu: MES might be in unrecoverable state, issue a GPU reset

> По каким-то техническим причинам, кажется.

Технические причины звучат примерно так: "Good morning sir, use lora, noise offset lora good, can fix everything, thank you."

https://huggingface.co/stabilityai/stable-diffusion-xl-base-1.0/blob/main/sd_xl_offset_example-lora_1.0.safetensors

> Кстати кто-нибудь на xdxl пробовал будку запускать, оно вообще реально без A100?

На 3090/4090 реально

https://github.com/recoilme/train#kohya-train-params-for-3090-with-24-ram

Но скорость пиздец конечно

Уже было?

>Stable Diffusion v1.6 Release

https://platform.stability.ai/docs/release-notes#stable-image-v1-release

>Stable Diffusion v1.6 Release

https://platform.stability.ai/docs/release-notes#stable-image-v1-release

В sd треде было

Почему доступ только через api

Без gradient_checkpointing выходит не заведется? Припоминаю что оно раза так в 1.5 скорость резало или даже больше.

А сами веса где?

SAI всегда сначала через апи дают пробовать, потом уже релизят веса

а сдхл это что было тогда?

Так, а на kaggle, если дают две Т4? accelerate, все дела?

Шта? Полторашка победила??

Надеюсь, что все штуки с когеренцией на высоких разрешениях они вынесли в отдельные слои. Чтобы с существующими миксами было проще мёржить.

> Без gradient_checkpointing выходит не заведется?

Не хватит памяти

> gradient_checkpointing

Ужасная вещь, пробовал с этим сделать лору, да, потребление памяти ниже чуть ли не в 2.5 раза, скорость всего в 1.5-2 раза была ниже, но не запомнилось практически ничего. У вас получалось с этим параметром удачно натренить что нибудь?

Есть 2 папки: с небольшим проверочным датасетом и классификационными картинками. Выставляю какие то настройки, Изображения классов на изображение экземпляра ставлю на 20, нажимаю Тренироваться - хуяк, please check your dataset directories. Что? Чего блядь? Нажимаю ещё раз Тренироваться - начинается генерация классификационных картинок.. У меня же блядь уже есть эти картинки, хули ты сука их генерируешь. Мне кажется этот dreambooth вообще не видит, что у меня есть какие-то изображения хоть в одной хоть в другой папке, всё максимально криво, во время обучения он выдает картинки которые вообще не о том, какая то потрескавшаяся штукатурка, мусор, подобие карты местности, но только не портреты людей.

Давайте помогайте кто шарит, спасайте.

Давайте помогайте кто шарит, спасайте.

Вот такая хуйня высирается

Папка с изображениями должна называться %количество повторений%_%название концепта%, например 10_proverka

Закидываешь изображения/подписи в папку, например d:\mygreatlora\10_proverka и указываешь путь датасета d:\mygreatlora

А папку с классификационными картинками с подписями как размещать?

Перекинул папки на жесткий диск с рабочего стола, теперь вроде видит классификационные картинки, по крайней мере не пытается их заново генерировать, первая генерация выдала это. В чем проёб?

Как sdxl лоры на персонажей в сравнении с 1.5 кто-нибудь сравнивал?

2d если конкретно

> с небольшим проверочным датасетом

Это тут не поможет. Про структуру папок вроде сказали, ну и пользуйся кохой а не встроенным костылем автоматика, там все сильно лучше.

Пережарил, лр снижай.

Анон, это кабздец. У меня нет апстрима. Я линуксоид во втором поколении, больше 10 лет на убунте. Я не могу жить без апстрима. Это неправильно.

Ты, может быть, меня вспомнишь. Может быть, я тебе уже даже надоел. Я треню DreamBooth на колабе от ShivamShrirao, основательно так перепиленном под мои нужды. Треню редко, в среднем раз в неделю. Не так много того, что мне хочется иметь, а датасеты собирать долго.

Так вот, у меня нет апстрима. Совсем. Шивам забросил своё поделие. Попытка воткнуть вместо его скрипта официальный, из диффузерсов - провалилась. Слишком большое расхождение. Шивам в своё время вообще не пуллреквестил, и в результате многие нужные опции реализованы совсем иначе - в его форке и в диффузерсах. Я пытаюсь сейчас всё это бэкпортнуть, но... но... диффузерсы категорически скептически настроены против того, чтобы принимать новые фичи! Вообще! Никто этого не хочет. Коха? Последний коммит 7 месяцев назад. ЛастБен? Что-то в том же духе.

Наверное, я обречен вечно страдать без апстрима. Это кара за жажду обладания тем, что мне не принадлежит.

Ты, может быть, меня вспомнишь. Может быть, я тебе уже даже надоел. Я треню DreamBooth на колабе от ShivamShrirao, основательно так перепиленном под мои нужды. Треню редко, в среднем раз в неделю. Не так много того, что мне хочется иметь, а датасеты собирать долго.

Так вот, у меня нет апстрима. Совсем. Шивам забросил своё поделие. Попытка воткнуть вместо его скрипта официальный, из диффузерсов - провалилась. Слишком большое расхождение. Шивам в своё время вообще не пуллреквестил, и в результате многие нужные опции реализованы совсем иначе - в его форке и в диффузерсах. Я пытаюсь сейчас всё это бэкпортнуть, но... но... диффузерсы категорически скептически настроены против того, чтобы принимать новые фичи! Вообще! Никто этого не хочет. Коха? Последний коммит 7 месяцев назад. ЛастБен? Что-то в том же духе.

Наверное, я обречен вечно страдать без апстрима. Это кара за жажду обладания тем, что мне не принадлежит.

Что думаете про этот Vae от OpenAI? Лица в меньшей мере распидарашивает

https://github.com/AUTOMATIC1111/stable-diffusion-webui/issues/13879

https://github.com/AUTOMATIC1111/stable-diffusion-webui/issues/13879

О, кстати, в автоматике в отдельной ветке реализовали

А ты быстрый. Это говно уже успели обоссать 10 раз, в автоматике передумали делать его потому что хуже обычного VAE.

Расширение, добавляющее LCM Sampler в sd-webui

Теперь lcm лору для sdxl можно использовать в автоматике!

https://github.com/light-and-ray/sd-webui-lcm-sampler

Теперь lcm лору для sdxl можно использовать в автоматике!

https://github.com/light-and-ray/sd-webui-lcm-sampler

Это всё ещё не полноценная реализация семплера, я в прошлом треде кидал сравнение с этим обрубком. По качеству всё ещё лучше частичное LCM использовать, так хоть негативы будут работать.

Негативы отрубаются при cfg 1.0

Жрёт память люто, проблемы полностью не фиксит. Вердикт: в печь. Банальные хайрез фиксы, деталеры, и прочие двухпроходные трюки работают быстрее, лучше, экономичней.

Пасаны, как лечить эту хуйню? Походу из за этого у меня dreambooth не работает, восклицательные знаки явно не просто так выставились.

Купил 3060, по бенчмаркам на англоязычных сайтах она выдаёт 12it/s. А у меня 6it/s.

Если у кого-то есть 3060, прошу сделайте тест

a house

Steps: 20, Sampler: Euler, CFG scale: 4.5, Seed: 3005468437, Size: 512x512, Model hash: 84d76a0328 (https://civitai.com/models/25694/epicrealism), Version: 1.6.1

Напишите it/s и время генерации картинки

Напишите свой set COMMANDLINE_ARGS=

Версию драйвера

Версию cuDNN

Версию PyTorch

Если у кого-то есть 3060, прошу сделайте тест

a house

Steps: 20, Sampler: Euler, CFG scale: 4.5, Seed: 3005468437, Size: 512x512, Model hash: 84d76a0328 (https://civitai.com/models/25694/epicrealism), Version: 1.6.1

Напишите it/s и время генерации картинки

Напишите свой set COMMANDLINE_ARGS=

Версию драйвера

Версию cuDNN

Версию PyTorch

6 it/s выглядит норм. Чуть больше 3 сек на генерацию, у меня так же

Скорее всего ты видел тесты нового драйвера с включенным tensorrt

Э, а че у меня сажа включилась. Бамп

xformers включил?

Да, при этом

--precision full and не работает, выдаёт ошибку

--no-half снижает производительность вдвое

> --no-half снижает производительность вдвое

Что здесь тебя удивляет, так и должно быть. Эти параметры на видеокартах белого человека не нужны.

Если судить по бенчмарку из шапки то примерно 6 итераций там и должно быть, покажи что за бенчмарки ты смотрел.

https://vladmandic.github.io/sd-extension-system-info/pages/benchmark.html

там есть без tensor rt с ебенячими показателями

плюс ещё тут смотрел 6-7 секунд у пацанов

а у меня 9-10

https://www.reddit.com/r/StableDiffusion/comments/z0f5k0/stable_diffusion_rtx_3060_12gb_vs_rtx_3060ti/

Карту проверил в бенчмарках, выдаёт что нужно, но в СД показатели ниже чем средние.

как же хочица 1.6...

А такое видал? Установил ебать дримбут, сразу пиздота непонятная началась.

Переустановил SD, получилось 7.2 - 7.5 секунд на генерацию из реддита

Хз что ещё сделать, они там не пишут какую модель используют, от модели же тоже зависит скорость?

В моём тесте получается 6,5 - 7.2 it/s, 3.2 секунды генерится картинка

Тут все ок, 6-7 it/s для 3060. Есть один с 12 it/s, но там sdp оптимизатор и большой batch size. Как я понял, это флаг на split attention, или quad attention

Можно еще в настройках до кучи token merge поставить на примерно 0.4 - даст ещё около 20% скорости

А, затупил, spd - это speed. Короче вот этот флаг:

--opt-sdp-attention May results in faster speeds than using xFormers on some systems but requires more VRAM. (non-deterministic)

А блин, затупил еще сильнее. Короче хрен знает что за sdp. В общем больше памяти жрет, не детерменистичный - это большие минусы. А судя по бенчмарку, преимущество в скорости только при большом batch size

>sdp оптимизатор

у меня с ним результат ещё хуже чем xformers

>Можно еще в настройках до кучи token merge поставить на примерно 0.4 - даст ещё около 20% скорости

Я щас буду устанавливать все игры оптимизаторы

Братишка, а объясни ещё что такое AITemplate? Его можно запустить вместе с TensorRT?

lora и tensor rt невозможно применить вместе?

Так чего там с этой лцм-лорой и мерджем?

На аниме работает? Чувствительность к негативам и цфг какая?

Контролнет, хайрезфикс, и всё такое?

Хочу понять, стоит заморачиваться или нет. 4080 в компе - это, конечно, хорошо, но если можно урезать количество шагов в 4 раза - это ж еще лучше.

P.s. кохай свой хайрезфикс запилил, мнения?

https://github.com/wcde/sd-webui-kohya-hiresfix

На аниме работает? Чувствительность к негативам и цфг какая?

Контролнет, хайрезфикс, и всё такое?

Хочу понять, стоит заморачиваться или нет. 4080 в компе - это, конечно, хорошо, но если можно урезать количество шагов в 4 раза - это ж еще лучше.

P.s. кохай свой хайрезфикс запилил, мнения?

https://github.com/wcde/sd-webui-kohya-hiresfix

>Так чего там с этой лцм-лорой и мерджем?

>На аниме работает? Чувствительность к негативам и цфг какая?

>Контролнет, хайрезфикс, и всё такое?

Всё работает. Возможно имеет тенденцию к упрощению или замыливанию фона; недавно обнаружили баг с кривым шедулером, может пофиксят. LCM оказался хорошей финишной штукой, имеет смысл генерить недопроявленную композицию на минимальном разрешении обычным методом (512х512, 4-6 шагов и т.п.), потом апскейл до рабочего разрешения и прогнать через LCM. Так получается когерентность лучше, чем чисто LDM или чисто LCM. Если с контролнетами юзать, то первый этап не нужен, можно сразу LCM.

>P.s. кохай свой хайрезфикс запилил, мнения?

Всё пиздато, работает и каши не просит.

Хуита

Возможно, надо лору конвертировать тоже. Если ты про lcm, то ее надо мержить

20/20 [00:02<00:00, 8.04it/s]

@echo off

set PYTHON=

set GIT=

set VENV_DIR=

set CUDA_MODULE_LOADING=LAZY

set NUMEXPR_MAX_THREADS=16

set PYTORCH_CUDA_ALLOC_CONF=garbage_collection_threshold:0.9,max_split_size_mb:512

set COMMANDLINE_ARGS=--autolaunch --opt-sdp-attention --upcast-sampling --opt-channelslast

git pull

call webui.bat

Драйвер 546.01 нвидя студио, как у всех белых людейлюдей

Cuda compilation tools, release 12.1, V12.1.105

Build cuda_12.1.r12.1/compiler.32688072_0

PyTorch второй

Вот только у меня NVIDIA GeForce RTX 2060, а после твоих мощностей мне чет расхотелось покупать что-то помощнее, когда выхлопа будет меньше

А если 150 шагов, то какая скорость? У меня была 2060Super, на ней получалось 9.2 it/s

Нажал Apply LoRA checkpoint to TensorRT model

и кажется получилось.

Если я подключаю в sd_lora LCM лору, то получается 5сек.

Если я подключаю в sd_unet TRT для лоры (не для модели, тогда работать не будет), а в sd_lora не подключаю ничего (тогда тоже работать будет), то получается 3.8 секунды.

Это оно? Или что-то не правильно?

А у тебя 2060 на 12 гб?

У тебя разница во времени из-за загрузок модели. Надо смотреть на время второй генерации после изменения модели

Очевидно, что 3060 мощнее 2060, и значит у меня какая-то проблема.

А попробуй в аргументы добавить только xformers?

С 2060 имеет смысл обновляться тогда уже на 4060 Ti и что-то выше. Или ждать следующего года, может подвезут 4060с с 12 гб для нищеты.

я несколько раз прогенерировал после изменения модели

150/150 [00:18<00:00, 7.98it/s]

Ну на этой модели столько

Da

>А попробуй в аргументы добавить только xformers?

А я не помню, какой у меня из аргументов является альтернативой для иксов, от куды. Они же в конфликт вступят.

А, тьфу, слепой я. ТОЛЬКО иксы, понял, щас

WARNING:xformers:A matching Triton is not available, some optimizations will not be enabled.

И как фиксить?

Генерит незначительно медленнее, хотя сосноль говорит, что иксы подкручены

150/150 [00:20<00:00, 7.27it/s]

> И как фиксить?

Тритон только для прыщей и в SD не используется.

У тебя там VAE какое-то подключено не стандартное, кста, попробуй генерацию без него.

Пробовал, там без разницы. Либо разница несущественная настолько, что даже не видно.

> 150/150 [00:18<00:00, 7.98it/s]

> Ну на этой модели столько

> Da

12 гб 2060 основана на 2060 super. А та в свою очередь по бенчмаркам, что кидали недавно, не отличается от 3060 в генерации

HFValidationError ( huggingface_hub.utils._validators.HFValidationError: Repo id must be in the form 'repo_name' or 'namespace/repo_name': 'путь/к/моей/модели/блять.safetensors'. Use `repo_type` argument if needed.

Какова хуя, помогите посоны. Норм запускается только на стандартной модели 1.5

Олсо как запустить тренировку из сосноли, а не из вебгуи?

Какова хуя, помогите посоны. Норм запускается только на стандартной модели 1.5

Олсо как запустить тренировку из сосноли, а не из вебгуи?

Путь/имя базовой модели неверно указал.

> Олсо как запустить тренировку из сосноли, а не из вебгуи?

Ты про что именно здесь? Там есть кнопка "печать команды", ее копируешь и вставляешь в консоль, или пишешь все параметры вручную.

> Путь/имя базовой модели неверно указал.

В том и дело что верно, прямой путь непосредственно к модели .safetensors

Если точно так же указываю стандартную 1.5 - съедает и начинает работать.

Гугл показывает схожие проблемы, например https://github.com/guoyww/AnimateDiff/issues/14#issuecomment-1635563101

>Там есть кнопка "печать команды

Кнопка есть, но начинается с accelerate что не является исполняемым файлом. И как параметр, который передается в train_network.py это не выглядит (хотя и похоже на конвейер, типа передачи вывода на ввод в другое место). Я не проверял еще это канеш, но выглядит так, как будто не заработает.

> В том и дело что верно

Прямой/обратный слеш, отдельные символы и прочее точно верные? Такое выдавало при ошибке в пути, по твоей ссылке о том же.

> но начинается с accelerate что не является исполняемым файлом.

Орли? Венв активируй и сразу станет им.

> Я не проверял еще это канеш, но выглядит так, как будто не заработает.

В фонд золотых цитат.

>Прямой/обратный слеш, отдельные символы и прочее точно верные? Такое выдавало при ошибке в пути, по твоей ссылке о том же.

У меня стандартная 1.5 лежит там же где и остальные модели. И прописывал я это не руками, а через гуй намышетыкал - тут же (почти) нельзя ошибиться.

>Венв активируй

Указать venv как PATH то есть?

>В фонд золотых цитат.

Бля ну не издевайся, консоль не поймет что такое accelerate потому что ничего об этом не знает. Она поймет максимум следующий далее train_network.py с паравозом ключей к нему, но не accelerate. Это на первый взгляд.

> Указать venv как PATH то есть?

> Бля ну не издевайся, консоль не поймет что такое accelerate потому что ничего об этом не знает

Не издеваюсь и без негатива, просто у тебя даже базовых знаний нет зато лезешь рассуждать.

По той же причине ошибка с неверным путем с вероятностью 99.5%, а прошлое могло работать вообще потому что подсасывало с обниморды по названию (да оно так может).

>просто у тебя даже базовых знаний нет

Я погуглил, я молодец, понял о чем ты. Странно, venv должен активироваться при старте вебгуя, но действительно при указании модели 1.5 я видел что

>прошлое могло работать вообще потому что подсасывало с обниморды по названию.

Но думал что это мож зависимости какие к модели, хз.

> Странно, venv должен активироваться при старте вебгуя

Так для него он активировался, но только для него а не глобально, каждый новый терминал - своя активация среды.

Ну вот и понятно стало, внимательнее будет, в первую очередь чекни чтобы слеши прямые а не обрашные были, базированная херь в шинде.

> каждый новый терминал - своя активация среды.

Я имею в виду один терминал, да. Батник с вебгуи ведь должен в т.ч. активировать venv, но при этом непонятно почему он не берет модель по прямому пути. Навскидку очень тупое предположение - потому что модели лежат в отдельной директории, но при указании прямого пути все должно работать же энивей.

Но я попробую запуск из сосноли, потому что пока гуглил - встретил мнение что это именно проблема вебгуя.

Как тренить лору на hll или на животных, как то отличается от обычного обучения или нужно какие то флаги ставить?

Какой положняк по тренировки лиц? Могу ли я мешать анфасы с профилем или одтельно тренить на анфас и на профиль?

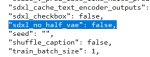

--v_parameterization --zero_terminal_snr --scale_v_pred_loss_like_noise_pred

Tensor RT не работает с SDXL моделями? Выдаёт ошибку

Так.. Решил заняться тотальным обновлением софта, а то там хлам всякий тянется уже с релизов полугодовой давности. Вебуй для генерации вижу теперь запилили работающим без нужды засирать системный диск питоновским говном. Это хорошо.

А как быть с тренировкой лор? Гайд к скрипту традиционно начинается с "поставьте питон, поставьте ГИТ". Не сделали еще такой же установки чисто в свою папку?

А как быть с тренировкой лор? Гайд к скрипту традиционно начинается с "поставьте питон, поставьте ГИТ". Не сделали еще такой же установки чисто в свою папку?

https://github.com/serpotapov/stable-diffusion-portable

https://github.com/serpotapov/Kohya_ss-GUI-LoRA-Portable

Ты можешь сам ставить всё в свою папку, посмотри как это делает хач, или используй его сборку.

Ну какого черта в новом вебуи сделали систему сохранения промптов совсем черезжопной. Раньше выбрал в выпадающем меню, нажал применить - ВСЕ. Теперь выбираешь в меню, открываешь отдельное меню и уже оттуда применяешь. Нахрен так делать было?! Есть плагин, который схоронять может промпты нормально удобно умеет и при этом не перегружен свистоперделками типа перевода текста и ведения целой базы данных.

Нужно ли указывать pretrained model при обучении лор? Какие подводные камни у обучения с чекпоинтом и без него?

Если я указываю рандомный чекпоинт (хуй знает, пусть будет эпикреализм) в качестве pretrained model - полученная лора будет совместима с другими чекпоинтами (например с киберреалистик), или таким образом она затачивается на идеальную работу с конкретным, а со всеми другими будет хуйня?

Поясните за положняк.

Если я указываю рандомный чекпоинт (хуй знает, пусть будет эпикреализм) в качестве pretrained model - полученная лора будет совместима с другими чекпоинтами (например с киберреалистик), или таким образом она затачивается на идеальную работу с конкретным, а со всеми другими будет хуйня?

Поясните за положняк.

Чёт проиграл.

SD и NAI давно не вставляет, там нет самого главного : motion. Живой кадр, выразительная динамика, развитие и раскрытие динамической композиции в таймлайне. А так от ультра-высокого разрешения нет толку.

Васянский костыль типа deforum это не motion, а наркоманский трип. Gen-2 и та новая модель тоже нет. Хотя наработки для годных моделей давно представлены. Стабилити лоханулись, надо было пилить модель для видео вместо XL. Пусть оче базовую, но с пониманием концепта motion и temporal - остальное бы допилило комьюнити.

Васянский костыль типа deforum это не motion, а наркоманский трип. Gen-2 и та новая модель тоже нет. Хотя наработки для годных моделей давно представлены. Стабилити лоханулись, надо было пилить модель для видео вместо XL. Пусть оче базовую, но с пониманием концепта motion и temporal - остальное бы допилило комьюнити.

До этого ещё минимум год-два, если не больше, можешь залегать в спячку.

Достигнутый максимум темпоральной стабильности на сегодня это vid2vid с необходимостью обучать с нуля https://isl-org.github.io/PhotorealismEnhancement/ , для диффузии нет такого пока

Эх! А ведь дифьюжн модели будто специально предназначены для того, чтоб генерировать контент, ебейшее CGi с vfx как здесь

https://youtube.com/watch?v=Qwz5H9M8rsM

Упарывался игорем когда-то давно, интро видео как раз пример простого и грамотно сделанного моушена в компьютерной графике: освещение, камера, персонаж с гестурами. Такие пока делаются лишь спецами за бешеные деньги и спецы с навыками везде нарасхват

в марвел и голливуде, в геймдеве, на Западе и в Азии.

matplotlib не отрисовывает графики в дебаге в gradio приложении, кто-нибудь сталкивался? Как чинили?

Есть мнение, что тренить лору надо на SD / NAI (в зависимости от мясности тянки), тогда она будет совместима со всеми моделями. Но ты теоретически можешь тренить и на одном чекпоинте - тогда, теоретически, она будет на этом чекпоинте лучше, чем если тренить на SD, а на всех остальных - существенно хуже.

Но лично я не проверял.

Гит - не пихон, его нормальные люди пишут. Лично Линус, ЕМНИП, руку к его созданию приложил. Там нет зоопарка несовместимых между собой версий и вот этого всего питонячьего дерьма.

Гит не засирает твою систему, он облагораживает её, сраный ты форточник. Ставь свежайшую версию глобально и забудь про неё, она подойдёт ко всем автоматикам ещё несколько лет (а то и несколько десятков лет).

о, дримбут-братишка. няяяя...

... и повышенную когерентность на дополнительных слоях, как инпаинтинг... чтобы рррраз - и смёржил...

А в нормальное место логи можешь скидывать, типа пастебина? Это ж сука кошмар эпилептика - логи в виде видоса сука!!! Зумеры хреновы!

В сторис выложить не забудь

CUDA, говорит, кривая у тебя.

Походу, твоя тулза предпочитает тренить на тех моделях, что выложены на обниморде, а не у тебя на винте. Попробуй в качестве пути указать

admruul/anything-v3.0

и посмотри, запустится ли. Если запустится - то, возможно, дело в этом.

Убери из пути русские буквы. Кириллицу. Пробелы. И т.д. Правило 8.3, все дела!

Аноны, выручайте. В программировании не шарю от слова совсем. Пару месяцев назад с кайфом генерировал всю хуйню, потом прогу снес. Ща решил снова установить, но выдает вот эту поеботу. Че делать не ебу, может из вас кто подскажет че-нить. В гугле не забанили, вообще все блять сделал из того что предлагали, все равно выдает эту срань. Уже неделю с этим ебусь, да все никак пофиксить не выходит.

Когда начинаю генерировать выдает это, забыл уточнить

Еще забыл уточнить что иногда он может сгенерировать одну пикчу, но на этом все заканчивается.

vae кривое?

--no-half в аргументы добавить?

Об этом в гайдах только ленивый не написал, пробовал конечно. Не пашет. VAE и другое ставил, и вообще выключал

Ща попробовал вписать еще раз, теперь даже начало генерировать, правда что-то в стиле этого

Давай сюда скрин настроек, особенно хэш модели. Аскотест проходил?

Не уверен про какие ты настройки, но предположил что это. Аскотест не проходил, ща гляну че это

Ох бля...

Погуглил немного, нихера не понял. Уточни что надо заскринить, вообще не шарю толком)

БЛЯТЬ ЭТО ТРЕД НЕ ДЛЯ НЕОСИЛЯТОРОВ - ЭТО ТЕХНО ТРЕД!

> ТЕХНО ТРЕД

И где твое техно, пчел?

Будем гонять сегодняшних неосиляторов - потеряем будущих техногуру! Всё лишнее - детям!

Настройки того места, где ты нажимаешь кнопку "генерировай".

нормальное современное искусство, чёнетак? фигачишь в NFT и продаёшь

Спасибо за понимание, я просто в целом очень далек от всего этого, но очень хотел бы влиться в это все и разобраться, а тут такая хуйня. Знакомых шарящих нет, так что не придумал ничего лучше чем сюда написать. Скрин настроек вот, меня все по 100 раз, везде то же самое. Если проверку отключить, в тупую выдает черные квадраты

Это конечно заебись, но хотелось бы иметь возможность создавать не только это)

На других моделях то же самое? Нафига кфг скейл 2 выставил, кстати (стандарт - 7)? И пиздец у тебя браузер засран, конечно, я вот на отдельном генерю, без лишнего мусора. В своей васянозапускалке (которую ни один здоровый человек использовать не будет) попробуй выставить в качестве параметров --xformers --medvram --no-half-vae --precision full, а не то, что там сейчас.

Другие модели вообще в первую очередь пробовал поставить. скейл менял когда просто параметры перебирал, смотрел мб че как работать будет. Просто перед скрином ниче специально не менял, кинул как на тот момент было. Поставил то что ты сказал, теперь вообще выдает это

Ну могу только предложить последовать путём анона из поста, с нвидия-проблемами я лично мало знаком, у меня свои, амдешные.

Спасибо, гляну как домой вернусь тогда. У кого еще будут идеи, предложите, попробую. Заранее благодарен

Галочки лишние для создания текстурок поснимай

Снеси этот малвер для васянов, клонируй репу гитом и запусти батник.

И шизу такую в негатив ставить не стоит, оно сделает только хуже.

откуда ты это скачиваете? как вы это блять вообще находите?

почему нельзя просто скачать сборку автоматика дефолтную

1. Удали это говно.

2. Скачай это.

https://github.com/AUTOMATIC1111/stable-diffusion-webui

3.

в webui-user.bat

set COMMANDLINE_ARGS=--autolaunch --xformers

больше никаких аргументов, если карта RTX

если GTX

set COMMANDLINE_ARGS=--autolaunch --xformers --precision full --no-half

Не слушай его Тебе надо medvram и xformers. Даже gt 1030 не требует эту херню с полной точностью - это только для амудэ

>если GTX

У него GTX 1660 6GB, видно на скринах. Это говно что, уровня амуды или даже хуже, без нохалфа не пашет?

На счет xformers заработает ли на 1060 не уверен, но если не заработает - не страшно

> если GTX

Только если 1600 серия, и то там вроде это подебили большей частью. А то сейчас на паскалях сделает так и будет жаловаться насколько они медленные.

так и так только что закончил это делать. Установил стандартную версию, в батник вписал вроде все что надо. Нихуя все равно не работает. Та же хуйня абсолютно.

Да блять, раньше без этого все работало, и xformers, и вся хуйня. Вообще мозги себе не ебал. Как выше уже писал, потом переустановил через пару месяцев, и пиздец.

Вы правильно думаете, у меня 1660 стандартная.

покажи батник и скрин sd в браузере

ты прежде чем скачать дождался, что он всё скачает?

Какой версии питон?

Слушай, лучше не открывай свой пиздак, а

16серия требует --xformers --precision full --no-half

Максимальная производительность с такими настройками

medvram только замедляет работу и иногда ведёт к ошибкам, для простых генераций в нём нет никакого смысла на 6gb, его прописывать стоит только при имг2имг и апскейле

https://stability.ai/news/stable-video-diffusion-open-ai-video-model

SAI сделали видео-модель. Выглядит сравнимо с ранвеевской, те же несколько секунд относительной темпоральной стабильности. Пока только API через вейтлист.

SAI сделали видео-модель. Выглядит сравнимо с ранвеевской, те же несколько секунд относительной темпоральной стабильности. Пока только API через вейтлист.

А, стопэ, я еблан, веса сразу выпустили. Вот они https://huggingface.co/stabilityai/stable-video-diffusion-img2vid-xt

Короче, аноны, похоже это победа. Запустил нейронку буквально сделать скрин для ответа на вот это , а в итоге она заработала блять). Последнее что сделал перед тем как уйти, вписал вот это set ATTN_PRECIGION=fp16. Короче пока вроде пашет. Спасибо всем кто пытался помочь, приятно осознавать, что в трудную минуту не кинут, а помогут)

Если что можешь смело удалять все строки с commandline args кроме последней, у тебя переменная перезаписывается и xformers нету.

c lowvram модом еле помещается в 24Гб видеопамяти.

Спасибо, ух щас погенерим.

О, это хорошо. Animate diff так не может

Это для генерации ещё влезает, или я надеюсь ты про обучение 😳

Попробуй этим скриптом конвертнуть из safetensors в папочки и расскажешь как прошло

https://github.com/huggingface/diffusers/blob/main/scripts/convert_original_stable_diffusion_to_diffusers.py

cd ./diffusers

# assume you have downloaded xxx.safetensors, it will out save_dir in diffusers format.

python ./scripts/convert_original_stable_diffusion_to_diffusers.py --checkpoint_path xxx.safetensors --dump_path save_dir --from_safetensors

# assume you have downloaded xxx.ckpt, it will out save_dir in diffusers format.

python ./scripts/convert_original_stable_diffusion_to_diffusers.py --checkpoint_path xxx.ckpt --dump_path save_dir

Обучил лору в kohya_ss, в diffusers работает хуже чем в automatic, нужно запускать в diffusers. Что делать?

>в diffusers работает хуже чем в automatic

>Что делать?

нужно запускать в diffusers

Можно в sd next как-то убрать шуе-интерфейс, и сделать чтоб он был как stable-diffusion-webui, только с возможностью diffusers?

Можно ли в риге openposeBones в Блендере как-то зафиксировать длину рук\ног?

SD 1.6 это строго проприетарная модель? То есть можно не ждать.

Нет, просто они всегда мурыжат новые версии SD за своим апи, прежде чем релизнуть веса.

> они всегда мурыжат новые версии SD за своим апи

И когда ты такое видел? Очевидно они не будут релизить 1.6.

>И когда ты такое видел?

Блять, всегда. 1.5, 2.0, 2.1, SDXL. Сначала у них в проге и/или через апи, потом релиз весов через какое-то время.

Не пизди. 1.5 вообще не их модель, они её не релизили, это файнтюн Runway. Двуха и XL 1.0 были сразу в день релиза доступны.

> Очевидно они не будут релизить 1.6.

Какой смысл гейткипить? В ней ничего радикально нового и уникального чего нет в файнтюнах 1.5, отсутствуют и какие-то крутые коммерческие перспективы. А вот актуализировать самую массовую и популярную базовую модель - тема хорошая.

>Двуха и XL 1.0 были сразу в день релиза доступны.

То день релиза. Они долго держали веса за своей дримстудией, потом в один момент просто обозвали очередной чекпоинт релизом и выпустили.

1.5 и 1.4 - это их. 1.3, 1.2, 1.1 - вот это не их, это от CompVis

> 1.5 и 1.4 - это их.

Чел, до 1.4 - это CompVis, 1.5 - это файнтюн 1.2 силами Runway. Стабилити к первой SD имеют отношение только в виде предоставления серверов для CompVis. Они ничего сами не тренировали до 2.0.

https://huggingface.co/runwayml/stable-diffusion-v1-5

А, была еще и третья контора RunWay. Как все запутано

Блджажд, что они с таггером сотворили? Как им вообще теперь пользоваться? Почему он на базовой Deepdanbooru модели срет про какой-то tensorflow_io?

К ключу --save_state можно указать директорию сохранения? Куда сохраняется по умолчанию, с пустым ключом без указания директории?

Это про обучение лоры, если что.

Олсо поясните почему при запуске с батника с вебгуи скорость обработки 40-50s/it, а при запуске из сосноли (с набором команд, сгенереных в вебморде) скорость 30-33it/s.

Что так тормозит при запуске вебгуи?

Олсо поясните почему при запуске с батника с вебгуи скорость обработки 40-50s/it, а при запуске из сосноли (с набором команд, сгенереных в вебморде) скорость 30-33it/s.

Что так тормозит при запуске вебгуи?

https://github.com/chengzeyi/stable-fast

Ускорятор для diffusers. Жрёт меньше памяти, работает быстрее TensorRT или AIT, при этом не требует компиляции.

Ускорятор для diffusers. Жрёт меньше памяти, работает быстрее TensorRT или AIT, при этом не требует компиляции.

> работает быстрее TensorRT

Открываю ссылку и сразу вижу что ты пиздишь. В их же бенчмарках он медленнее.

> не требует компиляции

А тебе от этого легче? Совместимости всё так же ни с чем нет. Ещё и пердоликс-онли.

> Куда сохраняется по умолчанию

В папку которая указана для выхлопа моделей, создает дирректорию соответствующую эпохе.

> Что так тормозит при запуске вебгуи?

Венвы то одинаковые? Так разницы быть не должно, с другой стороны

> 40-50s/it

Это что за дичь? Если обучаешь на 1030 то аппаратное ускорение браузера может вредить.

>В папку которая указана для выхлопа моделей

Готовых? Ок, спасибо.

>Венвы то одинаковые? Так разницы быть не должно, с другой стороны

Одинаковые, стартую оттуда, откуда же стартует вебгуи.

>Это что за дичь? Если обучаешь на 1030

На 1063. Кстати из сосноли скорость увеличилась до 29s/it за прошедшее с моего поста время.

>аппаратное ускорение браузера может вредить.

Интересно каким он тут боком. Я стартанул обучение из консоли, но при этом браузер остался открытым для параллельного двачевания.

Олсо, может подскажете мне параметры для тренировки на строго определенный ебальник? В прошлую интерацию обучения на свою еотову с 60 повторениями каждого фото генерация выдавала примерно одну очень похожую из 20 не очень похожих. Офк мне нужно полное сходство.

> В папку которая указана для выхлопа моделей

А вот хуй. Output folder указан, параметр --save_last_n_steps="1000" есть, на данный момент прогресс в полторы тысячи шагов но Output folder пуст.

Не хочу просрать четверо суток из-за броска по питанию, бсода или иного факапа.

> Одинаковые, стартую оттуда, откуда же стартует вебгуи.

Тогда разницы быть не должно, может как-то влияет особенности выгрузки врам в рам, или интерфейс жрадио на себя что-то там выделяет. Только мониторингом можно проверить.

> Интересно каким он тут боком.

Да хз, больше там нет отличий, одно и то же запускается.

> на данный момент прогресс в полторы тысячи шагов

Оно будет сохранять только каждую эпоху и даже об это напишет, шаги тут не при чем. Сколько эпох в обучении?

> четверо суток

Ты делаешь что-то неправильно, тут братишка на 1050ти тренили и там всего часов 12 выходило емнип. Лучше распердоль коллаб или купи видеокарту, 4 суток на то что должно делаться максимум минут 15 это жесть.

>может как-то влияет особенности выгрузки врам в рам

>там нет отличий, одно и то же запускается.

Вот и я про то же.

>Оно будет сохранять только каждую эпоху и даже об это напишет, шаги тут не при чем. Сколько эпох в обучении?

Эпоха одна и закончится она через 84 часа. А я хочу пощупать результат, поэтому поставил сохранение каждую 1000 шагов (аналог параметра сохранения каждые n эпох).

>Ты делаешь что-то неправильно

Я не нашел прямого мана, поэтому мне и нужна рекомендация по параметрам, или прямой конфиг. Опытным путем увидел что 60 шагов дали результат лучший чем 30, поэтому зарядил на сотню. Датасет 120 фото, 100 шагов на каждое, скорость 30s/it - вот и вырисовывается несколько суток. Впрочем, параллельно на другой пекарне учится лора с датасетом в 30 фото, и там как раз 1050 (без ти), доучится примерно к вечеру понедельника. Вощем-то у меня параметры почти все в дефолте стоят, может в этом дело, но куда крутить я не знаю.

А, ну и коллаб я конечно же не буду распердоливать, я сам себе администратор локалхоста. С видимокартой тоже пока непонятно, это сейчас я загорелся, если через полгода не пройдет - обновлюсь, иначе без задач.

> Эпоха одна

Ууу, ну земля пухом, насмотрятся своего хача а потом ебут друг друга в локалхост, лол.

> увидел что 60 шагов

О каких шагах ты говоришь, число повторений датасета?

Оптимальные параметры довольно просты и сложны, есть несколько вариантов про которые можешь в статьях из шапки почитать, вот один из них: адам8, lr unet = 2e-3, lr text = 1e-3, alpha=1, dim 32-128, число повторений подбирай так чтобы получилось 400-500 на эпоху (для 100 это будет 4-5), 10 эпох.

~15 минут разобраться, ~15 на тренировку каждой дальнейшей вместо нескольких дней на то что у владельцев 4090 уходит пара минут.

>Ууу, ну земля пухом, насмотрятся своего хача

Все так.

>О каких шагах ты говоришь, число повторений датасета?

Число повторений каждого фото. То, что задается именем директории n_datasetname.

>Оптимальные параметры довольно просты

Благодарю. Попробую при следующем обучении.

>~15 на тренировку каждой дальнейшей вместо нескольких дней

Фарш невозможно провернуть назад. Выходные у меня один хуй заняты, а в трудо-выебудни я работаю, так что скорость ебет только мою хотелку по факту. Владельцам 4090 я канеш завидую, но сам к ним смогу примкнуть лет через 5 лол, когда цена упадет до той, которую я могу безболезненно оторвать от своих финансов. Эти условные 100к я с большей охотой вложу в ремонт или влошу в фондовый срынок чем в дофаминовую морковку передергивания писюна на еотову с максимально возможной скоростью. Хотя от этого мне канеш грустно, я бы лучше морковку навернул а не вот это вот все.

>400-500 на эпоху

>10 эпох.

Что ты собрался 4000-5000 шагов тренить?

Хотя если с 2е-3... Нухз, возможно.

Я на базовое 1е-4 и 2е-5 всегда ориентируюсь, 2000-2200 шагов суммарно. И то обычно в конце уже перетрен получается, насыщение где-то на 1300-1700 начинается.

> Что ты собрался 4000-5000 шагов тренить?

Расчет был на то что он по эпохам пройдется и выберет лучшую, плюс его дженерик тнус точно запомнит. Перетрен с таким лром можно получить только на упоротом датасете, свитспот 2.5-3.5к, дальше просто бесполезно.

Хотя что там с еотовыми хз, ведь подборка их клозап фейсов вместо разнообразных пикч это тот еще пиздец вместо датасета и оно может очень рано начать ломаться.

Ээ.. Насчет количества шагов. А как быть если тренишь стиль или концепт, а там овер 300 минимум надо артов, а лучше больше. Там если по дефолту делать по 10 (как в гайдах по созданию датасетов пишут) раз на каждый арт, то выйдет овер 3000 шагов только на одну эпоху. Или вы тут про тренировку на персонажа обсуждаете где куда меньше артов надо в общем? Хотя я тренил с дофига каким количеством артов и по 3-5 эпох. Перетрен? Да, явно перетрен. Но можно просто применять Лору с весом поменьше и вполне работает нормально.

> овер 300 минимум надо артов

> по 10 (как в гайдах по созданию датасетов пишут) раз на каждый арт

Если там написано именно так и не указаны какие-то нюансы, то следует ставить под сомнение такие советы. Есть случаи где лору на стиль или даже персонажа тренят оче долго с десятками/сотнями тысяч шагов и большим числом эпох, но там в основном дадапт, хитрые шедулеры, и нет свидетельств того что это оптимально и результат качественно будет отличаться от тренировки короче.

На персонажа достаточно меньше, но и стили разные бывают, иногда с 4-х десятков такое тренируется что потом удивляешься.

> Перетрен?

По результатам смотреть надо, оно может и не оверфитнуться заметно, просто время попусту потратишь. Если же нужно снижать вес чтобы не ломало - пиздарики.

>овер 300 минимум

Это прям лютый оверкилл.

Сотни обычно вполне хватает. Может и с 40 натрениться.

Блять, арендуй 4090 на vast.ai и дрочи свой писюн со скоростью света.

Настрой колаб. Или обучи на цивите. 4 дня ходишь, лайкаешь, получаешь максимум 125 buzz в день. 500 buzz (ЕМНИП, а сейчас может и 600 уже) стОит натренить лору. Генерить вроде можно там же или на гравита и темпочтой от дядюшки Мохмала.

О, сочувствую, чувак. Там семплеры соответствуют нетривиально, в курсе? В issues diffusers на github поищи табличку. Алсо, ты точно используешь lpw pipeline? Иначе не будут работать (скобочки) [как] (в автоматике:1.07)

Либо dreambooth теми же kohya-ss/sd_scripts, в diffusers работает, брат жив, еот хороша, всем рекомендую.

Чувак, у тебя ошибка в слове preciSion

но раз работает - не трогай!

Бесплатный колаб медленный пиздос, да и платный тоже. В то время как на васте (или подобном хостинге) можно занидорага арендовать БОЛЬШОЙ УТЮГ. Например лоры для SDXL тренятся куда лучше на 48 гигах.

Я сейчас балуюсь реалтайм генерацией по нарисованной подложке в плагине для криты, в паре с копеечным планшетом это такая охуенная вещь, я прям себя рисователем с большой дороги почуствовал. Но для реалтайма надо чтобы генерация 1344х768 в SDXL была не больше секунд четырех, поэтому на медленней чем 4090 я и не смотрю. Дома у меня 3060, на ней такое не прокатит.

Тренирую лору на своём лице. Скажите, стоит ли для улыбающегося и серьёзного лица тренировать разные лоры? Стоит ли в одной лоре совмещать улыбку и серьёзное лицо?

в одну лору, но обязательно протэгать выражение лица: smile, happy, calm, serious, concentrated, worried, relaxed, etc.

Если часть фоток с очками, а часть без - очки тэгать обязательно!

я не оч по инглишу, погугли

Спасибо. А почему хачатур говорил, что теги это хуйня без задач, и не работают?

Что скажете насчёт однокартиночных лор? (не IP-Adapter)

https://civitai.com/articles/3021/one-image-is-all-you-need

https://civitai.com/articles/3021/one-image-is-all-you-need

Аноны в файле моделей, чекпоинте информация о весах хранится тоже в матрицах, или в каком-то более человекопонятном виде?

Потому что долбоёб

Херня без задач.

Надеюсь когда выложат sd 1.6 в открытый доступ, достаточно будет сделать мерж разницы с 1.5 в любой файнтюн, и тем самым генерировать в высоких разрешений без хайрез фиксов

Иначе зачем они называют ее 1.6, если у нее будет не формат 1.x моделей

Ну ты и соня. Уже давно 2.0 вложили.

Я тоже надеюсь. Более того, я тут уже полтреда как надеюсь, что хайрезность обеспечивается дополнительными слоями - как инпантинг, и мёрж там тривиален.

Но если нет, или если не выложат... Ох, анончики, объясните мне (тупому), почему никто до сих пор не натренил просто дополнительные слои на паре тысяч изображений (пусть бы только тянок, ладно) на обеспечение хайреза? Это же ведь определение гипернетворка как он есть, разве нет?..

Чем finetune отличается от dreambooth ? Я нихуя не понимаю

Dreambooth один из видов finetube

*finetune

Ребятки, я походу не дотренировал лору, можно ли продолжить с того места где я остановился? Можно ли продолжить тренировать готовую лору?

Я про это спрашиваю, в kohya_ss

Я там недавно обосрался со своей первой моделью которую более 12 часов тренировал.

Можно.

Как?) Я делаю это в программе от хрисТа

Тогда у него и спрашивай. Мы-то откуда знаем как что делать в мокропиське хача.

Ладно, скажи как в стандартной проге делать

Да-да, анонимус разрешаэ!

> что хайрезность обеспечивается дополнительными слоями

Судя по практике - такое маловероятно, для повышения резрешения достаточно дополнительной тренировки имеющейся структуры. Возможность мерджить разницу это не отменяет, но каков будет результат сказать сложно.

> до сих пор не натренил просто дополнительные слои на паре тысяч изображений

Объясни что имел ввиду, какие еще слои?

Превое - более старый традиционный способ, будка функциональнее.

Странная херня, через час использования Автоматика, скорость генерации начинает падать. Приходится перезагружать комп.

Почему результат такой уёбищный? Как нормально обучить? Хули у всех всё получается, а у меня нихуя?

Какие параметры нужно выставить чтоб обучилось нормально?

>Какие параметры нужно выставить чтоб обучилось нормально?

Оптимальные

Но автор как раз приводит задачи и демонстрирует применение.

Ты там памятники несуществующим людям собрался генерить? Шапку прочти. Чет проиграл с первой.

Так в том то и дело, что практически всё то, что он приводит, либо делается самим автоматиком "из коробки", без лоры, либо контролнетом.

Не надо писать тэги к картинке, не надо тратить время на тренировку, просто берешь и делаешь.

Хотел через img2img надрочить на обработку фото в таком стиле с прорисованными волосками, но эта хуйня какая то необучаемая. На ютубе вообще мало уроков, все делают только лоры, а нормальные модели кто делать будет!

Ресайз картинок под разрешение тренировки с сохранением соотношения сторон. Тут задаешь, какое разрешение будет минимальным/максимальным.

Кропать оно не будет, именно отресайзит.

Ну, насколько я помню эту фигню, конечно.

это сегменты какие то злоебучие, а не ресайз. разрешение тренировки у меня 768 на 1024

Вот под это разрешение оно тебе и будет ресайз делать.

Грубо говоря, если в базовых настройках 512х512 у тебя 0.26 мегапикселов, и в сете есть огромная картинка с соотношением 4:1, то отресайзит в 1024х256 под те же самые 0.26 мегапикселов.

Опять же, это то, как я эту фигню сам понимаю, исходя из данных, которые скрипт в лог по подготовленным изображениям выводит.

Вот это вот.

Тут у меня 6 повторений, всего 40 картинок. Разрешение тренировки было 768х768, с максимумом бакета на 1024.

Чёт сомнительно что такую простоту в переносе стиля и редактировании можно получить зеро-шот методами. У меня не получалось.

IPAdapter работает со входными 224х224, другие зерошот методы (референс-онли, t2i style adapter и т.п.) тоже в сравнимом, потому что все они юзают CLIP-ViT для кодировки, а он принимает ограниченное разрешение. И самое большое их ограничение - они переносят всё, нельзя нормально фильтровать, приходится изгаляться. Например если оставить перса на белом фоне сегментацией, они захавают и фон в том числе, а у него просто убираешь тег и убирается фон. А уж как это использовать для бутстрапа датасета для полноценной лоры, как он это предлагает - вообще хз.

А у него на демках чистенькая фильтрация признаков с пикчи с использованием знаний самой модели (а не CLIP-ViT), прям куда круче чем у меня когда-либо получалось. Зерошот может быть лучше конечно со временем, но конкретно текущие методы очень ограничены. Если эта хуйня действительно работает как у него написано, занимает пару минут и не требует танцев с бубном - хули бы и нет? Надо разобраться, попробовать, потестить. Никогда не подумал бы что лору можно делать из лишь одной пикчи.

> Кропать оно не будет, именно отресайзит.

Вроде как будет чтобы подогнать по кратность (по дефолту 64 вроде). Там в конце пишется ошибка, обычно оно пренебрежимо мало.

Зря максимум так близко к разрешению тренировки выставил, вон6 пикч не влезли.

Так некоторые лоры твикеры делали, но там намеренный оверфит а потом отсечка некоторых слоев.

> в мокропиське хача

Если вы вдруг не видели или не знаете, мокрописька от христа тянет билд от автоматика.

Но мокрописька от автоматика смущает вас намного реже, насколько я заметил.

Поэтому не выебывайтесь и давайте советы годные.

> мокрописька от автоматика

Довольно крупный и сложный проект, которые разрабатывается и поддерживается длительное время множеством людей. И то к ней вагон замечаний и претензий, а высказывания о забагованности уже стали мемом.

> мокрописька от христа

Подзалупная херь от глупого унтерменьша, напизженная у остальных и все равно выполненная криво. При этом создана для выполнения оче простых функций, а ца - падкие на синдром утенка кабанчики.

И на кой хер для тренировки тащить автоматика, чтобы заиметь потом конфликт зависимостей с кохой?

> давайте советы годные

Поставь любой нормальный гуи для кохи и делай все там, или вообще через консоль скриптом.

>Зря максимум так близко к разрешению тренировки выставил, вон6 пикч не влезли.

Всё влезло же.

Сложи все строки и раздели на 6 (число повторов).

240\6 = 40

Ну попробуй.

Мне что-то сомнительной кажется такая штука.

Особенно если ты собрался ее тренировать на концепт, который в модели отсутствует как таковой.

> И на кой хер для тренировки тащить автоматика, чтобы заиметь потом конфликт зависимостей с кохой?

Аллоу, маня, что коха, что сд от дружка хача ставятся сорт оф портейбл на самом деле не совсем и не срут в систему. Конфликта нет, они даже параллельно работать могут.

>Подзалупная херь от глупого унтерменьша

На самом деле ты сейчас обосрал крупный и сложный проект, который разрабатывается и поддерживается длительное время множеством людей. Потому что все, что делает мокрописька от хача - это распаковывает гит с пердоном и увязывает с ними билд от автоматика через 1,5 бат-файла, которые задают необходимые параметры сессии и дергают потроха билда автоматика.

>Поставь любой нормальный гуи для кохи

А он внезапно нормальный, кто бы мог подумать что мокрописька от хача тоже тянет "официальный" коховский билд, пикрил.

Вощем-то из этого следует что синдром утенка - у тебя, лол.

> Всё влезло же.

Часть пикч была в меньшем разрешении, другое дело что не критично.

> маня

Ай лол, любитель понюхать хачевскую сперму огрызается.

> обосрал крупный и сложный проект, который

Нет, речь про хачевские надстройки что "устанавливают и конфигурируют", это ты не разделяешь их с оригинальными.

> мокрописька от хача тоже тянет "официальный" коховский билд

А что еще она может тянуть, будто он что-то свое может создать.

> синдром утенка - у тебя

Назвать вещи своими именами? Нет, синдром утенка это защищать и оправдывать говноподелки с которых начал и уверовал.

>речь про хачевские надстройки что "устанавливают и конфигурируют"

Где? Там ничего кроме гита с питоном нет.

>будто он что-то свое может создать.

Оче хорошо. Мы разобрались что мокрописька от хача - это суть довольно крупный и сложный проект, которые разрабатывается и поддерживается длительное время множеством людей.

>говноподелки

А нет, похоже что не разобрались, опять вернулись на шаг назад. Ты где-то делишь на ноль, тебе так не кажется?

Аноны, а подскажите каую-нибудь удобную штуку для тэгирования изображений. Чтоб наглядная была.

Типа, в левой части у тебя картинка - справа плашки с тэгами. Кликаешь на плашку - тэг включается/отключается.

Ну и предварительный прогон чтоб был, как в ВД-тэггере, с разными моделями и уровнем чувствительности. Плюс с возможностью добавлять свои тэги принудительно.

WD-тэггер хорош только для полной автоматизации, вручную им работать практически невозможно.

Типа, в левой части у тебя картинка - справа плашки с тэгами. Кликаешь на плашку - тэг включается/отключается.

Ну и предварительный прогон чтоб был, как в ВД-тэггере, с разными моделями и уровнем чувствительности. Плюс с возможностью добавлять свои тэги принудительно.

WD-тэггер хорош только для полной автоматизации, вручную им работать практически невозможно.

Ох. Я в этом не очень хорошо шарю, но попробую объяснить. Знаешь, как модели по слоям мёржат? У UNet есть некие слои, в которых хранятся, собственно, веса. На разных слоях хранятся веса, отвечающие за разное. Где-то я даже картинку видел, на каком что. Соответственно, если мёржить разные слои с разным коэффициентом, то будет получаться разный результат, причём направление этого результата вроде как даже можно предсказать (уххх, алхимия! старина Фламель в гробу вертится!).

Знаешь, как из любой модели сделать инпаинтинговую? Нет, можно, конечно, и натренить - у Шивама, кажется, скрипты такие были. Но вообще-то общепринятый способ - тот самый послойный мёрж. У официальной инпаинтинговой модели есть четыре дополнительных слоя в UNet, и при мёрже A + (B - C), где А - инпаинтинговая модель, В - кастомка, С - SD1.5, эти самые инпаинтинговые слои остаются нетронутыми.

https://www.reddit.com/r/StableDiffusion/comments/zyi24j/how_to_turn_any_model_into_an_inpainting_model/

Можно ли провернуть такой же фокус, добавив слои и натренировав их обычным образом, но при залоченной модели - скажем, на разрешение 1024х1024? Если это удастся, то потом это разрешение можно будет переносить на любую полторашную модель (кроме, быть может, инпаинтинговых) без потери информации в модели, без искажения.

И я полагаю, что именно это делают гипернетворки, разве нет?..

Продолжаю мысль.

Ты спросишь: зачем мне поддержка 1024х1024 нативно, если есть хайрез фикс? А я отвечу: обучение, чуваки мои, обучение. Мы можем сколько угодно кормить адетайлер фоточками няшных рук. Но только сетка в целом сможет понять, где рука правая, а где левая, насколько разными должны быть ноги и как держать солнышко на ладошке.

Можем, я неправ и долбодятел. Это со всеми бывает. Но почему никто даже не попробовал?

> как из любой модели сделать инпаинтинговую

В ней есть допольнительные слои и добавлены лишние операции связанные с такой обработкой, это считай просто локальное возмущение имеющейся модели без существенных изменений того что она может генерировать. При том насколько улучшается перфоманс в том самом инпеинте, учитывая сочетания значительно ушедших от исходника современных моделей и древних значений в "дополнительных слоях инпеинта", и в целом целесообразность это процедуры - под вопросом.

Аналогия понятна и ожидаема, но здесь нюанс. Для получения хорошей работы в высоких разрешениях такого недостаточно, все ее части должны быть организованы таким образом, чтобы сохранять когерентность при большем количестве обрабатываемых данных. Невозможно сделать пару волшебных слоев, которые из поломанной херни вдруг сделают хорошую картинку.

Плюс в том что на возможность мерджей это, скорее всего, не повлияет и к сд 1.6 можно будет в пару кликов добавить то что было дообучено на 1.5. Но, может случиться всякое, пока не увидим ее можно только гадать.

> Ты спросишь: зачем мне поддержка 1024х1024 нативно

Странный вопрос, чем выше порог когерентности модели, офк если говорить про реальные величины а не те где нужно долго ловить удачный рандом, тем точнее она помнит и понимает мелкие детали, включая и пальцы (но панацеи тут всеравно не будет), тем более качественно можно делать апскейл. Все правильно.

> Но почему никто даже не попробовал?

Сейчас сложно найти новые файнтюны 1.5 что проводят в разрешении 512.

Нейрочелики, как дообучить модель в finetune kohya_ss ?

У меня вопрос, как сочетается опен сорс лицензия, по которой работают sai (как понимаю, она вирусная, и при всем желании они отказаться от нее не смогут), и то, что они прячут за api 1.6, и раньше прятали xl?

Это лицензии с пользователями, т.е. это только для тебя вирусная GPL или что там у них, не ебу, а SAI правообладатель и могут делать что хотят. Часто в софте делают коммерческую лицензию и вирусную для опенсорса, никто не запрещает проприетарщине иметь не совместимые между собой лицензии.

Ох, чувак, учи матчасть. И про вирусность лицензии, и про разницу копилефта и пермиссива, и вот это всё. В двух словах не объяснить. Грубо говоря, у SD - пермиссивка, не вирусная: мол, вот вам веса, творите что хотите. Или нет, анончики?..

Лицензия не опенсорс, а OpenRAIL++. Попенсорс был бы, если был бы весь процесс можно было бы реплицировать с нуля, включая точный датасет и все настройки тренировки. Ну и датасет тоже должен позволять такое использование.

А в чём проблема что прячут за api? Ну никак не совместимо. Как выпустят веса, так будет OpenRAIL++.

Так же как и лору или будку, в чём конкретно вопрос?

https://huggingface.co/stabilityai/sdxl-turbo

Вжух! SDXL-турбо, под реалтайм использование. Быстрее LCM (1-2 шага), и по словам SAI качество лучшеее.

Вжух! SDXL-турбо, под реалтайм использование. Быстрее LCM (1-2 шага), и по словам SAI качество лучшеее.

Кал какой-то. Похоже тренировалось на 512, на 1024 мутанты как на ванильной полторашке, качество говно. Мержил разницу к кастомкам - пиздец хуже LCM. Негативы не работают так же как и с LCM.

У них обратные результаты, а на 4 шагах получается что-то уровня SDXL. Собственно цель и была избавиться от LCM-мыла. Пока читаю пейпер, не вижу ничего препятствующего негативам как в LCM

На практике я не вижу этого результата. И апскейлится оно очень хуёво. XL и так такое себе по качеству картинки, а это совсем пизда.

> избавиться от LCM-мыла

Легко избавляется дополнительными 4-6 шагами хайрезфикса с Euler a.

> не вижу ничего препятствующего негативам как в LCM

Они выключены вообще в демо SAI, в принципе их нет. Если на практике включить CFG 1.5 - сразу пидорасит.

Есть демо на клипдропе

https://clipdrop.co/stable-diffusion-turbo

Выглядит очень плохо, хуже ванильной полторашки. Всё в артефактах, разрешение как у полторахи, вместо людей месиво.

ну че все идёт к тому что нейросетки будут риалтайм?

Всё идёт к тому что в следующем году полторашку изобретут второй раз. Будет реальным прорывом, глядя на то как отрицательно прогрессирует качество в последние пол года. Какая-то рекурсия, год прошёл, а стало только шакальнее, зато в 10 раз быстрее.

Какое быстрее, у меня до сих пор на CPU не идет. Не покупать же видяху.

>Сейчас сложно найти новые файнтюны 1.5 что проводят в разрешении 512.

Ага, вот только все примеры к топовым моделям сделаны на каких-нибудь 512х640 или 512х768 и потом прохайрежены. Но ладно, я могу быть долбодятлом и долбиться в глазоньки... можешь, плиз, показать хорошие, годные современные фотореалистичные модели, по качеству не уступающие фотогазму (возьмём его за точку отсчёта), которые легко сгенерят мне тянку без искажения пропорций... ну, хотя бы 649х960? 16 тянок из 16, например. С тебя сид-промпт - прочие сорцы, с меня - попытаться построить контрпример.

И как тогда, кстати, делают современные инпаинтинговые модели, которыми раздевают тянок? Тренят скриптом? Каким?..

Сколько гигов оперативки?

8, но это shared RAM

Я в крите балуюсь "реалтаймом" в 4 секунды на фрейм безо всяких ЛЦМ, и это просто охуенно, совершенно иной способ, мамины "промпт инженеры" сосут бибу. Игнорируй довена выше, он ноет абсолютно всегда.

Кстати, есть идея прикрутить подобный процесс в редактор на андроиде, с использованием облака. Рисовать пальцем. Технически будет несложно, просто нет такого же редактора на андроид чтоб сделать плагин.

Я скушал аренда-пилюлю и уже передумал покупать 4090. Покупать имеет смысл если тебе есть чем её загрузить 24/7. На деньги что нужны для 4090 и компа под неё, я могу лет 6-7 подряд генерить в темпе 2 часа в день, а там уже несколько поколений пройдёт, и заточки под новый куда компьют, и вообще всё совершенно изменится.

И при этом мне не нужна 4090 большую часть времени, обычно хватает V100 16ГБ или 3090 24ГБ, а для тренировки всё равно выгодней арендовать большой утюг вроде A100 80ГБ, т.к. можно увеличить размер батча и выйдет быстрее+дешевле чем на 4090, либо тренировать SDXL на полной точности. Так что выходит намного дешевле.

На реддите пояснили, чем civitai отбивает затраты на свой генератор. Ответ: ничем.

>Burning venture capital until they get bought by someone larger or crash, like a lot of companies

Потом продадут бизнес, а новые владельцы введут цензуру, позапрещают всё NSFW и модели с лолями типа CuteYukiMix.

Кстати, уже был похожий, охуенный сайт - который закрылся, когда сжег бабло с инвестиций. Подозреваю, что и с проектом SD, и со стабилити та же история. Эх...

>Burning venture capital until they get bought by someone larger or crash, like a lot of companies

Потом продадут бизнес, а новые владельцы введут цензуру, позапрещают всё NSFW и модели с лолями типа CuteYukiMix.

Кстати, уже был похожий, охуенный сайт - который закрылся, когда сжег бабло с инвестиций. Подозреваю, что и с проектом SD, и со стабилити та же история. Эх...

Пальцем неудобно, куда лучше небольшой планшет купить графический, с пером. Рисовать толком уметь не надо, надо просто мочь представлять картинку в голове. Хотя можно и айпад/самсунг с пером, тоже прокатит.

>Невозможно сделать пару волшебных слоев, которые из поломанной <...> сделают хорошую картинку.

Давай зададимся (пока теоретически) более простой целью. Допустим, что нам нужно уметь делать хайрезный дженерик. Одна тян, стоит/сидит, смотрит в камеру / вбок / вдаль / на тебя как на говно. Много ли тут информации надо впитать, а? Голова сверху, ноги снизу, пупок один (ну или там по количеству тянок), грудей один ряд. Горизонт слева и справа на одном уровне. Небо вверху одним куском. Ну и так далее. Возможно ли это теоретически - или я принципиально не понимаю, как работают гипернетворки?

какой денойз в им2им ставишь?

>Подозреваю, что и с проектом SD, и со стабилити та же история.

Ага, только есть нюанс. Джинна в бутылку не загнать, веса полторашки и сдохли уже в паблике, контролнет придумала не стабилити, а коммьюнити (поправьте, если неправ). Мир уже никогда не будет прежним. А бабло инвесторов... ну, это бабло инвесторов. Они знают, что идут на риск.

Братюнь, купить можно и видеокарту для ПК, а нужны именно решения для девайсов которые есть под рукой.

Рисовать умею, стилус для Wacom планшета где-то проебался лет пять назад, - да и мобильные устройства мне так-то больше нравятся.

Можно кулстори с подробностями? Оно, конечно, лучшие вещи в мире бесплатны, но о нелучших тоже неплохо бы знать. Какой страны карточка, которой платишь? Какой сервис используешь? Почём час аренды утюга?

Блять, отрыл Армению, зарывай обратно. Чугуниевая долина в таком режиме вообще десятилетиями живёт. Реальность же в том что цена тренировки резко упала и доступна / скоро будет доступна хуям простым.

> годные современные фотореалистичные модели

Предпочитаю 2д, сорян. Стоит отметить что большинство современных миксов без проблем переваривают 768х768, 800х600 и подобные разрешения и хорошо себя показывают на апскейлах.

Раньше думал что в фотораелизме там дохуя какой прогресс, но поизучав посты авторов "топовых моделей", их рекомендации, гайды и прочее сильно засомневался. Но это лишь оценочное суждение по узкой выборке, офк найдутся и хорошие мастера - моделеделы.

Натренить базовую модель в ~768, не поломав а наоборот улучшив, сделав лучшую работу с мелкими деталями и когерентность, добавив то что хочешь - не то чтобы сложно, а потом результат мерджишь по усмотрению, получая все фишки. "Повышение эффективного разрешения" возможно даже лорой сделать, будет побочный эффект если тренить в изначально большем разрешении. Офк речь о нормальной а не пиздеце с клозап лицами. Другой пример - собаки, которые заявляют 1024 базовым разрешением и относительно когерентных тней генерируют в нем.

> кстати, делают современные инпаинтинговые модели

Просто современные модели - дримбус. Инпаинтовые - мерджем разницы с древностью времен 1.4. Возможно есть более новые зафантюненные модели с теми слоями, не в курсе. Чтобы раздевать тяночку достаточно самой обычной модели без всяких доп слоев.

Хз как они работают, писали что шли поверх основной модели. Если у тебя в глубине поломалось, то обратно не соберешь, для работы в повышенном разрешении вся модель должна хорошо работать, а не иметь при себе волшебную добавку. Как раз ту самую информацию что ты описал оно должно чувствовать на большей области.

Я не он, но использую полнофункциональное API бесплатно. Не хватает лишь мелочей типа обработки видео.

Алсо, а где можно взять соответствующие датасет хотя бы на пару тысяч картинок? Можно, конечно, взять фотки одноклассниц из вконтактика заботливо мною сохранённые на винте ещё в бытность школьником, а вы что подумали? и протегать их, но такой датасет ведь будет нелегален, верно? Нельзя ведь просто так взять картинку из интернета и распространять её. Нехорошо-с, неопенсорсненько.

Набирать же генерации с цивиты... Ох, ну с анимцом ещё туда-сюда этот способ, но реалистик... Ой...

Раз бесплатно, то тем более пили кулстори. Анонимус ждёт!

>Предпочитаю 2д

Сейм.

Но для меня есть два направления, одно из них это манга-стиль. Причем ортодоксальный, без 2.5д, без "обведенного" 3д носа у персонажей.

Второе - это японские айдору и AV контент, с фотореалистичными SD моделями. Здесь задача подражать скриншотам из японских фильмов, поэтому реализм должен наоборот быть максимальным, без CG эффектов. Почему-то не перевариваю блядей как в met-art, MILF и подобные фетиши. Но японские JAV актрисы это другое, они милые. Причем, могу сразу на глаз различать японок, кореянок и китаянок - у них разное строение лиц, например кореянки немного похожи на белых. Мои любимые актрисы ирл Yua Mikamo и Yui Hatano. Ayumi Shinoda всратка, но шишка колом. Юлька вообще грудастая богиня, сразу видно еврейскую кровь.

>Mikamo

Mikami

vast.ai, другой страны + впн для оплаты, час утюга от полубакса до полутора в зависимости от утюгастости и времени суток, час обычной видюхи в 2-3 раза дешевле. Сетевой трафик не бесплатный, это тоже надо учитывать и экономить размеры. Есть ещё runpod, есть serverless апи для генерации типа comfyuiworkflows с готовым подключением комфи или modal с быстрым холодным стартом, которые берут только за загрузку, они вроде дешевле, но если нагружать дохуя то дороже.

nogpu-webui.com

Если не сможешь разобраться - значит, тебе не нужно

>Предпочитаю 2д, сорян. Стоит отметить что большинство современных миксов без проблем переваривают 768х768, 800х600 и подобные разрешения и хорошо себя показывают на апскейлах.

О, чувак, вот тебе Lametta с 1024х1024 от фуррей. Не ах какой идеал, но пикрил сделаны на ней без хайрезфикса.

https://huggingface.co/NickKolok/lametta-v2012-beastboost-2ch-fp16

Но у неё есть некие проблемы с обучаемостью с будке. Впрочем, не исключено, что это у меня проблемы с кривизной рук.

> "Повышение эффективного разрешения" возможно даже лорой сделать, будет побочный эффект если тренить в изначально большем разрешении.

Всё уже украдено придумано до нас. https://civitai.com/models/110071/hd-helper

Толком не тестил, хотя вау-эффекта не даёт.

>Всё уже украдено придумано до нас.

На аниме-моделях нифига не работает, кстати.

>nogpu-webui.com

Так со сбросом кук (в моём случае - chromium-browser --temp-profile) и на гравити можно. Какие плюсы/минусы?.. Какие подводные?

На анимэ-моделях есть BeastBoost. Про проверку которого на реалистике мне ничего не известно. Мой ноут почти успел достигнуть японского возраста согласия, но последний внезапно подняли

Некоторые выложены в публичном доступе на той же обниморде, на кагле есть коллекции и т.д., но офк на них уже тренили и качество там самое разное. Собирай самостоятельно на различных агрегаторах и потом тегай хотябы тем же клипом.

> но такой датасет ведь будет нелегален, верно?

Это серая зона в принципе, сложно доказать и на обычного пользователя всем похуй. Если так это волнует - делай свои фотографии в публичных местах, обрабатывай и используй. Можно этот процесс даже автоматизировать чтобы время не тратить, закону не противоречит. Или используй ресурсы со свободной линцензией контента, много начинающих фотографов выкладывают с такими.

> Набирать же генерации с цивиты

Только если самые отборные и удачные, иначе преумножит количество артефактов.

Эх, назвал два самых "сложных" направления из 2д. По первому проблематично собрать датасет ибо сложно сортировать чтобы остальное не подмешивалось. Но и избегать этого нельзя ибо не наберешь должного баланса и разнообразия датасета, как вариант вообще просто лорой воспользоваться поверх "униваерсальной модели". Второе уже сильно в фотореализм, но с элементами. Только пиздеть рассуждать могу, подсказать нечего, увы.

> пикрил сделаны на ней без хайрезфикса

Год назад о подобном можно было только мечтать, отличный пример.

Да, будку на колабе.

На гравити нужно регать акк, даже если и не сдетектят сразу твое временное мыло. Всё это - руками.

>назвал два самых "сложных" направления из 2д.

Щта? Это же и есть самые проработанные файнтюны. Первое Anything v3 и прочие, второе - есть реалистик модели специально для азиаток.

Чем превосходит XL?

Генерируй с dall-e 3

Да неправильно это - добиваться когерентности лорами, да извинит поздний час мой теоретизирующий максимализм. Лора - это ведь искажение весов модели, искажение, которое что-то убирает, что-то корёжит. Не должно это так работать, должно быть приращение знания! Вот жопой чую! Должен быть способ добавить информацию в модель, как это делают две самые успешные технологии в мире SD, два game changer - инпаинтинг и контролнет... Должна быть выраженная модульность.

Хотя добавить гипернетворк/слои, отвечающие за когерентность, а потом уже вместе с ними тренировать модель как единое целое на высоких разрешениях - тоже вполне себе хорошая идея. Вот сейчас что будет, если условную NAI начать тренировать на 1280х1280? Подозреваю, что полная фигня! Тут ведь был анон с датасетом под 1024, или это в SD-треде?..

Человек с высшим математическим образованием никогда не скажет "полная жопа" - он тактично уточнит, что наблюдаемая жопа - банахова.

>BeastBoost is a trick developed by Anonymous on 2ch.hk/ai/ imageboard.

RAKI SUKA

Извольте детальнее изложить причину недовольства, сударь, пока я не вызвал Вас по айпи на дуэль на пингах ?

> Первое Anything v3

Древнее зло, не соответствующее современным стандартам и недалеко ушедшее от наи, в сравнительных гридах хорошо заметно, которое вполне себе выдает 2.5+д если попросить художниками и длинными промтами на реализм.

Правильный путь - полноценный файнтюн.

> Хотя добавить гипернетворк/слои, отвечающие за когерентность

Это как добавить человеку вторую печень чтобы улучшить его мелкую моторику, никакого толку. Простая тренировка решит эту проблему. Если ты просто про изменение размеров слоев или их структуры - это уже другая модель будет, как 2.1/xl.

> Подозреваю, что полная фигня!

Если найдешь хороший сбалансированный датасет, подберешь параметры тренировки и постепенно поднимешь разрешение - будет не фигня. Только это просто лишь на словах, сделать это так чтобы при этом ничего случайно не лоботомировалось - та еще задача. Для анимца просто хайрез пикчи это меньшая из проблем.

Это шаманство с мёрджами мы тут сравнительно недавно тестировали, и лично я пришел к выводу, что не стоит оно того. Начинает выдавать картинки с разной степенью контрастности, вдобавок периодически выдавая непонятные цветовые акценты туда, где их быть не должно. Особенно сильно било синим и фиолетовым цветами. Чертовы синие собаки, их явно было слишком много в датасете оригинальной меховой модели.

Хотя возможно, что с тех пор методика мёрджа как-то поменялась. Хз.

Совместимостью со всем полторашным хозяйством, включая схемы обучения, лоры, контролнеты и т.д. Насколько там хорошая совместимость - вопрос дискуссионный, но явно лучшая, чем полное её отсутствие у сдохли.

Что не отменяет того факта, что за сдохлей может быть будущее.

Кстати, из релиза "контры" (SD 1.6) убрали хвастовство про хайрез, теперь там просто

> stable-diffusion-v1-6 has been optimized to provide higher quality 512px generations when compared to stable-diffusion-v1-5

https://platform.stability.ai/docs/release-notes#stable-image-v1-release

Насколько я понимаю, это всё тот же train-diff задом наперёд.

>Это как добавить человеку вторую печень чтобы улучшить его мелкую моторику, никакого толку.

Чего это никакого? Быстрее выводится алкоголь -> меньше трясутся руки -> лучше мелкая моторика!

Всегда знал, что бенгали - пиздаболы, лишь бы струсить бабла с инвесторов.

И ещё один вопрос. Как водится, ЕОТ. Тренил я её, тренил, и наконец натренил. Нагенерил много картинок. Понятно, что какие-то похожие и удачные, а какие-то... Вот пикрил1. Вроде няша, и вроде волосы такие, и причёска, и глаз столько же. Однако ж - не она!

А пикрил 2 вообще капец. И тоже не она. Пикрил3 тоже не очень-то похож - и субъективно, и объективно. Пикрил4 вобще морду помяло.

Не пропадать же нагенерённому добру? Может, его можно как-то присобачить к тренировочному датасету (с отрицательным весом? как отдельный концепт?) и повторить тренировку?..

Алсо, а как вообще валидируется успешность тренинга лица, кроме подсчёта совпадений на https://search4faces.com/search_vkwall.html ?

А пикрил 2 вообще капец. И тоже не она. Пикрил3 тоже не очень-то похож - и субъективно, и объективно. Пикрил4 вобще морду помяло.

Не пропадать же нагенерённому добру? Может, его можно как-то присобачить к тренировочному датасету (с отрицательным весом? как отдельный концепт?) и повторить тренировку?..

Алсо, а как вообще валидируется успешность тренинга лица, кроме подсчёта совпадений на https://search4faces.com/search_vkwall.html ?