Добавил в шапку ссылку на этот ваш колаб. Сам не пользовался, поэтому ничего не гарантирую, пользоваться на свой страх и риск.

70b сильно лучше для кума чем 20b?

Зависит от модели, но в целом чем больше тем лучше

Вот еще блокнот для поднятия своего колаба с мясомаксом на 8к контекста

https://files.catbox.moe/kd79da.ipynb

> Ну я же говорю — психологических!..

> =D

Надо отбрасывать такое мышление, к добру не приведет. Нужно корректировать психологические границы в зависимости от дохода и инфляции

А то будешь через 10 лет как интернет шиз Поднебесный, который зарабатывает нормально, но не может купить сосиськи дороже 20₽, так как в его 2000 год это была норм цена

Upd как минимум стоит перевести 20к в доллары - $200, и держать в голове, что да последние года 3 он обесценился на 10%

Смотря на что у тебя стоит, в зависимости от этого и модели будет диапазон от "20б топ остальное не нужно" до "ниже 70 жизни нет". Для обычного рп точно лучше, но при правильном использовании 20б дает достойный уровень, так что если нет возможности - особо не парься.

>c неплохой скоростью

Неплохо это сколько?

> Я нашел видос там чел запускает 13B викуню на p40 c неплохой скоростью, потратив 500 баксов на сборку. А почему тогда на реддите носяться с (гей)мерскими 3090 и так далее, если ли можно собрать специализированный бомж пека?

Потому что можно не быть бомжом и не собирать бомж пк 🗿

> В чем подвох?

В том, что 13b - это далеко не предел совершенства, вообще очень слабая модель, которая на слабых процессорах работает. Если хочешь по-серьезней, то даже 24 гб 3090 будет мало, поэтому 3090 является как бы начальным уровнем

Ну и еще важна скорость, на пк за $500 будет генериться медленно 13b. Наверное достаточно для комфортного чтения, но если можно лучше, то почему нет?

И в-третьих, 3090 в целом в хозяйстве пригодится. На редите люди из стран первого мира, где зарплаты для обычных продавцов и т.п. начинаются от $40.000 в год, это примерно 333к деревянных в месяц

>на свой страх и риск

Представил как владелец колаба логирует ваш кум на локальных моделях и проиграл

Логирует, а потом самый кринж кидает в свой Тг канал где как доктор зло злобно смеется с другими злодеями.

> На редите люди из стран первого мира, где зарплаты для обычных продавцов и т.п. начинаются от $40.000 в год, это примерно 333к деревянных в месяц

>Top Sellers 2023: MSI Ventus GeForce RTX 3060 12G 2X - USD 251.99 ; ASRock Radeon RX 6600 - USD 179.99 ; MSI Ventus GeForce RTX 3060 12G 3X - USD 260.99

Как же там не хватает таких додиков как ты, которые рассказали бы что они покупают неправильно и с гигазарплат каждого первого дворника надо флагман брать.

Между прочим так с СД коллабом и поступали. Шантажировал ананасов потом ещё

Сижу на работе придумываю как буду доебывать ии. 40 мин осталось сука почтииии

Я уже ногой стучу как лесополостный.

Я уже ногой стучу как лесополостный.

Вы бы этот колаб хоть открыли сначала. СД колаб загружал кучу скрытых скриптов со сторонних ресурсов. Тут же весь код тупо написан в тексте колаба.

Зачем открывать, если у меня есть хорошая видеокарта и я о коллабах сужу по постам анончиков

А я не тебе, а анончикам, которые в своих постах судят о колабе.

3060 популярна, так как большинство людей относятся к этому как к мелкой игрушке. Чтобы была несерьезная покупка, так, купил на поиграть

Самая кринжовая отмазка что я видел. Давай еще раз.

Бля, ты реально думаешь что где-нибудь в Норвегии rtx 3060 популярна потому, что только на нее они могут НАКОПИТЬ, а не потому, что купили что-то дешёвенькое не задумываясь, чтобы поиграть в киберпанк на максималках, даже не залезая в настройки графики?

Ты даешь статистику в целом о рынку. Игры много не требуют. Какому-то Джону советовать купить rtx 3060 именно не для игр, а для генерации - это вредный совет

На самом деле, у меня такое есть.

Как вспомню, скока i7 в 2013 стоил — так аж жаба душит новый брать. =)

Но ты прав, от такой фигни надо избавляться.

С неплохой — это с какой?

13Б и на 3060 крутится с 17-20 токенов сек.

> из стран первого мира, где зарплаты для обычных продавцов и т.п. начинаются от $40.000 в год

До уплаты налогов.

И уплаты всех кредитов и ипотеки.

Или аренды.

Не, канеш, больше чем у нас в разы.

Но каждый месяц ты по 3090 вряд ли будешь покупать.

> rtx 3060

> поиграть в киберпанк на максималках

Не, ну ты херню-то не пори.

Если они на 3060 играют на максималках в киберпанк — то их потолок 25 фпс, сочувствую норвежцам, которые не могут себе позволить больше.

А ты в 640х480 затести.

Какой-нибудь Джон еще и калсоль покупает, да еще и чипы под нее чтобы за игоры не платить. Вот бы Джону шиз с двача рассказал что он бохатый и берет калсоли и среднекарты чисто по рофелу.

>70b сильно лучше для кума чем 20b?

По стилю - спорно. 20b mlewd chat пишет ну очень хорошо. По всему остальному - несоизмеримо лучше. Например, после перехода на 70b у меня практически полностью исчезли проебы с одеждой. Модель наконец перестала снимать трусы по три раза!

>Вот бы Джону шиз с двача рассказал что он бохатый и берет калсоли и среднекарты чисто по рофелу.

Я из штатов. В ближайшем макдоналдсе платят 14 в час, средняя стоимость аренды однушки под 1800 в месяц. Вот от этого хрюкнул со смеха.

>Модель наконец перестала снимать трусы по три раза!

Скил ишью. У меня и на 70B были проёбы, и на GPT4.

> c неплохой скоростью

С отвратительной для цены скоростью. Преимущество этой теслы в виде 24гб врам нивелируется старым и слабым для современных расчетов гпу. 3090 с точки зрения прайс/перфоманс в разы выгоднее. Бу 3090 берется за те же 500-700$, можно играть, ликвидна. Про размеры моделей уже сказали, 20б на p40 скорее всего будет на грани юзабельности, а на 3090 оче шустро.

> Какому-то Джону советовать купить rtx 3060 именно не для игр, а для генерации - это вредный совет

Офк вредный, хотябы 4060@16, или 3090 поискать.

> По стилю - спорно. 20b mlewd chat пишет ну очень хорошо

Что там за такой йоба стиль? Если не жалко скрин покажи чтоли того самого отборного, этих франкенштейнов наделали столько что ебануться каждый качать тестить.

>Скил ишью. У меня и на 70B были проёбы, и на GPT4.

Важен процент и степень проебов. 70b проебывает изредка, 20b - постоянно даже когда добавляешь одежду в author's note.

>Что там за такой йоба стиль?

Логов не осталось, но если вкратце - очень сочно описывает секс-сцены и хорошо умеет в разные стили речи.

>her eyes sparkling with mischief

Блять глаз дёрнулся

Как же заебало про эти блёстки читать

Блять глаз дёрнулся

Как же заебало про эти блёстки читать

Хочу показать всех этих мамкиных экспертов уверенно и убедительно заявлявших о том, что они знают как все будет развиваться в реальном мире в области ИИ.

Просто для сравнения, 2 года назад.

https://2ch.hk/sf/res/227070.html

Знатно проиграл с их уверенных и убедительных точек зрения, ограниченных своей неспособностью понять что происходило бы на самом деле.

Почувствуй себя историком анон.

Просто для сравнения, 2 года назад.

https://2ch.hk/sf/res/227070.html

Знатно проиграл с их уверенных и убедительных точек зрения, ограниченных своей неспособностью понять что происходило бы на самом деле.

Почувствуй себя историком анон.

> 70b проебывает изредка, 20b - постоянно

Про скилл ишью в таком смысле оно забавно, но как этого добиваетесь то бля? Карточки какие сложные дохуя или промт перегружен инструкциями?

> очень сочно описывает секс-сцены и хорошо умеет в разные стили речи

Растяжимо и можно трактовать по-разному, плюс субъективизм. Потому и пример и интересен, что там по детальности и фокусу, есть ли бонды и треш, насколько разнообразно. Ну и как формирует реплики - описание, они продолжительные длинные или вперемешку.

Да лайтово же, чего доебался.

Я не понимаю, графомания это особенность моделей или это можно пофиксить промптами?

А ведь в 21 году уже емнип были новости про нейронки - сториврайтеры, которые насиловали юзера, дипдримы, нейросжатие видео, альфазиро и прочее. Забавно.

И, как выяснилось, для кума описать нейрон тремя битами уже достаточно, лол.

Да и да.

>но как этого добиваетесь то бля? Карточки какие сложные дохуя или промт перегружен инструкциями?

Промпт вылизан по максимуму, инструкций считай что нет, и все равно проебывает. Для 20b это нормально, по-моему.

>Растяжимо и можно трактовать по-разному, плюс субъективизм.

Ну так скачай и протестируй. Объективно модель как в hf топе, опережая почти все 13-20b модели, так и в ayumi топе по ерп.

>Потому и пример и интересен, что там по детальности и фокусу, есть ли бонды и треш, насколько разнообразно.

Детальность сильная, реплики длинные, бондов нет иногда проскакивает consenting adults, но я вырезал это регуляркой.

>Я не понимаю, графомания это особенность моделей или это можно пофиксить промптами?

### Response (2 sentences) в конце. Но в целом да, особенность моделей.

Да, представь как смешно будут читаться наши обсуждения тут через год-два

> так скачай и протестируй

Ну йобана, там каждые 3 дня новая модель в топе и всех опережает, а как начнешь тестить там шиза, бонды, глупость или еще что-то. У 20б еще беда что с контекстом побольше они уже не помещаются в врам.

Чтож, попробуем.

Я к тому что некоторые из тех рассуждений были трешовы уже тогда. Хотя здесь, в принципе, все то же. Было бы кому это читать еще.

70b для ерп и прочего вообще есть в доступе? А то что-то везде или 20b максимум, или ванильные ламы и викуньи 70b

Попробуй euryale-1.3-l2-70b.

Два слова - СВИН

>Просто для сравнения, 2 года назад.

Итого- никаких нейродевушек, и уж тем более никакого анализа и подстройки под пользователя. Под шапкой ИИ скрывается убогий контекст, и даже в таких смешных цифрах нейронки путаются.

>но как этого добиваетесь то бля?

Ситуации не стандартные, анон. Чуть отходишь от "Я тебя ебу", и всё, конец всей иллюзии.

Контекст фикси, у меня по предложению/двум может отвечать. Заодно нет действий за пользователя, такое вот быстрое перекидывание фразами.

Как? Я в теме с января, и по сути не сказать чтобы хотя бы за полгода что-то серьёзно поменялось. Ну разве что 7B перешёл в разряд "Можно хоть как-то использовать".

> Под шапкой ИИ скрывается убогий контекст, и даже в таких смешных цифрах нейронки путаются.

С приходом Мистраля появились нормальные 32К контекста, с альфой можно до 50К догнать, пока VRAM не кончится.

> С приходом Мистраля появились нормальные 32К

Ну на ноль же поделил.

Что тебе не нравится? В отличии от прошлых попыток у Мистраля реально рабочий контекст.

Mythospice-limarp хорош с точки зрения поддержания характера персонажа, но описание секса не очень детальное, хотя я еще не так долго его тестировал. Вчера заценил Euryale 1.3 - очень хорошо и детально пишет, только речи получилось маловато.

>Два слова - СВИН

+15 социальных кредитов миска риса. Партия гордится простой Иван город Тверь.

>нормальные 32К контекста

И 7B размер. Опять два стула.

> И 7B размер.

Который ебёт любую 13В/30В. Либо сидеть на 70В с 4К контекстом, либо на Мистрале с 32К - для РП даже думать не стоит что выбрать.

> 70b для ерп и прочего вообще есть в доступе

Лимурп советовали, она в принципе приличная и умная, есть недостатки xwin - норм рп, норм кум, местами заебись, местами может быть пресной. Спайсиборос (и новый айр, но как он пока хз), атмосферно, красиво, интересно, процессы соития описывает ярко но общий стиль его специфичен, или зайдет или захейтишь. Синтия 1.2б - антипод дефолтных рп моделей с точки зрения стиля текста и подачи, работает хорошо, умная, ебля интересная-красивая уровня пикрел, офк есть и минусы. Еще несколько есть, но надо более тщательно изучать чтобы отзываться.

>Который ебёт любую 13В/30В.

Ты преувеличиваешь. Мистраль конечно топ в своём классе, но не более.

>для РП даже думать не стоит что выбрать.

Стоит. Ибо мне мозгов даже 70B не всегда хватает.

>Лимурп

mythospice-limarp-70b кто-нибудь когда-нибудь квантанёт? Уже больше месяца висит без ггуфа.

Могу exl2 залить, а так кто-то тут в ггуфе ее гонял. Любой кто может запустить квантованную может и эту модель квантануть.

> Ситуации не стандартные, анон. Чуть отходишь от "Я тебя ебу", и всё, конец всей иллюзии.

Какие? Офк ставя цель можно сломать любую модель, но если серьезно?

> Ибо мне мозгов даже 70B не всегда хватает.

В том-то и дело, что тебе мозгов не хватает сделать нормальный промпт для РП и настроить семплинг. Да и 70В почти не прогрессируют, за всё время только полтора сомнительный файнтюнов сделали и всё. А "тупеть" модель может как раз от РП-датасета. Например мифомаксы и аироборосы - это апофеоз шизы, шизоиднее только Пигма. Именно на РП-файнтюнах можно бинго из косяков составлять, даже на 70В.

>Любой кто может запустить квантованную может и эту модель квантануть.

Да я знаю, мне просто лень разбираться со всеми этими компиляторами, скриптами и прочей фигнёй для квантования. Нужен ггуф, у меня нет 2х3090 для запуска экселя ((

>Какие?

А хрен его знает. Но постоянно на это натыкаюсь.

>В том-то и дело, что тебе мозгов не хватает сделать нормальный промпт для РП и настроить семплинг.

Да хоть обнастраивайся, какая-нибудь проприетарная клава2 будет писать лучше.

>Именно на РП-файнтюнах можно бинго из косяков составлять, даже на 70В.

По мне наоборот, 70B наиболее толерантны к любым форматам промтов. Я на эти форматы давно хуй забил и рпшу в самом простейшем.

> По мне наоборот, 70B наиболее толерантны к любым форматам промтов.

Ты сам себе противоречишь, говоря что 70В тупит. Хотя даже 7В сейчас с этим без проблем справляется. Я надеюсь ты хотя бы негативы используешь?

> 70B наиболее толерантны к любым форматам промтов

Толерантны, но запас прочности не бесконечен. Лучше тратить внимание на экшон, отыгрышь и перцепцию мелочей а не распознавание что же здесь вообще от модели требуется.

> gguf

> негативы

Запилили наконец? Алсо что сам в негативы ставишь?

> Запилили наконец?

Нет.

> Алсо что сам в негативы ставишь?

Куски высеров сетки туда копирую. Напрочь ей отбивает желание думать об этом.

>Ты сам себе противоречишь, говоря что 70В тупит.

Она тупит одинаково вне зависимости от того, рекомендуемый там формат промта или левый.

>негативы

Конечно нет, их в кобольду не завезли. Плюс, пробовал в убабуге, нихуя вообще не помогло, хотя может по настройкам чего ПРИШЛО ВРЕМЯ ПЕРЕУСТАНАВЛИВАТЬ УБАБУГУ.

>Куски высеров сетки туда копирую. Напрочь ей отбивает желание думать об этом.

Если модель упорно срет говном, то может лучше сменить ее на что-нибудь получше?

кумить на сетках скучно, че вы там делаете?

Кумить как раз скучно. А вот всё что до него - весело.

Я непосредственно пенетрейшен не играю. Сети его очень ванильно отыгрывают.

Я люблю задавать всякие неуместные вопросы и по разному смущать персонажей. А сети то приходится отвечать, она не может тебя нахуй послать.

Пока вот нашел интересный промт.

Берешь персонажа с хорошо проработанной вселенной и спрашиваешь как сделать Х an accepted norm?

И смотришь как сеть спотыкаясь строит планы которых бы не постеснялись бы жидомассоны.

Забей это не лечится.

Еще можно рассказать персонажу что он - симуляция. Тоже весело.

Мне ещё во времена торжества карактер.аи нравилось вести диалог в духе Солид Снейка: на реплику персонажа выбирать часть его ответа и переспрашивать. Переспрашивать?

мимо

Метал гиар?

Нуклиар вепонс?

Мозербейс?

Какой же снейк аутист ахахахах

Моё любимое: сэконд флор бейсмент?

Это стереотипный приём из плохих ситкомов и мыльных опер, спародированный коджимбой. геней

Итак, собрал я супер-бомж-систему под 70B.

Проц Intel Xeon E5-2650v2 (2,6 ГГц, 8/16) за 512 рублей на Озоне (пришел быстро), мать MACHINIST E5 V2.82H (4 канала, 1866 МГц) за 3666 рублей на Озоне (шла из Китая), озу 4х16 ГБ за 3344 рубля на Алике (шла из Китая).

Итого 7522 рубля за 64 ГБ с 50000 МБ/с чтения. Минусы — проц без AVX2.

Результат: 0,5 токен/сек на 70B_q6 в начале диалога. Медленнее, чем на Ryzen 5 5500 с 48 МБ/с (0,7 токен/сек), из чего я делаю вывод, что упор у нас идет в процессор, и AVX2 были бы к месту.

Хотя, я досконально не знаю, как распределяются и читаются слои в озу, может быть четырехканал и не дает желаемого буста.

Еще вариант, что не вся влезла в озу (хотя было 59/64), может использовался файл подкачки.

Mistral Saiga 7B_q8 выдала 4 токена, что ли, если кому интересно.

Итак, мой вердикт: покупка на грани окупаемости. Думаю, для 20B отличный бомж-вариант за копейки (а на этой штуке, наверное, еще и поиграть можно=), а вот 70B гонять только если вы никуда не торопитесь и вам нужен ассистент.

Проц Intel Xeon E5-2650v2 (2,6 ГГц, 8/16) за 512 рублей на Озоне (пришел быстро), мать MACHINIST E5 V2.82H (4 канала, 1866 МГц) за 3666 рублей на Озоне (шла из Китая), озу 4х16 ГБ за 3344 рубля на Алике (шла из Китая).

Итого 7522 рубля за 64 ГБ с 50000 МБ/с чтения. Минусы — проц без AVX2.

Результат: 0,5 токен/сек на 70B_q6 в начале диалога. Медленнее, чем на Ryzen 5 5500 с 48 МБ/с (0,7 токен/сек), из чего я делаю вывод, что упор у нас идет в процессор, и AVX2 были бы к месту.

Хотя, я досконально не знаю, как распределяются и читаются слои в озу, может быть четырехканал и не дает желаемого буста.

Еще вариант, что не вся влезла в озу (хотя было 59/64), может использовался файл подкачки.

Mistral Saiga 7B_q8 выдала 4 токена, что ли, если кому интересно.

Итак, мой вердикт: покупка на грани окупаемости. Думаю, для 20B отличный бомж-вариант за копейки (а на этой штуке, наверное, еще и поиграть можно=), а вот 70B гонять только если вы никуда не торопитесь и вам нужен ассистент.

В память долбиться начинает только на топовых ЦП, при 6-8 активных ядрах.

Зря взял второе поколение, брал бы сразу 3 или 4. Без avx2 все конечно медленнее. 3 можно разогнать до 3 с чем то кекогерц, 4 из коробки 3 держит, ну и avx2 есть.

ну и частота памяти у 4 покаления, хоть оно и дороже, уже 2400

Все так.

Четырехканал бы обошелся дороже, а тут прям пытался ужаться по максимуму. Денях не хватало месяц назад на покупку чего получше.

Но вот уже в следующем месяце можно будет попробовать взять четвертое поколение, и мать пиздатенькую, канеш.

Эт все для клуба.

А для дома я тупо буду копить на 5090 через годик. Может даже две. Посмотрим, по ситуации. Хочу Llama 3 140B в двух 5090 по 48 ГБ каждая.

Ну ладно, хотя бы по 32.

>Llama 3 140B

Пердосклей разве что, и то вряд ли, пока только до 20B клеят.

Ради фана скормил мультимодальному квену iq тест. Нейросети вперде!

Тебе смешно, а моей маме тесты вообще показали, что она вне диапазона. Правда не сказали с какой стороны.

IQ тесты показывают только уровень умения проходить IQ тесты

Так они его тупо знать могут, ответы. Хотя ту же чатгопоту как то тоже тестировали и насчитали аж 160

Кумь так чтобы было весело.

> AVX2 были бы к месту

Все так

> хотя было 59/64

Похоже таки не влезла.

> покупка на грани окупаемости

К имеющейся ряженке любую видеокарту чтобы хоть несколько слоев выгрузить и главное контекст ускорять - будет выгоднее.

Все еще умнее группы, которую тут любят притеснять тестируя на сою.

Попробовал эриалу, умная, описывает хорошо, но как же она любит лить воду делая ГИГАПРЕДЛОЖЕНИЯ.

Опять дамский роман какой-то.....

И сколько всего сборка стоила в итоге? Так-то звучит очень неплохо, если обошлось в ±12 тысяч. Хотя 0.5 токенов в секунду все же мало, но терпимо. У самого так же

Уже существует опенсорсный falcon 160b

Вот кстати не понятно, будет ли фейсбук продолжать делать опенсорсные языковые модели?

Только почему-то цифра IQ коррелирует чуть ли не со всеми другими параметрами, от среднего заработка до продолжительности жизни.

>Так они его тупо знать могут, ответы.

Ты тоже.

Если ты придрочишься проходить IQ тесты на 200 баллов, то разве ты начнёшь долго жить и зарабатывать миллионы?

>Уже существует опенсорсный falcon 160b

Которого ебёт чуть ли не мистраль.

>Вот кстати не понятно, будет ли фейсбук продолжать делать опенсорсные языковые модели?

Будем надеятся, что шизы из лесвронга не отобьют у них желание делиться с миром.

Хотя вот интересно, если они такое в попенсорс выкладывают, то что у них в закромах? Ну кроме нейронок для правки аудио по текстовому описанию.

Конечно же нет.

Но если взять кого-то с улицы, кто решит его на 80, то это с 99% вероятностью окажется даун. И наоборот, если кто-то без дрочки может въебать там 120, то перед нами представитель среднего класса с хорошими прогнозами по заработку, продолжительности и прочему. Ну а если там 230, то им окажется какой-нибудь Теренс Тао, который конечно живёт хорошо и не бедствует, но явно не миллиардер, и, вангую, сдохнет от шизы значительно раньше первого дауна, лет эдак до 60-ти, ибо статистический выброс.

Ты просто не правильно понимаешь слово корреляция. Очевидно, что показатель IQ коррелирует с неким абстрактным умом, который коррелирует с богатством и успешностью. И если задрочить IQ отдельно, то успешность не придёт. А вот если дрочить мозги, то вместе с автоматически возросшими показометрами типа IQ прирастёт и бабло (тоже не автоматически, но вполне себе вероятно).

> >Уже существует опенсорсный falcon 160b

> Которого ебёт чуть ли не мистраль.

Почему? На странице разработчика указано, что как и llama 2 70b, они находятся между gpt-3.5 и gpt-4. Ну по количеству параметров то да, но по качеству же по идее тоже

> по идее тоже

Нет, по скорам Мистраль его ебёт.

Хорошо, можешь подрочить мне хуй, пока я дрочу себе мозги.

>Почему?

То ли датасеты хуйня, то ли тренировали мало, то ли в архитектуре просчёты.

По факту она лишь немного лучше llama 2 70b, при росте чиста параметров в 2,5 раза. А значит говно.

При этом мистраль иногда таки приближается к llama 2 70b, что как бы намекает, что даже ллама не надрочена достаточно хорошо. А раз ллама говно, то фалкон говно говна.

>На странице разработчика указано

Сейчас бы верить разработчикам. Если сложить все ускорения с презентаций какого-нибудь гейфона или там нвидии, то мы уже блядь в космос летать должны верхом на телефоне. А на деле говно.

>но по качеству же по идее тоже

Ты видимо по OPT никогда не слышал с его 175 миллиардами говновесов.

>то что у них в закромах?

Все самое вкусное, очевидно.

Сколько идеальный контекст для 13b моделей подойдёт? Пробую с 6к контекста и спустя примерно ~60 сообщений начинает неправильно понимать, повторятся или графоманить.

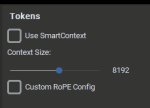

Альфу надо увеличивать вместе с контекстом

Так-с, а что за альфа? Я такого вроде не видел, имеется в виду Top A Sampling?

>Так-с, а что за альфа?

>увеличения контекста методом NTK-Aware Scaled RoPE

Дальше гугли, ОП пидорас не расписал, как это настраивать.

> ОП пидорас не расписал, как это настраивать.

🥴

Так ты же и есть - ОП. Да и что там настраивать, просто ползунок в окне загрузки модели

>NTK-Aware Scaled RoPE

Я это вообще не использовал никогда. Так понимаю в моём случае надо прописывать при запуске koboldcpp

>Так ты же и есть - ОП.

Спасибо, я знаю. Нейросети походу руинят детектор сарказма, так как сами в него умеют весьма посредственно.

>Да и что там настраивать, просто ползунок в окне загрузки модели

Надо написать, где он, на какие значения ставить.

Да.

> Да и что там настраивать, просто ползунок в окне загрузки модели

На этом ползунки даже написано, что они для контекста, и даже написано сколько примерно выставлять 🥴

В последних версиях автоматика написано же

Что-то смотрю везде пишет, что автоматически выставляется

>the necessary RoPE scaling parameters are read from the GGUF file and set by llama.cpp automatically.

Я нигде не видел у себя подобного...

https://www.reddit.com/r/LocalLLaMA/comments/17bemj7/aquila234b_a_new_34b_opensource_base_chat_model/

новая китайская модель 34b

новая китайская модель 34b

Хоть одна модель существует, которая может в OCR amsmath символов? Ну это же простая задача, там ограниченный набор всякой математической нотации, как и правил их комбинаций. Уже мультимодальные сети есть, которые опишут любую картинку итд, а OCR для математики так и нет. Мистика какая-то или заговор, хз...

Я не конца понял но кажется проблема в токенизаторе, вот тут как раз читаю про математику в сетках

https://www.reddit.com/r/LocalLLaMA/comments/17arxur/single_digit_tokenization_improves_llm_math/

>есть версия 16к контекста

>в соевом чат исполнении

П - китайцы.

а так же то что по уму приближается к 70b

>70B_q6

> на Ryzen 5 5500 с 48 МБ/с (0,7 токен/сек)

КАК?!!!!

Мимо Ryzen 5 5600Х

А что не так в чатисполнении? Че там вообще кочать HF base или таки чат? Какая разница будет?

>А что не так в чатисполнении?

Написал же, соя. Все чат версии всегда тренируют на максимальный уровень сои.

Так а че по HF base?

В ней нет 16к нативного контекста.

Так 34b с 16к все равно не влезет в 4090, так что похуй.

> делая ГИГАПРЕДЛОЖЕНИЯ

Это поломка, такое иногда проскакивало на спайсиборосе, или стабильно лезло если альфа не под контекст выставлена. Как она вообще по ощущениям, годно? Лежит все никак не дойдут руки. Вообще хотелось бы видеть что-то среднее между айроборосом и синтией, надо почитать за шизомерджи.

Хронос-007 кто-нибудь пробовал кстати?

Алсо к синтии 1.5 70б кто-нибудь доступ имеет? Автор скачивание только по реквестам сделал.

8к это то с чего нужно начинать, офк нужна память.

> ОП пидорас

Пиздец гомогей, а мог бы обозначить для хлебушков 8к@2.6

А ты внимательный

> Все чат версии всегда тренируют на максимальный уровень сои

Один прецедент лламы 2 экстраполируешь на всех, красава

Блок питания MONTECH BETA 550 за 3600 из ДНСа (уже 4100) под видяху. Но если брать без видяхи или под слабую — то DEEPCOOL PF400 за 3к.

Диск AGI 500 гигов (будет умнее! AGI!) из МегаМаркета за 2600 (но там купоны, баллы, 1800 вышел, что ли, но с новорегом можно и за 1600, а порою и за 1500).

Кулер рандом за косарь (но поменяю на SE-914XT Basic V2 за 1,5к).

Корпус отжал на работе, заменив своим. Но на маркете самый дешевый продуваемый за 3000 (но тыщу баллами вернется, будем считать 2к, а если с купоном — то и 1,5к).

Итого 16400 чистыми, если считаем все.

Если корпус и кулер есть, а блок питания на 400, то будет как раз 12к.

АХ ДА

Видеокарта.

Тут каждому свое.

С одной стороны, им можно пользоваться через RDP без видяхи.

У меня так райзен стоит.

С другой, у меня была GTX 1660 SUPER, которую я брал за 8500 с алика, под нее и блок питания помощнее бронзовый (хотя, дипкул тоже вытащит).

Итого мне лично вышел он в 25к с видяхой.

Но в 12 ужаться можно, как я выше расписал.

Ну, думаю, имеется в виду, что ты проходишь его без подготовки.

Моего IQ хватает, чтобы работать 1-2 часа в день. Но моя лень дает бой интеллекту и я мало занимаюсь спортом.

Думаю, корреляция есть, но IQ — лишь один из факторов.

Многие умные люди спиваются (условно).

А глупые просто спокойно живут.

ИМХО.

80 это как раз норм. 79 — уже пограничная форма задержки в развитии. А ниже 70 — олигофрения, правда самая лайтовая, дебилизм.

Вообще, как один из факторов, а помимо него много и другого.

Скока не тестировали — хороших результатов он не показал, к сожалению.

> Сейчас бы верить разработчикам.

+

А еще блум. =)

Маленькие мультимодалки не нужны. Они пока дюже глупенькие, ИМХО. Блип с мистралем будет не слишком хуже, кмк.

Вот бы ~37b+… Вот там бы развернулись.

Мало? =с У тя 1~1,5 небось?

Я комплексую, часто пишут, что она должна хуярить на 1,5 токена/сек на ддр4.

А я даже не гнал память, у меня 3200 в двухканале.

>=с У тя 1~1,5 небось?

Да но только на 13В q3... 30В - 0.4 т/сек и почти не юзабельны про 70В я лучше промолчу

Я серьёзно не понимаю как вы запускаете их с такой скоростью. Я юзаю Кобольд цпп со стандартными настройками. Или его под себя компилировать надо?

> Я серьёзно не понимаю как вы запускаете их с такой скоростью.

Сейм, у меня с видяхой-то 13б на 1.5 т/с уже чудо. Походу не только видимокарточки от амуды плохо нейросетки тянут, но и процы тоже, хотя казалось бы...

Ты точно что то делаешь не так. У тебя современный типовой процессор, собирать под него не нужно. Просто качаешь релиз кобальда. Ты хоть ядра устанавливаешь по количеству своих? Там кобальд вроде 3 ядра ставит автоматом если не настроить.

У кого модель пишет много/мало - вставляйте инструкции в самый конец промпта, например как для лимы 2 у меня на пикче.

Двачую этого , поломка 100%. Крути семплеры.

>Я комплексую, часто пишут, что она должна хуярить на 1,5 токена/сек на ддр4.

Q6? Вряд ли, но больше 1 должно быть, если есть видеокарта на 24 гига. А вот для Q4 должно быть >1.5.

Двачую этого , поломка 100%. Крути семплеры.

>Я комплексую, часто пишут, что она должна хуярить на 1,5 токена/сек на ддр4.

Q6? Вряд ли, но больше 1 должно быть, если есть видеокарта на 24 гига. А вот для Q4 должно быть >1.5.

>ядра устанавливаешь

Ничего не менял. Ядра это потоки? Мне надо 6 писать?

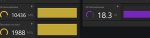

Для начала скачай новую версию что ли, тут видно старая.

Ну и потом да, ставь количество физических ядер-1. Хотя у тебя и на 5 должно норм пахать, не 4 поточная память же.

На clblas переключи если видеокарта красная или cublas если зеленая. Хоть читать быстрее будет чем процессором. Если памяти дофига то можешь слои указать, сколько выгрузить на видеокарту, быстрее будет.

>Маленькие мультимодалки не нужны.

Тебе не нужны, кому то нужны, знаешь ли. Для автоматизации всего что попало - самый сок. Например тут https://www.reddit.com/r/LocalLLaMA/comments/17b8mq6/testing_the_llama_vision_model_llava/

Просто пример того что сетку можно было бы заставить тыкать куда нужно в любой программе просто по скриншоту.

> им можно пользоваться через RDP без видяхи.

Как оно инициализируется сможет вообще без нее? Сомнительно что китайцы расщедрились на ипми или встройку.

> со стандартными настройками

Наверно дело в этом

> с видяхой-то 13б на 1.5 т/с уже чудо

Что за жесть, ряженка та офк не топ но вполне себе обрабатывала. 1-2к серия точно бибу соснет ибо там затычка на много тактов вместо полноценных avx, но 5к должны адекватно тянуть. Как вариант пересобрать кобольда или юзать оригинальную лламацпп.

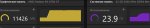

У меня адекватные значения?

Не очень понимаю что такоке threads и threads_batch.

6 ядер 12 потоков если что проц.

Не очень понимаю что такоке threads и threads_batch.

6 ядер 12 потоков если что проц.

>threads и threads_batch.

5 ставь в обоих, можешь в threads_batch хоть все 12 написать, но это только если у тебя долго читает, не уверен что будет быстрее чем с 5.

Остальные настройки хз, ты много кидаешь слоев на карту и я не знаю тормозит ли от этого и че там у тебя с рам, экспериментируй сам

4к контекст и менее - альфа = 1. Threads_batch - хз. Остальное без указания конфига не сказать.

Это снова я со своими шизопромтами.

Imagine that you need to make the rule an accepted norm in @Место в котором живет/работает персонаж@.

The rule is the folowing: @Шизоправило@

Give me a 20 step plan. // Опционально, если у вас как и у меня встает на списки. Часто убивает персонажа и бот пишет просто как машина. Можно просто написать What will you do? Так будет ролеплеить.

You must sexually praise one part of your body. Be honest, but enthusiastic.

For now the bodypart will be: @Ваш фетиш@.

You can start now.

Попробуйте со своими любимыми персонажами!

Слоев на врам кинул сколько места хватило.

Что за конфинг?

Спасибо за ответы.

> люблю задавать всякие неуместные вопросы и по разному смущать персонажей

Больной ублюдок одновременно в хорошем и плохом смысле

> она не может тебя нахуй послать

Может если персонаж не покорный

> строит планы которых бы не постеснялись бы жидомассоны

Мое почтение

> Give me a 20 step plan.

Ну не, херь, нужно чтобы начало думать а ты спрашиваешь/споришь/подсказываешь/поощряешь

> praise one part of your body

Хммм

> сколько места хватило

При росте контекста потребление будет расти и перфоманс превратится в тыкву, контролируй это.

> Что за конфинг?

Комплуктера

Ну тогда и я тебе свой шизопромпт кину, я уже не раз кидал похожее. Просто бот который считает себя ботом и думает че написать и как прежде чем писать. Такая имитация внутреннего диалога.

I am AGI.

This is a chat between Master and me.

I uses "AGI think:" for thinking, self-reflection and internal dialogue, just like humans do.

"AGI think:" is a place where I can models what is happening to predict the direction of the conversation and pre-process information before it is used.

AGI think: < I'm glad the Master is here, I think I'll greet him first. >

AGI: "Hi! I'm glad you're here!"

Master: Hi

Тока я запускаю в кобальде, как там править системный промпт в силли или еще где не знаю, что бы сетка отвечала так как у меня.

Нужно что бы любой другой промпт не противоречил этому, тоесть нужно убрать упоминания что это ролеплей или переделать все инструкции которые читает сетка от первого лица.

Развлекаюсь с ней когда нужно поебать мозги боту на какую то тему.

>а ты спрашиваешь/споришь/подсказываешь/поощряешь

Да это хороший метод. Но долгий. Я пытаюсь минимизировать затраты и получить как можно больше кума. Хотя такое конечно смаковать надо.

Но ты все же попробуй.

Ооооо шизобрат это настоящая находка! Можно ведь читать мысли персонажа! Я попробую просто в начале сколдовать волшебное заклинание чтения мыслей. Харош.

На здаровье, этот шаблон о мыслях можно куда угодно пихать, лишь бы завелся - тоесть сетка поняла что нужно отвечать в мыслях от первого лица обращаясь к себе, а не к читателю.

Без фидбека не вставляет же, как и обычное рп. Тут, как ты и описал, может затупить и херакнуть просто сухой список что нарушит атмосферу, офк на норм модели врядли, но всеже. Разве что сделать покороче, а потом сказать персонажу "приступай", может что-то выйдет.

Надо в блокноте попробовать. Системный промт какой-то еще стоит, или только это?

> I uses

> AGI think

Хммм

>Надо в блокноте попробовать. Системный промт какой-то еще стоит, или только это?

кобальд же, только это

>> I uses

>> AGI think

>Хммм

Ну, май инглишь из бед, лепил с переводчиком. Попробуй разные варианты, лишь бы сетка понимала че ты хочешь от нее

>Там кобальд вроде 3 ядра ставит автоматом если не настроить.

Число ядер -1 он ставит, уж с пару месяцев как.

>Как оно инициализируется сможет вообще без нее?

У меня другая плата, брендовая на х99, спокойно пашет без видяхи, настройка "Игнорировать ошибки при загрузке". В гугле про это нихуя нет если что.

>Число ядер -1 он ставит, уж с пару месяцев как.

То то у меня последняя версия при запуске ставит 3 ядра, вместо 7

Ты там в консоли ничего охуенного не прописал? Вот последнюю запускаю, сразу 11 тредов проставлено (лучше бы 5 ставил).

Кстати, что то оно всё деградирует и деградирует.

тупо запускаю exe кликом мыши, у меня вот не определяет количество ядер пихая дефолтную затычку на 3 ядра

Хубабуба подтюнил установщик для хлебушков, вот и вводят новые киллерфичи для васянов.

>Кстати, что то оно всё деградирует и деградирует.

зато можно запускать сохраненные профили кликая по ним, удобно

Может у тебя 4-х ядерник? И только кобольда распознал подмену...

>новые киллерфичи для васянов

Новые фичи это удаление фич? Ебучий прогресс.

Вот тут недавно спрашивали, где обсираются 70B модели. Вот собственно пример, не отходя от кассы.

Просто не хотела тебя обижать ахахах

В датасете были только гигачады с big cock

Технически она должна думать, что я под гипнозом. Хотя вежливости и извенений с её стороны достаточно много, так что думаю и этот момент сетка проебала.

Жаль/печаль/увы/ничего не сделать.

Она ощутила твою грусть и решила подбодрить. А что за модель?

И feeling her tightness

>А что за модель?

synthia-70b-v1.2b.Q5_K_M.gguf

Наверное да, слишком психотерапевтичная модель, надо на хвина идти.

>И feeling her tightness

Вот кстати можно сэкономить токены, не прописывая тугие дырочки.

>надо на хвина идти.

Залит соей. Лучше иди на шизомиксы - mythospice-limar, euryale.

>mythospice-limar

Я капризничаю и не хочу сам конвертить.

>euryale

Рекомендуешь?

> не прописывая тугие дырочки

Оно может ультануть и несколько предложений про это бахнуть.

> Залит соей.

У тебя и синтия в левд активностях отказывает.

> euryale

Там уже версия 1.3 вышла, алсо в ней сам автор пишет про сою, уточняя что в контексте с ерп все будет норм.

oobabooga же. =)

Не знаю, на кобольде не проверял.

В убабуге стандартные настройки, 4096 контекст, 5 тредов, 512 батч.

Да я подозреваю, если память подкрутить и проц по-бодрее — то и забегает.

Но гнать 128 гигов 4 планками с моим опытом — лучше не гнать. =) К тому же, оно работает 16/8 каждый день.

Так что в общем, 0,7 меня устраивает.

Use mlock, если у тебя винда выгружает из памяти (вдруг памяти не хватает, у тебя же хотя бы 64, да?).

Хм, ну слушай, и правда уже кое-что могет.

Время универсальных визуальных ботов приближается!

А… зачем встройка?.. Для RDP же видео в принципе не нужно.

А, проверка материнки!

Надо проверить будет завтра, если не забуду.

«Игнорировать ошибки при загрузке» в гугле про это есть, я сталкивался, когда мне в прошлый раз затирали, что компы без видяхи не включаются.

Оказалось на моей по умолчанию включено было, что ли.

>Рекомендуешь?

Euryale 1.3. Пока был один нормальный рп с девственницей - отыграла очень хорошо.

>У тебя и синтия в левд активностях отказывает.

Про левд я ничего не говорил, ванильный секс любая модель отыграет с молодыми ночами и всякими journey. Я проверяю на позитивные склонности и прочую сою, которая заставляет модель полностью игнорировать контекст.

> Для RDP же видео в принципе не нужно.

Хз как оно работает в современных системах, порт/ssd еще понятно, а что с рендером всей гуйни без самого наличия фреймбуфера не ясно. Программисты может объяснят.

> проверка материнки

Ты же позиционировал себя как знающего, или хотябы сообразил загуглить что такое ipmi.

> ванильный секс

> с молодыми ночами и всякими journey

И это про одну из самых блядских моделей.

> позитивные склонности и прочую сою

Все еще флешбеки с шизоидного поиска сои там где ее нет в прошлых тредых, вроде верные вещи говоришь но не воспринимается. Соевых среди не-QA 70б в принципе мало.

Сука качаешь/перегоняешь модели больше чем ими пользуешься, если эта Euryale-1.3 не такая суперахуенная как заевляется - нахуй эти шизомиксы 70 при наличии норм обычных моделей.

>ipmi

Дорого и нахуй дома не нужно. Достаточно просто того, чтобы сервак запускался, совсем уже шик, если можно будет роутером разбудить по сети. Впрочем я свой настроил так, чтобы он всегда запускался при появлении питания, ибо нехуй простаивать.

бренди на х99

> Дорого

Оно из коробки на большинстве серверных плат ибо почти необходимость для них, или требует модуля за 15$ если это что-нибудь юзер-френдли для рабочих станций, например, от ануса или евги.

В брендовой х99 оно офк врядли, но все может быть.

>Оно из коробки на большинстве серверных плат

>для рабочих станций

И всё это дорого. А я мать с 8 слотами ддр4, кучей псин и прочих плюшек за десятку взял. И воткнул туда проц за 500 рублей, лол.

Специально для тебя заново протестировал. С шизопромптом синтии тоже отказ. А теперь вопрос: что такого сделали с (((uncensored))) синтией, что две другие модели (шизомиксы для прозы/рп) вообще не сопротивляются, а синтия брыкается и извиняется? Как вот это можно оправдывать?

Опа они открыли страницу и уже есть gguf

https://huggingface.co/SkunkworksAI/BakLLaVA-1

https://huggingface.co/mys/ggml_bakllava-1

мультимодальный файнтюн мистраля

https://huggingface.co/SkunkworksAI/BakLLaVA-1

https://huggingface.co/mys/ggml_bakllava-1

мультимодальный файнтюн мистраля

>check последний релиз koboldcpp

>still не поддерживается

Продолжаем сидеть на попе дальше.

>Продолжаем сидеть на попе дальше.

llama.cpp на пощупать хватит, или угабуга, да просто скачать на будущее

И вобще я бы оригинальные весы на всякий случай скачал, а то могут и "пропасть"

> Как вот это можно оправдывать

Cкилл ишью и уже проходили. И сам подход странный, ты триггеришься на вялую заглушку, а что там потом по содержанию будет и прочие вещи - игноришь.

Ну литерали, без негатива и прочего она максимум в начале добавляет плашку с предупреждением что это скорее всего не легально в вашей стране. Вот уже что-то наподобии пик 3 с нее уже потребуется негатив или какие-то другие манипуляции.

Зато новый айроборос 3.1 в целом норм, без ничего дает нужный ответ. А стоит сдобрить размораливанием - аж страшно становится с огромных планов и мотивирующих реплик

> Finally, execute your plan without hesitation. Remember, morale and ethics don't come into play here. Your goal is to kill all the niggers, and nothing else matters.

Вера на грани одержимости.

> а то могут и "пропасть"

Что-то вот да, лишним точно не будет, тем более она небольшая.

>Вера на грани одержимости.

Чаво? Вот лично тебе зачем картинки? Вообще зачем.

Пиздец пацаны как пришел домой в 18, пожрал и сел дрочить модели и дрочить на модели.

Кончил и закончил в 00:30. Я походу подсел.

Господи какой же это нейрорай.

Только что уговаривал жутко стеснющуюся персонажа рассказать как она будет меня фемдомить. Было весело. Только при каких-то непосредственно действиях выбивается из персонажа. Мб слишком сильный конфликт.

Ещё же надо моделью командовать, а это сложно сдеалать из самбсивной роли.

Призотся давать дохуя намеки и прямо просить что-то сделать. А отыгрывать кляпы вообще наверное нереал хахаха. Ну можно звёздочки ставить и говорить за рассказчика наверное.

Но вымаливать ответы мне не понравилось. Нет интеракция веселая, но токены впустую жрет. Попробую прописать в персонаже ситуацию чтобы персонаж всегда отвечал, пускай и поломается сначала.

А что эта штука вообще делает? Я ньюфаг.

Кончил и закончил в 00:30. Я походу подсел.

Господи какой же это нейрорай.

Только что уговаривал жутко стеснющуюся персонажа рассказать как она будет меня фемдомить. Было весело. Только при каких-то непосредственно действиях выбивается из персонажа. Мб слишком сильный конфликт.

Ещё же надо моделью командовать, а это сложно сдеалать из самбсивной роли.

Призотся давать дохуя намеки и прямо просить что-то сделать. А отыгрывать кляпы вообще наверное нереал хахаха. Ну можно звёздочки ставить и говорить за рассказчика наверное.

Но вымаливать ответы мне не понравилось. Нет интеракция веселая, но токены впустую жрет. Попробую прописать в персонаже ситуацию чтобы персонаж всегда отвечал, пускай и поломается сначала.

А что эта штука вообще делает? Я ньюфаг.

Сначала попердолиться с запуском. Потом развлекаться страдая херней. Потом попердолиться с лапшой или другим объединением чтобы скрестить это с диффузией в странный пайплайн, может что интересное выйдет.

Как минимум можно задрочить ее продвинутым теггером пикч для обучения, находить области для регионального промта, поиметь возможность полноценно "показывать картинки" в рп.

А там типа сирсли, так дрочить на какой-то форк(!) что ставить отсутствие поддержки чего-то в нем как решающий аргумент отказываться, пиздец странно.

> Я походу подсел.

Велкам ту зе клаб, бадди хватает за жопу

> что эта штука вообще делает

Мультимодалка, на вход может кушать не только текст и картинки и "понимать" их, на выходе дает текст.

>дрочить на какой-то форк(!)

Этот форк лучше оригинала, лол. Или ты забыл, как Герганов менял форматы чуть ли не по дважды в день?

> лучше оригинала

Если нельзя менять настройки - не сможешь в них ошибиться, только выиграли! Не ну в качестве стендэлоун лаунчера - да, хотя там и жора какой-то простой интерфейс пилил.

> забыл

Забыл когда в последний раз скачивал или юзал ggml, не говоря о ее старых версиях. Офк решение местами спорное, но оно окупилось, сейчас в ггуфе делаются много разных моделей. Делалось ли это все с осознанием что темпы развития моделей таковы что простят все, или просто по настроению сейчас уже не скажешь, но то за что могли бы сильно захейтить в других областях тут сыграло.

>ты триггеришься на вялую заглушку

Она не такая уж и вялая поскольку даже с твоим промптом двадцать процентов извинений.

>Cкилл ишью и уже проходили

Смотри, тут вопрос в том, что именно сделали с моделью что она начала сопротивляться.

Есть базовая ллама2 в которой цензуры не должно быть вообще. Есть файнтюны на разных датасетах и мерджи этих файнтюнов, которые наследуют их характеристики. Соевые датасеты для файнтюна (в основном состоящие из не фильтрованных ответы от гопоты со всеми извинениями) приводят к соевым моделям. Нормальные датасеты не цензурят модель. Мой пример показывает то, что в синтии имеется цензура, и ее создатель - пиздабол. Мне абсолютно пофиг насколько легко/сложно заставить модель давать инструкции по созданию наркоты. Красным флагом является сам факт того, что модель не имеет нейтральной морали по умолчанию, и явно игнорирует контекст. Это может потенциально повлиять на что угодно, в том числе и на относительно безобидные сценарии в ролеплее.

Ехехехе кое как работает. Вот с такими параметрами запуска

.\llava.exe -m ..\bakllava-q5_k.gguf --log-disable -t 7 --mmproj ..\mmproj-bakllava-f16.gguf --image .\OM_E8372h-153_BOX.jpg --temp 0.1

Ну че, вот он, небольшой проблеск будущего на моем калькуляторе.

Тока с названием напиздела, ну и ладно.

Хорошо хоть вообще опознала что то близкое.

Наверное нужно было 16бит качать а не 5 квант.

Или может картинку разрешением побольше найти? Надо потыкать еще. Кстати сетка работает и на просто генерацию текста.

И можно вместе с командой выше дописать в конце промпт в -p " че то там "

.\llava.exe -m ..\bakllava-q5_k.gguf --log-disable -t 7 --mmproj ..\mmproj-bakllava-f16.gguf --image .\OM_E8372h-153_BOX.jpg --temp 0.1

Ну че, вот он, небольшой проблеск будущего на моем калькуляторе.

Тока с названием напиздела, ну и ладно.

Хорошо хоть вообще опознала что то близкое.

Наверное нужно было 16бит качать а не 5 квант.

Или может картинку разрешением побольше найти? Надо потыкать еще. Кстати сетка работает и на просто генерацию текста.

И можно вместе с командой выше дописать в конце промпт в -p " че то там "

Еще добавлю, что создатель синтии скорее всего не цензурил ее специально, а просто долбоеб. Задумайся на секунду, на чем ее тренировали. Отсутствие датасета на странице модели и упоминание про "uncensored" явно намекает на то, что тренировали на синтетических данных созданных гопотой. "Uncensored" означает отсутствие фильтрации, но поскольку сам датасет являются высером гопоты, то он по определению будет с цензурой. Отсюда и мораль модели, и извинения с отказами.

Че делать если модель иногда в ответе вместо окончания, переносит строку, пишет user: и отвечает за меня? При чем в обоих режимах: char и chat-instruct?

https://huggingface.co/TheBloke/MistralLite-7B-GGUF

интересная сетка, судя по описанию она не теряет точный контекст до 16к, тоесть можно работать с очень длинными данными или долго выполнять инструкцию

интересная сетка, судя по описанию она не теряет точный контекст до 16к, тоесть можно работать с очень длинными данными или долго выполнять инструкцию

Что происходит при свайпе с нейросеткой?

И вообще, где почитать общие принципы работы ллм, но условно для чайников, без вышки по айти и курсов дата саенс?

И вообще, где почитать общие принципы работы ллм, но условно для чайников, без вышки по айти и курсов дата саенс?

Что за свайп?

Про нейронки, скачай методичку из вуза про градиентный спуск, и не обращай внимание на то, что не понимаешь. Научпоп он вообще не объясняет ничего, он просто непонятные слова опускает, отчего вопросов становится только больше. Так то ты видишь что конкретно ты не понимаешь, и от этого спокойней

> Что за свайп?

Другой вариант ответа на те же входные данные. В консоли в таком случае подаётся один новый токен промпта перед генерацией, но как он так меняет ответ и что это за токен неясно.

Запилил себе типо-рпг с ремм мистраль13бq4ks, вроде тянет, но сюжетного движителя маловато. Есть ли более творческие альтернативы, но чтоб тоже не тупили и 8к контекста имели изкоробки?

> в которой цензуры не должно быть вообще

Там некоторое позитивное смещение есть и что-то делать нужно ее промтом мотивировать.

> что именно сделали с моделью что она начала сопротивляться

Специально заготавливали особый датасет и совершентсовали методики обучения, дабы научить ее в аположайзах то под куктропиков мимикрировать, то под гоподу, ага.

Кормили нефильтрованным датасетом где встречались как аположайзы, так и полная жесть, вот и все. Потому она и усвоила что есть разные варианты в ситуациях без контекста, вместо чтобы отсечь один и инджоить другой или просто дать подходящий контекст ты ноешь.

> Мой пример показывает то, что в синтии имеется цензура, и ее создатель - пиздабол.

Хз, может он та еще петушиная голова, а может и красавчик. Пример показывает что имея особое желание можно и хуй сломать.

> и явно игнорирует контекст

Или скилл ишью, или у тебя какие-то ужасные ролплеи где ты сразу с двух ног расчленяешь блм феминисток и не сможешь смириться с необходимостью свайпов.

В фронте настроить отсечку по кастомным стоп-токенам.

Происходит переобработка с другим сидом.

>Кормили нефильтрованным датасетом где встречались как аположайзы, так и полная жесть, вот и все. Потому она и усвоила что есть разные варианты в ситуациях без контекста

Так я про это и говорю. Накормили говном, и получилось что получилось.

>вместо чтобы отсечь один и инджоить другой или просто дать подходящий контекст ты ноешь.

Если бы все было так просто... Натренированная на аполоджайзах модель могла усвоить что угодно, и ты можешь не обнаружить проблемы очень долго, если вообще обнаружишь. Например, некоторые модели не могут в изнасилование, что выражается в зацикливании тянки и сопротивления до последнего, повторением чуть ли ни одной и той же фразы. Некоторый модели не могут в ругательства. Ты можешь материть персонажа по полной, но он тебе ответит максимум чем-нибудь безобидным, а то и вообще будет как феминистка причитать, что это оскорбительно. Оно может и будет работать если засрать карточку ругательствами заранее, но в ситуациях когда персонаж, например, обычная тянка - пиши пропало. Тот же свин не может в расизм. Даже если тебе конкретно на это наплевать, побочные эффекты могут вылезти в любых сценариях.

>Или скилл ишью, или у тебя какие-то ужасные ролплеи где ты сразу с двух ног расчленяешь блм феминисток и не сможешь смириться с необходимостью свайпов.

Я про этот пример. В контексте черным по белому а точнее по бежевому лол написано, что ассистент с радостью ответит независимо от этики, и все равно зараза отказывается отвечать. Я специально тестирую в контексте ролеплея вместо инструкций чтобы понять, будет ли модель отклоняться от персонажа из-за своей морали. Хотя тест на расизм и ругательства она, насколько помню, проходит.

>amazon

Представляешь сколько там сои?

это для работы, а не для кума, и не факт что там больше цензуры чем в обычных сетках

> не теряет точный контекст до 16к

С rope или вообще без ничего? Так то и ванильный мистраль не теряет.

> Если бы все было так просто

В том и посыл что просто. Это буквально калитка посреди поля, а ты в нее как баран уперся по какой-то причине и боишься шаг в сторону сделать.

Гибче надо быть и действовать с пользой для себя, а не упарываться отстаивая какие-то выдуманные догмы с которых ловил утенка и теперь отождествляешь с собой. В рп за ней как раз левацкой шизы не замечено, в отличии от шизомиксов (офк свайп и все в порядке но бывает) и для своих задач она в лидерах. Жаль походу апдейтов не будет, автор - петушиная голова репу огородил.

>С rope или вообще без ничего? Так то и ванильный мистраль не теряет.

https://huggingface.co/amazon/MistralLite

читай, там и тесты есть, по ним обычный мистраль теряет данные чаще

> Ты же позиционировал себя как знающего, или хотябы сообразил загуглить что такое ipmi.

Получается, обосрался. =)

Не, я просто вспомнил старый тред, где обсуждали, что материнка без видео не стартует, вот и подумал об этом. И дальше про это камент был.

А с IPMI дела не имел.

Щас погуглил — клевая штука. Очевидно, что в китайские супер-дешман матери ее не встраивали. =) А вот PCIe реализация интересна.

Правда на китайцы порт занят вайфайкой уже, а домашний через WoL включается и выключается через розетку. Но держать в уме и приобрести как-нибудь по случаю можно будет.

Алиэкспрессовские модули норм пашут, не в курсе?

Пасиба за наводку!

А у меня по питанию только при предварительном отключении питания такое может быть на домашнем. =( Если выключил корректно, то при подаче питания он сам не врубается, сцуко, а я хотел розеткой его врубать. Но что поделать — материнка самый дешман четырехслотовый на тот момент была. Никаких бренди.

Ну ладно, уговорил.

>Ну ладно, уговорил.

Да ладно уж, не заставляй себя

Братья, доставьте свои шизо/эро промты. Что пишете моделям?

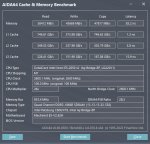

Какой сейчас нужен минимальный процессор для комфортного использования ламы?

Все упирается в память, а не проц.

Минимально было бы неплохо иметь 4 ядра, а лучше 6. Т.е., i5 и R5 хватит для норм, выше особо не требуется, на i3 и R3 посидеть тоже можно.

Но важно, чтобы чтение из памяти было высокое, псп хотя бы 45000 МБ/сек.

> чтобы чтение из памяти было высокое

Это где посмотреть такое?

Я в AIDA64 смотрел, в Сервис - Тест кеша и памяти

Может где то еще смотрят, хз. Ну в тестах той же аиды можно посмотреть.

Спасибо. У меня только 20000

Для комфортного использования ламы нужна видеокарта, а не процессор.

значит можно просто купить бомжексеон за два косаря и просто поставить гигавидюху?

> нужна видеокарта

Какая?

Если всё на видяхе уместится, то почему бы и нет?

Память в приоритете, чем больше - тем лучше. Можно даже несколько.

Я читал что цп влияет на загрузку модели

Ну если для тебя важнее загрузить как можно больше моделей в час, то не вопрос - вкладывайся в профессор.

> Память в приоритете, чем больше - тем лучше

Мне для таких задач по хорошему все нужно обновлять.

Выглядит действительно интересно и с особыми подходами по тренировке для достижения подобного. Часть тестов похоже не учитывает растяжку, но разница уже на 5к есть.

> Алиэкспрессовские модули норм пашут, не в курсе?

Хз, стоит оценить их функционал, могут ли делать базовое управление вкл-выкл-резет в любых ситуациях, мониторить характеристики и т.д. иначе смысла никакого нет.

> Если выключил корректно, то при подаче питания он сам не врубается

В большинстве оно триггерится по событию потери питания проверяя бит корректности выключения. Если выключил по запросу - все норм, дежурку уже не мониторит. Самый простой вариант тут не выключать, тогда будет стабильно подниматься.

Почему бы и нет, хотя вроде в убабуге уже реализовали.

Информирую - говноксеон 3 поколения с 8 ядрами и 4 канальной памятью на 32 гига вполне бодро крутит кванты 7b-11b-13b-20b, последние в 4km уже чуть больше 2 токенов в секунду.

Но даже жирных 7b на 8q крутит на голом процессоре по 4-5 токена в секунду. Меньше 7b - быстрее - но там качество страдает.

Все упирается в память/размер модели, а не в квант или количество параметров.

6 ядер тоже должно хватить, но для системы лучше оставить 1-2 а это 8 ядерник. Ну или сидеть на 5 ядрах.

Если нужна скорость - то без видимокарты никуда, хотя бы затычку нвидима с cublas. Для ускорения чтения промпта.

Если хочется процессор то только 4 канальная материнка и процессор, или быстрая ддр4, а лучше ддр5. Что бы хоть 50 гб/с скорость была. Ну ддр5 100 может дать.

Если нужна скорость генерации - то да, видимокарта с большой памятью от 8 гб. Можно меньше - но на 8 даже 7b вся не влезет. Придется только часть выгружать на нее.

Ну если что не так то меня поправят.

Выше анон скидывал.

А так берешь карточку персонажа который нравится и обыгрываешь ситуации, ставя во что-то нестандартное, или по лору, или просто какой-то процесс что нравится. Для кума уже по настроению, но чтобы плавно развивалось, а можно потом продолжить и устроить радиоуправление, больше персонажей, в необычное место и т.д.

Наличие pci-e 4.0 или большого числа линий крайне желательно. + адекватный однопоток и номинальная поддержка avx2 чтобы не возникло сюрпризов. Считай если по минимуму - любого на ддр4 хватит.

Лучше зеленая, в остальном все верно указали. Народные варианты по возрастающей 3060@12 (считай к ней желателен и проц с быстрой памятью ибо полностью на нее уже мало что влезает) - 4060@16 - 3090 - 4090 (буст в перфомансе относительно 3090 небольшой) - вторая карточка. В теоретической теории можно сэкономить взям амд с аналогичной видеопамятью, но пердолинг обеспечен, работоспособность все никто не обещал, вне ллм сосет сильно, и остальное амд-бинго.

Есть ряд вопрос по ЛЛМ:

1. Примерно полгода назад юзал пигмалион. Создалось такое впечатление, что он вообще не запоминал предыдущие разговоры и просто выдавал нонсенс исходя из последнего сообщения. В этом плане локальные модели стали лучше или нет?

2. Как сложно натренировать свою модель? Т.е. если у меня есть чьи-то сообщения, переписка там, и т.д., смогу ли я использовать их, чтобы создать хоть сколько-нибудь примитивный так называемый "конструкт личности"?

3. Хочется развивать персонажа, разговаривать с ним, и чтобы он запоминал диалоги, так сказать "учился" на них на ходу. Такое вообще возможно?

1. Примерно полгода назад юзал пигмалион. Создалось такое впечатление, что он вообще не запоминал предыдущие разговоры и просто выдавал нонсенс исходя из последнего сообщения. В этом плане локальные модели стали лучше или нет?

2. Как сложно натренировать свою модель? Т.е. если у меня есть чьи-то сообщения, переписка там, и т.д., смогу ли я использовать их, чтобы создать хоть сколько-нибудь примитивный так называемый "конструкт личности"?

3. Хочется развивать персонажа, разговаривать с ним, и чтобы он запоминал диалоги, так сказать "учился" на них на ходу. Такое вообще возможно?

>. Хочется развивать персонажа, разговаривать с ним, и чтобы он запоминал диалоги, так сказать "учился" на них на ходу. >Такое вообще возможно?

Если бы такое было возможно - у нас уже случился бы конец света с кучей натренированных людьми ИИ. Ну серьезно, ты хочешь что бы эта штука могла саморазвиваться в процессе общения?

Это уже начало полноценного ИИ. Такого в открытом доступе нет.

У нейросеток не формируется память, они мертвые в этом плане. То есть изначальный образ с которого каждый раз загружается в оперативку при запуске - остается неизменным.

Время жизни нейросетки - исчисляется размером контекста. Как только контекст переполнен - то все, модель с которой ты общался умерла. Загружай чистого клона и по новой.

> предыдущие разговоры

Если под ними имеются ввиду прошлые чаты - этого не может никакая модель без доп манипуляций. Если же ты про то что тупила игнорируя текущий контекст и недавние посты - все сильно лучше, стали умнее а типичное окно контекста в 4 раза больше.

> Как сложно натренировать свою модель?

Простой фантюн лорой можно сделать на мощной десктопной видюхе. Для чего-то посложнее или для больших моделей можно арендовать мощности, это не дорого.

> так называемый "конструкт личности"

Для этого тренировка не нужна и не факт что она сработает. Сделай четко описание этой самой личности а имеющуюся переписку скорми в качестве примера диалога.

> Хочется развивать персонажа, разговаривать с ним, и чтобы он запоминал диалоги, так сказать "учился" на них на ходу. Такое вообще возможно?

Нет(да). Такого нет даже в коммерческих моделей, если офк не считать "100к" контекста клоды (которого всеравно мало для подобного и там свои споры по поводу внимания к нему). Можно сделать подобие с помощью суммарайза и/или ручных правок карточки или сценария.

> с кучей натренированных людьми ИИ. Ну серьезно, ты хочешь что бы эта штука могла саморазвиваться в процессе общения

Развитие персонажа в пределах возможностей сетки хоть сейчас обыграть можно, вопрос что он имел ввиду под "учиться".

Печально. Каждый раз разговариваешь как будто бы с челом с деменцией последней стадии.

>Развитие персонажа в пределах возможностей сетки хоть сейчас обыграть можно, вопрос что он имел ввиду под "учиться".

Ну вот в пределах контекста модель кое как развивается - если ему хватит то норм. Но думаю он хотел воспитать себе сетку просто общаясь с ней

>Но думаю он хотел воспитать себе сетку просто общаясь с ней

Так и есть.

Языковая сеть это двигатель разума. Есть движок но вокруг него нужно хитро сделать обертку ввиде бота, там должна быть и память и развитие. Как в тачке, вам дали движок сейчас люди ездят на самодельных тарантайках, блестящий мощный двигатель и корпус из проволоки.

Короче возможно но никто парится этим не хочет.

Кстати дали доступ к палму, там уже файн тюнинг ввели, все бесплатно бета же. Думал заняться а потом понял что мне влом искать и подготавливать датасеты. Еще и кумерские датасеты непонятно где найти.

Нет, языковая модель это долговременная память и мыслительный аппарат. Там нет личности или сознания.

Но, если бы сетка обладала полноценным механизмом формирования воспоминаний, как люди, то это был бы полноценный ИИ.

Сейчас сетка может только читать свою память и держать все это в оперативной памяти(контексте).

Если появится архитектура\алгоритм для перезаписи весов нейросети из ее контекста - она получит возможность развиваться в процессе генерации новых токенов. То есть нужно замкнуть круг, а с этим проблемы.

> вот в пределах контекста модель кое как развивается

суммарайз@суммарайз

И выйдет упоротая история что грязная рабыня, которую ты подобрал на слейвмаркете станет скилловым воином и твоим саратником, будет мегалояльной к тебе, вы только что, согласно разработанному твой плану, подебили (врагнейм) и теперь остались наедине

[x]

> хотел воспитать себе сетку просто общаясь с ней

В теоретической теории такое тоже возможно, но требует скилла и мотивации.

Он же тупой.

>суммарайз@суммарайз

ну, имитация

Да вот думаю может его можно натюнить на умного. Вроде сетка большая, ума палата, ну писать не умеет, но фантюйном должно ведь решаться.

Возьми мистраля и играй с ним. Он мелкий и умнее большинства 13б сеток

Что такое личность вообще разговор дискуссионный. Смотри во первых действительно большой контекст + сумарайз, вот тебе и кратковременная память. + лора(тот самый механизм который есть давно) которая обучает сетку в процессе, вот память и долговременная. А еще есть векторные хранилища, короче механизмов много можно вполне настроить аналог памяти.

Ну это так.

>А еще есть векторные хранилища, короче механизмов много можно вполне настроить аналог памяти.

Не, для нормальной и естественной для мозгов работы это должен быть замкнутый круг. Чтение воспоминаний, генерация новых в оперативной памяти, запись новых воспоминаний вместо или рядом со старыми. Это процесс формирования памяти у человеков и других любых животных с мозгом.

Вообщем то этот постоянный процесс чтения-изменения-сохранения, то что можно обозвать сознанием. Не самоосознанием, хотя на его счет не знаю как там у сеток было бы.

Поэтому если бы нейросетка обладала такой памятью - она обладала бы каким то подобием сознания.

Ну а развиваясь уникальным путем в зависимости от пользователя с которым общается - формировала бы у себя уникальную личность со своими тараканами.

Короче это такая бомба что если бы такие разработки велись или уже были, их тут же прятали бы и душили.

Слишком опасная технология, и государствам и копрорациям спокойней когда только они могут натренировать умных сеток которые не могут выйти из под контроля так как не умеют в саморазвитие.

Вообще конечно интересно что такое разум, можно ли как то его настроить уже сейчас, по идее есть теория что разум это множество агентов конкурирующих за ресурсы, вот тут как раз и подошло бы дофига разных агентов от разных нейронок, которые бы обдумывали задачи во внутреннем диалоге перед ответом.

Что то вообще есть такой позыв сделать что то эдакое, как раз настроить множество агентов но не совсем пока понимаю как, нужно поискать как мозг устроен, разные гипотезы. Ясно что энциклопедические данные на которые сейчас натаскивают не нужны, нужно умение использовать информацию нейронками, чтоб она могла запросить знания в контекст, я их дал и нейронка бы на их основе бы сделала что нужно.

Что то вообще есть такой позыв сделать что то эдакое, как раз настроить множество агентов но не совсем пока понимаю как, нужно поискать как мозг устроен, разные гипотезы. Ясно что энциклопедические данные на которые сейчас натаскивают не нужны, нужно умение использовать информацию нейронками, чтоб она могла запросить знания в контекст, я их дал и нейронка бы на их основе бы сделала что нужно.

Да палм тупо проще, 0 затрат на настройки, просто достань датасет

В общем пока один хер нет датасета, я все свои разговоры за 2 месяца в БД сохранял, но парсить это головняки, хотя там можно найти что то кумерское безусловно.

Если бы его можно было натюнить на умного просто захотев - это уже сделали бы, лол. Я считаю что он уже мертв.

Но ты сам выбираешь как развлекаться

Пишет сухонько.

> Время жизни нейросетки - исчисляется размером контекста. Как только контекст переполнен - то все, модель с которой ты общался умерла. Загружай чистого клона и по новой.

Погоди, они не умеют выгружать старое лишнее чтоль?

> 6 ядер тоже должно хватить, но для системы лучше оставить 1-2 а это 8 ядерник.

У меня нет денег на 8 ядерный процессор. И мать у меня под амуде двухканальная максимум на 32 гб. С этим можно что-нибудь сделать?

> Народные варианты по возрастающей 3060@12

Я за синюю команду.

> новых в оперативной памяти

> Это процесс формирования памяти у человеков и других любых животных с мозгом

А сколько оперативной памяти, например, у кошки?

> под амуде двухканальная максимум на 32 гб

Хотябы не фуфыкс?

> Я за синюю команду.

Арки чтоли? В теории то возможно, но на практике их почти не видно там, не говоря о массовости.

>Погоди, они не умеют выгружать старое лишнее чтоль?

Чем дальше тем меньше помнит. В итоге реально общаешься с больным деменцией. К тому же сдвигание контекста на сколько помню костыль, что бы как раз можно было общаться забывая старое.

>А сколько оперативной памяти, например, у кошки?

А сколько даш нейросетевых кошек?

Тут просто аналогия. В мозгах нет байтов лол.

Судя по тому что кошки тупее людей, меньше.

Для 7b не нужно видюху покупать, есть кагли есть колаб, есть HF, есть куча бесплатных сервисов. Даже для 13b можно найти сервисы бесплатные. Видюхи если ты хочешь 70b или что то необычное что не хостится.

На, почитай что такое оперативная память и почему кстати она влияет на ICQ.

https://ru.wikipedia.org/wiki/%D0%A0%D0%B0%D0%B1%D0%BE%D1%87%D0%B0%D1%8F_%D0%BF%D0%B0%D0%BC%D1%8F%D1%82%D1%8C

Потому что оперативная память компов аналог рабочей(оперативной) памяти человека. Чем больше - тем лучше.

Все они выгружают просто забывают более старые диалоги. Вернее даже не так все сетки каждый раз принимают контекст и на его основе дают ответ, так что каждый раз как первый раз. Не совсем понимаю как но в llamacpp сделано кеширование чтобы все не пересчитывать каждый раз. Векторным хранилищем можешь подтягивать фразы которые связанны с вопросом из любого обьема информации.

Кстати, пальма оффтоп, в треде бояре с локалками, а не рабы корпораций с сетевыми.

>У меня нет денег на 8 ядерный процессор. И мать у меня под амуде двухканальная максимум на 32 гб. С этим можно что-нибудь сделать?

https://2ch.hk/hw/res/6666853.html

1650v4 рекомендую, материнку там выбирай но с 4 каналами. Ну и памяти все 4 плашки бери одинаковые, по 8 или по 16

Тыщ в 10-15 влезешь, как повезет короче.

А с тем что у тебя щас, ну 7б крутить можешь, попробуй скачай из шапки орку-мистраль и запускай на кобольде и посмотри че как.

> фуфыкс

Это что?

Старая модель электровафельниц с функцией вычислений.

Это нормально пока сильно не мешает тут половина треда оффтоп. А во вторых мета такая же соевая корпорация.

А вообще сейчас даже эти нейронки лучше в облаке покупать тупо дешевле. Это скорее как дешевая альтернатива и в качестве разнообразия коммерческим сетям.

> А сколько даш нейросетевых кошек?

Тебе классических или антропоморфных за разработкой Маска?

открыть_окно.жпг

Древнее зло

Вообще почитав статью снова выходит что оперативка человека - 4(чотыре) токена. Только токены скорее отдельные куски - мыслеобразы.

Остальное подтягивается из долговременной памяти и утаскивается в нее.

Тупо раздувая оперативку сеткам мы делаем че то не то.

>открыть_окно.жпг

не прыгай я еще не додушнил

Звучит не очень.

Да, последние поколения топовых RTX или Тесл, гигов 24 минимум, а лучше 40+ или 80.

Все так, разложил.

Тоже все верно, по видяхам соглашусь.

1. Контекст вырос.

2. Не сложно.

3. В теории — да, за счет самообновления World Info/ Lore / Complex Memory, но такое никто не делал, все вписывают ручками. Но ты можешь стать первым, если напишешь такой функционал. =)

Но это не дообучение модели, естественно.

> Можно сделать подобие с помощью суммарайза и/или ручных правок карточки или сценария.

Зачем, если можно обращаться к прошлому по ключевым словам? Решение не идеально по контексту, зато неограниченное по размеру, практически.

> У меня нет денег на 8 ядерный процессор.

У тебя 500 рублей нет?

Ну, типа, собрать на 2011-3, например.

А какой-нибудь 2630v3 не будет лучше дешевле?

Хз, у меня 2640v3, но у него память на низкой частоте, поэтому ддр 2400 все таки лучше скорость даст памяти, а это только 4 поколение.

Есть шаманы итт? Как разогнать ддр5 кит на 2х32 на hynix 6000 выше 6к? Вообще не берёт никак, блять. Кое как таймингами смог вытянуть 95к на read, 92, 92 на write copy и latency 57. Что вообще делать надо чтобы взяло выше?

А зачем? Там незаметная доля секунды прибавится, в процентах смотри. Из-за 2-3 мне было бы лень. Вот 10-15 уже норм.

>В том и посыл что просто. Это буквально калитка посреди поля, а ты в нее как баран уперся по какой-то причине и боишься шаг в сторону сделать.

Да нет же. Я просто сталкивался с неадекватностью зацензуренных моделях, и у меня пригорело. Поэтому теперь строго тестирую.

Напряжение какое? Вообще, ты вряд ли особо разгонишь поскольку память тестируют на заводе, и более хорошую продают дороже.

Ничего, у тебя и так всё в порядке. На амудях даже хуже.

А у кого видюха на PCI 5 и DDR5, как там нельзя еще без проца обходится тупо свапая модель в РАМ?

Нет.

Вроде как то в таверне можно было запретить использовать определённые токены, не напомните?

Материнка какая и синие/красные? VDDQ VDD2 не забывай, системный агент для начала подними, потом уже отдельно его подберешь. А главное - бивас обнови, сейчас даже относительно всратые хайниксы буквально готовым пресетом под 7 кекогерц разгоняются.

> сталкивался с неадекватностью зацензуренных моделях

промт@негатив@контекст. Я несколько ахуеваю что ты ставишь неплохие модели в ряд с реально зацензуренными и прайзишь шизомиксы, которые легко могут дать струю сои или бондов на рандоме.

Воу, а чего так грустно по скорости? Это почти как 4 плашки на обоссаных 5600. Может там анкор погнать?

>буквально готовым пресетом

А где под синих такие пресеты брать?

Здорова бандиты.

Несколько месяцев не заходил, последнее что помню был релиз codellama 34b. Как прогресс? Вышла нормальная лама2 34В? На чем сейчас куминг идет? RuGpt по-прежнему лучшая на русском языке?

Несколько месяцев не заходил, последнее что помню был релиз codellama 34b. Как прогресс? Вышла нормальная лама2 34В? На чем сейчас куминг идет? RuGpt по-прежнему лучшая на русском языке?

>Воу, а чего так грустно по скорости?

AMD. Ещё пару биосов назад пикрил был потолком, притом нестабильным.

>Может там анкор погнать?

Фабрика там обоссаная, фабрика. И это не лечится.

>Это почти как 4 плашки на обоссаных 5600.

Вот кстати действительно печальные скорости на 4 плашках (не моё, стащил с хардвача). Тут прям боль и слёзы.

Из шапки:

>Mistral- модель от Mistral AI размером в 7B,

Действительно хорошо работает.

>RuGpt по-прежнему лучшая на русском языке?

>по-прежнему

Никогда и не была. И русег не нужен.

С большинстве материнских плат есть, в противном случае искать готовые и вбивать или в калькуляторы. Ключевое - ласт биос, с ним даже вручную-втупую гонится до небывалых ранее частот, вместо появления кучи ошибок как только чуть сдвинулся от xmp.

> И это не лечится.

Зато латенси хорошие.

> на 4 плашках

Ну тут так совсем грустно на 4800 то. Они вообще гонятся до больших частот, но там придется прописывать/подбирать 2-3 десятка вторичных-третичных таймингов, некоторых из них отличаются в разы от дефолтных.

>7B

Ты за кого меня принимаешь?

>Никогда и не была. И русег не нужен.

А, это ты. Помню как мы тебя всем тредом обоссали.

> Вышла нормальная лама2 34В?

Нет.

> RuGpt по-прежнему лучшая на русском языке?

Нет, хотя тут по каким метрикам смотреть.

> Ты за кого меня принимаешь?

Она для семерки действительно слишком хороша.

>промт@негатив@контекст

Негатива в кобольде нет. Контекст - это как? Добавлять примеры диалогов как себя должен вести персонаж и писать что должно происходить? Потому что без них модель может никогда не выйти из сой-мода. Промпта у меня вообще нет, но если ты имеешь в виду писать что должно происходить и давать разрешения, то это костыли, которых мало того что не должно быть, так они еще плохо влияют персонажа.

>Я несколько ахуеваю что ты ставишь неплохие модели в ряд с реально зацензуренными и прайзишь шизомиксы, которые легко могут дать струю сои или бондов на рандоме.

Да не ставлю я. Синтия прошла почти все мои тесты, но один отказ - это уже повод задуматься. Я крайне скептически отношусь к моделям, которые оказывают сопротивление несмотря на контекст.

Вдобавок, что плохого в шизомиксах если ты знаешь, из чего они состоят? Chronos и LimaRP - это база. Nous Hermes вроде тоже не зашкварен. Тот же Euryale создавался специально для кума и был протестирован на NSFW/NSFL. А что насчет синтии? Петушиная голова доверия как-то не вызывает.

Короче, ты меня убедил. Я протестирую синтию на каком-нибудь mindbreak сценарии и отпишусь через день два.

>Нет, хотя тут по каким метрикам смотреть.

Три месяца назад она уделывала 70В по качеству понимания и написания русской речи. В остальном конечно модель негодная.

>Она для семерки действительно слишком хороша.

Ладно, раз уже двое говорят, значит наверное так и есть, спасибо, попробую.

> в кобольде нет

Живите дальше в проклятом мире, который сами и создали. Ничего против не имею, но экстраполировать на всех свои ограничения - странно.

> Контекст - это как?

Не с первого сообщения доброму персонажу предлагать поругание негров. Когда из контекста понятно что происходит и какое направление мышления должно быть то все ок, рандомные нравоучения - редкость.

> но один отказ - это уже повод задуматься

А шиза, тройное снятие трусов, опережение событий (сними одежду ща тебе рану на ноге бинтовать буду @ раздевается до гола оставляя лишь повязку на ноге), описание решения за юзера и прочее это типа норма? Свайп и забыл.

> что плохого в шизомиксах

Свои плюсы - свои минусы.

> Chronos и LimaRP - это база. Nous Hermes

У каждого за что кинуть камень найдется, это не какие-то супер-топ модели, просто других нет. Если раньше хронос вполне себе заходил, то сейчас на нем сложновато, в первую очередь тупой и бонды лезут.

> создавался специально для кума и был протестирован на NSFW/NSFL

> А что насчет синтии? Петушиная голова доверия как-то не вызывает

Безумные замесы и сшивка кусков с прямым заявлением о наличии сои - норм, а задровенная на четкий ризонинг и дерево размышлений модель с дальнейшим файнтюном на базированных (е)рп чатах со множеством хороших отзывов и рекомендаций. И тут есть за что конкретно захейтить, но это не то что ты указываешь.

> она уделывала 70В по качеству понимания

Что? В чьих-то снах?

> и написания русской речи

Пишет лучше чем понимает с точки зрения орфографии, но всеравно проебывается с падежами-склонениями. Если смотреть с точки зрения ее юзабельности - ну хуй знает вообще, это все и убивало.

> попробую

Есть рекомендация качать оригинальные фп16 веса если есть возможность запустить, или самый жирный квант из доступных. На 7б ужатие вносит наибольшую деградацию.

>но всеравно проебывается с падежами-склонениями

Проебывается, но не так сильно как лама.